,Versteckte‘ NOAA-Temperaturdaten enthüllen, dass 6 der letzten 9 Monate in den USA zu kalt ausgefallen waren – und die NOAA bekommt nicht einmal den Juni hin

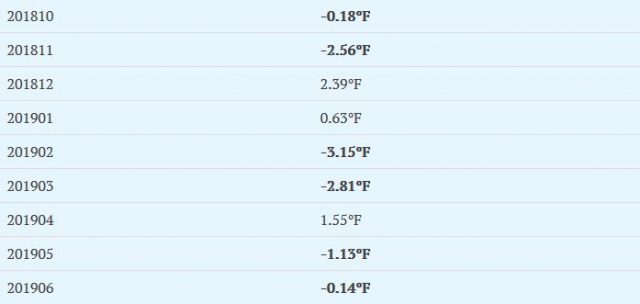

Wenig bekannte Daten des hoch modernen Climate Reference Network der USA (welche es anscheinend niemals schaffen, Eingang in den monatlichen „Klimazustands“-Bericht der NOAA Eingang zu finden) zeigen, dass sechs der letzten neun Monate zu kalt ausgefallen waren, was in der folgenden Tabelle durch Fettdruck hervorgehoben ist:

Tabelle 1: mittlere Temperatur-Anomalie von Oktober 2018 bis Juni 2019 in den USA. Die ganze Datentabelle steht hier.

Man beachte die negative Abweichung für Juni 2019 mit -0,14°F.

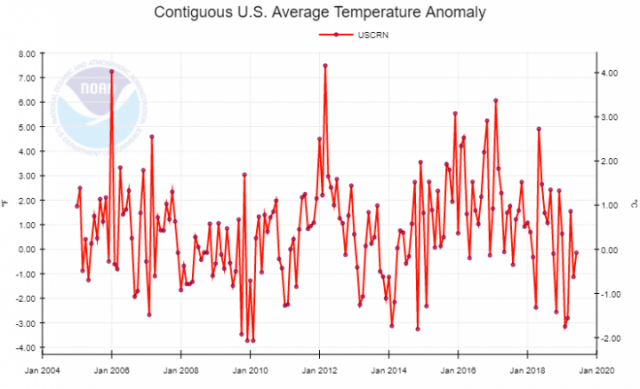

Die direkt der National Climate Data-Page der NOAA entnommenen Daten zeigen nicht nur, dass es in längeren Zeiträumen im Jahre 2019 zu kalt gewesen war, sondern auch, dass das Mittel der Temperatur in den USA im Jahre 2019 niedriger liegt als im Jahre 2005, dem Beginn des Datensatzes:

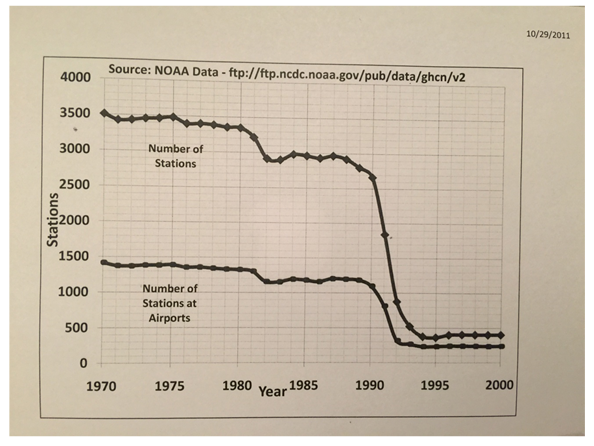

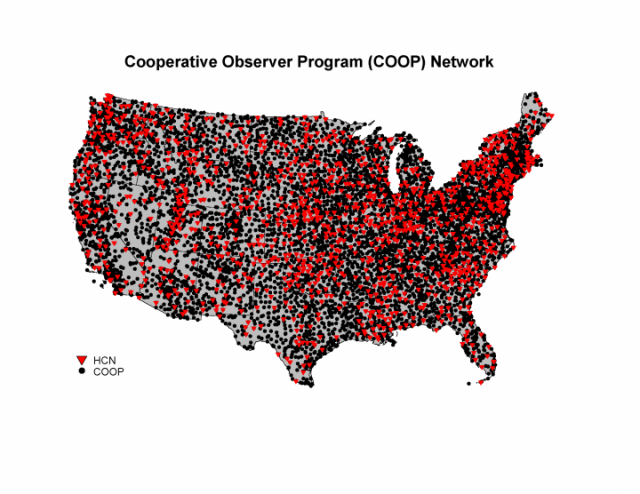

Das U.S. Climate Reference Network (USCRN) wurde eingerichtet, um die genauesten Temperaturmessungen zu zeigen im Vergleich zum alten Cooperative Observer Network (COOP), welches durch den UHI, Probleme des Aufstellortes und eine Fülle von vom Menschen induzierten Inhomogenitäten wie Stationsverlagerungen, unvollständige Daten, aufgelöste Stationen sowie Bedingungen an Rollbahnen von Flughäfen beeinträchtigt worden waren, die niemals dafür gedacht waren, als Klimaaufzeichnungen herangezogen zu werden.

Die Leserschaft dieses Blogs kennt meine Arbeiten bzgl. dieser Probleme (hier), und als Folge davon gab es einen Report der GAO über Probleme des alten COOP-Netzwerkes. Man untersuchte einen Unter-Datensatz des größeren COOP-Netzwerkes (USHCN) und schrieb:

Der Übersicht der GAO von Wettervorhersage-Büros zufolge genügten 42% der aktiven Stationen im Jahre 2010 nicht einer oder mehreren Anforderungen der Standards bzgl. der Aufstellung. Unter Berücksichtigung der Erfordernisse des Betriebs der Stationen fand die GAO, dass die Büros allgemein, aber nicht immer, die erforderlichen Werkzeuge zur Hand hatten, um jährliche Inspektionen von Stationen durchzuführen und Stationsaufzeichnungen zu aktualisieren. NOAA-Funktionäre sagten GAO, dass jährliche Begutachtungen der Stationen sowie ständige Aktualisierungen der Aufzeichnungen notwendig sind einschließlich der Aufstell-Bedingungen, damit die NOAA und andere Nutzer der Daten die Bedingungen kennen, unter welchen die Daten aufgezeichnet wurden. Die NOAA-Mitarbeiter identifizierten eine Reihe von Herausforderungen, welche dazu beitrugen, dass einige Stationen nicht die Standards erfüllten, einschließlich der Verwendung von Messinstrumenten, die via eines Kabels mit einer Anzeige in irgendeinem Raum verbunden waren – wodurch sich die installierte Ausrüstung näher an einem Gebäude befinden kann als von den Standards vorgeschrieben.

Die NOAA verfolgt nicht, ob USHCN-Stationen den Standards der Aufstellung und der Erfordernis der Aktualisierung von Aufzeichnungen der Station genügen, und sie verfügt nicht über eine Abteilung, welche sich der Probleme nicht erfüllter Standards von Stationen annimmt. Leitlinien der Durchführung von Messungen schreiben aber entsprechende Informationen vor, um die Ergebnisse des Programms zu bewerten. Die Informationskanäle der NOAA jedoch sind nicht darauf ausgelegt zu verfolgen, ob die USHCN-Stationen den Standards bzgl. Aufstellung und Aktualisierung genügen. Ohne zentral verfügbare Informationen kann die NOAA einfach nicht angeben, wie sich die Stationen verhalten. – Quelle

Die Antwort der NOAA? Anstatt darauf einzugehen, wurde der Unter-Datensatz der COOP-Stationen im Jahre 2012 kurzerhand beendet. Auf seiner Klimadaten-Website sagt die NOAA jetzt:

Nationale monatliche Temperatur-Aktualisierungen des USHCN wurden ausgesetzt. Die offiziellen CONUS-Temperaturaufzeichnungen beruhen jetzt auf nClimDiv. Die USHCN-Daten von Januar 1895 bis August 2014 werden aber zu historischen Vergleichszwecken weiter gezeigt. – Quelle

Und dennoch, während das USHCN eingestellt wurde und dessen Daten nicht mehr in den monatlichen und jährlichen NOAA-Klimaberichten auftauchen, bestehen die im USHCN erkannten Probleme im größeren COOP-Netzwerk fort, von welchem viele tausend Stationen verbleiben:

Alles, was die NOAA gemacht hat war, die von uns benannten sichtbaren Symptome zu behandeln (indem man sie einfach entfernte). Die Wurzel des Übels packte man jedoch nicht an und verwendete weiterhin die Mehrzahl der Daten darin – Daten mit der gleichen Art von Problemen und Inhomogenitäten, die schon im USHCN-Unterdatensatz erkannt worden waren. Das USHCN bestand aus 1218 Stationen aus über 8700 COOP-Stationen, und jene verbleibenden Daten werden herangezogen, um den U.S. Climate Divisional Dataset zu berechnen, welcher dann wiederum als heutige „offizielle“ Temperatur-Mittelwerte verkauft wird. Im Grunde war alles, was sie taten, das Problem unter den Teppich zu kehren und dann zu tönen, dass man über Algorithmen verfüge, um schlechte Daten zu „fixieren“.

Inzwischen werden perfekt gute Daten ignoriert zugunsten „fixierter“ schlechter Daten. Die NOAA sagt Folgendes zum hochmodernen Climate Reference Network:

Die Absicht des USCRN-Programms ist es, ein Klimabeobachtungs-Netzwerk mit nachhaltig hoher Qualität zu erhalten, welches in 50 Jahren mit höchstem Vertrauensniveau die Frage beantworten kann: Wie hat sich das Klima der Nation während der letzten 50 Jahre geändert?

Diese Stationen wurden mit der Klimawissenschaft im Hinterkopf gestaltet. Drei unabhängige Messungen von Temperatur und Niederschlag werden an jeder Station durchgeführt, wobei die Kontinuität der Messungen sowie die Wartung gut kalibrierter und hoch genauer Messungen sichergestellt werden. Die Stationen werden in unberührten Umgebungen aufgestellt, in denen noch viele Jahrzehnte lang keine nennenswerten Entwicklungen zu erwarten sind. – Quelle

Die Daten aus der übrigen Welt, erfasst im Global Historical Climatology Network (GHCN) der NOAA besteht zum größten Teil aus der gleichen Art von Stationen mit gleich großen oder sogar noch größeren Problemen bzgl. der Daten (wegen des Fehlens einer konsistenten Qualitätskontrolle).

Unglücklicherweise scheint die NOAA zu glauben, dass es diese Daten des hochmodernen Climate Reference Network nicht wert sind, der Öffentlichkeit mitgeteilt zu werden. Eine Durchforstung der letzten 5 Jahre monatlicher und jährlicher „Klimazustands“-Berichte ergab, dass nicht ein einziges Mal diese Daten hoher Qualität erwähnt worden waren. Vielmehr zog man es vor, stattdessen die Daten des alten COOP-Netzwerkes zu zeigen, die jetzt die neue Verpackung als der U.S. Climate Divisional Dataset erhielt.

Tatsächlich behauptet der NOAA-Klimareport für Juni 2019, dass der Monat in den USA um 0,2°F zu warm war (hier), obwohl dem US Climate Reference Network die Juni-Daten diesen Monat als 0,14°F zu kühl auswiesen.

Wie sieht nun aber die korrekte Temperatur der USA für den Juni aus?

Auch im Mai 2019 gab es Unstimmigkeiten. Dem USCRN zufolge lag die Mitteltemperatur um 1,13°F unter dem vieljährigen Mittel.

Der „offizielle“ Klimareport der NOAA nannte eine nur halb so große Abweichung (hier)

Es sieht so aus, als ob sich die NOAA noch nicht einmal darauf einigen kann, wie die Temperatur in den USA auf monatlicher Basis aussieht. Man verwendet alte und unzuverlässige Daten, während man es ablehnt, die besten Daten zu verwenden, die sie haben. Warum?

Das ist eine schändliche Inkompetenz der Regierung, die einmal untersucht werden sollte.

Man fragt sich, ob schreiende Schlagzeilen wie „heißest jemals“ in diesem Monat überhaupt existieren würden, falls es auf der Welt eine globale Version des USCRN geben würde – mit regelmäßiger Datenkontrolle und Messungen weit entfernt von der vom Menschen induzierten Wärmeinsel über Städten.

Übersetzt von Chris Frey EIKE