Die Temperaturen im Dezember 2020 und das deutsche Stromabschaltungsgesetz

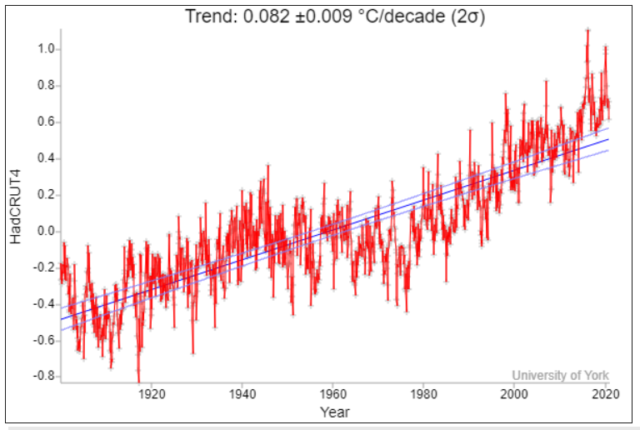

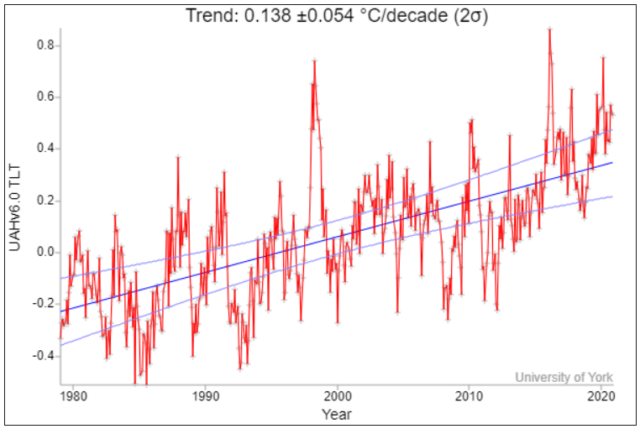

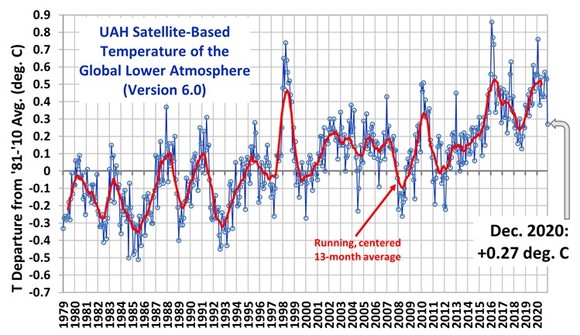

Aber zunächst zur Temperaturentwicklung.Die globale Mitteltemperatur der satellitengestützten Messungen ging im Dezember stark zurück. Die Abweichung vom 30-jährigen Mittel (1981 bis 2010) betrug nur noch 0,27 Grad Celsius (November 0,53 Grad Celsius). 2020 blieb allerdings das zweitwärmste Jahr seit 1979 (hinter 2016). La Nina wird sich in den nächsten Monaten noch stärker bemerkbar machen, so dass im neuen Jahr 2021 mit einem weiteren Temperaturrückgang zu rechnen ist.

Trotz Rückgang der CO2– Emissionen steigt die Konzentration in der Atmosphäre

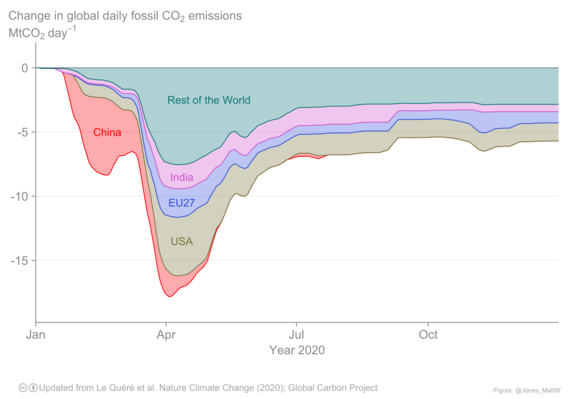

Die weltweiten CO2-Emissionen gingen in 2020 um 6,7 % zurück, und zwar von 36,4 Milliarden Tonnen CO2 auf 34,1 Milliarden Tonnen. Die Emissionen gingen Coronamaßnahmen-bedingt in den USA um 12,1 %, in Europa um 11,2 % zurück. In China blieben die Emissionen aus Kohlekraftwerken unverändert ; die Gesamtemissionen gingen nur um 1,7 % zurück. Der Anteil Chinas an der Gesamtemission der Welt stieg demzufolge auf 29,3 %. Fast jede dritte Tonne CO2 stammt nunmehr aus China. Der Anteil wird weiter steigen, da China nach dem Pariser Abkommen für sich den Status eines Entwicklungslandes beansprucht und demzufolge bis 2030 die Emissionen an CO2 weiter ansteigen lassen darf. Allein der Anstieg in diesem Jahrzehnt bis 2030 entspricht der Gesamtemission von Europa.

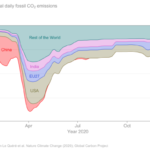

Die Verteilung des Rückgangs der CO2-Emissionen zeigt die Grafik des Global carbon projekts. Sie zeigt eindrucksvoll, dass es seit Mai keinen Rückgang der CO2-Emissionen in China mehr gegeben hat.

Und warum gehen die CO2 Konzentrationen nicht zurück ?

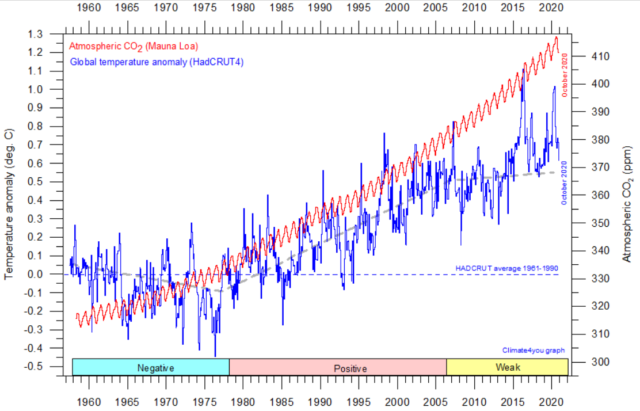

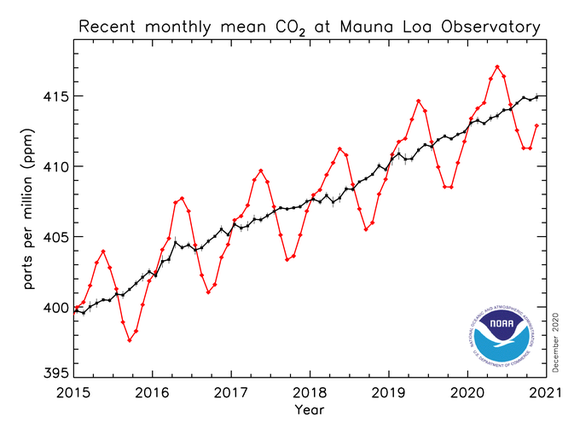

Trotz des Rückgangs der Emissionen gehen die Konzentrationen in der Luft nicht etwa zurück, sondern steigen weiter. Im Jahre 2019 hatten wir eine CO2– Konzentration von 409,5 ppm im Jahresmittel und 2020 von 412 ppm.

In 2020 wurden nur noch 34 Milliarden Tonnen CO2 emittiert. Zusammen mit den Landnutzungsänderungen ergeben sich rund 40 Milliarden Tonnen CO2. Mehr als die Hälfte wurden durch die Pflanzen und die Meere aufgenommen, so dass 19 Milliarden Tonnen in der Luft verblieben. Das entspricht einem Anstieg von 2,5 ppm in 2020 gegenüber 2019. In 2018 war der Anstieg 1,9 ppm, in 2019 betrug er 2,8 ppm. Die Messungen von Mauna Loa zeigen die Entwicklung sehr anschaulich. Die rote Kurve zeigt die jahreszeitlichen Schwankungen. Bei der schwarzen Linie sind die jahreszeitlichen Schwankungen herausgemittelt.

Die Schwankungen entstehen durch die Vegationsunterschiede von Sommer zu Winter in der Nordhemisphäre und der unterschiedlichen Aufnahme des CO2 von Sommer zu Winter durch die größeren Ozeanflächen der Südhemisphäre. Die CO2-Zunahme würde langfristig erst gestoppt, wenn die Emissionen um die obengenannten 19 Milliarden Tonnen vermindert würden. Eine Emissionsminderung um 40 Milliarden Tonnen auf Null ist nicht erforderlich,denn die Aufnahme von etwa 21 Milliarden Tonnen CO2 durch Pflanzen und Meere richtet sich allein nach der Gesamtkonzentration von 412 ppm und wird sich daher nach einer Emissionssenkung nicht wesentlich ändern.

Das deutsche „steuerbare-Verbrauchseinrichtungen-Gesetz“ oder Stromabschaltungsgesetz

Wenn man sich die oben beschriebenen globalen CO2-Emissionsentwicklungen vergegenwärtigt und betrachtet die völlig aus den Fugen geratenen europäischen und deutschen Massnahmen zur Energiewende, so wird man sprachlos.

Das neueste Produkt der Energiewende ist das Steuerbare-Verbrauchseinrichtungen Gesetz. Die Politik hat sich einreden lassen, dass der Umstieg auf die Elektromobilität aus Klimaschutzgründen dringend geboten sei (wer sich vom Gegenteil überzeugen will, sollte dies in unserem Buch „Unerwünschte Wahrheiten“ nachlesen). Das Niederspannungsnetz, das unsere Häuser und Wohnungen versorgt, kommt aber mit steigender Zahl an Ladestationen für E-Autos an seine Kapazitätsgrenze. Das gleiche Problem einer Überlastung der Netze ensteht auch beim Umstieg von Gas-und Ölheizungen auf elektrisch betriebene Wärmepumpen. Beides zusammen kann den Strombedarf und den Anschlusswert einer Wohnung oder eines Hauses schnell verdoppeln bis verdreifachen und die Niederspannungnetze zum Zusammenbruch führen, wenn die E-Auto -Besitzer nach Hause kommen und ihr E-Auto aufladen wollen oder wenn alle Wärmepumpenbesitzer gleichzeitig ihre Wohnung mit Strom heizen wollen.

Der Gesetzentwurf des Bundesministers für Wirtschaft schreibt nun vor, dass bei einem Anschluss einer Ladestation oder einer Wärmepumpe der Netzbetreiber das Recht hat, den Strom für zwei Stunden abzuschalten. Wir kennen das aus Entwicklungsländern, in denen reihum der Strom abgeschaltet wird. Dort nennt man es „load shedding“ ( Lastabwurf oder Stromabschaltung). Im deutschen Gesetzentwurf nennt man dies schönfärberisch Spitzenglättung:

Wir können uns schon vorstellen, wie das Gesetz als Vorkehrung bei tagelangen Dunkelflauten weiterentwickelt wird. Denn selbstverständlich wird der Stromkunde auch verpflichtet, über smart meter seine Stromverbrauchsdaten durch den Netzbetreiber rund um die Uhr per internet überwachen zu lassen. Eine beeindruckende Kritik dieses Gesetzentwurfes gibt es hier durch Dr. Humpich.

Nachdenklich stimmt, dass kaum eine deutsche Zeitung über diesen geplanten Eingriff in die autonomen Entscheidungen der Bürger über ihre Energieversorgung berichtet hat. Wird nicht berichtet, weil es vielleicht eher ein Zeichen für die bevorstehende Strom-Mangel-Wirtschaft ist ? Oder ist es gar eine zu abschreckende Nachricht für alle, die beabsichtigen, sich ein E-Auto anzuschaffen ?

Es ist ein Offenbarungseid der Energiewende und der Einstieg in die planwirtschaftliche Zuteilung von Strom und Energie. Und darüber berichtet man ungern, wenn man die bejubelte Energiewende für alternativlos hält.