Die westliche Welt begann im ausgehenden 19. Jahrhundert, fast nur in den entwickelten Ländern Klima- und Wetterdaten mittels Messstationen aufzuzeichnen, von denen wir heute noch glauben profitieren zu können. Doch auch um 1900 war die Nordhalbkugel der Erde immer noch sehr spärlich mit Messstationen ausgestattet, das änderte sich erst in der zweiten Hälfte des 20. Jh. Erst ab 1960 waren, auf Grund des kalten Krieges die USA, Europa und weite Teile der damaligen Sowjetunion vglw. dicht bestückt.

Video des Vortrages von Michael Limburg anlässlich der 12. IKEK am 23. und 25.11.18

Für die Südhalbkugel galt das jedoch nie, die war und blieb spärlich versorgt, was sowohl der Entwicklung der dort befindlichen Länder, als auch an der geringen Landbedeckung geschuldet ist.

Hinzu kam, dass über den Ozeanen eine genügende Abdeckung, die diesen Namen auch verdient, außerhalb der Hauptschifffahrtsrouten nicht vorhanden war.

Doch selbst wenn die besser wären, sind die verfügbaren historischen Klimadaten viel zu dünn, sowohl in der Flächenabdeckung, als auch in der kontinuierlichen Langzeit-Messdauer, um als Basis für die präzise Berechnung einer globalen Mitteltemperatur dienen zu können.

Und nicht nur das, denn sie sind auch viel zu ungenau, als dass Klimatologen mit ihrer Hilfe eine präzise Bestimmung der globalen Mitteltemperatur durchführen und somit als valide Quellenlage gelten könnten.

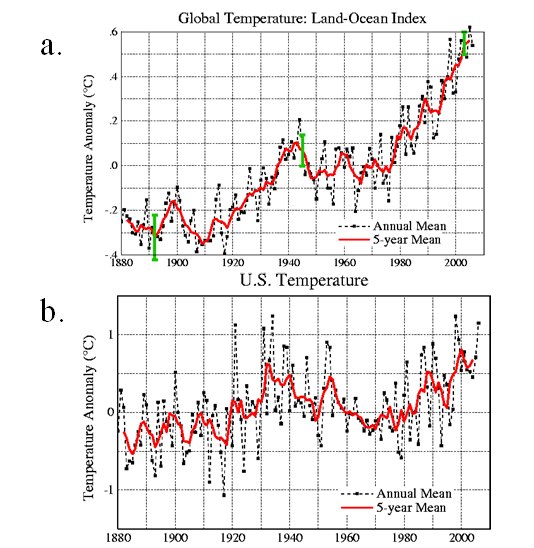

Die Klimatologen glauben aber, es sei so, obwohl jeder, der sich mit Messtechnik und Fehlerstatistik auskenne, feststellen muss, dass die Daten dafür nicht taugten. Schuld an diesem Irrglauben ist ein Artikel der Klimawissenschaftler Hansen & Lebedeff von 1988, in dem sie behaupteten, dass die Werte einer Messstation für eine Kreisfläche von 2.400 km Durchmesser als „Normal“ stehen könne.

Als „Beweis“ dafür führten sie lediglich an, dass die Trendverläufe der Teststationen innerhalb dieser Fläche immer noch eine Korrelation von ≥ 0,5 (als „gut“ bezeichnet) aufwiesen. Mittels einfachem direkten Vergleiches von realen Verläufen hätten sie jedoch erkennen müssen, dass auch bei Korrelation von ≥ 0,5 die Zeitreihen der Temperatur viel zu unterschiedlich seien, als dass eine Station im Zentrum als Maß für alle stehen könnte. Beispielsweise fänden sich im Umkreis des Nordpols zwei Messstationen mit je rund 1.000 km Abstand zum Pol, was viel zu weit weg sei, um das Wetter und seine Daten dort genau genug erfassen zu können.

Ein weiterer Fehler ist anzunehmen, das die statistische Regel, nach der zufällige Messfehler mit dem Quotienten aus 1/√n sich von selbst und nur von ihrer Zahl abhängig, in Richtung Null korrigieren, unbekümmert für sämtliche Messwerte angewendet werden darf.

Dem ist jedoch nicht so, weil die Messempfindlichkeit eine Untergrenze darstellt, bis zu der sich zufällige – also gleich verteilte – Messfehler ausgleichen könnten.

Die statistische Regel, nach der zufällige Messfehler mit dem Quotienten aus 1/√n – wobei n die Zahl der Messungen ist – gegen Null tendieren, findet da ihre Untergrenze.

Ein weiterer wichtiger Einflussfaktor auf die Messgenauigkeit ist bspw. das Material des Schutzbehälters, in denen sich der Messfühler befindet, das sogenannte Wetterhäuschen (z.B. Englische Hütte). Allein dadurch entsteht ein systematischer Messfehler von etwa 0,2°C (+/-). Bei einem Wechsel des Wetterhäuschens oder des Messgerätes erhalte man so „sprunghafte systematische Fehler“. Diese schlagen 1:1 auch bei Anomalienbildung mit dem „Stationsnormal“ durch, und gleichen sich nicht – wie weit und breit geglaubt- gegenseitig aus.

In Berlin beispielsweise würden seit 1990 elektronische Fühler eingesetzt, was die örtliche mittlere Temperatur scheinbar um 0,1°C erhöht habe. Korrigiert wurde das bis heute nicht.

Zusammenfassend kann festgestellt werden, dass die systematischen Fehler bei der Erhebung von Klimadaten sehr vielfältig und zum allergrößten Teil nicht mehr zu korrigierbar sind, da die Umstände unter denen sie entstanden, nicht mehr rekonstruierbar sind. Das hat zur Folge, dass jeder ehrliche Versuch, eine globale Mitteltemperatur aus den vorhandenen Daten zu berechnen, mit einen Unsicherheitsband von mindestens vier Grad umgeben sein muss.

Das wiederum ermögliche keinerlei Bestimmung von Änderungen im Bereich von einem Grad, und damit auch keinerlei Bestimmung einer evtl. Ursache. All das verschwinde im Rauschen der Messfehler.

Die einzig gute Nachricht ist, dass oszillierende Einflüsse (periodisches auf und ab) von diesem Problem nicht betroffen sind, und damit sehr wohl sichtbar seien. Ihre Präsenz erlaubt die Bestimmung ihrer Zykluszeiten, jedoch nur sehr unsicher, bezüglich ihrer Amplituden.

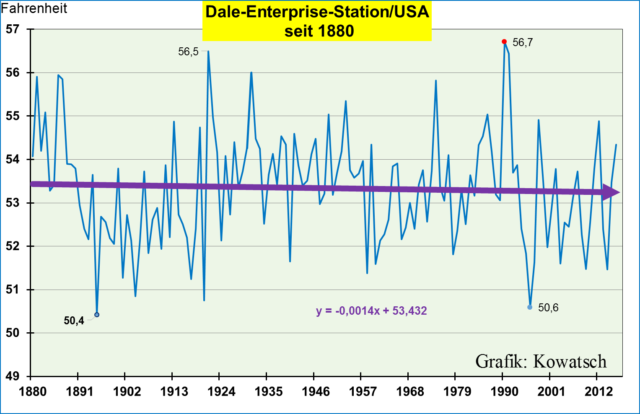

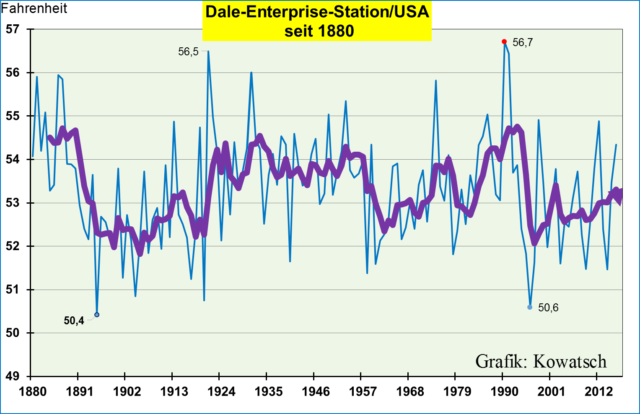

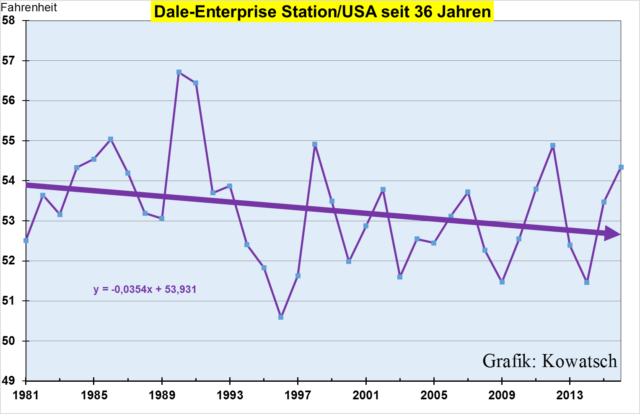

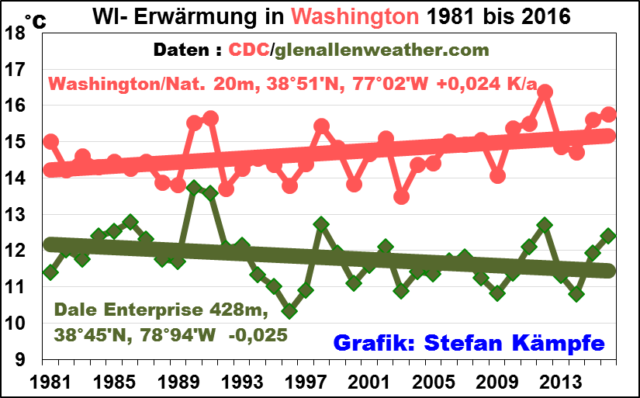

Hinzu kommt, dass Rohdaten der Vergangenheit auf breiter Front offensichtlich gefälscht wurden, mit dem Ziel, die Vergangenheit kühler erscheinen zu lassen, damit die Gegenwart wärmer erschiene. Das folgende Video zeigt einige verblüffende Zusammenhänge.

Video von Tony Heller zu der Manipulation historischer Temperaturdaten