Die Klimaschau von Sebastian Lüning: Wie ein Klimaforscher die Sonne klein redet, Hoffen auf die Kernfusion

Die global gemittelten Temperaturen sind seit 1850 bis 2020 um ca. 1,1 Grad C gestiegen. Vom IPCC, Intergovernmental Panel for Climate Change, wurde im letzten Zustandsbericht AR 5, 2014, dieser Anstieg mit mindestens 50% Wahrscheinlichkeit der menschlichen Emission von Kohlendioxid, CO2, durch Nutzung fossiler Brennstoffe zugeschrieben.

Bis Ende des Jahrhunderts 2100 sollte die globale Temperaturerhöhung unter 2 Grad C bleiben, besser unter 1,5 Grad C durch drastisches Reduzieren der CO2 Emissionen. Satelliten-Messungen seit 1979 bis 2020 zeigen einen Anstieg von 0,13 Grad C pro Jahrzehnt, also in den 80 Jahren bis 2100 noch ca. 1 Grad C. Diese Forderung beruht auf Grund der Berechnungen mit Modellen, die allerdings den Einfluss einer veränderlichen Sonnenaktivität, markiert durch die Sonnenflecken, nicht beinhalten. In diesem Artikel soll gezeigt werden, dass dies eine unzulässige Annahme ist.

In diesem Jahrhundert wird die Zahl der Sonnenflecken stark zurück gehen, mit ihnen einher ein Beitrag zur Verringerung der global gemittelten Temperatur um -0,5 bis – 0,7 Grad C. Das bedeutet aber, dass selbst bei gleichbleibender Emission von CO2 durch den Menschen, die globale Temperatur deutlich unter 2 Grad C bleiben wird!

„Am 6. Februar veränderte sich die grausame 15 Wochen anhaltende Kälte, sich zu jedermanns Vergnügen in ein löbliches Tauwetter zu verwandeln, welches aber ohne Schäden nicht abging. Zwischen Maastricht und Scheermase wurde ein Berg durch den Eisgang weggeströmt, wobei wohl 1500 Stück Vieh umkam…Das losbrechende Eis nahm zu Bremen zwei Pfeiler einer Brücke weg und richtete an Schiffen und Befestigungen große Schäden an.“

So ein Bericht zum 6. Februar 1684 (aus Rüdiger Glaser, Klimageschichte Mitteleuropas, 2001). 1684 befand man sich in der stärksten Abkühlungsphase des Maunder Minimums, eine 50 Jahre dauernde Zeit zwischen 1650 und 1700, in der die Aktivität der Sonne sehr schwach war. In dieser Zeit war die Zahl der Sonnenflecken sehr gering, nahezu Null. Die Temperaturen fielen vor allem im letzten Jahrzehnt des 17. Jahrhunderts extrem ab, wobei alle Jahreszeiten davon erfasst waren. Es waren die Zeiten der ruhigen Sonne, in denen die Sonne schwieg!

[Siehe auch, empfehlenswert: Die kalte Sonne, Warum die Klimakatastrophe nicht stattfindet, Fritz Vahrenholt, Sebastian Lüning, Hoffmann und Campe Verlag]

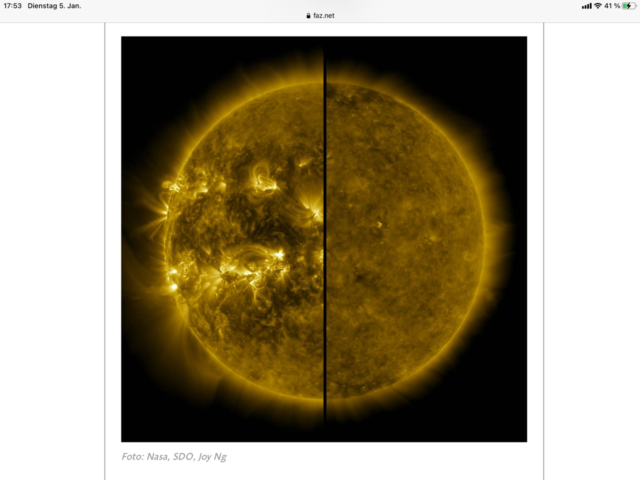

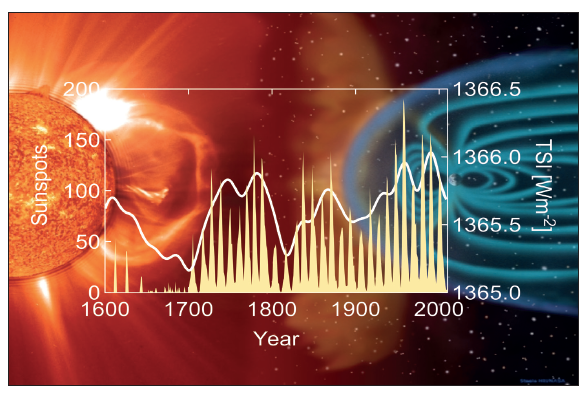

Die Sonne ist keine absolut konstante Strahlungsquelle, sondern ihre Abstrahlung zeigt auch in kurzfristigen Zeiten Veränderungen, die uns in Form der Sonnenflecken bekannt sind Abb.: 1.

Abb 1: Sonnenflecken, links aktive Sonne, rechts schweigende Sonne

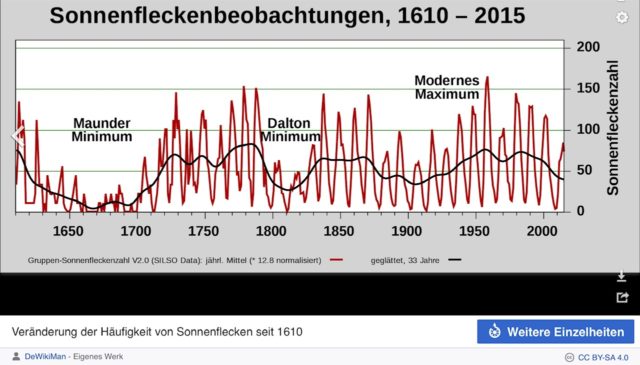

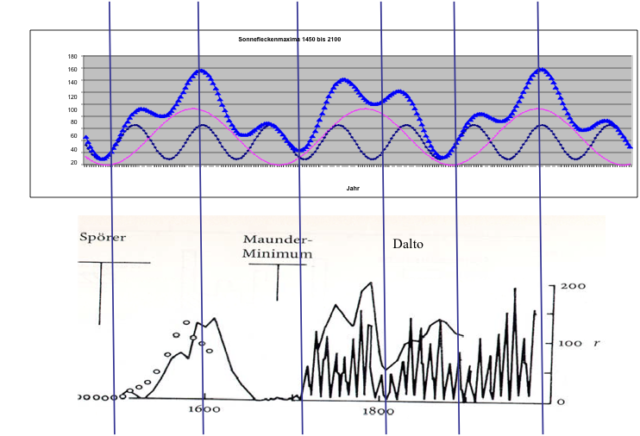

Die nächste Abbildung 2 zeigt die Variabilität der Sonnenflecken und damit der Sonnenaktivität in den vergangenen 500 Jahre. Man erkennt deutlich, wie stark sich die Zahl der Sonnenflecken verändert. Neben dem kurzfristigen 11 Jahres Rythmus gibt es längere Zeiträume, in denen es nur eine sehr geringe Zahl gegeben hat.

Abb 2: Veränderung der Zahl der Sonnenflecken ab 1600. Quelle: DeWikiMan, Sunspots-gn-yr-total-smoothed-de, CC BY-SA 4.0

Diese Minima umfassen das Maunder-Minimum und um 1800 (Französische Revolution) das Dalton-Minimum mit der anschließenden „Kleinen Eiszeit“ bis ca. 1899. Bemerkenswert ist, dass diese Zeiten mit erheblichen Abkühlungen und Klimaveränderungen zumindest in Europa einhergingen. Diese ergaben schlechte Ernteerträge mit all ihren sozialen Auswirkungen. Die erheblichen Klimaschwankungen in den letzten Jahrhunderten bis 1900 waren sicherlich ohne menschliche CO2 Emissionen entstanden und sind auf natürliche Variabilität des Klimas, hervorgerufen durch die Änderung der Sonnenaktivität, zurückzuführen.

Wie wird sich die Aktivität der Sonne in Zukunft entwickeln?

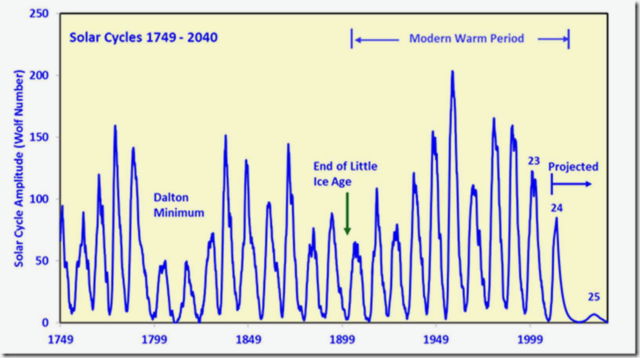

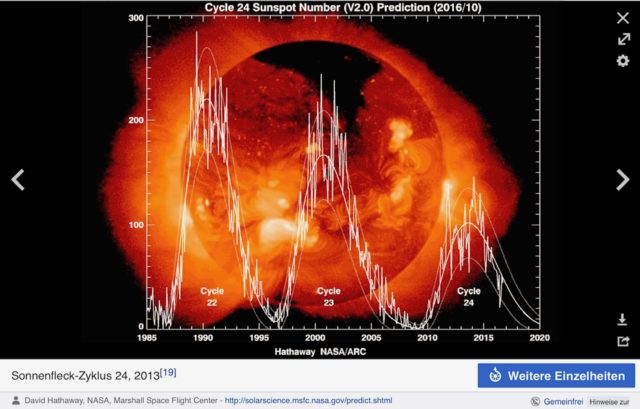

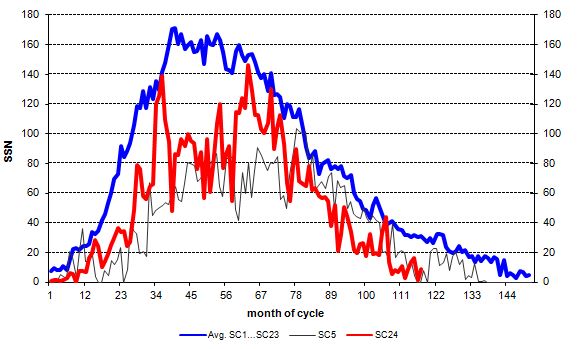

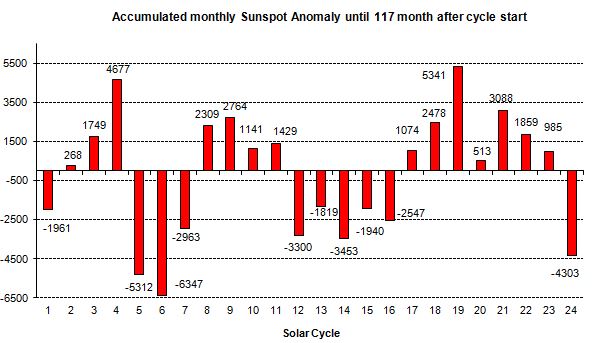

Spannend ist natürlich die Frage, ob man zukünftig von einer weiteren Abschwächung der Sonnenaktivität, die nach der Zeit hoher Sonnenaktivität ansteigend ab 1900 bis 2000 derzeit bereits sehr niedrig ist, ausgehen muss. W. Livingston und M. J. Penn (siehe auch IAU Symposium No. 273, Abb.2) sehen eine dramatische Abschwächung im Zyklus 25 voraus. Immerhin stimmte ihre Vorhersage für den Zyklus 24 recht gut mit dem aktuellen Verlauf überein (siehe folgende Abbildungen 3,4).

Abb 3: Sonnenflecken ab 1749 bis 1999 (Nr. 23) und Projektion für Nr 24, 25

Abb 4: Sonnenfleckenzyklus 22-24, The Solar Physics Group at NASA

Empirische Untersuchungen legen nahe, dass die Sonnenfleckenzahlen über den 11-jährigen Schwabe Zyklus hinaus weiteren periodischen Schwankungen unterliegen. Diese periodischen Schwankungen der Sonnenflecken-Intensität sind der Gleissberg-Zyklus von ca. 80- 88 Jahren und der De Vries- oder Seuss-Zyklus von 200-210 Jahren.

Der Autor hatte in der folgenden Graphik Abb. 5 (R. Link, 2009 [1]), die als sinusförmig angenommenen Sonnenfleckenzyklen Gleissberg und De Vries aufaddiert, nachdem die Zyklen in ihrer Phase zueinander und ihren Längen, sowie die Sonnenfleckenzahlen an die beobachteten Werte der Abb.: 2 angepasst wurden (blaue, fetter gedruckte Kurve). Die Zyklen Zeiten für die optimale Anpassung betragen 84 Jahre Gleissberg/Seuss (dunkelblau), 208 Jahre De Vries (rot).

[1] https://rlrational.wordpress.com/2010/03/22/wenn-die-sonne-schweigt/

Klimawandel – Eine rationale Diskussion

Abb.: 5 Überlagerung von Gleisberg- und Suess-Zyklus

Es ergibt sich eine gute Übereinstimmung mit der Variabilität der Sonnenfleckenzyklen der vergangenen 500 Jahre. Der Abbildung kann man entnehmen, dass wir in den kommenden Jahren wieder auf eine ruhige, schweigende Sonne zulaufen, sofern die bisherigen periodischen Variationen in die Zukunft extrapoliert werden können. Bis 2050 werden wir mit einer Aktivität ähnlich dem Dalton Minimum und bis 2100 wie im Maunder Minimum mit den entsprechenden niedrigen Temperaturen zu rechnen haben. G. Feulner und S. Rahmstorf, Potsdamer Institut für Klimafolgenforschung PIK [2], haben in einer Arbeit mittels eines Klimamodells berechnet, dass die Erwärmung vom Maunder Minimum bis 1950 zwischen 0,5 bis 0,7 °C beträgt.

[2] On the effect of a new grand minimum of solar activity on the future climate on Earth, Georg Feulner and Stefan Rahmstorf, GEOPHYSICAL RESEARCH LETTERS, VOL. 37, 2010

Die Veränderung der Sonnenaktivität durch die Sonnenflecken und deren Einfluss auf unser Klima ist in den Klimamodellen nicht berücksichtigt. Insgesamt kann man davon ausgehen, dass die Sonne in diesem Jahrhundert abkühlend auf die globale Temperatur wirken wird. Die Stärke dieser Abkühlung kann man nicht mit Sicherheit voraussagen, bis zu -0,5 °C können es aber durchaus werden. Somit ergibt sich bis 2100 bei gleichbleibender CO2 Emission, keine erforderliche Reduktion, eine globale mittlere Temperatur von nur noch ca. 1,5 Grad C.

EIKE-Redaktion:

Der Beitrag erschien zuerst am 12.01.2021 in der“kalten Sonne“, wir danken der KA und Dr. Link für die Genehmigung der Übernahme.

Der einzige und vermeintliche Vorteil einer solchen Technik ist, dass kein CO2beim Einsatz entsteht, was den geltenden Klimadogmen sehr entgegen kommt. CO2ist bekanntlich ein Molekül von ca. 0,1 mm Größe (Greta Thunberg kann, qualitätsjournalistisch bestätigt, CO2-Moleküle mit bloßem Auge sehen, was nach ophthalmologischen Erkenntnissen auf diese Größe schließen lässt), das bei zunehmender Konzentration in der Luft aufgrund der Zusammenstöße mit dem Kopf schwere Schädel-Hirn-Traumata auslösen kann, die sich in manischer Klimahysterie äußern.

Elementarer Wasserstoff hat allerdings den Nachteil, dass das nächste natürliche Vorkommen ca. 150 Millionen Kilometer oder 8,3 Lichtminuten entfernt ist und eine Temperatur von 5.500°C aufweist, was Gewinnung und Transport etwas problematisch machen. Wasserstoff muss folglich auf der Erde aus anderen Stoffen produziert werden.

Das und der technisch nicht gerade unheikle Umgang mit elementarem Wasserstoff haben seinen Einsatz bislang auf wenige industrielle Bereiche beschränkt, aber das soll ja anders werden. Man produziert ihn derzeit hauptsächlich durch thermische Formierung von Erdgas (Methan) mit Wasser oder partielle Oxidation von Erdgas, wobei Wasserstoff und CO2entstehen, alternativ auch durch Zersetzung von Methan im elektrischen Lichtbogen, wobei neben Wasserstoff elementarer Kohlenstoff anfällt. Da Erdgas bei unter 4 ct/kWh liegt, die Verluste erträglich sind und man bei den Produktionsprozessen bislang auf nichts Rücksicht nimmt, ist das ökonomisch in Ordnung. Aus klimadogmatischer Sicht müsste das CO2der ersten Verfahren abgeschieden und gelagert werden, was den Wirkungsgrad unter 50% treiben würde, und da der Kohlenstoff des letzten Verfahrens, in dem fast die Hälfte der Energie steckt, ebenfalls unbrauchbar wäre, landet man auch da bei der gleichen Wirkungsgradhausnummer. Zudem widerspricht der Einsatz von Erdgas Ressourcendogmen.

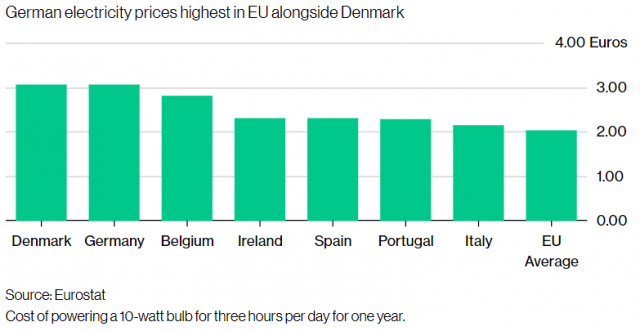

Dogmatisch korrekt und obendrein effizienter wäre eine komplett CO2-freie Produktion durch die Elektrolyse von Wasser, bei der immerhin ca. 85% der eingesetzten Energie im Wasserstoff landen würde. Dazu braucht man Strom. Den könnte man aus AKWs beziehen, Kosten z.Z. ca. 4 ct/kWh, langfristige Tendenz: abnehmend. Würde man das machen, wären bei einem Grundpreis von knapp 5 ct/kWh nachfolgende Verluste je nach Anwendung vermutlich kein großes Problem.

Will man aber nicht (Kein-AKW-Dogma). Es muss alles mit Windkraft oder Fotovoltaik gemacht werden, Kosten ca. 12 ct/kWh, Tendenz langfristig eher zunehmend. Da in Summe ohnehin nicht genügend Wind und Sonne zur Verfügung steht, zeitweise aber manchmal zu viel, will man diesen zeitweisen Überschuss für die Wasserstoffproduktion nutzen. So weit die offizielle Version, die bereits daran hapert, dass es nicht genügend Wind- und Sonnenstrom für alle Anwendungsgebiete gibt und geben wird. Aber das verschweigt man besser.

Die Niederländer wollen nun im Groninger Land einen neuen riesigen Windpark bauen. Der sollte zunächst soundsoviel Wohnungen versorgen können, falls der Wind weht, und ansonsten Wasserstoff produzieren. Inzwischen haben die Niederländer nachgerechnet: das mit den Wohnungen lohnt irgendwie nicht, also planen sie jetzt, nur Wasserstoff aus dem Windstrom zu produzieren. So um die 800.000 to/a sind geplant und irgendwie soll der Wasserstoff dann auch zu den Industrien an Rhein und Ruhr und zu Verbrauchern anderswo kommen. Die Niederländer meinen, das lohnt sich (für sie). Schauen wir uns das mal genauer an.

Im weiteren schauen wir auf ein paar Zahlen. Manche sind problemlos in Tabellenwerken zu finden, bei anderen ist das weniger einfach. Doch zunächst einmal zu den einfachen Sachen: Wasserstoff ist ja fürchterlich energiereich. Pro Kilogramm liegt er im Vergleich mit anderen Energieträgern deutlich an der Spitze, wobei wir hier die Verbrennungsenthalpie bei vollständiger Verbrennung betrachten.

| Energieinhalt | Wasserstoff | Methan | Butan | Kohle |

| kJ/kg | 286.000 | 50.125 | 49.620 | 32.750 |

Diese Werte werden gerne verkauft, um dem Betrachter den Wasserstoff schmackhaft zu machen. Für den Transport ist aber das Volumen interessanter als das Gewicht, und da sieht die Bilanz für den Wasserstoff weniger brillant aus:

| Energieinhalt | Wasserstoff | Methan | Butan | Kohle |

| kJ/m³ (Gas) | 25.535 | 35.803 | 128.500 | (~82*10⁶) |

| kJ/m³ (F) | 20,2*10⁶ | 21*10⁶ | 28*10⁶ | ~82*10⁶ |

Egal wie man es betrachtet, Steinkohle liegt volumenmäßig an der Spitze. Aufgelistet ist der Energieinhalt bei Normaldruck/Temperatur als Gas und sowie als Flüssiggas. Wenn man Gas komprimiert, liegt man irgendwo dazwischen. NPT-Wert * Druck in bar = Energieinhalt. Auch als Flüssiggas bringt Wasserstoff gerade einmal 70 kg/m³ auf die Waage und hat dann eine Temperatur von -252°C, die Alkane wiegen immerhin schon um die 500 kg/m³ (bei -160°C und 0°C), Kohle bei ca. 2,5 to. Solche Daten, die für den Transporteur interessanter sind, muss man allerdings selbst ausrechnen.

Die Frage wäre dann: Gas oder Flüssiggas? Die Russen liefern ihr Erdgas durch Röhren zu uns, die US-Amerikaner verflüssigen es und liefern es per Tanker. Ziemlich leicht lässt sich ermitteln, womit man bei Flüssiggas zu rechnen hat:

| Verluste | Wasserstoff | Erdgas |

| Verflüssigung | ≥35% | ~12% |

| Lagerung pro Tag | ~3% | ~0,1% |

Verflüssigung kostet recht viel Energie, was einer der Gründe ist, weshalb das US-Gas auch teurer ist als das russische, aber das nur nebenbei. Bei Erdgas (Siedepunkt -161°C) hält sich das trotzdem noch in Grenzen, Wasserstoff mit einem um fast 100°C niedrigeren Siedepunkt ist aber ein echtes Problem: In Houston eingeschifft wäre in Rotterdam weniger als die Hälfte übrig. Was für die Niederländer auch gelten würde, wie wir gleich sehen werden.

Für die niederländische Wasserstoffproduktion kommt ein anderes Problem hinzu, das sie praktisch auf einen Stand mit Wasserstoff aus Houston setzen würde, würden sie auf Flüssigwasserstoff setzen: mit einem Atomkraftwerk könnte man den Wasserstoff „just-in-time“ in der Menge produzieren, in der er benötigt wird, die Niederländer müssen aber so produzieren, wie der Wind weht. Nimmt man Stromleistungen aus Wind und Leistungsbedarf der Kunden als Vorbild für eine Wasserstoffwirtschaft, bedeutet das über den Daumen gepeilt, dass von den 800.000 to/Jahr über den Daumen gepeilt ein Drittel bis zur Hälfte längere Zeit gelagert werden müsste. Nach Elektrolyse, Verflüssigung, Transport und Lagerung kämen noch bestenfalls 35% der Energie an, was mit allem Drumherum bereits zu einem Preis von knapp 50 ct/kWh ab Tank führen würde.

Das Mittel der Wahl ist somit der Transport von Wasserstoff als Gas durch Pipelines, weil die üblichen Druckgasflaschen mit 50 l Inhalt, 300 bar Fülldruck und 50 kg Gewicht wohl kaum lukrativ sind. Auch in Pipelines muss das Gas allerdings komprimiert werden. Bei AKW-Wasserstoff käme man vermutlich mit den üblichen 16 bar aus. Bei den großen Mengen, die bei Windkraftproduktion zwischengespeichert werden müssten, müsste man aber auch Gaskavernen, in denen das Erdgas zwischengespeichert wird, einsetzen und bei höheren Drücken arbeiten. Wenn man Gas komprimiert, muss Volumenarbeit geleistet werden, außerdem erhitzt sich Gas bei Kompression. Da weder die Temperatur in den Leitungen/Speichern gehalten werden kann noch an der Verbraucherseite die mechanische Energie bei der Entspannung genutzt wird, handelt es sich um reine, bei größer werdendem Druck steigende Verluste. Die sind zwar nicht so spannend wie bei der Verflüssigung, aber bei ca. 80 bar bleiben ohne Berücksichtigung anderer Verluste wie beispielsweise Erzeugen und Halten des Kissendrucks in den Kavernen oder Druckerhöhungen in längeren Leitungen vom Windstrom noch ca. 60% übrig. Beim Verbraucher dürften also auch hier nur knapp über 50% ankommen.

Solche Zahlen sind übrigens schon nicht mehr ganz einfach zu ermitteln. Zum einen redet man ungern über Verluste, zum anderen werden alle möglichen Schönrechnungsfaktoren eingerechnet. Wir kommen später noch darauf zurück. Solche Transportverluste entstehen zwar auch beim Erdgas, aber beim Wind-Wasserstoff müssen wir mindestens vom 5-fachen des Grundpreises von Erdgas ausgehen und dieser Faktor findet sich in allen Zahlen wieder. Zudem spielen auch noch weitere individuelle Randbedingungen mit. Als Kunde ahnt man vermutlich so ganz langsam, wohin sich die Abrechnung für die Heizung bewegt, wenn statt Erdgas niederländischer Wasserstoff eingesetzt wird.

Die Pipeline-Version hat allerdings die Nebenbedingung, dass man auch Pipelines zur Verfügung hat. Wenn genügend vorhanden sind, kann man Erdgaspipelines außer Betrieb nehmen und umwidmen, ansonsten müsste man neue bauen. Das Gleiche gilt für Speicherkavernen. Als Alternative zum Wasserstofftransport bietet sich Power-2-Gas an, wobei man den Wasserstoff gar nicht erst transportiert, sondern mit CO2zu Methan umwandelt. Da die Reaktion zwischen Wasserstoff und CO2in der Gesamtbilanz exotherm ist, sieht das gar nicht so schlecht aus, wenn man die Abwärme nutzen kann.

Hier dreht allerdings die Schönfärberei voll auf. Realistisch betrachtet kommen von der Windkraft vermutlich ca. 60% im Methan an, das dann dem normalen Erdgas untergemischt werden kann. Spezialisten rechnen das unter Hinzuziehen aller möglichen Nebenbedingungen und theoretischer Optionen auf Werte nahe 100% hoch, also Wind=Gas. Eine der Mogelpackungen, die drinstecken: Wo bekommt man das CO2her? Richtig, aus CO2-Abscheidung aus anderen Prozessen. Das kostet ebenfalls wieder Energie, die bezahlt werden muss, was letztlich auch den Preis für das künstliche Erdgas weiter aufbläht. Die Kreuz- und Querrechnung ist ohne viel Aufwand kaum zu durchschauen und ob wirklich alle theoretischen Effekte auch in der Praxis genutzt werden können, ist fraglich. Man liegt sicher nicht weit daneben, wenn man unterstellt, dass bei P2G in der Gesamtbilanz ungefähr 40% des primären Windstroms ankommen. Mit entsprechenden Auswirkungen auf die Preise.

Besonders im Zusammenhang mit dem immer mehr platzenden E-Mobilitätstraum werden dem Publikum gerne flüssige organische Wasserstoffträger verkauft (dass Wasserstoffgas an Tankstellen eine dumme Idee sein könnte, scheint selbst Grünen ohne Knallgasreaktion einzuleuchten). Der Wasserstoff wird hierbei bei erhöhten Temperaturen chemisch in ein Molekül eingebaut und aus diesem bei noch höheren Temperaturen wieder freigesetzt. Handelsüblich sind etwa 150°C und höherer für Schritt 1 sowie 300°C für Schritt 2, jeweils in Gegenwart bestimmter Katalysatoren. Schritt 1 ist exotherm, wobei man versuchen kann, die Verluste durch Nutzen der Abwärme zu minimieren, Schritt 2 endotherm, d.h. es muss auf jeden Fall Energie zugeführt werden. Es ist etwas schwierig, an Daten zu gelangen, aber Wirkungsgrade bis zu 70% scheinen halbwegs realistisch zu sein. Die Datenlage ist deshalb schwierig, weil die den Wasserstoff nutzenden Brennstoffzellen einen höheren Wirkungsgrad als Benzinmotoren aufweisen, was sich propagandistisch besser macht als die Einzelwerte. Vermutlich sieht die Gesamtbilanz ohne alles Schönen kaum anders aus als bei Benzin.

Wieviel Wasserstoff kommt dabei zusammen? Nehmen wir als Rechenbeispiel einmal Toluol (verwendet werden andere verwandte Verbindungen, aber Toluol, ein Benzolabkömmling, war mal ein Kandidat), das bei einer Molmasse von 92 g/mol insgesamt 3 mol = 6 g Wasserstoff reversibel binden kann. Pro Kubikmeter kann Toluol bei einer Dichte von 0,87 g/cm³ umgerechnet ca. 14 kg Wasserstoff speichern, was einem Energieinhalt von 4*10⁶ kJ entspricht. Das ist gerade einmal 1/5 dessen, was ein LNG-Erdgasfahrzeug im gleichen Volumen mit sich führt. Nicht gerade der Renner. Bei der Untersuchung anderer Möglichkeiten, Wasserstoff an irgendetwas zu binden, findet man kein wirklichen Unterschiede zu diesen Werten.

Zum Transport von Wasserstoff eignen sich organische Wasserstoffträger somit eher nicht, und auch für die Mobilität kommen neben dem relativ geringen Energieinhalt und der damit notwendigen Tankstellendichte andere Probleme hinzu. An der Tankstelle muss man erst die alte Flüssigkeit ablaufen lassen, bevor man den Tank neu füllen kann, und auch der Tankwagen fährt voll wieder zurück und nicht leer. Auch mit AKW-Wasserstoff stellt sich die Frage, ob das wirklich die Technik der Zukunft ist, mit dem Preisgefüge, das sich aus Windkraft-Wasserstoff ergibt, braucht man diese Frage allerdings gar nicht erst zu stellen.

Die Gastechniken werden auch als Energiepuffer für windschwache Zeiten gehandelt, d.h. man macht aus dem Gas in einem Kraftwerk wieder Strom, wenn kein Wind weht. Wäre genügend Strom vorhanden, wären Gasspeicher als solche vermutlich im Gegensatz zu allen anderen Ideen tatsächlich skalierbar, d.h. man könnte möglicherweise genügend Kavernen als Puffer bauen. Dummerweise landen wir bei P-2-G-2-P bei Wirkungsgraden um die 30%, d.h. in Überschusszeiten muss der Wind 3 kWh Überschussstrom produzieren, um in Mangelzeiten 1 kWh wieder zurück gewinnen zu können. Wir können uns die weiter Diskussion vermutlich sparen.

Wie schon erwähnt, war es teilweise nicht ganz einfach, realistische Zahlen aus dem üblichen Mogelwerk heraus zuziehen und ich erhebe keinen Anspruch, wirklich die letzten technischen Details berücksichtigt zu haben. Wer in den Zahlen einen Rechenfehler findet, darf ihn auch gerne behalten. Aber auch Korrekturen dürften die Bilanzen nur unwesentlich ändern. Technisch ist alles machbar, großenteils auch vom Standpunkt eines Ingenieurs hochinteressant, aber bezüglich der Dogmenbefriedigung, unter der alles firmiert, skaliert mal wieder nichts. Da die große Stromwende einschließlich der Elektromobilität aus einer ganzen Reihe von Gründen nicht funktioniert und das selbst dem grünen Ideologieapparat auffällt, verkauft man dem Volk nun die nächste Technik ausgerechnet auf Basis des Nichtfunktionierenden nach dem Motto „wenn etwas nicht funktioniert und obendrein zu teuer ist, propagiere ich eben etwas, was überhaupt nicht funktioniert und noch teurer ist“. Und keiner lacht.

Über den Autor

Prof. Dr. Gilbert Brands hatte eine Professur an der FH Emden im FB Elektrotechnik + Informatik, Lehr- und Arbeitsgebiete Kryptologie, IT-Sicherheit, Programmierung, Mathematik, Quanteninformatik und anderes Hardcorezeug aus der Informatik. Davor selbständig, angefangen 1982 mit der Entwicklung eines Systems zur zeitgleichen Leistungserfassung für die RAG. Vom Studium her ist er Physikochemiker.

Es war das Jahr 1958, um genau zu sein, als die NASA zum ersten Mal beobachtete, dass Änderungen der Sonnenbahn der Erde und Änderungen der Erdneigung für das verantwortlich sind, was die Klimawissenschaftler heute als „Erwärmung“ (oder „Abkühlung“, je nach ihrer Agenda) bezeichnen. In keiner Weise erwärmt oder kühlt der Mensch den Planeten durch das Fahren von Geländewagen oder das Essen von Rindfleisch, mit anderen Worten.

Im Jahr 2.000 veröffentlichte die NASA auf ihrer Website des Earth Observatory Informationen über die Milankowitsch-Klimatheorie, die zeigen, dass sich der Planet tatsächlich durch äußere Faktoren verändert, die absolut nichts mit menschlichen Aktivitäten zu tun haben. Aber auch diese Informationen sind nach 19 Jahren noch nicht in den Mainstream eingeflossen, weshalb „Klimaschützer“ jetzt behaupten, dass wir wirklich nur noch 18 Monate, oder zwölf Jahre, oder auch 13 Jahre hätten, bevor der Planet an einem Überschuss an Kohlendioxid (CO2) stirbt.

Die Wahrheit entspricht jedoch viel mehr dem, was der serbische Astrophysiker Milutin Milankowitsch, nach dem die Milankowitsch-Klimatheorie benannt ist, darüber vorgeschlagen hat, wie die jahreszeitlichen und breitenmäßigen Schwankungen der Sonnenstrahlung, die die Erde auf unterschiedliche Weise und zu unterschiedlichen Zeiten trifft, den größten Einfluss auf die sich ändernden Klimamuster der Erde haben.

Die folgenden zwei Bilder (von Robert Simmon, NASA GSFC) helfen, dies zu veranschaulichen, wobei das erste Bild die Erde auf einer Umlaufbahn von fast 0 (Exzentrizität*) und das zweite Bild die Erde auf einer Umlaufbahn von 0,07 zeigt. Diese Bahnveränderung wird durch die exzentrische, ovale Form im zweiten Bild dargestellt, die absichtlich übertrieben wurde, um die massive Veränderung des Abstands zwischen Erde und Sonne zu zeigen, je nachdem, ob sie sich im Perihel* oder im Aphel* befindet.

„Selbst die maximale Exzentrizität der Erdumlaufbahn – 0,07 – wäre bei der Auflösung einer Webseite nicht darstellbar“,

bemerkt die Hal Turner Radio Show.

„Trotzdem ist die Erde bei der aktuellen Exzentrizität von 0,017 im Perihel fünf Millionen Kilometer näher an der Sonne als im Aphel.“

Für weitere verwandte Nachrichten über den Klimawandel und die globale Erwärmung aus einer unabhängigen, nicht etablierten Perspektive, sollten Sie sich unbedingt ClimateScienceNews.com ansehen.

Was die Schräglage der Erde bzw. die Änderung ihrer axialen Neigung betrifft, so zeigen die beiden folgenden Bilder (Robert Simmon, NASA GSFC), wie stark sich die Erde sowohl um ihre Achse als auch um ihre Rotationsorientierung verschieben kann. Bei den höheren Neigungen werden die Jahreszeiten der Erde viel extremer, während sie bei niedrigeren Neigungen viel milder werden. Ähnlich verhält es sich mit der Erddrehachse, die je nachdem, welche Halbkugel im Perihel auf die Sonne ausgerichtet ist, die jahreszeitlichen Extreme zwischen den beiden Hemisphären stark beeinflussen kann.

Dazu sei erwähnt, daß „Klima“ auf deutsch „Neigung“ bedeutet. Das Wort wurde gewählt, weil die gesamte Tagseite der Erde gleichermaßen von der Sonne bestrahlt wird, die Erwärmung aber ausschließlich vom Eintreff-Winkel, der Neigung der Strahlen in bezug auf die Erdoberfläche, abhängt. Am heißen Äquator ist der Winkel etwa 90%; an den kalten Polen ist er deutlich flacher.

Aus diesen verschiedenen Variablen konnte Milankowitsch ein umfassendes mathematisches Modell entwickeln, das die Oberflächentemperaturen auf der Erde weit in der Zeit zurückrechnen kann, und die Schlussfolgerung ist einfach: Das Klima der Erde hat sich schon immer verändert und befindet sich ohne unser Zutun als Mensch in einem ständigen Wandel.

Als Milankowitsch sein Modell erstmals vorstellte, wurde es fast ein halbes Jahrhundert lang ignoriert. Dann, 1976, bestätigte eine in der Zeitschrift Science veröffentlichte Studie, dass Milankowitschs Theorie in der Tat richtig ist und dass sie verschiedenen Perioden des Klimawandels entspricht, die im Laufe der Geschichte stattgefunden haben.

1982, sechs Jahre nach der Veröffentlichung dieser Studie, nahm der National Research Council der U.S. National Academy of Sciences die Theorie von Milankowitsch als real an und erklärte sie für wahr:

„… orbitale Variationen bleiben der am gründlichsten untersuchte Mechanismus der Klimaveränderung auf Zeitskalen von Zehntausenden von Jahren und sind bei weitem der klarste Fall eines direkten Effekts der wechselnden Sonneneinstrahlung auf die untere Erdatmosphäre.“

Wenn wir das Ganze in einem einfachen Satz zusammenfassen müssten, wäre es so: Der größte Faktor, der das Wetter und die Klimamuster auf der Erde, beeinflusst ist die Sonne, beziehungsweise die Periode der Sonne. Abhängig von der Position der Erde zum Zentralgestirn zu einem bestimmten Zeitpunkt werden die Klimabedingungen dramatisch variieren und sogar drastische Anomalien hervorrufen, die alles, was die Menschen über die Funktionsweise der Erde zu wissen glaubten, herausfordern.

Aber anstatt diese Tatsache zu akzeptieren, bestehen die heutigen Klima-„Wissenschaftler“, zusammen mit linken, und zunehmend auch rechten Politikern, und natürlich den Massenmedien darauf, dass nicht wiederverwendbare Einkaufstüten im Supermarkt und kein Elektrofahrzeug den Planeten so schnell zerstören, dass wir unbedingt globale Klimasteuern als Lösung einführen müssen.

„Die Klimadebatte ist nicht über die Wissenschaft. Es ist ein Versuch, der Bevölkerung politische und wirtschaftliche Kontrollen durch die Elite aufzuzwingen“,

schrieb ein Kommentator bei der Hal Turner Radio Show.

„Und es ist ein anderer Weg, die Bevölkerung gegen sich selbst zu spalten, mit einigen, die an die menschengemachte globale Erwärmung glauben und anderen, die nicht daran glauben, d.h. teilen und erobern.“

Sie können den vollständigen Bericht der Hal Turner Radio Show unter diesem Link lesen.

Der Vollständigkeit halber: Die Gegendarstellung von Correctiv.

*Exzentrizität: von ex-zentern, vom Mittelpunkt abweichend

*Perihel, Aphel: Perihel bezeichnet den sonnennächsten und Aphel (gesprochen Ap’hel) den sonnenfernsten Bahnpunkt.

Prof. Shaviv erklärt mit einem Schaubild die Einflußfaktoren in der Atmosphäre und zweifelt dabei die Sicht des Weltklimarates an, daß die Klimasensitivität (viel CO2, starke Erhitzung) hoch sei. Er betont, daß das Argument, die Erwärmung im 20. Jahrhundert sei einzigartig gewesen, falsch sei. Er weist auf die beiden „Klimagates“ und die dabei aufgedeckten Manipulationen hin. Die oft kolportierte Information, „97% aller Wissenschaftler“ seien für die Treibhaus-Klimatheorie, sei irrelevant, weil Wissenschaft keine demokratische Abstimmung sei.

Prof. Svensmark zeigt, wie die kosmische Hintergrundstrahlung, sehr schnelle Teilchen aus dem Weltall, das Klima beeinflussen. Treffen solche Partikel auf die Atmosphärenluft, werden verschiedene teils radioaktive Produkte erzeugt, wie C14, Al26, Be10. Die Teilchen aggregieren nach und nach zu rund 50 Nanometer großen Aerosolen und dienen dann als Kondensationskeime für Luftfeuchtigkeit und erzeugen so Wolken in den oberen Schichten der Atmosphäre, welche das Sonnenlicht reflektieren und somit die Erde kühlen.

In Zeiten, in denen die Sonne zyklusgemäß gering aktiv ist (wie aktuell), wird die Hintergrundstrahlung kaum solar beeinflußt und kann so viele Wolken hervorbringen.

Das solare Minimum wird tatsächlich immer tiefer. Am vergangenen Wochenende wurde der bisherige Rekord sonnenfleckenfreier Tage im Weltraum-Zeitalter gebrochen. Bisher zeigte sich die Sonne im Jahre 2019 an über 270 Tagen fleckenfrei, darunter die letzten 33 Tage hintereinander [Stand: 16.12.2019]. Seit Beginn des Weltraum-Zeitalters gab es in keinem einzigen anderen Jahr so viele derartige Tage.

Der bisherige Rekordhalter war das Jahr 2008, als die Sonne 268 Tage lang fleckenfrei war. Dazu war es im epochalen Solaren Minimum 2008-2009 gekommen, dem bisherigen tiefsten solaren Minimum des Weltraum-Zeitalters. Inzwischen hat dieses Jahr 2019 diesen Spitzenplatz eingenommen.

Ein solares Minimum ist ein normaler Bestandteil des 11-jährigen Sonnenfleckenzyklus‘. Die letzten beiden Minima (2008-2009 und 2018-2019) waren lang und tief, was sie zu Minima einer „Jahrhundert-Klasse“ machte. Will man ein Jahr mit noch mehr sonnenfleckenfreien Tagen finden, muss man bis 1913 zurückgehen, als 311 derartige Tage registriert worden waren.

Vorige Woche hat das Sonnenzyklus-Prognose-Gremium von NOAA/NASA eine neue Vorhersage ausgegeben. Auf der Grundlage mehrerer Prognoseverfahren kamen sie zu dem Ergebnis, dass das gegenwärtige solare Minimum erst im April 2020 seinen tiefsten Punkt erreichen wird (±6 Monate), gefolgt von einem neuen solaren Maximum im Juli 2025. Dies bedeutet, dass wenige oder gar keine Sonnenflecken sowie geringe Sonnenaktivität noch eine ganze Weile andauern werden.

Solare Minima verändern definitiv den Charakter von Weltraumwetter. Solare Flares und geomagnetische Stürme nehmen ab, was das Auftreten von Polarlichtern in höheren Breiten abnehmen lässt. Das Weltraumwetter „beruhigt“ sich. Andererseits intensiviert sich die kosmische Strahlung. Das sich abschwächende solare Magnetfeld gestattet mehr Partikeln aus den Tiefen des Weltalls den Eintritt in das Sonnensystem, was das Strahlungsniveau in der Erdatmosphäre enorm verstärkt. Tatsächlich wird genau das bereits beobachtet, erreichte doch die kosmische Strahlung in der Atmosphäre jüngst ein 5-Jahre-Maximum, was schon bald einen anderen entsprechenden Rekord des Weltraumzeitalters brechen dürfte. Man sollte darüber nachdenken, wenn man demnächst ein Flugzeug besteigt.

Quelle: Dr. Tony Phillips, Spaceweather.com

Link: https://wattsupwiththat.com/2019/12/16/its-official-we-are-in-a-deep-solar-minimum/

Übersetzt von Chris Frey EIKE

Einführung

Allerdings kann die Sonne auch viel weniger Energie pro Zeiteinheit emittieren, dies wird aber verschwiegen. Dadurch werden die Bürger irregeführt und ihre Schuldgefühle angeheizt.

Es gibt etwa 30 Astrophysiker, die behaupten, dass das Klima durch die Sonne bestimmt wird. Das stimmt mit der Aussage des NIPCC (Nongovernmental International Panel on Climate Change) überein, wonach die Natur und nicht menschliche Aktivität, das Klima bestimmt. Das Dogma der „menschgemachten Klimaerwärmung“ hat sich mittlerweile aber derart verhärtet, dass viele Astrophysiker um ihre Karriere fürchten müssen, wenn sie andere Überzeugungen vertreten.

Im Folgenden werden wir nicht auf die Aussagen der rund 30 Astrophysiker eingehen, sondern uns auf die Veröffentlichungen von Prof. Dr. N. Scafetta, Prof. Dr. Valentina Zharkova und Dr. H. Abdussamatov konzentrieren. Diese weisen nach, dass menschliche Aktivität keinen oder nur einen minimalen Einfluss auf den Klimawandel hat. Zudem fügen wir die Studien von Irina Kitiashvili (NASA) über die Entwicklung zukünftiger Sonnenzyklen bei. (Referenzen am Schluss.)

Sonnenzyklen im Lauf der Jahrhundert

Abb. 1 ist der Veröffentlichung von Dr Abdussamatov vom Februar 2011 entnommen. Die obere Kurve gibt die „Total Solar Irradiance“ d.h. die gesamte Sonneneinstrahlung seit 1600 an. Die untere Kurve stellt die sich verändernde Sonnenflecken-Aktivität dar. In Zeiten geringer Sonnenflecken-Aktivität ist die auf die Erde treffende Energiemenge besonders niedrig. Man spricht dann von „Solar Minimum“. In den letzten 400 Jahren gab es drei Solar-Minima.

Abb. 1: TSI (gesamte Sonneneinstrahlung in Watt pro Quadratmeter) und Anzahl Sonnenflecken sowie Abschätzung der künftigen Entwicklungen (gestrichelte Linie)

Die Forschungsresultate von Abdussamatov aus dem Jahr 2011 stimmen mit denjenigen von Scafetta und Kitiashvili (NASA) aus dem Jahr 2019 überein. Es gibt mehrere TSI-Messmethoden, und nicht alle Wissenschafter kommen zu identischen Ergebnissen. Interessant ist aber, dass Scafetta von einer Zunahme der emittierterten Sonnenenergie bis zum Jahr 2000 und von einer anschliessenden Abnahme spricht. Das deckt sich mit den neuesten Resultaten von Kitiashvili (NASA), die eine markante Reduzierung der Sonnenflecken für die Jahre 2020 bis 2032 prognostiziert (nach ihrer Berechnung des Sonnenzyklus 25). Dies ist gleichbedeutend mit einer Reduktion der emittierten Sonnenenergie, was einen Temperaturrückgang auf der Erde gleichkommt. Gemäss NASA muss sogar mit einem „Grand Solar Minimum“ gerechnet werden, das mit dem sog. Dalton-Minimum der Jahre 1790 – 1820 vergleichbar sei.

Weitere Studien von Zharkova et al. erweitern die TSI-Messungen mit den Oszillationen des Sonnenmagnetfeldes und rechnen mit einem „Grand Solar Minimum“, das im Jahr 2020 beginnen und bis ins Jahr 2055 dauern wird. Dieses „Grand Solar Minimum“ ist mit dem „Maunder-Minimum“ vergleichbar. Damals war das Klima besonders kalt, weshalb man von einer „Kleinen Eiszeit“ spricht. Besonders interessant ist, dass dieses Grand Solar Minimum mit dem sogenannten Suess/de Vries-Sonnenzyklus korreliert, der eine Periode von 208 Jahren aufweist. Eine weitere Übereinstimmung ergibt sich mit dem „Super-Grand Solar Cycle“ nach Zharkova, der eine Periode von 1950 Jahren hat.

Um wie viel wird TSI abnehmen?

Viele Astrophysiker rechnen beim „Grand Solar Minimum“ mit einer gleich grossen Abnahme wie die frühere Zunahme. Entscheidend ist aber auch die Dauer des Minimums. Das Dalton-Minimum dauerte nur 30 Jahre, das Maunder-Minimum hingegen 70 Jahre. Je länger die Periode ist, umso tiefer wird die Temperatur ausfallen.

In der Literatur (s.Referenzen Zharkova) wird die Zunahme der von der Sonne emittierten Wärmeleistung d.h. die Energie in Joules pro Sekunde seit dem letzten Maunder-Minimum bis zum Jahr 2000 mit einem Wert von 1 bis 1,5 Watt pro Quadratmeter angegeben. Abdussamatov gibt den viel höheren Wert von 6 W/m2 an. Die Wissenschaft ist sich in diesem Punkt also noch nicht einig. Wir gehen für unsere Untersuchungen vom kleinsten Wert von 1 W/m2aus.

Was bedeutet die Abnahme der Sonnenwärmeleistung um 1 W/m2 für die globale Erdtemperatur?

Die Energieflüsse im System von Atmosphäre und Erdoberfläche lassen sich anhand einer einfachen Energie-Bilanz eruieren. Die gesamte Wärmeabnahme wird berechnet, indem der Querschnitt der Erde mit 1 W/m2 multipliziert wird. Bei einem 11-Jahreszyklus (Schwabe-Sonnenzyklus) lässt sich eine Abnahme der Wärmeleistung von 4.4 mal 1022 Joule errechnen.

Danach wird die mittlere Temperaturabnahme der Gesamtatmosphäre unter dem Einfluss der Gesamt-Wärmereduktion errechnet. Diese Temperatur-Reduktion wird dann korrigiert, indem die planetare Albedo und die Absorption an der Erdoberfläche berücksichtigt wird. Dabei werden die IPCC-Strahlungsbilanzangaben nach Kiehl und Trenberth zugrunde gelegt.

Die Masse der Atmosphäre beträgt 5.15 mal 1018 kg und die Wärmekapazität der Luft ist 1kJ/kg. Daraus wird die Temperaturabnahme mit 8, 5 °C errechnet. Nach den IPCC-Strahlungsbilanzen der Erde beträgt das planetare Albedo 30 %, die Erdoberfläche absorbiert 50 % der Wärme und die Atmosphäre absorbiert 20 %. Es ergibt sich also für die Atmosphäre eine globale Temperaturabnahme von rund 1.7 °C bei einer TSI-Abnahme von nur 1 W/m2.

Nach Scafetta nimmt der TSI seit dem Jahre 2000 ab. Nach den Satellitenmessdaten nimmt die globale Erdtemperatur dagegen erst seit 2016 ab. Dieser Unterschied ist nicht verwunderlich, wenn man die Wärme-Pufferfunktion der Meere berücksichtigt. Im Beitrag II haben wir bereits auf die massgebende Rolle der Meere hingewiesen.

Fazit

Die Mainstream-Klimatologen haben die Rolle der Sonne beim Klimawandel zu wenig berücksichtigt und ihr Augenmerk einzig auf die Treibhausgase gerichtet. Es ist ein naiver Fehlschluss zu behaupten, die gleichzeitige Zunahme der Erdtemperatur und des Treibhausgas-Ausstosses seien kausal voneinander abhängig. Es gibt keine experimentellen Nachweise dafür und die Berechnungen der „Micky-Mouse-Modelle“ (siehe Beitrag II) sind unzuverlässig.

Astrophysiker, die nicht nur die Erd-, sondern auch die kosmischen Verhältnisse berücksichtigen, erwarten in den nächsten Jahren eine ähnliche Entwicklung wie bei den seinerzeitigen Maunder- resp. Dalton-Minima. Ob die Astrophysiker/Klimatologen oder die Mainstream-Klimatologen recht haben, wird sich recht bald erweisen.

Unsere nächstfolgenden Beiträge werden sich mit Früh-Indikatoren auseinandersetzen, welche die These der zu erwartenden Abkühlung um 1 bis 1,5°C untermauern. Zudem betrug die Erdtemperaturerhöhung seit des Maunder-Minimums bis zum TSI-Maximum im Jahr 2000 nur rund 1°C. Nach dem IPCC müsste die Erdtemperaturerhöhung, wegen der Erhöhung der Treibhausgaskonzentration, viel höher sein, da die Erhöhung von rund 1°C bereits allein durch die Sonne verursacht wird.

F.Ferroni, Dipl.Ing.ETH

Präsident NIPCC-SUISSE

Referenzen

Abdussamatov,H.I., Bicentennial Decrease of the Total Solar Irradiance Leads to Unbalanced Thermal Budget of the Earth and the Little Ice Age, Applied Physics Research , Vol4.No.1; February 2012

Kitiashvili, I., Solar Activity Forecast for the Next Decade, Presentation 2019 (siehe Anhang oder Link)

Scafetta, N, Wilson, R. C., Comparison of Decadal Trends among Total Solar Irradiance Composites of Satellite Observations, Advances in Astronomy, Volume 2019, Article ID 1214896

Zharkova, V.V., Shepherd,S.J., Zharkov, S.I., and Popova, E., Oscillations of the baseline of solar magnetic field and solar irradiance on a millennial timescale,www.nature.com/scientificreports, June 2019

Der Beitrag erschien zuerst auf dem Schweizer Blog Carnot-Netzwerk hier

An jedem beliebigen Tag stammen 70 bis 80% des Stroms im östlichen Netz Australiens [noch immer] aus Kohlekraftwerken.

Natürlich gibt es viele Gelegenheiten, bei denen Wind und / oder Sonne sich zieren und absolut nichts an Energie hinzufügen. Das Gegenteil ist jedoch nie richtig: Würden sich Kohlekraftwerke wie Sonnenkollektoren und Windmühlen verhalten, würden die Australier mehr als die Hälfte der Zeit frieren oder schwitzen und das womöglich auch noch im Dunkeln.

Vorgespiegelte Tugend funktioniert nicht mit gesundem Menschenverstand. Die moderne Idee, dass die Welt bald auf fossile Brennstoffe verzichten kann, besteht aus zwei Teilen kindlichem Unsinn und drei Teilen Hipster-Heuchelei. [..~ im Trend liegende …]. Dieselbe Klasse, die hochtrabend über die Übel von Treibstoffen auf Kohlenstoffbasis schwafelt, jetten ziemlich glücklich [im Flugzeug] um die Welt und verbreiten ihre angebliche moralische Reinheit in unsere Ohren.

Wäre Heuchelei eine Treibstoffquelle, hätten die Australier die billigste Energie der Welt, wie Adam Creighton betont.

Wäre Heuchelei Energie, könnte das die Nation antreiben.

The Australian, Adam Creighton, 26. März 2019

Könnte Heuchelei als Energie für unser Landes genutzt werden, wären die Energiekriege vorbei. Das Energie- „Trilemma“ wäre gelöst, Heuchelei wäre zuverlässig (siehe jederzeit die Social Media Nachrichten), erschwinglich (kostenlos) und verursachte nur geringe Emission (besonders wenn sie schriftlich ausgedrückt werden). Neben der Heiligkeit [des Papstes] ist dies eine große Kraft unserer Zeit.

Wir exportieren gerne Uran für andere, damit diese emissionsfreien, zuverlässigen Strom erzeugen, aber rümpfen darüber unsere Nasen, anstatt es selbst zu verbrauchen. Das Gezeter, wenn es darum geht, Kohlekraftwerke abzuschalten und das sogar wenn es darum geht, damit noch die Zeit zu überbrücken, bis die Batterietechnologie die Zuverlässigkeit erneuerbarer Energien verbessert – das kommt rüber wie pure Heuchelei.

Insbesondere Kohle und Eisenerz finanzieren auch unseren Lebensstil, indem wir erschwingliche Autos, Fernseher und Auslandsurlaube kaufen können – quasi alle Waren und Dienstleistungen im Wert von 35 Milliarden US-Dollar, die wir jeden Monat importieren.

Der bloße Hauch eines Verbots australischer Kohleimporte nach China, hat den Dollar im letzten Monat um 1 Prozent nach unten gedrückt. Und China ist nicht einmal unser größter Kunde. China hat im letzten Jahr für etwa 60 Milliarden Dollar thermische und metallurgische Energie [Kohle, Uran] gekauft.

Die Bemühungen, die Adani Carmichael-Mine in Queensland zu verhindern, die Energie für einkommensschwache Inder liefern würde, ist das spitze Ende einer noch extremeren Bewegung, die durch Richard Marles, Labour Partei als Gallionsfigur für die Absicht steht, den Markt für Kohle [Abbau und Export] zusammenbrechen zu lassen.

[Adani ist ein indischer Großkonzern, für Rohstoffe, Logistik, Agrobusiness und Energieversorgung. Adani hat einen Vertrag, Kohle in Australien, „Carmichael-Mine“, Queensland abzubauen. Die Finanzierung wird nach dem Aufruf des IPCC, keine Projekte der fossilen Industrie zu unterstützen, in abgespeckter Form durch Andani selbst finanziert. Es entstehen Arbeitsplätze im Bergbau, bei der Eisenbahn und am Hafen. Die Umweltaktivisten wollen das unter allen Umständen verhindern und verzögern alle möglichen Genehmigungen mit ausstehenden Gutachten für Wasser, Umwelt, gefährdete Vogelarten uvam. – Recherchen des Übersetzers]

Ohne Kohleexporte (und Eisenerz, das zweitwertigste) würde unsere Währung zusammenbrechen. Die Nachfrage der Chinesen, Japaner und Koreaner nach unseren Ressourcen untermauert die Nachfrage nach unserer Währung, die unsere Exporteure wie BHP, Rio Tinto, Yancoal und Glencore benötigen, um ihre Steuern, Löhne, lokale Lieferanten und Aktionäre zu zahlen.

Ohne diese Steuern könnten Sie die für das Budget der für nächste Woche geplanten Kürzungen vergessen, die ausschließlich auf einem Einnahmenzuwachs der Exporteure der Nation beruhen.

Eine Welt, die mit erneuerbaren Energien betrieben wird, wäre ein wissenschaftlicher und ökologischer Triumph, aber auch eine wirtschaftliche Katastrophe für Australien, das – abgesehen von nicht erkennbaren, dramatischen Innovationen – von den Exporten fossiler Brennstoffe abhängig ist.

Wenn sich die Welt, wie im Pariser Abkommen von 2015 vorgesehen, von fossilen Brennstoffen entfernt, wird unsere Währung, die bereits zu den schwächsten der Ländern der westlichen Welt gehört, bis 2030 um weitere 6 Prozent fallen, so der Ökonom Warwick McKibbin.

„Die implizite Steuer für Australiens Exporte durch die CO2-Steuer führt sowohl auf kurze als auch auf lange Sicht zu einem erheblichen Verlust der Handelsbedingungen“, schreibt er in der neuesten Brookings-Studie, in dem er ebenfalls auf einen Lohnrückgang von 2 Prozent hinweist.

So sonnig und windig Teile von Australien auch sein mögen, wir können das nicht abfüllen und exportieren. Unser Know-how bei königlichen Kommissionen, bei Regierungsanfragen und beim Kaffeezubehör – so fortschrittlich es auch sein mag – wird voraussichtlich nicht in der Nähe des 100-Mrd.-USD-Plus an Exporten fossiler Brennstoffe im vergangenen Jahr heranreichen.

In der Zwischenzeit machen wir uns das Leben schwerer, indem wir mehr erneuerbare Energie in unser Netz zwingen und gleichzeitig zuverlässige Grundlast-Kraftwerke abschalten, ein Ansatz, der durch den australischen Energieversorger AEMO im Dezember als „chaotisch“ beschrieben wurde.

Es ist kaum ein freier Markt mehr im herkömmlichen Sinne vorhanden. Verzerrt durch staatliche und bundesstaatliche Vorschriften und Eingriffe, zusätzlich zu den Konfusionen der drei großen Einzelhändler – AGL, Origin und EnergyAustralia, letztere ein Unternehmensbesitz aus Hongkong.

Regierungsziele für erneuerbare Energien haben „die Verbindung zwischen den physischen Bedürfnissen eines zuverlässigen Stromsystems und den wirtschaftlichen Anreizen der Marktteilnehmer, die Energiekosten im Großhandel so niedrig wie möglich halten“, gebrochen. Kapitalanleger haben das Stromnetz übernommen.

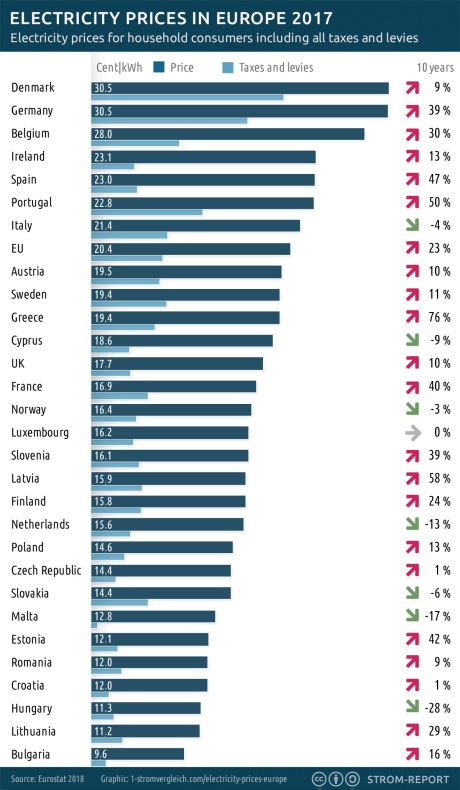

Befürworter erneuerbarer Energien argumentieren, Wind und Sonne seien billiger als Kohle und Gas. Die Einzelhandelspreise sind jedoch in einem Jahrzehnt real um 56 Prozent gestiegen, da der Anteil der erneuerbaren Energieträger an der Energieversorgung auf etwa 16 Prozent (in Südaustralien 55 Prozent) gestiegen ist. Korrelation ist keine Ursache, aber irgendwann sollte sich die Dividende von dieser „billigen“ Stromquelle auf unseren Rechnungen zeigen.

Victorias Hazelwood-Kohlekraftwerk, das rund fünf Prozent des Stroms für den nationalen Markt lieferte, wurde Anfang 2017 aufgrund einer Entscheidung eines französischen Unternehmens, das von der französischen Regierung kontrolliert wird, geschlossen.

Laut AEMO sind die Großhandelspreise für Strom in Victoria seitdem von weniger als 40 USD auf 100 USD pro Megawattstunde gestiegen. Im Januar dieses Jahres erreichten sie 250 Dollar pro Megawattstunde. Die Preise sind in New South Wales um 100 Prozent und in Südaustralien im gleichen Zeitraum um 86 Prozent gestiegen. (… würde Frankreich einer australischen Firma erlauben, die Energieversorgung und -preise des [französischen] Landes zu bestimmen?)

Das Kraftwerk von Liddell in NSW, ähnlich groß wie Hazelwood, wird im Jahr 2022 geschlossen. Sein Eigentümer AGL sagt, die Preise würden davon unbeeinflusst bleiben und die Zuverlässigkeit werde nicht beeinträchtigt. Lieferanten [Stromversorger] haben ein Interesse an weniger Leistung und höheren Preisen.

Sogar den Behörden kann nicht vertraut werden. Anfang 2017 sagte AEMO, dass die Schließung von Hazelwood „die Sicherheit des Strommarktes Victoria nicht beeinträchtigen würde“. Im November wies AEMO darauf hin, dass „das Risiko von Unterbrechungen der Stromversorgung für den kommenden Sommer erhöht wäre … wenn keine weiteren Schritte unternommen würden“.

Die eingeleiteten Schritte beinhalten Snowy 2.0, eine schicke, teure Batterie, die Strom für etwa 140 Stunden liefert. Dieses Lieblings Projekt der Regierung, eine Erweiterung des Snowy-Hydro-Systems [Pumpspeicher…], ist weit davon entfernt, das Problem des Mangels an zuverlässiger, kostengünstiger Stromversorgung zu lösen und hängt von hohen Preisen ab.

Das Wasser wird den Hügel hinaufgepumpt, wenn die Großhandelspreise für Strom niedrig sind, und wird abgelassen, wenn die Strompreise hoch sind. Je höher die Preise sind, desto besser für Snowy und seinen endgültigen Eigentümer, die Bundesregierung. Mit rund 6 Mrd. USD, einschließlich etwa 2 Mrd. USD für die Aktualisierung des Übertragungsnetzes, sind es drei Mal die Kosten eines neuen emissionsarmen Kohlekraftwerks.

Es ist unwahrscheinlich, dass sich der gesunde Menschenverstand in der Regierung durchsetzt, da die meisten Wähler den Schmerz noch nicht fühlen. Die Stromausgaben machten 2017 – selbst nach einem Jahrzehnt der Preiserhöhungen – 2,17 Prozent der Haushaltsausgaben aus. Das sind weniger als Essensgerichte zum Mitnehmen mit 2,56 Prozent oder Restaurants. Die Haushalte machten im vergangenen Jahr nur ein Viertel des Stromabsatzes aus. Das Geschäft wird insbesondere durch die Schwerindustrie gemacht. Leider wählen die nicht.

[Aber deren Angestellte!]

Von STT ein Beispiel für Industrielle Anbieter, die auf zuverlässigen und unterbrechungsfreien Strom angewiesen sind, findet sich hier: http://www.bundabergwalkers.com.au/ – Schwermaschinenbau, Bergbau und Zuckerindustrie.

The Australian

[Bezahlsperre?]: The Australian

Gefunden auf stopthesethings vom 04.04.2019

Übersetzt durch Andreas Demmig

Die Zufallsentdeckung eines Agrarwissenschaftlers aus Münster deutet nun an, dass der Regen in Deutschland und anderen Teilen Europas in gewissen Monaten einem bislang verborgen gebliebenen Muster folgt. Im Rahmen der Agrarberatung durchforstete Ludger Laurenz die jahrzehntelangen Niederschlagsaufzeichnungen der Wetterstation Münster, wobei ihm besonders im Februar ein ständiges Auf und Ab im 11-Jahresrythmus auffiel. Nach eingehender Prüfung war klar, dass der Rhythmus eng mit der Aktivität der Sonne korrelierte, dem gut dokumentierten 11-jährigen Sonnenfleckenzyklus.

Laurenz tat sich daraufhin mit zwei Kollegen zusammen, um zu überprüfen, inwieweit das beobachtete Muster aus Münster in anderen Teilen Deutschlands und Europas reproduzierbar ist und ob das Phänomen auch in anderen Monaten existiert. Horst-Joachim Lüdecke von der Hochschule HTW des Saarlandes besorgte sich daraufhin die gesammelten Niederschlagsdaten Europas seit Beginn des 20. Jahrhunderts. Der emeritierte Physiker entwickelte einen Rechner-Algorithmus, mithilfe dessen die Ähnlichkeit der Veränderungen im Regen und der Sonnenaktivität bestimmt wurde. Alle 39 europäischen Länder und alle 12 Monate eines Jahres wurden über insgesamt 115 Jahre anhand mathematischer Korrelationen quantifiziert.

Um mögliche Verzögerungseffekte mit einzuschließen, wurden die Datenreihen von Regen und Sonnenflecken dabei auch systematisch auf Verschiebungen hin überprüft. Dazu wurden die Zeitreihen wie Kämme zeitlich gegeneinander schrittweise verschoben und die jeweilige Veränderung des Korrelationsmaßes notiert. Die auf diese Weise erhaltenen mehrdimensionalen Daten wurden vom Geowissenschaftler Sebastian Lüning auf systematische Trends hin ausgewertet und kartographisch visualisiert. Lüning ist mit dem schweizerischen Institut für Hydrographie, Geoökologie und Klimawissenschaften (IFHGK) assoziiert und hat sich auf die Erforschung solarer Klimaeffekte spezialisiert.

Die auskartierten Ergebnisse zeigen, dass die ursprünglich in Münster entdeckte Verknüpfung von Februar-Niederschlägen und der Sonnenaktivität für weite Teile Mitteleuropas und Nordeuropas Gültigkeit und dort sehr hohe statistische Signifikanz besitzt. In Richtung Südeuropa schwächt sich die Korrelation hingegen deutlich ab. Die statistische Untersuchung konnte zudem systematische Phasenverschiebungen über den Kontinent hinweg nachweisen. In Deutschland und Nachbarländern waren die Februar-Niederschläge jeweils besonders gering, wenn die Sonne vier Jahre zuvor sehr stark war. Die Verzögerung scheint über die langsame Tiefenzirkulation des Atlantiks zustande zu kommen, wie frühere Arbeiten andeuten. Auf Basis des statistisch-empirisch ermittelten Zusammenhangs lässt sich nun auch der besonders niederschlagsarme Februar 2018 in Deutschland erklären, der einer besonders hohen Intensitätsspitze der Sonnenaktivität Anfang 2014 folgte.

Ähnliche Zusammenhänge zwischen Regen und Sonnenaktivität ließen sich in abgeschwächter Weise auch in einigen anderen Monaten feststellen, insbesondere im April, Juni und Juli, was einen Großteil der Vegetationsperiode in Mitteleuropa ausmacht. Es entstand ein komplexes Bild des Zusammenspiels von Sonne und Regen in Europa, welches deutliche Trends über 1000 km hinweg erkennen ließ und von Monat zu Monat teils stark variierte. Die Studie erhärtet damit das Konzept einer solaren Beteiligung an der europäischen hydroklimatischen Entwicklung, was sich bereits aus einer ganzen Reihe von lokalen Fallstudien anderer Autoren angedeutet hatte. Der genaue Mechanismus, mit dem das Sonnensignal Einfluss auf die Niederschläge nimmt, ist jedoch noch weitgehend unklar und erfordert weitere Forschungsbemühungen.

Der nun erstmals flächenmäßig über Europa auskartierte solare Niederschlagseffekt eröffnet neue Möglichkeiten für eine verbesserte Mittelfrist-Vorhersage von Niederschlägen. Insbesondere die Landwirtschaft, aber auch die Abwehr von Extremwetterschäden im Zusammenhang mit Starkregen und Dürren könnten davon profitieren. Nächster Schritt bei der Verfeinerung der Vorhersagemethodik ist eine genauere Quantifizierung von Effekten durch atlantische Ozeanzyklen, die für das Regengeschehen speziell in Westeuropa ebenfalls eine wichtige Rolle spielen.

Ludger Laurenz, Horst-Joachim Lüdecke, Sebastian Lüning: Influence of solar activity on European rainfall. Journal of Atmospheric and Solar-Terrestrial Physics, 185 (20129) 29-42, doi: 10.1016/j.jastp.2019.01.012

Das pdf kann bis Ende März 2019 kostenlos unter der folgenden URL abgerufen werden: https://authors.elsevier.com/a/1YXWZ4sIlkiVhv

Dieser Beitrag ist zuerst erschienen online: Institute for Hydrography, Geoecology and Climate Science, Hauptstraße 47, 6315 Ägeri, Schweiz (IFHKG): https://www.ifhgk.org/aktuelle-forschung-science-news/

Falschfarbenbild der Nachtseite der Venus, aufgenommen mit der IR2-Kamera auf Akatsuki bei 1,735 µm (blau) und 2,26 µm (rot) und Mischung der beiden (grün). Auf der Nachtseite der Venus beobachtet IR2 das Infrarotlicht, das aus der unteren Atmosphäre durch die Wolken kommt, und der Schatten der Wolken ist im Bild zu sehen. Hier werden Hell und Dunkel umgekehrt, um Wolken in weißlicher Farbe anzuzeigen. (Bildnachweis: JAXA / PLANET-C-Projektteam –http://cosmos.isas.jaxa.jp/?p=700)

Akatsuki hat möglicherweise entdeckt, warum sich die Atmosphäre der Venus so schnell dreht. Der Grund kann für die Bewohnbarkeit erdgroßer Exoplaneten eine entscheidende Rolle spielen.

Die Venus ist ein Planet, der in Größe und Masse fast wie die Erde ist. Dies ist eine wesentliche Studie, um die möglichen Bedingungen auf felsigen Planeten zu verstehen. Ein bestimmendes Merkmal unserer Nachbarwelt ist eine dichte, dicke Atmosphäre, deren reflektierende Eigenschaften die Astronomen dazu verleiteten, den Planeten nach der mythologischen Göttin der Schönheit zu benennen – die Fähigkeit der Atmosphäre Wärme einzufangen, treibt jedoch die Oberflächentemperatur bis zum Schmelzpunkt von Blei.

Ausgewählte Werte zum Vergleich der Planeten

Quelle: Mark A. Garlick, „Der große Atlas des Universums“, Kosmos Verlag, 2011, 2. Ausg.

| Erde | Venus | |

| Durchschnittlicher Sonnenabstand |

149,6 Mio km (1AE) | 108,2 Mio km (0,72 AE) |

| Sonneneinstrahlung gemittelt |

1361 Watt/m² (max, oberer Rand der Atm.) |

(Erde = 1) 1,91 |

| Äquatordurchmesser | 12.756 km | 12.104 km |

| Rotationsdauer (siderisch, d.h. vollständige Umdrehung) | 23,93 h | 243 Tage (retrograd = rückläufig) |

| Masse | 5,974 x 10^24 kg | (Erde = 1) 0,82 |

| Volumen | 1,08 Bill km³ | (Erde = 1) 0,86 |

| Gravitation an Oberfläche | 1 g (9,8 m/s²) | (Erde = 1) 0,91 |

| Durchn. Dichte | 5,5 (Wasser = 1) | 5,24 |

| Druck an der Oberfläche | 101,4 kP | (Erde = 1) 92 |

| Höchsttemperatur | 58°c | 464 °C |

| Tiefstemperatur | -88°C (~-94°C akt. !) |

Ergänzung durch den Übersetzer

Die seltsamste Erscheinung der venusianischen Atmosphäre ist vielleicht ihre Geschwindigkeit. Winde peitschen um den Planeten bis zu 60-mal schneller als sich die Oberfläche dreht; ein Phänomen, das als atmosphärische Superrotation bekannt ist.

Die Windgeschwindigkeiten auf der Venus sind in den oberen Wolkenschichten mit mehr als 100 m/s (360 km/h) recht hoch. Die Oberfläche des Planeten dreht sich jedoch extrem langsam. Der Planet umkreist die Sonne in 225 Erd-Tagen, benötigt jedoch 243 Erd-Tage, um sich um seine Achse zu drehen, wodurch der Venus-Tag (eine vollständige Umdrehung) länger dauert als ein Venus-Jahr.

Abbildung der Gezeiten- Verriegelung. Die grüne Region des Satelliten (Mond oder Planet) ist niemals von der Oberfläche des Zentralkörpers (Planet oder Stern) aus sichtbar. (Bildnachweis: en.wikipedia/)

Eine solche langsame Rotation kann ein übliches Merkmal von Exoplaneten in Erdgröße sein, wie dem TRAPPIST-1-System und Proxima Centauri-b, deren enge Umlaufbahnen zu ihrem Stern wahrscheinlich zu Blockierung der Rotation geführt haben. Wie der Mond, der die Erde umkreist, dreht sich eine tidally locked world [Gezeitensperre] einmal pro Umlaufbahn, so dass eine Seite permanent dem Stern (der Sonne) zugewandt ist, während die andere eine ewige Nacht erlebt. Planeten mit langsamer Rotation und erdähnlichen Atmosphäre müssen die Wärme effizient um den Planeten transportieren, oder sie riskieren den Zusammenbruch der Atmosphäre, wenn auf der kalten Nachtseite die Welt gefriert. Ein solch katastrophales Ende könnte vermieden werden, wenn tidally-locked Welten typischerweise die schnellen Winde einer superrotierenden Atmosphäre haben.

Also, was ist die Ursache für die Super-Rotation der Venus?

Klassisch gibt es zwei Hauptthesen für die Super-Rotation. Im ersten Szenario führt der Reibungswiderstand der Atmosphäre über der Planetenoberfläche zu einer Verlangsamung der Rotation des Planeten, um die Winde zu beschleunigen (Gierasch-Rossow-Williams-Mechanismus). Im zweiten Szenario werden die Winde aufgrund der Erwärmung durch die Sonne (so genannte Solarthermie) angeregt.

Modelle des ersten „Surface-Up“ -Mechanismus sind bekanntermaßen empfindlich für die genauen Startbedingungen auf dem Planeten. Geringfügige Änderungen der Temperaturverteilung des Planeten können die Super-Rotation töten oder einleiten. Dies lässt vermuten, dass relativ wenige sich langsam drehende Welten zu atmosphärisch erhaltenden, superdrehenden Winden führen würden, da die Bedingungen auf dem Planeten genau richtig sein müssten.

Künstlerische Gestaltung des Akatsuki Venus Klima-Orbiters, der sich der Venus nähert.

Super-Rotation auf der Venus wurde jedoch sowohl an den oberen Wolkenschichten als auch in Tiefen von mehreren zehn Kilometern beobachtet. Könnte der Einfluss der Sonne angesichts der Tatsache, dass die Venus einen großen Teil des einfallenden Sonnenlichts reflektiert, tatsächlich die Superrotation der mittleren Schichten antreiben?

Die Raumsonde Akatsuki (japanisch „Morgendämmerung“) drang am 7. Dezember 2015 in den Orbit der Venus ein. Am dritten Jahrestag des Orbit-Einsatzes fand in Tokio eine Pressekonferenz statt, um die neuesten Ergebnisse zu diskutieren.

Unter der Leitung des International Top Young Fellow (JAXA’s prestigeträchtiges Postdoc-Stipendienprogramm), Dr. Javier Peralta , präsentierte die Pressekonferenz die Ergebnisse einer neuen Studie, die im Dezember in dem Astrophysical Journal Supplement veröffentlicht wurde.

Dr Javier Peralta, ITYF at ISAS/JAXA und Hauptautor dieser Studie.

In dieser Studie verwendete Peralta 466 Bilder der Venuswolken, die von der IR2-Kamera auf Akatsuki bei einer Infrarotwellenlänge von 2,26 Mikrometern zwischen März und November 2016 aufgenommen wurden. Durch den Vergleich von Bildern, die zu verschiedenen Zeitpunkten aufgenommen wurden, konnte Peralta die Wolken verfolgen, während sie um die venusianische Kugel herumschwirrten, um ihre Geschwindigkeit zu messen.

An der Tagseite der Venus wird die Atmosphäre durch das einfallende Sonnenlicht beleuchtet.

Stark reflektiert wird das sowohl in ultravioletten wie auch in infraroten Wellenlängen durch die oberen Wolkenschichten in einer Höhe von 60 bis 70 km oberhalb der Planetenoberfläche. Die nächtliche Beleuchtung wird jedoch durch Infrarotwärme erzeugt, die von Venus ‚heißer Oberfläche ausgeht. Dies wird teilweise durch Wolken in tieferen Höhenlagen zwischen 48 und 60 km blockiert. Da die Wolken für dieses Infrarotlicht unterschiedliche Transparenz haben, werden ihre Formen sichtbar, wenn sie mit der IR2-Kamera von Akatsuki betrachtet werden. Es waren diese tieferen Wolken der Nachtseite, die Peralta aufspürte.

Falschfarbenbild der Nachtseite der Venus unter Verwendung von mit IR2-Kamera aufgenommenen Bildern von 1,735 um (blau) und 2,26 um (rot). (Bildnachweis: JAXA / PLANET-C-Projektteam)

Der Cloud-Tracking-Algorithmus (Wolken-Verfolgung) von Peralta war halbautomatisch und wurde sowohl manuell als auch per Computer durchgeführt. Die Wolken wurden manuell identifiziert und dann per Software kartiert und das Ergebnis erneut von Hand bestätigt.

Das Ergebnis waren 2.947 Windmessungen, die ein interessantes Muster zeigten. Es gab eine deutliche Beschleunigung der Wolken, die an den Standort der Sonne gebunden war. Dies deutet stark darauf hin, dass die Sonnenstrahlung sich auch weit unterhalb der oberen Atmosphäre auf die Wolken auswirkt.

In niedrigeren Höhenschichten war diese Beschleunigung vorwiegend zonenförmig (wickelte sich westwärts um den Planeten), wobei keine meridionalen (Nord-Süd-) Windbeschleunigungen festgestellt wurden. Dies deutete auf ein von der Sonne angetriebenes System hin, da die Oberfläche zu Windströmungen in beide Richtungen hätte führen sollen. Peralta ist jedoch vorsichtig, als er darauf bestand, dass dies „Fall nicht abgeschlossen“ sei.

„Bei den Meridianwinden ist mit Akatsuki kein klarer Trend zu erkennen“, sagte er. „Aber wir sollten das bestätigen, indem wir Windmessungen mit noch höherer Genauigkeit versuchen.“

Peralta hofft, dass die kombinierten Ergebnisse von Akatsuki und Venus Express der Europäischen Weltraumorganisation noch mehr über dieses System enthüllen könnten. Animationen, Bilder und die Windmessungen der Peralta-Studie stehen zum Download zur Verfügung und können von der Community erkundet werden.

Peralta sichtete auch andere Daten als nur von Akatsuki und verglich die Ergebnisse früherer Venus-Missionen bis ins Jahr 1978. Wobei es schwierig ist, die Ergebnisse von Instrumenten verschiedener Raumsonden und Bodenteleskope zu vergleichen,

Peraltas Ergebnisse deuteten darauf hin, dass sich die Windgeschwindigkeiten der Venus in den letzten dreißig Jahren verändert haben. Eine solche Entdeckung stimmt nicht nur mit einem Solartreiber überein, sondern kann auf die erste Erkennung von Klimawandels auf einem anderen Planeten hinweisen.

„Wenn die Gezeiten der Sonne durch superrotierende Winde angetrieben werden, kann dies bedeuten, dass sich die Wolkenalbedo (das Maß der Reflektion) im Laufe der Zeit verändert hat und die Auswirkungen der Sonnenstrahlung beeinflusst hat“, erklärt Peralta.

Ein solches Ergebnis ist eine gute Nachricht für tidally-locked Welten. Wenn der superrotierende Wind der Venus von der Sonne angetrieben werden kann, könnte eine solche schnelle Zirkulation bei langsam drehenden, aber möglicherweise gemäßigten Welten um andere Sterne üblich sein. Während das Wetter unter einer super-rotierenden Atmosphäre sich sehr von dem auf der Erde unterscheiden würde, könnte es dem Planeten ermöglichen, seine Atmosphäre und sogar die gewünschten Oberflächenbedingungen für das Leben zu erhalten.

Durch den Vergleich der beiden erdgroßen Planeten in unserem eigenen Sonnensystem, können wir viel mehr darüber lernen, was es braucht, um eine bewohnbare Welt zu sein.

Weitere Information: The Akatsuki spacecraft homepage

Journal paper by Peralta et al. (uneingeschränkter Zugang)

Nachtwinde an den unteren Venuswolken mit Akatsuki / IR2: Längen-, Ortszeit- und Dekadavariationen aus dem Vergleich mit früheren Messungen

Abstrakt

Wir zeigen Messungen der Windgeschwindigkeiten an den nächtlichen unteren Venuswolken aus Beobachtungen der JAXA-Mission Akatsuki im Jahr 2016, ergänzt durch neue Windmessungen aus bodengestützten Beobachtungen, die mit dem TNG / Near Infrared Camera Spectrometer (NICS) von 2012 und IRTF / aufgenommen wurden. SpeX in den Jahren 2015 und 2017. Die zonalen und meridionalen Komponenten der Winde wurden mittels Cloud-Tracking an insgesamt 466 Akatsuki- Bildern der Venus gemessen, die mit der Kamera IR2 unter Verwendung der 2,26 μ aufgenommen wurden-Filter mit räumlichen Auflösungen von 10 bis 80 km pro Pixel und Abdeckung vom 22. März bis 31. Oktober 2016. Mehr als 149.000 Windvektoren wurden mithilfe einer automatischen Schablonenanpassungstechnik erhalten, und 2947 Windvektoren wurden mithilfe eines manuellen Verfahrens abgeleitet. Die Meridianprofile beider Windkomponenten stimmen mit den Ergebnissen der Venus Express- Mission in den Jahren 2006–2008 überein. Allerdings ist eine stärkere Windvariabilität für die Zonenkomponente in äquatorialen Breiten zu erkennen, in denen Akatsuki- Beobachtungen eine bessere Betrachtungsgeometrie als Venus Express aufweisen. Die zonalen Winde in niedrigen Breiten deuten auch auf eine zonale Variabilität hin, die mit Sonnenfluten oder sich vertikal ausbreitenden orographischen Wellen zusammenhängen könnte. Schließlich deutet die Kombination unserer Windmessungen aus TNG / NICS-, IRTF / SpeX- und Akatsuki- Bildern mit den von 1978 bis 2017 veröffentlichten Daten auf Variationen von bis zu 30 ms −1 im Wind an den nächtlichen unteren Venuswolken hin.

***

Gefunden auf Whatsupwiththat vom 24.01.2019

Übersetzt durch Andreas Demmig

https://wattsupwiththat.com/2019/01/24/first-detection-of-climate-change-on-another-planet/

Die polaren Eiskappen begannen sich letztmalig vor etwa 13 Millionen Jahren zu bilden, vorher gab es über zwölf Millionen Jahre lang keine Vereisung der Pole. Eine verstärkte Vereisung von Grönland und Nordamerika setzte erst vor etwa drei Millionen Jahren ein, als auch ein schneller Wechsel von Eiszeiten und Warmzeiten begann; insgesamt ist aber eine globale Tendenz – bis heute anhaltend – zur Abkühlung erkennbar. Erdgeschichtlich gesehen sind sogar unsere drei vergangenen Warmzeiten eher im unteren Temperaturbereich der Erdgeschichte anzusiedeln.

Zurück ins Heute: Gegenwärtig ist eine Erwärmung seit 1975 festzustellen oder zumindest zu vermuten. Das führt zu der Frage, was verursachte diese oder viele andere Erwärmungen, wenn es CO2 jedenfalls nicht sein kann. Man kommt dann vielleicht auf eine ganz einfache Lösung der Frage; es ist nicht ausschließlich, aber im Wesentlichen die Sonne selbst, die Erwärmungen und Abkühlungen verursacht.

Für den Menschen ist es natürlich nicht einfach, in großen Dimensionen und gleichzeitig einfach zu denken, es fällt sogar schwer, sich vorzustellen, dass unsere Alpen bis etwa 1500 im Winter fast völlig schneefrei waren, so wie jetzt der Kilimandscharo schneefrei wird. Noch gibt es unzählige Forscher, die der CO2-Meinungsdiktatur Widerstand leisten wollen und so wurden in den letzten Jahren auch andere Theorien bezüglich der Erwärmung hervorgebracht. Eine davon bezieht sich auf die Rolle der Sonne.

Wie schon dargelegt, ist die Erde, anders als von der Treibhaustheorie ausgesagt, kein geschlossenes sondern ein offenes System. So ist es nicht unbedingt verwunderlich, dass es in den letzten Jahren nicht nur auf der Erde, sondern im gesamten Sonnensystem zu einer Erwärmung kam. Davon betroffen sind Mars, Jupiter, Pluto und andere Planeten und Monde.

Satellitenmessungen der letzten Jahre, beispielsweise der Raumsonde Odyssee, zeigen eine Erwärmung des ganzen Sonnensystems, nicht nur der Erde. So schmolz bereits ein Teil der Polkappen des Mars weg und Pluto erlebte eine Erwärmung von fast zwei Grad Celsius während der letzten 14 Jahre. Jay Pasachoff, Professor für Astronomie am Williams College, stellt fest, dass zum Beispiel Plutos globale Erwärmung (oder besser gesagt, plutonische Erwärmung) auf eine Zunahme des Sonnenlichts zurückzuführen ist.

Dennoch, so der Forscher, reiche diese Erklärung allein nicht aus, um die Zunahme der Erwärmung auf dem Pluto zu erklären. Hinzu komme die elliptische Bahn und die Rotationsachse des Planeten. Diese Faktoren lassen mehr oder weniger Sonnenlicht auf die Oberfläche auftreffen. Beide Faktoren führen zu einer deutlichen durchschnittlichen Erwärmung. Was für alle anderen Planeten gilt, kann zumindest auf der Erde auch in Betracht gezogen werden.

Ilya Usoskin von der Universität Oulu, Finnland und Kollegen – unter anderem ein Wissenschaftler vom deutschen Max-Planck-Institut für Sonnensystemforschung in Katlenburg-Lindau – untersuchten die Sonnenaktivität der vergangenen Jahrhunderte und veröffentlichten ihre Entdeckungen Ende 2006.

Sie verwendeten eine neuartige Methode. Sie untersuchten die Titanium-44-Mengen in niedergegangenen Meteoriten der letzten 240 Jahre, wodurch letztlich auf die Sonnenaktivität geschlossen werden konnte. Ihre neuartige Messmethode hier zu beschreiben würde zu weit führen, aber sie erlaubte es, die Sonnenaktivitäten weitgehend ohne verzerrenden Einfluss von terrestrischen Faktoren nachzuweisen. Sie fanden dabei heraus, dass die Sonnenaktivität im 20. Jahrhundert stark zunahm, besonders ausgeprägt in den letzten Jahrzehnten.

Dieser starke Anstieg wurde vorher als nicht erwiesen betrachtet, weswegen die Vertreter der Treibhaustheorie die Sonne zwar für vergangene Temperaturanstiege ebenfalls in bestimmtem Maße verantwortlich machten, aber nicht für den der letzten zwei Jahrzehnte.

Frühere Berechnungen variierten von 60 bis an die 100 Prozent für den Einfluss der Sonnenaktivität auf das Erdklima. Als jedoch die Treibhaustheorie alles übernahm, verlor man diesen Ansatz aus den Augen. Wie kann man sich nun die Korrelation zwischen Sonnenaktivität und Erdklima vorstellen?

Diese Theorie erklärt den Klimawandel nicht in Hinsicht auf ein paar hundert oder zehntausend Jahre, sondern rechnet in Erdzeitaltern und den einhergehenden Klima-Verschiebungen. Die SKS geht davon aus, dass die kosmische Strahlungsintensität das Wetter und insbesondere die Wolkenbildung beeinflusst. Explodierende Sterne verursachen bekanntlich einen konstanten Strahlungsregen in der Milchstrasse, bestehend aus Protonen, Elektronen, Heliumkernen und Myonen (schwere Elektronen).

Die Myonen ihrerseits sind auf atomarer Ebene dabei, die Wolkenbildung auf Höhen bis zu 3.000 m zu verursachen. Sie reißen nämlich in der Atmosphäre Elektronen von ihren Atomen und diese freigesetzten Elektronen lassen Wolkenkondensationskerne entstehen. Atmosphärischer Wasserdampf kondensiert um diese Kondensationskerne, um Wassertröpfchen zu bilden.

Wenn dann mehr Wolken gebildet werden, kommt nicht mehr soviel an Sonnenlicht zur Erde durch, wodurch ein Abkühlungseffekt erzeugt wird. 2006 waren die Entdecker dieser Theorie in der Lage, im Laborversuch nachzuweisen, dass ihre 1996 entwickelte Theorie stimmt, etwas, was bei der Treibhaustheorie nie geschah, dort verließ man sich auf Parameter und gewisse Annahmen und Vermutungen.

Zu dieser Wolkenbildung ist Schwefelsäure als Katalysator notwendig. Schwefelsäure kommt in der Atmosphäre vor und wird ständig durch Vulkane und vor allem Plankton ersetzt.

Das variable Magnetfeld der Sonne umhüllt die Erde durch einen magnetischen Sonnenwind, Heliosphäre genannt. Ihr Radius wird auf 100 bis 150 Astronomische Einheiten (AE) geschätzt. Sie schützt uns vor ankommenden kosmischen Strahlen, die von den explodierenden Sternen verursacht werden und auf uns niederschießen.

Sonnenflecken sind dunkle Flecken oder Bereiche erhöhter magnetischer Intensität, die seit über 400 Jahren durch Teleskope zu beobachten sind. Gibt es mehr Sonnenflecken, verstärkt sich die Heliosphäre, wodurch wiederum mehr kosmische Strahlen von der Erde abgehalten werden.

Im 20. Jahrhundert verdoppelte sich die magnetische Aktivität der Sonne und so konnten weniger kosmische Strahlen die Erde erreichen. Die Wolkenbildung wurde reduziert und die Temperatur stieg an. Die SKS des Klimawandels erklärt erstmals diejenigen Beobachtungen, die während der letzten 400 Jahre gemacht wurden, und die immer einen direkten Zusammenhang von Sonnenflecken und Temperatur auf der Erde herstellen konnten.

Bild: Die Spiralarme der Milchstraße sind Bereiche erhöhter kosmischer Strahlung. Betritt das Sonnensystem diesen Bereich, erhöht sich nachweisbar die Temperatur der Erdatmosphäre. (NASA)

Bild: Die Spiralarme der Milchstraße sind Bereiche erhöhter kosmischer Strahlung. Betritt das Sonnensystem diesen Bereich, erhöht sich nachweisbar die Temperatur der Erdatmosphäre. (NASA)

Eine weitere Unterstützung erfährt diese Theorie durch Forschungen zweier Wissenschaftler: Unser Sonnensystem passiert alle 135 Millionen Jahre in seiner Rotation um das Zentrum der Milchstrasse einen der Spiralarme der Milchstrasse (Bild 2). Diese Arme besitzen eine hohe Dichte an kosmischer Strahlung.

Der Astrophysiker Nir Shaviv und der Geologe Ján Veizer zeigten 2003 beziehungsweise 2005 deutlich, dass die Veränderung der Erdtemperatur während der letzten 500 Millionen Jahre mit der Intensität der kosmischen Strahlung, die beim Passieren eines der Spiralarme der Milchstrasse auf die Erde trifft, korreliert (veröffentlicht in Geological Society of America Today 2003;13:4-10, Geoscience Canada 2005;32:13-30).

Sie fanden ebenfalls heraus, dass der CO2-Gehalt der Atmosphäre schon bis zu 18 Mal höher lag als heute. Während der ordovizischen Eiszeit war der CO2-Gehalt immerhin noch zehn Mal höher als heute, was ebenfalls jeglicher CO2-Erwärmungstheorie spottet, denn wieso hätte es in einer Eiszeit einen solch starken Anstieg beim CO2 geben können.

So zeigen andere Forscher, dass das allgemeine Magnetfeld der Sonne sich in den letzten 100 Jahren verdoppelte, ebenso die Anzahl der Sonnenflecken. Die Sonne wurde kräftiger und auch etwas heller. (Parker, E.N. 1999. Sunny side of global warming. in Nature).

Auf einer kleineren Zeitachse gesehen spielen noch andere solare Zyklen eine offensichtliche Rolle bei Erderwärmungen oder Abkühlungsphasen, insbesondere der 1.500jährige Sonnenzyklus spielt eine große Rolle. Dieser Zyklus kann seit 12.000 Jahren bei Erderwärmungen nachgewiesen werden, letztmalig verursachte er die mittelalterliche Wärmeperiode.

Die bislang völlig wirkungslose „CO2-Bekämpfung“, vor allem die dazugehörige, sich auf einem Irrweg befindende Forschung wird immer mehr zum globalen Geldfresser und verbraucht bereits soviel an Geld, wie etwa die Mongolei an Bruttoinlandsprodukt erwirtschaftet, Tendenz steil nach oben steigend. Wie viel CO2 der CO2-industriell-ideologische Komplex selbst ausstößt, wird wohl ein Geheimnis bleiben.

AUSSAGE 1:

Mojib Latif am 4. Dezember 2012 in der Talkshow “Pelzig hält sich“:

„Eins will ich ja auch nochmal sagen. Ich wäre ja froh, wenn es die Sonne wäre. Dann könnten wir ja nichts tun. Ja, aber das ist es nicht. Wenn Sie sich die Sonnenstrahlung angucken, seit 50 Jahren ist die Sonne schwächer geworden. Und wie soll eine schwächer werdende Sonne eigentlich eine massive Erwärmung verursachen?“

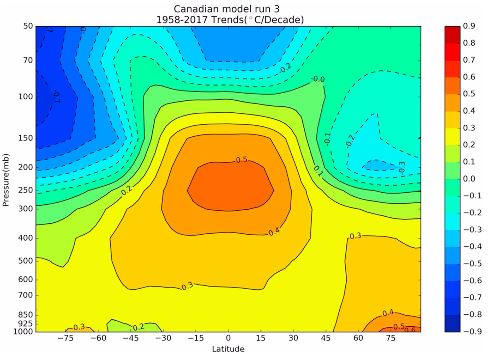

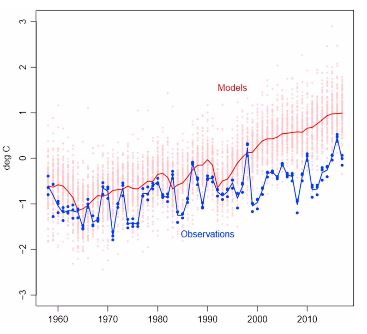

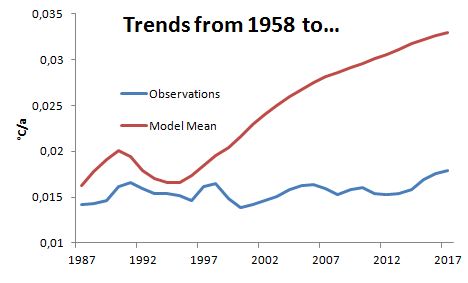

Falsch. Die Sonne ist in den letzten 50 Jahren in Wahrheit stärker geworden, wenn man die Total Solar Irradiance (TSI) (weiße Kurve im Diagramm) berücksichtigt, die auch die kosmische Strahlung bzw. das Sonnenmagnetfeld mit einbezieht.

Abbildung: Entwicklung der Sonnenaktivität während der vergangenen 400 Jahre. Weiße Kurve zeigt solare Gesamtstrahlung (Total Solar Irradiance, TSI), gelbe Ausschläge markieren Sonnenflecken. Quelle: PAGES2K-Webseite, heruntergeladen im März 2016.

———–

AUSSAGE 2:

Mojib Latif am 4. Dezember 2012 in der Talkshow “Pelzig hält sich“:

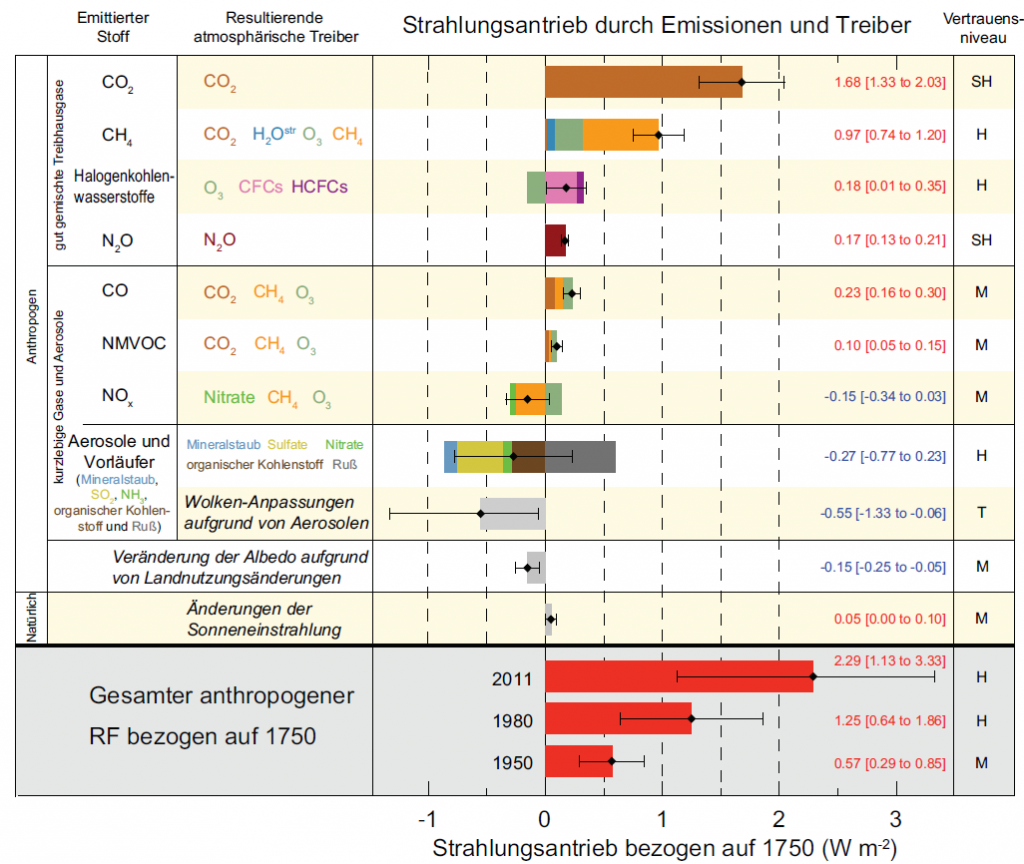

„Ja, das kann man ja alles quantifizieren. Das ist natürlich eine glatte Lüge, wenn behauptet wird, dass wir die Sonne nicht mit berücksichtigen. Es gibt kein Klimamodell, dass die Sonne nicht mitberücksichtigt. Ich meine wir sind ja keine Deppen. Hier wird ja irgendwie der Eindruck erweckt, als wenn wir die größten Vollidioten aller Zeiten sind. So ist es ja nicht.“

Falsch, Herr Latif. Ein Blick auf den Strahlungsantrieb im 5. IPCC-Klimazustandsbericht reicht aus, um zu sehen, dass die Sonne in den Modellen nahezu keinen Einfluss hat. CO2: 1,68 W/m2, Sonne: 0,05 W/m2. Die Sonne spielt damit praktisch keine Rolle.

Abbildung: Strahlungsantrieb der einzelnen Klimafaktoren laut 5. IPCC-Bericht. Die Sonne spielt praktisch keine Rolle beim IPCC.

———–

AUSSAGE 3:

Mojib Latif im Interview mit der Neuen Osnabrücker Zeitung (NOZ) am 12. September 2012:

NOZ: Herr Latif, trägt eher die Sonne zur Erderwärmung bei oder das Treibhausgas Kohlendioxid, CO2?

LATIF: Es ist ein Mix aus beidem. Klar ist, dass der Mensch über die Hälfte des Temperaturanstiegs seit Beginn der Industrialisierung zu verantworten hat.

Zuvor hatte Latif der österreichischen Zeitung ‚Die Presse‘ (DP) am 9. Februar 2012 das Folgende gesagt:

DIE PRESSE: Zurück zur bisherigen Erwärmung, 0,8 Grad seit 100 Jahren. Für Vahrenholt kommt die Hälfte von der Sonne. Und beim IPCC kommt alles vom CO2?

LATIF: Nein, das hat der IPCC nie gesagt, er ist sehr vorsichtig und sagt, dass etwa die Hälfte der Erwärmung anthropogen ist.

DIE PRESSE: Dann sagt er das Gleiche wie Vahrenholt?

LATIF: Ja, das ist es ja, was mich wahnsinnig macht: Da wird ein Popanz aufgebaut und dann genüsslich zerrissen.

Wieder liegt Latif falsch. Hier genügt ein Blick in den neuen Spezialbericht des IPCC zum 1,5-Grad-Ziel:

Den langfristigen Erwärmungstrend seit vorindustriellen Zeiten widerspiegelnd, lag die beobachtete mittlere globale Oberflächentemperatur in dem Jahrzehnt 2006–2015 um 0,87 °C(wahrscheinlich zwischen 0,75 °C und 0,99 °C) höher als der Durchschnitt für den Zeitraum 1850–1900 (sehr hohes Vertrauen).

Die geschätzte anthropogene globale Erwärmung stimmt mit dem Ausmaß der beobachteten Erwärmung innerhalb von ±20 % (wahrscheinlicher Bereich) überein.

Oder anders ausgedrückt: Die gesamte beobachtete Erwärmung der letzten 150 Jahre ist laut IPCC anthropogen.

———–

Drei Latif-Aussagen, drei Mal voll daneben. Gilt unter diesen Umständen Latifs Kritik an der Kalten Sonne überhaupt noch? Gerne würden wir mit Mojib Latif darüber persönlich sprechen. Ist er nach seiner früheren Verweigerung zur Diskussion jetzt vielleicht gesprächsbereit? Wir hoffen auf gute klimatische Entwicklungen für 2019.

Wir wünschen allen Kalte-Sonne-Bloglesern – und natürlich auch Herrn Latif – einen Guten Rutsch ins neue Jahr.

Die EIKE Redaktion schließt sich diesem Wunsch des kalte Sonne Teams vorbehaltlos an.

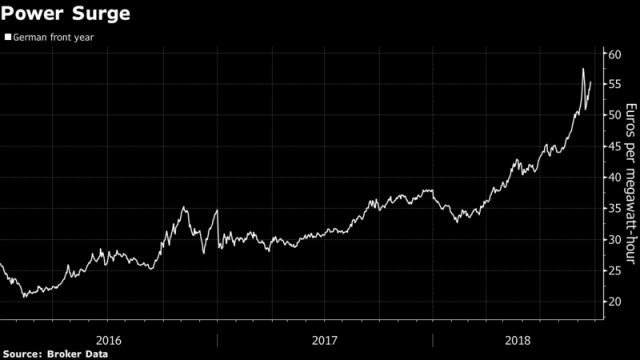

Lehnen Sie sich einen Moment zurück und bedenken Sie, dass die Wind- und Solarindustrie in den letzten 30 Jahren hunderte Milliarden an Subventionen erhalten hat und dass ihre kombinierte Energielieferung jedoch kaum mehr als einen Rundungsfehler der Statistik ausmacht.

Während die Energieausbeute von Wind und Sonne auf globaler Ebene trivial ist, sind die Kosten für die Integration in das Stromnetz dieses erbärmlichen Paares weit von gut-und-böse entfernt.