Joachim Müller-Jung und die „Verpöbelung des Diskurses“

Als Paradebeispiele für „Pseudoexperten, die pausenlos Unsinn verzapfen“ führt Müller-Jung ausgerechnet den pensionierten Mikrobiologen Prof. Sucharit Bhagdi und den jüdischen Chemie-Nobelpreisträger Michael Levitt an.

Prof. Bhagdi ist in Deutschland bekannt geworden durch das Büchlein „Corona Fehlalarm?“, das er zusammen mit seiner Ehefrau, der Biochemikerin Prof. Karina Reiss veröffentlicht hat. Dieses gemeinverständlich abgefasste Büchlein hält sich nun schon seit etlichen Wochen auf dem ersten Platz der Sachbuch-Bestseller-Liste des SPIEGEL. Doch geht Müller-Jung mit keinem Wort auf die dort mit eindrucksvollen Kurven belegten Argumente ein. Vielmehr entrüstet er sich darüber, dass Prof. Bhagdi kürzlich in einem inzwischen von YouTube gelöschten Video die inzwischen mancherorts eingeführte Maskenpflicht für Schulkinder als „Kindesmisshandlung“ brandmarkt und darauf hinweist, dass es in Deutschland seit Wochen keine neuen Fälle von Covid-19-Erkrankung mehr gibt. Doch Prof. Bhagdi belegte diese Aussage mit den laufenden Berichten über Lungen-Infektionen, die die die Sentinel-Arztpraxen an das regierungsamtliche Robert-Koch-Institut (RKI) senden. Darin finden sich keine Hinweise auf SARS-CoV-2 mehr, dafür aber immer mehr Hinweise auf Rhinoviren, die offenbar von der Maskenpflicht profitieren.

Wie unterscheidet Müller-Jung zwischen Experten und Pseudoexperten? Unter den letztgenannten versteht er „Verschwörungstheoretiker von höherer akademischer Warte“, die sich an der „Verpöbelung des Diskurses“ beteiligen, indem sie die Rechtfertigung der Aufhebung bürgerlicher Freiheitsrechte und die Infragestellung der Menschenwürde durch den „Lockdown“ in Zweifel ziehen. Dabei scheint es Müller-Jung durchaus bewusst zu sein, dass Naturwissenschaft und Medizin grundsätzlich nur mehr oder weniger provisorisches Vermutungswissen produzieren können. Er weigert sich aber, daraus den Schluss zu ziehen, dass es in einer Welt, in der (fast) alles Wissen provisorisch bleibt, idealerweise nur revidierbare Entscheidungen geben sollte. In einem freiheitlichen, lernfähigen Gemeinwesen sollte es also keine „Klimapolitik“ mit einem bis 2050 gesetzlich festgelegten Fahrplan geben können. Es sollte auch keinen „Lockdown“ mit unabsehbaren gesundheitlichen und wirtschaftlichen Folgen geben können. Denn beide Entscheidungen stützen sich auf mehr als wackelige Hypothesen und Problem-Diagnosen.

Auch gute Wissenschaft wird ideologisch, wenn sie in die Hände von totalitär denkenden Bürokraten fällt. Es war die Idee Jean Monnets, eines der Väter der EU, die europäische Einigung und tendenziell den Weltstaat gänzlich auf die Wissenschaft zu gründen. Die politische Macht sollte immer in der Hand von „Wissenden“ liegen. Demokratische Wahlen waren nur als Dekor gedacht. Wie die EU-Bürokratie hängt offenbar auch unsere Bundesregierung der Illusion an, die Wissenschaft könne beim Menschen die zu schwachen oder fehlenden Instinkte ersetzen, die den Tieren eine optimale Anpassung an ihre Umwelt ermöglichen. Auf welch unsicheren Beinen diese Ideologie des Szientismus steht, hat der weltweit führende Epidemiologe, der Stanford-Professor John P.A. Ioannidis, schon im Jahre 2005 demonstriert, indem er nachwies, dass die meisten Ergebnisse biomedizinischer Forschung nicht reproduzierbar sind.

Was die Menschen über das Tierreich erhebt, ist nicht in erster Linie die Wissenschaft, sondern die Freiheit. Diese ist nach jüdisch-christlicher Auffassung ein Geschenk Gottes in Form der Zehn Gebote. In einem freiheitlichen Gemeinwesen sollte der freiwillige Tausch auf dem Markt (worin sich die Bedürfnisse und Wünsche von Millionen, wenn nicht Milliarden von Menschen widerspiegeln) und nicht irgendeine Wissenschaft (oder Pseudowissenschaft) die wichtigste Grundlage für individuelle und kollektive Entscheidungen sein. In den positiven und negativen Signalen, die der Markt liefert, manifestiert sich (neben irrationalen Impulsen) auch der gesunde Menschenverstand. Darunter kann man in erster Näherung die Entscheidungen verstehen, die die Menschen mithilfe ihres Stirnhirns zustande bringen. Dazu gehören nicht nur ethische Bewertungen, sondern auch Vergleiche zwischen Kosten und Nutzen und nicht zuletzt Abwägungen zwischen verschiedenen Übeln.

Dergleichen haben die deutschen Behörden nicht einmal ansatzweise durchgeführt, bevor sie am 23. März 2020 ohne Not den „Lockdown“ beschlossen und der Bundestag am 25. März eine „epidemische Lage von nationaler Tragweite“ feststellte. Das zeigt das im Mai 2020 an die Öffentlichkeit gelangte interne Papier eines Referenten des deutschen Bundesinnenministeriums. Der Referent warf den deutschen Behörden vor, nicht im Ansatz eine ganzheitliche Abwägung der Gefahren und Risiken vorgenommen, sondern die Anstrengungen auf eine einzige Aufgabe, die Bekämpfung des Coronavirus durch die Vermehrung von Intensiv-Betten in Krankenhäusern, konzentriert zu haben. Dabei seien die durch das einseitige Krisenmanagement verursachten Todesfälle (etwa von nicht behandelten Krebs- und Herz-Kreislauf-Patienten) schlicht verdrängt worden. Zweieinhalb Millionen Menschen seien nicht medizinisch versorgt worden. Es sei dadurch eine potentielle Lebenszeit im Umfang von mehreren Millionen Jahren geopfert worden. Bei Außenstehenden könne deshalb der Verdacht aufkommen, es gehe gar nicht um die Sicherheit und Gesundheit der Bevölkerung, sondern hauptsächlich um die Akzeptanz der Regierung und der Regierungsparteien (so mein Resümee im „European Scientist“).

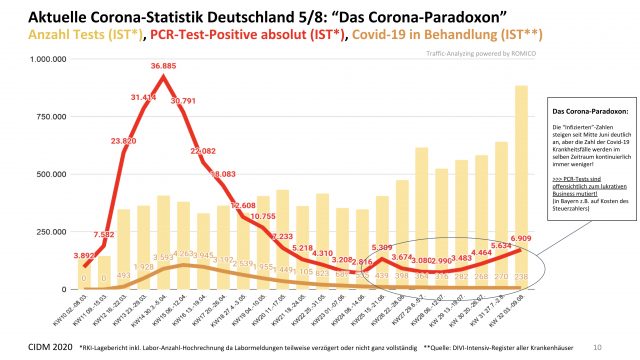

Ergebnisse wissenschaftlicher Forschung können selbstverständlich zum Bestandteil des gesunden Menschenverstandes werden. Sie werden seit den alten Griechen aber auch missbraucht, um dem gemeinen Volk das Maul zu stopfen. So wies der oben zitierte BMI-Referent darauf hin, dass die Entscheidung für den „Lockdown“ auf der Basis „ungeeigneter Informationen“ getroffen wurde. Dazu gehört vor allem die vom RKI in den Vordergrund gerückte Reproduktionszahl R, die ein statistisches Artefakt darstellt, weil die genaue Zahl der Infizierten unbekannt ist und die Zahl der gemeldeten Neuinfektionen in erster Linie eine Funktion der Zahl der durchgeführten PCR-Tests ist. Ausschlaggebend für die Gefahreneinschätzung könne nur die Mortalitätsrate sein, sagte der BMI-Referent. Diese hätte man durch die bei Meinungsumfragen und Wahlprognosen bewährte Stichproben-Technik leicht realistisch abschätzen können. Doch außer bei der umstrittenen „Heinsberg-Studie“ der Bonner Professoren Hendrik Streek und Gunther Hartmann im Bundesland Nordrhein-Westfalen, die im Hotspot Gangelt im Kreis Heinsberg eine Infektionssterblichkeit (IFR) von 0,37 Prozent ermittelte (das heißt in der Größenordnung einer mittelschweren Influenzawelle), wurde das gar nicht erst versucht.

Längst überschneidet sich die Quote der positiv Getesteten mit der erwarteten Quote falsch positiver Tests. Man kann also davon ausgehen, dass die Infektionszahlen, mit deren Hilfe regierungsfromme, weil um ihre Jobs zitternde Journalisten dem Publikum tagaus, tagein Angst vor einer „zweiten Corona-Welle“ einflößen, fast ausschließlich falsch positive Testergebnisse widerspiegeln. Die Covid-19-Epidemie ist bei uns seit gut einem Vierteljahr vorbei. Das auszusprechen, ist allerdings zum Tabu geworden, dessen Übertretung einem leicht die Karriere kosten kann. Auch Joachim Müller-Jung geht es offenbar darum, die äußerst kostspielige Fehlentscheidung der Bundesregierung zu vertuschen und mitzuhelfen, den Ausnahmezustand mindestens bis zur nächsten Bundestagswahl im September 2021 aufrecht zu erhalten.