Verlegung der Torpfosten: Klammheimlich definiert das IPCC um, was ,Klima‘ ist

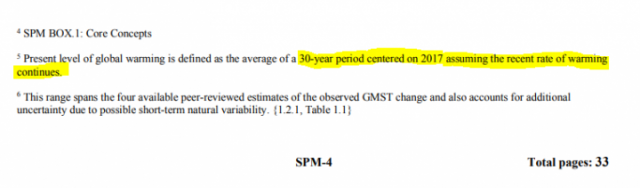

Für seine jüngste Angabe von 1,5 Grad hat das IPCC die Definition von ,Klima‘ verändert zu etwas, das man lose als „das Klima, in dem wir uns befinden“ bezeichnen könnte. Es zieht immer noch den 30-Jahre-Zeitraum für seine Abschätzung der globalen Erwärmung heran und nennt das folgerichtig Klima – aber jetzt sind es die 30 Jahre um den heutigen Tag.

Es gibt einige offensichtliche Probleme mit dieser heimlichen Verschiebung der Torpfosten. Wir haben gemessene Temperaturdaten aus den letzten 15 Jahren, aber natürlich keine einzige Messung aus den kommenden 15 Jahren. Allerdings kann man nun wirklich nicht sagen, dass fehlende Daten irgendein Problem für erfinderische Klimawissenschaftler sind.

Globale Erwärmung wird vom IPCC jetzt als eine spekulative globale Mitteltemperatur über 30 Jahre gehandelt, welche einerseits auf gemessenen globalen Temperaturdaten aus den letzten 15 Jahren beruht, und andererseits auf den vermuteten globalen Temperaturen der nächsten 15 Jahre. Dieser Vorschlag wurde vor dem jüngsten IPCC-Treffen in Incheon, Korea, auf den Tisch gelegt. Er wurde zustimmend als eine vernünftige Sache angesehen, um Klimatrends besser zu kommunizieren. Erstaunlicherweise vermengt diese neue IPCC-Definition reale und empirische Daten mit nicht existenten und spekulativen Daten – und geht dann einfach davon aus, dass sich ein kurzfristiger 15-Jahre-Trend auch während der kommenden 15 Jahre fortsetzen wird.

Allerdings ist diese neue Definition von Klima und globaler Erwärmung nicht nur philosophisch bedenklich, sondern sie ist auch offen für Spekulation und Manipulation. Es ist eine Sache zu spekulieren, wie das zukünftige Klima aussehen könnte; aber es ist eine ganz andere Sache, wenn das IPCC das Klima aufgrund von Daten definiert, die noch gar nicht existieren und nur Erwartungen darüber zur Grundlage hat, dass das Zukünftige einfach nur mit Gefahren befrachtet ist.

Diese Strategie betont die Temperatur der letzten 15 Jahre gleich doppelt, welche keine Extrapolation der Daten aus den 15 Jahren zuvor ist, und deren Verlauf war auch anders als prophezeit. Seit dem Jahr 2000 nämlich hat die Natur uns eine Lektion erteilt, welche das IPCC immer noch nicht gelernt hat.

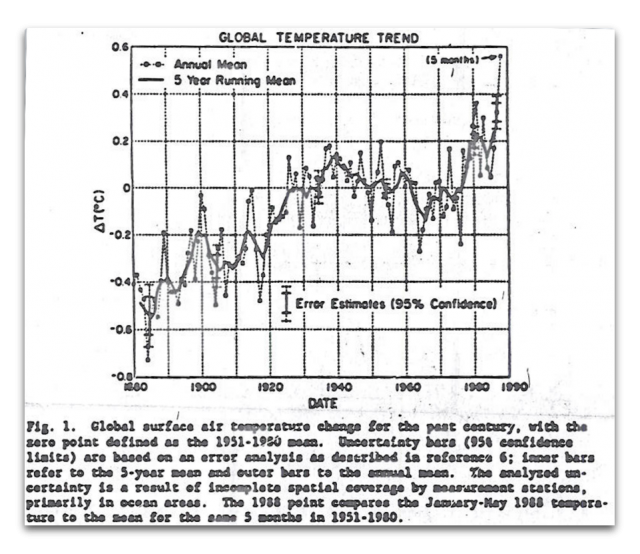

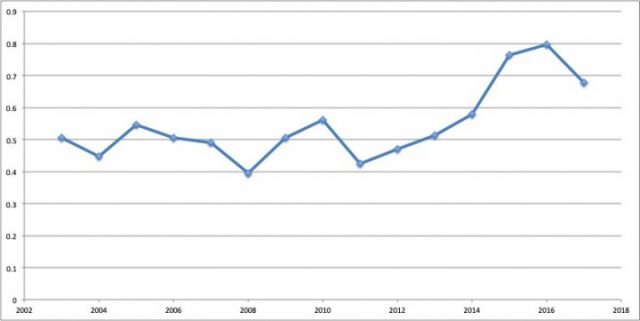

Mit dieser neuen Definition von Klima sind sämtliche Daten aus der Zeit vor den letzten 15 Jahren irrelevant, sind sie doch Teil des Klimas zuvor. Schauen wir mal auf die vergangenen 15 Jahre nach HadCRUT4. Die erste Abbildung zeigt den Zeitraum 2003 bis 2017:

Es ist eine allgemein bekannte Graphik, die keinen Erwärmungstrend zeigt – außer man fügt am Ende den El Nino hinzu, welcher aber natürlich ein Wetterereignis ist und nichts mit Klima zu tun hat. Die Auswirkung des El Nino auf den Trend ist signifikant. Mit Hinzufügung desselben nämlich beträgt der Trend der letzten 15 Jahre etwa 0,15°C pro Jahrzehnt, das liegt nahe dem derzeit mit 0,2°C pro Jahrzehnt angegebenen dekadischen Trend. Vor dem El Nino-Ereignis hatte der Erwärmungstrend jedoch lediglich 0,02°C pro Jahrzehnt betragen, was statistisch völlig insignifikant ist.

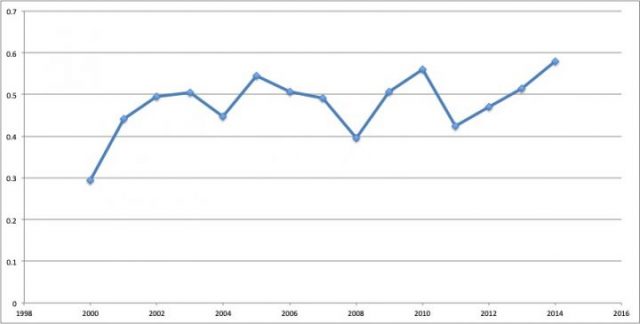

Diese zweite Graphik zeigt den Verlauf über die 15 Jahre vor dem jüngsten El Nino, also von 2000 bis 2014. Der Trend über diesen Zeitraum wird beeinflusst durch den Startzeitpunkt, bei welchem es sich um ein starkes La Nina-Jahr handelt. Ohne diesen beträgt der Trend 0,03°C pro Jahrzehnt – statistisch ebenfalls völlig insignifikant. Man beachte, dass es schwächere El Ninos und La Ninas im Verlauf dieses Zeitraumes gegeben hat, aber insgesamt zeigt sich dabei nur ein geringer Gesamteffekt.

Was also soll man heranziehen? Die El Nino-Version, welcher eine Erwärmung von 0,6°C über die letzten 30 Jahre bis heute zeigt, oder die Nicht-El Nino-Version, die keine signifikante Erwärmung zeigt? Nun, die Letztere natürlich! Trends sollten frei sein von einer Kontamination durch kurrzzeitige Wetterereignisse – ebenso wie sie frei sein sollten von Abnahmen aufgrund von Aerosolen durch Vulkanausbrüche, welche durch Abschirmung des Sonnenlichts eine gewisse Zeit Abkühlung bewirken.

Das gleiche Problem erkennt man in dem 1,5°C-Report des IPCC, wenn dieses das Jahrzehnt 2006 bis 2015 analysiert, was es extensiv tut. In diesem spezifischen Jahrzehnt ist es signifikant wärmer als in den anderen Jahren, und zwar um etwa 0,2°C. Die NOAA sagt dazu: „Die globalen Temperaturen des Jahres 2015 waren stark beeinflusst durch starke El Nino-Bedingungen während jenes Jahres“. Der Temperaturtrend einschließlich des El Nino 2015 beträgt 0,2°C, wieder jene Zukunft. Ohne den El Nino ist der Trend statistisch nicht signifikant.

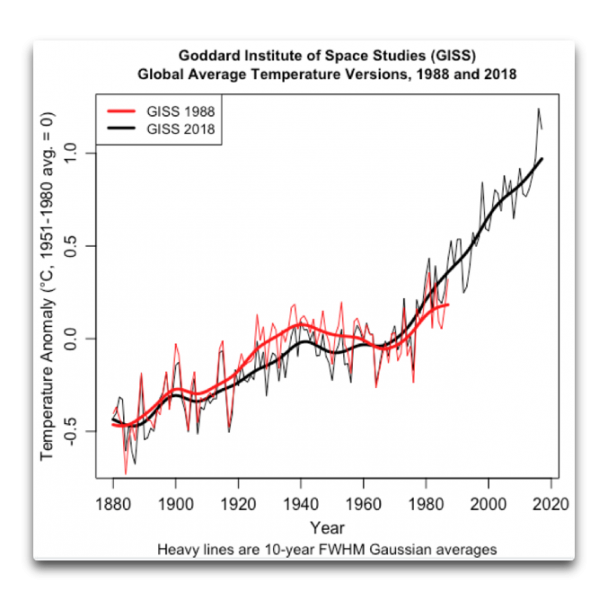

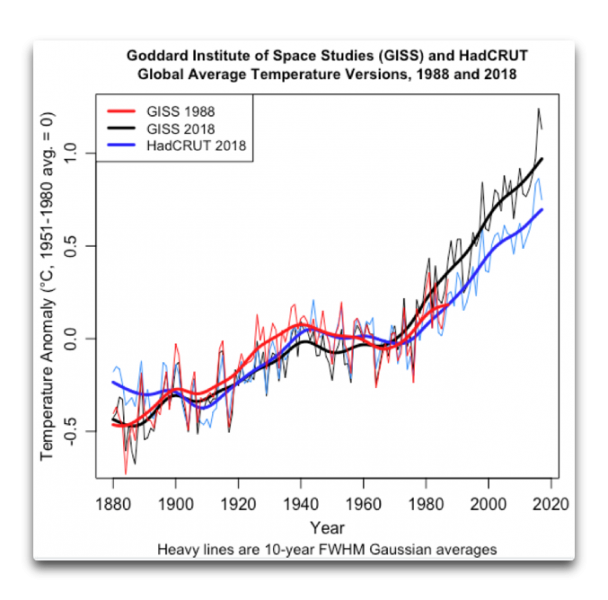

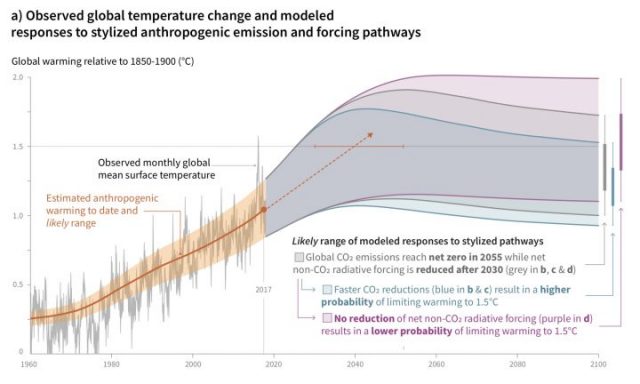

Um die zukünftige Temperatur und das Klima zu sehen, welche das IPCC in seinem Report ins Auge fasst, betrachte man die Abbildung 1 in ihrer Summary for Policymakers:

Der Versuch des IPCC, die Torpfosten zu verschieben, ist höchst fragwürdig. Nicht existierende Daten, extrapoliert über vermutete Temperaturtrends während der nächsten 15 Jahre sollten nicht formaler Bestandteil dessen sein, was Klima konstituiert.

——————————

Aktualisierung: Im befindet sich auf Seite 4 eine Fußnote, welche den falschen Denkansatz des IPCC darstellt:

Übersetzt von Chris Frey EIKE