Wird „Corona“ eine Blaupause für den Klimawandel?

Dabei stellt sich die Frage: Auf welchen Zahlen basieren diese politischen Entscheidungen

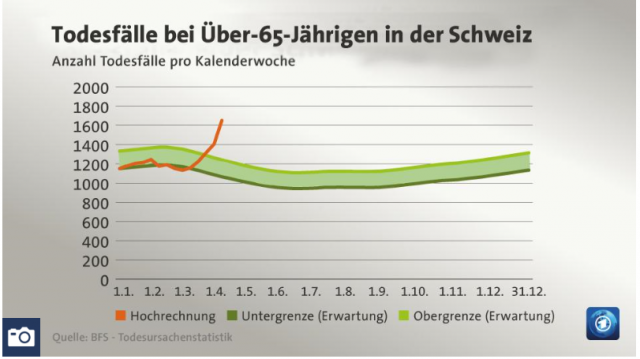

In der Tagesschau vom 17.04. wurde mit inhaltsschweren Worten und der Erklärung, dass wenigstens manche Länder, wie zum Beispiel die Schweiz, schon mehr Zahlen zu Corona veröffentlichen, sowie einer drastisch deutlichen Grafik gezeigt, wie stark die Pandemie die Mortalität in die Höhe treibt und sicherlich noch kein Ende davon erreicht ist.

Eine eindringliche Warnung an das Deutsche Volk, die schlimmen, aber unbedingt erforderlichen Maßnahmen ihrer Führerin – und deren Landesfürsten – einzuhalten, da sie aufgrund solcher Grafiken mit Sicherheit erforderlich sind:

[1] Tagesschau vom 17.04.2020: Das Problem mit der Sterblichkeitsrate

Anomalie in Schweizer Statistik

All dies zeigt, dass es aktuell noch sehr schwierig zu schätzen ist, wie viele Covid-19-Erkrankte sterben. Manche Länder – wie etwa die Schweiz – veröffentlichen jedoch regelmäßig Zahlen aller Todesfälle. Und hier zeigt sich, dass dort seit Mitte März mehr Menschen gestorben sind als in der selben Zeit der Vorjahre.

Auffällig ist der Unterschied vor allem bei den Über-65-Jährigen. In der Woche bis zum 5. April starben in dieser Altersgruppe in der Schweiz mehr als 1650 Menschen. Laut der offiziellen Statistik waren dies etwa 500 mehr, als zu erwarten gewesen sind.

[3] Deutschlandfunk 01. Mai 2020: Coronavirus Übersterblichkeit – Wie tödlich ist das Coronavirus wirklich?

Wie viele Menschen sterben am Coronavirus? Statistiken zur sogenannten Übersterblichkeit können helfen, diese Frage zu beantworten. Doch auch dabei gibt es Probleme – die zum Teil von Kritikern und Aktivisten missbraucht werden.

Ende April sagte der Präsident des Robert Koch-Instituts Lothar Wieler: „Wir gehen eigentlich davon aus, dass mehr Menschen an dem Virus gestorben sind, als eigentlich gemeldet.“ Belastbare Zahlen gebe es dafür noch nicht, aber man beobachte, dass die Übersterblichkeit steige ...Experten hoffen nun, durch Daten zur Übersterblichkeit ein genaueres Bild der Covid-19-Todesfallzahl zu bekommen …

So, wie es kein Ereignis mehr gibt, an dem der schlimme Klimawandel nicht seine bösen Finger im Spiel hat, geschieht in Deutschland nichts mehr, an dem nicht auch das böse Räääächts partizipiert. Und dieses Rääächts macht es ganz perfide, indem es „Zahlen missbrauchen“und dazu an unserer unfehlbaren Kanzlerin Zweifel hegen.

[3] Deutschlandfunk: Vorsicht Missbrauch

… Trotz all solcher Unsicherheiten und statistischer Probleme greifen manche Kritiker der Corona-Einschränkungen einzelne Zahlen heraus, um sie in ihrem Sinne zu missbrauchen. Die frühere CDU-Bundestagsabgeordnete und DDR-Bürgerrechtlerin Vera Lengsfeld, die heute der AfD nahe steht, rief dazu auf, die Maßnahmen zu Corona sofort aufzuheben. Dazu verlinkte sie eine Petition, in der damit argumentiert wird, Covid19 sie nachweislich weniger gefährlich als die Grippe …

„Missbrauchte“ Zahlen

Wer Bild 1 genauer ansieht, liest für die schlimme, rote Linie den Zusatz: „Hochrechnung“.

Nun hat der Autor kürzlich „Rechnungen“ mit Coronazahlen gesichtet und dabei festgestellt, dass man mit den Zahlen vieles kann, nur nicht ihnen – und schon gar nicht den daraus abgeleiteten Berechnungen – auch nur im Ansatz vertrauen:

[2] Eike 21. April 2020: Corona und die Genauigkeit von Statistik

Nun eine kurze Sichtung mit der Fragestellung, ob die Frau Vera Längsfeld nicht doch eher Recht als Unrecht hat.

Zahlen dazu finden sich beim Statistischen Bundesamt. Von deren Homepage kann man sich die Mortalitäten bis zum 05.04.2020 in Tagesauflösung als Excel-Datei laden.

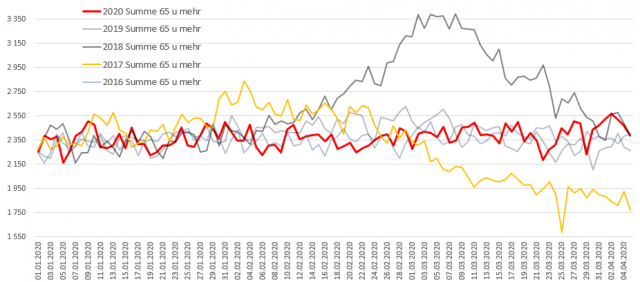

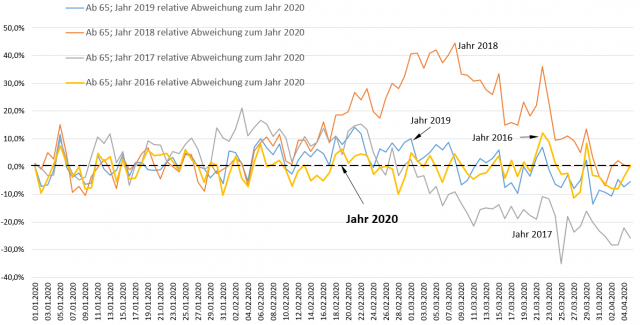

Das nächste Bild zeigt die aus diesem Datensatz erstellte Grafik der täglichen Todeszahlen in auf den 1.1.2020 als Startdatum mit gleichen Startzahlen normierten Jahresverläufen (absolut stimmen also nur die Werte für 2020 (rote Linie) genau) für die Risikogruppe ab 65.

Man vergleiche diese Grafik mit der „Angabe“ in Bild 1:

Nichts, aber auch gar nichts der Aussage aus der Schweiz lässt sich in Deutschlands Daten finden. Nirgendwo die Spur einer Corona-Übersterblichkeit. Allerdings gibt es solche in erheblichem Ausmaß, jedoch vor einigen Jahren, als es niemanden auch nur entfernt interessiert hat.

Man stelle sich vor, die Sterblichkeit des Jahres 2018 müsste aktuell publiziert werden. Der „baldige Tod der gesamten Weltbevölkerung“ würde wohl ausgerufen …

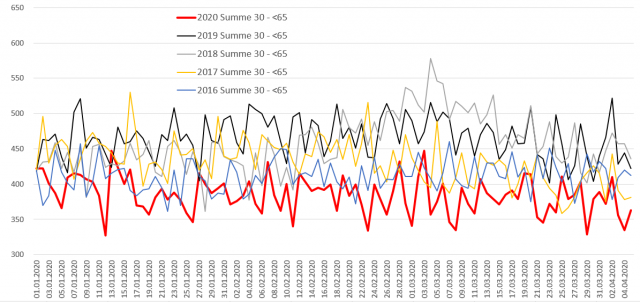

Das gilt genau so, wenn man die Daten für alle Personen unter 65 Jahre betrachtet. „Mit Corona“ ist die Sterblichkeit über den gesamten Zeitraum sogar am Niedrigsten. Auch bei dieser Gruppe liegt „die Schweiz“ katastrophal daneben.

Um direkt zu sehen, wie stark die Sterbezahlen-Verläufe schon über wenige Jahre schwanken – und wie die letzten vier Jahre gegenüber dem „Coronajahr“ 2020 abweichen, eine Differenzdarstellung, ergänzend zum Bild 2:

Weshalb „Blaupause für den Klimawandel“?

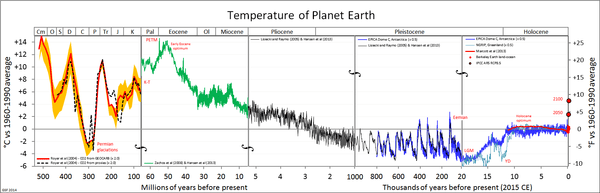

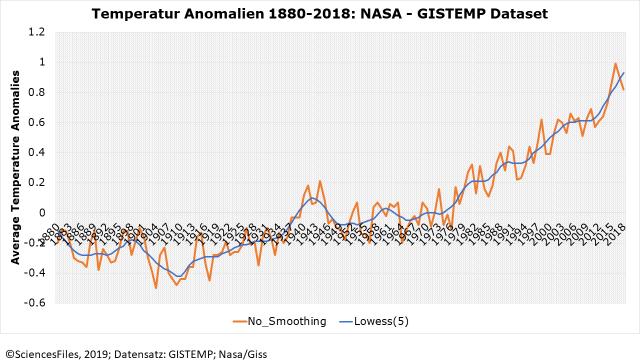

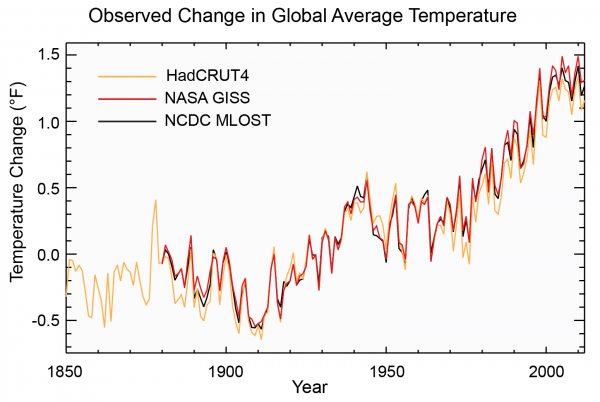

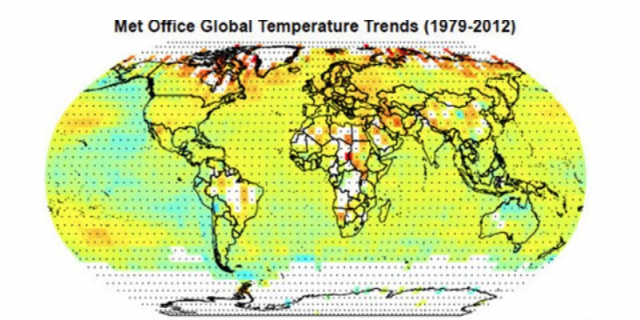

Betrachte man Bild 1 vereinfacht als „Hockeystick“ und die Bilder 2 und 3 als in der Natur gemessen Wirklichkeit. Dann hat man genau die Diskrepanz zwischen Simulationsaussagen und gemessener Wirklichkeit, wie sie der Autor seit vielen Jahren Recherche beim Klimawandel ebenfalls immer neu erkennt. Und man hat genau den gleichen Irrsinn unglaublicher Geldverschwendung aufgrund vollkommen unbrauchbarer, da völlig falscher Simulationsrechnungen. Sogar die Zuweisung von Kritikern als Räääächts ist identisch ….

Und so darf man sich sehr wohl die Frage stellen, ob die Maßnahmen unserer von ihrer Entourage für unfehlbar erklärten Kanzlerin und ihrer Landesfürsten wirklich so sinnvoll sind, auch wenn die Freitagshüpfer und ihre Einflüsterer es ganz toll finden, dass die Wirtschaft endlich kaputt gemacht wird.

Nun ja, inzwischen fordern es auch immer mehr CEOs in Petitionen an Frau Merkel, dass sie bitte auch ihr Geschäft zur Klimaförderung kaputt machen soll …

Man ist mit den (sehr wenigen) vorhandenen Daten überfordert und will auch erst langsam welche gewinnen

Im Monat x mit „Corona“ sollte man meinen, dass unsere Verantwortlichen, welche mit viel, viel Einsatz und Engagement die Wirtschaft und das öffentliche Leben in die Knie gezwungen haben und das Ausgeben von möglichst viel Geld – wie es v. d. Layen mit der EU – die neben dem Retten der Welt vor dem Klima nun parallel die Welt auch vor Corona rettet – weiter betreibt, Interesse an belastbaren Daten hätten.

Doch scheint dem bei Weitem nicht so zu sein. Es ist sicher auch viel angenehmer, zu erfahren, dass Bill Gates unsere Kanzlerin ob dem Krisen(miss)Management lobt und Trump verdammt, als offengelegt zu bekommen, dass unsere Verantwortlichen im Kern immer noch kein wirkliches Wissen zu ihren Entscheidungen vorlegen können.

So scheint die – eher gegen, und schon gar nicht auf Anordnung der Politik – durchgeführte „Heinsberg-Studie“ bisher der einzige Versuch gewesen zu sein, über eine Einwohnerpopulation wenigstens im Ansatz gemessene Stichprobenzahlen zu erhalten.

Anstelle von Unterstützung erfuhr und erfährt diese Maßnahme allerdings weiterhin eher Gegenwind: [5] „ … ein führender Epidemologe äußert sich zurückhaltend … G. K., Leiter der Abteilung Epidemologie am Helmholzzentrum für Infektionsforschung … warnte in einer Videokonferenz davor, die Zahlen auf ganz Deutschland zu übertragen … man könne zum Beispiel argumentieren … insgesamt bezeichnete Krause die Daten der Studie allerdings als sehr überzeugend …“

Wenn untergeordnete Behörden keine Anweisungen „von Oben“ haben, machen sie lieber nichts, als etwas vorbeugend:

[6] … mancher kommt da ins Grübeln. Dennoch bewilligen die Gesundheitsämter keine Tests – nicht einmal dann, wenn deren Partner nachweislich an Corona erkrankt war … es gibt noch ein Problem der Antikörpertests: Die Meistens sind nicht sehr zuverlässig … das bundeseigene Paul-Ehrlich-Institut weist darauf hin, dass es an verbindlichen Standards und unabhängigen Prüfungen fehlt …

Immerhin „startet“ ein Institut langsam:

[6] … Das Robert-Koch-Institut startet in diesen Tagen selbst eine bundesweite Antikörper-Studie …

Wo man längst wichtige Daten generieren könnte, bleiben solche – sofern sie überhaupt erhoben werden – unter Verschluss:

[4] Nordbayerische Nachrichten, Lokalausgabe vom 05.05.2020: Eine Klinik im Ausnahmezustand

Der Kreis Tirschenreuth hat die höchste Corona-Rate in Deutschland. Über 800 Opfer wurden alleine in WEIDEN behandelt … Landkreis Tirschenreuth … nach wie vor das Corona-Epizentrum in Deutschland … Bei über 1,5 % Przent der Bevölkerung des Kreises Tirschenreuth hat das zuständige Gesundheitsamt eine Infektion mit dem Coronavirus registriert … mehr als das Zehnfache der Quote des Kreises Erlangen-Höchstadt …

Wie viele dieser Patienten intensivmedizinisch betreut werden mussten, beziehungsweise müssen ,darüber gibt Kliniksprecher … keine Auskunft. Auch nicht darüber, bei wie vielen Menschen … die Mediziner den Kampf gegen die Folgen des Virus verloren haben …

Dabei wäre eine parallele, fundierte Analyse wie in „Heinsberg“ sicher sehr notwendig gewesen, denn in diesen Landkreisen geschah eigentlich Unfassbares:

[4] Warum hat das Virus gerade diese Region so hart getroffen?

Die Fachleute stehen immer noch vor einem Rätsel: … Mitarbeiter des Robert-Koch-Instituts suchen seit einigen Tagen am Ort des Geschehens nach Antworten … sondern auch die Frage klären, warum die Sterberate in dem oberpfälzischen Landkreis überdurchschnittlich hoch ist … im Bundesdurchschnitt 3,9 % … liegt diese Zahl aktuell bei über 10 % …

Dank an Dr. rer. nat. Hans Penner, der mit einem Infomail mit der Grafik über die Mortalitäten von einem Herrn Seifert die Anregung zu diesem Artikel gab.

Nachtrag

Zu Corona erscheinen fast im Stundentakt neue Nachrichten. Nach der Einpflege dieses Artikels erschien einer auf Achgut mit im Kern dem gleichen Thema:

Achgut 05.05.2020: Der größte Crashtest aller Zeiten

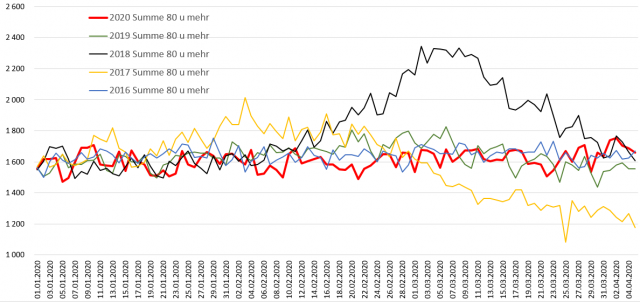

Darin steht, dass vor allem Personen ab 80 Jahren betroffen sind.

Deshalb ergänzend die Mortalität aller Personen ab 80 Jahren:

Bild 4 Deutschland, Personen ab 80. Verlauf der absoluten Sterbezahlen vom 01.01. bis 05.04., Jahre 2016 – 2020. Das „Coronajahr“ 2020 in Rot. Alle Werte auf den Startwert des Jahres 2020 normiert. Grafik vom Autor anhand der Daten des Statistischen Bundesamtes erstellt

Dank an Dr. rer. nat. Hans Penner, der mit einem Infomail mit der Grafik über die Mortalitäten von einem Herrn Seifert die Anregung zu diesem Artikel gab.

Quellen

[1] Tagesschau vom 17.04.2020: Das Problem mit der Sterblichkeitsrate

[2] Eike 21. April 2020: Corona und die Genauigkeit von Statistik

[3] Deutschlandfunk 01. Mai 2020: Coronavirus Übersterblichkeit – Wie tödlich ist das Coronavirus wirklich?

[4] Nordbayerische Nachrichten, Lokalausgabe vom 05.05.2020: Eine Klinik im Ausnahmezustand

[5] Nordbayerische Nachrichten, Lokalausgabe vom 05.05.2020: Mehr Klarheit bei der Dunkelziffer

[6] Nordbayerische Nachrichten, Lokalausgabe vom 05.05.2020: Wer hat schon Antikörper im Blut