Warum Modelle keine Temperatur prognostizieren können: Ein Kaleidoskop des Scheiterns

Allerdings hatte er sich dabei auf – wie sich herausstellte – fehlerhafte Mondspektraldaten verlassen. Als er dies erkannte, rechnete er zehn Jahre später nach und veröffentlichte 1906 eine zweite Arbeit, in der er das tat, was sich Klima-„Wissenschaftler“ heute zu tun strikt weigern: Er widerrief seine erste Arbeit und veröffentlichte eine revidierte Schätzung, diesmal in deutscher Sprache, die von wahrhaft gläubigen Thermageddonisten nur selten zitiert wird:

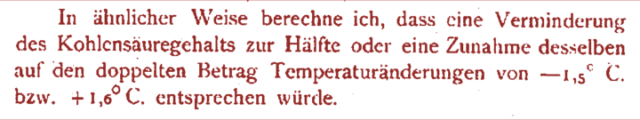

Seine korrigierte Berechnung, die in dem damals neu gegründeten Journal of the Royal Nobel Institute veröffentlicht wurde, schlug 1,6 C° ECS vor, einschließlich der Wasserdampf-Rückkopplung.

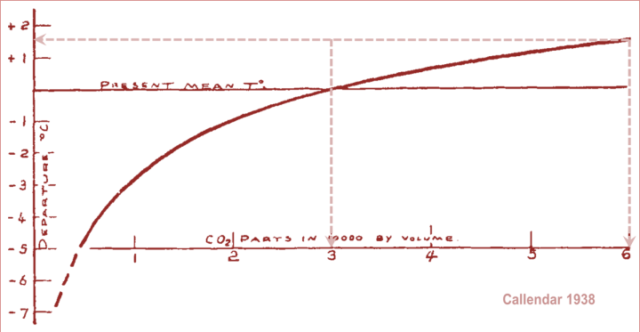

Guy Stewart Callendar, ein britischer Dampfingenieur, veröffentlichte 1938 seine eigene Berechnung und präsentierte sein Ergebnis vor der Royal Society (die anschließende Diskussion in der Gesellschaft ist sehr lesenswert). Auch er sagte 1,6 C° ECS voraus, wie die gestrichelten Linien zeigen, die ich seiner Grafik hinzugefügt habe:

Dann gab es einen plötzlichen Sprung in der vorhergesagten ECS. Plass (1956) sagte 3,6 C° ECS voraus. Möller (1963) sagte eine direkte oder Referenz-CO2-Verdoppelungssensitivität (RCS) von 1,5 C° voraus, die auf bis zu 9,6 C° anstieg, wenn sich die relative Feuchte nicht veränderte. Er fügte einen wichtigen Zusatz hinzu: „…die Veränderung des Strahlungsbudgets durch eine veränderte CO2-Konzentration kann vollständig ohne Veränderung der Oberflächentemperatur kompensiert werden, wenn die Bewölkung um +0,006 erhöht wird.“ Es überrascht nicht, dass er zu dem Schluss kam, dass „die Theorie, dass klimatische Variationen durch Variationen des CO2-Gehalts bewirkt werden, sehr fragwürdig wird.“

[Hervorhebung im Original]

Manabe & Wetherald (1975), die ein frühes radiativ-konvektives Modell verwendeten, sagten 2,3°C ECS voraus. Hansen (1981) gab eine mittlere Schätzung von 2,8°C° ECS an. Im Jahr 1984 kehrte er zu dem Thema zurück und führte zum ersten Mal die Rückkopplungsformel aus der Regelungstheorie ein, dem Studium der Rückkopplungsprozesse in dynamischen Systemen (Systeme, die ihren Zustand über die Zeit verändern). Er sagte 1,2°C RCS und 4°C ECS voraus, was einen Rückkopplungsanteil von 0,7 impliziert.

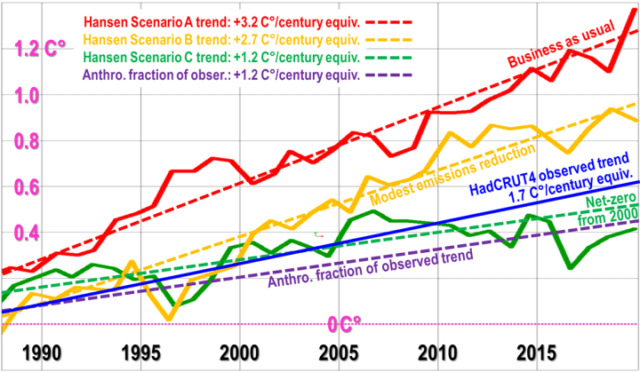

Im Jahr 1988 sagte er in seiner inzwischen berüchtigten Aussage vor dem US-Senat in einem Juni, der so heiß war, wie es in Washington DC seither nicht mehr der Fall war, 3,2°C pro Jahrhundert voraus (was in etwa dem ECS entspricht), bei einem Business-as-usual-Szenario (und es ist das Business-as-usual-Szenario, das seither eingetreten ist), aber die tatsächliche Erwärmung beträgt kaum mehr als ein Drittel der von ihm vorhergesagten Business-as-usual-Rate:

Im Jahr 1988 kehrte der verstorbene Michael Schlesinger zum Thema Temperaturrückkopplung zurück und fand heraus, dass in einem typischen allgemeinen Zirkulationsmodell der Rückkopplungsanteil – d. h. der Anteil der Gleichgewichtsempfindlichkeit, der durch die Rückkopplungsreaktion beigetragen wird – ein absurd hoher Wert von 0,71 war, was einen Systemgewinnfaktor (das Verhältnis der Gleichgewichtsempfindlichkeit nach der Rückkopplung zur Referenzempfindlichkeit davor) von 3,5 und somit, unter der Annahme von 1,05 RCS, einen ECS von 3,6 C° bedeutet.

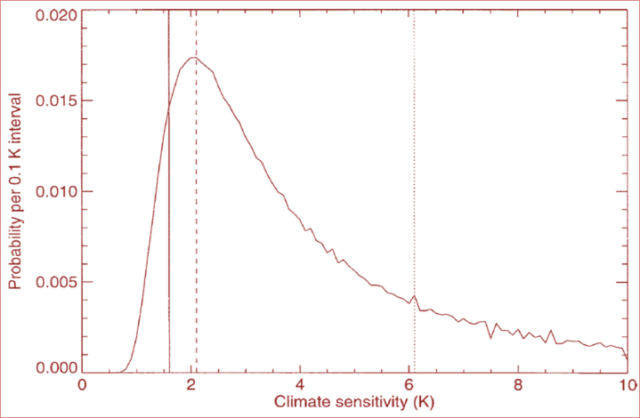

Gregory et al. (2002) stellten eine vereinfachte Methode zur Ableitung der ECS unter Verwendung einer Energiebilanzmethode vor. Energiebilanzmethoden gab es schon seit einiger Zeit, aber erst in den frühen 2000er Jahren wurden die Satelliten- und Ozeandaten zuverlässig und umfassend genug, um diese einfache Methode anzuwenden. Gregory generierte eine Wahrscheinlichkeitsverteilung, die stark rechts-verschoben ist (aus einem Grund, der später deutlich wird), mit einer mittleren Schätzung von 2 C° ECS:

Auf Gregorys Ergebnis folgten viele weitere Arbeiten, die die Energiebilanzmethode verwendeten. Die meisten von ihnen finden, dass ECS 1,5-2 C° beträgt, ein Drittel bis die Hälfte des mittleren Bereichs von 3,7-4 C°, den die aktuellen allgemeinen Zirkulationsmodelle vorhersagen.

Im Jahr 2010 schrieben Lacis et al. in Anlehnung an die Methode der GCMs:

„Für den verdoppelten CO2-Einstrahlungsantrieb, … für den die direkte, nicht rückgekoppelte Antwort der globalen Oberflächentemperatur 1,2 C° beträgt …, impliziert die ~4 C° Oberflächenerwärmung [einen] … [Systemverstärkungsfaktor] von 3,3. …“

Lacis et al. fuhren fort zu erklären, warum sie dachten, dass es einen so großen Systemverstärkungsfaktor geben würde, der einen Rückkopplungsanteil von 0,7 impliziert:

Nicht kondensierende Treibhausgase, die 25 % des gesamten terrestrischen Treibhauseffekts ausmachen, … sorgen für die stabile Temperaturstruktur, die das derzeitige Niveau des atmosphärischen Wasserdampfs und der Wolken über Rückkopplungsprozesse aufrechterhält, die die restlichen 75 % des Treibhauseffekts ausmachen.

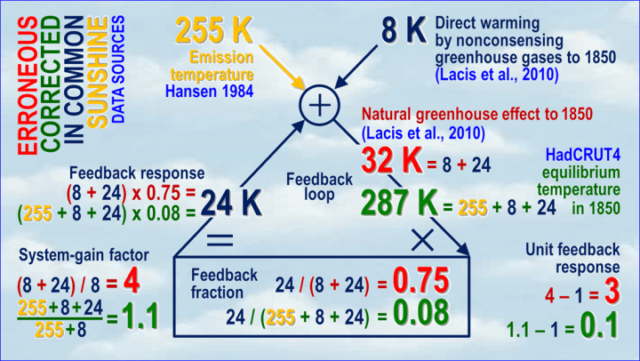

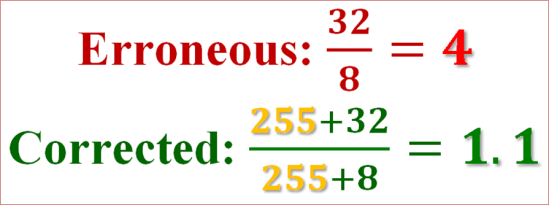

Leider wird in der obigen Passage explizit ein außerordentlicher, in der gesamten Klimatologie universeller Fehler begangen, der der Grund dafür ist, dass die Modellierer eine weitaus größere Erwärmung erwarten – was daher auch ihre Modelle simulieren – als es die direkte und einfache Energiebilanzmethode nahelegen würde. Das einfache Blockdiagramm unten demonstriert den Fehler, indem es die fehlerhaften (rot) mit den korrigierten (grün) Werten in der gesamten Schleife vergleicht:

Werfen wir einen Blick auf die Rückkopplungsschleife für das vorindustrielle Zeitalter. Wir untersuchen die vorindustrielle Ära, denn als die Modellierer zum ersten Mal versuchten, den Einfluss des Wasserdampfs und anderer Rückkopplungen abzuschätzen, von denen keine direkt und zuverlässig durch Messung oder Beobachtung quantifiziert werden kann, begannen sie mit der vorindustriellen Ära.

Zum Beispiel sagt Hansen (1984):

„… diese Voraussetzung der Energiebilanz ergibt eine [Emissionstemperatur] von etwa 255 K. … die Oberflächentemperatur ist etwa 288 K, 33 K wärmer als die Emissionstemperatur. … Die gleichgewichtige globale mittlere Erwärmung der Oberflächenluft beträgt etwa 4°C … Dies entspricht einem [Systemgewinnfaktor] von 3-4, da die zur Wiederherstellung des Strahlungsgleichgewichts mit dem Weltraum erforderliche rückkopplungsfreie Temperaturänderung 1,2-1,3°C beträgt.“

Lassen Sie uns zunächst den Kreislauf der Klimatologie durchlaufen. Die direkte Erwärmung durch vorindustrielle, nicht kondensierende Treibhausgase (das kondensierende Gas Wasserdampf wird als Rückkopplung behandelt) beträgt etwa 8 K, aber der gesamte natürliche Treibhauseffekt, die Differenz zwischen der 255 K hohen Emissionstemperatur und der 287 K hohen mittleren globalen Oberflächentemperatur im Jahr 1850, beträgt 32 K. Daher ist der Systemgewinnfaktor der Klimatologie 32 / 8 oder 4, so dass ihr imaginärer Rückkopplungsanteil 1 – 1/4 oder 0,75 beträgt – wiederum absurd hoch. Somit würde aus 1 K RCS 4 K ECS werden.

Gehen wir nun den Weg der Regelkreistheorie, der zuerst von Black (1934) in den Bell Labs in New York bewiesen und in der Praxis lange und schlüssig verifiziert wurde. Man muss nicht nur die vorindustrielle Referenzsensitivität gegenüber nicht kondensierenden Treibhausgasen über den summativen Ein-/Ausgangsknoten am Scheitelpunkt der Schleife in die Schleife eingeben: man muss auch die 255 K Emissionstemperatur (gelb) eingeben, die als Eingangssignal bekannt ist (der Hinweis steckt im Namen).

Es ist die Sonne, Dummkopf!

Dann ist der Ausgang des Kreislaufs nicht mehr nur der natürliche Treibhauseffekt von 32 K: Es ist die globale mittlere Oberflächentemperatur im Gleichgewicht von 287 K im Jahr 1850. Der Systemgewinnfaktor ist dann 287 / (255 + 32), oder 1,09, weniger als ein Drittel der Schätzung der Klimatologie. Der Rückkopplungsanteil ist 1 – 1 / 1,09, oder 0,08, also um eine Größenordnung kleiner als die Schätzung der Klimatologie.

Daher gibt es im Gegensatz zu dem, was Hansen, Schlesinger, Lacis und viele andere sich vorstellen, keinen guten Grund in den vorindustriellen Daten zu erwarten, dass die Rückkopplung auf der Erde in ihrer Größenordnung einzigartig im Sonnensystem ist, oder dass ECS so etwas wie das imaginäre Drei- oder Vierfache von RCS sein wird.

Wie aus dem Zitat von Lacis et al. ersichtlich ist, geht die Klimatologie in der Tat davon aus, dass der System-Gain-Faktor im Industriezeitalter etwa gleich groß sein wird wie der für das vorindustrielle Zeitalter. Daher ist das übliche Argument gegen die korrigierte vorindustrielle Berechnung – dass sie keine Inkonstanz der Rückkopplungsantwort der Einheit mit der Temperatur berücksichtigt – nicht relevant.

Darüber hinaus kommt eine einfache Energiebilanzberechnung des ECS unter Verwendung aktueller Mainstream-Daten aus der Industriezeit in einem Verfahren, das sich völlig von der vorindustriellen Analyse unterscheidet und in keiner Weise von ihr abhängig ist, zu demselben Ergebnis kommt wie das korrigierte vorindustrielle Verfahren: ein vernachlässigbarer Beitrag der Rückkopplungsreaktion. Demnach ist die Rückkopplungsreaktion der Einheit annähernd konstant mit der Temperatur, und ECS ist kaum mehr als die 1,05 K RCS.

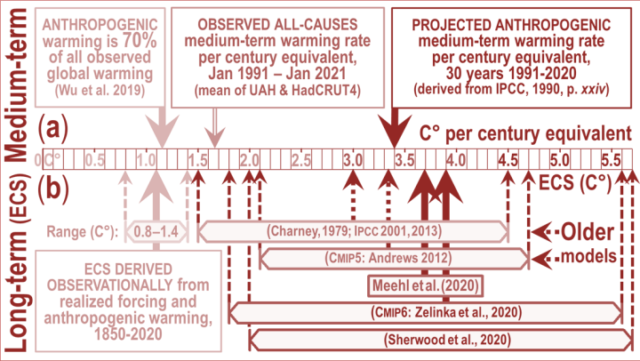

Warum also liegen die Modelle mit ihren Vorhersagen so falsch? Mittelfristig (oben im Diagramm unten) betrug die mittelfristig projizierte anthropogene Erwärmung pro Jahrhundertäquivalent 3,4 K, wie vom IPCC 1990 vorhergesagt, aber die beobachtete Erwärmung betrug nur 1,65 K, wovon nur 70% (Wu et al. 2019) oder 1,15 K anthropogen waren. Die Vorhersage des IPCC war also etwa dreimal so hoch wie die nachträgliche Beobachtung, was mit dem Fehler, aber nicht mit der Realität übereinstimmt.

Da der gegenwärtig geschätzte verdoppelte CO2-Strahlungsantrieb in etwa dem vorhergesagten Strahlungsantrieb aus allen anthropogenen Quellen für das 21. Jahrhundert entspricht, kann man in der neuesten Generation von Modellen die gleiche dreifache Übertreibung im Vergleich zu den 1,1 K ECS beobachten, die sich aus den aktuellen Klimadaten (untere Hälfte des obigen Diagramms) ableiten lassen, einschließlich der realen Erwärmung und des Strahlungsungleichgewichts, und zwar über die Energiebilanzmethode.

Der Fehler, die große Rückkopplungsreaktion auf die Emissionstemperatur zu vernachlässigen und sie somit effektiv zu der eigentlich winzigen Rückkopplungsreaktion auf die direkte Treibhausgas-Erwärmung zu addieren und falsch zu zählen, ist elementar und schwerwiegend. Dennoch scheint es in der gesamten Klimatologie universell zu sein. Hier sind nur ein paar Aussagen davon:

[Es folgen diese Statements, auf deren Übersetzung hier verzichtet wird. Sie gehen alle in die gleiche Richtung und untermauern Moncktons Vorwurf. A. d. Übers.]

Die Auswirkung des Fehlers ist in der Tat drastisch. Der Systemgewinnfaktor und damit der ECS wird um das Drei- bis Vierfache überschätzt; der Rückkopplungsanteil wird um das Zehnfache überschätzt; und die Einheitsrückkopplung (d.h. die Rückkopplungsantwort pro Grad direkter Erwärmung vor Berücksichtigung der Rückkopplung) wird im mittleren Bereich um das 30-fache und am oberen Rand der Modellvorhersagen um das 100-fache überschätzt.

[Hervorhebungen im Original]

Der Fehler kann sehr einfach verstanden werden, wenn man sich anschaut, wie die Klimatologie und die Regelungstheorie den Systemverstärkungsfaktor auf der Grundlage vorindustrieller Daten berechnen würden:

Da RCS kaum mehr als 1 K beträgt, ist ECS, nachdem die Sonnenscheintemperatur von 255 K zur Glättung von Zähler und Nenner der Klimatologie hinzugefügt wurde, kaum mehr als der Systemgewinnfaktor. Und das ist das Ende des „Klimanotstands“. Es war alles ein Irrtum.

Natürlich wird die Rückkopplungsformel in den Modellen nicht direkt berücksichtigt. Rückkopplungen werden ex post facto aus ihren Outputs diagnostiziert. Kürzlich sagte ein angesehener skeptischer Klimatologe mit Blick auf unser Ergebnis, dass wir aus der Diskrepanz zwischen den ECS-Schätzungen der Modelle und unseren eigenen hätten erkennen müssen, dass wir falsch liegen müssen, weil die Modelle das Klima perfekt abbilden.

Es erweist sich sicherlich als nicht weniger schwierig, den Skeptikern den Fehler der Regelungstheorie zu erklären als der totalitären Fraktion, die von diesem Fehler so mächtig profitiert. Hier ist also, wie unser angesehener Co-Autor, ein führender Professor für Regelungstheorie, es ausdrückt:

Natürliche Größen sind, was sie sind. Eine Größe als die Summe aus einem Basissignal und dessen Störung zu definieren, ist ein vom Beobachter geschaffenes Modell. Wenn das Basissignal – analog zum Eingangssignal in einer elektronischen Schaltung – willkürlich gewählt wird, hört die Störung (die Differenz zwischen der willkürlich gewählten Basislinie und der Größe, die die Summe aus Basislinie und Störung ist) auf, eine reale, physikalische Größe zu sein: Sie ist lediglich ein Artefakt eines Konstrukts, das eine physikalische Größe willkürlich in mehrere Komponenten aufteilt. Das reale System kümmert sich jedoch nicht um die Modelle, die von seinem Beobachter erstellt werden. Dies lässt sich leicht an der wichtigsten Rückkopplungsschleife von allen demonstrieren, der Wasserdampf-Rückkopplung, bei der die Erwärmung dazu führt, dass Wasser verdunstet und der entstehende Wasserdampf, ein Treibhausgas, eine zusätzliche Erwärmung erzwingt.

Die Klimatologie definiert die Rückkopplung so, dass nur die Störung – nicht aber auch das Basissignal, die Emissionstemperatur – die Rückkopplung auslöst. Die Implikation ist, dass in der Sicht der Klimatologen die Sonne kein Wasser verdunstet. In ihren Modellen verdunstet die gesamte Sonneneinstrahlung von 1363,5 W/m² kein einziges Wassermolekül, während die Erwärmung, die durch nur 25 W/m² des vorindustriellen Antriebs durch nicht kondensierende Treibhausgase verursacht wird, allein für die gesamte natürlich vorkommende Verdunstung von Wasser auf der Erde verantwortlich ist. Dies ist offensichtlicher Unsinn. Wasser kümmert sich weder um die Quelle der Wärme, die es verdunstet, noch um die fehlerhaften Definitionen der Klimatologie für Rückkopplungen. Im Modell der Klimatologie würde die Wasserdampf-Rückkopplung aufhören zu funktionieren, wenn alle Treibhausgase aus der Atmosphäre entfernt würden. Die Sonne würde durch ihre Emissionstemperatur kein einziges Wassermolekül verdampfen, denn nach der Definition der Klimatologen verdampft Sonnenschein kein Wasser.

Wärme ist immer die gleiche physikalische Größe, unabhängig von der Quelle der Wärme. Der Zustand eines Systems kann durch die darin enthaltene Wärmeenergie beschrieben werden, unabhängig von der Quelle der Wärme. Temperatur-induzierte Rückkopplungen werden durch verschiedene Wärmequellen ausgelöst. Die Sonne ist die größte dieser Quellen. Die Wärme aus der Sonneneinstrahlung folgt genau den gleichen Naturgesetzen wie die Wärme aus dem Treibhauseffekt. Alles, was bei der Analyse des Verhaltens eines physikalischen Systems zählt, ist der Gesamtwärmeinhalt, nicht seine ursprüngliche Quelle oder Quellen.

Die Modelle der Klimatologie spiegeln diese Tatsache nicht wider. Ein Modell eines natürlichen Systems muss die inneren Abläufe dieses Systems widerspiegeln, die nicht durch irgendeinen „Konsens“ wegdefiniert werden dürfen. Der Maßstab für ein gutes Modell eines realen Systems ist nicht „Konsens“, sondern die objektive Realität. Die Funktionsweise eines Rückkopplungs-Verstärkers in einem dynamischen System wie dem Klima (ein dynamisches System ist ein System, das seinen Zustand im Laufe der Zeit ändert) ist seit langem theoretisch bewiesen und wurde wiederholt in realen Anwendungen demonstriert, wie z. B. in den Steuerungssystemen für Kraftwerke, Space Shuttles, den Fliegen auf den Saphirwellen von Kirchturmuhren, den Reglern von Dampfmaschinen und der erhöhten spezifischen Luftfeuchtigkeit bei wärmerem Wetter im Klima und den Systemen, die uns zum Mond gebracht haben.

Jeder Regelungstheoretiker, dem wir unsere Ergebnisse gezeigt haben, hat die Sache sofort kapiert. Jeder Klimatologe – ob Skeptiker oder Thermagedonist – hat sich unangenehm verrenkt. Denn die Regelungstheorie liegt genau außerhalb der Kompetenz und Komfortzone der Klimatologie.

Lassen Sie uns also mit einer Untersuchung darüber enden, warum die „perfekten“ Modelle in Wirklichkeit und formal völlig unfähig sind, uns irgendetwas Nützliches darüber zu sagen, wie viel globale Erwärmung unsere Industrien und Unternehmen verursachen könnten.

Die Modelle versuchen, die Navier-Stokes-Gleichungen mithilfe der numerischen Strömungsmechanik für Zellen von typischerweise 100 km x 100 km x 1 km in einer Reihe von Zeitschritten zu lösen. In Anbetracht der Erdoberfläche und der Tiefe der Troposphäre müssen die Gleichungen immer und immer wieder, Zeitschritt für Zeitschritt, für jede von etwa einer halben Million solcher Zellen gelöst werden – in denen viele der relevanten Prozesse, wie z. B. die Bildung von Kondensationskernen nach der Svensmark-Theorie, auf der Sub-Grid-Skala stattfinden und von den Modellen überhaupt nicht erfasst werden.

Nun sind die Navier-Stokes-Gleichungen notorisch widerspenstige partielle Differentialgleichungen: tatsächlich so widerspenstig, dass noch keine Lösungen in geschlossener Form gefunden wurden. Sie können nur numerisch gelöst werden, und gerade weil es keine Lösungen in geschlossener Form gibt, kann man nicht sicher sein, dass die numerischen Lösungen keine Fehler enthalten.

…

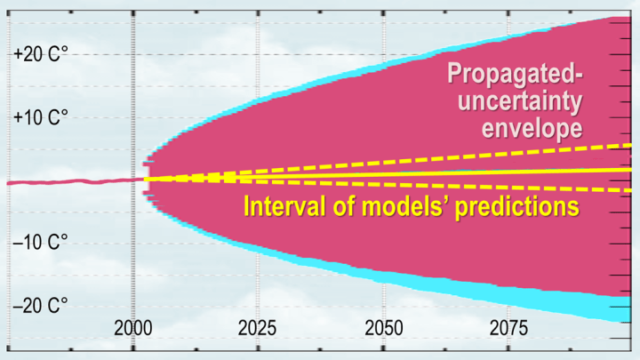

Es gibt eine weitere große Schwierigkeit mit Modellen, die in einer Reihe von Zeitschritten ablaufen. Wie Pat Frank vor zwei Jahren in einem bahnbrechenden Papier von großer Genialität und Auffassungsgabe zum ersten Mal dargelegt hat – ein Papier übrigens, das bisher noch keine von Fachleuten begutachtete Widerlegung erfahren hat – macht die Ausbreitung der Unsicherheit durch die Zeitschritte der Modelle sie formal unfähig, uns irgendetwas darüber zu sagen, wie viel oder wie wenig globale Erwärmung wir verursachen könnten. Was auch immer die Modelle sonst noch für einen Nutzen haben mögen, ihre Vorhersagen zur globalen Erwärmung sind reine Vermutungen und völlig wertlos.

Ein Problem ist, dass die Unsicherheiten in den Schlüsselvariablen so viel größer sind als das winzige mittlere anthropogene Signal von weniger als 0,04 Watt pro Quadratmeter und Jahr. Zum Beispiel unterliegt der wolkenarme Anteil einer jährlichen Unsicherheit von 4 Watt pro Quadratmeter (abgeleitet durch Mittelwertbildung über 20 Jahre). Da die Ausbreitung von Unsicherheiten in Quadratur erfolgt, breitet sich diese eine Unsicherheit so aus, dass sie für sich allein eine Unsicherheits-Bandbreite von ±15 bis ±20 °C über ein Jahrhundert ergibt. Und es gibt viele, viele solcher Unsicherheiten.

Daher ist jede Vorhersage auf der Hundertjahresskala, die in diesen Bereich der Unsicherheit fällt, nichts weiter als eine aus der Luft gegriffene Vermutung. Hier sieht man, wie die Unsicherheitsausbreitung dieser einen Variable in nur einem Modell aussieht. Das gesamte Intervall der CMIP6 ECS-Projektionen liegt deutlich innerhalb der Unsicherheits-Bandbreite und sagt uns daher nichts – gar nichts – darüber, wie viel Erwärmung wir verursachen könnten.

Pat hatte die gleichen Schwierigkeiten wie wir, Skeptiker und Thermageddonisten gleichermaßen von seiner Richtigkeit zu überzeugen. Als ich ihn das erste Mal sah, wie er einen erstklassigen Vortrag zu diesem Thema hielt, auf dem Treffen der World Federation of Scientists in Erice auf Sizilien im Jahr 2016, wurde er von Wissenschaftlern auf beiden Seiten in einer skandalös bösartigen und ignoranten Art und Weise niedergebrüllt, die an die grobe Misshandlung von Henrik Svensmark durch die profitgierigen Rohlinge der einst so angesehenen Royal Society vor einigen Jahren erinnert.

Hier sind nur einige der unsinnigen Antworten, mit denen Pat Frank in den letzten paar Jahren seit der Veröffentlichung zu tun hatte, und davor von Gutachtern bei mehreren Zeitschriften, die einfach nicht bereit waren, ein so bahnbrechendes Ergebnis zu veröffentlichen:

Fast alle Gutachter von Dr. Franks Arbeit a) kannten den Unterschied zwischen Genauigkeit und Präzision nicht; b) verstanden nicht, dass eine Temperaturunsicherheit kein physikalisches Temperaturintervall ist; c) erkannten nicht, dass die Ableitung einer Unsicherheit zur Bedingung einer projizierten Temperatur nicht impliziert, dass das Modell selbst zwischen Eishaus- und Treibhaus-Klimavorhersagen oszilliert [ein tatsächlicher Einwand eines Gutachters]; d) behandelte die Fortpflanzung der Unsicherheit, eine statistische Standardmethode, als ein fremdes Konzept; e) verstand nicht den Zweck oder die Bedeutung eines Kalibrierungsexperiments; f) verstand nicht das Konzept der instrumentellen oder Modellauflösung oder deren empirische Grenzen; g) verstand überhaupt nicht die physikalische Unsicherheitsanalyse; h) erkannte nicht einmal, dass ±n nicht dasselbe ist wie +n; i) erkannte nicht, dass die Unsicherheit von ± 4 W/m² im Wolkenantrieb ein jährlicher Mittelwert war, der aus den Daten von 20 Jahren abgeleitet wurde; j) verstand nicht den Unterschied zwischen dem Basiszustandsfehler, dem räumlichen Effektivwertfehler und dem globalen Netto-Mittelwertfehler; k) erkannte nicht, dass die Bildung des Mittelwerts der Unsicherheiten die Vorzeichen der Fehler aufhebt und das wahre Ausmaß der Unsicherheit verbirgt; l) erkannte nicht, dass die Gewohnheit der Klimamodellierer, Differenzen gegenüber einem Basiszustand zu bilden, die Unsicherheit nicht abzieht; m) stellte sich vor, dass ein Simulationsfehler im troposphärischen Wärmeinhalt keine falsche Lufttemperatur erzeugen würde; verstand nicht, dass die Unsicherheit des geringen Wolkenanteils, auf der die Analyse basierte, weder eine Basiszustandsunsicherheit, noch ein konstanter Fehler, noch ein zeitinvarianter Fehler war; n) stellte sich vor, dass die angeblich korrekte Temperaturprojektion von Hansen (1988) für 1988-2020 die Analyse ungültig machte.

Pah! Wir haben dieselbe Art von Unsinn ertragen müssen, und zwar aus demselben Grund: Die Klimatologen sind mit den relevanten Bereichen der Mathematik, Physik und Wirtschaft außerhalb ihres eigenen engen und allzu oft stumpfsinnig engstirnigen Spezialgebiets nur unzureichend vertraut, und sie sind höchst unwillig zu lernen.

Die Quintessenz ist, dass die Klimatologie einfach falsch liegt, was das Ausmaß der zukünftigen globalen Erwärmung angeht. Keine Regierung sollte dem, was sie sagt, auch nur die geringste Aufmerksamkeit schenken.

[Hervorhebung vom Übersetzer]

Link: https://wattsupwiththat.com/2021/05/09/why-models-cant-predict-temperature-a-history-of-failure/

Übersetzt von Chris Frey EIKE