NASA und NOAA „PASSEN“ Temperaturdaten an: Die Rohdaten zeigen, dass die USA sich ggü. den 30er Jahren abgekühlt haben

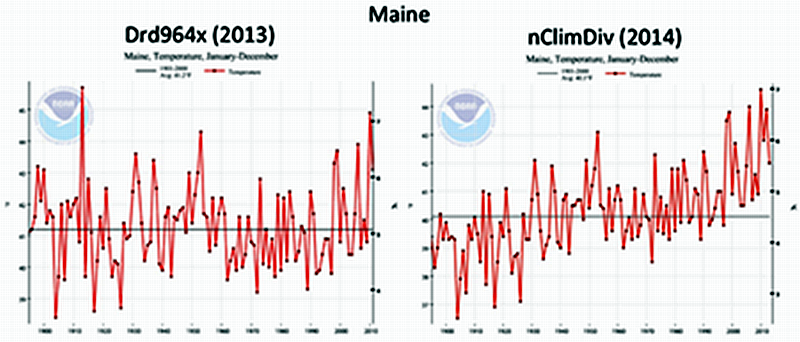

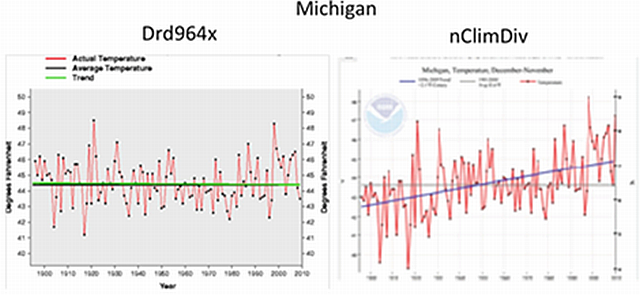

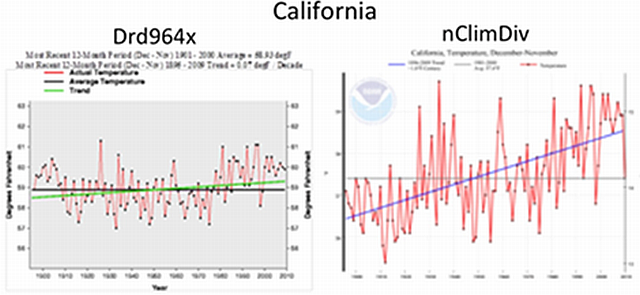

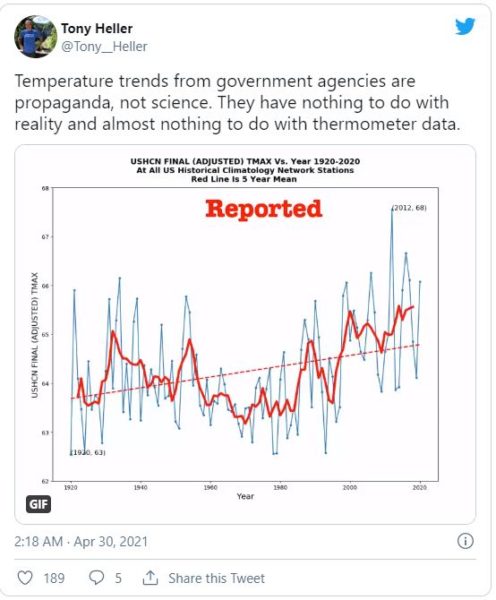

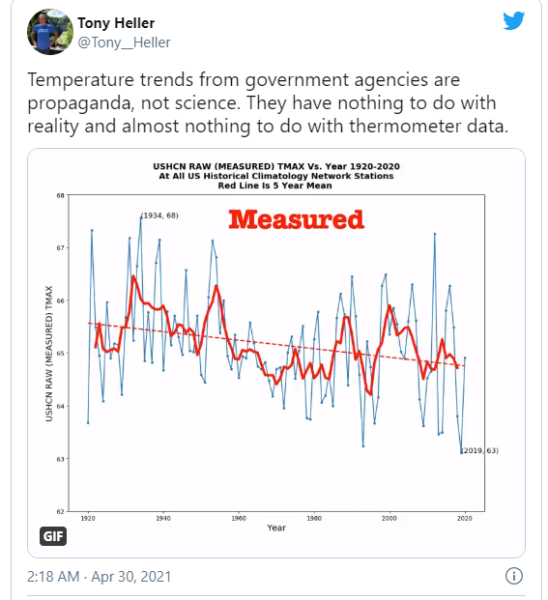

Das (im Original GIF animierte) Diagramm zeigt klar die historischen US Klimatologie Netzwerk -Stationen mit Rohdaten und danach mit offiziellen Anpassungen durch NASA und NOAA .

Hier sehen Sie die offiziell „adjusted“ maximalen Temperaturdaten über die Jahre 1920 – 2020, die einen Erwärmungstrend zeigen.

Und hier sind es die tatsächlichen „gemessenen“ Daten, die einen unverkennbaren Abkühlungstrend aufzeigen.

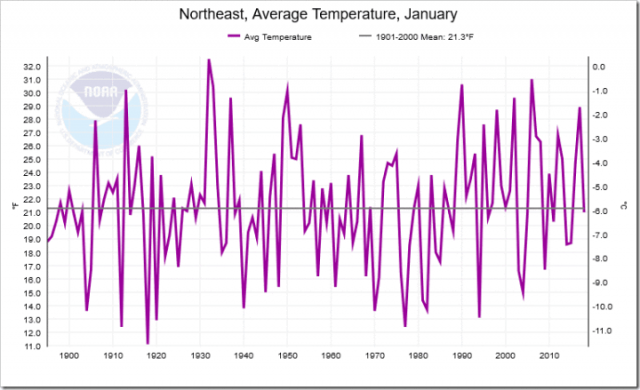

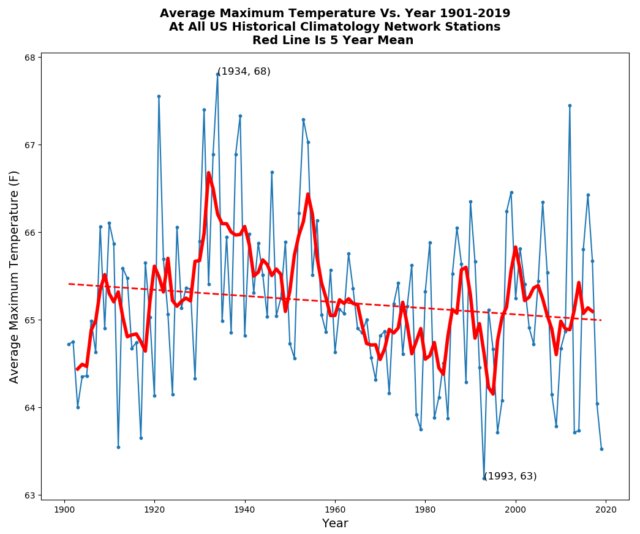

Unten sehen Sie eine vergrößerte Ansicht der US-Thermometerdaten, bevor die NASA / NOAA ihre schmuddeligen „adjustments“ vornahm.

Durchschnittliches Temperaturmaximum 1901 – 2019 , Rote Linie gleitendes 5 Jahres Mittel

Die Grafik zeigt, dass die Temperaturen von 1920 bis 1960 tatsächlich wärmer waren als heute. Es war angenehm wärmer, oft mit 2 bis 3 Grad Fahrenheit. (~ 1,5 bis 2 °C)

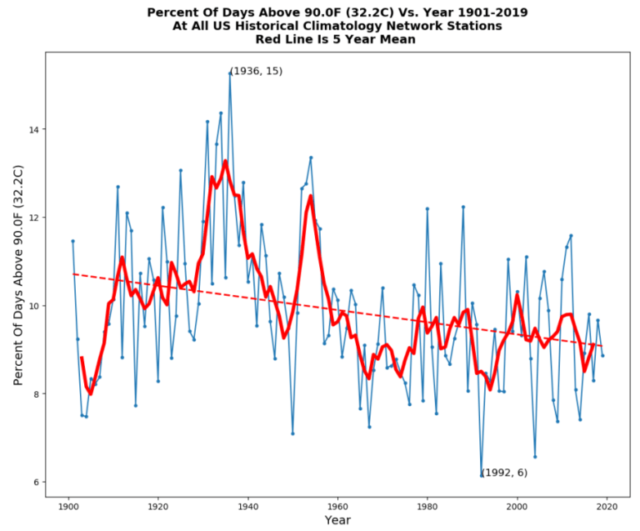

Der gleiche Trend ist in der vorstehenden Grafik zu erkennen, in der der Prozentsatz der Tage über 32,2 ° C (90 ° F) in den Jahren zwischen 1901 und 2019 erneut an allen Stationen des US-amerikanischen Netzwerks für historische Klimatologie angegeben ist (beachten Sie auch, dass die Grafik bis 2019 läuft und daher die Rekordkälte der letzten anderthalb Jahre ausschließt) Quelle: [Climate Science Special Report]

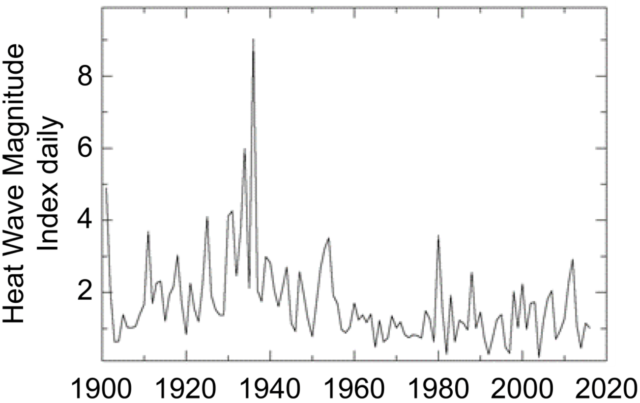

Die Daten zur Nationalen Klimabewertung stützen den Trend weiter und zeigen, dass die Sommer in den Vereinigten Staaten von 1910 bis 1960 viel heißer waren.

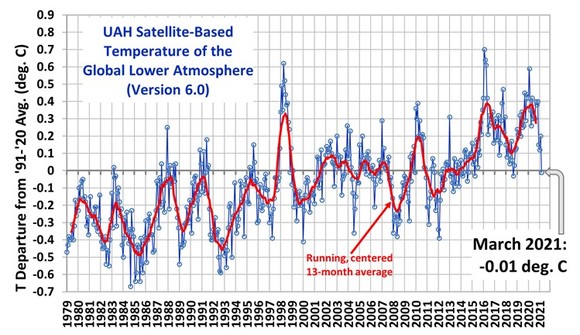

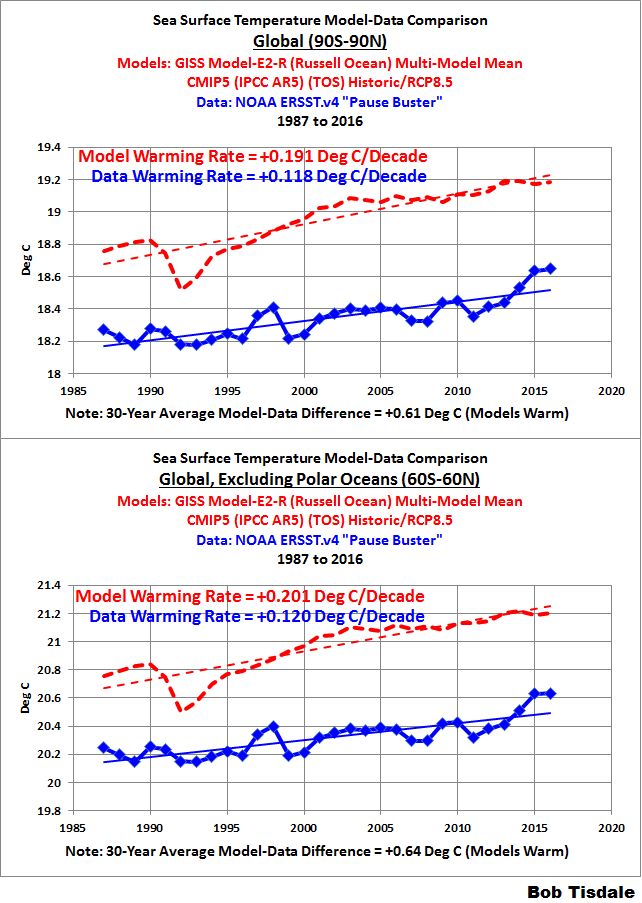

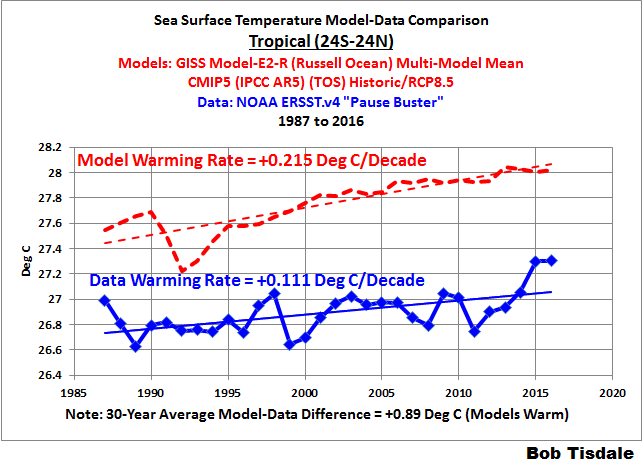

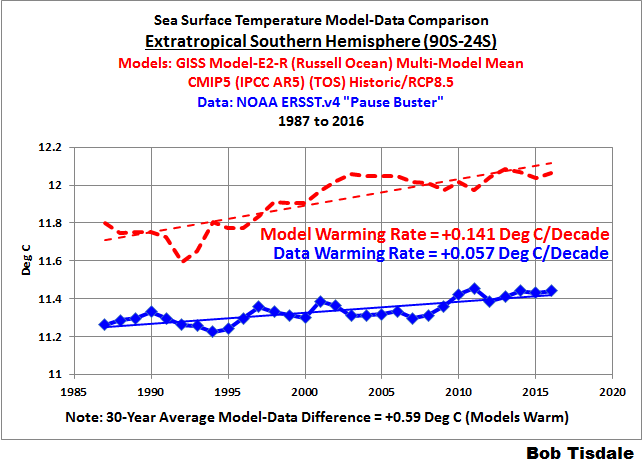

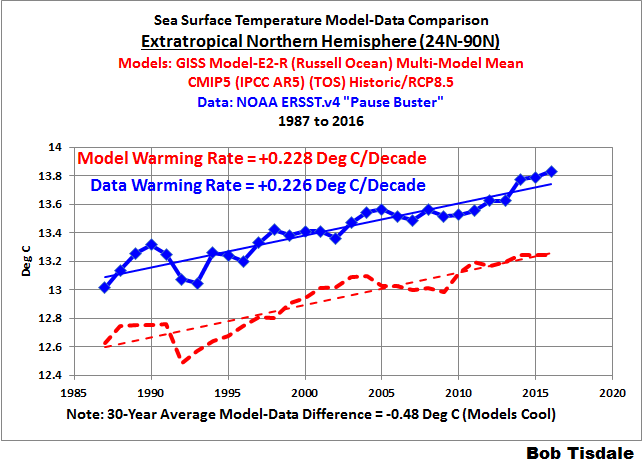

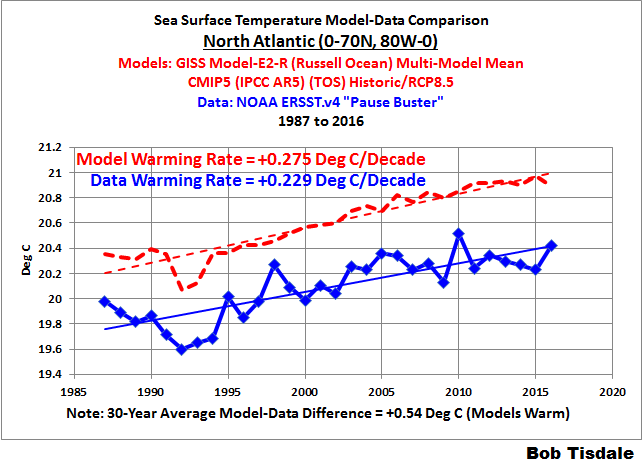

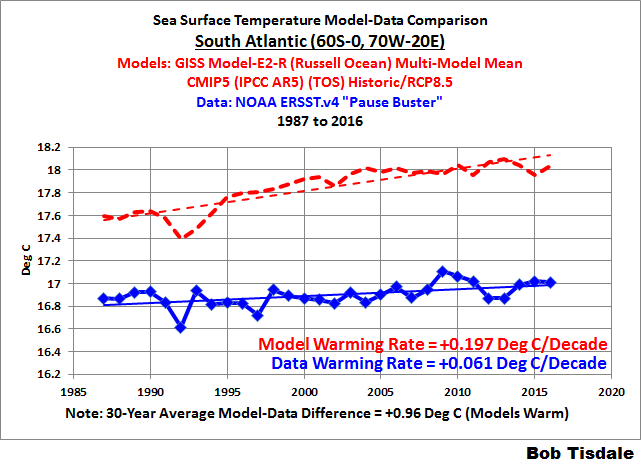

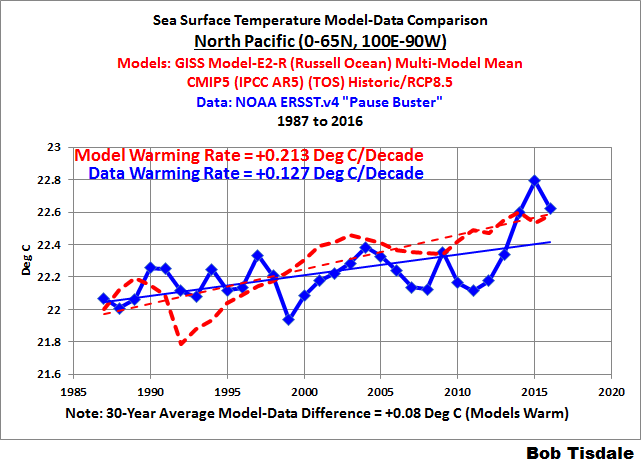

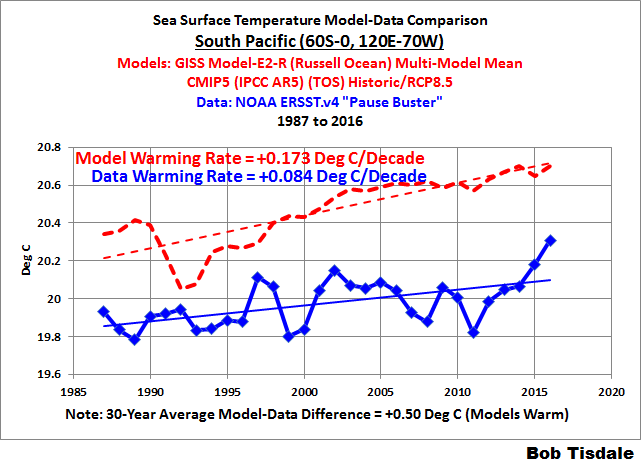

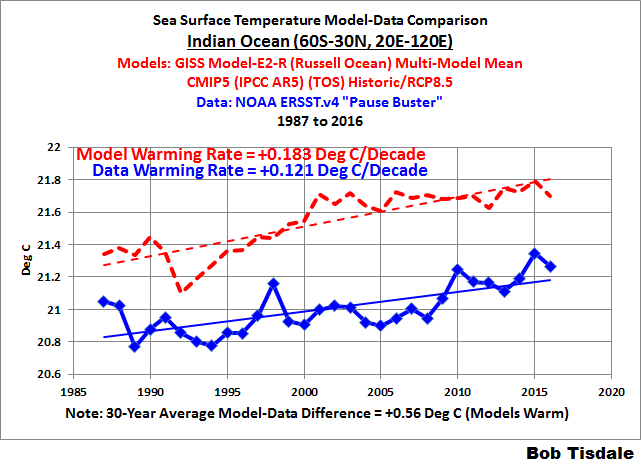

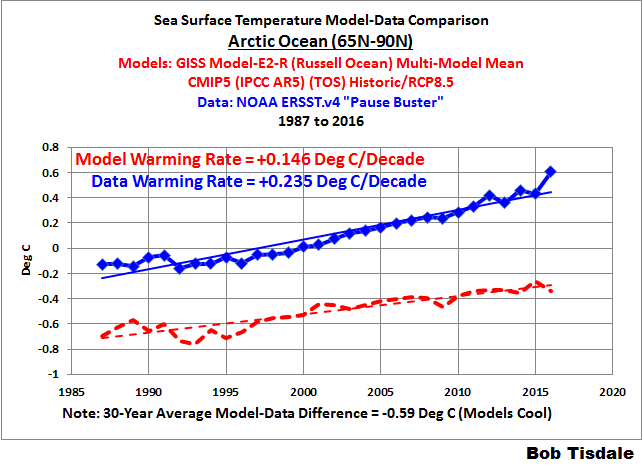

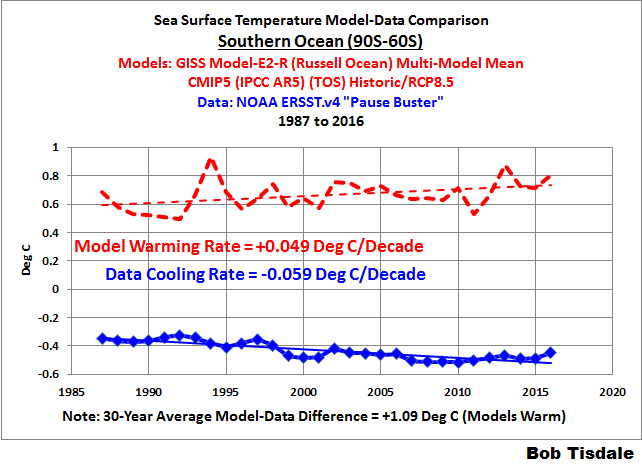

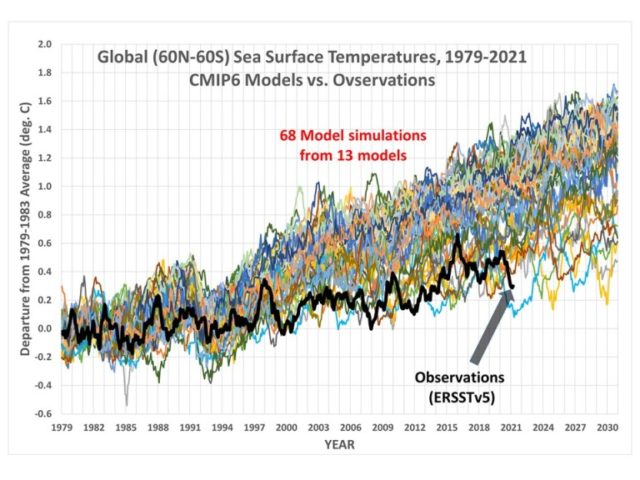

Darüber hinaus zeigen die jüngsten Beobachtungen [Observations] der Meeresoberflächentemperatur – selbst die von den Erwärmungsaktivisten kontrollierten – deutlich, dass sich die Projektionen katastrophaler Klimaentwicklungen als weit von der Realität entfernt erweisen:

Mehr zum Thema finden Sie HIER.

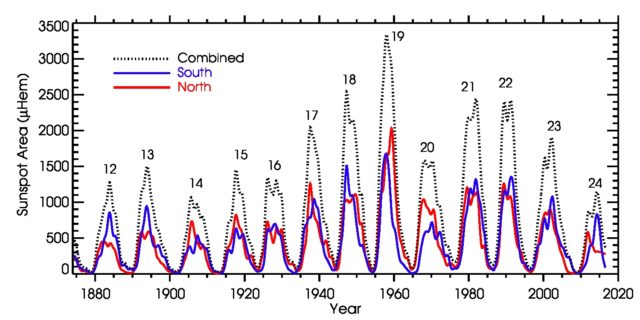

Wenn Sie sich noch nicht darauf eingelassen haben, dass Regierungen ihre Bevölkerung routinemäßig anlügen, sollten Ihnen die obigen Diagramme einen Einblick dazu bieten. Die globale Erwärmung ist kaum „global“, wenn die Vereinigten Staaten – das viertgrößte Land der Erde – sich abkühlen seit dem Ende von „the dust bowl“ [Katastrophenfilm von 2012, über die schlimmen Auswirkungen von Sandstürmen, durch Klimawandel und natürlich Menschen verursacht]. Und ich denke, es ist auch vernünftig anzunehmen, dass nicht nur die USA seit Mitte der 1930er Jahre einen Abkühlungstrend erleben. Der nordamerikanische Kontinent ist geografisch nicht einzigartig – und diese Beobachtungen stimmen gut mit der beobachteten Sonnenaktivität überein, nachdem die zwischen 1930 und 1960 zunehmende Aktivität allmählich nachgelassen hat:

Sonnenzyklen und Sonnenflecken

Die Daten können leicht manipuliert werden und manipulierte Statistiken werden verwendet, um die Aussagen der Politik zu beweisen und Richtlinien zu erlassen. Und heute scheinen Regierungsbehörden – gespielt von den unsichtbaren Strippenziehern über ihnen – ein glänzendes und mächtiges neues Werkzeug gefunden zu haben, um ihr Angst- und Kontrollarsenal durchzusetzen: „den Klimanotfall “.

Ein letzter Hinweis zu diesem Thema:

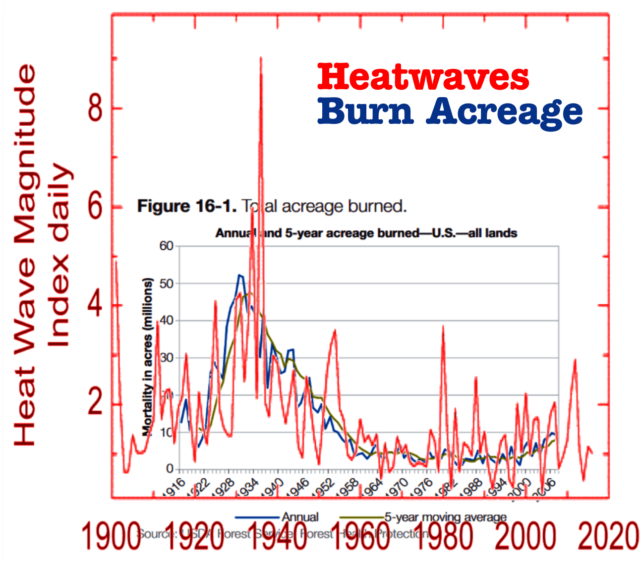

Die durch „Feuerbrünste“ betroffene Landfläche war von 1910 bis 1960 viel höher als heute, was nicht verwunderlich ist, da Hitzewellen normalerweise mit Dürre verbunden sind, betont Tony Heller. Es besteht eine enge Korrelation zwischen Hitzewellen und Brandfläche, wie in der obigen Tabelle dargestellt, die die offiziellen Daten von Hitzewellen (rote Linie) mit denen der Verbrennungsfläche (blaue und grüne Linien) überlappt.

Die Klimaaktivisten möchten, dass Sie glauben, dass Waldbrände eine direkte Folge steigender Temperaturen sind, aber wie Tony Heller gezeigt hat: Die Temperaturen steigen nicht und die Brandflächen nehmen auch nicht zu.

Die tatsächlichen Daten zerstören die Einpeitschungen eines „Klimanotfalls“ und so hat die Biden-Regierung kürzlich die Branddaten vor 1983 gelöscht, mit der glanzlose Begründung, dass „es nicht offiziell war“ ( hier verlinkt ).

Total Wildland Fires and Acres (1983-2020)

Vor 1983 verfolgten die föderalen Waldbrandbehörden die offiziellen Waldbranddaten nicht unter Verwendung der aktuellen Meldeverfahren. Infolgedessen werden auf dieser Website keine offiziellen Daten von vor 1983 veröffentlicht.

Wenn man etwas tiefer gräbt, wird einem der wahre Grund klar, warum sie die Daten vor 1983 gelöscht haben. Das Jahr 1983 registrierte die geringste Brandfläche. Ab 1983 konnten sie es so aussehen lassen, als würde die Brandfläche zunehmen.

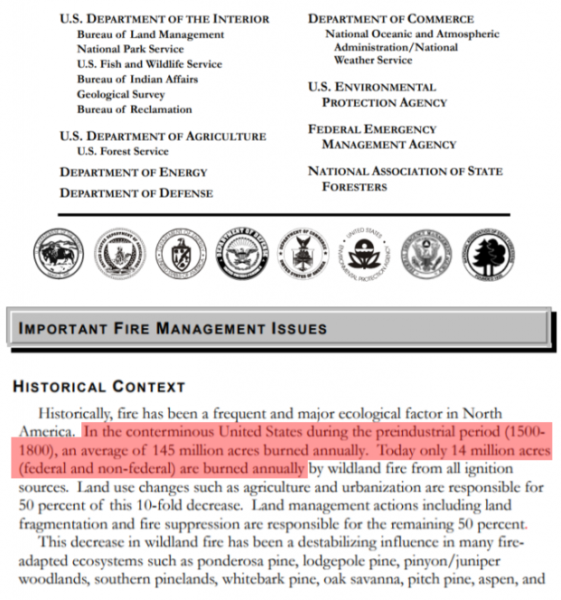

In der Realität besteht keine Korrelation zwischen steigendem CO2 und der verbrannten Fläche. Die Brandfläche in den USA ist tatsächlich um 90 Prozent gesunken, als der CO2 Anteil noch auf vorindustriellem Niveau lag – aber die Behörde hat kürzlich auch dieses Dokument gelöscht:

Übersetzung des rot markierten Textteiles:

In den heutigem Gebieten der USA brannten in der vorindustriellen Zeit (1500 – 1800) durchschnittlich 145 Millionen Acres pro Jahr [~ 586.000 km², zum Vergleich Deutschland: 357,386 km²]. Heute werden jährlich nur 14 Millionen Acres (Bundes- und Nicht-Bundesland) verbrannt

Fallen Sie nicht auf die täglichen Lügen herein, die von machtgierigen Politikern, willfährigen Wissenschaftlern und fremdfinanzierten Aktivisten verbreitet werden .

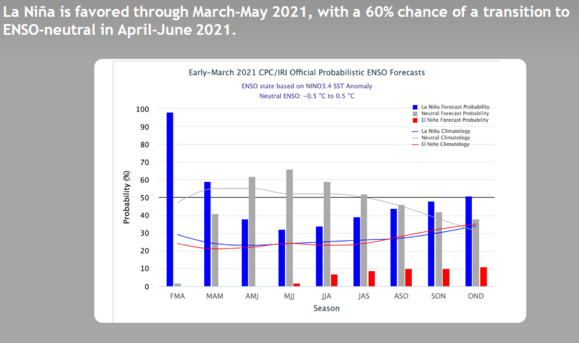

Die Beobachtungen zeigen, dass die KALTEN ZEITEN zurückkehren, dass die mittleren Breiten sich ABKÜHLEN, im Einklang mit der großen Konjunktion , der historisch geringen Sonnenaktivität , den wolkenkeimbildenden kosmischen Strahlen und einem meridionalen Jetstream-Fluss (neben anderen Einflüssen).

Sowohl NOAA als auch NASA scheinen sich jedoch einig zu sein – wenn Sie zwischen den Zeilen lesen. NOAA sagt, dass wir Ende der 2020er Jahre ein „ausgewachsenes“ Grand Solar Minimum erreichen und die NASA sieht diesen bevorstehenden Sonnenzyklus (25) als “ das schwächste der letzten 200 Jahre “.

NASA veröffentlichte früher Artikel mit Überschriften wie:

Niedrige Temperaturen während des Maunder-Minimums

…. Von 1650 bis 1710 sanken die Temperaturen in weiten Teilen der nördlichen Hemisphäre, als die Sonne in eine ruhige Phase eintrat, die jetzt als Maunder-Minimum bezeichnet wird. Während dieser Zeit traten nur sehr wenige Sonnenflecken auf der Sonnenoberfläche auf, und die Gesamthelligkeit der Sonne nahm leicht ab. Bereits mitten in einer überdurchschnittlich kälteren Zeit, der kleinen Eiszeit, gerieten Europa und Nordamerika in einen Tiefkühlzustand: Alpengletscher erstreckten sich über Ackerland bis ins Tal; Meereis kroch südlich von der Arktis; und die berühmten Kanäle in den Niederlanden froren regelmäßig ein – ein Ereignis, das heute selten ist.

… Der Einfluss des Sonnenminimums ist in diesem Bild deutlich zu sehen, das den Temperaturunterschied zwischen 1680, einem Jahr im Zentrum des Maunder-Minimums, und 1780, einem Jahr normaler Sonnenaktivität. Tiefes Blau in Ost- und Mittel-Nordamerika sowie in Nord-Eurasien zeigt, wo der Temperaturabfall am größten war. Fast alle anderen Landflächen waren 1680 ebenfalls kühler, was durch die unterschiedlichen Blautöne angezeigt wird. Die wenigen Regionen, die 1680 wärmer zu sein scheinen, sind Alaska und der östliche Pazifik (links), der Nordatlantik südlich von Grönland (links von der Mitte) und nördlich von Island (oben in der Mitte).

Darüber hinaus können wir die Vielzahl neuer wissenschaftlicher Arbeiten nicht ignorieren, in denen die immensen Auswirkungen des Beaufort Gyre auf den Golfstrom und damit auf das Klima insgesamt dargelegt werden.

https://electroverse.net/u-s-has-been-cooling-since-the-1930s/

Übersetzt durch Andreas Demmig

Nachsatz:

Über „Manipulation“ berichteten wir auf Eike schon häufig. Nutzen Sie die Suchfunktion um die Beiträge zu finden.