Pandemie der Dummheit.

Schon in der 2007 erschienenen ersten Auflage meines Buches „Öko-Nihilismus“ habe ich davor gewarnt, man werde wohl bald nicht mehr zwischen Computersimulationen mathematischer Modelle und der realen Welt unterscheiden können. Inzwischen ist die Konfusion Realität. Seit der im Auftrag des Club of Rome erstellten Computersimulations-Studie „Die Grenzen des Wachstums“ (1972) werden staatliche Eingriffe in Grundrechte wie das Recht auf Privateigentum sowie Meinungs- und Bewegungsfreiheit immer öfter mit dem Verweis auf theoretische Modelle eines angeblich exponentiellen Wachstums von Problemen wie Umweltbelastung, Rohstoffverbrauch und neuerdings Virusinfektionen gerechtfertigt. Dabei tritt unbegrenztes exponentielles Wachstum sowohl in der Natur als auch in der Gesellschaft nur sehr selten auf. Bei einer Epidemie nur im theoretischen Fall, dass in der Bevölkerung keinerlei Abwehrkräfte vorhanden sind. In der Regel kommt es nur als aufsteigender Ast einer sigmoidalen Sättigungskurve vor. Das hat Angela Merkel nicht davon abgehalten, ein angeblich exponentielles Wachstum der SARS-CoV-2-Infektionen als Begründung für den von ihr unter Umgehung des Bundestages durchgedrückten Oster-Lockdown zu benutzen. Immerhin wurde sie schon am Folgetag, dem 24. März 2021, gezwungen, den drastischsten Teil ihres Beschlusses zumindest dem Anschein nach wieder zurück zu nehmen. In Wirklichkeit hält sie daran fest, im Einsperren der Menschen die einzig wirksame Maßnahme gegen die Verbreitung von Viren zu sehen.

Dabei zeigt der Vergleich zwischen Deutschland und dem US-Ferienparadies Florida, wo es seit dem letzten Sommer keinerlei Corona-bedingte Beschränkungen des täglichen Lebens gibt, dass Lockdowns keinerlei positiven Einfluss auf die Infektionskurven und die Anzahl der Todesopfer haben – negativen dagegen schon. In 98,4 Prozent der Paarvergleiche der Google-Bewegungsdaten von 87 Ländern und Regionen hat ein Lockdown keinerlei Einfluss auf die Entwicklung der Zahl der Covid-Toten, wo bei noch zu berücksichtigen wäre, dass viele der statistischen Covid-Opfer nicht an, sondern mit Covid (neben Vorerkrankungen) gestorben sind. Das ist das Ergebnis einer sauberen statistischen Analyse der ersten Covid-19-Welle vom 15. Februar bis zum 21. August 2020 (Savaris, R.F., Pumi, G., Dalzochio, J. & Kunst, R. (2021).

In Deutschland hat sich die Physikerin Viola Priesemann vom Göttinger Max-Planck-Institut für Dynamik und Selbstorganisation mit ihren Modellen der Ausbreitung von Covid-Epidemie-Wellen hervorgetan beziehungsweise wurde von unkritischen Massenmedien in die Rolle der Pythia gelobt. Viola Priesemann machte im Dezember 2020 auch als Mitverfasserin des Aufrufs „Contain Covid 19“ von sich reden, der im Januar 2021 zunächst im Fachmagazin „The Lancet“ erschien. Darin forderte sie zusammen mit Melanie Brinkmann, Sandra Ciesek und anderen einen radikalen EU-weiten Lockdown bis die positiven PCR-Tests auf täglich zehn von einer Million Einwohner gesunken sind. In Deutschland wurde dieser Appell von der überwiegend linksradikalen Bewegung „Zero Covid“ aufgegriffen. Zu den Erstunterzeichnern des Appells mit dem Titel „Das Ziel heißt null Infektionen. Für einen solidarischen europäischen Shutdown“ gehörten bekannte linksradikale Wiederholungstäter*Innen wie Georg Restle, Margarete Stokowski, Luisa Neubauer, Stefanie Sargnagel, Natascha Strobl, Rudolf Hickel, Frigga und Wolfgang Fritz Haug. Darin fordern sie einen grundlegenden Strategiewechsel. Der Versuch, die Pandemie durch eine Abflachung der Infektionskurve zu kontrollieren, sei gescheitert. Das Ziel müsse vielmehr lauten: „Gemeinsam runter auf null.“ Ob und wie weit das überhaupt realistisch ist, wird nicht gefragt. Umsetzen ließe sich die Forderung einer „solidarischen Pause von einigen Wochen“ nur mit totalitären Methoden, die darauf hinauslaufen, die Staatsbürger wie unmündige Kinder oder gar wie Sklaven zu behandeln. Aufs Ganze gehen, ist ja wohl die ursprüngliche Definition von Totalitarismus. Umso bedenklicher ist es, dass auch Regierungsmitglieder (wie zuletzt Bundesgesundheitsminister Jens Spahn mit seiner Forderung eines zweiwöchigen Total-Lockdown) sich immer öfters der Argumentation von „Zero Covid“ anschließen. Die bekannteste Definition der Dummheit lautet bekanntlich, von der Wiederholung oder gar Steigerung einer unwirksamen Maßnahme bessere Ergebnisse zu erwarten. Aber vielleicht ist die Kontrolle der Epidemie gar nicht das Ziel der Bundesregierung…

Inzwischen hat Jörg Phil Friedrich in der Tageszeitung DIE WELTonline, die selbst mitgeholfen hat, Frau Priesemann in die Rolle einer Wahrsagerin zu hieven, am 24. März grundsätzliche Kritik an den politisch gefälligen Modellspielereien geübt. Dort liest man u.a.: „Kann es sein, dass wir trotz einer jahrhundertelangen Geschichte der Rationalisierung der Welt immer noch so etwas wie „Wahrsager“ brauchen und dass die modellierende Naturwissenschaft, so ungenau sie auch immer sein mag, heute die Rolle dieser magischen Kräfte übernehmen muss? (…) Weil die Modelle mit Inzidenzen und R-Werten rechnen, meinen wir, diese Zahlen hätten auch direkte Bedeutung für politische Entscheidungen. Andere Dinge, die nicht in den Modellen vorkommen oder sich erst gar nicht mathematisch fassen lassen, wie die gesellschaftliche Stimmung, die Veränderung des kulturellen Klimas, die Auswirkungen auf die Lebensqualität, scheinen unwichtig zu werden, weil sie ja nicht in den Modellen stehen.“

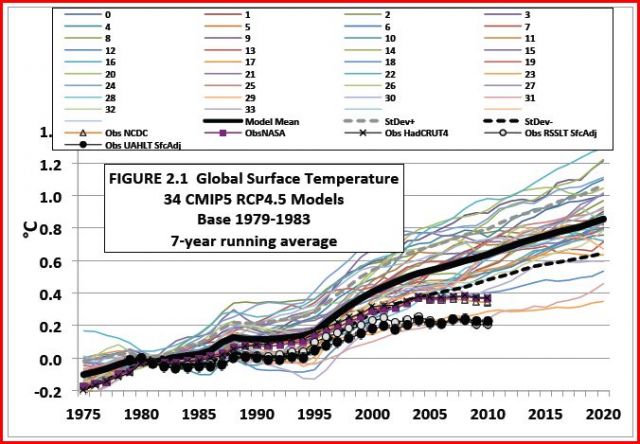

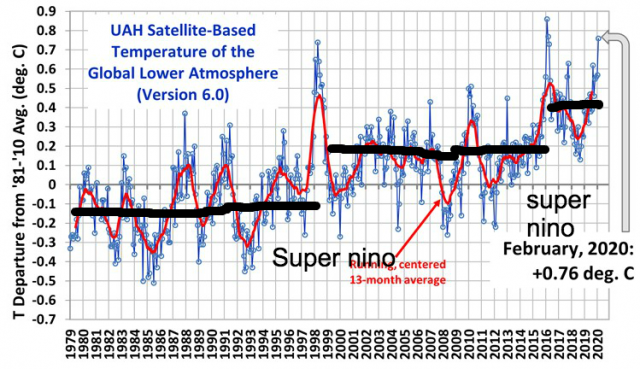

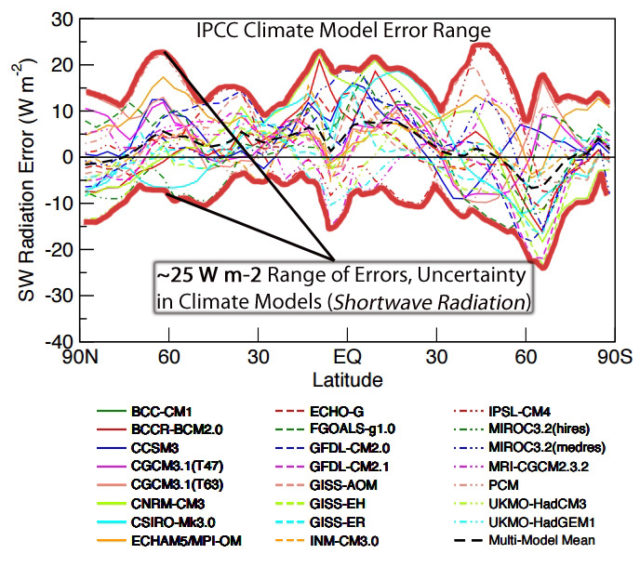

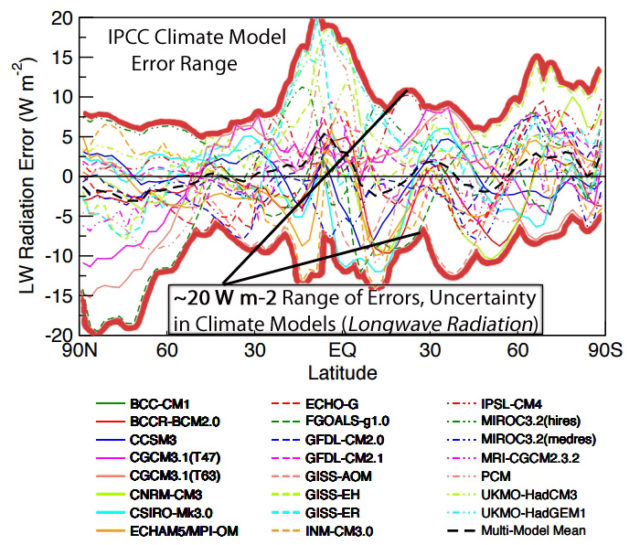

Zwei Tage zuvor stand im gleichen Blatt ein ausführliches Interview mit dem Stanford-Professor John Ioannidis, der als führender Epidemiologe der Welt gilt. Der auch in Deutschland aktive Forscher erklärte schon im Januar in einer gemeinsam mit anderen Forschern im „European Journal of Clinical Investigation“ veröffentlichten Studie, drakonische Maßnahmen zur Eindämmung der Epidemie wie eine Verschärfung eines bereits bestehenden Lockdowns seien überflüssig. Diese Studie stieß zumindest in Deutschland auf methodische Einwände. Inzwischen betont Ioannidis sogar, die Lockdowns hätten insgesamt eher einen negativen Effekt gehabt. Leider sei das aber wegen der opportunistischen Haltung der meisten jungen Forscher nicht deutlich geworden, beklagt Ioannidis im Interview mit der WELT: „… bei der großen Mehrheit meiner Kritiker handelt es sich nicht um Wissenschaftler, sondern um Aktivisten oder um Anfänger, die selbst noch wenig publiziert haben. (…) Viele Forscher versuchen, ihre Analysen so anzupassen, dass es zu einem bestimmten Narrativ passt. Inzwischen haben rund 459.000 Wissenschaftler etwas zu Covid-19 veröffentlicht. Die kamen ganz plötzlich aus dem Nichts. Das mögen kluge, in Datenanalyse gut ausgebildete Leute sein, aber sie haben nicht die geringste Ahnung von Epidemiologie oder Infektionskrankheiten oder dem Gesundheitswesen. Ihre überambitionierten Modellierungen beruhen auf unsicheren, sehr fehleranfälligen Daten – das ist, als ob man einen Mercedes-Motor in einen alten Holzkarren einbaut. In ihrem Enthusiasmus glauben viele dieser Wissenschaftler, sie könnten fehlerhafte Daten analysieren, als handelte es sich dabei um Messwerte aus einem Teilchenbeschleuniger. Dabei bieten Modellierungen immer nur eine schwache Evidenz. Sie sollten auch auf meine Modellierung nicht vertrauen.“

Modelle sind provisorische Hilfsmittel der Forschung. Sie sollten niemals mit der Realität verwechselt werden, weil sie komplexe Zusammenhänge mehr oder weniger extrem vereinfachen müssen. Statt als Hilfsmittel der Forschung erscheinen Modelle heute aber immer öfters als deren eigentliches Ziel. Dieser Verdacht drängt sich auch bei der Corona-Forschung auf. Hat das von den Medien verbreitete Virus-Modell eines bunten Plüschballs überhaupt eine eindeutige Entsprechung in der Realität? Diese ketzerische Frage sollte zumindest so lange nicht als abwegig betrachtet werden, als es noch nicht gelungen ist, SARS-CoV-2 in Reinform zu isolieren und sein Genom vollständig zu sequenzieren. Zumindest einige „Querdenker“ halten SARS-CoV-2 für ein „Phantom-Virus“, hinter dem sich in Wirklichkeit mehr oder weniger harmlose Exosomen verbergen. Daher ist es auch unklar, ob PCR-Tests nach Christian Drosten das Virus an asymptomatischen Probanden wirklich nachweisen können oder ob der Test nicht vielmehr das Virus mithilfe des Primers aus wenigen Aminosäuren quasi „erschafft“.

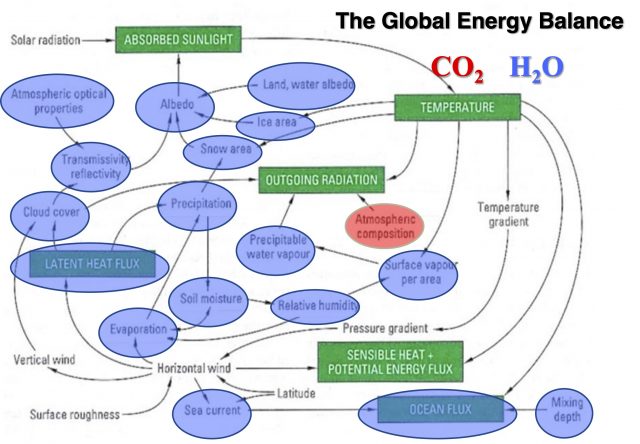

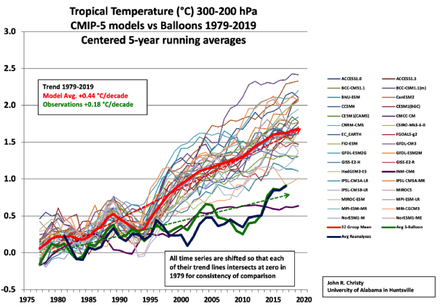

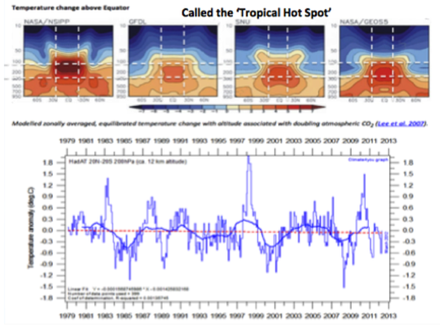

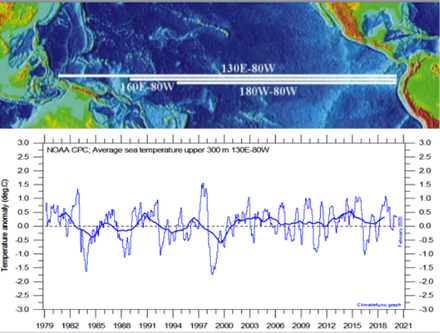

Weil heute offenbar zu viele Forscher vor allem auf die Bestätigung eines Narratives aus sind, anstatt ergebnisoffen nach der Wahrheit zu suchen, verschwimmen die Grenzen zwischen Science und Science fiction immer mehr. Damit einher geht eine Renaissance des magischen Denkens. Dieses offenbart sich kaum irgendwo deutlicher als in der Behauptung, die „Energiewende“ mit dem Ziel der CO2-Neutralität wirke als Vorsorge gegen Covid-19. Was nicht wie gewünscht eintritt, wird notfalls inszeniert oder aus dem kollektiven Gedächtnis verdrängt, indem man einfach beschließt, über reale Probleme nicht mehr zu reden: Zum Beispiel über die Kohlekraftwerke, die nur acht Tage nach ihrer offiziellen, vom Staat entschädigten Abschaltung ihren Betrieb wieder aufgenommen haben, um das Stromnetz vor dem Zusammenbruch zu bewahren. Oder über die enormen Umweltbelastungen, die E-Autos bei der Rohstoffgewinnung in armen Ländern verursachen. Oder nicht zuletzt über die immensen gesundheitlichen und wirtschaftlichen Kollateralschäden der Corona-Lockdowns.

Immerhin läutet nun der Vorstandsvorsitzende des Deutschen Krebsforschungszentrums, Professor Michael Baumann, die Alarmglocke, indem er darauf hinweist, dass die einseitige Ausrichtung der Krankenhäuser zu massiven Kollateralschäden führt. Wegen der Verschiebung von Untersuchungs- und OP-Terminen rechnet er mit bis zu 40.000 zusätzlichen Krebstoten. Darauf hatte schon im Frühjahr 2020 der Oberregierungsrat Stephan Kohn im Bundesinnenministerium (BMI) in einer 80-seitigen Studie hingewiesen. Zweieinhalb Millionen Menschen seien durch die einseitige Ausrichtung des Gesundheitswesens auf Covid-19 nicht medizinisch versorgt worden, schätzte Kohn. Es sei dadurch eine potentielle Lebenszeit im Umfang von mehreren Millionen Jahren geopfert worden. Kohn wurde daraufhin sofort seines Amtes enthoben. Dabei hatte er nur angewandt, was in seinem Ministerium schon im Jahre 2012 aus einer realistischeren Risikoanalyse möglicher Epidemie-Ereignisse gefolgert worden war, nämlich Maßnahmen zur Eindämmung einer Epidemie einem realistischen Kosten-Nutzen-Vergleich zu unterwerfen. Nach Oberregierungsrat Kohn führt die Nichtbeachtung der Risikoanalyse von 2012 nun zu bedenklichen Konsequenzen: „Die Resilienz des hochkomplexen und stark interdependenten Gesamtsystems Kritischer Infrastrukturen ist gesunken. Unsere Gesellschaft lebt ab sofort mit einer gestiegenen Verletzlichkeit und höheren Ausfallrisiken von lebenswichtigen Infrastrukturen. Das kann fatale Folgen haben…“. Im Parallel-Universum, in dem sich Angela Merkel und ihre handverlesenen Berater bewegen, scheint diese Schlussfolgerung allerdings unerwünscht, da „nicht hilfreich“ zu sein.