Warum werden Sonne und Kosmos bei der Berechnung künftiger Erdtemperaturen unterschätzt?

Einführung

Allerdings kann die Sonne auch viel weniger Energie pro Zeiteinheit emittieren, dies wird aber verschwiegen. Dadurch werden die Bürger irregeführt und ihre Schuldgefühle angeheizt.

Es gibt etwa 30 Astrophysiker, die behaupten, dass das Klima durch die Sonne bestimmt wird. Das stimmt mit der Aussage des NIPCC (Nongovernmental International Panel on Climate Change) überein, wonach die Natur und nicht menschliche Aktivität, das Klima bestimmt. Das Dogma der „menschgemachten Klimaerwärmung“ hat sich mittlerweile aber derart verhärtet, dass viele Astrophysiker um ihre Karriere fürchten müssen, wenn sie andere Überzeugungen vertreten.

Im Folgenden werden wir nicht auf die Aussagen der rund 30 Astrophysiker eingehen, sondern uns auf die Veröffentlichungen von Prof. Dr. N. Scafetta, Prof. Dr. Valentina Zharkova und Dr. H. Abdussamatov konzentrieren. Diese weisen nach, dass menschliche Aktivität keinen oder nur einen minimalen Einfluss auf den Klimawandel hat. Zudem fügen wir die Studien von Irina Kitiashvili (NASA) über die Entwicklung zukünftiger Sonnenzyklen bei. (Referenzen am Schluss.)

Sonnenzyklen im Lauf der Jahrhundert

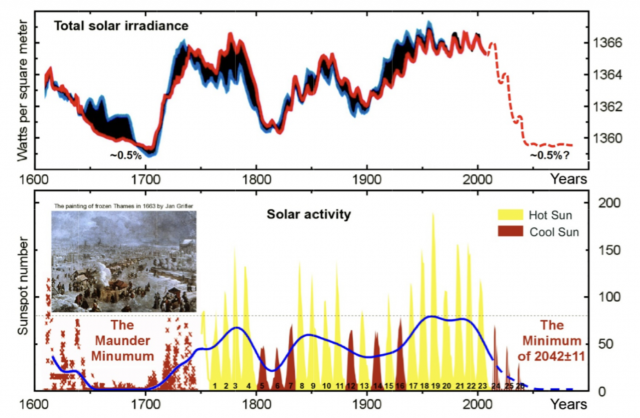

Abb. 1 ist der Veröffentlichung von Dr Abdussamatov vom Februar 2011 entnommen. Die obere Kurve gibt die „Total Solar Irradiance“ d.h. die gesamte Sonneneinstrahlung seit 1600 an. Die untere Kurve stellt die sich verändernde Sonnenflecken-Aktivität dar. In Zeiten geringer Sonnenflecken-Aktivität ist die auf die Erde treffende Energiemenge besonders niedrig. Man spricht dann von „Solar Minimum“. In den letzten 400 Jahren gab es drei Solar-Minima.

Abb. 1: TSI (gesamte Sonneneinstrahlung in Watt pro Quadratmeter) und Anzahl Sonnenflecken sowie Abschätzung der künftigen Entwicklungen (gestrichelte Linie)

Die Forschungsresultate von Abdussamatov aus dem Jahr 2011 stimmen mit denjenigen von Scafetta und Kitiashvili (NASA) aus dem Jahr 2019 überein. Es gibt mehrere TSI-Messmethoden, und nicht alle Wissenschafter kommen zu identischen Ergebnissen. Interessant ist aber, dass Scafetta von einer Zunahme der emittierterten Sonnenenergie bis zum Jahr 2000 und von einer anschliessenden Abnahme spricht. Das deckt sich mit den neuesten Resultaten von Kitiashvili (NASA), die eine markante Reduzierung der Sonnenflecken für die Jahre 2020 bis 2032 prognostiziert (nach ihrer Berechnung des Sonnenzyklus 25). Dies ist gleichbedeutend mit einer Reduktion der emittierten Sonnenenergie, was einen Temperaturrückgang auf der Erde gleichkommt. Gemäss NASA muss sogar mit einem „Grand Solar Minimum“ gerechnet werden, das mit dem sog. Dalton-Minimum der Jahre 1790 – 1820 vergleichbar sei.

Weitere Studien von Zharkova et al. erweitern die TSI-Messungen mit den Oszillationen des Sonnenmagnetfeldes und rechnen mit einem „Grand Solar Minimum“, das im Jahr 2020 beginnen und bis ins Jahr 2055 dauern wird. Dieses „Grand Solar Minimum“ ist mit dem „Maunder-Minimum“ vergleichbar. Damals war das Klima besonders kalt, weshalb man von einer „Kleinen Eiszeit“ spricht. Besonders interessant ist, dass dieses Grand Solar Minimum mit dem sogenannten Suess/de Vries-Sonnenzyklus korreliert, der eine Periode von 208 Jahren aufweist. Eine weitere Übereinstimmung ergibt sich mit dem „Super-Grand Solar Cycle“ nach Zharkova, der eine Periode von 1950 Jahren hat.

Um wie viel wird TSI abnehmen?

Viele Astrophysiker rechnen beim „Grand Solar Minimum“ mit einer gleich grossen Abnahme wie die frühere Zunahme. Entscheidend ist aber auch die Dauer des Minimums. Das Dalton-Minimum dauerte nur 30 Jahre, das Maunder-Minimum hingegen 70 Jahre. Je länger die Periode ist, umso tiefer wird die Temperatur ausfallen.

In der Literatur (s.Referenzen Zharkova) wird die Zunahme der von der Sonne emittierten Wärmeleistung d.h. die Energie in Joules pro Sekunde seit dem letzten Maunder-Minimum bis zum Jahr 2000 mit einem Wert von 1 bis 1,5 Watt pro Quadratmeter angegeben. Abdussamatov gibt den viel höheren Wert von 6 W/m2 an. Die Wissenschaft ist sich in diesem Punkt also noch nicht einig. Wir gehen für unsere Untersuchungen vom kleinsten Wert von 1 W/m2aus.

Was bedeutet die Abnahme der Sonnenwärmeleistung um 1 W/m2 für die globale Erdtemperatur?

Die Energieflüsse im System von Atmosphäre und Erdoberfläche lassen sich anhand einer einfachen Energie-Bilanz eruieren. Die gesamte Wärmeabnahme wird berechnet, indem der Querschnitt der Erde mit 1 W/m2 multipliziert wird. Bei einem 11-Jahreszyklus (Schwabe-Sonnenzyklus) lässt sich eine Abnahme der Wärmeleistung von 4.4 mal 1022 Joule errechnen.

Danach wird die mittlere Temperaturabnahme der Gesamtatmosphäre unter dem Einfluss der Gesamt-Wärmereduktion errechnet. Diese Temperatur-Reduktion wird dann korrigiert, indem die planetare Albedo und die Absorption an der Erdoberfläche berücksichtigt wird. Dabei werden die IPCC-Strahlungsbilanzangaben nach Kiehl und Trenberth zugrunde gelegt.

Die Masse der Atmosphäre beträgt 5.15 mal 1018 kg und die Wärmekapazität der Luft ist 1kJ/kg. Daraus wird die Temperaturabnahme mit 8, 5 °C errechnet. Nach den IPCC-Strahlungsbilanzen der Erde beträgt das planetare Albedo 30 %, die Erdoberfläche absorbiert 50 % der Wärme und die Atmosphäre absorbiert 20 %. Es ergibt sich also für die Atmosphäre eine globale Temperaturabnahme von rund 1.7 °C bei einer TSI-Abnahme von nur 1 W/m2.

Nach Scafetta nimmt der TSI seit dem Jahre 2000 ab. Nach den Satellitenmessdaten nimmt die globale Erdtemperatur dagegen erst seit 2016 ab. Dieser Unterschied ist nicht verwunderlich, wenn man die Wärme-Pufferfunktion der Meere berücksichtigt. Im Beitrag II haben wir bereits auf die massgebende Rolle der Meere hingewiesen.

Fazit

Die Mainstream-Klimatologen haben die Rolle der Sonne beim Klimawandel zu wenig berücksichtigt und ihr Augenmerk einzig auf die Treibhausgase gerichtet. Es ist ein naiver Fehlschluss zu behaupten, die gleichzeitige Zunahme der Erdtemperatur und des Treibhausgas-Ausstosses seien kausal voneinander abhängig. Es gibt keine experimentellen Nachweise dafür und die Berechnungen der „Micky-Mouse-Modelle“ (siehe Beitrag II) sind unzuverlässig.

Astrophysiker, die nicht nur die Erd-, sondern auch die kosmischen Verhältnisse berücksichtigen, erwarten in den nächsten Jahren eine ähnliche Entwicklung wie bei den seinerzeitigen Maunder- resp. Dalton-Minima. Ob die Astrophysiker/Klimatologen oder die Mainstream-Klimatologen recht haben, wird sich recht bald erweisen.

Unsere nächstfolgenden Beiträge werden sich mit Früh-Indikatoren auseinandersetzen, welche die These der zu erwartenden Abkühlung um 1 bis 1,5°C untermauern. Zudem betrug die Erdtemperaturerhöhung seit des Maunder-Minimums bis zum TSI-Maximum im Jahr 2000 nur rund 1°C. Nach dem IPCC müsste die Erdtemperaturerhöhung, wegen der Erhöhung der Treibhausgaskonzentration, viel höher sein, da die Erhöhung von rund 1°C bereits allein durch die Sonne verursacht wird.

F.Ferroni, Dipl.Ing.ETH

Präsident NIPCC-SUISSE

Referenzen

Abdussamatov,H.I., Bicentennial Decrease of the Total Solar Irradiance Leads to Unbalanced Thermal Budget of the Earth and the Little Ice Age, Applied Physics Research , Vol4.No.1; February 2012

Kitiashvili, I., Solar Activity Forecast for the Next Decade, Presentation 2019 (siehe Anhang oder Link)

Scafetta, N, Wilson, R. C., Comparison of Decadal Trends among Total Solar Irradiance Composites of Satellite Observations, Advances in Astronomy, Volume 2019, Article ID 1214896

Zharkova, V.V., Shepherd,S.J., Zharkov, S.I., and Popova, E., Oscillations of the baseline of solar magnetic field and solar irradiance on a millennial timescale,www.nature.com/scientificreports, June 2019

Der Beitrag erschien zuerst auf dem Schweizer Blog Carnot-Netzwerk hier