Kurzer Abriss der CO2-Rekorde in der Atmosphäre

Eine kurze Geschichte der Rekorde des atmosphärischen Kohlendioxids

Von David Middleton

Die WMO – World Meteorological Organization (Warum muss ich nur immer denken: Weltpolizist wenn “Welt und “Organisation” im Titel erscheinen?)

hat vor kurzem angekündigt, dass die Treibhausgase in der Atmosphäre eine neue Rekordhöhe (Bild rechts) erreicht hätten. Rekorde werden aber nur aufgestellt, damit sie gebrochen werden können.

Ich frage mich, ob die WMO-Leute folgende drei Fakten kennen:

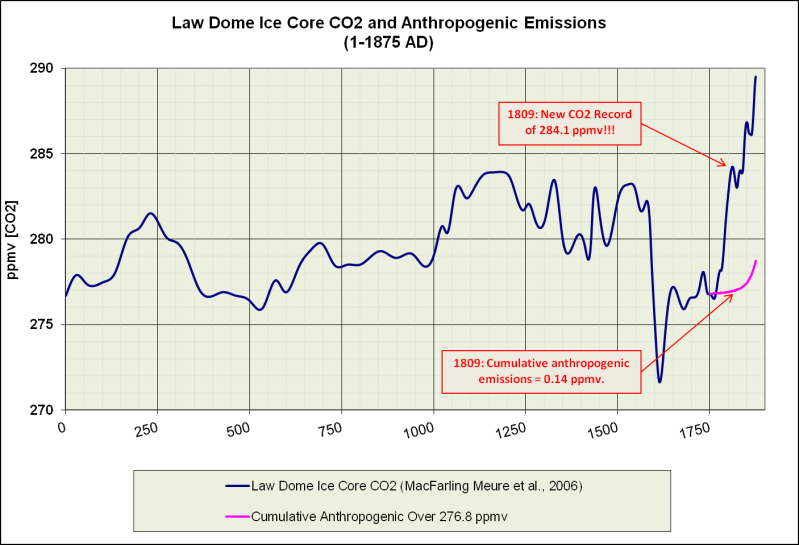

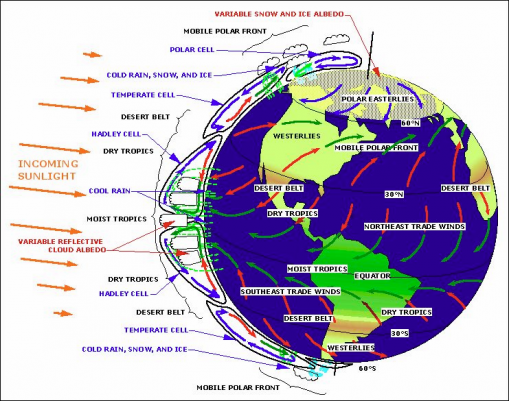

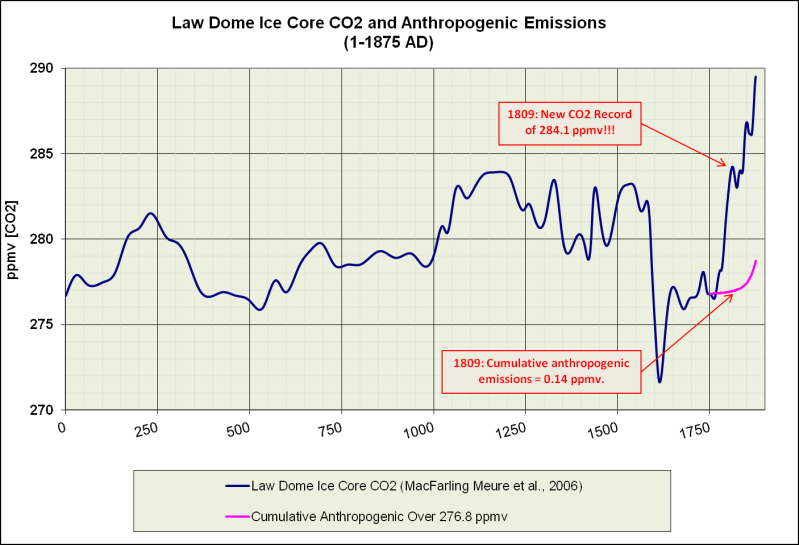

1) Der erste CO23-Rekord wurde bereits 1809 aufgestellt, als die kumulierten menschlichen Kohlenstoff-Emissionen noch unter 0,2 ppm CO2 lagen?

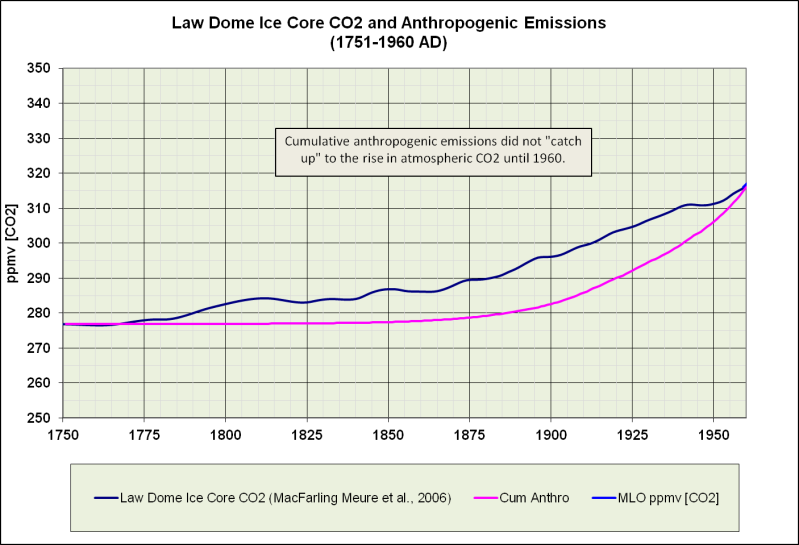

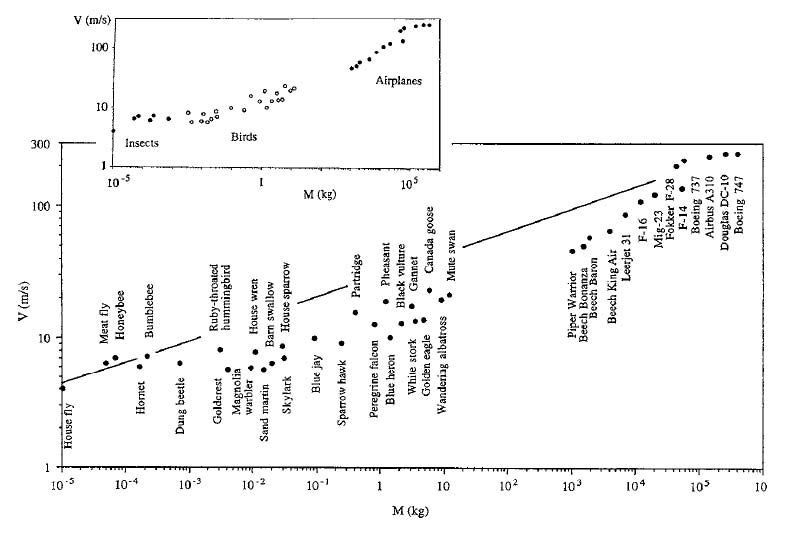

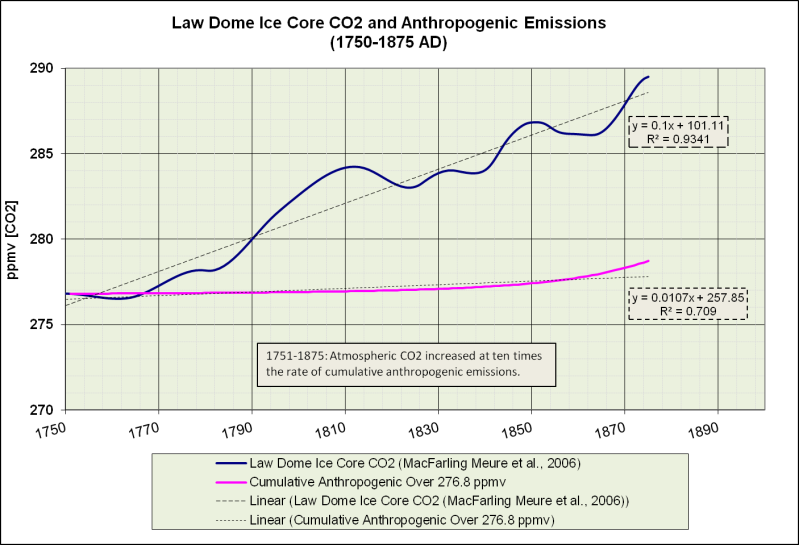

Fig. 1. Der Original CO2 – “Hockey Schläger.” CO2-Emissionsdaten vom Oak Ridge National Laboratory’s Carbon Dioxide Information Analysis Center (CDIAC).

Die Emissionen (GtC) werden durch 2,13 geteilt, um ppmv CO2 zu erhalten.

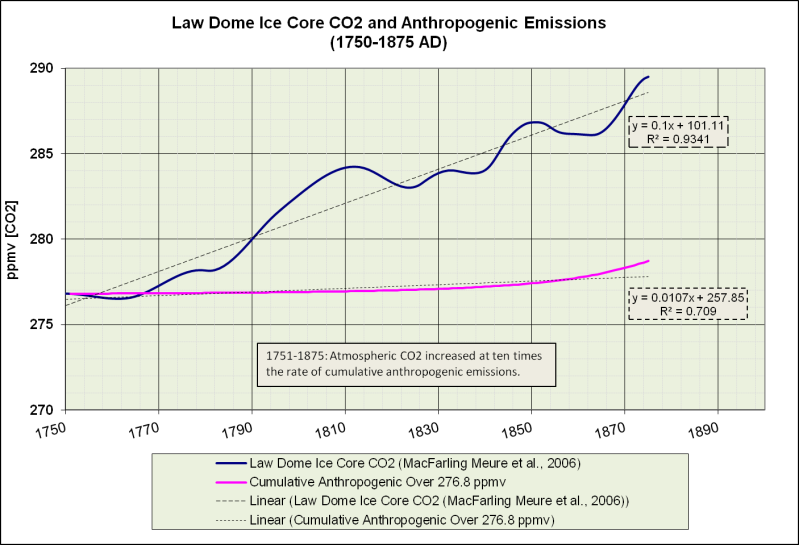

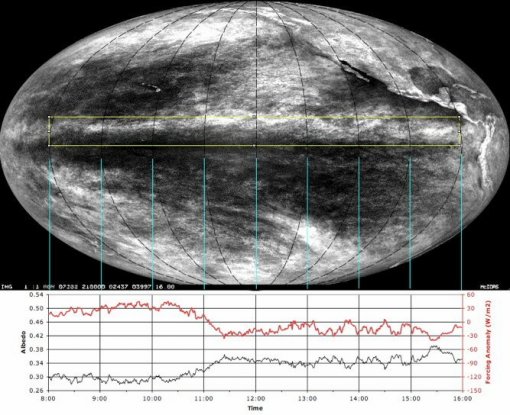

2) Von 1750 bis 1875 stieg die atmosphärische CO2-Konzentration mit einer um das Zehnfache höheren Rate an im Vergleich zu den kumulierten anthropogenen Emissionen …

Fig. 2. Woher in drei Teufels Namen ist dieses CO2 gekommen?

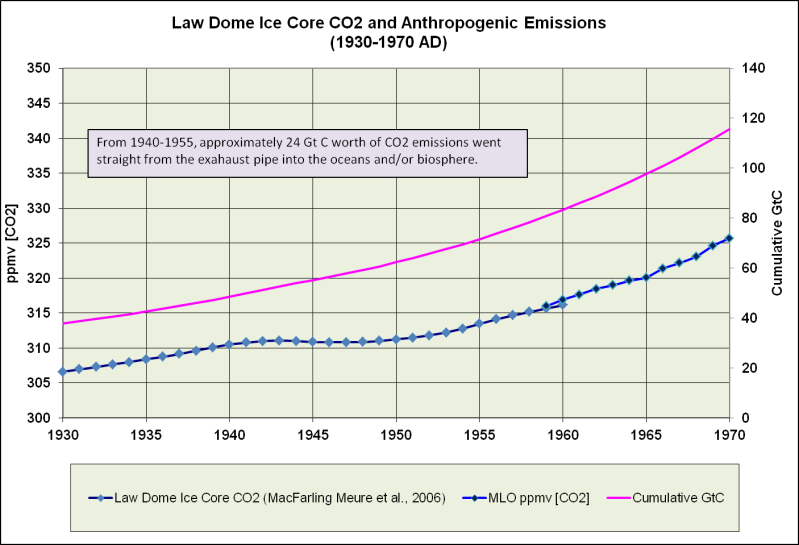

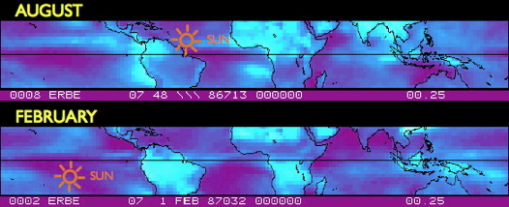

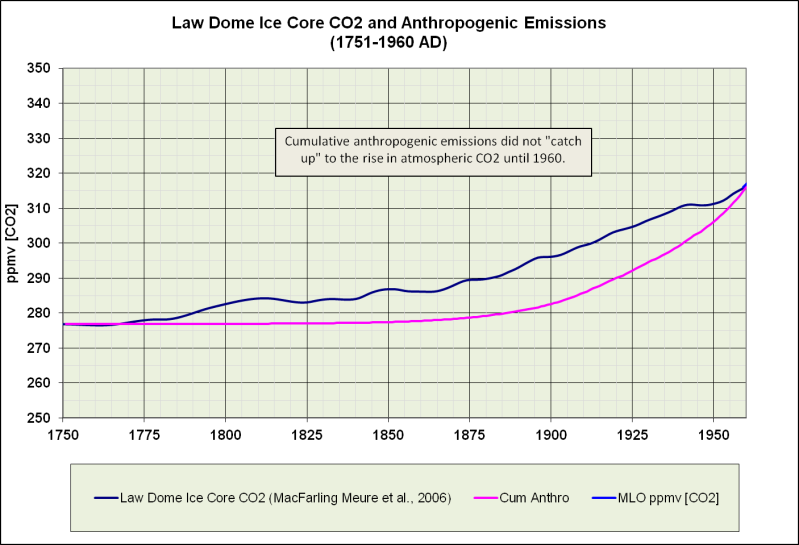

3) Die kumulierten anthropogenen Emissionen haben 1960 nicht mit dem Anstieg des atmosphärischen CO2 gleichgezogen …

Fig. 3. Die Menschen haben über 100 Jahre gebraucht, um mit der Natur gleich zu ziehen.

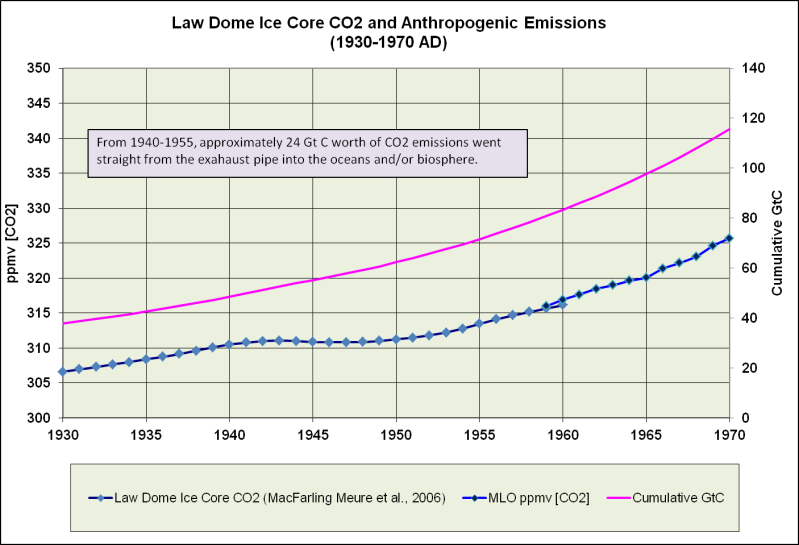

Die Emissionen haben sich nur angeglichen, weil die Konzentration des atmosphärischen CO2 auf einer Höhe um 312 ppmv zwischen 1940-1955 blieb.

Abnahme des atmosphärischen CO2 um die Mitte des 20. Jahrhunderts.

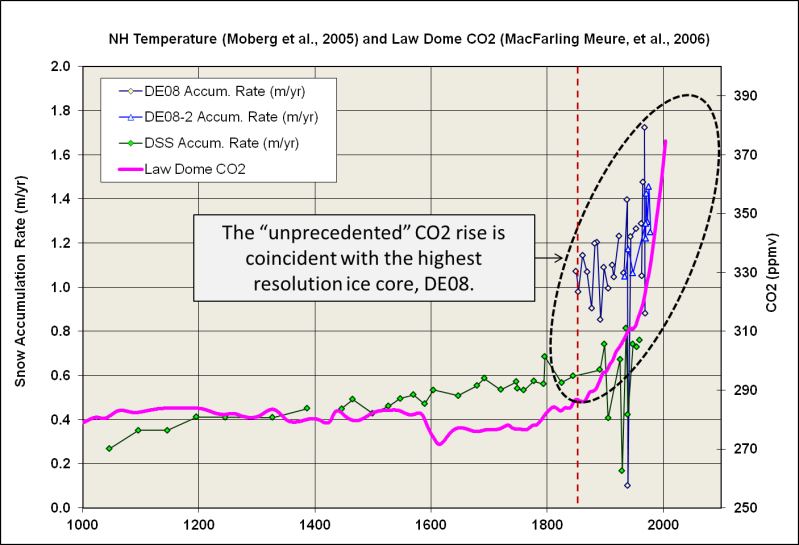

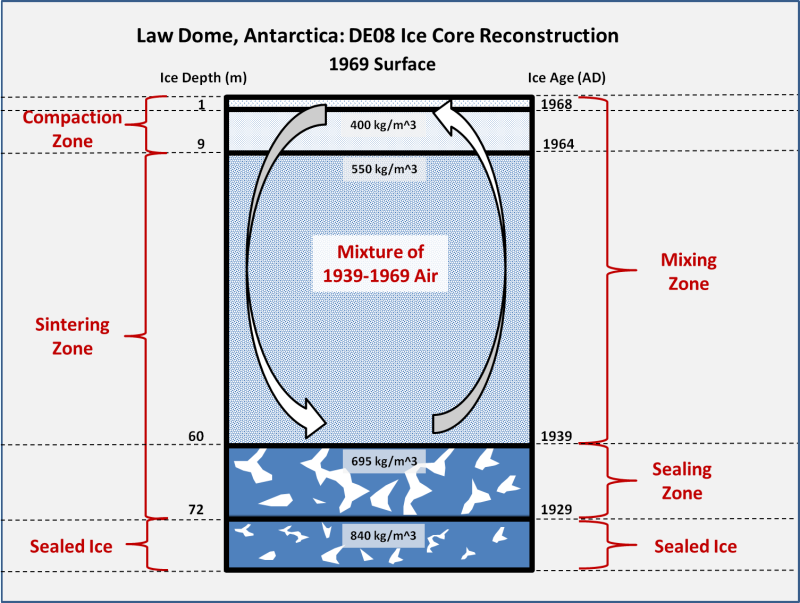

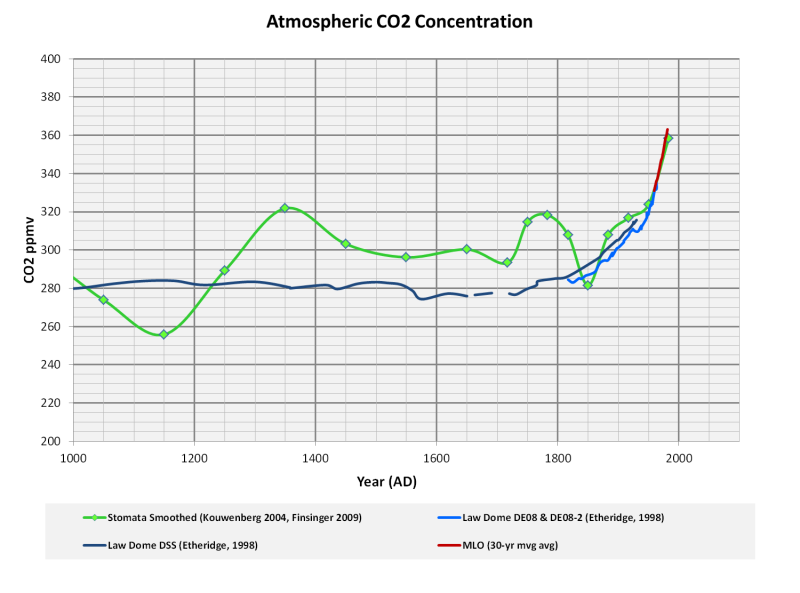

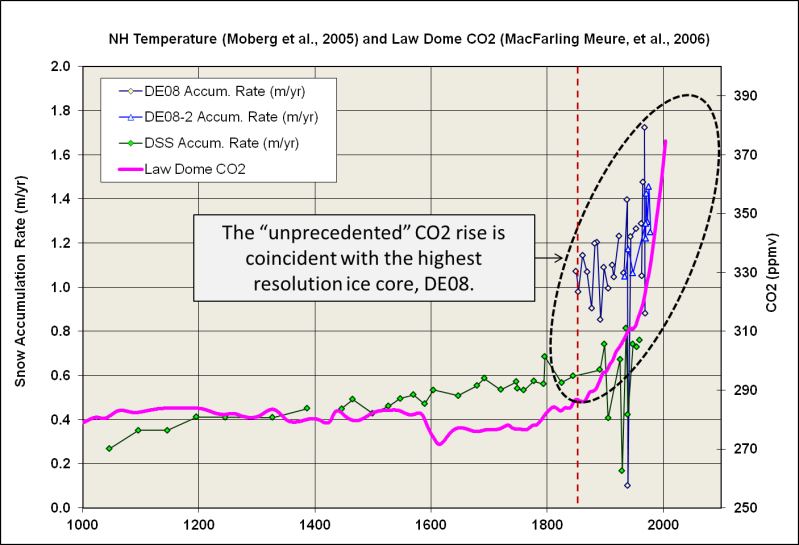

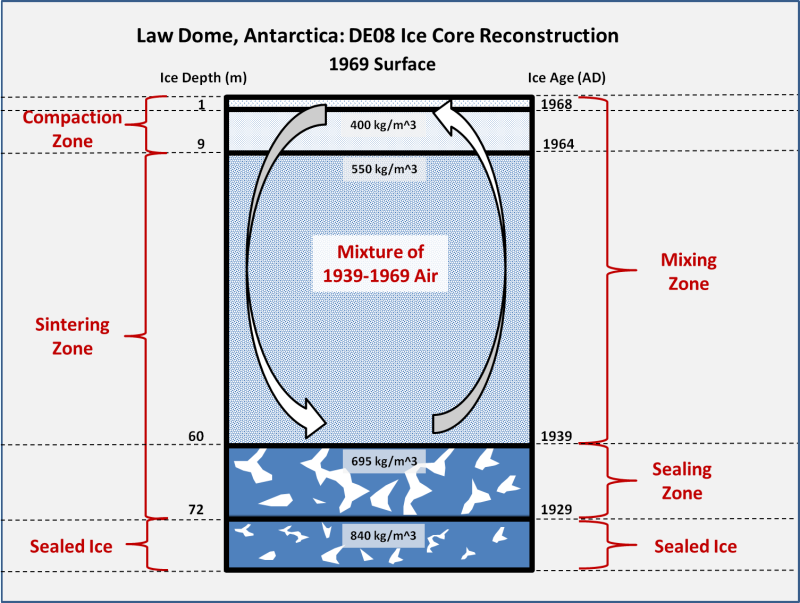

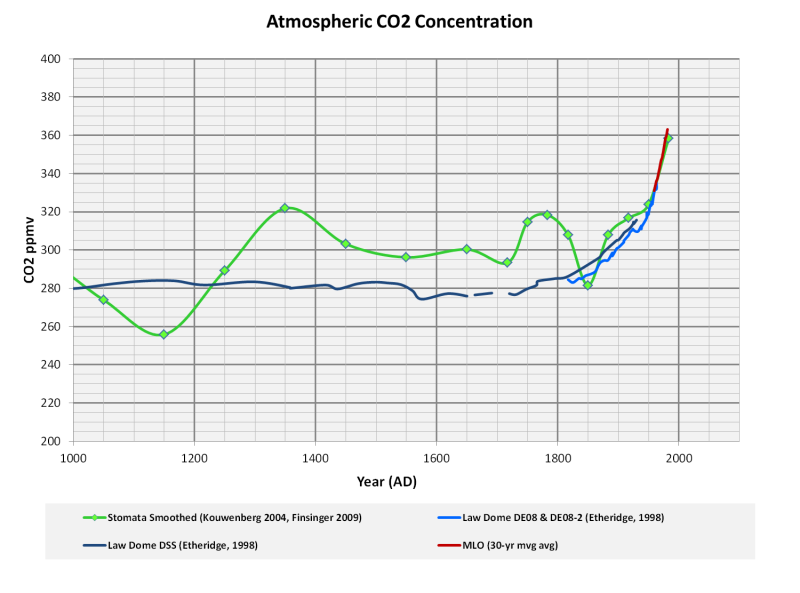

Die mir bekannten antarktischen Eisbohrkerne mit der höchsten Auflösung stammen von Law Dome (Etheridge et al., 1998), hier besonders der DE08 Kern. Im vergangenen Jahrzehnt wurde die Auflösung des Law Dome Eisbohrkerns noch verbessert durch eine dichtere Entnahme von Proben und die Anwendung von frequenzverstärkender Signalverarbeitungstechnik (Trudinger et el., 2002; MacFarling Meure et al., 2006). Wie erwartet haben die höher aufgelösten Daten höhere Variabilität bei den vor-industriellen CO2-Konzentrationen gezeigt.

Pflanzenstomata-Rekonstruktionen (Kouwenberg et al., 2005; Finsinger and Wagner-Cremer, 2009) und heutige chemische Analysen (Beck, 2007) zeigen, dass die CO2 Höhen von den 1930ern bis zu den frühen 1940ern auf der Ebene von 340 bis 400 ppmv lagen und dann rasch in den 1950ern abnahmen. Diese Ergebnisse wurden von den Anhängern des sogenannten wissenschaftlichen Konsens zurückgewiesen, weil diese Fluktuationen nicht in den antarktischen Eisbohrkernen nachzuweisen wären. Dennoch haben MacFarling Meure et al., 2006, entdeckt, dass sich ein möglicher Nachweis einer CO2-Abnahme um die Mitte des 20. Jh. im DE08 Eisbohrkern befände …

Die Stabilisierung der atmosphärischen CO2-Konzentration während der 1940er und 1950er ist eine bemerkenswerte Erscheinung in den Eisbohrkern-Proben. Die neuen hochdichten Messungen bestätigen das Ergebnis und zeigen, dass die CO2-Konzentrationen zwischen 310–312 ppm etwa zwischen 1940 -1955 verharrten. Die Zunahmeraten bei CH4 und N2O haben sich auch in jenem Zeitraum vermindert, die Veränderung bei N2O liegt aber im Bereich der Messungenauigkeit. Die Glättung wegen des Lufteinschlusses im Eis (etwa 10 Jahre bei DE08) entfernt hochfrequente Veränderungen aus der Aufzeichnung, die wahre atmosphärische Variation kann daher größer sein, als sie sich in den den Luftproben im Eisbohrkern darstellt.

Sogar eine Abnahme der atmosphärischen CO2-Konzentration Mitte der 1940er stimmt mit der Law Dome Aufzeichnung einschließlich der Glättung durch den Lufteinschluss überein, was auf eine große zusätzliche Senke von ~3.0 PgC Jahr-1 hinweist. [Trudinger et al., 2002a]. Die d13CO2 Aufzeichnung aus jener Zeit lässt erkennen, dass diese zusätzliche Senke meist ozeanischer Herkunft war und nicht durch niedrigere fossile Emmissionen oder die irdische Biosphäre verursacht. [Etheridge et al., 1996; Trudinger et al., 2002a]. Immer noch ungeklärt ist, welche Prozesse diese Erscheinung hervorgerufen haben könnten.

Die CO2-Stabilisierung ereignete sich während eines Wechsels eines lang andauernden El Niño zu einem La Niña [Allan and D’Arrigo, 1999]. Dies fiel zusammen mit einem Übergang von einer Warm- zu einer Kalt-Phase der Pacific Decadal Oscillation [Mantua et al., 1997], einer Abkühlung [Moberg et al., 2005] und progressiv zunehmender Abschwächung der nordatlantischen thermohalinen Zirkulation [Latif et al., 2004]. Der kombinierte Effekt dieser Faktoren auf die Gasmengen wird derzeit noch nicht gut verstanden. Sie könnten signifikant für die atmosphärische CO2-Konzentration sein, falls der Austausch in Bereichen von Kohlenstoff-Aufnahmen, wie z. B. im Nordpazifik, verstärkt, oder wenn der Abfluss aus den Tropen unterdrückt würde.

Von etwa 1940 bis einschließlich 1955 gingen ca. 24 Mrd. Tonnen Kohlenstoff aus Abluftkaminen direkt in die Ozeane und/oder in die Biosphäre.

Fig. 4. Oh weh! Was ist mit all dem Kohlenstoff passiert?

Wenn die Aufnahme von CO2 in die Ozeane eine Versauerung der Meere bewirkt haben sollte, müssten wir dann nicht Beweise dafür finden? Hätte nicht eine “große zusätzliche Senke von ~3.0 PgC Jahr-1″ (oder mehr) von ~1940-1955 irgendwo in den Ozeanen Spuren hinterlassen müssen, vielleicht Schnecken oder ein Riff aufgelöst haben?

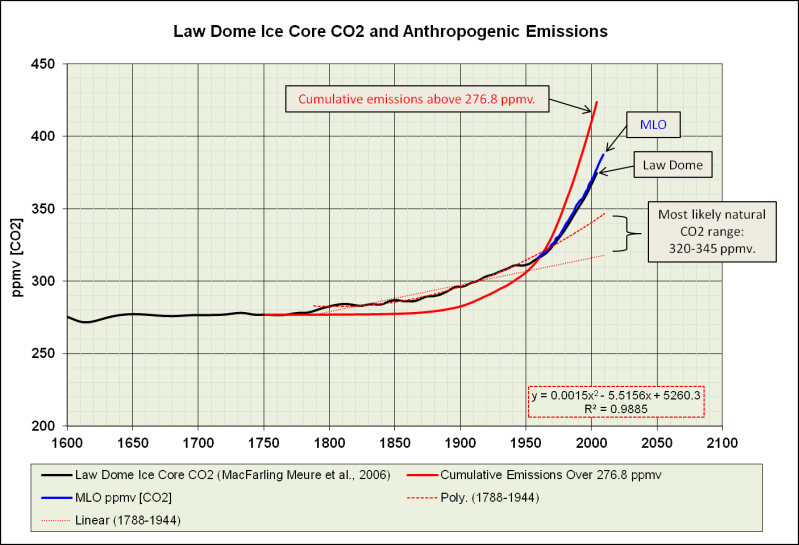

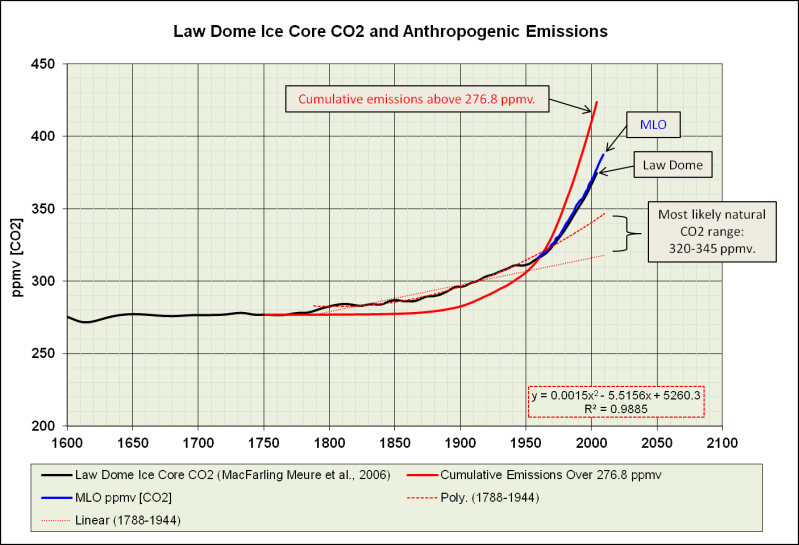

Wenn das atmosphärische CO2 nur einfach seinen prä-industriellen Verlauf fortgesetzt hätte, wären sehr wahrscheinlich 315-345 ppmv um 2010 erreicht worden …

Fig. 5. Wahrscheinlich sind 40-60% des Anstiegs des atmosphärischen CO2 seit 1750 auf natürliche Ursachen zurückzuführen.

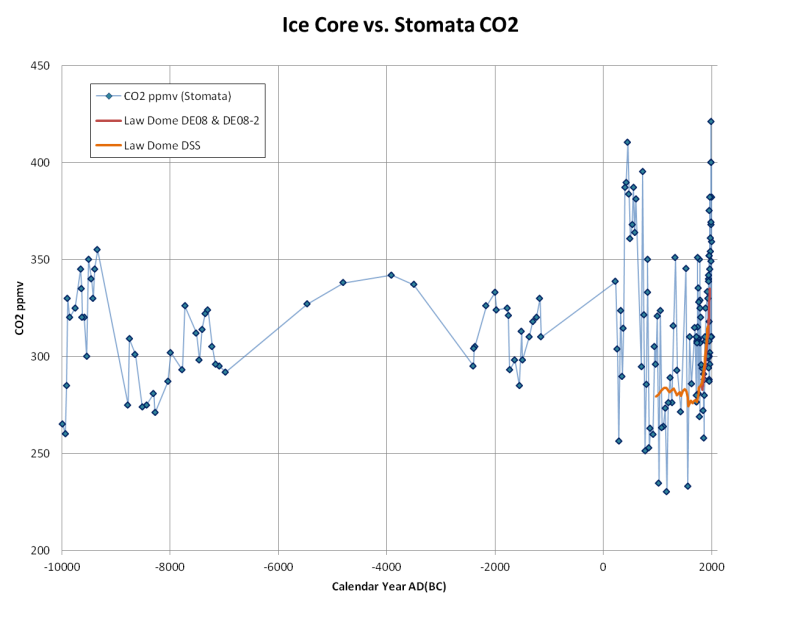

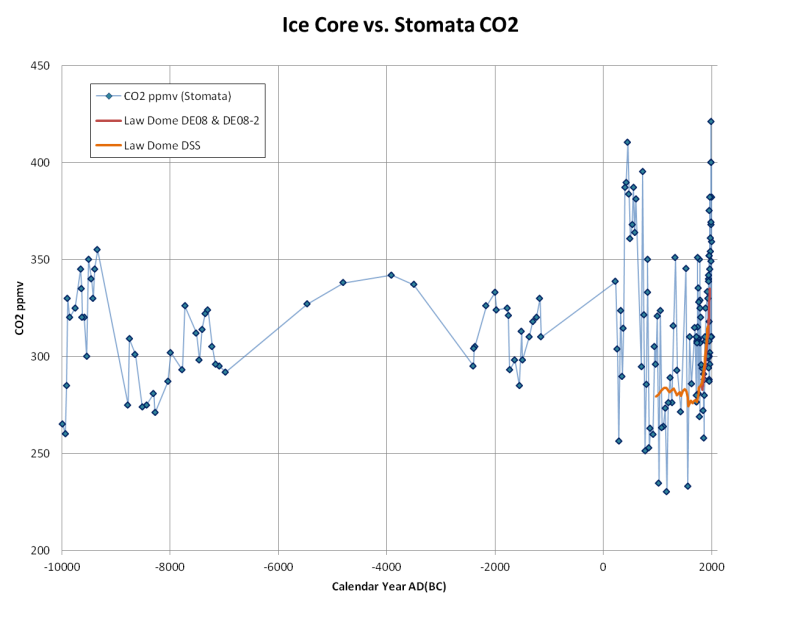

Es ist doch seltsam, dass die aus Pflanzen-Stomata abgeleiteten CO2-Rekonstruktionen darauf hindeuten, dass CO2-Konzentrationen von 315-345 ppmv während des Holozäns nicht ungewöhnlich waren …

Fig. 6. CO2 aus Pflanzen-Stomata: Nordschweden (Finsinger et al., 2009), Nordspanien (Garcia-Amorena, 2008), Südschweden (Jessen, 2005), Washington State USA (Kouwenberg, 2004), Niederlande (Wagner et al., 1999), Dänemark (Wagner et al., 2002).

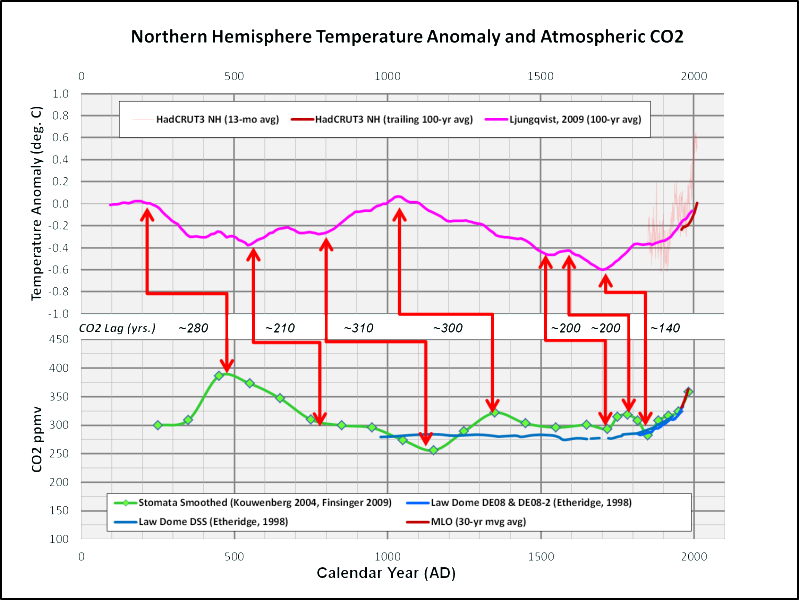

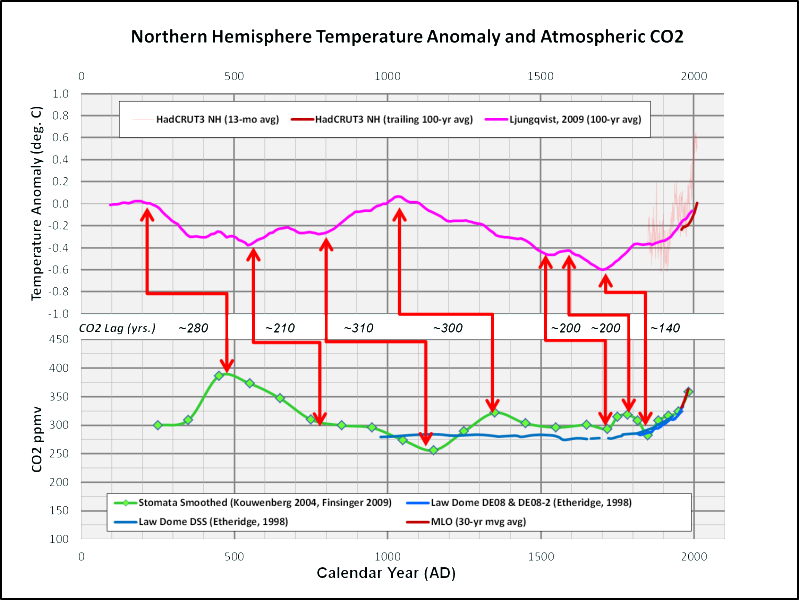

Was also könnte all diese CO2-Veränderungen angetrieben haben, bevor der Mensch anfing, fossile Brennstoffe zu benutzen? Waren es möglicherweise doch Temperaturänderungen?

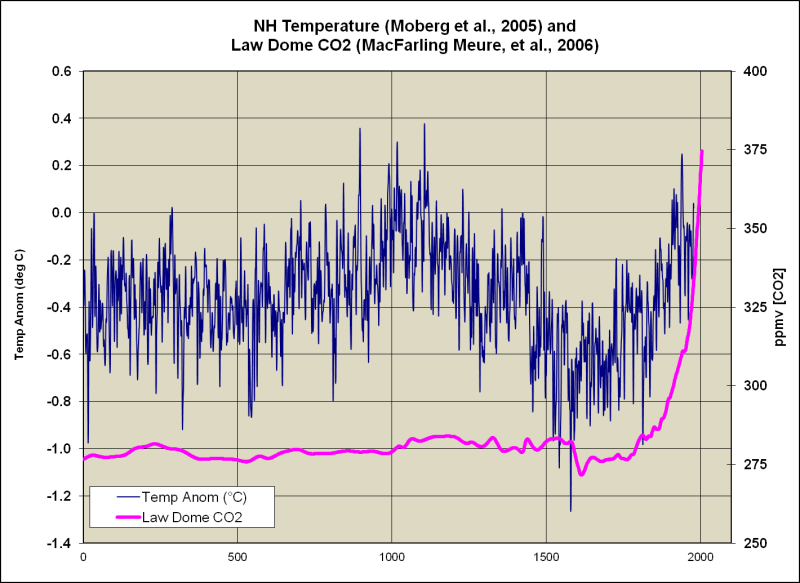

CO2 als Feedback

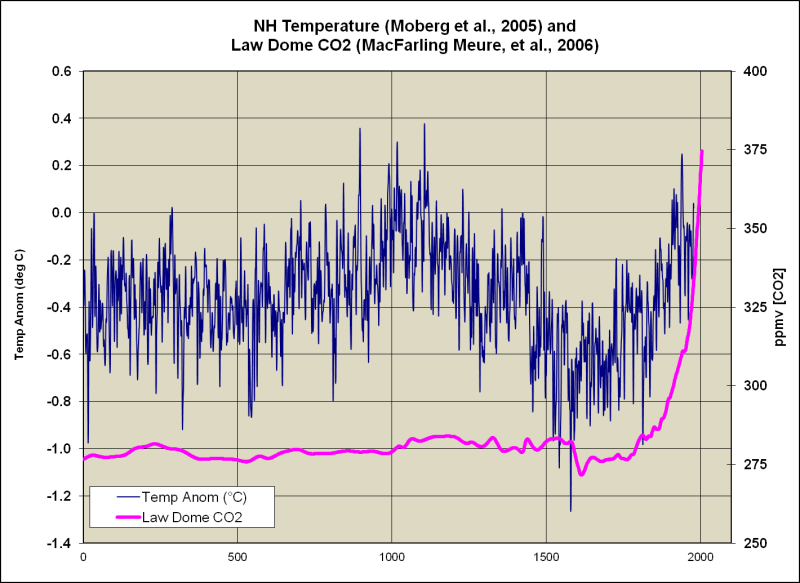

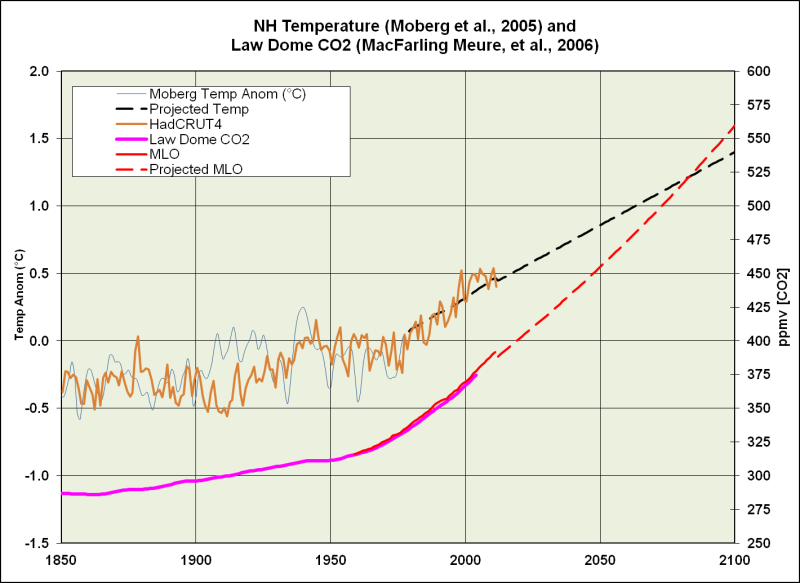

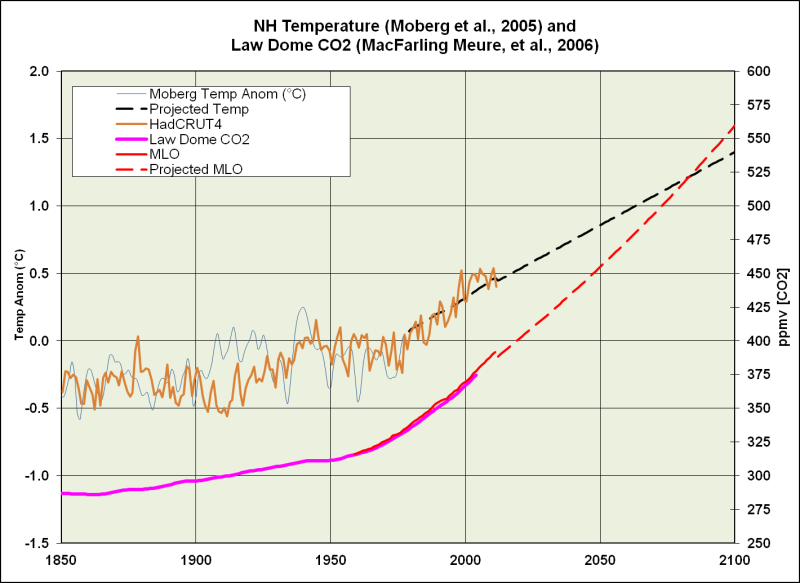

Wenn ich eine Temperatur-Rekonstruktion (Moberg et al., 2005) zusammen mit der Law Dome CO2-Ganglinie plotte, sieht es für mich ganz so aus, als ob das CO2 etwa 100 Jahre nach dem Temperaturanstieg mit dem Anstieg begann …

Fig. 7. Temperatur-Rekonstruktion (Moberg et al., 2005) und Law Dome CO2 (MacFarling Meure et al., 2006).

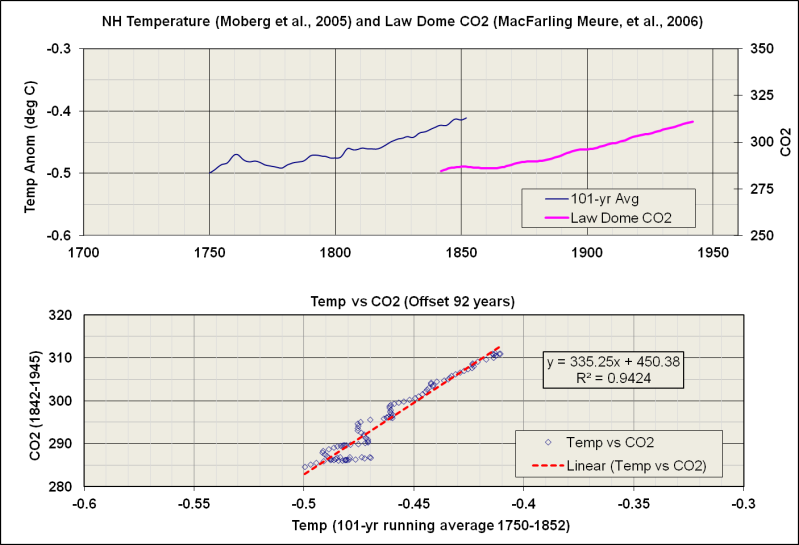

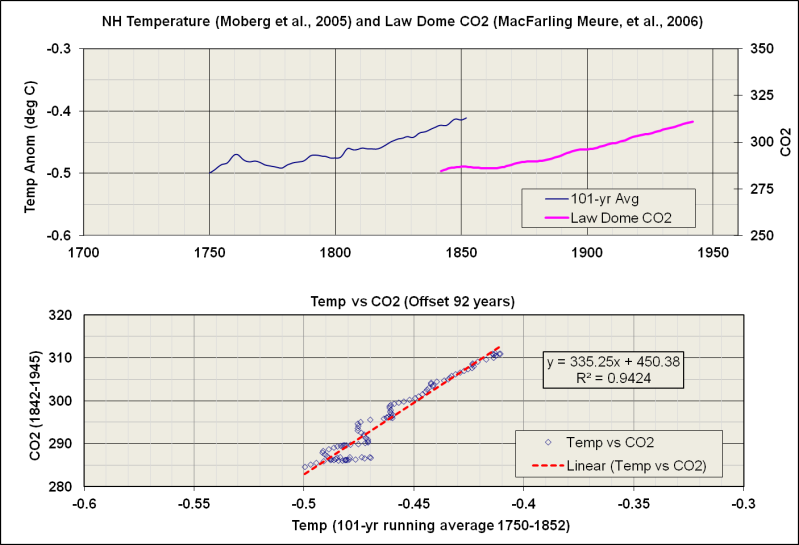

Der Anstieg des CO2 von 1842-1945 sieht ganz so aus, wie der Temperaturanstieg von 1750-1852…

Fig. 8. Mögliche Beziehung zwischenTemperaturanstieg und nachfolgendem CO2-Anstieg.

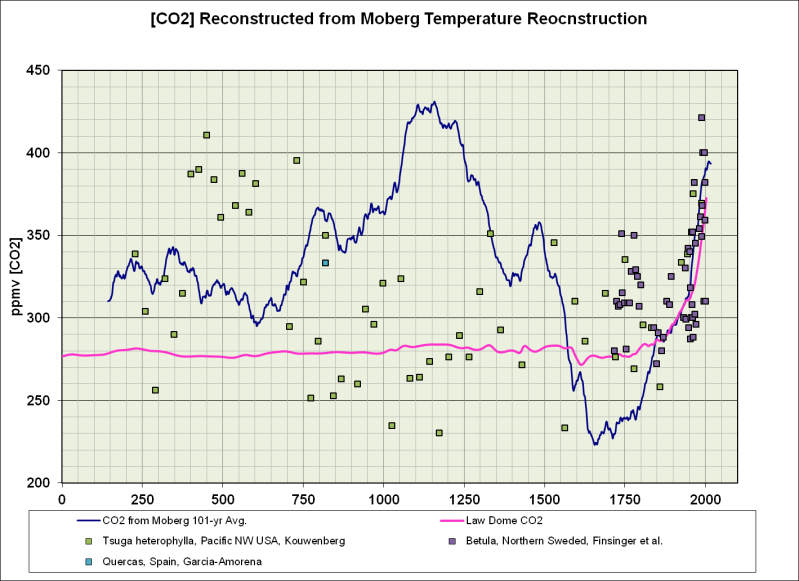

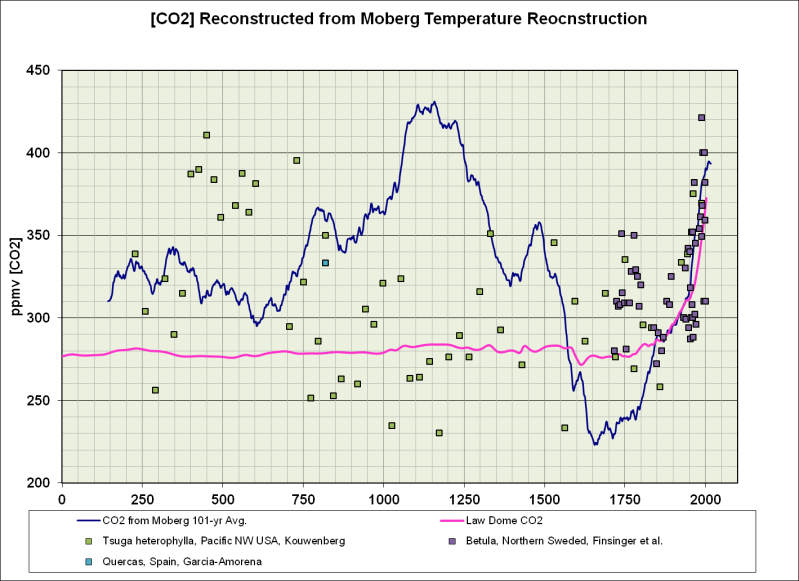

Die Korrelation ist sehr stark. Eine berechnete CO2-Chronologie ergibt eine gute Übereinstimmung mit dem DE08 Eisbohrkern und dem Stomata-abgeleiteten CO2 seit 1850. Man sieht auch, dass das atmosphärische CO2 auf ~430 ppmv um die Mitte des 12. Jahrhunderts n.Chr. anstieg.

Fig. 9. CO2 aus den Moberg-Temperaturen errechnet (dunkelblaue Linie), Law Dome Eisbohrkern (Magentafarbene Linie) und Pflanzenstomata (grün, hellblaue und purpurfarbene Kästchen).

Die Spitze des CO2 um die Mitte des 12. Jh. zeigt sich weder in den Eisbohrkernen noch in den Pflanzenstomata. Die Korrelation bricht vor den 1830ern ab. Der gleiche Abbruch zeigt sich auch, wenn CO2 als Antrieb und nicht als Feedback behandelt wird.

CO2 als Antrieb

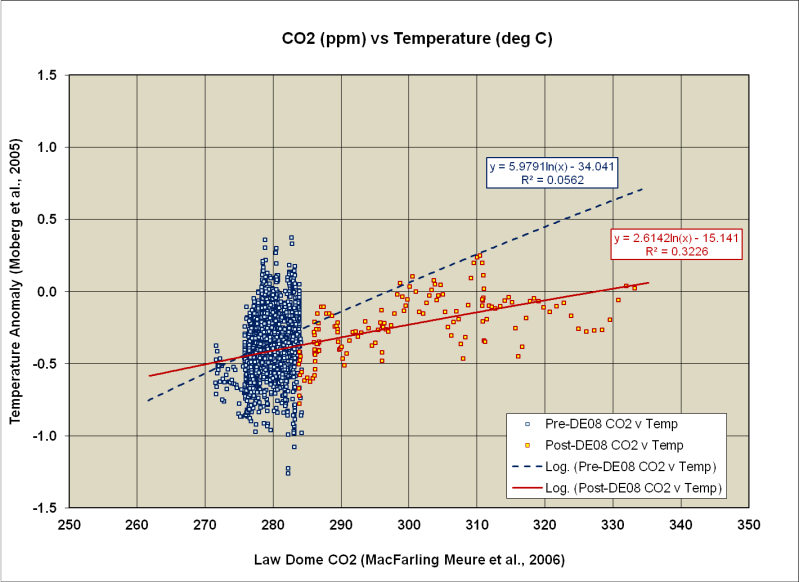

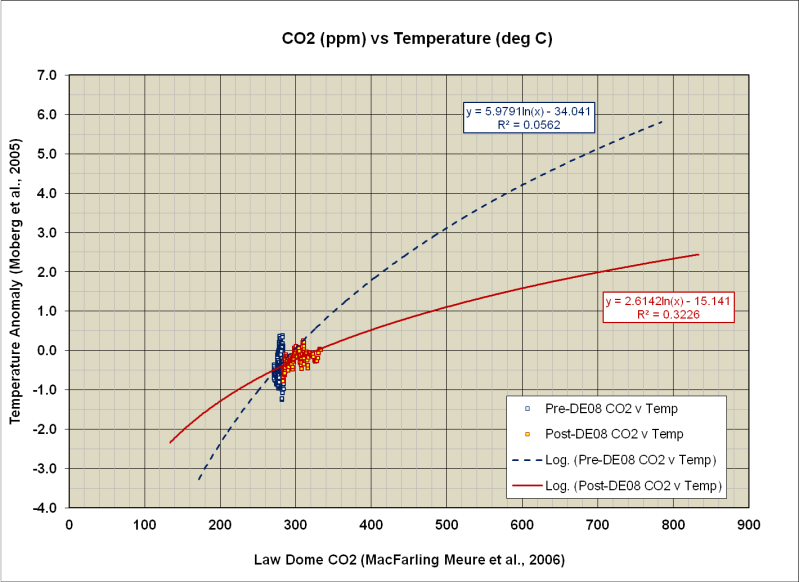

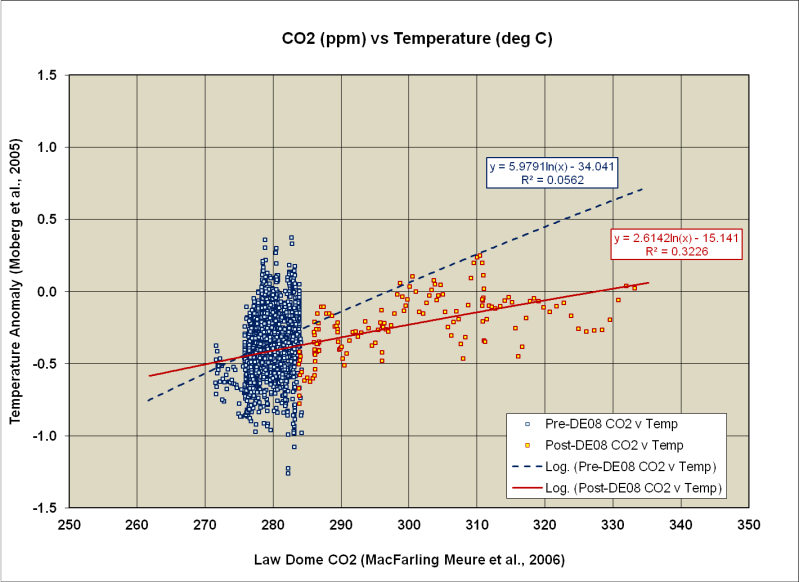

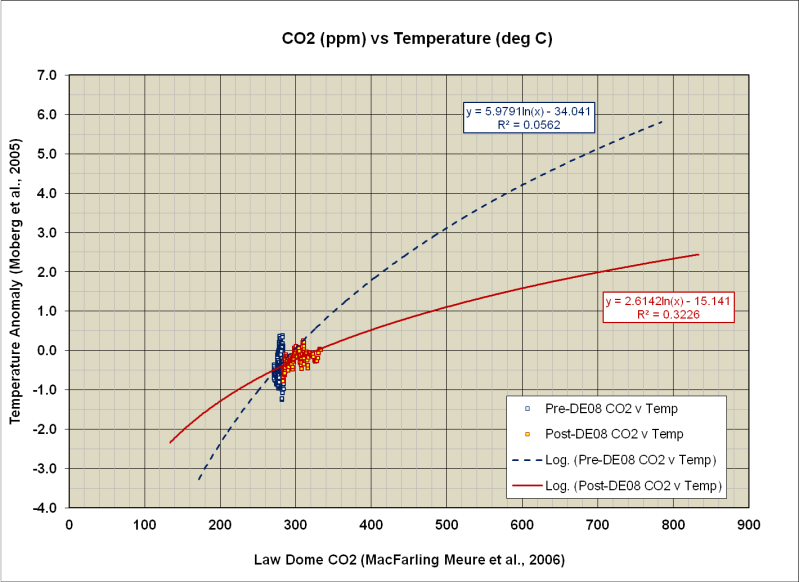

Wenn ich direkt das CO2 vs. Temperatur ohne Verzögerung plotte, erhalte ich eine gute Korrelation mit den Nach-DE08-Eisbohrkern-Daten (>1833) und überhaupt keine Korrelation mit den Prä-DE08-Eisbohrkerndaten (<1833) …

Fig. 10. Temperature und CO2 zeigen eine mäßige Korrelation seit ~1833; aber überhaupt keine Korrelation vor 1833.

Wenn ich bis auf etwa 840 ppmv CO2 extrapoliere, erhalte ich etwa 3 °C Erwärmung bezogen auf 275 ppmv. Ich erhalte also den gleichen Betrag an Erwärmung bei einer Verdreifachung des prä-industriellen CO2. Das IPCC behauptet das schon bei einer Verdoppelung.

Fig. 11. CO2 vom Law Dome DE08 Eisbohrkern, geplottet gegen Mobergs NH Temperatur-Rekonstruktion.

Das auf dieser Korrelation beruhende Gleichgewicht der Klimasensitivität (Equilibrium Climate Sensitivity – ECS) bei einer Verdoppelung des prä-industriellen CO2 beträgt ~1.5 to 2.0 °C. Sehr rätselhaft ist aber das totale Fehlen einer Korrelation in den Eisbohrkernen, die älter als DE08 sind.

Eisbohrkern-Auflösung und das Fehlen einer Temperatur-Verbindung mit CO2 vor 1833

Könnte das Fehlen der Variabilität in den älteren (aus tieferen Schichten stammenden) Eisbohrkernen etwas mit der Auflösung zu tun haben? Der DE08 Eisbohrkern hat eine viel stärkere Auflösung als nahezu alle anderen antarktischen Eisbohrkerne, darin eingeschlossen der tiefere und ältere DSS Eisbohrkern von Law Dome.

Fig. 12. Die zeitliche Auflösung der Eisbohrkerne wird von der Schnee-Akkumulationsrate bestimmt.

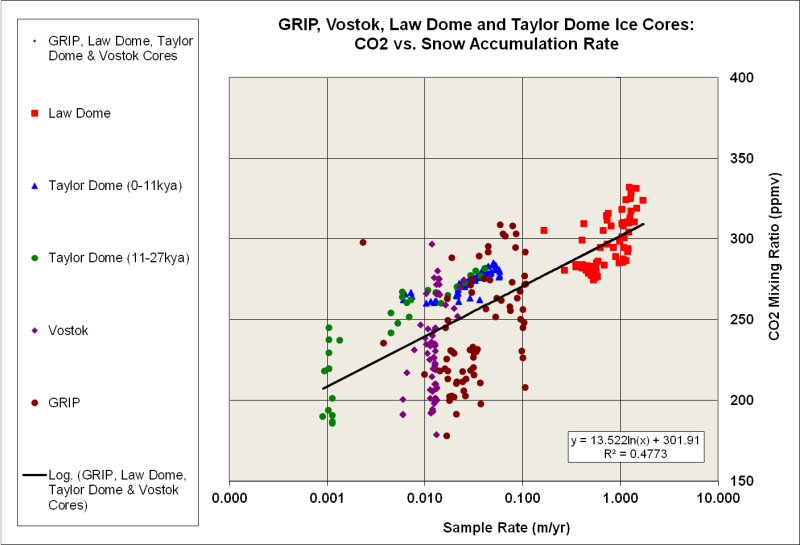

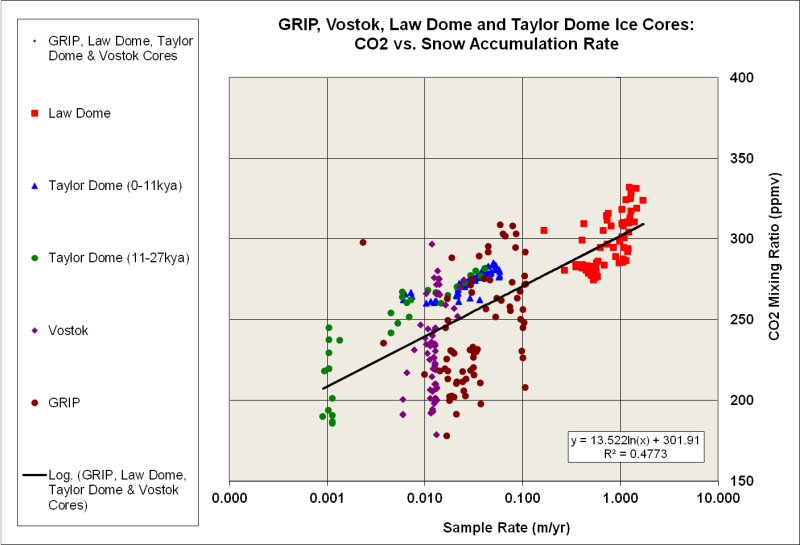

Die Amplitude des CO2-“Signals” scheint auch gut mit der Schnee Akkumulationsrate zu korrelieren (Auflösung) des Eisbohrkerns…

Fig. 13. Schnee-Akkumulationsrate vs. CO2 für verschiedene Eisbohrkerne aus Antarktika und Grönland.

Könnte es sein, dass Schnee-Akkumulationsraten, die signifikant unter 1 m/a liegen, jahrhundertlange und höherfrequente CO2-Schübe nicht auflösen? Könnte es auch sein, dass die Frequenzdegradation ebenfalls die Amplitude des CO2-“Signals” abschwächt?

Wenn die weitaus meisten Eisbohrkerne, die älter und tiefer als DE08 sind, die jahrhundertelangen und höherfrequenten CO2-Schübe nicht auflösen, macht es dann nicht Sinn, dass Eisbohrkern-abgeleitete CO2- und Temperaturgänge nur als kaum zusammenhängend für den längsten Teil des Holozäns gelten müssen?

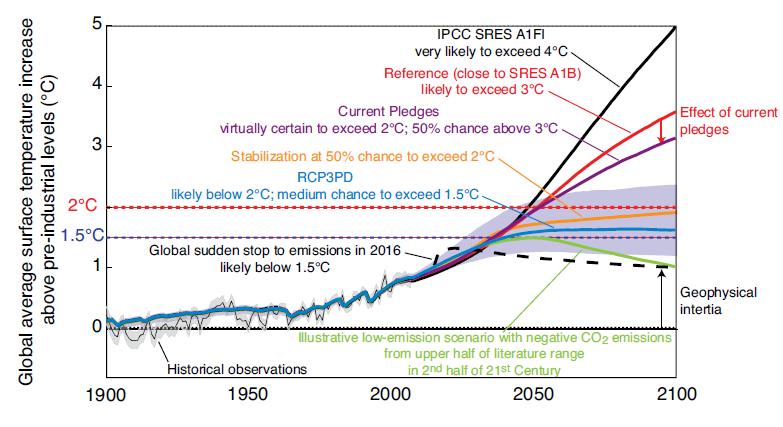

Warum scheinen die Belege immer nur anzuzeigen, dass das beste Szenario des IPCC das schlimmste ist, das in der realen Welt vorkommen kann?

Dieses Stück aus einem Artikel von Brad Plummer in der Washington Post erregte meine Aufmerksamkeit …

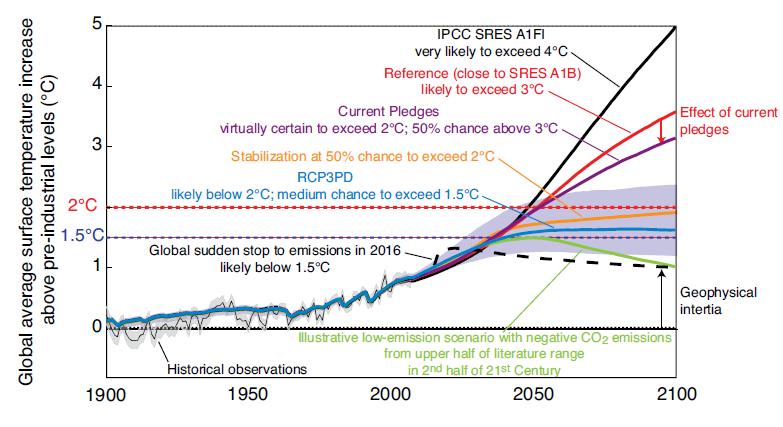

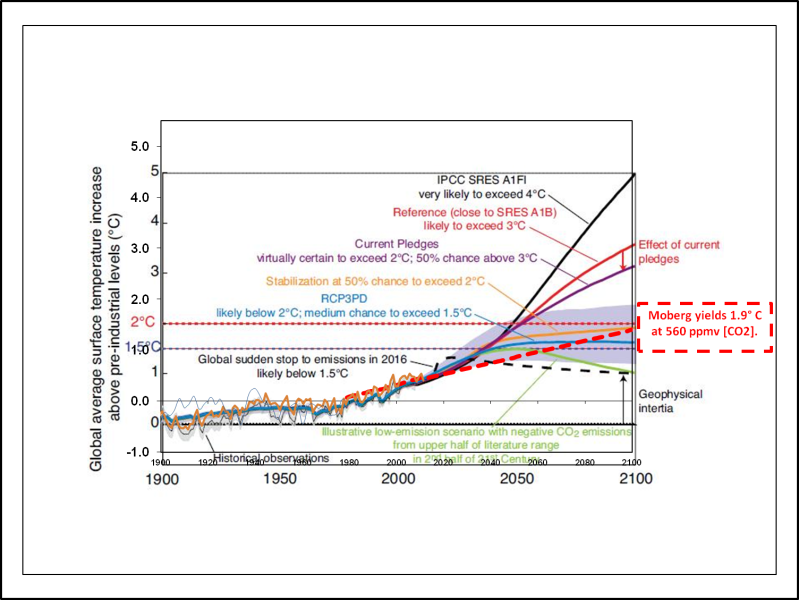

Fig. 14. Die mythischen Szenarien des IPCC. Ich denke, der graue Bereich repräsentiert den Bereich von "Grüntopia" [Anm.d.Ü.: der Verfasser benutzt ein Wortspiel: aus UTOPIA macht er GRÜNTOPIA.]

Es sieht so aus, als ob die Erde um 2100 n.Chr. zu einer Venus (A1FI) würde, wenn es so weiterginge, wie gehabt.

Wie sieht es aus, wenn ich reale Daten benutze?

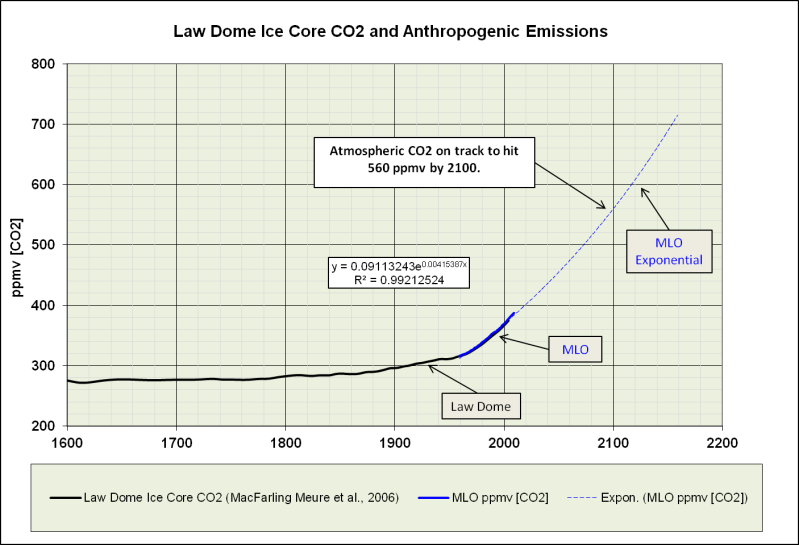

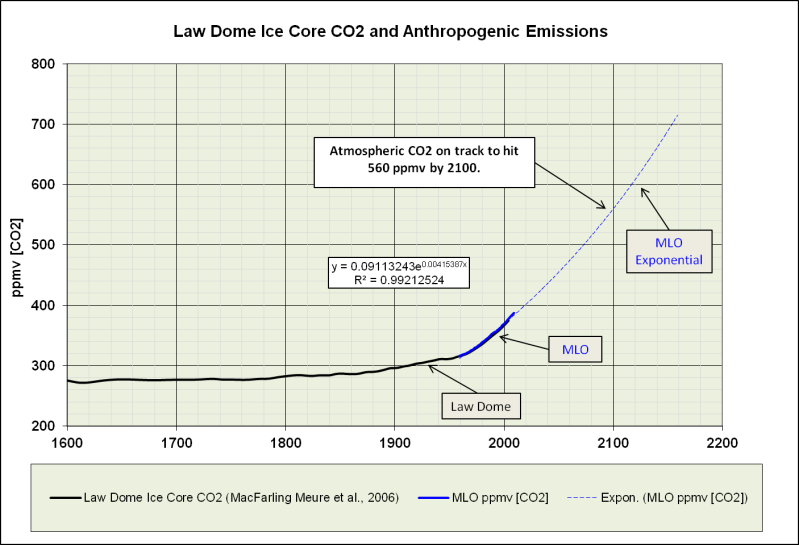

Nehmen wir an, dass das atmosphärische CO2 entlang einer exponentiellen Trendlinie bis 2100 ansteigt.

Fig. 15. Projektion des CO2 bis 560 ppmv im Jahre 2100.

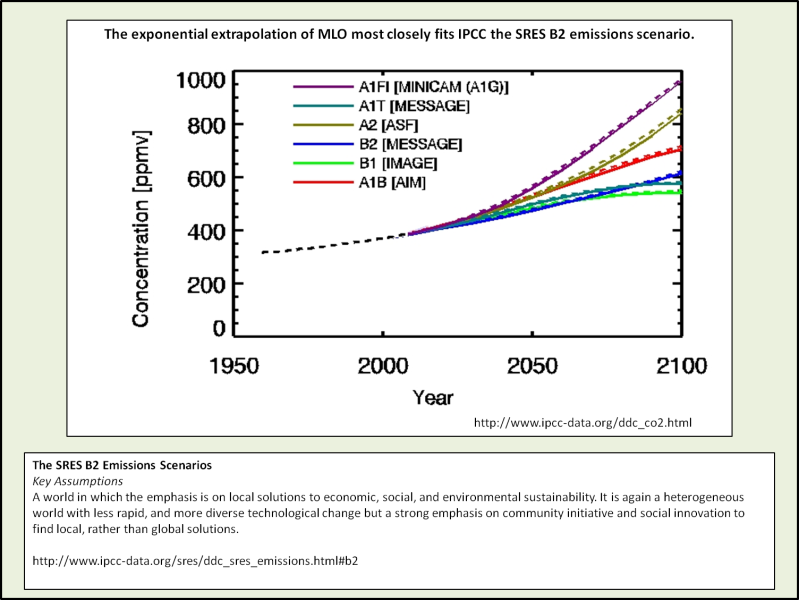

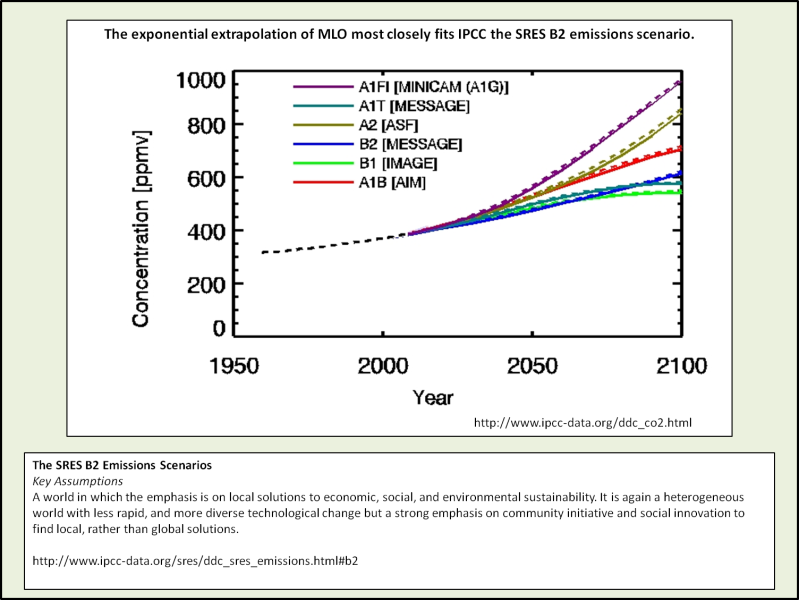

Ich erhalte eine CO2-Konzentration von 560 ppmv, das gleicht dem IPCC Emissions-Szenario SRES B2 …

Fig. 16. IPCC Emissions-Szenarien.

Wenn es weitergeht, wie gehabt, werden wir die gleiche Konzentration haben, wie im IPCC Grüntopia-Szenario. Warum bin ich nicht erstaunt?

Wenn wir annähmen, dass die gesamte Erwärmung seit 1833 vom CO2 verursacht wurde (das stimmt nicht), würden 560 ppmv zu etwa 1°C zusätzlicher Erwärmung im Jahre 2100 führen.

Fig. 17. Projizierter Temperatur-Anstieg, abgeleitet aus der Moberg NH Temperatur-Rekonstruktion und dem CO2 aus dem Law Dome DE08 Eisbohrkern. Projizierte Temp. Anom. = 2.6142 * ln(CO2) – 15.141

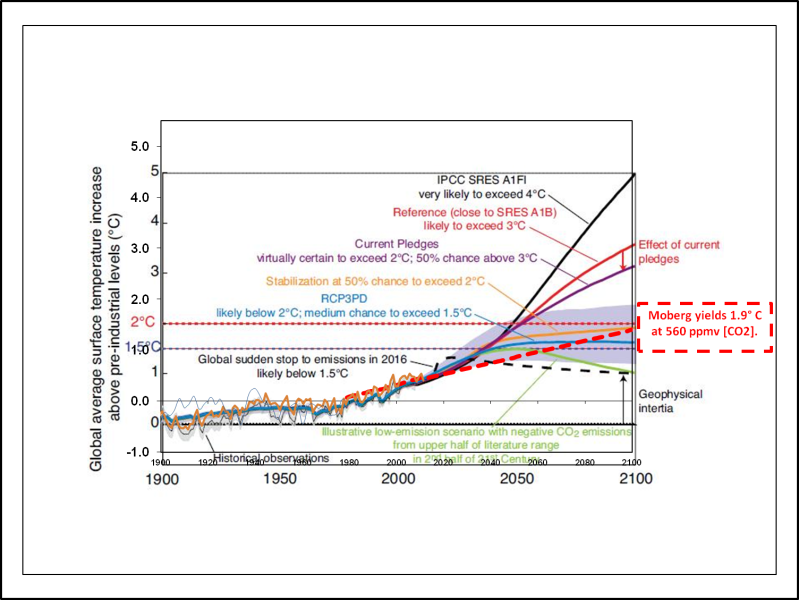

Wie verträgt sich das mit den mythischen Szenarien des IPCC? So ungefähr, wie erwartet. Das schlimmste Szenario, das aus den derzeitigen Beobachtungen abgeleitet werden kann, gleicht dem bestmöglichen IPCC-Szenario aus Grüntopia …

Fig. 18. Der aus Mobergs NH-Temperatur-Rekonstruktion und dem CO2 aus dem Law Dome DE08 Eisbohrkern abgeleitete projizierte Temperatur-Anstieg weist darauf hin, dass die 2°C “Grenze” des IPCC nicht überschritten werden wird.

Schlussfolgerungen

Die Rekorde bei den atmosphärischen CO2-Konzentration waren bereits gebrochen, bevor anthropogene Emissionen bedeutend wurden.

Atmosphärische CO2-Konzentrationen sind zwischen 1750-1875 rascher angestiegen als anthropogene Emissionen.

Anthropogene Emissionen haben bis 1960 nicht mit dem atmosphärischen CO2 gleichgezogen.

Der natürlichel Kohlenstoff-Austausch-Fluss ist variabler als der sogenannte wissenschaftliche Konsens wahrhaben will.

Das Gleichgewicht der Klimasensitivität (ECS) kann 2°C nicht übersteigen und ist wahrscheinlich näher bei 1°C.

Das schlimmste Szenario, das auf Belegen beruht, gleicht dem besten grün-utopistischen des IPCC.

Eisbohrkerne mit Akkumulationsraten unter 1m/a taugen nicht für ECS-Abschätzungen.

Das ECS, das aus dem Law Dome DE08 Eisbohrkern und Mobergs NH-Temperatur- Rekonstruktion abgeleitet iist, unterstellt, dass die gesamte Erwärmung seit 1833 dem CO2 zuzurechnen wäre. Wir wissen sicher, dass mindestens die Hälfte der Erwärmung auf solare Einflüsse und natürliche klimatische Schwankungen zurückgeht. Daher sind die abgeleiteten 2°C wahrscheinlich nur 1°C. Weil klar ist, dass etwa die Hälfte des Anstiegs von 275 auf 400 ppmv natürlichen Ursprungs ist, liegt die anthropogene Komponente des 1°C ECS wahrscheinlich unter 0,7°C.

Das Fehlen einer Korrelation zwischen Temperatur und CO2 seit dem Beginn des Holozäns bis 1833 und die Tatsache, dass der moderne CO2-Anstieg mindestens 200 Jahre lang höher war als die anthropogenen Emissionen, führt mich als Amateur-Klimaforscher zu dem Schluss, dass das CO2 während der vergangenen 10.000 Jahre sehr viel veränderlicher war als die antarktischen Eisbohrkerne anzeigen.

Appendix I: Ein alternativer Blick auf die CO2-Anstiegsrate

In Fig. 15 habe ich eine mit Excel berechnete exponentielle Trendlinie erzeugt, um die MLO CO2 Zeitreihe zu extrapolieren bis zum Ende dieses Jahrhunderts. Wenn ich die Emissionen extrapoliere und annehme, dass 55% der Emissionen in der Atmosphäre verbleiben, erhalte ich ~702 ppmv bis zum Ende des Jahrhunderts, dazu gehören 0,6°C Erwärmung und eine gesamte Erwärmung von 2,5°C gegenüber der “präindustriellen.” Sogar dieses schlimmste aller schlimmen Szenarien ergibt 1°C weniger Erwärmung als das IPCC-A1B-Referenz-Szenario. Es steht etwa in der Mitte zwischen A1B und dem oberen Rand des grün-utopistischen Bandes.

Appendix II: CO2-Aufzeichnungen, frühe Jahre

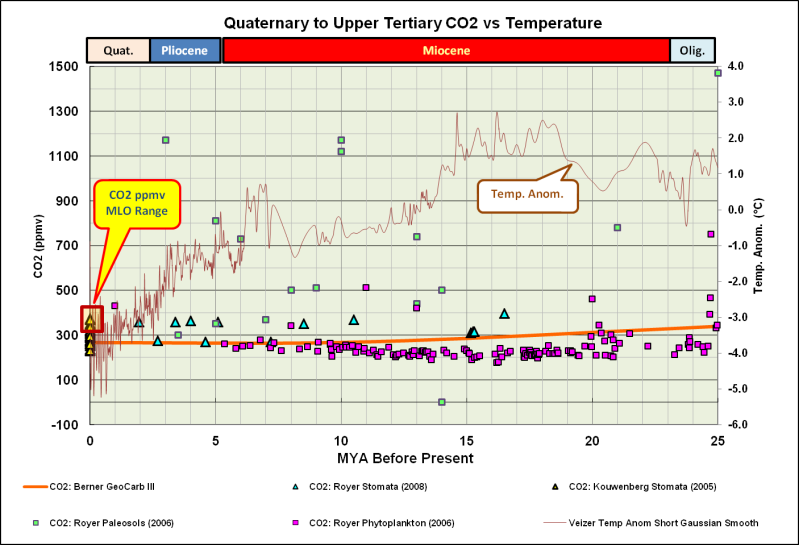

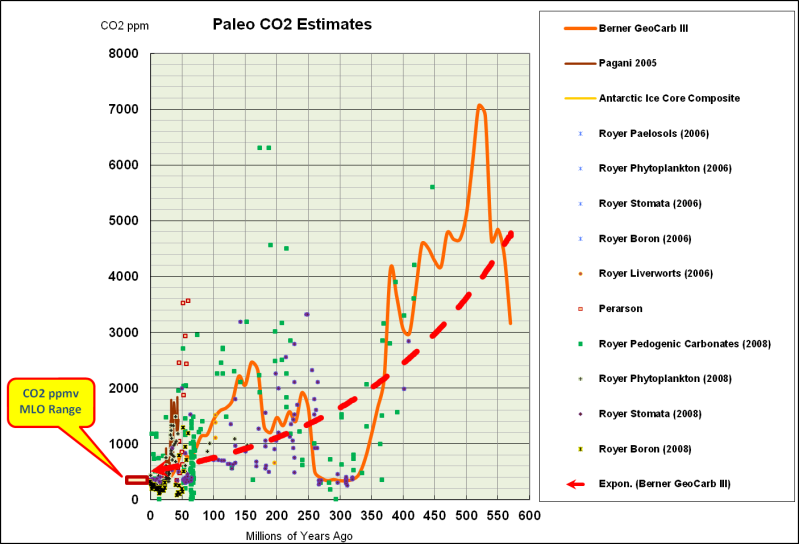

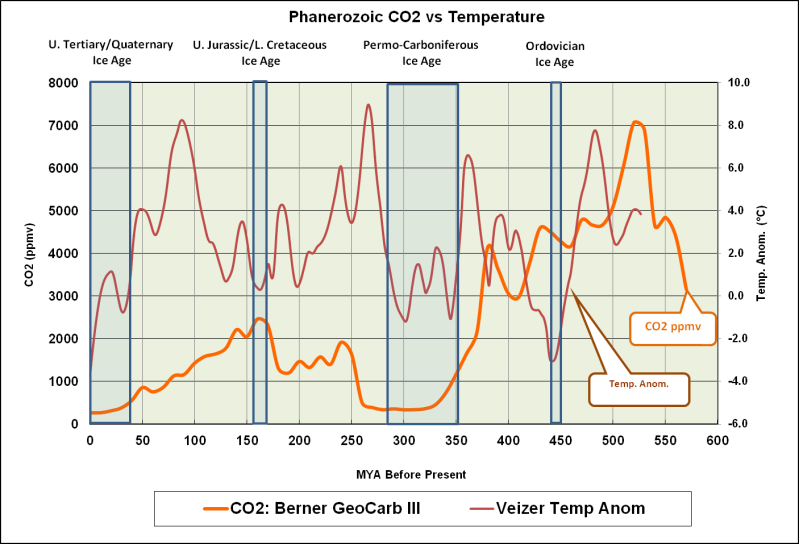

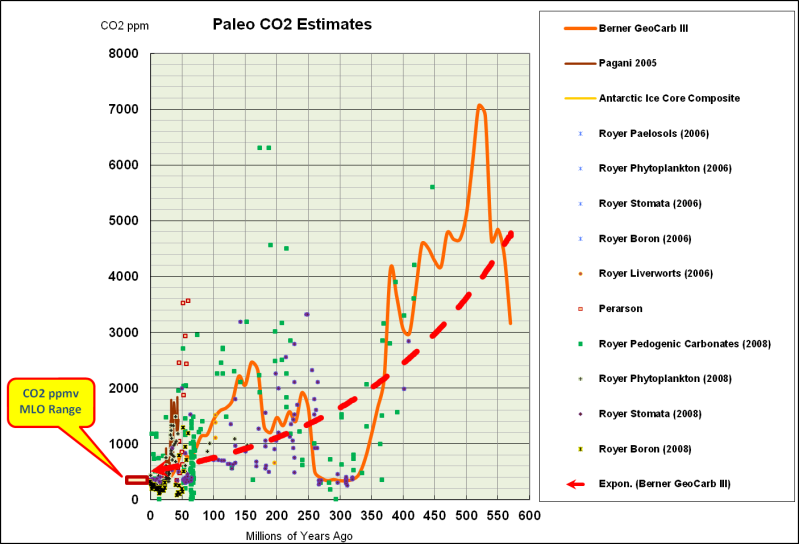

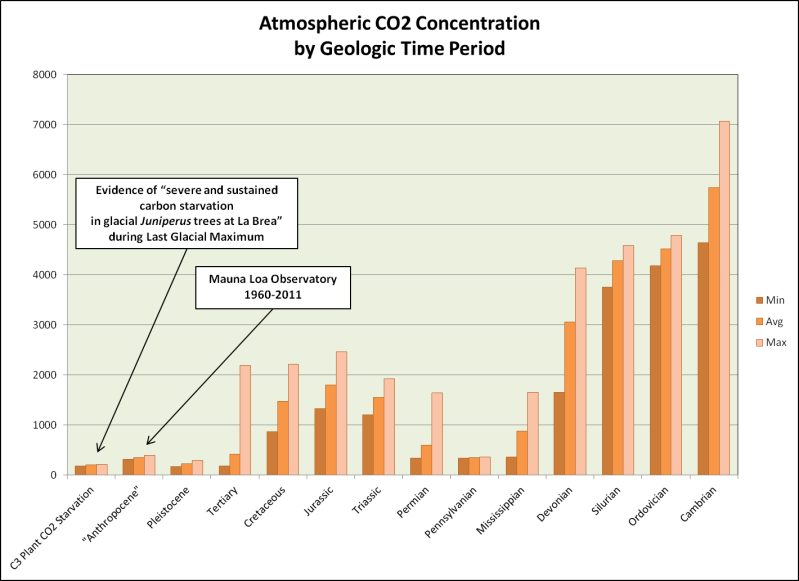

Immer wenn CO2-Aufzeichnungen erwähnt werden oder atemberaubende Aussprüche wie, “Kohlendioxid auf dem höchsten Stand seit 800.000 Jahren,“ betrachte ich diese „Aufzeichnungen“ gerne in einem geologischen Kontext. Die nachfolgenden Grafiken stammen aus Bill Illis’ ausgezeichneter Sammlung paläo-klimatischer Daten.

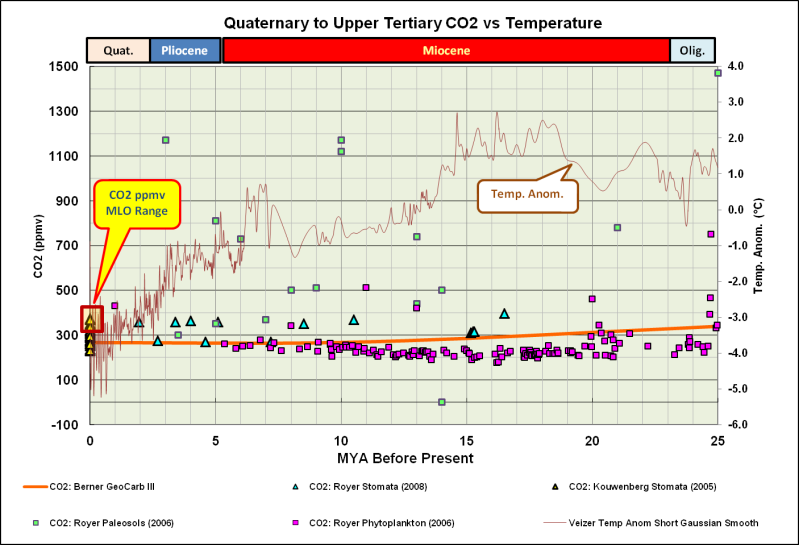

Die Treibhausgase haben ein neues Rekordhoch erreicht! Stimmt das? Das Anthropozän sieht überhaupt nicht anders aus, als die vorhergehenden 25 Million Jahre … Außer, dass es viel kälter ist.

Aus geologischer Perspektive sieht der “Hockeyschläger” des CO2s im Anthropozän eher aus wie die Nadel im Heuhaufen. Und es sieht eher so aus, als ob die Erde ihr CO2 in etwa 25 Millionen Jahren verloren haben wird.

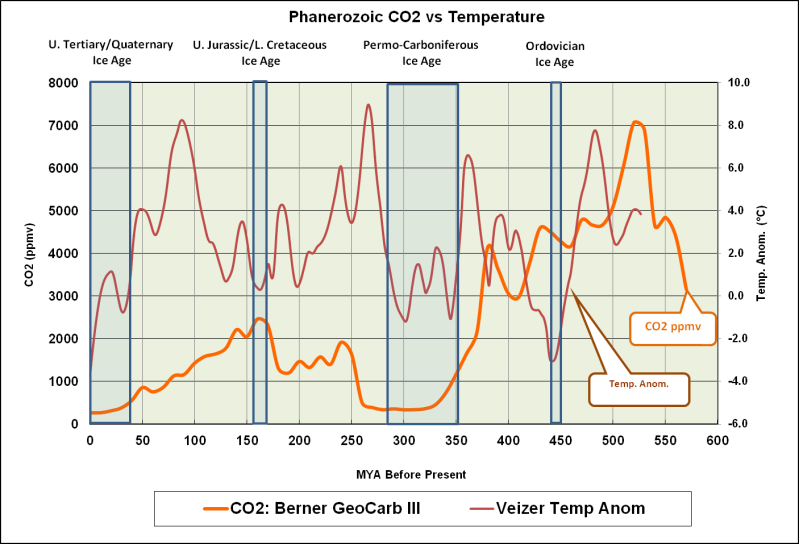

Einer meiner Allzeit-Favoriten! Man beachte das totale Fehlen einer Korrelation zwischen CO2 und Temperatur während der meisten Zeit im Phanerozoischen Eon.

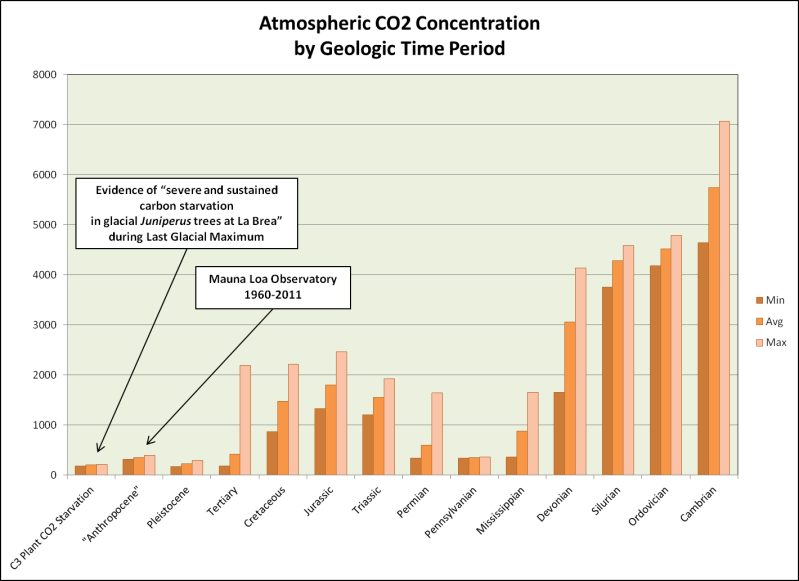

Im folgenden Balkendiagramm habe ich das CO2 nach geologischen Perioden dargestellt. Kambrium bis zur Kreidezeit sind Berner und Kothavala, 2001, (GEOCARB) entnommen, das Tertiär von Pagani, et al. 2006 (Tiefsee-Sediment-Eisbohrkerne), das Pleistozän stammt von Lüthi et al. 2008 (EPICA C Antarctic ice core), das“Anthropozän” ist von NOAA-ESRL (Mauna Loa Observatory), der CO2-Verlust von Ward et al., 2005.

Anthropozäne CO2-Konzentrationen liegen viel näher am Bereich der C3-Pflanzen-Aussterbe-Grenze (Ward et al., 2005) als sie in den vorgehenden 540 Millionen Jahren waren.

[Sarkasmus an]: Ich wollte auch Venus in das Balkendiagramm einfügen, doch dann hätte ich eine logarithmische Skala gebraucht. [Sarkasmus aus]

Appendix III: Von Pflanzen-Stomata abgeleitete CO2-Konzentrationen

Der Katalog der fachbegutachteten Papiere, die höhere und stärkere veränderliche präindustrielle CO2-Konzentrationen zeigen, ist sehr eindrucksvoll und anwachsend. Hier nur ein paar Erwähnungen:

Wagner et al., 1999. Century-Scale Shifts in Early Holocene Atmospheric CO2 Concentration. Science 18 June 1999: Vol. 284 no. 5422 pp. 1971-1973…

Im Gegensatz zu konventionellen Eisbohrkern-Schätzungen von 270 bis 280 ppmv verweist das Frequenzsignal aus den Stomata auf frühe Holozän Kohlendioxid-Konzentrationen von gut über 300 ppmv.

[…]

Die meisten Holozän-Eisbohrkern-Aufzeichnungen aus der Antarktis haben keine ausreichende zeitliche Auflösung.

[…]

Unser Ergebnisse falsifizieren die Vorstellung von einer relativ stabilen CO2-Konzentration von 270 bis 280 ppmv im Holozän bis zur industriellen Revolution. SI-basierte CO2-Rekonstruktionen könnten sogar darauf hindeuten, dass während des frühen Holozäns die atmosphärischen CO2-Konzentrationen von 300 ppmv eher die Regel als die Ausnahmen waren.

Die Eisbohrkerne können die CO2-Schübe nicht auflösen, die in Zeiträumen stattfanden, die kürzer waren als das Zweifache der Zeit der Blaseneinschlüsse. Das ist ein Grundsatz aus der Signal-Theorie. Die Behauptung einer stabilen prä-industriellen Konzentration von 270-280 ppmv ist völlig falsch.

McElwain et al., 2001. Stomatal evidence for a decline in atmospheric CO2 concentration during the Younger Dryas stadial: a comparison with Antarctic ice core records. J. Quaternary Sci., Vol. 17 pp. 21–29. ISSN 0267-8179 …

Es ist möglich, dass eine Anzahl von kurzzeitigen Fluktuationen, die aus den mit stomatalen Methoden stammenden Aufzeichnungen herrühren, nicht in Eisbohrkernen entdeckt werden, wie z. B. in Dome Concordia, wo langsame Akkumulationen stattfanden. Neftel et al. (1988) zufolge können CO2-Fluktuationen mit einer Dauer von weniger als dem Doppelten der Blaseneinschlusszeit (gleich etwa 134 Kalenderjahren im Falle des Byrd-Eises und bis zu 550 Kalenderjahren im Dome Concordia) nicht im Eis nachgewiesen oder durch Dekonvolution rekontruiert werden.

Noch nicht einmal die höchstaufgelösten Eisbohrkerne, wie Law Dome, haben ausreichende Auflösung um die MLO-Instrumentenaufzeichnung korrekt abzubilden.

Kouwenberg et al., 2005. Atmospheric CO2 fluctuations during the last millennium reconstructed by stomatal frequency analysis of Tsuga heterophylla needles. Geology; January 2005; v. 33; no. 1; p. 33–36…

Die Diskrepanzen zwischen den Eisbohrkern- und den aus Stomata stammenden Rekonstruktionen können teilweise durch variierende Altersverteilungen der Luft in den Blasen erklärt werden aufgrund der Einschlusszeit in der Übergangszone im Firn-Eis. Dieser Effekt erzeugt ein Bohrstellen-spezifisches Glätten des Signals (Dekaden beim Dome Summit South [DSS], Law Dome, noch mehr bei Eisbohrkern von Gebieten mit niedrigen Akkumulationsraten), wie auch als Alters-Differenz zwischen der Luft und dem umgebenden Eis, welches die Konstruktion von wohlbegrenzten Zeitskalen verhindert. (Trudinger et al., 2003).

Stomata-Rekonstruktionen sind für das Holozän wiederholbar, wenigstens für die Nordhalbkugel. Sie zeigen konsistent, dass der prä-industrielle natürliche Kohlenstoff-Fluss viel variabler war als die Eisbohrkerne erkennen lassen.

Wagner et al., 2004. Reproducibility of Holocene atmosphärisch CO2 records based on stomatal frequency. Quaternary Science Reviews. 23 (2004) 1947–1954…

Die Mehrzahl der stomatischen frequenzbasierten Abschätzungen des CO2 für das Holozän unterstützt nicht die weithin akzeptierte Vorstellung von vergleichsweise stabilen CO2-Konzentrationen in Verlauf der letzten 11.500 Jahre. Um auf die Kritik zu antworten, dass diese stomatischen Frequenz-Variationen von lokalen Veränderungen der Umwelt herrühren oder von methodologischen Einschränkungen, wurden unterschiedliche stomatische Frequenz-Aufzeichnungen über drei Klimaperioden im Holozän verglichen: während der Präborealen Oszillation, dem 8,2-tausenjährigen Abkühlungsereignis und der Kleinen Eiszeit. Die unter Benutzung verschiedener Kalibrationsverfahren dargestellten Fluktuationen in den paläo-atmosphärischen CO2-Aufzeichnungen, die von verschiedenen Kontinenten und Pflanzenarten stammen (Laub abwerfende Bedecktsamer und Korniferen), sind völlig vergleichbar. Sie zeigen starke Beweise für die Richtigkeit der auf Laub basierenden CO2-Ableitungen [Rekonstruktionen].

Die antarktischen Eisbohrkerne haben nicht genügend Auflösung weil der Prozess der Firn-Verdichtung wie ein Tiefpass-Filter wirkt.

Van Hoof et al., 2005. Atmospheric CO2 during the 13th century AD: reconciliation of data from ice core measurements and stomatal frequency analysis. Tellus 57B (2005), 4 …

Rekonstruktionen des atmosphärischen CO2 sind derzeit aus direkten Messungen von Lufteinschlüssen im antarktischen Eis verfügbar und zugleich aus stomataler Frequenzanalyse aus fossilem Laub. Eine Periode, wo beide Methoden konsistente Belege für natürliche CO2-Veränderungen ergeben, ist das 13. Jh. n.Chr. Die Ergebnisse der beiden voneinander unabhängigen Methoden unterscheiden sich signifikant hinsichtlich der Amplitude der geschätzten CO2-Veränderungen (10 ppmv beim Eis, gegenüber 34 ppmv bei der stomatalen Frequenz). Wir vergleichen dabei die stomatale Frequenz und die Eisbohrkern-Ergebnisse, indem wir ein Firn-Diffusionsmodell benutzen, um den möglichen Einfluss der Glättung während des Einschlusses auf die zeitliche Auflösung und auf die Amplitude der CO2-Veränderungen auswerten. Die sichtbaren großen Diskrepanzen zwishcen den Amplituden, die durch die kontrastierenden Methoden abgeschätzt werden, verschwinden, wenn die stomatalen Rohdaten analog so geglättet werden, wie es auf natürliche Weise durch den Firn geschieht.

Die Herleitung des Gleichgewichts der Klimasensitivität (Equilibrium Climate Sensitivity – ECS) aus dem atmosphärischen CO2 beruht zum großen Teil auf antarktischen Eisbohrkernen. Problematisch dabei ist, dass die Temperatur-Schätzungen auf dem Verhältnis von Sauerstoff-Isotopen im Eis selbst beruhen, während die CO2-Schätzungen auf Gasblasen beruhen, die im Eis eingeschlossen sind.

Die Temperatur-Daten sind sehr hoch aufgelöst. Die Verhältnisse der Sauerstoff-Isotopen zueinander sind Funktionen der Temperatur zur Zeit der Schneeablagerung. Die CO2-Daten haben eine niedrige und variable Auflösung, weil es Jahrzehnte bis Jahrhunderte dauert, bis sich die Gasblasen gebildet haben. Die CO2-Werte aus den Eisbohrkernen repräsentieren Durchschnittswerte über viele Jahrzehnte bis Jahrhunderte. Die Temperaturdaten haben eine jährliche bis dekadische Auflösung.

Der am höchsten aufgelöste antarktische Eisbohrkern ist der DE08 Eisbohrkern von Law Dome.

Beim IPCC und beim sogenannten wissenschaftlichen Konsens nimmt man an, dass man beim CO2 bis auf jährige Veränderungen auflösen kann. Das aber geht nicht. Jeder CO2-Wert steht, grob gesprochen, für einen 30-jährigen Durchschnitt und nicht für einen jährigen Wert.

Wenn man die Messwerte vom Mauna Loa (rote Linie) und Pflanzen-Stomata-abgeleitetes prä-industrielles CO2 (grüne Linie) mit einem 30-Jahr-Filter glättet, verbinden sie sich recht gut mit dem Law Dome DE08 Eisbohrkern (hellblaue Linie) …

Der tiefere DSS Eisbohrkern (dunkelblaue Linie) hat eine viel geringere zeitliche Auflösung wegen seiner viel geringeren Akkumulationsrate und Kompressions-Effekten. Er ist völlig ungeeignet für Veränderungen auf einer Jahrhundert-Skala, schon gar nicht auf einer dekadischen Skala.

Beim IPCC und beim sogenannten wissenschaftlichen Konsens nimmt man richtigerweise an, dass die Auflösung durch die Blasen-Einschlusszeit bestimmt wird. Falsch ist es aber, die Blasen-Einschlussperiode auf die Einschlusszone zu begrenzen. Im Falle von Eisbohrkern DE08 sucht man nach einem Signal mit einer Frequenz von einer Änderung/a, als eine Stichprobe jeweils für 8-10 Jahre genommen. Das tatsächliche Signal hat eine Frequenz von 1 Änderung/30-40 Jahre, als eine Stichprobe jeweils für 8-10 Jahre genommen.

CO2-Änderungen im Bereich von 30-40 ppmv über Zeiträume von weniger als ~60 Jahre können im DE08 Eisbohrkern nicht genau aufgelöst werden. Das ergibt sich aus den Grundlagen der Signaltheorie. Wagner et al., 1999, zogen sehr feindselige Reaktionen auf sich, die aus der Gemeinde des sogenannten wissenschaftlichen Konsenses kamen. Aber alles, was Dr. Wagner-Cremer getan hatte, war die Falsifizierung einer einzigen kleinen Hypothese…

Ganz im Gegensatz zu den konventionellen Eisbohrkern-Abschätzungen von 270 bis 280 ppmv, deutet das Frequenzsignal der Stomata auf frühe Holozän-Kohlendioxid-Konzentrationen von weit über 300 ppmv.

[…]

Unsere Ergebnisse widerlegen die Vorstellung einer relativ stabilen CO2-Konzentrationen von 270 bis 280 ppmv im Holozän bis zur industriellen Revolution. SI-basierte CO2-Rekonstruktionen legen sogar nahe, dass im frühen Holozän die atmosphärischen CO2-Konzentrationen über >300 ppmv lagen und dies eher als Regel denn als Ausnahme.

Die pflanzlichen Stomata beweisen sehr schön, dass im Holozän die CO2-Konzentrationen häufig im Bereich zwischen 300-350 ppmv lagen und gelegentlich über 400 ppmv während der letzten 10.000 Jahre.

Die falsche Schätzung eines 3°C-Klimasensitivitäts-Gleichgewichts für CO2 (Equivalent Climate Sensitivity to CO2) ist total von der Annahme bestimmt, dass die präindustriellen CO2-Konzentrationen im Bereich von 270-280 ppmv lagen, wie es die antarktischen Eisbohrkerne nahelegen.

Die pflanzlichen Stomata-Daten zeigen klar, dass die präindustriellen atmosphärischen CO2-Konzentrationen viel höher waren und viel veränderlicher, als die antarktischen Eisbohrkerne andeuten. Das bedeutet, dass der Anstieg des atmosphärischen CO2 seit den 1800ern nicht besonders anomal ist und dass zumindest die Hälfte davon auf ozeanische und biosphärische Reaktionen durch die Aufwärmung seit dem Ende der Kleinen Eiszeit zurückgeht.

Kouwenberg schloss, dass das CO2-Maximum um ca. 450 n.Chr. eine lokale Anomalie gewesen wäre, weil es nicht mit einem Temperaturanstieg im Einklang mit Rekonstruktion von Mann & Jones, 2003, zu korrelieren war.

Weil das Erdklima einfach nicht mit den Modellen übereinstimmen will, wird der sogenannte Konsens irgendwann akzeptieren müssen, dass er in einem grundlegenden Irrtum befangen ist. Wir hoffen aber, dass uns der eifernde CO2-Wahn nicht vorher in den Bankrott getrieben haben wird.

Bis zum Auswechseln des Paradigmas werden alle Schätzungen einer prä-industriellen Beziehung zwischen atmosphärischem CO2 und der Temperatur, die auf antarktischen Eisbohrkernen beruhen, falsch sein, weil die Eisbohrkern-Temperaturen und die CO2-Zeitreihen völlig unterschiedliche Auflösungen haben. Und solange Anhänger des sogenannten Konsensus nicht die Grundlagen der Signalverarbeitung verstanden haben, werden sie [die Schätzungen] auch weiterhin falsch bleiben.

Referenzen:

Anklin, M., J. Schwander, B. Stauffer, J. Tschumi, A. Fuchs, J.M. Barnola, and D. Raynaud. 1997. CO2 record between 40 and 8kyr B.P. from the Greenland Ice Core Project ice core. Journal of Geophysical Research 102:26539-26545.

Barnola et al. 1987. Vostok ice core provides 160,000-year record of atmospheric CO2.

Nature, 329, 408-414.

Berner, R.A. and Z. Kothavala, 2001. GEOCARB III: A Revised Model of Atmospheric CO2 over Phanerozoic Time, American Journal of Science, v.301, pp.182-204, February 2001.

Boden, T.A., G. Marland, and R.J. Andres. 2012. Global, Regional, and National Fossil-Fuel CO2 Emissions. Carbon Dioxide Information Analysis Center, Oak Ridge National Laboratory, U.S. Department of Energy, Oak Ridge, Tenn., U.S.A. doi 10.3334/CDIAC/00001_V2012

Etheridge, D.M., L.P. Steele, R.L. Langenfelds, R.J. Francey, J.-M. Barnola and V.I. Morgan. 1998. Historical CO2 records from the Law Dome DE08, DE08-2, and DSS ice cores. In Trends: A Compendium of Data on Global Change. Carbon Dioxide Information Analysis Center, Oak Ridge National Laboratory, U.S. Department of Energy, Oak Ridge, Tenn., U.S.A.

Finsinger, W. and F. Wagner-Cremer. Stomatal-based inference models for reconstruction of atmospheric CO2 concentration: a method assessment using a calibration and validation approach. The Holocene 19,5 (2009) pp. 757–764

Fischer, H. A Short Primer on Ice Core Science. Climate and Environmental Physics, Physics Institute, University of Bern.

Garcıa-Amorena, I., F. Wagner-Cremer, F. Gomez Manzaneque, T. B. van Hoof, S. Garcıa Alvarez, and H. Visscher. 2008. CO2 radiative forcing during the Holocene Thermal Maximum revealed by stomatal frequency of Iberian oak leaves. Biogeosciences Discussions 5, 3945–3964, 2008.

Illis, B. 2009. Searching the PaleoClimate Record for Estimated Correlations: Temperature, CO2 and Sea Level. Watts Up With That?

Indermühle A., T.F. Stocker, F. Joos, H. Fischer, H.J. Smith, M. Wahlen, B. Deck, D. Mastroianni, J. Tschumi, T. Blunier, R. Meyer, B. Stauffer, 1999, Holocene carbon-cycle dynamics based on CO2 trapped in ice at Taylor Dome, Antarctica. Nature 398, 121-126.

Jessen, C. A., Rundgren, M., Bjorck, S. and Hammarlund, D. 2005. Abrupt climatic changes and an unstable transition into a late Holocene Thermal Decline: a multiproxy lacustrine record from southern Sweden. J. Quaternary Sci., Vol. 20 pp. 349–362. ISSN 0267-8179.

Kouwenberg, LLR. 2004. Application of conifer needles in the reconstruction of Holocene CO2 levels. PhD Thesis. Laboratory of Palaeobotany and Palynology, University of Utrecht.

Kouwenberg, LLR, Wagner F, Kurschner WM, Visscher H (2005) Atmospheric CO2 fluctuations during the last millennium reconstructed by stomatal frequency analysis of Tsuga heterophylla needles. Geology 33:33–36

Ljungqvist, F.C.2009. Temperature proxy records covering the last two millennia: a tabular and visual overview. Geografiska Annaler: Physical Geography, Vol. 91A, pp. 11-29.

Ljungqvist, F.C. 2010. A new reconstruction of temperature variability in the extra-tropical Northern Hemisphere during the last two millennia. Geografiska Annaler: Physical Geography, Vol. 92 A(3), pp. 339-351, September 2010. DOI: 10.1111/j.1468-0459.2010.00399.x

Lüthi, D., M. Le Floch, B. Bereiter, T. Blunier, J.-M. Barnola, U. Siegenthaler, D. Raynaud, J. Jouzel, H. Fischer, K. Kawamura, and T.F. Stocker. 2008. High-resolution carbon dioxide concentration record 650,000-800,000 years before present. Nature, Vol. 453, pp. 379-382, 15 May 2008. doi:10.1038/nature06949

MacFarling Meure, C., D. Etheridge, C. Trudinger, P. Steele, R. Langenfelds, T. van Ommen, A. Smith, and J. Elkins (2006), Law Dome CO2, CH4 and N2O ice core records extended to 2000 years BP, Geophys. Res. Lett., 33, L14810, doi:10.1029/2006GL026152.

McElwain et al., 2001. Stomatal evidence for a decline in atmospheric CO2 concentration during the Younger Dryas stadial: a comparison with Antarctic ice core records. J. Quaternary Sci., Vol. 17 pp. 21–29. ISSN 0267-8179

Moberg, A., D.M. Sonechkin, K. Holmgren, N.M. Datsenko and W. Karlén. 2005.

Highly variable Northern Hemisphere temperatures reconstructed from low- and high-resolution proxy data. Nature, Vol. 433, No. 7026, pp. 613-617, 10 February 2005.

Morice, C.P., J.J. Kennedy, N.A. Rayner, P.D. Jones (2011), Quantifying uncertainties in global and regional temperature change using an ensemble of observational estimates: the HadCRUT4 dataset, Journal of Geophysical Research, accepted.

Pagani, M., J.C. Zachos, K.H. Freeman, B. Tipple, and S. Bohaty. 2005. Marked Decline in Atmospheric Carbon Dioxide Concentrations During the Paleogene. Science, Vol. 309, pp. 600-603, 22 July 2005.

Rundgren et al., 2005. Last interglacial atmospheric CO2 changes from stomatal index data and their relation to climate variations. Global and Planetary Change 49 (2005) 47–62.

Smith, H. J., Fischer, H., Mastroianni, D., Deck, B. and Wahlen, M., 1999, Dual modes of the carbon cycle since the Last Glacial Maximum. Nature 400, 248-250.

Trudinger, C. M., I. G. Enting, P. J. Rayner, and R. J. Francey (2002), Kalman filter analysis of ice core data 2. Double deconvolution of CO2 and δ13C measurements, J. Geophys. Res., 107(D20), 4423, doi:10.1029/2001JD001112.

Van Hoof et al., 2005. Atmospheric CO2 during the 13th century AD: reconciliation of data from ice core measurements and stomatal frequency analysis. Tellus 57B (2005), 4

Wagner F, et al., 1999. Century-scale shifts in Early Holocene CO2 concentration. Science 284:1971–1973.

Wagner F, Aaby B, Visscher H, 2002. Rapid atmospheric CO2 changes associated with the 8200-years-B.P. cooling event. Proc Natl Acad Sci USA 99:12011–12014.

Wagner F, Kouwenberg LLR, van Hoof TB, Visscher H, 2004. Reproducibility of Holocene atmospheric CO2 records based on stomatal frequency. Quat Sci Rev 23:1947–1954

Ward, J.K., Harris, J.M., Cerling, T.E., Wiedenhoeft, A., Lott, M.J., Dearing, M.-D., Coltrain, J.B. and Ehleringer, J.R. 2005. Carbon starvation in glacial trees recovered from the La Brea tar pits, southern California. Proceedings of the National Academy of Sciences, USA 102: 690-694.

############################

Original hier bei WUWT

Übersetzung: Helmut Jäger, EIKE

############################