TheBestSchools

Prof. Happer: Vielen Dank, dass Sie sich für dieses Interview bereit erklärt haben und an einer Diskussion mit dem australischen Physiker David Karoly teilnehmen. Die Kontroverse um die globale Erwärmung ist sowohl außerordentlich kompliziert und hoch emotional aufgeladen. In diesem Interview werden wir das Ganze aus verschiedenen Blickwinkeln betrachten, die sowohl wissenschaftlicher als auch politischer Natur sind.

Im Folgenden beschreibt Happer, Jahrgang 1939, seinen Lebenslauf, der ihn nach dem 2. Weltkrieg in die JASON-Gruppe führte, eine Gruppe von Wissenschaftlern, die für die US-Regierung geheime und nicht geheime Studien durchführte. Dabei wurde er auch ins Energieministerium berufen. Hier wurde er später konfrontiert mit der regierungsamtlichen Propaganda bzgl. Klimawandel, der er zunächst folgte, bis ihn die schrillen Dissonanzen in der Argumentation störten. So kam es, dass er von seinem vieljährigen Posten am Energieministerium gefeuert wurde nach Amtsantritt der Bill Clinton/Al Gore-Regierung, weil er die Al Gore-Behauptungen zu hinterfragen gewagt hatte. Seitdem wurde er zu einem Vertreter der Klimaskeptiker, und als solcher wurde er auch interviewt.

————————————–

Gleich bei der ersten Frage des Interviews beschreibt Happer, wie die Destruktiv-Organisation Greenpeace gegen ihn vorgegangen war. Weil dies beispielhaft stehen kann für das, was viele ehrliche und der wirklichen Wissenschaft verpflichteten Forscher widerfahren kann, wird Happers Antwort hier in ganzer Länge übersetzt:

TheBestSchool

Wir haben erfahren, dass Sie jüngst Opfer einer von Greenpeace organisierten „verdeckten“ Operation geworden sind. Verleumderische Behauptungen darüber, wie sie da herausgekommen sind, gibt es im Internet zuhauf, selbst in Ihrem Wikipedia-Beitrag. Würden Sie uns vielleicht kurz Ihre Seite der Story erzählen?

William Happer

Greenpeace ist eine der vielen Organisationen, die mit dem Alarmismus hinsichtlich einer vermeintlichen Bedrohung durch globale Erwärmung sehr gut leben kann. Sie sind nicht in der Lage, die auf extrem schwachen Füßen stehende Wissenschaft zu verteidigen. Darum dämonisieren sie nicht nur den vermeintlichen „Verschmutzer“, also das atmosphärische CO2, sondern auch sämtliche Wissenschaftler, die ihre Propaganda effektiv widerlegen.

Ich glaube, ich sollte mich geschmeichelt fühlen, eines ihrer Opfer zu sein: je mehr Feinde, je mehr Ehre [das steht so im Original, gefolgt von einer sinngemäßen Übersetzung ins Englische! Anm. d. Übers.], wie es in einem alten Sprichwort aus Deutschland heißt. Aber meine Erfahrungen in dieser Hinsicht verblassen doch sehr im Vergleich zu dem, was man Wissenschaftlern wie Willie Soon, Patrick Michaels und anderen angetan hat, welche nicht nur verunglimpft, sondern gleich von ihren Arbeitsstellen vertrieben wurden.

Die Schmierenkampagne begann im Jahre 2015, als ich eine E-Mail von einem Greenpeace-Agenten erhielt, der sich als ein Repräsentant eines „Kunden“ in Nahost ausgab. Er wollte, dass ich etwas über die Vorteile von CO2 schreibe. Wie ich weiter unten ausführen werde, habe ich schon sehr lange die Ansicht vertreten, dass mehr CO2 vorteilhaft für die Erde ist, hauptsächlich weil die Pflanzen damit effektiver gedeihen und ihre Widerstandskraft gegen Dürren stärken, und weil die Erwärmung durch mehr CO2, wie es von den Modellen des Establishments prophezeit wird, um einen Faktor drei oder mehr übertrieben wird.

Seit Jahren habe ich jeden nur denkbaren Weg benutzt, um die guten Nachrichten über die Vorteile von CO2 zu verbreiten. Daher rannte man bei mir offene Türen ein, ein Op-Ed oder einen Beitrag zu diesem Thema für den Kunden zu schreiben. So weit es mich betraf, benutzte ich den Kunden, nicht vice versa. Ich empfehle jedem geneigten Leser mit Interesse an dieser Episode, den vollständigen E-Mail-Austausch zwischen mir und dem Greenpeace-Agenten zu lesen. Er ist im Internet einsehbar.

In einer der ersten E-Mails mit Datum 3. 11. 2015 stellte ich fest:

Ich würde sehr gerne helfen, falls meine Standpunkte, umrissen in den Anhängen, auf einer Linie liegen mit denen Ihres Kunden.

Der Satz macht klar, dass ich lediglich daran interessiert war, dem „Kunden“ zu helfen, meine schon lange gehegten Ansichten zu publizieren und nicht hausieren zu gehen damit, was auch immer der „Kunde“ im Sinn hatte.

Man beachte auch die Bemerkungen in meiner E-Mail-Antwort vom 5. 11. 2015:

Um sicherzustellen, dass Ihr Kunde durch meine Ansichten nicht in die Irre geführt wird, stelle ich klar, dass es sehr wohl reale Verschmutzer im Zusammenhang mit der Verbrennung fossiler Treibstoffe gibt, als da wären Oxide von Schwefel und Stickstoff, fliegende Asche und Schwermetalle bei Kohle, volatile organische Stoffe bei Benzin, usw. Ich stehe voll hinter Vorschriften für die kosteneffektive Kontrolle dieser realen Verschmutzer. Aber die Klimagespräche in Paris basieren auf der Prämisse, dass CO2 selbst ein Verschmutzer ist. Das ist komplett falsch. Mehr CO2 wird der Welt zum Vorteil gereichen. Der einzige Weg, CO2 zu limitieren, wäre es, keine fossilen Treibstoffe mehr zu verwenden. Das jedoch, so glaube ich, wäre eine ausgesprochen unmoralische und irrationale Politik.

Der Schlussabschnitt meiner Mail vom 5. 11. 2015 lautet:

Meine Aktivitäten, den Klima-Extremismus zurückzudrängen, führe ich als ein Herzensanliegen meinerseits durch, um die in Ehren gehaltenen Ideale der Wissenschaft zu verteidigen, die so stark korrumpiert sind durch den Klimawandel-Kult. Falls Ihr Kunde überlegt, mich zu entlohnen, falls ich etwas schreibe, würde ich fordern, dass eine wie auch immer geartete Entlohnung direkt an die CO2-Koalition geht. Dies war das Arrangement, welches ich mit den Anwälten vereinbart hatte, die die Peabody Coal Company bei den Anhörungen in Minnesota vertraten. Die Entlohnung, die ich erhalten hätte, wurde nicht an mich gezahlt, sondern an die CO2-Koalition, einer von Steuern befreiten, uneigennützigen Bildungsorganisation. Die CO2-Koalition deckt mitunter Reisekosten von mir ab, zahlt mir aber darüber hinaus keinerlei Gehalt.

Ich habe niemals auch nur einen Penny für irgendeine meiner Aktivitäten zur Aufklärung der Öffentlichkeit bzgl. der Vorteile von CO2 für die Welt genommen.

Daran kann man erkennen, dass ich etwas gratis schreiben würde als eine „Arbeit des Herzens“, solange nur gewährleistet war, dass meine Botschaft (nicht die Botschaft des „Kunden“) noch mehr Menschen erreicht. Die erwähnte CO2-Koalition ist eine neue, von Steuern befreite nichtkommerzielle Organisation, welche meine Freunde zusammen mit mir ins Leben gerufen hatten, um die guten Nachrichten über CO2 noch weiter zu verbreiten. Ich denke, man könnte es eine „Anti-CO2-Diffamierungs-Liga“ bezeichnen. Die Koalition führt eine Von-Der-Hand-In-Den-Mund-Existenz, mit einem Jahresbudget unter 200.000 Dollar pro Jahr. Selbst ein paar tausend Dollar von dem „Kunden“ würden helfen, die Lichter nicht ausgehen zu lassen. Als ich es zum letzten Mal gecheckt hatte, verfügt Greenpeace über ein Jahresbudget von 350 Millionen Dollar, das ist über 300 mal so viel wie das Budget der Koalition.

Noch einmal, ich habe niemals auch nur einen Penny genommen für meine Aktionen, der Öffentlichkeit nahezubringen, dass mehr CO2 der Welt zum Vorteil gereicht. Ich habe sogar Tausende Dollar meines mäßigen Universitäts-Gehaltes für diesen Zweck geopfert. Falls irgendein Leser dieses Interviews der Koalition helfen möchte, kann er weitere Informationen und wie man spenden kann auf der Website der CO2-Koalition finden.

Unter den Folgen der Greenpeace-Schmähkampagne waren viele böse, obszöne Telefonanrufe und E-Mails, in denen ich, meine Familie und sogar meine Enkelkinder bedroht wurden*. George Orwell hat diese Taktiken in seinem Roman 1984 beschrieben, in dem er die täglichen obligatorischen „Zwei Minuten Hass“ auf Emmanuel Goldstein (Leo Trotzky) und seine Agenten beschrieb, die die Feinde von Big Brother (Stalin) und seinen Schergen waren.

[*Hervorhebung vom Übersetzer!]

Greenpeace und weitere, sogar noch fanatischere Elemente der Globale-Erwärmung-Bewegung stehen in vollem Umfang hinter der historischen Lüge, dass ihr ideologisches Ziel – die Eliminierung fossiler Treibstoffe – jedwede Mittel rechtfertigt, einschließlich der Verfälschung wissenschaftlicher Daten und Rufmord ihrer Gegner.

Aber Kipling hat recht: wir werden siegen:

If you can bear to hear the truth you’ve spoken

Twisted by knaves to make a trap for fools,

Or watch the things you gave your life to, broken,

And stoop and build ’em up with worn-out tools.

[Die nächste Frage von TheBestSchools befasst sich mit dem allgemeinen CO2-Narrativ, welches in Politik und Medien auf und ab kolportiert wird. Happer sagt dazu:]

William Happer

Lassen Sie mich zunächst auf die Stichworte eingehen, die Sie genannt haben. Ja, das CO2-Niveau ist gestiegen, und zwar um etwa zwei ppm pro Jahr während der letzten Jahre. Ja, CO2 ist ein „Treibhausgas“. Das heißt, es ist teilweise undurchlässig für die thermische Infrarotstrahlung der Erdoberfläche, aber transparent für das meiste Sonnenlicht. Die weitaus größten Anteile der Atmosphäre, Stickstoff und Sauerstoff, sind sowohl bzgl. Sonnenlicht als auch thermische Strahlung durchlässig und daher keine Treibhausgase.

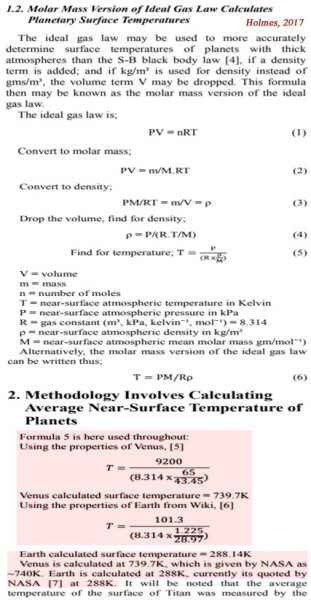

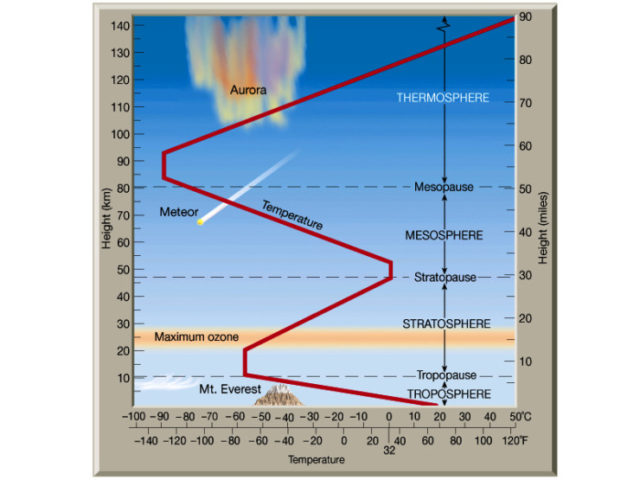

Die Aussage „wegen des gestiegenen CO2-Gehaltes muss die Erdatmosphäre wärmer werden“, ist nicht gut formuliert. Wie man weiß hat die Atmosphäre keinen einzelnen Temperaturwert. Das approximierte vertikale Temperaturprofil der Atmosphäre sieht so aus:

Abbildung 1: Vertikales Temperaturprofil der Erdatmosphäre. Man geht davon aus, dass mehr CO2 die Stratosphäre abkühlt und die Troposphäre erwärmt. Der Betrag der Erwärmung an der Erdoberfläche wird wahrscheinlich um 1°C liegen bei einer Verdoppelung der CO2-Konzentration in der Atmosphäre. Quelle: Astrobites.

Obwohl es bedeutende Ausnahmen gibt, ist die Atmosphäre normalerweise nahe der Oberfläche am wärmsten und kühlt sich mit zunehmender Höhe ab. Eine repräsentative Abkühlungsrate über die ersten 10 km oder so ist etwa 6,5°C pro km. Darum suchen die Menschen im Sommer die Berge auf, um der Hitze zu entkommen. Ich besuchte die Hochschule in der kleinen Stadt Lenoir in North Carolina auf einer Seehöhe von etwa 400 m, wo es üblicherweise um etwa 8°C wärmer war als im beliebten Erholungsort Blowing Rock auf einer Seehöhe von etwa 1100 m, etwa 20 Meilen [ca. 32 km] entfernt von der Gipfelkette der Blue Ridge Mountains.

[Es folgt eine Erklärung der Vorgänge in Troposphäre und Stratosphäre. Darauf aufbauend führt Happer weiter aus:]

Mit jedem weiteren Jahr, das vorübergeht, gibt es aus Beobachtungen weniger Unterstützung für diese „positive Rückkopplung“ der direkten Erwärmung durch CO2.

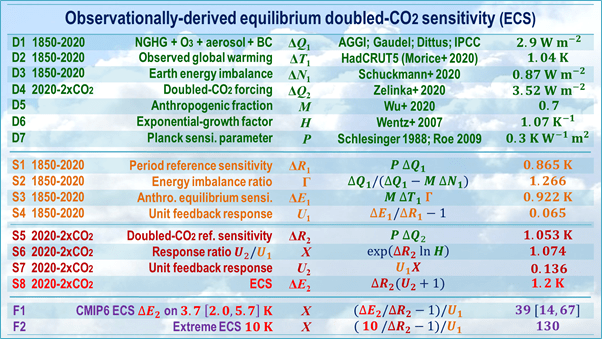

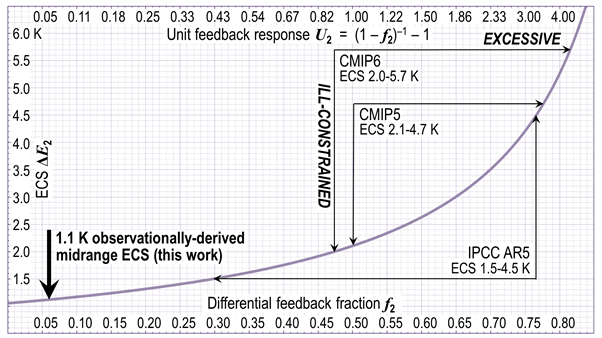

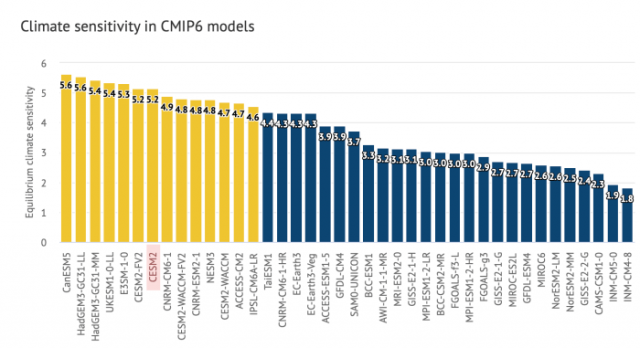

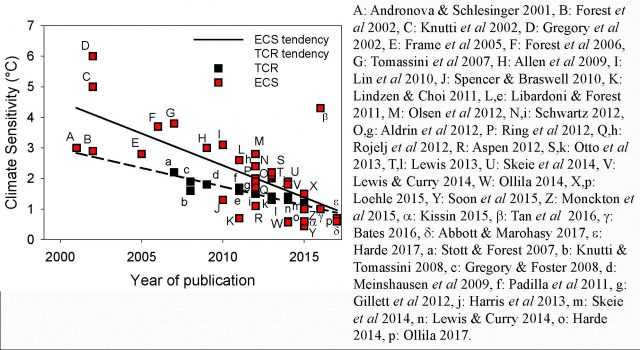

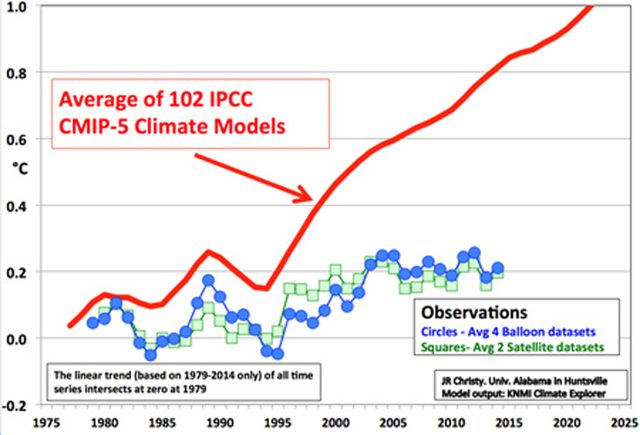

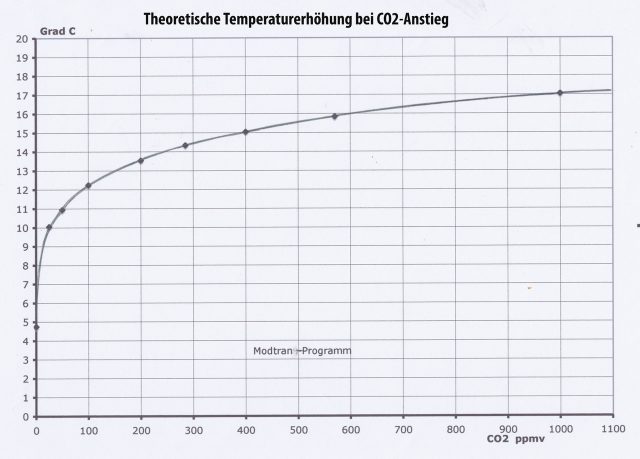

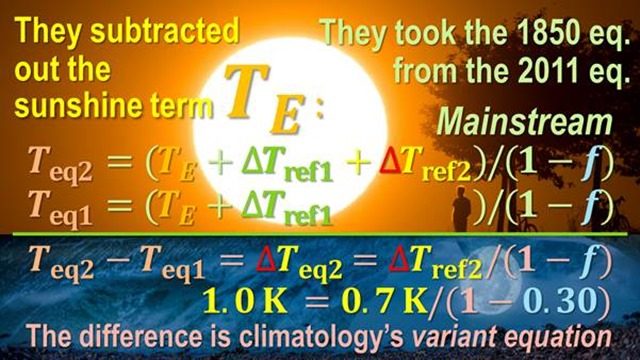

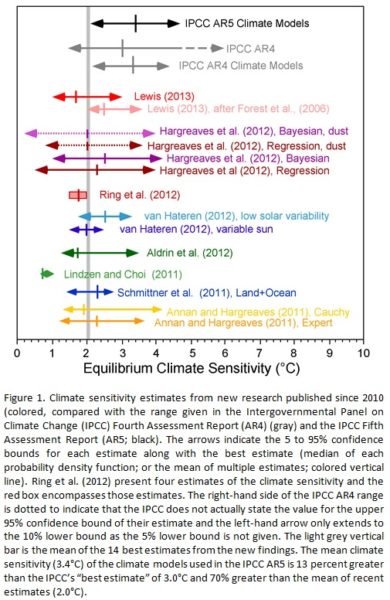

Die Troposphäre, also die unteren 11 km der Luft – unterscheidet sich deutlich von der Stratosphäre. Nahe der Erdoberfläche erfolgt der weitaus größte Beitrag zum Wärmeaustausch durch Konvektion feuchter Luft und nicht durch Strahlung. Nur bei dieser könnte CO2 jedoch einen direkten Unterschied ausmachen. Mehr CO2 kann möglicherweise die Troposphäre und die Erdoberfläche erwärmen. Aber hinsichtlich die Größenordnung dieser Erwärmung weiß man kaum etwas. Mein Schätzung lautet, dass sich die Erdoberfläche bei einer Verdoppelung der CO2-Konzentration um etwa 1°C erwärmen wird und in der mittleren Troposphäre vielleicht um 1,2°C. Diese Zahlen lassen sich aus den direkten Auswirkungen von mehr CO2 berechnen. Die vom IPCC genannte wesentlich höhere „Gleichgewichts-Klimasensitivität“, etwa 3°C pro Verdoppelung der Konzentration, stammt aus der Annahme, dass die relativ geringe direkte Temperaturzunahme durch mehr CO2 erheblich verstärkt wird durch Änderungen er Eigenschaften von Wasserdampf und Wolken. Mit jedem weiteren Jahr, das vorübergeht, gibt es immer weniger Stützung durch Beobachtungen für diese „positive Rückkopplung“ der direkten Erwärmung durch CO2.

Lassen Sie mich jetzt zu den vier offiziellen IPCC-Positionen Stellung nehmen, die Sie erwähnt hatten:

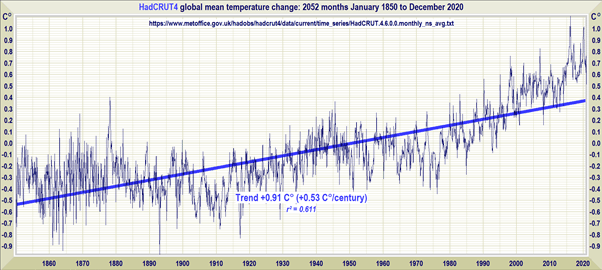

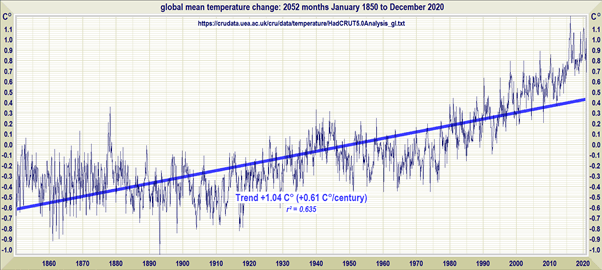

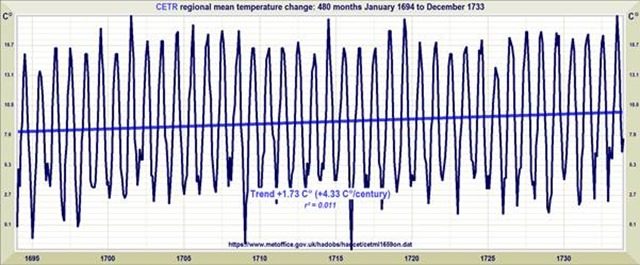

Globale Erwärmung ist eine fundierte Tatsache. Diese Feststellung ist nur zur Hälfte richtig. Ein korrekteres Statement wäre „globale Erwärmung und globale Abkühlung sind beides fundierte Tatsachen“. Die Erde ist ständig Schauplatz von Erwärmung und Abkühlung. Seit dem Jahr 1800 hat sich die Erde um etwa 1°C erwärmt, wobei der größte Teil dieser Erwärmung vor einer stärkeren Zunahme des atmosphärischen CO2 stattgefunden hat. Es gab eine ziemlich substantielle Abkühlung von 1940 bis 1975. Es gab praktisch keine Erwärmung während der letzten 20 Jahre, obwohl das CO2-Niveau schneller denn je zugenommen hat. Dieser Wechsel zwischen Erwärmung und Abkühlung war während der gesamten geologischen Historie ein Charakteristikum des Erdklimas.

Die Erwärmung ist anthropogen. Nein! Der größte Teil der Erwärmung ist natürlichen Ursachen geschuldet. Aber vieles der CO2-Zunahme von etwa 280 ppm im Jahr 1800 auf etwa 400 ppm im Jahre 2015 ist möglicherweise anthropogenen Ursprungs, obwohl Ozeane und Festland durch die Erwärmung etwas CO2 freigesetzt haben. Die Erwärmung der Städte korrelierte sehr gut mit dem zunehmenden CO2-Gehalt. Dies ist dem gut erforschten Städtischen Wärmeinseleffekt sich ausbreitender Städte geschuldet. Aber nicht der zunehmende CO2-Gehalt ist Ursache der Erwärmung in den Städten, sondern das Verschwinden von Grünland und Wäldern mit ihrer Verdunstungs-Abkühlung sowie der Ausbau von Straßen und Gebäuden, die keinen Wasserdampf verdunsten. Natürlich hat auch das CO2-Niveau gleichlaufend mit der städtischen Erwärmung zugenommen, aber das zusätzliche CO2 ist nicht Ursache der Erwärmung in Verbindung mit Verstädterung. Korrelation heißt nicht Kausalität! Die Sonne geht morgens nicht deswegen auf, weil der Hahn kräht. Außerhalb städtischer Gebiete der Erde ist die Korrelation zwischen CO2-Niveau und Temperatur praktisch nicht erkennbar.

Unter den mächtigen natürlichen Einflüssen auf das Klima sind relativ kurzzeitige periodische Phänomene der Änderungen von Meeresströmen wie El Nino und längerzeitliche periodische Änderungen wie die PDO oder die NAO. Von großen Vulkanausbrüchen weiß man, dass sie das Klima ein paar Jahre lang abkühlen. Es gibt immer mehr Beweise, dass Änderungen der Sonnenaktivität irgendwie das Klima beeinflussen, und vermutlich gibt es noch viele andere Einflüsse, die wir noch gar nicht entdeckt haben.

Ein geringer Anteil der Erwärmung von 1°C während der letzten beiden Jahrhunderte muss dem gestiegenen CO2-Gehalt geschuldet sein, welches in der Tat ein Treibhausgas ist. Im Gleichgewicht sollte die Temperaturzunahme ΔT=S log2 (400 ppm/280 ppm) betragen haben, wobei S die Gleichgewichts-Klimasensitivität ist. Ohne Rückkopplung kann die theoretische Sensitivität berechnet werden mit nahe S = 1°C, und der Logarithmus zur Basis 2 ist log2 (400/280) = 0,51. Also hätte die rückkopplungs-freie Erwärmung ΔT = 0,51° C betragen sollen, also etwa halb so groß wie die beobachtete Erwärmung sein müssen. Die andere Hälfte der Erwärmung wäre dann natürlichen Ursachen geschuldet, vielleicht wegen der Erholung der Erde aus der „Kleinen Eiszeit“, über die wir weiter unten noch sprechen werden.

Die vom IPCC genannte Gleichgewichts-Sensitivität beträgt S = 3°C, also etwa drei mal so viel wie der rückkopplungsfreie Wert von S = 1°C. Folglich hätte die CO2-induzierte Erwärmung den IPCC-Modellen zufolge drei mal größer sein müssen, also ΔT = 1,54° C, was substantiell mehr ist als beobachtet. Um diese blamable Überschätzung zu rechtfertigen, nehmen die Modelle des Establishments an, dass ein großer Teil dieser Erwärmung durch Abkühlung durch Aerosole aufgefangen worden ist – beispielsweise durch kleine Schwefelpartikel aus der Verbrennung stark schwefelhaltiger Kohle und Öl. Tatsächlich weiß man, dass bei großen Vulkanausbrüchen freigesetzte Schwefelpartikel wie beim Ausbruch des indonesischen Vulkans Tambora im Jahre 1815 mehrere Jahre lang zu einer weltweiten Abkühlung geführt hatten. Aber der Teufel steckt im Detail, und viele Wissenschaftler, die sorgfältig die Physik dahinter untersucht hatten, betrachten die Aerosol-Korrekturen größten teils als einen Schummel-Faktor, ins Spiel gebracht seitens des Globale-Erwärmung-Establishments, um zu vermeiden zugeben zu müssen, dass der Gleichgewichts-Temperaturanstieg durch eine Verdoppelung des CO2-Gehaltes viel weniger als S = 3°C beträgt.

Aus all dem folgt, dass mehr CO2 für die Menschheit erheblich von Vorteil ist.

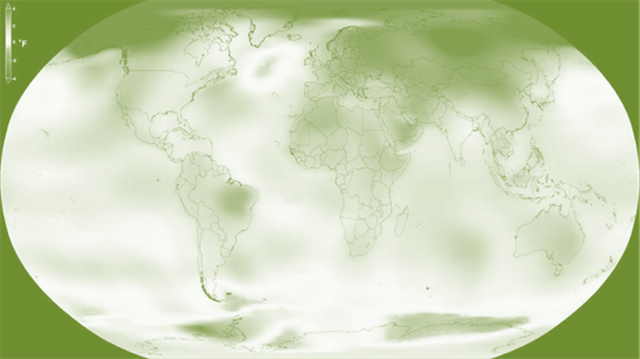

Es ist ein großes Problem für die Menschheit. Falsch, das genaue Gegenteil ist der Fall: Mehr CO2 wird ein Vorteil für die Menschheit sein. Die prophezeite Erwärmung durch CO2 ist erheblich übertrieben. Die Gleichgewichts-Erwärmung durch eine CO2-Verdoppelung beträgt nicht 3°C, was man marginal vielleicht als Problem ansehen könnte, sondern eher etwa 1°C, was vorteilhaft wäre. Man sollte nicht vergessen, dass „globale Erwärmung“ ein Mittelwert ist. In den Tropen wird es kaum Erwärmung geben, ebenso über Mittag. Irgendeine Erwärmung wird es hauptsächlich in gemäßigten und polaren Gebieten geben sowie nachts. Dies wird die landwirtschaftliche Saison in vielen Ländern wie Kanada, Skandinavien und Russland verlängern. Außerdem verstärkt mehr CO2 die Effizienz der Photosynthese der Pflanzen und macht diese dürreresistenter. Fazit: Alles in allem wird mehr CO2 für die Menschheit ein großer Vorteil sein.

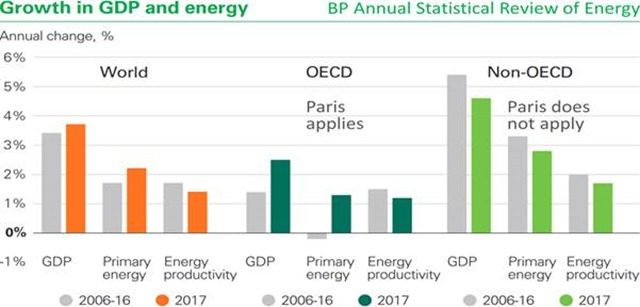

Eine gemeinsame globale Anstrengung ist erforderlich, um die Erwärmung zu bekämpfen. Angesichts der Kommentare oben ist dies blanker Unsinn. Maßnahmen der Regierung, um das gar nicht existierende Problem zu bekämpfen, haben die Landschaft mit Windparks und Solarfarmen verschandelt. Sie haben den Strompreis stark steigen lassen, was unverhältnismäßig die Ärmsten der Gesellschaft getroffen hat. Maßnahmen der Regierung haben die Wissenschaft korrumpiert, sie wurde mit Geld überflutet, damit sie zu politisch korrekten Ergebnissen kommt. Es ist endlich an der Zeit für Regierungen, die Wahrheit über globale Erwärmung zuzugeben. Erwärmung ist nicht das Problem. Die Maßnahmen der Regierung sind das Problem.

[Es folgt eine längere Passage zu Klimamodellen. Dann folgen längere Passagen zu den Themen Satellitenbeobachtrungen und Datenmanipulation. All dies ist ebenfalls schon in verschiedenen Beiträgen auf dieser Website zur Sprache gekommen.]

[Hier folgt im Interview eine ausführliche Beschreibung und Diskussion zu allen Aspekten bzgl. globale Erwärmung, als da wären die fabrizierte „Nichtexistenz“ des Stillstands, der Hockeyschläger, Datenmanipulationen usw. Das war alles wiederholt und seit Längerem Thema von Beiträgen auf diesem Blog, so dass dieser teil übersprungen wird. Dann aber geht es darum, ob wirklich Grund zum Alarm besteht, wobei die Ausführungen Happers sehr interessant sind. Im letzten Teil geht es dann noch um den sog. „Konsens“, zu dem Happer ebenfalls treffende Bemerkungen abgibt:]

TheBestSchools

Lassen Sie uns jetzt zum nächsten Punkt kommen, nämlich: Selbst unter der Annahme, dass die globale Erwärmung eine etablierte Tatsache und durch menschliche Aktivitäten verursacht ist (im Besonderen durch Verbrennung fossiler Treibstoffe), beharren Kritiker immer noch darauf, dass man mit Fug und Recht hinterfragen kann, ob es irgendwelche Gründe für Alarm angesichts dieser Fakten gibt. Oftmals werden Gründe angeführt, warum globale Erwärmung so schlecht nicht ist, darunter:

● Die Mittelalterliche Warmzeit zeigt, dass eine globale Erwärmung um ein paar Grad keine Katastrophe ist.

● Die mögliche Existenz verschiedener negativer Rückkopplungseffekte zeigt, dass sich die Erwärmung sehr gut selbst begrenzen könnte. Unter diesen negativen Rückkopplungen sind:

– verstärkte Wolkenbildung, welche mehr Sonnenenergie reflektieren

– Zunehmende Vegetation, welche mehr CO2 absorbiert

Unterstützer des Konsens‘ würden sagen, dass die Größenordnung des gegenwärtigen anthropogenen Antriebs zu Erwärmungen führen muss, welche jene aus früheren historischen Epochen marginalisiert.

Was meinen Sie dazu?

William Happer

Ich bin davon überzeugt, dass der größte Teil der Erwärmung natürlichen Gründen geschuldet ist, auf welche die Regierungen keinerlei Einfluss haben.

Wie ich oben erläutert habe, stelle ich nicht in Frage, dass sich die Erde nach dem Ende der Kleinen Eiszeit erwärmt hat, aber ich bin überzeugt, dass der größte Teil der Erwärmung natürliche Ursachen hat. Schon jetzt sehen wir mehr Vegetation auf der Erde, die mehr CO2 absorbiert. Aber wie ich in der Antwort auf Ihre nächste Frage ausführen werde denke ich, dass mehr CO2 gut für die Welt ist, dass diese seit Zehner-Millionen Jahren in einer CO2-Armut gesteckt hat und dass 1000 oder 2000 ppm ideal wären für die Biosphäre. Ich bin perplex angesichts der hysterischen Versuche, das CO2-Niveau unter 350 ppm zu drücken, ein Wert, den man aus einem Blick in die Glaskugel gefunden hat, der aber in keiner Weise auf Wissenschaft beruht.

TheBestSchools

Jetzt gehen Sie weiter als viele andere Kritiker des Konsens-Standpunktes, wenn Sie nicht nur betonen, dass gesteigerte atmosphärische CO2-Konzentrationen und globale Erwärmung keine Katastrophe seien, sondern dass sie sogar in großem Umfang vorteilhaft für die Menschheit seien.

Können Sie das bitte näher ausführen?

William Happer

Wir verdanken unsere Existenz grünen Pflanzen, die Kohlendioxid-Moleküle (CO2) und Wasser-Moleküle (H2O) mit Hilfe des Sonnenlichts in Kohlehydrate umwandeln. Ein Sauerstoff-Molekül (O2) wird für jedes CO2-Molekül freigesetzt, welches zu einem Kohlehydrat wird. Viel Sauerstoff ist ein Lebenselixier für die meisten Tiere. Aber wegen des derzeit sehr geringen CO2-Nivaus setzt Sauerstoff der photosynthetischen Effizienz von C3-Pflanzen ernsthafte Grenzen. Dies betrifft alle Bäume und viele landwirtschaftlich genutzte Pflanzen.

Pflanzen an Land bekommen den benötigten Kohlenstoff aus dem CO2 in der Luft. Die meisten Pflanzen ziehen andere Nährstoffe – Wasser, Stickstoff, Phosphor, Kalium – aus dem Boden. Genau wie Pflanzen besser wachsen auf gedüngten und gut bewässerten Böden, wachsen sie auch besser in der Luft mit CO2-Konzentrationen, die viele Male höher liegen als gegenwärtig.

[Es folgen ein paar Absätze, in denen er oben gesagtes näher erläutert und wie der geringe CO2-Gehalt das Pflanzenwachstum beeinträchtigt. Alle Absätze, die hier in der wörtlichen Übersetzung übersprungen werden, listet er am Ende konzentriert auf. Als nächstes jedenfalls geht es um den „Konsens“. Das folgt hier wieder in der direkten Übersetzung:]

TheBestSchools

Als nächstens wollen wir uns dem so genannten „Konsens“ zuwenden, von dem es heißt, dass er unter den Wissenschaftlern weltweit bzgl. globaler Erwärmung existiert.

Wir haben diesen Terminus der Bequemlichkeit halber verwendet, und es sieht mit Sicherheit so aus, als ob die Mehrheit der Wissenschaftler, die sich zu diesem Thema zumindest öffentlich äußern, dazu neigen, die offizielle IPCC-Position zu stützen. Andererseits wird die Behauptung, dass der Konsens „überwältigend“ ist (häufig wird die Zahl „97 Prozent“ genannt) von deren Befürwortern herangezogen, um Diskussionen und abweichende Meinungen abzuwürgen. Aus diesem Grund war die Behauptung der Kritik einiger Konsens-Kritiker ausgesetzt.

Beispiel: In ihrem Buch Taken by Storm (Key Porter Books, rev. ed. 2007) behaupten Christopher Essex und Ross McKitrick, dass ein solcher „Konsens“ nur wegen etwas besteht – falls das überhaupt so ist – was sie einen „perfekten Sturm“ nennen, in welchem übertriebene Behauptungen durch NGO-Propagandisten (wie Greenpeace) aufgenommen und von den Medien noch weiter aufgebauscht werden, was den Politikern (die normalerweise kein wissenschaftliches Hintergrundwissen haben) das Gefühl vermittelt, dass sie etwas tun müssen, was man bemerkt. All dies, behaupten sie, hat einen dämpfenden Effekt auf Wissenschaftler, die nicht den Konsens-Standpunkt teilen, die dies jedoch nicht offen sagen, weil sie Nachteile für ihre Laufbahn befürchten. In diesem Sinne wird der „Konsens“ zu einer sich selbst erfüllenden Prophezeiung.

Wie sehen Sie das? Gibt es einen Konsens bzgl. globaler Erwärmung? Ist er überwältigend? Falls ja, sind die Gründe dafür das, was Essex und McKitrick anführen, oder andere?

William Happer

Essex und McKitrick sind zur Zielscheibe geworden in ihrem Buch Taken by Storm. Es ist verblüffend, dass viele Skeptiker wie ich selbst im Ruhestand sind. Abgesehen von Rufmord gibt es nicht viel, was uns die Angriffshunde des Klimakonsens‘ tun können, zumindest bisher. Aber junge Akademiker wissen genau, dass sie ihre Karriere aufs Spiel setzen, wenn sie irgendwelche Zweifel an der Parteilinie bzgl. globaler Erwärmung verlauten lassen.

Was den Konsens in der Wissenschaft betrifft, kann niemand eloquenter sein als Michael Crichton in seinem Vortrag „Aliens Cause Global Warming“ (PDF) am California Institute of Technology im Jahre 2003:

[Es folgt ein Ausschnitt aus diesem Vortrag, der in der berühmten Aussage kulminiert:]

In der Wissenschaft ist ein Konsens irrelevant. Relevant sind ausschließlich reproduzierbare Ergebnisse. Die größten Wissenschaftler in der Geschichte sind genau aus dem Grunde die größten, weil sie mit dem Konsens gebrochen haben.

Es gibt so etwas wie Konsens in der Wissenschaft nicht. Falls es Konsens ist, ist es keine Wissenschaft. Falls es Wissenschaft ist, ist es kein Konsens. Punkt!“ Soweit Crichton.

TheBestSchools

Hier klangen schon schwierige moralische, gesellschaftliche und politische Dinge an, zusätzlich zu den rein wissenschaftlichen Dingen. Darum wollen wir jetzt in den Teil des Interviews einsteigen, in dem wir direkt einige der gesellschaftlichen Dinge ansprechen, die für die öffentliche Diskussion über globale Erwärmung relevant sind.

Im Einzelnen möchten wir Ihnen vier spezielle Fragen stellen:

● Sind konzertierte Maßnahmen der Regierung auf globaler Ebene wünschenswert?

● Falls ja, welchem Prinzip der Fairness sollte bei jenen Maßnahmen Rechnung getragen werden?

● Wenn die Hürden sehr hoch sind und es einen breiten wissenschaftlichen Konsens gibt, sollten Kritiker der Mainstream-Standpunkte nichtsdestotrotz aufgefordert werden, ihre Standpunkte frei benennen zu können?

● Ist politisches Eintreten durch Wissenschaftler überhaupt etwas Gutes?

[Die Frage wird dann noch näher ausgeführt und alle wesentlichen Punkte angesprochen, die auch hier in vielen Beiträgen auf diesem Blog schon angeklungen waren. Daher folgt hier gleich Happers Antwort:]

William Happer

Lassen Sie mich beginnen mit ihren oben aufgelisteten Fragen:

Sind konzertierte Maßnahmen der Regierung auf globaler Ebene wünschenswert? Nein! Mehr CO2 ist gut für die Welt, nicht schlecht. Konzertierte regierungsamtliche Maßnahmen können trotzdem ergriffen werden, wie schon so oft in der traurigen Historie menschlicher Dummheit. Ein Beispiel sind die Kreuzzüge, als die Anführer des „Westlichen Christentums“ sich zusammengeschlossen haben, um die Völker des östlichen Mittelmeergebietes zu bestrafen. Die Ära der Prohibition in den USA ist ein lokaleres Beispiel eines idiotischen Kreuzzuges, der sich als verheerend herausgestellt hatte. Einige wenige Opportunisten werden erheblich profitieren, falls konzertierte Maßnahmen bzgl. Klima ergriffen werden, aber die meisten Menschen und auch die Umwelt werden leiden.

Werden unsere allmächtigen Regierungen die Zunahme oder die Abnahme der Sonnenaktivität bekämpfen? Wo ist Owen Glendower (Bild 31 links), wenn wir ihn brauchen, um die „Geister aus der dunklen Tiefe“ zu beschwören, oder King Canute, um die Gezeiten zu stoppen? Ich bin nicht erpicht darauf, mich wahnwitzigen, von der Regierung gesponserten Geoengineering-Programmen eines flüchtigen Dr. Strangelove zu unterwerfen. Auch ist die Reduktion der menschlichen Population von derzeit sieben Milliarden Menschen auf nicht mehr als 1 Milliarde nicht sehr anziehend für mich, obwohl dies durch einflussreiche Klimaberater von Politikern und sogar des Papstes befürwortet wird. Sind wir gezwungen, Strohhalme zu ziehen, um zu entscheiden, welche sechs der sieben Menschen vom Angesicht der Erde verschwinden müssen?

Bzgl. CO2 sollten keinerlei Maßnahmen ergriffen werden. Aber ich stehe enthusiastisch hinter Maßnahmen gegen die wirkliche Verschmutzung von Luft, Boden oder Wasser durch Flugasche, Oxide oder Schwefel sowie Stickstoff aus der schlampigen Verbrennung von Kohle, oder Wasserverschmutzung durch sorglosen Umgang mit Düngern und Pestiziden, oder auch Plastikmüll in den Ozeanen infolge menschlicher Schlampigkeit.

Falls ja, welchem Prinzip der Fairness sollte bei jenen Maßnahmen Rechnung getragen werden? Ich betrachte den Krieg gegen den verantwortungsvollen Umgang mit Kohle und anderen fossilen Treibstoffen als zutiefst unmoralisch. Er wird die meisten Menschen verarmen lassen infolge steigender Energiekosten. Er wird kumpelhaft Kapitalisten bereichern, die den Rückhalt der Regierung haben, wenn sie die Menschen zwingen, ihre ineffiziente, kostspielige und unzuverlässige Energie aus Windmühlen und Solarparks zu kaufen. Es ist wie die französische Adlige, die als man ihr sagte, dass die Diner kein Brot mehr hätten geantwortet hatte: „Dann lasst sie Kuchen essen!“. Bei verantwortungsvoller Verwendung setzen fossile Treibstoffe nur vernachlässigbare Mengen an Verschmutzern frei wie Flugasche, Schwefel- und Stickoxide usw. Das so stark dämonisierte CO2, das zusammen mit H2O freigesetzt werden muss, ist tatsächlich ein Vorteil für die Erde, und nicht ein Verschmutzer.

Wenn die Hürden sehr hoch sind und es einen breiten wissenschaftlichen Konsens gibt, sollten Kritiker der Mainstream-Standpunkte nichtsdestotrotz aufgefordert werden, ihre Standpunkte frei benennen zu können? Jawohl! Dies ist die unveräußerbare Antwort für eine freie Gesellschaft, für welche ich und viele andere kämpfen, genau wie unsere Vorfahren es getan haben.

Ist politisches Eintreten durch Wissenschaftler überhaupt etwas Gutes? Jawohl! Wissenschaftler sollten sich auf jeder Seite eines kontroversen Themas äußern dürfen. Beispiel: Andrei Sacharov, einer meiner Helden, war ein leidenschaftlicher Verfechter eines Teststopps von Kernwaffen in der Atmosphäre. Er war davon überzeugt, dass der radioaktive Fallout der Bevölkerung der ganzen Welt große Schäden zufügen würde. Mein Onkel Karl Morgan, Gründer des Bereiches Gesundheits-Physik war ein leidenschaftlicher politischer Gegner, die Bevölkerung sorglos Strahlung auszusetzen.

…

[Als Nächstes führt Happer aus, dass er von Jugend auf für die Demokraten in den USA aktiv war. Es war zutiefst schmerzhaft für ihn zu sehen, wie sehr die Demokraten „sich genauso massiv der globalen Erwärmung verschrieben haben wie früher die Puritaner in Massachussetts den Hexen“.

Bei der nächsten Frage geht es darum, wie man am besten CO2-Emissionen reduzieren könnte. Dafür sieht Happer keinerlei Notwendigkeit, vielmehr würden solche Maßnahmen große Belastungen und keinerlei Vorteile bringen („All pain – no gain“). Weiter geht es dann mit „Freedom of Speech“, also der Redefreiheit. Dazu führt Happer aus:]

William Happer:

In der Wissenschaft kann es ohne Kontroversen keinerlei Fortschritt geben!

Fortschritte in der Wissenschaft sind ohne Kontroversen nicht möglich. Beispielsweise gab es Jahrzehnte Lang hitzige Debatten um die Theorie von Alfred Wegener bzgl. der Kontinentalverschiebung. Stanley Prusiner musste erbitterten Widerstand hinnehmen bzgl. seiner Theorie von Prionen und Rinderwahnsinn, weil diese Theorie gegen das Dogma stand, dass DNA oder RNA Auslöser von Infektionskrankheiten sein müssen, und nicht ein Protein.

Der Unterschied zur Kontroverse um die globale Erwärmung ist diesmal die direkte Involvierung von Regierungen auf einer Seite. Wie Sie sagen, Forderungen des Kongresses, denen zufolge Klimaskeptiker dunkler Machenschaften angeklagt werden sollten, sind in den USA beispiellos, obwohl es einen ominösen Präzedenzfall gibt in Gestalt des Lysenkoismus, über den wir vorhin gesprochen haben.

Bernie Sanders sagt, er wird „Klimaleugner vor Gericht bringen“, falls er zum Präsidenten der USA gewählt werden würde. Was hätten Menschen wie ich von einem Präsidenten Sanders zu erwarten? Ein Konzentrationslager? Das Erschießungskommando?

Und was geschah mit dem Ersten Artikel der US-Verfassung?

Es gibt viele ehrliche Wissenschaftler, die mit dem Thema Klima der Regierung zuarbeiten. … Ich bewundere diese Wissenschaftler und mache sie nicht verantwortlich für die aggressiven Wenigen, die mich und andere diffamieren als vermeintliche Prostituierte der Industrie fossiler Treibstoffe.

Während des Großen Terrors unter Stalin waren die Äquivalente zu bösen fossilen Treibstoffen Leon Trotzki und seine Anhänger. Sie waren eine direkte Bedrohung für Stalins Kontrolle über die weltweite kommunistische Bewegung, genau wie heute Klimaskeptiker angesehen werden als eine existentielle Bedrohung des Globale-Erwärmung-Establishments.

Ich wäre überrascht, wenn die Förderung von Klimaskeptikern insgesamt über 2 oder 3 Millionen Dollar pro Jahr hinausgehen würde, und selbst diese Schätzung könnte noch viel zu hoch sein. Dagegen beliefen sich während der letzten Jahre die Ausgaben der US-Regierung für die Klimaforschung (PDF) etwa 20 Milliarden Dollar pro Jahr – über 1000 mal mehr als die Förderung von Skeptikern. Aber selbst dieser gewaltige finanzielle Vorteil ist nicht ausreichend, um den beklagenswert schwachen wissenschaftlichen Fall zu stützen, dass die Welt durch mehr CO2 in Gefahr ist.

TheBestSchools:

Dann gibt es da noch die Frage, ob sich Wissenschaftler in die Politik einbringen sollten, und zwar bis zu dem Grad, den wir bei der Episode globale Erwärmung erlebt haben. Argumentiert wird mit zwei Gründen:

a) Politiker könnten faul werden und ihre Verantwortung, sich zu informieren, von sich wegzuschieben, selbst besser das Thema zu verstehen.

b) Wissenschaftler könnten die Integrität wissenschaftlicher Forschung selbst kompromittieren bis zu einem Grad, in dem sie sich selbst schädigt, wenn es in Zukunft erneut kontroverse Themen geben sollte.

…

William Happer:

Viele diesbezügliche Dinge haben wir schon angesprochen. Ich denke, dass der Wissenschaft allgemein bereits sehr großer Schaden zugefügt worden ist durch den Wahnsinn um die globale Erwärmung während der letzten Jahrzehnte. Vor zwanzig Jahren haben vermeintliche Experten-Wissenschaftler feierlich erklärt, dass unsere Kinder und Enkel nicht mehr wissen werden, was Schnee ist. Vor ein paar Wochen musste sich Washington D.C. mühsam aus 3 Fuß Schnee [ca. 90 cm] herauswühlen – vielerorts ein neuer Rekord.

Bei der Entgegennahme seines Friedensnobelpreises (der auch Yassir Arafat verliehen worden war), sagte Al Gore, dass die Arktis bis 2013 sommers eisfrei sein könnte infolge der CO2-Emissionen. Ich ersuche jeden Leser, sich auf der entsprechenden Daten-Site umzusehen. Nur wenige Minuten der Betrachtung des Links zum „Meereis“ dürften ausreichen zu erkennen, dass sich seit dem Jahr 2007 das Meereis kaum verändert hat.Mit allem Respekt gegenüber Al Gore, es gab sehr viel Sommereis im Jahre 2013.

Ich hoffe, wenn der Globale-Erwärmung-Skandal einmal hinter uns liegt, dass man der Wissenschaft dann vergibt, dass sie sich so lange diesem Vorgang verschrieben hat. Die Biologie der Sowjetunion brauchte Jahrzehnte, um sich von dem durch den Lysenkoismus angerichteten Schaden zu erholen.

TheBestSchools:

Zum Schluss möchten wir Sie bitten – im Telegrammstil, wenn Sie mögen – uns die fünf stärksten Argumente gegen den Konsens-Standpunkt zu nennen, ebenso wie die fünf schwächsten Argumente, die die Befürworter allgemein pro dieses Konsens-Standpunktes anführen.

William Happer:

● Klimamodelle haben weit mehr Erwärmung prophezeit als den Beobachtungen zufolge tatsächlich eingetreten ist. Dies ist ein ganz starker Beweis dafür, dass die aus einer Verdoppelung des CO2-Gehaltes resultierende Gleichgewichts-Temperatur nicht 3°C bis 3,5°C beträgt, wie es den meisten Klimamodellen zufolge der Fall sein soll, sondern viel weniger, möglicherweise nahe 1°C.

● Der Konsens hat weitgehend die enormen positiven Auswirkungen von mehr CO2 in der Luft ignoriert.

● Zu den starken Temperaturänderungen der Mittelalterlichen Warmzeit und der Kleinen Eiszeit war es lange vor dem großmaßstäblichen Verbrauch fossiler Treibstoffe nach der Industriellen Revolution gekommen.

● Es gibt eine starke Korrelation zwischen Temperatur und Sonnenaktivität.

● Rasende persönliche Angriffe auf glaubwürdige Gegner zeigen, dass Unterstützer des Konsens‘ eine sehr schwache wissenschaftliche Grundlage haben. Man braucht keine potentiell kontraproduktiven persönlichen Angriffe, wenn man starke wissenschaftliche Argumente auf seiner Seite hat.

Schwächste Argumente pro Konsens-Standpunkt:

● 97 Prozent aller Wissenschaftler stimmen dem Konsens zu.

● Die Temperatur ist während des vorigen Jahrhunderts gestiegen, das CO2-Niveau auch. Darum wurde der Temperaturanstieg durch CO2 verursacht.

● zunehmendes CO2.

● Von der Regierung finanzierte, den Konsens unterstützende Forscher befinden sich nicht in einem Interessenkonflikt.

● Wissenschaftliche Opponenten des Konsens‘ sind Prostituierte der bösen Fossile-Treibstoffe-Industrie.

TheBestSchools

Vielen Dank, Prof. Happer, für dieses Interview!

William Happer ist Cyrus Fogg Brackett Professor der Physik, Emeritus, im Fachbereich Physik der Princeton University. Als langzeitliches Mitglied von JASON, einer Gruppe von Wissenschaftlern, die der US-Regierung als unabhängige Berater zur Verfügung stehen für die Bereiche, Wissenschaft, technik und nationale Sicherheit, war Happer Direktor des Office of Science im Energieministerium von 1991 bis 1993.

Am ehesten ist er der Öffentlichkeit bekannt als Stimme der Kritik des UN-IPCC-Konsens‘ bzgl. der globalen Erwärmung. Er wurde häufig gerufen, um als Experte auszusagen vor verschiedenen Komitees des US-Kongresses zum Thema globale Erwärmung (Klimawandel). Im Jahre 2015 fand er sich im Zentrum einer Kontroverse, bei der eine so genannte „verdeckte“ Operation involviert war, die Greenpeace organisiert hatte.

Eine Liste mit einigen Forschungsergebnissen von Prof. Happer findet sich hier.

Link: http://www.thebestschools.org/special/karoly-happer-dialogue-global-warming/william-happer-interview/

—————————————————

So weit Ausschnitte aus diesem Interview. Inzwischen geht es aber weiter! Der Washington Post zufolge wird sich Prof. Happer mit dem gewählten Präsidenten Trump zu einem Gespräch treffen. Im jüngsten Rundbrief der GWPF vom 16.1.2017 wird folgendermaßen darauf hingewiesen:

Trump trifft den Priceton-Physiker der sagt, dass CO2 gut für uns ist

Ja, Donald Trump hat sich mit Al Gore getroffen. Aber vor ein paar Tagen traf sich dem Transitions-Team von Trump zufolge der gewählte Präsident auch mit William Happer, einem Professor der Physik an der Princeton University, welcher eine prominente Stimme war beim Hinterfragen, ob wir uns wegen des vom Menschen verursachten Klimawandels Sorgen machen müssten. Bei einer Anhörung vor dem Senat im Jahre 2015 argumentierte Happer, dass „die Vorteile von mehr Kohlendioxid in der Luft die Nachteile weit überwiegen, beispielsweise durch eine Steigerung landwirtschaftlicher Erträge“. Happer ist ein hervorragender Physiker (und Mitglied des Beratungsgremiums der GWPF), der prominente Stellungen im Energieministerium bekleidet hatte, ebenso wie an seiner Universität, und der auf 200 wissenschaftliche Veröffentlichungen mit seinem Namen zurückblicken kann. – Chris Mooney, The Washington Post, 13 January 2017

——————————————–

Die Aussagen Happers bzgl. Treibhausgase werden in dem Rundbrief ebenfalls angesprochen:

William Happer: Die Wahrheit über Treibhausgase

„Thema des Autors war es, die bemerkenswertesten Beispiele jener Moral-Epidemien zu sammeln, welche mal aus dem einen, dann aus einem anderen Grund so begeistert kolportiert worden sind. Außerdem sollte er damit zeigen, wie einfach sich die Massen haben in die Irre führen lassen, und wie nachahmend und gesellig Menschen sind, sogar noch hinsichtlich ihrer Verblendung“, schrieb Chalres Mackay im Vorwort der ersten Ausgabe seiner Extraordinary Popular Delusions and the Madness of Crowds [etwa: Außerordentlich populäre Wahnvorstellungen und die Verrücktheit der Massen]. Ich möchte über eine zeitgemäße Moral-Epidemie sprechen, nämlich über das Narrativ, dass eine zunehmende atmosphärische Konzentration von Treibhausgasen, insbesondere Kohlendioxid, katastrophale Folgen für die Menschheit und den Planeten haben wird. Dieser moderne „Klima-Kreuzzug“ hat viel gemein mit den Kreuzzügen des Mittelalters, die Mackay beschreibt, gibt es doch auch hier wahre Gläubige, Opportunisten, Zyniker, geldhungrige Regierungen, Manipulateure aller Art und sogar Kinder-Kreuzzüge. – William Happer: The Truth about Greenhouse Gases, Global Warming Policy Foundation (PDF)

Alles übersetzt und aufbereitet von Chris Frey EIKE