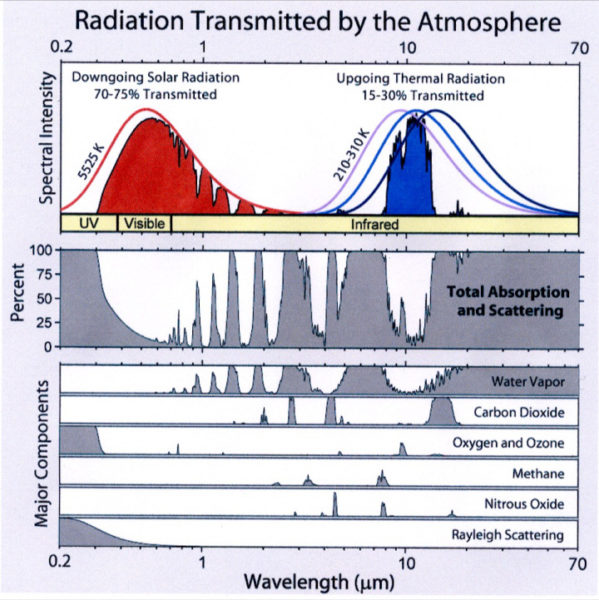

Das Klimasystem der Erde ist ein dynamisches, nichtlineares System, das permanent sowohl von langperiodischen als auch von kurzperiodischen und unsystematischen Einflussfaktoren angetrieben wird. Längerfristige Antriebe sind vor allem die Veränderungen des solaren Energieflusses, der „Solarkonstanten“. In welchem Ausmaß auch der anthropogene Treibhauseffekt eine Rolle beim längerfristigen Klimawandel spielt, soll in dieser Untersuchung nach dem Residuumprinzip überprüft werden.

Zu den kurzperiodischen Klimafaktoren zählen die Veränderungen der Meeresoberflächentemperatur, wie sie u.a. im Pazifik als ENSO-Kalt- und Warmphasen und im Atlantik als meridionale Temperaturschaukel (H.Malberg, G.Bökens 1993) auftreten. Auch der vulkanische Einfluss wirkt sich kurzzeitig auf das Klima aus. So kommt es nach Vulkanausbrüchen durch den Feinstaub zu einer erhöhten atmosphärischen Trübung und damit infolge einer verstärkten Absorption von Solarstrahlung zu einer Erwärmung in der oberen Stratosphäre bei gleichzeitiger Abkühlung in den bodennahen Schichten.

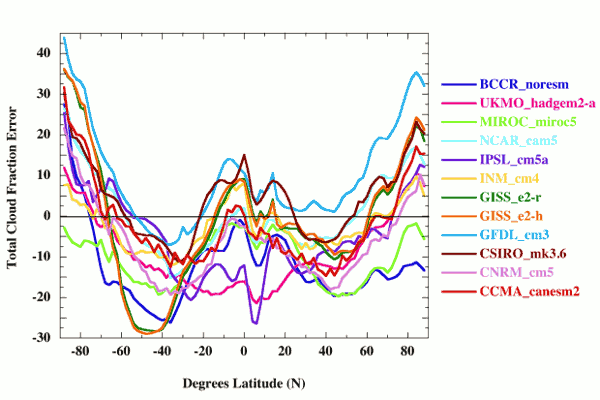

Als Beispiel für klimarelevante Wechselwirkungen/Rückkopplungen seien die gekoppelten Änderungen von Temperatur und Schnee-/Eisbedeckung beschrieben. Eine Erhöhung der Temperatur führt zu einem Rückgang der Schnee-/Eisbedeckung. Die Erdalbedo verringert sich, und die Temperaturerhöhung wird verstärkt. Analoges gilt, wenn sich Abkühlungen bei zunehmender Schnee-/Eisbedeckung (erhöhte Albedo) verstärken. Hohe Klimaeffekte haben auch Änderungen der Wolkenbedeckung.

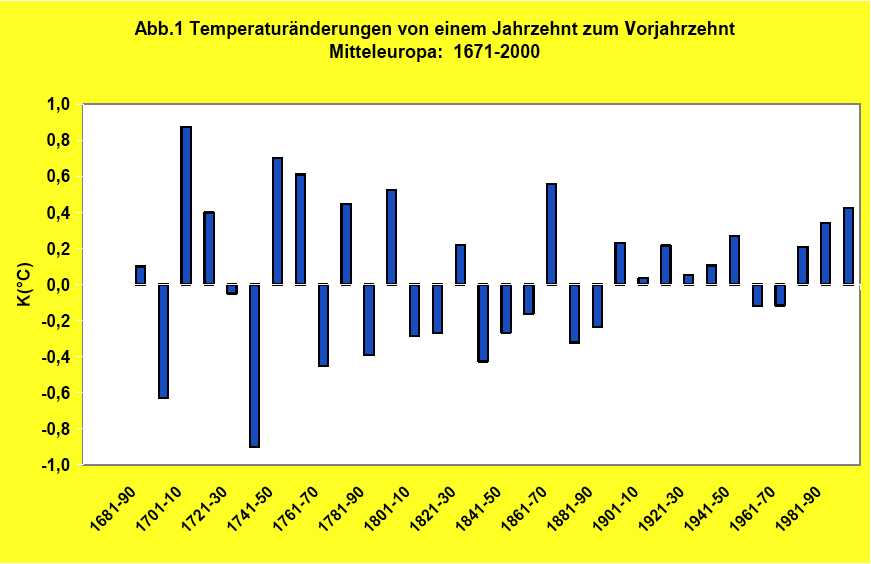

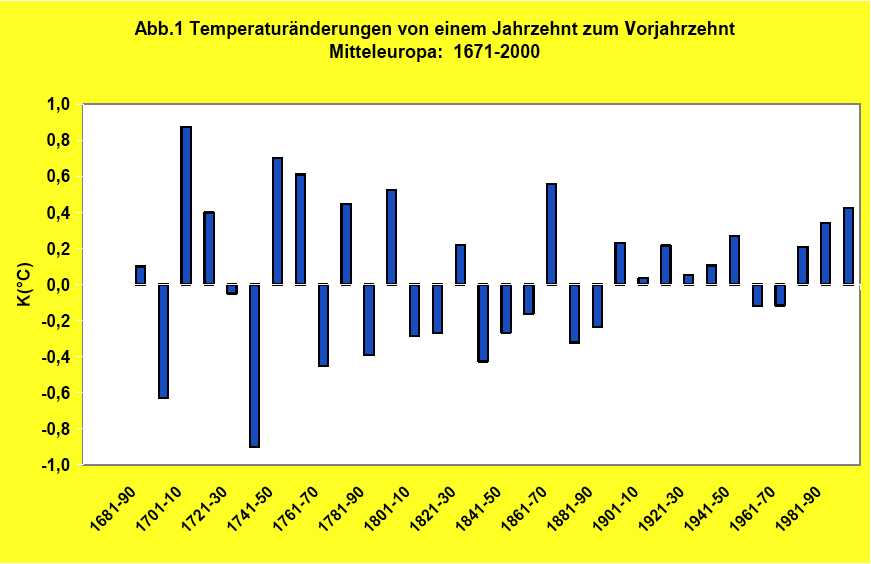

Eine Vielzahl von Prozessen ist somit zu jedem Zeitpunkt in unserem Klimasystem wirksam. Was wir als Klimaverhalten beobachten, ist das Gesamtresultat aller Antriebe, welche auf der kurz- und langfristigen Zeitskala ablaufen. In Abb.1 sind die in Mitteleuropa seit der Endphase der Kleinen Eiszeit beobachteten Temperaturänderungen eines Jahrzehnts zum Vorjahrzehnt wiedergegeben. Dabei sind positive wie negative Temperatursprünge von 0,4K bis 0,5K keine Seltenheit. Im Einzelfall werden sogar +/-0,9K erreicht. Die Konsequenz aus diesem Temperaturverhalten ist, dass es nicht möglich ist, langfristige Klimaänderungen auf der Basis von einzelnen dekadischen (oder etwa jährlichen) Temperaturänderungen zuverlässig zu beurteilen.

Aufgrund dieses Sachverhalts haben unsere klimatologischen Lehrer als Klimaperioden 30-jährige Mittelwerte eingeführt. Auf diese Weise wird erreicht, dass die kurzzeitig wirkenden Klimaeinflüsse herausgefiltert werden und allein die langfristige, nachhaltige Klimaänderung sichtbar wird.

In Abb.2 sind anhand der 30-jährig gleitenden Mitteltemperaturen die langfristigen Klimaänderungen von Mitteleuropa seit der Kleinen Eiszeit wiedergegeben. Der permanente Klimawandel ist ein Faktum. Ferner wird in der Abbildung (relativ zum Mittelwert) deutlich, wann unternormale, also kalte, und wann übernormale, also warme Klimabedingungen geherrscht haben. Der Kleinen Eiszeit des 17. Jahrhunderts folgte eine Wärmeperiode im 18. Jahrhundert. An diese schloss sich die Kälteperiode des 19. Jahrhunderts an. Ihr folgte die Erwärmung im 20. Jahrhundert. Fazit: Der Klimawandel ist ein systemimmanenter Prozess. Alle unsere Vorfahren mussten sich auf veränderte Klimaverhältnisse einstellen. Auch die heutigen und nachfolgenden Generationen werden dieses tun müssen – egal welche CO2-Maßnahmen ergriffen werden.

Ursachen der langfristigen Klimaänderungen

Bei der Frage nach der primären Ursache des langfristigen Klimawandels ist die Klimawissenschaft auch unmittelbar vor dem UN-Klimagipfel in Kopenhagen (Dezember 2009) unverändert in zwei grundsätzliche Lager gespalten. Das eine Lager ist sich mit Politik und Medien in der Annahme einig, dass der anthropogene Treibhauseffekt den langfristigen Klimawandel primär verursache, auch wenn es dafür keinen schlüssigen Beweis gibt. Vor allem empirische Klimatologen und Astrophysiker gehen dagegen davon aus, dass der solare Einfluss auf das Klima, wie zu allen Zeiten, der dominierende langfristige Klimaantrieb ist. Zur Klärung dieses Dissens sollen nachfolgend unterschiedliche räumliche und zeitliche Klimaskalen analysiert werden. Dabei bleibt der methodische Ansatz gegenüber den früheren Untersuchungen grundsätzlich unverändert, jedoch werden entsprechend den Klimaperioden über 3 Dekaden Untersuchungsintervalle von 3 Sonnenfle-ckenzyklen definiert.

Die rotierende Sonne ist wie unser Klimasystem ein dynamisches, nichtlineares System. In ihr wirken nukleare, elektrische, magnetische, thermische Kräfte sowie die Gravitation. Die Folge der damit verbundenen Prozesse sind kurz- und langzeitliche Schwankungen des solaren Energieflusses. In Bezug auf die längerfristigen klimarelevanten Auswirkungen ist es daher auch beim solaren Antrieb sinnvoll, die kurzperiodischen/unsystematischen Aktivitätsschwankungen herauszufiltern. Dieses erfolgt, wie gesagt, durch die Mittelwertbildung der Sonnenfleckenzahlen über 3 Sonnenfleckenzyklen, im Mittel also über 33 Jahre.

Die globale Klimaskala

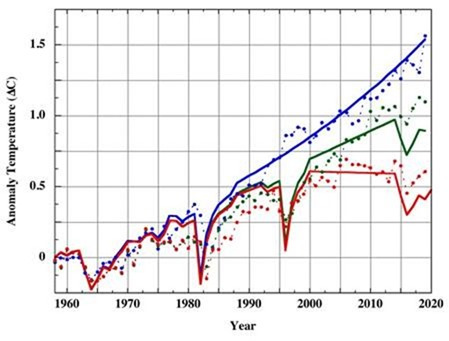

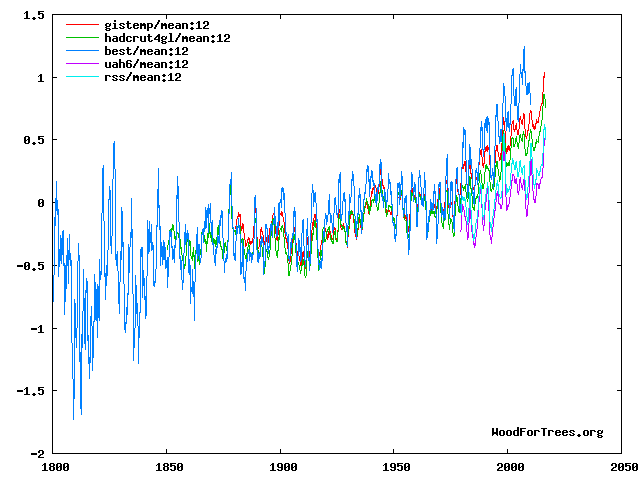

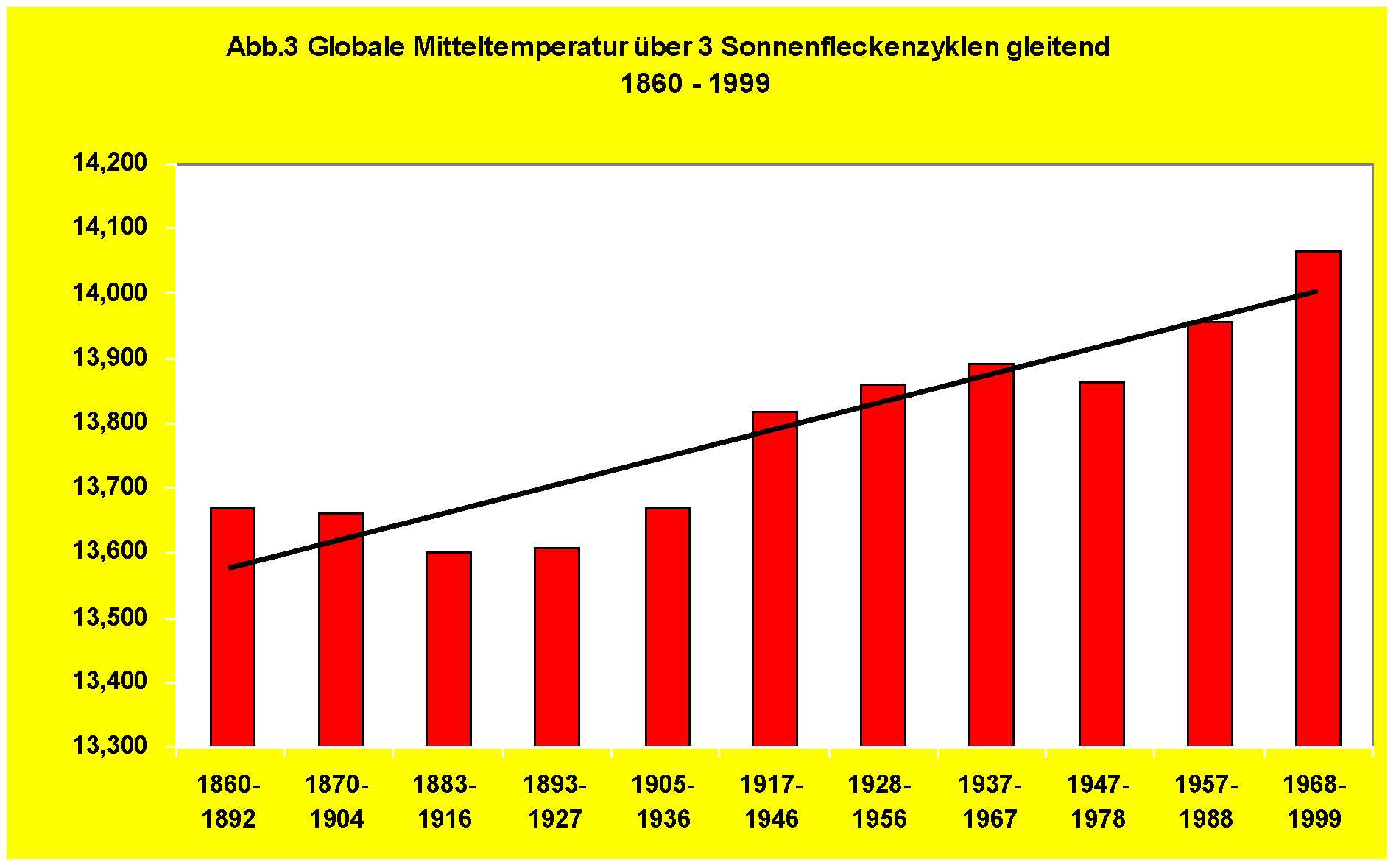

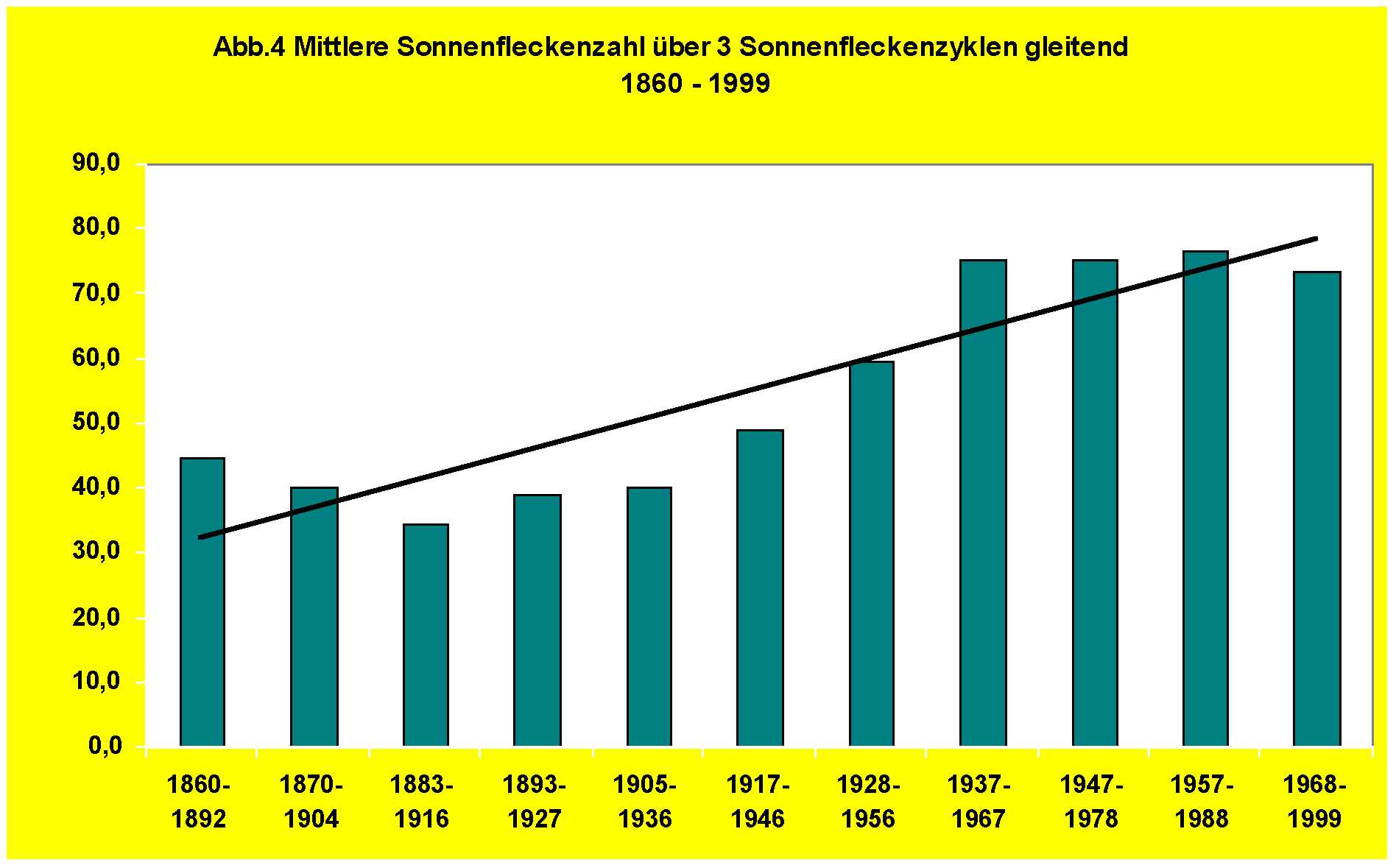

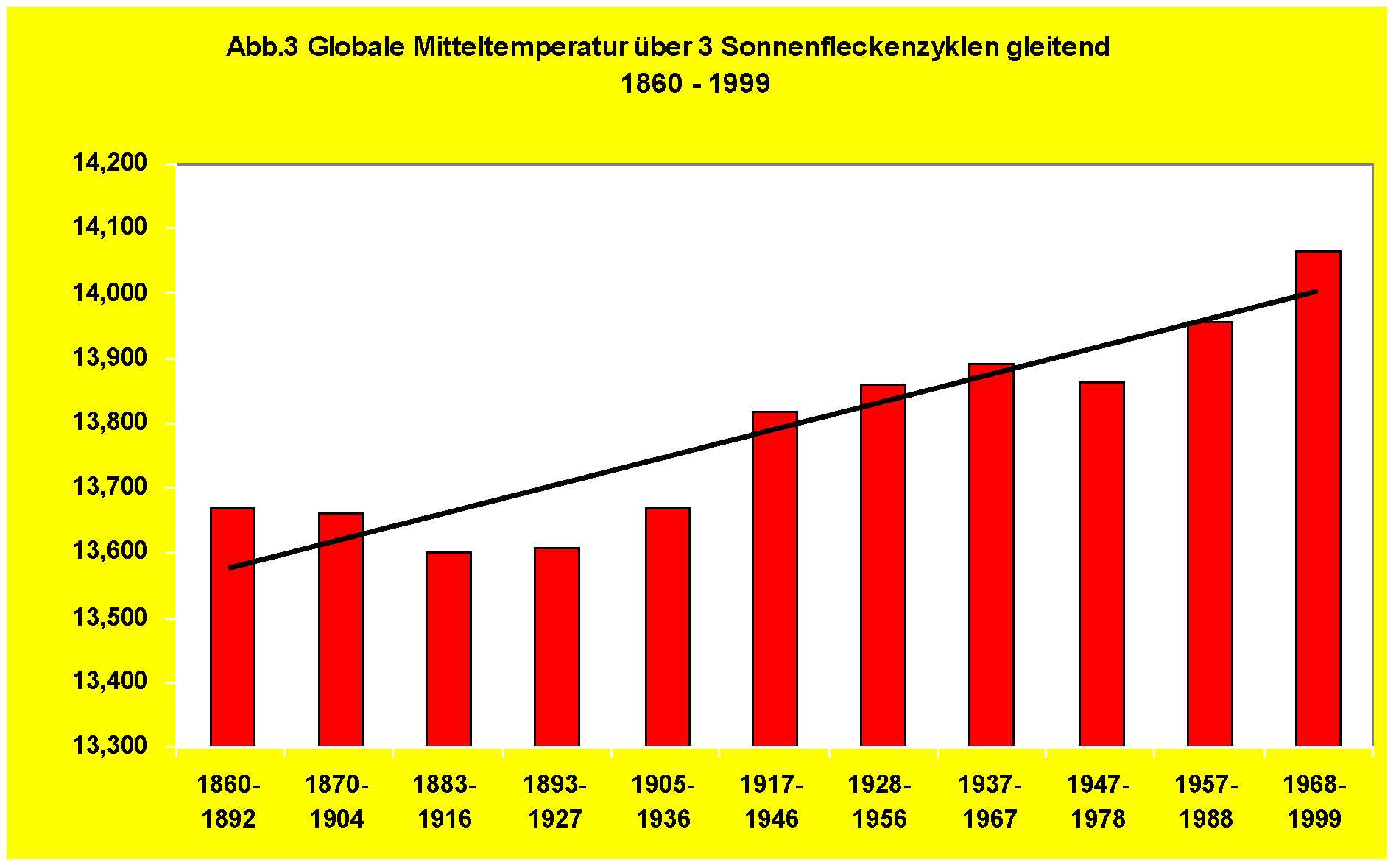

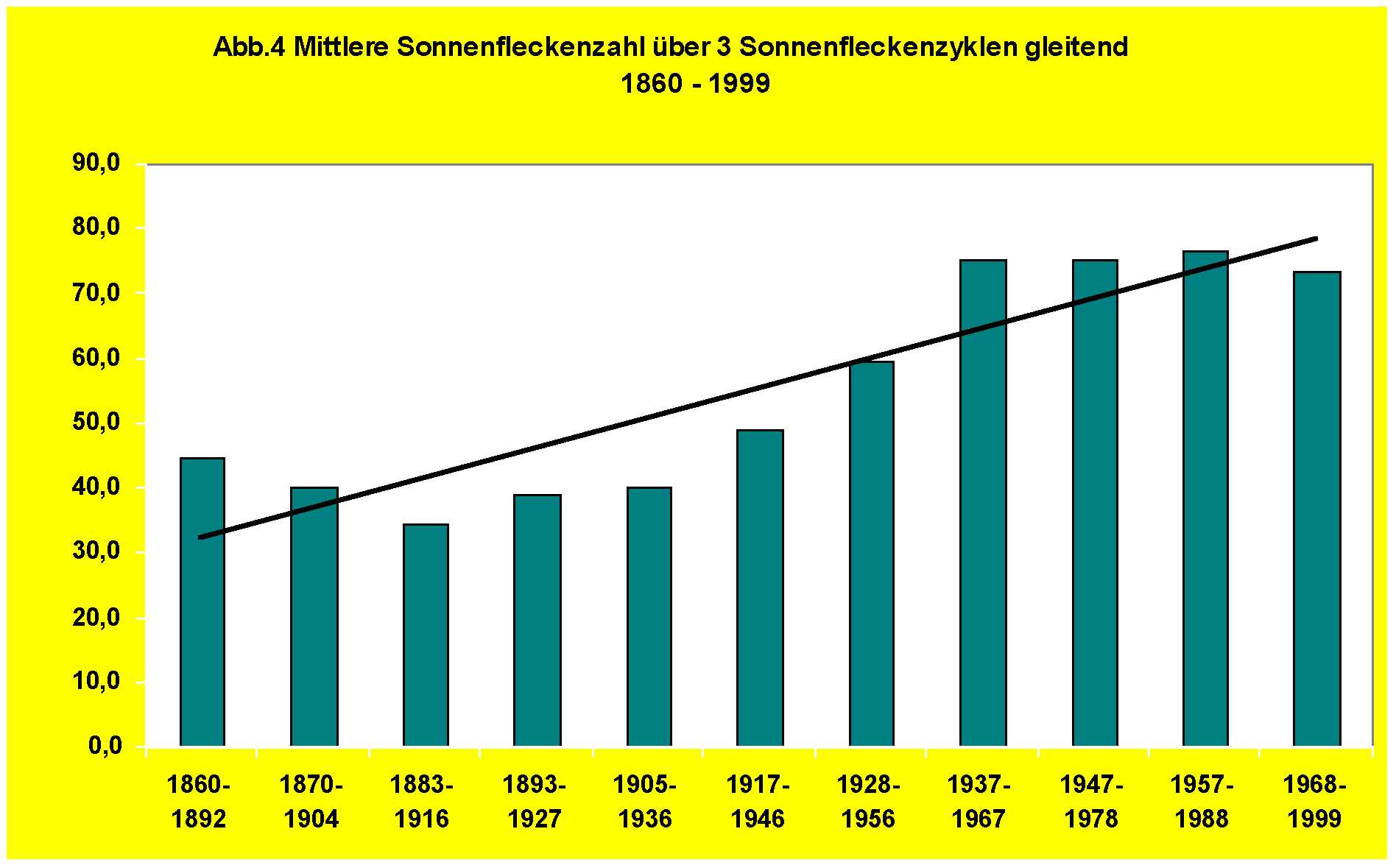

Von den untersuchten Klimaskalen umfasst die globale/hemisphärische Skala (mangels weltweiter Beobachtungsdaten) mit rund 150 Jahren den kürzesten Zeitraum der jüngeren Klimageschichte. In Abb.3 ist die globale Mitteltemperatur, in Abb.4 die mittlere Sonnenfleckenzahl jeweils über 3 Sonnenfleckenzyklen gleitend für die Zeit 1860-1999 dargestellt.

Vergleicht man Abb.3 und Abb.4 miteinander, so fällt die längerfristige globale Erwärmung unverkennbar mit einem Anstieg der Sonnenfleckenzahl, also mit einer langfristigen Zunahme der Sonnenaktivität, zusammen. Temperatur und Sonnenaktivität verlaufen grundsätzlich synchron. Analoges gilt für die Temperaturentwicklung auf der Nord- und Südhalbkugel.

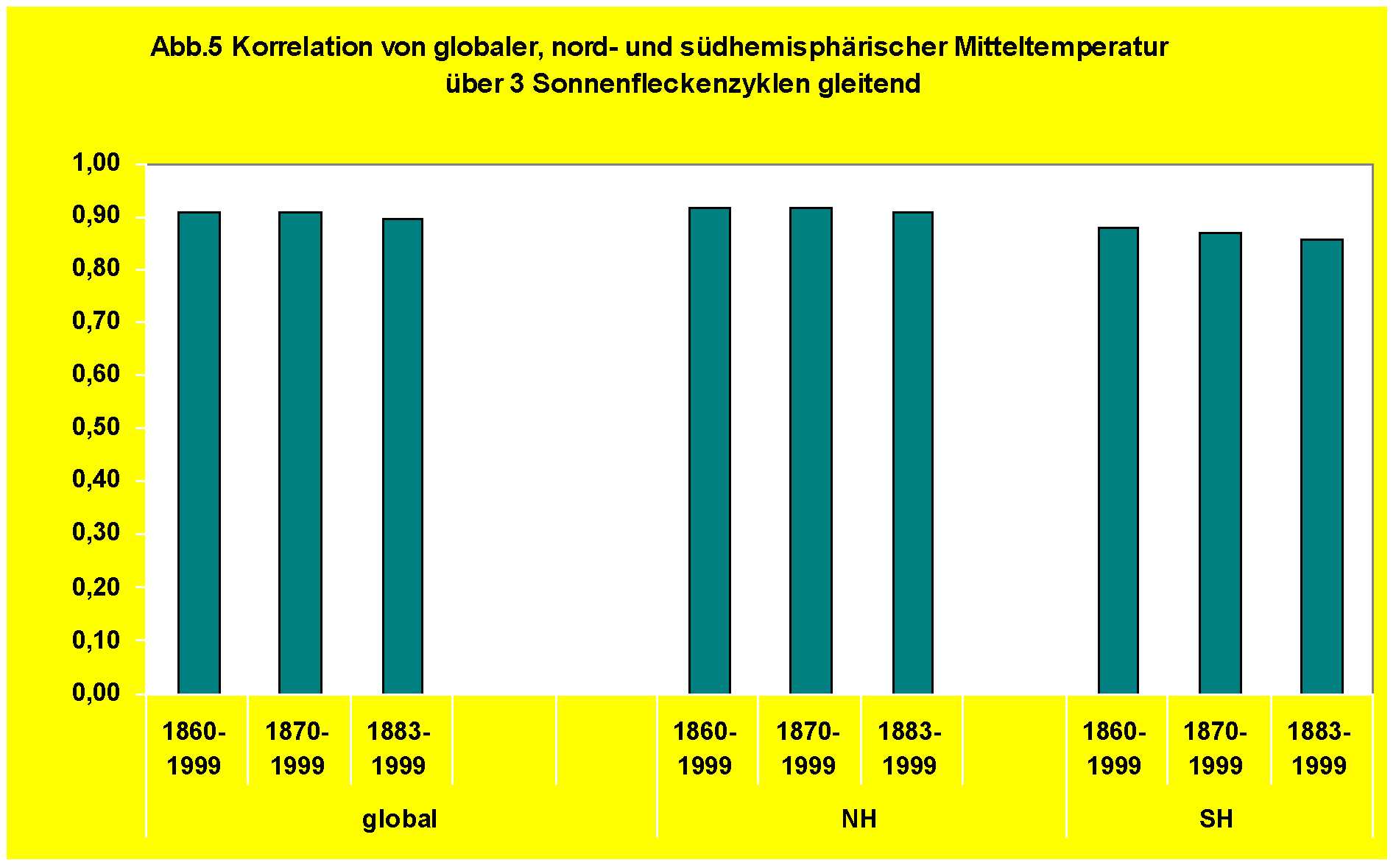

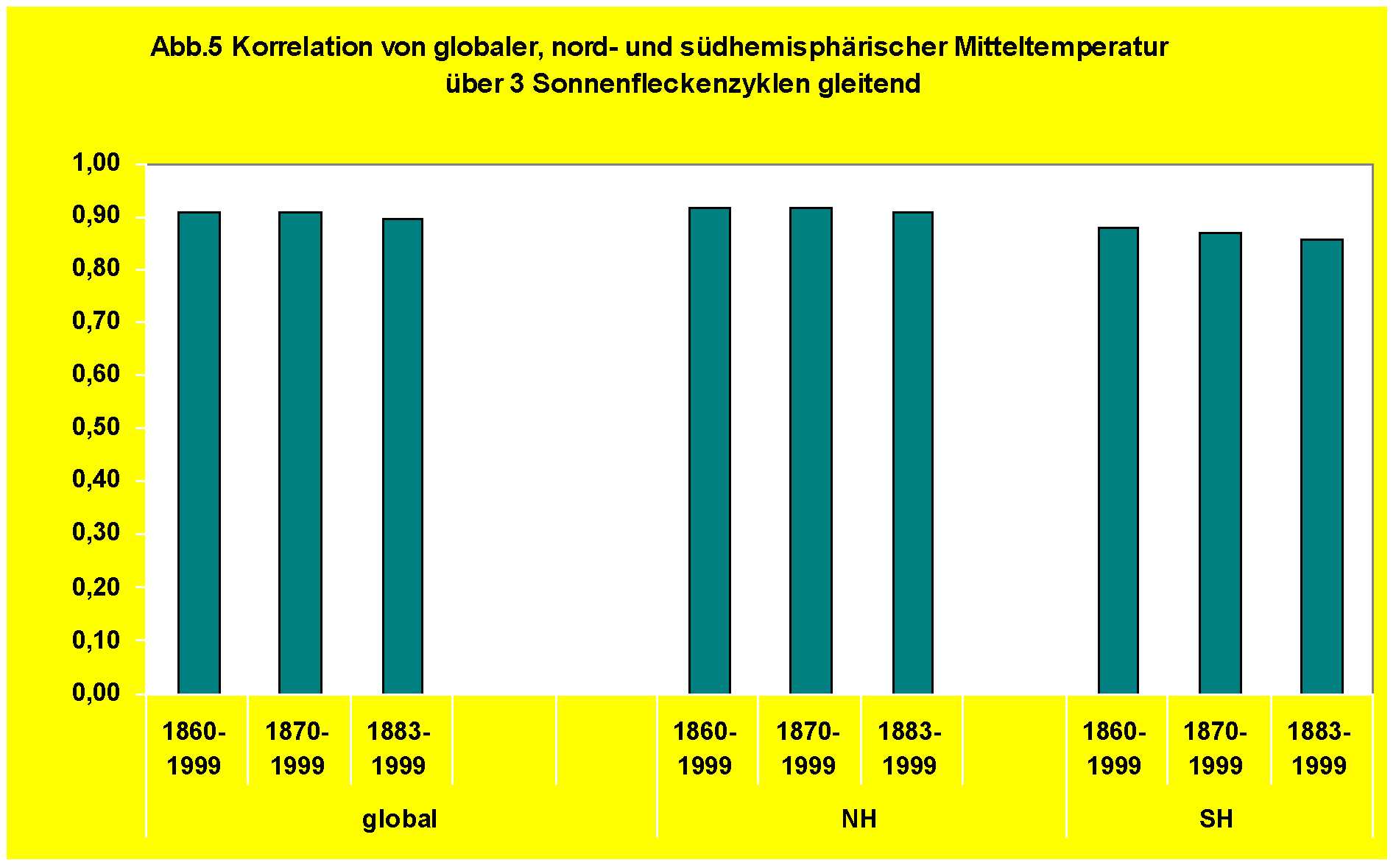

Um den quantitativen Zusammenhang zwischen den langfristigen solaren Antriebsänderungen und den effektiven (direkten und indirekten) Auswirkungen auf die globale/ hemisphärische Temperatur zu bestimmen, wurde eine Korrelationsanalyse durchgeführt. Die Ergebnisse sind für die zeitlichen Intervalle 1860-1999, 1870-1999 und 1883-1999 in Abb.5 wiedergegeben.

Wie sich zeigt, ergibt sich für die von kurzperiodischen Einflüssen befreite langfristige Temperaturentwicklung ein globaler Korrelationskoeffizient von +0,90 mit dem solaren Antrieb. Mit +0,92 liegt der Korrelationskoeffizient für die Nordhalbkugel leicht höher als der Wert der Südhalbkugel von +0,87 –vermutlich ein Effekt der unterschiedlichen Land-Meer-Verteilung. Ferner zeigt der Blick auf Abb.5, dass die Korrelationskoeffizienten eine hohe zeitliche Stabilität aufweisen.

Die lokale Klimaskala (Deutschland)

Während die globale Klimareihe den Klimawandel erst seit der Mitte des 19. Jahrhunderts erfasst, geben die Klimabeobachtungen von Hohenpeißenberg (60 km südwestlich von München gelegen) Aufschluss über die Klimaentwicklung in Deutschland seit 1780. Dabei zeichnen sich die Hohenpeißenbergdaten –im Gegensatz zu den globalen Daten- durch eine hohe Homogenität aus. Durch die über 3 Sonnenfleckenzyklen berechneten Mitteltemperaturen wurden die vielfältigen zirkulationsbedingten kurzfristigen kontinentalen und maritimen Einflüsse eliminiert, so dass im Ergebnis allein das langfristige Klimaverhalten von Deutschland erkennbar wird.

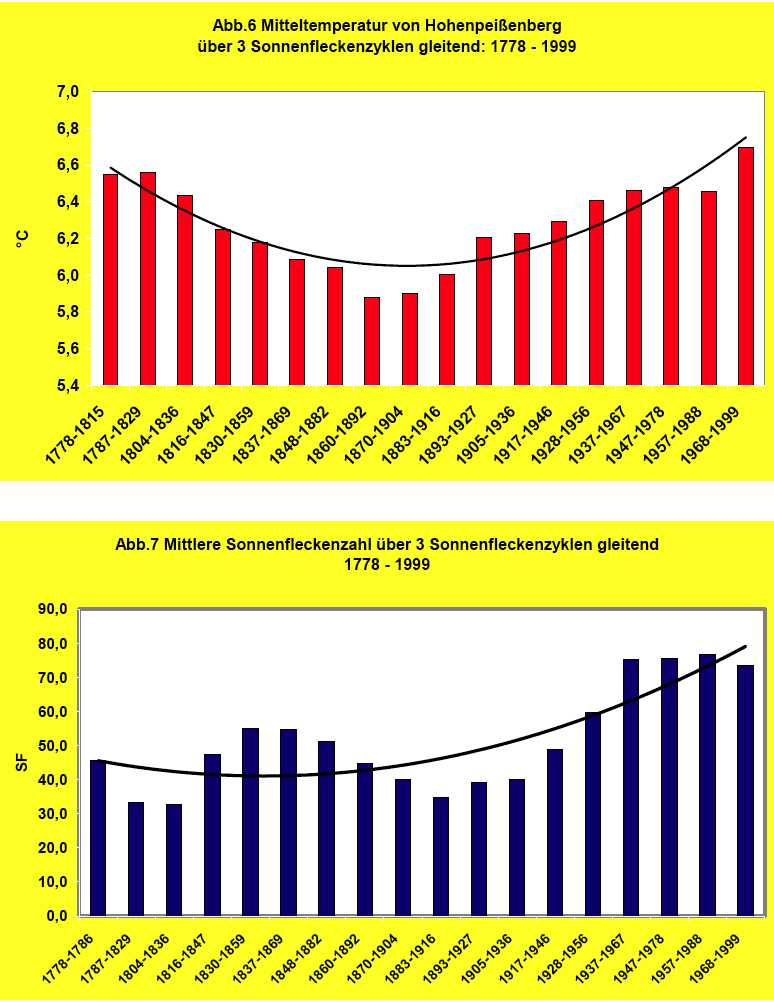

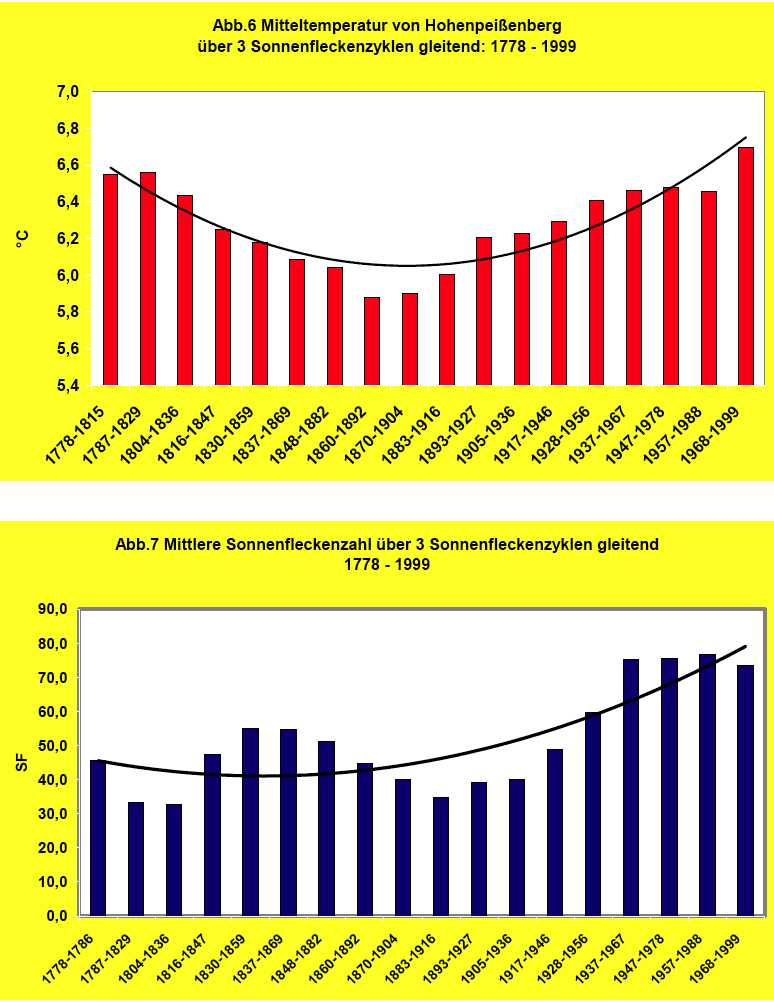

In Abb.6 ist die Klimaentwicklung anhand der Temperaturbeobachtungen von Hohenpeißenberg für den Zeitraum 1778-1999 dargestellt. (Die zwei Jahrestemperaturen 1778/1779 wurden zur Vervollständigung des entsprechenden Sonnenfleckenzyklus aus der Berliner Klimareihe reduziert).

Wie Abb.6 zeigt, weist das Temperaturverhalten während der 220 Jahre einen U-förmigen Verlauf auf. Einer Wärmeperiode um 1800 folgte ein deutlicher Temperaturrückgang im 19. Jahrhundert. Ihm folgte dann als Klimaerholung der Temperaturanstieg im 20. Jahrhundert.

Die über 3 Sonnenfleckenzyklen gleitenden mittleren Sonnenfleckenzahlen sind in Abb.7 dargestellt. Wie sich zeigt, weist die solare Aktivität in den 220 Jahren einen grundsätzlich analogen Verlauf zum Temperaturverhalten von Deutschland auf.

Der verstärkten Sonnenaktivität am Ende des 18. Jahrhunderts mit einem Mittelwert von rund 45 Sonnenflecken folgten im 19. Jahrhundert zeitweise Werte zwischen 30 und 35 und zum Ende des 20. Jahrhunderts von über 70, was einer Zunahme der mittleren Sonnenfleckenzahl um 100% während der jüngsten Erwärmung entspricht.

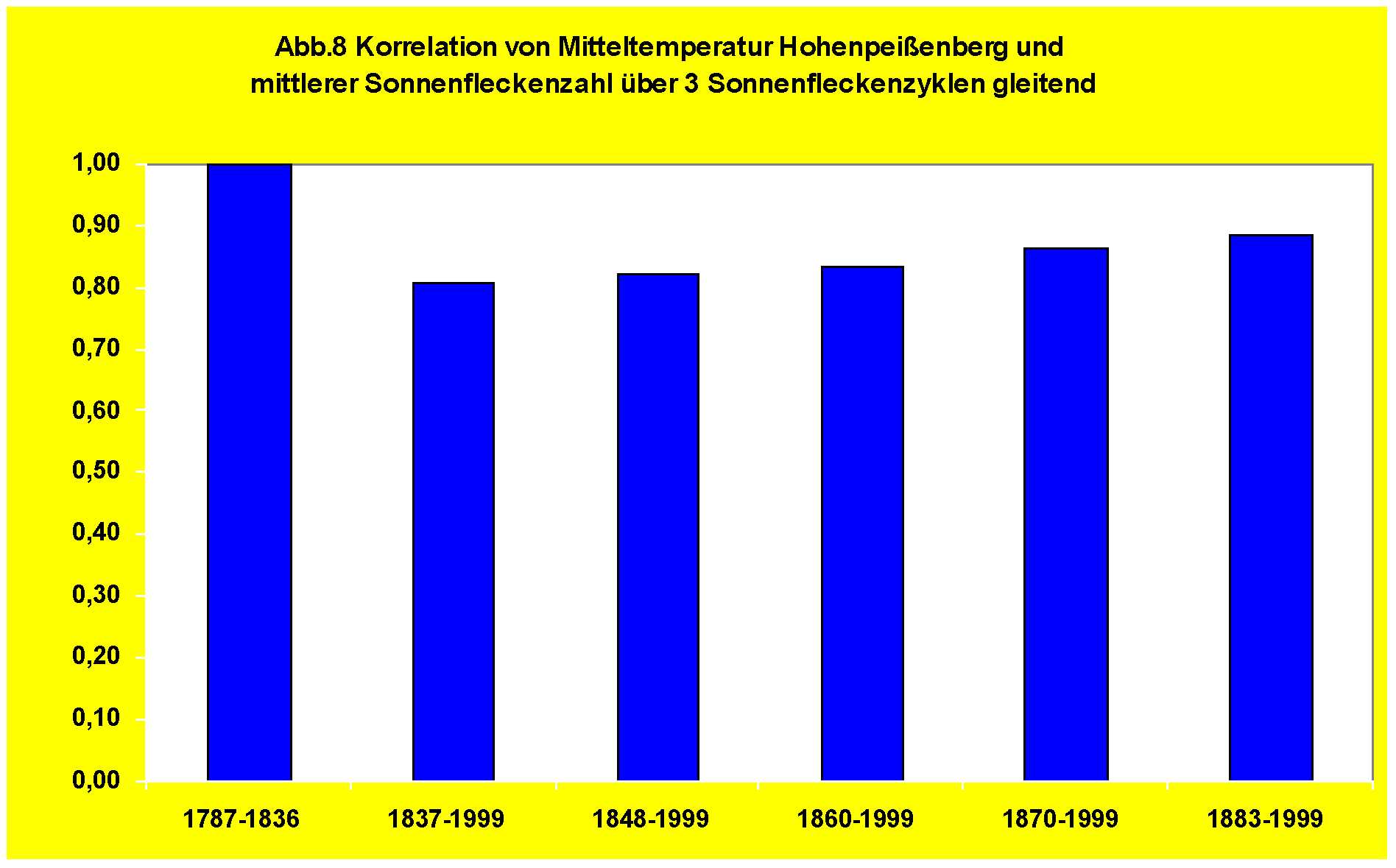

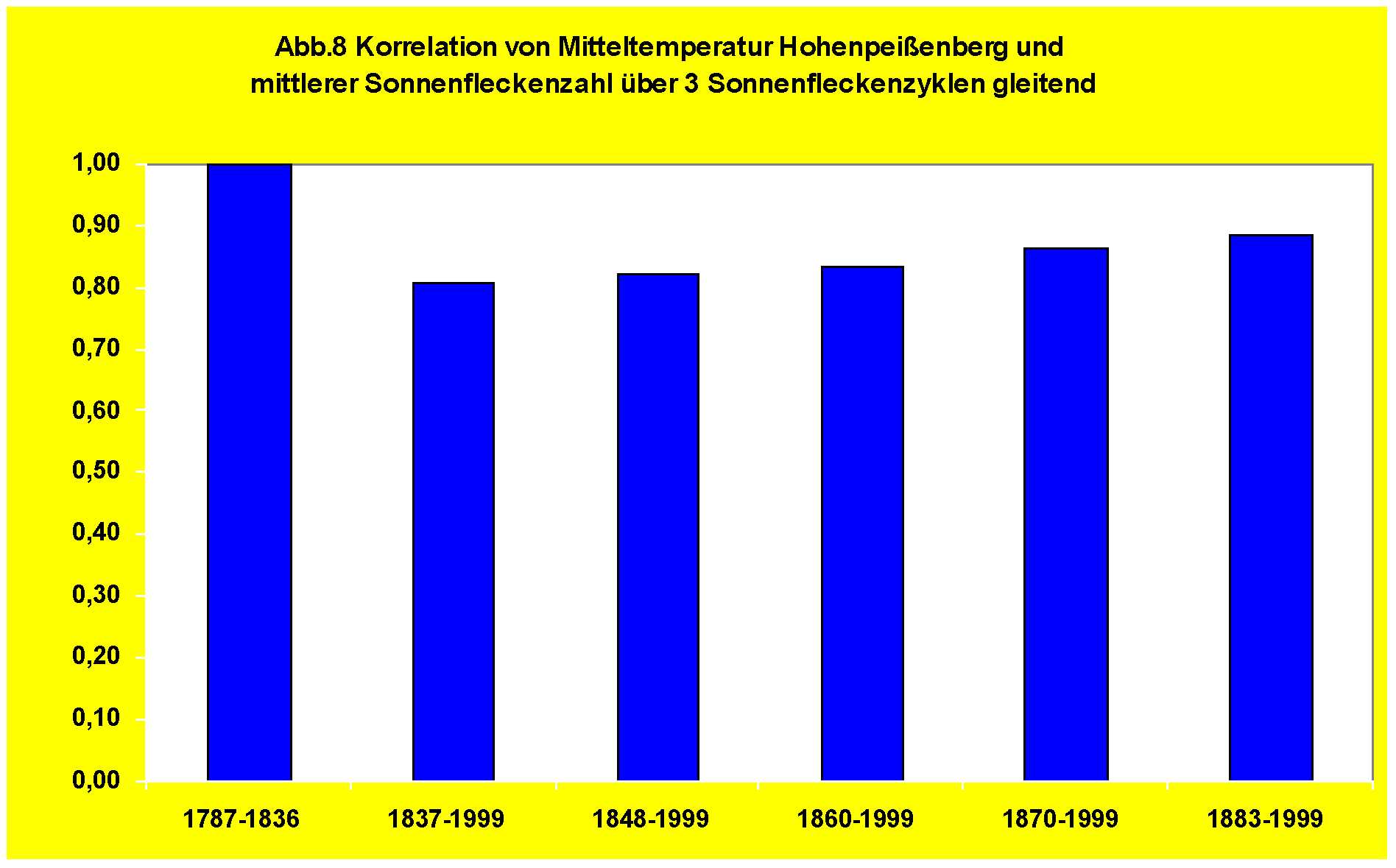

Den engen Zusammenhang zwischen den langfristigen Änderungen der Sonnenaktivität seit 1778 und dem gleichzeitigen langfristigen Temperaturverhalten in Deutschland zeigt die statistische Korrelationsanalyse.

Der rapide Temperatursturz zu Beginn des 19. Jahrhunderts fällt mit einer ebenfalls kurzen, aber deutlichen Abnahme der Sonnenfleckenzahl zusammen (Dalton-Minimum der solaren Aktivität). Entsprechend hoch ist die Korrelation für den Zeitraum 1787-1836. Auch wenn wegen der geringen Zeitspanne der Koeffizient statistisch nicht signifikant ist, so ist der Zusammenhang zwischen solarem Aktivitätseinbruch und Temperatursturz eindeutig.

Für die Temperaturentwicklung in Deutschland seit 1837 berechnen sich Korrelationskoeffizienten mit der Sonnenaktivität -je nach Zeitintervall- zwischen +0,81 und +0,89 (Abb.8). Damit dürfte es keinen Zweifel geben, dass sich der integrale (direkte und indirekte) solare Einfluss auf den langfristigen Klimawandel selbst auf der lokalen Klimaskala von Deutschland eindeutig nachweisen läßt und dass zwischen der jüngsten Erwärmung und der Zunahme der Sonnenaktivität ein hoher kausaler Zusammenhang besteht. Je nach Zeitraum vermag der solare Antrieb 65-80% der Temperaturvarianz, d.h. des Temperaturverhaltens der letzten 220 Jahre zu erklären.

Die regionale Klimaskala (Mitteleuropa)

Die Untersuchung der Klimaentwicklung von Mitteleuropa basiert auf den Klimareihen von Berlin-Dahlem (J.Pelz), Prag sowie den beiden Stationen Basel und Wien (F.Baur). Den drei Dekaden 1671-1700 liegen die auf Mitteleuropa reduzierten Beobachtungen der Zentralenglandreihe (G.Manley) zugrunde. Damit stehen für die langfristige Klimadiagnose geprüfte Beobachtungsdaten für die Zeit seit dem letzten Höhepunkt der Kleinen Eiszeit zur Verfügung. (Nicht einbezogen wurden die Klimabeobachtungen von Hohenpeißenberg, da sonst die lokalen und die regionalen Ergebnisse nicht unabhängig voneinander gewesen wären).

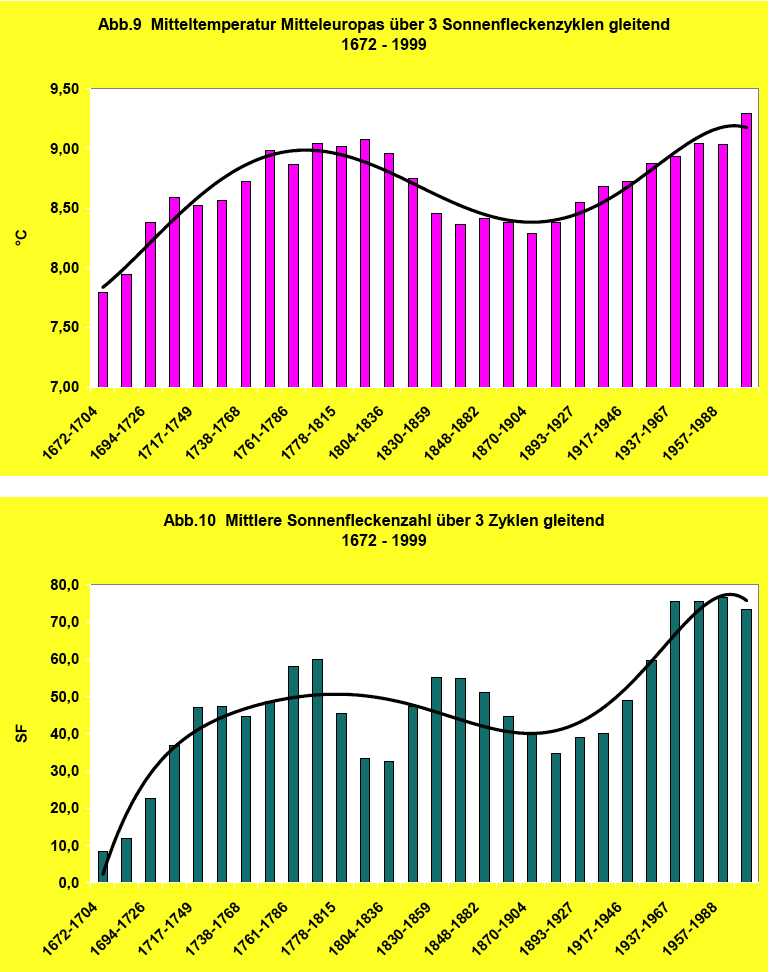

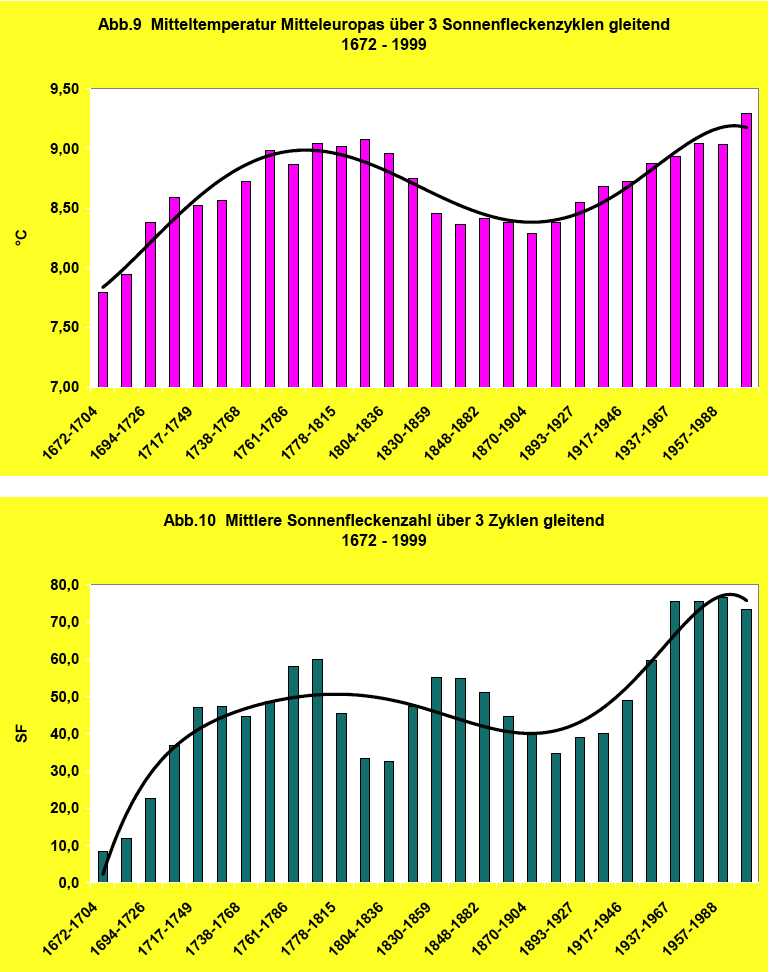

In Abb.9 ist anhand der über 3 Sonnenfleckenzyklen gemittelten Temperaturen die langfristige Klimaent-wicklung von Mitteleuropa wiedergegeben (vgl. Abb.2). Nach der Endphase der Kleinen Eiszeit im 17. Jahrhundert stieg die Temperatur bis zum Wärmeoptimum um 1800 an. Dieser Wärmeperiode folgte die Kälteperiode des 19. Jahrhunderts. Ihr schloss sich die Erwärmung des 20. Jahrhunderts an. Die beiden Kälteperioden waren dabei mit einer maximalen Ausdehnung der Alpengletscher verbunden. Mit Gebeten, mit Bittprozessionen und dem Versprechen, in Zukunft tugendhafter zu leben, hofften die Menschen damals, dass eine höhere Macht einen weiteren Vorstoß der Gletscher verhindern (Der Tagesspiegel, 7.8.2009) und damit der Kälte Einhalt gebieten möge.

Fragt man nach dem dominierenden Klimaantrieb, nach der primären Ursache des wiederholten Wechsels der ausgedehnten Kälte- und Wärmeperioden in den letzten 3 Jahrhunderten, so liefert der Vergleich des Klimawandels seit der Kleinen Eiszeit (Abb.9) mit der Veränderung der Sonnenfleckenzahl (Abb.10) eine schlüssige Antwort. Das synchrone langfristige Verhalten von Temperatur und Sonnenaktivität über die gesamte Zeitspanne ist so eindeutig, dass jeder Zufall ausgeschlossen werden kann.

Der ruhigen Sonne des Maunder-Minimums Ende des 17. Jahrhunderts folgte die Zunahme der Sonnenaktivität im 18.Jahrhundert. Dieser folgte das solare Dalton-Aktivitätsminimum im 19. Jahrhundert und der Anstieg der solaren Aktivität im 20.Jahrhundert auf die höchsten Werte der letzten Jahrhunderte.

Ferner kommt in beiden Zeitreihen deutlich ein periodisches, sinusartiges Schwankungsverhalten zum Ausdruck. Der Vergleich von Abb.9 und Abb.10 zeigt: Sonnenaktivität und Temperaturverlauf weisen beide eine rund 200-jährige Schwingung auf. In der Astrophysik wird diese 200-jährige Schwingung der Sonnenaktivität als De-Vries-Zyklus bezeichnet.

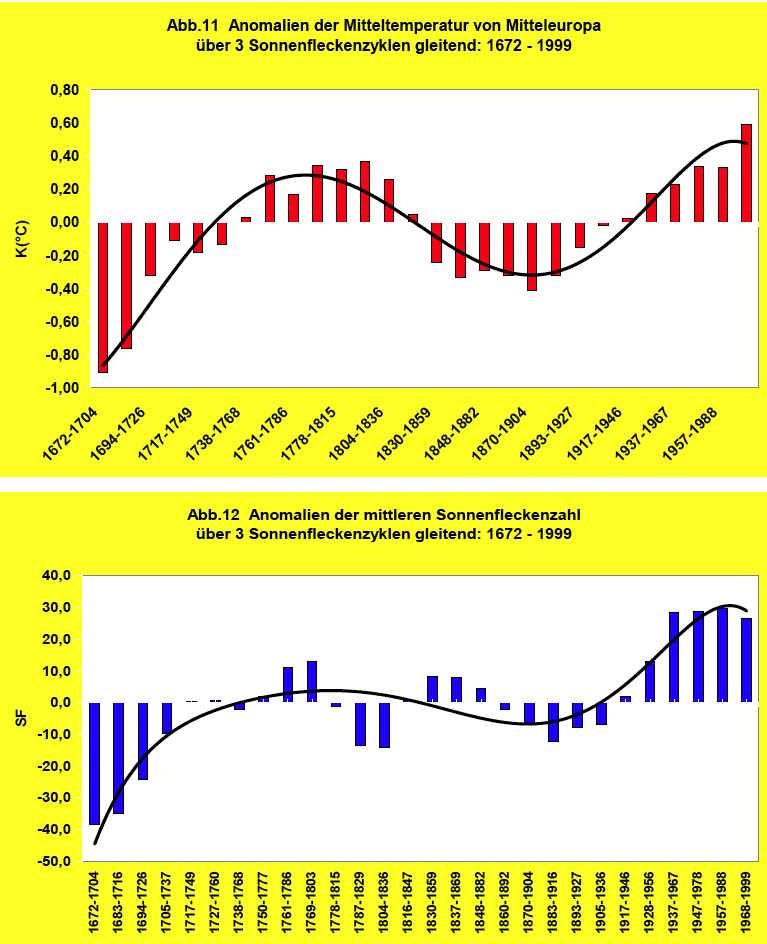

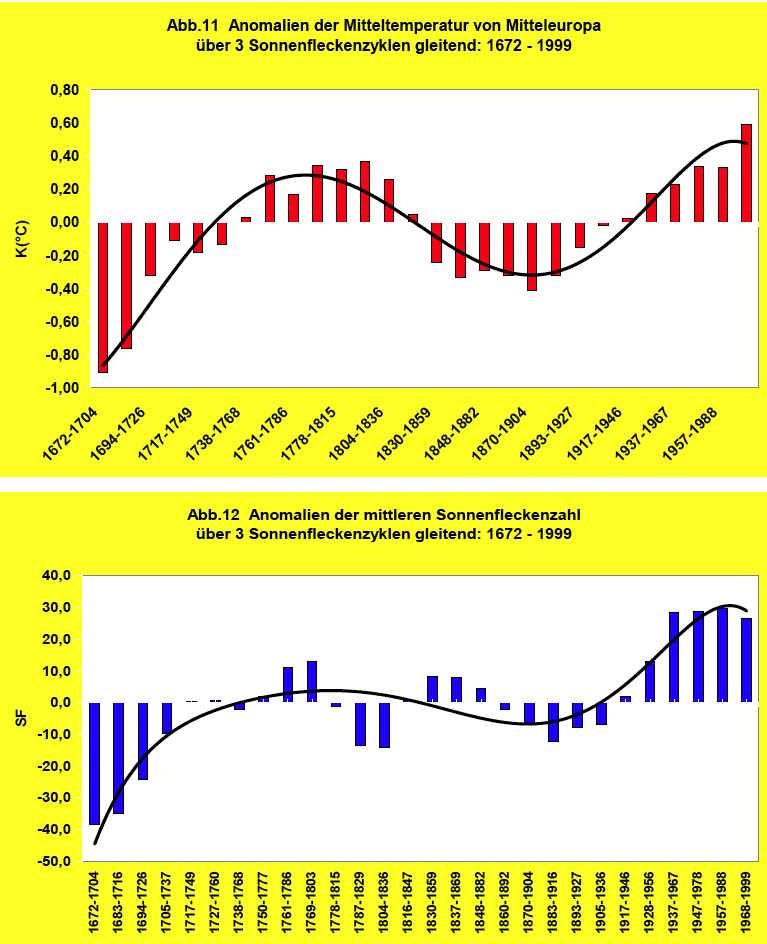

Die hohe Verknüpfung von Klimaentwicklung und Sonnenaktivität seit der Kleinen Eiszeit kommt auch beim Vergleich von Abb.11 und Abb.12 zum Ausdruck. Dort sind die Abweichungen vom Mittelwert der Temperatur bzw. der Sonnenfleckenzahl für die 3 Sonnenfleckenzyklen umfassenden Klimaperioden dargestellt.

Die negativen Anomalien der Temperatur des 17. und des 19. Jahrhunderts sind gekoppelt mit den negativen Anomalien der solaren Aktivität. Den positiven Temperaturabweichungen des 18. und des 20. Jahrhunderts entsprechen die zeitgleichen positiven Abweichungen der solaren Aktivität.

Anders ausgedrückt: Perioden mit übernormaler Sonnenaktivität, entsprechen einer aktiven Sonne und sind mit Wärmeperioden verbunden. In Zeiten mit einer unternormalen Sonnenaktivität, einer ruhigen Sonne, kommt es zu Kälteperioden.

Grundsätzlich lässt sich somit über den Zusammenhang von Sonnenaktivität und Klimaverhalten festhalten: Zeiten mit langfristig zunehmender Sonnenaktivität fallen langfristig mit Erwärmungen zusammen. In Perioden mit einer langfristigen Abnahme der solaren Aktivität kommt es langfristig zur Abkühlung.

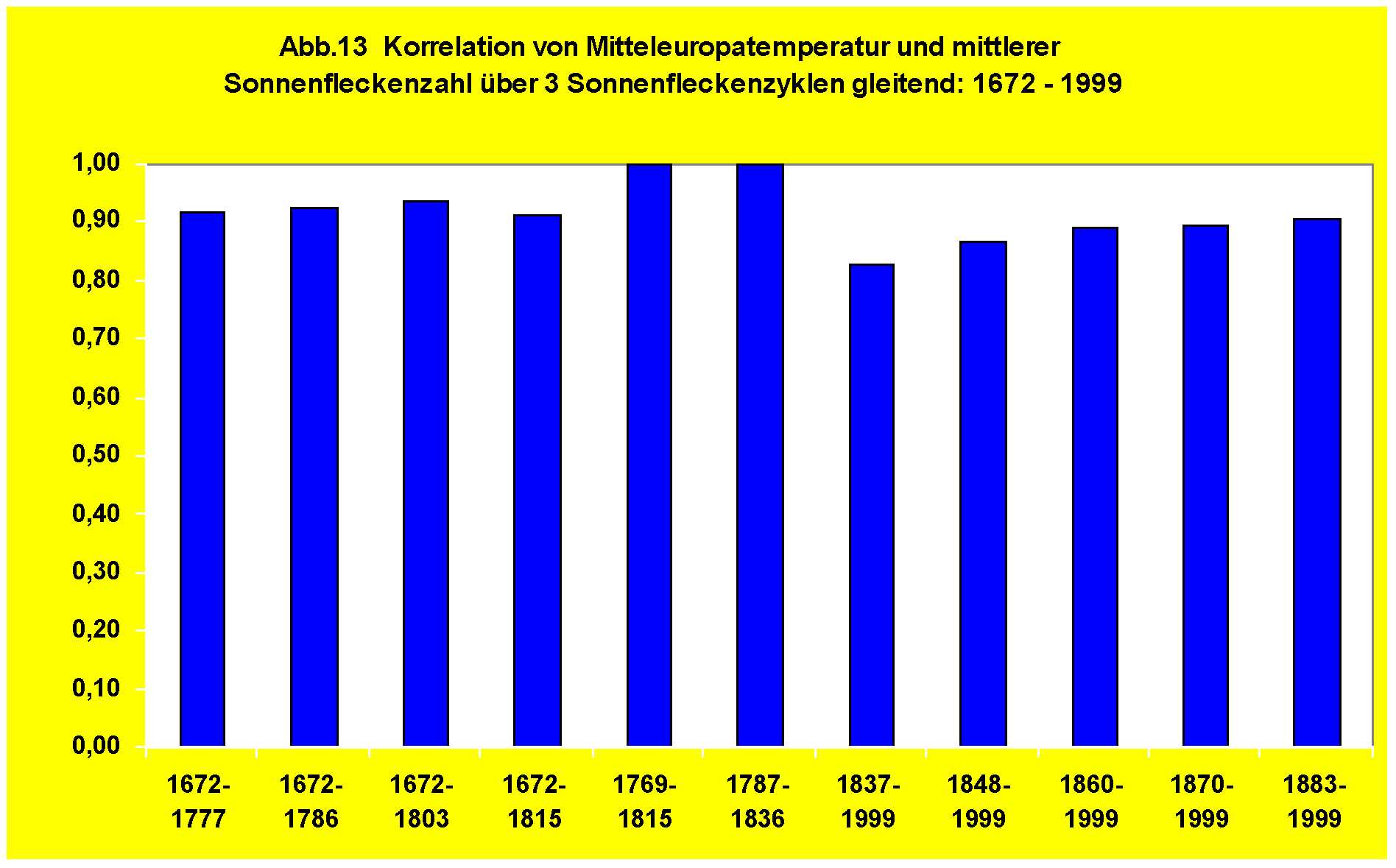

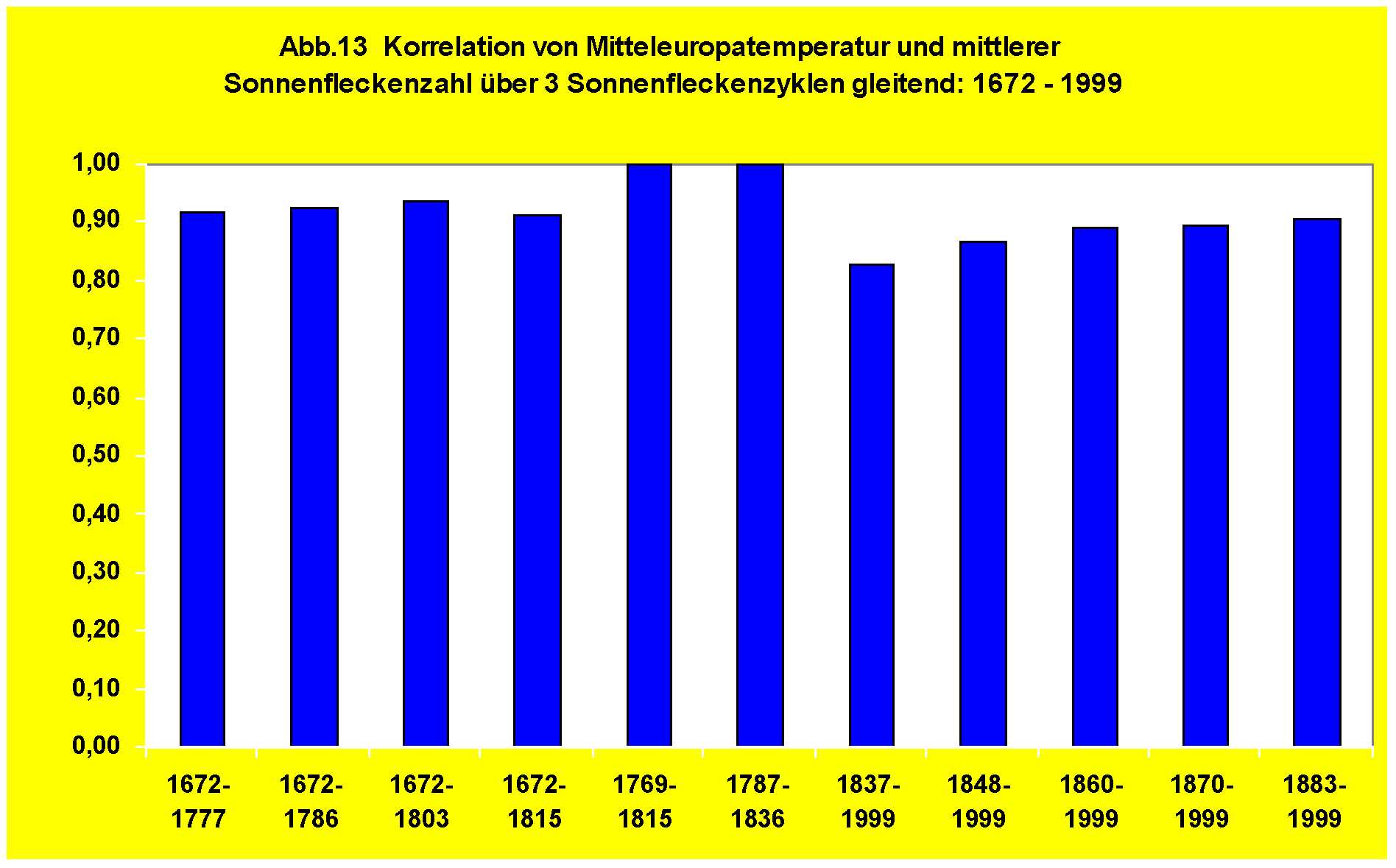

Dieser qualitative Zusammenhang wird durch die Ergebnisse der Korrelationsanalyse in vollem Umfang bestätigt. Korreliert wurden wiederum die über 3 Sonnenfleckenzyklen gleitenden Mitteltemperaturen mit den entsprechenden mittleren Sonnenfleckenzahlen. Die Ergebnisse sind in Abb. 13 dargestellt.

Wie zu erkennen ist, berechnen sich für den Zusammenhang zwischen dem langfristigen Verhalten der solaren Aktivität und dem langfristigen Temperaturanstieg nach der Kleinen Eiszeit bis zum Ende des 18.Jahrhunderts Korrelationskoeffizienten von +0,90 bis +0,94. Analoges gilt für die kurze, intensive Ab-kühlungsphase zu Beginn des 19. Jahrhunderts. Für die heute diskutierte Erwärmung von der Mitte des 19. Jahrhunderts bis zum Ende des 20.Jahrhunderts ergeben sich Korrelationskoeffizienten mit der Sonnenaktivität von +0,83 bis +0,87 und für die Periode vom Ende des 19. Jahrhunderts bis 1999 von +0,90 bis +0,92. Bedenkt man, dass ein Korrelationskoeffizient (per Definition) maximal den Wert 1,0 annehmen kann, so ist der dominierende solare Einfluss auf den langfristigen Klimawandel nicht länger weg zu diskutieren.

Zusammenfassende Schlussbetrachtungen

In dieser klimadiagnostischen Untersuchung wurde der Klimawandel der letzten Jahrhunderte auf drei räumlichen Klimaskalen analysiert: auf der globalen, der lokalen und der regionalen Klimaskala. Damit verbunden sind drei zeitliche Klimaskalen.

Die globale/ hemisphärische Untersuchung basiert auf den CRU-Klimareihen (Hadley-Center,UK) seit 1850. Der lokalen Klimaskala liegen die homogenen Klimabeobachtungen von Hohenpeißenberg seit 1780 zugrunde. Die regionale Klimaskala wird durch die „Klimareihe Mitteleuropa“ erfasst. Sie reicht bis 1671 zurück und damit bis zum letzten Höhepunkt der Kleinen Eiszeit.

Als erster Sachverhalt ist festzustellen: Die globale IPCC- Klimareihe ist mit rund 150 Jahren die kürzeste. Sie erfasst nur ein sehr begrenztes Zeitfenster und ihre Erwärmung ist ohne Bezug zur Klimavorgeschichte.

Der zweite wichtige Tatbestand ist: Die globale Klimareihe beginnt, wie die Klimareihe Mitteleuropa beweist, zu einer Zeit mit den lebensfeindlichsten Klimaverhältnissen nach der Kleinen Eiszeit. In der Mitte des 19. Jahrhunderts waren die Klimabedingungen so ungünstig, dass als Folge der Kälteperiode in Mitteleuropa Missernten und Hungersnöte auftraten und Menschen verhungert sind. Wer diese lebensfeindliche Klimaepoche für Mensch und Natur zum Referenz-/Normalklima erklärt, indem er die aktuelle Erwärmung dramatisiert und als Klimakatastrophe darstellt, der stellt die Klimarealität auf den Kopf und schürt bewußt eine Klimahysterie. Man fragt sich unwillkürlich: cui bono?

Wie die gegenwärtigen Klimabedingungen auf der langfristigen Klimaskala wirklich einzuordnen sind, wird durch die lokale Klimareihe von Hohenpeißenberg und die Klimareihe Mitteleuropa dokumentiert:

In den letzten Jahrhunderten kam es zu einem wiederholten Wechsel von anhaltenden Kälte- und Wärmeperioden. Dem letzten Höhepunkt der Kleinen Eiszeit im 17. Jahrhundert folgte eine Erwärmung im 18. Jahrhundert. Ihr folgte nach einem rapiden Temperaturrückgang die Kälteperiode des 19. Jahrhunderts und dann die Wärmeperiode im 20. Jahrhundert.

Der Einwand, Mitteleuropa sei für das globale Klimaverhalten nicht repräsentativ, ist auf der langfristigen Klimaskala unrichtig. Dass die Klimaentwicklung der letzten Jahrhunderte in Mitteleuropa den globalen Klimaverlauf auch vor 1850 grundsätzlich widerspiegelt, lässt sich aus der extrem hohen Korrelation von +0,95 (1851-2000) bis +0,97 (1881-2000) ableiten, die sich für die 30-jährig gleitenden Klimaperioden zwischen globalem und mitteleuropäischem Klimaverhalten ergibt. Dieser Zusammenhang ist auf dem 99,9%-Niveau hochsignifikant.

Vor diesem Hintergrund stellt die globale Erwärmung nach 1850 lediglich den aufsteigenden Ast einer langperiodischen Klimaschwingung dar.

Die Antwort auf die Frage nach dem dominierenden Klimaantrieb auf der globalen, lokalen und regionalen Klimaskala folgt aus der Analyse des langfristigen Klimaverhaltens einerseits und den langfristigen Veränderungen der solaren Aktivität anderseits.

Klimafluktuationen, also kurzperiodisch wirkende Antriebe (z.B. El Nino/La Nina, Vulkanausbrüche), sind auf der langfristigen Klimaskala grundsätzlich unerheblich. Diese stellen klimatische Oberschwingungen dar, die dem langfristigen Klimaverlauf nur überlagert sind.

Der nachhaltige Prozess, dem sich Mensch und Natur anpassen müssen, ist die langfristige Klimaänderung.

Entsprechend der klimatologischen Konvention, Klimafluktuationen durch die Bildung 30-jähriger Mittelwerte zu eliminieren, wurde die Klimadiagnose über den Zusammenhang von solarem Antrieb und Klimaverhalten mittels Klimaperioden von 3 Sonnenfleckenzyklen (im Mittel 33 Jahre) durchgeführt.

Auf diese Weise wird es möglich, das langfristige Klimaverhalten und die primäre Ursache deutlicher zu erkennen als dieses unter Einbezug der vielfältigen kurzfristigen Variabilität möglich ist.

Auf der globalen Klimaskala berechnen sich für den Zusammenhang von solarer Aktivität und globaler/ hemisphärischer Temperatur im Zeitraum 1860-1999 stabile Korrelationskoeffizienten von +0,90. Das Ergebnis ist auf dem 99,9%-Niveau hochsignifikant.

Auf der lokalen Klimaskala (Deutschland) folgen für den Zusammenhang zwischen Temperaturverlauf Hohenpeißenberg und solarer Aktivität im Zeitraum 1860-1999 statistisch hochsignifikante Korrelationskoeffi-zienten von +0,83 bis +0,89. Für die vorhergehende kurze, intensive Abkühlungsphase liegt die Korrelation mit der Sonnenaktivität über +0,90.

Auf der regionalen Klimaskala von Mitteleuropa ist die enge Kopplung zwischen den langfristigen Änderungen der solaren Aktivität und dem Klimaverhalten seit der Kleinen Eiszeit, d.h. für über 300 Jahre nachweisbar. Für die Erwärmungsperiode unmittelbar nach der Kleinen Eiszeit berechnen sich Korrelationskoeffizienten von +0,90 bis +0,94. Ebenso hohe Werte ergeben sich für die kurze, rapide Abkühlung zur Zeit des Dalton-Minimums der solaren Aktivität. Die jüngste Erwärmung Mitteleuropas weist ab 1848 je nach Zeitintervall Korrelationskoeffizienten von +0,87 bis +0,92 mit den Änderungen der solaren Aktivität auf. Auch diese Werte sind auf dem 99,9%-Niveau statistisch abgesichert.

Fazit: Der dominierende Einfluss der solaren Aktivität auf das langfristige Klimaverhalten ist auf der globalen und hemisphärischen sowie auf der lokalen und regionalen Klimaskala eindeutig nachzuweisen. Langfristige Änderungen des solaren Energieflusses führen im Klimasystem zu direkten und indirekten Reaktionen. Direkt sind die breitenkreisabhängigen Temperaturänderungen gemäß dem jeweiligen Einfallswinkel der Sonnenstrahlung. Dabei kommt naturgemäß in den Tropen und den wolkenarmen Subtropen den Einstrahlungsänderungen das stärkste klimatische Gewicht zu, denn 50% der Erdoberfläche liegen in dieser strahlungsintensivsten Zone zwischen 30°N-30°S. Dort findet folglich auch im System Erde/Ozean-Atmosphäre die stärkste thermische Energieumsetzung statt.

Über die damit verbundenen Veränderungen der Hadley-/Passat-Zirkulation kommt es zu komplexen Auswirkungen auf die gesamte planetarische Zirkulation, d.h. auf die atmosphärischen und ozeanischen Wärme-transporte.

Indirekt sind jene Auswirkungen, die durch photochemische Prozesse (Ozonschicht) und durch Rückkopplungseffekte, z.B. durch großräumige Veränderungen der Wolken- und Schnee-/Eisbedeckung hervorgerufen werden.

Es liegt in der Natur statistisch-klimadiagnostischer Analysen, dass sie die physikalischen Einzelprozesse nicht aufzulösen vermögen. Die vorgestellten Ergebnisse stellen das Integral über alle durch die solaren Antriebsänderungen verursachten Auswirkungen auf das Temperaturverhalten dar. Der Zusammenhang zwischen Klima-/ Temperaturentwicklung in den letzten Jahrhunderten und den Änderungen des solaren Antriebs in dieser Zeit sind statistisch auf dem 99,9%-Niveau abgesichert.

Wie die früheren Untersuchungen gezeigt haben, ergeben sich unter Einbezug auch der kurzperiodischen natürlichen Klimaantriebe für den solaren Antriebsanteil Korrelationen von +0,75 bis +0,80. Das entspricht einer erklärten Varianz durch den solaren Effekt bis zu 65%. Betrachtet man allein die relevanten langfristigen Klimaänderungen, indem die kurzfristigen Klimaschwankungen herausgefiltert werden, so folgt: Für den Zusammenhang zwischen langzeitlichem solarem Aktivitätsverhalten und langfristiger Klimaentwicklung berechnen sich Korrelationskoeffizienten von +0,90. Der integrale solare Anteil erklärt somit rund 80% der langzeitlichen Klima-/Temperaturänderungen. Die statistische Irrtumswahrscheinlichkeit liegt nur bei 0,01 Prozent.

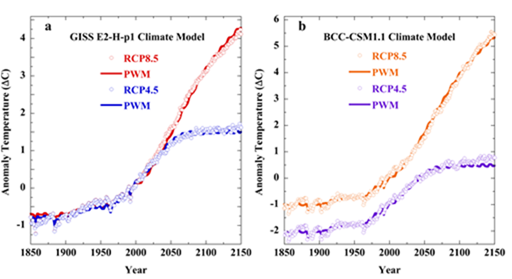

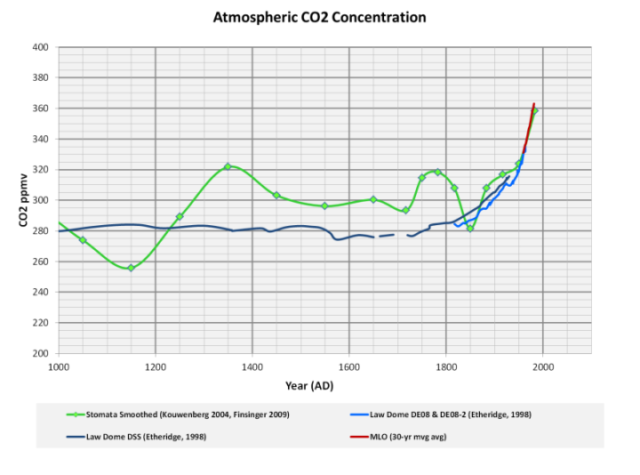

Daraus folgt: Die in den bisherigen Klimamodellen dem solaren Effekt zugewiesene Statistenrolle widerspricht der Klimarealität. Dem solaren Einfluss kommt die dominierende Rolle beim langfristigen Klimawandel zu. Der anthropogene Treibhaus-/CO2-Einfluss auf die langfristige Klimaentwicklung wird weit überschätzt. Sein Beitrag vermag nach den obigen Ergebnissen maximal 20% des langfristigen Temperaturverhaltens zu erklären. Abkühlungsphasen, ob kurz- oder langfristig, kann der anthropogene Treibhauseffekt dabei physikalisch überhaupt nicht erklären. Als jüngste Beispiele seien der Temperaturrückgang der letzten 10 Jahre und die Abkühlung in den 1960er/70er Jahren genannt.

Es ist ein Rätsel, wie die Politik auf der Grundlage einer der Klimavergangenheit widersprechenden und wissenschaftlich nicht konsensfähigen Arbeitshypothese über den anthropogenen CO2-Einfluss „Klimabeschlüsse“ mit weitreichenden Konsequenzen begründen kann. Alle Szenarienrechnungen, ob bei Banken, in der Wirtschaft oder in der Klimaforschung, sind im Konjunktiv und daher unter Vorbehalt zu verstehen. Sie basieren auf vielfältigen Annahmen und führen in eine Vertrauenskrise, wenn sie als fundierte Prognosen missinterpretiert werden. Wenn die klimatische Zukunft der klimatischen Herkunft so offensichtlich widerspricht, ist über kurz oder lang mit einem Platzen der anthropogenen „Klimablase“ und mit mehr realistischen Klimamodellen zu rechnen.

Statt einer auf tönernen Füßen stehenden Klimapolitik wäre es angebracht, alle Anstrengungen auf eine ehrgeizige globale Umweltpolitik zu konzentrieren. Saubere Luft, saubere Flüsse, Seen und Ozeane, ein unbelasteter Erdboden gehören zu den fundamentalen Rechten aller Menschen. So ist z.B. das Abschmelzen hochgelegener Gletscher eine Folge fehlenden Umweltschutzes in der Vergangenheit und nicht des Klimawandels. Eine Erwärmung von 1°C vermag physikalisch bei Gletschertemperaturen weit unter 0°C nichts zu bewirken. Ein mit Russ und Staub verunreinigter Gletscher verliert dagegen sein natürliches Reflexionsvermögen und absorbiert verstärkt Sonnenlicht und damit Wärmestrahlung. Die Folge: Der Gletscher „schwitzt in der Sonne“, er schmilzt. Die im Schatten liegenden Gletscherregionen schmelzen hingegen nicht.

Die Klimazukunft

„Prognosen sind immer schwierig, vor allem wenn sie die Zukunft betreffen“, soll der berühmte Atomphysiker Nils Bohr einmal gesagt haben. Dies gilt auch für das Verhalten der Sonne. Die rund 200-jährige Schwingung der solaren Aktivität ist jedoch ein astrophysikalisches Faktum. Neben dem beschriebenen Maunder- und Dalton-Minimum im 17. bzw. 19. Jahrhundert wird der rund 200-jährige De-Vries-Zyklus auch durch das Spoerer- Minimum im 15. Jahrhundert belegt. Die damit verbundene rund 200-jährige Klimaschwankung ist ebenfalls ein Faktum. Alle drei solaren Aktivitätsminima waren mit Kälteperioden verbunden. Im 15. Jahrhundert war zeitweise die Ostsee vollständig zugefroren. Im 17. Jahrhundert lag der letzte Höhepunkt der Kleinen Eiszeit, der 200 Jahre später die Kälteperiode des 19. Jahrhunderts folgte. Die Phasen hoher Sonnenaktivität korrespondieren dagegen jeweils mit den Erwärmungen im 16., 18. und 20. Jahrhundert.

Gemäß dieser rund 200-jährigen Schwingung befinden wir uns mit hoher Wahrscheinlichkeit derzeit am Ende einer Wärmeperiode und damit am Beginn einer Abkühlung als Folge eines zu erwartenden solaren Aktivitätsrückgangs. Zu diesem Ergebnis kommen auch das SSRC (Space Science Research Center) in Orlando/USA und – nach einem Bericht der russischen Zeitung „Novosti“ (Juni 2008) – das russische Hauptobservatorium Pulkov bei Sankt Petersburg.

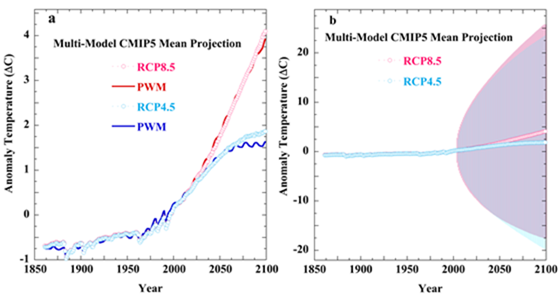

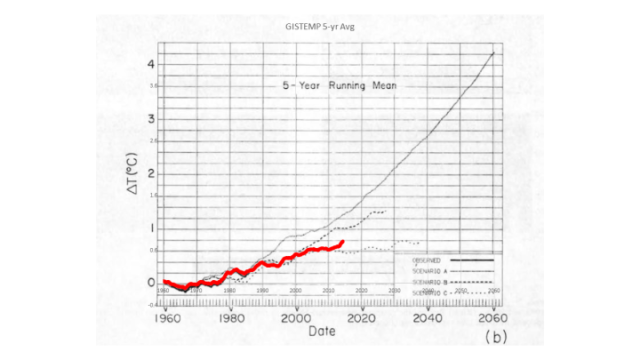

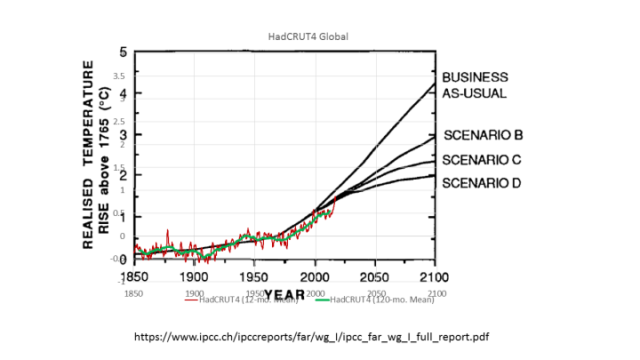

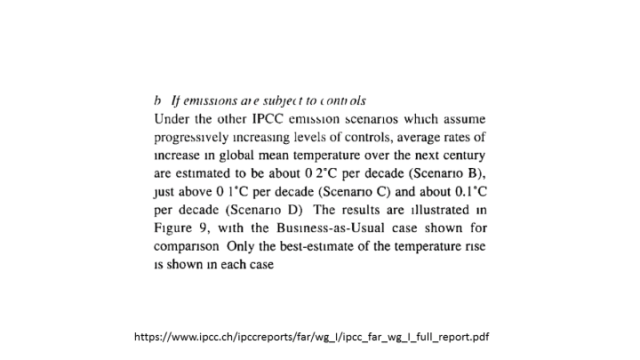

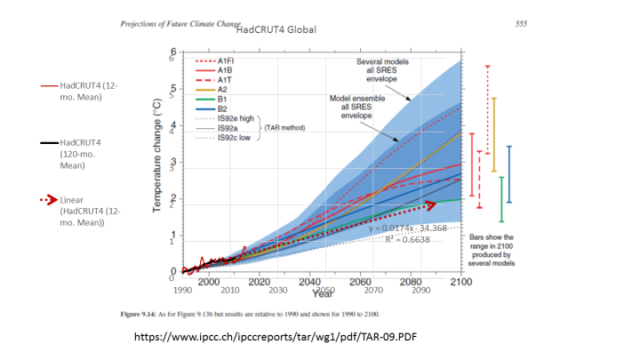

Die von den bisherigen Klimamodellen aufgrund des CO2-Effekts für das 21. Jahrhundert vorhergesagte fortschreitende Erwärmung ist aufgrund der klimadiagnostischen Ergebnisse daher höchst unwahrscheinlich.

P.S.1 Australische Wissenschaftler (R.M.Carter et al.) sind ebenfalls zu Ergebnissen über den hohen El Nino-Einfluss bei der globalen Erwärmung der letzten Jahrzehnte gekommen (J.Geophys.Res., 2009), wie sie in den Beiträgen zur BWK SO 34/07 und SO 11/09 dargelegt worden sind.

P.S.2 Es ist soeben erstmals gelungen, mit einem Klimamodell (NCAR/USA) nachzuweisen, dass schon geringe solare Aktivitätsänderungen klimatisch messbare Auswirkungen verursachen: Meehl, G.A.,J..M. Arblaster, K. Matthes, F. Sassi, and H. van Loon (2009), Amplifying the Pacific climate system response to a small 11 year solar cycle forcing, Science, 325, 1114-1118.

P:S.3 Die Sonne ist weiterhin nahezu frei von Sonnenflecken, und die Eisbedeckung in der Arktis liegt in diesem Sommer über der der beiden Vorjahre.

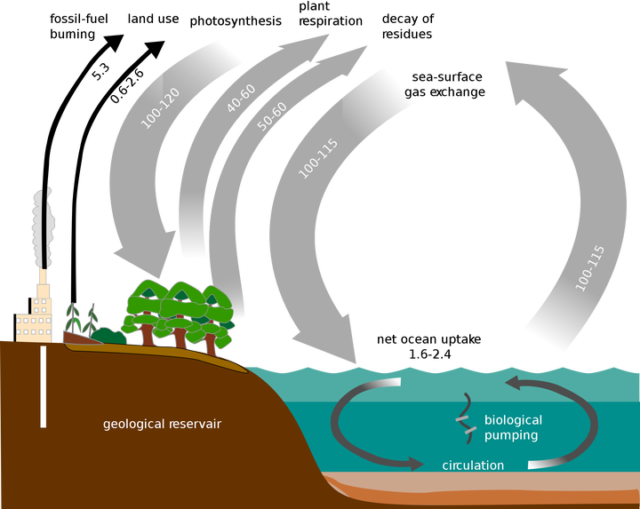

P.S.4 Kohlendioxid wird zu Unrecht als „Klimakiller“ und „Umweltverschmutzer“ verteufelt. Außer Wasser gibt es für das irdische Leben im allgemeinen und die Welternährung im speziellen kei-nen Stoff , der wichtiger ist als das Spurengas CO2 (0,038 Vol.%). Aus H2O und CO2 bauen Pflan-zen (Photosynthese) unter Produktion des lebenswichtigen Sauerstoffs O2 ihre Zellsubstanz auf, d.h. die gesamte Nahrungsgrundlage für Mensch und Tier.., J.M. Arblaster, K. Matthes, F.

Literatur

– Brohan, P., J.J. Kennedy, I. Haris, S.F.B. Tett and P.D. Jones: Uncertainty estimates in regional and global observed tem-perature changes: a new dataset from 1850. J. Geophysical Research

111, D12106, doi:10.1029/2005JD006548 — pdf

– BMBF „Herausforderung Klimawandel“. 2004: http://www.bmbf.de/pub/klimawandel.pdf

– Claußnitzer, A. Das Maunder-Minimum. Eine Modellstudie mit dem „Freie Universität Berlin Climate

Middle Atmosphere Model“ (FUB-CMAM). Diplomarbeit. 2003

– Cubasch, U. Variabilität der Sonne und Klimaschwankungen. Max-Planck-Forschung. Das Wissen-

schaftsmgazin der Max-Planck-Gesellschaft (2001)

– Eddy, J.A. „The Maunder Minimum“. Science 192. 1976

– EIKE: www.eike-klima-energie.eu

– Hennig, R. Katalog bemerkenswerter Witterungsereignisse –von den alten Zeiten bis zum Jahre 1800.

Abh. Kgl. Preuß. Met.Inst.Bd.II/4 .1904

– Hoyt, D. V. und Schatten, K. H.: The role of the sun in climate change. New York-Oxford, Oxford Univer-

sity Press. 1997

– Jones, P.D., New, M., Parker, D.E., Martin, S. and Rigor, I.G., 1999: Surface air temperature and its varia-

tions over the last 150 years. Reviews of Geophysics 37, 173-199.

– Labitzke,K. and H. van Loon: The signal of the 11-years sunspot cycle in the upper troposphere-lower

Stratosphere. 1997

– Labitzke, K. On the solar cycle – QBO – relationship. J.A.A., special issue 67, 45-54. 2005

– Landscheidt, T. Solar oscillations, sunspot cycles, and climatic change. In: McCormac, B. M., Hsg.:

Weather and climate responses to solar variations. Boulder, Ass. Univ. Press (1983)

– Malberg,H. und G. Bökens: Änderungen im im Druck-/Geopotential- und Temperaturgefäl le zwischen Subtropen und Sub-polarregion im atlantischen Bereich im Zeit

raum 1960-90. Z.f.Meteor. N.F. (1993)

– Malberg, H. Beiträge des Instituts für Meteorologie der Freien Universität Berlin/Berliner Wetterkarte: .

– Über den Klimawandel in Mitteleuropa seit 1850 und sein Zusammenhang mit der Sonnenaktivität. SO 17/02

– Die globale Erwärmung seit 1860 und ihr Zusammenhang mit der Sonnenaktivität. SO 27/02

– Die nord- und südhemisphärische Erwärmung seit 1860 und ihr Zusammenhang mit der Sonnenaktivität. SO 10/03

– Der solare Einfluss auf das mitteleuropäische und globale Klima seit 1778 bzw. 1850. SO 01/07 (2007) –

In Memoriam Prof. Richard Scherhag.

– Über den dominierenden solaren Einfluss auf den Klimawandel seit 1701. SO 27/07

– El Nino, Vulkane und die globale Erwärmung seit 1980. SO 34/07

– El Niño und der CO2-Anstieg sowie die globale Erwärmung bei C11/09O2-Verdopplung. SO 02/08

– Die unruhige Sonne und der Klimawandel. SO 20/08

– Über die kritische Grenze zwischen unruhiger und ruhiger Sonne und ihre Bedeutung für den Klimawandel. SO 03/09

– La Nina – El Nino und der solare Einfluss – Der Klimawandel 1950-2008. SO 11/09

– Über das Stadtklima und den Klimawandel in Deutschland seit 1780. SO 18/09

– Malberg, H. Klimawandel und Klimadiskussion unter der Lupe. Z. f. Nachhaltigkeit 5. 2007

– Malberg, H. Klimawandel und Klimadebatte auf dem Prüfstand. Verh. Ges.Erdkunde zu Berlin. 2007

– Matthes, K., Y. Kuroda, K. Kodera, U. Langematz: Transfer of the solar signal from the stratosphere to the troposphere: Northern winter. J. Geophys. Res., 111.2005

– Matthes, K., U. Langematz, L. L. Gray, K. Kodera Improved 11- year solar signal in the Freie Universität

– Berlin climate middle atmosphere model. J. Geophys. Res., 109. 2003

– Negendank, J.W. Gehen wir einer neuen Kaltzeit entgegen? Klimaänderungen und Klimaschutz.TU-Cottbus.2007

– Pelz, J. Die Berliner Jahresmitteltemperaturen von 1701 bis 1996, Beilage Berl. Wetterkarte, 06/1997

– Scafetta; N. and B.J. West: Is Climate Sensitive to Solar Variability. Physics today. (2008)

– Scherhag, R. Die gegenwärtige Abkühlung der Arktis. Beilage Berliner Wetterkarte SO31/1970

– Svensmark, H. Cosmic rays and earth‘s climate. Space Science Rev. 93 (2000)

– Svensmark, H. Cosmic Climatlogy – A new theory emerges. A&G, Vol. 48 (2007)

– Svensmark, H., Friis-Christensen, E. Reply to Lockwood and Fröhlich – The persistent role of the Sun in Climate forcing. Danish Nat.Space Center. Scientific Report 3/07 (2007)

– Wehry, W. Einige Anmerkungen zu meteorologischen Messungen und Datenreihen. Beiträge BWK SO 22/09

Daten: Den Temperaturdaten von Basel und Wien liegen die Klimareihen von F. Baur zugrunde, die im Rahmen der „Berliner Wetterkarte“ fortgeführt wurden.

Die Temperaturdaten von Prag wurden der Internet-Veröffentlichung www.wetterzentrale .de/Klima/ entnommen, erweitert durch Werte, die von der Station Prag direkt zur Verfügung gestellt wurden.

Die Temperaturreihe von Berlin entspricht der von J.Pelz auf Berlin-Dahlem redzierten Werten ab 1701.

Die globalen Temperaturreihen basieren auf den Werten des Climatic Research Unit, UK. (www.cru.uea.ac.uk/cru/data)

Die Sonnenfleckenzahlen entstammen den Veröffentlichung von NOAA

(ftp:/ftp.ngdc.noaa.gov/STP/SOLAR_Data/Sunspot¬_Numbers/Monthly/)

Die Sonnefleckenzahlen vor 1749 wurden aus verschiedenen Quellen ermittelt.

Horst Malberg, Univ.-Prof. (a.D.) für Meteorologie und Klimatologie; EIKE Beiratsmitglied

Datei hier: Langfristiger Klimawandel auf der globalen, lokalen und regionalen Klimaskala und seine primäre Ursache: Zukunft braucht Herkunft

Herausgegeben vom Verein BERLINER WETTERKARTE e.V. zur Förderung der meteorologischen Wissenschaft 60/09 http://www.Berliner-Wetterkarte.de ISSN 0177-3984

Related Files