Die Klimaschau von Sebastian Lüning: Wie ein Klimaforscher die Sonne klein redet, Hoffen auf die Kernfusion

Ich erwähne das alles, um Sie wissen zu lassen, dass ich weit, weit davon entfernt bin, ein Anfänger oder gar ein Programmierer-Geselle zu sein. Ich habe z. B. mit „computerbasierter Evolution“ gearbeitet, um zu versuchen, den Aktienmarkt zu analysieren, bevor die meisten Leute überhaupt davon gehört haben. …

Nun, wer meine Arbeiten gelesen hat weiß, dass ich weit davon entfernt bin, Computer-Klimamodelle zu lieben. Ich wurde gefragt: „Was haben Sie gegen Computermodelle?“ und „Wie können Sie den Modellen nicht vertrauen, wir benutzen sie doch für alles?“

Nun, basierend auf einer lebenslangen Erfahrung auf diesem Gebiet kann ich Ihnen ein paar Dinge über Computerklimamodelle und Computermodelle im Allgemeinen versichern. Hier ist die Kurzfassung:

● Ein Computermodell ist nichts anderes als eine physikalische Umsetzung der Überzeugungen, Vorstellungen, falschen Ideen und Missverständnisse desjenigen, der das Modell geschrieben hat. Daher werden die Ergebnisse, die es produziert, die Überzeugungen, Auffassungen, falschen Ideen und Missverständnisse des Programmierers unterstützen, bestätigen und verkörpern. Alles, was der Computer tut, ist, diese Überzeugungen und Missverständnisse offiziell und vernünftig aussehen zu lassen. Oh, und er macht sehr, sehr schnell Fehler. Ich habe das schon erlebt.

● Computer-Klimamodelle gehören zu einer bestimmten Klasse von Modellen, die „iterative“ Computermodelle genannt werden. In dieser Klasse von Modellen wird die Ausgabe eines Zeitschrittes als Eingabe für den nächsten Zeitschritt in den Computer zurückgespeist. Mitglieder dieser Klasse von Modellen sind notorisch launisch, instabil und neigen zu internen Oszillationen und allgemein zum Herunterfallen. Normalerweise müssen sie in gewisser Weise künstlich „eingezäunt“ werden, damit sie nicht außer Kontrolle geraten.

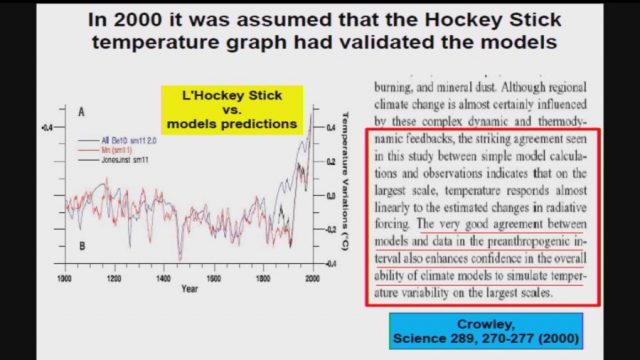

● Wie jeder bestätigen kann, der schon einmal versucht hat, z. B. den Aktienmarkt zu modellieren, kann ein Modell, das die Vergangenheit absolut fehlerfrei reproduzieren kann, in der Tat sehr wahrscheinlich völlig falsche Vorhersagen für die Zukunft liefern wird. Ich habe das auch schon erlebt. Wie es in der Brokerwerbung in den USA heißen muss: „Vergangene Performance ist keine Garantie für zukünftigen Erfolg“.

● Das bedeutet, dass die Tatsache, dass ein Klimamodell das vergangene Klima perfekt nachzeichnen kann, NICHT bedeutet, dass es eine genaue Darstellung der Realität ist. Und vor allem bedeutet es NICHT, dass es die Zukunft genau vorhersagen kann.

● Chaotische Systeme wie Wetter und Klima sind notorisch schwer zu modellieren, selbst auf kurze Sicht. Das ist der Grund, warum Vorhersagen über den zukünftigen Weg eines Wirbelsturms in den nächsten 48 Stunden die Form eines Kegels und nicht einer geraden Linie haben.

● Es gibt einen ganzen Zweig der Informatik namens „V&V“, was für Validierung und Verifizierung steht. So können Sie sicher sein, dass Ihre Software der Aufgabe gewachsen ist, für die sie entwickelt wurde. Hier ist eine Beschreibung aus dem Internet:

Was ist Software-Verifizierung und -Validierung (V&V)?

Verifizierung

820.3(a) Verifikation ist die Bestätigung durch Prüfung und Erbringung eines objektiven Nachweises, dass festgelegte Anforderungen erfüllt wurden.

„Dokumentierte Verfahren, die in der Benutzerumgebung durchgeführt werden, um die Ergebnisse zu erhalten, aufzuzeichnen und zu interpretieren, die erforderlich sind, um festzustellen, dass die vorgegebenen Spezifikationen erfüllt wurden“ (AAMI).

Validierung

820.3(z) Validierung bedeutet die Bestätigung durch Untersuchung und Erbringung eines objektiven Nachweises, dass die besonderen Anforderungen für einen bestimmten Verwendungszweck konsistent erfüllt werden können.

Prozessvalidierung bedeutet die Feststellung durch objektive Beweise, dass ein Prozess konsistent ein Ergebnis oder ein Produkt erzeugt, das seinen vorgegebenen Spezifikationen entspricht.

Designvalidierung ist der objektive Nachweis, dass die Produktspezifikationen mit den Bedürfnissen des Anwenders und der vorgesehenen Verwendung(en) übereinstimmen.

„Dokumentiertes Verfahren zur Erlangung, Aufzeichnung und Interpretation der Ergebnisse, die erforderlich sind, um festzustellen, dass ein Prozess konsistent ein Produkt hervorbringt, das den vorgegebenen Spezifikationen entspricht“ (AAMI).

Weitere Informationen zu V&V hier.

● Ihre durchschnittliche Fahrstuhl-Steuerungssoftware wurde mehr V&V unterzogen als die Computerklimamodelle. Und wenn die Software eines Computermodells nicht einer umfangreichen und strengen V&V unterzogen wurde, ist die Tatsache, dass das Modell sagt, dass etwas in der Modellwelt passiert, KEIN Beweis dafür, dass es in der realen Welt tatsächlich passiert … und selbst dann, wie man sagt, „Mist auftritt“. Wir haben eine Marssonde verloren, weil jemand eine einzige Zahl nicht von imperialen Maßen in metrische umgerechnet hat … und Sie können darauf wetten, dass die NASA ihre Programme einer umfangreichen und strengen V&V unterzieht.

● Computermodellierer, mich manchmal eingeschlossen, unterliegen alle dem fast unwiderstehlichen Wunsch, die Modellwelt mit der realen Welt zu verwechseln. Sie sagen Dinge wie „Wir haben festgestellt, dass das Klimaphänomen X durch den Antrieb Y verursacht wird“. Richtig wäre aber: „Wir haben festgestellt, dass in unserem Modell das modellierte Klimaphänomen X durch unseren modellierten Antrieb Y verursacht wird“. Leider sind die Modellierer nicht die einzigen, die bei diesem Prozess getäuscht werden.

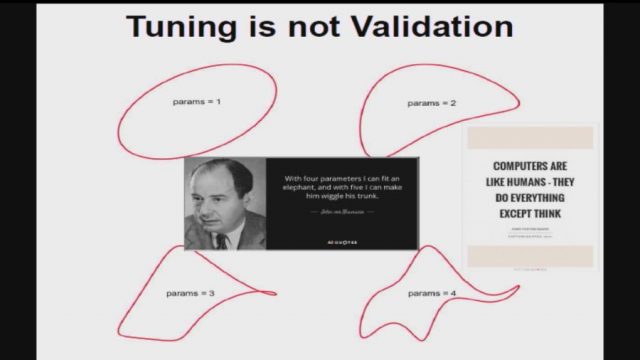

● Je mehr einstellbare Parameter ein Modell hat, desto unwahrscheinlicher ist es, dass es die Realität genau abbildet. Klimamodelle haben Dutzende von abstimmbaren Parametern. Hier sind 25 von ihnen, es gibt aber noch viele mehr:

Was ist falsch mit Parametern in einem Modell? Hier ist eine oft wiederholte Geschichte über den berühmten Physiker Freeman Dyson, der von dem noch berühmteren Enrico Fermi zu diesem Thema belehrt wurde …

Im Frühjahr 1953 hatten wir nach heroischen Anstrengungen theoretische Graphen der Meson-Proton-Streuung gezeichnet. Wir beobachteten freudig, dass unsere berechneten Zahlen ziemlich gut mit den gemessenen Zahlen von Fermi übereinstimmten. Also machte ich einen Termin aus, um mich mit Fermi zu treffen und ihm unsere Ergebnisse zu zeigen. Stolz fuhr ich mit dem Greyhound-Bus von Ithaca nach Chicago, um Fermi ein Paket mit unseren theoretischen Graphen zu zeigen.

Als ich in Fermis Büro ankam, überreichte ich Fermi die Graphen, aber er warf kaum einen Blick auf sie. Er lud mich ein, Platz zu nehmen, und fragte mich freundlich nach der Gesundheit meiner Frau und unseres neugeborenen kleinen Sohnes, der jetzt fünfzig Jahre alt geworden war. Dann verkündete er sein Urteil mit ruhiger, gleichmäßiger Stimme. „Es gibt zwei Wege, Berechnungen in der theoretischen Physik durchzuführen“, sagte er. „Der eine Weg, und das ist der Weg, den ich bevorzuge, besteht darin, ein klares physikalisches Bild von dem Prozess zu haben, den man berechnet. Der andere Weg ist, einen präzisen und in sich konsistenten mathematischen Formalismus zu haben. Beides hat man nicht.“

Ich war etwas verblüfft, wagte es aber ihn zu fragen, warum er die pseudoskalare Mesontheorie nicht als einen in sich konsistenten mathematischen Formalismus ansah. Er antwortete: „Die Quanten-Elektrodynamik ist eine gute Theorie, weil die Kräfte schwach sind, und wenn der Formalismus mehrdeutig ist, haben wir ein klares physikalisches Bild, das uns leitet. Bei der pseudoskalaren Mesonentheorie gibt es kein physikalisches Bild, und die Kräfte sind so stark, dass nichts konvergiert. Um Ihre berechneten Ergebnisse zu erreichen, mussten Sie willkürliche Abschneideverfahren einführen, die weder auf solider Physik noch auf solider Mathematik beruhen.“

In meiner Verzweiflung fragte ich Fermi, ob er nicht beeindruckt sei von der Übereinstimmung zwischen unseren berechneten Zahlen und seinen gemessenen Zahlen. Er antwortete: „Wie viele willkürliche Parameter haben Sie für Ihre Berechnungen verwendet?“ Ich dachte einen Moment über unsere Abschneideverfahren nach und sagte: „Vier.“ Er sagte: „Ich erinnere mich, dass mein Freund John von Neumann zu sagen pflegte: Mit vier Parametern kann ich einen Elefanten einpassen, und mit fünf kann ich ihn mit dem Rüssel wackeln lassen.“ Damit war das Gespräch beendet. Ich bedankte mich bei Fermi für seine Zeit und Mühe, und nahm traurig den nächsten Bus zurück nach Ithaca, um den Studenten die schlechte Nachricht zu überbringen.

● Das Klima ist wohl das komplexeste System, das der Mensch zu modellieren versucht hat. Es hat nicht weniger als sechs große Subsysteme – den Ozean, die Atmosphäre, die Lithosphäre, die Cryosphäre, die Biosphäre und die Elektrosphäre. Keines dieser Subsysteme ist für sich genommen gut verstanden, und wir haben nur punktuelle, lückenhafte, grobe Messungen von jedem einzelnen. Jedes von ihnen hat seine eigenen internen Zyklen, Mechanismen, Phänomene, Resonanzen und Rückkopplungen. Jedes der Subsysteme interagiert mit jedem der anderen. Es gibt wichtige Phänomene, die auf allen Zeitskalen von Nanosekunden bis zu Millionen von Jahren und auf allen räumlichen Skalen von Nanometern bis zum gesamten Planeten auftreten. Schließlich gibt es sowohl interne als auch externe Einflüsse von unbekanntem Ausmaß und Wirkung. Wie wirkt sich zum Beispiel der Sonnenwind auf die Biosphäre aus? Nicht nur das, wir sind erst seit ein paar Jahrzehnten an dem Projekt dran. Unsere Modelle sind … nun ja … um großzügig zu sein, würde ich sie als Bastelvorlagen für die Komplexität der realen Welt bezeichnen.

● Viele Läufe von Klimamodellen enden auf dem Fußboden des Schneideraums, weil sie nicht mit den Überzeugungen, Auffassungen, falschen Ideen und Missverständnissen des besagten Programmierers übereinstimmen. Sie zeigen uns nur die Ergebnisse der Modellläufe, mit denen sie einverstanden sind, nicht aber die Ergebnisse der Läufe, bei denen das Modell aus den Fugen geraten ist. Hier sind zweitausend Läufe von 414 Versionen eines Modells, das zuerst eine Kontroll- und dann eine Doppel-CO2-Simulation durchführt. Man erkennt, dass viele der Ergebnisse weit aus dem Rahmen fallen:

Aus all diesen Überlegungen folgt, dass jeder, der glaubt, dass die Klimamodelle etwas „beweisen“ oder „feststellen“ oder „verifizieren“ können, was vor fünfhundert Jahren passiert ist oder in hundert Jahren passieren wird, in einem Narrenparadies lebt. Diese Modelle sind dieser Aufgabe in keiner Weise gewachsen. Sie mögen uns Einsichten bieten oder uns dazu bringen, neue Ideen in Betracht zu ziehen, aber sie können nur Dinge in der Modellwelt „beweisen“, nicht aber in der realen Welt.

Ich möchte klarstellen, dass ich selbst Dutzende von Modellen geschrieben habe und nicht gegen Modelle bin. Ich habe sie mein ganzes Leben lang geschrieben und benutzt. Allerdings gibt es diese Modelle, und dann gibt es jene Modelle. Einige Modelle wurden getestet und einer umfangreichen V&V unterzogen, und ihre Ergebnisse wurden mit der realen Welt verglichen und als sehr genau befunden. Also benutzen wir sie, um interplanetare Sonden zu navigieren und neue Flugzeug-Tragflächen und ähnliches zu entwerfen.

Klimamodelle gehören leider nicht zu dieser Klasse von Modellen. Verdammt, wenn sie es wären, bräuchten wir nur eines von ihnen, anstatt der Dutzenden, die heute existieren und die uns alle unterschiedliche Antworten geben … was zu der ultimativen Hybris der Modellierer führt, der Idee, dass die Mittelung dieser Dutzenden von Modellen das „Rauschen“ beseitigt und nur solide Ergebnisse zurücklässt.

Schließlich könnte ich als lebenslanger Computerprogrammierer der Behauptung „Alle Modelle sind falsch, aber einige sind nützlich“ nicht mehr widersprechen. Nehmen wir beispielsweise die CFD-Modelle, die die Boeing-Ingenieure verwenden, um die Tragflächen von Jumbo-Jets zu entwerfen oder die Modelle, die unsere Aufzüge steuern. Will mir jemand ernsthaft weismachen, dass diese Modelle falsch sind? Wer das wirklich glaubt, würde nie wieder fliegen oder in einen Aufzug steigen. Sicher, sie sind keine exakten Reproduktionen der Realität, das ist es, was „Modell“ bedeutet … aber sie sind richtig genug, um sich in Situationen, in denen es um Leben und Tod geht, auf sie verlassen zu können.

Lassen Sie mich diese Frage klar formulieren. Während Modelle, die richtig sind, absolut nützlich sind, ist es sicherlich auch möglich, dass ein Modell, das falsch ist, nützlich ist.

Aber damit ein Modell, das falsch ist, nützlich ist, müssen wir unbedingt verstehen, WARUM es falsch ist. Sobald wir wissen, wo es falsch gelaufen ist, können wir den Fehler beheben. Aber bei den komplexen iterativen Klimamodellen, die Dutzende von Parametern benötigen, bei denen die Ausgabe eines Zyklus‘ als Eingabe für den nächsten Zyklus verwendet wird und bei denen ein hundertjähriger Lauf mit einem halbstündigen Zeitschritt 1,75 Millionen Schritte umfasst, ist es fast unmöglich zu bestimmen, wo ein Klimamodell vom Weg abgekommen ist. War es ein Fehler in dem Parameter, der die Eistemperatur in 10.000 Fuß Höhe angibt? War es ein Fehler in dem Parameter, der die Bildung von Schmelztümpeln auf dem Meereis nur auf bestimmte Monate beschränkt? Es gibt keine Möglichkeit, das festzustellen, also gibt es auch keine Möglichkeit, aus unseren Fehlern zu lernen.

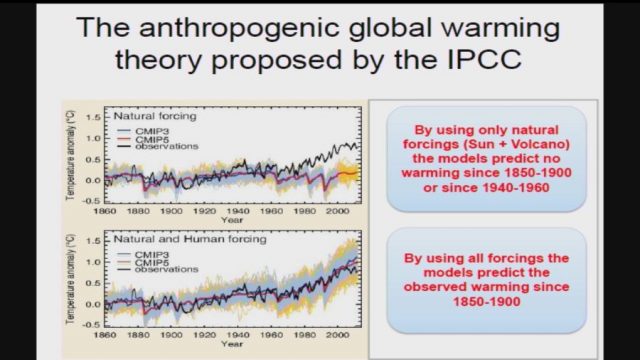

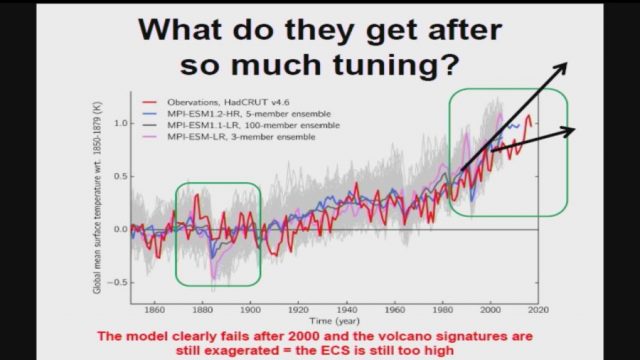

Als nächstes werden alle diese Modelle „getrimmt“, um den vergangenen langsamen Erwärmungstrend darzustellen. Und im Allgemeinen machen sie das gut … weil die verschiedenen Parameter angepasst und das Modell im Laufe der Zeit verändert wurde, bis sie das taten. Es ist also keine Überraschung, dass sie diesen Job gut machen können … zumindest in den Teilen der Vergangenheit, auf die sie getrimmt worden waren, um sie zu reproduzieren.

Aber dann ziehen die Modellierer die modellierten „anthropogenen Antriebe“ wie CO2 heraus und verkünden stolz, dass – da das Modell die vergangene allmähliche Erwärmung nicht mehr reproduzieren kann – dies beweist, dass die anthropogenen Antriebe die Ursache der Erwärmung sind … Ich nehme an, dass das Problem mit dieser Behauptung klar wird.

Hinzu kommt, dass die Gittergröße der Computermodelle weit größer ist als wichtige Klimaphänomene wie Gewitter, Staubteufel und Tornados. Wenn das Klimamodell falsch ist, liegt das daran, dass es diese Phänomene nicht enthält? Ich sage: ja … die Klima-Computermodellierer sagen nichts.

Wir wissen ja nicht einmal, ob die Navier-Stokes-Gleichungen der Strömungsdynamik, wie sie in den Klimamodellen verwendet werden, zur richtigen Antwort konvergieren, und soweit ich das beurteilen kann, gibt es keine Möglichkeit, das zu bestimmen.

Um den Kreis zu schließen, lassen Sie mich zu meinem Ausgangspunkt zurückkehren – ein Computermodell ist nichts anderes als meine Ideen, die verfestigt wurden. Das war’s. Das ist alles.

Wenn ich also denke, dass CO2 der geheime Steuerknopf für die globale Temperatur ist, dann wird die Ausgabe eines jeden von mir erstellten Modells diese Annahme widerspiegeln und verifizieren.

Wenn ich aber denke (wie ich es tue), dass die Temperatur durch sich entwickelnde Phänomene in engen Grenzen gehalten wird, dann wird die Ausgabe meines neuen Modells diese Annahme widerspiegeln und verifizieren.

Nun, würden die Ausgaben eines dieser sehr unterschiedlichen Modelle „Beweise“ für die reale Welt sein?

Nicht auf diesem Planeten.

Und das ist die kurze Liste der Dinge, die mit Computermodellen falsch sind … es gibt viel mehr, aber wie Pierre sagte, „die Ränder dieser Seite sind zu klein, um sie zu enthalten“ …

Link: https://wattsupwiththat.com/2021/03/12/there-are-climate-models-and-there-are-climate-models/

Übersetzt von Chris Frey EIKE

“The result has obvious consequences also for the models’ warming expectations for the 21st century because, to make these models consistent with our proposed adjusted temperature record, their projected warming should be reduced by about 40% for all emission scenarios.”

Professor Scafetta ist niemand der sagt, es gäbe keinen anthropogenen Klimawandel. Er gehört zu den Wissenschaftlern, die tatsächlich am Thema interessiert sind und nicht bemüht sind, Forschungsarbeiten zu produzieren, die beim IPCC Wohlgefallen finden. Ein Wohlgefallen, das gemeinhin mit Forschungsgeldern belohnt wird. Als ernsthafter Wissenschaftler steht Scafetta vor einem Problem. Diesem:

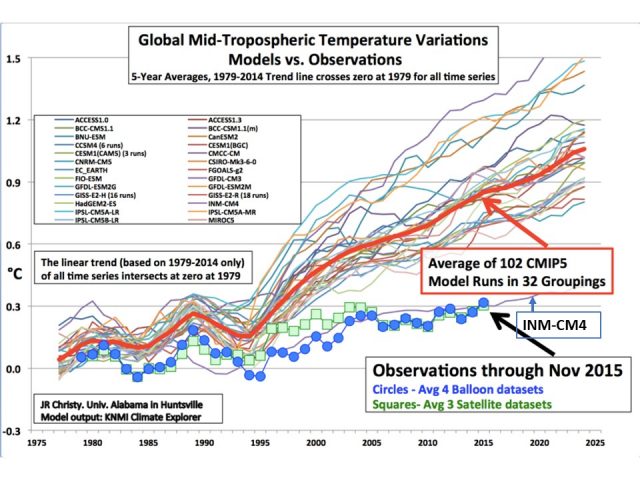

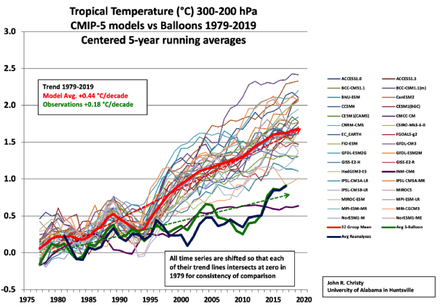

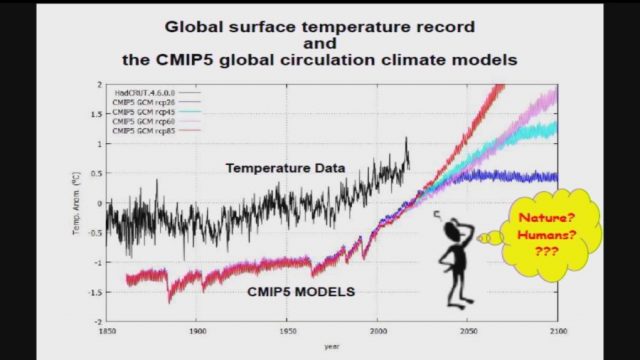

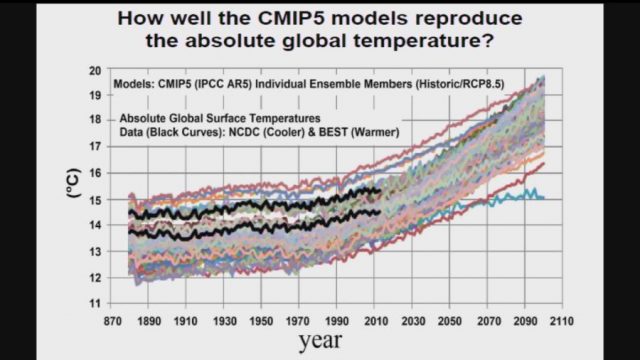

Die Abbildung, die Roy Spencer monatlich fortschreibt, zeigt die Temperatur, die in der Troposphäre gemessen wird. Die Daten werden bei der Universty of Huntsville, Alabama gesammelt und als Datensatz bereitgestellt. Scafetta hat sich diesen Datensatz besorgt und zudem hat er sich den Datensatz der Climate Research Unit der University of East Anglia (CRU-TS4.04) besorgt, der Temperatur-Messdaten für Messstationen weltweit kompiliert, die wiederum als Grundlage dienen, auf der die CMIP-Modelle des IPCC berechnet werden. Auch diese Daten, das komplette Datenset für CMIP-5 (Coupled Model Intercomparison Project Phase 5), mit dem die düsteren Prognosen des IPCC erstellt werden, hat sich Scafetta besorgt und dann angefangen, zu vergleichen.

Von den Klimamodellen, so schreibt Scafetta, werde erwartet, dass sie in der Lage seien, globale und lokale Klimavariationen, wie sie durch unterschiedliche Bewölkung, Flächennutzung, und -versiegelung, Aeorosole in der Luft und vieles mehr verursacht werden, adäquat abbilden. Das Problem: Sie tun es nicht. Sie tun es nicht einmal ansatzweise. ALLE, ausnahmslos alle Klimamodelle, die das IPCC vertreibt, überschätzen die Erwärmung, die sich seit 1940 ergeben hat (siehe Abbildung oben), und zwar um ein Vielfaches, was insofern rätselhaft ist, als die Klimamodelle angeblich so kalibriert sind, dass sie die vergangenen Temperaturen akkurat abbilden. Das tun sie offensichtlich nicht, und es kommt noch dicker: Scafetta findet, dass unterschiedliche Modelle des IPCC lokale Unterschiede quasi nach Lust und Laune produzieren, ohne Systematik, widersprüchlich, zufällig.

Normalerweise werden Modelle, die beliebige Ergebnisse auf lokaler Ebene produzieren, in den Mülleimer geworfen. Normalerweise. Aber die Modelle, die das IPCC verbreitet, um es dadurch Milliardären zu ermöglichen, dass sie ihren Reichtum steigern, sie dienen nicht dazu, die Realität akkurat abzubilden, sie dienen dazu, politische Munition zu liefern, mit der man dann nicht nur die Klimawandel-Hysterie anheizen kann, sondern mit der es auch möglich ist, diejenigen, die darauf hinweisen, dass der menschliche Einfluss auf das Klima, sofern er überhaupt in relevantem Ausmaß vorhanden ist, z.B. im Vergleich zum Einfluss der Sonne eher irrelevant ist, zu diskreditieren.

Wie schlecht die Modelle des IPCC sind, das zeigt die folgende Abbildung:

In beiden Abbildungen sind Klimamuster dargestellt. Beide Abbildungen unterscheiden sich darin, dass unterschiedliche Klimamodelle des IPCC zum Einsatz gekommen sind. Wären diese Modelle auch nur ansatzweise reliabel, dann müssten die Farbmuster in beiden Abbildungen identisch sein. Sie sind es offenkundig nicht. Sie sind willkürlich und widersprüchlich. Die Modelle sind absoluter Junk – oder, in der zurückhaltenderen Formulierung von Scafetta:

“…is shown in Fig. 6, which indicates that the various models show very different local patterns that contradict each other while they are supposed to reproduce climatic patterns on a 60-year period also locally.”

Nun stellt man solche Berechnungen nicht an, um zu zeigen, dass die Klimamodelle des IPCC Junk sind. Das ist allgemein bekannt, wird nur von Aktivisten und Politdarstellern aus den unterschiedlichsten Motiven heraus ignoriert. Nein, solche Berechnungen werden auf Basis einer Hypothese darüber angestellt, warum die Modelle des IPCC so daneben sind, wobei die Hypothese sich nicht auf die politische Motivation bezieht, die ist nicht fraglich, denn wenn jemand Hysterie verbreitet und gleichzeitig das Heilmittel gegen die Hysterie feilbietet, dann können nur Motive der eigenen Bereicherung oder Boshaftigkeit, der Wunsch, andere zu schädigen, dahinter stehen, nein, die Hypothese hat die Fehler, die systematischen Fehler zum Gegenstand, die – absichtlich oder unabsichtlich – in Klimamodelle integriert sind und dazu führen, dass die Erwärmung so hoffnunglso überschätzt wird.

Nun stellt man solche Berechnungen nicht an, um zu zeigen, dass die Klimamodelle des IPCC Junk sind. Das ist allgemein bekannt, wird nur von Aktivisten und Politdarstellern aus den unterschiedlichsten Motiven heraus ignoriert. Nein, solche Berechnungen werden auf Basis einer Hypothese darüber angestellt, warum die Modelle des IPCC so daneben sind, wobei die Hypothese sich nicht auf die politische Motivation bezieht, die ist nicht fraglich, denn wenn jemand Hysterie verbreitet und gleichzeitig das Heilmittel gegen die Hysterie feilbietet, dann können nur Motive der eigenen Bereicherung oder Boshaftigkeit, der Wunsch, andere zu schädigen, dahinter stehen, nein, die Hypothese hat die Fehler, die systematischen Fehler zum Gegenstand, die – absichtlich oder unabsichtlich – in Klimamodelle integriert sind und dazu führen, dass die Erwärmung so hoffnunglso überschätzt wird.

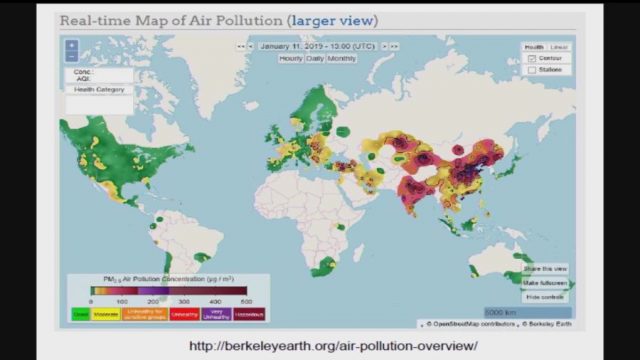

Die Hypothese, die Scafetta gebildet hat, sieht Urban Heat Islands im Mittelpunkt. Es ist schön eine solche Hypothese zu lesen, denn rund 60 Jahre nachdem Garrett Hardin mit seinem Artikel, “The Tragedy of the Commons” darauf hingewiesen hat, dass die meisten Probleme, vor denen die Menschheit steht, eine Folge von ÜBERBEVÖLKERUNG sind, 60 Jahre später setzt sich wieder das Bewusstsein durch, dass die Menge, in der Menschen den Planeten bevölkern, vielleicht das eigentliche Problem sein könnte. Urban Heat Islands (UHIs) entstehen durch Urbanisierung und mit UHIs wird im Wesentlichen umschrieben, dass nächtliche Winde die Luft der Städte, die sich tagsüber aufheizen, ins Umland bringt und dafür sorgt, dass auch das Umland aufgeheizt wird. Die globale Temperaturzunahme, so die Hypothese, ist zumindest in Teilen auf solche UHIs zurückzuführen.

Messbar wird dieses Phänomen über die Minimaltemperaturen, denn im Gegensatz zu dem, was MS-Medien so gerne verbreiten, sind es nicht die Maximaltemperaturen, die in den letzten Jahren gestiegen sind, sondern die Minimaltemperaturen. Aus beiden, den Maximal- und den Minimaltemperaturen für die 2,5 Kilometer mal 2,5 Kilometer großen Flächen, die die Grundeinheit vieler Klimamodelle bilden, berechnet Scafetta den Diurnal Temperature Range (DTR), also die tägliche Temperaturspannweite für die jeweiligen Messeinheiten, die gleichmäßig über die Erde verteilt sind und stellt auf dieser Grundlage zunächst fest, dass die Klimamodelle des IPCC nicht in der Lage sind die Veränderung in den DTR, die sich in den 60 Jahren bis 2014 ergeben haben, abzubilden.

DTR sind ein direktes Ergebnis der Urbanisierung, der sich daraus ergebenden Urban Heat Islands, und die Erwärmung der letzten Jahrzehnte schlägt sich darin nieder, dass die tägilche Temperaturspannweite um Städte herum geringer geworden ist. Das ist zunächst einmal eine Hypothese, aber eine, die Scafetta schnell bestätigen kann. Die daraus folgende Beobachtung, dass Klimamodelle des IPCC diese Veränderung nicht erfassen, dass sie willkürliche und in jedem Fall in Richtung einer erheblichen Überschätzung der Erwärmung gehende Ergebnisse produzieren, führt zum Masterstroke: Wenn es in Klimamodellen einen “Erwärmungs-Bias” gibt, dann sollten diese Modelle die globale Erwärmung in Gegenden, in denen es keine Urban Heat Islands gibt, die die Überschätzung reduzieren, erheblich überschätzen, dann sollten die Modelle deutlich von den Messdaten abweichen. Scafetta prüft diese Hypothese für Grönland und siehe da, das Ergebnis ist dramatisch:

Die rote Linie bildet die Beobachtungsdaten ab, die blaue Linie gibt die Modell-Simulation wieder, die auf Basis dieser Beobachtungsdaten errechnet wurde. Die Abweichung ist erheblich.

“Thus, the models (which are calibrated to reproduce, on average, the observed global warming trend since 1900) hindcast almost twice the warming than what has been recorded in Greenland since 1930-1950.

In den Modellen des IPCC wird die tatsächliche Erwärmung eben einmal verdoppelt. Wer daran wohl ein Interesse haben könnte?

Aber damit ist Scafetta noch nicht am Ende. Nachdem er gezeigt hat, dass die Erwärmung, die in den Klimamodellen des IPCC berechnet wird, die tatsächliche Erwärmung um ein Vielfaches übertreibt, selbst dann, wenn tatsächliche Beobachtungsdaten den Ausgangspunkt der Modellierung bilden, nachdem er gezeigt hat, dass in der Erwärmung, die die Klimamodelle abbilden, nicht klimatische Erwärmung enthalten ist, die sich als Ergebnis von Urbanisierung einstellt, geht Scafetta daran, den entsprechenden Fehler, der in den Klimamodellen des IPCC enthalten ist, zu quantifizieren.

Das Ergebnis sieht so aus:

Die grünen Linien, es sind 106 an der Zahl, geben die Entwicklung der globalen Temperatur an, wenn die unterschiedlichen Modelle des IPCC genutzt werden, um die entsprechende Modellierung vorzunehmen. Die orange Linie stellt den Mittelwert der 106 Modelle dar. Die rote Linie zeigt die tatsächlich in der Troposphäre gemessene Temperatur, und die schwarze Linie zeigt die Rekonstruktion der Temperatur, die Scafatta auf Grundlage der Daten aus East Anglia vorgenommen hat. Wie von Geisterhand geführt, kommen alle Modelle des IPCC im Verlauf der Zeit zu Temperaturen, die weit über den tatsächlichen Temperaturen liegen, während die Berechnung von Scafetta die tatsächliche Temperatur, die über den Datensatz der University of Huntsville zugänglich ist, sehr gut abbildet.

Daraus ergibt sich nur ein Schluss: Die von Scafetta formulierte Hypothese, dass in den Modellen des IPCC nicht nur die globale Temperatur als viel zu hoch berechnet wird, sondern die Ergebnisse auch deshalb falsch sind, weil der Einfluss, den Urbanisierung und daraus entstehende Urban Heat Islands auf die globale Temperatur haben, nicht berücksichtigt wird, ist bestätigt. Fehlt noch die Angabe, um wie viel sich die Panik-Zahl der Erwärmung die das IPCC so gerne verbreitet, reduziert, wenn diese Fehler aus dem Modell beseitigt werden:

“In the light of the above findings, and under the assumption that the SST [Sea Surface Temperature] warming since 1940–1960 is accurate, the models can be scaled on the SST record and used to estimate an expected land warming. Corrected in such a way, we determined that 25–45% of the recorded 0.97±0.05 °C land warming from 1940 to 1960 to 2000–2020 is likely due to urbanization and other unidentifed non-climatic factors biasing the available climatic records.”

Mit anderen Worten: Unter der Annahme, dass die Temperaturangaben, die in den Modellen des IPCC für die Meeresoberfläche enthalten sind, korrekt sind, eine Annahme, die dem IPCC sehr entgegen kommt, beläuft sich der Fehler in den Modellen des IPCC auf mindestens 25%-45% im Verlauf der letzten 60 Jahre. Im Durchschnitt, so schreibt Scafetta einige Zeilen weiter, überschätzen die Modelle des IPCC die tatsächliche Erwärmung des Planeten um 40%. Und diese Schätzung von Scafetta basiert auf der Annahme, dass die Modellierung der Temperatur der Meeresoberfläche richtig ist, eine Annahme, die man nicht machen muss. Scafettas Schätzung von 40% ist somit eine sehr konservative Schätzung. Die tatsächliche Übertreibung liegt vermutlich deutlich darüber.

In jedem Fall wird uns nicht nur im Hinblick auf SARS-CoV-2 absoluter Unfug erzählt, wird nicht nur im Hinblick auf SARS-CoV-2 mit falschen Zahlen hantiert, auch im Hinblick auf die angebliche Klimakrise basiert die gesamte Geschichte auf mehr oder weniger frei erfundenen Zahlen. Dass man die Erfindung dann als Resultat einer Modellierung verkauft, ist nur sympbolische Kosmetik.

Scafetta, Nicola (2021). Detection of non-Climatic Biases in Land Surface Temperature Records by Comparing Climatic Data and their Model Simulations. Climate Dynamics.

Der Beitrag erschien zuerst bei ScienceFiles hier

Eine der Freuden von Diskussionen mit Klimawissenschaftlern ist, dass man einen Einblick in ihre Denkweise bekommt. Nehmen Sie zum Beispiel das oft postulierte: „Man sollte sich das große Ganze ansehen“. Was viele Klimawissenschaftler damit meinen, ist die Betrachtung der neuesten super-duper Ozean-Atmosphäre gekoppelten Modelle mit zeilenweisen Strahlungstransfer-Codes und was nicht noch alles. Ohne das, so die Behauptung, kann man nicht verstehen, wie das Klimasystem funktioniert. Seltsamerweise bedeutet „das große Ganze betrachten“ für einen Physiker wie mich genau das Gegenteil: das zu betrachtende System auf das Wesentliche zu reduzieren und Erkenntnisse über sein Innenleben aus der zugrundeliegenden Physik zu gewinnen, ohne sich von Details ablenken zu lassen.

Was ist hier also das große Ganze? In ihrer einfachsten Form ist die Erde ein Wärmeübertragungssystem im Nicht-Gleichgewicht (aber in einem stabilen Zustand), in dem Wärme (überwiegend) in den Äquatorregionen eintritt und Wärme (überwiegend) an den Polen verloren geht. Im Inneren wird die Wärme durch atmosphärische und ozeanische Strömungen von den Tropen zu den Polen transportiert, wodurch die Tropen abgekühlt und die Polarregionen erwärmt werden. Ohne diesen Transport würde die lokale Temperatur nur durch das Gleichgewicht zwischen Sonneneinstrahlung und Strahlungsverlusten bestimmt, wodurch die Tropen wärmer wären als sie sind und die Pole kälter. Die Tropen sind kühler, als sie es ohne diesen Transport wären, während die Polarregionen wärmer sind. Daher: kalte Tropen und warme Pole.

Jetzt kommt das Rätsel: Der Wärmetransport zwischen Tropen und Polargebieten wird durch deren Temperaturdifferenz bestimmt. Je größer diese ist, desto größer ist der Wärmestrom. Der Wärmetransport verringert aber diese Temperaturdifferenz und wirkt damit seiner eigenen Verursachung entgegen. Betrachten wir z. B. den Grenzfall eines sehr großen Wärmestroms, bei dem die Wärmeübertragung praktisch augenblicklich erfolgt. Als Ergebnis hätten die Pole die gleiche Temperatur wie die Tropen, aber dann kann es überhaupt keinen Wärmestrom geben, weil dieser durch eine Temperaturdifferenz angetrieben wird. Wir haben also einen Widerspruch. Von der umgekehrten Situation auszugehen, dass es keinen Wärmestrom gibt, ist ebenfalls unhaltbar, weil die große Temperaturdifferenz einen Wärmestrom hervorruft. Es gibt aber einen Wärmestrom, der daher mit der von ihm verursachten Temperaturdifferenz konsistent sein muss. Ein kleinerer Temperaturunterschied ist nicht möglich, denn das würde den Wärmestrom verringern und damit die Differenz wieder vergrößern; und ein größerer Temperaturunterschied würde den Wärmestrom vergrößern und damit verringern. Dies deutet stark darauf hin, dass sich die Atmosphäre als Ganzes in einem Zustand einpendelt, in dem die Temperaturdifferenz zwischen den Tropen und den Polen minimal ist, während gleichzeitig der von ihr verursachte Wärmestrom zwischen ihnen maximal ist. Wir können diese Einsicht nutzen, um seine Größe zu berechnen, indem wir das Prinzip der Maximalen Entropieproduktion MEP anwenden, eine Arbeitshypothese in der Nicht-Gleichgewichtsthermodynamik, die zunehmend Unterstützung in Beobachtungen findet (siehe Kleidon für eine ausgezeichnete Einführung, Ref. 1, 2).

Das MEP-Prinzip besagt, dass ein System, das weit vom (thermodynamischen) Gleichgewicht entfernt ist, sich an einen stationären Zustand anpasst, in dem Energie dissipiert und Entropie mit der maximal möglichen Rate produziert wird. Beachten Sie, dass „maximale Entropieproduktion“ etwas völlig anderes ist als „maximale Entropie“. Letztere bezieht sich auf ein geschlossenes System im thermodynamischen Gleichgewicht. Hier haben wir es mit einem offenen System zu tun, das sich nicht im thermodynamischen Gleichgewicht befindet, sondern in einem stetigen Nicht-Gleichgewichtszustand.

Ich fürchte, ich muss hier einige Formeln einführen. Was ich tun werde ist, die Grundgleichung und ihre Lösung hier anzugeben, während ich für die Kenner der Materie in einem Anhang erläutere, wie man diese Lösung findet. Diejenigen, die mit der Thermodynamik vertraut sind, werden diesen Ausdruck für die Produktion, also die Änderung, dS der Entropie S durch eine Änderung des Wärmeinhalts dQ bei der Temperatur T kennen:

Hieraus folgt direkt die Formel für die Entropie-Produktion durch einen Wärmefluss Q zwischen den Äquator-Gebieten mit der Temperatur Te und den Polen mit der Temperatur Tp:

Die Wärme verlässt die äquatorialen Regionen mit der Temperatur Te, daher das Minuszeichen, und erreicht die Pole mit der Temperatur Tp. Die Maximierung von S ist gleichbedeutend mit der Suche nach der optimalen Kombination von Q und Te -Tp. Die Lösung dieser Gleichung ist recht einfach (siehe Anhang). Die tatsächliche Differenz Te -Tp beträgt fast die Hälfte der Differenz, die sich ohne Energiefluss ergeben hätte. Halb, also nicht 0,3 oder 0,7 mal.

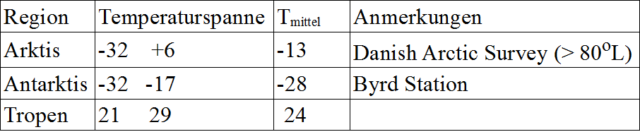

Testen wir dieses Ergebnis anhand von Modellen und Beobachtungen. Es scheint gut etabliert zu sein – aus Berechnungen mit Standard-Atmosphärenmodellen –, dass ohne den Wärmetransfer die äquatorialen Regionen etwa 15 Grad wärmer und die Pole etwa 25 Grad kälter wären (Celsius, ref 3). Ich nehme diese Abschätzungen für bare Münze; sie implizieren eine Asymmetrie β = 0,25, für die 1 – 2α ~ 0,51 gilt (siehe Anhang). Dann lautet die Vorhersage, dass der Temperaturunterschied zwischen den Tropen und den Polen mit dem Wärmetransfer etwa 41 Grad beträgt (also (15 + 25) × 0,51∕0,49), während der Unterschied ohne diesen Transfer etwa 80 Grad betragen würde. In der Tabelle sind einige reale Beobachtungen aufgeführt:

Für die Antarktis habe ich die Daten der Byrd-Station verwendet, weil sie auf einem Plateau liegt und daher vermutlich weniger von einer möglichen Abschirmung durch Berge betroffen ist. Die gemittelte polare Temperatur scheint bei etwa -21°C zu liegen. Für die Tropen entspricht das untere Ende des Bereichs überwiegend den ozeanischen Daten und sollte daher ein größeres Gewicht im Mittelwert haben, der hier mit 24°C angenommen wird. Die beobachtete Temperaturdifferenz zwischen polaren und äquatorialen Regionen liegt also bei etwa 45 Grad, gegenüber einer Vorhersage von 41 Grad. Nicht schlecht für ein so einfaches Modell.

Es mag ein einfaches Modell sein, aber das MEP-Prinzip hat eine wichtige Implikation. Die Maximierung der Entropieproduktion für stationäre Bedingungen impliziert eine starke negative Rückkopplung auf Störungen (siehe Kleidon). Jede Störung wird per Definition zu einer Abnahme von S führen, und das System wird sich anpassen und versuchen, es wieder zu optimieren. Eine solche Störung in Klimamodellen ist bekannt und seit langem etabliert und weithin als gültiges Konzept akzeptiert: die „polare Verstärkung“. Sie besagt, dass sich in einer sich erwärmenden Atmosphäre die Polarregionen schneller erwärmen als die äquatorialen Regionen; daher nimmt Te – Tp ab. Es ist jedoch auch eines der seltsamsten Konzepte, die in der Klimamodellierung zu finden sind, weil es keine begrenzende Bedingung hat: Nirgendwo in der Literatur steht etwas wie „unter diesen und jenen Bedingungen, bei diesem Grad der Erwärmung, wird die polare Verstärkung aufhören“. Dies könnte zu einer Absurdität führen: Sollte die Atmosphäre heiß genug werden, würde der Temperaturunterschied zwischen Äquator und Pol komplett verschwinden oder sogar das Vorzeichen wechseln. Es muss also Bedingungen geben, unter denen die Verstärkung nicht mehr stattfindet. Warum ist das wichtig? Wenn es einen solchen Mechanismus gibt, der unter bestimmten Umständen einsetzt, dann muss man erklären, warum er gerade jetzt nicht funktioniert, und das könnte peinlich sein. Wie dem auch sei, aus dem Vorangegangenen sollte ersichtlich sein, dass das Konzept der polaren Verstärkung in der Tat ziemlich fragwürdig ist: Die verringerte Differenz von polaren und äquatorialen Temperaturen reduziert den Wärmefluss zu den Polarregionen, was eine Abkühlung zur Folge hätte. Ein realistisches Klimamodell sollte sich so verhalten, wie es die zugrundeliegende Physik vorgibt. Daraus lässt sich ableiten, dass eine solche Rückkopplung in den aktuellen Klimamodellen nicht vorhanden ist und dass folglich das ganze Konzept ein Artefakt eines unvollständigen Modells sein könnte. (Sie haben es hier zuerst gelesen.)

Aber wie das Leben so spielt hat sich die Arktis in den letzten 3 oder 4 Jahrzehnten erwärmt. Das würde das Konzept der polaren Verstärkung beweisen, oder? Nun, diese Erwärmung mag in der Arktis der Fall sein, aber sie sollte gleichzeitig auch für die Antarktis gelten, aber dort scheint das Konzept den Vergleich mit den Beobachtungen nicht zu bestehen (ref 4).

Was mag also in der Arktis vor sich gehen? Ich erlaube mir, hierzu meine Meinung zu verkünden. Für mich liegt der Schlüssel in der Tatsache, dass es zwei Pole gibt. Es wäre außergewöhnlich, wenn zu allen Zeiten genau der gleiche Anteil der äquatorialen Wärme auf jeden Pol verteilt würde. Die Übertragungsmechanismen, atmosphärische und insbesondere ozeanische Strömungen, sind von Natur aus chaotische Systeme, die dazu neigen, von einem bestimmten quasi-stabilen Strömungsmuster zu einem anderen zu wechseln. Bei den Meeresströmungen kennen wir dieses Verhalten als Pazifische Dekadische Oszillation, Atlantische Multidekadische Oszillation, Dipol des Indischen Ozeans und dergleichen. Die Zeitskala für solche Veränderungen beträgt viele Jahrzehnte, von 3 für die PDO bis zu 6-8 für die AMO, weil eine enorme Masse und ein enormer Impuls von sich bewegendem Wasser beteiligt ist und Wasser eine inkompressible Flüssigkeit ist, was bedeutet, dass die Veränderung über das gesamte Strömungsmuster gleichzeitig stattfindet. Daher ist zu erwarten, dass die Verteilung der Wärme nach Norden und Süden Änderungen auf einer Zeitskala von Jahrzehnten in einer erratischen Wippe unterliegt. Wir leben zufällig in einer Zeit, in der die nördliche Hemisphäre etwas mehr als ihren gerechten Anteil an der Wärme bekommt; in ein paar Jahrzehnten kann das ganz anders sein. Um solche Veränderungen von einem möglicherweise zugrunde liegenden langfristigen Erwärmungstrend zu unterscheiden, werden Daten über einen viel längeren Zeitraum benötigt, als wir jetzt haben.

Anmerkung von Dipl.-Met. Christian Freuer hierzu: die „bipolare Schaukel“ oder „- Wippe“ ist ihm vor Jahrzehnten schon einmal untergekommen, aber nur aufgrund von Beobachtungen und ohne dass die damaligen Autoren eine Erklärung dafür parat hatten. Es ist äußerst erhellend und erfreulich, hier in relativ einfacher Form jetzt endlich eine solche Erklärung dafür zu finden. – Ende Anmerkung

Link zum Original siehe unten. Bis hier Übersetzt von Chris Frey EIKE

References:

(1) Axel Kleidon (2009): ”Non-equilibrium thermodynamics and maximum entropy production in the Earth system”, https://link.springer.com/article/10.1007/s00114-009-0509-x

(2) A Kleidon, R D Lorenz (editors) ”Non-equilibrium thermodynamics and the production of entropy” (2005) Springer, ISBN 978-3-540-22495

(3) e.g. http://earthguide.ucsd.edu/virtualmuseum/virtualmuseum/EarthsClimateMachine.shtml

Es folgt eine genaue theoretische Herleitung, deren Übersetzung ich hier mal weglasse. Anm. d. Übers.]

Solving the EP equation

The entropy production S for a heat flow Q between the equatorial regions of temperature Te and the polar regions of temperature Tp is given by:

The MEP hypothesis is that the atmospheric system tends to maximise S. This optimum can be found analytically as follows. Introduce Θe and Θp, the temperatures of the equatorial and polar regions respectively if there were no heat transport. That is, Θe and Θp stand for the radiative equilibrium temperatures of those regions. The actual temperatures (Te and Tp) are different because of the heat transport. Hence define ΔTe = Θe – Te and ΔTp = Tp – Θp. Let’s for the moment assume that they are both equal and equal to a fraction α of the range Θe – Θp:

Notice that the difference Te – Tp equals:

Obviously for α = 0 there is no heat transfer, hence S = 0, while for α = 0.5 we have Te equal to Tp and thus no entropy production either. In between these extremes the heat flux Q is somehow proportional to ΔTe, the larger the drop in temperature of the equatorial region, the larger the heat loss from it and one can assume the relation to be (close to) linear. This gives us an expression for S in terms of ΔT, hence as function of α :

The maximum of S in the range [0.0 – 0.5] is straightforwardly found with basic calculus techniques – you need to solve a cubic equation in α – and turns out to be almost exactly at α = 0.25. Alternatively, one could use the R analysis package, encode the function for S, find the maximum with Newton’s method and get a figure as a bonus.

The upshot of all this is that the MEP temperature difference Te -Tp is very nearly half the difference Θe – Θp which we would have had in the absence of any heat flow.

Let’s now revisit ΔTe and ΔTp. Adopting equality of ΔTe and ΔTp means assuming that for every degree drop in temperature of the equatorial regions the polar temperature rises by one degree. This is not very realistic; quite likely the polar temperature rises more because of area and heat capacity differences. We can include such an imbalance by slightly modifying the definitions of ΔTe and ΔTp and introduce an asymmetry parameter β:

With a value of β = 0.25, for instance, this would mean that for every 3 degrees drop in equatorial temperature the poles would gain 5 degrees. Notice that the difference Te – Tp remains as given earlier. Repeating the foregoing exercise for a range of β values presents us with an interesting result: the corresponding α values are practically unchanged: for β = 0 the maximum is at α = 0.2487, for β = 0.25 at 0.2441 and β = 0.33 at 0.2427. This means that irrespective of a possible asymmetry between equator and polar regions the temperature difference between the two remains firmly at about half the difference Θe – Θp, but that the centre of the range shifts according to the value of β

Link: https://wattsupwiththat.com/2020/12/21/of-warm-poles-and-cold-tropics/

Im Juli 1657 erklärte Friedrich III. von Dänemark und Norwegen dem Nachbarn Schweden den Krieg. Dabei wähnte er sich angesichts der übermächtigen Marine Dänemarks derart sicher, dass er auf seiner Hauptinsel Seeland kein Heer zusammenzog. Diesen Fehler sollte Friedrich im darauffolgenden Winter bitter bereuen. Da nämlich marschierten die Truppen von Karl X. Gustav von Schweden über den zugefrorenen Kleinen und Großen Belt nach Seeland, woraufhin der paralysierte König der Dänen und Norweger am 24. Februar 1658 den Frieden von Roskilde unterzeichnen musste, der ihm schmerzliche Gebietsverluste bescherte. Das Ganze war eine der vielen Auswirkungen der sogenannten „Kleinen Eiszeit“, die von etwa 1250 bis 1850 andauerte. In deren Verlauf sank die globale Durchschnittstemperatur um bis zu zwei Grad, was unter anderem Missernten, Hungersnöte und Teuerungen sowie daraus resultierende soziale Unruhen zur Folge hatte.

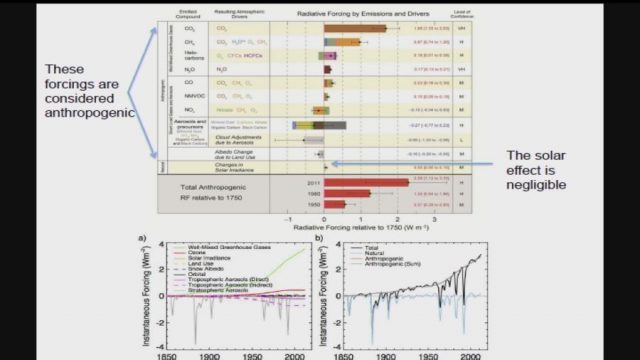

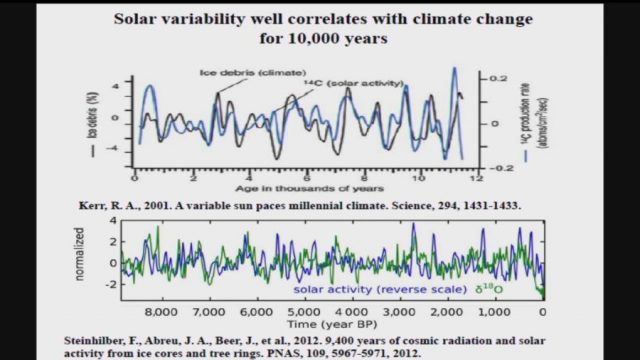

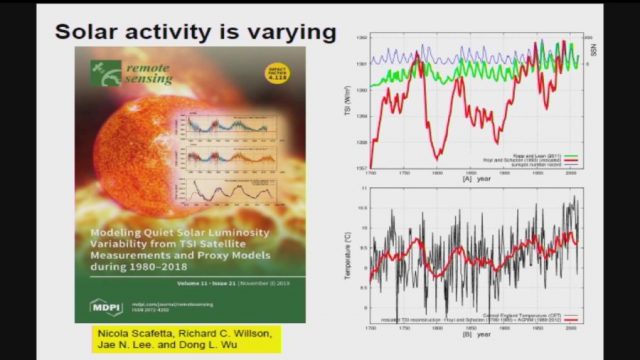

Besonders kalt fiel dabei die Phase zwischen 1645 und 1715 aus, die als Maunder-Minimum bezeichnet wird. Weitere heftige Temperaturstürze gab es auch während des Dalton-Minimums von 1790 bis 1830, des Spörer-Minimums von 1420 bis 1570 und des Wolf-Minimums von 1280 bis 1340. Ursache waren in jedem Falle Vulkanausbrüche, durch die große Mengen Asche und Gase in die Erdatmosphäre gelangten, Änderungen der Erdumlaufbahn sowie eine verringerte Aktivität der Sonne.

Der Abstand unseres Planeten zur Sonne schwankt – je nachdem, ob er mehr kreisförmig oder mehr elliptisch um das Zentralgestirn kreist. Dazu kommt das rhythmische Kippen der Erdachse: Je stärker diese geneigt ist, desto kälter kann es werden.

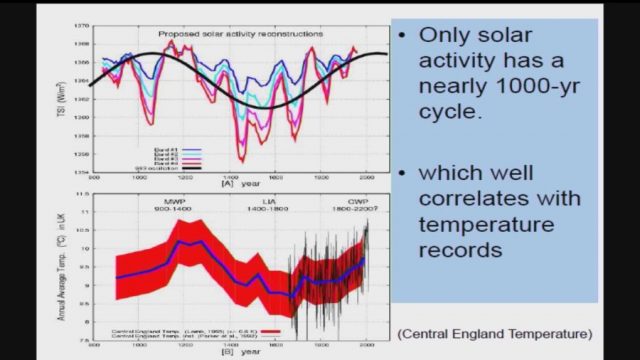

Sonnenflecken sind entscheidend

Den größten Einfluss auf die globale Temperaturentwicklung übt jedoch ganz offensichtlich die Sonne aus. Sie strahlt mal kräftiger und mal schwächer – das resultiert aus Veränderungen ihrer inneren Magnetfelder, die ähnlich wie bei einem elektrischen Dynamo Energie erzeugen. Markantester Ausdruck solcher Abweichungen ist die Zahl der Sonnenflecken, welche teilweise schon mit bloßem Auge beim Auf- und Untergang der Sonne oder einfachen Fernrohren zu sehen sind. Gibt es viele solcher dunkler Stellen auf der Oberfläche unseres Zentralgestirns, dann nimmt dessen Strahlung zu, werden sie weniger oder verschwinden sie komplett, geht die Strahlungsintensität zurück. Während des Maunder-Minimums erschienen lediglich 50 Sonnenflecken, und von 1672 bis 1704 gab es überhaupt keine – normal wären einige Tausend gewesen.

Im 20. Jahrhundert befand sich die Sonne hingegen in einer ungewöhnlich aktiven Phase, dem „Modernen“ beziehungsweise „Großen Maximum“, als dessen Höhepunkt die Jahre 1957/58 gelten. Zwischen 1950 und 2000 lag die Zahl der Sonnenflecken doppelt so hoch wie zum Ende der „Kleinen Eiszeit“, allerdings mit deutlich abnehmender Tendenz. Das nährte ab etwa 1970 die Befürchtung, unserem Planeten stehe eine baldige neue Kälteperiode bevor.

So warnte die Presse damals fast unisono vor dem kommenden „Cold Snap“ (Kälteeinbruch) und der „Spiegel“ schrieb am 12. August 1974, die Klimaabkühlung könnte zum Verhungern von einer Milliarde Menschen führen.

Zum Ende der 1980er Jahre hin verdrängte dann freilich das gegensätzliche Narrativ von der globalen Erwärmung die Warnungen vor der kommenden Eiszeit.

Seitdem war in wachsendem Maße davon die Rede, dass die Temperatur nicht sinken, sondern kontinuierlich steigen werde und der Mensch mit seinen Emissionen daran schuld sei. Nun liegen jedoch neue wissenschaftliche Erkenntnisse vor, welche das Szenario von einer drohenden Eiszeit doch nicht so unrealistisch erscheinen lassen, wie das Gros der Klimaforscher es heute gerne hätte.

So untersuchten Dan Lubin und David Tytler von der Universität von Kalifornien in San Diego mehr als 30 sonnenähnliche Sterne, die gerade ein starkes Aktivitätsminimum aufweisen, um abzuschätzen, wie weit sich die Strahlung unseres Gestirns im Vergleich zu heute abschwächen könnte. Dabei kamen sie auf einen Wert von immerhin bis zu sieben Prozent. Allerdings vertreten Lubin und Tytler die Ansicht, dass die hierdurch verursachte Abkühlung erst ab 2050 einsetzen werde.

Dahingegen erwartet die aus der Ukraine stammende Mathematikerin Valentina Zharkova von der Northumbria-Universität in Newcastle den Beginn der nächsten „Kleinen Eiszeit“ aufgrund der reduzierten Sonnenaktivität bereits 2021, wonach die Zahl der Sonnenflecken bis in die 2030er Jahre hinein um 60 Prozent zurückgehen – wie während des Maunder-Minimums. Das mathematische Modell vom Zharkova hat angeblich eine Vorhersagegenauigkeit von 97 Prozent.

Andere Forscher halten dagegen

Die dritte alarmierende Nachricht stammt von Martin Mlynczak vom Langley Research Center der NASA. Er verweist auf Daten des Forschungssatelliten TIMED, welcher die Verhältnisse in der oberen Erdatmosphäre untersucht und eine deutliche Abkühlung registriert hat. Für Mlynczak ist dies die Folge der verminderten Sonnenaktivität. Gleichzeitig meint der Wissenschaftler aber, die Messungen von TIMED stünden nicht im Widerspruch zu der herrschenden Meinung vom Temperaturanstieg in den unteren Bereichen der Lufthülle unseres Planeten.

Ähnlich argumentieren auch all jene, die unerschütterlich an der These von der menschengemachten globalen Erwärmung oder gar „Erhitzung“ festhalten, so wie beispielsweise die Mitarbeiter des Potsdam-Instituts für Klimafolgenforschung (PIK), das den Weltklimarat IPCC unterstützt, der wiederum den Takt im „Kampf gegen den Klimawandel“ vorgibt.

Zwar hüten diese sich, die eindeutigen wissenschaftlichen Befunde hinsichtlich der Schwankungen der Sonnenaktivität offiziell anzuzweifeln, behaupten aber, der möglicherweise bevorstehende Rückgang bei der Strahlungsintensität unseres Zentralgestirns werde kaum nennenswerte Auswirkungen zeitigen. Denn er könne nur zu einer Abkühlung von maximal 0,3 Grad führen, wohingegen der drohende Temperaturanstieg durch die ausgestoßenen Treibhausgase vier Grad betrage.

=================================================================

)* Anmerkung der EIKE-Redaktion :

Dieser Aufsatz ist zuerst erschienen in der Preußischen Allgemeinen Zeitung; 4. Dezember 2020, S.12; EIKE dankt der PAZ-Redaktion sowie dem Autor Wolfgang Kaufmann für die Gestattung der ungekürzten Übernahme, wie schon bei früheren Artikeln : https://www.preussische-allgemeine.de/

=================================================================

Klima-Prognosen „schlimmer als wir dachten“

Patrick J.Michaels, 14. Juli 2020

Da die Temperatur im Osten der USA normalerweise um die letzte Juliwoche ihr sommerliches Maximum erreicht, werden wir jedes Jahr um diese Zeit mit müden „Der Klimawandel ist schlimmer als wir dachten“ (WTWT)-Geschichten bombardiert. Die Produktion dieser Geschichten nimmt Zeit in Anspruch, von der Phantasie bis zur endgültigen Fassung, von der Redaktion bis zur Veröffentlichung, so dass sie gewöhnlich lange vor dem Sommermaximum eingereicht wurden. Daher die orchestrierte Angst.

Nun, mit dem WTWT-Narrativ stimme ich überein, aber nicht, soweit es das Klima betrifft, sondern nur, soweit es die Klimamodelle betrifft.

…

Quelle: Real Clear Energy

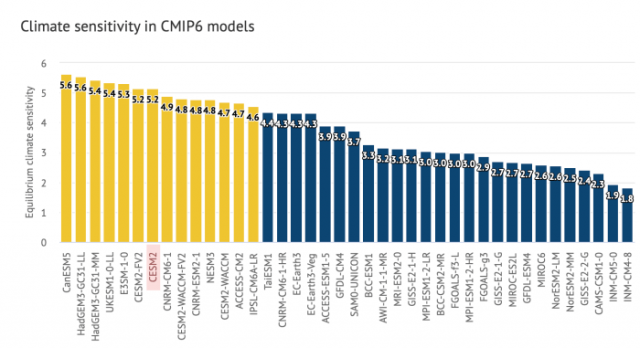

Pat Michaels fährt fort mit einer Diskussion über John Christys Analyse der CMIP5-Modelle, die zeigte, dass nur das russische INM-CM4-Modell und seine geringe Sensitivität (~2 ⁰C pro Verdoppelung) der Realität nahe kam. Folgende Graphik stammt aus dem Beitrag von Andy May vom November 2018:

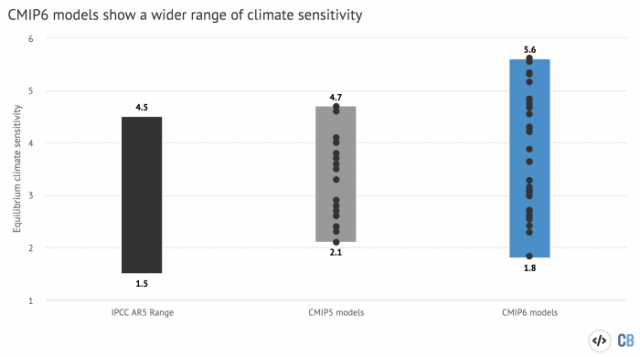

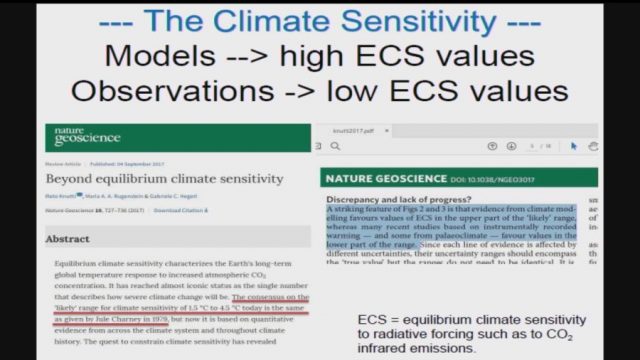

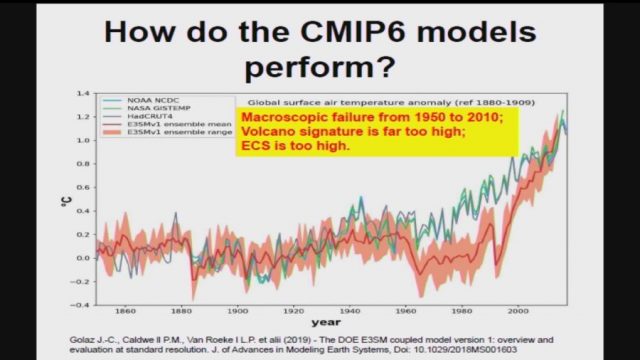

Dann stellt er fest, dass die neuen CMIP6-Modelle noch schlechter sind als CNMIP5:

Man sollte meinen, dass sich die Modellierer während der sieben Jahre zwischen CMIP5 und CMIP6 mit den grundlegenden Fehlern befasst, die alle anderen Modelle gemacht haben. Aber die CMIP6-Modelle sind out und in der Tat „schlechter als wir dachten“. Während ihr Fehler in der tropischen Atmosphäre dem des CMIP5 sehr nahe kommt (was nicht gut ist), ist die Bandbreite der globalen Vorhersagen noch größer als zuvor. Auch das ist kein gutes Zeichen, vor allem, weil dokumentiert ist, dass die Modelle „frisiert“ worden sind, um ein Ergebnis zu geben, welches das Modelliererteam sich wünscht.

Quelle: Real Clear Energy

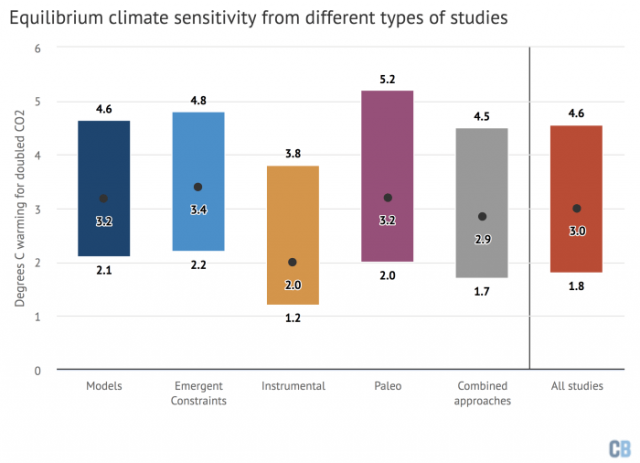

Das Komische ist, dass er einen Carbon Brief-Artikel von Zeke Hausfather zitiert, der eigentlich sehr gut ist. Die folgende Graphik stammt aus dem Artikel:

Mr. Hausfather stellt fest, dass Modelle mit hoher Sensitivität oft nicht einmal die Vergangenheit richtig wiedergeben:

Viele Modelle mit hoher Sensitivität liefern schlechte „Nachhersagen“

Klimamodelle liefern sowohl Projektionen der zukünftigen Erwärmung als auch „Nachhersagen“ vergangener Temperaturen. Diese „Hindcasts“ können als Werkzeug zur Bewertung der Leistung von Modellen verwendet werden, obwohl historische Temperaturen nur eine von vielen hundert verschiedenen Variablen sind, welche die Klimamodelle erzeugen.

Eine Reihe der Modelle mit höherer Sensitivität im CMIP6 hatten Schwierigkeiten, historische Temperaturen genau „hindcasten“ zu können. Einige zeigen so gut wie keine Erwärmung über das 20. Jahrhundert – wobei Kühleffekte durch Aerosole die steigenden Treibhausgaskonzentrationen in der Atmosphäre fast vollständig ausglichen – gefolgt von einer massiven Beschleunigung der Erwärmung während der letzten Jahrzehnte. Andere zeigen eine zu starke Erwärmung über die letzten 150 Jahre.

Quelle: Carbon Brief

Dann zeigte er folgenden ausgezeichneten Vergleich von Klima-Sensitivitäten, abgeleitet mittels vieler verschiedener Verfahren:

Klimasensitivitäten, die aus tatsächlichen Beobachtungsdaten (instrumentell) abgeleitet werden, ergeben Werte, die von harmlos bis leicht besorgniserregend reichen. Es ist auch wichtig zu beachten, dass die Gleichgewichts-Klimasensitivität (ECS) in Wirklichkeit ein Fake-Parameter ist. Was zählt, ist die transiente Klimareaktion (TCR), die im Allgemeinen nur etwa 2/3 der ECS ausmacht. Also würde ein ECS von 2 ⁰C wahrscheinlich einem TCR von 1,3 ⁰C entsprechen:

Im 3,5 °C ECS-Fall kommt es zum Zeitpunkt der Verdoppelung des atmosphärischen CO2 zu einer Erwärmung von etwa 2,0 °C. Die verbleibenden 1,5 °C der Erwärmung soll in den folgenden 500 Jahren eintreten … Aber sie wird wahrscheinlich deutlich innerhalb des Rauschens der natürlichen Variabilität liegen … Und ehrlich gesagt wird sich niemand die Mühe machen, diese Vorhersagen im Jahr 2520 zu überprüfen.

…

Link: https://wattsupwiththat.com/2020/07/15/pat-michaels-worse-than-we-thought/

Übersetzt von Chris Frey EIKE

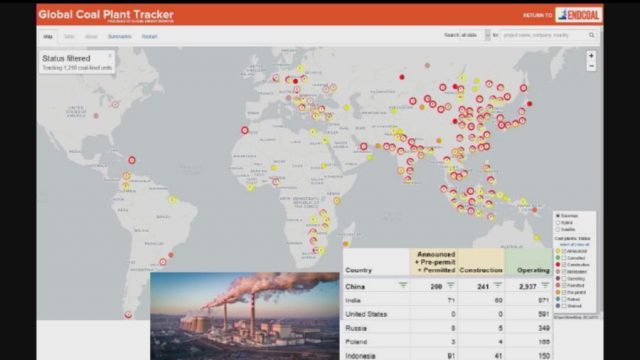

Indien importiert große Mengen an Kohle, Öl und Erdgas aus den USA, vor allem um erschwinglichen Strom für sein Stromnetz zu erzeugen. Dieses Netz muss schnell wachsen, um den Bedarf von über 1,3 Milliarden Menschen zu decken. Über 300 Millionen von ihnen – vergleichbar mit der gesamten US-Bevölkerung – haben derzeit keinen Zugang zu Strom. Aber sie brauchen ihn dringend für ihre Gesundheit und für ihren Weg aus der schweren Armut.

Die Rechtfertigung für die Reduktion des Verbrauchs fossiler Brennstoffe ist die Behauptung, dass der Klimawandel in der Zukunft verheerende Folgen haben wird, falls wir unsere Treibhausgasemissionen (THG) nicht reduzieren. Aber diese Behauptung steht nicht auf so festem Boden wie es die Mainstream-Medien und Politiker behaupten.

Tatsächlich deuten die Temperaturdaten darauf hin, dass die Behauptung übertrieben ist und tendenziell durch falsche Interpretationen fehlerhafter Modelle beeinflusst wird.

Das niemals endende Problem mit Modellen

Das Pariser Klimaabkommen und andere wichtige Klimaschutz-Vorgaben der Vereinten Nationen basieren strikt auf den Richtlinien, die in den Zustandsberichten eines als Intergovernmental Panel for Climate Change (IPCC) bekannten Klima-Flügels enthalten sind.

Der IPCC verwendet Vorhersagedaten, die von einer Vielzahl von Computer-Klimamodellen verarbeitet werden, um zu den politischen Empfehlungen in seinen Zustandsberichten zu gelangen.

Darunter sind auch Prognosen des Coupled Model Inter-Comparison Project (CMIP). CMIP besteht aus 100 verschiedenen Klimamodellen, die von führenden Modellierungsgruppen auf der ganzen Welt betrieben werden. Ihre Vorhersagen bilden die Grundlage für die Berichte des IPCC. Im Jahr 2013 enthielt der fünfte IPCC-Zustandsbericht (AR5) Klimamodelle des CMIP5 (fünfte Generation).

Doch die Prognosen dieser Modelle erwiesen sich als falsch. Sie übertrieben den Temperaturtrend und unterschieden sich deutlich von den Temperaturdaten, die von bodengestützten Thermometern, Sensoren an Wetterballons, Flugzeugen, Schiffen und Bojen, Satelliten-Fernerkundung und „Reanalysen“ abgeleitet wurden – letztere integrierten die Eingabe vieler verschiedener Datenquellen.

Dennoch nutzten weltweit für die Festlegung der Klima- und Energiepolitik zuständigen politischen Beauftragten diese Prognosen, um internationale Klimaabkommen wie das Pariser Abkommen zu rechtfertigen – und hören damit auch nicht auf.

Der bevorstehende sechste IPCC-Zustandsbericht (AR6), dessen Veröffentlichung für 2021 geplant ist, enthält Prognosen des CMIP6. Die CMIP6-Modelle erweisen sich jedoch als nicht besser als die CMIP5-Modelle. Tatsächlich sind die CMIP6-Modelle sogar schlechter!

Der leitende Klimatologe Dr. Roy Spencer hat beobachtet, dass „die CMIP6-Modelle von 1979 bis April 2020 eine um 50 Prozent höhere Nettooberflächenerwärmung (+1,08 Grad Celsius) zeigen als tatsächlich vom Boden aus gemessen (+0,72 Grad Celsius)“.

Zweifellos offenbart der Vergleich der CMIP5- und CMIP6-Vorhersagen mit den offiziellen HadCRUT-Temperaturdatensätzen eine sehr alte Geschichte: Modelle liegen bei der Vorhersage von Temperaturen in der realen Welt immer weit daneben und – verdächtigerweise – immer in die gleiche Richtung, nämlich nach oben.

Wir werden also nicht nur bezüglich des Klimas belogen, sondern werden durch den nächsten IPCC-Zustandsbericht erneut in die Irre geführt. Und mit noch extremeren falschen Prognosen wird es Forderungen nach einer noch restriktiveren Energiepolitik geben.

Es ist ziemlich erstaunlich, wie die nicht gewählten Politiker bei der UNO die führenden Politiker der Welt davon überzeugen und dazu überreden können, eine Klimapolitik zu verfolgen, die auf unwissenschaftlichen Schlussfolgerungen aus fehlerhaften Modellen beruht.

Auch die Mainstream-Medien haben ihren Teil dazu beigetragen. Die öffentliche Wahrnehmung des Klimawandels wurde stark durch eine voreingenommene Berichterstattung über das Klima-„Problem“ beeinflusst, wobei den enormen Diskrepanzen zwischen den Modellprognosen und den Beobachtungen in der realen Welt keine große Aufmerksamkeit geschenkt wurde.

Es ist nicht klar, um wie viel fehlerhafter die Projektionen bis zur endgültigen Veröffentlichung des neuen Bewertungsberichts werden. Aber eines ist klar: Die Energieversorgung auf der ganzen Welt wird durch pseudowissenschaftliche Interpretationen des Klima-Flaggschiffs der Vereinten Nationen in Geiselhaft genommen.

Vijay Jayaraj (M.Sc., Environmental Science, University of East Anglia, England), is a Research Contributor for the Cornwall Alliance for the Stewardship of Creation living in New Delhi, India

Übersetzt von Chris Frey EIKE

Ein Gedankenexperiment

Hier ist das Gedankenexperiment: Wir wollen eine Verbindung herstellen, die irgendwie Farbe erzeugt (der Mechanismus, wie sie das macht, ist nicht wirklich relevant). Wir wollen jedoch speziell eine gut definierte Farbe, die von der Anwendung, für die sie verwendet werden soll, vorgeschrieben wird. Sagen wir einen Türkis-Ton.

Nun haben unsere Geologen und Chemiekollegen einige Mineralien und Verbindungen vorgeschlagen, die Kandidaten für unser buntes Unternehmen sein könnten. Leider gibt es keinerlei Informationen darüber, welche Farben diese Stoffe produzieren. Dieser Umstand wird noch dadurch verstärkt, dass die Minerale äußerst selten und daher extrem teuer sind, während synthetische Minerale wirklich schwierig herzustellen und daher noch teurer sind. Wie gehen wir also vor, wie finden wir die besten Verbindungen, die wir ausprobieren können? Es kommt nicht in Frage, von jeder der vielen Verbindungen ein Muster zu bekommen und jede von ihnen auf die Farbe zu testen, die sie erzeugt. Was wir also tun, ist, die Physik des Farbe erzeugenden Prozesses für jede der vorgeschlagenen Verbindungen zu modellieren, um diejenigen zu finden, die Türkis erzeugen, falls es welche gibt. Das klingt einfach genug, ist es aber nicht, weil es mehrere verschiedene Codes gibt, nämlich insgesamt 5, die vorgeben, eine solche Simulation durchzuführen, jeder mit seinen eigenen zugrunde liegenden Annahmen und Eigenheiten. Wir führen diese Codes für die vorgeschlagenen Verbindungen durch und stellen fest, dass die Farben, die sie prognostizieren, leider für einzelne Verbindungen und im Allgemeinen überall uneinheitlich sind.

Nehmen Sie zum Beispiel die Verbindung Novelium1. Die vorhergesagten Farben reichen von Gelbgrün bis zu tiefem Violett mit einigen wenigen dazwischen wie Grün, Blau oder Ultramarin, ein Frequenzbereich mit dem Faktor 1,3; ähnlich für die anderen Kandidaten. In dieser Situation ist der einzige Weg vorwärts ein Experiment. Also graben wir tief in das Budget hinein und besorgen uns eine Probe von Novelium1, um zu sehen, welche Farbe es tatsächlich produziert. Es stellt sich als orange-rot heraus, was ziemlich enttäuschend ist. Wir sind wieder da, wo wir angefangen haben. Und wegen unserer Haushaltsbeschränkungen sind wir an dem Punkt, an dem wir aufgeben müssen.

Hier wollen wir ein Mitglied unseres Teams vorstellen. Nennen wir es Mike. Mike ist ein bisschen aufdringlich, weil ihm völlig klar ist, dass wir, wenn wir unser Ziel erreichen sollten, den einen oder anderen prestigeträchtigen Preis bekommen würden, etwas, worauf er ziemlich scharf ist. Er schlägt Folgendes vor: Wir nehmen das Modell, das die Farbe vorhergesagt hat, die der tatsächlichen Farbe am nächsten kommt, das ist das Modell, das uns Gelb-Grün gegeben hat, und passen seine Parameter so an, dass es stattdessen Orange-Rot vorhersagt. Das ist nicht allzu schwierig, und nach ein paar Tagen, in denen er auf einer Tastatur herumtüftelt, kommt er mit einem angepassten Modell, das die beobachtete Farbe erzeugt. Geschicklichkeit rundherum, bis auf ein oder zwei weitere skeptische Teammitglieder, die darauf bestehen, dass das neue Modell validiert werden muss, indem es die Farbe der Verbindung Novelium2 korrekt vorhersagen lässt. Da der Preis darauf beruht, ist dies eindeutig ein Muss, also kratzen wir den Boden des Budgets ab und wiederholen die Übung für Novelium2. Das angepasste Modell sagt Gelb voraus. Das Experiment ergibt Orange.

Wir gaben auf.

Was bedeutet das nun?

Können wir irgendetwas Nützliches hieraus ableiten? Um das herauszufinden, müssen wir drei Fragen beantworten.

Erstens: Was wissen wir nach der ersten Phase des Projekts, der Modellierungsübung, bevor wir das Experiment durchführten? Bedauerlicherweise lautet die Antwort: nichts Nützliches. Bei 5 verschiedenen Ergebnissen wissen wir nur mit Sicherheit, dass mindestens 4 der Modelle falsch sind, aber nicht welche. Selbst wenn die von uns gewünschte Farbe (Türkis) auftaucht, wissen wir immer noch nichts. Denn wie kann man sicher sein, dass der Code, der ihn erzeugt, das „richtige Ergebnis“ ist, wenn man die Ergebnisse der a priori gleichwertigen anderen Modelle berücksichtigt? Das kann man nicht. Wenn ein Modell uns Türkis gab, könnte es einfach ein glücklicher Zufall sein, wenn das Modell selbst noch fehlerhaft ist. Allein die Tatsache, dass die Modelle sehr unterschiedliche Ergebnisse liefern, sagt uns daher, dass höchstwahrscheinlich alle Modelle falsch sind. Tatsächlich ist es sogar noch schlimmer: Wir können nicht einmal sicher sein, dass die von Novelium1 erzeugte Echtfarbe im Bereich von Gelbgrün bis Violett liegt, selbst wenn es ein Modell gäbe, das die von uns gewünschte Farbe erzeugt. Im Anhang gebe ich eine einfache, auf Wahrscheinlichkeit basierende Analyse zur Unterstützung dieses und der folgenden Punkte.

Zweitens, was wissen wir nach dem unerwarteten Ausgang des eigentlichen Experiments? Wir wissen nur mit Sicherheit, dass alle Modelle falsch sind (und dass es nicht die gesuchte Verbindung ist).

Drittens: Warum ist Mikes kleiner Trick so kläglich gescheitert? Was ist da passiert? Die Parametereinstellung des ursprünglichen, ungefilterten Modells verkörpert das beste Verständnis der Physik – von seinen Machern, wenn auch unvollständig, aber das ist nicht wirklich relevant –, die ihm zugrunde liegt. Durch Modifizierung dieser Parameter wird dieses Verständnis verwässert, und wenn die „Feinabstimmung“ weit genug geht, verschwindet es vollständig, so wie die Grinsekatze verschwindet, je mehr man sie ansieht. Ein solches Modell im Nachhinein so zu optimieren, dass es an die Beobachtungen angepasst werden kann, ist daher gleichbedeutend mit dem Verzicht auf die Behauptung, dass man die dem Modell zugrundeliegende relevante Physik versteht. Jeglicher Vorwand, das Thema wirklich zu verstehen, verschwindet aus dem Fenster. Und mit ihm geht jede Vorhersagekraft, die das ursprüngliche Modell gehabt haben könnte. Ihr Modell ist gerade zu einer weiteren sehr komplexen Funktion geworden, die in einen Datensatz eingepasst wurde. Bekannt ist der Ausspruch des Mathematikers und Physikers John von Neumann über eine solche Praxis: „Mit vier Parametern kann ich einen Elefanten anpassen, und mit fünf kann ich ihn dazu bringen, mit dem Rüssel zu wackeln“. Bei dem optimierten Modell handelt es sich wahrscheinlich um ein neues, falsches Modell, das zufällig eine Übereinstimmung mit den Daten ergab.

Eine Anwendung auf Klimamodelle

Bewaffnet mit den Erkenntnissen aus der vorstehenden Geschichte sind wir nun in der Lage, einige grundsätzliche Aussagen zu den IPCC-Klimamodellen zu machen, zum Beispiel zu der Gruppe der 31 Modelle, die das CIMP6-Ensemble bilden (Eyring et al., 2019; Zelinka et al., 2020). Die interessierende Größe ist der Wert der Gleichgewichts-Klimasensitivität [Equilibrium Climate Sensitivity (ECS)], die erwartete langfristige Erwärmung nach einer Verdoppelung der atmosphärischen CO2-Konzentrationen. Die vorhergesagten ECS-Werte im Ensemble umfassen einen Bereich von 1,8°C am unteren Ende bis 5,6°C am oberen Ende, ein kolossaler Faktor 3 im Bereich, der von den 31 Modellen mehr oder weniger gleichmäßig belegt wird. Die Natur mag listig, ja sogar hinterhältig sein, aber sie ist nicht bösartig. Es gibt nur einen „wahren“ ECS-Wert, der der Verdoppelung der CO2-Konzentration in der realen Welt entspricht.

Können wir eine Erklärung zu diesem Ensemble abgeben? Nur diese beiden Beobachtungen:

Erstens, höchstwahrscheinlich sind all diese Modelle falsch. Diese Schlussfolgerung ergibt sich logisch aus der Tatsache, dass es viele a priori gleich gültige Modelle gibt, die nicht gleichzeitig richtig sein können. Höchstens eines dieser Modelle kann richtig sein, aber angesichts der übrigen 30 falschen Modelle stehen die Chancen schlecht, dass überhaupt ein Modell richtig ist. Tatsächlich lässt sich zeigen, dass die Wahrscheinlichkeit, dass keines der Modelle korrekt ist, bis zu 0,6 betragen kann.

Zweitens können wir nicht einmal sicher sein, dass die wahre ECS im Bereich der von den Modellen erfassten ECS-Werte liegt. Die Wahrscheinlichkeit, dass dies der Fall ist, liegt bei 1,0-0,6=0,4, was bedeutet, dass die Wahrscheinlichkeit, dass die wahre ECS in dem von den Modellen abgedeckten Bereich liegt, etwa 2 bis 3 beträgt (und damit die Wahrscheinlichkeit, dass die wahre ECS außerhalb des Bereichs liegt). Die oft gemachte Annahme, dass der „wahre“ ECS-Wert irgendwo im Bereich der Ergebnisse der Modelle im Ensemble liegen muss, basiert auf einem logischen Trugschluss. Wir haben absolut keine Ahnung, wo das „wahre“ Modell – Nummer 32, das „Experiment“ – innerhalb oder außerhalb der Spanne landen würde.

Es sind einige Einschränkungen zu machen. Was bedeutet es zum Beispiel: Das Modell ist „falsch“? Es bedeutet, dass es unvollständig sein könnte – es fehlen Konzepte oder Prinzipien, die in ihm vorhanden sein sollten – oder umgekehrt überkomplett – mit Dingen, die vorhanden sind, aber nicht vorhanden sein sollten – oder dass es Aspekte enthält, die einfach falsch oder falsch kodiert sind, oder alles davon. Da viele Ensemble-Modelle ähnliche oder sogar identische Elemente haben, könnte man ferner argumentieren, dass die Ergebnisse der Ensemble-Modelle nicht unabhängig sind, dass sie korreliert sind. Das bedeutet, dass man die „effektive Anzahl“ N der unabhängigen Modelle berücksichtigen sollte. Wenn N = 1 wäre, würde dies bedeuten, dass alle Modelle im Wesentlichen identisch sind, wobei der Bereich von 1,8°C bis 5,6°C ein Hinweis auf den intrinsischen Fehler wäre (was eine ziemlich schlechte Darstellung wäre). Wahrscheinlicher ist, dass N irgendwo im Bereich von 3 bis 7 liegt – mit einer intrinsischen Streuung von z.B. 0,5°C für ein einzelnes Modell – und wir sind wieder bei dem hypothetischen Beispiel oben.

Die Wahrscheinlichkeit von etwa 3 zu 2, dass keines der Modelle richtig ist, dürfte politisch interessant sein. Würden Sie mit diesen Quoten viel von Ihrem hart verdienten Geld auf ein Pferd setzen? Ist es klug, die Energieversorgung und damit die gesamte Wirtschaft Ihres Landes auf solche Quoten zu setzen?

Nachhersage

Ein anonymer Rezensent einer meiner früheren Schriften gab diesen offenen Kommentar ab, und ich zitiere:

Die Erfolgsbilanz der GCM’s ist insofern enttäuschend, als sie nicht in der Lage waren, den beobachteten Temperatur-Stillstand nach dem Jahr 2000 vorherzusagen, und auch nicht vorhersagen konnten, dass die Tropopausentemperaturen in den letzten 30 Jahren nicht gestiegen sind. Das Versagen der GCMs ist nicht auf Fehlverhalten zurückzuführen, aber die Modellierung des Erdklimas ist eine große Herausforderung.

Der wahre Wissenschaftler weiß, dass Klimamodelle noch in Arbeit sind. Der Pseudowissenschaftler, der unter dem Druck steht, die „Vorhersagen“ zu halten, muss einen Weg finden, um die Modelle und die Temperaturdaten der realen Welt „in Einklang zu bringen“.

Eine Möglichkeit dazu besteht darin, die Temperaturdaten in einem Prozess zu massieren, der „Homogenisierung“ genannt wird (z.B. Karl et al., 2015). Auf wundersame Weise verschwindet der „Stillstand“. Ein merkwürdiger Aspekt einer solchen „Homogenisierung“ ist, dass bei jeder Anwendung die „angepassten“ vergangenen Temperaturen immer niedriger sind, wodurch die angeblich „künstliche Erwärmung“ größer wird. Niemals andersherum. Offensichtlich kann man diesen kleinen Handgriff nur einmal ausführen, vielleicht zweimal, wenn niemand zusieht. Aber danach wird selbst der Dorftrottel verstehen, dass er reingelegt wurde, und die „Homogenisierung“ in den gleichen Mülleimer der Geschichte werfen wie Lysenkos „Vernalisierung“.

Der andere Weg ist die Anpassung der Modellparameter an die Beobachtungen (z.B. Hausfather et al., 2019). Angesichts der vielen anpassbaren Parameter und unter Berücksichtigung von von Neumans Witz ist es nicht überraschend, dass die Modelle durch eine solche „Nachhersage“ recht gut an die Daten angepasst werden können. In der kriecherischen Mainstream-Presse herrscht überall Eifer, mit manchmal urkomischen Ergebnissen. So verkündete beispielsweise ein Korrespondent einer überregionalen niederländischen Zeitung enthusiastisch, dass die Modelle die Temperaturen der letzten 50 Jahre korrekt vorhergesagt hätten. Dies wäre wirklich eine bemerkenswerte Leistung, denn die früheste Software, die als „Klimamodell“ betrachtet werden kann, stammt aus den frühen 1980er Jahren. Eine interessantere Frage ist jedoch: Können wir erwarten, dass ein derart angepasstes Modell eine Vorhersagekraft hat, insbesondere im Hinblick auf die Zukunft? Die Antwort ist ein schallendes „Nein“.

Sind Klimamodelle nutzlos?

Natürlich nicht. Sie können sehr nützlich sein als Werkzeuge zur Erforschung jener Aspekte der Physik der Atmosphäre und des Klimasystems, die noch nicht verstanden werden oder deren Existenz noch nicht bekannt ist. Wofür man sie nicht verwenden kann, sind Vorhersagen.

[Hervorhebung vom Übersetzer]

References:

Eyring V. et al. Nature Climate Change, 9, 727 (2019)

Zelinka M. et al. Geophysical Research Letters, 47 (2020)

Karl T.R., Arguez A. et al. Science 348, 1469 (2015)

Hausfather Z., Drake H.F. et al. Geophysical Letters, 46 (2019)

[Es folgt eine interessante Beschreibung der Bestimmung der Wahrscheinlichkeit, mit der ein bestimmtes Modell korrekt ist. Das ist das tägliche Brot eines Wetter-Prognostikers. Ein Faktor wird hierbei aber nicht erwähnt: Die Erfahrung eines seit Jahrzehnten praktizierenden Wetter-Prognostikers ist ein sehr gewichtiger statistischer Faktor, ist doch Erfahrung nichts anderes als Statistik. Dennoch, kein seriöser Prognostiker würde eine Prophezeiung, die über höchstens eine Woche hinausgeht, als Prognose bezeichnen – und sie schon gar nicht zu einer Grundlage schwer wiegender Entscheidungen machen.

Diese allgemein theoretische Betrachtung wird hier nicht mit übersetzt. Anm. d. Übers.]

Addendum: an analysis of probabilities

First the case of 5 models of which at most 1 can possibly be right. What is the probability that none of the models are correct? All models are a priori equally valid. We know that 4 of the models are not correct, so we know at once that the probability of any model being incorrect is at least 0.8. The remaining model may or may not be correct and in the absence of any further information both possibilities could be equally likely. Thus, the expectation is that, as a matter of speaking, half a model (of 5) is correct, which means the a priori probability of any model being incorrect is 0.9. For N models it is 1.0-0.5/N. The probability that all models fail then becomes: F=(1-0.5/N)^N which is about 0.6 (for N > 3). This gives us odds of 3 to 2 that none of the models are correct and it is more likely that none of the models are correct than that one of them is. (If we had taken F=(1-1/N)^N the numbers are about 0.34 with odds of 1 to 2)

Now an altogether different question. Suppose one of the models does give us the correct experimental result, what is the a posteriori probability that this model is indeed correct, given the results of the other models? Or, alternatively, that the model is incorrect even when it gives the ‘right’ result (by coincidence)? This posterior probability can be calculated using Bayes’ theorem,

P(X|Y) = P(Y|X)*P(X)/P(Y),

where P(X|Y) stands for the probability of X given Y and P(X) and P(Y) are prior probabilities for X and Y. In this case, X stands for ‘the model is incorrect’ and Y for ‘the result is correct’, in abbreviated form M=false, R=true. So the theorem tells us:

P(M=false|R=true) = P(R=true|M=false) * P(M=false) / P(R=true)

On the right-hand side the first term denotes the false-positive rate of the models, the second term is the probability that the model is incorrect and the third is the average probability that the result predicted is accurate. Of these we already know P(M=false)=0.9 (for 5 models). In order to get a handle on the other two, the ‘priors’, consider this results table:

The ‘rate’ columns represent a number of possible ensembles of models differing in the badness of the incorrect models. The first lot still give relatively accurate results (incorrect models that often return the about correct result, but not always; pretty unrealistic). The last with seriously poor models which on occasion give correct results (by happy coincidence) and a number of cases in between. Obviously, if a model is correct there is no false-negative (TF) rate. The false-positive rate is given by P(R=true|M=false) = FT. The average true result expected is given by 0.1*TT + 0.9*FT = 0.82 for the first group, 0.55 for the second and so on.

With these priors Bayes’ Theorem gives these posterior probabilities that the model is incorrect even if the result is right: 0.87, 0.82 etc. Even for seriously poor models with only a 5% false positive rate (the 5th set) the odds that a correct result was made by an incorrect model are still 1 to 2. Only if the false positive rate (of the incorrect models) drops dramatically (last column) can we conclude that a model that produces the experimental result is likely to be correct. This circumstance is purely due to the presence of the incorrect models in the ensemble. Such examples shows that in an ensemble with many invalid models the posterior likelihood of the correctness of a possibly correct model can be substantially diluted

Link: https://wattsupwiththat.com/2020/07/01/the-climate-model-muddle/

Bearbeitet von Chris Frey EIKE

Wolkendaten: Worst-case–Szenarien könnten zu schwach sein.

Modellierungen legen nahe, dass das Klima deutlich sensitiver auf Kohlenstoff-Emissionen reagiert als bisher gedacht.

Jonathan Watts @jonathanwatts

Sat 13 Jun 2020 16.00 AEST

Modellergebnisse von über 20 Institutionen werden für den Sechsten Zustandsbericht des IPCC berücksichtigt, dessen Veröffentlichung für das nächste Jahr geplant ist.

Verglichen mit der letzten Bewertung im Jahr 2014 zeigen 25% von ihnen eine starke Verschiebung der Klimasensitivität von 3°C zu 5°C nach oben – dem Ausmaß der Erwärmung, das von einer Verdoppelung des atmosphärischen Kohlendioxids gegenüber dem vorindustriellen Niveau von 280 Teilen pro Million ausgeht. Dies hat viele altgediente Beobachter schockiert, da die Annahmen zur Klimasensitivität seit den 1980er Jahren relativ unverändert geblieben sind.

„Das ist eine sehr tiefe Besorgnis“, sagte Johan Rockström, der Direktor des Potsdam-Instituts für Klimafolgenforschung. „Klimasensitivität ist der heilige Gral der Klimawissenschaft. Sie ist der wichtigste Indikator für das Klimarisiko. Seit 40 Jahren liegt sie bei 3°C. Jetzt sehen wir plötzlich große Klimamodelle auf den besten Supercomputern, die zeigen, dass es schlimmer kommen könnte, als wir dachten“.

…

Timothy Palmer, Professor für Klimaphysik an der Universität Oxford und Mitglied des Beirats des Met Office, sagte, die hohe Zahl mache die Wissenschaftler zunächst nervös. „Sie lag weit außerhalb früherer Schätzungen. Die Leute fragten, ob es einen Fehler im Code gab“, sagte er. „Aber es lief auf relativ kleine Änderungen in der Art und Weise hinaus, wie die Wolken in den Modellen dargestellt werden“.

…

Mehr hier.

[*Bemerkung: Diesen Unsinn habe ich – anders als die übrigen Passagen von Worrall in diesem Beitrag! – dem Linguee-Übersetzer anvertraut. Anm. d. Übers.]

Vor einem Monat berichtete WUWT hier von einer Studie, die nachwies, dass die neuen Projektionen höchster Klima-Sensitivität (vor allem CESM2) inkompatibel mit historischen Aufzeichnungen sind.

CESM2, eines der neuen Modelle, simuliert im Nachhinein [„Nachhersage“] Temperaturen in den Tropen über 55°C im frühen Eozän. Das sind Temperaturen, bei denen Photosynthese nicht mehr möglich ist, was leblose tropische Wüsten zur Folge gehabt hätte.

Die fossilen Aufzeichnungen sagen jedoch etwas gänzlich anderes; das frühe Eozän war eine Ära mit üppigem und blühendem tropischen Leben.

„Einige der neuesten Modelle, die zur Erstellung von Zukunftsprognosen verwendet werden, reagieren möglicherweise zu empfindlich auf den Anstieg des atmosphärischen Kohlendioxids und prognostizieren daher eine zu starke Erwärmung„, sagte Chris Poulsen von der U-M, Professor im Department of Earth and Environmental Sciences der U-M und einer der drei Autoren der Studie.— Quelle: Science Daily

Poulsens Team besteht nicht aus Klimaskeptikern. Sie legten nahe, dass CESM1.2, der Vorgänger von CESM2, „bemerkenswert gut“ bei der Simulation der Temperatur im frühen Eozän war. CESM1.2 geht von einer Gleichgewichts-Klimasensitivität von 4,2°C aus, CESM2 von einer solchen von 5,2°C.

Link: https://wattsupwiththat.com/2020/06/13/climate-scientists-step-up-the-climate-emergency-narrative/

Übersetzt von Chris Frey EIKE

Wir verordnen dem gesamten Land [= den USA] einen Shutdown auf der Grundlage der Modelle des Institute for Health Metrics and Evaluation (IHME), womit wir 17 Millionen Amerikaner arbeitslos gemacht haben (Tendenz weiter steigend), 17 Millionen Leben auf den Kopf gestellt haben (Tendenz weiter steigend) und … Nun, man schaue selbst:

[Dieser Graphik für die gesamten USA folgen im Original die Einzelgraphiken der US-Staaten Tennessee, Georgia und Florida. Sie sehen sehr ähnlich aus. Anm. d. Übers.]

Für die CNN-Klimaille … dieser gigantische Berg ist die Prophezeiung des IHME von 1. April bzgl. Einweisungen ins Krankenhaus wg. Coronavirus. Die kleineren Berge weit, sehr weit darunter sind die entsprechenden IHME-Prophezeiungen nach einer Überarbeitung jeweils vom 5., 7. und 9. April.