Das totalitäre Klimagebäude (2): Zehn fragwürdige Kernbehauptungen

Damit man auch nur in die Nähe einer solchen Vorstellung käme, müsste das komplette Narrativ der totalitären Klimabewegung zweifelsfrei zutreffen, das im Wesentlichen aus den nachfolgend skizzierten zehn Punkten besteht:

- Die globalen Temperaturen (auf der Erdoberfläche, wo die Menschen leben, sowie Tiere und Pflanzen) steigen in bedeutender Weise an, schon seit vielen Jahrzehnten, und dies ist eine ungewöhnliche, „unnatürliche“ Entwicklung.

- Dieser Anstieg beruht auf dem „Treibhauseffekt“, der durch zunehmende Umfänge von CO2 in der Atmosphäre hervorgerufen wird.

- Das zusätzliche CO2 ist verschuldet durch die industrialisierte Menschheit und ihre Verbrennung von fossilen Energieträgern: Kohle, Gas, Öl vor allem.

- Der (eigentlich eher geringe) „Treibhauseffekt“ des CO2 ist trotzdem gefährlich und Ursache der Temperaturanstiege, weil es einen „Feedback“-Effekt durch Wasserdampf gibt, der die Sache um ein Vielfaches schlimmer macht.

- Natürliche Ursachen für Klimawandel / veränderliche globale Durchschnitts-Temperaturen sind praktisch irrelevant: keine Ausreden für die Menschheit.

- Die immer höheren Temperaturen „bringen das ganze Klima durcheinander“, führen zu massiven Naturkatastrophen weltweit, die Menschenleben bedrohen. [Darunter auch ein bedrohlicher Anstieg der Meeresspiegel und die „Übersäuerung“ der Ozeane.]

- Wie es mit dem CO2-Anstieg und den Folgen für das Klima weitergeht, kann in den Computer-Modellen der „Klimawissenschaft“ seriös nachvollzogen und auf viele Jahrzehnte hinaus vorhergesagt werden.

- Selbst wenn es noch gewisse Unsicherheiten geben sollte: es gilt das „Vorsorgeprinzip“, also besser heute schon aktiv werden, ehe die Dinge ganz außer Kontrolle geraten.

- Dieser „Klimawandel“ ist also hochgefährlich und muss unbedingt verhindert werden.

- Der Prozess kann signifikant gebremst und schlimme Folgen vermieden werden, wenn vor allem die westlichen Industrienationen auf fossile Energie-Erzeugung verzichten und „dekarbonisieren“.

Damit ganz klar wird, was diese Liste bedeutet: Das sind nicht etwa „zehn gute Argumente“ dafür, warum „Klimaschutz“ notwendig ist, unabhängig voneinander. Es ist vielmehr eine Beweis- oder Indizienkette, die nur so stark ist wie ihr schwächstes Glied. Jeder der zehn Punkte ist eine Achillesferse, sodass es sich bei dem ganzen Narrativ um eine höchst wackelige Angelegenheit handelt, um ein argumentatives Kartenhaus: Selbst wenn nur einer der zehn Punkte falsch wäre, würde es in sich zusammenfallen.

Tatsächlich müssen hinter jeden der zehn Punkte Fragezeichen gesetzt werden. Manche Einzelbeobachtung oder Theorie hat womöglich etwas für sich, aber das meiste ist mindestens fragwürdig und vieles ist schlicht und einfach falsch, nachweisbar. Wenn juristische Maßstäbe eines Gerichtsverfahrens gelten würden: Hier gibt es nicht nur „vernünftige Zweifel“ daran, dass die gesamte Aussage zutrifft. Diese „Beweisführung“ ist dermaßen wackelig, dass eine nüchterne Staatsanwaltschaft schon darauf verzichten würde, überhaupt Klage zu erheben, um sich nicht vor einem seriösen Gericht in Grund und Boden zu blamieren.

Was man dazu wissen muss

Zu jedem der zehn Punkte ließe sich eine lange (wissenschaftliche) Abhandlung produzieren, und viele kluge Darstellungen kursieren ja schon längst im Internet, in Form von Aufsätzen, Büchern, Vorträgen, Videos. (Ja, es ist ein ziemlich unübersichtliches Themenfeld, das einen naturwissenschaftlichen Laien auch leicht verunsichern kann. Wenn die Dinge ganz simpel wären, hätten wir das Problem nicht.) Nachfolgend, auch als Startpunkt für jedermanns eigene weitere Befassung mit dem Thema, kritische Hinweise zu den zentralen zehn Punkten der Klima-Aktivisten:

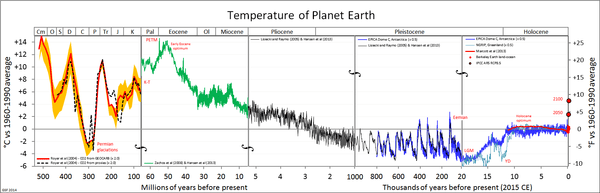

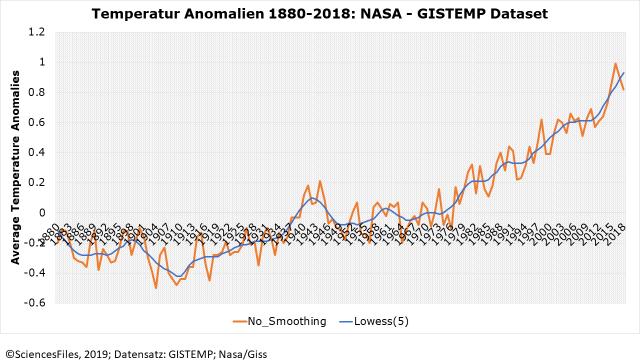

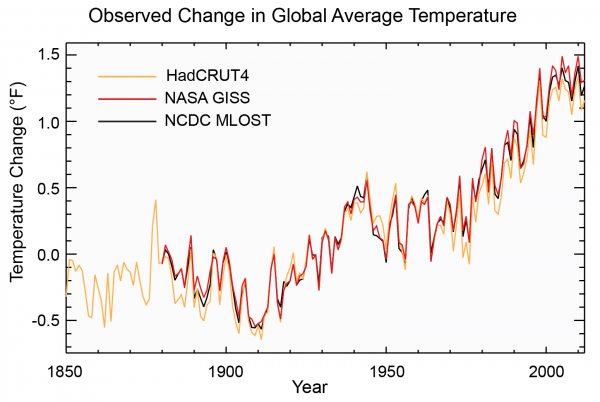

- („Global warming“ als „unnatürliche“ Entwicklung). Das Temperaturniveau auf der Erde lässt sich nicht so leicht aussagekräftig auf Zehntel-Celsius-Grade genau messen (um die es aber überhaupt nur geht!), erst recht kennen wir die Zustände der Vergangenheit nicht präzise, schon für das 19. Jahrhundert nicht, außerhalb kleiner Teile der (bewohnten) Erdoberfläche. Es hat aber immer schon deutliche Temperaturschwankungen gegeben, auch viel massivere. So hat die Erde zuletzt mehrere Eiszeiten erlebt. Wir sind gegenwärtig – in geologischen Maßstäben – immer noch am Ausgang der letzten Eiszeit und in kürzeren Maßstäben immer noch am Ende der „kleinen Eiszeit“ der frühen Neuzeit.

- (CO2-Treibhauseffekt als Ursache)

Schon die Korrelation (der synchrone Verlauf) zwischen Temperaturen und CO2-Gehalt der Atmosphäre ist in geologischen Maßstäben nicht nur fraglich, sondern weitgehend nicht-existent; soweit in jüngerer Erdzeit die Korrelation existiert, scheint die Temperatur dem CO2-Gehalt voranzugehen; jedenfalls kann die Korrelation auch auf einen dritten Faktor zurückgehen oder die Kausalität kann sogar „andersrum“ funktionieren: - (Zusätzliches CO2 in der Atmosphäre durch Menschheit verursacht)

Wenn es wärmer wird, können die Ozeane weniger CO2 binden, sie „gasen aus“. In den Ozeanen sind unvergleichlich größere Mengen CO2 „gespeichert“ als in der Atmosphäre (etwa Faktor 50). Biologisch und geologisch spricht man von einem (kleinen und großen) Kohlenstoff-Kreislauf, der auch die Gebirge und Gesteinsformationen (aus Calcium-Carbonat / Kalkstein) umfasst, sowie natürlich das gesamte Pflanzen- und Tierleben auf der Erde. - (Treibhauseffekt massiv verstärkt durch „Feedback“)

Der tatsächliche, physikalisch unstreitig vorhandene „Treibhauseffekt“ von CO2 ist nach neueren, experimentell-labormäßig gestützten Berechnungen geradezu lächerlich gering. Ob das angebliche „Feedback“ durch Wasserdampf die ihm zugeschriebene massive Verstärkung bewirken kann, ist sehr zweifelhaft, denn mehr Wasserdampf führt auch zu mehr Wolken, die die Erde beschatten und damit abkühlen. Es spricht aus meteorologischer Sicht vieles dafür, dass die Wolkenbildung in der Atmosphäre eine Art natürlichen „Thermostaten“ ergibt, der Klima-Auswüchse verhindert, anstatt sie zu verstärken. Wenn schon die geringste – wodurch auch immer hervorgerufene – Erwärmung irgendwo im regionalen Wetter einen „Feedback“-Effekt durch Wasserdampf anstoßen kann, warum dann nicht auch ohne den (minimalen) Anstoß durch etwas mehr CO2? Noch dazu ist Wasserverdunstung ein sehr effektiver Weg für die Erdoberfläche, Wärme-Energie abzugeben. - (Keine relevanten natürlichen Ursachen)

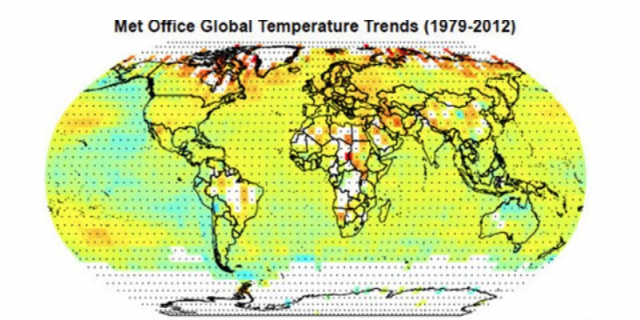

Das Klima hat erdgeschichtlich gewaltige Veränderungen vollzogen, um Größenordnungen stärker als gegenwärtig vielleicht messbar. Es muss also massive natürliche Ursachen geben – und warum sollten diese gerade jetzt vollständig „still“ und unauffällig sein? Alles Leben und alle Energie auf der Erde werden von der Sonne angetrieben, die aber nicht „perfekt gleichmäßig“ funktioniert, wie wir teilweise schon seit Jahrhunderten wissen („Sonnenflecken“ – auch kreist die Erde nicht perfekt gleichmäßig und stabil um die Sonne.) Zu behaupten, die Sonne hätte mit unserem Klima oder seiner Veränderung nichts zu tun, ist absurd. - (Immer mehr Naturkatastrophen)

Es gibt für die bei diesem Thema überhaupt nur relevanten letzten fünf bis sieben Jahrzehnte (seit der CO2-Ausstoß der Industrienationen weltweit nennenswerte Umfänge erreicht) keinen Nachweis, dass Naturkatastrophen häufiger oder schlimmer würden. Wir werden jetzt quasi täglich mit Katastrophenmeldungen überschüttet, um das Narrativ zu belegen, aber ein seriöser statistischer Beleg existiert nicht, wie sogar in IPCC-Kreisen und -Papieren zugegeben wird. (Noch ganz unabhängig von der Frage, ob zunehmende Naturkatastrophen, soweit es sie gäbe, überhaupt von veränderten Temperaturen verursacht wären.) Der Anstieg der Meeresspiegel ist konstant, unabhängig vom CO2, und noch eine Folge der auslaufenden Eiszeiten; die angebliche „Übersäuerung“ der Ozeane ist reine Propaganda und wissenschaftlich unhaltbar. - (Computer-Modelle aussagekräftig)

Die GCM-Computermodelle („general circulation model“) gießen nur in Zahlen, was die Anhänger der Klimapanik an Theorien – vorläufigen Behauptungen, Hypothesen – entwickelt haben. Sie werden so justiert, dass sie (und nur sehr unvollkommen) frühere Klima-Entwicklungen nachbilden können. Das ist kein Beweis für die Richtigkeit der Theorien. Vor allem haben die Modelle bisher regelmäßig komplett versagt bei ihren Prognosen. Sie haben keine größere wissenschaftliche Validität als Wettervorhersagen in einer Boulevardzeitung für den Sommer nächsten Jahres. Insgesamt haben die „wissenschaftlichen“ Klimapanik-Produzenten seit Jahrzehnten, auch über die Modellberechnungen hinaus, groteske Fehlprognosen veröffentlicht und sich als lächerlich falsche Propheten erwiesen, Scharlatane durch und durch. - („Vorsorgeprinzip walten lassen“)

„Vorsorge“ kann nicht heißen, einseitig Risiken des „Klimawandels“ maßlos zu über- und Kosten seiner „Bekämpfung“ ignorant zu unterschätzen. Es ist auch nicht per se der einzig richtige Weg, ein Problem „an der Ursache“ zu bekämpfen – es kann viel klüger sein, sich auf Unvermeidliches einzustellen und vorzubereiten. Ein steigender Meeresspiegel, selbst wenn er durch CO2 verursacht wäre, kann mit Deichbau wirksam „eingedämmt“ werden. Holland, wie wir es kennen, würde sonst nicht existieren. Auf den Malediven, die angeblich schon längst untergegangen sein sollten, werden Milliarden in Tourismus investiert. Ein schwerer Sturm, selbst wenn er von „globaler Erwärmung“ verursacht wäre, bringt ungeschützte Menschen um, aber nicht Bewohner von stabilen Betonhäusern. Armut bringt Menschen um, und vor der Natur nicht geschützt zu sein. Dieser Schutz ist leicht möglich, wenn genug materieller Wohlstand vorhanden ist. In 30 oder 50 Jahren können Weltgegenden, die heute noch von Armut geprägt sind, weit zu unserem Wohlstand aufgeschlossen haben und brauchen vor der Natur keine Angst mehr zu haben. - (CO2-Emissionen lebensgefährlich für die Menschheit)

Der „Klimawandel“ mag existieren oder nicht, er mag durch CO2 verursacht sein oder nicht, aber sicher ist: Der CO2-Gehalt der Atmosphäre war mit knapp 300 ppm vor der Industrialisierung gefährlich niedrig; Pflanzen haben sich aus solcher Luft kaum noch vernünftig ernähren können. Die heutigen Lebensformen haben sich erdgeschichtlich entwickelt, als es tausende ppm an CO2-Gehalt gab. Weltweit ergrünen riesige Flächen durch die „Düngung“ mit mehr CO2 in der Luft, auch das ist unbestritten. Mit mehr CO2 in der Luft können Pflanzen auch in trockenen Regionen besser überleben, weil sie nicht mehr so viel Wasser verlieren – das ist Basis-Biologie. Das alles kann auch helfen, mehr Menschen weltweit anständig zu ernähren. - („Dekarbonisierung“ der Industriestaaten als Lösung)

Es spielt selbst nach Projektionen des IPCC praktisch keine Rolle, ob Deutschland, ob der Rest Europas, ob dauerhaft die USA ihre CO2-Produktion mindern, denn China und Indien verfeuern so viel fossile Brennstoffe, um ihren Wohlstand aufzubauen, dass der Zug längst abgefahren ist. Wenn wir Konsumgüter nicht bei uns produzieren, „für den Klimaschutz“, aber dafür aus China kaufen, wird der CO2-Ausstoß sogar größer, denn unser Kraftwerkspark ist effizienter als der chinesische. Die Menschheit ist nicht bereit, „zurück in die Höhle“ zu wechseln oder gar „zurück auf die Bäume“, und mit Solar und Wind lässt sich der Energiebedarf einfach nicht decken. Das ganze CO2-Minderungsregime von Paris dient nur der Selbstverstümmelung der bisher reichen Länder, es ändert nichts am Weltklima. Selbst wenn die Theorien der Klimapaniker über die Erwärmung durch CO2 weitgehend stimmen würden: Es geht nur darum, ob eine fiktive Katastrophe schon im Januar 2100 eintritt oder erst im Februar 2100.

Man sieht, selbst wenn die kritischen Hinweise zu den Nummern eins bis neun völlig gegenstandslos wären, nur eine „Verschwörungstheorie“ von „Klimaleugnern“: Schon Punkt zehn beweist, dass die Aktivisten und mit ihnen jetzt auch amtlich das Bundesverfassungsgericht auf einem Holzweg sind, und nicht auf einem „nachhaltigen“. Punkt zehn ist übrigens auch ungefähr das, was Bjørn Lomborg seit vielen Jahren unermüdlich – und sehr überzeugend – vorträgt. Er ist ausdrücklich kein „Klimaleugner“, er nimmt die IPCC-Theorien weitgehend als akzeptable Diskussionsgrundlage, und dennoch wendet er sich vollständig gegen den Panik-Aktivismus, der die Politiker ergriffen hat.

Renommierte Umweltschützer gegen Panik

Es ist angeblich moralisch geboten, den Planeten vor uns Menschen zu retten, um jeden Preis. Aber nicht nur ist der Planet gar nicht wirklich in Not; selbst wenn es Probleme gäbe, ihre „Lösung“ sollte nicht schlimmer sein als das Problem. Man amputiert kein Bein wegen eines blauen Flecks, man erschießt einen Ladendieb nicht zur Strafe und Vorbeugung. Die Klimapanik lebt von der völligen Abstraktion und Verabsolutierung, von der Absage an gesunden Menschenverstand, Pragmatismus, Verhältnismäßigkeit. Und sie lebt davon, die Bedürfnisse der Menschen zu verachten, die angeblich das perfekte „natürliche Gleichgewicht“ auf der Erde zerstören. Wie wahnhaft diese Weltsicht ist, lässt sich daran ablesen, dass sich ihr längst langjährige wirkliche Umweltschützer widersetzen, wie zum Beispiel Michael Shellenberger, ebenso in aller Deutlichkeit der Greenpeace-Mitbegründer Patrick Moore.

Dass die „Klimawissenschaft“ keine Panik rechtfertigt, erläutert ganz aktuell mit einem Bestseller der Physiker Steve Koonin, der unter Obama (!) die US-Regierung beraten hat. Zu den Autoren sehr bemerkenswerter, wirklich wissenschaftlich basierter Abhandlungen gehören auch weitere Amerikaner wie Roy W. Spencer und Patrick J. Michaels, der Kanadier Ross McKitrick, der Skandinavier Henrik Svensmark, der Brite Matt Ridley, der deutsche Professor Horst-Joachim Lüdecke; bemerkenswerte Hinweise gegen die vorherrschende Propaganda präsentiert in unnachahmlicher Weise per Videoclip Tony Heller; die aktuelle Forschung wird lebhaft diskutiert in einem Blog von Anthony Watts. Prof. Fritz Vahrenholt und Sebastian Lüning sind dem hiesigen Publikum ohnehin vertraut (Buch).

Das sind Ausschnitte einer in Wahrheit alles andere als „erledigten“ weltweiten Debatte; das sind auch nicht „Verschwörungstheoretiker“, die in ihrem Keller als Pseudo-Privatgelehrte an Physik und Naturgesetzen zweifeln, sondern das sind im Gegenteil arrivierte Funktionsträger und solide Selbst-Denker, die das Narrativ „hinterfragen“ und sich nicht von Politaktivisten mundtot machen lassen. Auf der „Gegenseite“, bei den angeblich wissenschaftlichen Größen hinter der Klimapanik, steht ein Michael „Hockeystick“ Mann, der seine Kritiker gerichtlich mundtot zu machen versucht, aber nicht bereit ist, seine Methoden offenzulegen – womit er sich gegen kollegiale Versuche der Replikation sträubt und damit als Wissenschaftler disqualifiziert; es gibt den „climategate“-Skandal rund um ein für die Klima-Beobachtung zentrales Institut in England, dessen ans Tageslicht gekommener E-Mail-Austausch klar politisch-taktische Motive für die „Forschung“ belegt; letztlich ist nicht auszuschließen, dass an den angeblichen „Fakten“ über die Temperaturentwicklung massiv und ungeniert herummanipuliert wird.

Ein zentraler Urheber der ganzen Panik, der mit seinem Auftritt vor einem Gremium des US-Parlaments vieles ins Rollen gebracht hat, ist James Hansen, dessen angeblich wissenschaftliche Prognosen sich beinahe vollständig als lächerliche, wahnwitzige Horrorvisionen herausgestellt haben. Die Panik-Propheten reihen sich nahtlos ein in eine lange Reihe von Untergangs-Denkern, die es schon mit anderen Themen und schon Jahrzehnte früher gegeben hat; so hat sich ein gewisser Paul Ehrlich mit seinen apokalyptischen Szenarienzur Überbevölkerung ebenso gründlich blamiert wie der „Club of Rome“ mit seinen düsteren Prognosen. All diese Wichtigtuer haben zwar irgendwie Thesen und Theorien von „wissenschaftlicher“ Seite aufgegriffen, aber sie haben einzelne Trends verabsolutiert und gegenläufige Erkenntnisse ausgeblendet, die ihnen den Auftritt vermasselt hätten – genau keine Wissenschaft, denn diese setzt Selbstkritik, regelrecht Selbstzweifel und offene Debatte voraus.

Lesen Sie morgen Teil 3: „Klimawissen für jedermann“

Teil 1 finden Sie hier.

Der Beitrag erschien zuerst bei ACHGUT hier