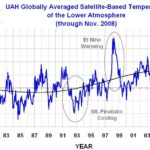

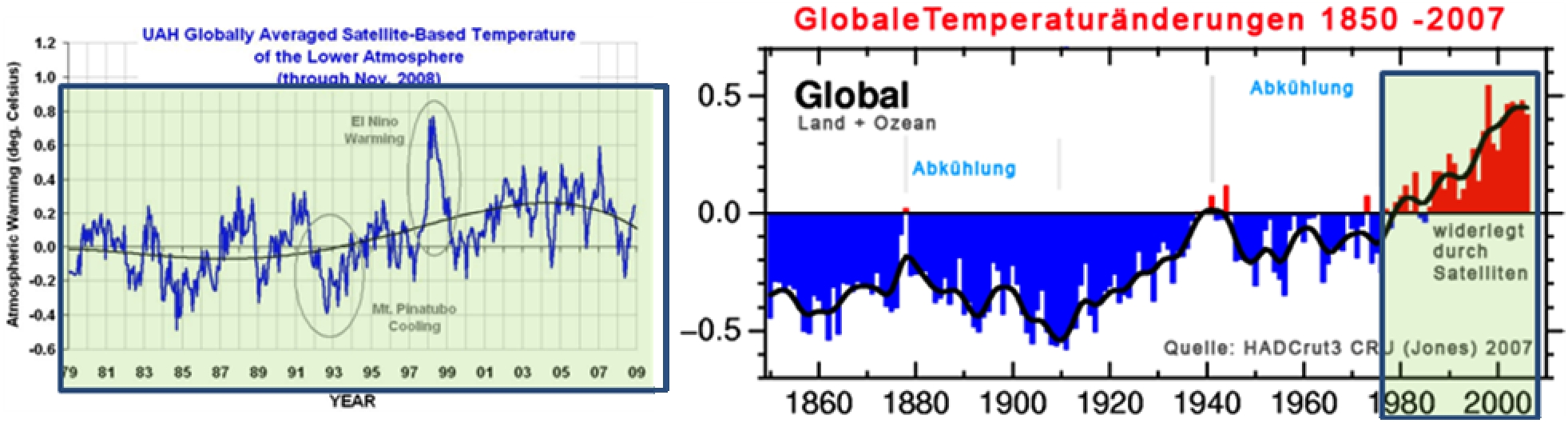

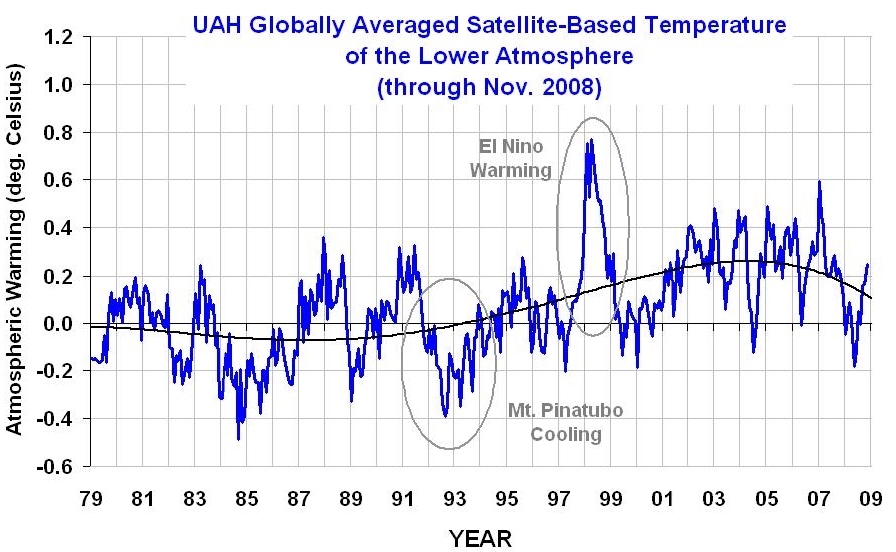

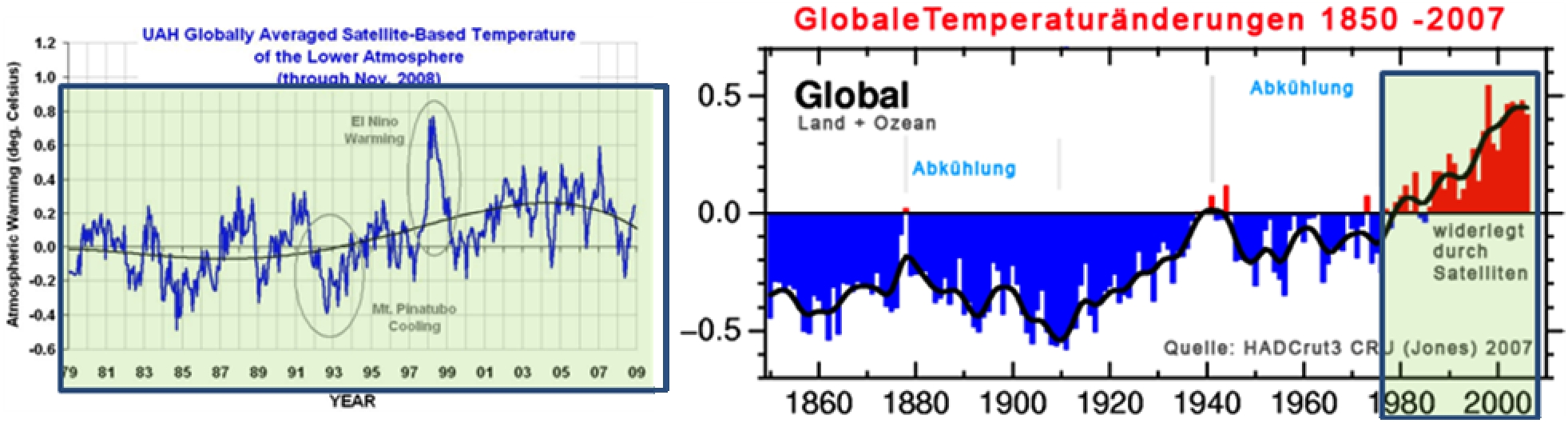

Die Abbildung 1 zeigt die anhand vieler Millionen Satellitendaten ermittelte Temperaturkurve von 1979 – 2009 und zwar die Abweichung vom langfristigen Mittel (Nulllinie). Sie wird in Zusammenarbeit der University of Alabama Huntsville (UAH) und der NASA generiert.

Die Abbildung zeigt eine sehr leichte Erwärmung ab 1988 bis 2003 von ca. 0,3°C. Seitdem fällt die Langfristkurve der Temperatur und diese nähert sich wieder der Nulllinie des Langfristmittels. Zusätzlich sind zwei Ereignisse eingezeichnet, die den Trend einmal in die negative Richtung und einmal in die positive Richtung beeinflussen. Dies ist zum einen der Ausbruch des Vulkans Pinatubo auf den Philippinen in 1991, der durch seinen gewaltigen Ausstoß, der letztendlich das Sonnenlicht absorbierte, weltweit die Temperaturen für den Zeitraum von 2 Jahren um ca. 0,6°C fallen lies. In 1999 führte der starke El-Niño zu einem kurzfristigen Temperaturanstieg von ca. 0,7°C. Beides geht auf natürliche Ursachen zurück und hat nichts mit einem menschengemachten CO2-Ausstoß zu tun. Betrachten wir nun die berüchtigte Jones-Temperaturkurve (Abbildung 2), wie sie noch 2007 im 4. IPCC-Bericht um die Welt ging und in Politik und Medien entsprechenden Anklang fand, so ist plötzlich ein Temperaturanstieg zu verzeichnen, der durch Satellitenmessungen nicht bestätigt wird.

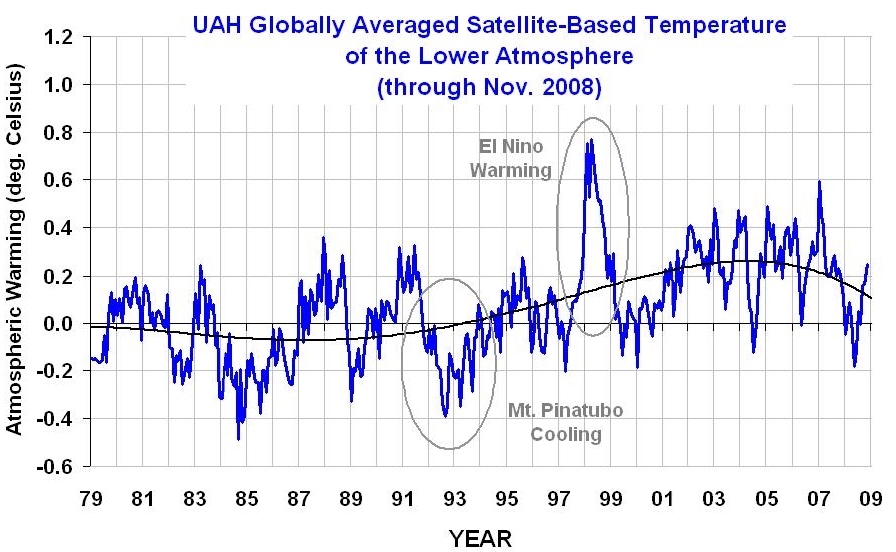

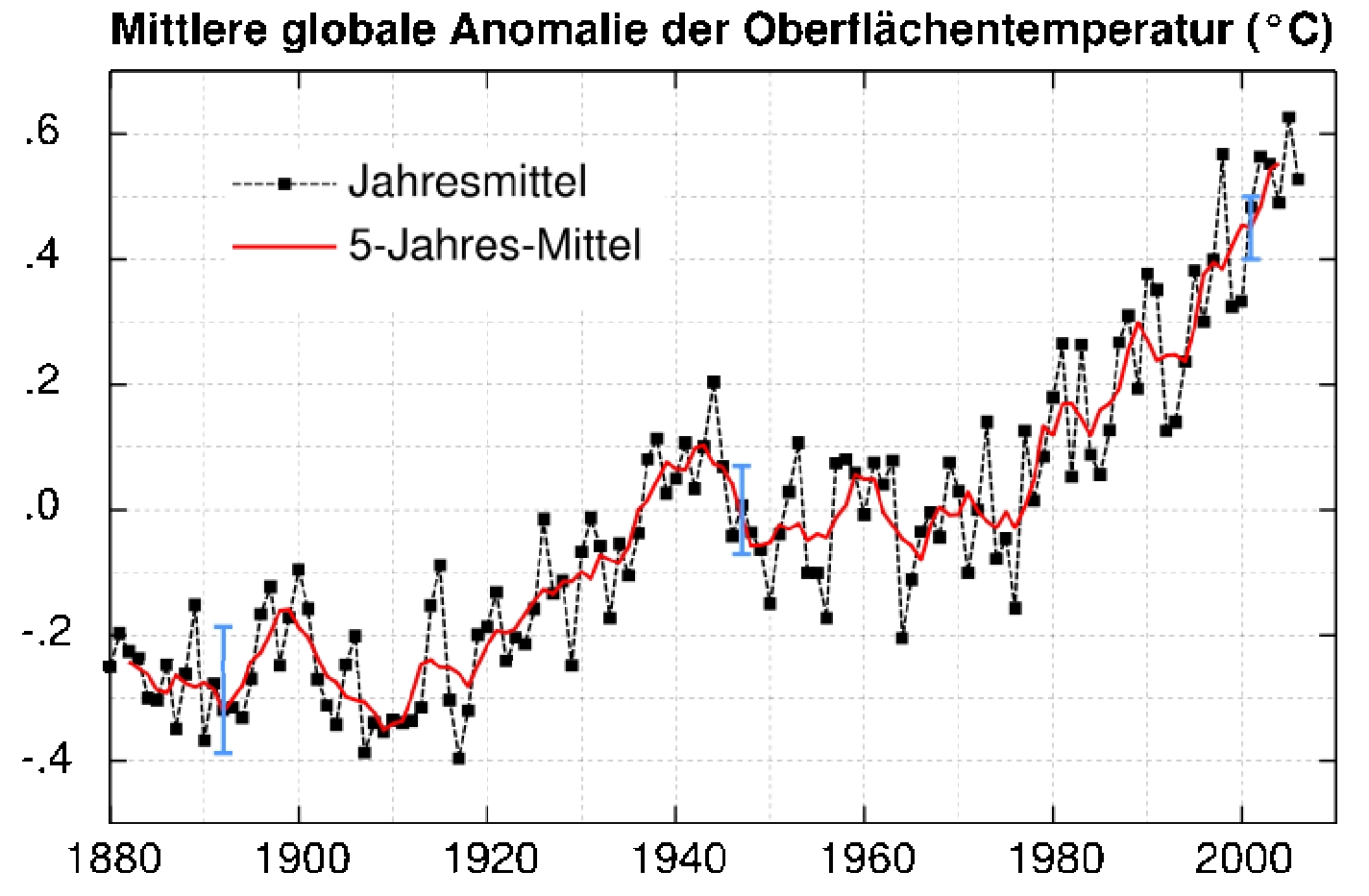

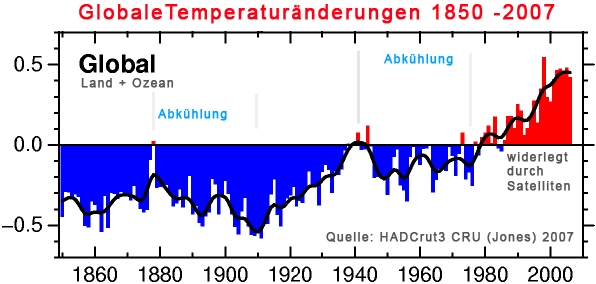

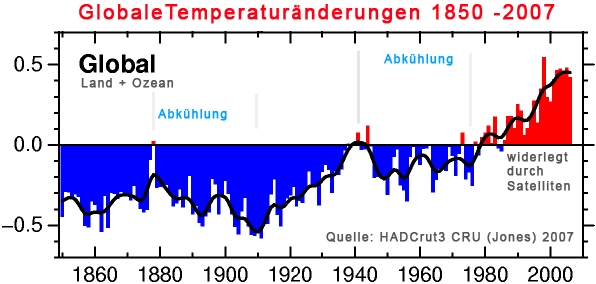

Abbildung 2

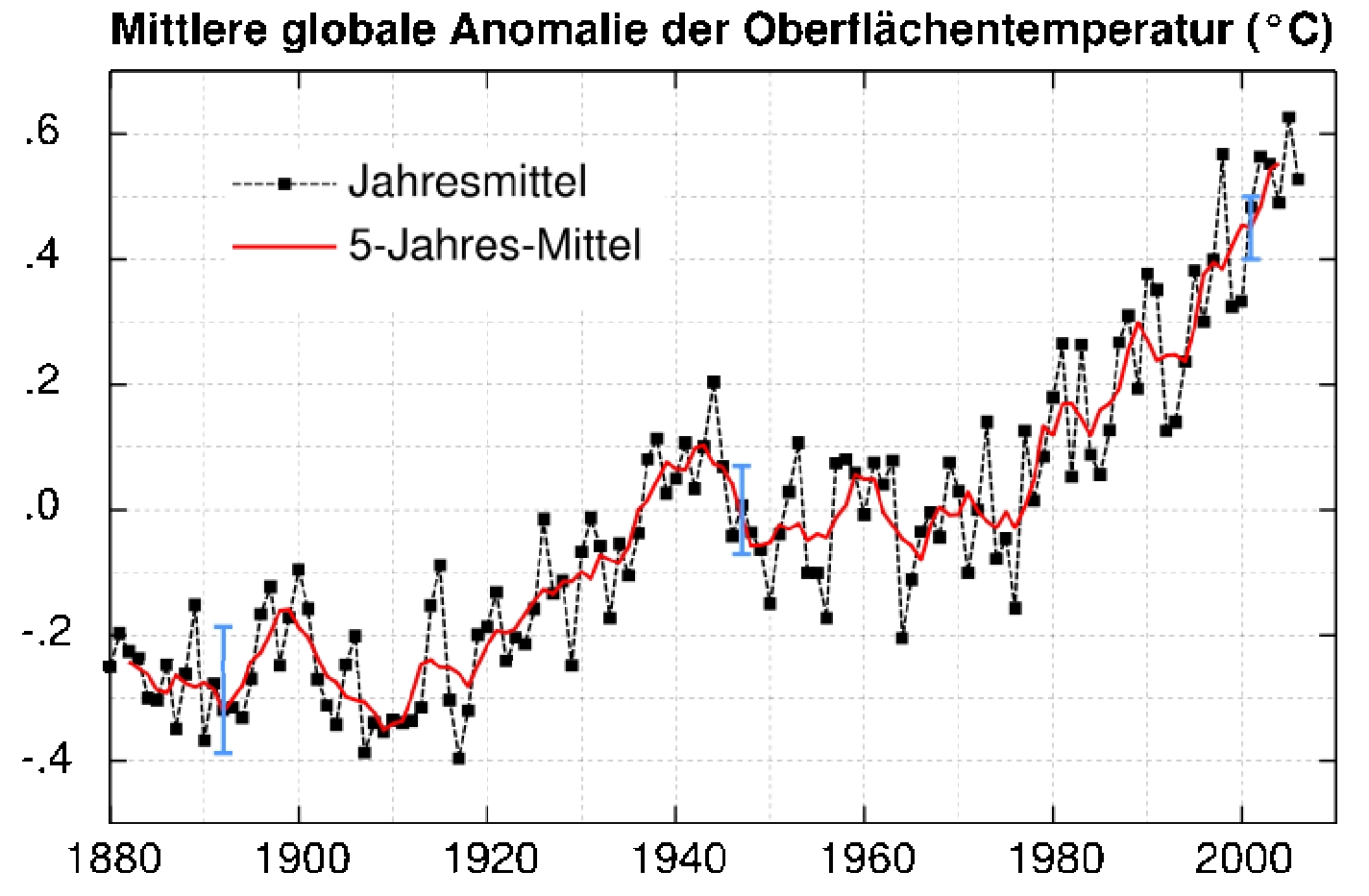

Die Abbildung 2 zeigt die globale Temperaturentwicklung von Jones 2007 (HadCrut3) für den Zeitraum von 1850 – 2007, welche durch Climategate als Fälschung offengelegt wurde. Deutlich ist hier ein Temperaturanstieg seit den 1970-Jahen zu sehen, der in den Satellitendaten nicht vorkommt. Dass gleiche Bild bei den Daten, für die Prof. Hansen (GISS, Abbildung 3, die drei blauen Balken stellen Standardabweichungen, als mathematische Fehlermöglichkeiten dar) verantwortlich ist. Aus beiden Datenreihen stellt das IPCC seine Prognosen zusammen und kommt zu dem Schluss, die Erde würde sich durch Menschenhand drastisch erwärmen.

Abbildung 3

Sowohl Jones (HADCrut3), als auch Hansen (GISS) verwenden für die Ermittlung ihrer Temperaturreihen Daten von bodengestützten Messstationen. Seit langem ist bekannt, dass diese unzulänglich, weil stark fehlerbehaftet sind. Zu diesen Fehlern zählen beispielsweise:

· Wärmeinseleffekt

· Mangelnde Datendichte (über weite Flächen gibt es keine Messstationen, die Daten werden nur geschätzt

· Unterschiedliche geographische Höhe der vielen Messstationen. Pro 100m Höhe nimmt die Temperatur um etwa 0,65°C ab, wodurch die Messdaten korrigiert werden müssen, sollen die Daten miteinander vermischt werden.

· Falsche Aufstellung der Messstationen

· Änderung der Messerfassungszeiten

· Software-/Algorithmusfehler, also Auswerte- und Berechnungsfehler u.v.m.

Ich möchte Ihnen die o.g. Punkte kurz erläutern.

Wärmeinseleffekt bedeutet, dass durch zunehmende Besiedlung, Industrialisierung und technische Entwicklungen, ortsgebundene Messstationen heute im Vergleich zu früher zu hohe Temperaturen messen und daher die Daten korrigiert werden müssen. Die Abbildung 4 zeigt, wie die Bevölkerungsdichte bodenbasierte Temperaturdaten beeinflusst.

Abbildung 4

Die Abbildung 4 zeigt den Wärmeinseleffekt nach Goodridge 1996. Deutlich ist erkennbar, dass mit zunehmender Einwohnerzahl die Temperaturanomalie immer schneller steigt. Dies ist nicht vorrangig durch das Fehlen von Grünflächen/Bäume, die moderierend auf den Temperaturverlauf wirken zurückzuführen, sondern durch den Einsatz von Elektro- und Verbrennungsmaschinen oder Kühlanlagen, die entsprechend ihre Verlustwärme, bzw. Abwärme an die Umgebung abgeben, was die Temperaturen immer mehr ansteigen lässt. Jedem ist bekannt, dass es z.B. im Winter in Städten wärmer ist als auf dem Land.Datendichte

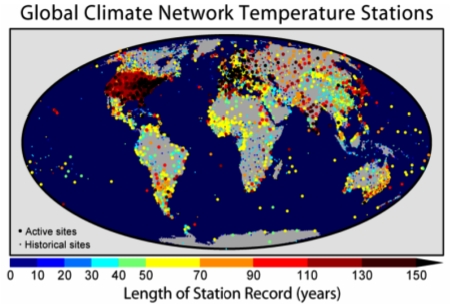

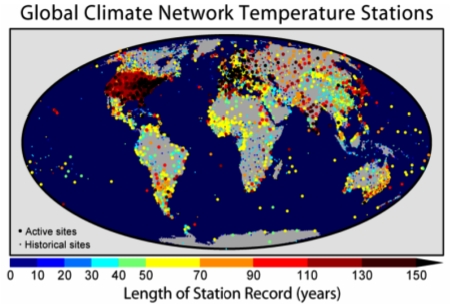

Die Abbildung 5 zeigt die Messstationen des globalen Temperaturnetzwerks und die bisherige Betriebsdauer. Es ist deutlich erkennbar, dass in weiten Bereichen, insbesondere den Ozeanen, die Erfassungsdichte weit unterdurchschnittlich ist. Da die Ozeane etwa 70% der Erdoberfläche aufweisen, ergibt dies eine starke Schräglage der statistischen Messwerteerfassung und Auswertung.

Abbildung 5

Mangelnde Aufstellung der Messstationen

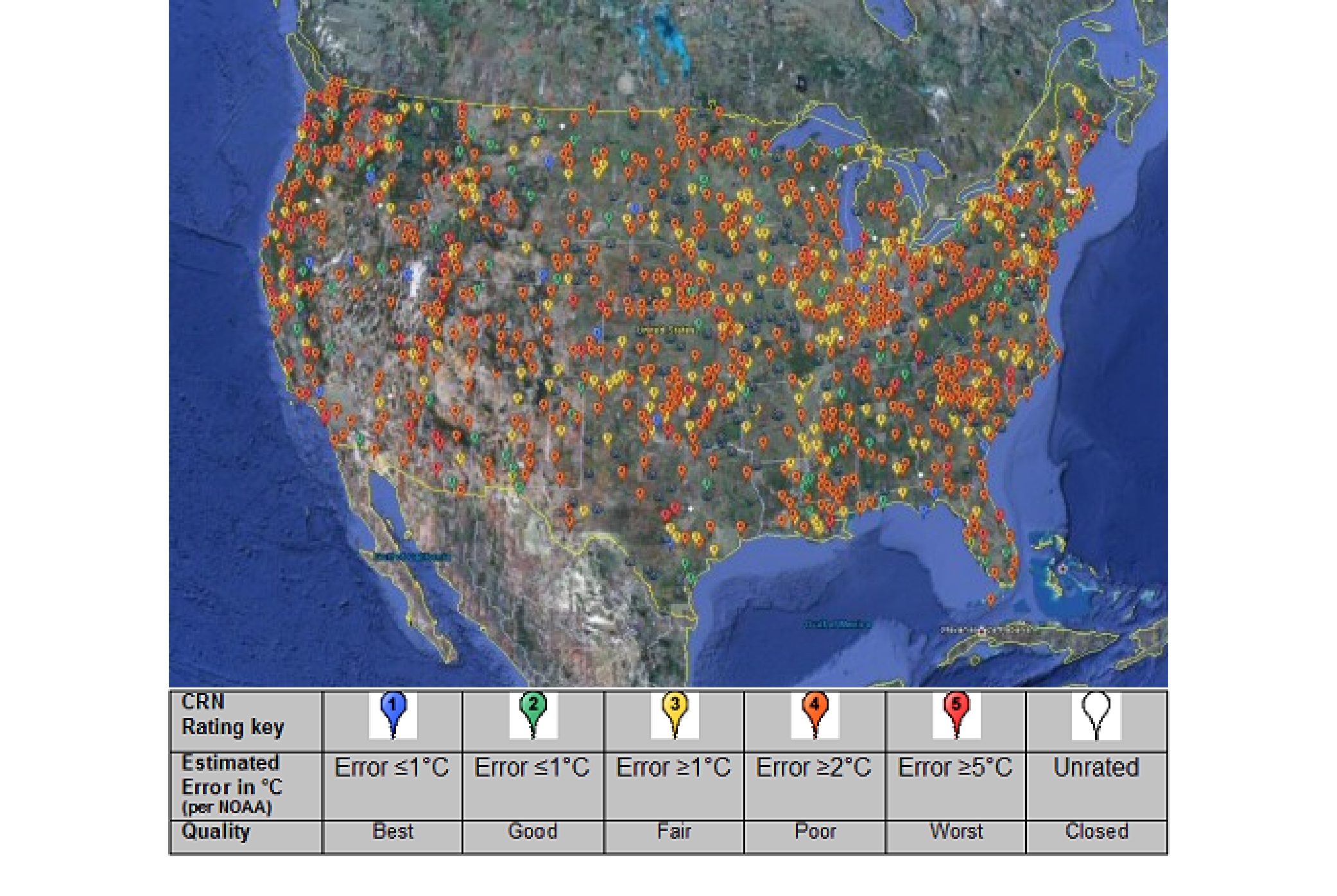

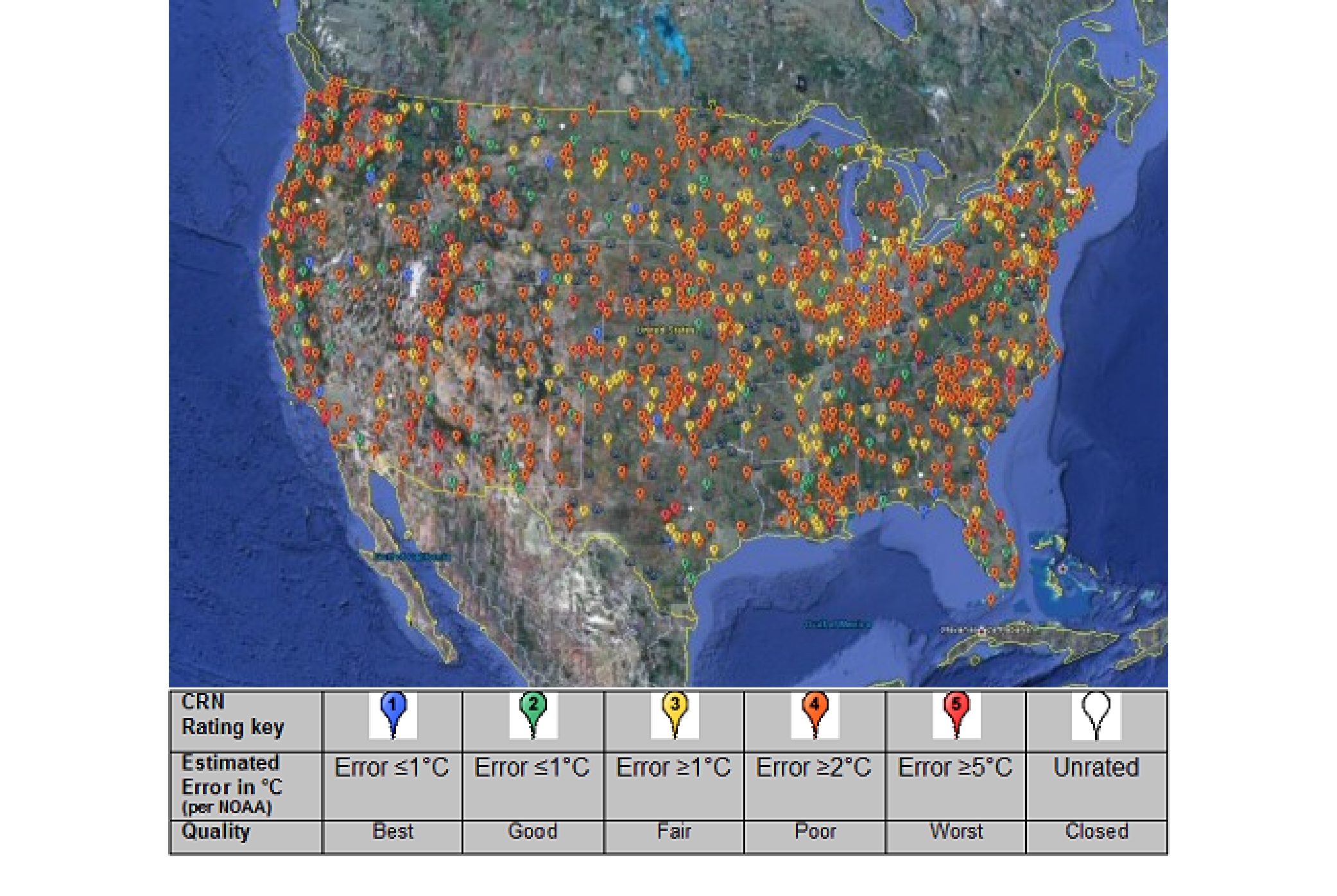

Im Gegensatz zu Deutschland, gibt es in den USA Audits (Überprüfungen) von unabhängiger Seite, inwieweit die dortigen Messstationen, den Ansprüchen genügen. Sozusagen ein Tüv. Bei der letzten durchgeführten Überprüfung in 2009 wurde festgestellt, dass 61% aller Temperaturmessstationen nicht geeignet für Temperaturreihen sind (Abbildung 6).

Abbildung 6

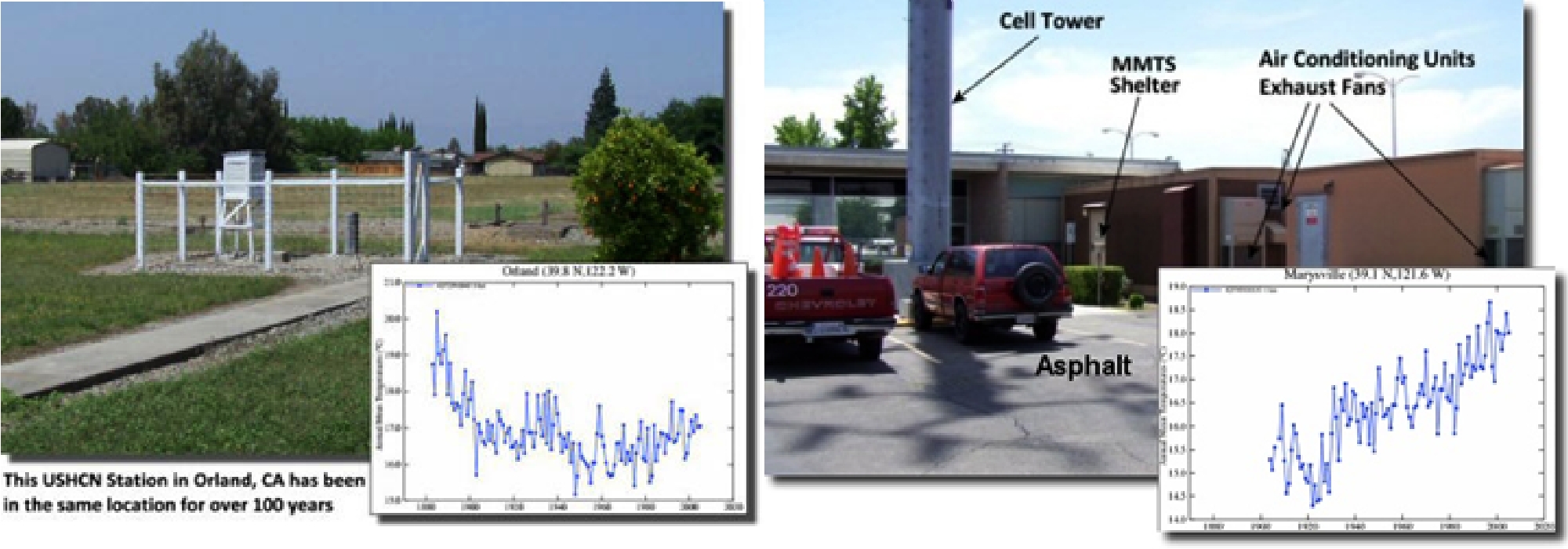

Das folgende Beispiel gibt die Antwort, warum dem so ist.

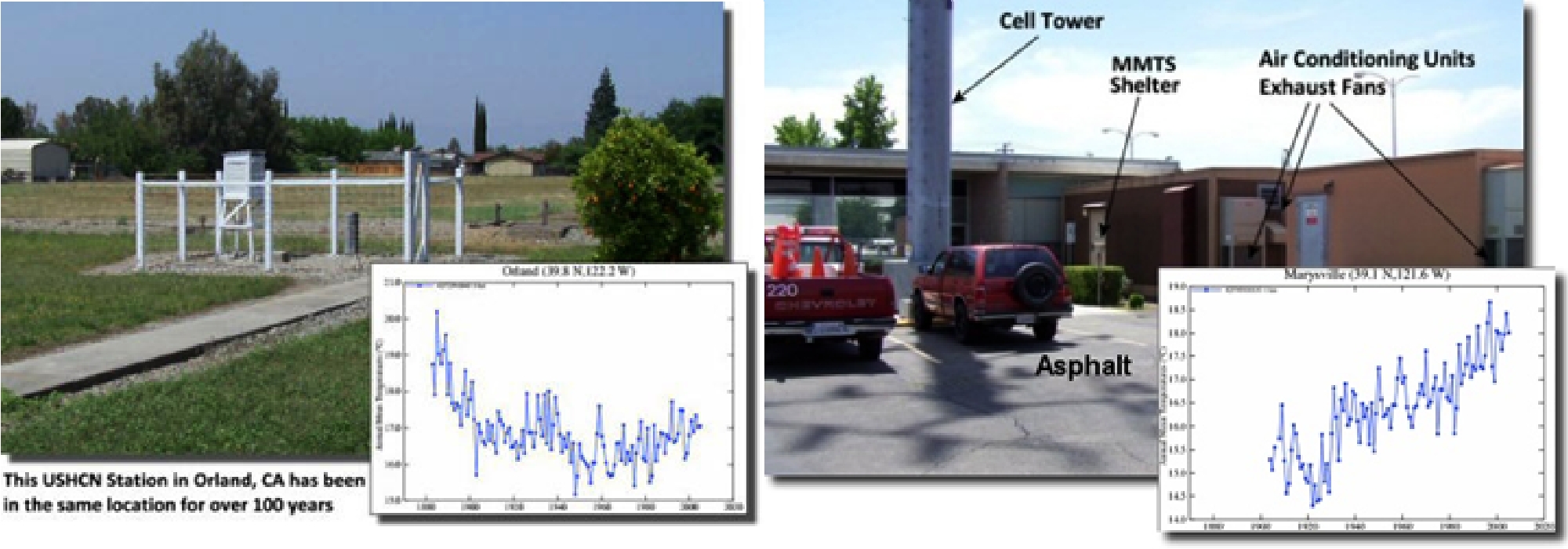

Abbildung 7

Die Abbildung 7 links zeigt die Messstation Orland in Kalifornien. Deutlich ist zu sehen, dass die Temperaturen zu Beginn des 20. Jahrhunderts z.T. deutlich höher lagen als während des sog. Klimawandels. Die Abbildung rechts (beide Abbildungen, Quelle: http://www.surfacestations.org/) zeigt eine ungenügende Station, die sich in unmittelbarer Nähe von aktiven Heizstrahlern befindet und einen starken Temperaturanstieg ausweist.

Erfassungszeiten

Zu Beginn 2001 wurde weltweit der Standard der Temperaturerfassungszeiten geändert. Bis zu diesem Zeitpunkt hatte jedes Land eine eigene Datenerhebung, so dass die Daten aus wissenschaftlicher Sicht gar nicht miteinander vermengt werden dürfen. So wurde in Deutschland dreimal am Tag gemessen (7,30 Uhr, 14,30 Uhr und 21,30 Uhr, letzter Wert wurde doppelt gewertet, um sich den 4. Wert in der Nacht zu sparen) in Frankreich zweimal am Tag (Min- und Maxtemperaturwert) gemessen und daraus der Tagesmittelwert bestimmt. Ab April 2001 wird nun stündlich gemessen, wobei Ausnahmen (alle 6 Stunden) zulässig sind. Wegen der starken Asymmetrie des Tagesganges der Temperatur ergeben beide Erfassungsmethoden (vor April 2001 und danach) andere Temperaturtagesmittelwerte. Durch die neue Methode wird der Tagestemperaturmittelwert nach oben verändert.

Abbildung 8

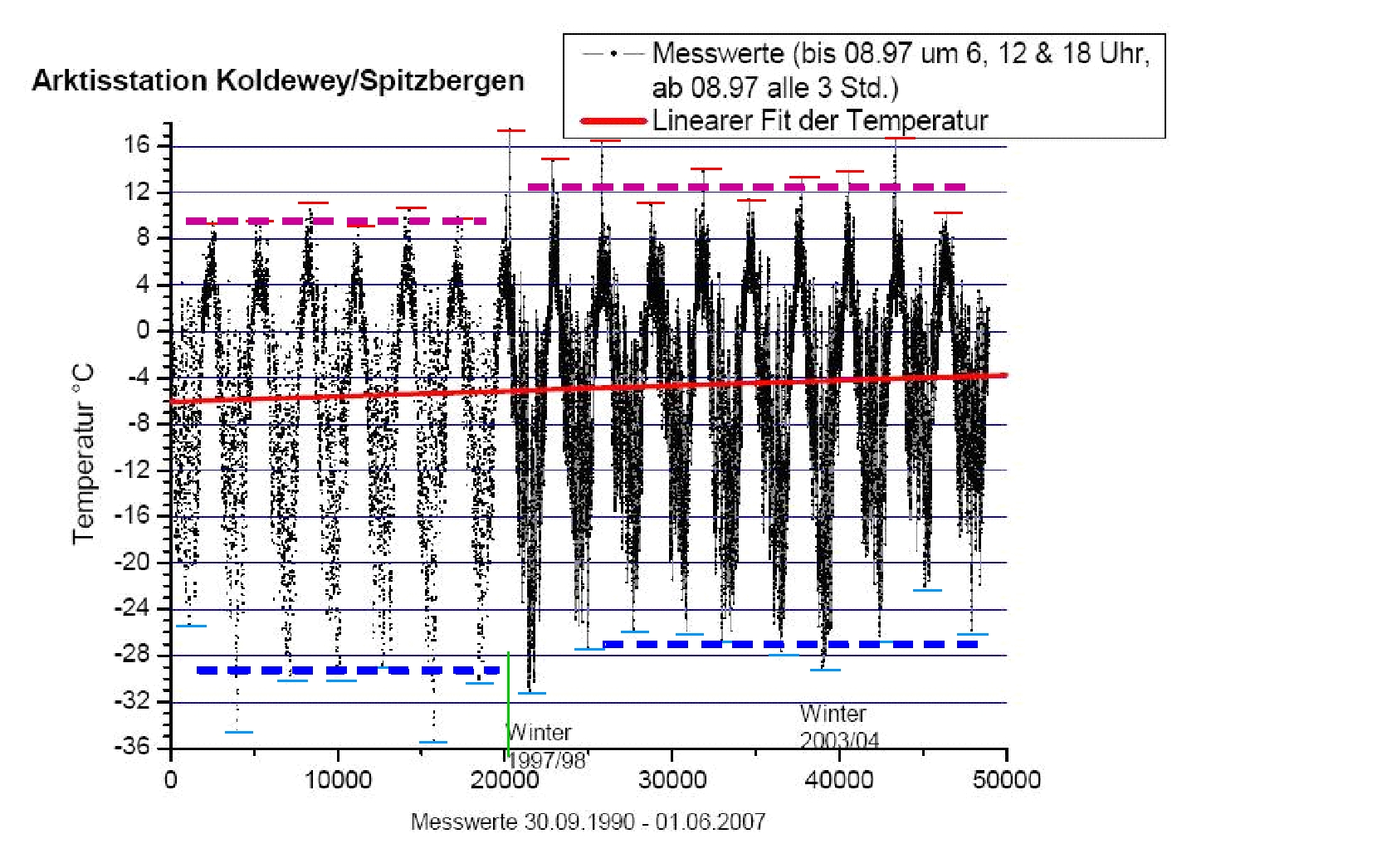

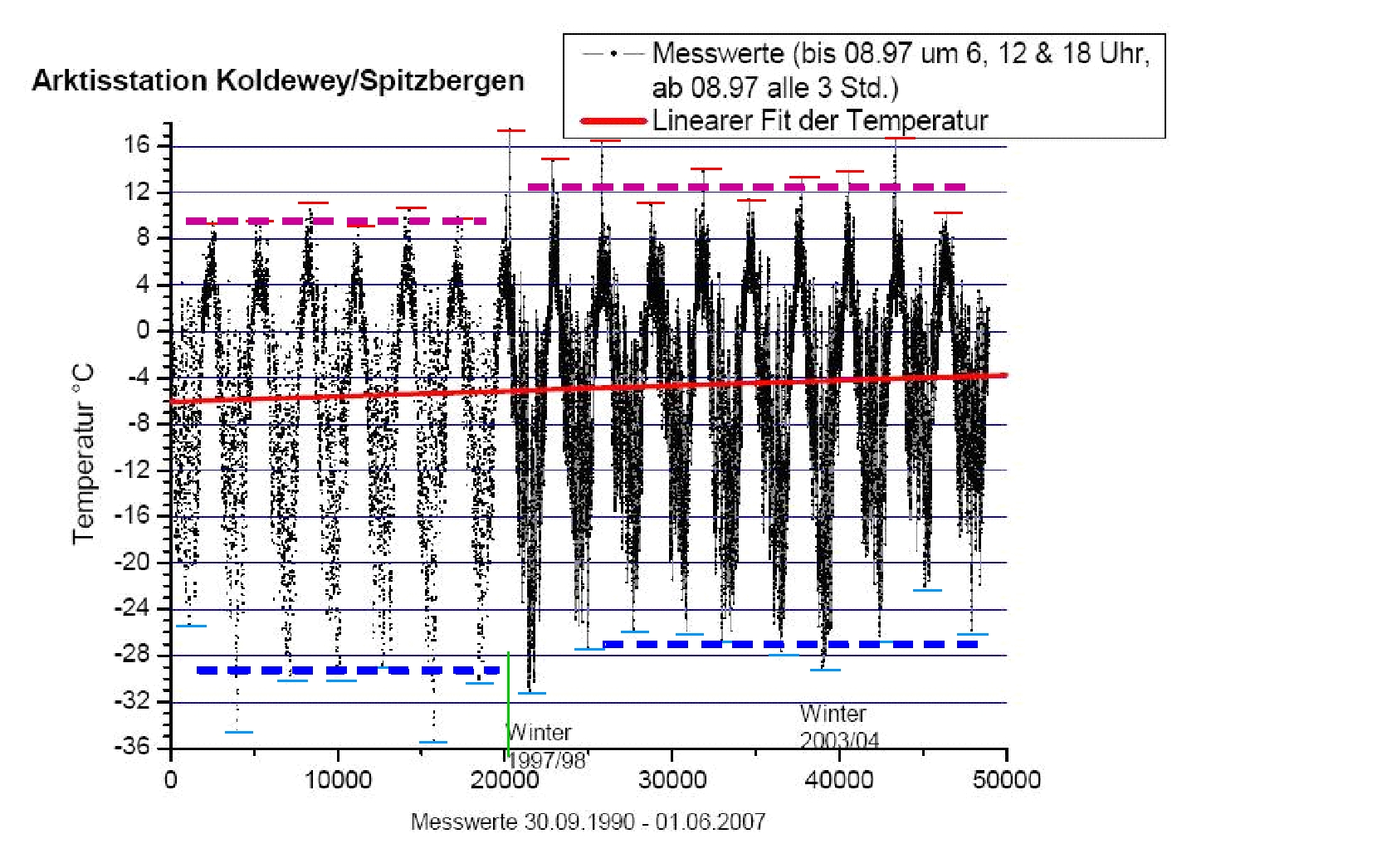

Die Abbildung 8 zeigt die Temperaturmessungen (auf der Abszisse sind die Anzahl der Messungen aufgetragen) der Wetterstation in Ny Ålesund auf Spitzbergen (Station “Koldewey“), die vom Alfred-Wegener-Institut betrieben wird. Vom Herbst 1990 bis Sommer 1997 wurde dreimal am Tag und zwar um 6-, 12-, und 18 Uhr gemessen. Ab Sommer (bis heute, ab der grünen Linie) wird achtmal täglich gemessen und zwar um 0-, 3-, 6-, 9-, 12-, 15-, 18-, und 21 Uhr. Sehr gut ist zu erkennen, dass mit der neuen Temperaturerfassung, die Temperaturkurve deutlich angehoben wird. Die Messwerte um 15 Uhr verursachen darüber hinaus noch starke Temperaturausreißer nach oben (die Anhebung der Min/Max-Werte ist durch die farbigen Querbalken markiert). Sowohl im Zeitraum 1990 bis Sommer 1997, als auch im Zeitraum vom Winter 1997 bis 2007 ist keine Tendenz der Temperatur zu erkennen. Wird aber über den gesamten Zeitraum von 1990 bis 2007 die Temperatur betrachtet, so steigt diese, aufgrund der vorgenommenen Änderung der Datenerfassung.

Die meteorologischen Institute (auch der DWD) verhelfen durch diesen Trick in der Temperaturdatenerfassung der globalen Temperaturkurve zu einem Anstieg, während gleichzeitig die Satellitenmessungen einen tatsächlichen Rückgang der Temperaturen zeigen. Verstehen Sie mich bitte nicht falsch, es ist nichts dagegen einzuwenden, dass in der Meteorologie ein, dem technischen Standard entsprechendes optimiertes Datenerhebungssystem eingeführt wurde. Es ist nur befremdend, dass dies in den Temperaturreihen nicht vermerkt wird, da durch das neue Verfahren der Vergleich der Datenreihen vor und nach 2001 nicht mehr möglich ist. Wegen der starken Asymmetrie des Tagegangs der Temperaturen werden die berühmten Äpfel mit Birnen verglichen.

Im Zusammenhang mit Climatgate wurde viel darüber berichtet, dass Mails gelöscht wurden, Rohdaten der Temperaturen beim CRU verschwunden sind, ebenfalls gelöscht wurden, etc. Auch der Beleg (Abbildung 8), dass durch zusätzliche Erfassungszeiten, die Temperaturdaten künstlich nach oben verschoben werden, wurde, nachdem der Verfasser dies in 2008 in einer Diskussion Herrn Prof. Dr. Rahmstorf auf KlimaLounge vorhielt, aus dem Netz genommen. Der Beleg war unter der Internetseite „Bremen und Umland im Bild“ (http://home.arcor.de/meino/klimanews/index.html) zu finden. Da der Verfasser von der Seite eine free-pdf. besitze, können Sie sich in der Anlage von der Richtigkeit überzeugen.

Algorithmusfehler

Besonders das GISS fiel in den letzten Jahren durch eine Reihe eklatanter Fehler auf. So mussten beispielsweise Monatsdaten nachträglich korrigiert werden, weil Daten von Vormonaten in die Bewertung einflossen. Als Folge wurden Oktoberwerte ausgewiesen, die alle bisherigen Rekorddaten brachen, weil Septemberdaten verwendet wurden, u.v.m.

Gezielte Manipulationen

Wie die Welt dank des Glimategate-Skandals erfahren hat, haben Jones und Hansen ihre Datenreihen durch einen “Trick“ angepasst. Wie dies geht, zeigt die Abbildung 9.

Abbildung 9

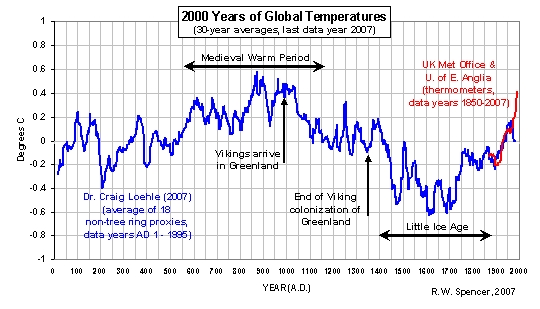

Die Abbildung 9 zeigt die aus Baumringdaten rekonstruierte Temperaturkurve der letzten 2.000 Jahre (blaue Kurve). Es ist ersichtlich, dass ab ca. 1960 die Daten nicht mit den gemessenen Temperaturdaten übereinstimmen. Die blaue Kurve zeigt einen Temperaturrückgang, während die Bodenmessungen einen Anstieg ausweisen (vortäuschen). Jones hat offensichtlich die Datenreihe ab ca. 1960 abgeschnitten und durch die gemessenen Werte ersetzt, wodurch ein steiler Temperaturanstieg zu sehen ist, der, wie bereits erwähnt, in den Sattelitenmessungen, die im Gegensatz zu den Bodenmessungen nicht punktuell, sondern in der gesamten Oberfläche und kontinuierlich messen, nicht erkennbar ist. Es handelt sich also um eine bewusste Fälschung und Täuschung der Adressaten aus Politik und Medien.

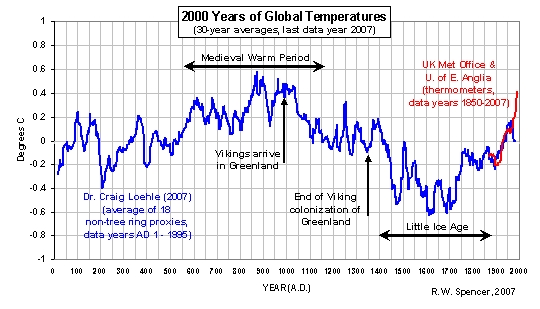

Werden dann weitere, man muss schon von Fälschungen der Daten ausgehen, Korrekturen der Temperaturen der ersten Hälfte des 20. Jahrhunderts vorgenommen, dann erscheint die berüchtigte Jones-Kurve (Abbildung 2), die Politik und Medien manipulierte. Ich möchte Ihnen als Beweis einen Ausdruck aus 1978, Quelle National Geographic vorstellen, auf dem um 1940 eine starke Warmperiode, mit Temperaturen von über 0,5°C über dem Langfristmittel abgebildet ist, die bei Jones und Hansen heute nicht mehr zu sehen ist.

Abbildung 10

In der Abbildung 10 von Jones (oben) beträgt der Temperaturhub zwischen 1940 und 1970 nicht mehr 0,5°C, wie noch in der Abbildung der National Geographic von 1978 zu sehen, sondern er wurde auf wundersame Weise auf 0,1°C herunter manipuliert. Es gibt kein anderes Wort, als Manipulation oder Betrug von Temperaturdaten dafür. Oder sollte Jones von seiner Arbeit so überfordert sein, dass ihm ein solch katastrophaler Fehler unterlaufen ist. Dann wären er und mit ihm das IPCC, als kompetente Vertreter ihres Standes nicht mehr haltbar und Politik und Medien sollten sich schleunigst nach geeigneteren Personen umsehen. Auf der 2. Klimakonferenz in Berlin am 04. Dez. 2009 war z.B. eine Vielzahl von ihnen vertreten.

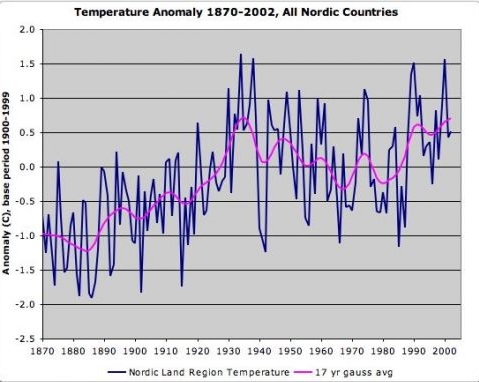

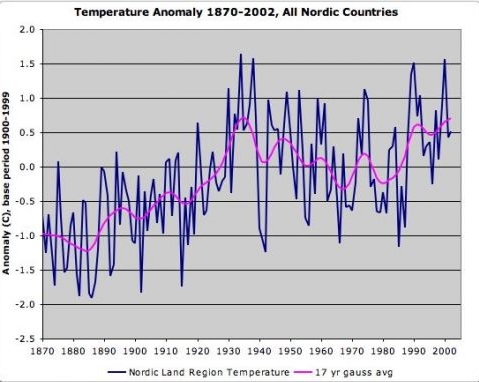

Werden von unabhängiger Seite die Temperaturrohdaten ausgewertet, so ist auch heute der starke Temperaturanstieg in der ersten Hälfte des 20. Jahrhunderts zu sehen, Abbildung 11.

Abbildung 11

Die Abbildung 11 zeigt die Temperaturdaten von 1870 – 2002, Quelle: (http://wattsupwiththat.com/2009/11/29/when-results-go-bad/#more-13373). Klar erkennbar, dass in der ersten Hälfte des 20. Jahrhunderts die Temperaturen höher lagen, als zum Ende des 20. Jahrhunderts, obwohl CRU, GISS und IPCC der Welt anderes weismachen wollen (Abbildung 2 und 3). Die Abbildung deckt sich mit den US-Temperaturwerten – das wärmste Jahr im 20. Jahrhundert ist 1934. Von den 10 wärmsten Jahren liegen 6 vor 1940! Auch bei den US-Temperaturdaten hatte das GISS zuerst falsche Daten geliefert, die zu dessen wohl gefälschter Temperaturkurve passen. Das GISS musste die TOP-Temperaturjahre korrigieren, als der bekannte Meteorologe Steve McIntyre ihm Fehler in der Datenauswertung nachwies.

Weitere Datenfälschungen, z.B. über arktische Temperaturen sind hier zu entnehmen: http://bobtisdale.blogspot.com/2008/07/polar-amplification-and-arctic-warming.html

oder Manipulationen bei Ländermessungen:

http://landshape.org/enm/australian-temperature-adjustments/

Anhand des Climategate-Skandals und der großen Unterschiede (Abbildung 13) zwischen den satellitenbasierten Temperaturreihe und den Daten der GISS und Jones (CRU) ist festzuhalten, dass die offiziellen Datengeber des IPCC, die Daten einer Kurspflege unterzogen haben, die das Konstrukt eines anthropogenen Klimawandels beweisen sollten. Ihre Daten halten einer wissenschaftlichen Überprüfung nicht stand, wie bereits die Hockey-Stick-Kurve von Prof. Mann, die ebenfalls (vor 3 Jahren) als Fälschung entlarvt wurde. Eine wissenschaftliche Überprüfung der HadCrut-Daten wird sich allerdings schwierig gestalten, weil ganze Rohdatensätze und Tabellen aus unerklärlichen Gründen verschwunden sind.

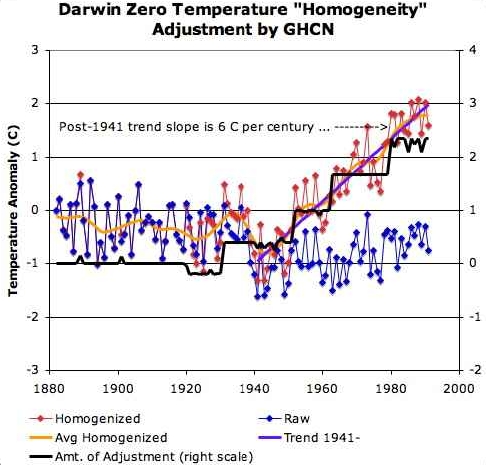

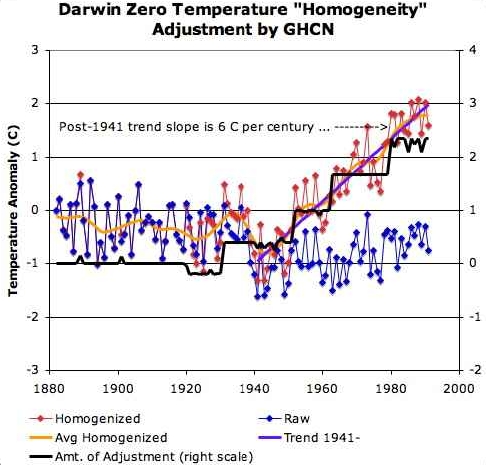

Abbildung 12

Die Abbildung 12 (Quelle: http://wattsupwiththat.com/2009/12/20/darwin-zero-before-and-after/#more-14358) zeigt die Temperaturdatenreihe der nordaustralischen Messstation „Darwin Zero“. Die Rohdaten zeigen einen gänzlich anderen Temperaturverlauf, wie die „bereinigten“ Werte (GHCN: Global Historical Climatology Network). Während diese Temperaturwerte einen gewaltigen Temperaturanstieg signalisieren, zeigt der Trend bei den Rohdaten eine leicht fallende Temperaturentwicklung.

Es muss davon ausgegangen werden, dass die Affäre um die gefälschten CRU-Daten nur die Spitze des Eisbergs darstellt und in den nächsten Wochen mit weiteren Enthüllungen zu rechnen ist, wie am Beispiel von Dr. Ben Santer, Klimaforscher und Leit-Autor des IPPC, Mitarbeiter am IPCC SAR Bericht von 1995, zeigt, der am 19.12.2009 in der Jesse Ventura Talkshow zugab, die Teile aus dem Kapitel 8 des Berichtes gelöscht zu haben, die ausdrücklich einen vom Menschen verursachten Klimawandel verneinen (http://www.eike-klima-energie.eu/news-anzeige/climategate-update-ipcc-leit-autor-ben-santer-gibt-faelschung-zu/).

Werden die satellitenbasierten Messungen (insbesondere deren Verlauf), mit den CRU-Daten verglichen, wird der Manipulationsverdacht sichtbar (Abbildung 13).

Abbildung 13

Während die aus Millionen Satellitendaten der NASA ermittelte globale Temperaturreihe nur einen sehr schwachen Temperaturanstieg ab 1988 zeigt, der seit 2003 wieder rückläufig ist und fällt, zeigen die Daten von Jones (und der GISS, siehe Abbildung 3) einen rasanten Temperaturanstieg im gleichen Zeitraum (grün hinterlegter Bereich).

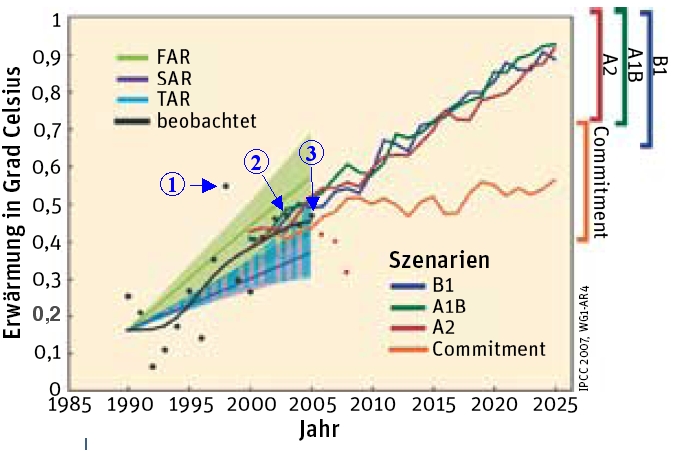

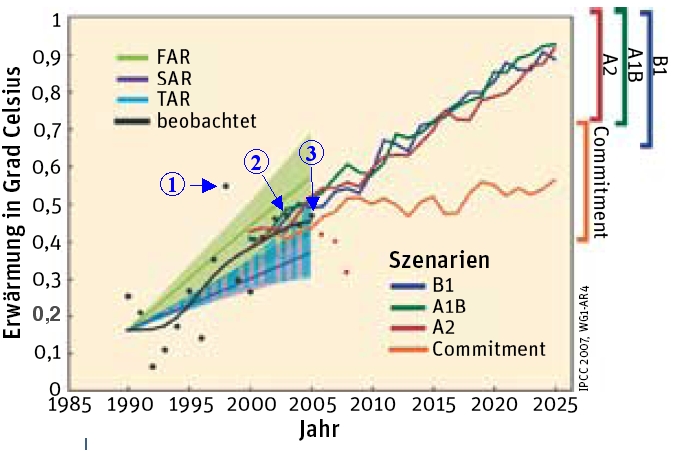

Anhand der Satellitendaten, die seit 1979 vorliegen, ist festzuhalten, dass es bis Ende der 1980-Jahre keine Temperaturerhöhung gab, bis zur Jahrtausendwende ein leichter Anstieg von ca. 0,3 °C zu verzeichnen ist, der natürlichen Ursprungs ist, sich in die historischen Temperaturwerte einfügt und seit Beginn dieses Jahrtausends, aufgrund nachlassender Sonnenaktivität (EIKE berichtete mehrmals über die Zusammenhänge), die Temperaturen deutlich fallen, wie die Abbildung 14 zeigt.

Abbildung 14

Die Abbildung 14 zeigt die vier Temperatur-Szenarien (B1, A1B, A2, Commitment) aus dem IPCC-Bericht 2007, die aus den IPCC-Klimamodellen ermittelt wurden. Das Szenario “Commitment“, welches die niedrigste Temperaturentwicklung angibt, geht dabei von einer gleich bleibenden CO2-Konzentration wie im Jahr 2000 aus! Bei den drei anderen Szenarien steigt indes die CO2-Konzentration weiter an, wie dies z.B. die Mauna Loa-Daten wiedergeben, Quelle: ergänzt nach Spektrum der Wissenschaft 02/09, “Kalt erwischt“, S. 21 – 22. Die roten Punkte geben die tatsächliche Temperaturentwicklung bis 2008 wieder (schwarze Punkte, sind die gemessenen Temperaturwerte bis 2005). Seit 2005 fallen die Temperaturen deutlich. Die grün, blau und violett schraffierten Bereiche zeigen die Szenarien der früheren IPCC-Vorhersagen (FAR = First Assessment Report, 1990; SAR = Second Assessment Report, 1995; TAR = Third Assessment Report, 2001).

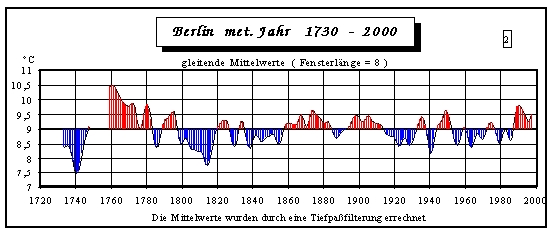

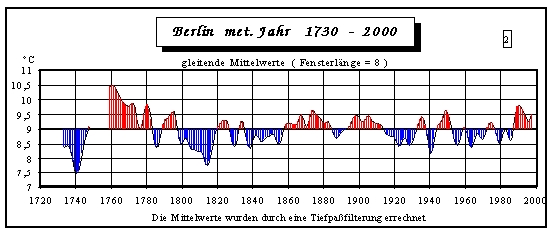

Für unsere Berliner Politiker zum Abschluss noch eine Datenreihe der dort gemessenen Temperaturen von 1730 – 2000, Quelle: (http://www.wetterzentrale.de/klima/tberlintem.html). Unnötig festzuhalten, dass es keinen Grund für irgendwelche Panik oder gar einer Klimasteuer oder Ähnlichem gibt. Auch in Berlin fallen die Temperaturen seit Jahren wieder, wie in der Abbildung 16 ersichtlich.

Abbildung 15

Die Abbildung 15 zeigt die Datenreihe der Temperaturen von Berlin im Zeitraum von 1730 – 2000. Deutlich zu sehen, dass es in der Vergangenheit teils deutlich höhere Temperaturen über längere Zeitintervalle gab als heute.

Die Abbildung 16 zeigt die Temperaturen in Berlin seit Dezember 2005 bis Dez. 2009. Auch in Berlin, wie überall auf der Welt, gehen die Temperaturen deutlich zurück. Die Max-Werte um einige °C.

Abbildung 16

Die Abbildung 16 zeigt den Temperaturgang in Berlin-Tempelhof von Dez. 2005 – Dez. 2009. Sowohl Min als Max-Temperaturwerte zeigen eine eindeutig fallende Tendenz, obwohl der CO2-Pegel in den vergangenen 4 Jahren deutlich angestiegen sein soll.

Es ist an der Zeit, dass unsere Politiker die Realitäten erkennen und nicht weiter unseligen Propheten der Klimakatastrophe verfallen, so wie dies noch jüngst von unserem Umweltminister Herrn Röttgen verlautbar wurde, der das Scheitern der Klimakonferenz von Kopenhagen, insbesondere den USA anlastete. Herr Röttgen sollte besser einmal in Erwägung ziehen, ob sich die dortigen Verantwortungsträger nicht längst den Realitäten stellten und vor allem, diese Realitäten auch berücksichtigen, während an manchen Stellen in Berlin anscheinend noch mittelalterliche Inquisition das Wort geredet wird.

Raimund Leistenschneider-EIKE

Die Dokumentation finden Sie auch als pdf Datei im Anhang

Related Files