Der Mann, der den Weg bereitete für den gesamten Betrug der vom Menschen verursachten globalen Erwärmung: Stephen Schneider.

Der Schub hinter diesem Betrug ist erstaunlich und im Moment nicht aufzuhalten. Er wird getrieben durch eine Sicherheit, die gestützt wird durch zusammengestümperte Beweise aus vorprogrammierten, vorbestimmten Ergebnissen von Computermodellen. Es gibt keine empirischen Beweise – also wie und warum ist dieser Glaube so beständig? Woraus speist sich der Gedanken dahinter, und woher kommt die Macht dieses Glaubens? Ich denke, dass es eine Person gibt, die man dafür verantwortlich machen kann, weil sie den Tenor vorgibt und das Mantra erschuf, dass Fakten unerheblich sind; er ermöglichte, dass die Illusion von AGW erhalten blieb, zu welchen Kosten auch immer. Das war so effektiv, dass man nicht einmal Fragen stellen kann, ohne gleich gesellschaftlich ins Abseits geschoben zu werden. Man wird einer jener „Leugner“.

Ich war sehr verärgert, als ich die Eloge auf Stephen Schneider im AR5 des IPCC lesen musste. Darin heißt es (Auszüge):

Der Synthese-Report des AR 5 ist dem Andenken an Stephen H. Schneider gewidmet, einem der führendsten Klimawissenschaftler unserer Zeit.

Steve Schneider, in New York geboren, durchlief eine Ausbildung als Plasma-Physiker, erhielt ein Stipendium im Bereich Klimawissenschaft vor fast 40 Jahren und bemühte sich unermüdlich um Wissenserweiterung in diesem Bereich und um Informationen für Politiker und der Öffentlichkeit zum großen und zunehmenden Problem Klimawandel und Lösungen, diesem zu begegnen. Zu jeder Zeit blieb Steve Schneider mutig und direkt beim Vertreten seiner Standpunkte. Seine Überzeugungen waren getrieben von der Stärke seiner außerordentlichen wissenschaftlichen Erfahrung … Seine Zusammenarbeit mit dem IPCC begann mit dem AR 1 1990, welcher eine bedeutende Rolle spielte bei der Gründung des UNFCCC. Sein Leben und seine Leistungen haben die Autoren dieses Reports inspiriert und motiviert.

Der letzte Satz sagt alles, aber nur, wenn man um die vollständige Verwicklung von Schneider in den größten Betrug aller Zeiten weiß.

Das Dilemma all dieser frühen Verfechter von AGW war Folgendes: falls sie um die Klimatologie wussten, wussten sie auch, dass die Arbeit des IPCC korrumpierte Wissenschaft war. Falls sie sich nicht dazu äußerten, wurden sie zu Komplizen dieses Betrugs. Falls sie es nicht besser wussten – und bemerkenswert Viele wussten es nicht – waren sie inkompetent. Oftmals wurde mancher nur auf die betrügerische Wissenschaft durch unpassende Umstände aufmerksam wie etwa den Kontakt mit einem bekannten Skeptiker.

Schneider wusste das alles, hatte er doch im Jahre 1976 ein Buch über globale Abkühlung veröffentlicht mit dem Titel „The Genesis Strategy“. Damals war die Abkühlung Konsens. Er schrieb:

Es gibt kaum noch gespeicherte Nahrungsmittel, um den Schock der Wetterprobleme abzumildern, welcher so plötzlich und unerwartet die Ernteerträge der Jahre 1972, 1974 und 1975 dezimierte, und es gibt immer mehr Beweise, dass derartig schädliches Wetter im nächsten Jahrzehnt häufiger vorkommen könnten als im vorigen Jahrzehnt. Die unmittelbarste und weit reichende Gefahr ist die Möglichkeit einer Nahrungsmittel-Klimakrise, welches die wohlhabenden Länder mit beispiellosen Preissteigerungen für Nahrungsmittel belasten würde, während in der nicht industrialisierten Welt (sic) Hunger und politische Instabilität um sich greifen würde.

Der Autor des Artikels in der NYT fasste Schneiders Arbeit mit den Worten zusammen: „… spiegelt den Konsens der klimatologischen Gemeinschaft in seinem neuen Buch „The Genesis Strategy“.

Zu jener Zeit gehörte auch ich der Klima-Gemeinschaft an, wusste aber aus historischen Aufzeichnungen und mit dem Verständnis der zugrunde liegenden Prozesse, dass es sich lediglich um einen weiteren Klimazyklus handelte. Zu viele Menschen beuteten den Schub aus, der sich aus der Finanzierung, aus Karriereschüben oder politischer Überzeugung ergab. Niemand betrachtete die Wissenschaft, oder noch schlimmer, sie suchten sich nur die Wissenschaft heraus, die ihre Haltung zu bestätigen schien. Sie sprangen auf einen Zug auf, den ich den Trend-Zug nenne, und argumentierten, dass dieser Zug immer weiterfahren würde. Es war falsch, zynisch, missbräuchlich und hatte nichts zu tun mit den wertfreien und apolitischen Positionen und Arbeiten zu tun, welche in der Wissenschaft unabdingbar sind.

Stephen Schneider gab den Tenor für das vor, was dann folgte. Seine verlogene, manipulative Philosophie fand Eingang in die Arena der Öffentlichkeit in seinem Interview im Magazin Discover im Jahre 1989. Darin sagte er unter Anderem:

Einerseits sind wir ethisch der Wissenschaftlichen Methode verpflichtet, also dem Versprechen, die Wahrheit zu sagen, die ganze Wahrheit und nichts als die Wahrheit. Das bedeutet, dass wir alle Zweifel, Schwächen und Möglichkeiten ansprechen müssen. Andererseits sind wir nicht einfach nur Wissenschaftler, sondern auch Menschen. Und wie die meisten Menschen wollen wir die Welt verbessern, was in diesem Zusammenhang heißt, daran zu arbeiten, das Risiko eines potentiell gefährlichen Klimawandels zu reduzieren. Um das zu tun, brauchen wir breit gefächerte Unterstützung, um die Vorstellung der Menschen anzusprechen. Das bedeutet natürlich umfangreichste Berichterstattung in den Medien. Also müssen wir ängstigende Szenarien entwerfen, vereinfachende dramatische Aussagen machen und wenig Aufhebens um irgendwelche Zweifel machen, die wir vielleicht noch haben. Diese doppelte ethische Bindung, in der wir uns häufig wiederfinden, kann nicht mittels irgendeiner Formel gelöst werden. Jeder von uns muss für sich entscheiden, was die richtige Ausgewogenheit ist zwischen effektiv und ehrlich zu sein. Ich hoffe, dass dies beides bedeutet.

Tut mir leid, Stephen, es gibt keine Entscheidung zwischen Effektivität und Ehrlichkeit. Tatsache war, dass er die korrupte Denkweise unterstrich und bloßstellte, welche den massiven Betrug erzeugte und vorantrieb. Das Problem ist, dass Menschen wie Schneider teuflische Genies sind. Es ist eine Sache, derartige Gedanken zu haben, aber eine ganz andere Sache, diese auch zu implementieren. Es ist das Gleiche wie die Implementation des Gedankens „die industrialisierten Nationen loswerden“ von Maurice Strong.

Im Jahre 1996 war Schneider Vizevorsitzender einer Konferenz, auf der sein Gedanke des Effektivseins ohne ehrlich zu sein angewendet wurde. Es war zwar eine Konferenz außerhalb des IPCC, doch waren alle in die IPCC-Korruption verwickelte Schlüsselpersonen involviert, die auch bei den durchgesickerten E-Mails der CRU maßgeblich benannt worden sind. Tatsächlich war die Konferenz ein Manifest, wie man vorangehen und wie man Wissenschaft und die Wahrheit auf jede Art und Weise an die Wand fahren könnte. Die Konferenz war betitelt mit „Characterizing and Communicating Scientific Uncertainty“. Ich empfehle, sich dieses Dokument vorzunehmen und zu beklagen, aber auch um zu erfahren, was Schneider angerichtet hat. Der Einleitungsabschnitt lautete:

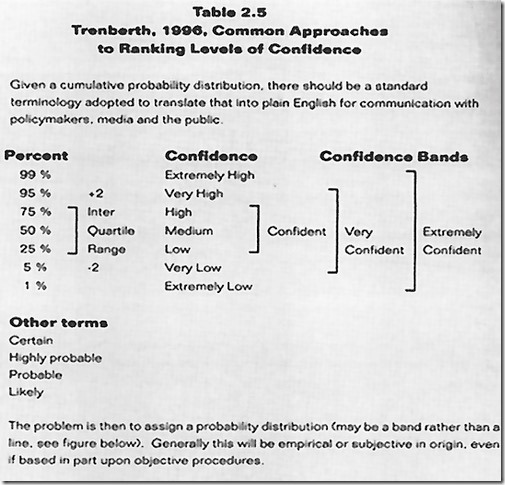

All the names are here, Santer, Schlesinger, Tol, Karl, MacCracken, and Trenberth with his first probability table (Figure1). It is an attempt to confuse by pretending to clarify.

Unsicherheiten, oder allgemeiner Debatten über das Niveau der Unsicherheit, welche notwendig sind für eine „solide“ Schlussfolgerung ist ein ewiges Thema in der Wissenschaft. Die Schwierigkeiten, Unsicherheiten zu erklären, wurden zunehmend dringlicher, trachtete doch die Öffentlichkeit nach politischen Vorgaben, wie man mit der globalen Umweltveränderung umgehen sollte. Wie kann Wissenschaft für die Gesellschaft am nützlichsten sein, wenn die Beweise unvollständig oder mehrdeutig sind, die subjektiven Beurteilungen der Experten bzgl. der Wahrscheinlichkeit des Eintretens der Ergebnisse variieren und Politiker nach Anleitung und Rechtfertigung suchen für Maßnahmen, die bedeutende gesellschaftliche Veränderungen nach sich ziehen dürften? Wie können Wissenschaftler ihre Charakterisierung der Unsicherheiten verbessern, so dass Bereiche mit geringer Uneinigkeit nicht gleichgesetzt werden mit rein spekulativen Bedenken, und wie können individuelle subjektive Beurteilungen zur Haltung ganzer Gruppen werden? Und außerdem, wie können Politiker und die Öffentlichkeit diese Ergebnisse verstehen und für angemessene Entscheidungen anwenden? Kurz gesagt, wie können wissenschaftliche Ergebnisse in öffentlichen politischen Debatten fair und offen angesprochen werden?“

Alle üblichen Verdächtigen tauchen hier auf: Santer, Schlesinger, Tol, Karl, McCracken und Trenberth mit ihrer ersten Wahrscheinlichkeitstabelle (Abbildung). Es ist der Versuch der Verwirrung unter dem Deckmantel der Klarstellung:

Die Einbeziehung der Eloge über Schneider und die darin enthaltene Rührseligkeit hinsichtlich seines Einflusses auf sie und den gesamten IPCC-Prozess sind der absolute Beweis meiner These. Mehr als jeder andere erzeugte er den größten Betrug der Geschichte und trieb ihn voran. Er intellektualisierte auf das Perverseste das Konzept von Unsicherheit in Sicherheit und gab das Verfahren vor, mit welchem man unzureichende und falsche Beweise in eine Form umwandeln konnte, die stark genug war, um zur Grundlage einer die Welt verändernden Philosophie und Politik zu werden.

Übersetzt von Chris Frey EIKE