Der Wärmeinseleffekt als maßgeblicher Treiber der gemessenen Temperaturen

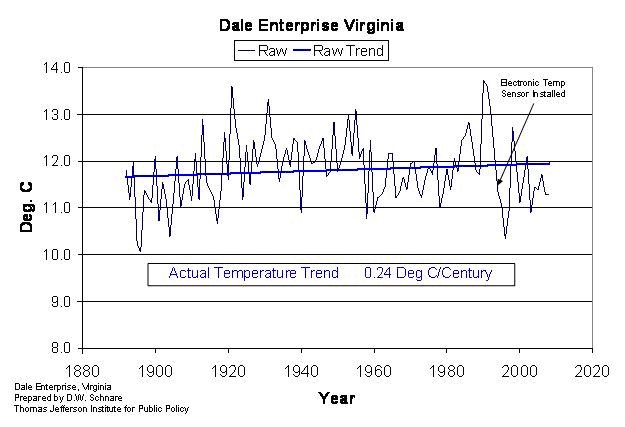

Bezugnehmend auf unseren Artikel, sah sich der DWD gezwungen, EIKE eine Gegendarstellung zukommen zu lassen, die wir beantworteten und darin belegen konnten, dass unsere Artikel nichts an Richtigkeit und damit Brisanz verloren hatten. Einer wissenschaftlichen Diskussion stellte sich der DWD indes nicht. In der jüngst erschienenen Arbeiten von Anthony Watts über die Wirkung dieses Effektes in der er belegen konnte, dass auch in den USA die ausgewiesene Erwärmung doppelt so hoch angegeben wird, als wie in der Realität gemessen und damit nicht nur – wie wir damals zeigten- in Deutschland. Dieser Beitrag wird nun zeigen, dass der der Studie von Watts et al vorschnell entgegen gehaltene Argument, sie hätte den sog. TOBs (Time of Observation Errors) nicht berücksichtig, abwegig ist und am Ergebnis nichts ändern würde, wenn es so wäre.

Trotz der immer bescheideneren Sommer, der immer kälteren Winter, wird uns von Seiten diverser Institute und meteorologischer Behörden erzählt, die Temperaturen würden immer weiter ansteigen. Wir möchten diesen Behörden nicht vorhalten, sie würden falsche Zahlenwerte verbreiten, aber was werden dort für Temperaturen gemessen, die als Vergleich mit früheren Messwerten herangezogen werden? Sind sie geeignet, um Aussagen über eine vermeintliche Erwärmung und vor allem, deren Höhte, treffen zu können? Einer von uns (Leistenschneider) hat eine eigene Methodik entwickelt, mit der der WI aus einer vorhandenen Messreihe herausgerechnet werden kann. Ähnliche Verfahren werden zwar auch von anderen Autoren benutzt. (A. Watts, Tom Karl (1), Frank Lansner etc.).

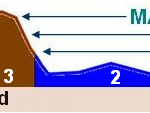

Abbildung 1, (Quelle hier ) zeigt einen Querschnitt durch Regionen in den USA, die Lansner untersuchte. Er weist zu Recht darauf hin, das die Stationslage in Bezug auf ihre Umgebung (z.B. Küste, Küstennah; Gebirge, Ebene) einen wesentlichen Einfluss auf die gemessene Temperatur hat. Wobei es nicht ausreicht, wenn nur „UHI-freie“ Stationen mit „UHI Behafteten“ im Umkreis zur Homogenisierung verglichen werden. Dadurch entstehen nur neue Fehler.

Die von uns verwendete Methodik vergleicht dazu jedoch auf eine andere Weise eine Referenzstation mit der zu untersuchenden Messreihe. Die Theorie für diese Methodik basiert auf zwei fundamentalen Gesetzen der Physik:

- • Dem Strahlungsgesetz nach Planck und dem

- • Abkühlungsgesetz nach Newton

Das Strahlungsgesetz nach Planck gesagt, dass ein Körper umso mehr Energie pro Zeit abstrahlt, umso wärmer er ist. Das Abkühlungsgesetz nach Newton gibt an, dass eine Masse, umso mehr Energie pro Zeiteinheit verliert (kälter wird), je wärmer er ist. Dies heißt in der Praxis nichts anderes, dass mehr Energie notwendig ist, einen 300 Kelvin warmen Körper um 10 Kelvin zu erhöhen, als einen 250 Kelvin warmen Körper um den gleichen Betrag. In einer Erwärmungsphase muss es also zu einer Angleichung zwischen einer wärmeren und einer kälteren Station kommen. Mit seiner Aussage, dass sich arktische Gebiete schneller erwärmen würden als wärmere, sagt das IPCC im Prinzip nichts anderes, wenn auch die dort genannten Erwärmungswerte von 3 Kelvin und mehr, auf einer falschen Datenlage beruhen, da z.B. das GISS im betroffenen arktischen Gebiet gar keine Messstation hat (WUWT und EIKE berichteten ausführlich darüber).

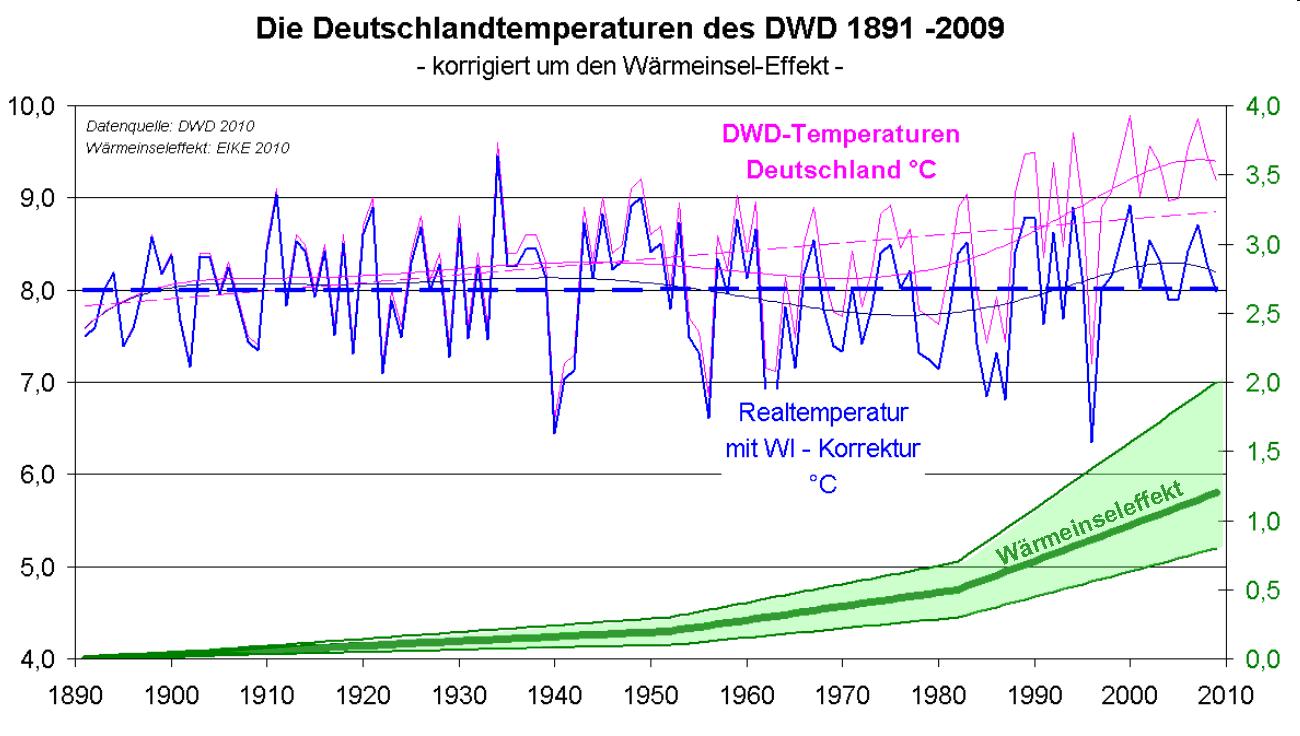

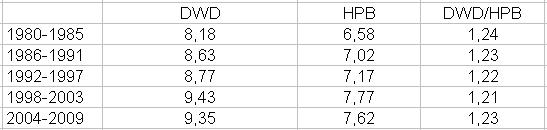

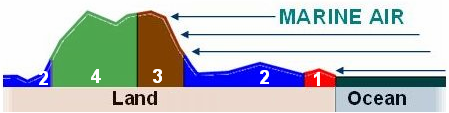

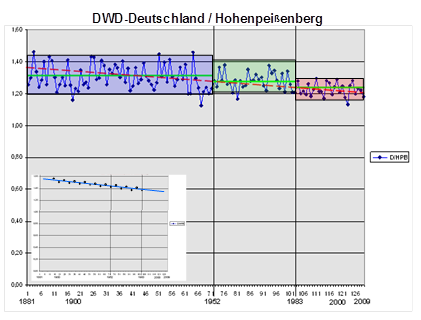

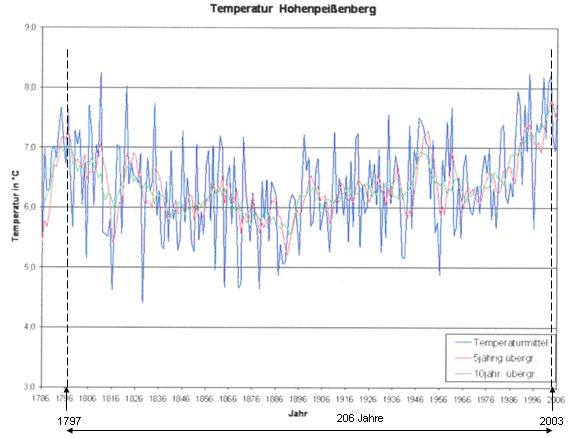

Für ein Betrachtungsland (z.B.: Deutschland) ist die von der Sonne zur Verfügung gestellte Energie und für die Referenzstation gleich, sowie der CO2-Backgroundlevel (für die Anhänger des AGW). Als Referenzstation, ohne nennenswerten*2) WI, haben die Autoren die meteorologische Station auf dem Hohen Peißenberg (HPB) gewählt, die nach eigenen Angaben des DWD als Referenzstation gilt und von der seit dem Ende des 18. Jahrhunderts verlässliche Temperaturdaten vorliegen (Abbildung 2).

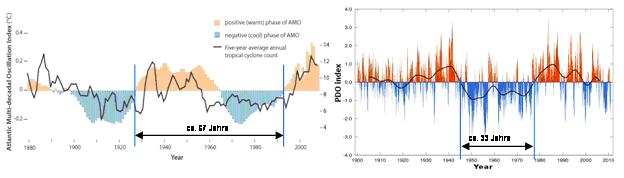

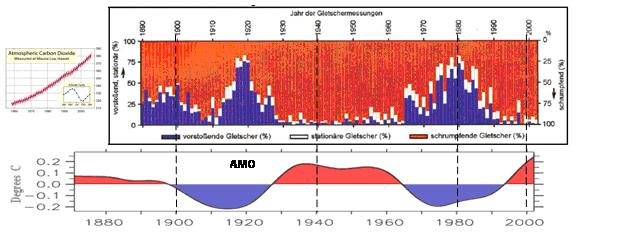

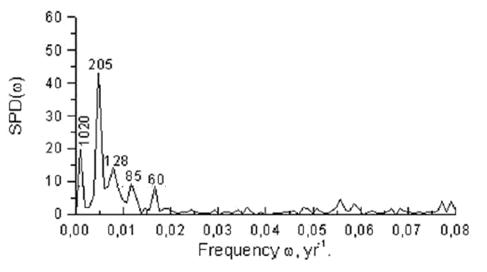

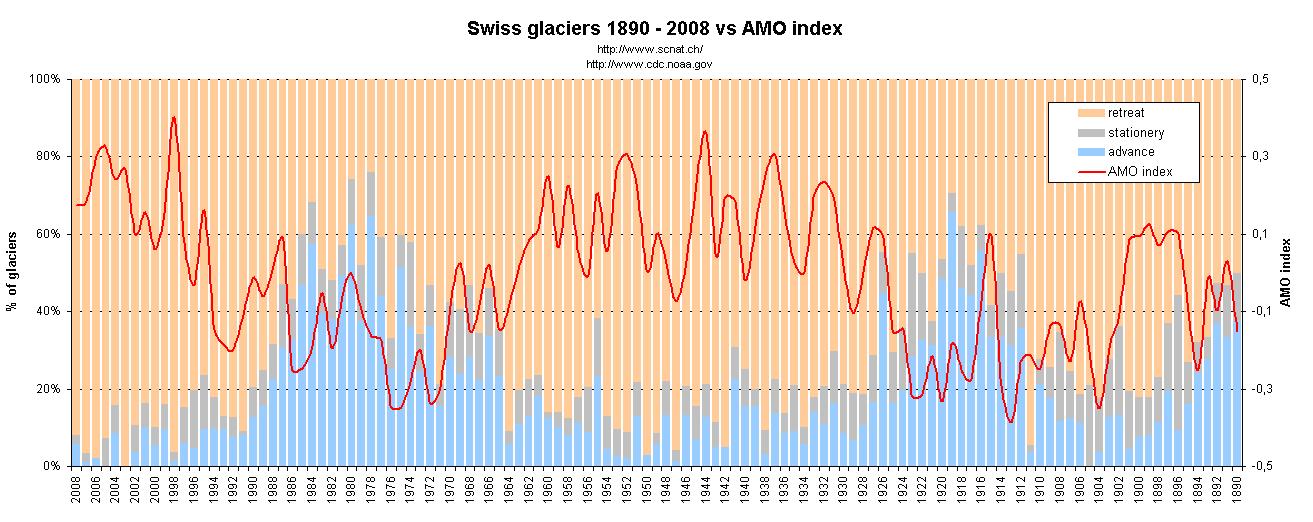

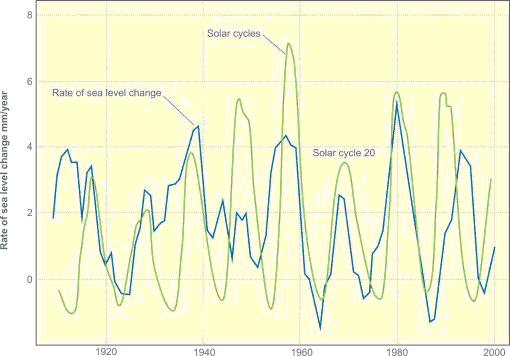

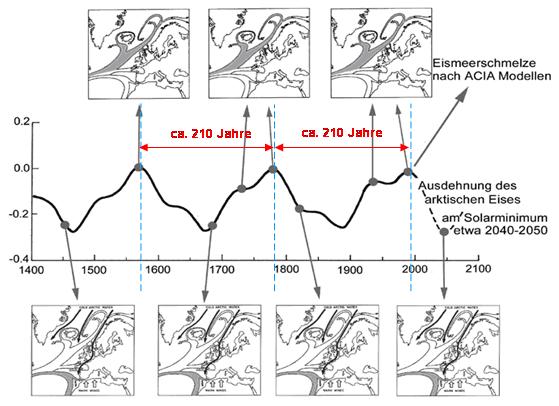

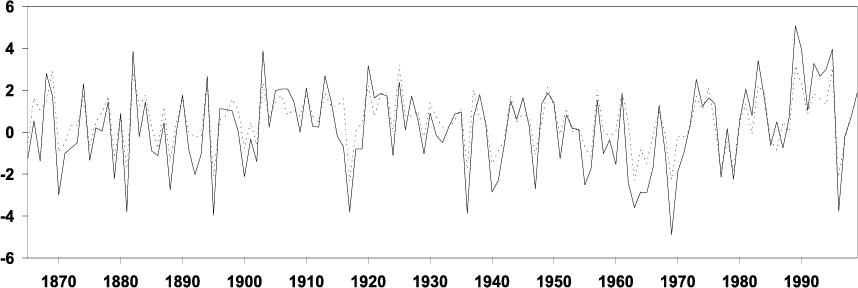

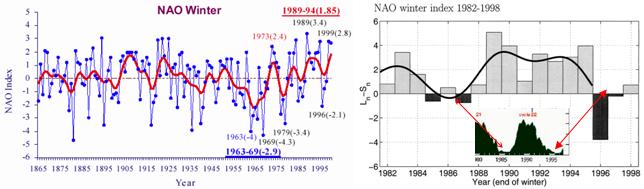

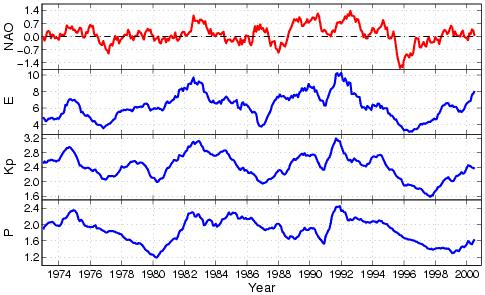

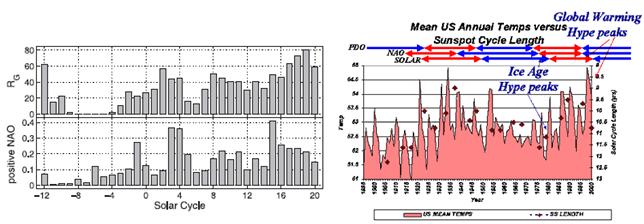

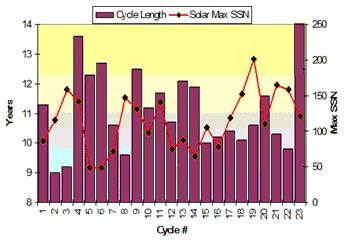

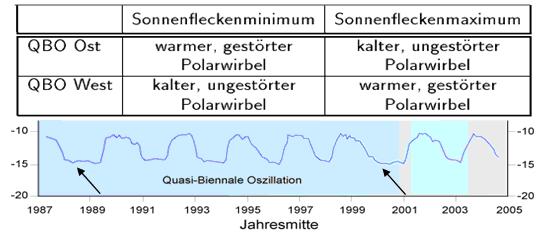

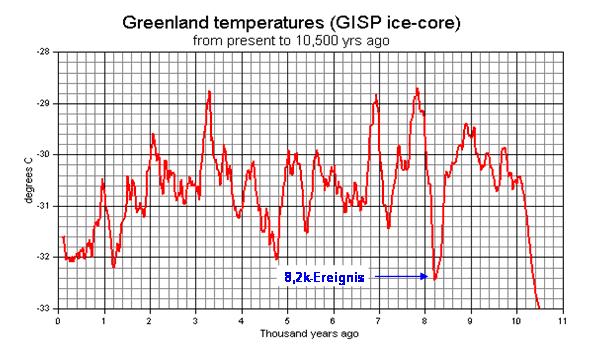

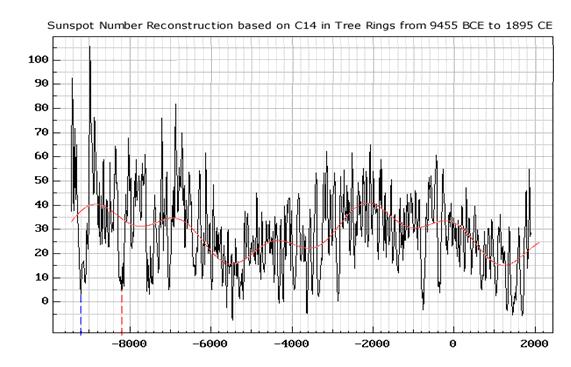

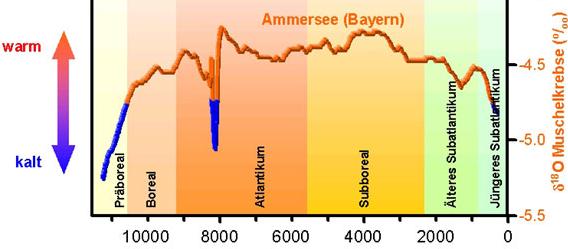

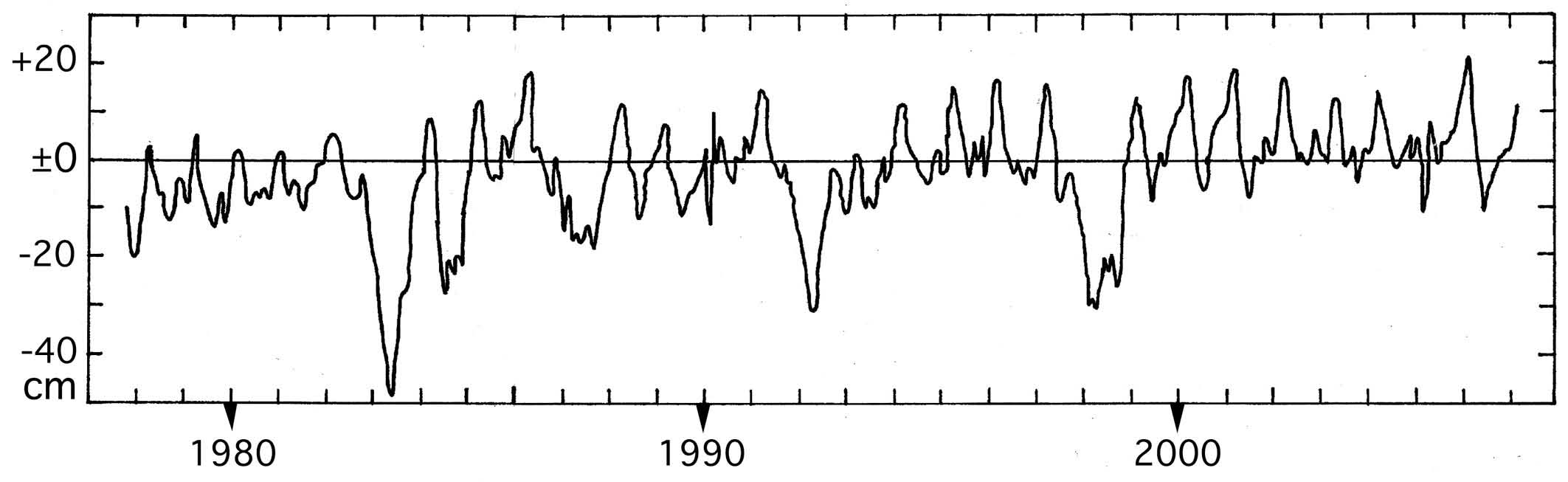

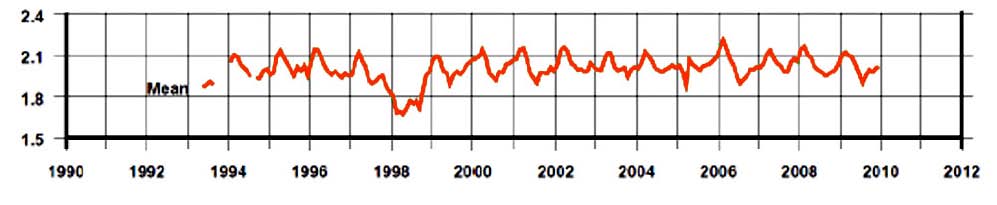

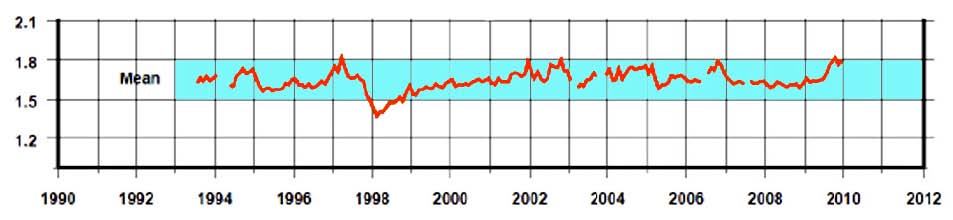

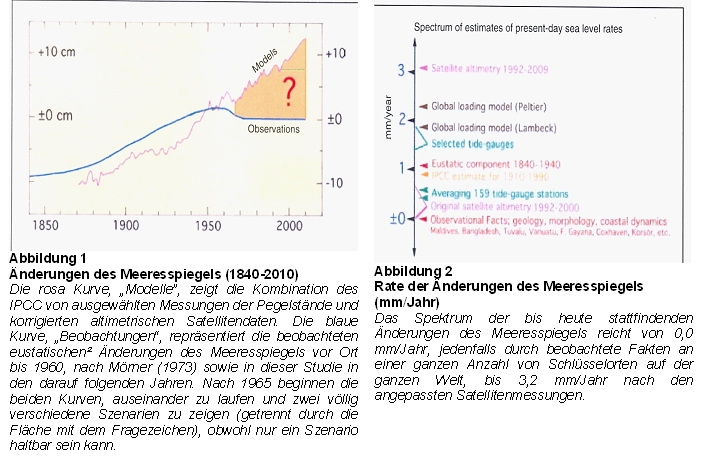

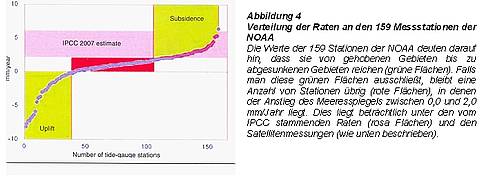

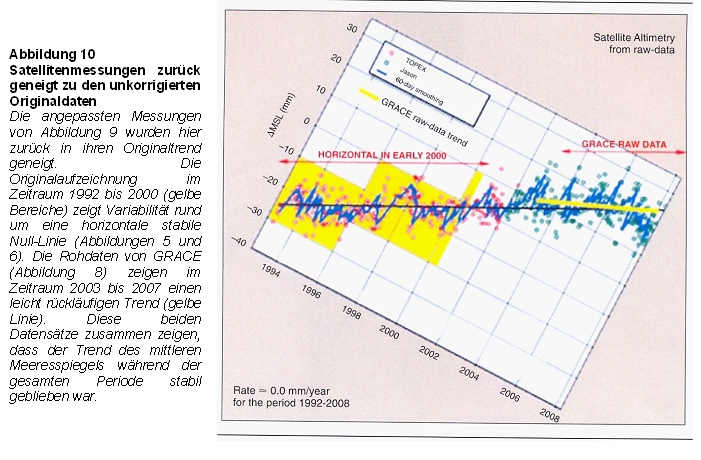

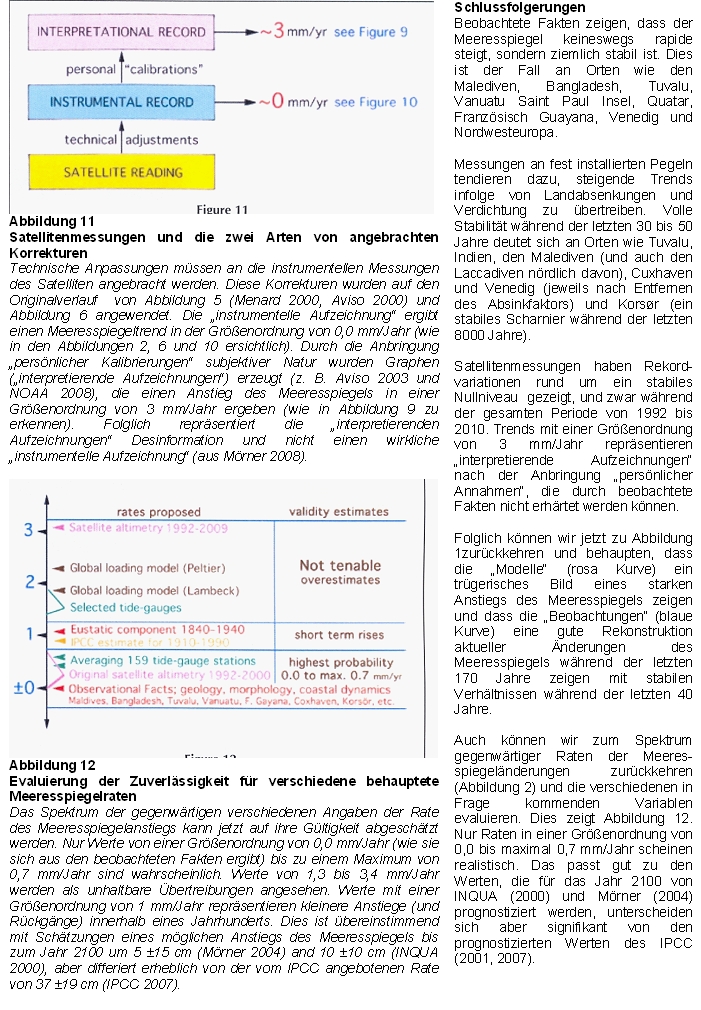

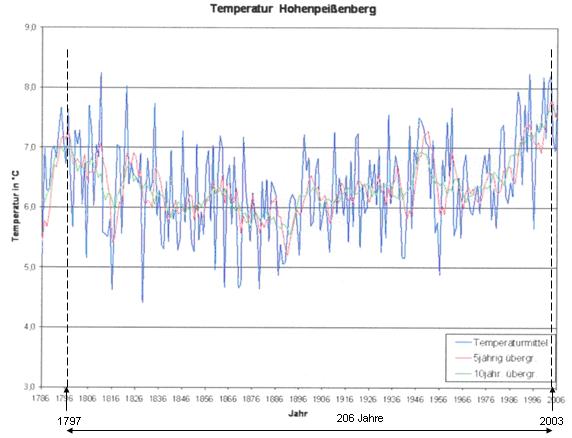

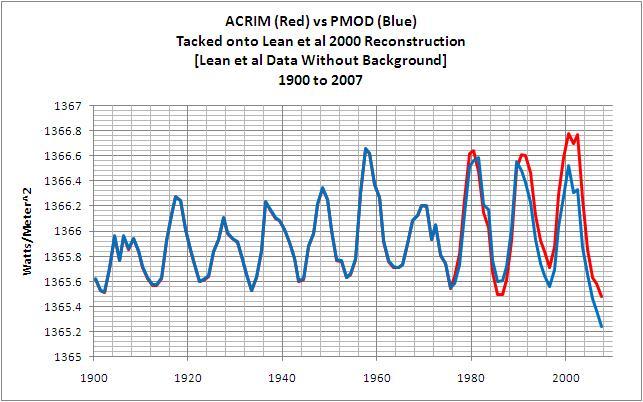

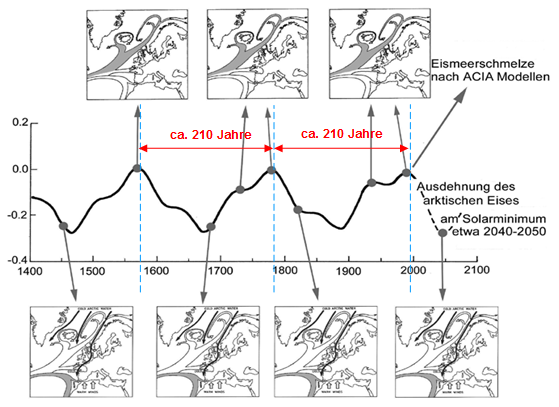

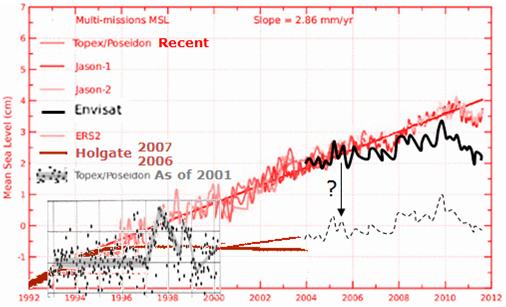

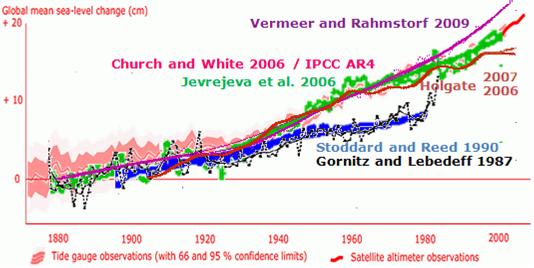

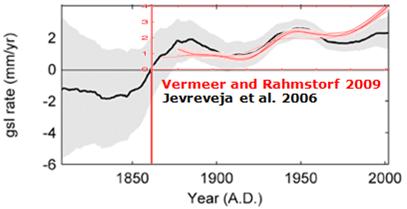

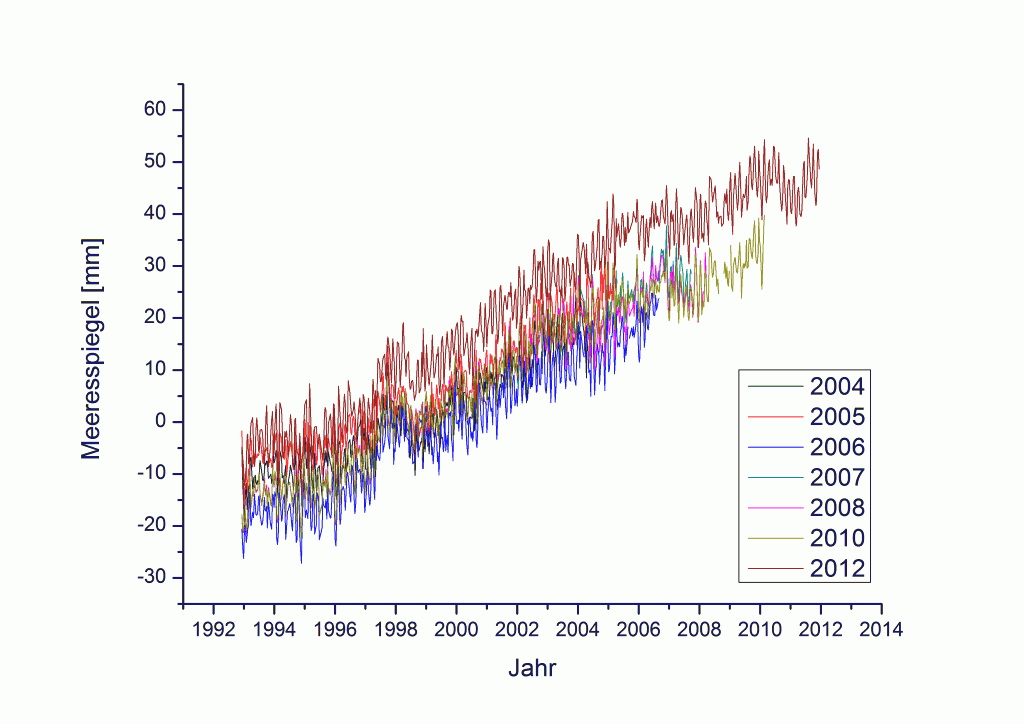

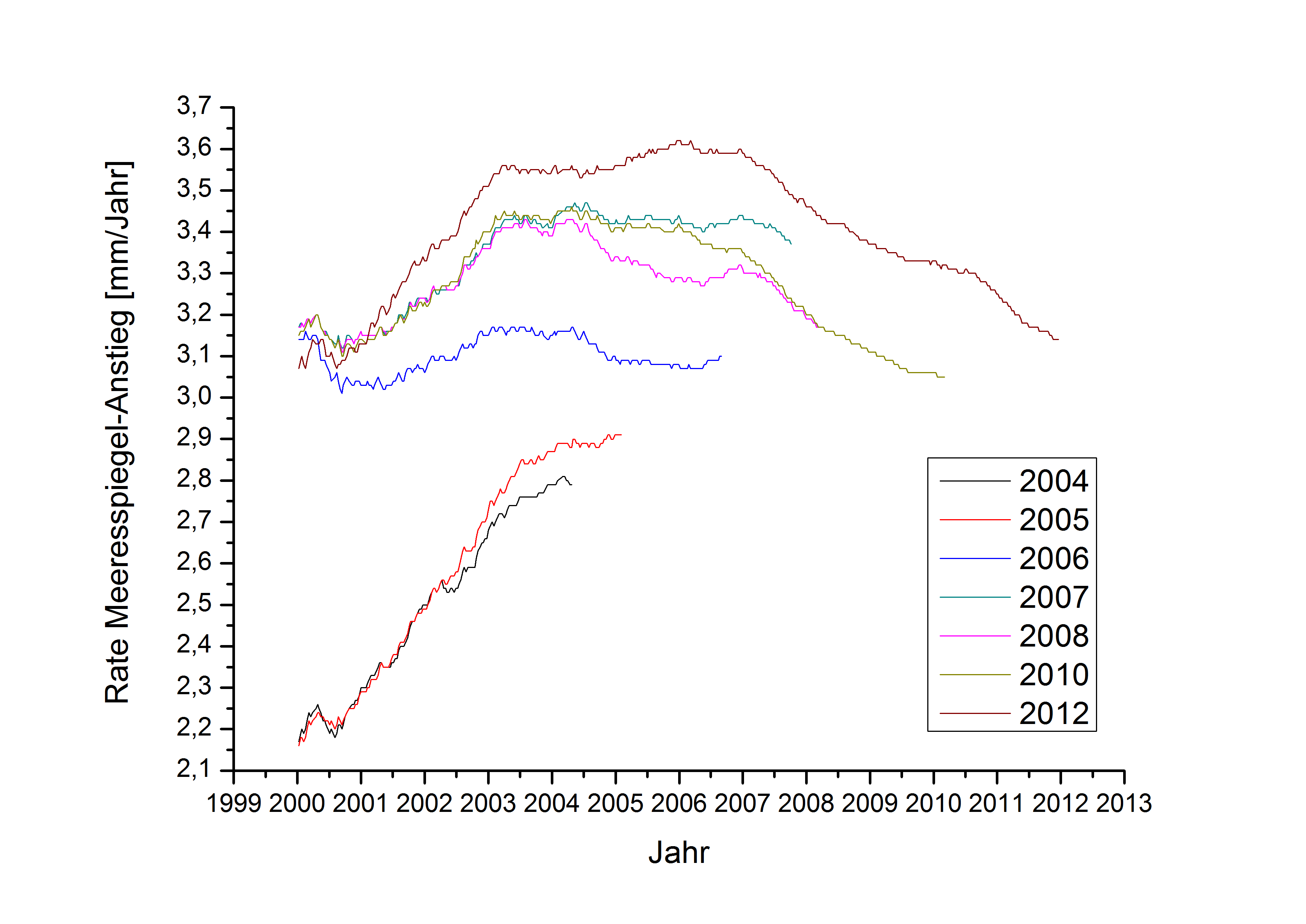

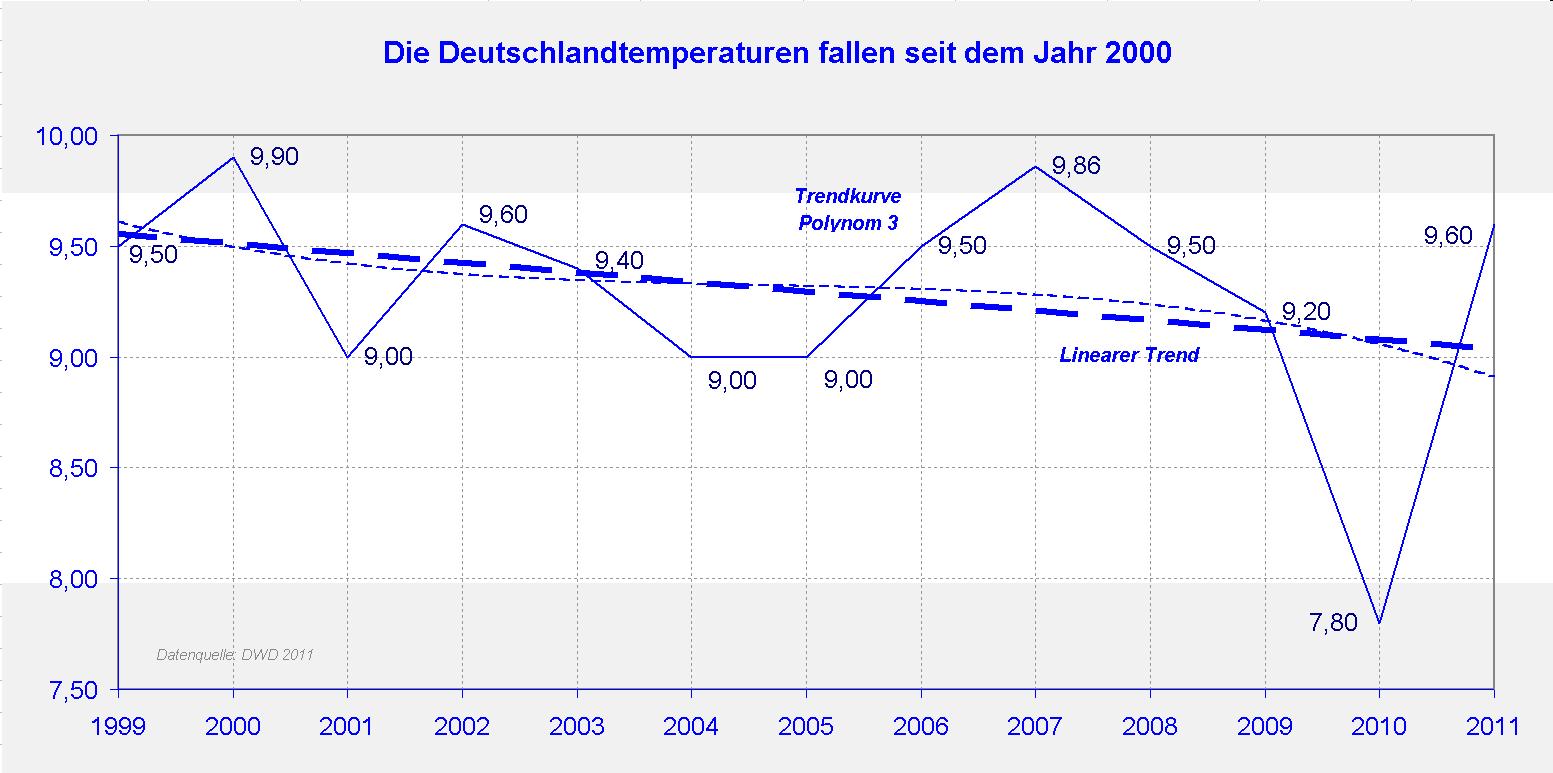

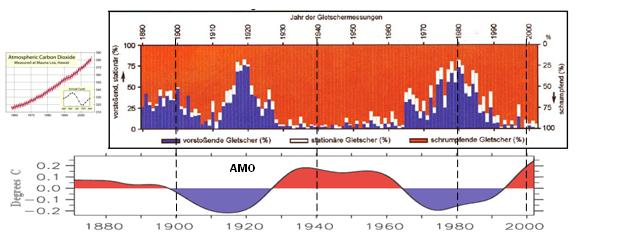

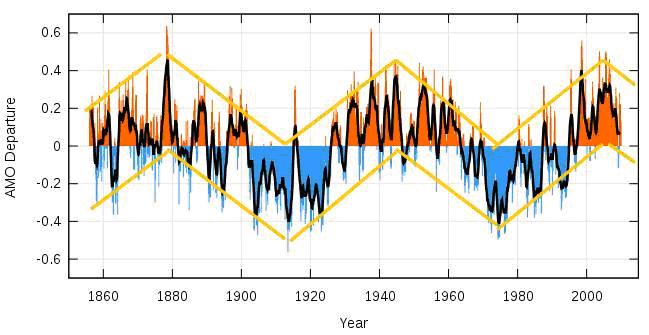

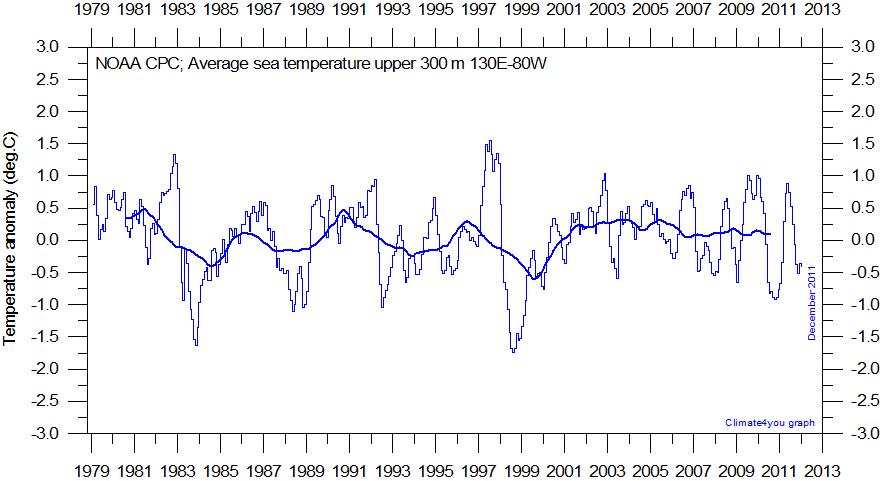

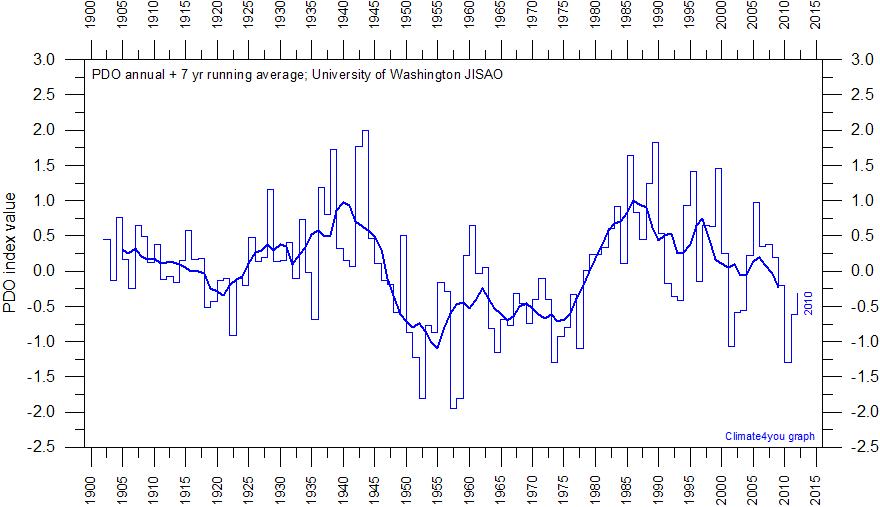

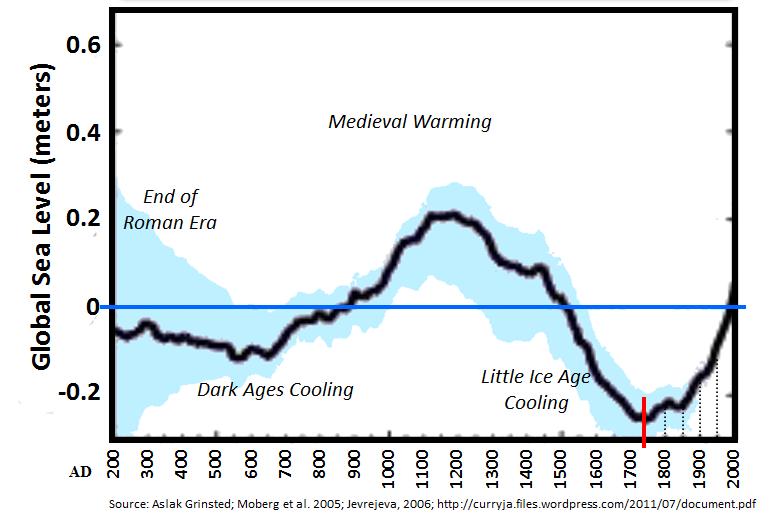

Abbildung 2 * zeigt die Temperaturentwicklung am HPB von 1786 – 2006. Deutlich ist ein natürliches Schwingverhalten zu sehen, deren Periode bei ca. 206 Jahren liegt (Maxima der 5 und 10-Jahrestrends). Darin spiegelt sich der Hauptsonnenzyklus, der im Mittel 208-jährige de Vries/Suess-Zyklus, der in 2003, als Europa unter einem Hitzesommer3 litt, sein Maximum hatte. Seitdem fällt die solare Aktivität. Hauptsonnenzyklus deshalb, weil die Fourieranalyse der Wolfzahl (Sonnenflecken) dort die stärkste Periode ergibt. Dr. Axel Mörner2 hat in seiner Arbeit “Keine Gefahr eines globalen Meeresspiegelanstiegs“ transparent gezeigt, wie der Hauptsonnenzyklus die arktische Meereisbedeckung bestimmt (Abbildung 3).

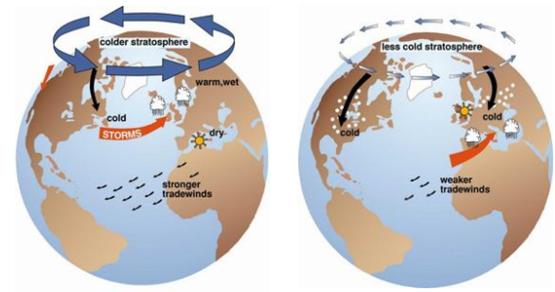

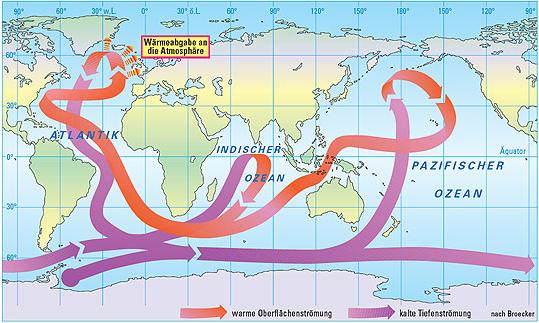

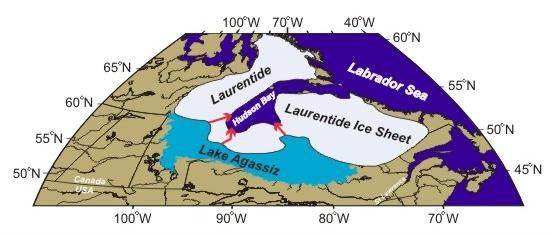

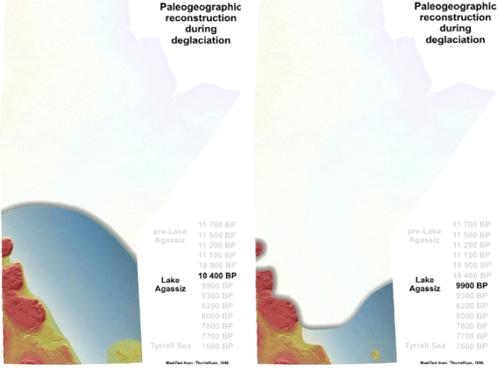

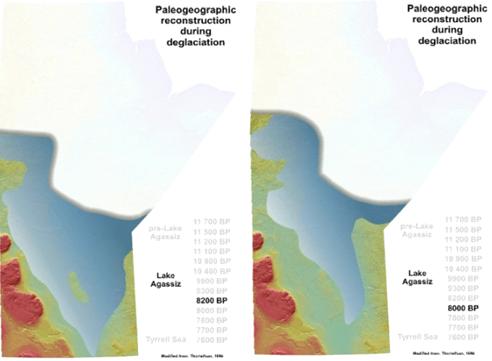

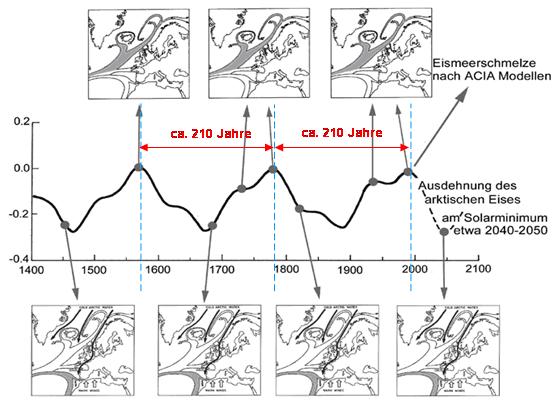

Natürliche Schwankungen auf die Meeresströmungen im Nordatlantik und somit auf den Golfstrom, zeigt Abbildung 3, Quelle: Dr. Axel Mörner, “Keine Gefahr eines globalen Meeresspiegelanstiegs“. Die Abbildung wurde vom Autor um den de Vries/Suess-Sonnenzyklus (Zeiten) ergänzt. Zu sehen ist die arktische Eisentwicklung in Verbindung mit den vorherrschenden Meeresströmungen in Relation zum Hauptsonnenzyklus (de Vries-Suess-Zyklus). Sowohl die arktische Eisbedeckung, als auch das Muster der Meeresströmungen folgt dem im Mittel 208-jährigen de Vries-Suess-Zyklus. Bei Sonnenminima erleben Nordwesteuropa, der Nordatlantik und die Arktis Kaltphasen. Die Abbildung zeigt weiter, dass für die nächsten 30 – 40 Jahre eine arktische Eisausdehnung und keine Eisschmelze zu erwarten ist. Weiter zeigt die NASA, dass die Sonne zum ausgehenden 20. Jahrhundert immer aktiver wurde.

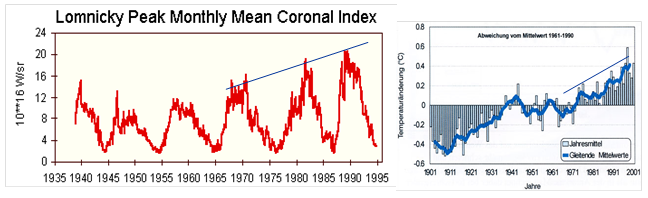

Abbildung 4 links (Quelle: hier ) zeigt die gesamte Strahlungsleistung der Korona von 1938 – 1995 in W/sr, mit r = 2.800 MHz Radio flux. Deutlich ist zu sehen, dass parallel zum (leichten) Temperaturanstieg die Strahlungsleistung der Korona stark (25%) ansteigt. Hierbei handelt es sich um die tatsächliche Strahlungsleistung und nicht, wie beim TSI, um die Strahlungsleistung eines kleinen Wellenlängenbereiches (Leistenschneider ging in seiner 8-teiligen EIKE-Reihe “Dynamisches Sonnensystem – Die tatsächlichen Hintergründe des Klimawandels“ in 08/11 ausführlich darauf ein). Die NASA beweist damit, dass die Sonne bis zum ausgehenden 20. Jahrhundert immer aktiver wurde. Die rechte Abbildung zeigt die globale Temperaturentwicklung nach Jones.

Aufgrund seiner natürlichen Schwingung, die dem Hauptsonnenzyklus entspricht, gehen wir davon aus, dass HPB weitgehend WI-frei* ist und damit grundsätzlich als Referenzstation geeignet ist. Zur Berechnung des WI werden beide Datenreihen (Deutschland und HPB) in Relation zueinander gesetzt.

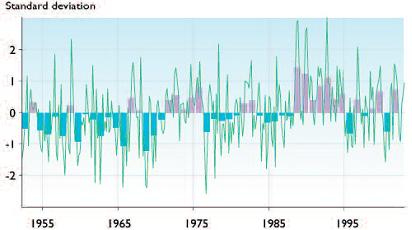

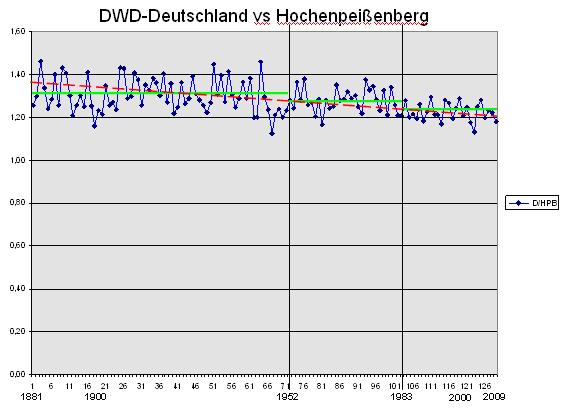

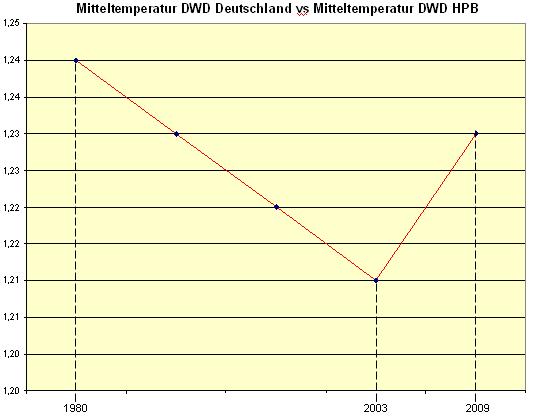

Abbildung 5 zeigt die Datenreihe D/HPB im Zeitraum 1881 – 2009. Für Deutschland liegen erst ab 1881 Daten vor, daher kann die Datenreihe erst 1881 beginnen. Die Datenreihe zeigt, dass sich die Werte von HPB und Deutschland mehr und mehr angleichen (Trend ist negativ). D.h., auf HPB wird es vergleichsweise (in %) mehr warm. Dies liegt daran, dass sich kalte Gebiete, fernab von Zivilisations- also WI-Einflüssen, relativ schneller erwärmen. Drei Bereiche sind erkennbar, in denen die Werte jeweils um einen gemeinsamen Mittelwert pendeln. Nach Planck und Newton muss die Annäherung beider Stationen in einer Erwärmungsphase gleichmäßig verlaufen. D.h., die gemessenen Streuwerte der Temperatur müssten sich statistisch gleichmäßig um die Ausgleichsgerade verteilen (kleine Abbildung, idealisiert dargestellt). Das tun sie aber nicht, wie der tatsächliche Verlauf zeigt. In drei Bereichen verlaufen sie waagerecht, d.h., zusätzliche Energie ist notwendig, um die Angleichung zu verhindern. Diese kann nur vom WI kommen, da die Sonne für beide gleichermaßen strahlt.

In der Relationskurve (Abbildung 5) ist demnach der WI „verborgen“. Der WI ist in der Dämpfung (oder Spreizung, je nach Betrachtung) des DWD-Temperaturverlaufs zu HPB enthalten, weil die DWD-Deutschland-Daten relativ weniger steigen und in der statistischen Verteilung der Temperaturstreuwerte (farbige Bereiche). Die durch den WI höheren Temperaturen, dämpfen den Erwärmungstrend, bzw. erzwingen eine andere Verteilung. Um den WI in den zu sehenden Zeiträumen zu ermitteln (für die Zeiträume 2 und 3 berechnet), wird folgendermaßen vorgegangen:

- • Ermittlung der jeweiligen Mittelwerte für D und HPB in den o.g. drei Zeiträumen (1881 – 1952, 1953 – 1982 und 1983 – 2009). Ergibt 6 Mittelwerte.

- • Differenzbetrachtung der Mittelwerte von Epoche Xn+1 zu Xn. Getrennt für HPB und D (ergibt 4 Differenzmittelwerte, da Epoche 0 – vor 1881 – nicht bekannt ist, bzw. nicht in die Bewertung einfloss, da diese Werte nach dem DWD, für Deutschland zu ungenau sind).

- • Betrachtung der jeweiligen Epochendifferenzwerte zueinander, d.h. Wert für D2 (2 steht für Epoche 2) wird mit Wert HPB2 verglichen und die Differenz bestimmt.

- • Mit dieser Differenz wird der jeweilige WI im 2. und 3. Zeitraum berechnet.

- • WI im 1. Zeitraum wurde mit 0,2°C konservativ geschätzt. Grund des WI: Andere Verteilung der Stationen, andere Messsysteme, andere Flächen – Deutschland wurde kleiner (um die Hälfte) und große Landschaftsflächen fielen weg, Beginn der industriellen Landschafts-veränderung, …

- • WI HPB von 1881 – 2009 mit 0,2°C anhand der Bebauungsveränderungen abgeschätzt.

Dass auch HPB nicht WI-los sein kann, liegt daran, dass die Messstation bis 1940 im dortigen Kloster untergebracht war und anschließend in die meteorologische Station verlegt wurde. Im Kloster war nur ein Raum, nämlich der Gemeinschaftsraum, beheizt, in der jetzigen Station aber alle Gebäude die zum Komplex gehören. Der damalige Leiter hatte gefordert, in der Übergangszeit Parallelmessungen durchzuführen, was jedoch nicht geschah. Die alte Wetterstation wurde dann den Mönchen weggenommen und bekam ein eigenes Gebäude beim Friedhof, das seinerseits ständig erweitert und beheizt wurde. Heute stehen dort umfangreiche Gebäudekomplexe. Außerdem wurde allmählich ein stetig sich vergrößernder Parkplatz angelegt, der zugleich auch als Parkplatz für den Friedhof in der Nachbarschaft dient. Fassungsvermögen geschätzt, etwa 100 Autos.

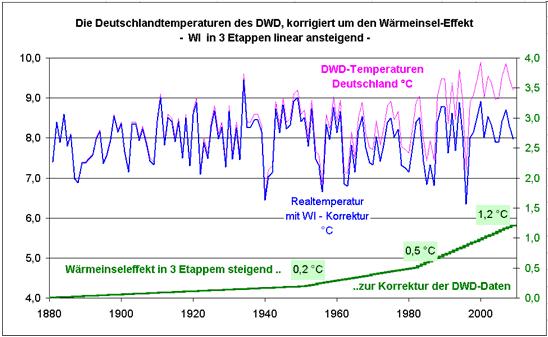

Daraus folgt zwingend: Bis 1940 hatte der HPB keinen WI. Dann hat er einen geringen, wegen zunehmender Bebauung entwickelt. Wie eingangs geschildert, ist die Station nicht (mehr) vollständig WI-frei, wie sie allgemein in der Literatur und vom DWD dargestellt wird. Für die drei Zeiträume ergibt sich für Deutschland ein dynamischer WI:

Zeitraum 1: 1881 – 1952 = +0,2°C

Zeitraum 2: 1953 – 1982 = +0,3°C

Zeitraum 3: 1983 – 2009 = +0,6°C

Der Gesamt-WI ist die Steigung über alle drei Zeiträume.

WI-Deutschland über alle drei betrachteten Zeiträume von 1881 – 2009 = +1,1°C.

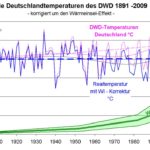

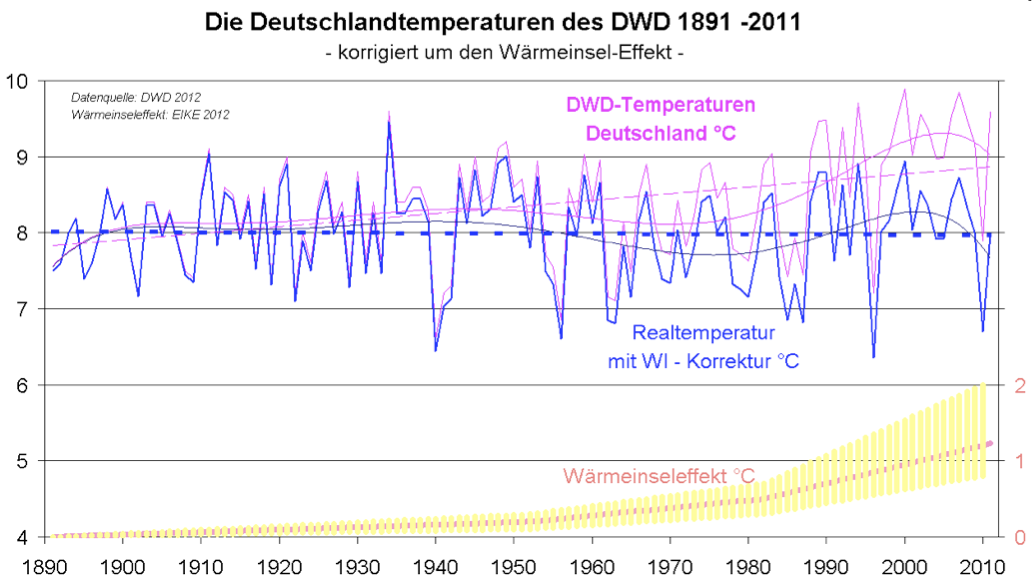

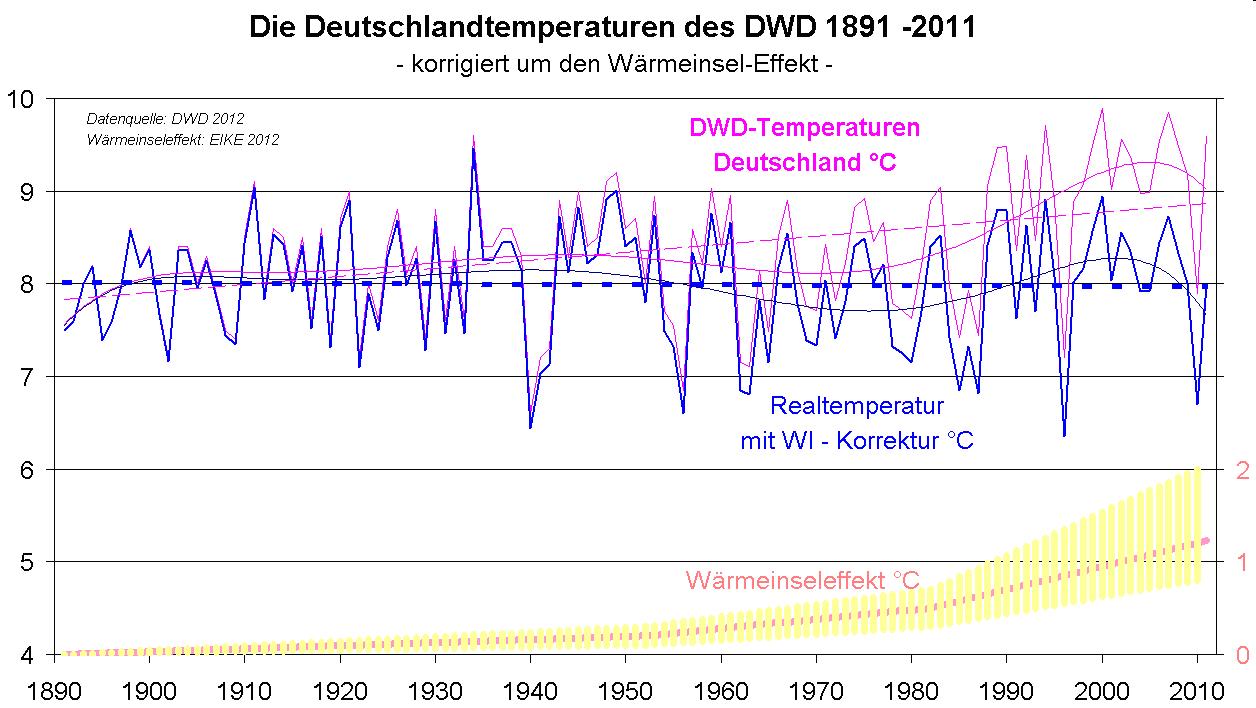

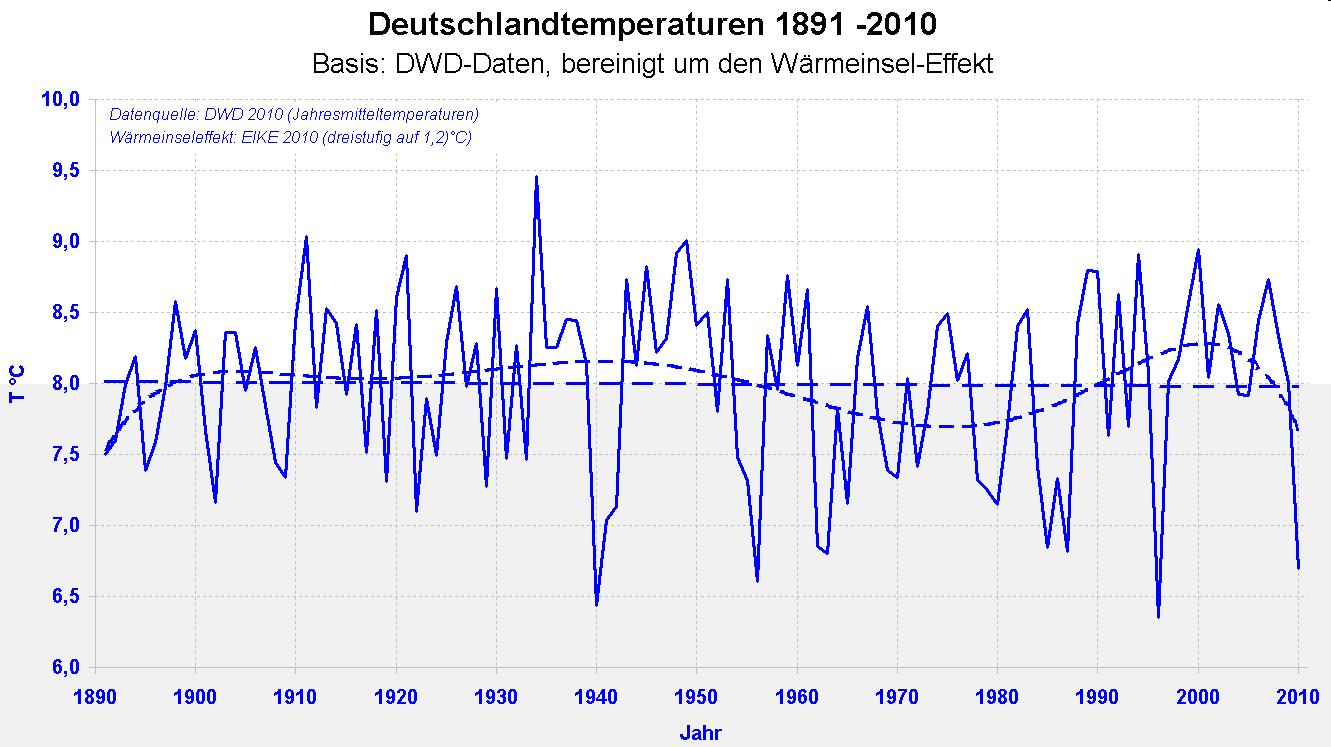

Abbildung 6 zeigt den unmittelbaren Vergleich der Deutschlandtemperaturen DWD und der WI-bereinigten von 1891 – 2011. Die blau gestrichelte Linie zeigt den Temperaturmittelwert im Betrachtungszeitraum. Die Temperaturen in Deutschland durchbrechen die Mittellinie nach unten, was bedeutet, dass die heutigen Temperaturen im 120-Jahresvergleich zu kalt sind. Zum berechneten WI wurde, wie dies auch beim IPCC üblich ist, der Fehlertoleranzbereich angegeben (gelb). Der Fehlertoleranzbereich trägt folgenden Punkten Rechnung:

Der WI-Wert der 1. Epoche musste abgeschätzt werden, da die davor liegende Vergleichsperiode zur Berechnung nicht zur Verfügung steht. Dabei wurde konservativ vorgegangen und der WI mit +0,2°C nach folgenden Kriterien festgelegt:

- • Große ländliche Gebiete fielen 1945 im Osten weg.

- • Die um die Jahrhundertwende beginnende Industriealisierung Deutschlands, die besonders in den 1930-Jahren forciert wurde.

- • Die Umwandlung großer Naturflächen in Agrargebiete, mit der damit verbundenen Entwässerung der Landschaft – Verdunstungswärme, die kühlend wirkt, entfiel.

Sowie, dass HPB durch die Bebauungsmaßnahmen nicht mehr vollständig WI-los ist.

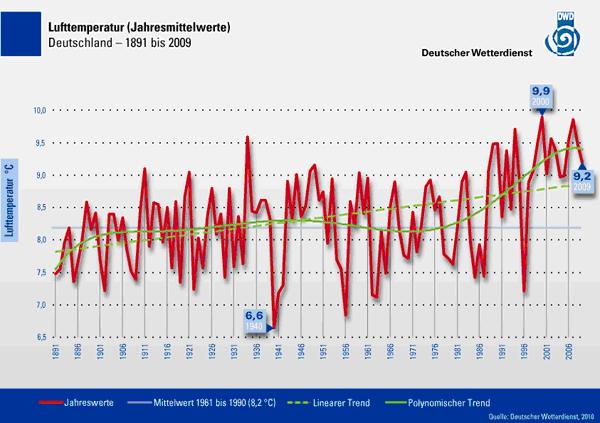

Unsere Untersuchung zeigt, dass mehr als die Hälfte der ausgewiesenen, gemessenen Erwärmung, auf den WI entfällt und von den +1,9°C, die der DWD für den Betrachtungszeitraum4 angibt, nur +0,8°C tatsächliche Erwärmung übrig bleiben. Somit exakt dieselben Werte, die auch Anthony Watts in seiner jüngst erschienenen Arbeit veröffentlichte. Der Vergleich unseres Ergebnisses mit der breitengradabhängigen Erwärmung für den 49-Breitengrad (geographisches Mittel für Deutschland) erhärtet unser Ergebnis.

TOB Time of Observation Error (Bias)

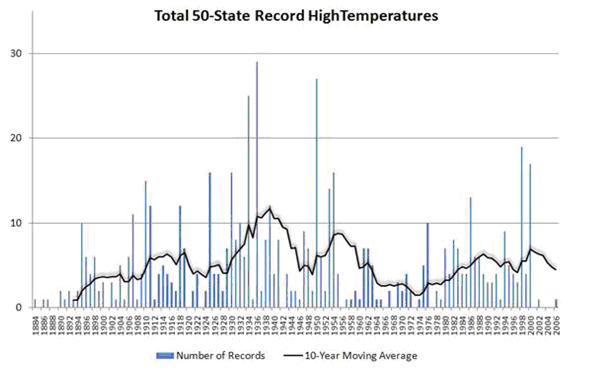

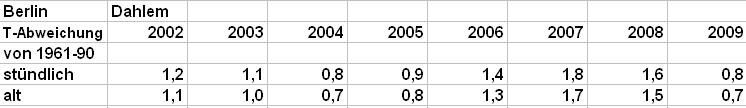

Was hat nun unsere Arbeit als Beleg für die Untersuchung von Anthony Watts zu tun? Sehr viel, da ihm vorgehalten wird, er hätte den TOB (Time of Observation Error) nicht berücksichtigt. Der ist jedoch nur relevant bei Mittelwerten, die aus Min/Max-Werten, wie in den USA gebildet werden, nicht aber bei Mittelwerten aus täglichen Mehrfachmessungen zu festen Zeiten, wie sie von Anfang an in Deutschland zur Anwendung kommen. Bis zum April 2001 wurden in Deutschland nach dem Mannheimer Verfahren die Mittelwerte gebildet. Gemessen wurde um 7:00, 14:00 und 21:00 Uhr, wobei der letzte Wert doppelt gezählt wurde. Seit April 2001 wurde stündlich gemessen (allein diese Umstellung brachte auf Grund der Asymmetrie des Temperaturtagesgangs eine scheinbare Temperaturerhöhung von +0,1°C, wie Leistenschneider anhand der Station Berlin-Dahlem nachweisen konnte) und seit 2009 sogar halbstündlich. Dennoch zeigt unsere Untersuchung, die exakt gleichen Relations wie Anthony Watts – d.h. die gemessenen Temperaturen liegen gut doppelt so hoch, wie die tatsächlichen Vergleichstemperaturen. Der Grund dafür braucht nicht lange gesucht zu werden. Er liegt in der Konzentration der ausgesuchten Messstationen in Städten und auf Flughäfen. So liegen mehr als 52% aller GHCN-Messstationen auf Flughäfen. Was es damit auf sich hat, zeigte bereits vor mehr als 2 Jahren WUWT (Abbildung 6).

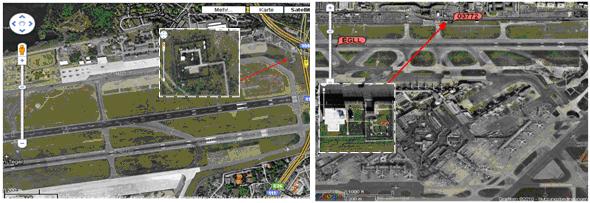

Abbildung 7 zeigt die Temperaturmessstation auf dem Flughafen von Rom und dessen Lage zum Rollfeld. Dass dies kein Einzelfall ist, konnten die Autoren in ihrem Beitrag (hier) belegen, wie z.B. Abbildung 7 zeigt.

Abbildung 8, Quelle: (hier) zeigt die Wetterstation auf dem Frankfurter Flughafen. Sie liegt nicht nur sehr nah am Rollfeld (ca. 70m), sondern in direkter Richtung zu den Abgasstrahlen der Jets, wie in der rechten Abbildung zu sehen. Das Bild erinnert frappierend an die Zustände auf dem Flughafen von Rom, wie von A. Watts gezeigt.

Abbildung 9 zeigt die Lage der DWD-Wetterstation auf dem Flughafengelände (roter Pfeil).

Die Messstation liegt exakt zwischen beiden Start- und Landebahnen und ist dem gesamten Verkehrsaufkommen (außer Startbahn West) unmittelbar ausgesetzt, d.h. wird von allen Abgasstrahlen der Verkehrsflugzeuge unmittelbar beeinflusst. Dabei lässt sich folgende Korrelation ableiten: Je höher das Flugaufkommen, umso höher die gemessenen Temperaturen der Wetterstation! Wieso dass? Ganz einfach, die erwärmten Luftschichten werden nicht zwischen Starts oder Landungen ausgetauscht und die Erwärmung beginnt von neuem, sondern bei 120 Flugbewegungen/Stunde und der in Deutschland vorherrschenden geringen Luftbewegungen (gemittelt über das Jahr, siehe als Anhaltspunkt die geringe Auslastung der Windanlagen in Deutschland von nur ca. 16%), bleibt ein Anteil an eingebrachten Erwärmung, weil die Luft nicht schnell genug ausgetauscht wird.

Selbst bei angenommener homogener Verteilung der Abgaswärme über das Flughafenareal (Raumvolumen), ergibt sich ein WI von +0,6°C, wie bei EIKE (Herr Prof. Lüdecke) ermittelt wurde. Für die Überschlagsbetrachtung dienten folgende Daten:

Arealfläche 1940 ha

Flugbewegungen 120/h

dabei je Anzahl der Triebwerke (gemittelt: 2,5 – 3)

Mantelstromtriebwerk Rolls-Royce Trent xxx (Rolls Royce-Trend-Familie)

Schub: zertifiziert bis zu 250 – 360 kN (80.000 lbf)

Einlass-Massenstrom: 800 – 1200 kg/s

Durchmesser Auslass: ca. 2 m

Austrittstemperatur ca. 300 – 700°C (je Last, 600°C typisch im Flugverkehr)

Eine Überschlagsrechnung ergibt :

Flugplatzfläche = 5 qkm = 5 .106 m2

Angenommene max. Starthöhe beim Verlassen des Volumens: 200 m

Startzeit: 100 s

Eintrag an erhitzter Luft

durch die Turbinen: 1.000 kg/s . 100 s = 105 kg = 105 m3 Luft auf 600 °C.

Durch (stationäre) Vermischung gilt die einfache Beziehung für die Mischtemperatur T mit einer Lufttemperatur von angenommenen 20 °C:

(108 – 105) . 20 + 105 . 600 = 108 . T, woraus T = 20,6 °C folgt.

Die Verteilung der heißen Abgasstrahlen ist jedoch nicht homogen, sondern die Messstationen liegen, wie an Rom und Frankfurt gezeigt, in unmittelbarer Richtung der heißen Abgasstrahlen und es ist nicht so, dass diese nur im Moment der Beaufschlagung wirken, sondern noch Stunden nach dem Start, die Temperaturen erhöht halten. Aufklärungssatelliten der USA machen sich diesen Effekt zu Nutze und können noch Stunden, nachdem ein Jetflugzeug auf einer Rollbahn startete/landete, dies anhand der Erwärmung nachweisen.

In erster Linie werden die heißen Abgasstrahlen durch den sog. Wirbelschleppeneffekt über das ganze Flughafenareal verteilt, ganz gleich, wo die Messstation sich befindet.

Wirbelschleppen bestehen aus entgegengesetzt rotierenden Luftmassen. Sie dehnen sich rückwärts und nach unten(!) aus. Wirbelschleppen können für nachfolgende Luftfahrzeuge sehr gefährlich sein, da sie die sonst laminare Strömung extrem stören, wodurch ein Strömungsabriss entstehen kann. Aus diesem Grund müssen nachfolgende Flugzeuge einen Abstand zum voraus fliegenden Flugzeug auf gleicher Höhe von 5 – 12 km halten. Am Beispiel des neuesten Flugzeugs der Airbus-Familie, dem A 380, gelten die folgenden Bestimmungen:

- • A380 gefolgt von Flugzeug der Gewichtsklasse „schwer“ = +2 nm zusätzlich zum geltenden ICAO Abstand (6 nm gesamte Distanz)

- • A380 gefolgt von Flugzeug der Gewichtsklasse „mittel“ = +3 nm zusätzlich zum geltenden ICAO Abstand (8 nm gesamte Distanz)

- • A380 gefolgt von Flugzeug der Gewichtsklasse „leicht“ = +4 nm zusätzlich zum geltenden ICAO Abstand (10 nm gesamte Distanz)

nm = nautische Meile

Abbildung 10 links, Quelle: NASA, zeigt am Beispiel eines Kleinflugzeugs recht anschaulich, wie solche Wirbelschleppen die Luftschichten hinter sich regelrecht durchquirlen. Abbildung rechts zeigt die Luftverwirbelung und deren Ausbreitung bei einer anfliegenden Boeing 777.

Die Autoren konnten zeigen, dass die gemessenen Temperaturen am Flughafen Frankfurt um +2,5°C zu hoch waren. Der WI für den Flughafen Frankfurt demnach bei +2,5°C liegt. Für den Flughafen London Heathrow scheint der WI ebenfalls in dieser Größenordnung zu liegen. Der Jahresmittelwert betrug 2009 bei der Wetterstation am Flugplatz Heathrow bei London 11,9°C. Laut Met Office (http://www.metoffice.gov.uk/climate/uk/datasets/Tmean/ranked/UK.txt) lag die Mitteltemperatur 2009 in Großbritannien bei 9,17°C. Gut 2,7°C Temperaturdifferenz zu London Heathrow. Anzumerken ist noch, dass Flughafenstationen als ländliche Stationen gelten und somit bei einer üblichen WI-Betrachtung gar nicht berücksichtigt werden.

Fazit

Somit festzustellen, dass die Temperaturmessstationen auf Flughäfen für die Aufzeichnung von Temperaturzeitreihen oder sonstiger Vergleichsaussagen gänzlich ungeeignet sind. Anhand der dortigen Daten lässt sich nur herausfinden, dass sich das Flugaufkommen in den letzten Jahren erhöht hat, was grundsätzlich auch richtig ist. Ob für diese Feststellung jedoch eine teure Messstation notwendig ist, darf bezweifelt werden. Wird der Tatsache Rechnung getragen, dass sich ca. 52% aller GHCN-Temperaturstationen auf Flughäfen befinden, so zeigt dies, dass die ausgewiesene Erwärmung auf dem WI beruht oder, überspitzt formuliert, auf dem steigenden Flugaufkommen.

Die Arbeiten von Anthony Watts, ebenso wie unsere zeigen, dass der Hauptanteil der ausgewiesenen, gemessenen Erwärmung in der Tat auf menschliche Ursachen zurück zu führen sind, jedoch nicht auf Treibhausgase, wie dem CO2, sondern auf dem WI, der somit als Haupttreiber der gemessenen Temperaturen gilt. Zu beiden Seiten des Atlantiks schlägt der WI mit gleichen Werten zu Buche. Hinzu kommt, dass zunehmend die Solarforscher die Klima-Debatte dominieren, weil sie sowohl die langfristigen wie auch die kurzfristige Klimaschwankungen vollständig erklären können, was Leistenschneider in seiner 8-teiligen EIKE-Reihe “Dynamisches Sonnensystem – Die tatsächlichen Hintergründe des Klimawandels“ zeigte. Für „CO2+Co.“ bleibt nichts mehr übrig.

In Anbetracht der Tatsache, dass mit der vermeintlichen Erwärmung immer noch Politik betrieben und ganze Volkswirtschaften einer verfehlten Energie- und Umweltpolitik ausgesetzt sind, ist es an der Zeit, dass sich Behörden wie der DWD einer wissenschaftlichen Diskussion stellen und die Politik endlich den Tatsachen Rechnung trägt, dass es nicht mehr wärmer, sondern kälter wird und Klimawandel keine Ausnahmeerscheinung unserer Tage ist, sondern ein stetiger und natürlicher Vorgang.

*) Eine 100%-WI-freie Station für die letzten 130 Jahre konnten wir in Deutschland nicht finden, da insbesondere, die in Städten oder stadtnahen Gebieten befindlichen Stationen, die einen kontinuierlich langen Messzeitraum abbilden, wesentlich WI-behaftet sind. Auf Grund dessen haben wir unser Ergebnis (Abbildung 6) mit einem Fehlertoleranzbereich versehen, der diesem Punkt, dass HPB nicht zu 100% WI-los ist, Rechnung trägt.

Literaturverzeichnis (falls nicht im Text bereits erwähnt)

1 Karl, T.R., C.N. Williams, Jr., F.T. Quinlan, and T.A. Boden, 1990: United States Historical Climatology Network (HCN) Serial Temperature and Precipitation Data, Environmental Science Division, Publication No. 3404, Carbon Dioxide Information and Analysis Center, Oak Ridge National Laboratory, Oak Ridge, TN, 389 pp.

2 Dr. Niels Axel Mörner, “Keine Gefahr eines globalen Meeresspiegelanstiegs“, http://www.solidaritaet.com/fusion/2008/1/fus0801-klima.pdf Original: Quaternary Studies, Journal der Portugiesischen Vereinigung für Quartär-Forschung (APEQ), Nr. 5, 2007,

3 Met Office Hadley Centre, ”Climate change and the greenhouse effect” Dezember 2005, Seite 30

4 DWD, Lufttemperatur (Jahresmittelwerte) Deutschland 1891 – 2009

Raimund Leistenschneider – EIKE ; Josef Kowatsch – Hüttlingen

Lafromboise weist in Ihrem Vortrag und einem neuen Buch nach, dass der Weltklimarat nicht die besten Forscher versammelt, wie immer behauptet wird. Stattdessen sitzen

Lafromboise weist in Ihrem Vortrag und einem neuen Buch nach, dass der Weltklimarat nicht die besten Forscher versammelt, wie immer behauptet wird. Stattdessen sitzen  Montfort. und

Montfort. und