Multiperiodisches Klima: Spektralanalyse von Klimadaten

1. Allgemeines

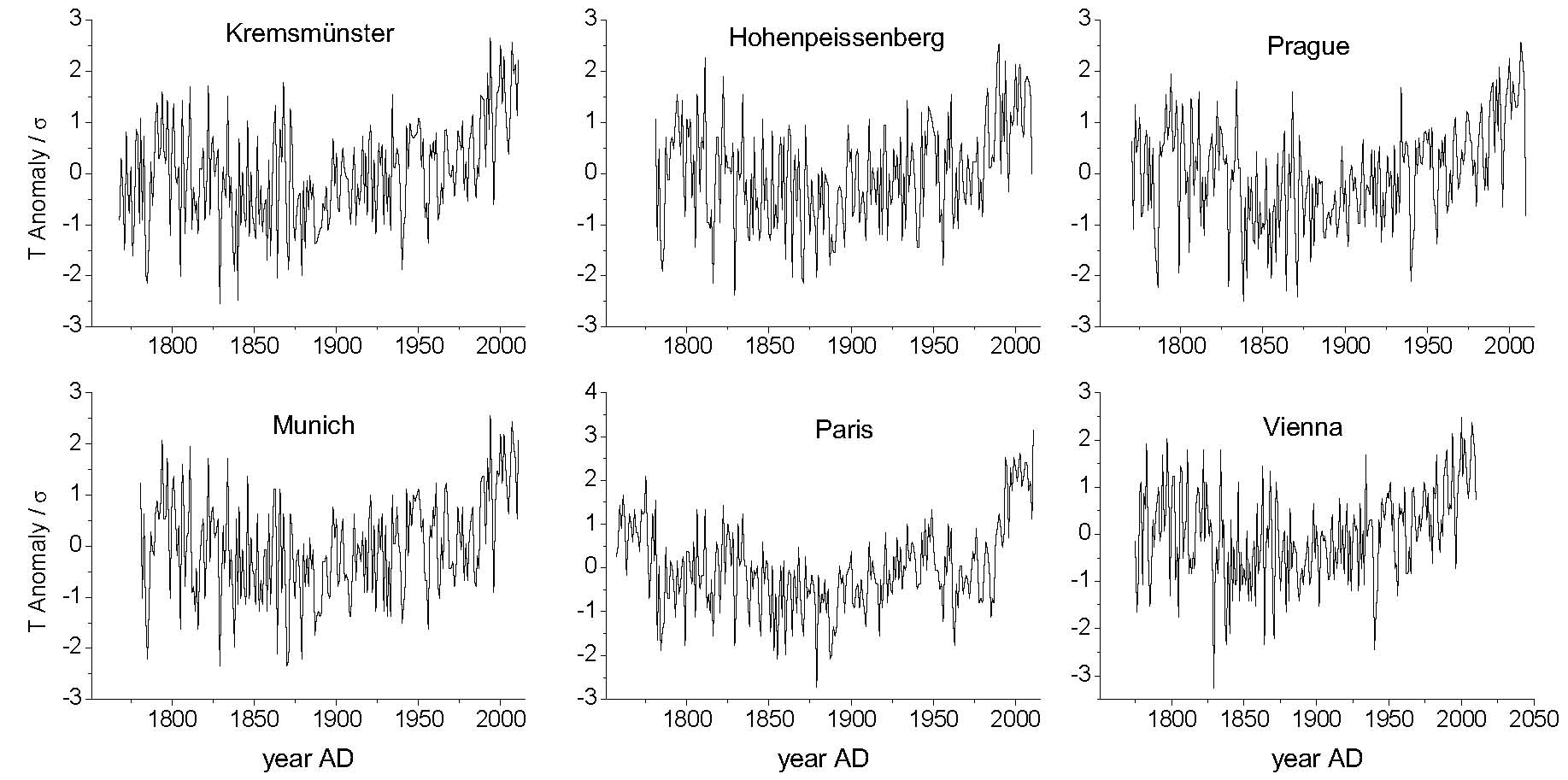

Für die Analyse wurden am längsten zurückreichende Temperaturaufzeichnungen weltweit verwendet. Da die „offiziellen“ Temperaturmessungen (insbesondere die von GISS veröffentlichten) durch vielfältige Manipulationen, wie „Normalisierungen“, „Ausschluss von „verdächtigen“ Daten“, selektiver Ausschluss von etwa 70 % der weltweiten Mess-Stationen usw. kaum mehr für objektive Analysen geeignet sind, wurden die Messdaten zum Teil direkt von den Messstationen bezogen. Die längsten Aufzeichnungen existieren für Mitteleuropa (Abb.1).

Abb.1: Instrumentelle Temperaturdaten von 6 mitteleuropäischen Stationen

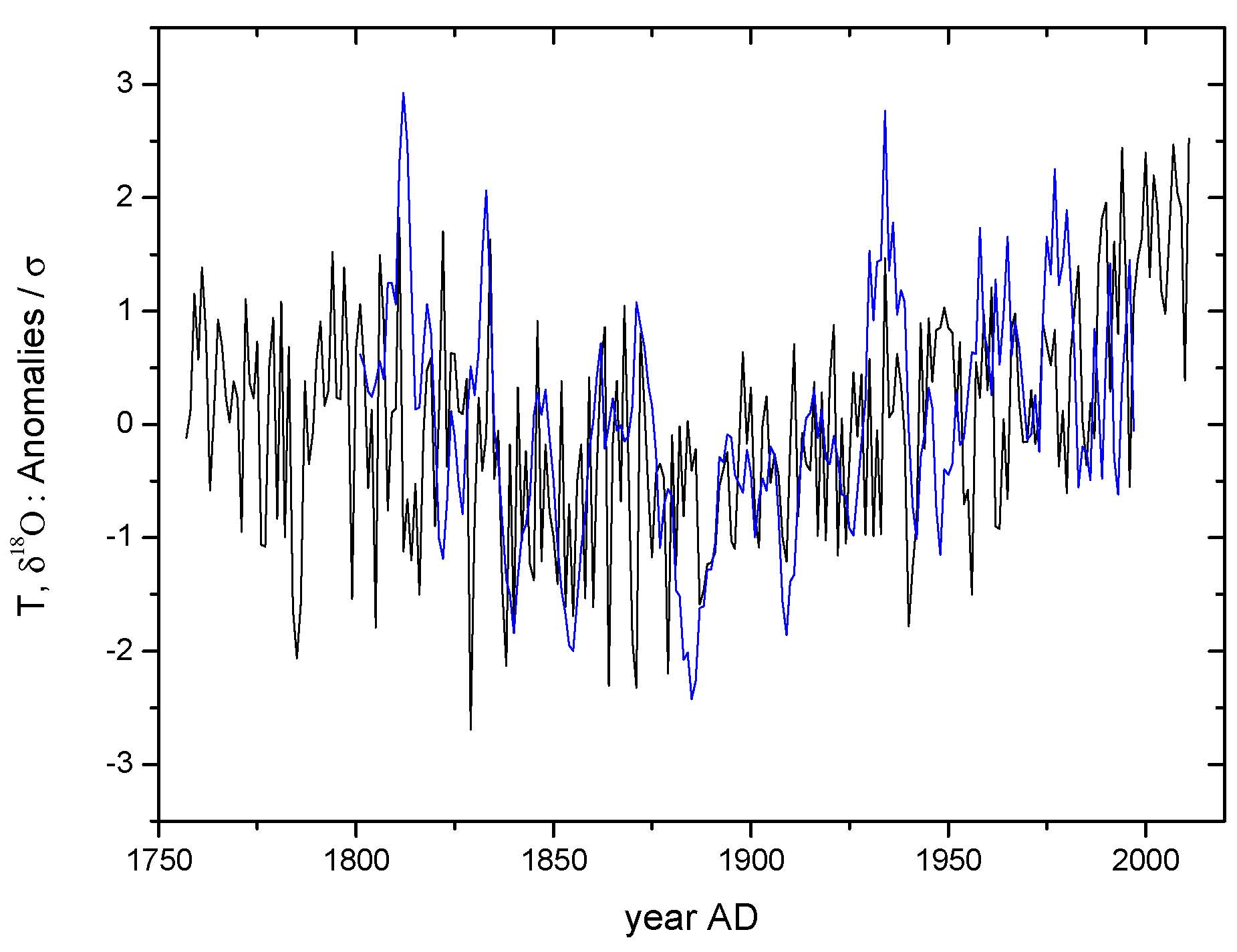

Wegen der geringen Unterschiede der Daten der verschiedenen Messstationen haben wir sie in einer „mitteleuropäischen Temperaturkurve“ (Abb.2) zusammengefasst. Die blaue Kurve gibt Temperaturen aus antarktischen Eisbohrkernen wieder, welche nahelegt, dass der mitteleuropäische Temperaturverlauf für den ganzen Globus repräsentativ ist.

Bild 2: "Europäische" Gesamtkurve zusammen mit Eisbohrkerndaten der Antarktis

2. Spektren und Zyklen

Es gibt zwei grundsätzlich unterschiedliche Vorgehensweisen bei der Analyse von Zeitreihen [2], [3]. In der ersten wird angenommen, dass der die Zeitreihe bildende Prozess durch ein mathematisches Modell wiedergegeben werden kann (oft sind es sog. AR Modelle). Man versucht dann, mit den auf das Modell zugeschnittenen Analyseverfahren die Modell-Parameter zu ermitteln. Falls das Modell nicht realistisch ist (wessen man nie sicher sein kann), erhält man naturgemäß falsche Ergebnisse. Deshalb sind „modellfreie“ Verfahren, wie von uns gewählt, oft vorzuziehen.

Zu diesen modellfreien Analyseverfahren gehören neben den Methoden der Spektralanalyse, die bekannteste ist die Fourier Transformation (FT) und ihre Rücktransformation (IFT), beispielsweise auch die Detrended Fluctuation Method (DFA) zur Ermittelung des Hurst Exponenten einer Reihe [4]. Die DFA kam auch in unserer Arbeit zur Anwendung. Es musste die diskrete FT verwendet werden, weil die Daten Temperaturpunkte mit äquidistanten Abständen darstellen, keine kontinuierlichen, analytischen Funktion.

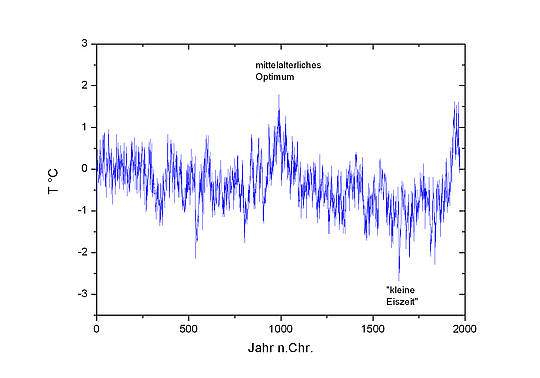

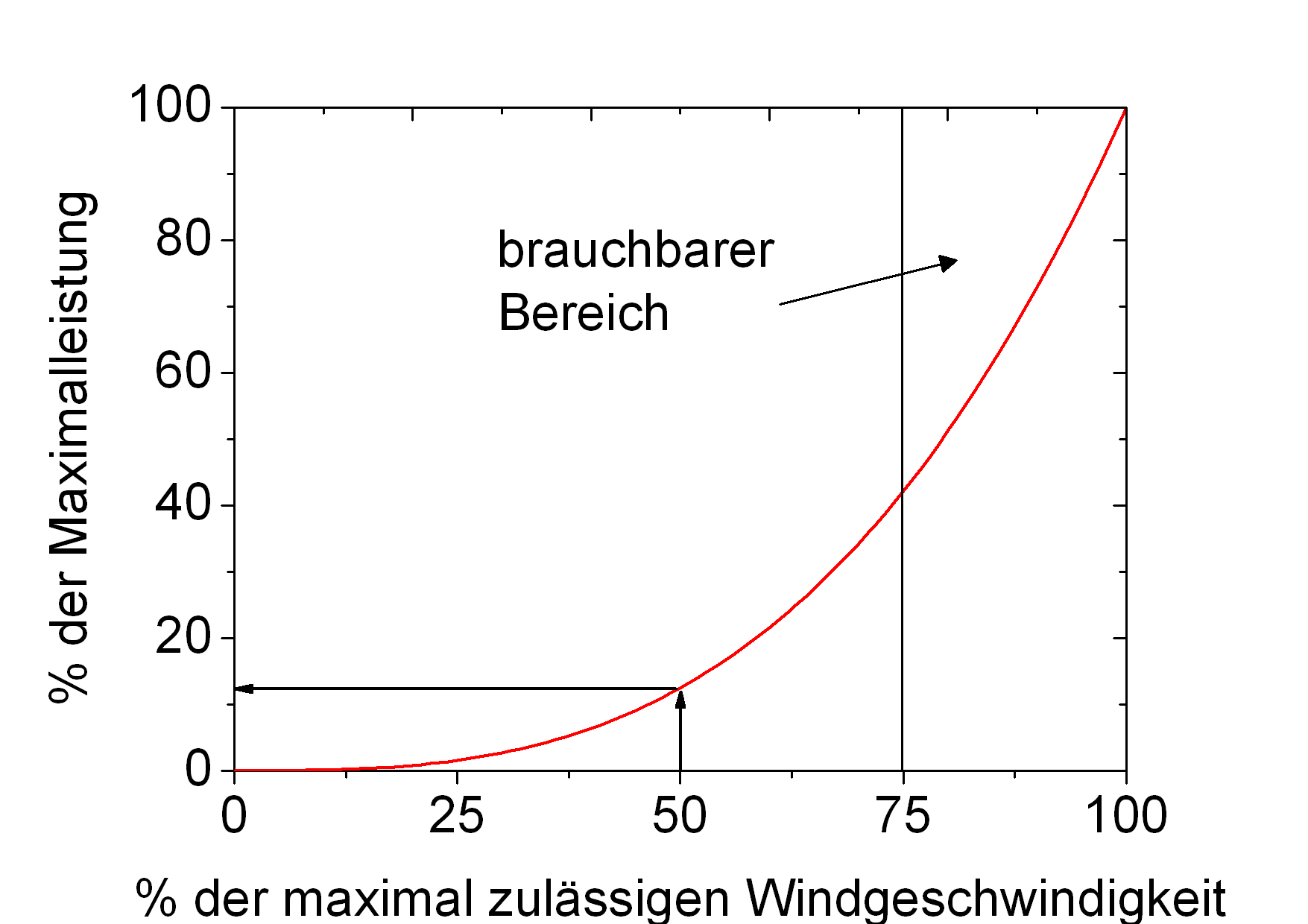

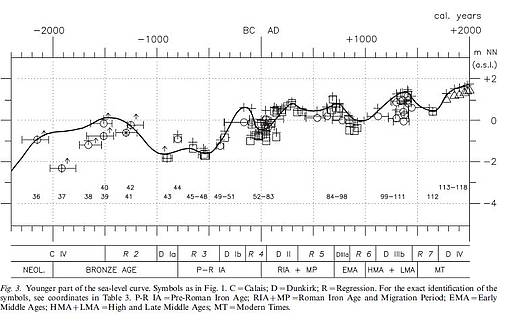

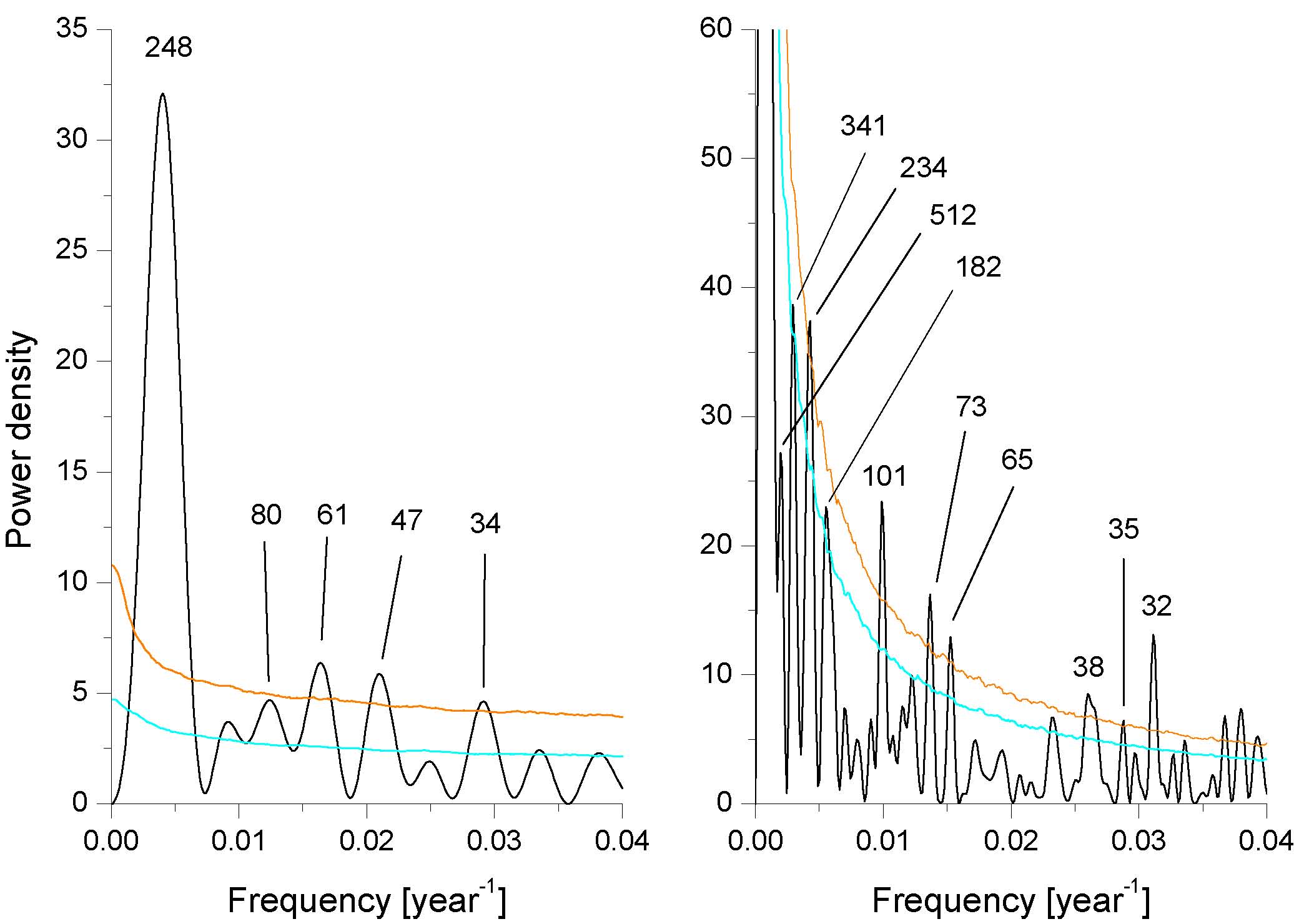

Das aus der FT resultierende Spektrum, welches die mitteleuropäische Temperaturreihe im Frequenzbereich zeigt (Abb. 3), überrascht zunächst. Intuitiv hätte man ein mehr oder minder kontinuierliches Spektrum erwarten können, welches zufälligen Temperaturschwankungen entspräche. Im Gegensatz dazu besteht das Spektrum aus diskreten Maxima.

Abb. 3: links Spektrum der "europäischen" Reihe, rechts das Stalagmitenspektrum

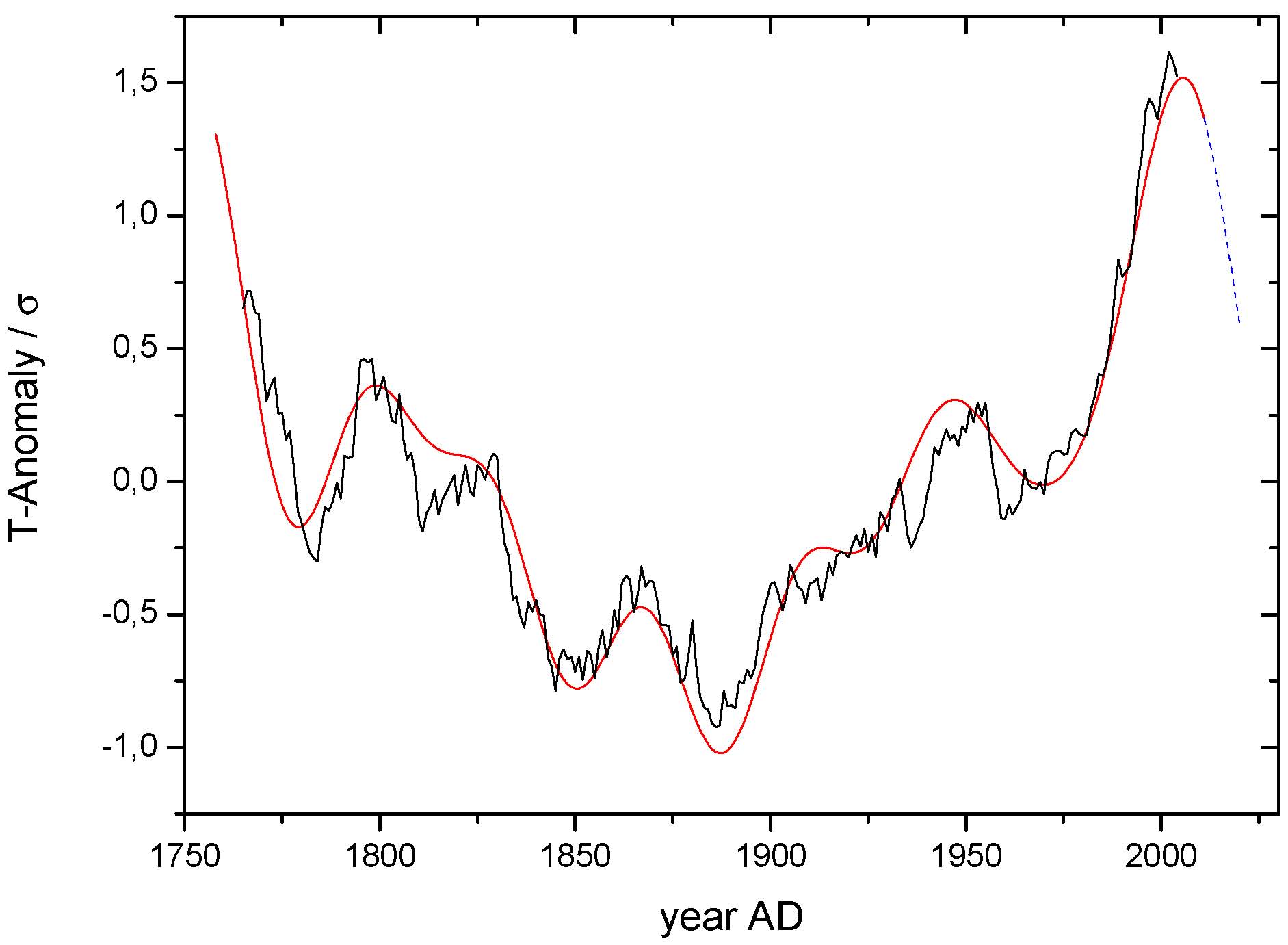

Dies zeigt an, dass das Klima von periodischen Vorgängen dominiert ist. Bei einer solchen Spektralanalyse können allerdings Artefakte auftreten. Zur Prüfung ob Maxima nicht evtl. Artefakte sind und ob die diskreten Spektralkomponenten alleine den realen Temperaturverlauf beschreiben, wurden die 6 stärksten Spektralkomponenten ausgewählt und nur mit diesen via IFT in den Zeitbereich zurück transformiert. Abb. 4 zeigt, dass diese 6 Komponenten, die periodische Vorgänge darstellen, den Klimaverlauf sehr gut wiedergeben.

Abb. 4: schwarz Messdaten über 15 Jahre geglättet, rot Wiedergabe mit nur 6 Spektralkomponenten

Dies legt nahe, dass sie keine Artefakte sind. Weiter zeigt die gute Übereinstimmung von Rekonstruktion und Messdaten, dass außer periodischen keine anderen Prozesse das Klima beeinflussen. Nichtperiodische Vorgänge wie z.B. eine Erwärmung durch den monoton zunehmenden CO2-Gehalt der Luft können danach höchstens nur einen sehr kleinen Bruchteil der insgesamt etwa 0,7 Grad Erwärmung seit 1880 bewirkt haben.

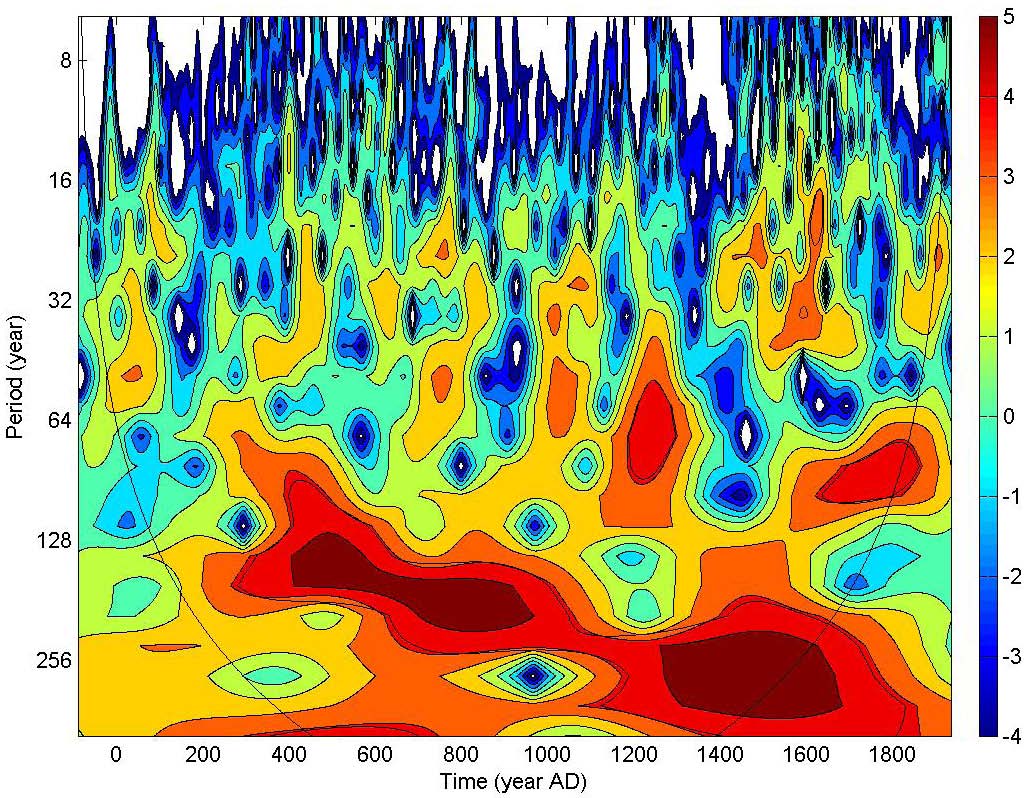

Allerdings muss die Existenz einer starken 240 Jahr Komponente, die ja die Haupttemperaturänderungen (Abfall von 1780 bis 1880, und dann Anstieg bis 1990) beschreibt, kritisch geprüft werden. Die zeitliche Länge der Messdaten enthält nur eine Periode einer möglichen 240 Jahr Periode. Das ist für eine sichere Bestimmung wirklich periodischen Verhaltens selbstverständlich unzureichend. Längere Temperaturmessungen waren daher notwendig. Wir wählten dazu eine von Mangini [5] gewonnene Stalagmiten-Temperaturreihe aus, die ebenso wie die unserer Messstationen aus Mitteleuropa stammt und zwar aus der Spannagel-Höhle bei Innsbruck. Der Temperaturverlauf, gewonnen aus der Stalagmitenanalyse, stimmt recht genau mit Temperaturverläufen überein, die in ähnlicher Weise aus Sedimenten des Nordatlantiks gewonnen wurden. Im Stalagmitenspektrum (Abb. 3 rechts) ist die 240 Jahre Periode eine der stärksten. In Abschnitt 6 unserer Arbeit sind noch weitere, wesentlich tiefer greifende Belege aufgeführt, die die von uns gefundenen Periodizitäten als Artefakte ausschließen. Abb. 5 zeigt das Wavelet-Diagramm der Spannagel Daten.

Wavelet-Analysen geben zusätzlich zur FT an, zu welcher Zeit mit welcher Stärke Periodizitäten herrschten, dies freilich nur zum Preis einer grundsätzlich höheren Frequenzungenauigkeit als der der FT. Im Wavelet-Bild tritt deutlich eine Oszillation hervor, die ihre Periode von 1100 bis heute von 125 Jahren auf 240 Jahren verändert hat.

Abb. 5: Wavelet Diagramm des Stalagmiten

Diese Oszillation war seit fast 1000 Jahren DIE dominierende Klimaänderung und steht in Übereinstimmung mit der 240 Jahre Komponente im Spektrum (Abb. 3 links). Letztere darf durch das Wavelet Diagramm somit als gültig bestätigt angesehen werden.

Die ca. 65 Jahr Komponente ist die gut bekannte und 1400 Jahre zurückverfolgbare „Atlantisch-Pazifische Oszillation“ AMO/PDO. Deren Maxima und Minima sind in Abb. 4 deutlich zu erkennen. Die AMO/PDO resultiert als Eigendynamik, d.i. hier Rückkopplung zwischen Atmosphäre und Meer. Sie stellt einen „Oszillator“ dar, der keinen äußeren Antrieb („forcing“) braucht. Soweit wir sehen, ist die von uns gefundene 240 Jahre Periode nichts anderes als der aus der Astrophysik gut bekannte „de Vries Zyklus“ dessen bestimmender Einfluss auf das Klima vielfach vermutet wurde (hier, hier). Die übrigen Zyklen zwischen 240 und 65 Jahren Periodenlänge sind schwächer.

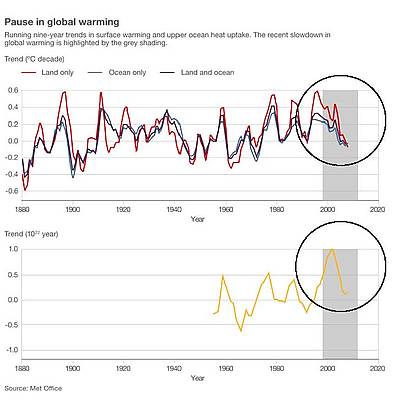

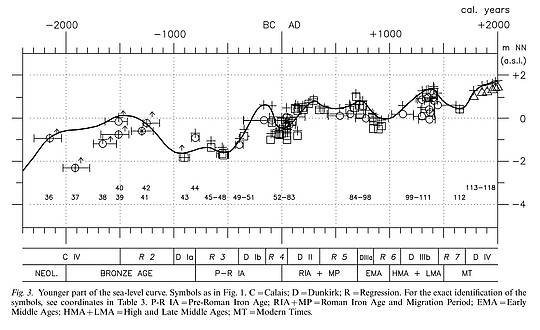

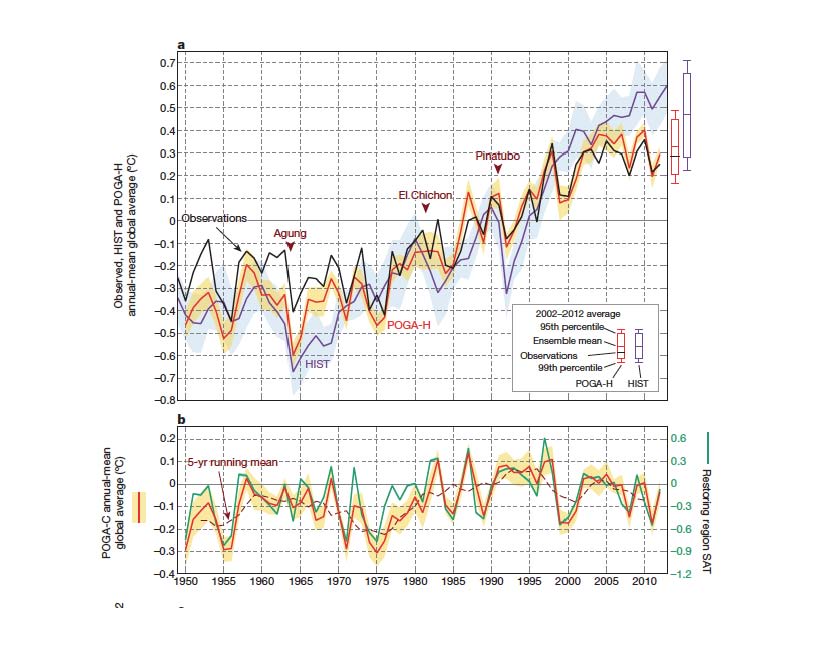

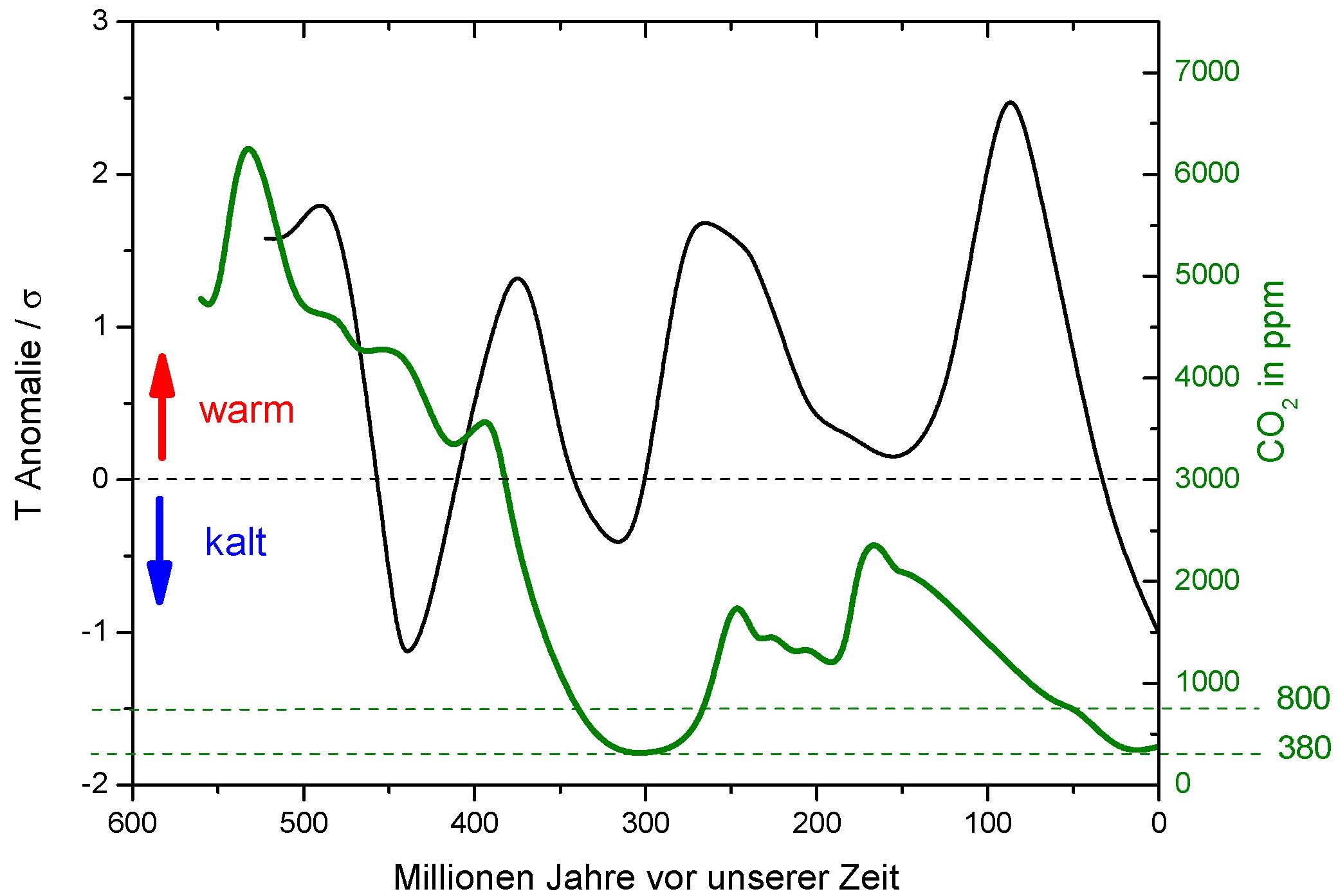

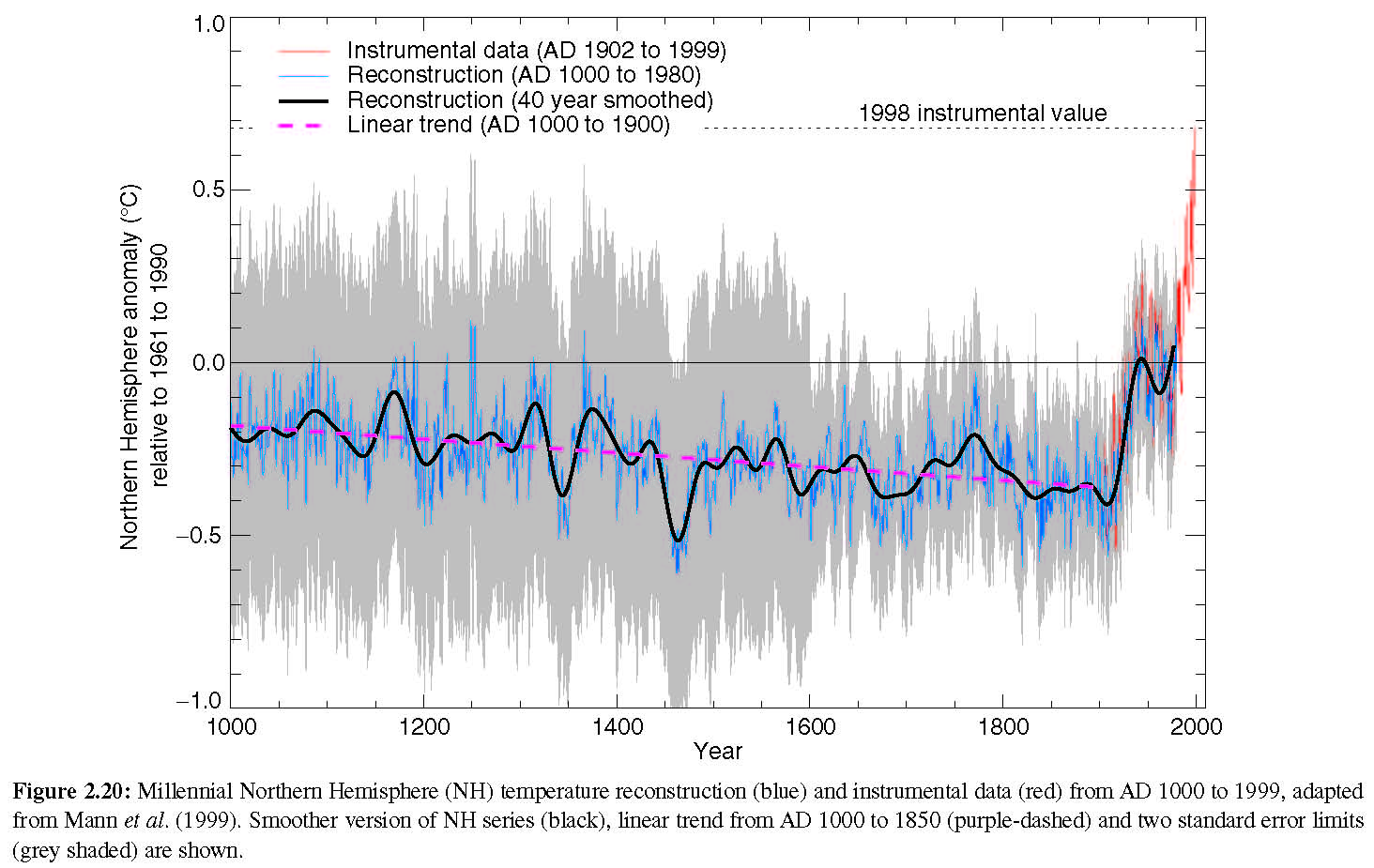

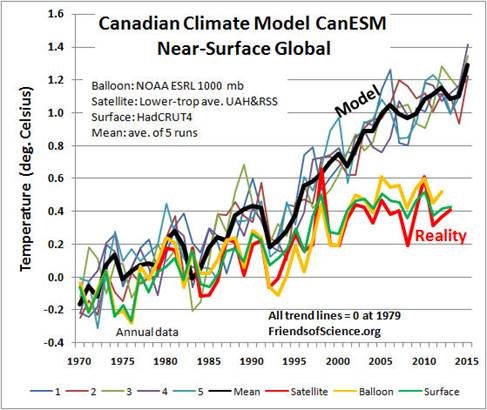

Der Klimaverlauf wird praktisch ausschließlich durch den de Vries Zyklus und die AMO/PDO bestimmt. Insofern ist richtig, wie offiziell angeführt, dass das Klima nicht alleine durch solare Emissionsschwankungen bestimmt wird. Die Eigendynamik des Systems Atmosphäre/Meer (AMO/PDO) ist ebenfalls bedeutend. Zusammen ergeben diese beiden Zyklen mit hoher Genauigkeit den gemessenen Klimaverlauf. Eine irgendwie ins Gewicht fallende Erwärmung durch anthropogenes CO2 kann man nach den von uns gefundenen Ergebnissen ausschließen. Dies stimmt mit den Ergebnissen anderer Analysen überein, die sich auf Messungen gründen [6]. Im Gegensatz dazu basieren die „offiziellen“ Voraussagen über den Klimaeinfluss von anthropogenem CO2 nur auf grob unvollständigen Modellen, die selbst in den einfachsten Tests allesamt "durchfielen". So ist z.B. die Voraussage spätestens nach 25 Jahren nicht mehr von zufälligem Raten zu unterscheiden [7]-[9]. Wie es jetzt schon einer breiteren Öffentlichkeit bekannt wurde, können Klimamodelle nicht einmal die jüngste Temperaturstagnation über etwa 15 Jahre wiedergeben (Abb. 6).

Abb. 6: ein stellvertretendes Beispiel der Diskrepanz von Klimamodellen und Realität (Bildquelle, WUWT, 24.10.2013).

Dass eine Erwärmung durch CO2 in Zukunft stärker ausfallen könnte, kann ebenfalls ausgeschlossen werden. Der seit Beginn der Industrialisierung erfolgte CO2 Anstieg in der Atmosphäre von 40% repräsentiert bereits eine Temperaturzunahme von 50%. Mit anderen Worten kann die mögliche Erwärmung bis 2100, zu welchem Zeitpunkt eine Verdopplung der CO2 Konzentration, verglichen mit vorindustriellen Werten, vom IPCC für möglich gehalten wird (exponentieller Anstieg mit der heutigen Rate), nicht mehr als ca. 0,1 bis 0,2 Grad betragen.

Viel plausibler ist allerdings eine merkliche Abkühlung. Der 65 Jahre Zyklus und der 240 Jahre Zyklus haben ungefähr beide derzeit ihre Maxima. Das ist in Übereinstimmung mit der ausbleibenden Erwärmung in den letzten 15 Jahren (Abb. 6, Abb. 7). Beide sorgen in Zukunft für fallende Temperaturen. Der 65 Jahre Zyklus relativ schnell. Sein nächstes Minimum wird um 2035 liegen. Der 240 Jahre Zyklus wird zu einem absoluten Minimum gegen Ende des 21. Jahrhunderts führen.

3. Anmerkungen zur Spektralanalyse

Neben dem ältesten Verfahren der FT stehen heute zahlreiche modernere Methoden zur Verfügung, stellvertretend Periodengramme für ungleichmäßige Zeitschritte, Multi Taper Methoden und Wavelet-Verfahren. Diese Methoden weisen in manchen Details Vorteile, in anderen aber auch Nachteile gegenüber der klassischen FT auf. Bei vielen der neuen Verfahren gibt es im Gegensatz zur FT frei wählbare Parameter, was ihre Ergebnisse subjektiven Einflüssen aussetzt. Welche Methode der Spektralanalyse am günstigsten ist, hängt von dem zugrunde liegenden Problem ab und kann nicht allgemein beantwortet werden.

Grundsätzlich bleibt bei der FT bzw. der IFT der Informationsgehalt unverändert, der Frequenzbereich bietet lediglich eine andere Darstellungsform als der Zeitbereich. Als weiteres Merkmal der FT wird eine Reihe endlicher Länge als unendlich periodisch fortgesetzt angenommen. Der Zeitverlauf jeder Spektralkomponente setzt sich daher zwangsläufig am Zeitende der untersuchten Zeitreihe wie an deren Zeitanfang wieder fort. In diesem Zusammenhang ist anzumerken, dass der in Abb. 6 gestrichelt eingezeichnete Verlauf nach dem Jahre 2010 nicht die Fortsetzung der FT darstellt. Er ist vielmehr eine von uns vorgenommene Abschätzung des weiteren Temperaturverlaufs auf Basis der zwei stärksten Spektralkomponenten, hier von 240 Jahren und von 65 Jahren Periodenlängen.

Durch Zero Padding (ZP), d.h. dem Auffüllen der Reihe am Anfang oder Ende mit Nullen bleibt nach der FT der Informationsgehalt des Spektrums ebenfalls unverändert, nur steigt die Auflösung im Frequenzbereich mit der Anzahl der Nullen an (ZP erzeugt optimale Interpolation im Frequenzbereich). Dies kann für die genauere Bestimmung der Periodenlängen tiefer Frequenzen (lange Periodenlängen) wichtig sein.

4. Methoden und Programmierung

Die von uns verwendeten Methoden, vorrangig die Fourier-Analyse, die DFA und die Monte-Carlo-Methode sind Standardverfahren. Rechencodes für Methoden, die für die eigene Programmierung zu aufwendig sind, was in unserer Arbeit nur die Wavelet-Analyse betraf, kann man heute für alle gebräuchlichen technischen Programmiersprachen aus zahlreichen Internet-Seiten von US-Universitäten unentgeltlich entnehmen. Wir haben keine „eigenen neuen“ Verfahren oder Methoden entwickelt, sondern brauchten lediglich die notwendigen Programmteile zur Verknüpfung von Standardbausteinen zu schreiben, die von uns schon früher kodiert wurden. Wir verwendeten die Programmiersprache matlab, für kleinere Aufgaben VB6.0. Ferner kam das unverzichtbare EXCEL/VBA zum Einsatz.

5. "Resonanz auf unsere Veröffentlichung"

Unser paper wurde auf den Blogs von Anthony Watts (hier) und Joanne Nova (hier) besprochen und dort in zahlreichen Kommentaren diskutiert. Im mathematisch-physikalischen Kolloquium der Universität Hannover am 22.10.2013 berichtete und diskutierte Carl Weiss über unsere Arbeit.

Quellen

[1] im als pdf angefügten Originalpaper: Zitate der Arbeiten von „Scafetta“ und den in diesen Arbeiten zitierten Quellen

[2] im als pdf angefügten Originalpaper Zitat der Arbeit von Ghil et al.

[3] P. Stoica and R. Moses: Spectral Analysis of Signals, Prentice Hall

[4] A. Bunde und J. Kantelhardt: Langzeitkorrelationen in der Natur: von Klima, Erbgut und Herzrythmus, Physikalische Blätter 57, Nr. 5 (2001), Wiley-VCH

[5] A. Mangini and C. Spötl: Reconstruction of temperature in the Central Alps during the past 2000 yr from d18 O stalagmite record, Earth and Planetary Science Letters 235, 741-751 (2005)

[6] Neben weiteren stellvertretend die folgenden Publikationen:

R.S. Lindzen and Y-S. Choi: On the Observational Determination of Climate Sensitivity and Its Implications, Asia-Pacific J. Atmos. Sci. (47(4), 377-390 (2011), http://tinyurl.com/3mbresk

R.P. Allen: Combining satellite data and models to estimate cloud radiative effect at the surface and the atmosphere, Meteorol. Appl. 18, 324-333 (2011)

R.W. Spencer, and W.D. Braswell: On the Misdiagnosis of Surface Temperature Feedbacks from Variations in Earth’s Radiant Energy Balance, Remote Sensing 3(8) (2011), R.W.

Spencer, and W.D. Braswell: On the diagnosis of radiative feedback in the presence of unknown radiative forcing, Journal of Geophysical Research, Vol. 115 (2010)

G. Paltridge et al.: Trends in middle- and upper-level tropospheric hunmidity from NCEP reanalysis data, Theor. Appl. Climatol. 98 (2009)

M. Beenstock, Y. Reingewertz, and N. Paldor: Polynomial cointegration tests of anthropogenic impact on global warming, Earth Syst. Dynam. 3, 173-188 (2012)

H. Harde: How much CO2 really contributes to global warming? Spectrospcopic studies and modelling of the influence of H2O, CO2 and CH4 on our climate, Geophysical Research Abstracts, Vol. 13, EGU2011-4505-1 (2011)

R.W. Spencer and W.D. Braswell: On the misdiagnosis of surface temperature feedbacks from variations in Earth’s radiant energy balance, Remote Sens. 3, 1603-1613 (2011)

H.-J. Lüdecke: Long-term instrumental and reconstructed temperature records contradict anthropogenic global warming, Energy & Environment 22, No, 6 (2011)

H.-J. Lüdecke, R. Link, F.-K. Ewert: How Natural is the Recent Centennial Warming? An Analysis of 2249 Surface Temperature Records, Int. J. Mod. Phys. C, Vol. 22, No. 10 (2011),

[7] M. Collins, Climate predictability on interannual on decadal time scales: the initial value problem, Clim. Dynam., 2002, 19, 671-692

[8] G.J. Boer: A study of atmosphere-ocean predictability on long time scales, Clim. Dynam., 2000, 16, 479-477

[9] G.J. Boer and S.J. Lambert: Multi-model decadal potential predictability of precipitation and temperature, Geophys. Res. Lett., 2008, 35, L05706, 1-6

Zu den Autoren:

Prof. Dr. Horst-Joachim Lüdecke (Physiker) lehrte nach Forschungs- und Industrietätigkeit an der HTW des Saarlandes. Fachveröffentlichungen in Kernphysik, Strömungsmechanik, Chemietechnik und Klimaphysik sowie 1 Fachbuch und 2 Klimasachbücher (hier). Er ist Pressesprecher von EIKE.

Prof. Dr. Carl Otto Weiss (Physiker) war Abteilungsdirektor an der Technischen Bundesanstalt Braunschweig und Autor bzw. Mitautor von weit über 200 Fachveröffentlichungen zur Laserspektroskopie. Er ist EIKE Mitglied.

Dr. Alexander Hempelmann (Physiker), der dritte Autor der hier besprochenen cp-Veröffentlichung ist wissenschaftlicher Mitarbeiter der Sternwarte Hamburg.