Das Rätsel der Eiszeiten – Teil XI: Das Ende der letzten Eiszeit

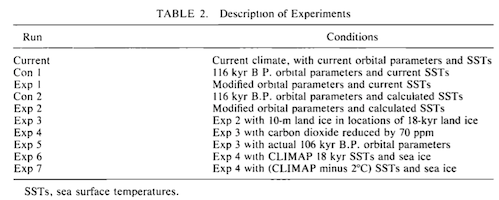

In den letzten Artikeln haben wir zumeist die Modelle hinsichtlich der Auslösung der letzten Eiszeit betrachtet. In Teil sieben haben wir dazu einige frühe GCMs (GCM = global circulation model) betrachtet – Ende der achtziger bis Mitte der neunziger Jahre. In Teil acht ging es um vier verschiedene Studien vor etwa einem Jahrzehnt. In Teil neun ging es um eine Studie, die die letzten 120.000 Jahre simuliert hat, und Teil zehn befasste sich mit einer der jüngsten Studien der Auslösung einer Vereisung vor 115.000 Jahren mittels des letzten Klimamodells CCSM4.

Wir werden zum Mechanismus der Auslösung einer Eiszeit wieder zurückkehren, aber in diesem Beitrag wollen wir das Ende der letzten Eiszeit betrachten. Dies teils deswegen, weil jemand auf einem anderen Blog eine sich damit befassende Studie vorstellte und ich daraufhin einige Zeit damit zubrachte, diese Studie zu verstehen. Aus den letzten 20.000 Jahren gibt es einige exzellente Aufzeichnungen aus beiden Polargebieten. Das vor etwa 20 Jahren initiierte EPICA-Projekt erbrachte Daten aus Eisbohrkernen der Antarktis, die man mit den NGRIP-Daten aus Eisbohrkernen Grönlands vergleichen konnte, die etwa 800.000 Jahre zurückreichen. Aus anderen Forschungsprojekten standen zusätzliche Proxy-Daten aus der ganzen Welt zur Verfügung.

Shakun et al. 2012

Die Studie stammt von Shakun et al. 2012. Randbemerkung: Eine der Ko-Autoren war Bette Otto-Bliesner, ebenso wie für Jochum et al. 2012. Diese Studie haben wir in Teil zehn unter die Lupe genommen. Bette Otto-Bliesner ist eine der Leitautoren des IPCC-AR 5 im Abschnitt über Paläoklima.

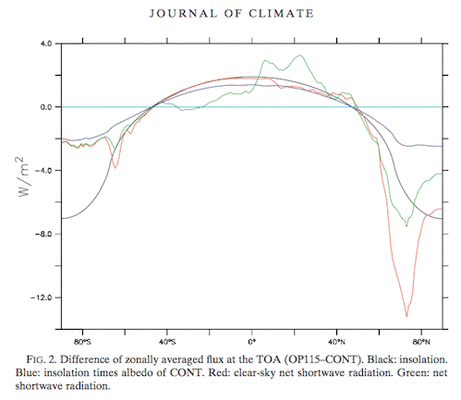

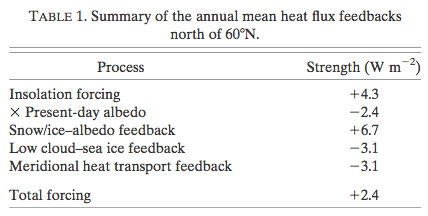

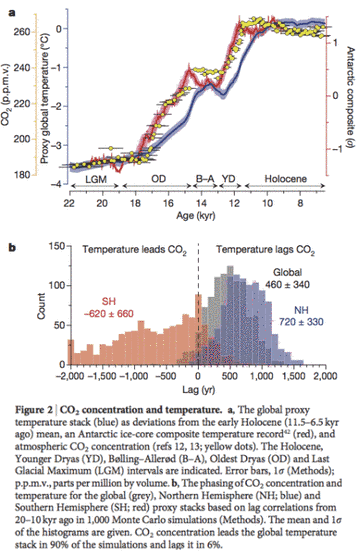

Das letzte glaziale Maximum (LGM) ereignete sich vor etwa 22.000 bis 18.000 Jahren. Der Meeresspiegel lag damals 120 m niedriger als heute, weil dicke Eisschilde Teile von Nordamerika und Europa überdeckten. Warum und wie ist diese Zeit zu Ende gegangen? In der Studie geht es im Wesentlichen um die zweite Frage nach dem "wie". Die obere Kurve in der folgenden Abbildung zeigt die Temperaturen der Antarktis in rot, das CO2 in gelben Punkten und die globalen Temperaturen in blau:

Bildinschrift: CO2-Konzentration und Temperatur. a: Der globale Proxy-Temperaturblock (blau) als Abweichungen vom Mittel des frühen Holozäns (vor 11.500 bis 6500 Jahren), ein Komposit aus antarktischen Eisbohrkernen (rot) und die atmosphärische CO2-Konzentration (gelbe Punkte). Gekennzeichnet sind das Holozän, das jüngere Dryas (YD), Bølling-Alleröd (B-A), das älteste Dryas (OD) und das letzte Glaziale Maximum (LGM). Fehlerbalken, 1 sigma (Methoden); parts per million by volume ppmv. b: Phasen der CO2-Konzentration und der Temperatur global (grau), für die Nordhemisphäre (NH, blau) und die Südhemisphäre (SH, rot). Die Proxy-Blöcke basieren auf Verzögerungs-Korrelationen von vor 20.000 bis 10.000 Jahren in 1000 Monte-Carlo-Simulationen (Methoden). Das Mittel und die 1 sigma-Bandbreite werden gezeigt. Die CO2-Konzentration führt den globalen Temperaturblock in 90% der Simulationen und hinkt ihr hinterher in 6% aller Fälle.

Die zweite Graphik zeigt uns das Histogramm von CO2-Änderungen in Bezug auf die Temperatur sowohl für die Antarktis als auch global. Man erkennt deutlich, dass die Temperaturen der Antarktis vor etwa 18.000 Jahren nachhaltig zu steigen begannen – vor den globalen Temperaturen. Wir können erkennen, dass die CO2 Konzentration geringfügig den antarktischen Temperaturen vorausgelaufen oder mit dieser synchron verlaufen ist. Dies zeigt, dass die CO2-Zunahme hier eine positive Rückkopplung auf den ursprünglichen antarktischen Temperaturanstieg hatte (grundlegender Physik zufolge steigt durch mehr CO2 der Strahlungsantrieb in der Troposphäre an – siehe Anmerkung 1).

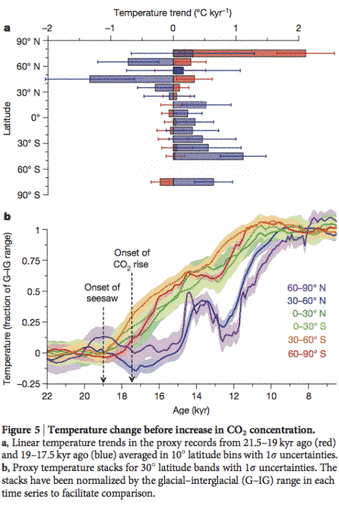

Aber was war die Ursache für diesen initialen Anstieg der antarktischen Temperaturen? Eine ins Spiel gebrachte Möglichkeit ist ein vorausgegangener Temperaturanstieg in höheren nördlichen Breiten, den man in der zweiten Graphik der folgenden Abbildung erkennt:

Bildinschrift: Temperaturänderung vor Zunahme der CO2-Konzentration. a: Lineare Temperaturtrends in den Proxy-Aufzeichnungen von vor 21.500 bis 19.000 Jahren (rot) sowie von vor 19.000 bis 17.500 Jahren (blau), gemittelt über Streifen von 10° Breite mit Unsicherheiten von 1 sigma. b: Proxy-Temperaturblöcke für Streifen von 30° Breite mit Unsicherheiten von 1 sigma. Die Blöcke wurden durch die Glazial-Interglazial-Bandbreite (G-IG) in jeder Zeitreihe normalisiert, um Vergleiche zu ermöglichen.

Shagun et al. führen aus: „Eine wichtige Ausnahme ist das Einsetzen des Abschmelzens, das aufgrund einer globalen Erwärmung von etwa 0,3°C erfolgte vor der initialen Zunahme des CO2-Gehaltes vor 17.500 Jahren. Dieses Ergebnis zeigt, dass das CO2 nicht der Grund für die initiale Erwärmung war. Substantielle Temperaturänderungen in allen Breiten (Figure 5b) laufen der CO2-Zunahme vor 17.500 Jahren voraus. Dies zeigt, dass CO2 nicht als Auslöser des Abschmelz-Beginns in Frage kommt. Diese frühe globale Erwärmung erfolgte in zwei Phasen: einer graduellen Zunahme vor 21.500 bis 19.000 Jahren, gefolgt von einer stärkeren Zunahme vor 19.000 bis 17.500 Jahren (Figure 2a). Die erste Zunahme hängt mit einer Erwärmung der nördlichen mittleren und hohen Breiten zusammen, am deutlichsten in Grönland, gibt es doch anderswo zu dieser Zeit nur geringe Änderungen (Figure 5) Die zweite Zunahme ereignete sich während eines ausgeprägten interhemisphärischen Wipp-Ereignisses (Figure 5), möglicherweise verbunden mit einer Abnahme der AMOC-Stärke (Anm. der Redaktion: AMOC = Atlantic Meridional Overturning Circulation), wie man in der Pa/Th-Aufzeichnung (Anm. der Redaktion: Pa ist das Proactinium-Isotop 231Pa, Th ist das Thoriumisotop 230Th, die für die Altersbestimmung verwendet werden) und unserer Modellierung sieht (nachfolgend Figure 4f, g)…… In jedem Falle zeigen wir, dass diese räumlich-zeitlichen Verteilungen der Temperaturänderung konsistent sind mit einer Erwärmung in mittleren und hohen nördlichen Breiten. Dies führte zu einer Reduktion der AMOC vor etwa 19.000 Jahren und war der Auslöser für die darauf folgende globale Abschmelz-Erwärmung. Allerdings braucht man noch weitere Aufzeichnungen, um Ausdehnung und Größenordnung der frühen Erwärmung in diesen Breiten zu stützen“. So weit Shagun et al.

Die hier erwähnte interhemisphärische Wippe ist wichtig für das Verständnis und bezieht sich auf die Beziehung zwischen zwei großräumigen Meeresströmungen – zwischen den Tropen und den hohen nördlichen Breiten einerseits sowie den Tropen und der Antarktis andererseits. Dann wird von den Autoren ein „plausibles Szenario” für die initiale Erwärmung der Nordhemisphäre wie folgt präsentiert:

Ein mögliches Antriebs-Modell zur Erklärung dieses Teils der Ereignisse beginnt mit steigender borealer sommerlicher Einstrahlung, die die Erwärmung im Norden auslöst. Dies führt zu dem beobachteten Rückzug der nordhemisphärischen Eisschilde und dem Beginn des Anstiegs des Meeresspiegels vor etwa 19.000 Jahren (Fig. 3a, b) mit dem begleitenden Süßwasser-Antrieb, welcher zu einer Abnahme der AMOC führte, die die Südhemisphäre erwärmte via der bipolaren Wippe.

Dies ist ein recht schwacher Abschnitt in dieser Studie. Ich finde es seltsam, dass jemand dies schreibt und nicht im Mindesten auf die offensichtlichen Fehler darin hinweist. Bevor ich dies ausführe, müssen zwei Punkte angesprochen werden:

1. Der in Rede stehende Mechanismus wird beschrieben als ein „mögliches Antriebs-Modell“ und ist nicht wirklich Gegenstand der Studie und wird auch offenbar nicht durch irgendwelche Beweise in der Studie gestützt.

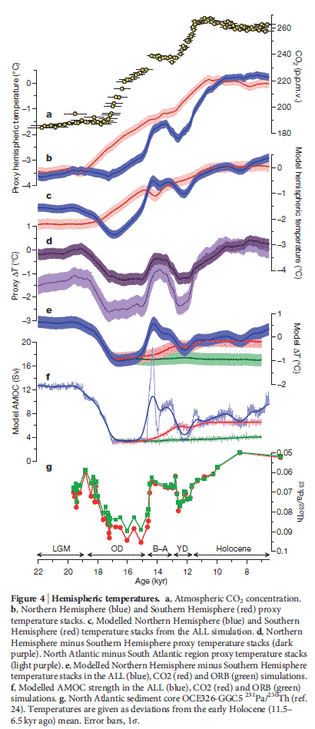

2. Ihre Modellläufe, obige Figure 4c stützen die Hypothese nicht – sie zeigen Temperaturen der Nordhemisphäre mit einem zu jener kritischen Periode abwärts gerichteten Trend. Man vergleiche die obige Fig. 4b und 4c (b sind Proxy-Daten, C ist das Modell). Allerdings stellen sie nicht die höheren Breiten heraus; vielleicht hat also ihr Modell dieses Ergebnis gezeigt.

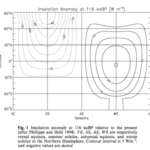

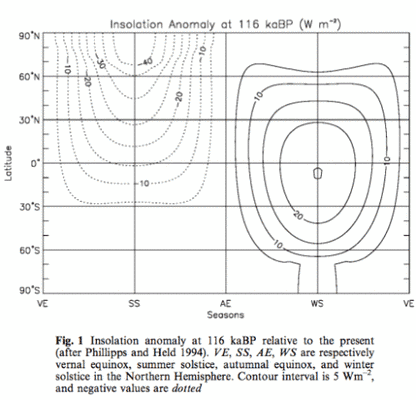

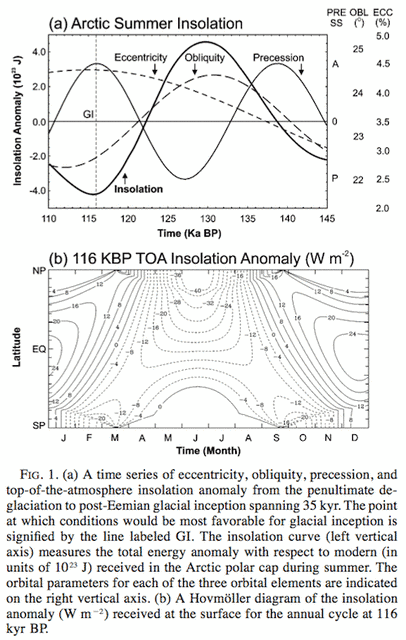

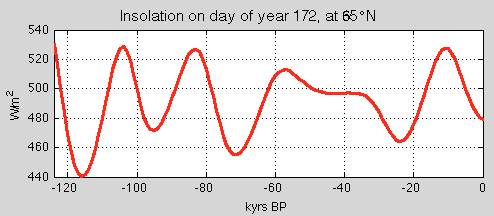

Der offen liegende Kritikpunkt an dieser Hypothese ist, dass die Einstrahlung (Sommer, bei 65°N) während früherer Perioden sehr viel stärker war:

Abbildung 4

Wir haben dies gesehen bei Ghosts of Climates Past – Pop Quiz: End of An Ice Age (Anm. der Redaktion: diesen Teil bitte im Original naclesen).

Auch wurden während der letzten Eiszeit frühere Perioden signifikanter Temperaturanstiege in hohen nördlichen Breiten aufgezeichnet. Warum war keiner davon in der Lage, die gleiche Folge von Ereignissen und einen antarktischen Temperaturanstieg auszulösen?

Zur Zeit der LGM wiesen die Eisschilde ihre größte Ausdehnung auf mit der positiven Rückkopplung einer höheren Albedo als Konsequenz. Falls eine geringe Zunahme der sommerlichen Einstrahlung in hohen nördlichen Breiten Abschmelzen auslösen kann, würde sicher die viel höhere sommerliche Einstrahlung vor 100.000 oder 82.000 Jahren ein Abschmelzen ausgelöst haben unter der Voraussetzung des zusätzlichen Vorteils der geringeren Albedo zu der Zeit. Bei der Fertigstellung dieses Abschnitts schaute ich noch einmal auf die Website von Nature, um zu sehen, ob es dort irgendwelche Zusatzinformationen gibt (Nature-Studien sind kurz, und Online-Material, das in der PDF nicht auftaucht, kann sehr nützlich sein). Es gab einen Link zu der Site News & Views zu dieser Studie von Eric Wolff. Eric Wolff ist einer der wichtigsten Beitragenden zu EPICA, Leitautor und Mitautor vieler EPICA-Studien. Daher schien es mir sinnvoll, seine Perspektive zu dieser Studie zu lesen. Viele Leute scheinen nämlich davon überzeugt zu sein, dass die Milankovitch-Theorie richtig sei und sie nicht zu akzeptieren absurd ist. Siehe zum Beispiel die von mir zuvor schon einmal erwähnte Blog- Diskussion. Es ist also angebracht, ausführlich aus Wolffs kurzem Artikel zu zitieren:

In der Zeit von vor 19.000 bis 10.000 Jahren kam die Erde aus der letzten Vereisungsperiode. Der gesamte Globus erwärmte sich, Eisschilde zogen sich von den Nordkontinenten zurück, und die Zusammensetzung der Atmosphäre änderte sich signifikant. Viele Theorien versuchen zu erklären, was diese Transformation ausgelöst und am Leben gehalten hat, aber es fehlen belastbare Beweise, diese Theorien zu validieren.

Auf Seite 49 dieser Ausgabe verwenden Shakun et al. eine globale Rekonstruktion der Temperatur um zu zeigen, dass der Übergang von der Eiszeit in die derzeitige Zwischeneiszeit von einer gegenphasigen Temperaturentwicklung der beiden Hemisphären der Erde gekennzeichnet war, die einer kohärenten Erwärmung überlagert war. Änderungen der Meeresströme, die die gegensätzliche Reaktion in jeder Hemisphäre kontrollieren, scheinen für das Ende der Eiszeit mit ausschlaggebend gewesen zu sein.

Wieder einmal hat ein führender Klimawissenschaftler angemerkt, dass wir nicht wissen, warum die letzte Eiszeit zu Ende gegangen ist. Wie wir in Teil VI – “Hypotheses Abound” gesehen haben, erklärt der Titel den Inhalt:

Einige Studien haben zur Diskussion gestellt, dass Änderungen des ozeanischen Wärmetransportes ein wesentlicher Teil zur Beendigung einer Eiszeit sind. Shakun et al. kombinieren ihre Daten mit Simulationen auf der Grundlage eines Ozean-Atmosphäre-Modells, um eine plausible Abfolge der Ereignisse seit der Zeit vor etwa 19.000 Jahren zu präsentieren. Sie meinen, dass eine Reduktion der AMOC (im Modell induziert durch den Eintrag von Süßwasser in den Nordatlantik) zur Erwärmung der Südhemisphäre und einer insgesamten Abkühlung der Nordhemisphäre geführt hat. Die Kohlendioxidkonzentration begann bald danach zu steigen, möglicherweise durch Ausgasen aus den Tiefen des südlichen Ozeans. Obwohl sie ziemlich gut dokumentiert ist, bleibt die genaue Kombination der Mechanismen für diesen Anstieg fraglich. Danach erwärmten sich beide Hemisphären gleichlaufend, hauptsächlich als Reaktion auf den Anstieg des Kohlendioxidgehaltes, jedoch mit weiteren Oszillationen auf Grund des hemisphärischen Kontrastes mit Variation der Stärke der AMOC. Das Modell reproduziert sehr gut die Größenordnung und die Verteilung der globalen und hemisphärischen Änderungen mit dem sich ändernden Kohlendioxid und der sich ändernden AMOC als grundlegenden Komponenten.

Der Erfolg des von Shakun und Kollegen verwendeten Modells bei der Reproduktion der Daten ist ermutigend. Aber eine Schwäche ist, dass die Größenordnung des Süßwasser-Eintrags in den Atlantik im Modell adjustiert worden ist, um die abgeleitete Stärke der AMOC und die Größenordnung der interhemisphärischen Klimareaktion zu erzeugen. Das Ergebnis impliziert nicht, dass die Ozean-Zirkulation in dem Modell die korrekte Sensitivität hinsichtlich der Menge des Süßwasser-Eintrags aufweist.

Die Arbeit von Shakun und Kollegen bietet eine solide, auf Daten basierende Grundlage für eine plausible Kette der Ereignisse während der meisten Zeit, in der die Eiszeit endete. Aber was führte zu der Reduktion in der AMOC vor 19.000 Jahren? Die Autoren verweisen darauf, dass in der Zeit von vor 21.500 und 19.000 Jahren die Temperatur im nördlichsten Breitenband (60°N bis 90°N) signifikant gestiegen war. Sie folgern, dass dies Folge einer Steigerung der sommerlichen Einstrahlung in hohen nördlichen Breiten ist (einfallende Solarstrahlung), getrieben von den gut bekannten Zyklen der Erdumlaufbahn um die Sonne. Sie argumentieren, dass dieser Anstieg zu einem auslösenden Schmelzen von Eisschilden geführt hat, was nachfolgend die Reduktion der AMOC einleitete.

Allerdings muss diese Folgerung mit Vorsicht betrachtet werden. Erstens gibt es nur sehr wenige Temperaturaufzeichnungen in diesem Breitenbereich: Die Erwärmung ist nur in Eisbohrkernen aus Grönland klar erkennbar.

Zweitens, es gibt mindestens einen vergleichbaren Temperaturanstieg in den Grönland-Eisbohrkernen, und zwar in der Zeit von vor 62.000 und 60.000 Jahren, der nicht zum Ende der Eiszeit geführt hat. Und schließlich, obwohl es stimmt, dass die sommerliche Einstrahlung im Norden von vor 21.500 und 19.000 Jahren zugenommen hat, blieb deren absolute Größenordnung geringer als zu irgendeiner Zeit von vor 65.000 und 30.000 Jahren. Es ist völlig unklar, warum eine Zunahme der Einstrahlung von einem niedrigen Wert das Ende der Eiszeit ausgelöst haben soll, während eine anhaltende Periode höherer Einstrahlung dies nicht bewirkt hat.

Kurz gesagt, man braucht eine weitere Zutat, um die Verbindung zwischen Einstrahlung und Eiszeit-Ende zu erklären – ebenso wie die Auslöser der Serie von Ereignissen, die so gut in der Studie von Shakun und Kollegen beschrieben worden sind. Die Schaukelei der Temperatur zwischen Nord und Süd während der gesamten Vereisungsperiode, die am klarsten in rapiden Erwärmungen Grönlands zum Ausdruck kommt (Dansgaard-Oeschger-Ereignisse), wird oftmals als Signal verstanden, dass es in der AMOC zahlreiche Änderungen der Stärke gegeben hat. Allerdings dauerte die Schwächung in der AMOC, die vor 19.000 Jahren eingesetzt hatte, viel länger als derartige Schwächungen zuvor, was einen viel substantielleren Anstieg der südlichen Temperatur und der Kohlendioxid-Konzentration ermöglicht hatte. Warum war es zu jener Zeit so schwierig, die AMOC neu zu beleben und deren Schwäche zu beenden?

Und was könnte die fehlende Zutat sein, die den Anstieg der Einstrahlung im Norden vor etwa 20.000 Jahren in den Auslöser der Deglaziation verwandelt hatte, wenn eine stärkere Einstrahlung in früheren Zeiten dies nicht vermocht hat? Es wurde in die Diskussion geworfen, dass eine Eiszeit nur zu Ende geht, wenn die Eisschilde im Norden besonders groß sind. Falls dies wirklich die zusätzliche Zutat ist, dann muss der nächste Schritt zum Verständnis der Kausalkette darin bestehen zu verstehen, welcher Aspekt der großen Eisschilde das Einsetzen und die Persistenz der AMOC kontrolliert, die anscheinend das Schlüsselelement der letzten Deglaziation war.

Danke, Eric Wolff. Meine Zusammenfassung von Shakun et al. hinsichtlich ihres zentralen Themas: es ist eine sehr gute Studie mit soliden neuen Daten, guten Erklärungen und Graphiken. Allerdings ist in diesem Bereich alles noch im Fluss.

Parrenin et al 2013

Parrenin et al. schreiben:

Das Verständnis der Rolle des atmosphärischen CO2-Gehaltes während vergangener Klimaänderungen erfordert genaue Kenntnisse darüber, wie der Gehalt relativ zur Temperatur mit der Zeit variiert. Antarktische Eisbohrkerne konservieren hoch aufgelöste Aufzeichnungen des atmosphärischen CO2-Gehaltes sowie die Temperatur in der Antarktis während der letzten 800.000 Jahre.

Hier zeigen wir eine überarbeitete relative Zeitskala für die Konzentration von CO2 in der Atmosphäre sowie die antarktische Temperatur während der letzten Erwärmung mit schrumpfenden Gletschern, und zwar mittels Daten aus fünf antarktischen Eisbohrkernen. Wir leiten die Synchronisierung zwischen CO2-Konzentration und antarktischer Temperatur zu vier verschiedenen Zeiten ab, als sich deren Trends abrupt änderten.

Wir finden keine signifikante Asynchronizität zwischen ihnen. Das zeigt, dass die antarktische Temperatur nicht hunderte Jahre begonnen hat zu steigen vor [dem Anstieg der] atmosphärischen CO2-Konzentration, wie es in früheren Studien gezeigt worden ist.

Aua! In einem späteren Artikel werden wir in die komplexe Welt der Datierung von Eiskernen und der darin eingeschlossenen Luftbläschen eintauchen.

WAIS Divide Project Members (2013)

Die Ursache für die Erwärmung der Südhemisphäre während der jüngsten Deglaziation bleibt Gegenstand der Diskussion. Hypothesen eines Auslösers auf der Nordhemisphäre durch ozeanische Umverteilungen basieren teilweise auf dem abrupten Einsetzen einer Erwärmung, die in den Eiskernen der Ostantarktis erkennbar ist und sich auf vor 18.000 Jahren datieren lässt. Diese fand mehrere tausend Jahre statt, nachdem die sommerliche Einstrahlung in hohen nördlichen Breiten zuzunehmen begonnen hatte vor etwa 24.000 Jahren.

Eine alternative Erklärung lautet, dass lokale Änderungen der solaren Einstrahlung die Erwärmung der Südhemisphäre unabhängig verursachen. Hier präsentieren wir Ergebnisse eines neuen, jährlich aufgelösten Eisbohrkerns aus der Westantarktis, die diese beiden Ansichten in Einklang bringen. Die Aufzeichnungen zeigen, dass die Schnee-Akkumulation in der Westantarktis vor 18.000 Jahren angefangen hat zuzunehmen, was mit steigenden Kohlendioxid-Konzentrationen, einer Erwärmung der Ostantarktis und einer Abkühlung der Nordhemisphäre zusammenfällt, verbunden mit einer abrupten Abnahme der AMOC. Allerdings begann eine signifikante Erwärmung in der Westantarktis bereits mindestens 2000 Jahre früher.

Abnehmendes Meereis rund um die Antarktis, getrieben durch zunehmende lokale Einstrahlung, ist der wahrscheinliche Grund für diese Erwärmung. Die maritim beeinflussten Aufzeichnungen aus der Westantarktis zeigen eine aktivere Rolle des Südlichen Ozeans beim Einsetzen der Deglaziation, als es aus Eisbohrkernen der Ostantarktis hervorgeht, die weitgehend isoliert sind von Änderungen des Meereises.

Wir erkennen daran, dass „zunehmende solare Einstrahlung” in irgendeinem Teil der Welt mit irgendeinem Wert als eine Hypothese für das Ende einer Eiszeit präsentiert werden kann. „Lokale solare Einstrahlung“ bedeutet hier die solare Einstrahlung im Gebiet der Antarktis. Man vergleiche dies mit Shakun et al., dem zufolge zunehmende Einstrahlung (von einem sehr niedrigen Wert) in hohen nördlichen Breiten als Hypothese einer Erwärmung im Norden präsentiert wurde, die dann eine Erwärmung im Süden initiiert hat.

Das WAIS Projekt ist eine sehr interessante Studie mit neuen Daten aus der Antarktis, dem westantarktischen Eisschild WAIS, wo die Bohrung im Jahre 2011 abgeschlossen worden ist. In diesem Projekt ist zu lesen:

Weil das Klima der Westantarktis ein anderes ist als im Inneren der Ostantarktis kann der Ausschluss westantarktischer Aufzeichnungen zu einem unvollständigen Bild von Klimaänderungen der Vergangenheit in der Antarktis und im Südlichen Ozean führen. Das Innere der Westantarktis liegt tiefer und ist viel stärker von maritimen Luftmassen beeinflusst als das Innere der Ostantarktis, die umgeben ist von steilen Berghängen. Maritim beeinflusste Örtlichkeiten sind von Bedeutung, weil sie direkter atmosphärische Bedingungen reflektieren, die aus Änderungen der Meeresströme und des Meereises resultieren. Eisbohrkern-Aufzeichnungen an Küsten sind allerdings oft schwierig zu interpretieren infolge der komplizierten Eisflüsse und der Geschichte der Höhe über dem Meeresspiegel.

Der Ort des Eisbohrkerns WAIS-WDX in der zentralen Westantarktis ist einmalig, liegt er doch in einem Gebiet mit sehr geringer Änderung der Seehöhe. Er ist stark beeinflusst von maritimen Bedingungen und weist eine relativ hohe Schnee-Akkumulationsrate auf. Das ermöglicht die Gewinnung genau datierter Aufzeichnungen mit hoher zeitlicher Auflösung.

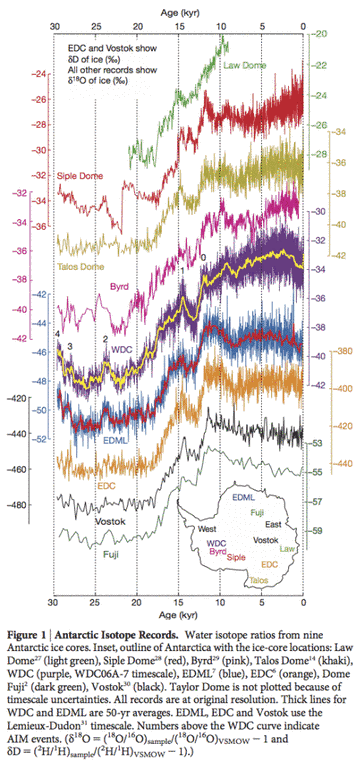

WDC zeichnet wie folgt ein etwas anderes Bild als die anderen antarktischen Eisbohrkerne:

"…und eine signifikante Erwärmung bei WDC begann vor 20.000 Jahren, etwa 2000 Jahre vor einer signifikanten Erwärmung bei EDML und EDC. Sowohl die WDC als auch der schwächer aufgelöste Byrd-Eisbohrkern zeigen, dass die Erwärmung in der Westantarktis vor Abnahme der AMOC begann, die ins Spiel gebracht worden ist, um die Erwärmung der Südhemisphäre zu erklären (unter den Literaturhinweisen fand sich auch Shakun et al. 2012). Die signifikanteste frühe Erwärmung bei WDC erfolgte in der Zeit von vor 20.000 bis 18.800 Jahren, obwohl es auch in der Zeit von vor 22.000 bis 21.500 Jahren zu einer signifikanten Erwärmung gekommen war. Die Größenordnung der Erwärmung bei WDC vor 18.000 Jahren ist viel größer als bei EDML oder EDC.

Bildinschrift Figure 1: antarktische Isotopen-Aufzeichnungen. Verhältnis von Wasserisotopen von neun antarktischen Eisbohrkernen. Eingefügt sind die Umrisse der Antarktis mit den Stellen, an denen die Bohrkerne entnommen worden sind: {es folgen die Namen} From WAIS Divide Project (2013)

Wir werden diese Studie in einem späteren Artikel detaillierter unter die Lupe nehmen.

Schlussfolgerung

Das Ende der letzten Eiszeit ist ein faszinierendes Thema, das unsere Fähigkeit herausfordert, Klimawandel zu verstehen. Eine Kritik an der Klimawissenschaft auf vielen Blogs lautet, dass Klimawissenschaftler von GCMs besessen seien anstatt sich mit „realer Wissenschaft“ zu befassen, „reale Experimente durchzuführen“ und „wirkliche Daten betrachten“. Ich kann nicht sagen wo das Gleichgewicht wirklich liegt, aber zumindest auf meiner eigenen Reise durch die Klimawissenschaft fand ich in der Tat, dass es eine willkommene und gesunde Besessenheit gibt, neue Datenquellen zu finden, Daten zu analysieren, Datensätze zu vergleichen und reale Experimente durchzuführen. Die Eisbohrkern-Projekte aus Grönland und der Antarktis wie NGRIP, EPICA und WAIS Divide Projekt sind dafür gute Beispiele.

In anderen Klimablogs scheinen Autoren und Kommentatoren sehr glücklich zu sein, dass Klimawissenschaftler eine Studie geschrieben haben, die „die orbitale Hypothese“ stützt, ohne jede kritische Untersuchung, welche Beweise diese Studie eigentlich stützen.

Kommen wir aber jetzt zu der Kernfrage dieses Artikels zurück, nämlich der nach der Beendigung der letzten Eiszeit. Das Problem ist derzeit wohl nicht so sehr das Fehlen einer Theorie, sondern vielmehr, dass die Datenflut noch nicht in eine klare Reihenfolge von Ursache und Wirkung gebracht werden konnte. Dies ist ganz offensichtlich essentiell, um eine vernünftige Theorie zu entwickeln. Und jede Theorie, die das Ende der letzten Eiszeit erklären kann, wird auch erklären müssen, warum es nicht früher dazu gekommen ist. Die Erwähnung „zunehmender Einstrahlung“ scheint mir eine Art fauler Journalismus zu sein. Zum Glück stimmt zumindest Eric Wolff mit mir darin überein.

Quellen

Global warming preceded by increasing carbon dioxide concentrations during the last deglaciation, Shakun, Clark, He, Marcott, Mix, Liu, Otto-Bliesner, Schmittner & Bard, Nature (2012) – free paper

Climate change: A tale of two hemispheres, Eric W. Wolff, Nature (2012)

Synchronous Change of Atmospheric CO2 and Antarctic Temperature During the Last Deglacial Warming, Parrenin, Masson-Delmotte, Köhler, Raynaud, Paillard, Schwander, Barbante, Landais, Wegner & Jouzel, Science (2013) – free paper, in submission form (rather than published form)

For interest Valérie Masson-Delmotte is one of the two co-ordinating lead authors for AR5 for the Paleoclimate section, Frédéric Parrenin is a contributing author.

Onset of deglacial warming in West Antarctica driven by local orbital forcing, WAIS Divide Project Members, Nature (2013) – free paper

Anmerkungen

Note 1 – see for example, CO2 – An Insignificant Trace Gas? – an 8-part series on CO2, Atmospheric Radiation and the “Greenhouse” Effect – a 12-part series on how radiation interacts with the atmosphere, Visualizing Atmospheric Radiation – a 13-part series to help us get a better grasp of how this works including “does water vapor overwhelm CO2″, “is CO2 saturated” and many other questions.

Link: http://scienceofdoom.com/2014/01/09/ghosts-of-climates-past-eleven-end-of-the-last-ice-age/