PROBLEMSTELLUNG

Nach über vierzig Jahren des politischen Streitens um die Erkundung des Standortes Gorleben als mögliches Endlager für hoch radioaktive Abfälle unternehmen die politisch Verantwortlichen einen erneuten Anlauf, die hoheitliche Aufgabe der Entsorgung Wärme-entwickelnder hoch radioaktiver Abfälle vorzubereiten. Hierzu wurde im Einvernehmen zwischen fast allen Parteien das „Gesetz zur Suche und Auswahl eines Standortes“ [Standortauswahlgesetz vom 23. Juli 2013*] verabschiedet. Mit dem Gesetz sollen die Regeln zur Endlagerung neu festgelegt werden. Es sieht vor, nach zwei, drei oder mehr Standorten zu suchen, um den für die Sicherheit vergleichbar besten Standort zu finden. An diesen Standorten sollen anschließend die notwendigen übertägigen Forschungsarbeiten sowie die untertägigen Erkundungsarbeiten durchgeführt werden. Nach Vorlage aller Ergebnisse von den verschiedenen Untersuchungsbergwerken soll mittels eines Vergleichs die Auswahl des für eine Million Jahre bestmöglich sicheren Standortes getroffen werden.

Das Ganze verschlingt immense Summen und dient nur dazu, die Endlagerfrage für weitere Jahrzehnte als offenen Posten hinstellen zu können.

RÜCKBLICK IN DIE VERGANGENHEIT

Seit den 1970er Jahren wird der Standort Gorleben auf seine Eignung als Endlager untersucht. Seitdem haben Wissenschaftler einschließlich Nuklear-Chemiker und Nuklear-Physiker, Ingenieure und Techniker tausende von Daten ermittelt, diese in hunderten Berichten zusammengestellt und dabei auch viele – von wenigen Fachleuten und vielen gesellschaftlichen Gruppen gestellte – kritische Fragen sachkundig beantwortet. Auf Anfrage eines Abgeordneten zur Eignung Gorlebens hat im Gegensatz dazu der stellvertretende Ministerpräsident der Landesregierung Niedersachsens, Mitglied der neu geschaffenen Endlager-Kommission, am 12. September 2014 geantwortet: „Die neue Landesregierung hat … eine Neubewertung des Standortes Gorleben vorgenommen. Sie ist der Auffassung, dass der Standort geologisch ungeeignet und politisch verbrannt ist“ [Niedersächsischer Landtag – 17. Wahlperiode, Drucksache 17/1999, 2014*].

Die für das Endlagerprojekt Gorleben entstandenen Kosten, die zum größten Teil von der Energiewirtschaft bezahlt wurden, beliefen sich auf über anderthalb Milliarden Euro. Die Arbeiten wurden im Juni 2000 aus politischen Gründen von der neu gewählten rot-grünen Regierung mit einem Moratorium unterbrochen, obwohl bis dahin keine nachweisbaren K.O. Kriterien vorlagen.

Seit dieser Zeit wurden neben der Offenhaltung der Grube keine weiteren wesentlichen standortbezogene Untersuchungen durchgeführt. Nach einer zehnjährigen Unterbrechung der Erkundung wurden die Arbeiten wieder aufgenommen.

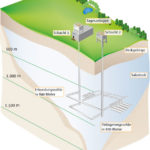

Zuerst jedoch noch ein kurzer erklärender Einwurf: Endlager und Untertagedeponien/UTD sind im geologisch-bergmännischen Sinne dasselbe. Es sind Synonyme! (Im Englischen gibt es dafür auch nur ein Wort: „waste disposal“). Trotzdem wurde und wird in Deutschland bei der politischen Diskussion über die Entsorgung hoch radioaktiver Abfälle die Öffentlichkeit dieser Sachverhalt nicht thematisiert. Insbesondere wird die Existenz einer Untertagedeponie für hoch toxische Sonderabfälle in Salz, die seit Jahren in Deutschland in Betrieb ist, nicht wahrgenommen. Abgesehen von der zusätzlichen Berücksichtigung der Radioaktivität und der höheren Einlagerungstemperaturen der Abfälle unterscheiden sie sich nicht grundsätzlich bei den Anforderungen an die Geologie, an die Untersuchungstechniken, an den Bau des Bergwerkes, an den Betrieb und den langzeitsicheren Verschluss für ein Endlager und für eine Untertagedeponie für Sonderabfälle, die im Gegensatz zu radioaktiven Abfällen ewig toxisch bleiben. Mit dieser Information könnte der Öffentlichkeit ideologiefrei erklärt werden, dass die Entsorgung von hoch radioaktiven Abfällen nicht des Teufels ist, sondern eine beherrschbare Technologie darstellt. Nur in Deutschland zeigt sich in der Wahrnehmung der Entsorgung von hoch toxischen und hoch radioaktiven Abfällen der Bevölkerung ein – wohl gewollter – unüberwindbare Zwiespalt zum gleichen Sachverhalt.

Im Jahr 2000 wurde vom BMU die Erkundung des Salzstocks Gorleben durch ein Moratorium unterbrochen. Es sollte zur Klärung von konzeptionellen und sicherheitstechnischen Fragen zur Endlagerung für einen Zeitraum von drei bis maximal zehn Jahre dienen. Nach Auffassung der damaligen rot-grünen Bundesregierung bestanden keine grundsätzlichen Zweifel an den bisher gewonnen geologischen Befunde zur Eignungshöffigkeit des Salzstockes. („Vereinbarung zur Endlagerung zwischen der Bundesregierung und den Energieversorgungsunternehmen vom 14.06.2000 paraphiert bzw. 11.06.2001 unterschrieben) [http//www.kernenergie.de/kernenergie-wAssets/docs/themen/ Vereinbarung14-06.pdf, *] In Anlage vier der Vereinbarung heißt es zusätzlich, dass „… die bisherigen Erkenntnisse über ein dichtes Gebirge und damit die Barrierefunktion des Salzes positiv bestätigt wird“. Die Bundesregierung hatte zugesagt, die moratoriumsbegründenden Zweifelsfragen zügig abzuarbeiten und hat mehrfach Ende 2004 als Termin für das Ende der Bearbeitung genannt.

Eine aus sechs hochrangigen Fachleuten bestehende International-Expert-Group Gorleben (IEG) hat 2001 im Auftrag der Energiewirtschaft einen Fachbericht (125 S.) erstellt, mit dem Ziel, eine unabhängige und neutrale Meinung zu den bis zu diesem Zeitpunkt vorliegenden Ergebnissen zu erhalten und um die noch zu bearbeitende Themen aufzuzeigen. Der Bericht wurde 2001 in Hannover der Presse vorgestellt. Kopien wurden an das Bundesamt für Strahlenschutz (BfS) übergeben. [International Expert Group Gorleben, 2001: Repository Project Gorleben – Evaluation of the Present Situation.*] Dieser Bericht wird weder vom BfS noch in den zahlreichen Fachberichten zu Gorleben erwähnt. Er dürfte wohl auf dem ‚Index‘ des BfS stehen, weil es sich nicht um einen offiziellen Bericht handelt. Dies gilt dagegen nicht für die in den 90-iger Jahren von Greenpeace etc. finanzierten Gutachten der Gegner, bei denen es sich ebenfalls um nicht offizielle Berichte handelt – und trotzdem sind diese heute das geologische Maß für die Zukunft!

Diese „International Peer-Review-Group“ bestand aus folgenden sechs hochrangigen international anerkannten Fachleuten. Ausführlichere Lebensläufe sind in dem Bericht enthalten:

♦ Per-Eric Ahlsröm: MSC in Engineering Physics; 1984 – 1992, Wissenschaftsdirektor und anschließend Vice Präsident der „Swedish Nuclear Fuel and Waste Management Co.

♦ D. Alexandre: Chemiker und Geologe; 1987 – 1990, Deputy Director of ANDRA (French Agency for Radioactive Waste Management), ab 1990 Research Director beim CEA.

♦ Dr. C. Heath: PhD in Nuclear and Chemical Engineering; 1977 -1981, arbeitete als Direktor für das U.S.Department of Energy „DOE“ hauptsächlich im Yucca Mountain Project, Nevada.

♦ Dr.-Ing. Klaus Kühn: Bergingenieur; 1973 – 1995, Direktor des Instituts für Tieflagerung, Professor an der Technischen Universität Clausthal.

♦ Dr. Ch. McCombie: Physiker; 1970 -1974, arbeitet bei der „United Kingdom Atomic Energy Authority“, 1970 – 1979 beim „Swiss Institute for Reactor Research“ (heute Paul Scherrer Institut) und 20 Jahre lang war er „Executive Advisor“ für die NAGRA (Schweiz).

♦ Dr. W. Weart: Geophysiker, Geologe und Mathematiker; seit 1975 arbeitet er für die „Waste Isolation Pilot Plant“ WIPP in New Mexico und brachte das erste Endlager für schwach und mittel aktive Abfälle im Salzgestein in Produktion.

Das Expertengremium kam zu dem Schluss, dass angesichts der bis 2000 vorliegenden Ergebnisse eine Unterbrechung der Erkundung durch ein Moratorium aus wissenschaftlich-technischer Sicht nicht gerechtfertigt ist. Es sind deshalb auch keinerlei Hinweise genannt, die das politische Diktum der Gegner, das Auswahlverfahren des Standortes sei fahrlässig gewesen, bestätigen. Im Gegenteil!

Wie das Gremium weiter feststellte, wurden die Untersuchungsarbeiten in Gorleben ohne wissenschaftliche Begründung aus rein politischen Gründen unterbrochen.

Als Folge des Moratoriums sind bis 2010 keine wesentlichen weiteren wissenschaftlich-technischen Untersuchungen am Standort Gorleben durchgeführt worden [Gorleben – das Endlagersuchgesetz – ein deutsches Drama; 2013*]. Somit konnten auch keine grundlegenden weiterführenden Erkenntnisse erzielt werden. Dies steht im Widerspruch zu der Begründung des Moratoriums zur ‚Klärung offener Fragen‘.

ABLAUF DER EREIGNISSE AM STANDORT GORLEBEN SEIT 2010

Im November 2010 beauftragte das Bundesumweltministerium die Gesellschaft für Anlagen- und Reaktorsicherheit (GRS) mit dem Forschungsvorhaben „Vorläufige Sicherheitsanalyse Gorleben“ mit verschiedenen Fragestellungen zum Standort Gorleben sowie zu grundsätzlichen methodischen Fragen. [GRS Projektbeschreibung; 2010*]. Die ausführliche Studie sollte nach Plan Ende 2012 von einer international besetzten, neutralen Peer-Review-Gruppe bewertet werden. Das Auftragsvolumen belief sich auf 8.966.950,57 Euro, die zum größten Teil vom Steuerzahler aufgebracht wurden [Deutscher Bundestag, Drucksache 17/6817; 2011*].

Der 424 Seiten umfassende Bericht [Vorläufige Sicherheitsanalyse Gorleben“ (VSG); 2013*], führt die Ergebnisse von 15 Arbeitspaketen zusammen, die auf insgesamt 20 Einzelberichten der GRS und 5 Einzelberichten der BGR beruhen. Die Einzelberichte umfassen insgesamt 5628 Seiten. Dafür hat die GRS folgende Partner in das Projekt eingebunden:

♦ die Bundesanstalt für Geowissenschaften und Rohstoffe (BGR),

♦ die DBE TECHNOLOGY GmbH,

♦ das Institut für Aufbereitung, Deponietechnik und Geomechanik der TU Clausthal,

♦ das Institut für Gebirgsmechanik GmbH (IfG),

♦ das Institut für Sicherheitstechnologie (ISTec),

♦ das Karlsruher Institut für Technologie/Institut für Nukleare Entsorgung (KIT/INE),

♦ die international nuclear safety engineering GmbH (nse; Zusammenschluss mehrerer Institute der RWTH Aachen),

♦ das Institut für Atmosphäre und Umwelt (IAU) der Universität Frankfurt

♦ die T-Systems Solutions for Research GmbH.

Der GRS bzw. den eingebundenen Partnern oblag jeweils allein die Auswahl ihrer Mitarbeiter, die an dem Vorhaben arbeiteten. Alle Einzelberichte sind somit von ausgewiesenen Fachleuten erstellt worden, die von den Abfallverursachern weder ausgesucht noch bezahlt wurden. Diese Beteiligung vieler Wissenschaftseinrichtungen, die über Jahrzehnte langes Knowhow zu allen endlagerrelevanten Aspekten verfügen, und deren direkte interdisziplinäre Zusammenarbeit unter der wissenschaftlichen Führung eines Steering Committes hat sich bewährt.

Die kurzen zusammenfassenden Einzelergebnisse (Fakten) der zahlreichen Unterkapitel der Studie wurden auf zwei Seiten für jeden Leser verständlich zusammengestellt und veröffentlicht [Gorleben – Offizielle vorläufige Sicherheitsanalyse ergibt – Gorleben ist geeignet; 2014*]

Ursprüngliche Zielsetzung der „Vorläufigen Sicherheitsanalyse Gorleben (VSG)“

Die ursprüngliche im Jahr 2000 formulierte Zielsetzung der „Vorläufigen Sicherheitsanalyse Gorleben (VSG)“ forderte die Erarbeitung einer systematischen Zusammenstellung des Kenntnisstandes zu Gorleben. Darauf aufbauend sollte eine vorläufige Eignungsprognose und die Identifizierung des noch bestehenden Bedarfs an standortspezifischen und standortunabhängigen Fragestellungen im F&E-Bereich erarbeitet werden.

Insgesamt waren knapp 80 Wissenschaftler mit den Einzelthemen der Studie beschäftigt. Nach Abschluss der Arbeiten sollte mittels eines Peer-Review-Verfahrens eine Prognose zum Salzstock Gorleben gegeben werden. Für das Peer-Review-Verfahren war geplant, entweder

♦ die EU,

♦ die IAEA oder

♦ OECD/NEA

auszuwählen. Nicht das BMU, sondern die ausgewählte Institution soll entscheiden, wie die Peer-Review-Group zusammengesetzt wird und aus wie vielen Personen sie bestehen soll [Deutscher Bundestag, Drucksache 17/6817, 2011*].

Aktualisierte Zielsetzung der VSG Studie

Ohne einen sachlichen Grund – wahrscheinlich auf politischen Wunsch – wurde in 2011 die Zielsetzung der Studie gerändert. Es wurde verordnet, dass der Eignungsnachweis nur eines Standorts in der Studie nicht mehr gültig ist, sondern in Zukunft der Eignungsnachweis nur nach einem mehrstufigen Auswahlverfahren und nur im Vergleich mit anderen Standorten entschieden werden darf. [Vorläufige Sicherheitsanalyse Gorleben VSG, Projektbeschreibung, Aktualisierte Zielsetzung*]. „Geeignet“ in diesem Sinn wird damit nur der Standort sein, bei dem die verschiedenen grundsätzlichen und vergleichsspezifischen Kriterien erfüllt sind und ‚die bestmögliche‘ Sicherheit für einen Zeitraum von einer Million Jahre gewährleistet ist. Diese verordnete Aktualisierung hatte zum Ergebnis, dass die angestrebte vorläufige Eignungsaussage für den Standort Gorleben nicht mehr abschließend bewertet werden darf, denn die bisherigen Projektziele sollen mit der Zielsetzung ergänzt werden, zukünftige Standortauswahlverfahren zum Vergleich verschiedener Endlagerstandorte zu ermöglichen. Zusätzlich soll untersucht werden, welche Konzepte für den Verschluss eines Endlagers an Standorten mit anderen geologischen Gegebenheiten übertragbar sind.

Der hier gewählte politische Ansatz geht davon aus, dass bei der Festlegung eines Standortes nicht nur die Kriterien an ein Endlager erfüllt sein müssen. Zusätzlich wird eine Optimierung des Auswahlverfahrens gefordert, welche der geübten Praxis der Optimierungsverfahren in eklatanter Weise widerspricht. Optimierung ist nur sinnvoll, soweit dies in einem wirtschaftlich vertretbaren Rahmen erfolgt. Die Untersuchung weiterer Standorte und die damit verbundenen immensen zusätzlichen Kosten sowie die gezielte Aufgabe des Standortes Gorleben sind angesichts seiner absehbaren Eignungshöffigkeit wirtschaftlich nicht vertretbar.

Die geplante internationale Bewertung fand nach Fertigstellung der VSG Studie nicht mehr statt. Als Folge des in Deutschland entstandenen Fukushima-Syndroms wurde in einem am 27. Juli 2013 in Berlin stattgefundenen parteiübergreifenden Konsensgespräch wieder ohne eine fachliche Begründung – denn durch dieses Naturereignis hat sich die Tsunamigefahr für Gorleben nicht erhöht – die Chance genutzt, die bergmännischen Erkundungsarbeiten im Salzstock Gorleben einzustellen.

Stimmen, die sich seit Jahrzehnten gegen die Eignungshöffigkeit von Gorleben aussprechen

Sie stammen hauptsächlich aus dem letzten Jahrhundert. Die genannten Kritikpunkte wurden weder in der Vereinbarung zwischen der Bundesregierung und der Energiewirtschaft [Anlage 4 der Vereinbarung vom 11.06.2001*] noch in dem VSG-Bericht bestätigt. Auch handelt es sich bei all den genannten Veröffentlichungen um keine offiziellen Berichte. Trotzdem stehen sie nicht auf dem ‚Index‘ wie der IEG Bericht von 2001.

Grimmel, E. (1979) … (59 S.) … Institut für Angewandte Ökologie e.V.; Mauthe, F. (1979) … (60 S.) … Geologisches Institut der Universität Hannover; Duphorn, K. (1983) … (265 S.) … Universität Kiel;

*Appel, D. et al. (1984) … (?) … Fraktion der Grünen; Duphorn, K. (1984) … (47 S.) … Universität Kiel; Grimmel, E. (1984) … (?) … (?); Duphorn, K. (1986) … (?) … Z. dt. geol. Ges.; Duphorn, K. (1988) … (141 S.) … im Auftrag der SPD, Kiel; Duphorn, K. (1993) … (202 S.) … im Auftrag des rot-grünen Nieders. Umweltministeriums; Albrecht, I et. al. (1993) … (166 S.) … im Auftrag des rot-grünen Nieders. Umweltministeriums; Grimmel, E. (1993) … (152 S.) … im Auftrag des rot-grünen Nieders. Umweltministeriums; Paluska, A. (1993) … (236 S.) … (?); Schenk, V. (1993) … (39 S.) … (?); *Appel, D. et al. (1993) … (118 S.) … PanGeo Geowissenschaftliches Büro; *Appel, D. et al. (2006) … (40 S.) … Gruppe Ökologie e.V. im Auftrag von Greenpeace; Schneider, U. (2009) … (64 S.) … im Auftrag der Fraktion Die Linken im Niedersächsischen Landtag; Kreusch, J. (2010) … (12 S.) … Ausarbeitung für den 1. Untersuchungsausschuss der 17. Wahlper.; *Kleemann , U. (2011) … (28 S.) … im Auftrag der Rechtshilfe Gorleben; Schneider, U. (2011) … (36 S.) … im Auftrag von Greenpeace; Kreusch, J. (2012) … (30 S.) … im Auftrag von Greenpeace! (*Mitglied im Gorleben-Ausschuss, (unterstrichen: finanziert von Politik oder NGO). [Niedersächsischer Landtag – 17. Wahlperiode, Drucksache 17/1999, 2014*].

VERSUCH EINER BEWERTUNG DIESER ENTWICKLUNG.

Wie ist es in einem hochindustrialisierten Land wie Deutschland möglich, ein erfolgreiches Projekt, an dem zahlreiche wissenschaftliche und technische Fachinstitute, Forschungsinstitute, Universitäten, Industrieunternehmen, Landesbehörden, Genehmigungsbehörden, u.a. zusammengearbeitet haben, durch parteipolitische und kirchliche Organisationen sowie Nichtregierungsorganisationen (NRO/NGO) und sonstige gesellschaftliche Gruppierungen gezielt zu vernichten?

Bei dem Gorleben Projekt handelt es sich, unabhängig von dem Ausstieg aus der Kernenergie, um ein notwendiges Projekt in einem gesellschaftlichen Spannungsumfeld. Ein technisches Projekt wird weitestgehend von wissenschaftlichen und technischen Parametern geleitet, die im Grunde genommen von jedem überprüft und sachlich bewertet werden können. Das gesellschaftliche Umfeld dagegen wird von anderen Parametern geleitet. Hier dominieren menschliche Befindlichkeiten, kulturelle Erfahrungen, Religionen, politische Bewegungen und ihre Propaganda, Ideologien, aber auch Machtverteilungen, Machterhalt sowie Machtmissbrauch. Zum Machtmissbrauch und zur Rolle der Parteien formulierte Alt-Bundespräsident Richard von Weizsäcker 1992 in einem Interview: „Probleme instrumentalisieren sie, um sich gegenseitig zu bekämpfen, statt sie zu lösen.“ Was den Konflikt um die Endlagerung radioaktiver Abfälle überaus treffend beschreibt.

Um diese beiden Welten des gesellschaftlichen Umfeldes und der Technik erfolgreich bei dem Endlagerstandort zusammenzuführen, wäre eine höchstmögliche Transparenz von beiden Seiten erforderlich gewesen. Leider wurde die Information der Öffentlichkeit und damit die Herstellung von Transparenz zu diesem Projekt, die primär in der Zuständigkeit des Bauherrn, also der Bundesrepublik Deutschland, bzw. seines zuständigen Bundesumweltministeriums und seiner nachgeordneten Behörde BfS liegt, in sträflicher weise vernachlässigt, wie ein Vergleich zu der Öffentlichkeitsarbeit in den Projekten Schwedens, der Schweiz und Finnlands zeigt. In Deutschland waren der bauausführenden Technik Auftragsnehmer-seitig die Hände gebunden. Darüber hinaus stoßen technische Belange in der deutschen Öffentlichkeit auf wenig Interesse. Nur das BfS als die verantwortliche Fachbehörde berichtete damals routinemäßig und auch oft nur auf Nachfrage über den technischen Stand des Projektes.

Vorgetragene Kritikpunkte wie z.B. die Standortauswahl, die quartäre Rinne, oder die Gasgefährdung im und unter dem Salzstock, die in den neunziger Jahren in hauptsächlich von Greenpeace und von der damaligen rot-grünen Regierung finanzierten Gutachten veröffentlicht worden sind [Niedersächsischer Landtag – 17. Wahlperiode, Drucksache 17/1999, 2014*], sind von der BGR mit fachlichen Antworten richtig gestellt worden. Diese Bewertungen der BGR blieben jedoch in der Öffentlichkeit nahezu ungehört, da die Meinungshoheit weitestgehend von den Gorleben-Gegnern besetzt ist, wie sich an dem unendlichen Umgang der Politik mit den heute vorliegenden Ergebnisse der VSG Studie leicht nachvollziehen lässt.

Seit 2000 wurde die Öffentlichkeit zunehmend einseitig informiert. Denn die Presse und die Fernsehmedien berichteten mehr und mehr gezielt lancierte Desinformationen. Das BfS korrigiert selten öffentlich diese Falschmeldungen, oder übte Verschweigen von positiven Ergebnissen durch Gefahren [Asse – die Fakten; 2013*], die in dramatischer Art und Weise überhöht dargestellt wurden. Wissenschaftliche-technische Erfolge wurden negiert.

Warum konnte sich gerade in Deutschland ein derartiges Missverhältnis zwischen wissenschaftlich-technischer Offenheit und Ideologie, häufig gesteuert durch Ängste, entwickeln? Um das zu verstehen, sollte man sich daran erinnern, dass in 1999 nach dem altersbedingten Ausscheiden von Dr. Alexander Kaul, Professor für Strahlen- und Biophysik auf Veranlassung der damaligen rot-grünen Regierung Dipl. Ing. Wolfram König, Architekt und Ingenieur für Stadtentwicklung, ein aktiver Politiker der Grünen, zum Präsident des BfS ernannt wurde. Aus heutiger Sicht war das damals eine gravierende, eine langzeitsichere politische Entscheidung der Gegner. Die reifen Früchte können heute gepflückt werden. Anstatt die versprochenen Verbesserungen zur Transparenz des BfS zu realisieren, wie sie in dem AkEndbericht [Auswahlverfahren für Endlagerstandorte, Dez. 2002*] genannt werden, wurde im Tagesgeschäft vom BfS zu Gorleben genau das Gegenteil getan. Insbesondere zu den positiven Ergebnissen der VSG war vom BfS in der Öffentlichkeit nicht viel Erklärendes zu erfahren.

Die Meinungsführerschaft wurde dagegen zunehmend übernommen von Politikern und von Lobby Organisationen (Greenpeace, BUND etc.), aber auch von Stiftungen (Heinrich Böll Stiftung bzw. Stiftung Leben & Umwelt, Hans Böckler Stiftung etc.), oder von Kirchen und deren Akademien wie beispielhaft der Evangelischen Akademie Loccum, wo bei einer Tagung zur Endlagerung (17.10. bis 19.10.2014) ein Mitglied der Endlager-Kommission, angeregt haben soll „… überall Atomangst zu verbreiten, vor allem in Schulen…“. All diese Protagonisten wie Parteien, Verbände und Organisationen konnten nun ihre Botschaften und Behauptungen über dicht geknüpfte Informationsnetzwerke und hunderte von Internetforen bis heute verbreiten, verbunden mit zahlreichen bestens organisierten Vortragsveranstaltungen, Versammlungen oder vorgedruckten Anleitungen zur Meinungsmache, unabhängig davon, ob sie den Tatsachen entsprechen oder nicht. Widersprüche zu diesen Desinformationen waren vom BfS oder von beamteten Fachleuten selten in der Presse zu finden. Die für die Allgemeinheit so sehr benötigte und angekündigte Transparenz über die Ergebnisse bei Gorleben ist deshalb seit dem Jahr 2000 zunehmend zu einer „einseitigen Transparenz“, oder einer „Intransparenz“ verkommen.

Bestes Beispiel dafür ist die Antwort des Ministers des Niedersächsischen Umweltministeriums und Mitglied der Endlager-Kommission in 2014 auf die kürzliche Frage eines Abgeordneten der FDP zu Gorleben [Niedersächsischer Landtag – 17. Wahlperiode, Drucksache 17/1999, 2014*]. Die Antwort erwähnt nicht, dass nach Auffassung der rot-grünen Bundesregierung (2001) die bisher gewonnen geologischen Befunde einer Eignungshöffigkeit des Salzstocks Gorleben … nicht entgegen stehen. [Anlage 4 der Vereinbarung vom 11.06.2001*]. Auch werden mit keinem Wort die Ergebnisse der in 2013 fertiggestellten VSG-Studie angesprochen. Nur in einem aufgeführten Zitat eines 12 seitigen Gutachtens von Herrn Kleemann, Mitglied der Endlager-Kommission, finanziert von der Rechtshilfe Gorleben e.V., wird die VSG-Studie erwähnt. Wie derart eklatante Desinformationen des Niedersächsischen Umweltministerium von der Öffentlichkeit bewertetet werden überlasse ich Anderen.

WIE GEHT ES WEITER?

Laut Standortauswahlgesetz vom 23.Juli 2013 ist das – „Ziel des Standortauswahlverfahrens, in einem wissenschaftsbasierten und transparenten Verfahren für die im Inland verursachten, insbesondere hoch radioaktiven Abfälle den Standort für eine Anlage zur Endlagerung nach § 9a Absatz 3 Satz 1 des Atomgesetzes in der Bundesrepublik Deutschland zu finden, der die bestmögliche Sicherheit für einen Zeitraum von einer Million Jahren gewährleistet …“ Mit diesem Wortlaut wird dem interessierten Bürger nicht nur suggeriert, dass die dreißigjährige Standortsuche und die folgenden übertägigen und untertägigen Standortuntersuchungen in Gorleben nicht in einem wissenschaftsbasierten Verfahren durchgeführt wurden, sondern erst ab jetzt mit diesem Gesetz die Standorte für die möglichst langzeitsicherste Endlager gesucht, irgendwann einmal gefunden und anschließend mittels untertägigen Erkundungen bewertet werden. An dem dann ausgewählten Standort soll das Erkundungsbergwerk zum Endlagerbergwerk ausgebaut und die zur Auswahl aufgefahrenen Erkundungsbergwerke verschlossen werden. Zu beachten ist die unrealistische Formulierung “ … bestmögliche Sicherheit …“, die es auch bei der Untersuchung von zwei oder mehreren Standorten nicht geben kann! Denn es könnte immer noch einen weiteren noch viel sichereren Standort geben, der nicht untersucht worden ist.

Die bis 2010 geltende Zielvorgabe für ein Endlager lautete – die allerdings wegen der Bezugnahme auf Gorleben als Referenz heute nicht mehr genannt werden darf – schlicht und vernünftig: „Nachweis eines langzeitsicheren Endlagers.“

Kapitel 1

Zu „Allgemeine Vorschriften und Vorbereitung des Standortauswahlverfahren“ ist Folgendes zur Kommission anzumerken. Die Kommission besteht aus 8 Vertretern der Wissenschaft, von denen drei Geowissenschaftler sind, die in der Fachwelt nicht durch sachliche Veröffentlichungen zu Gorleben aufgefallen sind und 25 fachfremden Persönlichkeiten, von denen ein Teil Lobbyisten von NRO/NGO, Kirchenvertretern und Gewerkschaften sind. In der Vergangenheit sind diese wegen ihren negativen Minderheitsvoten zu wissenschaftlich-technischen nachprüfbaren Ergebnissen aufgefallen.Warum sollten diese ab heute an einer zeitgerechten und kostenbewussten Lösung der Entsorgung von hoch radioaktiven Abfällen interessiert sein? Verfolgt man die Berichterstattung der vergangenen zwanzig Jahre, benötigt dieser Hinweis zu deren Verhinderungspolitik keine weitere Erklärung. Der komplizierte Entscheidungsweg innerhalb der Kommission zu komplexen Sachverhalten wird deshalb nur schwer zu fach- und sachgerechten Antworten führen.

Diese Komplexität verhindert aber auch in Zukunft nicht, blitzschnelle politische Entscheidungen ohne all diese Formalismen zu treffen – wenn es die Politik wünscht, wie das nachfolgende Beispiel zeigt.

Der Deutsche Bundestag wurde in 2011 über die geplante Bewertung der VSG-Studie durch eine neutrale internationale Peer-Review-Gruppe informiert [Drucksache 17/6817, 2011*]. In einem am 27. Juli 2013 stattgefundenen parteiübergreifenden Konsensgespräch hatte man jedoch entschieden, diese neutrale Analyse nicht mehr zu vergeben, ohne die breite Öffentlichkeit darüber zu informieren. Die Öffentlichkeit ist jedoch an Resultaten wie diesem interessiert. Denn der Bürger hätte, wie in dem ´Stand AG´ langatmig gefordert wird, ein Recht darauf gehabt, auch aus neutralem Mund die wissenschaftlich-technischen und langzeitrelevanten Ergebnisse der Standortuntersuchung Gorleben zu erfahren, für die die Energiewirtschaft mehr als anderthalb Milliarden Euro ausgegeben hat. Interessant zu diesem Vorgehen ist zu wissen, dass nur vier Tage zuvor, am 23. Juli 2013, das ‚Stand AG‘ vom Bundestag verabschiedet worden ist, in dem es nach § 29 (3) heißt: “[dass] … spätestens mit Inkrafttreten dieses Gesetzes [die VSG-Studie] ohne ein Eignungsprognose für den Standort Gorleben eingestellt“ wird. Per Gesetz ist es nun verboten, die Ergebnisse der VSG-Studie durch neutrale, internationale Fachgutachter bewerten zu lassen! Ein herausragendes aber auch viel sagendes ‚Timing‘!

Diese Art der Entscheidungen hätte auch eine zukünftige ‚monströse‘ Kommission mit sehr komplizierten und langwierigen Abstimmungsverfahren sowie ein neues Bundesamt für Kerntechnische Entsorgung nicht verhindert! Gibt es heute Anzeichen dafür, dass sich mit dem ‚Stand AG‘ in Zukunft ein solcher Vorgang nicht wiederholen kann? Wohl kaum!

Kapitel 1 und 2 Öffentlichkeitsbeteiligung

Die generellen Grundsätze zur Öffentlichkeitsarbeit sind ausführlich dargestellt. Es wird sich aber schnell weisen, wie schwierig es werden wird, der Öffentlichkeit die komplexen, von den Fachleuten aber verstandenen geologischen, bergmännischen, kerntechnischen und insbesondere langzeitrelevanten Sachverhalte zu erklären. Zur Erinnerung: ein geologischer Körper ist im Gegensatz zu einem technischen Projekt nicht normierbar und dessen Charakterisierung kann letztendlich nicht in Zahlen ausgedrückt werden. Denn in der Geologie gilt das Aktualitätsprinzip: „Dieses Prinzip der Gleichförmigkeit der Prozesse besagt, dass geologische Vorgänge, die heute zu beobachten sind, ebenso in der Vergangenheit gewirkt haben. Es sind also Rückschlüsse von heutigen Abläufen auf Bildungsprozesse in der Vergangenheit möglich und umgekehrt“. Das ist der Grund, warum für die Endlagerung ein tiefes Verständnis von geologischen Analogien, die Kenntnis über das Verhalten von natürlichen entstandenem „Atommüll“ in der Natur, das Entstehen von Erzlagerstätten und deren Veränderungen als Folge von chemischen und physikalischen Gesetzen in den unterschiedlichsten Gesteinsarten und über sehr lange Zeiträume so wichtig ist [z.B. The Origin of the Chemical Elements, P.K. Kuroda; 1982*].

Diese Komplexität ist jedoch die offene Flanke für die Gegner der Endlagerung. Ziel der Öffentlichkeitsarbeit müsste es deshalb sein, diese Fakten mit ehrlicher und politisch unabhängiger Transparenz den Bürgern aktiv zu erklären. Trotz des fortdauernden Versprechens der Verantwortlichen ist dies aus politischen Gründen nur sehr zurückhaltend geschehen. Und deshalb hatte diese Taktik in den vergangenen Jahren Erfolg. Denn wenn die sozialdemokratische Umweltministerin des Landes, Barbara Hendricks, heute ohne Widerspruch in aller Öffentlichkeit behaupten kann, die Endlagerung sei nicht mit dem Christentum vereinbar, ein Landesbischof in öffentlichen Sitzungen die Endlagerung als Teufelszeug diskriminiert [Endlagersuchkommission – Rückfall ins Mittelalter*], in Seminaren sich Soziologen zur Radioaktivität sachfremd äußern dürfen und sogenannte Fachleute jahrelang Behauptungen wiederholen können, die von Fachbehörden längst widerlegt worden sind, kann es in Deutschland keine rationale Suche nach einem langzeitsicheren Endlager bzw. Untertagedeponie für hoch radioaktive Abfälle geben. Dies zeigt beispielhaft, dass sich wie in der Vergangenheit auch in Zukunft mit dem ‚Stand AG‘ außer hohen Kosten nicht viel ändern wird. Denn bei der Berichterstattung über Gorleben hat das Korrektiv einer ideologiefreien Presse bis auf wenige Ausnahmen total versagt. Trotz der vielen Worte zur Bürgerbeteiligung im Gesetz, wird sich die Desinformation – nicht zuletzt mit den vielfältigen Möglichkeiten des Internets an der von vielen gewünschte Desinformation zu diesem Thema ändern.

Kapitel 3 Standortauswahlverfahren

Zu dem fachlichen Bereich ist wenig zu sagen, da der Gesetzestext die wissenschaftlich-technische Methodik der Endlagerung beschreibt, die allerdings seit Jahrzehnten international bekannt ist und auch bei der Standortuntersuchung von Gorleben und der Auswertung der Ergebnisse zum größten Teil schon berücksichtigt worden und dokumentiert sind.

In § 12 bis § 20 werden die formalen Verfahrensschritte im Einzelnen aufgelistet. Sie betreffen die für ein Großprojekt üblichen gesetzlichen Vorschriften und die Einbindung von zuständigen Bundes- und Landesbehörden, Standortregionen und Forschungseinrichtungen. In diesen Kapiteln werden, insbesondere in § 10 aber nicht nur dort, detaillierte Hinweise zur Durchführung von Bürgerversammlungen genannt und die jeweiligen Verfahrensschritte im Zusammenwirken mit der Öffentlichkeit beschrieben wie auch die organisatorischen Vorbereitungen für die Bürgerversammlungen durch die Vorhabenträger. Und genau hier liegt der Hinweis auf das Versagen dieses Gesetzes. Denn wie die Vergangenheit gezeigt hat, ist es äußerst unwahrscheinlich, dass in Zukunft die Vorhabenträger die Öffentlichkeit so sachgerecht informieren werden, dass auch durch ein Ideologie und Politik getriebener Widerstand die Entsorgung radioaktiver Abfälle in tiefen geologischen Gesteinseinheiten verhindert wird. Die völlige Transparenz im Projekt ließe sich nur durch eine politisch und finanziell unabhängige Öffentlichkeitsarbeit herstellen, die vom Vorhabenträger zeitnah die Information abfordert bzw. in den Projektfortschritt informativ eingebunden ist. Offensichtlich ist diese vollkommene Transparenz aber hierzulande nicht erwünscht, wodurch der politischen Manipulation in Zukunft Tür und Tor geöffnet bleibt. Denn in dem Gesetzestext ist hierzu nichts zu finden.

In der 7. Sitzung der Kommission am 6. Dezember 2014 weist ein Mitglied der Kommission nach seinen Berechnungen darauf hin, dass ein Standort nach den neuen Regeln nicht vor 2058 gefunden werden könne und mit der Inbetriebnahme nicht vor 2083 also in 68 Jahren zu rechnen sei [www.bundestag.de/presse/hib/2014_12/-/345264*]. Historisch gesehen: Hätte man vor 68 Jahren, im Jahr 1947 (Währungsreform 1948) ein Projekt mit gleichem Zeitaufwand geplant, wäre es erst heute fertig geworden. Auch wenn das Endlager zehn Jahre früher zur Verfügung stehen sollte, wird eine sehr lange Zeit die teure dezentrale übertägige Zwischenlagerung des ´Atommülls´ die Lösung sein müssen, bis eine nicht in Deutschland entwickelte Technik (Transmutation) einer energetischen Nutzung der „Abfälle“ zur Verfügung steht. In diesem Zusammenhang muss deshalb deutlich gefragt werden, ob weiterhin nach einem Endlager gesucht werden soll. Eine entsprechende Anpassung im Atomgesetz wäre einfacher und auch wirtschaftlicher, als das deutsche Hassthema Endlagerung ewig am Leben zu erhalten.

Kapitel 4 Kosten

Konkrete Zahlen zu den Kosten können wegen der Komplexität der Verfahrensschritte und die dadurch zu erwartenden langen Zeiträumen realistischerweise nicht genannt werden. Aus wirtschaftlicher, aber ins besonders aus ‚ökologischer‘, aus naturbewusster Sicht wäre eine wenige tausend Euro teure Bewertung der Ergebnisse von Gorleben vernünftiger gewesen. Aus ‚ökologistischer‘, aus ideologischer Perspektive zählt das jedoch nicht. Dank der zukünftigen Suche wird die Zeit gewollt nur mit politischen Scheinaktivitäten gefüllt. Bis heute gegoltene wissenschaftliche, technische und wirtschaftliche Gesichtspunkte werden negiert. Mit dem neuen Gesetz werden die Kosten ins Unendliche steigen und zwar wegen der neuen Behörde, den komplizierten Abstimmungsprozessen, wegen der Suche nach mehreren neuen Standorten und deren übertägigen Erkundung, wegen des Baus von zumindest drei zusätzlichen Untersuchungsbergwerken mit Abraumhalden zur untertägigen Erkundung und wegen des Verschlusses von zumindest zweien einschließlich der Grube Gorleben.

Ob ein derart ideologisch überprägtes Projekt entsprechend dem geplanten Verfahren jemals realisiert wird, ist die offene Frage. Deshalb lässt sich auch keine halbwegs wirklichkeitsnahe Zahl zu den Kosten bis zur theoretischen Inbetriebnahme eines neuen Endlagers nennen. Beispielhaft sei hier auf die große Diskrepanz der Kostenschätzung hingewiesen, die bei der Entscheidung zur Energiewende propagiert wurden zu den Kosten, die bis heute tatsächlich entstanden sind und weiter entstehen werden. Typisch für die heutigen Politiker ist, dass man erst jetzt – nach der Verabschiedung des ‚Stand AG‘ beginnt, über die Höhe und die Finanzierung der zukünftigen Entsorgung der radioaktiven Abfälle nachzudenken. Fakt ist: es hätte einen sichereren und kostengünstigeren Weg gegeben. Unabhängig davon, wer die Kosten übernehmen wird, sie müssen auf jeden Fall von den zukünftigen Generationen der Deutschen bezahlt werden. Das ist das einzig Sichere an diesem Kapitel.

Kapitel 5 Schlussvorschriften

§ 29 Bestehender Erkundungsstandort:

(1) „ … Der Salzstock Gorleben dient nicht als Referenzstandort für andere zu erkundende Standorte. Der Umstand, dass für den Standort Gorleben Erkenntnisse aus der bisherigen Erkundung vorliegen, darf eben sowenig in die vergleichende Bewertung einfließen, wie der Umstand, dass für den Standort Gorleben bereits Infrastruktur für die Erkundung geschaffen ist. Der Ausschluss nach dem Standortauswahlgesetz erfolgt:

♦ wenn der Salzstock Gorleben nach §13 nicht in der ersten Stufe zu den Regionen gehört, die nach geowissenschaftlichen, wasserwirtschaftlichen und raumplanerischen Kriterien entsprechen,

♦ wenn Gorleben nicht nach §14 zu den festgelegten übertägig zu erkundenden Standorten gehört,

♦ wenn Gorleben nicht nach §17 bei der Auswahl für die untertägige Erkundung den Anforderungen und Kriterien in dem bis zu diesem Zeitpunkt des Standortauswahlverfahrens der Standortentscheidung entspricht und

♦ wenn Gorleben nicht nach § 20 der ausgewählte Standort ist.

♦ Das Erkundungsbergwerk (Gorleben) wird bis zu der Standortentscheidung nach dem Standortauswahlgesetz unter Gewährleistung aller rechtlichen Erfordernisse und der notwendigen Erhaltungsarbeiten offen gehalten, sofern der Salzstock Gorleben nicht nach Absatz 1 aus dem Verfahren ausgeschlossen wurde. Der Betrieb eines Salzlabors, insbesondere zur standortunabhängigen Forschung zum Medium Salz als Wirtsgestein, ist ab dem Zeitpunkt nach Satz 1 unzulässig. Die vorläufige Sicherheitsuntersuchung des Standortes Gorleben wird spätestens mit Inkrafttreten dieses Gesetzes ohne eine Eignungsprognose für den Standort Gorleben eingestellt“.

(2)„… Der Betrieb eines Salzlabors, insbesondere zur standortunabhängigen Forschung zum Medium Salz als Wirtsgestein, ist ab dem Zeitpunk nach Satz 1 unzulässig.“

(3)„Die vorläufige Sicherheitsuntersuchung des Standortes Gorleben“ [VSG] „wird spätestens mit Inkrafttreten dieses Gesetzes ohne ein Eignungsprognose für den Standort Gorleben eingestellt.“

Für die Politik ist dieses an den Schluss des ‚Stand AG‘ angeklebte Kapitel das wichtigste Kapitel des Gesetzes – und zeigt den Geist dieses Gesetzes.

ERGEBNIS

Um glaubhaft zu bleiben, hätten die Gegner von Gorleben eine internationalen Bewertung der VSG-Studie begrüßen und unterstützen müssen, da sie seit Jahren mit großem propagandistischem Aufwand die Eignungshöffigkeit von Gorleben aus fachlicher Sicht bezweifeln und dies jahrelang der Öffentlichkeit eingehämmert haben. Denn würde das von einer internationalen Peer-Review-Gruppe erarbeitete Votum zur vorläufigen Eignungsprognose (VSG-Studie) negativ ausfallen, dann hätten sie den Nachweis bekommen, dass sie seit Jahren das Projekt verantwortlich begleitet haben. Die Verabschiedung des ‚Stand AG‘ wäre in diesem Fall berechtigt. Diesen fairen Wettbewerb zwischen Wissenschaft und Technik und Politik und Ideologie wollte man jedoch nicht eingehen. Da die Gegner offensichtlich selbst an dieses Resultat nicht glauben wollten, zeigt die Verhinderung des neutralen Testats die Verzweiflung der heutigen Politiker. Die nur vier Tage dauernde Umsetzung dieses am 23. Juli 2013 verabschiedeten Gesetzes und das am 27. Juli 2013 ergangene Verbot des Testats der VSG verstärkt diesen Hinweis.

Das Gesetz bedeutet aber nicht nur den ‚quasi‘ gesetzlichen Todesstoß für Gorleben, es beinhaltet auch, dass in Deutschland per Gesetz verboten wird, an diesem Standort wissenschaftlich erforderliche Untersuchungen zur Langzeitsicherheit durchführen zu dürfen. Mit dieser gezielten Unterbrechung wird aus politischen Gründen bewusst eine Wissenslücke herbeigeführt, um den Standort aus dem Wettbewerb auszuschließen. Nach den vorliegenden Erfahrungen ist davon auszugehen, dass auf dem langen Weg zur Festlegung eines neuen Standortes auch in Zukunft nicht fachliche Erkenntnisse, sondern grün-ökologistische Propaganda den Ton angeben wird.

Bei dem Gesetz geht es nicht nur um die endlose Verzögerung der Endlagerung. Nein, es geht dabei auch um einen legitim erscheinenden Ausschluss von Gorleben aus dem Standortauswahlprozess – und um den Sieg einer Bewegung, einer Ideologie, die mit einer über viele Jahre gezielt vorbereiteten, politisch gesteuerten Propaganda durchgesetzt wurde. Mit Hilfe dieser Propaganda und heute mit der zusätzlichen Unterstützung der ‚Facebookisierung‘ ist es gelungen, die Ritualisierung der Desinformation zu nutzen, die sich im Netz wie eine Seuche ausgebreitet hat. Und damit ließen sich in einem noch größeren Teil der Bevölkerung irrationale Ängste schüren, die es der grünen Bewegung erleichterte, die Macht zu erschleichen.

Die Vergangenheit hat uns eingeholt.

Dieser politische Vorgang macht deutlich, dass Gorleben nicht aus wissenschaftlich-technischen, sondern aus rein politisch-ideologischen Gründen beendet werden soll! Das ‚Stand AG‘ ist ein Anti-Gorleben-Gesetz und es ist ein teures „Ad calendas graecas, ein teures ideologisches Monster bis auf den Sankt-Nimmerleins-Tag“. Mit diesem Anti-Gorleben Gesetz ist das Ende des weltweit am besten untersuchten und chancenreichsten Endlagerstandortes abzusehen. Ob dieser mit ideologischen Parolen erreichte Sieg zum Wohle zukünftiger Generationen gereichen wird, wird sich zeigen.

Fasst man zusammen: Mit einer ’neu-deutschen‘ Standortsuche und einer anschließenden Untersuchung dieses Standortes soll jetzt für eine möglichst sichere Entsorgung von Wärme-entwickelnden, hoch radioaktiven Abfällen begonnen werden. Grundlage dafür soll nach Ansicht des Niedersächsischen Umweltministers anscheinend hauptsächlich der Kenntnisstand dienen [Niedersächsischer Landtag – 17. Wahlperiode, Drucksache 17/1999, 2014*], der von einigen geologisch zweifelhaften Gutachten aus dem vorigen Jahrhundert stammt. Und das, ohne offiziell gegenüber der Öffentlichkeit das Ergebnis der Vereinbarung von 2001 zwischen der rot-grünen Regierung und der E-Wirtschaft zu nennen, dass „die bisher gewonnen geologischen Befunde einer Eignungshöffigkeit des Salzstocks Gorleben nicht … entgegen“ stehen [Anlage 4 der Vereinbarung vom 11.06.2001*], und dass es eine neun Millionen Euro teure, qualitativ hochwertige Auswertung (VSG-Studie) der mehr als anderthalb Milliarden teuren Erkundungsergebnisse des Standortes Gorleben gibt, in der keine K.O Kriterien zur Eignungshöffigkeit von Gorleben zu finden sind.

Literatur: [*] bei Google zu finden

Dr. Helmut Fuchs

Mitautor des Kapitels 3 Kernenergierohstoffe im Lehrbuch „Angewandte Geowissenschaften, Band IV“, Herausgegeben von Friedrich Bender; Ferdinand Enke Verlag Stuttgart.

ANHANG

In einem Politthriller „Die German Angst [Helmut Fuchs und Rolf Kamradek, bookshouse Verlag; 2013, ISBN 978-9963-727-780;*] haben mein Co-Autor und ich das Missverhältnis zwischen wissenschaftlich-technischer Offenheit und einer fachfremden Ideologie thematisiert, die seit den 80-er Jahren durch Schüren und Kreieren von Ängsten die Öffentlichkeit verunsichert und so die wirtschaftliche Entwicklung lahm legt. Die politischen Hintergründe dieser Entwicklung werden aufgezeigt. Wenn man in dem Thriller die Worte Grafit durch Uran, sowie Keramik-Grafit-Motor durch Kernkraft ersetzt, wird die Verhinderungspolitik („Stand AG: Paragraph 9a Absatz 3 Satz 1 des AtG“) für die Entsorgung hoch radioaktiver Abfälle in Deutschland, die mit einem unbezahlbaren Schrecken ohne Ende zu keinem Ergebnis kommen darf, für die nachfolgende Generation, entsprechend der Vorhersage des Romans, deutlich.

***