Frau Umweltministerin Hendriks Glaube an den menschengemachten Klimawandel ist so unerschütterlich, dass Sie im Eifer schon mal Tsunamis durch Klimawandel entstehen lässt [1] und ihn auch „täglich spürt“ [36], obwohl es seit ca. 20 Jahren nicht mehr wärmer wird. Kritik an der offiziellen Klimadoktrin duldet Sie gar nicht und kann dann schon mal richtig böse werden[30].

Der bayerische Ableger, Frau Umweltministerin Scharf steht dem wenig nach. Sie lässt ihr Ministerium verkünden:

[31] „Der vom Menschen verursachte Klimawandel ist wahrscheinlich die größte Herausforderung der Menschheit“.

Sie hat einen Klimamarathon zur Weltklimakonferenz in Paris gestartet und kämpft nun mit Einsatz dafür, Bayern klimasicher zu machen[26].

Da außer echten Fachpersonen wohl niemand so genau weiß, was man unter „klimasicher“ zu verstehen hat, werden erst einmal Forschungsgelder losgetreten, um wichtige, ohne Klimawandel-geschulte Forschungszentren bisher im Technologieland Bayern nicht lösbare Probleme anzugehen. Darunter sind dann auch:

[27] „Schutz der Beschäftigten vor Hitze und Sonneneinstrahlung. Maßnahmen des vorbeugenden Arbeitsschutzes, Klimatisierungen oder neue Arbeitszeitmodelle,“

[32] Angehen der Problematik: „Sand und andere Feinsedimente aus Flüssen können das Seewasser trüben. Dadurch erhalten Unterwasserpflanzen weniger Licht zum Wachsen.“

[33] Renaturierung von Mooren zur CO2-Senkung.

Der Verfasser wird den Verdacht einfach nicht los, dass „der Klimawandel“ im Kern nur eine verschleierte, gigantische Arbeits-Beschaffungsmaßnahme für die Akademikerschwemme darstellt.

Die Klimawissenschaftler welche auf der Zugspitze forschen wissen auch, wer für ihr Forschungsbudget sorgt und nutzten die Gunst der Stunde. Spontan brachten sie ihre tiefe Bestürzung ums Klima zum Ausdruck, dabei nicht vergessend zu erwähnen wie viel Forschungsaufwand noch erforderlich ist. Vorsichtshalber wurde dazu das nötige Schreckensszenario gelistet:

[1]: "Der Gletscher schmilzt, die Baumgrenze wandert nach oben, Steinschläge drohen“

● "…steigt aber auch die Waldbrandgefahr, und sie kann in Monaten auftreten, die bislang völlig ungefährlich waren.“

● "Der Pollenkalender muss umgeschrieben werden", sagt Menzel. Und: Die Pollen sind heute aggressiver und damit gefährlicher für die Gesundheit“.

● „…Es drohen Steinschläge und Hangrutsche. Wo der Permafrost verschwindet, stehen auch die Stützen für Skilifte und Berggondeln nicht mehr sicher – was wirtschaftliche Folgen für den Tourismus hätte.“

● [2]:"Forscher Ralf Sussmann : Wasserdampf sagt er, spiele bei der Klimaerwärmung eine sehr viel stärkere Rolle als angenommen ….„Dass die verwendeten Klimamodelle diesen Faktor viel zu niedrig einrechneten“.

● Ökoklimatologin Annette Menzel: „Wir haben hier oben ein Stethoskop, mit dem wir sie (die grüne Lunge unter uns) sehr gut abhören können. Das, was sie da hört, gefällt ihr gar nicht. Seit Jahrzehnten steigt die Durchschnittstemperatur kontinuierlich an. …dass mit den häufiger auftretenden Hitzewelle nicht nur die Waldbrandgefahr steigt, sondern auch die Zahl der Hitzetoten. Und dass mit dem warmen Klima auch Mücken und Zecken kommen, die Krankheiten übertragen.

Zuerst einmal sehen wir uns die Infos der Klimaforscher an, welche der Redakteur und scheinbar auch die zwei Fachpersonen willig und unreflektiert aufnahmen, um zu sehen, was der Zwang zur Fremdfinanzierung bewirkt:

● "Der Pollenkalender muss umgeschrieben werden",

Der Uba-Klima-Monitoringbericht 2015 listet dazu[3]:

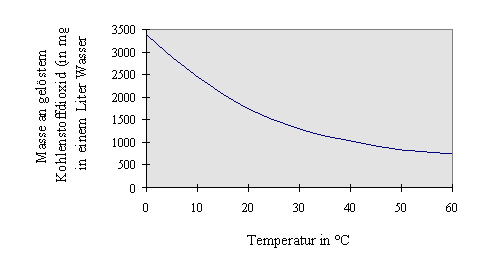

Belastung mit Ambrosiapollen

Die Ausbreitung und Etablierung der Beifuß-Ambrosie wird vermutlich durch den Klimawandel begünstigt. Noch zeigen die Ergebnisse der Pollenmessungen aber keine signifikanten Trends.

Weiter kommt zu Pollen nichts, außer dass Pollen-Apps verstärkt angeboten und abgerufen werden.

Anmerkung zu den Bildern dieses Blogartikels. Kein Bild ist vom Autor inhaltlich verändert. In einigen sind aber zum besseren Verständnis Erklärungstexte / Zahlen und Hinweispfeile zugefügt. Diese sind immer an der schwarzen Farbe und anderen Schriftart erkennbar. Es wurde aber darauf verzichtet, auf solche Ergänzungen hinzuweisen.

Bild 1: Belastung mit den stark allergenen Ambrosiapollen. Seit 2006 Abnahme erkennbar.

● "steigt aber auch die Waldbrandgefahr, und sie kann in Monaten auftreten, die bislang völlig ungefährlich waren.“

Der Uba-Klima-Monitoringbericht 2015 listet dazu, dass sowohl Anzahl als auch die Fläche von Waldbränden abgenommen hat:

[3]:Trotz zunehmender Waldbrandgefahr nicht mehr Waldbrände…

Bild 2: Abnahme der Anzahl und Fläche von Waldbränden

● ….Und dass mit dem warmen Klima auch Mücken und Zecken kommen, die Krankheiten übertragen.

Der Uba-Klima-Monitoringbericht 2015 listet dazu:

[3]:Es wird befürchtet, dass in Deutschland unter künftig veränderten Klimabedingungen sowohl für die tierischen Überträger wie beispielsweise Stechmücken oder Zecken als auch für die Erreger selbst günstigere Bedingungen herrschen und infolge dessen auch das Infektionsrisiko für den Menschen steigt.

Man hat also die üblichen – vorsorglichen – Klimawandel-Befürchtungen, aber keine Belege.

In einer vergleichbaren Landesstudie steht dazu deshalb auch ganz lapidar:

[8] Die Chance, dass die Erwärmung die Malaria zurückbringen würde, schätzen die Autoren als äußerst gering ein.

● …dass mit den häufiger auftretenden Hitzewellen nicht nur die Waldbrandgefahr steigt, sondern auch die Zahl der Hitzetoten.

Das Märchen der Klimawandel-Hitzetoten ist also auch schon auf der Zugspitze angekommen. Demnach ziehen die US-Rentner die es sich leisten können wohl zum Suizid nach Florida in die Wärme und die Deutschen aus dem gleichen Grund nach Spanien.

In einer Studie kam man vor Jahren zu einem ganz anderen Ergebnis

[8] Eine Studie der britischen Regierung zieht positive Bilanz der sonnigeren letzten drei Jahrzehnte.

"Von Kälte verursachte Sterblichkeit ist erheblich größer als die auf Hitze zurückzuführende, sowohl in Großbritannien als auch im übrigen Europa", heißt es in der Studie.

Der Uba Monitoringbericht zeigt, dass seit dem Hitzejahr 2003 die Hitzetage stetig abnehmen und inzwischen auf den Stand von 1976 zurückgekommen sind.

Bild 3: Grafik der Hitzeextreme aus dem Uba-Bericht 2015[3].

Und bezüglich der „Klimawandel-Hitzetoten“ ist der Bericht ebenfalls s ganz unspektakulär. Zudem ist die Datenlage dazu gravierend schlecht, womit gar keine fundierte Aussage möglich ist.

Bild 4[3]: Darstellung des Uba-Berichtes 2015 zum Thema „Hitzetote“

Diesen Zustand konnte das Uba nicht auf sich sitzen lassen und hat ganz aktuell eine DWD-Studie dazu publiziert, die das Gegenteil belegen soll[17]. Doch auch diese weist in Wirklichkeit nur aus, dass die „Klimawandel-Hitzetoten“ im Mortalitätsrauschen verschwinden und bezüglich der Mortalität die Vorteile der Gesamterwärmung bei weitem überwiegen. Details dazu kann man in meinem EIKE Blogbeitrag[35] nachlesen.

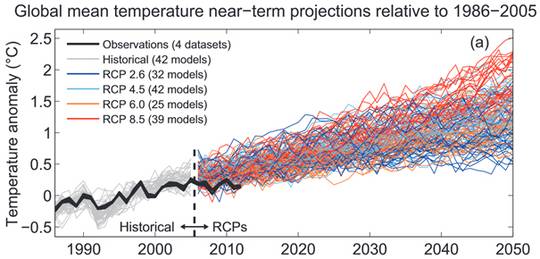

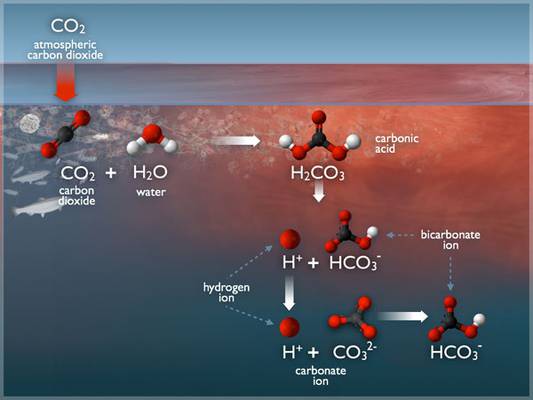

● „Wasserdampf sagt er, spiele bei der Klimaerwärmung eine sehr viel stärkere Rolle als angenommen ….Dass die verwendeten Klimamodelle diesen Faktor viel zu niedrig einrechneten“.

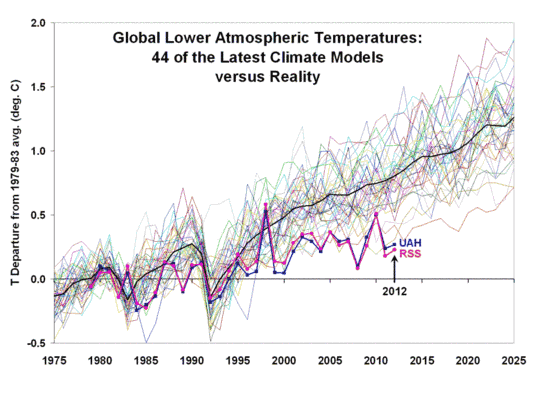

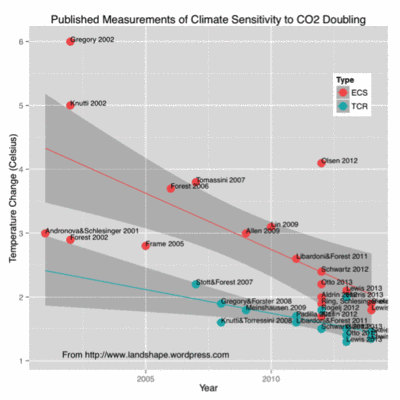

Der Durchbruch für die Forcingtheorie. CO2 alleine bewirkt viel zu wenig und benötigt deshalb zwingend einen Wirkungsverstärker, der im Wasserdampf gefunden wurde. Ist aber dessen Verstärkung zu gering, bricht das Forcing in sich zusammen. Und genau diese Gefahr besteht. Das musste selbst das IPCC erkennen und reduziert (langsam) den Forcing-Vertrauensbereich zu niedrigen Werten. Auf der Zugspitze erklärt nun ein Forscher, dass das IPCC die Forcing-Geschichte wieder zurückdrehen darf. Obwohl die IPCC Klimamodelle bereits mit den niedrigeren Werten heute völlig daneben – weil zu hoch – liegen[34].

Auch die Betreiber des Blogs „www.kaltesonne.de“ werden sich nun umsehen müssen. Hatten sie doch beschrieben, dass der IPCC das Wasserdampf-Forcing noch viel zu hoch ansetzt [11].

Für den der weiß, dass der Klimafachmann auf der Zugspitze ein neues, lasergestütztes Messgerät zur Wasserdampfanalyse der Atmosphäre bekommen hat, relativiert sich die Aussage. Irgendwie muss man die Investition vor einem so honorigen Besuch ja begründen.

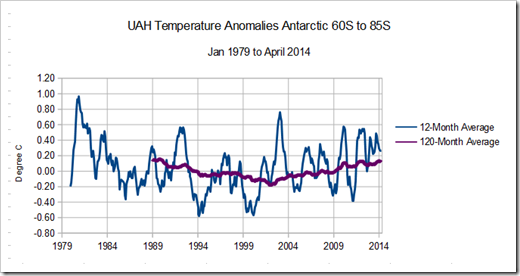

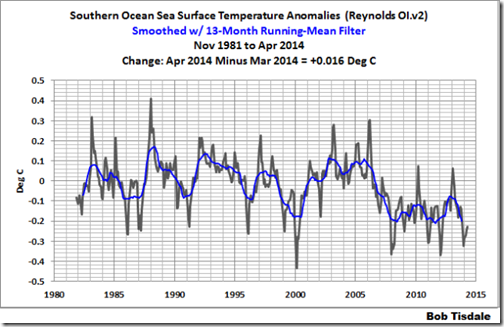

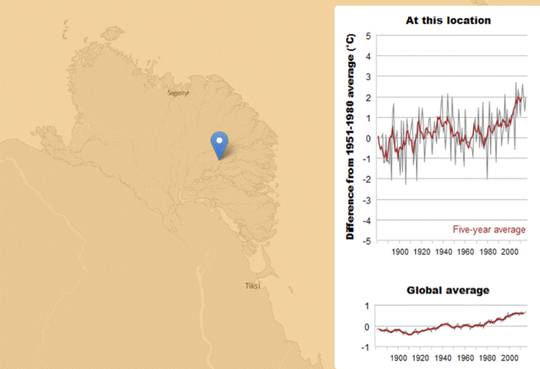

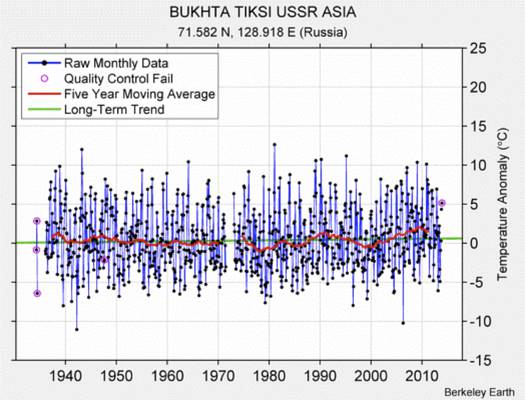

● „…Seit Jahrzehnten steigt die Durchschnittstemperatur kontinuierlich an.“

Dass es seit ca. 2 Jahrzehnten nicht mehr wärmer wird, aber schon seit 150 Jahren kontinuierlich anstieg, „vergaß“ man zu erwähnen.

Der Autor hat die Temperaturdaten der Messstation Zugspitze vom DWD geladen und graphisch dargestellt. Er findet darin (als Nichtfachmann) keinen (signifikanten) menschengemachten Klimaeinfluss. Auch sieht man eine erkennbare, Jahrzehnte-lange Zyklik, die beim stetigen Anstieg des CO2 zumindest verwundert. Eigentlich findet er die Kurven insgesamt vollkommen unspektakulär und wüsste nicht, was der Mensch daran ändern sollte. Aber im Blog finden sich bestimmt Fachleute, die erklären können, wo sich darin der Klimawandel versteckt hält.

Bild 5: Selbst erstellte Grafik der Zugspitztemperatur-Monatswerte seit 1901 anhand der DWD-Monatsdaten

Bild 6: Selbst erstellte Grafik der Zugspitztemperatur Monats Max / Min-Werte seit 1901 anhand der DWD-Daten

So weit also zu den von den Experten dargestellten Schrecken, welche das nicht mehr so kalte Klima verursacht und aus der Zugspitzhöhe besonderst scharf sichtbar sein sollen.

Zurück zum Thema Gletscher.

Es ist unbezweifelbar, dass die Alpengletscher massiv geschrumpft sind und eventuell noch weiter schrumpfen. Es ist aber nicht sicher, ob es das noch nie gab und es vom Menschen verursacht sein muss. Im Folgenden wird jedoch nicht auf die Diskussionen zu Gletscher-Rückzugstheorien eingegangen, sonder nur aus Publizierungen gelistet, die am signifikanten menschlichen Einfluss zweifeln lassen.

Vorab dazu die Info, dass es nach Sichtung der Publizierungen im Wesentlichen zwei Richtungen gibt:

● Eine „Standardrichtung“, welche davon ausgeht, dass bis ca. 1980 aller Gletscherschwund „natürlich“ war, ab dann jedoch der Mensch der wesentliche „Gletschertöter“ ist. Verbunden mit der Aussage, dass die Alpen ohne Gletscher „unnatürlich“ wären und der Mensch dagegen vorgehen muss.

● Eine kleine „Protestgemeinde“, welche darauf hinweist, dass es bereits zu früheren Zeiten massiven Gletscherschwund, schlimmer noch – insgesamt wesentlich weniger Gletscher gegeben hat – und der aktuelle Schwund keinesfalls erheblichen, menschengemachten Charakter trägt.

Im vom Bayerischen Umweltministerium herausgegebenen Statusbericht Gletscher werden diese prosaisch beschrieben:

[9] Gletscher faszinieren den Menschen seit jeher. Gletscher sind unberührte Naturwunder, sensible Ökosysteme, Wasserspeicher, Orte der Schönheit und der Magie, der Beständigkeit und des Wandels zugleich. Diese Werke der Schöpfung und Evolution gilt es zu bewahren und zu schützen.

Der Schreiberling dieser Prosa hat wohl viel romantische Literatur gelesen. Ob er jedoch auch nur eine Spur Ahnung über die Auswirkungen der Gletscher auf die Menschen hat, die darunter leben mussten kann man bezweifeln.

Welche Schrecken stellte das kalte Klima dar? Gehen wir in der Geschichte zurück zu den Zeiten, als die „Orte der Schönheit und Magie“ – noch groß und mächtig waren und sich der Mensch davor verzweifelt zu schützen versuchte.

[6] Es ist in der neueren Literatur mehrfach und immer wieder bestätigt, daß gerade in der sogenannten „Kleinen Eiszeit“, die von etwa 1590 bis 1850 dauerte, eine rasante Zunahme des Hexenwesens vermeldet wird. Die in dieser Zeit sich dramatisch häufenden Naturereignisse, besonders die in den stark vergletscherten Regionen der Alpen häufigen Gletschersee-Ausbrüche und Extrem-Wasserschäden wurden diesen „Wettermachern“ und „Hexern“ zugeschrieben.

[4] Bei Hochständen endete der Fieschergletscher in zwei Gletscherzungen, die nahe an die Weiler Brucheren und Unnerbärg heranreichten. Es ist deshalb verständlich, dass sich die Fieschertaler bedroht fühlten.

Um die Gletschergefahr abzuwenden, machten die Fieschertaler der Sage nach das Gelübde, sich an den Samstagen von der Vesper an jeglicher knechtlicher Arbeit zu enthalten. Eine Ausnahme war das Einlegen von dürrem Heu und Getreide. Als der Fieschergletscher 1652 vorstiess, unternahmen die Talbewohner eine gletscherbannende Prozession unter der Leitung eines Geistlichen und beschworen das „Gespenst“ im Fieschergletscher. Der Gletscher soll daraufhin nicht mehr weiter vorgerückt sein.

Im Jahr 1676 ersuchten die Talbewohner Papst Innozens XI., das Gelübde umwandeln zu dürfen, da sich nicht alle Fieschertaler an dieses hielten. Dies geschah dann auch im Jahr 1678. Die Fieschertaler mussten unter anderem versprechen, keine verborgenen Tänze zu veranstalten und die Frauen keine roten Schürzen mehr tragen zu lassen. Im Jahr 1860 drohte wiederum Gefahr, weil der Fieschergletscher erneut zu einem Hochstand vorgestossen ist. Die Fieschertaler machten erneut ein Gelöbnis, nämlich alljährlich eine Bittprozession zur Kapelle im Ernerwald durchzuführen, eine Kerze in der Kirche an Sonn- und Feiertagen zu unterhalten und jährlich eine Messe zu lesen.

[5]: Als man barhaupt den Grossen Aletschgletscher bannen wollte

Angelangt am Sitze des Übels wird vorab das hl. Messopfer gefeiert, dann eine kurze Predigt gehalten, hierauf mit dem Allerheiligsten der Segen erteilt, um den sich schlängelnden Gletscher einzudämmen und demselben Zügel anzulegen, auf dass er nicht weiter mehr sich ausdehne. Es werden die feierlichen Beschwörungen der Kirche in Anwendung gebracht und der äusserste Teil des Gletscherberges mit Wasser, geweiht im Namen unseres hl. Vaters (St. Ignatius), besprengt. Überdies wurde daselbst eine Säule aufgerichtet, auf der sich das Bildnis ebendesselben hl. Patriarchen befand, gleichsam das Bild eines Jupiter, der nicht flüchtigen Soldaten, sondern dem gefrässigen Gletscher Stillstand gebietet. Um diese Zuversicht auf die Verdienste des Heiligen blieb nicht ohne Frucht. Er hat den Gletscher zum Stehen gebracht, so dass er von nun an sich nicht weiter ausdehnte. Im Monat September 1653.»

Unterhalb des Aletschgletschers beten fromme Menschen über 3 Jahrhunderte für den Rückgang dieser Gletscher-Bedrohung (“Der kalte Tod”).

“… Es gab eine Zeit, in der der Aletschgletscher wuchs und wuchs. Er rückte bedrohlich nahe ans Dorf heran. Dazu kamen die Ausbrüche des Märjelensees. 35 Mal brach der Eisstausee im 17. Jahrhundert oberhalb von Fiesch aus.

1678 legten die Bewohner von Fiesch und vom Fierschertal ein Gelübte ab, in dem sie vor Gott und der Welt kund taten, fortan tugendhaft zu leben und brav zu beten, dass der Gletscher sein Wachstum einstelle. Sie hielten einmal pro Jahr eine mehrstündige Prozession im Ernerwald ab, um gegen das Wachstum des Gletschers zu beten. Die Prozession fand am Tag des Gründers des Jesuitenordens, dem Heiligen Ignatius von Loyola, am 31. Juli statt.

Pfarrer Johann Joseph Volken, ein Vorfahre des heutigen Regierungsstatthalters Herbert Volken leitete 1678 das Gelübde seiner Gemeinde an die nächste kirchliche Instanz weiter, den Bischof von Sitten. Von dort aus gelangte es an den Nuntius der römisch-katholischen Kirche der Schweiz in Bern, der es dem Vatikan zur Absegnung unterbreitete. Papst Innozenz segnete das Gelübde ab

[6] Berühmt und zugleich berüchtigt ist seit über 400 Jahren zum Beispiel der Vernagtferner in den Ötztaler Alpen. Aus einem Seitental ist der Gletscher in den Jahren 1600, 1676, 1678, 1771, 1772 und dann wieder 1845 und 1848 in das Rofental vorgestoßen und hat, mit dem Guslarferner vereinigt, hinter der Zwerchwand eine Eismauer gebildet, weit über 100 Meter hoch. Dahinter wurde ein See gestaut, der ca. 1300 Meter lang war. Dieser See ist mehrmals durch die teilweise poröse Eismauer durchgebrochen und hat im ganzen Ötztal große Schäden angerichtet. Die Wassermassen von geschätzten 1 ½ bis 3 Millionen Kubikmeter sind dann binnen einer Stunde oder eineinhalb Stunden ausgebrochen. Der einem Dammbruch vergleichbare Durchbruch war bis dato keine menschlichen Eingriffe und technischen Maßnahmen verhinderbar.

Daß der durch den Vernagtferner hinter Rofen gestaute See im Jahre 1678 ausgebrochen ist und große Schäden durch das ganze Ötztal hinaus, ja bis ins mehr als 120 km entfernte Innsbruck angerichtet hat, wird nach der Überlieferung und – inzwischen aktenkundig gemacht – einem herumziehenden „Malefiz- Buben“, einem „Wettermacher“ zugeschrieben. Es ist dies der namentlich bekannte Thomann Jöchl aus dem Zillertal, der in Meran bei einem Prozeß im Jahre 1679 mit 12 anderen Angeklagten verurteilt und hingerichtet wurde. Dieser „Hexenmeister“ habe auch den Ausbruch des Fischbaches im Jahre 1678 in Längenfeld verursacht. Der Pflegsverwalter von Petersberg tritt als Zeuge auf und meldet, „daß ein gottloser pue anno 1678 durch das etzthal gehend, von vorgedachten Valtin Kuprian zu Prugg, allwo er übernachtet, nicht nach verlangen traktiert worden, durch zauberei und des teifels hilf den ferner den ausbruch und in lengenfelder thal ein wetter gemacht“.

Örtliche Chronisten wie Johann und Benedikt Kuen sowie Franz Stippler berichten von bescheidenen „Maßnahmen“ der Bevölkerung und der Verwaltung.

„Aus gnädiger Lizenz Ihro fürstlichen Gnaden Herrn Paulin Bischof zu Brixen, ist von drei Priestern und Curaten im Özthal auf dem obersten Berg des Ferner- Anfangs, dann auch zuunterst auf dem Eis als auf einer Ring Mauren das Hl. Meßopfer samt einer eifrigen Predigt in Gegenwart der Procession von 2 Communitaten als Lengenfeld und Sölden verrichtet worden, worbey sich sehr viele Personen von den äußeren Kirchspielen eifrig und andächtig eingefunden. Es sind auch zwei ehrwürdige Herrn Capuciner von Imst etliche Wochen lang zu Vent verblieben, welche täglich das Hl. Meßopfer um dieser Gefahr Abwendung verrichtet, item sind zu unterschiedlichen Orten andächtige Kreuzzüge angeordnet, auch insonderheit durch die kleinen Kinder gehalten worden…“.

Und heute (Zitat, leider ist mir der Verfasser nicht mehr bekannt):

In unserer Zeit werden nun von angeblichen Klimaforschern die Werte menschlichen Denkens und Empfindens ins Gegenteil verkehrt. Statt dankbar zu sein, wollen die Katastrophentrommler jetzt für mehr Kälte und Gletscherschäden sorgen. Wieso soll denn eine zähflüssige Eis-Lava wünschenswerter sein als blühende Alpenwiesen? Die Bewohner früherer Tage würden sagen: „Gott hat unsere Gebete gehört, wir haben es jetzt besser.“

Die Fotos aus den Tälern beweisen: Die Gletscherschmelze hinterlässt wieder blühende Landschaften. Die Anzahl der wild lebenden Tiere, z.B. Murmeltiere, Vögel, in den Alpen nimmt zu und nicht ab, genauso die Vegetation und die Vielfalt der Pflanzen.

Fazit: Kälte ist lebensfeindlich, Wärme ist lebensfreundlich. Das warme Mittelalter wäre der wünschenswerte Klimazustand und nicht die kleine Eiszeit. Doch leider gehen die Temperaturen seit 10 Jahren wieder zurück, das Poleis nimmt zu. Die kurze, 20jährige Wärmeperiode von 1980 bis zur Jahrtausendwende scheint vorbei zu sein.

Wie wird der Gletscherrückgang aktuell dargestellt

Wieder Zitate aus der Publikation des bayerischen Staatsministeriums für Umwelt und Gesundheit.

[9] Gletscher sind aber auch Mahnmale des Klimawandels. Sie reagieren in beispiellosem Tempo auf die Veränderung des globalen Klimasystems, das durch die Emission von Treibhausgasen aufgrund menschlicher Aktivitäten zunehmend erwärmt wird. Überall auf der Erde schmelzen Gletscher ab und ziehen sich in größere Höhen zurück. Der Klimawandel ist eine der größten Bedrohungen der Alpen und ihrer Gletscher.

Unsere Gletscher sind markante Zeichen der Bayerischen Alpen, insbesondere der Berchtesgadener Alpen und des Wettersteingebirges. Sie tragen zur Attraktivität der Gebiete bei. Helfen Sie mit, damit auch die nachfolgenden Generationen die Schönheit der Alpen bewundern und genießen können!

[9] Gletscherrückgang – eine dramatische Folgereaktion des Klimawandels in den Alpen

Sowohl Ausmaß und Geschwindigkeit der globalen Erderwärmung als auch die vom Menschen emittierten Treibhausgase als wesentliche Ursache des Klimawandels sind unbestritten.

Die wichtigsten Ursachen des Gletscherrückgangs:

● Frühlings- und Sommermonate mit intensiver Sonneneinstrahlung

● wenig Schneezuwachs im Winter (Massenumsatz)

● erhöhte Lufttemperaturen

● sommerliche Regenereignisse bis in große Höhen

…. sich seit etwa 1980 die Gletscherflächen in Bayern aufgrund des Klimawandels dramatisch verringert haben. Der südliche Schneeferner verlor 84 % seiner Fläche. Der nördliche Schneeferner (-32 %) und der Höllentalferner (-18 %) mussten dagegen moderate Flächenverluste hinnehmen;

● seit etwa 2000 der Flächenverlust aller bayerischen Gletscher eine rapide, klimabedingte Beschleunigung erfahren hat, der einzig der Höllentalferner aufgrund seiner Muldenlage noch widerstehen kann.

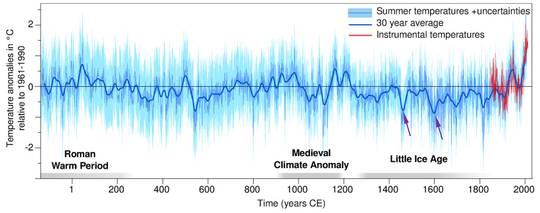

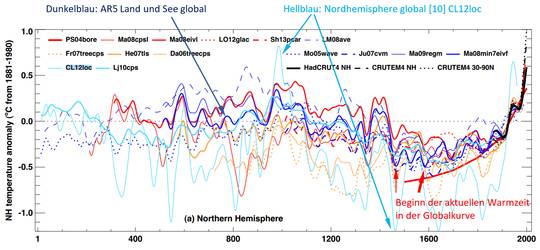

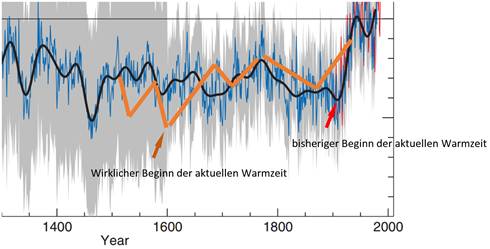

Sieht man sich die im vorhergehenden Kapitel gezeigten Bilder 5 und 6 mit den Temperaturverläufen an, so stellt man fest, dass das mit dem „Menschengemacht“ bei den Gletschern stark angezweifelt werden darf. Auch dass die Gletscher sich erst seit 1980 vom Menschen verursacht verringern, will einem nicht unbedingt einleuchten. Schließlich verringern sie sich definitiv bereits vereinzelt seit 1820 [12] und in Summe spätestens seit 1860. Auch fordert die Klimawandeltheorie, dass die Winter mehr Niederschläge bekommen und die Sommer weniger (IPCC 2007 und[13]). Genau wegen des umgekehrten Wetterverhaltens sollen die Gletscher aber schrumpfen[9]. Und dass die Sommer entgegen allen Verlautbarungen nicht heißer geworden sind, zeigen sowohl die DWD-Daten der Zugspitzstation, Publizierung [15] für den Alpenraum als auch global die folgende Grafik aus [10]:

Bild 7: Verlauf der Sommertemperaturen von 1751 bis ca. 2000[10]

Wie verliefen das Klima und die Gletscherstände früher. Hat es solche Schwunde und Temperaturschwankungen wirklich noch nie gegeben?

Auf EIKE kamen dazu schon Blogartikel [18] [7].

In [7] machte Professor Dr. Gernot Patzelt vom Institut für Hochgebirgsforschung der Universität Innsbruck zentrale Aussagen:

[7]:Die gegenwärtige Gletscher-und Klimaentwicklung zeigt keine Verhältnisse, die es in der Vergangenheit ohne menschlichen Einfluss nicht schon mehrfach und lange andauernd gegeben hat. Der gegenwärtige Rückgang der Alpengletscher kann nicht als Bestätigung für die Hypothese eines anthropogen verursachten Klimawandels dienen.

Gletscherschwundperioden dieser Art gab es in der Vergangenheit mehrfach und auch in deutlich stärkerem Ausmaß. Die Rekonstruktion der Gletscherentwicklung erlaubt die Aussage, dass in rund 65 % der letzten 10.000 Jahre die Gletscher kleiner waren und die Sommertemperaturen daher so hoch oder höher lagen als heute.

Bild 8: [7] Standort und Wachstumsperioden von Waldbäumen, die durch den gegenwärtigen Rückgang des Gepatschferners – des zweitgrößten Gletschers der österreichischen Alpen – eisfrei geworden sind.

Dazu Bilder aus [18] mit der Darstellung, wie der Steinlimigletscher (Kanton Bern, Schweiz) zur Römerzeit vor 2000 Jahren und um 1993 aussah.

Bild 9: [18] Der Steinlimigletscher (Schweiz) zur Römerzeit

Bild 10: [18] Der Steinlimigletscher (Schweiz) 1993 mit den Ausbreitungslinien von 1856 (obere) und 1913 (untere)

Und wer es immer noch nicht glauben will dass die Alpen in historischer Zeit weitgehend gletscherfrei waren kann es immer neu an der Pasterze (Großglockner) erleben. Im Juni 2015 wurden zwei Teile eines insgesamt 7,9 m langen Baumstammes aus der Seitenmoräne über dem heutigen Gletscherende geborgen[19].

[19] Damit ist belegt, dass dass in den Bereichen wo heute Eis, Schutt, Sand und Wasser regieren, vor 9.000 und auch zwischen 7.000 und 3.500 Jahren teils hochstämmige, alte Zirben wachsen konnten – eine unglaubliche Vorstellung!

Seit Beginn der Nacheiszeit vor etwa 11.500 Jahren war die Pasterze nie größer als beim letzten Hochstand von 1852 bis 1856, jedoch schon öfters deutlich kleiner als heute.

Bild 11: Aufnahme einer Stammhälfte mit Blick von der Fundstelle auf den Gletscher

„Pasterze“ heißt in der damaligen Sprache so viel wie „Weideland“. Also erlebten Menschen noch, dass im Bereich des heutigen Gletscherursprungs der Gletscher nicht nur fehlte, sondern die Umgegend sogar fürs Vieh genutzt werden konnte (und wie aktuell belegt, sogar Hochstammbäume wuchsen).

Eine Rekonstruktion der Baumgrenzen in den Alpen sieht wie folgt aus:

Bild 12: [15] Die höhenmäßige Verteilung von dendrochronologisch bzw. 14C-datierten Holzproben aus dem inneren Kaunertal, Westtirol, für den Zeitraum der letzten 9000 Jahre. Die Balken belegen jeweils einzelne Proben bzw.

Gruppen von Proben mit gleicher Standorthöhe, die Balkenlänge zeigt die zeitliche Erstreckung der Jahrringserie einer Einzelprobe bzw. einer Standortmittelkurve an (Nicolussi et al. 2005, ergänzt).

Der Rückzug der Gletscher seit Beginn des Gletscherschwundes um ca. 1850

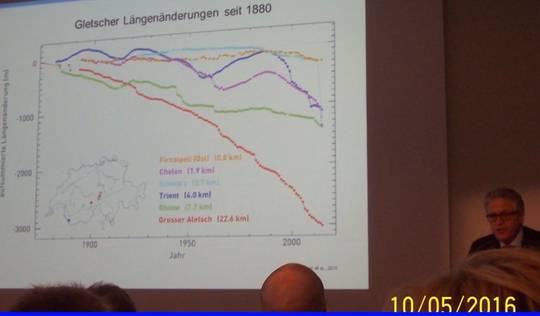

In den folgenden Bildern ist erkennbar, dass die Gletscher vom Beginn des Rückzugs an relativ konstant schrumpfen. Eine Beschleunigung aufgrund immer höheren CO2-Atmosphärenanteils sieht man nicht wirklich.

Bild 13: [14]

Bild 14: [15] Verlauf der Gletscherrückzuge in den Alpen seit 1890

Fazit

Bild 13 und 14 zeigen, dass der Gletscherschwund von Beginn an relativ stetig verläuft. Dass er wie in Bild 13 inzwischen zunimmt, liegt einmal an der Erfassungsmethodik und natürlich auch daran, dass mit geringerem

Volumen / Fläche eine Beschleunigung eintreten muss. Bild 14, welches ein größeres Gletscher-Ensemble betrachtet zeigt, dass es hohe Schwankungen gibt und die Darstellung, bis 1980 war alle Gletscherschmelze natürlich und danach menschengemacht, angezweifelt werden kann.

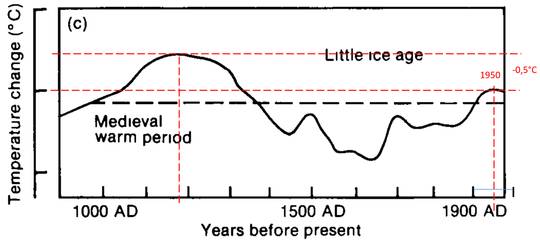

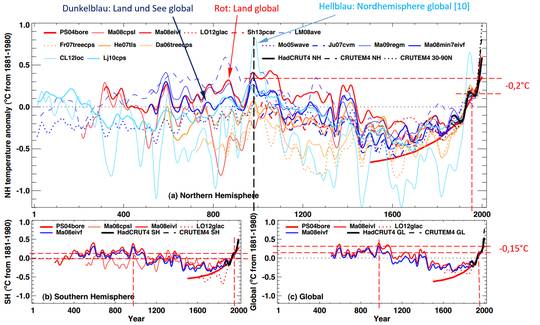

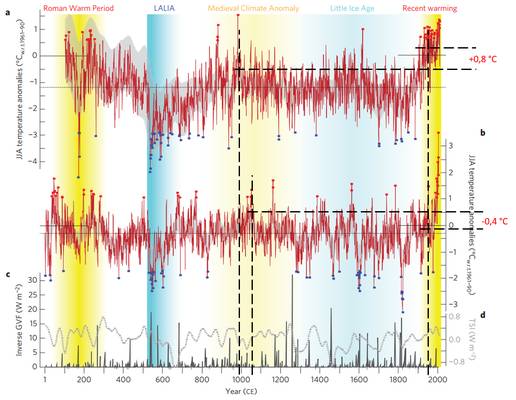

Die Klimarekonstruktion der Alpen

Wie sie aussieht, hängt davon ab, welcher „Klima- Glaubensrichtung“ der / die jeweiligen Verfasser angehören.

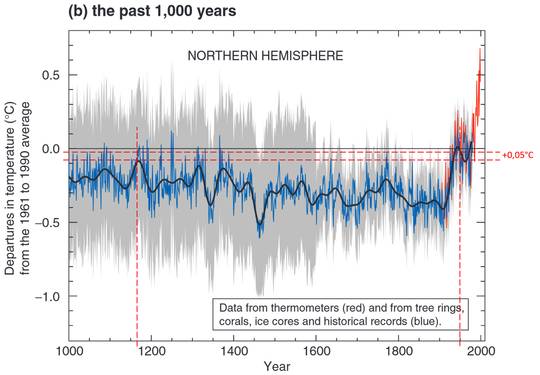

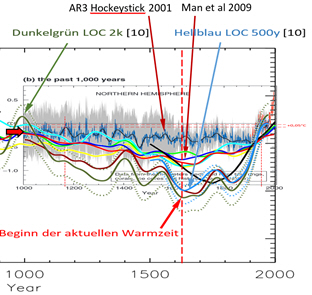

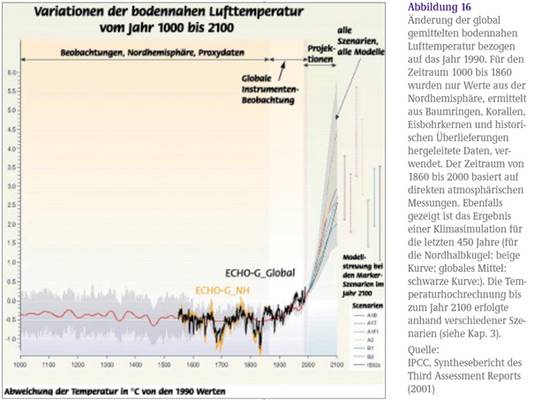

Zuerst ein Bild aus [13]: Variation der globalen Jahresmitteltemperatur von 1000–2100. Quelle: IPCC (2001)

Bild15: Klimadarstellung nach IPCC

EIKE Lesern ist diese Kurve und die Problematik bekannt. Anderen zur Wiederholung ein Kommentar dazu:

[23] Die Klimarekonstruktionen des Weltklimarats (IPCC) beruhen maßgeblich auf den Untersuchungen von Baumringen. Zahlreiche Veröffentlichungen lassen jedoch vermuten, dass die Variabilität des Klimas im Winter deutlich höher ist als im Sommer. Da die Bäume im Winter ruhen, zeichnen sie diese Veränderungen nicht auf. Das führt dazu, dass die Prognosen des IPCC die natürliche Klimavariabilität unterschätzen.

Deshalb andere, realistische Darstellungen

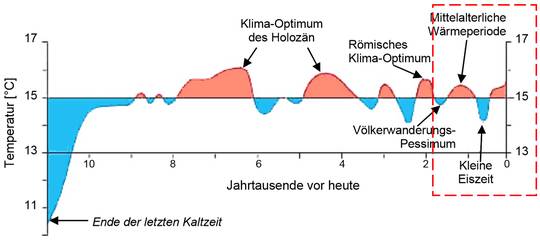

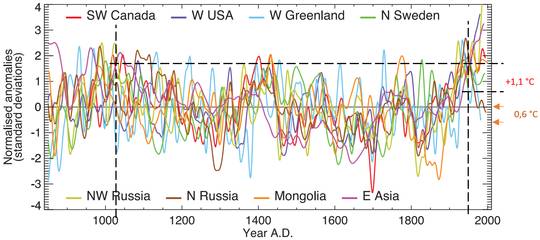

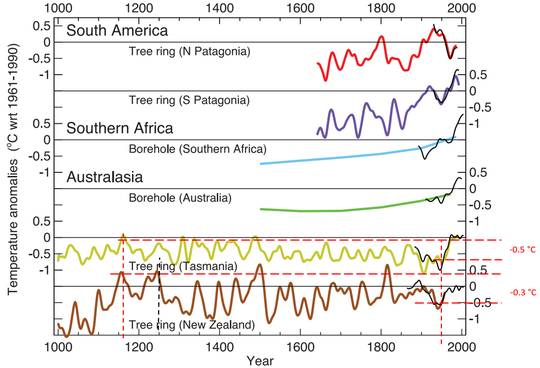

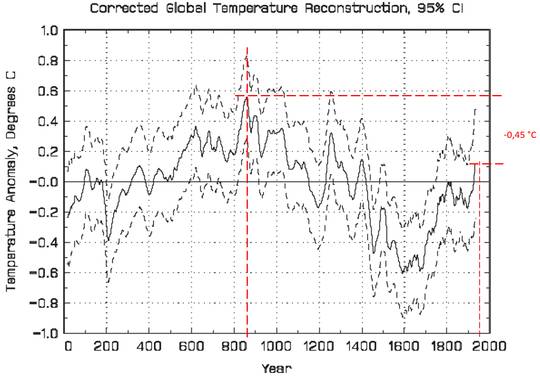

Es ist anzumerken, dass die Klimaverläufe des Holozän-Zeitalters(also bis vor ca. 10.000 Jahren je nach verwendeten Proxies und Autor weit voneinander abweichen. Damit wird aber auch deutlich, zu welch unterschliedlichen Ergebnissen eben verschiedene Methoden und Proxis führen und dass eine „Einheitskurve“ eine Illussion bleibt. Der Trend ist aber immer gleich: früher war es oft deutlich wärmer als heute und schnelle Klimaschwankungen gab es bereits früher regelmäßig. Unsere aktuelle Temperatur und die Beschleunigung ist damit überhaupt nicht zwingend „unnatürlich“ und einzigartig, wie es vom IPCC und dem Klima-Mainstream suggeriert wird.

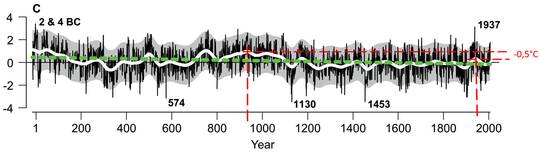

Zuerst der (mögliche) Verlauf des Nord-Europäischen Klimas aus [20]

Bild 16: Rekonstruierter Klimaverlauf Nordeuropas aus Baumdichtemessungen

Dazu steht als Erklärung:

[20] Vulkanausbrüche, Effekte der Landnutzung und Veränderungen der Treibhauskonzentrationen in der Atmosphäre scheinen jedoch im Vergleich zur Sonneneinstrahlung einen geringeren, eher kurzfristigen Effekt auf die Klimaabkühlung zu haben. Sie lassen sich in den Rekonstruktionen der sehr langfristigen Temperaturtrends kaum abbilden.

Bisherige Klimarekonstruktionen unterschätzten diesen Einfluss der natürlichen Klimavariabilität. Nach den Messungen der Wissenschaftler ist der Kühlungs-Effekt – über die letzten 2000 gerechnet – etwa viermal so groß wie die Auswirkungen des anthropogenen Klimawandels seit 1750. Dabei gibt es jedoch erhebliche Schwankungen je nach Zeitraum, Region und Jahreszeit.

Großräumige Klimamodelle, die z.B. auch der internationale Klimarat IPCC verwendet, scheinen diesen natürlichen Abkühlungseffekt bisher zu wenig berücksichtigt, so die Forscher.

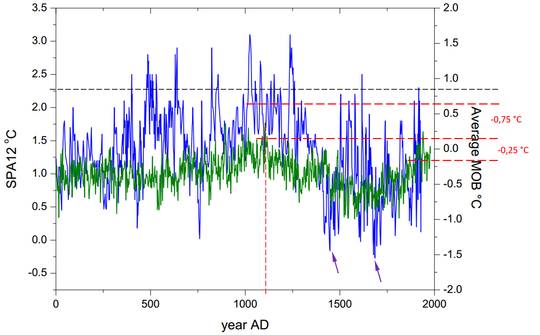

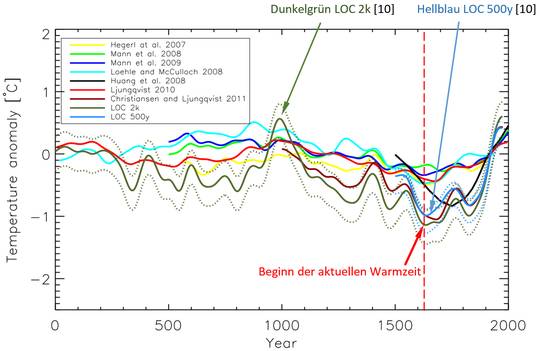

Nun die Klimarekonstruktion (COMNISPA-Kurve) der Uni Heidelberg [21] [22] aus Tropfstein-Isotopenuntersuchungen. Diese Klimarekonstruktion wird selbst nicht angezweifelt, Es wird aber behauptet, sie gelte nur für Europa und gegenüber den „Hockeystickkurve“ nicht global. Da sie aber vorwiegend aus Tropfsteinen von Alpenhöhlen rekonstruiert ist, muss sie den Klimaverlauf der Alpen auf jeden Fall richtig wiedergeben. Deutlich sind die extremen Klimaschwankungen in der Vergangenheit, welche die aktuelle vollkommen relativieren.

Das folgende Bild zeigt den relativen Temperaturverlauf des Holozän für Europa aus Tropfstein-Rekonstruktionen (schwarzer Verlauf). Bildtext: Rekonstruktion des Klimas: Die Auswertung der Proben aus drei hochalpinen Stalagmiten und der Vergleich mit Holz- und Torffunden aus Schweizer Gletschern erlauben es, eine Klimakurve für die letzten 9000 Jahre zu erstellen.

Bild 17: COMNISPA-Kurve[21]

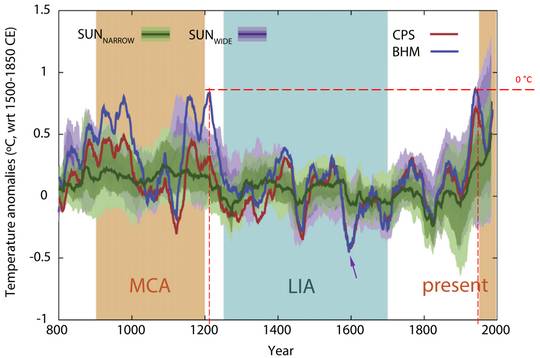

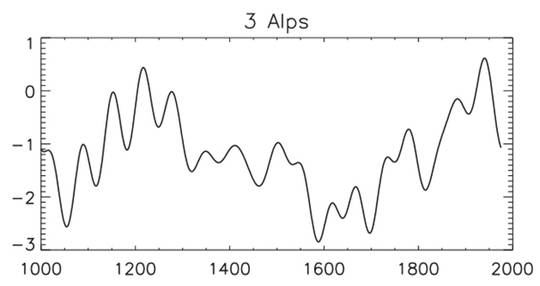

Und zuletzt eine Rekonstruktion aus [16]

Bild 18: [16] Schwankungen der mittleren Sommertemperaturen im Holozän bis heute.

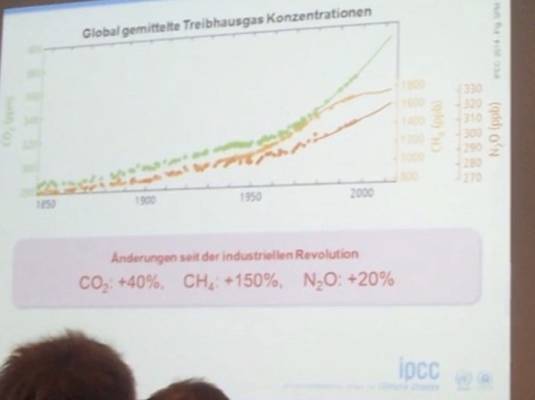

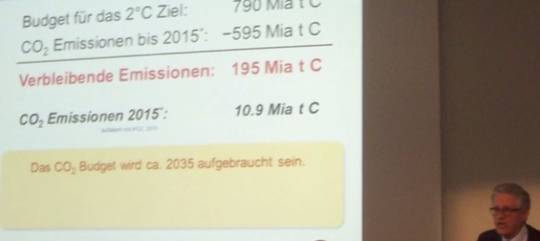

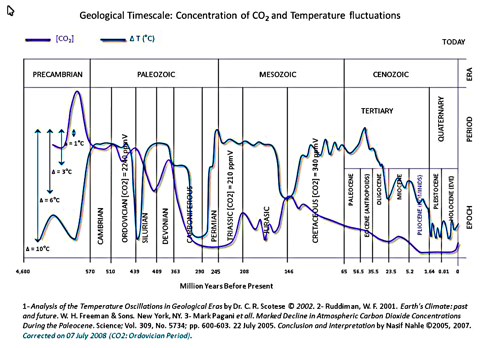

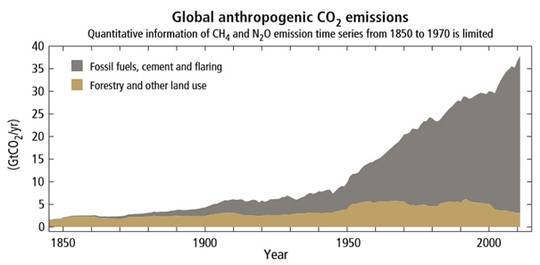

Dazu der Verlauf von Klima und CO2 aus [24], sowie der Text der Einleitung daraus:

[24] Klima zeichnet sich immer durch Wandel aus und die heutige Klimaänderung ist verglichen mit denen der Vergangenheit in ihrem Ausmaß noch sehr moderat und nicht ungewöhnlich.

Kohlendioxid war und ist ein wichtiges Treibhausgas, aber es war nicht allentscheidend für die Klimawandel der Vergangenheit. Die bisherigen Untersuchungen liefern Argumente dafür, dass die Sonne einen deutlichen lenkenden Einfluss auf das Klima ausgeübt hat. Auch wenn die menschliche Gesellschaft durch Emissionsminderung nicht korrigierend auf klimatische Veränderungen einwirken kann – dies zeigen Modellrechnungen sehr deutlich – so ist Ressourcenschutz, vernünftiges Verhalten und nachhaltiges Wirtschaften keineswegs überflüssig, da unsere fossilen Energieträger endlich sind.

Die bisherigen Untersuchungen liefern also viele Argumente dafür, dass die atmosphärischen Treibhausgase in den vergangenen 1000 Jahren nicht die Auslöser und Hauptfaktoren von dokumentierten und rekonstruierten Klimaänderungen gewesen sein können, sondern dass die Sonne einen deutlichen lenkenden Einfluss auf das Klima ausgeübt hat. Kohlendioxid war und ist ein wichtiges Treibhausgas, aber es war nicht allentscheidend für die Klimawandel der Vergangenheit.

Bild 19: [24]

Im Bild 19 ist der CO2-Verlauf „IPCC-gerecht“ eingetragen. Damit ein unbedarfter Leser aber nicht denkt, der historische Verlauf und Messung des CO2 sei unumstritten, anbei eine andere Rekonstruktion. Die rote Kurve sind Werte historischer Originalmessungen und die graue Linie Eisbohrkern-Rekonstruktionen. Man ahnt es. Die graue Linie gilt als „wahr“ und die historischen Messkurven wurden vom IPCC als falsch „verworfen“. Bilddetails und ausführliche Darlegungen dazu kann man in [28] nachlesen. Anbei nur ein Zentralkommentar daraus:

[28]. Wegen vermeintlich fehlender Meßdaten vor 1958 wurde die Keelingkurve mit CO2-Rekonstruktionsdaten aus Eisbohrkernen kombiniert, so daß sich eine Art exponentielle Kurve der CO2-Konzentration der Welt ergab. Diese Kurve ist die Grundlage aller Berichte des Weltklimarates 1990, 1995, 2001 und 2007.

Bild 20: [28]

Fazit

Praktisch allen nicht „IPCC-gerechten“ Klimarekonstruktionen ist gemeinsam:

● dass es früher sehr wohl wärmere Zeiten als aktuell gegeben hat,

● schnelle Klimaschwankungen auch früher in teilweise extremerem Ausmaß und Geschwindigkeit stattfanden,

● das Klima ausgeprägte Zyklen aufweist,

● der aktuelle Verlauf überhaupt nicht „unnatürlich“ sein muss

● CO2 auf den Klimaverlauf – wenn überhaupt – einen relativ geringen Einfluss hat

● Zusätzlich: Der wirkliche CO2-Verlauf vor Beginn der Mauna Loa-Messungen strittig ist

Damit man sieht, wie viel mehr Angst wir davor haben sollten, in eine neue Eiszeit zu schlittern, anbei eine Rekonstruktion dazu.

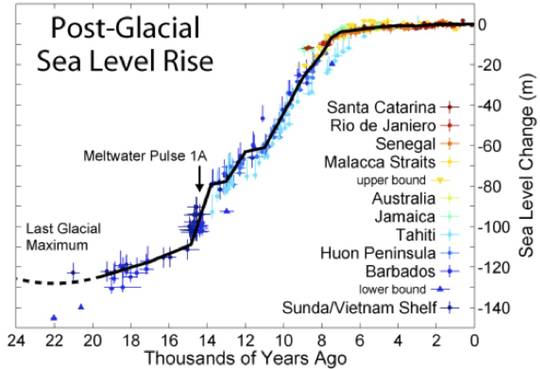

Bild 21: [21] Eiszeit-Zyklen

Abschluss-Statement

Der Verfasser hofft, mit diesem Blogartikel etwas über die Problematik der anthropogenen CO2-Klimawandeltheorie am Beispiel der Gletscherschmelze informiert zu haben. Jeder kann sich darauf aufbauend selbst Gedanken machen, ob die Dogmen der Ökokirche genügend stichhaltig sind, dass es sich lohnt, nur zur CO2-Reduzierung Billiarden EUROs auszugeben.

Im Mittelalter haben die Ausgaben (an die Kirche) zur Bannung des Klimas den damaligen Menschen gar nichts genutzt, aber wenigstens Kunstwerke übriggelassen die man noch heute bestaunt. Die heutigen Ausgaben zur Bannung des Klimas durch CO2-Reduzierung könnten ähnlich sinnlos verlaufen. Ob man die dazu errichteten EEG-Energiekunstwerke dereinst aber bestaunen wird?

Dazu eine Bildfolge zum Nachdenken. Die Windkraftbilder stammen alle von [29]. Dort lässt sich eine ganze Präsentation laden und ein Link zu einem entsprechenden youtube-Film.

Bild 22: Menschenfeindliche, aber von Touristen „geforderte“ Landschaft

Bild 23: Gleiche, aber menschen- und naturfreundliche Landschaft, die angeblich keine Touristen mehr „anzieht“

Man stelle sich nun vor, zur Römerzeit vor dieser grünen Berg-Weidelandschaft zu stehen und ein Priester sagt:

„Weil die Menschen nicht ausreichend dem Gott Jupiter geopfert haben, wird er zur Strafe diese blühende Landschaft in eine zerstörerische und lebensfeindliche Gletscher-und Steinwüste verwandeln“.

So kommt es und 2.000 Jahre später dichtet dann jemand dazu (Bild 22): „Orte der Schönheit und der Magie, der Beständigkeit und des Wandels zugleich. Diese Werke der Schöpfung und Evolution gilt es zu bewahren und zu schützen“. Ergänzt mit der Behauptung, die Landschaft wie sie zur Römerzeit war kann man künftigen Generationen nicht zumuten.

Oder zeigen Sie einem BUND-Aktivisten Bild 23 und sagen: Diese freundliche Landschaft haben wir schon überall und wirkt einfach nur langweilig. Unseren Event-Touristen müssen wir aber etwas Besonderes bieten wie Sommer- Schilaufen und Eisklettern. Deshalb werden wir die Almen vereisen, unwirtlich machen und verschottern, wie es das Planungsbild 22 zeigt. Wir bitten dazu um Zustimmung.

Was nun folgt sind EEG-Klimarettungs-Kunstwerke und CO2-neutrale Landschaften

Dafür, dass man in Zukunft nur noch unter solchen EEG-Alleen wandert, werden uns unsere Enkel laut offizieller Klimalehre bestaunen und für den bald ganz Deutschland umfassenden, nachhaltigen Klima-Kulturlandschaftsumbau loben.

Sind wir nicht irgendwie verrückt geworden?

Zu den folgenden Bildern: Die Bilder mit Windrädern sind original. Bei den „vorher“-Ansichten wurden die Windräder wegretuschiert!

Bild 24: Naturnahe Landschaft vorher

Bild 25: Gleiche Landschaft zum Kampf gegen den Klimawandel hochgerüstet

Bild 26: Naturnahe Landschaft vorher

Bild 27: Gleiche Landschaft zum Kampf gegen den Klimawandel hochgerüstet

Bild 28: Naturnahe Landschaft vorher

Bild 29: Gleiche Landschaft zum Kampf gegen den Klimawandel hochgerüstet

Bild 30: Naturnahe Landschaft vorher

Bild 31: Gleiche Landschaft zum Kampf gegen den Klimawandel hochgerüstet

Quellen

[1] 07.07.15 Artikel: Hendricks inspiziert den Gipfel des Klimawandels

http://www.welt.de/politik/deutschland/article143706476/Hendricks-inspiziert-den-Gipfel-des-Klimawandels.html

[2] Aus dem entsprechenden Artikel in „meiner“ Lokalzeitung.

[3] Umweltbundesamt: Klimamonitoringbericht 2015

[4] Hanspeter Holzhauser . Ein Gelübde im Wandel der Zeit.

http://www.myswissalps.ch/story/615

[5] Hanspeter Holzhauser . Als man barhaupt den Grossen Aletschgletscher bannen wollte.

http://www.myswissalps.ch/story/615

[6] Hans Haid, Sölden. Über Gletscherbannungen, Bittgänge, scharfe Gelübde, Kinderprozessionen zum Ferner usw.

alpine space – man & environment, vol. 4: Ist es der Sindtfluss?

[7] EIKE 07.01.2010: Klimawandel und die Gletscher in den österreichischen Alpen als Zeitzeugen!

[8] DIE WELT 15.02.08: Klimaerwärmung verlängert das Leben. Eine Studie der britischen Regierung zieht positive Bilanz der sonnigeren letzten drei Jahrzehnte.

http://www.welt.de/wissenschaft/article1677009/Klimaerwaermung-verlaengert-das-Leben.html

[9] Bayerisches Staatsministerium für Umwelt und Gesundheit: Bayerische Gletscher im Klimawandel – ein Statusbericht

[10] A. Hoy: Veränderung langjähriger Temperaturreihen in Mitteleuropa und weltweit.

[11] Klaus-Eckart Puls und Sebastian Lüning 17. März 2013: Alles nur Schall und Rauch? Der Wasserdampf-Verstärker als Achillesferse in der Klimamodellierung

[12] E. Richter (Graz):Geschichte der Schwankungen der Alpengletscher.

[13] M. Zemp et al. Jahrbuch Oekologie08_2007: Europäische Alpen bald ohne Gletscher?

[14] Bayerische Akademie der Wissenschaften. Markus Weber: Der „Magersucht“ eines Alpengletschers auf der Spur.

[15] alpine_space_vol6. Roland Psenner at al: Klimawandel in Österreich. Die letzten 20.000Jahren …und ein Blick voraus

[16] Wissenschaftliche Mitteilungen aus dem Nationalpark Hohe Tauern Bd. 4 (1998): 225-240 Heinz Slupetzky et al: Hinweise auf kleinere Gletscherstände der Pasterze

[17] Uba Juli 2015: Klimawandel könnte künftig mehr Hitzetote fordern. Hitzewellen erhöhen das Sterblichkeitsrisiko von Herzkranken um bis zu 15 Prozent. Das ergab eine Studie des Deutschen Wetterdienstes (DWD) für das Umweltbundesamt (UBA). http://www.dwd.de/klimawandel

[18] EIKE 30.07.2012: Die Römer kannten keine Gletscher – Studie zur Klimaerwärmung. Die Erde hat sich in den letzten 2000 Jahren abgekühlt – Studie widerlegt gängige Meinung zur Klimaerwärmung.

[19] 24.06.2015. Pasterze gibt nach tausenden von Jahren einen meterlangen Baumstamm frei.

Nationalpark Hohe Tauern und Österreichischer Alpenverein bergen mit fachlicher Unterstützung der Universität Graz einen sensationellen Gletscherfund am Fuße des Großglockners und machen ihn für wissenschaftliche Untersuchungen und in Folge für die Öffentlichkeit zugänglich.

In einer spektakulären Bergung konnte die – in zwei Teile zerbrochene – Zirbe am 24. Juni 2015 mit Hilfe eines Hubschraubers erfolgreich aus dem Gletschervorfeld der Pasterze geborgen werden. Beide Teile zusammen haben insgesamt eine Länge von 7,9 m und das stattliche Gewicht von 1.700 kg.

http://www.hohetauern.at/de/aktuelles/8-aktuelles/2575-pasterze-gibt-nach-tausenden-von-jahren-einen-meterlangen-baumstamm-frei.html

[20] Jan Esper et. al (2012): Orbital forcing of tree-ring data. Nature Climate Change, 8.7.2012, doi:10.1038/nclimate1589

Kurzbeschreibung dazu bei Redaktion Pflanzenforschung.de unter: Fossile Kiefern als Klimazeugen http://www.pflanzenforschung.de/index.php?cID=5454

[21] Uni Heidelberg, Anne Wackerbarth 25.01.2007. Präsentations-Foliensatz „Das Klima des Holozäns“

[22] EIKE 10.04.2009. Die unterschlagene historische COMNISPA-Temperaturkurve!

[23] Uni Heidelberg. Nicole Vollweiler und Augusto Mangini Blättern im Buch der Klimageschichte. Stalagmiten zeugen vom Klima der letzten Jahrtausende http://www.uni-heidelberg.de/presse/ruca/ruca07-3/klima.html

[24] Dr. U. Berner et al, Hannover: Klimawandel und CO2 aus geowissenschaftlicher Sicht

[25] 12.3.2015 beim Besuch einer Schule:

http://www.nwzonline.de/politik/die-unschuldigen-sind-die-leidtragenden_a_25,0,413070643.html

[26] Bayerisches Umweltministerium 12. April 2015. Scharf: 2015 wird Jahr des Klimas / Bayern soll klimasicher werden

[27] EIKE Blogartikel: In Deutschland kein Klimawandel in Sicht – das kann die SZ nicht auf sich sitzen lassen

[28] Energy & Environment Volume 19 No. 7 2008. Ernst-Georg Beck 2008: 50 Jahre kontinuierliche CO2- Messung auf Mauna Loa

[29] http://www.rtf-radmarathon.de/VB/pages/landschaftszerstoerung.php

[30] The European 01.06.2015. Barbara Hendricks vs. Björn Lomborg http://www.theeuropean.de/thilo-spahl/10196-streit-um-kosten-und-nutzen-deutscher-klimapolitik

[31] Bayerisches Staatsministerium für Umwelt und Verbraucherschutz. Rubrik: Klimaforschung in Bayern:

Der vom Menschen verursachte Klimawandel ist wahrscheinlich die größte Herausforderung der Menschheit. Wissenschaftler rechnen bei einem "weiter-so-wie-bisher" mit der Gefahr, dass bis 2100 ein Anstieg von 3 bis 5 Grad im Sommer und 4 bis 6 Grad im Winter in den Alpen erreicht wird. Dies hätte dramatische Auswirkungen auf das einzigartige alpine Ökosystem und seine Leistungen als Wasserspeicher, Erholungsraum und Lebensraum.

http://www.stmuv.bayern.de/umwelt/klimaschutz/forschung/index.htm

Auswirkungen des Klimawandels auf die Wirtschaft

An dem Projekt nahmen insgesamt sieben bayerische Unternehmen teil.

Die Fallstudien zeigen, dass sich für Klimaanpassungsstrategien zentrale Handlungsfelder herauskristallisieren:

● Schutz der Beschäftigten vor Hitze und Sonneneinstrahlung. Maßnahmen des vorbeugenden Arbeitsschutzes, Klimatisierungen oder neue Arbeitszeitmodelle,

[32] Bayerisches Staatsministerium für Umwelt und Verbraucherschutz 04.05.2015: PRESSEMITTEILUNG Nr. 74/15

[33] Bayerisches Staatsministerium für Umwelt und Verbraucherschutz: Bayerische Klima-Anpassungsstrategie (BayKLAS)

[34] EIKE Blogartikel: Roy W. Spencer, Ph. D. 95% aller Klimamodelle stimmen überein: Die Beobachtungen/Messungen müssen falsch sein! http://www.eike-klima-energie.eu/news-cache/95-aller-klimamodelle-stimmen-ueberein-die-beobachtungenmessungen-muessen-falsch-sein/

[35] EIKE Blogbeitrag 21.7.14: Ruhestand im Süden kann Tödlich sein. Analyse der Uba und DWD Studie zur Mortalitätserhöhung durch Klimawandel. http://www.eike-klima-energie.eu/news-cache/ruhestand-im-sueden-kann-toedlich-sein-wetterdienst-glaubt-klimawandel-toetet-alte-menschen/

[36] EIKE 01.04.2014. Kein Aprilscherz- O-Ton Umweltministerin Hendricks: "Klimawandel findet täglich statt!" http://www.eike-klima-energie.eu/climategate-anzeige/kein-aprilscherz-o-ton-umweltministerin-hendricks-klimawandel-findet-taeglich-statt/