Statistik und Verfügbarkeit von Wind- und Solarenergie in Deutschland

Windkraft

Wetter ist ein zufälliges Phänomen – vor einem Ausflug ins Grüne kann die Wettervorhersage schon mal eine spannende Sendung sein. Wir sind diesem Zufall auch ausgeliefert – nicht umsonst können Ausflüge buchstäblich ins Wasser fallen. Und obwohl Wind und Wetter zufällig sind, hat jeder ein vernünftiges Gefühl dafür: Im Sommer kommen sonnige Tage öfter vor als etwa im Spätherbst. Mit windigem Wetter verhält es sich eher umgekehrt. Wie würden wir uns ein Bild davon machen, ob es an einem bestimmten Ort eher windiger oder weniger windig ist? Wir würden die Windintensität als Windgeschwindigkeit messen und dann die Tage oder Stunden auszählen, an denen die Windgeschwindigkeit z. B. zwischen 2 und 2,5m/s liegt. Das ganze würden wir in einem Diagramm auftragen – dieses Häufigkeitsdiagramm, auch Histogramm genannt, charakterisiert die Windigkeit an einem Ort. In diesem Diagramm kann man ablesen, wie sich die Windgeschwindigkeit im Verlaufe eines Zeitraums auf niedrige und hohe Windgeschwindigkeiten verteilt. Für diese Verteilung hat sich in der Szene der Begriff Windhöffigkeit eingebürgert.

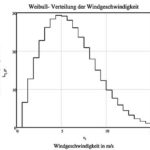

Diese Wind-Häufigkeitsdiagramme haben überwiegend eine ähnliche Struktur, gleichgültig wo man sie gemessen hat: Lediglich die durchschnittliche Geschwindigkeit und die Höhe der Histogramm – Linien verschiebt sich etwas. Bei großen Windgeschwindigkeiten verschieben sich die Linien zu höheren, bei kleinen Windgeschwindigkeiten zu niedrigeren Werten hin. Es ist allgemein anerkannt, dass der Wind nach einem ganz bestimmten Häufigkeitsschema verteilt ist, das nach dem schwedischen Mathematiker Weibull benannt ist. Man spricht daher von einer Weibull-Verteilung.

Abbildung 1: Weibull- Verteilung bei einer mittleren Windgeschwindigkeit von 5,75m/s

Bei einem Windrad erzeugt nun der Wind auf die Rotorflügel einen Druck, der den Rotor in Drehung versetzt. Diese Kraft auf den Rotor erzeugt im Generator den Strom, den ein Windrad ins Netz einspeist. Die Menge an produziertem Strom wird nach Kilowattstunden (kWh) bemessen – so wie im Privathaushalt die Strommenge nach kWh abgerechnet wird, wird auch die Stromproduktion so gemessen. Genaugenommen verbirgt sich hinter der Kilowattstundenzahl nicht die Strommenge, sondern der Gegenwert an Energie, den ein Windrad produziert. Wenn ein Windrad nun gemütlich vor sich hin trudelt, wird es einen längeren Zeitraum brauchen, um eine bestimmte Strommenge zu produzieren. Bei schwachem Wind (Windgeschwindigkeit 4 m/s) braucht ein 3000 kW Windrad ungefähr 20 Stunden, um den Jahresverbrauch eines Haushalts von 2500 kWh zu erzeugen. Bei starkem Wind (Windgeschwindigkeit 10 m/s) kann es die gleiche Strommenge in nur einer Stunde produzieren – das Windrad läuft mit weitaus höherer Anstrengung und leistet mehr. Der Grad der Anstrengung einer Maschine wird in der Fachsprache als deren Leistung bezeichnet. Die größte Leistung einer Maschine ist deren Nennleistung. Die Leistung wird in der Einheit kW gemessen- bei Autos hat sich bis heute die Angabe in PS gehalten. Die PS-Zahl ist beim Auto die Nennleistung des Motors.

Strom muss im Augenblick des Verbrauchs produziert werden- die Leistung der Stromquelle muss in jedem Augenblick mit der Leistung des Verbrauchers übereinstimmen. Aus diesem Grund ist für die Beurteilung der Verfügbarkeit die sogenannte momentane Leistung (kW) und nicht die Strommenge (physikalisch korrekter: die Arbeit, gemessen in kWh) für die Beurteilung maßgeblich.

Die Leistung (kW) eines Windrads steigt und fällt mit der Windgeschwindigkeit. Die im Windrad produzierte elektrische Leistung schwankt mit der Windgeschwindigkeit. Man würde salopp sagen, je höher die Windgeschwindigkeit ist, desto höher ist auch die Leistung des Windrads. Leider ist es nicht ganz so einfach, weil die Leistung sehr viel stärker anwächst als die Windgeschwindigkeit selbst: Wie man sagt, ist dieser Zusammenhang bei einem Windrad „kubisch“, d. h. die Leistung des Windrads ändert sich mit der 3. Potenz der Windgeschwindigkeit. Dieser Zusammenhang ist bekannt, seit man Ventilatoren, Propeller und Schiffsschrauben baut. Das bedeutet, dass sich die Leistung verachtfacht, wenn sich die Windgeschwindigkeit verdoppelt. Die Leistung eines Windrads reagiert also sehr empfindlich auf Änderungen der Windgeschwindigkeit. Das kann man auch daran ablesen, dass die Produktion der gleichen Strommenge mal fast einen ganzen Tag und bei günstigem Wind nur eine Stunde dauert. Bei einem Windrad mit einer Leistung von 3000 kW bedeutet das, dass die Leistung von 37 kW auf 480 kW anwächst, wenn sich die Windgeschwindigkeit von 3 m/s auf 6 m/s erhöht. Die genannten Zahlen stammen aus einem Datenblatt für eine Enercon 101- Windkraftanlage. Diese Leistungscharakteristik könnte für eine Stromversorgung ungünstiger nicht sein – schließlich ändert sich die Windgeschwindigkeit zufällig je nach Wetterlage. Eine kaum spürbare Erhöhung der Windgeschwindigkeit um 10% bewirkt eine Leistungserhöhung von 30%. Bei schwachem Wind trudelt ein Windrad eher gemütlich vor sich hin, bei starkem Wind läuft es zur Höchstleistung auf. Ein Auto mit zufälligen Zündaussetzern, das mit Vollgas gefahren wird, hat ein ähnliches Leistungsverhalten.

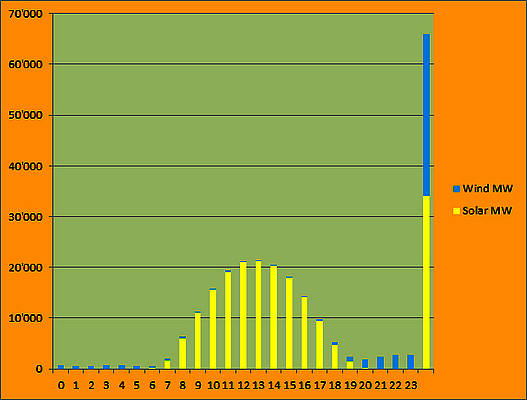

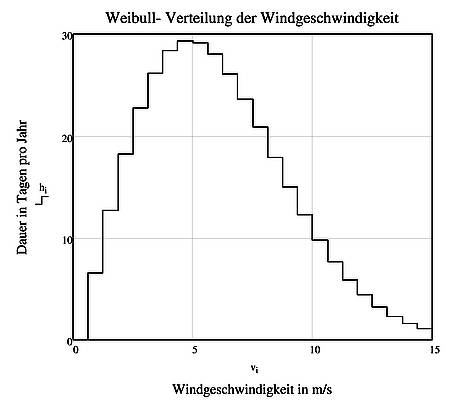

Abbildung 2: Häufigkeitsdiagramm eines 3000 kW- Windrads

Wenn man nun das Häufigkeitsdiagramm der Windgeschwindigkeit kennt, wie kommt man nun auf das Häufigkeitsdiagramm der eingespeisten Leistung? Hier hilft die Mathematik: Man kann das Häufigkeistdiagramm der Windgeschwindigkeit umrechnen auf das Häufigkeitsdiagramm der eingespeisten Leistung. Hier kommt man zunächst zu dem überraschenden Ergebnis, dass die Häufigkeit der eingespeisten Leistung einer gänzlichen anderen Gesetzmäßigkeit folgt als die Windgeschwindigkeit. Diese Tatsache ergibt sich aus der kubischen Abhängigkeit der Leistung von der Windgeschwindigkeit. Das Häufigkeitsdiagramm eines 3000 kW Windrads ist in Abbildung 2 dargestellt. Unschwer kann man erkennen, daß niedrige Leistungen sehr häufig und hohe Leistungen eher die Ausnahme sind. In dieser Abbildung kann man ablesen, dass die Leistung eines 3000 kW Windrads an 132 Tagen im Jahr (also mehr als 4 Monate) zwischen 0 und 145kW (das sind rund 5 % der Nennleistung) liegt. Die volle Leistung (hier 3000 kW) erreicht ein Windrad nur selten. Dass Windräder häufig still stehen, ist also kein subjektiver Eindruck, sondern eine mathematisch beweisbare und damit erwiesene Tatsache. In einer Propagandaschrift der Windlobby unter dem Titel ‚A bis Z- Fakten zur Windenergie‘ wird dieser Zusammenhang wie folgt umschrieben „Allerdings drehen sich die Rotoren nicht immer mit maximaler Leistung“.

Aus diesem Grund ist die weit verbreitete Behauptung der Windlobby unzutreffend, dass Windräder Haushalte mit Strom versorgen können – die Versorgungsaufgabe scheitert schon daran, dass Windräder keinen Strom liefern wenn, und das ist sehr häufig, der Wind nur mäßig weht und Leistung daher klein ist. Letztlich ist dies Folge aus der Weibull-Verteilung der Windgeschwindigkeit und dem (kubischen) Zusammenhang zwischen eingespeister Leistung und Windgeschwindigkeit.

Betrachtet man nun eine größere Fläche, in der eine große Anzahl von Windkraftanlagen verteilt ist, stellt sich die Frage, in welchem Umfang sich diese Windräder untereinander ergänzen können. Produzieren die einen Windräder Strom, wenn andere still stehen? Weht der Wind immer irgendwo? Ohne eine genaue statistische Analyse vorzunehmen, kann man sich dieser Frage vorläufig ganz anschaulich nähern: Hohe Windgeschwindigkeiten treten typischerweise bei Tiefdruckwetterlagen auf und die Größe des Tiefdruckgebiets bestimmt die Fläche, in der mit erhöhten Windgeschwindigkeiten zu rechnen ist. In der gesamten Fläche sind dann hohe eingespeiste Windleistungen zu erwarten. Die umgekehrte Aussage gilt in der gleichen Weise: Bei geringen Windgeschwindigkeiten sind die Windleistungen in der gesamten Fläche niedrig. In beiden Fällen können sich Windräder in dieser Fläche nicht untereinander ergänzen. Bei Hochdruckwetterlagen können diese Flächen schon mal so groß wie ganz Deutschland sein. Mittlere Tiefdruckgebiete haben praktisch immer die Größe von mindestens mehreren Bundesländern, normale Tiefdruckgebiete überdecken fast immer ganz Deutschland.

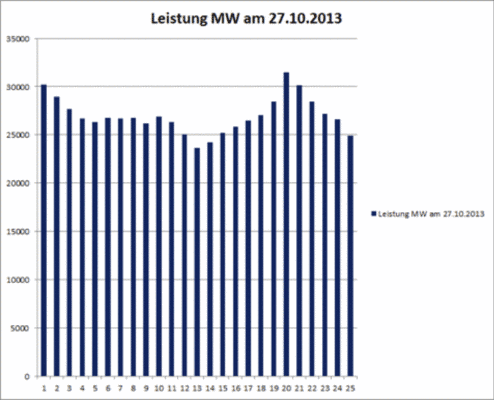

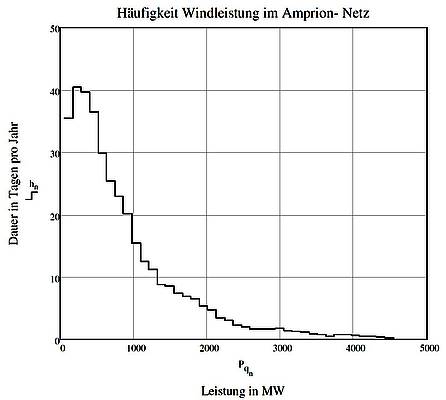

Abbildung 3: Häufigkeitsdiagramm der Windleistung im Amprion- Netz

Wenn man nun das Häufigkeitsdiagramm der eingespeisten Windleistung in einem kleineren Gebiet, wie etwa das vom Netzbetreiber Amprion, erstellt, findet man diese Überlegungen bestätigt:

Auch in einem Gebiet von der Größe des Amprion-Netzes ergänzen sich Windräder untereinander nicht. Das Häufigkeitsdiagramm zeigt noch immer den fallenden Verlauf: Niedrige Leistungen bis zum Stillstand sind besonders häufig, große Leistungen sind eher selten. Auch eine große Zahl von Windrädern verhält sich offensichtlich ähnlich wie ein einzelnes Windrad. Auch in einer mittleren Fläche ist der häufigste Betriebszustand aller Windräder zusammen der Stillstand.

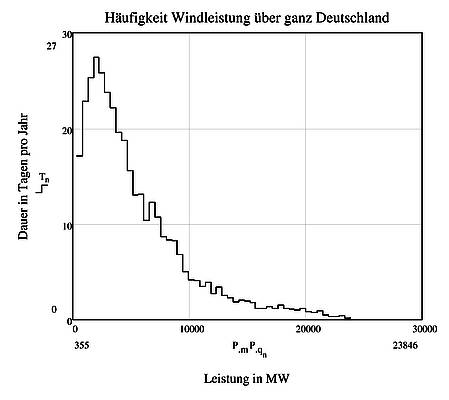

Nimmt man die eingespeiste Leistung von ganz Deutschland (Abbildung 5), kann man im Häufigkeitsdiagramm zumindest erkennen, dass kleine Leistungen seltener werden. Die Leistung Null kommt, anders als bei Flächen von der Größe Niedersachsens oder Nordrhein- Westfalens, nicht mehr vor. Windräder können sich in geringem Umfang durchaus ergänzen: Gleichwohl sinken die Leistungen im großflächigen Verbund auf sehr geringe Werte ab. Bei einer installierten Windrad-Leistung von 31000 MW im Jahre 2012 ist die niedrigste Einspeiseleistung aller Windräder in Deutschland zusammen auf 170 MW (also auf 0,5% der installierten Leistung) gesunken. Dieser Wert ist so nahe bei Null, dass man die Aussage treffen kann, dass die gesicherte Leistung aller Windkraftanlagen in Deutschland zusammen mit Null anzusetzen ist. Damit ist nachgewiesen, dass sich die Anlagen auch bei einer Fläche von der Größe Deutschlands nicht untereinander zu einer gesicherten Leistung ergänzen.

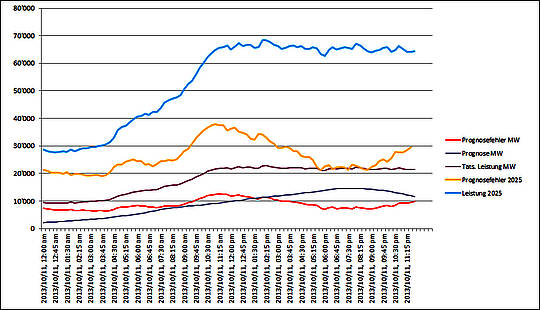

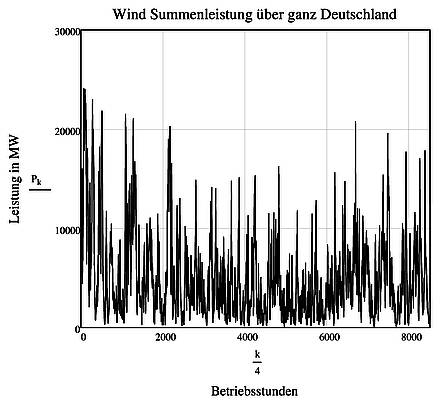

Abbildung 4: Zeitverlauf der Windleistung in ganz Deutschland

Immer wieder, so auch im IWES Windenergie Report 2012, wird behauptet, „andererseits erreicht man nur durch eine gleichmäßige geografische Verteilung über eine große Fläche eine Glättung der Netzeinspeisung“. Abgewandelt findet sich diese These auch in der Agora Kurzstudie Entwicklung der Windenergie in Deutschland in der Form „Ein geographisch verteilter Ausbau führt zu einer stetigeren Einspeisung aus Windenergieanlagen.“

Alle 23000 Windkraftanlagen in Deutschland verhalten sich in ihrem Häufigkeitsdiagramm ungefähr so, wie ein einzelnes Windrad (Abbildung 2). Daraus ergibt sich, dass die Einspeisungen der einzelnen Windräder untereinander stark korreliert sind- wenn ein Windrad hohe Leistungen einspeist, ist das auch für eine große Zahl anderer Windräder der Fall. Das erklärt den ausgeprägt ungleichmäßigen Verlauf der Einspeisung in Abbildung 4. Ein weiterer Ausbau der Windenergie bewirkt aufgrund dieser Korrelation keine stetigere Einspeisung, sondern vielmehr einen Anstieg der Ungleichmäßigkeit. Diese Aussage fußt auf einem Satz aus der mathematischen Statistik, demzufolge die Ungleichmäßigkeit (mathematisch korrekter: Streuung bzw. Standardabweichnung) korrelierter zufälliger Größen mit dem Mittelwert anwächst. Am IWES- Institut hat man durchaus richtig erkannt, dass es „eine grundsätzliche Korrelation der Erzeugung aus Wind in ganz Deutschland“ gibt. Dass diese Aussage mathematisch im Widerspruch zur behaupteten „stetigeren Einspeisung“ steht, gehört dort offenbar (noch) nicht zum Stand des Wissens.

Der nunmehr von der Politik beschlossene weitere Ausbau der Windkraft in Deutschland wird daher die bekannten technischen und ökonomischen Probleme mit der schlichten Strenge mathematischer Notwendigkeit weiter verschärfen.

Dass sich technisch vorgebildete Autoren zu der ganz offensichtlich unzutreffenden Behauptung „Aufgrund der Distanz von über 600 km, flaut der Wind üblicherweise nicht zum selben Zeitpunkt in Hamburg und München ab“ hinreißen lassen und bei einem Zeitverlauf wie in Abbildung 4 von „Glättung“ sprechen, wirft ein Schlaglicht auf die Qualität und Seriosität wissenschaftlicher Arbeit einschlägiger Studien und Konzepte.

Abbildung 5: Häufigkeitsdiagramm der Windleistung in ganz Deutschland

Leistung immer sicher zur Verfügung zu stellen, wird als Grundlastfähigkeit bezeichnet. Die oft verbreitete Aussage, der Wind wehe immer irgendwo ist erwiesenermaßen unzutreffend. Auch über das ganze Land gesehen sind Windkraftanlagen nicht grundlastfähig. Ohne zusätzliche grundlastsichere Kraftwerke ist eine unterbrechungsfreie sichere Stromversorgung mit Windrädern in Deutschland schon aus Gründen der statistischen Verfügbarkeit nicht möglich. In dem Häufigkeitsdiagramm für die gesamte bundesweit eingespeiste Windleistung kann man außerdem ablesen, dass die Windleistung an 120 Tagen (also rund 4 Monaten) im Jahr unterhalb von 10% der installierten Leistung liegt.

Fazit:

Bei einem Versorgungsgebiet von der Größe Deutschlands ist Windkraft nicht in der Lage, einen Beitrag zur Sicherung der Grundlast bei der Stromversorgung zu leisten.

Photovoltaik

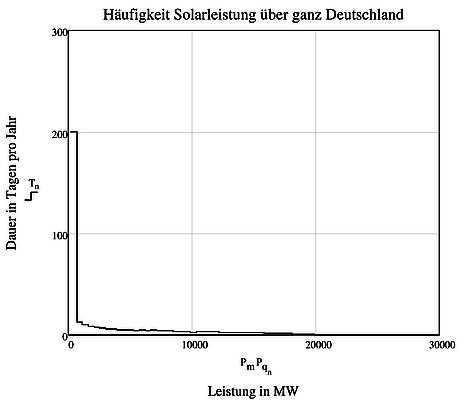

Die Nennleistung aller Photovoltaikanlagen in Deutschland belief sich per Ende 2012 auf rund 32.700 MW. Diese Leistung steht aus naheliegenden Gründen bei Dunkelheit nicht zur Verfügung, womit klar, ist, dass Photovoltaikanlagen keinen Beitrag zur Sicherung der Grundlast leisten. Das Häufigkeitsdiagramm in Abbildung 6 zeigt, dass alle Solaranlagen zusammen in 52% ihrer Betriebsdauer (das sind rund 190 Tage im Jahr) keinen Strom liefern.

Abbildung 6: Häufigkeitsdiagramm der Solarleistung in ganz Deutschland

An 292 Tagen (diese Zeitspanne entspricht ungefähr neuneinhalb Monaten) liegt die Leistung unter 6700 MW, also unter 20% der Nennleistung. Diese Zahlen verdeutlichen, dass die Angabe der Nennleistung nichts über die Verfügbarkeit einer Energieform aussagt. Die durchschnittliche Leistung aller Solaranlagen in Deutschland liegt bei 3200 MW, also bei 10% der installierten Leistung.

Windkraft und Photovoltaik

Der Gedanke, dass die aus Wind- und Photovoltaikanlagen gewonnenen Energien sich gegenseitig ergänzen, hat etwas Verlockendes und scheint zunächst sogar naheliegend. Schließlich überwiegt im Sommer der Sonnenschein und in den eher dunklen Wintermonaten der Wind. In Deutschland sind per Ende 2012 Wind- und Solarkraftwerke mit einer Nennleistung von rund 64.000 MW installiert. Einen Beitrag zur sicheren Grundlast können beide Energieformen nicht leisten, weil die Grundlast von Wind- und Photovoltaik einzeln und auch zusammen bei Null liegt.

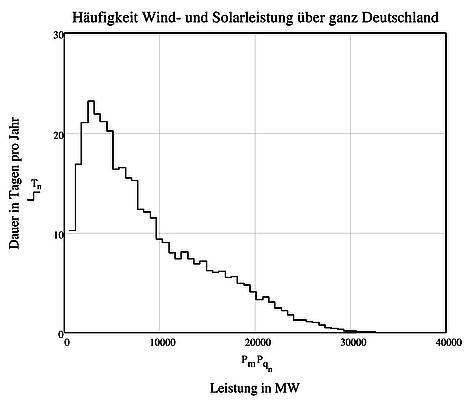

Abbildung 7: Häufigkeitsdiagramm der Wind- und Solarleistung in ganz Deutschland

Das Häufigkeistdiagramm in Abbildung 7 zeigt, dass die summarische Leistung aus Wind- und Sonnenenergie an 90 Tagen im Jahr (3 Monate) unter 3200 MW (entsprechend 5% der installierten Leistung) und an 180 Tagen (6 Monate) unter 6550 MW (entsprechend 10% der installierten Leistung) liegt. Während eines halben Jahres stehen die sogenannten erneuerbaren Energien nur zu einem Bruchteil der Nennleistung zur Verfügung. Die Behauptung, dass sich beide Energieformen im Mix ergänzen, ist daher unzutreffend.

Bei einem Versorgungsgebiet von der Größe Deutschlands sind Wind- und Solarenergie nicht in der Lage, einen Beitrag zur Sicherung der Grundlast bei der Stromversorgung zu leisten. Auch im Verbund liegt deren sichere zur Verfügung stehende Leistung bei Null – ein Netz kann mit diesen Kraftwerken ohne Speicher bzw. zusätzliche Kraftwerke nicht betrieben werden. Ohne Stromspeicher benötigt jede Wind- oder Solaranlage ein konventionelles Kraftwerk, das bei zurückgehender Leistung einspringen kann.

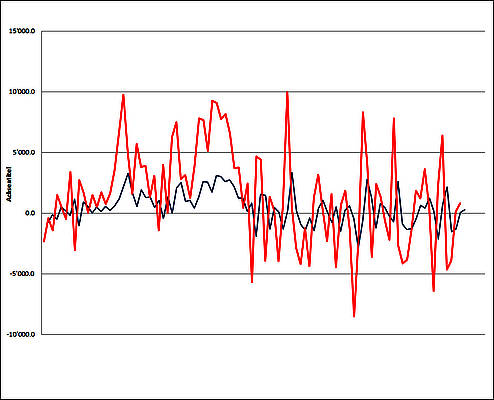

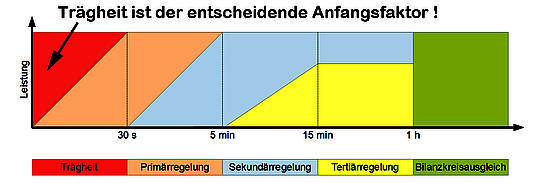

Da bis heute Speicher von nennenswerter Größe nicht vorhanden sind und auch nicht absehbar ist, dass eine Technologie zur Speicherung in ausreichendem Umfang zur Verfügung steht, können Windkraft- und Solaranlagen nur im Zusammenspiel mit konventionellen Kraftwerken betrieben werden- hierbei ist es zunächst gleichgültig, ob diese Kraftwerke mit Kohle oder Erdgas befeuert werden. Diese konventionellen Kraftwerke laufen im Hintergrund und werden in ihrer Leistung zurück gefahren, wenn die Leistung aus Wind- und Solarkraft ansteigt und wieder hoch gefahren, wenn die Leistung sinkt. Hierzu sind diese Kraftwerke im allgemeinen in der Lage, weil sie schnell auf Lastwechsel reagieren können und müssen. Ein modernes Kohlekraftwerk ist ohne weiteres in der Lage, die Leistung um 60% der Nennleistung in 15 Minuten also beispielsweise von 200 MW auf 500 MW zu erhöhen. Dieser Lastwechselbetrieb einer Kraftmaschine ist für jeden Autofahrer völlig selbstverständlich, wenn er beim Beschleunigen auf das Gaspedal tritt: Binnen einiger Sekunden steht die Nennleistung zur Verfügung. Dieses Regelverhalten eines Kraftwerks ist für den sicheren Betrieb eines Stromnetzes unabdingbar, weil Kraftwerke in der Lage sein müssen, Schwankungen der Last augenblicklich auszugleichen! Die Grenzen der Regelungsfähigkeit von Kraftwerken sind erreicht, wenn die eingespeiste Leistung aus sogenannten erneuerbaren Energien schneller ansteigt, als ein Dampfkraftwerk zurückgefahren werden kann. Um das Stromnetz vor einem Zusammenbruch zu bewahren, werden konventionelle Kraftwerke dann im sogenannten Drosselbetrieb gefahren: Der Dampf aus dem Dampferzeuger wird an der Turbine vorbei geleitet und im Kondensator wieder zu Wasser kondensiert. Diese Kraftwerke verbrauchen dann zwar Brennstoff und produzieren CO2, liefern aber keinen Strom. Der Verbundbetrieb von konventionellen Kraftwerken mit Windkraft- und Solaranlagen bestimmt auch die Grenze des weiteren Ausbaus. Wenn die konventionellen Kraftwerke auf ihre kleinste Leistung zurückgefahren sind, kann die Leistung aus Solar- und Wind vom Netz nicht mehr aufgenommen werden, die Anlagen müssen abgeregelt, also in ihrer Leistung begrenzt werden, weil der Strom dann vom Netz nicht mehr aufgenommen werden kann oder ins Ausland verkauft werden muss.

Mit der beschlossenen Abschaltung der Kernkraftwerke in Deutschland steht deren Leistung zur sicheren Versorgung der Netze in wenigen Jahren nicht mehr zur Verfügung. Da die gesicherte Grundlast von Photovoltaik und Windenergie bei Null liegt, muss diese Leistung durch konventionelle Kraftwerke ersetzt werden. Ein Zubau an Kapazitäten ist eine physikalische und technische Notwendigkeit, will man das Stromnetz auch in Zukunft sicher betreiben. Hierfür kommen nur Gas- oder Kohlekraftwerke in Frage – die Abschaltung der Kernkraftwerke ist daher nur mit einem Ausbau der konventionellen Kraftwerkskapazitäten möglich. Wer die Abschaltung von Kohlekraftwerken fordert, oder den Neubau von konventionellen Kraftwerken verhindern will, hat die Physik gegen sich.

Es ist daher fragwürdig, ob sich die CO2- Emissionen durch Solar- und Windkraftanlagen senken lassen- es ist eher zu erwarten, dass diese Emissionen in Zukunft -wie im letzten Jahr- weiter ansteigen werden.

Literatur

Hennig, H.-M., Palzer, A.:

100 % erneuerbare Energien für Strom und Wärme in Deutschland

Fraunhofer-Institut für Solare Energiesysteme ISE

Stuttgart, Kassel, Teltow, 2012

NN:

A bis Z

Fakten zur Windenergie

Hrsg.: Bundesverband Windenergie e.V., Berlin

Rohrig, K.:

Windenergie Report Deutschland 2012

Hrsg.: Fraunhofer-Institut für Windenergie und Energiesystemtechnik (IWES), Kassel, 2012

Pape, C. et. al:

Entwicklung der Windenergie in Deutschland

Agora Kurzstudie erstellt vom Fraunhofer- IWES, Kassel, Juni 2013

Über den Autor: Dr.-Ing. Detlef Ahlborn ist bei Vernunftkraft Leiter Fachbereich Technologie

Jahrgang 1960, selbständiger Unternehmer, Vater von 2 Kindern, Motorradfahrer und Naturwissenschaftler aus Leidenschaft, aus Großalmerode in Hessen. Bürgerinitiative Pro Kaufunger Wald und Hirschberg.

Fachgebiet: Energie- und Kraftwerkstechnik, Speicherung von erneuerbaren Energien, statistische Analyse und Verfügbarkeit von Wind- und Solarenergie.