In einem Artikel über den solaren Klimaeinfluss (M.Lockwood und C.Fröhlich..Royal Society’s journal, UK) ist zu lesen: “There is considerable evidence for solar influence on the Earth’s pre-industrial climate and the Sun may well have been a factor in post-industrial climate change in the first half of the last century. Here we show that over the past 20 years, all the trends in the Sun that could have had an influence on the Earth’s climate have been in the opposite direction to that required to explain the observed rise in global mean temperatures.”

Die Autoren stellen somit den in BWK-Beiträgen nachgewiesenen solaren Einfluss auf das langfristige Klimaverhalten nicht in Frage, inklusiv der jüngsten Erwärmung bis vor einigen Jahrzehnten. Wenn man aber das Temperaturverhalten in einem kurzen, nur 20 Jahre umfassenden Zeitraum untersucht, verlässt man die nachhaltige, langfristige Klimaskala und kommt in den Bereich der Klimafluktuationen, in dem kurzperiodische Klimafaktoren in Relation zu den langfristigen, übergeordneten Prozessen temporär an Bedeutung gewinnen. (BWK-Beiträge SO 11/09 SO 18/10, 01/11). Die kurzfristige Klimaskala lässt grundsätzlich noch keinen Schluss auf die langfristige Klimaskala zu. Wer hier bei der Interpretation keine Skalentrennung vornimmt, vergleicht Äpfel mit Birnen.

Zur Analyse des Klimawandels, also der nachhaltigen Klimaänderung, und seiner Ursachen sind „mindestens 30-jährige Klimaperioden“ (Weltorganisation für Meteorologie) erforderlich.

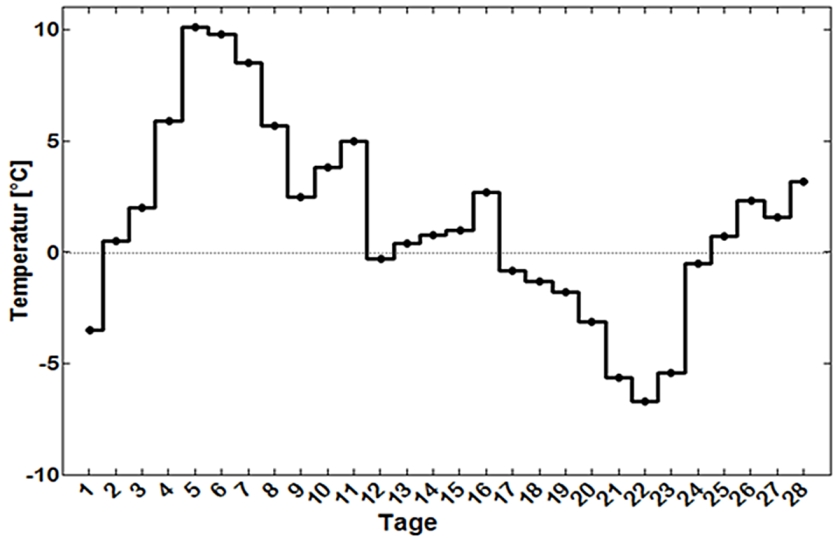

Wie wenig aussagekräftig dekadische Temperaturänderungen in Bezug auf die langfristige Klimaentwicklung sind, zeigt Abb.1. Dort sind die globalen Temperaturänderungen von einer Dekade zur Vordekade dargestellt. Danach hätte man seit 1860 mehrfach auf bevorstehende Klimaerwärmungen wie auf Abkühlungen schließen können. Völlig unhaltbar sind Aussagen auf subdekadischer Datenbasis. Die tatsächliche globale Erwärmung nach 1860 ist nur langfristig zu erkennen (Abb.4).

Die nachfolgenden Analysen stellen eine Ergänzung der früheren Untersuchungen zum Klimawandel dar. Im Gegensatz zur bisherigen Definition eines Sonnenfleckenzyklus von Sonnenfleckenmaximum zu Sonnenfleckenmaximum werden jetzt die Sonnenfleckenzyklen von Sonnenfleckenminimum zu Sonnenfleckenminimum definiert. Diese Verschiebung um eine halbe Wellenlänge ist nach der Schwingungslehre ohne Einschränkung möglich. Auch entspricht die neue Betrachtung der internationalen Zählweise der Zyklen. Ferner kann durch den veränderten Ansatz die zyklenbezogene Klimaanalyse zum einen bis zum Jahr 2009 ausgedehnt werden, wodurch auch das ungewöhnliche Temperaturverhalten seit 1998 betrachtet werden kann. Zum anderen ist durch die Untersuchung eine Überprüfung der früheren Ergebnisse gegebe

Die Klimaentwicklung Mittel- und Westeuropas 1680-2009

Die Klimareihe von Mitteleuropa basiert auf den Klimabeobachtungen von Berlin, Basel, Prag und Wien, die Klimareihe von Westeuropa auf der Central England Reihe (CET), wobei aus letzterer die Mitteleuropawerte für die beiden Dekaden 1680-1700 abgeleitet wurden (Reduktion -0,5°C).

Abb.2 zeigt den Klimawandel (anhand von Klimaperioden von 3 Sonnenfleckenzyklen gleitend) seit der Kleinen Eiszeit in Mitteleuropa, Abb.3 in Westeuropa.

Wie Abb.2 und Abb.3 belegen, setzte nach der Kleinen Eiszeit des 17.Jahrhunderts eine Klimaerwärmung im 18.Jahrhundert ein. Danach kam es zu einer rapiden Abkühlung, die um und nach der Mitte des 19.Jahrhunderts ihren Tiefpunkt erreichte. Ihr folgte der Temperaturanstieg im 20. Jahrhundert.

Sowohl im kontinental geprägten Mitteleuropa als auch im ozeanischen Westeuropa ist diese sinusartige Klimaschwingung seit 1680 mit einer Periodenlänge von rund 200 Jahren ein Faktum. Damit widerspricht die reale Klimaentwicklung dem sog. Hockey-Schläger-Verhalten, wonach die Klimatemperatur vor 1850 konstant gewesen sei und ein Temperaturanstieg erst mit dem Beginn der Industriealisierung nach 1850 einsetzte.

Der Einwand, der dargestellte Temperaturverlauf spiegele nur die regionalen Verhältnisse wider, nicht aber die globalen, ist nicht stichhaltig. So berechnen sich für den Zusammenhang zwischen dekadischen Central England- bzw. Mitteleuropatemperaturen und den globalen Dekadentemperaturen im Zeitraum 1851-2010 Korrelationskoeffizienten von +0,87 bzw. +0,94, d.h. West- und Mitteleuropa machen alle wesentlichen globalen Klimabewegungen mit. Nach den Gesetzen der Logik muss dieses auch für die Zeit vor 1850 gelten. Alles andere würde bedeuten, dass Europa vom nordhemisphärischen/globalen Klimawandel abgekoppelt wäre.

Die globale Klimareihe ab 1850 erfasst nur die Hälfte der Klimaentwicklung seit 1680. Sie gibt vom Klimawandel der letzten Jahrhunderte allein die jüngste Erwärmung wieder (Abb.4), d.h. sie beginnt in der kalten und lebensfeindlichen Periode des 19. Jahrhunderts, als in Mitteleuropa wegen der ungünstigen Klimabedingungen Menschen verhungert sind und die große Auswanderungswelle in die USA einsetzte. Der globale Temperaturanstieg um +0,7°C zwischen 1860 und 2010 war ein Segen und keineswegs der mit der „2°-Grenze“ propagierte Beginn einer Klimakatastrophe.

Das solare Aktivitätsverhalten seit 1680

In Abb.5 ist die mittlere Sonnenfleckenzahl für Klimaperioden von 3 Sonnenfleckenzyklen gleitend dargestellt. Damit entspricht der im Mittel 33-jährige Zeitraum von 3 Sonnenfleckenzyklen zum einen der Definition von Klimaperioden („mindestens 30 Jahre“) der Weltorganisation für Meteorologie. Zum anderen trägt der Ansatz dem kontinuierlichen solaren Energiefluss Rechnung. Erst dadurch lassen sich langfristige Sonnen-/Klimaprozesse von kurzperiodischen Prozessen trennen.

Wie bei den früheren Untersuchungen so folgt nach Abb.5 auch bei der veränderten Definition der Sonnenfleckenzyklen (Minimum bis Minimum) das sinusartige Schwingungsverhalten der Sonnenaktivität mit einer rund 200-jährigen Periodenlänge. Der ruhigen Sonne im 17. Jahrhundert (Maunder-Minimum) folgte eine zunehmend aktive Sonne im 18.Jahhundert. Ihr folgte im 19.Jahrhundert wieder eine Phase mit einer ruhigen Sonne (Dalton-Minimum). Dieser schloss sich die Periode mit stark zunehmender Sonnenaktivität im 20.Jahrhundert a

Vergleicht man den solaren Aktivitätsverlauf mit den Temperaturverläufen von Mitteleuropa (Abb.2) sowie Central England (Abb.3) seit der Kleinen Eiszeit, so ist das langfristige synchrone Verhalten von Sonnenaktivität und Temperatur unverkennbar. Der solare Antrieb hat somit die langfristige Klimaentwicklung, den Klimawandel, in Mittel- und Westeuropa nachweislich gesteuert.

Zum besseren Vergleich mit der globalen Klimaentwicklung ist der Verlauf der solaren Aktivität seit 1857 in Abb.6 dargestellt. Wie man sieht, hat die solare Aktivität seit Beginn der globalen Klimareihe wesentlich zugenommen. Der Vergleich mit Abb.4 zeigt, dass die langfristige Zunahme der Sonnenaktivität und die globale Erwärmung synchron verlaufen sind.

Damit folgt: Der solare Antrieb hat nachweislich sowohl das regionale Klimaverhalten in Mittel- und Westeuropa (sowie in Japan und den USA –BWK-Beitrag SO 01/11) als auch die globale Klimaentwicklung als dominierender Faktor bestimmt.

Anomalien von Sonnenaktivität und Temperatur seit 1680

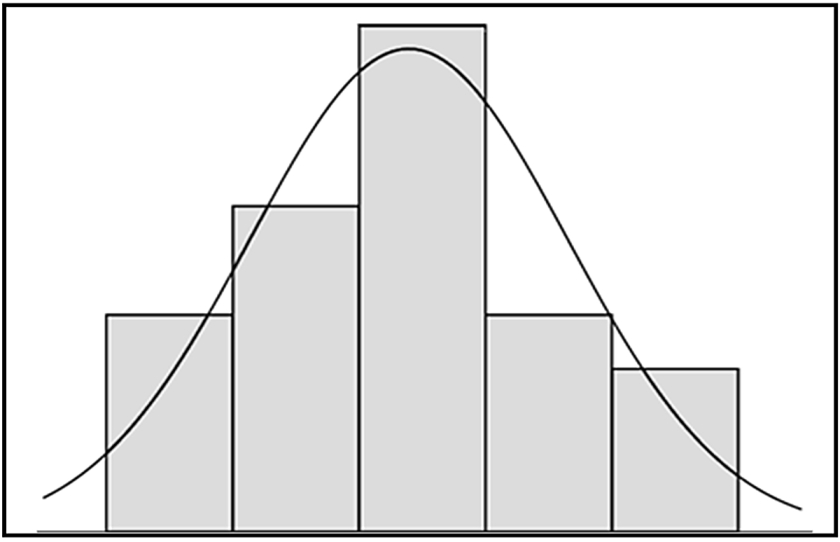

Korrelationen zwischen zwei Größen liefern ein wichtige Information über den Zusammenhang beider Größen. Bei einem direkten Zusammenhang ist die Korrelation positiv, bei einem inversen Zusammenhang ist sie negativ. Ein Korrelationskoeffizient von Null besagt, dass kein Zusammenhang zwischen den Größen besteht. Je mehr sich der Korrelationskoeffizient dem Maximalwert +1,0 nähert, um so stärker ist der direkte Zusammenhang. Wesentliche Voraussetzung bei Korrelationsbetrachtungen ist die sinnvolle Fragestellung. Eine Korrelation von Geburtenzahl und Zahl der Klapperstörche, ein beliebtes Antibeispiel, ist schon von der Fragestellung her Unfug. Eine Fragestellung über den Zusammenhang von solarer Aktivität und Klimatemperatur ist vernünftigerweise nicht zu bestreiten.

Korrelationen haben allerdings den Nachteil, dass sie unanschaulich sind. Die Berechnung des Korrelationskoeffizienten basiert jedoch auf den Anomalien der zu untersuchenden Größen, also ihren Abweichungen vom Mittelwert. Diese aber lassen sich anschaulich darstellen.

In Abb.7 sind die Anomalien der mittleren Sonnenfleckenzahl für die Klimaperioden von 3 Sonnenfleckenzyklen (gleitend) wiedergegeben. Im 17. und 19. Jahrhundert war die Sonnenfleckenzahl/ Sonnenaktivität unternormal (negative Werte). Im 18. und 20.Jahrhundert war die Sonnenfleckenzahl/ Sonnenaktivität dagegen übernormal (positive Werte). Das heißt: Die Beobachtungen belegen den sinusartigen Wechsel von Phasen mit einer ruhigen und einer unruhigen/aktiven Sonne. Die Periodenlänge beträgt rund 200 Jahre.

In Abb.8 sind für den Zeitraum 1680-2009 die über 3 Sonnenfleckenzyklen gleitend gemittelten Abweichungen der Temperaturen von Mitteleuropa dargestellt.

Wie die Temperaturanomalien belegen, herrschte in Mitteleuropa im 17. und im 19.Jahrhundert eine ausgeprägte Kälteperiode (negative Werte). Hingegen waren das 18. und das 20. Jahrhundert von übernormalen Temperaturen (positive Werte), von Wärmeperioden, gekennzeichnet. Analog zum solaren Aktivitätsverhalten wird das sinusartige Temperaturverhalten mit einer Periodenlänge von rund 200 Jahren sichtbar.

Der Vollständigkeit halber sei auch das Temperaturverhalten von Central England seit 1680 aufgeführt. Die Temperaturanomalien weisen -durch den unmittelbaren Ozean-/Golfstromeinfluss etwas gedämpft- den gleichen langfristigen Schwingungsverlauf auf wie in Mitteleuropa, d.h. sie verlaufen grundsätzlich ebenfalls synchron zu den langfristigen Änderungen der Sonnenaktivität seit 1680.

Damit dürfte der fundamentale Zusammenhang zwischen solaren Antriebsänderungen und der Reaktion des Klimasystems der Erde seit der Kleinen Eiszeit zweifelsfrei nachgewiesen sein. Zeiten mit einer unternormalen Sonnenfleckenzahl/Sonnenaktivität führen zu Kälteperioden, Zeiten mit einer übernormalen Sonnenfleckenzahl/Sonnenaktivität sind die Ursache von Wärmeperioden.

Korrelationen

Durch die Korrelationsberechnungen werden die o.g. Zusammenhänge zwischen Sonnenaktivität und Klimaverhalten in Maßzahlen gefasst. Gleichzeitig wird die Frage der Irrtumswahrscheinlichkeit der Aussagen, d.h. ihrer Sicherheit, (Signifikanzniveau) geklärt.

In Abb. 10 sind die linearen Korrelationen über den Zusammenhang von Sonnenfleckenzahl und Temperatur für gleitende Klimaperioden von 3 Sonnenfleckenzyklen dargestellt, und zwar für Mittel- und Westeuropa für den Zeitraum 1680-1823 (links) sowie ab 1857 für Mitteleuropa, Central England, global, Nord- und Südhalbkugel (rechts).

Mit Korrelationskoeffizienten bis zu +0,95 ist der Zusammenhang zwischen zunehmender Sonnenaktivität im 18.Jahrhundert und der synchronen Klimaerwärmung nach der Kleinen Eiszeit hoch-signifikant nachweisbar. Das gleiche gilt für den Zusammenhang von Dalton-Minimum und der raschen Temperaturabnahme Ende des 18./Anfang des 19.Jahrhunderts. Die Korrelation weist für die Abkühlungsphase den Maximalwert von +1,0 auf.

Für die Ursachenanalyse des Temperaturverhaltens nach 1857 ist es sinnvoll, die Korrelationen zum einen für den Zeitraum 1857-1996 und zum anderen für 1857-2009 zu berechnen. Im Zeitraum 1857-1996 folgen nach Abb.10 für den Zusammenhang von zunehmender Sonnenaktivität und langfristigem Temperaturverhalten als Korrelationskoeffizienten für Mitteleuropa +0,91, Central England +0,82, global +0,91, Nordhalbkugel +0,91 und Südhalbkugel +0,88. Damit bestätigen sich die früheren, für den Zeitraum 1860-1999 berechneten Korrelationen.

Berechnet man die Korrelationen für den Zeitraum 1857-2009, so ergibt sich nach Abb.10 folgendes Bild: Mitteleuropa +0,83, Central England +0,78, global +0,83, Nordhalbkugel +0,84, Südhalbkugel +0,81. Das heißt: In Bezug auf die langfristige Klimaentwicklung sind die Korrelationen nach wie vor sehr hoch. Durch die Verlängerung des Zeitraums um den 23. Sonnenfleckenzyklus (1997-2009) reduzieren sich jedoch die Korrelationskoeffizienten regional wie global, und zwar global von +0,91 auf +0,83 und in Mitteleuropa von +0,89 auf +0,83. Auffällig ist, dass im ozeanischen Central England der Rückgang nur 0,04 beträgt.

Das aktuelle Klimaverhalten

Damit erhebt sich die Frage nach der Ursache des Temperaturverhaltens im Zeitraum 1997-2009, welche den Rückgang der linearen Korrelation zwischen Sonnenfleckenzahl und Temperatur seit 1857 zur Folge hat. Bis 1996 konnte der solare Antrieb rund 80% der langfristigen Klimavarianz seit 1857 mit 99,9%-tiger Sicherheit erklären. 20% der Temperaturvariabilität waren auf andere klimarelevante Prozesse zurückzuführen. Offensichtlich hat deren Einfluss im 23. Sonnenfleckenzyklus das Temperaturverhalten maßgeblich bestimmt und die lineare Korrelation zwischen Sonnenaktivität und Temperatur verändert. Um diesen Vorgang zu analysieren, wird nachfolgend der Zusammenhang von mittlerer Temperatur und Sonnenfleckenzahl je Sonnenfleckenzyklus, also auf der kurzen Zeitskala betrachtet. Wie im Beitrag zur BWK SO 01/11 dargelegt, wirken sich in diesem Fall neben dem permanenten solaren Antrieb verstärkt die kurzperiodischen Klimaeinflüsse (z.B. Vulkanausbrüche und El Nino/La Nina) auf die Korrelation aus.

In Abb.11 sind die Korrelationen über den Zusammenhang von mittlerer Sonnenfleckenzahl und Mitteltemperatur je Sonnenfleckenzyklus ab 1857 für die Zeiträume bis 1964, 1976, 1986, 1996 und 2009 wiedergegeben. Wie sich zeigt, sind die Korrelationskoeffizienten für die Perioden bis 1996 stabil bzw. weisen noch eine steigende Tendenz auf, z.B. global von +0,67 auf +0,75. Der Einbruch der Korrelation von Globaltemperatur und Sonnenaktivität auf Werte um +0,50 erfolgt somit durch kurzfristige Prozesse erst im 23. Sonnenfleckenzyklus, also zwischen 1997 und 2009.

Die Klimagegenwart

Die Frage, welche Prozesse das Temperaturverhalten im 13-jährigen Zeitraum 1997-2009 so maßgeblich beeinflusst haben und wieso der solare Anteil gesunken ist, wird anhand der globalen Temperaturentwicklung des 20-jährigen Zeitraums 1991-2010 untersucht.

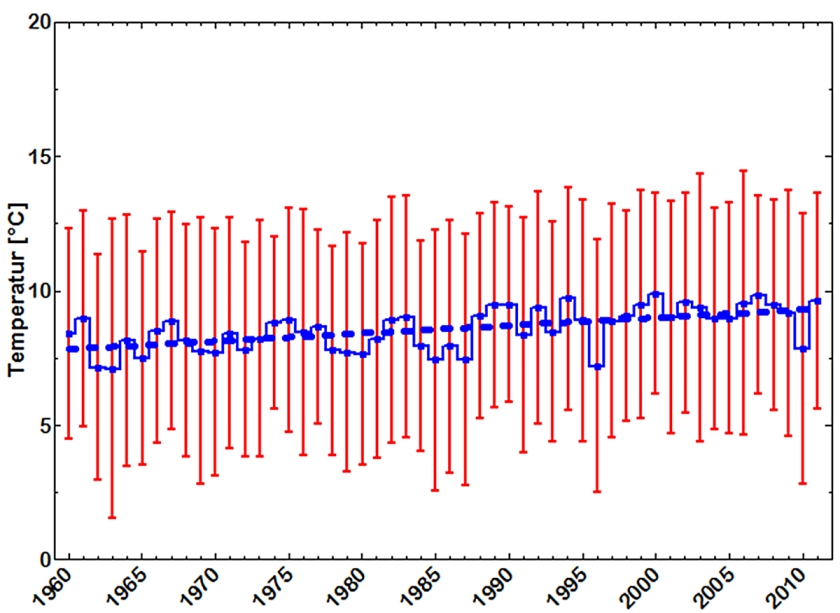

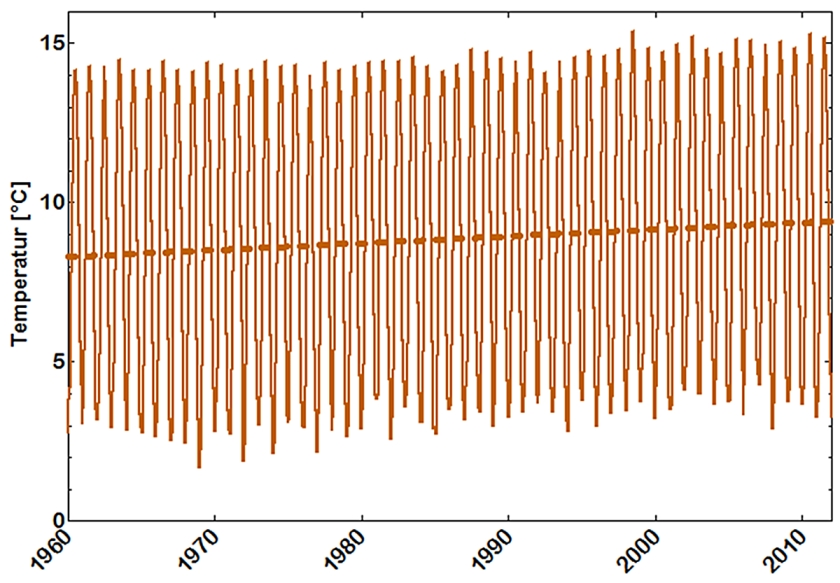

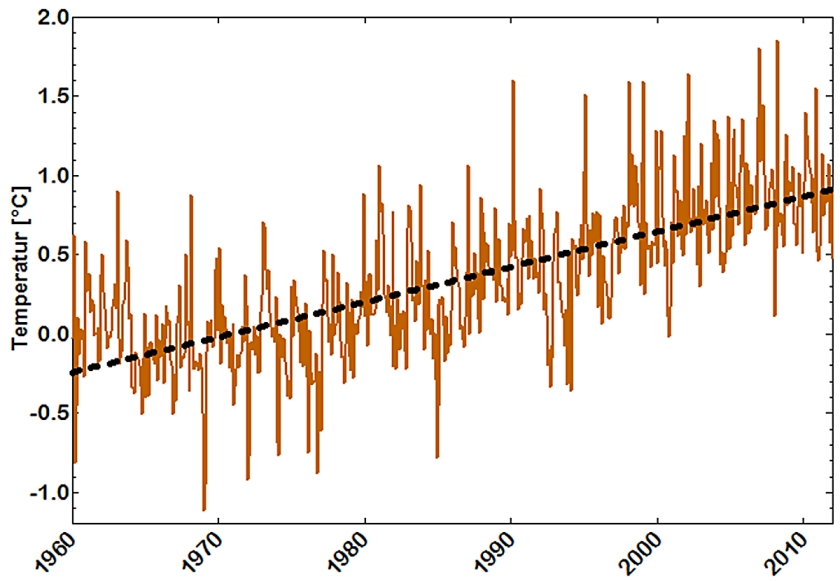

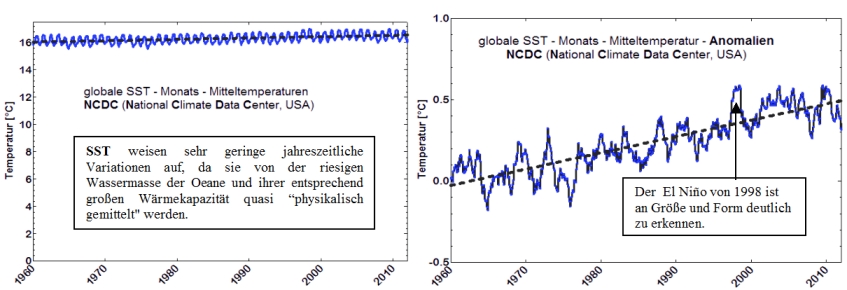

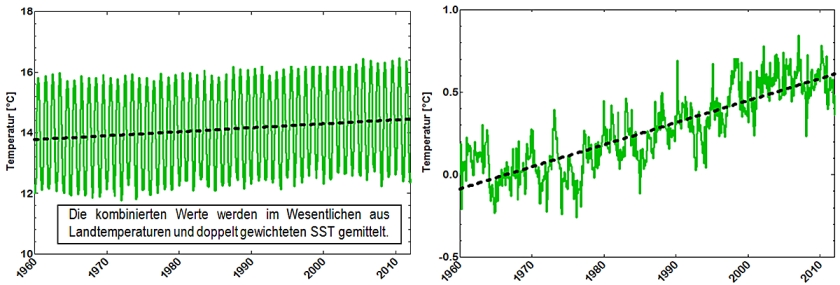

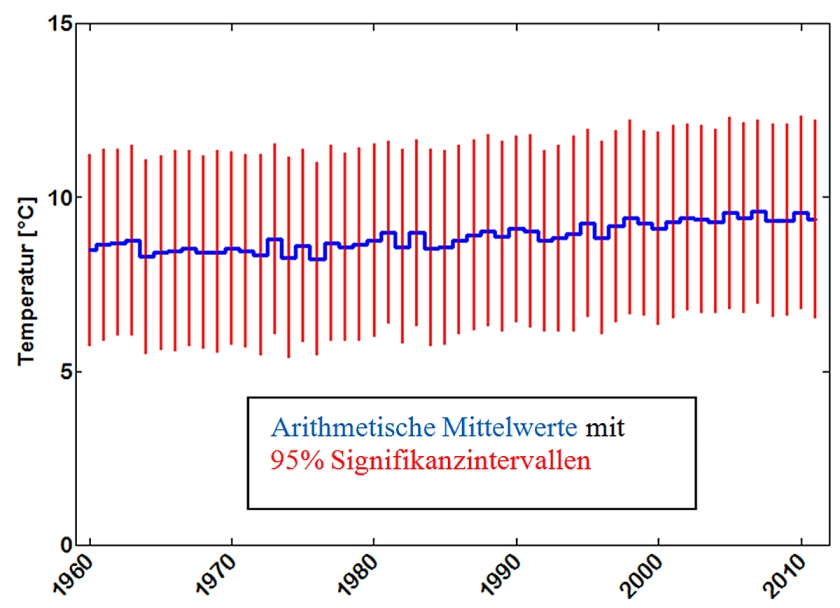

Abb.12 zeigt die globalen Jahresmitteltemperaturen 1991-2010 (Climate Research Unit, UK). Deutlich ist an dem gezackten Kurvenverlauf der Einfluss hoch-frequenter Klimaprozesse zu erkennen. Besonders auffällig ist die Temperaturspitze von 1998. Seit diesem Zeitpunkt ist die globale Temperatur nicht weiter gestiegen, d.h. seit 1998 findet keine weitere globale Erwärmung mehr statt.

Wie die Regressionskurve deutlich macht, verharrt die globale Temperatur seit 1998 auf einem gleichmäßigen Niveau mit einer leicht fallenden Tendenz, die sich im La Nina-Jahr 2011 verstärken wird.

Damit gilt es zu prüfen, inwieweit der anthropogene, der solare oder der ozeanische Klimaeinfluss das plateauartige globale Temperaturverhalten zwischen 1998 und 2010 zu erklären vermag.

Der atmosphärische CO2-Gehalt

Nach indirekten CO2-Bestimmungen war der Kohlendioxidgehalt der Luft in der Nacheiszeit bis 1850 konstant und lag bei 280 ppm. Damit scheidet jeder CO2-Einfluss auf den Klimawandel bis 1850 von vornherein aus. Weder bei der Wärmeperiode der Römerzeit, der Kälteperiode zur Völkerwanderungszeit, der mittelalterlichen (Wikinger-)Warmzeit noch der Kleinen Eiszeit hat der CO2-Effekt eine Rolle gespielt. Es waren somit nur natürliche Prozesse (Sonne, Ozeane, Vulkanausbrüche,…), die das Klima wiederholt nachhaltig veränderten.

Nach den obigen Korrelationsanalysen über den Zusammenhang von veränderlicher Sonnenaktivität und langfristiger Klimaentwicklung ist ebenfalls kein wesentlicher Treibhaus-/CO2-Einfluss auf den Klimawandel im Industriezeitalter zu erkennen. Der solare Effekt vermag auch bei der Erwärmung nach 1860 rund 80% des langfristigen regionalen und globalen Klimaverhaltens zu erklären.

Für den CO2-Einfluss auf den Klimawandel bleibt nur das Residuum von 20% übrig, in dem allerdings auch die langfristigen Antriebe von Ozean und globaler Eisbedeckung enthalten sind.

Damit bleibt allein noch die Frage zu klären, ob der gestiegene CO2-Gehalt der Luft das aktuelle Klimaverhalten bestimmt hat. Bedenkt man, dass von der CO2-Zunahme seit 1850 von 280 ppm auf 390 ppm im Jahr 2010 allein 45 ppm auf die 20 Jahre 1991-2010 entfallen, so wird der exponentielle CO2-Anstieg in Abb.13 verständlich. Mit diesem Anstieg müsste nach der anthropogenen Treibhaushypothese ein erheblicher Temperaturanstieg verbunden sein.

Vergleicht man nun Abb.12 und Abb.13 miteinander, so fällt zum einen auf, dass das CO2-Verhalten die kurzperiodischen Temperaturfluktuationen nicht zu erklären vermag. Der CO2-Effekt kennt physikalisch nur die Temperaturzunahme, Abkühlungen, ob kurz- oder langfristig, sind ihm wesensfremd und müssen durch natürliche, ihn überkompensierende Klimaprozesse erklärt werden. Ebensowenig vermag er sprunghafte Temperaturzunahmen zu erklären. Das gilt auch für die Temperaturspitze von 1998.

Nach 1998 steigt der CO2-Gehalt exponentiell weiter an. Die globale Temperatur hingegen geht, wie die Regressionskurve zeigt, in ein Plateau mit leicht fallender Tendenz über. Krasser kann die Divergenz zwischen aktuellem Temperatur- und CO2-Verhalten kaum sein. Damit folgt: Obwohl der CO2-Gehalt der Luft seit 1998 auf sein höchstes Niveau angestiegen ist, stagniert die globale Temperatur. Der CO2-Effekt spielt somit auch beim aktuellen Klimaverhalten keine erkennbare Rolle.

Der ozeanische Einfluss von El Nino und La Nina

Die atmosphärischen Auswirkungen der periodischen Wassertemperaturänderungen im tropischen Pazifik sind bereits in mehreren Beiträgen zu BWK gezeigt worden (SO 11/09, SO 18/10). El Nino als ENSO-Warmphase und La Nina als ENSO-Kaltphase (ENSO=El Nino-Südliche Oszillation) bestimmen wesentlich die kurzperiodischen globalen Temperaturfluktuationen. Weisen sie, wie in jüngster Vergangenheit, ein Trendverhalten auf, so können sie auch multi-dekadische Auswirkungen auf die Globaltemperatur haben. Ist (gemäß der ONI-Werte des US-Wetterdienstes) Tm die mittlere Abweichung der tropischen Pazifiktemperatur während einer El Nino-Phase vom Normalwert (Tm: positiv) bzw. einer La Nina-Phase (Tm:negativ), so kann der Wärmeeinfluss des Ozeans auf die Atmosphäre durch den thermischen Antriebsfaktor F=Tm*Mon beschrieben werden, wenn die zeitliche Dauer des jeweiligen ENSO-Ereignisses in Monaten erfasst wird.

In Abb.14 ist für jedes Jahrzehnt seit 1951 der resultierende Antrieb gemäß F(El Nino) minus F(La Nina) angegeben, also die Wärmebilanz zwischen den El Nino- und den La Nina-Phasen der Dekade.

Wie man erkennt, überwog in den 1950er Jahren der Einfluss von La Nina gegenüber dem El Nino-Einfluss auf die Atmosphäre. In der 1970er Dekade waren beide thermische Effekte gleich groß, d.h. bei der Ursachenanalyse für die Abkühlung der Nordhalbkugel in dieser Zeit kann ein ENSO-Einfluss vernachlässigt werden.

In den 1980er, den 1990er und vor allem in der Dekade 2001-2010 überwogen die Auswirkungen von El Nino jene von La Nina auf die Atmosphäre. Somit hatte El Nino nicht nur kurzperiodisch, sondern auch multi-dekadische Auswirkung auf die globale Temperatur seit den 1980er Jahren. Insbesondere in der Dekade 2001-2010 hat El Nino das globale Temperaturniveau wesentlich beeinflusst.

In Abb.15 sind die Korrelationskoeffizienten über den Zusammenhang zwischen den jährlichen globalen Mitteltemperaturen und den mittleren jährlichen Anomalien der Pazifiktemperatur im El Nino-/La Nina-Gebiet wiedergegeben. Wie man erkennt, nimmt der kurzperiodische Einfluss der ENSO-Warm- und Kaltphasen auf die Globaltemperatur seit 1991 von Jahr zu Jahr zu und erreicht im Zeitraum 1999-2010 einen Korrelationskoeffizienten von +0,80, bis 2009 sogar von +0,87. Berücksichtigt man den Umstand, dass die El Nino- und die La Nina-Ereignisse jahresübergreifend sind und korreliert den thermischen Antriebsfaktor F=Tm*Mon der ENSO-Phasen mit dem wärmeren/kälteren Jahr der entsprechenden jahresübergreifenden ENSO-Phase, so ergibt sich im Zeitraum 1998-2009/10 ein Korrelationskoeffizient von über +0,95, d.h. die seit 1998 dem Temperaturplateau überlagerten Temperaturfluktuationen gehen praktisch alle auf die Auswirkungen von El Nino/La Nina zurück.

Die Auswirkungen von El Nino auf die Atmosphäre haben somit einerseits einen maßgeblichen Beitrag zum aktuellen globalen Temperaturniveau geleistet und erklären anderseits zusammen mit den La Nina-Phasen die Pendelbewegungen der Globaltemperatur auf dem Temperaturplateau seit 1998.

Sonnenaktivität und gegenwärtiges Klimaverhalten

Um den solaren Einfluss auf den Klimawandel der letzten Dekaden einordnen zu können, ist in Abb.16 die mittlere Sonnenfleckenzahl der letzten 10 Sonnenfleckenzyklen dargestellt. Seit dem Zyklus 14 (1902-1913) ist sie von 31 auf 96 im Zyklus 19 (1955-1964) angestiegen. Synchron dazu stieg die globale Temperatur. Danach erfolgte im 20.Zyklus (1965-1976) ein Einbruch der Sonnenaktivität. Die mittlere Sonnenfleckenzahl ging um über 35% von 96 auf 59 zurück. Die Nordhalbkugel reagierte aufgrund ihres hohen Festlandanteils spontan auf den Rückgang der solaren Aktivität. In der Arktis kam es zu einem deutlichen Temperaturrückgang (R.Scherhag, BWK SO31/70), und das Nordpolareis dehnte sich im europäischen Teil so weit südwärts aus, dass die Eisbären von Grönland nach Island hätten wandern können. Noch im Frühjahr war die Dänemarkstraße zugefroren, wie die Satellitenaufnahmen zeigten. In der Klimaforschung begann man über eine bevorstehende weitere Kleine Eiszeit nachzudenken.

Doch überraschend nahm im 21. Sonnenfleckenzyklus (1977-1988) die Sonnenaktivität wieder zu. Die mittlere Sonnenfleckenzahl stieg auf 83 an. Mit 78 blieb die mittlere Sonnenfleckenzahl auch im 22. Sonnenfleckenzyklus (1987-1996) auf hohem Niveau, dem dritthöchsten seit der Kleinen Eiszeit. Analog stieg auch die Temperatur der Nordhalbkugel wieder an. Die Südhalbkugel hatte auf den kurzzeitigen solaren Einbruch im 20.Zyklus aufgrund der thermischen Trägheit ihres großen Ozeananteils nicht reagiert.

Dem hohen solaren Aktivitätsniveau der Zyklen 21 und 22 folgte im 23.Sonnenfleckenzyklus (1997-2009) erneut ein Einbruch. Die mittlere Sonnenfleckenzahl ging auf 52 zurück. Wenn die globale/ nordhemisphärische Temperatur nicht unmittelbar auf die solare Aktivitätsabnahme reagiert, liegt das zum einen an der thermischen Trägheit der Ozeane. Vor allem aber wirkt sich, wie gezeigt, der gegenwärtig hohe El Nino-Einfluss auf die globale Temperatur vorübergehend stabilisierend aus.

Zusammenfassend lässt sich sagen: Nach der deutlichen Zunahme der Sonnenfleckenzahl/ Sonnenaktivität im 20.Jahrhundert ist die mittlere Sonnenfleckenzahl im 23. Zyklus auf die kritische Grenze von rund 50 gesunken. Die in diesem Grenzbereich auftretende klimawirksame solare Aktivität entspricht dem indifferenten Klimazustand zwischen einer nachhaltigen Wärme- und einer Kälteperiode (BWK SO 03/09). Das heißt: Das derzeitige Klimaverhalten auf der kurzzeitigen Klimaskala sagt nichts über die weitere langfristige Klimaentwicklung aus. Diese wird auch in Zukunft maßgeblich vom Verhalten der Sonne abhängen.

Die Klimazukunft

Die entscheidende Frage für die zukünftige Klimaentwicklung lautet: Wie verhält sich die solare Aktivität im aktuellen 24.Sonnenfleckenzyklus und den nachfolgenden Zyklen? Nimmt die mittlere Sonnenfleckenzahl/Zyklus wieder zu, wäre nach der gegenwärtigen Stagnation der globalen Temperatur mit einem weiteren Temperaturanstieg zu rechnen. Sinkt die mittlere Sonnenfleckenzahl/Zyklus langfristig aber unter den kritischen Grenzwert von rund 50/Zyklus, so ist ein globaler Rückgang der Temperatur zu erwarten. Derzeit sprechen alle Anzeichen für eine bevorstehende Abkühlung.

So hat zum einen die NASA soeben (Feb.2011) ihre bisherige Prognose der Sonnenfleckenzahl im 24. Sonnenfleckenzyklus weiter nach unten korrigiert.

Abb.17 Sonnenfleckenzahl des 23. und Prognose des 24. Sonnenfleckenzyklus (NASA)

Wie die NASA-Prognose in Abb. 17 zeigt, wird die mittlere Sonnenfleckenzahl und damit die integrale Sonnenaktivität im aktuellen 24.Zyklus mit hoher Wahrscheinlichkeit den kritischen Grenzwert von 50 deutlich unterschreiten. Dieser Rückgang der solaren Aktivität wie die zu erwartende Abkühlung würden ferner der 200-jährigen Schwingung von Sonnenaktivität (Abb.5) und langfristiger Klimaentwicklung (Abb.2, Abb.3) entsprechen (De-Vries-Zyklus). Die von den Klimamodellen prognostizierte fortschreitende Klimaerwärmung erscheint vor diesem Hintergrund höchst unwahrscheinlich.

Dafür spricht auch die folgende Abbildung.

In Abb.18 ist die Abweichung der Periodenlänge der Sonnenfleckenzyklen vom 11-jährigen Mittelwert seit dem Zyklus 1646-1655 wiedergegeben. Wie man erkennt, sind positive Abweichungen von 2 bis 3 Jahren, also überlange Zyklen, selten.

Auffällig ist: Nach dem überlangen Zyklus 1621-1633 begann das Maunder Minimum, und dem Zyklus 1667-1679 folgte der letzte Höhepunkt der Kleinen Eiszeit Ende des 17. Jahrhunderts. In der Wärmeperiode des 18.Jahrhunderts fehlten überlange Zyklen. Mit den übernormalen Zykluslängen 1785-1798 bzw. 1811-1823 korrespondiert das Dalton-Minimum und damit der rapide Temperaturrückgang Ende des 18./Anfang des 19. Jahrhunderts. Die Kälteperiode um die Mitte des 19. Jahrhunderts fällt mit dem überlangen Zyklus 1844-1856 zusammen. Danach wurde bis 1996, also während der gesamten Erwärmungsphase nach 1860, kein überlanger Sonnenfleckenzyklus mehr beobachtet. Erst der Sonnenfleckenzyklus 1997-2009 weist wieder eine Überlänge wie die Zyklen im 17. und 19. Jahrhundert vor Beginn der Kälteperioden auf. Dieser Sachverhalt ist somit ein weiteres Indiz für den Übergang der Sonne von einer aktiven Phase zu einer ruhigen Sonne. Alle solaren Vorzeichen lassen daher nur den Schluss auf einen Rückgang der globalen Temperatur in naher Zukunft zu. Zu vergleichbaren Ergebnissen sind auch das russische Hauptobservatorium Pulkovo bei St.Petersburg und das US-amerikanische SSRC (Space Sciende Research Center) gekommen.

Zusammenfassende Schlussbetrachtungen

Die Analyse des Klimaverhaltens im Zeitraum 1680-2009 bestätigt die Ergebnisse der früheren Untersuchungen. Der mehrfache Klimawandel seit der Kleinen Eiszeit wurde empirisch nachweislich primär von den langfristigen Veränderungen der Sonnenaktivität gesteuert. Mittlere Sonnenfleckenzahl und Temperatur zeigen regional wie global/ hemisphärisch auf der langfristigen Klimaskala einen synchronen Verlauf. Die Korrelationskoeffizienten über diesen (über Klimaperioden von 3 Sonnenfleckenzyklen gleitenden) Zusammenhang liegen um +0,90 bis +1,0 und sind auf dem 99,9%-Niveau signifikant, d.h. die Irrtumswahrscheinlichkeit beträgt nur 0,1%.

Dabei gilt der dominierende solare Einfluss auf den nachhaltigen Klimawandel nicht nur für die Zeit bis 1850, in der der CO2-Gehalt der Luft konstant bei 280 ppm lag und damit a priori keine Rolle beim Klimawandel spielte. Auch nach 1850 ist kein wesentlicher anthropogener CO2-/ Treibhauseinfluss auf die Klimaentwicklung zu erkennen. Der solare Effekt vermag an der globalen wie regionalen Erwärmung von 1860 bis 1996 bei den kurzfristigen Klimafluktuationen mit ihren vielen natürlichen Einflussfaktoren 55%-60% und an dem langfristigen Temperaturanstieg rund 80% statistisch abgesichert zu erklären. Der solare Antrieb ist offensichtlich.

Seit der Kleinen Eiszeit war die mittlere Sonnenfleckenzahl/Sonnenaktivität je Zyklus niemals so hoch wie in der 2. Hälfte des 20.Jahrhunderts. Die Werte der Sonnenfleckenzyklen 19, 21 und 22 waren viermal so hoch wie zur Kleinen Eiszeit und doppelt so hoch wie zur Zeit der Kälteperiode des 19. Jahrhunderts. Die Behauptung, der solare Effekt mache nach den Klimamodellen nur 10% bei der Erwärmung im letzten Jahrhundert aus, ist vor dem Hintergrund der Klimageschichte unlogisch und nach der empirischen Klimaanalyse durch die Realität widerlegt. Die Größenordnung dürfte eher für den anthropogenen CO2-Einfluss auf das Klima zutreffen.

Vor der Betrachtung der Klimavariabilität im Zeitraum 1997/98-2009/10 ist festzuhalten: Entscheidend für die Beurteilung des nachhaltigen Klimawandels ist das langfristige Klimaverhalten. Nicht entscheidend sind dekadische oder etwa subdekadische Klimafluktuationen, da die Prozesse auf der kurzfristigen Klimaskala nur von vorübergehender Bedeutung sind.

In dem mit 13 Jahren anormale langen 23. Sonnenfleckenzyklus (1997-2009) ist die mittlere Sonnenfleckenzahl von rund 80 der beiden Vorzyklen auf 52 zurück gegangen. Damit hat sie den kritischen Grenzwert zwischen aktiver und ruhiger Sonne, zwischen einer Wärme- und einer Kälteperiode erreicht. In dieser indifferenten solaren Übergangsphase ist derzeit auf der kurzfristigen Klimaskala ein erhöhter Einfluss kurzperiodischer Klimaprozesse festzustellen.

Seit 1998 verharrt die globale Temperatur auf einem quasi-konstanten Niveau, einem Temperaturplateau mit leicht fallender Tendenz. Die globale Temperatur führt dabei lediglich kurze und kleine Pendelbewegungen nach oben und unten aus. Dieses gegenwärtige globale Temperaturverhalten korrespondiert zum einen mit den derzeit ungewöhnlich hohen thermischen Auswirkungen von El Nino auf die Atmosphäre, wodurch die globale Temperatur stabilisiert wird. Zum anderen korrespondieren die globalen Temperaturfluktuationen mit den kurzzeitigen Wechseln zwischen El Nino- und La Nina-Phasen. Die Korrelation zwischen dem jahresübergreifenden thermischen Antriebsfaktor F=Tm*Mon der El Nino- und La Nina- Ereignisse im Zeitraum 1998-2009/10 mit der erhöhten/erniedrigten globalen Jahrestemperatur in dieser Phase liegt über +0,95. Es ist somit offenkundig der Wärmefluss des tropischen Pazifiks, der seit dem starken El Nino von 1998 bis heute die globale Temperatur auf der kurzzeitigen Klimaskala bestimmt.

Der anthropogene CO2-Effekt kommt als Ursache des aktuellen Temperaturverhaltens nicht in Betracht. Wäre er dominant, müsste sich die globale Temperatur seit1998 auf Grund des exponentiellen CO2-Anstiegs stark erhöht haben. Eine konstante globale Temperatur ist durch einen angeblich dominierenden CO2-Effekt physikalisch ebenso wenig zu erklären, wie es globale Abkühlungen sind.

Entscheidend für die weitere Klimaentwicklung im 21.Jahrhundert wird sein, wohin sich die solare Aktivität aus dem kritischen Grenzbereich des 23. Sonnenfleckenzyklus entwickelt. Bei einem Übergang vom kritischen Grenzwert von rund 50 zu höheren mittleren Sonnenfleckenzahlen/ Sonnenaktivität je Zyklus wäre mit einer weiteren Erwärmung zu rechnen. Ein deutliches Absinken der mittleren Sonnenfleckenzahl/Zyklus unter 50 im 24. Sonnenfleckenzyklus und den folgenden Zyklen würde zu einer Abkühlung führen.

Derzeit weisen alle Vorzeichen auf eine bevorstehende globale Abkühlung hin. Zu den Indizien zählen zum einen die 200-jährige Schwingung der Sonnenaktivität und des synchronen Klimaverhaltens sowie der mit 13 Jahren überlange 23.Sonnenfleckenzyklus. Zum anderen ist nach der aktuellen NASA-Sonnenfleckenprognose eine deutliche Unterschreitung der kritischen mittleren Sonnenfleckenzahl im 24. Sonnenfleckenzyklus bis 2020 zu erwarten.

Die durch den solaren Effekt veränderte globale atmosphärische und ozeanische Zirkulation wird, wie zu allen Zeiten, letztlich über die regionalen Auswirkungen der globalen Abkühlung entscheiden.

Zusammenfassend kann man sagen: Das gegenwärtige solare Verhalten steht nicht im Widerspruch zu seinem dominierenden langfristigen Klimaeinfluss, sondern stellt eine Ergänzung dar, indem es den Klimazustand an der kritischen Grenze der solaren Aktivität zwischen aktiver und ruhiger Sonne, zwischen einer Wärme- und Kälteperiode charakterisiert. Solange die solare Aktivität an der kritischen Grenze verharrt, wird es global weder wärmer noch kälter, d.h. die globale Temperatur strebt durch den solaren Effekt in dieser Phase ein konstantes Niveau an. Solarer Antrieb und globale Temperatur verhalten sich in ihrem Zusammenspiel daher derzeit „normal“.

Fazit

Auch nach dieser Klimaanalyse ist der solare Einfluss auf unser Klimasystem der dominierende Antrieb des langfristigen, nachhaltigen Klimawandels. Der angeblich dominierende anthropogene CO2-/ Treibhauseffekt ist vor diesem Hintergrund eine offensichtliche Fehleinschätzung, insbesondere auch in Bezug auf seine katastrophalen Auswirkungen. Daher lautet mein Credo auch nach dieser Untersuchung: An die Stelle eines wissenschaftlich nicht konsensfähigen und daher wirtschaftlich nicht vertretbaren globalen Klimaschutzes sollte die oberste Priorität auf den weltweiten Umweltschutz gelegt werden. Saubere Luft, sauberes Wasser, unbelastete Seen, Flüsse, Ozeane und Erdböden sowie ein intaktes Ökosystem gehören zu den Grundrechten des Menschen weltweit. Ein stabiles Klima gehört, wie die Klimageschichte lehrt, nicht dazu. So sollte man auch bei der Suche nach den Ursachen des Artensterbens die Umweltsünden im Fokus haben, anstatt eine Temperaturschwankung dafür verantwortlich zu machen, die in der jüngeren Klimageschichte von Natur aus völlig normal ist.

Prof. Dr. Horst Malberg

zuerst erschienen in Beiträge zur Berliner Wetterkarte

c/o Institut für Meteorologie der Freien Universität Berlin C.-H.-Becker-Weg 6-10165 Berlin 19/11 http://www.Berliner-Wetterkarte.de ISSN 0177-3984 SO 09/11

Literatur

– Brohan, P., J.J. Kennedy, I. Haris, S.F.B. Tett and P.D. Jones: Uncertainty estimates in regional and global

observed temperature changes: a new dataset from 1850. J. Geophysical Research, 111, D12106,

doi:10.1029/2005JD006548 — pdf

– BMBF Herausforderung Klimawandel“. 2004: http://www.bmbf.de/pub/klimawandel.pdf

– Claußnitzer, A. Das Maunder-Minimum. Eine Modellstudie mit dem „Freie Universität Berlin Climate

Middle Atmosphere Model“ (FUB-CMAM). Diplomarbeit. 2003

– Cubasch, U. Variabilität der Sonne und Klimaschwankungen. Max-Planck-Forschung. Das Wissen-

schaftsmagazin der Max-Planck-Gesellschaft (2001)

– Eddy, J.A. „The Maunder Minimum“. Science 192. 1976

– EIKE: www.eike-klima-energie.eu

– Hennig, R. Katalog bemerkenswerter Witterungsereignisse –von den alten Zeiten bis zum Jahre 1800.

Abh. Kgl. Preuß. Met.Inst.Bd.II/4 .1904

– Hoyt, D. V. and Schatten, K. H.: The role of the sun in climate change. New York-Oxford, Oxford Univer-

sity Press. 1997

– Jones, P.D., New, M., Parker, D.E., Martin, S. and Rigor, I.G., 1999: Surface air temperature and its varia-

tions over the last 150 years. Reviews of Geophysics 37, 173-199.

– Labitzke,K. and H. van Loon: The signal of the 11-years sunspot cycle in the upper troposphere-lower

Stratosphere. 1997

– Labitzke, K. On the solar cycle – QBO – relationship. J.A.A., special issue 67, 45-54. 2005

– Landscheidt, T. Solar oscillations, sunspot cycles, and climatic change. In: McCormac, B. M., Hsg.:

Weather and climate responses to solar variations. Boulder, Ass. Univ. Press (1983)

– Malberg,H. und G. Bökens: Änderungen im im Druck-/Geopotential- und Temperaturgefäl le zwischen Sub-

tropen und Subpolarregion im atlantischen Bereich im Zeitraum 1960-90. Z.f.Meteor. N.F. (1993)

– Malberg, H. Beiträge des Instituts für Meteorologie der Freien Universität Berlin/Berliner Wetterkarte:

– Über den Klimawandel in Mitteleuropa seit 1850 und sein Zusammenhang mit der Sonnenaktivität. SO 17/02

– Die globale Erwärmung seit 1860 und ihr Zusammenhang mit der Sonnenaktivität. SO 27/02

– Die nord- und südhemisphärische Erwärmung seit 1860 und ihr Zusammenhang mit der Sonnenaktivität. SO

10/03

– Der solare Einfluss auf das mitteleuropäische und globale Klima seit 1778 bzw. 1850. SO 01/07 (2007) –

In Memoriam Prof. Richard Scherhag.

– Über den dominierenden solaren Einfluss auf den Klimawandel seit 1701. SO 27/07

– El Nino, Vulkane und die globale Erwärmung seit 1980. SO 34/07

– El Niño und der CO2-Anstieg sowie die globale Erwärmung bei C11/09O2-Verdopplung. SO 02/08

– Die unruhige Sonne und der Klimawandel. SO 20/08

– Über die kritische Grenze zwischen unruhiger und ruhiger Sonne und ihre Bedeutung für den Klimawandel. SO

03/09

– La Nina – El Nino und der solare Einfluss – Der Klimawandel 1950-2008. SO 11/09

– Über das Stadtklima und den Klimawandel in Deutschland seit 1780. SO 18/09

– Langfristiger Klimawandel auf der globalen, lokalen und regionalen Klimaskala und seine primäre Ursache:

Zukunft braucht Herkunft. SO 29/09 (2009)

– Der solare Einfluss auf den Klimawandel in Westeuropa seit 1672. SO 37/09 (2009)

– Rekonstruktion des Klimawandels seit 1860 bzw. 1672 aufgrund solarer Aktivitätsänderungen, SO 11/10

(2010)

– Kurzperiodische und dekadische Klimavariabilität im Zeitraum 1980-2009. SO18/10 (2010)

– Über scheinbare und tatsächliche Klimaerwärmung seit 1850. SO26/10 (2010)

– Malberg, H. Klimawandel und Klimadiskussion unter der Lupe. Z. f. Nachhaltigkeit 5. 2007

– Malberg, H. Klimawandel und Klimadebatte auf dem Prüfstand. Verh. Ges.Erdkunde zu Berlin. 2007

– Malberg, H. Der solare Einfluss auf den Klimawandel. Jahrbuch der Freunde und Förderer der TU Bergakade-

mie Freiberg, 2010

– Matthes, K., Y. Kuroda, K. Kodera, U. Langematz: Transfer of the solar signal from the stratosphere to the

troposphere: Northern winter. J. Geophys. Res., 111.2005

– Matthes, K., U. Langematz, L. L. Gray, K. Kodera Improved 11- year solar signal in the Freie Universität

Berlin climate middle atmosphere model. J. Geophys. Res., 109. 2003

– Negendank, J.W. Gehen wir einer neuen Kaltzeit entgegen? Klimaänderungen und Klimaschutz.TU-

Cottbus.2007

– Pelz, J. Die Berliner Jahresmitteltemperaturen von 1701 bis 1996, Beilage Berl. Wetterkarte, 06/1997

– Scafetta; N. and B.J. West: Is Climate Sensitive to Solar Variability. Physics today. (2008)

– Scherhag, R. Die gegenwärtige Abkühlung der Arktis. Beilage Berliner Wetterkarte SO31/1970

– Svensmark, H. Cosmic rays and earth‘s climate. Space Science Rev. 93 (2000)

– Svensmark, H. Cosmic Climatlogy – A new theory emerges. A&G, Vol. 48 (2007)

– Svensmark, H., Friis-Christensen, E. Reply to Lockwood and Fröhlich – The persistent role of the Sun in

Climate forcing. Danish Nat.Space Center. Scientific Report 3/07 (2007)

– Wehry, W. Einige Anmerkungen zu meteorologischen Messungen und Datenreihen. Beiträge BWK SO 22/09

– Winkler, P. Revision and necessary correction of the long-term temperature series of Hohenpeissenberg,

1781–2006- Theor. Appl. Climatol. 75 (2009)

Daten:

Den Temperaturdaten von Basel und Wien liegen die Klimareihen von F. Baur zugrunde, die im Rahmen der „Berliner Wetterkarte“ fortgeführt wurden.

Die Temperaturdaten von Prag wurden der Internet-Veröffentlichung www.wetterzentrale .de/Klima/ entnommen, erweitert durch Werte, die von der Station Prag direkt zur Verfügung gestellt wurden.

Die Temperaturreihe von Berlin entspricht den von J. Pelz auf Berlin-Dahlem reduzierten Werten ab 1701.

Die globalen Temperaturreihen basieren auf den Werten des Climatic Research Unit, UK.

(www.cru.uea.ac.uk/cru/data)

Die Sonnenfleckenzahlen entstammen den Veröffentlichungen von NOAA

(ftp:/ftp.ngdc.noaa.gov/STP/SOLAR_Data/Sunspot_Numbers/Monthly/)

Die Sonnen vor 1749 wurden verschiednen Quellen entnommen (u.a.Waldheimer,M.:The sunspot activityin the years 1610-1960 (Zürich 1961), Schove, D.J.:Snspot cycles (Hutchinson Stroudsburg 1983), Schönwiese,C.D. Klimatologie (UTB 1994)

Die ONI-Daten (Oceanic Nino Index) basiern auf: ftp:/www.cpc.ncep.noaa.gov/products/analysis/