Mit der Veröffentlichung der E-Mails und Daten aus der etablierten Klimaforschung wurde deren Brisanz für die Glaubwürdigkeit des Weltklimarates sowie seiner bisherigen Aussagen zur Erderwärmung nebst angeblicher Folgen international rasch klar: USA und UK setzten Untersuchungs-Kommissionen ein[1], in den internationalen Medien wurde ausführlich und kritisch berichtet. Ganz anders zunächst nicht in Deutschland, weshalb das P.T.-Magazin für Wirtschaft, Politik und Kultur[2] schrieb: “Der größte Wissenschaftsskandal aller Zeiten bringt das Lügengebäude der CO2-Ideologen endgültig zum Einsturz – und die deutschen Massenmedien ducken sich feige weg ! Während die selbsternannten Qualitätsmedien hierzulande also vom Verschweigen zum Verharmlosen übergingen, beherrschte die Titelseiten und Hauptnachrichtensendungen in Großbritannien und den USA längst nur noch ein Schlagwort: Climategate! Die Anlehnung an Watergate, den größten Skandal der amerikanischen Geschichte, zeigt, dass es sich hier wohl doch um etwas mehr als einen “gewöhnlichen“ Hackerangriff handeln mußte.“

Immerhin räumte dann nach einigen Tagen auch der SPIEGEL[3] ein:

“Cyberkrieg unter Klimaforschern: Zwei Wochen vor dem Klimagipfel in Kopenhagen bringen Hacker prominente Wissenschaftler in Erklärungsnot…“. Der SPEGEL berichtet dann weiter über Mail-Inhalte mit peinlicher Kollegen-Verleumdung, Andeutungen zu Daten-Manipulationen, Journalisten-Schelte und Ausgrenzung von anders denkenden Wissenschaftlern. Der SPIEGEL: “In einer Mail aus dem Jahr 1999 erklärt ein Forscher des Klimainstituts an der Universität von East Anglia, er habe den ’Trick’ eines US-Kollegen angewendet, um in einer Grafik den Rückgang der Temperaturen zu verbergen. Ein Klimatologe … beklagt sich …, es sei ein Hohn, dass man den gegenwärtigen Stillstand bei der Erwärmung nicht erklären könne.“ Genannt wird auch der US-Forscher Patrick Michaels, der seit Jahren die Position vertritt, dass der Klimawandel nicht so drastisch ausfallen werde, wie vom Mainstream der Klimatologen prognostiziert, mit der Aussage über die IPCC-Daten-Manipulation: “Das ist nicht nur eine rauchende Waffe, sondern ein wahrer Atompilz".

Der Kopenhagen-Gipfel scheitert

Drei Wochen nach dem ClimatGate palaverten einige Zehntausend Politiker, Wissenschaftler, Journalisten, Lobbyisten … in Kopenhagen 10 Tage lang, produzierten alleine bei An- und Abreisen Tausende Tonnen an CO2 sowie vor Ort große Mengen an Weltrettungs-Appellen und heißer Luft, und am 18. Dezember war alles zu Ende. Das beschrieb die Züricher Weltwoche[4] so: “Das Scheitern des Weltklimagipfels in Kopenhagen ist ein historischer Einschnitt, der das Ende der Klimahysterie einläutet…“ … “Die größten Verlierer von Kopenhagen scheinen die Klimaforschung und die wissenschaftlichen Eliten zu sein, die, mit wenigen Ausnahmen, seit Jahr und Tag eine umfassenden Klimahysterie gefördert haben. Es besteht kein Zweifel mehr daran, daß die meisten Regierungen das Vertrauen in die Prognosen und Forderungen der Klima-Alarmisten verloren haben.“ Weiter wird dann a.a.O. ausgeführt, daß die Klimaforschung auch wegen ClimatGate, dem Stillstand der Erderwärmung und des ’tollen Treibens führender Wissenschaftler hinter den Kulissen’ in einer schweren Glaubwürdigkeits-Krise steckt.

Die FAZ[5] schrieb zu der übertriebenen deutschen Wichtigtuerei in Kopenhagen:“Die deutschen Konferenzteilnehmer mussten sich anhören, dass die Erderwärmung nach Krieg, Wirtschaftskrise und Atomtod die neueste Projektionsfläche der “German Angst“ sei …“

Der Gletscher-Schwindel

Nach Kopenhagen wurden nahezu im Wochen-Takt mehr als ein Dutzend Fehler, Schlampereien und Manipulationen in den Berichten des IPCC aufgedeckt. Es begann mit GletscherGate : "…Sehr wahrscheinlich sind die Gletscher des Himalaya schon bis 2035 verschwunden…“ ist beim IPCC[6] zu lesen.

Dazu DER SPIEGEL[7]: “Klimaforscher in Erklärungsnot: Das Uno-Wissenschaftlergremium IPCC hat das Verschwinden der Himalaja-Gletscher bis 2035 vorausgesagt – aber das beruht offenbar auf peinlichen Fehlern.“ In der Tat, denn die IPCC-Quelle war ein WWF-Interview mit einem indischen Gletscher-Forscher, publiziert 1999 in einem populärwissenschaftlichen Magazin. Sowohl die Quelle als auch die Aussagen haben sich mittlerweile als unbrauchbar erwiesen. Schlimmer noch: Die Zahl 2035 ist ein “Zahlendreher“ aus einer lediglich groben Abschätzung aus dem Jahre 1996(!) von dem russischen Forscher Wladimir Kotlyakov ;

d o r t steht allerdings 2350 !

Diametral zu den IPCC-Aussagen erklärt das Indische Umweltministerium3: “Viele indische Himalaja-Gletscher sind in den letzten Jahren stabil, oder vergrößern sich, die Schrumpfrate vieler anderer hat sich verringert.“

Daß im IPCC auch ideologische Komponenten eine breite Basis haben, das deckt DIE ZEIT[8] auf. Danach sagte der für das IPCC-Asien-Kapitel zuständige Forscher MURAI LAL zur fehlerhaften 2035er-Prognose: “Es hatte mit den Ländern der Region und ihrer Wasserversorgung zu tun. Wir dachten, wenn wir das hervorheben können, wird das Politiker zu konkreten Maßnahmen ermuntern“. So etwa ist unvereinbar mit dem Objektivitäts-Anspruch der Wissenschaft, wie auch die ZEIT anmerkt.

Nun versuchten anfangs deutsche Medien und einige medien-bekannte deutsche Klima-Professoren die Angelegenheit herunter zu spielen, nach dem Motto: Ein Zahlendreher kann ja jedem mal passieren. Jedoch gerieten sie rasch in die Defensive, denn jetzt wurden monatelang nahezu im Wochen-Takt ständig neu “Pleiten, Pech + Pannen“ des IPCC offenbart.

Zunächst eine weitere “Gletscher-Panne“ (31.01.2010)[9]: “Der IPCC hatte in dem Bericht die schmelzenden Gletscher in den Alpen, den Anden und in Afrika auf den Klimawandel zurückgeführt. Der Sunday Telegraph berichtet, die darin gemachten Aussagen stützten sich vor allem auf einen Artikel, der in einem Alpin-Magazin erschienen war und sich seinerseits auf Beobachtungen bei Bergtouren bezog.“ An anderer Stelle wurde aus der Arbeit eines Geographiestudenten der Universität in Bern zitiert, der Bergführer in den Alpen interviewt hatte. Folglich: Sowohl die Quellen des IPCC als auch dessen Aussagen sind hier unbrauchbar.

Falsche Sturm-Prognosen

Immer wieder wird behauptet und von den Medien sensationell aufgemacht, daß mit der Erderwärmung des letzten Jahrhunderts Stürme zugenommen hätten und weiter zunehmen werden. Auch das ist, wie sich nun herausstellt, eine unbewiesene und sogar manipulierte IPCC-Behauptung, wie die Sunday Times[10] am 23.01.2010 berichtete: “IPCC/AR4 claimed that global warming is causing increases in property losses….“ …und der aktuelle Stand: “We find insufficient evidence to claim a statistical relationship between global temperature increase and catastrophic losses“.

Und dazu die FAZ[11]: “Der Weltklimarat soll wider besseres Wissen einen Zusammenhang zwischen der Erderwärmung und den (Anm.: angeblich!!) immer häufiger vorkommenden und verheerender wirkenden Wirbelstürmen und Überflutungen hergestellt haben.“ Es stellte sich heraus, daß das IPCC nur Erkenntnisse berücksichtigte, welche die These eines Zusammenhangs zwischen Erwärmung und Stürmen stützen. Mittlerweile – drei Jahre nach Veröffentlichung des jüngsten IPCC-Berichtes – sagt der Chef des Hamburger Climate Service-Centers, Guy Brasseur[12] : “Die IPCC-Wissenschaftler sind sich einig: Es gibt nicht mehr Stürme als früher. Allenfalls ist ihre Intensität klimabedingt leicht gestiegen, doch das ist noch nicht bewiesen“ – welche eine Einsicht plötzlich, denn nun bringt offensichtlich auch das IPCC seine Meinung in Übereinstimung mit den Erkenntnissen der weltweiten Wetterdienste[13] !

AmazonasGate

Im IPCC-Bericht (2007, Ch.13, WGrII) steht[14] , daß die anthropogene Erderwärmung zum Verschwinden von 40% des Amazonien-Regenwaldes führt. Dazu ist zu lesen[15]:

“Am 25.1. wurde dann enthüllt, daß auch die Behauptung, durch den Klimawandel könnten 40% der Amazonas-Regenwälder verschwinden, nicht wissenschaftlich begründet war. Im 13. Kapitel der Arbeitsgruppe II des IPCC-Berichtes von 2007, das auch den erwähnten Himalaja-Schwindel thematisiert, behauptete der IPCC: Bis zu 40% der Amazonaswälder könnten bereits auf einen geringen Rückgang der Niederschläge [durch globale Erwärmung] dramatisch reagieren, und dann wäre es wahrscheinlicher, daß Wälder durch Ökosysteme… wie tropische Savannen ersetzt werden“. Dazu berichtete der britische Internetblog EUReferendum am 25.1., daß der einzige “Beleg“ für diese Behauptung über das Verschwinden der Amazonaswälder ein Bericht der Umweltorganisationen WWF und IUCN sei, verfaßt von einem freien Journalisten/Aktivisten sowie einem Koordinator verschiedener WWF-Projekte über Waldbrände in Australien und Afrika. Die beiden Autoren sind also keine Wissenschaftler. Aber mehr noch, laut EUReferendum wird in ihrem Bericht an keiner Stelle behauptet, daß 40% der Regenwälder des Amazonas verschwinden könnten, wie es beim IPCC heißt. Übrigens: In diesem WWF-Bericht geht es nicht um Klimaänderungen, die den Amazonas-Urwald schädigen, sondern um die Zerstörung dieses Lebensraumes durch Holzeinschlag und Brandrodung! Was für ein Schwindel in dem IPC-Bericht!

IPCC-Temperaturen manipuliert

Von den US-Wissenschaftlern D’Aleo und Watts liegt eine 111-seitige Studie[16] mit dem Titel "Aufzeichnungen der Oberflächen-Temperaturen : Politisch betrieben Täuschung?" vor.

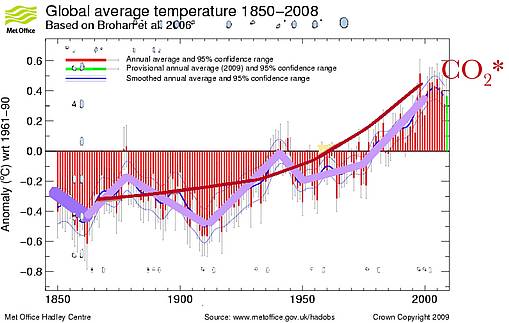

Die Autoren schreiben in der Einführung, daß “ … jüngste Enthüllungen, die sich aus den ClimateGate-E-Mails der Klima-Forschungs-Abteilung der Universität von East Anglia ergeben, zeigen, wie sehr angesehene Daten-Zentren, wie NOAA und NASA, sich dazu verabredet haben, die weltweiten Temperaturaufzeichnungen zu manipulieren, um den Eindruck zu erwecken, dass die Temperaturen im 20. Jahrhundert schneller angestiegen seien, als sie es tatsächlich taten.“ Der hier zitierte Bericht stellt einige der alarmierenden

Entdeckungen zusammen, z.B.: "Temperaturmessungen der Vor-Satelliten-Zeit (1850-1980) wurden so weitgehend, systematisch und gleichgerichtet gefälscht, dass nicht glaubwürdig behauptet werden kann, es habe im 20. Jahrhundert eine deutliche globale Erwärmung gegeben." Die Manipulation wurde auf unterschiedliche Weise vorgenommen, beispielsweise bei der Berechnung der Durchschnittstemperatur einer Region durch das Weglassen der Daten von Stationen auf “kalten Standorten“ oder das unsachgemäße Einrichten von Stationen auf “warmen Standorten“. Beide Arten der Manipulation täuschen eine wärmere Temperatur vor. Von den ca. 6000 Stationen wurden ab den späten 1980er und in den frühen 1990er Jahren die Daten von ca. 4500 Stationen bei der Berechnung der Durchschnittstemperaturen nicht mehr berücksichtigt – sie wurden “ausgesondert“ (Abbildung 1). Aus der Studie geht allerdings im Detail nicht hervor, welche dieser Stationen still gelegt wurden, und welche weiter verfügbar waren, aber trotzdem nicht mehr berücksichtigt wurden.

Phil Jones: AGW möglicherweise ein Konstrukt !

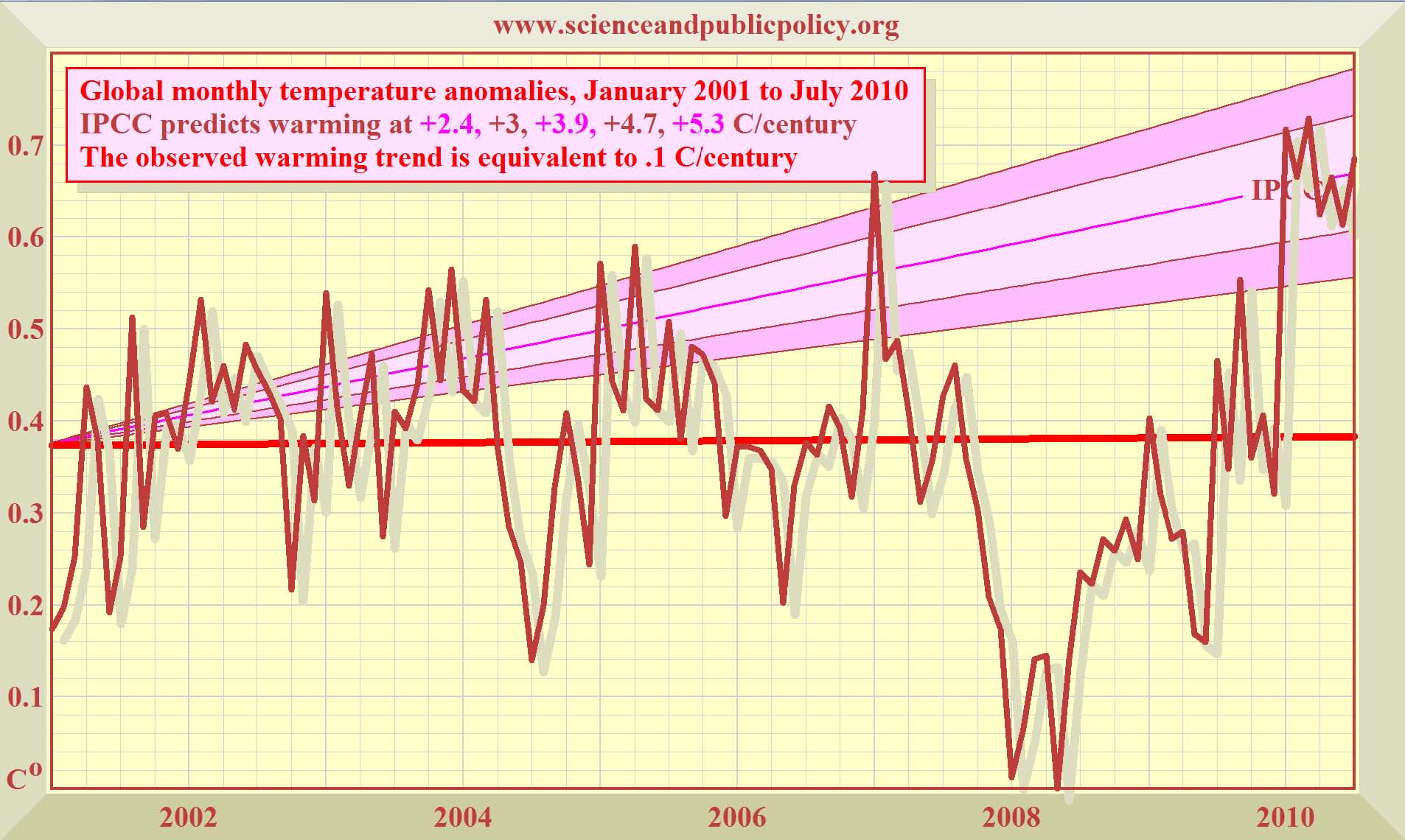

Nach diesen erdrückenden Hinweisen, daß die von den US-Amerikanischen Instituten für das IPCC erstellten Temperatur-Meßreihen mit großer Wahrscheinlichkeit in Richtung Anthropogen Global Warming (AGW) manipuliert wurden, kann es kaum noch überraschen, daß dieses auch für die IPCC-Reihe der englischen Institute HADLEY und CRU/UEA gilt. Das gestand der zurückgetretene CRU-Chef Prof. Phil Jones zumindest im BBC-Interview am 13.02.10 dann auch ein[17]:>“… he said that for the past 15 years there has been no ‘statistically significant’ warming…” und weiter a.a.O. ”… Professor Jones also conceded the possibility that the world was warmer in medieval times than now – suggesting global warming may not be a man-made phenomenon….”

F a z i t : Die bisher vom IPCC verwendeten Temperatur-Reihen zum Beweis einer mensch-gemachten Erderwärmung sind manipuliert, diskreditiert und für eine AGW-Aussage unbrauchbar!

Bodenerosion + Mißernten in Afrika ?

Zu entsprechenden Behauptungen und Berichten des IPCC schreibt die Züricher Weltwoche[18]: “In der Zusammenfassung für politische Entscheidungsträgervon 2007 können die politischen Entscheidungsträger Folgendes lesen: Durch Klimaschwankungen und -änderungen werden für viele Länder und Regionen Afrikas schwerwiegende Beeinträchtigungen der landwirtschaftlichen Produktion – einschließlich des Zugangs zu Nahrungsmitteln – projiziert . . . In einigen Ländern könnten sich die Erträge aus der vom Regen abhängigen Landwirtschaft bis 2020 um bis zu 50 Prozent reduzieren“. Nun führt die Weltwoche im weiteren aus, wie erbärmlich und manipuliert die Quellen sind. Der marokkanische Beamte Ali Agoumi hat ein Exposè erstellt, aus einen Bericht der marokkanischen Regierung, in dem bis 2020 von einem erwarteten Rückgang der Getreideerträge um 50 Prozent in trockenen und 10 Prozent in normalen Jahren die Rede ist. Ein gleichzeitig von der algerischen Regierung veröffentlichter Bericht rechnet für 2020 jedoch nicht mit einem Rückgang, sondern mit einer Verdoppelung der landwirtschaftlichen Produktion, räumt jedoch ein, dass wegen der erwarteten Klimaerwärmung der Getreideertrag pro Hektar zwischen 5,5 und 6,8 Prozent weniger betragen könnte. Die Weltwoche deckt auf:

“Aus den drei Berichten pflückt Agoumi eine einzige besonders alarmierende Voraussage heraus – Rückgang der Getreideerträge um 50 Prozent in trockenen Jahren in Marokko. Die Leitautoren der IPCC-Zusammenfassung übernehmen diese Voraussage ungeprüft und machen aus einem Land (Marokko) einige Länder.“

Die Wüste lebt !

Genau so wenig, wie Nordafrika verdorrt, so wenig stimmen auch die IPCC- und Medien-Aussagen über eine angeblichen Wüsten-Ausdehnung (Desertifikation). Dazu berichtet das Magazin National Geographik[19] : “Wüstenausdehnung, Trockenheit und Verzweiflung, das ist es, was die Erderwärmung bereit hält für die meisten Teile von Afrika – zumindest ist es das, was wir hören. Die sichtbar werdenden Tatsachen zeichnen eine sehr viel differenziertes Bild – eines, in welchem steigende Temperaturen eine Wohltat sein kann für Millionen von Afrikanern in den trockensten Gebieten des Kontinents … Wissenschaftler sehen jetzt Signale, daß die Sahara und die angrenzenden Regionen ergrünen aufgrund zunehmenden Regens.“

Zum gleichen Ergebnis kommt das ZDF-Magazin[20] “Abenteuer Wissen“ (Abbildung 3) : "… Die Sahara nämlich wird feuchter und damit grüner werden als sie heute ist. Beweise dafür liefert die Wüste selbst – mitten in Libyen". Daraus ergibt sich schon jetzt als Resultat[21] eine Ausweitung der Grünfläche zu Lasten der Wüste Sahara. Diese schrumpfte in den letzten 20 Jahren um ca. 300.000 km2 , ein Gebiet fast so groß wie Deutschland (357.000 km2).

Noch weitreichender sind die positiven Veränderungen hinsichtlich eines Ergrünens im Süden der Sahara im afrikanischen Armenhaus SAHEL, wie der SPIEGEL berichtet[22]: “Ground Zero ergrünt: Dürren, Hunger, Wüstenbildung – die Sahelzone gilt als Inbegriff einer Katastrophenregion. Nun gibt es gute Nachrichten: Viele Millionen Bäume wachsen in kargem Sandboden heran…. Auch seriöse Organisationen behaupten immer wieder, dass sich die Sahara Jahr für Jahr weiter nach Süden frisst, aber das stimmt so nicht. Seit 20 Jahren kommen allein im Niger jedes Jahr etwa eine viertel Million Hektar Baumbestand dazu.“ Das sind etwa 5 Millionen Hektar in den 20 Jahren, und abgeschätzt für die gesamte SAHEL-Zone etwa 300.000 km2.

Falsche Meeres-Spiegel-Angaben bei IPCC

Das IPCC droht immer wieder mit spektakulären Anstiegen des Meeres-Spiegels, hat aber seine Prognosen für die nächsten 100 Jahre mehr und mehr an die Realität angepaßt[23]: Von im Mittel 180 cm im IPCC-Bericht 1990 auf im Mittel 38 cm im IPCC-Bericht 2007. Nun stellt sich heraus, daß selbst die bisher vom IPCC genannte Zahl des gemessenen globalen Anstieges des Meeresspiegels für das 20. Jahrhundert von 18 cm falsch ist, nämlich deutlich zu hoch: Eine Überprüfung[24] von 159 Pegeln ergibt nur rund 8 cm : “Abstract:? ?159 tide stations with long (avg. ~85 year) mean sea level (MSL) measurement records make up the GLOSS-LTT designated tide stations for monitoring sea level trends around the world. A spreadsheet containing the MSL trend data for those stations is available on the noaa.gov web site. I downloaded it and used the data to check the IPCC’s claim that sea levels rose 18 cm during the last century (a rate of 1.8 mm/year).? ?I averaged the tide station data several different ways and found that the IPCC’s claimed 1.8 mm/year rate of MSL rise exaggerates the actual, measured>rate of MSL rise by more than 50%.“ Die immer wieder behauptete Beschleunigung des Meeresspiegel-Anstieges aufgrund der etwa dreiviertel Grad Erderwärmung innerhalb der vergangenen 150 Jahren existiert offensichtlich nur in den Computern.

Holland unter Wasser ?

In dem Zusammenhang wurden nun beim IPCC auch völlig unsinnige Behauptungen und Fehler hinsichtlich einer Überflutung der Niederlande aufgedeckt[25]: “Im IPCC-Bericht heißt es: Die Niederlande sind das Beispiel dafür, daß das Land sowohl von der Steigung des Meeresspiegels als auch durch Überschwemmungen der Flüsse gefährdet ist, denn 55% des Landes liegen unter dem Meeresspiegel. Das ist aber völlig falsch…“.

Gegen diese unsinige IPCC-Behauptung wehren sich nun auch die Holländer[26] :

“The Netherlands has asked the UN ?climate change panel to explain an inaccurate claim in a landmark ?2007[27] report that more than half the country was below sea level, the ?Dutch government said Friday.?According to the Dutch authorities, only 26 percent of the ?country is below sea level …

Bangladesch contra IPCC

Seit Jahren hört man vom IPCC und seinen Instituten Horror-Prognosen zu überfluteten Küsten in aller Welt, insbesondere auch zu Bangladesch[28]:“…IPCC hat den Untergang von Bangladesch vorhergesagt, … den Verlust von 17% seiner Landmasse bis 2050 aufgrund des Meeresspiegel-Anstieges infolge der globalen Erwärmung“ … “das Nobel-Preis-Träger-Gremium sagt, daß 20 Millionen Menschen in Bangladesch bis 2050 zu Umweltflüchtlingen werden, und daß das Land 30% seiner Nahrungsmittel-Produktion verlieren wird“, und weiter a.a.O.: “Der Direktor des NASA-Goddard-Instituts James Hansen zeichnet ein noch grauenhafteres Bild mit der Vorhersage, das ganze Land könnte bis zum Ende des Jahrhunderts unter Wasser stehen“. Die Reihe derartiger Zitate ließe sich hier beliebig fortsetzen – jedoch: Die Realität sieht offensichtlich und glücklicherweise(!!) ganz anders aus, wie die hier zitierte und kürzlich in Dhaka vorgestellte Studie zeigt, mit der sich Bangladesch gegen das IPCC zur Wehr setzt (a.a.O.) :“Neue Daten zeigen, daß Bangladesch’s Landmasse zunimmt, im Gegensatz zu den Vorhersagen, daß diese südasiatische Nation bis Ende des Jahrhunderts unter den Wellen verschwindet, wie “Experten“ behaupten.“ Und weiter wird dort ausgeführt, daß Wissenschaftler des Instituts für Umwelt und Geographie Dhaka Satelliten-Daten der letzten 32 Jahre ausgewertet haben und sagen, daß Bangladesch’s Landmasse in dieser Zeit jährlich um 20 km2 zugenommen hat, und daß seit 1973 rund 1000 km2 Land aus dem Meer entstanden sind. Dafür gibt es zwei Gründe:

(1) Die beiden großen Ströme Brahmaputra und Ganges transportieren ständig große Mengen Schwebestoffe stromabwärts, die sich im Delta ablagern,

(2) Die vom IPCC seit 15 Jahren prognostizierte Beschleunigung des Meeresspiegel-Anstiegs findet nicht statt, sondern der Anstieg verlangsamt sich weltweit (s.w.o.). Und so wird denn auch in Bangladesch umfassend “Entwarnung gegeben“ (a.a.O.):

"Seit mindestens 10 Jahren haben wir ’Experten’ sagen hören, Bangladesch wird unter Wasser sein, aber – völlig andersartig – zeigen unsere Daten nichts dergleichen“ … "einen natürlichen Landzuwachs hat es im Bereich des hiesigen Mündungsbeckens seit Hunderten von Jahren gegeben, und alle unsere Modelle zeigen, daß es für Jahrzehnte und Jahrhunderte so weiter geht“.

Man kann nur hoffen, daß der in Bangladesch Raum greifende Realitätssinn gegenüber dem vom IPCC geschürten Klima-Katastrophismus recht bald auch in Europa angelangt.

Arten-Sterben durch Klima: ein IPCC-Konstrukt

Und weiter gehen die IPCC-Flops, denn die Presse[29] berichtet :“Erneut irrt der vermeintlich unfehlbare Weltklimarat. Entgegen seinen Schreckensszenarien für die Tier- und Pflanzenwelt kommen immer mehr Wissenschaftler zu anderen Ergebnissen. Die Anpassungsfähigkeit der Natur scheint größer als vermutet. Klimapolitiker wollen davon aber nichts wissen“ …

“Im vierten und jüngsten Sachstandsbericht des IPCC aus dem Jahr 2007, der die Grundlage der Konferenz in Kopenhagen bildete, wird vorausgesagt, dass durch globale Erwärmung ein Fünftel der Tier- und Pflanzenarten weltweit verschwinden könnte“. Die Berliner Morgenpost berichtet nun weiter über eine Studie britischer Ökologen über drei Vogelarten, die nach der Roten Liste der Weltnaturschutzunion (IUCN, 2008) als wahrscheinlich in den vorangegangenen 10 Jahren ausgestorben geführt wurden:>’Die Indizien für klimatische Ursachen des Aussterbens wurden übertrieben’.

Und weiter a.a.O.: “Dass wärmere Temperaturen zu einem Rückgang der Artenvielfalt führten, sei keine plausible Prognose, findet auch der Ökologe Prof. Josef Reichholf von der Zoologischen Staatssammlung München. Artenverluste in beträchtlichem Umfang haben die Kaltzeiten gebracht – nicht die Warmzeiten“.

Und weiter berichtet die Berliner Morgenpost über einen CO2-Langzeitversuch des Bundesforschungsinstituts für Ländliche Räume in Braunschweig “Das Gegenteil eines Katastrophenszenarios für die Landwirtschaft ergibt sich … : Bei einem CO2-Gehalt, der den Voraussagen für das Jahr 2050 entspricht, wuchsen die Ackerpflanzen besser und benötigten deutlich weniger Wasser.“

CowGate: Fleischessen als Klima-Killer?

Der Begriff "CowGate" wurde von "The Washington Times" am 23. März 2010 geprägt[30],

anlässlich der Veröffentlichung eines Forschungsberichts zur Frage der Treibhausgas-Emissionen durch die Tierhaltung, erstellt von Dr. Frank Mitlöhner von der University of California. Mitlöhner entlastete durch seine Studie die Tierhaltung, die durch den FAO-Bericht aus dem Jahre 2006 mit dem Titel[31] ‚Livestock’s Long Shadow‘ und durch den jahrelangen weltweiten Medienrummel um diesen Bericht als Urheber erheblicher Umweltverschmutzung und vor allen Dingen als Quelle von weltweit 18% der anthropogenen Treibhausgasemissionen sehr in Misskredit geraten war (Schlagwort Meat = Heat). So lautete eine FAO-Behauptung, daß die THG-Emissionen der Tierhaltung diejenigen des Transportsektors überstiegen.

Mitlöhner rechnete nun mit diesem FAO-Bericht ab: "Weniger Fleisch- und Milchproduktion würde nur den Hunger in armen Ländern fördern. Die Tierhaltung für die globale Erwärmung verantwortlich zu machen, ist wissenschaftlich nicht haltbar, und nur eine Ablenkung von wichtigeren Dingen". Die Treibhausgasemissionen aus der Tierhaltung in den USA, deren Fleisch- und Milchproduktion übrigens den Eigenbedarf übersteigt, machten nur 3%, diejenigen aus dem Transportsektor aber 26% aus. Der Begriff Cowgate wurde inzwischen von verschiedenen internationalen Zeitungen und Zeitschriften aufgegriffen.

Hockey-Stick: Uraltlast des IPCC

Daß beim Weltklimarat IPCC im Sinne eines zu vermittelnden “Anthropogen Global Warming“ (AGW) schon lange vor ClimateGate manipuliert wurde, dafür gab es schon früher Anhaltspunkte. Von Michael Mann wurde um das Jahr 2000 eine Temperatur-Kurve konstruiert, die offensichtlich verbergen sollte, daß es im Mittelalter über ca. zwei Jahrhunderte deutlich wärmer war als heute[32]> – ohne anthropogenes CO2 !

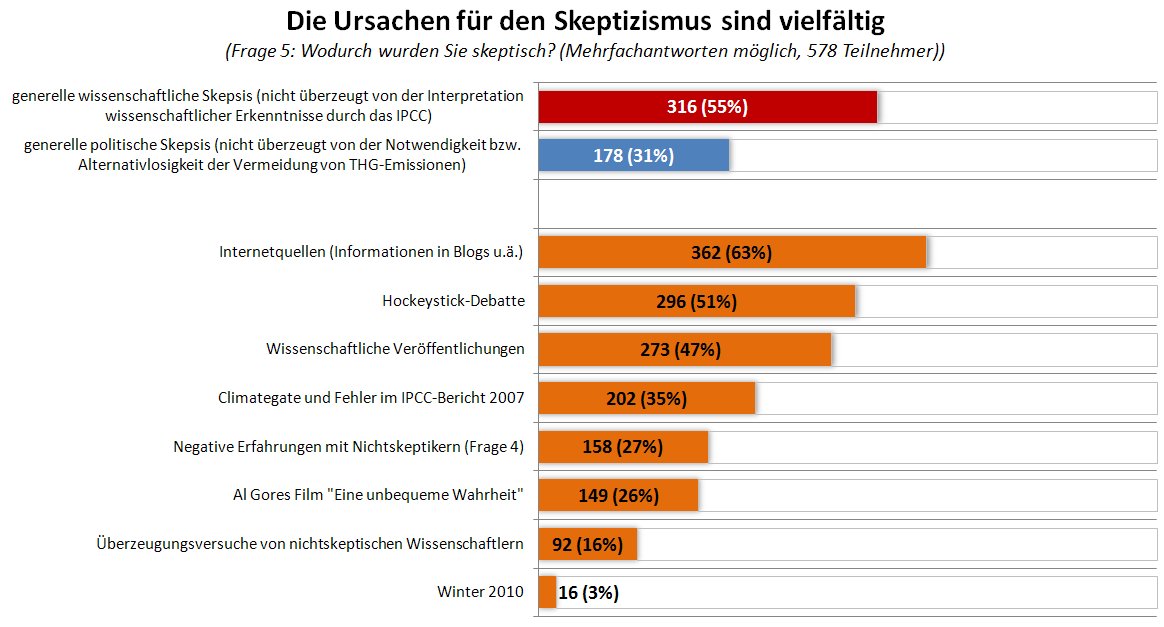

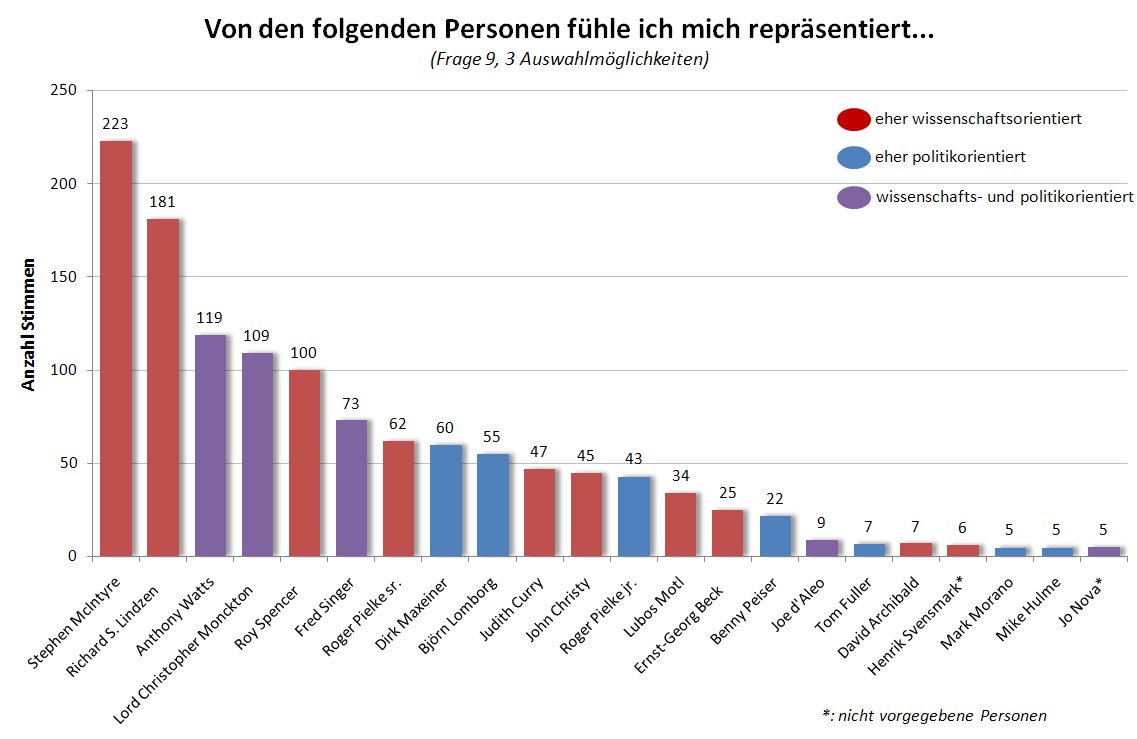

Diesen ersten großen IPCC-Skandal beschreibt der Delfter Geologie-Professor Salomon Kronenberg[33] wie folgt: “Ein Teil der alarmierenden Vorstellung geht auf die Rechnung des IPCC, insbesondere auf den hohen Stellenwert, den die Hockeystick-Kurve im TAR von 2001 bekommen hat. Diese Kurve suggeriert, die globale Durchschnittstemperatur sei in den letzten Tausend Jahren nahezu konstant geblieben und erst mit Beginn des Industrie-Zeitalters angestiegen. Keine Mittelalterliche Warmzeit, keine kleine Eiszeit lässt sich aus dieser Kurve ablesen. Es liegt auf der Hand, daß man dann denkt: Wenn wir kein Kohlendioxid mehr ausstoßen, kehrt das Klima von alleine wieder zu seinem früheren Zustand zurück. Sechs Jahre lang war die Kurve der am meisten umstrittene Bestandteil des Berichtes, und sechs Jahre lang hat sich das IPCC daran festgeklammert. Tausende von Klimawissenschaftlern des IPCC konnten sich nicht irren.“ Kronenberg beschreibt nun n seinem Buch den Fortgang der Geschichte: Im vierten IPCC-Bericht (2007) ist die Kurve lautlos verschwunden. Nur noch einen “einen verschämten Hinweis“ findet man, daß einige neue Untersuchungen auf eine größere Variabilität des säkularen Temperaturganges der Nordhalbkugel hinweisen. Kronenberg weiter: “Das IPCC hat die Kleine Eiszeit entdeckt! Was Tausende von Nicht-IPCC-Wissenschaftlern schon wußten, das ist nun auch zu den Klimatologen durchgedrungen. … Inzwischen haben die kanadischen Outsider Stephen McIntyre und Ross McKitrick die Daten Manns kritisch durchgerechnet. Sie kommen zu einer ganz anderen Kurve, in der die mittelalterliche Warmzeit sogar wärmer ist als das 20. Jahrhundert. Sie weisen nach, daß Mann bewusst Werte, die dem Hockeystick-Modell widersprachen, aus seinem Datenbestand heraus gelassen und unerlaubte statistische Prozeduren angewandt hat, um das gewünschte Ergebnis zu erhalten.“ Übrigens: Der Hockey-Kurven-Erfinder Michael Mann ist von der Liste der IPCC-Autoren verschwunden!

Nobelpreis-Juror: Distanzierung vom IPCC

Es mehren sich die Zweifel an der Entscheidung, daß IPCC und AlGore den Friedensnobelpreis zuerkannt bekamen. Dazu berichtete die Süddeutsche Zeitung[34] :

“Ein führender Juror für wissenschaftliche Nobelpreise hat sich vom Weltklimarat IPCC distanziert. Der Chef der Königlich-Schwedischen Wissenschaftsakademie, Gunnar Öquist, sagte am Dienstag in der Zeitung Svenska Dagbladet : Die Vereinten Nationen müssen jetzt die Arbeit des Klimarates unter die Lupe nehmen und Konsequenzen ziehen.“ Öquist erläuterte seine Entscheidung damit, daß zunehmend fehlerhafte Prognosen des IPCC über den Klimawandel bekannt geworden seien. Er übte auch Kritik an übereilten Schlußfolgerungen des IPCC, sowie an dessen Verwendung unwissenschaftlicher Quellen.

IPCC und UN : Die Reihen lichten sich

Schon wenige Tage nach dem Beginn des ClimateGate-Skandals war der Chef des IPCC-nahen Klima-Institus der Universität von Ost-England, Prof. Phil Jones, zurück getreten (s.w.o.). Am 18. Februar 2010 trat dann der Chef des UN-Klima-Büros, Yvo de Boer, zurück[35]:“Der oberste Klimaschützer der Vereinten Nationen ist nach dem gescheiterten Klimagipfel in Kopenhagen vor zwei Monaten tief frustriert. Gestern warf er das Handtuch. …. Kopenhagen war eine Katastrophe“.

Diese Einschätzung muß man nicht teilen. Bedenkt man, welche Belastungen aufgrund offensichtlich unzureichender Modelle und falscher Schlußfolgerungen des IPCC sich z.B. mit dem CO2-Ablaßhandel schon jetzt für Bürger und Volkswirtschaften ergeben, so kann sich Kopenhagen im Nachhinein als Glücksfall erweisen, weil zunächst weitere Abgaben und Steuern vermieden werden, weltweit!

Auch die Forderungen nach dem Rücktritt des IPCC-Chefs Rajendra Pachauri schwellen international an wie eine Flut, und selbst in Deutschland ist zu lesen[36]: “Der Ökonom (Anm.: Pachauri) ist zur Belastung geworden. Er steht im Verdacht, wissenschaftliche, politische und geschäftliche Interessen unzulässig zu vermischen. So hat Pachauris Institut Teri mit Sitz in Indien an der falschen Gletschervorhersage gut verdient und beträchtliche Forschungsgelder der EU kassiert“ …und weiter a.a.O.: “… Pachauri ist nicht der einzige, der Spekulation zur Wahrheit aufmotzt, um politischen Druck für die gute Sache zu erzeugen. Im Weltklimarat macht sich seit Jahren die unselige Tendenz breit, den mensch-gemachten Klimawandel zum Dogma zu erheben. Wer die beherrschende Lehre vom nahenden Weltuntergang hinterfragt, wird als Leugner abgestempelt. Offenheit für Querdenker sucht man vergeblich. Es ist an der Zeit für einen Neuanfang. Der Weltklimarat braucht dringend einen Klimawandel, wenn Forschung nicht zum Religionsersatz verkommen soll.“

Und selbst ehemalige Weggefährten setzen sich ab[37]: “Der Uno-Klimarat ist wegen falscher Prognosen heftig in die Kritik geraten. Damit gefährde er die Glaubwürdigkeit der gesamten Klimawissenschaft, warnen die Forscher Richard Tol, Roger Pielke und Hans von Storch. Sie verlangen eine Reform des Gremiums – und den Rücktritt seines Chefs Pachauri“.

Allerdings – es wirkt jetzt schon etwas grotesk, daß ausgerechnet auch der Potsdamer Professor Schellnhuber, im jahrelangen engen Schulterschluß mit IPCC und Pachauri einer der weltweit exzessivsten Katastrophen-Verkünder, nun dessen Rücktritt fordert[38]:“… im Interesse des IPCC und seiner eigenen Person sollte er nun den Vorsitz abgeben“. Im Schachspiel nennt man das ein “Bauern-Opfer“, um den “König“ zu retten. Genau so seltsam ist es, daß dieser PIK-Professor nun plötzlich auch das Auswahl-Verfahren des IPCC kritisiert (a.a.O.): “Aber mit diesem Verfahren kommen nicht immer die besten Forscher zum Einsatz.“ Schließlich: Kaum jemand hat sich jahrelang mit weitreichenden Beeinflussungs-Versuchen so stark in die Politik eingemischt wie Herr Schellnhuber. Ausgerechnet der fordert nun (a.a.O.): “Die Politik muß sich aus der Klimaforschung raushalten“.

Wer nun weiterhin Pachauri folgt, gerät in Bedrängnis. Das weiß auch die BILD-Zeitung[39]: “Zwar sind Hunderte von Wetterforschern und Meteorologen der Ansicht, daß Pachauris Theorie zweifelhaft sei. Aber ihre Erkenntnisse sind zerplittert und haben einstweilen keine Chance, sich gegen den mächtigen Weltklimarat durchzusetzen. Eines der Kabinette, das dem Inder Rajendra Pachauri in dessen Feldzug gegen CO2 ergeben folgt, ist die Bundesregierung der Kanzlerin Angela Merkel. Was sie sich davon verspricht, ist nicht erkennbar.“

Demgegenüber hat es in England, Australien und vor allem in den USA bezüglich der AGW-Hypothese innerhalb eines Jahres einen einschneidende Sinnes-Wandel gegeben[40]: “In der amerikanischen Klimadebatte haben die Skeptiker die Diskurshoheit erobert. … auch in Politik und Wirtschaft hat es seit etwa Herbst 2008 einen Paradigmenwechsel gegeben.“

Erster IPCC-Austritt : Indien !

Ausgerechnet das Land, das seit Jahren den IPCC-Vorsitzenden stellt, ist ausgetreten aus diesem Weltklimarat. Das beleuchtet auch, wie schlecht das Ansehen von Pachauri im eigenen Land ist[41]:

“Über Jahre galten seine Wissenschaftler als das Klimagewissen der Weltgemeinschaft – doch nun steckt der Weltklimarat in einer schweren Krise. Die Glaubwürdigkeit des Gremiums ist so weit beschädigt, daß Indien die Konsequenzen zieht, und sich aus dem IPCC zurückzieht“. Dazu sagte der indische Umweltminister Ramesh dem Sender Times Now, daß man sich nicht auf den IPCC verlassen könne. Es gäbe eine klare Grenze zwischen Klima-Wissenschaft und Klima-Missionierung.

Im gleichen Zusammenhang mit dem IPCC spricht der Leiter des Instituts für Küstenforschung am GKSS in Hamburg-Geesthach, Prof. Hans von Storch (a.a.O.) , von einem “Kartell der Alarmisten“.

Die Inder sind raus, sind die Chinesen die nächsten ?

Die ZEIT[42] berichtet, daß die deutsche Industrie nach dem gescheiterten Gipfel von Kopenhagen derzeit von der Regierung eine Pause beim Klimaschutz fordert. Außerdem wird a.a.O. berichtet, daß der Chefunterhändler der chinesischen Regierung bei der UNO Mitte Januar den menschlichen Beitrag zum Klimawandel plötzlich infrage stellte. Das zeigt erneut, wie schon auf dem Klima-Gipfel in Kopenhagen, daß es Länder wie Indien und China gibt, wo die wissenschaftlichen Regierungsberater eine ganz andere Meinung zum Klimawandel haben, als z.B. in Deutschland. Und Die ZEIT berichtet weiter a.a.O., daß in den USA sich wohl bald die Bundesumweltbehörde EPA vor Gericht fragen lassen muß, wie solide die wissenschaftliche Einschätzung sei, auf deren Basis sie CO2 zum “Luftschadstoff“ erklärt hat.

IPCC: Klimaschutz-Kosten klein gerechnet

“Jetzt übt ein renommierter Wirtschaftsforscher Kritik an dem Gremium – es soll die Kosten des Klimaschutzes absichtlich klein gerechnet haben“, schreibt der SPIEGEL[43].

Dort ist weiter zu lesen, daß der renommierte niederländische Wirtschaftsforscher Prof. Richard Tol den PIK-Forscher Ottmar Edenhofer in dieser Sache frontal angreift: “Während Edenhofer die Arbeit seiner Kollegen, etwa jene zu den Himalaja-Gletschern, als schlampig bezeichnet, müsse er sich genau diesen Vorwurf selber gefallen lassen … Sie alle bewerten viel zu optimistisch, wie teuer die Klimapolitik in der Zukunft sein wird“. Der Niederländer Tol erhebt schwere Vorwürfe gegen das IPCC, indem er von bewußter Verfälschung des Wissensstandes und der Verfolgung einer poltischen IPCC-Agenda spricht. Und weiter recherchierte der SPIEGEL: “Unterstützung bekommt Tol von seinem Kieler Kollegen Till Requate, der ihm in den meisten Punkten Recht gibt. Den Ökonomie-Professor stört schon seit langem die einseitige Darstellung der Arbeitsgruppe drei des Weltklimarats, etwa dabei, wie die Kosten der Vermeidung von CO2-Emissionen unterschätzt würden.“ Offensichtlich soll Politikern und Bürgern vom IPCC suggeriert werden, daß die Kosten für den Klimaschutz gering und damit die Lasten für die Bürger erträglich seien.

Fazit:

Jeder einzelne IPCC-Flop für sich genommen mag vielleicht als Flüchtigkeits-Fehler vernachlässigbar und unwesentlich erscheinen, aber die Summe der Schlampereien, Irrtümer und Manipulationen sind ein Skandal und eine Schande für die Naturwissenschaften.

Bedenkt man die weitreichenden Schlußfolgerungen, die auf der Basis einer Fülle von IPCC-Fehleinschätzungen schon jetzt für Wirtschaft und Bürger getroffen wurden, so kann nur ein Rücktritt aller Verantwortlichen und ein völliger Neuanfang die Konsequenz sein. So schreibt die angesehene Wirtschafts-Zeitschrift CAPITAL[44]:

“Barak Obama in den USA hat inzwischen ganz andere Sorgen. Der Traum von einem möglichst globalen Emissionshandel ist ausgeträumt. … Die wissenschaftlichen Berater sind beschädigt, auf den ClimateGate-Skandal folgte jüngst noch eine Serie von Enthüllungen peinlicher Fehler im Bericht des Weltklimarates. Im Zweifel für den Alarmismus, war dort offenbar die Faustregel. Es gibt Gründe genug, jetzt neu und illusionslos nachzudenken. Und in vielen Ländern geschieht dies auch. Nur die Europäer scheinen fest entschlossen, mit demselben alten Gaul in ihre nächste heroische Niederlage zu traben. Don Quijote rides again!

Klaus Puls.

Der Artikel erschien zuerst im Magazin Laufpass unter www.laufpass.com

Die pdf version dieses Artikels finden Sie im Anhang

[1] FAZ, 24.03.2010, Weitere Kommission in “Climatgate“-Affäre

[2] http://www.pt-magazin.de/newsartikel/datum/2010/01/11/climategate/

[3] http://www.spiegel.de/wissenschaft/natur/0,1518,662673,00.html ; 22.11.2009

[4] BENNY PEISER: Kopenhagen und der Niedergang der grünen Utopie, Weltwoche Zürich, 52/2009, S.12-13

[5] FAZ, 12.02.10, Eine Ungewisse Welt, Klimaimperative und Klimakonjunktive, Eine Schadensbesichtigung nach Kopenhagen

[6] IPCC, 2007, WGr.II, Kap.10.6.2, S.493

[8] DIE ZEIT, 28.01.2010, S.33, Sp.5

[9] http://de.news.yahoo.com/2/20100131/r_t_afp_pl_other/tpl-weltklimarat-stuetzte-sich-fuer-beri-ee974b3_1.html?printer=1

[10] Sunday Times, 23.01.10;

[11] FASZ, 24.01.10, S.5

[12] DIE ZEIT, 04.03.2010, S.29

[13] Viel Wind um Nichts, LAUFPASS 21/2009, S.12-15

[14] http://blogs.telegraph.co.uk/news/jamesdelingpole/100023598/after-climategate-pachaurigate-and-glaciergate-amazongate/ , 25.01.2010

[15] http://news.eirna.com/302034/amazongate-und-gletscher-skandal-glaubwuerdigkeit-des-weltklimarats-schmilzt-dahin

[16] Joseph D’Aleo und Anthony Watts: Surface Temperature Records: Policy driven Deception? 111 Seiten in:

Science and Public Policy Institute (SPPI Original Paper), 26.Januar 2010

[17] (1)>http://www.dailymail.co.uk/news/article-1250872/Climategate-U-turn-Astonishment-scientist-centre-global-warming-email-row-admits-data-organised.html#>

(2) http://news.bbc.co.uk/2/hi/science/nature/8511670.stm

[18] WELT-WOCHE 10.02.2010, 6/2010; H.BORN: Klima – Mängel, Behauptungen, Schlampereien;

http://www.weltwoche.ch/ausgaben/2010-06/artikel-2010-06-klima-maengel-behauptungen-schlampereien.html

[19] Sahara Desert Greening Due to Climate Change?

http://news.nationalgeographic.com/news/2009/07/090731-green-sahara.html

[20] http://www.zdf.de/ZDFde/inhalt/1/0,1872,1020545_idDispatch:5236912,00.html

[21] Argus, 06.02.2007, http://www.oekologismus.de/?p=452#more-452

[22] SPIEGEL, 17/2009, S.136

[23] Anthropogener Mersspiegelanstieg – vom Konstrukt zur Panik? Nat.Rdsch. H.11/2008, S.566-574

[24] http://www.burtonsys.com/global_msl_trend_analysis.html ; Analysis of global linear mean sea level (MSL) trends,?including distance-weighted averaging

[25] HAZ, 08.02.10, “Weitere grobe Fehler entdeckt“

[26] AFP, Feb 5, 2010, THE HAGUE

[27] IPCC-Rep., 2007, Ch. 12.2.3

[28] Bangladesh gaining land, not losing: scientists; by Shafiq Alam Wed Jul 30, 9:41 AM ET DHAKA (AFP);

http://news.yahoo.com/s/afp/20080730/sc_afp/bangladeshenvironmentunclimatewarming_080730134111;_ylt=Ai1fEIqHFVyfguECUfbGjKvPOrgF

[29] Berliner Morgenpost, 09.03.2010: SCHRECKENS-SZENARIEN: Der Klimawandel ist Tieren und Pflanzen schnuppe, http://www.morgenpost.de/web-wissen/article1271000/Der-Klimawandel-ist-Tieren-und-Pflanzen-schnuppe.html

[30] http://www.washingtontimes.com:80/news/2010/mar/23/meat-dairy-diet-not-tied-to-global-warming/

[31] http://www.fao.org/docrep/010/a0701e/a0701e00.HTM

[32] American Thinker, Dec 11, 2009: http://www.americanthinker.com/2009/12/understanding_climategates_hid.html#

[33] Prof. Dr. J. KRONENBERG (TU Delft), Der lange Zyklus, Primus-Verlag, Darmstadt, 2008, S.229-230

[34] SZ, 17.02.2010, S.8, Kritik am Weltklimarat

[35] HAZ, 19.02.2010, S.4

[36] HAZ, 06.02.10, “Krise der Klimaforschung“

[37] http://www.spiegel.de/wissenschaft/natur/0,1518,673765,00.html#ref=top , 25.01.2010

[38] Südd.Zeitg. 13./14.02.2010, WISSEN

[39] BILD, 6.3.10, Claus Jacobi, mein Tagebuch

[40] FAZ, 13.03.2010, M. Rüb: Immer weniger Amerikaner glauben an die vom Menschen gemachte Erderwärmung

[41] HAZ, 06.02.10, “Der Weltklimarat in der Krise“

[42] DIE ZEIT, 28.01.2010, S.33, Sp.1

[43] http://www.spiegel.de/wissenschaft/natur/0,1518,686205,00.html, 30.03.2010

[44] CAPITAL, 03/2010, S.55

Related Files

Obertertia“. Auch wenn man – wie Prof. Bott – von der nicht nachzuweisenden Wasserdampfverstärkung ausgeht, bleiben läppische acht tausendstel Grad oder knapp neun tausendstel Grad Celsius. Wahrlich ein großer Unterschied !

Obertertia“. Auch wenn man – wie Prof. Bott – von der nicht nachzuweisenden Wasserdampfverstärkung ausgeht, bleiben läppische acht tausendstel Grad oder knapp neun tausendstel Grad Celsius. Wahrlich ein großer Unterschied !

Abbildung 7: Verlauf von Proxydaten der Temperatur und der CO2 Konzentrationen aus Eisbohrkernmessungen für letzten 400.000 Jahre. Darin eingezeichnet die höher aufgelöste Graphik der letzen 8000 bis 22.000 Jahre. Deutlich ist die Nach-Eilung der CO2 Konzentration im Vergleich zu den Temperaturen zu erkennen.

Abbildung 7: Verlauf von Proxydaten der Temperatur und der CO2 Konzentrationen aus Eisbohrkernmessungen für letzten 400.000 Jahre. Darin eingezeichnet die höher aufgelöste Graphik der letzen 8000 bis 22.000 Jahre. Deutlich ist die Nach-Eilung der CO2 Konzentration im Vergleich zu den Temperaturen zu erkennen.

Prof. F.K. Ewert (EIKE), der über 800 weltweite Temperaturganglinien auf ihren absoluten Temperaturtrend hin untersucht hat, und dabei nur klärte: a) ist ein Trend vorhanden? Wenn ja? b) War er positiv oder negativ? Sein Ergebnis: Von 1990-2010 zeigten 50% aller Stationen weltweit keine Erwärmung oder Abkühlung, 28.8 % eine Erwärmung (ohne Stadterwärmungseffekt) und 16,4% eine Abkühlung. Die Arbeit betrachtete auch den gesamten Trend. Sein Ergebnis: Von 1880-2010 zeigten 74% aller Stationen weltweit keine Erwärmung oder Abkühlung, 5,1 % eine Erwärmung (ohne Stadterwärmungseffekt) und 3,8% eine Abkühlung

Prof. F.K. Ewert (EIKE), der über 800 weltweite Temperaturganglinien auf ihren absoluten Temperaturtrend hin untersucht hat, und dabei nur klärte: a) ist ein Trend vorhanden? Wenn ja? b) War er positiv oder negativ? Sein Ergebnis: Von 1990-2010 zeigten 50% aller Stationen weltweit keine Erwärmung oder Abkühlung, 28.8 % eine Erwärmung (ohne Stadterwärmungseffekt) und 16,4% eine Abkühlung. Die Arbeit betrachtete auch den gesamten Trend. Sein Ergebnis: Von 1880-2010 zeigten 74% aller Stationen weltweit keine Erwärmung oder Abkühlung, 5,1 % eine Erwärmung (ohne Stadterwärmungseffekt) und 3,8% eine Abkühlung

Anlage.

Anlage. Ameling,

Ameling,  Haas Manuskript,

Haas Manuskript,  Peters,

Peters,