Der große Solarschwindel!

Der Tag, an dem Angela Merkel die Sonnenenergie nach Nordvorpommern brachte, begann trübe und wolkenverhangen. Die Bundeskanzlerin war trotz enger Terminlage in ihren Wahlkreis gefahren, um im Orte Grimmen an der Trebel den Bau des größten Solarparks von Mecklenburg-Vorpommern auf den Weg zu bringen. Dass sich die Sonne bei dem symbolträchtigen ersten Spatenstich im Oktober vergangenen Jahres partout nicht zeigen wollte, tat Merkels guter Laune ebenso wenig Abbruch wie die Tatsache, dass die 30 480 Solarmodule auf der 19 Hektar großen Fläche allesamt den Stempel "Made in China" tragen sollten. "Der Solarpark ist eine Zukunftsinvestition", sagte die Regierungschefin unverdrossen und stach den rot lackierten Spaten in die bröckelige Tonerde: "Wir sind auf dem Weg in das Zeitalter erneuerbarer Energien.

Bei ihrer Unterstützung für die Solarwirtschaft weiß die Bundeskanzlerin die Mehrheit der Bevölkerung hinter sich. Sonnenstrom ist die Wunschenergie Nummer eins für die Deutschen, das ergab in der vergangenen Woche eine Umfrage, die der Wirtschaftsverband führender Public-Relations-Agenturen in Deutschland (GPRA) mit den Marktforschern von TNS Emnid veröffentlichte. Danach messen 99 Prozent der Befragten "der Sonnenenergie eine besonders hohe Wichtigkeit für die zukünftige Energieversorgung in Deutschland" bei. Die Sonne sei "aus Sicht der Verbraucher die wichtigste Energiequelle der Zukunft – noch vor Wasserkraft und Windkraft", heißt es im Ergebnis der Umfrage. Weniger als die Hälfte der Befragten glaubten dagegen noch an eine wichtige Rolle der Kohlekraftwerke, nur ein Fünftel an Atomkraft. "Die deutsche Bevölkerung hat die Energiewende längst vollzogen und vertraut regenerativen Energiequellen", lautet das Fazit des GPRA-Präsidiummitglieds Uwe Kohrs. Angesichts der derzeit diskutierten Kürzungspläne für Solarsubventionen müssten "Politik und Energieversorger aufpassen, dass sie nicht alles Restvertrauen verspielen."

Wissenschaftler aber reiben sich verwundert die Augen angesichts solcher Vorstellungen über die Struktur der deutschen Energieversorgung. Atom- und Kohlekraftwerke decken heute noch drei Viertel des deutschen Strombedarfs. Solarmodule tragen tatsächlich erst drei Prozent zur Bedarfsdeckung bei. Schon der Beitrag der Windenergie übertrifft den der Solaranlagen um ein Vielfaches – für einen Bruchteil der Kosten. Die Solarenergie kostet die Verbraucher Jahr für Jahr hohe Milliardenbeträge, verteuert den Klimaschutz, lässt sich nicht wirtschaftlich speichern und fällt in mehr als der Hälfte des Jahres fast komplett aus. Auch industriepolitisch ist die Solarförderung ein gewaltiger Schuss in den Ofen: Bereits mehr als 70 Prozent der in diesem Jahr in Deutschland verbauten Solarmodule stammen aus Asien.

Die Nachteile der solaren Energieversorgung im schattigen Deutschland sind aus wissenschaftlicher Sicht so eklatant, dass der Sachverständigenrat für Umweltfragen, ein hochkarätiges Beratergremium der Bundesregierung, dazu rät, den Ausbau der Fotovoltaik nicht mehr weiter zu forcieren, sondern im Gegenteil in sehr engen Grenzen zu halten. Der Flensburger Umweltwissenschaftler Olav Hohmeyer, ein Mitglied des Sachverständigenrats, fordert, die derzeitige solare Ausbaurate um mindestens 85 Prozent zurückzuschrauben, auf nur noch 500 bis 1000 Megawatt pro Jahr. Dabei ist der Sachverständigenrat durchaus kein natürlicher Feind erneuerbarer Energien: In anderen Gutachten zeigt das Professorengremium Wege auf, wie Ökostrom bis 2050 den kompletten deutschen Energiebedarf decken kann, verzichtet dabei aber lieber auf ein Übermaß an Sonnenenergie.

Die Forscher stehen mit ihrer Meinung nicht allein. Das Rheinisch-Westfälische Institut für Wirtschaftsforschung (RWI) sagt wegen des "Hype um die Fotovoltaik" in Deutschland einen "weiter anschwellenden Kosten-Tsunami" voraus. Das RWI, das zu den renommiertesten deutschen Wirtschaftsforschungsinstituten gehört, schlägt angesichts der deutschen Defizite bei Stromspeichern, Stromleitungen und der mangelhaften Vernetzung mit den europäischen Nachbarn deshalb sogar ein mehrjähriges Moratorium für erneuerbare Energien vor, um "die Förderanreize für diesen Zeitraum auszusetzen". Auch der unabhängige Energieexperte Sven Bode vom Arrhenius Institut für Energie- und Klimapolitik in Hamburg stellt offen die Frage, "ob die Förderung der Fotovoltaik nicht bereits heute vollständig eingestellt werden sollte".

Doch danach sieht es ganz und gar nicht aus: Die Fraktionen der Regierungsparteien wollen sich Morgen über die Novelle des Erneuerbare-Energien-Gesetzes verständigen und dabei auch die Vergütungssätze für die unterschiedlichen Ökostrom-Arten festschreiben. Schon jetzt ist absehbar, dass es zu keinen nennenswerten Abstrichen bei den Solarsubventionen kommen wird. Vorgesehen ist im derzeitigen Gesetzentwurf lediglich, dass die Einspeisevergütung um jeweils drei bis vier Prozentpunkte sinkt, wenn der Grenzwert von 3500 Megawatt um 1000 Megawatt überschritten wird. Dass dies ausreicht, die solare Kostenexplosion zu beenden, glaubt kaum ein Marktbeobachter.

Der Wirtschaftsflügel der Unionsfraktion im Bundestag ist dabei schon bereit, die richtigen Konsequenzen zu ziehen: Er will den Fotovoltaik-Zubau in Deutschland – wie in anderen Ländern längst üblich – durch einen festen "Ausgabendeckel" begrenzen. Thomas Bareiß, der die Energiepolitik der CDU/CSU-Fraktion koordiniert, will mit dieser Forderung auch in die Koalitionsgespräche im Bundestag gehen, denn: "Was sich hier abzeichnet, ergibt energiewirtschaftlich keinen Sinn und ist sozialpolitisch verantwortungslos."

Doch Bareiß hat Zweifel, ob sich die Position des Wirtschaftsflügels der Union in den Koalitions- und Fraktionsgesprächen noch durchsetzen wird. Auch die anderen Wirtschaftspolitiker der Fraktion glauben nicht, dass sie bei der eigenen Parteiführung und beim Koalitionspartner FDP durchdringen.

Warum die Bundesregierung den Subventionsirrsinn jetzt nicht beendet, ist offensichtlich. Zu groß ist die Sorge der Partei- und Regierungsspitzen, vor den anstehenden Landtags- und Bundestagswahlen vom ökologischen Mainstream der Bevölkerung abgestraft zu werden. Nach außen hin wolle die Bundesregierung nach der Abschaltung der Kernkraftwerke eben nicht nur als "Ausstiegspartei" wahrgenommen werden, formuliert es ein hoher Beamter des Bundeswirtschaftsministeriums: "Ebenso wichtig ist es zu zeigen, dass man auch in etwas einsteigt." Und die Kappung von Solarsubventionen – wie sinnvoll sie inhaltlich auch immer sein mag – "passt da eben nicht ins Bild".

Folge dieses politischen Populismus dürfte sein, dass auch in den kommenden Jahren jeweils mehr als die Hälfte der vom Verbraucher zu zahlenden Ökostrom-Milliarden an die Solarindustrie fließen wird – und hier wiederum zum weitaus größten Teil an die asiatischen Modul- und Zellen-Hersteller. Während die Solarlobby in der Öffentlichkeit behauptet, die Bundesregierung würde bei ihrer Energiewende die Windkraft bevorzugen, sprechen die Zahlen eine völlig andere Sprache: Nach der offiziellen Statistik des Bundesumweltministeriums wurden im vergangenen Jahr rund 19,5 Milliarden Euro für die Errichtung von Fotovoltaik-Anlagen in Deutschland ausgegeben, jedoch nur 2,5 Milliarden für die deutlich ergiebigere Windkraft. Während die installierte Leistung der Solarmodule 2010 um 7500 Megawatt zunahm, wuchs die angeblich bevorzugte Windkraft lediglich um 1500 Megawatt. Ein Missverhältnis, das sich nach den Zubauprognosen in diesem Jahr weiter verfestigen dürfte.

In ihrem "Energiekonzept" hatte sich die Bundesregierung im vergangenen Jahr noch das Ziel gesetzt, den Anteil erneuerbarer Energien bis 2020 von heute 17 auf dann 30 Prozent zu erhöhen. Nach der Reaktorkatastrophe von Fukushima und der Abschaltung mehrerer deutscher Atomkraftwerke wurde der zu erreichende Ökostrom-Anteil jetzt auf "mindestens 35 Prozent" heraufgesetzt. So steht es im Entwurf des Erneuerbare-Energien-Gesetzes, das Ende kommender Woche vom Bundestag in zweiter und dritter Lesung verabschiedet werden soll. Doch viele Ökonomen und nicht wenige Bundestagsabgeordnete fragen sich inzwischen, wie die beschleunigte "Energiewende" innerhalb von zehn Jahren gelingen soll, wenn die Förderpolitik für Ökostrom dem luxuriösen Motto "Vom Teuersten das Meiste" folgt. Müsste man angesichts des Zeitdrucks und der knappen Mittel nicht die effizientesten Techniken am stärksten fördern?

Dass die "Energiewende" eher zu einer "Sonnenwende" zu werden droht, hat viel damit zu tun, dass die einseitige Argumentation der Solarlobby öffentlich kaum je hinterfragt wird. Aber halten die wichtigsten Argumente einer Überprüfung stand?

1. Solarstrom ist nicht billig

"Die Sonne schreibt keine Rechnung": Angesichts der realen Kosten für Verbraucher und Volkswirtschaft bekommt das beliebte Lobbyistenwort einen fast zynischen Beiklang. Strom aus Solarmodulen, die im Jahre 2005 montiert wurden, wird 20 Jahre lang mit 50,23 Cent pro Kilowattstunde vergütet. Dieser Wert übersteigt den Börsenwert für Elektrizität um das Zehnfache. Die Stromnetzbetreiber sind verpflichtet, den Solarstrom, wie anderen Ökostrom auch, vorrangig einzuspeisen und mit dem gesetzlichen Fixpreis zu bezahlen. Die gewaltige Differenz zum eigentlichen Marktwert wird über die Stromrechnung auf alle Verbraucher abgewälzt.

Zwar wurde die Einspeisevergütung in mehreren Schritten gesenkt – auf heute rund 28 Cent pro Kilowattstunde. Doch weil der Preisverfall bei Solarmodulen noch drastischer war, können Investoren noch immer Traumrenditen auf Kosten der Verbraucher erzielen. Während ein Tagesgeldkonto derzeit kaum 2,5 Prozent abwirft, können Besitzer von Solardächern völlig risikolos jährlich sechs bis acht Prozent Gewinn einstreichen, gesetzlich garantiert über 20 Jahre lang. Kein Wunder, dass die Zahl der Fotovoltaik-Anlagen Jahr für Jahr exponentiell auf inzwischen mehr als 800 000 mit einer Gesamtleistung von rund 17 000 Megawatt angewachsen ist. Zum Vergleich: Ein Atomkraftwerk hat ungefähr 1000 Megawatt Leistung.

Die Frage, welche Nettokosten von den Verbrauchern zu schultern sind, hat in der Vergangenheit einigen wissenschaftlichen Streit ausgelöst. Das Rheinisch-Westfälische Institut für Wirtschaftsforschung hat die Strommengen aller bis Ende 2010 installierten Solarmodule mit ihren Einspeisetarifen summiert und um den eigentlichen Marktwert des Stroms bereinigt. Ergebnis: Allein für die bis Ende letzten Jahres verbauten Module wird der deutsche Verbraucher mit reinen Subventionskosten oder "Solarschulden" von real 81,5 Milliarden Euro belastet, die er über einen Zeitraum von zwanzig Jahren abzustottern hat.

Mit diesem gewaltigen Entzug an volkswirtschaftlicher Kaufkraft zahlt der Bürger für eine Stromquelle, die in jeder Nacht und mit Einbruch der dunklen Jahreszeit ihren Beitrag zur Stromversorgung fast völlig einstellt und durch andere Kraftwerke ersetzt werden muss. Obwohl die Solarenergie in diesem Jahr nur etwa 20 Prozent des gesamten Ökostrom-Aufkommens in Deutschland stellt und lediglich drei Prozent des gesamten Strombedarfs deckt, verschlingt sie 55 Prozent der gesamten Ökostrom-Beihilfen nach dem EEG.

Sogar die "Agentur für Erneuerbare Energien", ein in Berlin ansässiges Lobbybüro der Ökobranche, hielt das Kosten-Nutzen-Verhältnis des Solarstroms nach den RWI-Berechnungen für so schlecht, dass man das "Wuppertal Institut für Klima, Umwelt und Energie" im vergangenen Jahr mit einem Gegengutachten beauftragte. Man könne die "Horrorzahlen des RWI so nicht stehen lassen", hieß es dazu. Nötig sei endlich "eine seriöse Diskussionsgrundlage". Und tatsächlich: Das Gutachten der Wuppertaler fiel für die Ökolobbyisten wunschgemäß aus. In einer Pressekonferenz im Oktober vergangenen Jahres erklärte das Wuppertal Institut, man habe in den RWI-Berechnungen mehrere Rechen- und Bewertungsfehler gefunden, unter anderem bei der Diskontierung zukünftiger Werte. Fazit des Wuppertal Instituts: Die Subventionskosten des Solarstroms seien in Wahrheit 42 Prozent niedriger als vom RWI behauptet.

Das allerdings ließen die Essener Wissenschaftler nicht auf sich sitzen und überprüften ihrerseits die Berechnungen aus Wuppertal. Ihr Ergebnis publizierte das RWI in einer mehrseitigen Streitschrift mit dem Titel "Eine unbequeme Wahrheit": Die Wuppertaler hatten sich demnach selbst verrechnet und in ihren Formeln versehentlich doppelt abgezinst. Um diesen Fehler bereinigt, ergab die Kalkulation der Öko-Gutachter fast dieselbe "Horrorzahl", die zuvor vom RWI berechnet worden war. "Die vom RWI ermittelte Größenordnung der Kosten der deutschen Solarstromförderung wird durch die Wuppertal-Studie nolens volens bestätigt", resümieren die angegriffenen Wissenschaftler aus Essen zufrieden.

Wenn der Solarausbau vom Bundestag in der kommenden Woche nicht gedeckelt wird, steigen die Solarkosten innerhalb kürzester Zeit sogar auf einen dreistelligen Milliardenbetrag. Nach Berechnungen des RWI kämen bis 2020 für die deutschen Verbraucher weitere 42 Milliarden Euro Kosten hinzu. Dies allerdings auch nur unter der konservativen Annahme, dass der Solarzubau ab 2012 auf 3500 Megawatt jährlich begrenzt werden kann. Es könnte auch noch doppelt so teuer werden, wenn es bei der bisherigen Zubaurate bleibt.

Die Förderung der Solarbranche ist längst so hoch, dass sie den Bundeshaushalt völlig überfordern würde. Mehr als sieben Milliarden Euro überweisen die deutschen Verbraucher in diesem Jahr wohl an die Besitzer von Solaranlagen. Das übersteigt den Etat des Bundesumweltministeriums von 1,6 Milliarden Euro um fast das Vierfache. Die Summe, die von allen Bundesministerien zusammen in diesem Jahr für Energieforschung ausgegeben wird, beträgt mit 700 Millionen Euro nur ein Zehntel der Solarförderung.

Der Wissenschaftliche Beirat des Bundeswirtschaftsministeriums warnt angesichts der "riesigen Subventionen" bereits vor einem "gewaltigen Umverteilungsprogramm". Es wäre mit einem Volumen von mehr als 100 Milliarden Euro tatsächlich die größte soziale Umverteilung von unten nach oben, die je von einer sozialdemokratischen Regierung mit ausgelöst wurde. Denn die Milliardenlast zahlt der Mieter mit seiner Stromrechnung, den Ertrag streicht der tendenziell wohlhabende Solardach- also Immobilienbesitzer ein. Allein zu Jahresbeginn 2011 erhöhte sich die EEG-Umlage zur Förderung des Ökostroms in einem einzigen großen Schritt um 70 Prozent auf 3,53 Cent pro Kilowattstunde. Der Kostensprung, der den Strompreis für Privathaushalte um rund zehn Prozent verteuerte, war fast ausschließlich auf den Fotovoltaik-Zubau zurückzuführen.

2. Atomstrom ist nicht teurer

Die Kosten der Solarförderung mit denen der Kernenergie zu vergleichen und so zu relativieren, ist ein beliebtes Argument von Solarfreunden. Tatsächlich sind die Beihilfen für beide Technologien gar nicht mehr so weit von einander entfernt. In einer Studie zur staatlichen Förderung von Atomkraft kommt Greenpeace zu dem Ergebnis, dass die staatlichen Forschungsgelder für die Nukleartechnik bis 2010 real – also in Preisen des Jahres 2010 – rund 55 Milliarden Euro betrugen. Insgesamt gaben die öffentlichen Haushalte für die Atomkraft bislang sogar 203,7 Milliarden Euro aus, heißt es in der Greenpeace-Berechnung. Eine hohe Zahl, die auch dadurch zustande kommt, dass selbst "die Vorteile der Atomenergie durch den Emissionshandel" als Kostenpunkt angesetzt wurden – und eine Reihe weiterer fragwürdiger Posten, zum Beispiel die "Sanierungskosten des sowjetischen Uranerzbergbaus in Wismut".

Tatsächlich kommen die Solarkosten den von Greenpeace errechneten Atom-Subventionen schon recht nahe. Denn der Ausbau der Verteilnetze in den Kommunen, der wegen des Solarbooms nötig wird, kostet Experten zufolge allein schon rund 30 Milliarden Euro zusätzlich. Kommt es zum erwarteten Ausbau des Solarstroms, addieren sich Subventionen und Netzausbaukosten bis 2020 ebenfalls schon auf 150 Milliarden Euro. Noch nicht eingerechnet sind dabei die indirekten volkswirtschaftlichen Kosten, die durch die so ausgelösten Strompreissteigerungen entstehen, wie etwa Produktionsverlagerungen ins Ausland oder Arbeitsplatzabbau.

Kommt es also nicht zu einer effektiven Ausbaubremse für Fotovoltaik, dürften die Solar-Kosten in absehbarer Zeit denen der Kernenergie gleichen. Einziger Unterschied: Atomkraftwerke haben für dieses Geld den Strombedarf der größten europäischen Volkswirtschaft 40 Jahre lang rund um die Uhr zu einem Viertel gedeckt. Solarenergie deckt derzeit nur drei Prozent des Strombedarfs und kann nach Angaben des Bundesverbandes Solar auch im Jahr 2020 nur maximal neun Prozent zur Bedarfsdeckung beitragen, wie es in der "PV-Roadmap" des Verbandes heißt. Dabei ist freilich zu berücksichtigen, dass der Beitrag der Solar-Technologie in jeder Nacht und während langer Wintermonate fast auf null sinkt und dann komplett von einem weiteren, "doppelten" Kraftwerkspark ersetzt werden muss, dessen enorme Kosten in der Rechnung ebenfalls noch nicht berücksichtigt sind.

3. Die Nachfrage fehlt

Setzt sich die Solarlobby mit ihren Subventionswünschen politisch durch, dürfte im Jahr 2020 eine installierte Leistung von 70 Gigawatt Sonnenenergie am Netz sein. Dieses Ziel hat die Branche in ihrer "PV-Roadmap" selbst ausgegeben. Allerdings beträgt die gesamte Stromnachfrage Deutschlands im Schnitt nur 60 Gigawatt. Schon in zwei oder drei Jahren werden Solar- und Windkraftanlagen gemeinsam an einigen Tagen im Sommer, zur hellen Mittagszeit, phasenweise deutlich mehr Strom produzieren, als überhaupt nachgefragt wird. Wegen des gesetzlichen Einspeisevorrangs für Ökostrom müssten während dieser Stunde alle anderen Atom- Kohle- und Gaskraftwerke nicht nur gedrosselt, sondern komplett abgeschaltet werden.

Weil das mit enormen Kosten und technischen Risiken verbunden ist, bleibt als Alternative nur, den überschüssigen Strom an ausländische Abnehmer zu "verschenken". Die jüngsten Erfahrungen am Strommarkt zeigen allerdings, dass ausländische Abnehmer deutschen Ökostrom noch nicht einmal geschenkt haben wollen – sie nehmen ihn nur gegen Zuzahlung ab. Das hat in den letzten Monaten bereits mehrmals zum Effekt "negativer Strompreise" an der Europäischen Energiebörse geführt.

Die Besitzer großer Pumpspeicherkraftwerke wie etwa Österreich oder die Schweiz profitieren in diesen Stunden doppelt vom deutschen Ökowunder: Zunächst lassen sie sich die Abnahme des zur Unzeit produzierten deutschen Stroms teuer bezahlen. Dann kassieren sie für dieselben Kilowattstunden ein zweites Mal, wenn sie die gespeicherte Energie aus ihren Pumpspeichern ablassen und als teuren Spitzenlaststrom nach Deutschland zurückverkaufen.

Die absehbare temporäre Überproduktion von Wind- und Solarstrom führt zu einem weiteren, bislang ungelösten Problem: Welcher Sauberstrom muss für den anderen im Netz Platz machen, wenn doch beide eigentlich gesetzlichen Einspeisevorrang genießen? Regeln dafür sind auch in der jetzigen EEG-Novelle noch nicht enthalten. Ökonomen plädieren zwar dafür, dass in Zeiten der Überproduktion der billigere Windstrom den teureren Solarstrom verdrängen sollte. Doch RWI-Experte Frondel fürchtet, dass es wohl eher die leicht regelbaren Windparks sein werden, die in einer solchen Situation abgestellt werden, "da das Abschalten einer großen Zahl an kleinen, dezentralen Fotovoltaikanlagen mit großem Aufwand verbunden sein dürfte." Teuer verdrängt billig: Für die Verbraucher dürfte das anbrechende Solarzeitalter noch einige Überraschungen bereit halten.

4. Die Mär von der Autarkie

Dass Solarstrom "dezentral" produziert wird, stellt der Lobbyverband der Branche gern als Vorteil heraus, ohne allerdings zu erklären, worin eigentlich genau dessen Wert liegt. "Ob Einfamilien-, Mehrfamilien- oder Mietshaus: Jeder kann investieren, profitieren und sich künftig selbst versorgen", wirbt der Bundesverband Solarwirtschaft (BSW) dieser Tage in ganzseitigen Zeitungsanzeigen unter dem Titel "Solarstrom – ein Gewinn für alle". Das Argument appelliert an das unterschwellige psychologische Bedürfnis vieler Menschen nach Autarkie und Unabhängigkeit.

Allerdings bleibt Autarkie mit Solarenergie eine teure Illusion. Denn Tatsache ist, dass Solaranlagen in diesen Breitengraden nur an 875 Stunden der 8760 Stunden eines Jahres ihre Volllast erreichen. In der übrigen Zeit herrscht Nacht, schlechtes Wetter oder Winter. An neun von zehn Stunden sind Solardachbesitzer darauf angewiesen, Strom aus dem Verbundnetz zu beziehen, wie jeder andere auch.

5. Kommunen werden geschwächt

Dennoch lautet ein Argument der Solarbranche, die dezentrale Stromerzeugung stärke auch die Wertschöpfung in den Kommunen. Fragt man vor Ort einmal nach, ist die Begeisterung der Stadtwerke über den Fotovoltaikboom allerdings begrenzt. Zum Beispiel im nordrhein-westfälischen Froendenberg im Kreis Unna. Die Stadtwerke Froendenberg sind ein Traditionsbetrieb, der schon vor 100 Jahren damit begann, mit einem Wasserkraftwerk in der Ruhr Strom zu produzieren. Auch heute noch ist der Betrieb, der 22 000 Einwohner in 14 Ortsteilen versorgt, dem Ökostrom gegenüber aufgeschlossen: Es gibt neun Windräder, drei Laufwasserkraftwerke und 340 Fotovoltaik-Anlagen in der Stadt. Nur die Tatsache, dass die Dächer überall mit blauen Modulen belegt werden, treibt Bernd Heitmann, dem Geschäftsführer der Stadtwerke, die Sorgenfalten auf die Stirn. "Fotovoltaik hat die unangenehme Eigenschaft, dass alle Anlagen bei Sonneneinstrahlung zeitgleich ans Netz gehen", sagt er. "Das erzeugt einen plötzlichen Spannungshub, der im Verteilnetz nur in begrenztem Umfang vorhanden sein darf."

Mit ihren 340 Fotovoltaik-Anlagen haben die Froendenberger bereits 5,6 Megawatt ans Netz gebracht. Dabei liegt der Strombedarf in der Region, etwa an Feiertagen, oft nur halb so hoch bei rund 2,5 Megawatt. So musste Heitmann etwa 25 Anträge auf Netzanschluss neuer Solaranlagen bereits ablehnen, weil dies sein Leitungsnetz in einigen Außenbereichen überlastet hätte.

Um dem Solar-Problem Herr zu werden, müsste das kleine Stadtwerk allein 12 bis 13 Millionen Euro in den Ausbau der Leitungsnetze vor Ort investieren. "Das entspricht der Höhe unseres gesamten Eigenkapitals", sorgt sich Heitmann. Weil die Kosten des Netzausbaus vom örtlichen Netzbetreiber zu tragen sind, müssten die Stadtwerke ihre Netznutzungsentgelte erhöhen, um die Investition tragen zu können. "Das könnte sich zum Standortnachteil für unsere Stadt auswachsen", glaubt Heitmann. Aus Sicht des Stadtwerke-Chefs, "stimmt die Verhältnismäßigkeit nicht, wenn wir hier 12 Millionen Euro investieren müssen, damit 30 Leute dann ein paar Tausend Euro mit Solarstrom verdienen."

6. Das Problem der Stromspeicherung

An dem Tag im vergangenen Oktober, als Bundeskanzlerin Angela Merkel den Grundstein für den größten Solarpark Mecklenburg-Vorpommerns legte, brauchte Deutschland den ganzen Tag über knapp 50 Gigawattstunden Strom. Die 17 Gigawatt installierter Solarleistung in Deutschland hätte davon einen Gutteil decken können – wenn denn die Sonne geschienen hätte. Tatsächlich aber quälte sich die Solarleistung an diesem Tag nur ganz kurz am Mittag mal über die 2-Gigawatt-Grenze, um schon bald nach 16 Uhr gegen null abzutauchen. 88 Prozent der installierten Solarleistung an diesen Tag blieben ungenutzt, und die ungeliebten fossilen Kraftwerke mussten die Versorgung übernehmen.

Ganz anders die Situation am vergangenen Pfingstsonntag. Da lag der Strombedarf Deutschlands feiertagsbedingt bei lediglich 28 Gigawatt. Zugleich brannte diesmal die Sonne und die Solaranlagen speisten den ganzen Tag über mehr als sechs Gigawatt Strom ein. Als die Sonne über Mittag am höchsten stand, deckte Solarstrom mit zehn Gigawatt Leistung allein mehr als ein Drittel des gesamten deutschen Bedarfs. Es wäre schön gewesen, wenn der relative Solarstrom-Überschuss von Pfingsten hätte gespeichert werden können für die dunkle Jahreszeit – oder zumindest für die kommende Nacht. Doch Speichertechnologien stehen in der geforderten Größenordnung auch nicht ansatzweise zur Verfügung. Nach Berechnungen des Beratungsunternehmens Boston Consulting Group (BCG) liegt die derzeitige Speicherkapazität Deutschlands bei gerade einmal sieben Gigawatt. Um das schwankende Aufkommen von Wind- und Solarstrom mithilfe von Speichern ausgleichen zu können, müsste die Speicherkapazität bis 2025 vervierfacht werden.

Die billigste Art, dies zu tun, wäre der Bau von Pumpspeicherkraftwerken. Ein temporärer Überschuss von Ökostrom wird dabei dazu genutzt, Wasser bergauf in eine Talsperre zu pumpen. Bei Windflaute oder nächtlichem Ausfall des Solarstroms kann das Wasser in Röhren zu Tal rauschen und dabei eine Turbine zur Stromproduktion antreiben. Aber das größte deutsche Pumpspeicherkraftwerk Goldisthal hat gerade mal eine Leistung von einem Gigawatt. Viel zu wenig, um in der dunklen Jahreszeit Solarausfälle ausgleichen zu können.

Die Größenverhältnisse beschreiben die Wissenschaftler Sven Bode und Helmuth Groscurth vom Hamburger Arrhenius-Institut: Um eine Woche lang ohne Wind, Fotovoltaik und ohne konventionelle Kraftwerke auszukommen, bräuchte man nach ihrer Modellrechnung 1260 Pumpspeicherkraftwerke vom Typ Goldisthal. "Abgesehen davon, dass es in Deutschland dafür keine Standorte mehr gibt", schreiben die Autoren Bode und Groscurth, "wären die Kosten für eine Kilowattstunde astronomisch, da die meisten dieser Anlagen nur für einige Stunden im Jahr betrieben würden."

Auch die Batterien von Elektroautos können als Puffer für das schwankende Ökostromaufkommen noch lange nicht dienen. Da ein Elektrosmart im Schnitt nur 40 Kilowattstunden Strom speichern kann, wären nach den Berechnungen des Arrhenius-Instituts "250 Millionen dieser Fahrzeuge erforderlich, um ausreichend Strom für Deutschland für eine Woche zu speichern".

Der Sachverständigenrat für Umweltfragen, ein Beratergremium der Bundesregierung, schlug kürzlich in einem Sondergutachten vor, die norwegischen Wasserkraftwerke als Speicher für deutschen Ökostrom zu nutzen. Allerdings geben die Dimensionen dem Projekt eher visionären Charakter. So liegt heute erst ein Kabel in der Nordsee zwischen Norwegen und den Niederlanden. Dieses NorNed-Kabel hat eine Kapazität von 600 Megawatt. Bei einer annähernden Vollversorgung Deutschlands mit Ökostrom, wie sie die Bundesregierung bis 2050 erreichen will, müssten die Kabelkapazitäten laut Sondergutachten aber auf 70 000 Megawatt mehr als verhundertfacht werden, damit die Lichter auch nachts und bei Windflaute nicht ausgehen. Da aber schon die Baukosten des NorNed-Kabels 600 Millionen Euro betragen haben, ist nicht ganz klar, wer die Baukosten tragen könnte.

Der Plan wird dadurch erschwert, dass sich schon das NorNed-Kabel nur refinanzieren lässt, weil die Preise für Elektrizität im Strommarkt Skandinavien stets deutlich vom übrigen Europa abweichen. Das erlaubt den Kabelbetreibern Handels- oder Arbitragegeschäfte, um die Baukosten wieder hereinzuholen. Diese Finanzierungsmöglichkeit wird aber in dem Maße eingeschränkt, in dem weitere Seekabel hinzukommen. Denn durch den intensiveren Stromverbund würden sich die Elektrizitätspreise zwischen Skandinavien und dem Rest Europas tendenziell angleichen. Norwegen würde auf diesem Wege geradezu das höhere deutsche Strompreisniveau "importieren". Die Finanzierung der Seekabel auf diesem Wege wäre nicht mehr möglich. Ohnedies ist es unsicher, ob die Norweger ihre Flusstäler als Speicher für deutschen Ökostrom überhaupt zur Verfügung stellen würden – zumindest ohne dafür einen üppigen Preisaufschlag zu verlangen.

Andere Methoden sehen vor, Strom in Form von Druckluft in unterirdischen Kavernen zu speichern. Doch sie sind mit hohen Wirkungsgrad-Verlusten verbunden und sind schon aus geologischen Gründen nur begrenzt einsetzbar. Blei- oder selbst Lithium-Ionen-Akkus, wie sie von einigen Solarfirmen bereits angeboten werden, lassen die ohnehin verheerende Kostenbilanz der Solartechnik völlig aus dem Ruder laufen. Dass in absehbarer Zeit genügend wirtschaftlich nutzbare Speicher für Ökostrom zur Verfügung stehen, ist damit nicht zu erwarten.

7. Hightech-Industrie – aber nicht in Deutschland

Bundesumweltminister Norbert Röttgen (CDU) erhofft sich aus der ökologischen Energiewende vor allem ein Programm zur wirtschaftlichen und technischen Erneuerung und einen "Jobmotor" für Deutschland. Insbesondere in der Solarwirtschaft sieht der Minister eine neue Hightech-Industrie heranwachsen. Die Solarsubventionen dienen aus seiner Sicht dazu, den "Technologievorsprung" und die "Marktführerschaft" der deutschen Solarindustrie zu sichern. Lassen sich Solarsubventionen also wenigstens industriepolitisch begründen?

Die Zahlen ernüchtern: Der globale Marktanteil deutscher Solarzellen-Hersteller hat sich innerhalb des letzten Jahres von 15,4 auf 9,7 Prozent fast halbiert. Im gleichen kurzen Zeitraum hat sich der Weltmarktanteil Chinas um ein Viertel auf 48 Prozent gesteigert. Gefördert mit günstigen Darlehen der chinesischen Staatsbanken kaufen die chinesischen Hersteller wie Yingli, Suntech oder JA Solar gleich ganze Produktionslinien modernster westlicher Technologie in großem Stil ein. Die Qualität der asiatischen Solarzellen steht deshalb der von deutschen Anbietern in nichts nach, wie unabhängige Testlabors bestätigen.

Kein Wunder: Wie aus der "PV-Roadmap"-Studie des Solar-Bundesverbandes hervorgeht, investieren die deutschen Hersteller lediglich 2,5 Prozent ihres Umsatzes für Forschung und Entwicklung. Erstaunlich wenig für eine vorgebliche "Hightech-Branche". Im Maschinenbau oder in der Automobilindustrie liegt die F+E-Quote mindestens doppelt so hoch zwischen fünf und acht Prozent des Umsatzes. Da in China im Vergleich zu den deutschen Fabriken auch gleich große Stückzahlen gefertigt werden, ergeben sich Kostenvorteile, mit denen die deutsche Solarindustrie längst nicht mehr mithalten kann. Von den im letzten Jahr in Deutschland verbauten Solarmodulen stammten bereits 70 bis 80 Prozent von asiatischen Herstellern. Bislang völlig unbekannte Firmen wie etwa Yingli Solar treten inzwischen als Sponsor des Erstliga-Klubs Bayern München selbstbewusst in Erscheinung. Andere bereiten die Übernahmen deutscher Wettbewerber vor, wie die geplante Übernahme des Konstanzer Herstellers Sunways AG durch die chinesische LDK Solar beweist. Sogar Maschinenbauer und Ausrüster von Solarfabriken, eigentlich eine Domäne deutscher Ingenieurskunst, werden bereits von ausländischen Konkurrenten aufgekauft. Erst im Mai hatte Roth & Rau aus Hohenstein-Ernstthal, eines der wenigen deutschen Unternehmen auf der globalen Top-10-Liste der Solarfabrik-Ausrüster, dem Übernahmeangebot der Schweizer Firma Meyer Burger zugestimmt. Was Bundesumweltminister Röttgen besonders nachdenklich stimmen sollte: Ausgerechnet die erfolgreichsten Solarfirmen mit dem stärksten Marktwachstum wie etwa Meyer Burger stammen aus Ländern, die selbst überhaupt kein eigenes Einspeisegesetz für Ökostrom haben.

Der größte deutsche Anbieter Solarworld arbeitet zwar noch profitabel. Auf der Liste der 20 größten Solarzellen-Hersteller der Welt ist der deutsche Marktführer allerdings schon nicht mehr vertreten. Dort dominieren jetzt Chinesen. Auf der gesamten Top-20-Liste findet sich überhaupt nur noch ein deutsches Unternehmen, Q-Cells. Doch der einst weltweit führende Solarkonzern ist auf Platz neun abgerutscht, Tendenz fallend. Für die ersten drei Monate des laufenden Geschäftsjahres musste Q-Cells-Chef Nedim Cen gerade einen Verlust über 41 Millionen Euro ausweisen. Seither kursieren auch im Falle von Q-Cells Gerüchte um eine feindliche Übernahme.

8. Jobmotor Solarindustrie: ein Mythos

Dieser Trend ist – gerade mit Blick auf Arbeitsplätze in Deutschland – besonders misslich, weil die Zell- und Waferfertigung den eigentlichen "Hightech"-Teil der Solarproduktion darstellt, wohingegen das Zusammensetzen der Zellen in gerahmte Module eher dem "Medium- oder Lowtech"-Bereich zuzuordnen ist. Doch in der deutschen Branche herrscht stillschweigendes Einvernehmen über die Tatsache, dass Solarzellen in Deutschland nicht mehr wirtschaftlich zu produzieren sind. In dieser Woche war es Holger von Hebel, Chef der Firma Bosch Solar, der ankündigte, die nächsten großen Solarfabriken mit tausenden Arbeitsplätzen in Malaysia und den USA zu bauen. Wolfgang Hummel von der Hochschule für Technik und Wirtschaft (HTW) in Berlin, der den Solarmarkt seit Jahren intensiv verfolgt, glaubt: "Im Bereich der Solarzellen- und Modulproduktion ist kein weiterer Aufbau von Arbeitsplätzen in Deutschland mehr zu erwarten."

Damit hat Hummel vermutlich recht. Zwar wirbt die Solarlobby stets mit den 133 000 Arbeitsplätzen, die durch eine Kappung der Solarförderung gefährdet wären. Doch den Mythos vom angeblichen "Jobmotor" Solarindustrie hat die Branche selbst entzaubert: In ihrer eigenen "PV-Roadmap" gibt die Branche zu, dass von den 133 000 Arbeitsplätzen nur ein Bruchteil – lediglich 18 000 – in der eigentlichen Fotovoltaik-Produktion angesiedelt sind. Die Zahl von Solar-Arbeitsplätzen im Handwerk ist mit 39 000 demgegenüber mehr als doppelt so hoch. Weitere 64 000 Solar-Arbeitsplätze werden in den nicht weiter definierten Bereichen "Vorleistungen" und "Sonstiges" verortet.

Angesichts dieser Zahlenverhältnisse scheinen die zweistelligen Milliardensubventionen weniger dem Aufbau eines "Jobmotors" der Hightech-Industrie zu dienen als vielmehr einem arbeitsmarktpolitischen Strohfeuer im Handwerk. Dass sich daran allzu viel ändert, ist wenig wahrscheinlich: Sogar nach den Zielen, die sich die deutsche Solarbranche selbst steckt, soll die Zahl der Arbeitsplätze bis 2020 nicht nur nicht wachsen, sondern sogar leicht zurückgehen.

9. Erfolge einer gute Lobby

Als die Parteivorsitzenden von CDU, CSU und FDP am 23. Oktober 2009 zur Beratung ihres Koalitionsvertrages zusammenkamen, lag ein Vorschlag der Unionsarbeitsgruppe "Wirtschaft" auf dem Tisch, die schon damals ausufernden Solarsubventionen bereits zum 1. Januar deutlich um 30 Prozent zu senken. Als Angela Merkel, Horst Seehofer und Guido Westerwelle den Koalitionsvertrag tags darauf der Öffentlichkeit präsentierten, fand sich der Vorschlag der Abgeordneten darin nicht wieder. Nur unbestimmt, ohne festes Datum und Mengenangabe, stand dort, die Regierung wolle "im Dialog mit der Solarbranche" darüber reden, wie "eine kurzfristige Überförderung vermieden werden" könne.

Szenebeobachter sehen in der Verwässerung des Unionsvorschlags einen Erfolg des damaligen FDP-Vorsitzenden Guido Westerwelle. Denn Westerwelles Wahlkreis ist Bonn, wo der größte deutsche Solarkonzern Solarworld AG seinen Sitz hat. Solarworld-Chef Frank Asbeck stand nach Beobachtung mehrerer an den Koalitionsverhandlungen Beteiligter damals in regem SMS-Austausch mit seinem erklärten "Freund" Westerwelle. So dürfte es wohl auch kein Zufall sein, dass der Bundesverband der Solarwirtschaft (BSW) auch heute noch auf seiner Homepage unter dem Kapitel "Politikberatung" seine eigene Lobbyarbeit preist und dies unter der Überschrift "Ohne starke Lobby keine solare Energiewende" ausgerechnet mit einem Foto des Bundesaußenministers Guido Westerwelle dekoriert.

"Tag für Tag sind engagierte und kompetente Streiter des Verbandes auf den Fluren von Bundestag und Ministerien in Berlin unterwegs", heißt es in dem Abschnitt, in dem der BSW seine eigenen Lobbyerfolge feiert. "Die Politikberater des BSW-Solar" hätten schon "im Juni 2008 auch die Neu-Novellierung des EEG im Sinne der Branche positiv mitgestalten können." Erzielt wurden diese Erfolge mit einem außergewöhnlich hohen Etat für politische Arbeit: Der Bundesverband der Solarwirtschaft leistet sich in Berlin immerhin 29 hauptamtliche Mitarbeiter. Zum Vergleich: Die angeblich so mächtige Lobby-Organisation der deutschen AKW-Betreiber, das "Deutsche Atomforum" beschäftigt in der Hauptstadt lediglich 13 Mitarbeiter, Sekretariat und Buchhaltung schon miteingerechnet.

Doch auch Einzelunternehmen der Branche betreiben auf eigene Kosten politische Landschaftspflege. Dabei sind nicht alle Parlamentarier so ehrlich wie der Bonner SPD-Abgeordnete Ulrich Kelber, der auf seiner Homepage als "gläserner Abgeordneter" selbst zugibt, in den Jahren 2007, 2008 und 2009 jeweils Spenden in Höhe von 25 000 Euro von der Solarworld AG aus seinem Bonner Wahlkreis erhalten zu haben. Dies zusätzlich zu einer Spende über 15 000 Euro von "First Solar" im Jahre 2009. Allerdings betont der stellvertretende Fraktionsvorsitzende Kelber, durch die Gelder in seiner Arbeit nicht beeinflusst worden zu sein. Kelber ist in der SPD-Fraktion unter anderem für den Schwerpunktbereich Umwelt zuständig und ist Mitglied der "Arbeitsgruppe Energie".

Auch die IBC Solar AG aus Bad Staffelstein erklärt auf Nachfrage, dass sie "die politische Arbeit in Deutschland über Parteigrenzen hinweg unterstützt". IBC hatte unter anderem Bundeskanzlerin Merkel dafür gewinnen können, den ersten Spatenstich beim Bau des Solarpark Grimmen in Mecklenburg-Vorpommern zu setzen, den IBC errichtet und mit chinesischen Solarmodulen bestückt hatte. Als IBC in der vergangenen Woche den Baubeginn für den Solarpark "Jura" in Oberfranken feierte, war es mit CSU-Chef Horst Seehofer ebenfalls hohe politische Prominenz, die hier kamerawirksam den ersten Spatenstich setzte.

Das politische Engagement von IBC ist breit gestreut: "Die im Bundestag vertretenen Parteien CDU, CSU, SPD, FDP sowie Bündnis 90/Die Grünen wurden und werden von uns unterstützt", gibt die Firma Auskunft. Dabei halte man sich "strikt an die gesetzlichen Vorgaben", und knüpfe "in keinem Fall Bedingungen an die von uns getätigten Spenden". Wenn es im Zusammenhang mit Parteispenden zu Kontakten mit Abgeordneten komme, dann nur um die Zahlungmodalitäten abzustimmen, "nicht aber – und darauf legen wir großen Wert – um Einfluss auf die Entscheidungen dieser Mandatsträger zu nehmen."

Das klingt nach einem geradezu selbstlosen Engagement. Allerdings ergibt eine stichprobenartige Anfrage beim Schatzmeister der FDP, dass die Firma IBC Solar die Spendenempfänger relativ gezielt auswählt. "Im Jahr 2010 sind zwei Spenden in Höhe von jeweils 5000 Euro an den Kreisverband Dortmund sowie an den Kreisverband Regensburg verbucht", gibt FDP-Sprecher Wulf Oehme Auskunft. Dortmund ist der Wahlkreis von Michael Kauch, der als umweltpolitischer Sprecher der FDP-Bundestagsfraktion jetzt auch an der Verabschiedung der EEG-Novelle mitwirkt. Kurz vor den jetzt anstehenden parlamentarischen Gesprächen hatte sich Kauch für eine stärkere Kürzung, aber gegen eine feste "Deckelung" der Solarsubventionen ausgesprochen, wie sie etwa vom Wirtschaftsflügel der CDU gefordert wird. Der andere IBC-Spendenempfänger, der FPD-Kreisverband Regensburg, ist der Wahlkreis von Horst Meierhofer, dem stellvertretenden Vorsitzenden des Ausschusses für Umwelt, Naturschutz und Reaktorsicherheit im Bundestag.

Auch auf europäischer Ebene sind Solar-Lobbyisten erfolgreich: So gelang es etwa der Firma First Solar im vergangenen Jahr, bei der EU-Kommission in Brüssel eine Ausnahmegenehmigung für die Verwendung des krebserregenden Nervengifts Kadmium in der Verbindung Kadmiumtellurid zu erwirken.

Obwohl die EU-Kommission mit ihrer sogenannten RoHS-Richtlinie eigentlich die industrielle Verwendung giftiger Schwermetalle wie Quecksilber oder eben Kadmium zum Schutz von Mensch und Umwelt komplett untersagen wollte, machte sie dann für die Solarbranche doch eine Ausnahme. Die besonders günstigen und leistungsfähigen Solarmodule der Firma First Solar enthalten nach Angaben vom vergangenen Jahr pro Stück etwa sieben Gramm der toxischen Schwermetallverbindung. Nach Erkenntnissen der unabhängigen Initiative "Lobbycontrol" gab First Solar im Jahre 2009 für Lobbyarbeit in Brüssel zwischen 100 000 und 150 000 Euro aus. Dass First Solar im Kampf gegen das Kadmium-Verbot "mit problematischen Mitteln vorgegangen ist", sei "nicht auszuschließen", heißt es in dem Dossier der unabhängigen Initiative weiter.

10. Beitrag zum Klimaschutz?

Solarstrom gilt als "saubere" Energie, die klimaschädliche, fossile Kraftwerke verdrängt. Doch für Solarenergie gilt dasselbe wie für alle Ökostromvarianten: Unter dem Dach des Europäischen Emissionshandelssystems führen sie lediglich dazu, dass Emissionen verlagert, aber nicht vermieden werden.

Der Mechanismus wird von Vertretern der Ökostrom-Branche zwar immer wieder angezweifelt, gilt aber im Grundsatz als unwiderlegt. Denn im Kampf gegen die Kohlendioxid-Emissionen in Deutschland und Europa ist seit 2005 der sogenannte Emissionshandel das erste Mittel der Wahl. Wirtschaftssektoren bis hinunter zum einzelnen Kraftwerk bekommen eine streng begrenzte Menge an Emissionszertifikaten zugeteilt. Das sind Gutscheine, die für den Ausstoß von jeweils einer Tonne Kohlendioxid (CO2) berechtigen. Anlagenbetreiber, die weniger CO2 ausstoßen als geplant, können überzählige Zertifikate am freien Markt verkaufen. Dieses System setzt marktwirtschaftliche Kräfte für den Klimaschutz frei und erzeugt "Preissignale", die dafür sorgen, dass die Investitionen der Unternehmen zuerst in die günstigsten und effizientesten Umwelttechnologien fließen.

Durch Subventionen für bestimmte Ökostrom-Techniken wird der Emissionshandel als marktwirtschaftlich konzipiertes Klimaschutzinstrument jedoch ausgehebelt. Denn der Solarausbau sorgt zwar für weniger CO2-Emissionen in Deutschland, doch zugleich fallen dadurch in gleichem Umfang die Preise für Emissionszertifikate an der Börse. Das führt dazu, dass "Vermeidungsmaßnahmen in anderen Sektoren nicht ergriffen werden, weil es kostengünstiger ist, stattdessen Zertifikate zu kaufen", beschreiben die Wissenschaftler des Essener Wirtschaftsinstituts RWI die Wirkung: Andere Industriesektoren im europäischen Ausland "weisen folglich höhere Emissionen auf und gleichen so die Emissionseinsparungen, die im deutschen Stromerzeugungssektor durch das EEG ausgelöst werden, gänzlich aus." Im Ergebnis, so die Ökonomen, "ergibt sich lediglich eine Emissionsverlagerung". Der "Nettoeffekt" jeglicher Ökostrom-Subventionen sei, jedenfalls solange das europäische Emissionshandelssystem existiert, genau "null".

Zudem stellt die Fotovoltaik die bei Weitem teuerste Art des Klimaschutzes dar. Wissenschaftler der Internationalen Energieagentur (IEA) oder des RWI haben errechnet, wie viel es kostet, den Ausstoß von jeweils einer Tonne des Treibhausgases Kohlendioxid aus einem fossilen Kraftwerkspark durch den Einsatz verschiedener Ökostrom-Techniken zu verhindern. Ergebnis: Die CO2-Vermeidungskosten der Fotovoltaik lagen zuletzt bei rekordverdächtigen 648 Euro je Tonne. Denselben Klimaschutzeffekt würde man mit Windkraft schon für 69 Euro pro Tonne erzielen. Die Tatsache, dass an der Europäischen Strombörse in Leipzig Emissionsgutscheine für nur 16 Euro pro Tonne gehandelt werden, weist darauf hin, dass die Fotovoltaik als reines Klimaschutzinstrument sogar rund 40-mal teurer ist als die günstigste derzeit verfügbare CO2-Vermeidungstechnik.

Die Subventionierung gerade der teuersten CO2-Vermeidungstechnik aber "konterkariert das Prinzip des Emissionshandels, den Treibhausausstoß dort zu verringern, wo es am kostengünstigsten ist", stellt Manuel Frondel, Leiter des Kompetenzbereichs Umwelt und Ressourcen des RWI fest. Fazit: Welche Gründe es für die Subventionierung von Solarstrom auch immer geben mag: Klimaschutz gehört eher nicht dazu.

Obwohl also fast kein Argument der Solar-Befürworter einer kritischen Überprüfung standhält, droht der Solarzubau weiterzugehen. Denn weil die Preise für Solarmodule dank der chinesischen Billiganbieter allein im ersten Halbjahr 2011 um rund 30 Prozent gefallen sind, bleibt es für Investoren in Deutschland ein äußerst lukratives Geschäft, sich Solarzellen aufs Dach zu setzen. So sagen die Anlageexperten der Investmentbank Morgan Stanley voraus, dass in diesem Jahr erneut die Leistung von 6500 Megawatt auf deutsche Dächer geschraubt werden wird. Und die Credit Suisse erwartet sogar einen Zubau von 7500 Megawatt Solarleistung. Das ist fast die Menge, die im bisherigen Rekordjahr 2010 aufgestellt wurde. Und es wird noch mehr: Branchenbeobachter erwarten, dass Deutschland im kommenden Jahr mit einer wahren Flut von Billig-Solarmodulen überschwemmt wird, weil andere große Abnehmerländer wie Tschechien oder Italien ihre Solarförderung bis dahin drastisch zurückfahren wollen. Deutschland aber, das als einziges Land übrig bleibt, das Solarenergie weiter in unbegrenzter Höhe und Menge fördert, dürfte dann den größten Teil der Weltproduktion an Modulen geradezu aufsaugen. Nach inoffiziellen, aber gleichlautenden Schätzungen aus Kreisen des Bundesumwelt- und des Bundeswirtschaftsministeriums könnte so im kommenden Jahr erneut mindestens 10 000 Megawatt Solarkraft hinzukommen. Eine gewaltige Überkapazität, die den Spielraum für die Förderung anderer, effizienterer Ökostromarten stark einschränkt, und damit die Chancen für eine nachhaltige ökologische Energiewende zu vertretbaren Kosten verringert. Denn falls die Wirtschaftspolitiker der Unionsfraktion kommende Woche mit ihrer Forderung nach Deckelung der Solarausgaben scheitern sollten, ist die Messe erst einmal gelesen, glaubt ein Kenner der Solarszene: "Dann wird es wohl bis weit nach der nächsten Bundestagswahl 2013 dauern, bis man sich wieder mit dem Thema beschäftigt und endlich jemand die Notbremse zieht."

Daniel Wetzel aus "Die Welt am Sonntag" vom 26.6.11

mit freundlicher Genehmigung

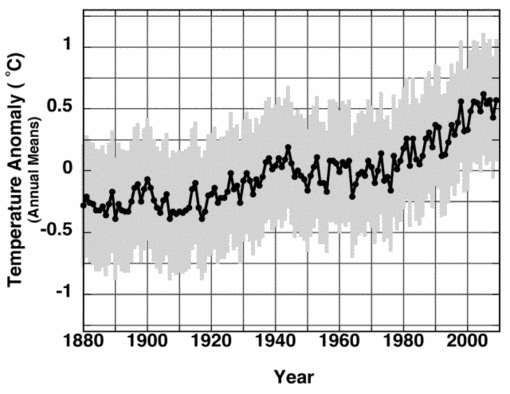

Feulner). Ein Abriss der wichtigsten Trendentwicklungen aus der Sicht des PIK. Die Diskussion im Anschluss war lebhaft. Herr Vahrenholt stellte den vorgetragenen Einfluss der solaren Aktivität – Herr Feulner stufte ihn mit 0,1 K als äußerst gering ein – in Frage. Er verwies auf neueste Untersuchungen von Shapiro (Shapiro et al 2011), wonach die TSI-Steigerung von der Kleinen Eiszeit bis heute möglicherweise 6 mal höher war als im AR4 angenommen. Verwiesen wurde auch auf ein in Januar 2010 erschienenen Paper von Solomon, wonach die Abkühlung der letzten 10 Jahre mit dem um 10 % verminderten Wasserdampf in der Stratosphäre in Zusammenhang gebracht wird.

Feulner). Ein Abriss der wichtigsten Trendentwicklungen aus der Sicht des PIK. Die Diskussion im Anschluss war lebhaft. Herr Vahrenholt stellte den vorgetragenen Einfluss der solaren Aktivität – Herr Feulner stufte ihn mit 0,1 K als äußerst gering ein – in Frage. Er verwies auf neueste Untersuchungen von Shapiro (Shapiro et al 2011), wonach die TSI-Steigerung von der Kleinen Eiszeit bis heute möglicherweise 6 mal höher war als im AR4 angenommen. Verwiesen wurde auch auf ein in Januar 2010 erschienenen Paper von Solomon, wonach die Abkühlung der letzten 10 Jahre mit dem um 10 % verminderten Wasserdampf in der Stratosphäre in Zusammenhang gebracht wird.  ppt Datei

ppt Datei  ppt Vortrag

ppt Vortrag ppt Datei

ppt Datei ppt Datei

ppt Datei

…

…