Teil 1 – Die Sonne bestimmt den Temperaturgang

Teil 2 – Die Sonne, der faszinierende Stern

Teil 3 – Sonnenflecken und ihre Ursachen

Teil 4 – Die Sonnenatmosphäre, Korona, Heliosphärische Stromschicht,

interplanetares Magnetfeld

Teil 5 – Die variable Sonne

Teil 6 – Der Einfluss der Sonne auf unser Wetter/Klima

Teil 7 – Der Einfluss der Sonne auf die Wolkenbedeckung über Svensmark hinaus

Teil 8 – Zukünftige Temperaturentwicklung und deren Schwankungen

Teil 8 – Zukünftige Temperaturentwicklung und deren Schwankungen

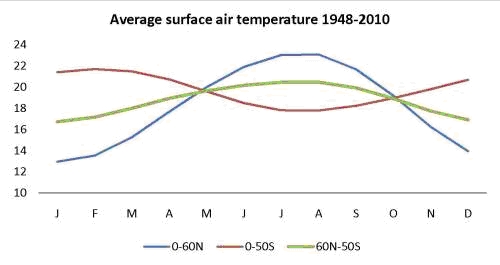

Da die Temperaturentwicklung ausschließlich von der solaren Aktivität abhängt, werden die Temperaturen mit der derzeit zurückgehenden Sonnenaktivität ebenfalls zurückgehen, so wie wir dies seit etwa 10 Jahren auch beobachten. Zu dieser Erkenntnis kommen NASA, wie auch das Space and Science Research Center (SSRC) in Orlando.

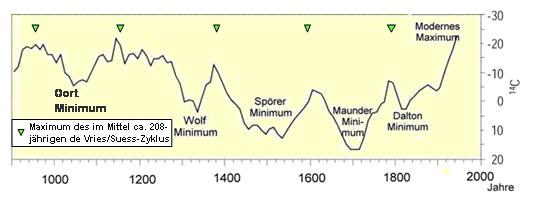

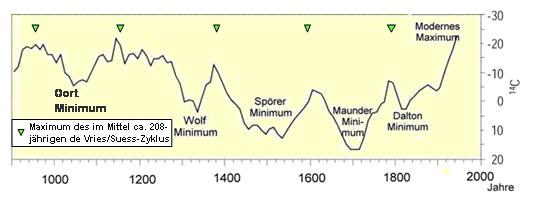

Wie dargelegt, bestimmt der Hauptsonnenzyklus, der im Mittel 208-jährige de Vries/Suess-Zyklus maßgeblich unser Klima. Er hatte zu Beginn des Jahrhunderts (2002/2003) sein Maximum. Wie nach jedem Hauptsonnenzyklus, gehen seither die Temperaturen deutlich zurück.

Abbildung 183 zeigt die Kälteperioden der letzten 1.100 Jahre (ergänzt nach Quelle: United States Geological Survey). Die Maxima der Warmperioden korrelieren jeweils mit dem Maximum des de Vries/Suess-Zyklus. Nach jedem Maximum fallen die Temperaturen deutlich.

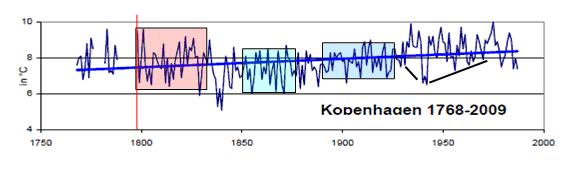

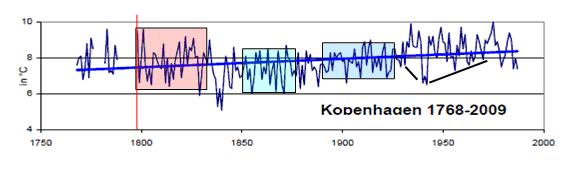

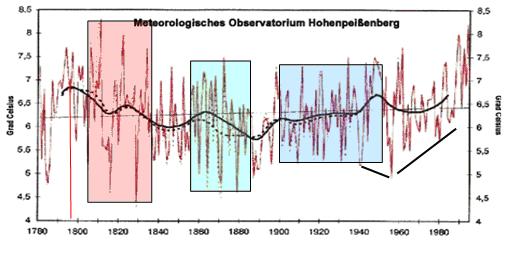

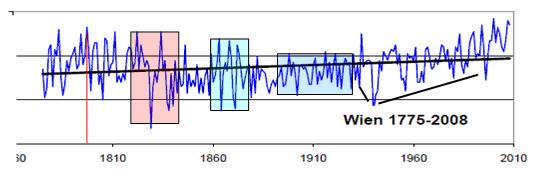

Daher werden der Temperaturverlauf ausgewählter Stationen nach dem davor liegenden Maximum des de Vries/Suess-Zyklus betrachtet. Dieses lag in den 1790-Jahren. Nur solche Stationen wurden betrachtet, in denen eine natürliche Schwingung zu sehen ist, um auszuschließen, dass menschliche Effekte, hier vor allen der Wärmeinseleffekt, auf den Temperaturverlauf störend wirken.

Abbildung 184, Quelle: Prof. Ewert, EIKE, zeigt den Temperaturgang von Kopenhagen im Zeitraum von 1768 – 2009. Die rote Linie gibt den Zeitpunkt des Maximums im Hauptsonnenzyklus an. Bis zu einem Zeitraum von 20 – 30 Jahren nach dem Hauptsonnenzyklus schwanken die Temperaturen noch stark zwischen warm und kalt (rote Fläche). Bis zum Erreichen seines Minimums, sind immer noch relativ hohe Temperaturausschläge zu verzeichnen, jedoch auf insgesamt niedrigerem Niveau (grüne Fläche). Unmittelbar vor und nach dessen Minimum ist das Klimasystem sozusagen in seinem eingeschwungenen, kalten Zustand und die Ausschläge sind am geringsten (blaue Fläche). Vor einem erneuten Temperaturanstieg (steigender Sonnenzyklus), fallen die Temperaturen auf ein Minumum und steigen dann kontinuierlich an (schwarze Linien).

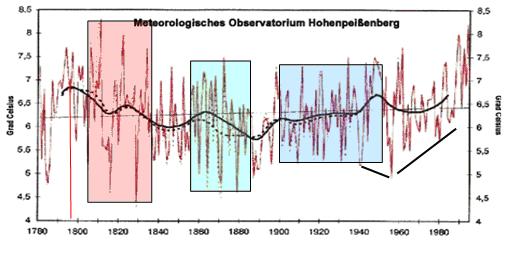

Abbildung 185, Quelle: (http://www.lanuv.nrw.de/luft/wirkungen/klima_grundlagen.htm) zeigt den Temperaturgang des Hohenpeißenberg von 1781-1995 nach Fricke 1997. Die rote Linie kennzeichnet wieder das Maximum des Hauptsonnenzyklus. Auch hier sind bis 30 Jahre nach dem Hauptsonnenzyklus starke Jahresschwankungen der Temperatur zu sehen (rote Fläche), die dann geringer werden (grüne Fläche) und nach dem Minimum im Hauptsonnenzyklus die geringsten Werte einnehmen (blaue Fläche).

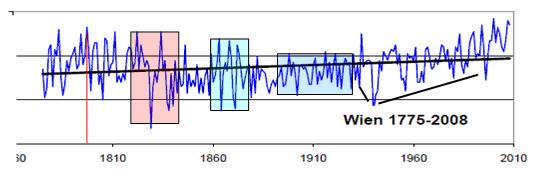

Abbildung 186: Zu sehen ist der Temperaturverlauf von Wien im Zeitraum von 1775 – 2008, Quelle: Prof. Ewert, EIKE. Der Temperaturverlauf verhält sich wie bei den vorherigen Datenreihen.

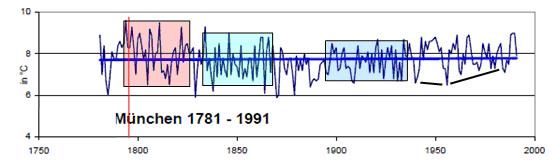

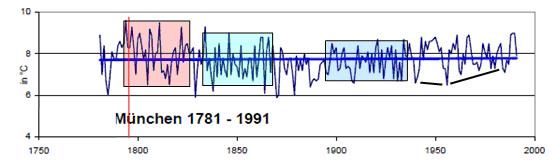

Abbildung 187: Ebenfalls das gleiche Bild bei der Temperaturgangreihe München im Zeitraum von 1781 – 1991.

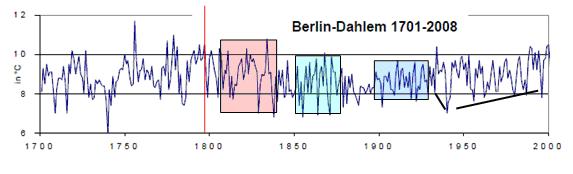

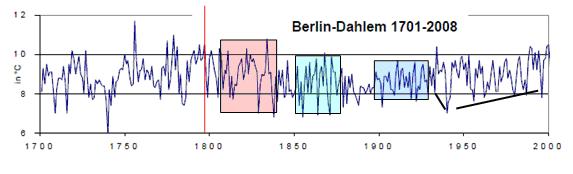

Abbildung 188: Temperaturgangreihe von Berlin-Dahlem von 1701 – 2008 mit den gleichen Merkmalen.

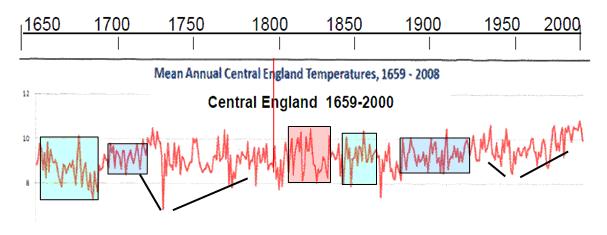

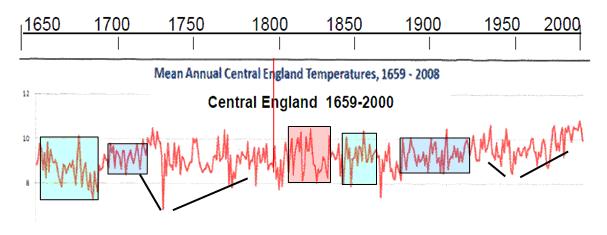

Abbildung 189: Temperaturgangreihe Zentralenglands von 1659 – 2000 (alle nicht eigens angegebene Quellen: Prof. Ewert, EIKE). Mit seinem ausgeglichenen Seeklima zwischen Atlantik und Nordsee nimmt England sicherlich eine Sonderstellung ein. Dies zeigt sich, dass hier die „grüne“ Phase von der „roten“ Phase nicht so stark differiert wie in Mitteleuropa. Aber auch hier ist das Muster, trotz der Moderation durch den Ozean, vorhanden. Die Temperaturgangreihe ist deshalb besonders interessant, weil sie bis 1659 zurückreicht und damit an einem weiteren Hauptsonnenzyklus gespiegelt werden kann (Maximum um 1590). Während der Epoche der "Kleinen Eiszeit" zeigt sich auch hier deutlich das typische Temperaturgangmuster. Auch beim davor liegenden Hauptsonnenzyklus, fallen zuerst die Temperaturen stark, bevor sie dann wieder ansteigen (schwarze Linien).

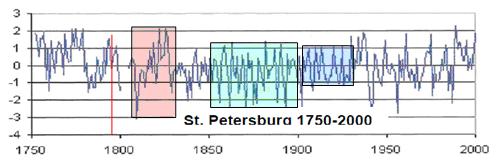

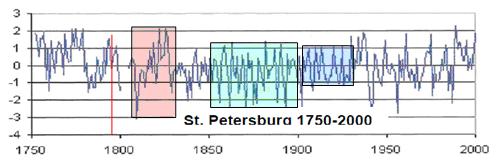

Abbildung 190: Eine weitere Region, neben Mitteleuropa und Großbritannien, St. Petersburg, zeigt ebenfalls das typische Muster des Temperaturganges nach einem Maximum im Hauptsonnenzyklus.

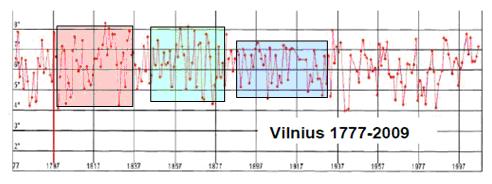

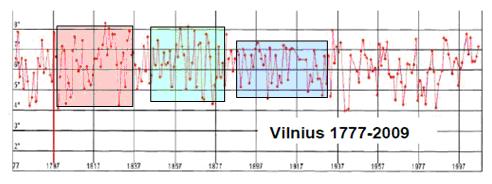

Abbildung 191: In Vilnius ein ähnliches Bild.

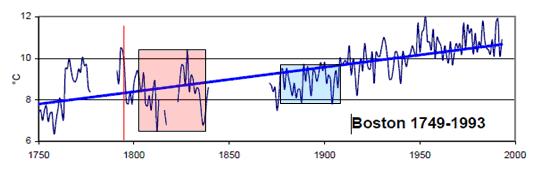

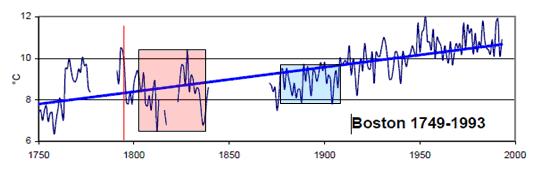

Abbildung 192: Nicht nur in Europa, sondern auch in Amerika ergibt sich das gleiche Muster des Temperaturganges nach einem Hauptsonnenzyklus, wenn auch hier sozusagen der mittlere Teil fehlt, weil keine Messungen vorhanden sind.

Fazit

Anhand der solaren Aktivitätsschwankungen, dem derzeitigen und weiteren Rückgang der solaren Aktivität, sowie der Vergleiche der Temperaturentwicklung nach einem Hauptsonnenzyklus, ist für die nächsten 40-50 Jahre mit einem spürbaren Rückgang der Temperaturen zu rechnen. Nach einem Hauptsonnenzyklus fallen die Temperaturen deutlich, dabei unterliegen sie hohen Schwankungen zwischen warm und kalt, wie wir es übrigens auch gegenwärtig wieder erleben, so dass der Temperaturgang für die nächsten 10 Jahre weiter diesen Extrema zwischen warm und kalt unterliegen sollte. Das Klimasystem verhält sich dabei wie ein physikalisch, elektrisches System, welches in seiner Übergangphase (Hystherese, beim Klima zwischen Warmzeit und Kaltzeit) empfindlich auf Veränderungen in seinen Eingangsgrößen reagiert. Im eingeschwungenen Zustand (z.B. kalt) ist es weitgehend stabil und nur geringen Schwankungen unterworfen. Ca. 40 – 50 Jahre nach einem Maximum im Hauptsonnenzyklus, sind die Schwankungen zwischen warm und kalt weiterhin relativ hoch, allerdings auf insgesamt niedrigerem Niveau. Im „eingeschwungenen“ Zustand ist das System stabil auf niedrigem Niveau.

Obwohl die Untersuchungen anhand eines, bzw. 2 Hauptsonnenzyklen sicherlich zu gering sind, um eine abschließende Aussage treffen zu können, zeigt sie, dass starke Temperaturschwankungen zwischen warmen und kalten Jahren in den ersten Jahrzehnten nach einem Hauptsonnenzyklus, insbesondere in Mitteleuropa, nichts ungewöhnliches darstellen. Die heutigen Schwankungen passen somit in sehr guter Weise zu den historischen.

Lässt sich darüber hinaus eine weiter gehende Prognose für die Temperaturentwicklung herleiten. Der Autor hält dies nicht grundsätzlich für unmöglich, wenn dazu weitere solare Zyklen, wie der Hallstatt-Zyklus, der die Hüllkurve des de Vries-Suess-Zykluss darstellt zu Grunde gelegt werden. Sonnenzyklen bestimmen nicht nur auf kurzen Zeitskalen, sondern auch auf langen Zeitskalen das Klima auf der Erde, wie die folgenden Abschnitte zeigen.

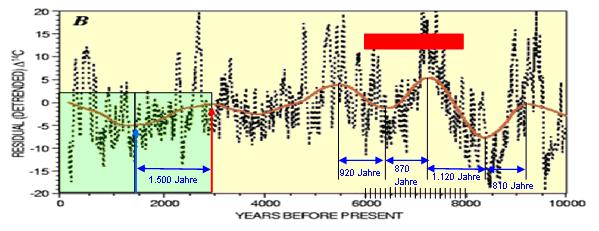

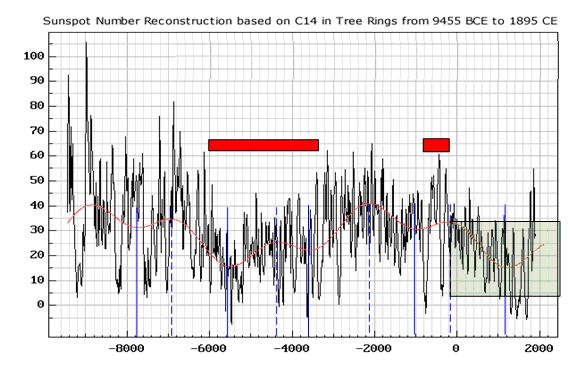

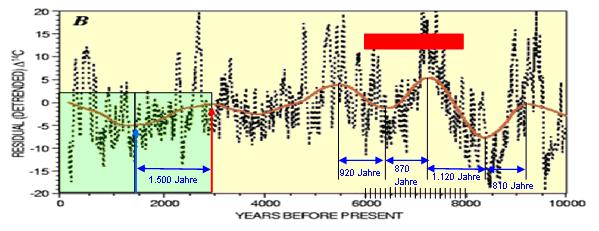

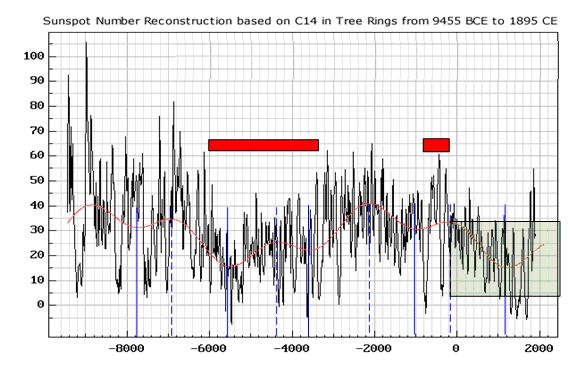

Abbildung 193 zeigt den im Mittel 2.300 Jahre dauernden Hallstatt-Zyklus (geglättete Kurve), gewonnen aus 14C-Werten aus Baumringen (schwarze Kurve: de Vries-Suess-Zyklus), Quelle: United States Geological Survey, “The Sun and Climate“, August 2000. Der Autor hat hierzu die Zyklenzeiten, bzw. Halbzyklenzeiten, (zwischen zwei Extrema) eingefügt. Deutlich ist zu sehen, dass die Länge des Hallstatt-Zyklus zur Gegenwart hin zunimmt. Zwischen letztem Maximum (roter, senkrechter Pfeil) und Minimum (blauer, senkrechter Pfeil) liegt eine Zeitspanne von 1.500 Jahren (grünes Rechteck). Sein letztes Minimum hatte er um 650 nChr. Seinerzeit herrschten übrigens besonders kühle Temperaturen. Wird dieses grüne Rechteck gespiegelt, so zeigt sich, dass der Hallstatt-Zyklus nach dieser 14C-Auswertung sein Maximum um das Jahr 2150 haben wird (in der Abbildung ist die Skalierung der letzten 500 Jahre nicht maßstabsgerecht zu den übrigen, deshalb scheint es, dass das Maximum um das Jahr 2000 liegt). In der Zeit des Holozän-Klimaoptimums (roter Balken) war die Zykluszeit wesentlich kürzer.

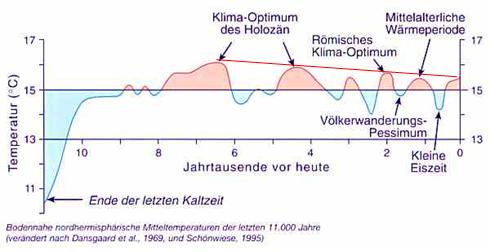

Anhand dieser Untersuchung (längere Zykluszeiten) ist davon auszugehen, dass der Trend des Temperaturrückgangs im Holozän, wie es die Arbeit von Schönwiese zeigt, fortgeführt wird.

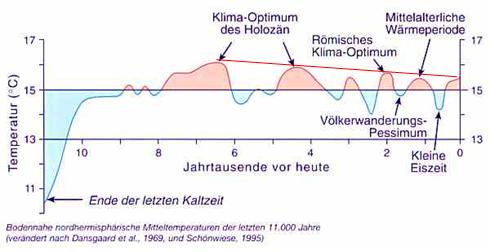

Abbildung 194, Temperaturgang im Holozän nach Schönwiese und dazu vom Autor, der linearen Trend (rot).

Die Analogie, dass mit kurzen Zyklenzeiten, höhere Temperaturen verbunden sind, wird durch die Untersuchungen erhärtet, dass auch beim Schwabe-Zyklus (kleine Skalen), die Zeiträume mit kurzen Zyklenzeiten, zu der aktiven Sonne und damit zu den Warmzeiten gehören! Erreicht der Hallstatt-Zyklus sein nächstes relatives Maximum, ist davon auszugehen, dass für mindestens die nächsten 1.500 Jahre der Temperaturtrend nicht nach oben, sondern im Gegenteil, nach unten, zu kälteren Temperaturen geht.

Abbildung 195 dient zum Vergleich der Ergebnisse aus der Abbildung 193. Sie stammt von Solanki, S.K., et al. 2005 (geglättete rote Kurve: Ray Tomes, “Cycles in Sunspot Number Reconstruction for 11,000 Years” – anhand von Berechnungen der Ausgleichskurve gibt Tomas das Maximum der Ausgleichskurve – Hallstatt-Zyklus – im Jahr 2.293 an). Auch diese Arbeit zeigt deutlich den Hallstatt-Zyklus. Wie in der Darstellung der USGS, war dessen Zykluszeit während des Holozän-Optimums kurz. Bei Solanki et al. auch der ansteigende Zyklus während des römischen Klimaoptimums (rechter rote Balken). Auch bei Solanki et al. werden die Zykluszeiten des Hallstatt-Zyklus zur Gegenwart hin länger, was dafür spricht, dass es einen, dem Hallstatt-Zyklus übergeordneten Sonnenzyklus gibt, der dessen Zykluslänge bestimmt. Nach der Untersuchung von Solanki et al., steigt der Hallstatt-Zyklus noch bis ca. zum Jahr 2.200 an, was in etwa der Untersuchung der USGS entspricht. Erst danach geht die solare Aktivität für längere Zeit (mindestens 1.500 Jahre, bis zum nächsten relativen Minimum im Hallstatt-Zyklus) wieder zurück. Nach M. A. Xapsos und E. A. Burke, ”Evidence of 6000-Year Periodicity in Reconstructed Sunspot Numbers” (Solar Physics, Volume 257, Number 2, 363-369) gibt es diesen, dem Hallstatt-Zyklus, zeitlich übergeordneten Sonnenzyklus.

Die folgende Abbildung bestätigt ebenfalls den Temperaturtrend nach dem Hallstatt-Zyklus bis zum Jahr 2.200.

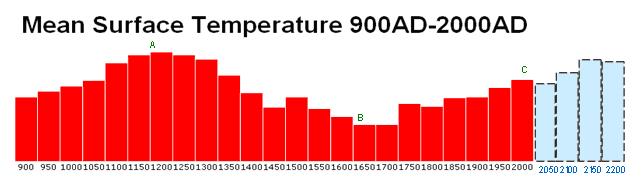

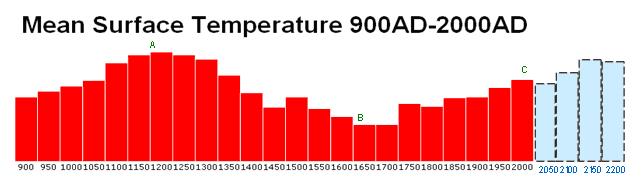

Abbildung 196 zeigt die gemittelten Temperaturen (rot) in 50-Jahresintervallen Quelle: (http://www.abd.org.uk/pr/274.htm). Deutlich ist eine Schwingung zu erkennen, die nur auf natürliche Ursprünge zurückzuführen ist. Wird die ansteigende Zykluslänge gleich der absteigenden gesetzt (komplette Schwingung), so ergibt sich das erweiterte Bild (grau) bis zum Jahr 2.200. Auch hier steigen bis um das Jahr 2150 die Temperaturen noch an. Der Temperaturrückgang nach C, also bis zum Jahr 2050, gibt zum einen, den bisherigen 10-jährigen Temperaturrückgang wieder, die bevorstehende zurückgehende Sonnenaktivität, sowie die Temperaturentwicklung nach dem davor liegenden Maximum des Hauptsonnenzyklus, nach dem die Temperaturen ebenfalls zurückgingen (rote Säule bei 1800).

Diese, auf langen Zeitskalen wirkenden solaren Aktivitäten geben den Langfristtrend an. Sie geben keine Auskunft über kurzfristige Schwankungen. Hierzu sind, wie gezeigt, die solaren Zyklen, wie Schwabe- und de Vries/Suess-Zyklus notwendig. Diese zeigen die klimatischen Veränderungen auf Zeitskalen von Jahren, bzw. Jahrzehnten. Anhand derer, in den nächsten 30-40 Jahren eine deutliche Abkühlung eintritt, wie wir sie seit einigen Jahren bereits beobachten.

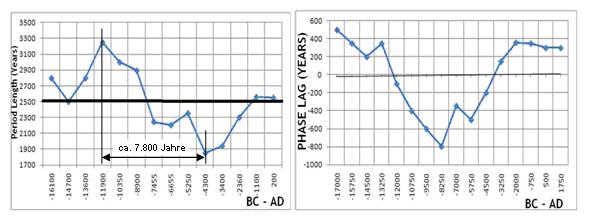

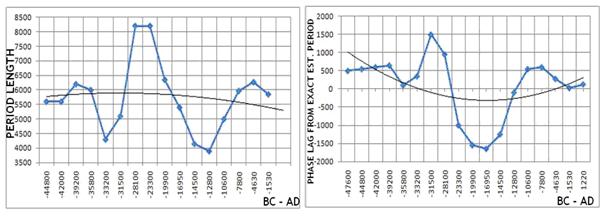

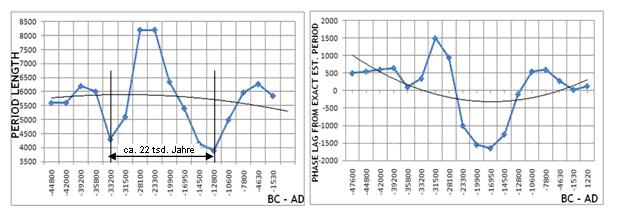

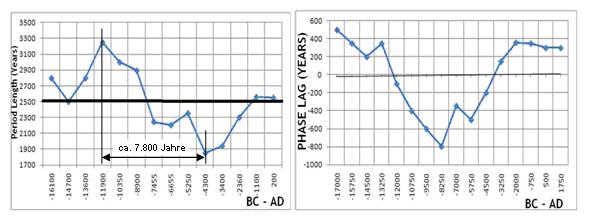

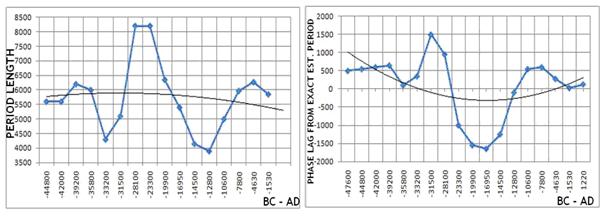

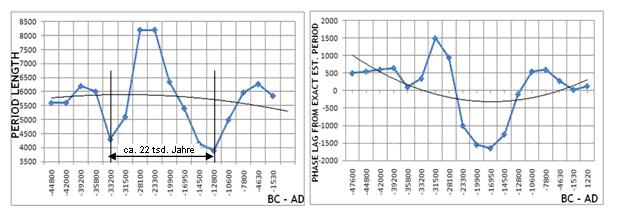

Die beiden Charts in Abbildung 197, Quelle: (http://garymorris93.cwahi.net/weather/solar_variations.html), zeigen Periodendauer (links) und Phasenverzögerung (rechts) des Hallstatt-Zyklus. Deutlich zu sehen, dass während des Klima-Optimums im Holozän, Zykluszeit und Phasenverzögerung sehr gering, bzw. stark negativ waren, was für eine starke solare Aktivität typisch ist! Dessen Periodendauer hat wiederum einen Zyklus von ca. 7.800 Jahren.

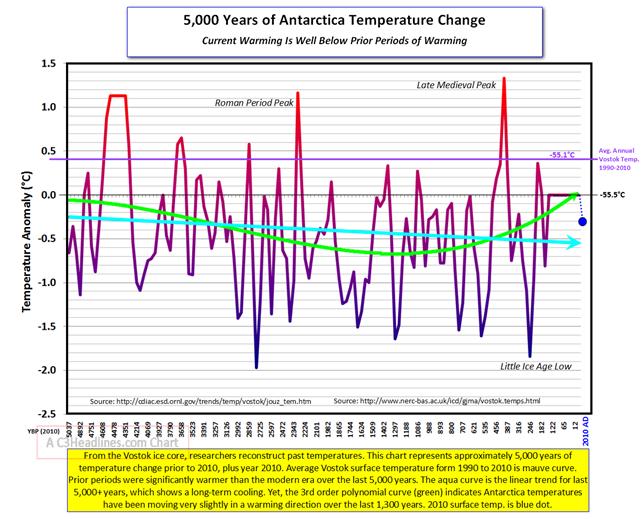

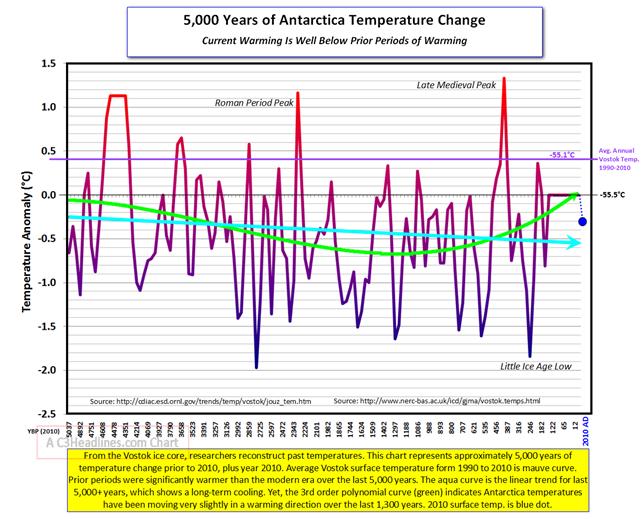

Abbildung 198 zeigt den Temperaturgang in der Antarktis der letzten 5.000 Jahre (http://www.c3headlines.com/). Deutlich zeichnen sich die Warmperioden der mittelalterlichen Warmzeit, des römischen Klimaoptimums und dem Holozänoptimum ab. Das gegenwärtige Temperaturniveau ist als mäßig einzustufen. Allein in 13 Zeitabschnitten war es in den letzten 5.000 Jahren wärmer als heute. Seit Beginn dieses Jahrhunderts ist wieder ein deutlicher Temperaturrückgang zu verzeichnen. Die derzeitigen Temperaturen (2010) sind als moderat einzustufen. Der Trend ist negativ (türkisfarbener Pfeil)

Im Betrachtungszeitraum ist deutlich ein Schwingverhalten (grün) zu sehen, mit Extrema vor ca. 1.000 Jahren und vor ca. 4.500 Jahren, was nur auf natürliche Ursachen zurückzuführen ist. Anhand der halben Periodenlänge, die auf der Abbildung zu sehen ist, beträgt die gesamte Schwingungsdauer für einen Zyklus ca. 7.800 Jahre. Dies ist dieselbe Schwingungszeit, wie sie die Sonne bei ihren Langzeitaktivitätsschwankungen in Abbildung 197 aufweist. Auch die Extrema in Abbildung 197 stimmen recht gut überein mit Abbildung 198 überein – vor ca. 1.100 Jahren und vor ca. 4.300 Jahren.

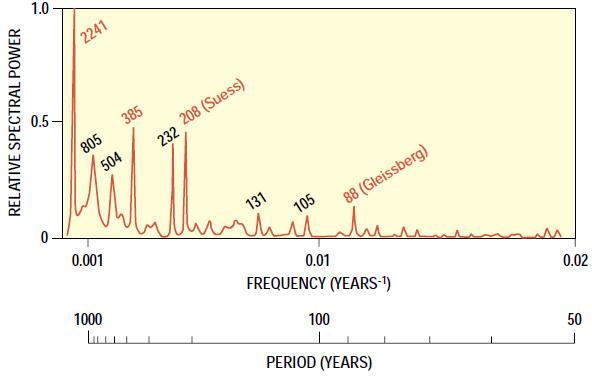

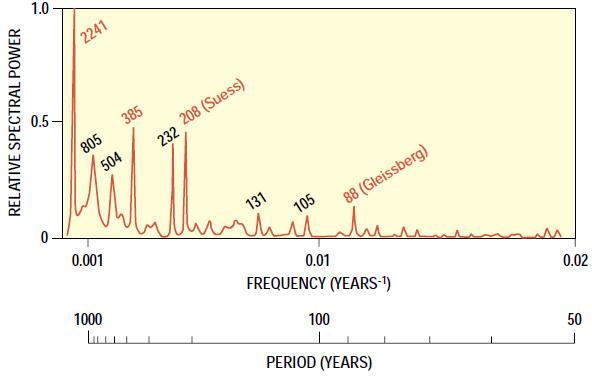

Abbildung 199, Quelle: United States Geological Survey, “The Sun and Climate“, August 2000, zeigt das Energiespektrum der 14C-Daten. Deutlich sind Maxima zu erkennen, die Sonnenzyklen zuzuordnen sind.

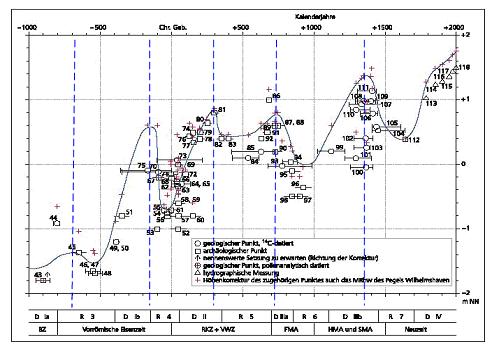

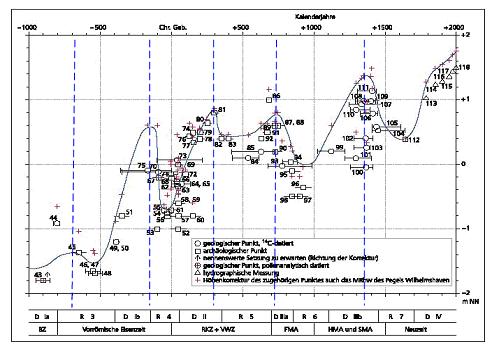

Abbildung 200, Quelle: K.E. Behre, “Probleme der Küstenforschung“, Band 28, Isensee-Verlag, 2003, zeigt die Meeresspiegelschwankungen an der deutschen Nordseeküste. Deutlich sind Schwingungen, mit einer mittleren Länge von ca. 510 Jahren zu sehen. Diese passen zu der vorherigen Abbildung, die zeigt, dass Anhand der Spektralanalyse eine Periode in der solaren Aktivität mit einer Länge von 504 Jahren vorhanden ist.

Über die direkte Sonnenaktivität hinaus, sind auch die Bahnparameter der Erde variabel. Langanhaltende periodische Änderungen in der solaren Einstrahlung, verbunden mit den Bahnparametern der Erde, sind die Milanković-Zyklen, die Änderungen in der Erdbahn, Neigung Erdachse, Änderung der Jahreszeiten auf der Erdbahn und Erdumlaufbahn um die Sonne beinhalten.

Milanković-Zyklen:

a) Exzentrizität: Form des elliptischen Orbits um die Sonne

Es findet eine Verschiebung der Sonneneinstrahlung zwischen den Erdhalbkugeln statt. Die Halbachsen können zwischen 0,005 und 0,058 variieren. Der Unterschied in der Sonneneinstrahlung variiert dabei zwischen 27 W/m2 und 314 W/m2 (Prof. Weber). Bei 0,0 sind beide elliptischen Halbachsen gleich (Kreisbahn). Mit zunehmender Exzentrizität wird die Erdbahn zunehmend zur Ellipse, wodurch sich im Laufe einer Umlaufbahn (Jahr) ständig der Abstand Erde zur Sonne und damit der Leistungseintrag ändert, was zu Temperaturschwankungen führen kann, aber nicht zwangsläufig führen muss, da Obligität und Präzession den Effekt entweder abschwächen, aber auch verstärken können. Es findet also eine Überlagerung statt.

Gegenwärtig beträgt die Exzentrizität 0,0174, was 6,7% mehr Einstrahlung auf der Südhalbkugel bedeutet. Bei 0,058 beträgt der Unterschied ca. 28%. Die Periodendauer schwankt aus Gründen des Gravitationseinflusses der großen Planeten von 90.000 – 100.000 Jahre.

Obligität: Neigung der Erdachse

Bei starker Neigung gibt es ausgeprägtere Jahreszeiten und starke Schwankungen der absorbierten Sonnenenergie in den hohen Breiten. Die Schwankungsbreite beträgt 21,30° – 24,36°. Der heutige Wert liegt bei 23,47°. Auf der Nordhalbkugel (große Landmassen) wird die Abkühlung verstärkt, wenn die Neigung am geringsten ist. Schnee kann im Sommer wegen mangelnder Wärme nicht mehr ausreichend geschmolzen werden. Die Periodizität beträgt 40.000 – 41.000 Jahre. Die Sonneneinstrahlung variiert dabei um 30 W/m2 (Prof. Weber).

Durch die Neigung der Erdachse ändert sich der Einstrahlwinkel der Sonnenstrahlung auf die Erde. Der Bereich, in dem diese senkrecht auf die Erde fallen, wird subsolare Zone genannt.

Mit zunehmender Neigung der Erdachse verschiebt sich die subsolare Zone (der Begriff wird überwiegend im englischen verwendet) mehr und mehr in die gemäßigten Zonen und damit in Richtung Nord- oder Südpol (folgende Abbildung). Dies hat zur Folge, dass die Sonneneinstrahlung zwischen Sommer und Winter in diesen Breiten mehr und mehr schwankt, was zu heißen Sommern und kalten Wintern führt. Es herrscht dann ein Klima, mit großen Temperaturschwankungen. Eine geringere Neigung der Erdachse führt demnach zu einem ausgeglicheneren Klima.

Abbildung 201 (Quelle: www.Biosphaere.info) zeigt die Lage der subsolaren Zone (Sonne steht senkrecht am Firmament) zur Obligität und die Abbildung rechts die ihre tatsächliche Wanderung über das Jahr, Quelle: (http://joseph-bartlo.net/supp/sungeo.htm).

c) Präzession: der Erdachse und des Orbits – Wanderung des Frühlingspunktes

Die Präzession (vom lateinischen praecedere = voranschreiten) moderiert das Timing der Jahreszeiten. Nach jeder Sonnenumrundung kehrt die Erde nicht mehr genau an ihre Ausgangsposition zurück, sondern „wandert“ dabei in ihrem Orbit geringfügig vorwärts durch die Tierkreiszeichen. Derzeit erreicht die Erde z.B. ihre größte Nähe zur Sonne am 03. Januar. Der Zyklus dauert 25.780 Jahre. Dabei ändert sich nicht der Einstrahlungsbetrag, sondern der Zeitpunkt.

Mit Änderungen in der solaren Aktivität selbst, befassen sich die Milanković-Zyklen nicht. Daher soll an dieser Stelle nach langperiodischen Schwingungen gesucht werden, die den Milanković-Zyklen entsprechen.

Abbildung 202: Periodenlänge (links) und Phasenverschiebung (rechts) des 5.800 Jahres-Zyklus, der Einfluss auf den 200- und den 2.300-Zyklus hat, Quelle: (http://garymorris93.cwahi.net/weather/solar_variations.html). Auffallend ist, dass während dem Höhepunkt der letzten Eiszeit, vor 20.000 Jahren, die Zykluszeit sehr lang und damit die solare Aktivität entsprechend gering war. Zum Ende der letzten Eiszeit vor ca. 12.500 Jahren erreichte die solare Aktivität hohe Werte (geringste Periodenlänge).

Es liegt der Schluss nahe, dass neben den Milanković-Zyklen, die die Abhängigkeit der solaren Einstrahlung zu den Bahnparametern der Erde wieder geben, zusätzlich die solare Aktivität in großen Zeitskalen stark schwankt und die Milanković-Zyklen, die die Änderung in der Erdbahn und damit verbunden, eine Änderung in der solaren Einstrahlung, die die Erdoberfläche erreicht beschreiben, die Einflüsse, die zu den Milanković-Zyklen führen, auch direkt die Sonnenaktivität ändern. Da die Milanković-Zyklen durch die Planeten des Sonnensystems verursacht werden und nach Landscheidt die Planeten die Sonnenaktivität auf kurzen und mittleren Zeitskalen moderieren, liegt der Schluss nahe, dass die Planeten nicht nur die Zeitintervalle der Erdbahnparameter, sondern auch die Sonne selbst auf langen Zeitskalen beeinflussen.

Die spannende Frage, wann oder ob sich die seit etwa 3 Millionen Jahre beobachteten Eiszeitintervalle fortsetzen, lässt sich anhand der derzeit vorliegenden Erkenntnisse über die solare Aktivität nicht beantworten. Sie lässt sich derzeit in erster Linie statistisch bewerten.

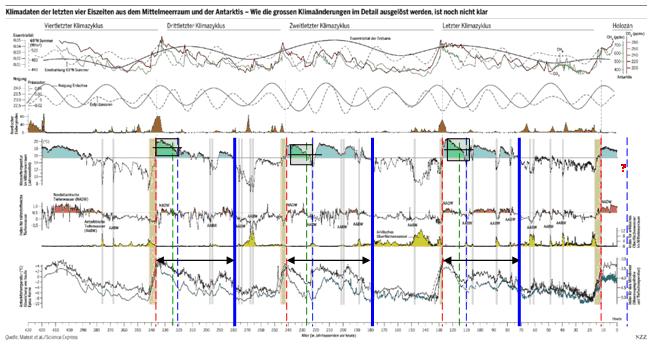

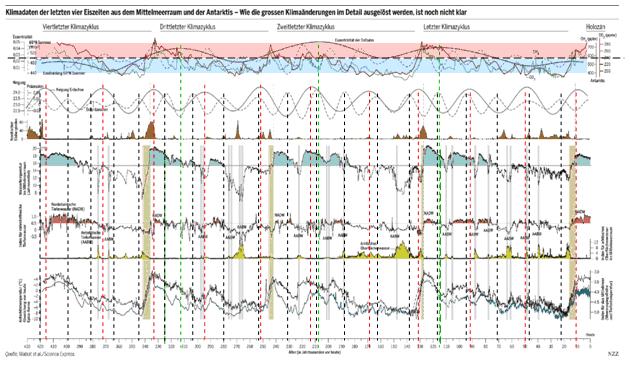

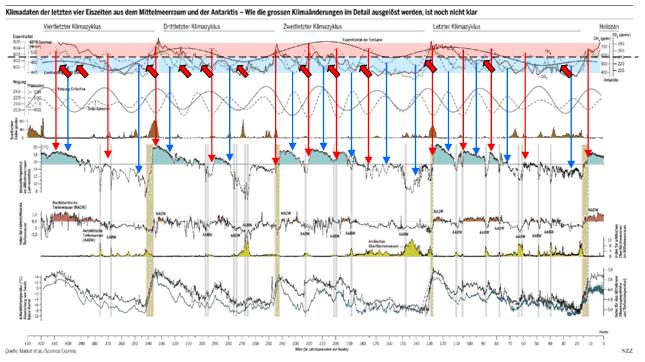

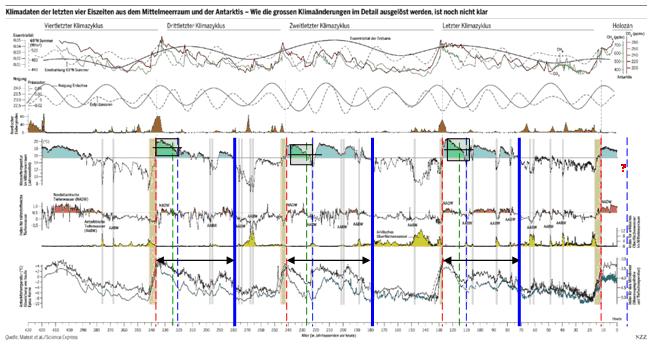

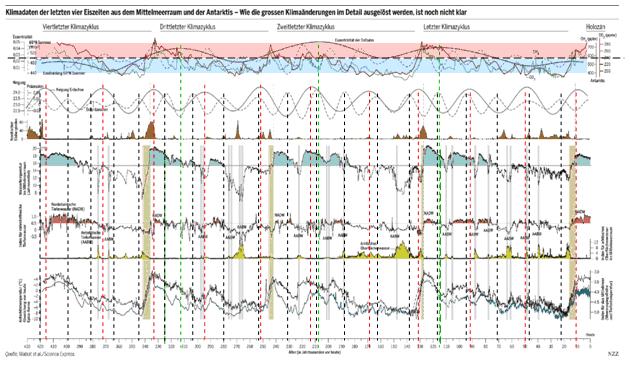

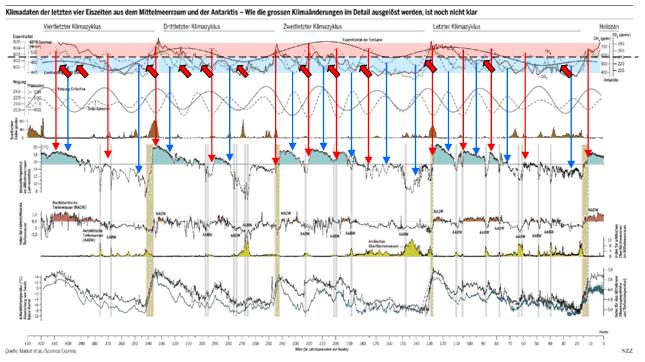

Abbildung 203, Quelle: NZZ vom 11. Juli 2007, “Genauere Informationen über die abrupten Klimaänderungen der Eiszeiten“ (Original: Matrat et al.) zeigt oben die Bahnparameter der Erde, Mitte, die Temperatur im Mittelmeerraum und unten, in der Antarktis. Im Betrachtungszeitraum sind drei ganze Eiszeitperioden zu sehen. Nach jedem Temperaturmaximum (rote gestrichelte Linie) kommt es zu einem typischen Temperaturrückgang nach gleichem Muster (blaue gestrichelte Linie). Die Zeitspanne dazwischen ist relativ konstant und beträgt ca. 18.000 Jahre. Die grüne gestrichelte Linie markiert den Zeitpunkt (ca. 13.700 Jahre nach Max), in dem die Temperatur dort ihren Mittelwert erreicht, also den Übergang zu kälteren Temperaturen im Betrachtungszeitraum durchschreitet.

Wie die Abbildung weiter zeigt, lag in den vergangenen drei Eiszeiten die großräumige Vereisung (blaue, durchgezogene Linie) in einem deutlichen Zeitabstand zum Temperaturmaximum. Die Zeitabstände sind wieder relativ konstant und legen den Beginn 55 – 60 tsd. Jahre nach Beginn des Temperaturmaximums. Inwieweit diese Temperaturmuster auf den jetzigen Zyklus, dessen Warmzeit vor ca. 12.500 Jahren begann, übertragen werden können, ist, wie eingangs genannt, derzeit wissenschaftlich nicht zu beantworten. Nach der statistischen Fortschreibung, stünde das Unterschreiten des Mittelwertes, also der Begin zu dauerhaft kühleren Jahren (blaue gestrichelte Linie) in ca. 1.200 Jahren an. Anhand der bekannten solaren Zyklen, beginnt zu diesem Zeitpunkt das solare Minimum im nächsten Hallstatt-Zyklus. Nach weiteren 5.000 Jahren beginnt der erste Kältezyklus. Dessen Dauer beträgt anhand der vorherigen Zyklen 2 – 3 tsd. Jahre.

Eine großräumige Vereisung, was allgemein mit dem Begriff “Eiszeit“ assoziiert wird, steht nach dieser statistischen Betrachtung erst in ca. 42 tsd. Jahren an. Wissenschaftsberichte, wie “Verhinderte der Mensch eine Eiszeit“ aus S.d.W. 02/06, der folgenden Untertitel trägt: “Anscheinend haben schon die Bauern der Jungsteinzeit einen bedeutenden Treibhauseffekt ausgelöst, als sie bei der Rodung von Wäldern und dem Anbau von Nassreis große Mengen Kohlendioxid und Methan freisetzten“ sind denn vor dem Hintergrund der realen Temperaturer-eignisse der letzten Eiszeiten, in denen die erste Warmepoche im Durchschnitt 18.000 Jahre andauert, blühender Unsinn und als solcher nicht zu überbieten. Es ist der tragische, zum scheitern verurteilte Versuch, einen nicht existierenden Effekt, den Treibhauseffekt herleiten zu wollen. Im vorliegenden Fall aus der Geschichte der Menschheit, um ihm damit eine vermeintliche Realität geben zu wollen. Aber auch hier hält der Wunsch der Wirklichkeit nicht stand. Anstatt weiter den Fokus in Richtung sog. THG zu lenken, sollten die Mittel besser in die Sonnenforschung investiert werden, um ihr die Geheimnisse zu entreißen, die uns die Frage beantworten, wann sich die klimatischen Bedingungen auf der Erde wirklich ändern.

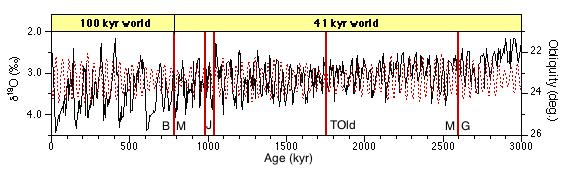

Für Langfristbetrachtungen der Temperaturentwicklung werden, wie bereits geschildert, die Milanković-Zyklen herangezogen. Dies ist darauf begründet, dass das Klima der letzten 3 Millionen Jahre, als die Erde wieder größere Vereisungen aufweist, zwischen zwei Zeitzyklen, die den Milanković-Zyklen entsprechen, pendelt (folgende Abbildung)

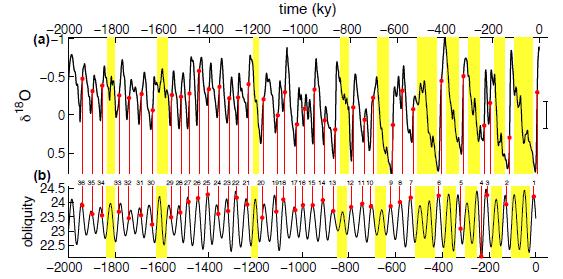

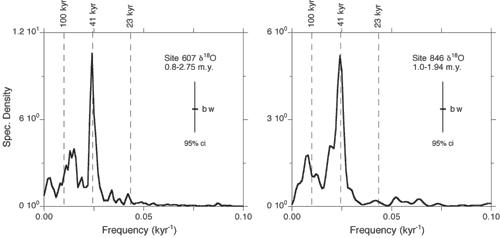

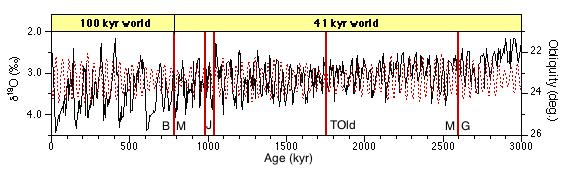

Abbildung 204, Quelle: (http://www.moraymo.us/current_projects.php) zeigt die aus dem Sauerstoffisotopenverhältnis ermittelten Temperaturschwankungen der letzten 3 Millionen Jahre. Von 3 Mio. Jahren bis vor ca. 700.000 Jahren schwankte die Temperatur zyklisch in Zeiträumen von 41.000 Jahren. Danach wechselte der Zyklus zu 100.000 Jahren. Der 41 ky-Zyklus steht allgemein für die Obligität und der 100 ky-Zyklus für die Exzentrizität. Der Grund für diesen Wechsel ist in der Wissenschaft nicht verstanden. Rot gepunktet = Obligität, B/M = Brunhes–Matuyama-Event, J = Jaramillo-Event, Told = Top of Olduvai-Event, G/M = Gauss/Matuyama – Event (jeweils Wechsel im Magnetfeld der Erde). An der Gauss/Matuyama-Grenze beginnt das Quartär, also die jüngste Erdepoche, die auch als Eiszeit bekannt ist.

Da in der Abbildung 203 zu dem Temperaturgang, sowohl alle drei maßgeblichen Milanković-Zyklen (Präzession, Obligität und Exzentrizität), sowie die daraus berechnete solare Einstrahlung für 65° Nord aufgezeigt sind, sollen ihre Extrema an der Temperaturentwicklung gespiegelt werden. In der ersten Abbildung, die Extrema von Präzession, Obligität und Exzentrizität.

Abbildung 205: Die Erdbahnparameter (Präzession und Exzentrizität), sowie die Neigung der Erdachse (Obligität), die die Einwirkung der Solarstrahlung auf der Nord-/Südhalbkugel moderiert, sind ganz oben, bzw. direkt darunter zu sehen. Die längste Periode hat die Obligität. Deren Maxima (Erdbahn besonders elliptisch) fallen jeweils mit Warmperioden der Eiszeitepochen zusammen (grüne gestrichelte Linien). Dies passt nicht zur These, da eine Kreisbahn die Erde am nächsten zur Sonne bringt. Extrema der Obligität (rote gestrichelte Linien) und Präzession (schwarze gestrichelte Linien) haben überhaupt keine Übereinstimmung zu Temperaturereignissen auf der Erde. Beide fallen sowohl mit Warm- als auch mit Kaltzeiten zusammen. Ganz oben sind noch die Pegel von CO2 und CH4 zu sehen die zu gar nichts passen.

Matrat et al. haben in Ihrer Datenreihe anhand der Milanković-Zyklen auch den berechneten Wert für die solare Einstrahlung für 65° nördlicher Breite angegeben. Dieser geographische Bereich ist besonders von Eiszeiten betroffen und dementsprechend dynamisch.

Abbildung 206: Die gestrichelte schwarze Datenreihe zeigt die Dynamik der solaren Einstrahlung für die letzten 420.000 Jahre für 65° Nord. Sie schwankt etwa zwischen 440 W/m2 und 550 W/m2. Der Autor hat die Bereich über dem Mittelwert rot (wärmer) und die Bereiche unter dem Mittelwert blau (kälter) gekennzeichnet. Manche Maxima/Minima in der berechneten solaren Einstrahlung stimmen mit dem Temperaturgang überein, andere wiederum nicht. Teilweise müsste es wärmer werden, wird aber kälter und teilweise kälter, wird aber wärmer (rote Blockpfeile). Zwei Beispiele: Am ersten Blockpfeil fällt die solare Einstrahlung stark ab, die Temperaturen bleiben aber konstant warm. Am dritten Blockpfeil steigt die solare Einstrahlung stark an, die Temperatur fällt jedoch auf ein absolutes Minimum. Rote Pfeile geben die Maxima und blaue Pfeile der Minima wieder.

Die Milanković-Zyklen geben kein einheitliches Bild zum Temperaturgang wieder, was auch in der folgenden Abbildung sichtbar wird.

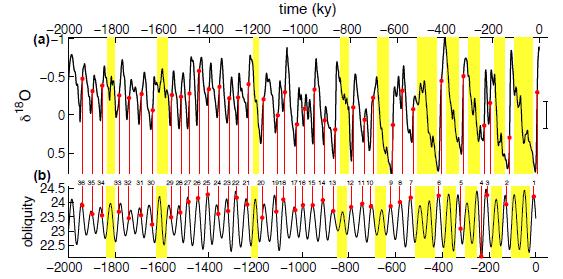

Abbildung 207, Quelle: ”Pleistocene glacial variability as a chaotic response to obliquity forcing”, P. Huybers, Department of Earth and Planetary Sciences, Harvard University (2009), zeigt unten die Obligität und oben die aus 18O rekonstruierte Temperatur. Die Ganglinien sind uneinheitlich zueinander.

Wenn die Milanković-Zyklen die Temperaturentwicklung nicht eindeutig genug wiedergeben, sog. THG keine Rolle spielen, schon allein deswegen nicht, weil z.B. CO2 der Temperatur nachläuft und nicht vorläuft, bliebe noch die variable Sonne, die die Temperaturzyklen steuert.

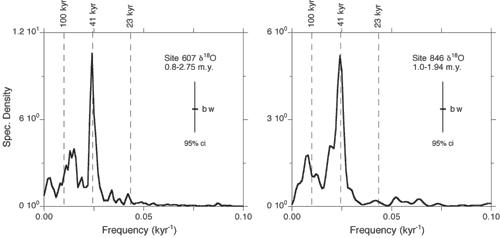

Abbildung 208 zeigt das Frequenzspektrum der Temperaturdaten im Pleistozän. In beiden Arbeiten bilden sich Maxima bei 23 ky, 41, ky und 100 ky aus, die den Milanković-Zyklen zugeordnet werden, Quelle: (http://www.moraymo.us/current_projects.php).

Gibt es Sonnenaktivitätszyklen, die in ihrer Länge den Milanković-Zyklen entsprechen – Ja!

Abbildung 209 (http://garymorris93.cwahi.net/weather/solar_variations.html): Der 6.000-jährige Sonnenzyklus, der den Hallstatt-Zyklus moderiert zeigt, dass ihm ein Zyklus mit einer Länge von ca. 22.000 Jahren übergeordnet ist. Darüber hinaus gibt es einen 100.000 Jahres-Zyklus in der Sonnenaktivität, der damit dem Milanković-Zyklus der Exzentrizität entspricht, Abbildung 210.

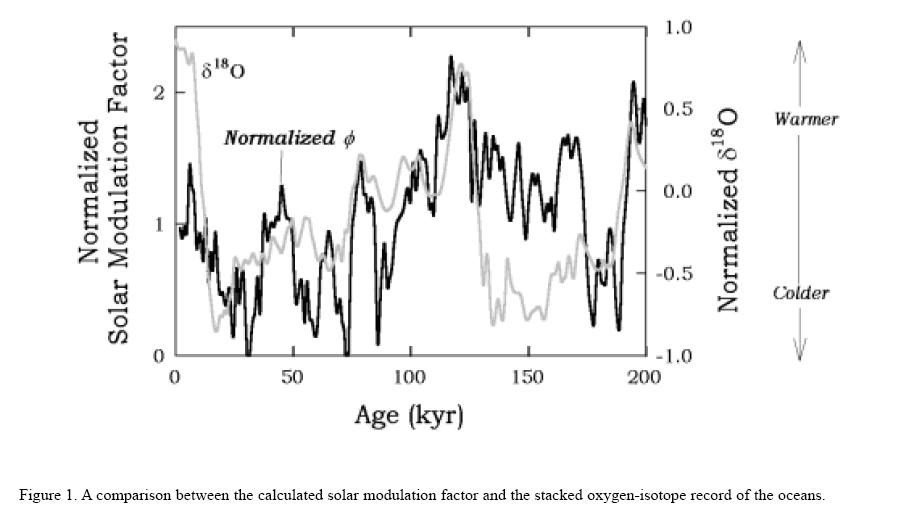

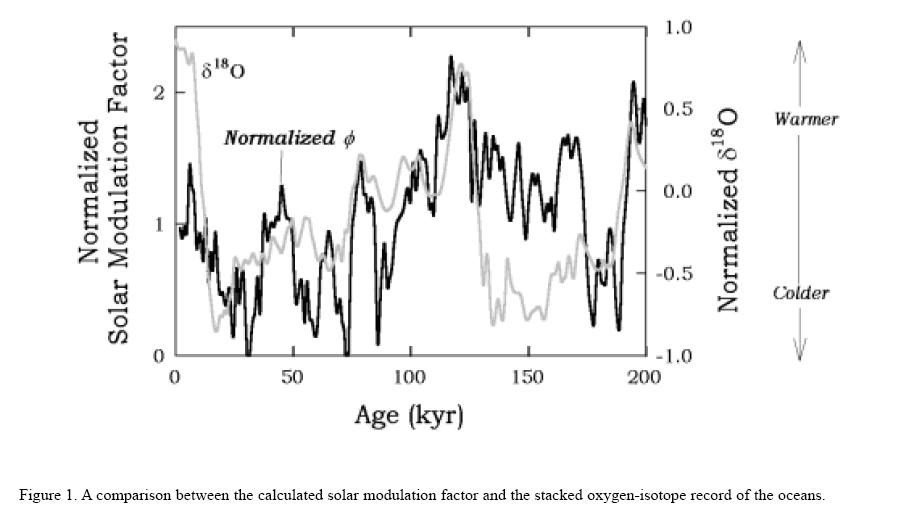

Abbildung 210 ist ein Auszug aus der Arbeit von Prof. Dr. Mukul Sharma und zeigt den 100.000 jährigen Sonnenzyklus und dazu als Kalibrierung, den 18O-Gahalt aus Proxys. Sauerstoff kommt in drei Isotopen vor, 16O, 17O und 18O. Bei Warmperioden verdunstet zuerst das leichtere 16O, so dass die Menge des in den Proxys (z.B. Sedimenten) eingelagerten 18O, Aufschlüsse über die seinerzeit vorherrschenden klimatischen Verhältnisse wiedergibt. In “astronews.com“ vom 11. Juni 2002 ist hierzu folgendes festgehalten:

“Die magnetische Aktivität der Sonne zeigt einen 100.000 Jahre langen Zyklus, der offenbar mit einem gleichlangen Zyklus des irdischen Klimas in Einklang steht. Das zeigen Untersuchungen des Geochemikers Mukul Sharma vom Dartmouth College in Hanover im US-Bundesstaat New Hampshire. Der Forscher veröffentlichte seine Analyse jetzt im Fachblatt Earth and Planetary Science Letters. Sharma vergleicht darin die Produktionsrate des radioaktiven Isotops Beryllium-10 mit den Variationen des irdischen Magnetfelds. "Überraschenderweise zeigt sich in den Daten eine Variation der Sonnenaktivität über wesentlich längere Zeitspannen als bislang vermutet", so Sharma. "Noch überraschender ist, dass diese Variationen offenbar eng mit den Eiszeiten und Zwischeneiszeiten der vergangenen 200.000 Jahre verknüpft sind."

“Beryllium-10 wird durch hochenergetische Teilchen erzeugt, die aus dem Weltall in die Erdatmosphäre eindringen. Die Stärke dieser "kosmischen Höhenstrahlung", und damit die Erzeugungsrate von Beryllium-10, werden sowohl durch die Sonnenaktivität, als auch durch die Stärke des Erdmagnetfelds gesteuert. Da die Stärke des Erdmagnetfelds in den letzten 200.000 Jahren gut bekannt ist, konnte Sharma aus den Beryllium-Daten auf die Schwankungen der Sonnenaktivität schließen.“

“Für die Entstehung der Eiszeiten hatten die Klimaforscher bislang geringfügige Schwankungen der Erdbahn verantwortlich gemacht. Allerdings führen diese Variationen nur zu minimalen Änderungen der Sonneneinstrahlung. Wie diese kleinen Änderungen zu den großen Unterschieden zwischen Eiszeiten und Zwischeneiszeiten führen können, ist bislang ungeklärt. Sharma betont allerdings, dass auch seine These der weiteren Überprüfung bedarf: "Ich habe nur auf die vergangenen 200.000 Jahre geschaut – meine Berechnungen müssen nun für die letzte Million Jahre verifiziert werden."

Der Grund, warum die Milanković-Zyklen, also die Veränderung der Erdbahnparameter und der daraus berechneten solaren Einstrahlung den Temperaturgang, sowie Eiszeiten nicht eindeutig wiedergeben, liegt denn daran, dass die „Akteure“, die die Erdbahnparameter beeinflussen, die Planeten des Sonnensystems, hier die großen Gasplaneten, auch die Sonne direkt beeinflussen und hiermit deren magnetische Aktivität und damit ihre Energieabgabe (siehe auch Dr. Landscheidt). Dies ist bei den Milanković-Zyklen nicht berücksichtigt. Dies ist das fehlende Glied, die Sonne selbst, den Temperaturgang im Pleistozän zu erklären und damit den Beginn und das Ende von Eiszeiten. Der Wechsel zwischen dem 41 ky-Zyklus und dem 100 ky-Zyklus sollte auf Veränderungen der dynamischen Plasmamassen in der Tachocline und der Konvektionszone der Sonne zurückzuführen sein.

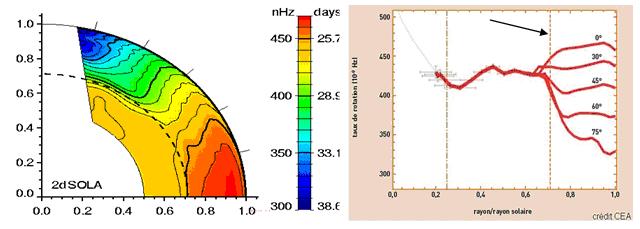

Von besonderem Interesse ist dabei, wie bereits gezeigt, die Tachocline, die als Ursprungszone für den Sonnendynamo gilt. Inwieweit deren Lage und Dicke, die beide die Magnetfelder in der Konvektionszone beeinflussen und damit die Energieabgabe der Sonne, über die Zeit konstant sind, ist nicht bekannt. Ist Dicke und/oder Lage der Tachocline variabel, hat dies natürlich Einfluss auf die magnetische Aktivität der Sonne. Bis vor ca. 10 Jahren wurde noch angenommen, dass die Tachocline konstant ist. Untersuchungen mittels Helioseismologie ergaben jedoch, dass sie in einem 16-Monatsrythmus oszilliert und in starker Wechselbeziehung mit der Strahlungszone steht.

Tachocline

Die Tachocline bildet die Grenzschicht zwischen starrer innerer Rotation der Sonne (obere Grenzschicht der Strahlungszone) und dynamischer Rotation in der Konvektionszone, deren Rotationsgeschwindigkeit erheblich von der der Strahlungszone abweicht. An der Grenzschicht kommt es wegen der stark unterschiedlichen Rotation zu einer starken Scherung. Diese Grenz-schicht wird Tachocline genannt (folgende Abbildung). Die in der Konvektionszone entstehenden Magnetfelder dringen bis zur Tachocline vor und werden durch die Scherung dort aufgewickelt, wodurch toroidale Felder entstehen, deren Feldlinien in Richtung der Rotationsgeschwindigkeit zeigen. Ab bestimmten Schwellwerten (“Instabilities in the Magnetic Tachocline“, R. Arlt, Astro-physikalisches Institut Potsdam) in der Feldstärke, kommt es zu Instabilitäten in der Tachocline.

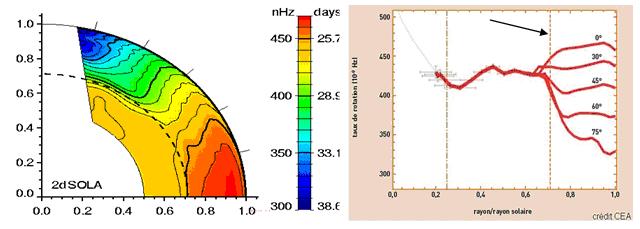

Abbildung 211 links (http://lcd-www.colorado.edu/SPTP/sptp_global.html) zeigt die Lage der Tachocline zum Sonnenradius und farbig die Rotationszeit. Die Abbildung rechts zeigt die Änderungen der Rotation zum Sonnenradius und zur geographischen Breite. Schwarzer Pfeil kennzeichnet die Tachocline, Quelle: (http://irfu.cea.fr/Sap/Phys/Sap/Activites/Projets/GOLF/science/page.shtml). Deutlich ist zu sehen, dass die differenzielle Rotationen im Bereich der Tachocline beginnt und diese damit ein wesentlicher Faktor für den Sonnenmagnetismus darstellt.

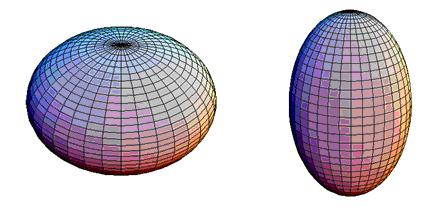

Die Tachocline bestimmt die Helizität (Drehrichtung, kann nur dort geändert werden, da sie die Basis für den Sonnenmagnetismus bildet) der Megnetfeldlinien, d.h. in welcher Form (rechtshändig = positiv / linkshändig= negativ) die Magnetfelder aufsteigen, bzw. abfallen. Dies ist mit entscheidend für eine Verstärkung oder Abschwächung der magnetischen Felder in der Konvektionszone. Die Lage der Tachocline liegt derzeit in Äquatornähe bei rt = 0,693 Sonnenradien und bei 60° bei rt = 0,717 Sonnenradien. Sie hat also eine prolate Form, womit sie der Rotationsformgebung, nach der rotierende Körper am Äquator am größten sind, wie auch alle Planeten entgegen läuft. Die Sonne selbst ist über Äquator und Pol etwa gleich. Da die Grenzfläche zwischen der Strahlungszone und Konvektionszone bei 0,713 Sonnenradien liegt, durchschneidet die Tachocline diese Grenzfläche. Die Tachocline hat eine Dicke von ca. 30.000 km.

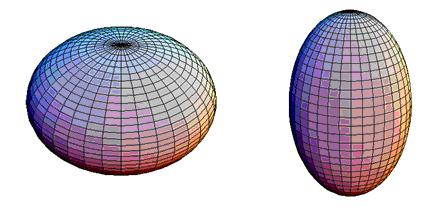

Abbildung 212 links: Durch Drehung abgeplattetes Rotationsellipsoid (oblate)Abbildung 212 rechts: Durch Drehung verlängertes Rotationsellipsoid (prolat)

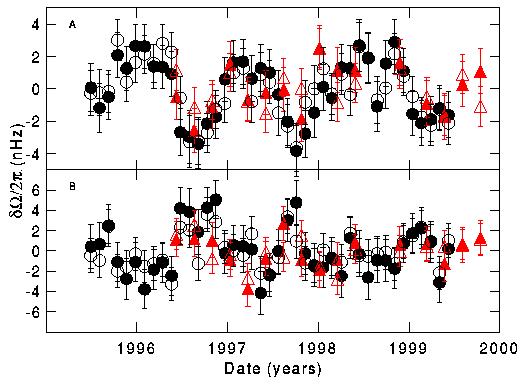

Wie eingangs geschildert, wurde nach Entdeckung der Tachocline vor gut 20 Jahren allgemein angenommen, dass es sich bei der Tachocline um ein weitgehend stabiles Gebilde handelt. Seit Ende der 1990-Jahre ist jedoch bekannt, dass die Tachocline hoch dynamisch ist und auf kurzen Zeitskalen mit einer Periodendauer von 16 Monaten pulsiert (folgende Abbildung).

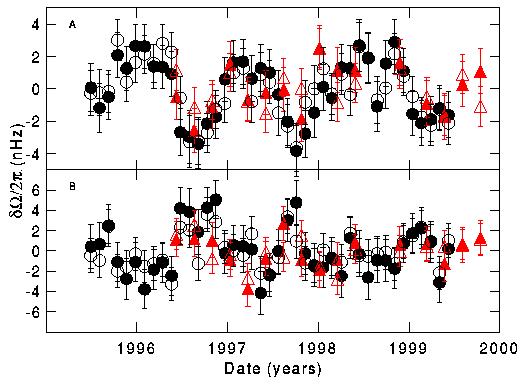

Abbildung 213, Quelle: (http://soi.stanford.edu/press/GONG_MDI_03-00/pressbase.gif) zeigt die Oszillation im Sonneninneren (0,72 Sonnenradius oben und 0,63 Sonnenradius unten). Deutlich die die 16-Monatsschwingung zu sehen und dies in Gebieten, über die Tachocline hinaus. Das darin enthaltene Gas rotiert mal schneller und mal langsamer. Rot sind nach MDI (Michelson Doppler Imager, SOHO) und schwarz nach GONG-Daten (Global Oscillation Network Group). “Entdeckt wurden die von niemand vorausgesagten Strömungen in vierjährigen Meßreihen des MDI-Instruments auf dem Satelliten SOHO und des GONG-Netzes von Sonnenteleskopen rund um die Erde.“ (http://www.astro.uni-bonn.de/~dfischer/news/SuW-L-1-10.html)

Nach der gängigen Theorie von Rüdiger und Kitchatinov (1997) wird angenommen, dass während der Entstehung der Tachocline ein schwaches Magnetfeld in der Sonne eingeschlossen wurde, welches die differenzielle Rotation in den äußeren Randbereich der Strahlungszone drängt und so die Tachocline erzeugt wird. Weiter geht die Theorie davon aus, dass die Tachocline aktiv mit der Strahlungszone verbunden ist und starke Wechselbeziehungen bestehen, was auf Grund ihrer Lage auch naheliegend ist.

Inwieweit die Tachocline über ihre von niemanden vermutete Oszillation auf großen Zeitskalen konstant oder variabel ist, lässt sich aus heutiger Sicht nicht beantworten, bzw., ob die Tachocline ihre prolate Form beibehält, oder zwischen prolat und oblat wechselt, was erheblichen Einfluss auf die magnetische Aktivität der Sonne haben sollte. Weiter muss davon ausgegangen werden, dass Einflüsse, die z.B. die Erdachse kippen lassen, ihre Obligität ändern, auch Einfluss auch die Tachocline haben und deren Lage in der Sonne ändern. Insbesondere bei einem möglichen Wechsel in der Form und Lage der Tachocline wäre mit erheblichen Einflüssen auf das Magnetfeld der Sonne zu rechnen, wobei in einer Übergangszeit das Magnetfeld in der Konvektionszone ganz verschwinden kann und dadurch lang anhaltende Kälteperioden auf der Erde ausgelöst werden. Ob weiter, die Tachocline zwischen prolat (derzeit) und oblat wechselt, ist ebenfalls ein interessanter Aspekt, um den Sonnendynamo besser verstehen zu können. Ausgeschlossen sollte ein solcher Wechsel nicht. Interessant ist in dem Zusammenhang, dass die letzte Eiszeitepoche exakt an der Gauss-Matuyama-Grenze vor 2,588 Mio. Jahren liegt, als sich das Magnetfeld der Erde umpolte. Zufall ist dies sicherlich nicht. Inwieweit die „Akteure“, die die Erdbahnparameter ändern, die Sonne im Raum wobbeln/wackeln lassen, nach Landscheidt das Barryzentrum ändern, auch auf die Konvektionszone und Tachocline der Sonne und auf die dynamischen Massen im Erdmantel*), die letztendlich die Magnetfeldpolarität bestimmen, parallel Einfluss nehmen und somit z.B. Eiszeiten auslösen, lässt sich wissenschaftlich derzeit noch nicht beantworten, sollte aber Inhalt weiterer Forschungsarbeiten sein, da der Autor davon ausgeht, dass darin der Schlüssel für das Verstehen des Erdklimas auf allen Zeitskalen liegt.

*) In seinem EIKE-Artikel „Gibt es einen Zusammenhang zwischen Sonnenfleckenaktivität und Erdbeben-/Vulkantätigkeit?“ (http://www.eike-klima-energie.eu/news-anzeige/gibt-es-einen-zusammenhang-zwischen-sonnenfleckenaktivitaet-und-erdbeben-vulkantaetigkeit/) hatte der Autor gezeigt, wie sowohl die Erdbebenaktivität, als auch die Vulkanaktivität mit der Aktivität synchron laufen. Dass Gravitationseinflüsse anderer Planeten auf den Vulkanismus Einfluss nehmen, lässt sich übrigens am Beispiel des Jupitermonds „Jo“ sehr gut beobachten. Er hat den stärksten Vulkanismus im gesamten Sonnensystem. Grund dafür ist die Gravitationskraft des Jupiters auf Jo, der eine elliptische Bahn um seinen Planeten vollführt, aufgrund dessen seine innere Form konstant „durchgeknetet“ wird.

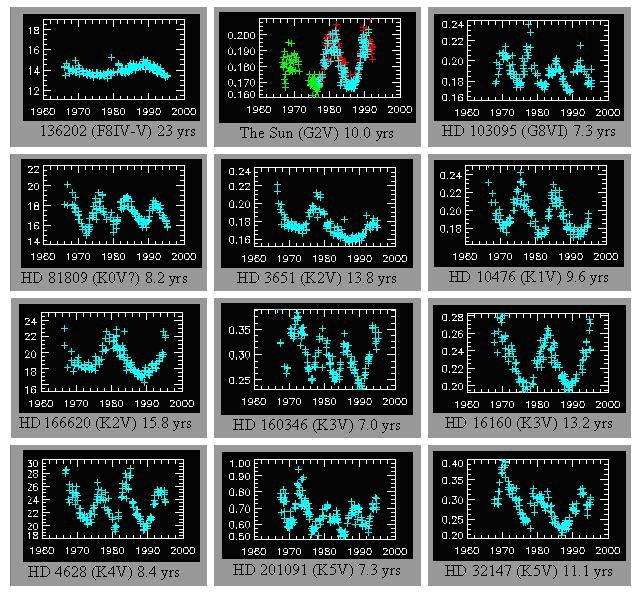

Da die Wissenschaft die Sonne erst seit ein paar hundert Jahren mit technischen Mitteln beobachtet und dieser Zeitraum im Lebenslauf der Sonne verschwindend klein ist, kann anhand der heutigen Beobachtungen nicht festgestellt werden, inwieweit die derzeitigen solaren Aktivitätsschwankungen auch für die Zeiträume davor galten, bzw. weiter gelten werden. Hier ist es hilfreich, andere Sterne, die etwa der Sonne entsprechen, zur Beantwortung heran zu ziehen.

Durch immer bessere Messsysteme gelang es Astrophysikern in den letzten Jahren, eine Vielzahl von Sternen mit magnetischer Aktivität zu erforschen. Beispielsweise befasst sich die Emmy Noether Research Group am Institut für Astrophysik der Uni Göttingen in einem groß angelegten Forschungsprogramm (“Magnetische Aktivität sonnenähnlicher Sterne und ultrakalter "Brauner Zwerge“) mit der Thematik. Deren Ergebnisse liegen derzeit noch nicht vor, da das auf 5 Jahre angelegte Projekt noch am laufen ist. Einzelbeobachtungen zeigten bereits einige Überraschungen, die darauf hindeuten, dass auch unsere Sonne Aktivitätsschwankungen unterliegt, die sich auf mehr als nur 0,1% im TSI-Strahlungsbereich, wie es die einschlägigen Veröffentlichungen des TSI zeigen und darüber hinaus, die Aktivitätsschwankungen ganz zum erliegen kommen.

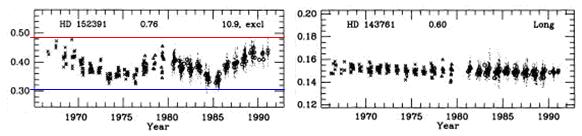

Wissenschaftler vom Smithsonian Center für Astrophysics und das Dartmouth College in Hanover (US-Bundesstaat New Hampshire, “Evidence for long-term brightness changes of solar-type stars“) untersuchten 74 Sterne auf ihre magnetische Aktivität. Die Messreihen gingen dabei teilweise über 23 Jahre. Anhand ihrer Untersuchungen stellten die Forscher fest, dass ca. 2/3 der Sterne ähnliche Aktivitätsschwankungen unterliegen, wie die Sonne, wogegen ca. 1/3 überhaupt keine Aktivitätsschwankungen aufweisen. Unter der Annahme, dass sich die Sterne gleich verhalten, schlossen Sie daraus, dass stellare Objekte wie die Sonne grundsätzlich zwischen zwei Aktivitätsschema pendeln, einer aktiven Phase und einer passiven Phase, ohne jegliche Aktivitätsschwankungen, wie die Sonne während dem Maunder Minimum. In einer Ruhephase strahlt (Helligkeitsbereich) ein Stern ca. 0,4% weniger als in einer aktiven Phase. Bei dem Stern HD 3651 (“Piscium“ im Sternbild Fische, HD steht für Henry-Draper-Katalog) konnte dieser Übergang, von der Phase ausgeprägter zyklischer Aktivität, in die Maunder-Minimum-Phase mit sehr geringer magnetischer Aktivität beobachtet werden (Nesme-Ribes, E., Baliunas, S. L. und Sokoloff, D.: “The stellar dynamo“, Scient. American, August 1996, 51-52).

Die bisherige Datenlage zeigt, dass der Übergang von der Aktivitätsphase in die passive Phase zum einen, nach starker magnetischer Aktivität und zum anderen, der Wechsel abrupt erfolgt. Dies spricht dafür, dass die Prozesse in der Konvektionszone, die einen starken solaren Zyklus antreiben, bei ihrer Umkehrung, neue magnetische Aktivität, umso länger und stärker dämpfen, je stärker die vorangegangene magnetische Aktivität im Hauptsonnenzyklus ist. Bei der Sonne ist dies der de Vries/Suess-Zyklus. Dies würde auch erklären, warum nach jedem Maximum im de Vries/Suess-Zyklus die Temperaturen auf der Erde stark abfallen.

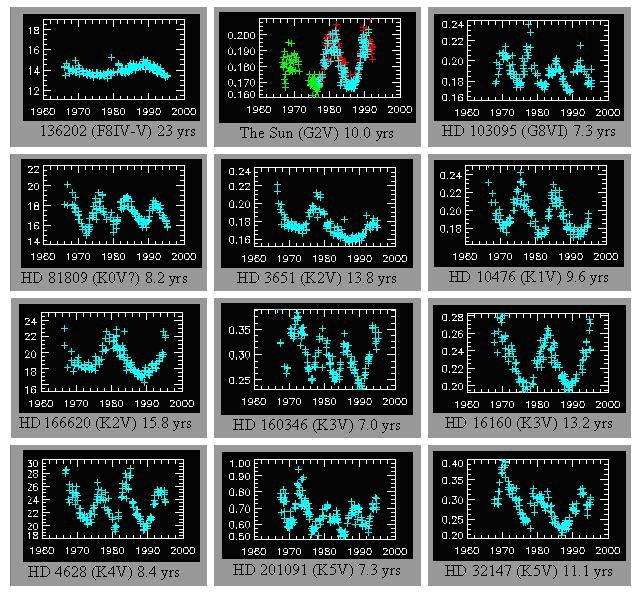

Abbildung 214, Quelle: (http://solar.physics.montana.edu/reu/2004/awilmot/introduction.html), zeigt am Beispiel von 11 Sternen, dass diese ähnliche Muster in ihren Aktivitätsschwankungen wie die Sonne (oben Mitte) aufweisen, was auf magnetische Aktivitätszyklen zurückzuführen ist und die Ausgangsthese vom Smithsonian Center für Astrophysics, dass sich die Sterne gleich verhalten, zu bestätigen scheint. Ausgewertet wurde die Ca II H and K-Linien.

Die Ca II H and K-Linien dienen zur Helligkeitsbestimmung von Sternen und gehen auf Joseph Fraunhofer zurück, der mit dieser Methodik die Sterne klassifizierte und die hellsten mit Großbuchstaben nummerierte. Die Nummerierung beginnt im roten Teil des Spektrums und endet im blauen. Die Calzium II-Linien liegen bei 397 nm (H-Linie) und 393nm (K-Linie) Wellenlänge. Die römische Ziffer kennzeichnet den Ionisationsgrad (I = neutral, II = einfach ionisiert, III = zweifach ionisiert, u.s.w.).

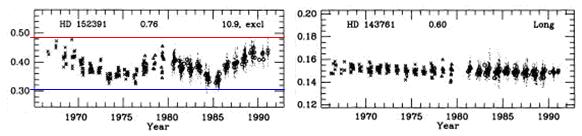

Die Datenreihen in Abbildung 214 zeigen weiter, dass die Aktivitätsschwankungen zeitlich sehr ähnlich sind und in der Amplitude meist deutlich stärker ausfallen als bei der Sonne. Bei HD 152391 (folgende Abbildung) fallen die Schwankungen gar fast 5-mal so stark aus wie auf der Sonne, was natürlich in erster Linie auf seine im Vergleich zur Sonne erhöhte Rotationsrate zurückzuführen ist.

Abbildung 215 links zeigt die Aktivitätsschwankungen des Sterns HD 152391, der mit 0,92 Sonnenmassen und einer Oberflächentemperatur von 5.500 Kelvin der Sonne sehr ähnlich ist. Rechts der Stern HD 143761, der nahezu keine Aktivitätsschwankungen aufweist, sich also in einer ruhigen Phase befindet, Quelle, wie oben.

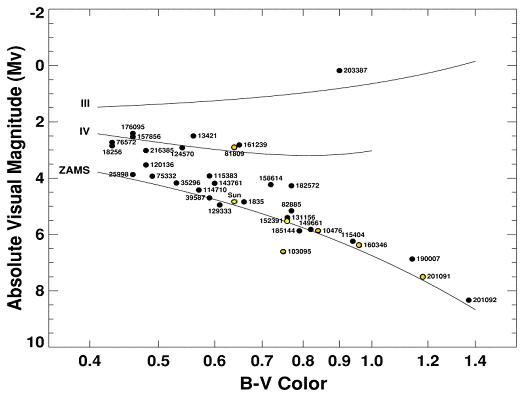

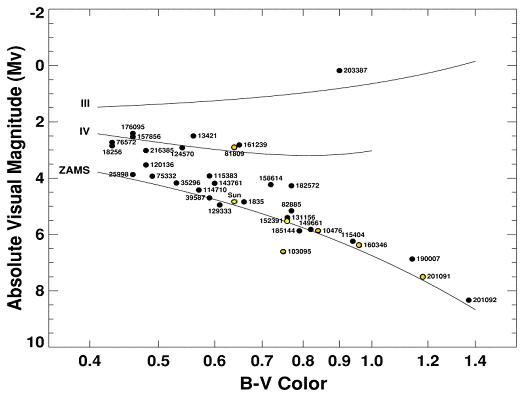

Abbildung 216, Quelle: (http://e-collection.ethbib.ethz.ch/eserv/eth:24899/eth-24899-01.pdf) zeigt das Hertzfeld-Russel-Diagramm für 34 sonnenähnliche Sterne nach Radick et al., 1998. Sonne und HD 152391 gelb, orange: Sterne aus der Abbildung 214.

Selbst bei stellaren Objekten, bei denen die Astrophysiker bisher davon ausgingen, dass sie keine oder nur wenig magnetische Aktivität aufweisen würden, wie z.B. sog. Zwergsterne, ergaben Untersuchungen (roter Zwerg TVLM513-46546, 0,09 Sonnenmasse, Oberflächentemperatur: 2.400 Kelvin), dass sie entgegen der gängigen Lehrmeinung, nicht nur keine, sondern sogar eine komplexe magnetische Aktivität aufweisen (Carnegie Institution, 06.12.2007). Dies zeigt, dass in diesem Forschungsfeld noch mit einigen „Überraschungen“ zu rechnen ist.

Das Max Planck Institut für Sonnenforschung (MPS) gibt an, dass die Sonne gegenwärtig geringere Schwankungen der Helligkeit aufweist, als vergleichbar aktive Sterne (http://www.mps.mpg.de/homes/schuessler/klima.pdf) und stellt die Frage: “Wird das so bleiben?“ Insgesamt ist festzuhalten, dass stellare Objekte eine ausgeprägte magnetische Aktivität ausweisen und diese zwischen einer aktiven Phase, die teils deutlich über den jetzigen Sonnenaktivitätsschwankungen liegen und einer inaktiven Phase, vergleichbar dem Maunderminimum pendelt. Die derzeitigen Aktivitätsschwankungen der Sonne im Vergleich zu ihren „Schwestern“ sind als vergleichsweise gering einzustufen.

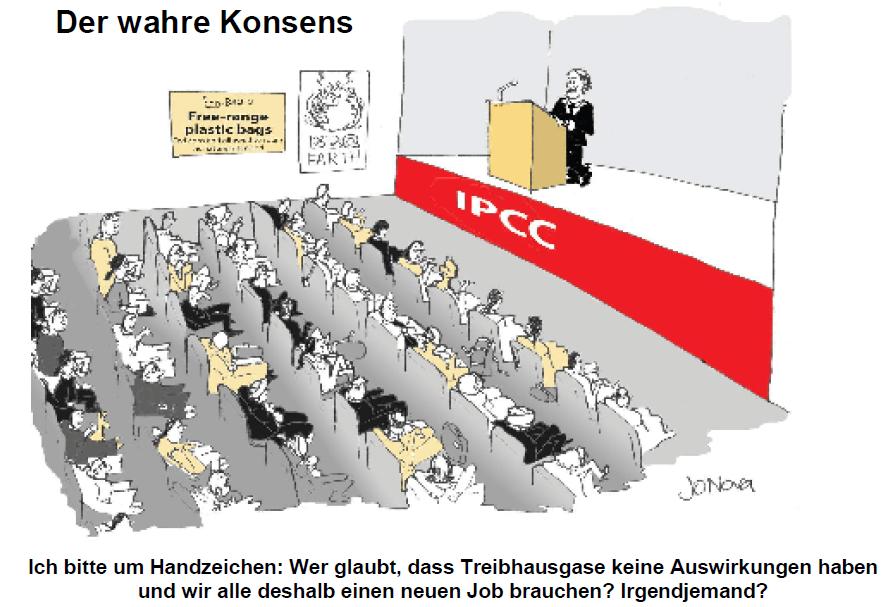

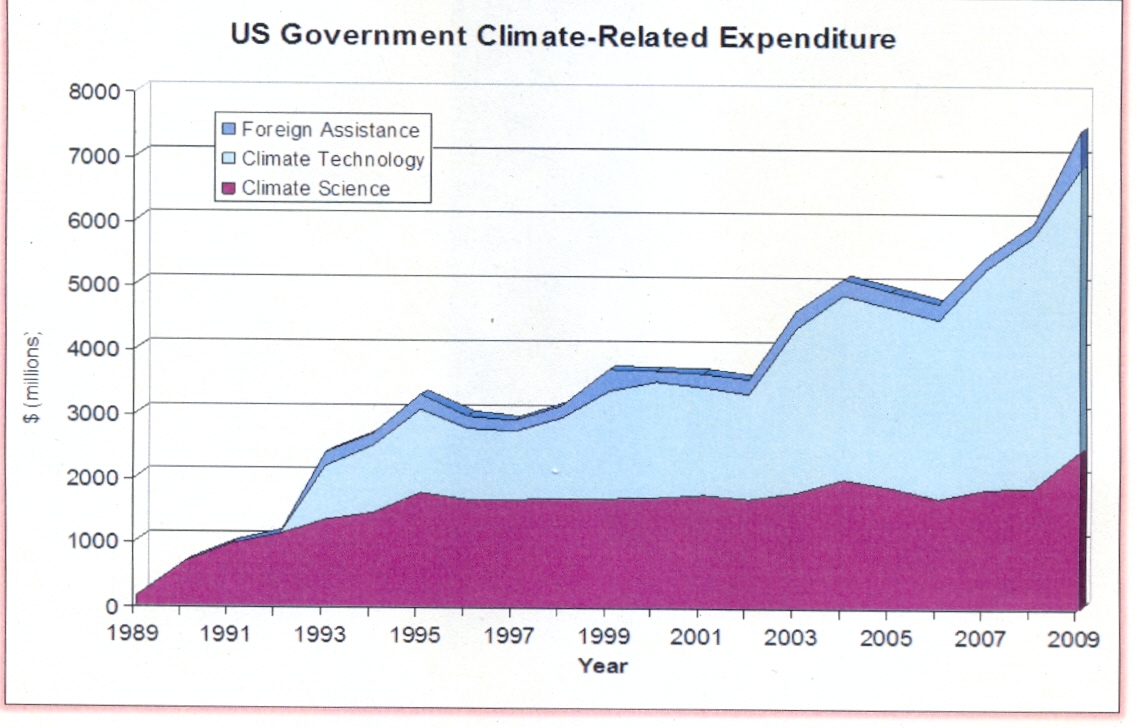

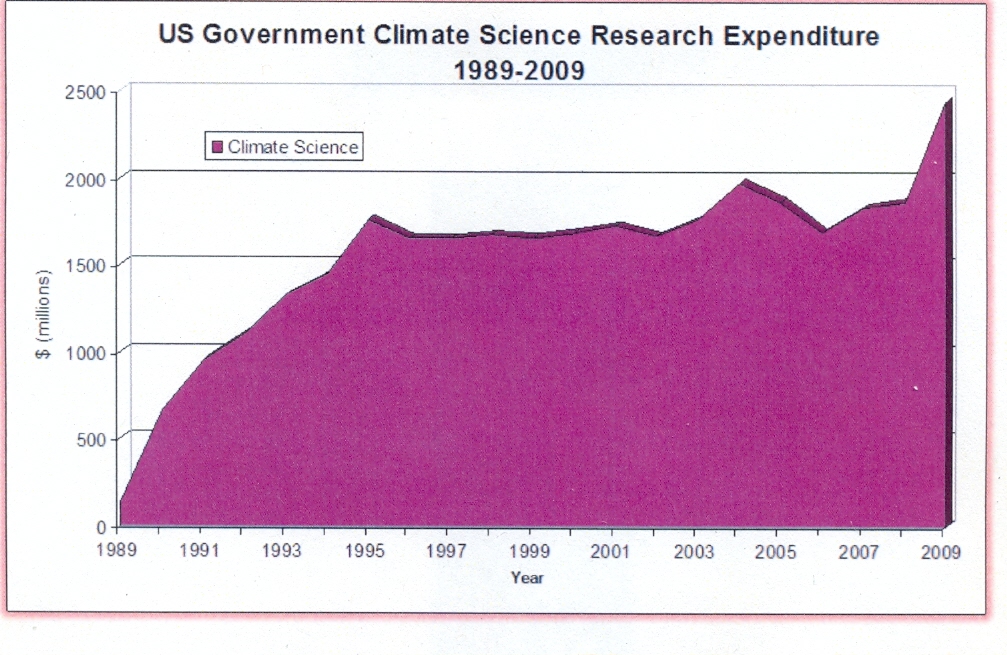

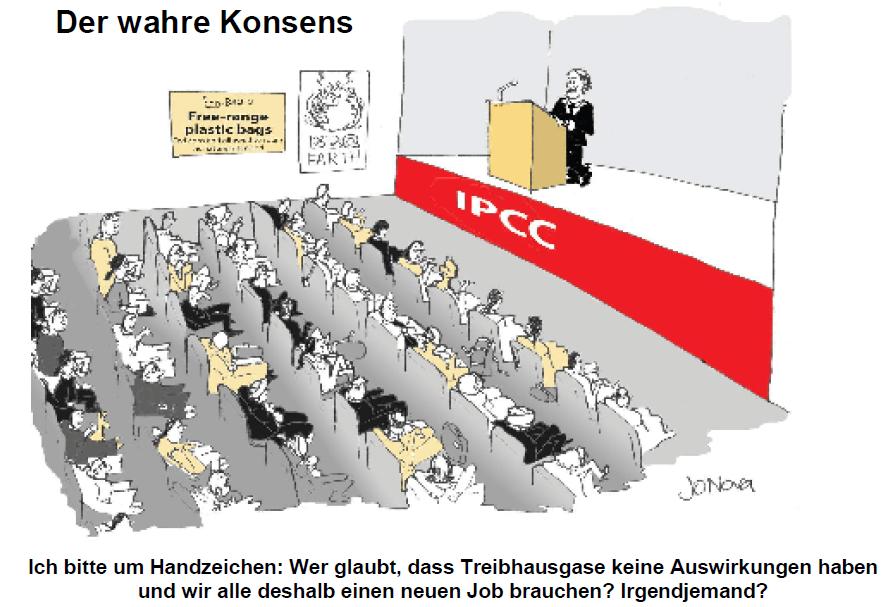

Man braucht kein Prophet zu sein, dass die Sonne noch viele Geheimnisse verborgen hält, die auf eine Entdeckung warten und die zum Verständnis den Klimas auf der Erde essenziell sind. Anstatt Unsummen an Gelder dafür zu verwenden, Exorzisten-gleich einem Teufel (CO2) nachzujagen, den es nicht gibt, sollten diese Gelder besser in die Sonnenforschung investiert werden. Ertrag und Ernte werden fruchtbarer ausfallen, als die bisherige Trockenernte bei den Treibhausgasen, die nach 20 Jahren nicht einmal den Beweis erbringen konnten, dass es einen Treibhauseffekt gibt – gibt keine wissenschaftlichen Beweise dafür, sondern einzig, zusammengebastelte Computermodelle, die mit manipulierten Daten (Climate Gate) und falschen Annahmen (siehe jüngstes Beispiel der NASA, die herausgefunden hat, dass die Erde fünfmal mehr Wärme in Weltall abstrahlt, als in den Modellen eingesetzt und daher in den Modellen viel zu viel Energie in der Atmosphäre verbleibt, was zur Folge hat, dass sämtliche Klimasimulationen grund-falsch, mit viel zu hohen Temperaturen sind) gefüttert werden und IPCC, PIK und Co. das Ergebnis anschließend als „Stein der Weisen“ verkaufen. Deren Absicht ist klar, wie die Karikatur in Abbildung 217 zeigt. Uns sollte das alles nicht gleichgültig sein, da IPCC, PIK und Co. ihr (bisher) sorgenfreies Leben mit unseren Steuergeldern betreiben.

Abbildung 217

Teufel, wie am Beispiel CO2, Horrorszenarien und Exorzisten sollten Hollywood vorbehalten bleiben, in der Realität und der Wissenschaft haben sie nichts zu suchen. Den Rückschritt ins Mittelalter gilt es zu verhindern. Die Artikelserie “Dynamisches Sonnensystem – die wahren Hintergründe des Klimawandels“ ist als Beitrag dazu zu verstehen. Weitere Aufklärung wird auf EIKE folgen.

Raimund Leistenschneider – EIKE

Übersicht über alle Teile:

Teil 1 – Die Sonne bestimmt den Temperaturgang

Teil 2 – Die Sonne, der faszinierende Stern

Teil 3 – Sonnenflecken und ihre Ursachen

Teil 4a – Die Sonnenatmosphäre, Korona, Heliosphärische Stromschicht,

interplanetares Magnetfeld

Teil 4b – Die Sonnenatmosphäre, Korona, Heliosphärische Stromschicht,

interplanetares Magnetfeld

Teil 5 – Die variable Sonne

Teil 6 – Der Einfluss der Sonne auf unser Wetter/Klima

Teil 7 – Der Einfluss der Sonne auf die Wolkenbedeckung über Svensmark hinaus

Teil 8 – Zukünftige Temperaturentwicklung und deren Schwankungen