Sie will ihren Gegnern endlich das Atomangst-Argument aus der Hand schlagen, mit dem man sie ständig ärgert. Sie will jetzt die Atomenergie einfach abschaffen und verkündet, daß sie nun plötzlich begriffen hätte, daß Atomreaktoren unsicher sind. Das habe sie vorher nicht gewußt. Frau M. ist übrigens Physikerin. Sofort werden sieben Kernkraftwerke abgeschaltet, die übrigen dann später. Weil die Reaktorsicherheits-Experten leider erklären, daß die Atomkraftwerke doch sicher sind, beruft Frau M. einen Ethikrat, der gar nicht erst über den Ausstieg diskutieren soll, sondern dem sie gleich die gewünschte Antwort als Frage vorlegt: „Wie kann ich den Ausstieg mit Augenmaß vollziehen…?“ Diesem Ethikrat gehört kein Energieexperte an, jedoch 2 Bischöfe…..

Dieser Rat gibt die gewünschte Antwort und dann wird ein Ausstiegs-Gesetzespaket beschlossen, das Parlament und Bundesrat anschließend in Rekordzeit verabschieden. Es herrscht große Angst, denn schon morgen können die Reaktoren explodieren. Jedenfalls genau die, die zuerst abgeschaltet wurden. Die übrigen noch nicht. Der jetzt fehlende Strom wird nun zum großen Teil aus den Nachbarländern importiert: Und das ist wieder überwiegend Atomstrom. Das stört jetzt aber niemanden mehr. Deutschland ist noch einmal davon gekommen. Frau M. nennt es die Energiewende.“

Das Drehbuch wird wegen Unglaubwürdigkeit abgelehnt. Soweit die Fiktion.

Wie man weiß, hat sich das aber tatsächlich im Frühjahr und Frühsommer 2011 zugetragen. Jetzt, wo sich die ersten Auswirkungen zeigen und die Fehler im Gesetzeswerk, in den Methoden ihrer Kaschierung und in der Argumentation der Regierung deutlich hervortreten und nun auch Reaktionen aus dem Ausland vorliegen, kann man eine Diagnose der sogenannten Energiewende versuchen.

1. Übertreiben, Beschönigen, Weglassen, Verschweigen

Wer die amtlichen Verlautbarungen zur Energiepolitik, zur Begründung von Gesetzen, die die Förderung bestimmter Energietechnologien betreffen, die politischen Erläuterungen zu sämtlichen staatlichen Maßnahmen auf diesem Gebiet kritisch betrachtet, der kann zunächst die durchgängig festzustellenden fast unglaublichen Fehler nicht fassen.

Bis er das System erkennt: Vorbei sind die Zeiten, als eine Oberste Bundesbehörde unter keinen Umständen die Bürger gezielt getäuscht und mit falschen Informationen in die Irre geführt hat. Die einzige lässliche Sünde war in diesen “guten alten Zeiten” das Weglassen allzu peinlicher Aussagen – aber es wurde niemals gefälscht und gelogen.

Vorbei. Die Manipulation von Fakten und absichtliche Falschinformationen sind seit etwa 6 Jahren zu einem normalen Mittel der Öffentlichkeitsarbeit geworden.

Da es sich bei dem Thema Energiewirtschaft und Energietechnik um Fachgebiete handelt, die dem Normalbürger eher fremd sind, war diese Politik der systematischen Desinformation außerordentlich erfolgreich – wie die Umfragen auf diesem Gebiet belegen.

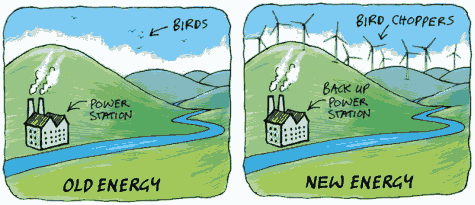

Das Haupt-Schlachtfeld dieses Medienkriegs sind die sogenannten erneuerbaren Energien, die es natürlich nicht gibt, denn Energie ist nicht erneuerbar. Gemeint sind regenerative Energietechniken, mit denen die Strahlungsenergie der Sonne, die kinetische Energie von Luftströmungen oder die chemische Energie von Biomasse ausgenutzt werden kann. Es war und ist das politische Ziel der letzten und der derzeitigen Bundesregierung, für diese Energietechniken trotz ihrer vielfachen und massiven Nachteile eine öffentliche Akzeptanz zu erreichen und Widerstände der Fachleute zu neutralisieren. Dazu dient diese systematische Fehlinformation – sie ist ein politisches Instrument zur Durchsetzung ideologischer Ziele.

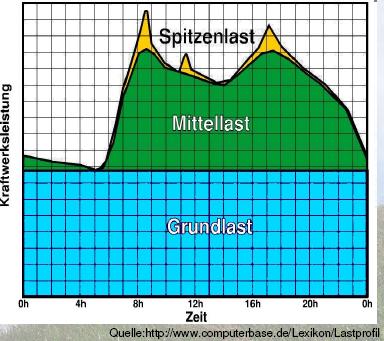

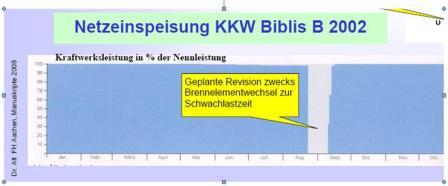

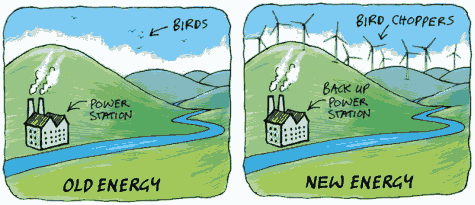

Eine Grundbehauptung für die Rechtfertigung der „Erneuerbaren“ ist der Ersatz von Kohlekraftwerken durch Wind- und Solarstrom. Tatsächlich konnte jedoch dadurch bis zum heutigen Tag kein einziges Kohlekraftwerk stillgelegt werden, weil diese Anlagen selbst bei starker Einspeisung des „grünen“ Stroms als Reserve unverzichtbar sind: Wenn Wind- oder Solarstrom wetterbedingt kurzfristig ausfallen, müssen diese Kohlekraftwerke so schnell wie möglich wieder hochgefahren werden und einspringen.

Man beachte: Sie müssen innerhalb von ca. 30 Minuten hochgefahren werden, was im Klartext bedeutet, daß sie nicht etwa aus dem kalten Zustand innerhalb von Stunden angefahren werden – da würde jede kurzfristige Ausregelung der Netzstörung nicht mehr möglich sein – , sondern die ganze Zeit „im Leerlauf“ betrieben werden müssen, was erheblich Kohle benötigt. Deshalb ersetzen Wind- und Solarstrom bei ihrer Einspeisung ins Netz nicht etwa den äquivalenten Kohleverbrauch der Kraftwerke im Verhältnis eins-zu-eins, sondern nur einen Teil davon.

Die Energiewende hat diese Situation noch weiter verschärft:

Auf dringende Bitten der Regierung und ihrer Bundesnetzagentur mußten die Kraftwerksbetreiber selbst ältere, nur noch teilweise betriebene Kraftwerksblocks wieder anfahren, weil deren Strom nach der Abschaltung der 8 Kernkraftwerke dringend gebraucht wird.

Es kann festgestellt werden:

Der Treibstoff für Merkels Energiewende ist Kohle – und zwar viel mehr als bislang. Daß es auch dabei aus verschiedenen Gründen wieder klemmt, wird in Kap. 8 „Das stille Ende großer Ankündigungen“ und Kap. 14 „Für die Bürger wird es immer teurer“ beschrieben.

Die von Frau Merkel angestrebte sogenannte Energiewende ist – abgesehen vom Ausstieg aus der Kernkraft – in allen Einzelheiten seit 6 Jahren der Kern der Energie-Regierungspolitik, neu ist nur der geradezu messianische Ehrgeiz, die selbst gesteckten Ziele in relativ kurzer Zeit zu erreichen. Der Anspruch, damit Vorbild für den Rest der Welt zu sein, ist nicht neu, sondern eher typisch.

Ein kurzer Durchgang durch die politisch wichtigsten Förderfelder im Energiebereich zeigt die offensichtlichen, aber verschwiegenen Schwachstellen:

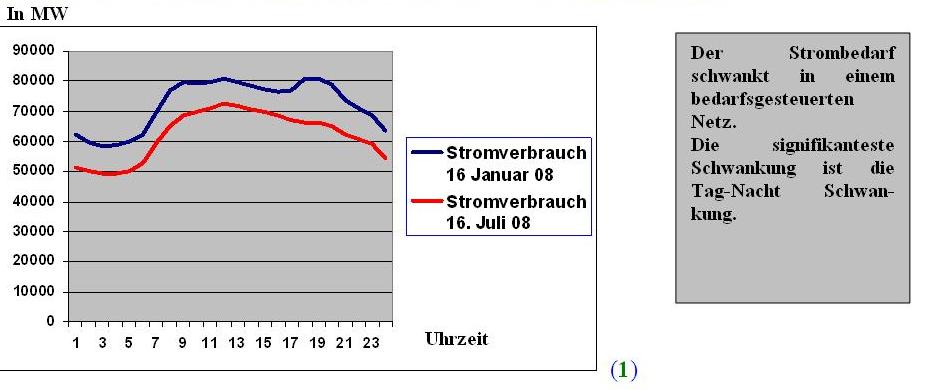

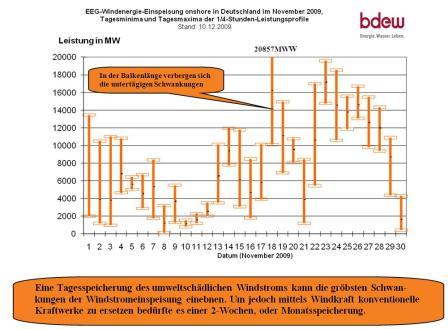

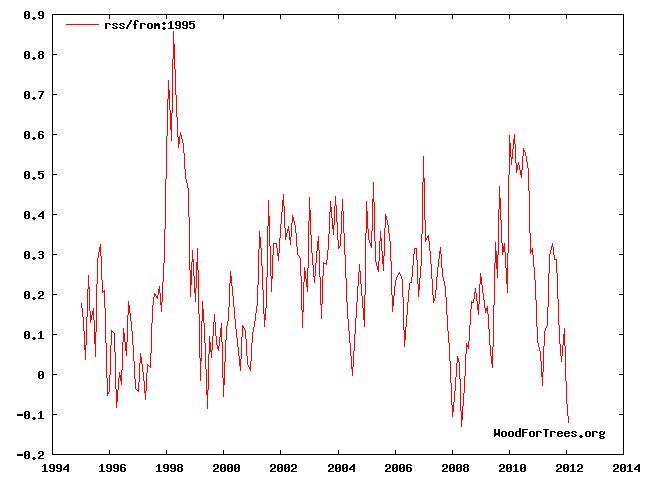

2. Windstrom – Versorgung nach Wetterlage

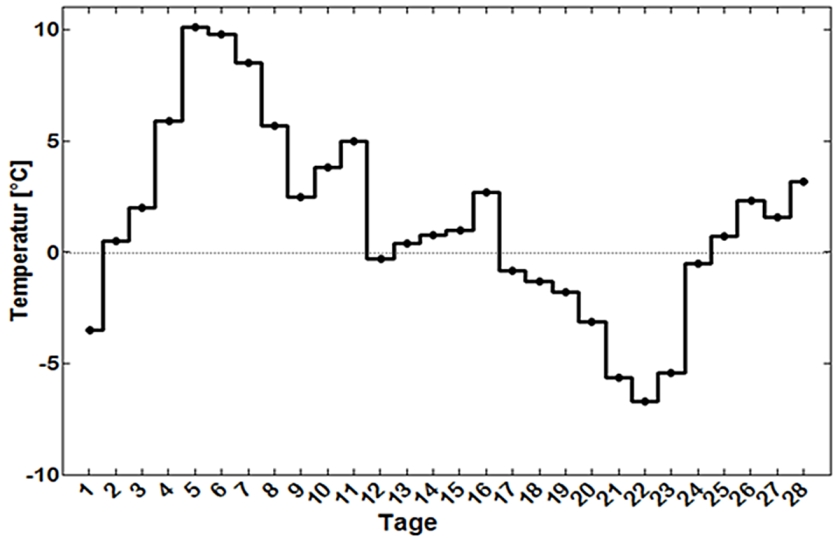

Die Stromerzeugung mit Windkraftanlagen zeigt wegen deren Wetterabhängigkeit extreme Schwankungen – einschließlich tagelanger Perioden ohne jede nennenswerte Leistung, aber auch plötzlich auftretende Leistungsspitzen, die das Verbundnetz an den Rand des Zusammenbruchs bringen. Großflächige Stromsperren drohen, vor allem im Winter, wenn der Bedarf steigt, das Ausland weniger liefert – und Flaute herrscht. Bei plötzlichem Starkwind kann das Gleiche geschehen. Man läßt es darauf ankommen.

November 2011: Lastganglinie aller deutschen Windkraftanlagen in viertelstündlicher Auflösung (Quelle: wilfriedheck.de)

Eine sehr beeindruckende Zahl zum Ausmaß der wetterbedingten Leistungsschwankungen der Windkraft und des Solarstroms nannte der Leiter Politik und Märkte der Essener RWE Innogy, Holger Gassner auf einem VDI-Kongress Ende November 2011:

„Es seien allein im ersten Halbjahr 2011 Variationen der verfügbaren Windkraftkapazitäten von 23 GW (= 23.000 MW) und der Photovoltaikleistung von 13 GW beobachtet worden.“

Ein Alptraum für die Übertragungsnetz-Betreiber. Die stets bei der Einweihung neuer Windparks behauptete Versorgung von mehreren tausend Haushalten gehört hierbei zu den Standardlügen, denn bei Flaute kann kein einziger Haushalt versorgt werden.

Es konnte trotz der bereits installierten gewaltigen theoretischen Maximalleistung aller Windkraftanlagen noch kein einziges Kohlekraftwerk abgeschaltet werden, weil die WKA im Gegensatz zu Kohle- und Kernkraftwerken eben keine Grundlast liefern – das heißt zu jeder Stunde an jedem Tag. Im Gegenteil: Man benötigt schnell regelbare Kraftwerke, die einspringen, wenn sich die Leistung der WKA zu schnell ändert, und die Kraftwerke, die das am besten können, sind Kernkraftwerke. Diese werden nun der Reihe nach abgeschaltet und fallen als Netzstabilisatoren aus.

Daher müssten neue Gasturbinen-Kraftwerke für diesen Zweck gebaut werden; allerdings rentiert sich das nicht.

Weil große Stromspeicher fehlen, muß man buchstäblich um jeden Preis versuchen, überflüssigen Windstrom, der oft genug verschenkt werden muß, ins Ausland zu leiten. Manchmal muß sogar dem Abnehmer dafür noch ein Preis bezahlt werden. Der dafür benutzte Begriff ist „negativer Preis.“ Der Erzeuger erhält dennoch die EEG-Einspeisevergütung; der Verbraucher zahlt dann doppelt für den überflüssigen grünen Strom.

Endgültig auf den Kopf gestellt wird die bei der Energiewende prinzipiell missachtete Marktwirtschaft durch die sogenannte Härtefallregelung in §12 EEG: Zufällig anfallender Wind- oder Solarstrom, der vom Netzbetreiber nicht akzeptiert werden kann und dessen Produktion folglich unterbleibt, muß trotzdem bezahlt werden – siehe Kapitel 5.

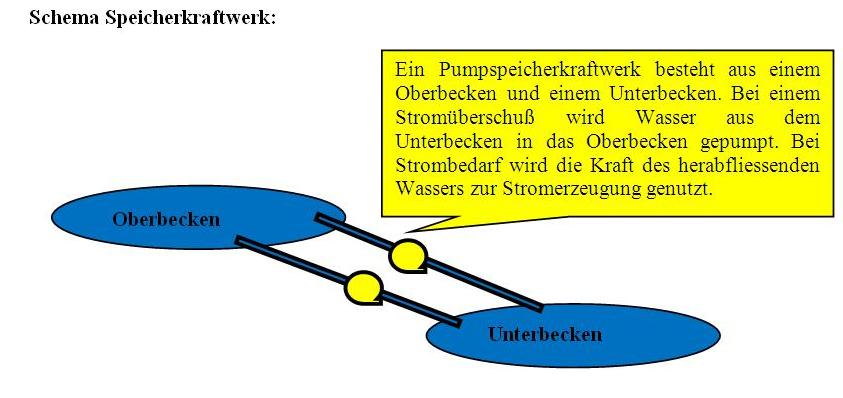

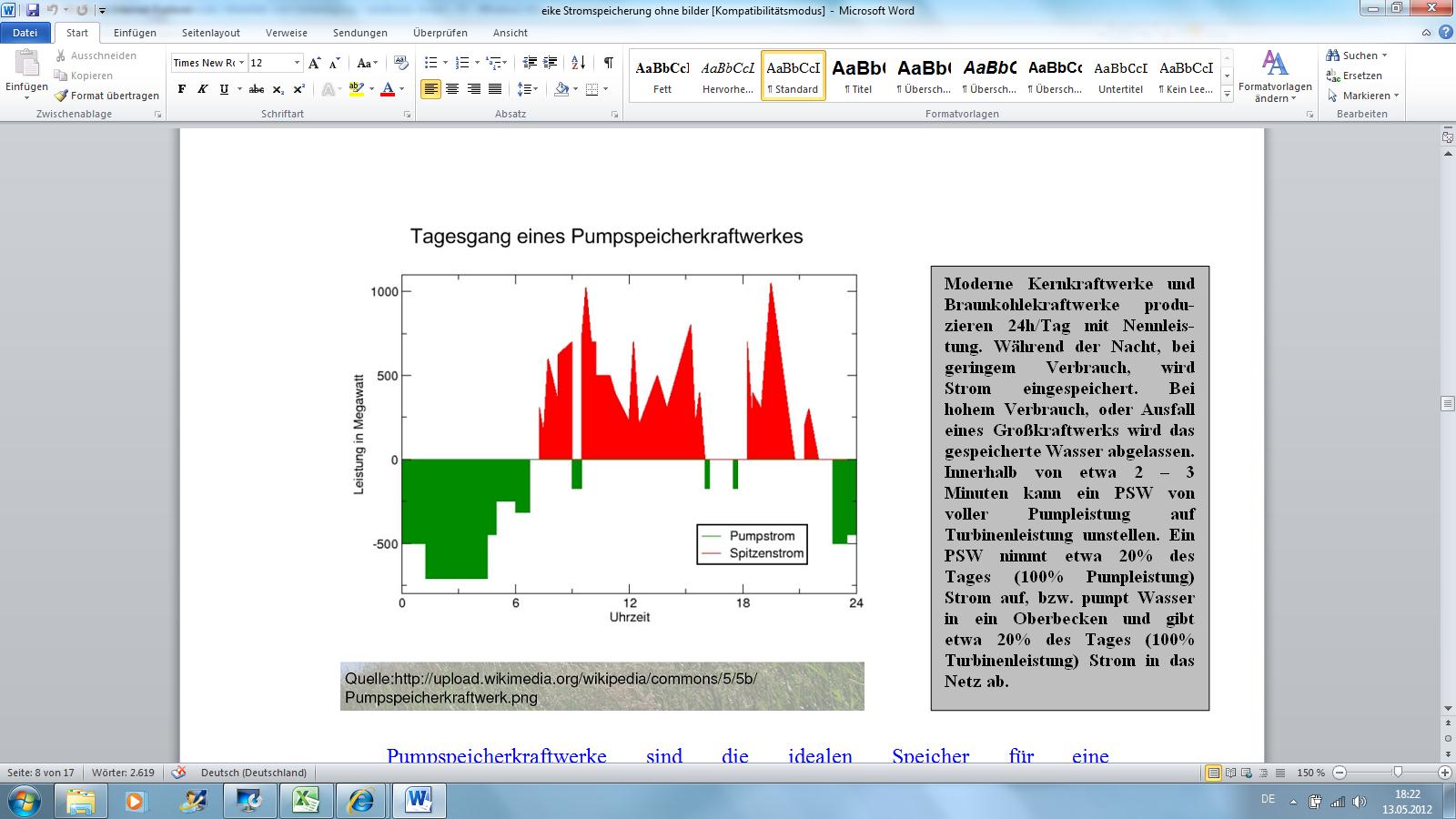

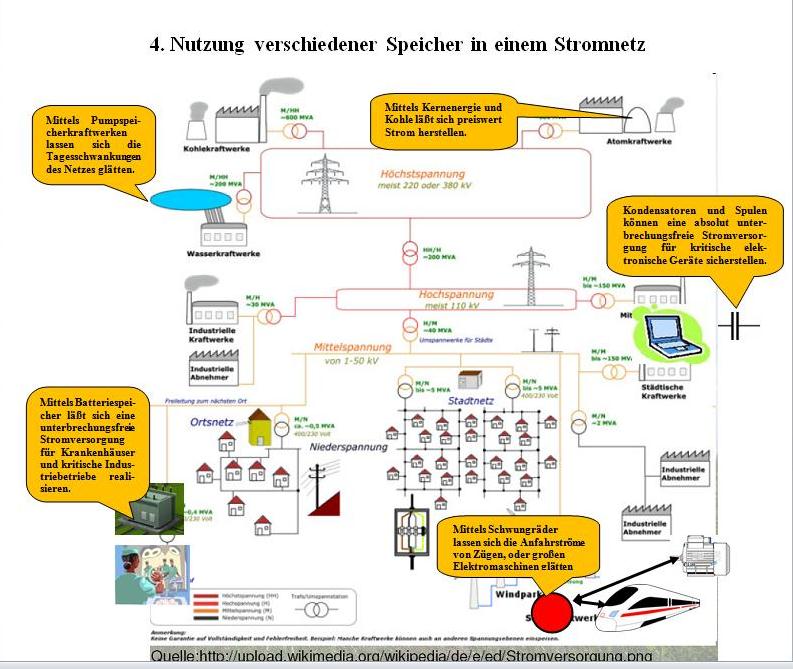

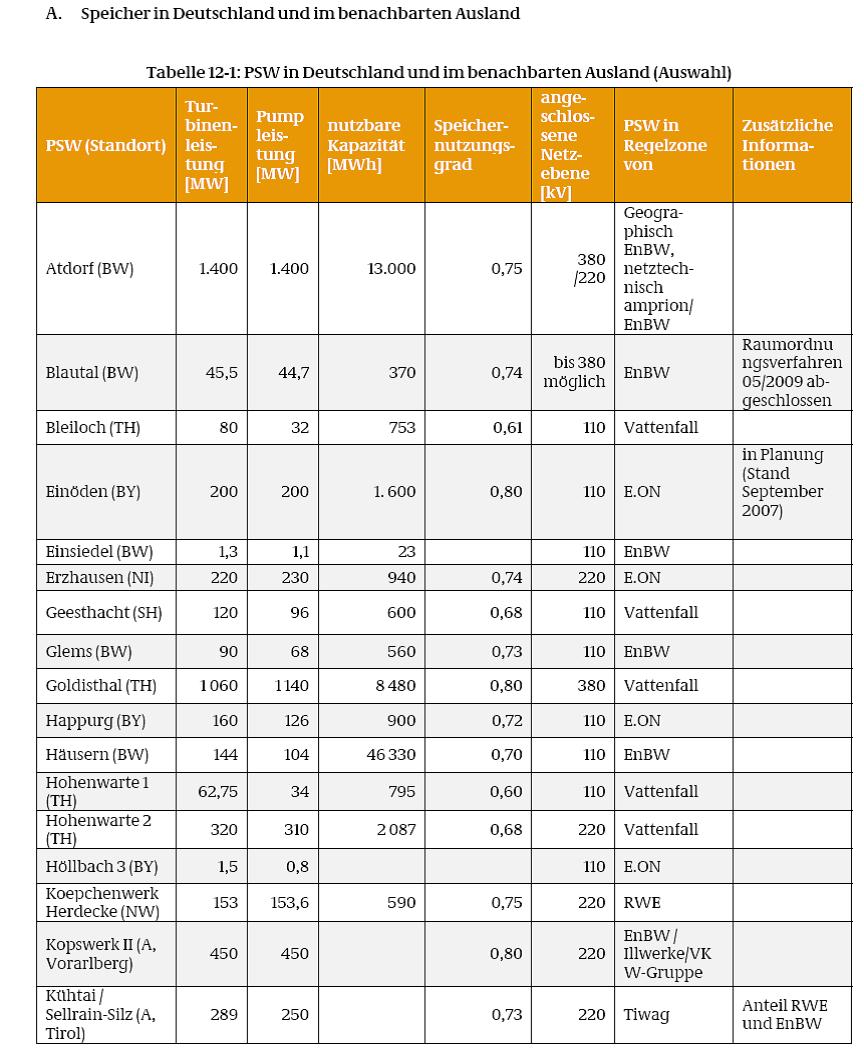

Der Ausbau der Windkraft erfolgt weiterhin mit hohem Tempo. Das vergrößert das Problem – aber man negiert es. Prinzipiell könnten Pumpspeicherwerke diese Schwankungen ausgleichen, aber Deutschland hat viel zu wenige davon und der immer größer werdende Bedarf kann hier niemals gedeckt werden.

Es werden Langzeitspeicher benötigt, um längere Flauten abfangen zu können. Eine 10-tägige Flaute ist nicht selten; aber Deutschland erlebte gerade eine 44 Tage andauernden Hochdruck-Wetterlage im Oktober – November 2011, die einen nicht enden wollenden, spektakulären Einbruch in der Windstromerzeugung mit sich brachte.

Es gibt bereits die Daten

Konventionelle Stromerzeugung und Windkraft im November 2011 (wilfriedheck.de)

Von der gesamten in Deutschland installierten Windstrom-Leistung von 27.215 MW (Stand nach EWI vom 30.6.11) lieferten die Windräder an 27 Tages des November:

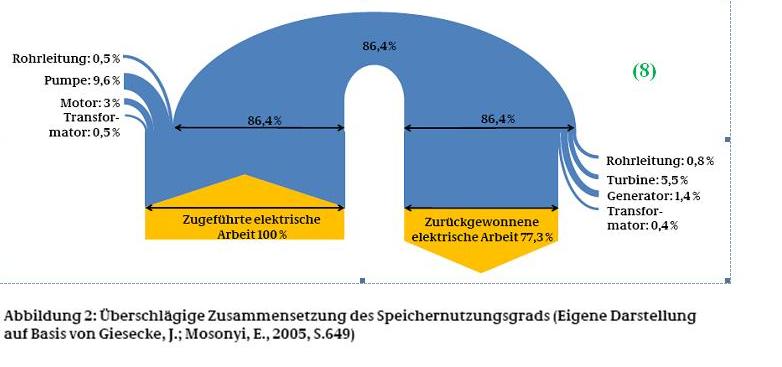

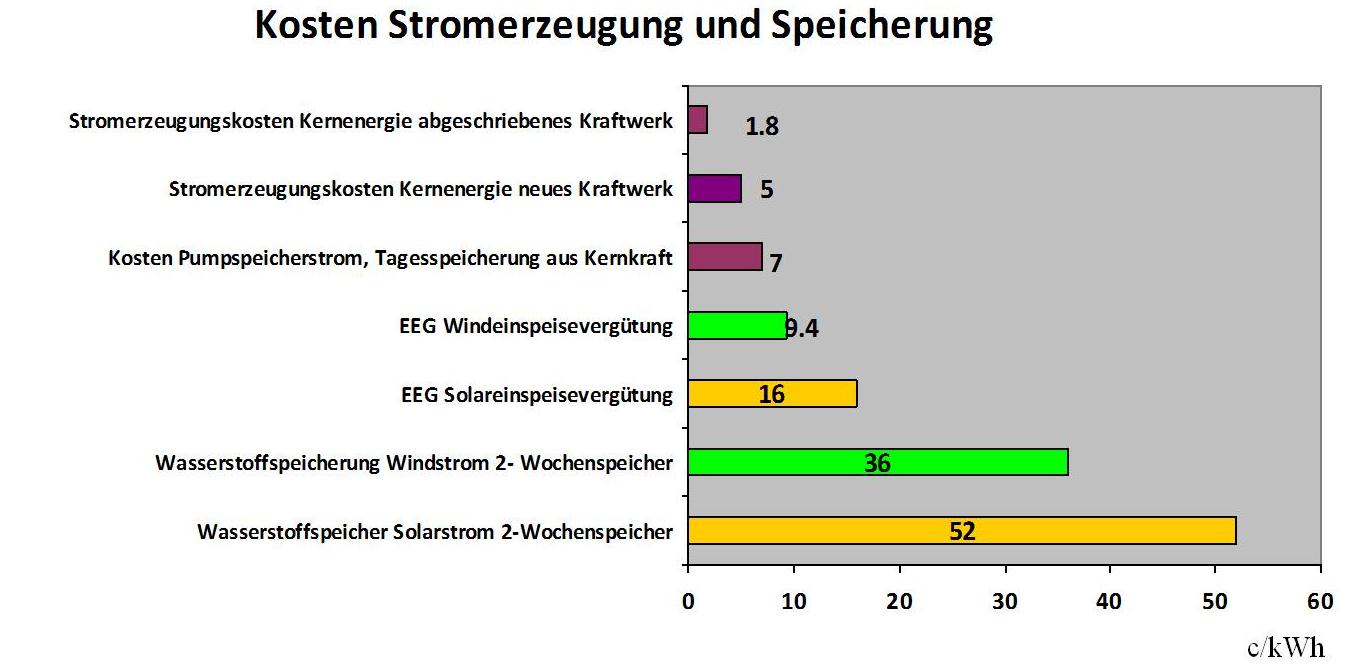

Zu diesem Thema schreibt Prof. Dr. Fritz Vahrenholt, RWE Innogy GmbH, daß bei 450 TWh (Terawattstunden = Milliarden kWh) Jahresverbrauch der durchschnittliche Tagesverbrauch bei 1,25 TWh liegt und bei 10 Tagen somit bei 12,5 TWh. Die derzeit in Deutschland vorhandene Kapazität an Pumpspeicher-Kraftwerken beträgt 7.000 MW, mit denen sich rund 0,04 TWh an Strom erzeugen lassen, wenn sie komplett leer laufen.

Demnach würde zur Abpufferung der Flautenzeit von 10 Tagen das 313-fache der heute installierten Pumpspeicherleistung benötigt. Dies sei für Deutschland und die Alpenregion auch auf Grund von Akzeptanzproblemen vollkommen unrealistisch.

Somit wird in vielen Studien oft auf Norwegen verwiesen.

Dort sind die meisten Speichermöglichkeiten derzeit einfache Stauseen mit natürlichem Zulauf, die zwar in Engpaßzeiten Strom liefern könnten, aber nicht als Senke (= Stromaufnahme bzw. –Speicherung) in (Windstrom-) Überschußzeiten zur Verfügung stehen. Zudem müßte im Bedarfsfalle einer Flaute in Deutschland ja auch noch Norwegen weiterhin versorgt werden.

Lastgang in Norwegen 2011 (wilfriedheck.de)

Die letzte Oktoberwoche und der November 2011 zeigten, daß Prof. Vahrenholts Annahme einer 10-tägigen Flaute als „worst case“ noch stark untertrieben war: Diese Flaute dauerte 3 bis 4 Wochen.

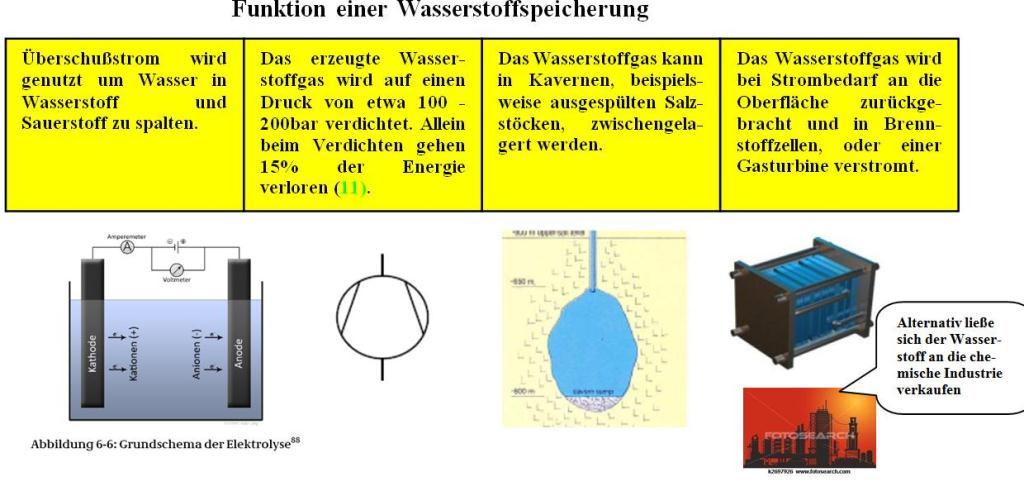

Angesichts dieser Misere werden von der Regierung Hoffnungen auf ganz neue Stromspeichermöglichkeiten geweckt: So trotz der oben beschriebenen Aussichtslosigkeit die Nutzung norwegischer Wasserkraftwerke per Seekabel, die Erzeugung von Wasserstoff mit überflüssigem Windstrom oder die Verwendung von Elektroautos als Speicher für das Stromnetz. Zu diesen Visionen weiter unten.

Ein weiteres, wohl nur aus Verzweiflung geborenes Riesenprojekt

ist der Bau von mindestens 3000 km neuer Höchstspannungsleitungen von Nord- nach Süddeutschland, um den im Norden erzeugten, dort aber gar nicht benötigten Windstrom bis nach Baden-Württemberg und Bayern zu transportieren, wo auch die Abschaltung der Kernkraftwerke besonders große Löcher in die Stromversorgung gerissen hat. Selbstverständlich kann der unzuverlässige Windstrom diese Grundlaststrom-Lücke auch nicht annähernd ausgleichen.

Daß der Plan auch aus anderen Gründen unrealistisch ist, kommt noch hinzu: Siehe dazu Kapitel 6 „Das zweimal vergessene Netz.“

Wenn man alle Systemschwächen der Windkraft ignoriert und nur die installierte, aber fast nie gelieferte Maximalleistung herausstellt und diese den Bürgern auch noch als zuverlässige Stromversorgung verkauft, dann kann man sie für die stärkste der “Erneuerbaren” halten. Realistisch betrachtet ist es jedoch nur eine gelegentliche, unberechenbar und zufällig anfallende Stromerzeugung, die nicht nur sehr teuer ist, sondern auch eine Störung der Stromversorgung darstellt.

Die Regierung kann das aber nicht zugeben,

denn für sie ist Windstrom die Schlüsselkomponente in ihrem Energiekonzept, das sich ohne die Verwirklichung von dessen Phantasiezahlen in Nichts auflösen würde: Bis 2030 sollen die sog. Erneuerbaren enorme 50 Prozent der Stromversorgung liefern; allein die Offshore-Windparks 15 %.

Abgesehen von den erwähnten prinzipiellen Systemschwächen, an denen die Physik und das Wetter Schuld sind, gibt es aber bereits jetzt Schwierigkeiten beim Anschluß der später weitestgehend nutzlosen Windräder auf See: Der Netzbetreiber Tennet, der im vergangenen Jahr das 11.000 km lange Höchstspannungsnetz von E.on gekauft hat, muß nun alle Windparks in der Nordsee anschließen. Jetzt warnte Tennet die Bundesregierung in einem Brandbrief vor Engpässen. Für die Anbindung der Windparks an die Stromnetze auf dem Festland haben die Netzbetreiber feste Fristen. Tennet:

“Tatsächlich gibt es in sämtlichen laufenden Projekten erhebliche Schwierigkeiten im Planungs- und Baufortschritt.“

Alle Beteiligten „stießen an die Grenzen ihrer Ressourcen“, und „hinzu kommen massive Probleme bei der Beschaffung des Kapitals.“ Das ist der Unterschied zwischen Ministerialpapieren und der Wirklichkeit.

Mit welchem tatsächlichen Windräder-Ausbau bis 2022 zu rechnen ist, hat soeben (Anfang Dezember 2011) dankenswerterweise die Bonner Bundesnetzagentur – immerhin eine staatliche Behörde – ermittelt bzw. abgeschätzt: Sie hat den Strombedarf und die Stromerzeugung in Deutschland in drei Szenarien berechnet; als Grundlage für den dann nötigen Netzausbau.

Welches Szenario dann Realität werde, hänge vor allem davon ab, wie stark die Windkraft zulege, sagte Behördenchef Matthias Kurth. Im mittleren Szenario erwartet die Behörde einen Ausbau der installierten Windstrom-Leistung

Die Netzagentur rechnet deshalb auch mit zeitweise erheblichen Stromüberschüssen. Wie diese dann zum Schaden der Verbraucher behandelt werden, ist in Kapitel 5 „Jenseits der Planwirtschaft…“ beschrieben.

In Anbetracht der schon beim jetzigen Ausbau kaum noch zu beherrschenden Schwierigkeiten – siehe die obigen Ausführungen zum unlösbaren Speicherproblem – ist diese Abschätzung der Bundesnetzagentur im Grunde die Projektion einer von Deutschland ausgelösten Katastrophe für den gesamten europäischen Netzverbund. Bereits jetzt beginnen sich die angrenzenden Länder dagegen zu wappnen: Siehe die Ankündigung Polens, die deutschen Windstrom-Überschüsse nicht mehr aufzunehmen – in Kap. 12 „Energiewende bedroht die Nachbarländer“.

Da diese voraussichtlich lange vor dem Erreichen der erwarteten Ausbauzahlen eintreten wird, bekommen wir sie ein paar Milliarden Euro billiger.

3. Solarstrom – geringer Nutzen für sehr viel Geld

Auch die Stromgewinnung aus Sonnenlicht leidet unter dem Wetter und zusätzlich auch unter den Tageszeiten: In der Dämmerung und des Nachts gibt es überhaupt keinen Strom. Ebenso liegt die Leistung der Photovoltaik (PV)-Module bei bedecktem Himmel, bei Regen und auch bei einer Schneedecke auf den Modulen bei Null. Weil auch bei klarem Himmel die Einstrahlung in Deutschland verglichen mit südlichen Ländern eher bescheiden ist, liefern alle für teures Geld installierten Photovoltaik-Zellen trotz ihrer inzwischen gewaltigen installierten theoretischen Maximalleistung, die Ende 2010 bereits den enormen Wert von 16.900 MW erreicht hatte, wegen ihres sehr geringen Nutzungsgrades auch nur einen kläglichen Anteil von 1,9% an der Inlands-Stromerzeugung.

Probleme verursacht die Photovoltaik wegen ihrer dezentral verteilten Einspeisung

auch in den unteren Spannungsebenen des Netzes, das bisher nur auf die Versorgung der Abnehmer, aber nicht auf die Bewältigung vieler Stromerzeuger ausgelegt ist. PV-Anlagen derzeit so ausgelegt sind, dass alle Anlagen – wie in der bisherigen Niederspannungsrichtlinie des BDEW gefordert – bei einer Netzfrequenz von 50,2 Hz, die die Folge einer gefährlich zu hohen Stromeinspeisung ist, gleichzeitig vom Netz gehen.

Dieser abrupte Einbruch kann dann zu einem Netzausfall führen, wie das BMU in einem Berichtsentwurf vom Mai 2011 selbst konstatiert – vgl. Kapitel 6.

Deshalb plant es, den Anwendungsbereich des § 6 EEG auch auf PV-Anlagen zu erstrecken, so dass auch diese in das Einspeisemanagement nach § 11 EEG einbezogen werden. Daß die Betreiber der unteren Verteilungsnetze überhaupt eine Chance zu einem Eingriff in die zahllosen Einzelanlagen haben, ist nicht der Fall.

Denn „bei Wolkendurchzug funktioniert das bei Solarstromanlagen nicht“,

wie der Leiter des Fachgebiets Elektrische Energieversorgungsnetze der TU München, Prof. Rolf Witzmann nüchtern feststellte. Gegen den dadurch verursachten rapiden Wechsel von Leerlauf zu voller PV-Leistung ist der Netzbetreiber machtlos; es hilft nur automatische Abschaltung durch die Einzelanlage selbst und kein „Einspeisemanagement“.

Genau darüber denkt das BMU jetzt nach. In die PV-Anlagen müßten Meßgeräte eingebaut werden, die ständig die Netzfrequenz messen und bei zu hoher Gesamt-Einspeisung, die sich durch Überschreiten der kritischen 50,2 Hertz-Grenze ankündigt, die Einzelanlage abschalten. Das erfordert also eine teure Nachrüstung aller PV-Anlagen. Aber damit nicht genug: Man kann davon ausgehen, daß auch hier wieder dafür gesorgt wird, daß dem Betreiber der nicht gelieferte Solarstrom voll bezahlt wird. Das ist schließlich das Prinzip der Regierung – siehe die „Härtefallregelung“ des EEG § 12.

Der Solarstrom-Nichterzeuger wird also dem Übertragungsnetzbetreiber einen Nachweis über die von seiner Automatik verhinderte Stromeinspeisung liefern müssen, was einen interessanten neuen Entschädigungs-Bürokratismus auszulösen verspricht.

Daß diese Entschädigungen und wahrscheinlich auch die technischen Nachrüstungen der PV-Anlagen wieder von den Stromkunden zu bezahlen wären, kann man sicher erwarten.

Die Erzeugung des Solarstroms ist extrem teuer

Die Besitzer derartiger Anlagen erhalten – entsprechend dem EEG-Gesetz – ab 1.7.2011 pro eingespeister Kilowattstunde 24,4 Cent, was dann dem Strompreis für Endverbraucher aufgeschlagen wird. Und das Geld, das die Solarzellen kostet, geht inzwischen zu ca. 60% nach China. Deutschland ist dank seiner übertriebenen Photovoltaik-Zwangsförderung der weitaus größte Kunde von Chinas neuen PV-Fabriken. Dort sind die Arbeitsplätze entstanden – mit dem Geld der Stromverbraucher, die sich keine eigene PV-Anlage leisten können.

China hat diesen gewaltigen, von deutschen Verbrauchern bezahlten Geldstrom für den Aufbau seiner Photovoltaik-Produktion eingesetzt und ist inzwischen der weltgrößte Hersteller. Chinas Solarzellen sind konkurrenzlos billig und jetzt brechen den deutschen Unternehmen die Umsätze weg. Deutschland exportierte 2010 Solarstromanlagen für 138 Millionen Euro nach China; China exportierte im Gegenzug solche Anlagen im Wert von 5,9 Milliarden Euro nach Deutschland.

Verluste werden geschrieben, Pleiten und Arbeitsplatzverluste drohen.

Es trifft diejenigen Arbeitsplätze, die nach grünen Plänen eigentlich an die Stelle der Jobs in der konventionellen Energiewirtschaft treten sollten. Der Windkraft droht exakt das gleiche Schicksal: 2006 fanden sich unter den zehn weltgrößten Windkraftanlagen-Herstellern noch vier deutsche. 2010 standen nur noch zwei Namen auf der Liste – wohl aber vier chinesische. Das ständig wiederholte Argument über die Erneuerbaren als Jobmaschine löst sich jetzt auf.

Ebenso wie der Windstrom leistet auch der Solarstrom keinerlei Beitrag zur Grundlast-Stromversorgung. Im Gegenteil stört auch diese Wetter-abhängige Stromeinspeisung vor allem die Stabilität im Netz und beansprucht ebenfalls große Stromspeicher, die es nicht gibt.

Ein erstaunliches Eingeständnis ist im EEG-Erfahrungsbericht 2011(Entwurf) des BMU zu lesen:

„Die Vergütungszahlungen im Rahmen des EEG beliefen sich 2010……auf über 12 Mrd. €….. Hier ist es in den letzten Jahren zu Fehlentwicklungen gekommen (!). So entfielen 2010 im Stromsektor von rund 23,7 Mrd. € Investitionen in erneuerbare Energien allein 19,5 Mrd. € und damit über 80% auf die Photovoltaik.“

Und zum Thema Strompreise liest man:

„Insgesamt stieg seit dem Jahr 2000 die durchschnittliche Vergütung für Strom aus (allen) erneuerbaren Energien von 8,5 Cent / kWh auf voraussichtlich 15,5 Cent / kWh (2010) an. Diese Entwicklung mußte dringend gestoppt werden.“

Mit der zum 1.1.2012 vorgesehenen EEG-Novelle, genannt „neues EEG“, habe die Regierung

„wirksam gegengesteuert und insbesondere mit dem Abbau der Überförderung der Photovoltaik entschlossen gehandelt.“

Das Zugeständnis durch die Regierung, daß es hier eine Überförderung gibt, ist interessant; die Behauptung, daß sie nun abgebaut würde, ist unwahr:

In einer Mitteilung des BMU über „Daten und Fakten zur Photovoltaik-Förderung“ vom 17.11.11 heißt es, daß nach dem am 1.1.12 in Kraft tretenden „neuen EEG“ der „Ausbaukorridor“ möglicherweise auf 2500 – 3500 MW zusätzliche PV-Leistung pro Jahr sinken könnte. Ob und wann das tatsächlich erfolgt, bleibt im Unklaren; konkrete und später nachprüfbare Angaben werden vermieden.

Mit einer Absenkung hat das wenig zu tun,

denn ein weiterer jährlicher Ausbau der PV um die genannte Leistung ist nur wenig kleiner als der in den ersten 9 Monaten von 2011 erfolgte Zubau mit 3400 MW. Es soll also genau so weiter gehen, nur nicht so extrem wie im Boomjahr 2010 mit 7200 MW Zubau.

Aber die weitere gewollte Entwicklung, die auch weiter über das EEG und damit über die Verbraucher finanziert wird, ist hier absichtlich nicht quantifiziert worden.

Diese Verschleierungstaktik des BMU hat nun die Bundesnetzagentur – immerhin eine staatliche Behörde – in ihrem im Kapitel 2 „Windstrom…“ erwähnten Bericht vom Dezember 2011 durchbrochen:

Er befaßt sich auch mit dem erwarteten Ausbau der Photovoltaik und nennt Zahlen. Hier erwartet die Behörde in ihrem wahrscheinlicheren Szenario bis 2022 einen Anstieg von heute 18.000 MW auf enorme 54.000 MW. Auch dies wird zu den für die bedauernswerten Verbraucher kostenträchtigen Stromüberschüssen führen.

Ebenso wie der erwartete extreme Ausbau der Windkraft (s.o.) dürfte auch dieser enorme Anstieg der PV sowohl an den dadurch ausgelösten Netzstörungen als auch an den nicht mehr verkraftbaren Kosten scheitern – aber erst nach vielen weiteren von den Verbrauchern gezahlten Milliarden Euro, die in diesem Falle zum größeren Teil nach China fließen.

Die Regierung sitzt in der Klemme:

Einerseits setzt sie voll auf die Photovoltaik. Sie ist eben neben dem Windstrom die zweite Säule der Energiewende. Sie darf trotz erwiesener Nutzlosigkeit nicht fallen, koste es was es wolle.

Andererseits ruiniert die „Überförderung“ die „notwendige Akzeptanz des EEG“ (Zitat aus dem o.e Bericht des BMU). Aber ohne eine derartige die Marktmechanismen außer Kraft setzende Überförderung könnte es den dringend gewünschten Zubau nicht geben. Und auch das „neue EEG“ sorgt weiterhin dafür.

4. Biogas: Wenn Nahrungsmittel verheizt werden

4. Biogas: Wenn Nahrungsmittel verheizt werden

Im Gegensatz zu Wind- und Solarstrom ist Biogas ein Energieträger, der gleichmäßig anfällt, gut speicherbar ist und mit dem auch über einen längeren Zeitraum Strom erzeugt werden kann, obwohl das seine mit Abstand schlechteste Nutzung darstellt. Ebenso wie die für eine Stromerzeugung vollkommen ungeeignete und quantitativ marginale Geothermie wird Biogas zu sehr zur Gewinnung elektrischer Energie eingesetzt, anstatt es mit einfachen Mitteln zu Erdgas zu veredeln und dem Wärmemarkt zuzuführen.

Der Grund dafür ist die ideologische Überbewertung von Stromerzeugung, was zum exzessiven und teuren Ausbau der Windkraft und der Photovoltaik geführt hat und was gleichzeitig zu einer Vernachlässigung der Nutzung regenerativer Energiequellen für die Wärmeerzeugung führte: Solarthermie und die Nutzung von Erdwärme mittels Wärmepumpen hätte statt dessen eine konsequente und wirkungsvolle Förderung verdient.

Die Probleme des Biogases liegen aber nicht allein in einer ineffizienten Nutzung:

Das Hauptproblem ist der große Flächenverbrauch, der zuvor landwirtschaftlich genutzte Flächen betrifft und an die Stelle der Produktion von Nahrungsmitteln Energiepflanzen setzt. Zwar wird angestrebt, pflanzliche Reststoffe und andere biologische Abfälle vermehrt einzusetzen, aber der Druck auf die Umwandlung von Agrarflächen zur Produktion von Raps, Mais, Miscanthus etc. hält wegen der damit erzielbaren weitaus höheren Renditen unvermindert an – eine direkte Folge der Überförderung. Und selbst wenn Gülle zu Biogas vergoren wird, erhöht die Zugabe von Weizen den Gasertrag beträchtlich – und wird unbedenklich angewendet.

Die gleichen Probleme ergeben sich bei der Herstellung von Biotreibstoff. Hier tritt ein weiterer negativer Umwelteffekt auf: Es wird in großem Umfang Palmöl aus subtropischen Ländern – z.B. Indonesien – eingeführt und hier verarbeitet. Im Ursprungsland werden daher neue Ölpalmplantagen eingerichtet und dafür Tropenwald gerodet.

Schon lange prangern vor allem die Kirchen die Umwandlung von Agrarflächen und die Verwendung von Lebensmitteln als Energieträger als unethisch und skandalös an. Selbst das dem Umweltministerium nachgeordnete Umweltbundesamt spricht Biogas und Biodiesel schon lange jeglichen Umweltnutzen ab. In seiner hilflosen und erfolglosen Verteidigung der Einführung des E-10-Treibstoffs wagte es der Umweltminister Röttgen denn auch nicht, diesem irgend einen positiven Umwelteinfluß zuzuschreiben.

Es stellt sich die Frage,

wie lange die Politik und die Öffentlichkeit dieser vom Staat unterstützten Vernichtung von Agrarfläche noch zuschaut. Daß man damit die Energiewende in irgendeiner Weise unterstützen könnte, wird durch einfache Rechnungen widerlegt, aus denen hervorgeht, daß in Deutschland nicht annähernd die für signifikante Biogas-Steigerungen erforderlichen Flächen verfügbar sind. Von den katastrophalen Konsequenzen für den Naturschutz ganz abgesehen.

5. Jenseits der Planwirtschaft: Entschädigung für die Nicht-Erzeugung von „Ökostrom“, Verpflichtung zur Hellseherei und „negative Preise“

Das Erneuerbare-Energien-Gesetz EEG enthält mehrere kaum glaubliche Vorschriften. Einige Beispiele:

Entschädigung für die Strom-Nichterzeugung

Die Härtefallregelung des EEG – der §12 – bestimmt: „Wird die Einspeisung von EEG-Strom wegen eines Netzengpasses…… reduziert, sind die von der Maßnahme betroffenen Betreiberinnen und Betreiber ……für 95 Prozent der entgangenen Einnahmen…zu entschädigen. Übersteigen die entgangenen Einnahmen in einem Jahr ein Prozent der Jahreseinnahmen, sind die Betreiberinnen……zu 100 Prozent zu entschädigen.“

Mit anderen Worten: Bei besonders häufigen Netzstörungen durch den grünen Strom gibt es für dessen Erzeuger mehr Geld.

Dies erinnert leider sehr an die Praktiken der Agrar-Planwirtschaft in der EU, wo ebenfalls Produktionsvermeidungen finanziell belohnt werden. In Deutschland wird nun auch die Energiewirtschaft dazu verurteilt, nach den schlimmsten Methoden der Planwirtschaft zu einem ineffizienten Milliardengrab zu verkommen.

Gesetzliche Verpflichtung zur Hellseherei

Der §12 EEG enthält auch eine Verpflichtung für die Netzbetreiber, die offenbar von den Gesetzesmachern für notorische Betrüger gehalten werden, in die Zukunft zu sehen und das Ergebnis den Betreibern der Ökostromanlagen (EE-Anlagen genannt) verbindlich mitzuteilen. Zitat:

„Betreiber von EE-Anlagen sollen künftig spätestens am Vortag vom Netzbetreiber über den erwarteten Zeitpunkt, den Umfang und die Dauer des Einspeisemanagements (Anm.: gemeint ist der Eingriff des Netzbetreibers, z.B. das Stoppen der Einspeisung in sein Netz) informiert werden.“

Der Netzbetreiber muß also „spätestens am Vortag“ eine Netzüberlastung oder Netzstörung voraussehen. Da derartige Überlastungen gerade durch den plötzlichen und massiven Anstieg von Windstrom innerhalb von Stunden verursacht werden, muß das der Netzbetreiber „spätestens am Vortag“ „den erwarteten Zeitpunkt“ und auch „den Umfang“ sowie ebenfalls „die Dauer“ der morgigen Störung und seiner dann notwendigen Eingriffe sicher feststellen und mitteilen..

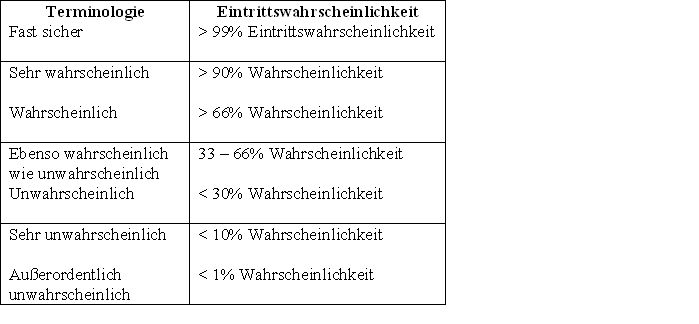

Wahrscheinlichkeits-Aussagen, wie sie die Meteorologen gerne benutzen, da selbst sie niemals exakt die regionalen Wettergeschehnisse vorhersagen können, sind hier unzulässig.

Man darf auf das Ergebnis der sicher kommenden Zivilklagen von Erzeugern gegen Netzbetreiber, die ihren hellseherischen Pflichten nicht nachgekommen sind, gespannt sein.

Diese Bestimmung sagt alles sowohl über den Realitätsbezug als auch über die Denkweise im Bundesumwelt-Ministerium.

Ökostrom-„Verkauf“ zu „negativen Preisen“

Bemerkenswert ist, daß es durch diese Härtefallregelung des EEG dem Netzbetreiber nicht erlaubt ist, bei Unverkäuflichkeit des Ökostroms an der Strombörse diesen abzuschalten bzw. dessen Einspeisung abzulehnen. Er muß stattdessen den vom Markt unerwünschten Strom entweder verschenken, oder gar noch dem Interessenten Geld bezahlen, damit er den Strom abnimmt. Das wird beschönigend „negative Preise“ genannt.

Das BMU schreibt in seinem „EEG-Erfahrungsberichts-Entwurf 2011“:

„Im September 2008 wurde an der Strombörse die Möglichkeit negativer Preise eingeführt. Dies ist bislang weltweit einzigartig. (Anm.: Die Verfasser sind eindeutig stolz darauf). Tatsächlich sind negative Preise inzwischen mehrfach vorgekommen, im Extremfall wurden Preise bis zu minus 500 €/MWh erreicht.

Um die Höhe negativer Preise zu begrenzen, sah die Ausgleichsmechanismus-Ausführungsverordnung (AusglMechAV) vom 22.2.2010 eine bis zum Jahresende 2010 befristete Übergangsregelung vor, welche die Netzbetreiber in Ausnahmefällen von der Pflicht befreite, EEG-Strom um jeden Preis an der Börse verkaufen zu müssen. Um das Kostenrisiko auch über das Jahr 2010 hinaus zu reduzieren, enthält die AusglMechAV seit dem 1.1.2011 eine bis zum 28.2. 2013 befristete Möglichkeit, negative Preise zu begrenzen. Danach greifen Preislimits zwischen minus 150 und minus 350 Euro.“

Es geht also genau so weiter. Selbstverständlich erhält der Erzeuger auch in diesen Fällen seine volle Einspeisevergütung, die genau wie die Zuzahlung an den Abnehmer den Verbrauchern aufgebürdet wird, die dadurch den grünen Strom doppelt bezahlen müssen.

Auch hier stimmt die Parallele zur Agrarpolitik der EU: Überschüsse, die keiner braucht, werden verbilligt, also unter den Erzeugungskosten, ins Ausland exportiert, wodurch dann die regionalen Erzeuger aus dem Markt verdrängt werden. Die durch den Überschußexport in den Empfängerländern angerichteten Schäden addieren sich zu den finanziellen Schäden, die in den EU-Staaten angerichtet werden. Eine exakte Parallele zum jetzt von Deutschland praktizierten doppelt subventionierten Export des überflüssigen Wind- und Solarstroms, der ebenfalls in den Empfängerländern zu Schäden führt: Deshalb die von Polen angekündigte Importsperre für grünen deutschen Überschuß-Strom. (Siehe den Abschnitt „Deutschlands Energiewende bedroht die Nachbarländer“ in Kapitel 12.)

Selbst die UdSSR und ihre Satellitenstaaten haben es während der Ära des „real existierenden Sozialismus“ und seiner letztlich das ganze System zerstörenden Planwirtschaft nicht fertig gebracht, die Nichtproduktion eines Wirtschaftsgutes mit einer Bezahlung zu belohnen. Das war Deutschland vorbehalten. Und das BMU hat hier recht: Das ist einzigartig.

6. Die zweimal vergessenen Netze

Mit den nicht vom Markt, sondern durch die Zwangssubvention des EEG kräftig wachsenden Installationen von Windrädern und Photovoltaikanlagen entstanden zwei ganz unvermeidliche Probleme, die die Große Koalition überhaupt nicht und die Schwarz-Gelbe Regierung erst nach massiven Warnungen der Netzbetreiber ernst nahmen:

Problem Nr.1:

Zum einen bemerkte man schließlich, daß der größere Teil der Windstromanlagen in Norddeutschland liegt, wo man aber deren Strom nicht brauchen kann. Anders in Süddeutschland, wo es nach der Abschaltung mehrerer der dortigen Kernkraftwerke durchaus einen Bedarf gäbe – wenn es dafür ausreichend dimensionierte Nord-Süd-Höchstspannungsleitungen gäbe. Was nicht der Fall ist.

Problem Nr.2:

Zum anderen bemerkte man bis zum Oktober 2011 nicht, daß es auch noch ein zweites gravierendes Netzproblem gibt: Im weitaus größeren regionalen Verteilungsnetz, das technisch nur für die Versorgung der Abnehmer, keineswegs aber für die stark schwankende Stromaufnahme aus vielen dezentralen Windparks und Photovoltaikanlagen (s.u.) und die Weiterleitung dieses Stroms in das Höchstspannungsnetz ausgelegt ist.

Zum bereits bestehenden Ausmaß dieser Situation hat Ende November Holger Gassner, der Leiter Politik und Märkte bei der RWE Innogy, mitgeteilt, daß allein im ersten Halbjahr 2011 ganz enorme Schwankungen der verfügbaren Windkraftkapazitäten von 23.000 MW und der Photovoltaikleistung von 13.000 MW beobachtet worden.

Zum Problem Nr. 1: Für eine bessere Abnahme des Windstroms wünscht die Regierung bereits bis 2020 den Bau von 3000 km neuen Höchstspannungsleitungen von Nord- nach Süddeutschland. Aber der ehemalige Wirtschaftsminister Brüderle legte am 21.3.2011 Eckpunkte für den Stromnetzausbau vor:

“Für den ehrgeizigen Ausbau der erneuerbaren Energien würden etwa 3.600 km neue Leitungen benötigt.”

Die Deutsche Energie-Agentur Dena rechnet jedoch mit erforderlichen 4.450 km an zusätzlichen Höchstspannungsleitungen und die parlamentarische Staatssekretärin im BMU, Katherina Reiche, nannte gerade 4200 km. Die Chancen dafür sind allerdings verschwindend. Bürger wehren sich erfolgreich dagegen; die Planungs- und Genehmigungsverfahren dauern und die Kosten sind enorm. Bisher sind gerade nur 214 km neu gebaut worden (s.u. „Monitorbericht“).

Weil die abgeschalteten Kernkraftwerke zuvor ganz wesentlich zur Stabilisierung des Netzes beigetragen hatten, das mit der schwankenden Ökostromproduktion zu kämpfen hat, – sie können Leistungsschwankungen am schnellsten von allen Kraftwerken durch massives Gegensteuern ausgleichen – mußten zuletzt immer häufiger Windparks zwangsweise abgeschaltet werden. Allein 2010 gingen dadurch ca. 150 Millionen kWh verloren.

Das führte aber keineswegs zu einer geringeren Belastung der Verbraucher,

denn die Regierung hat im EEG in der „Härtefallregelung“ des §12 dafür gesorgt, daß auch in derartigen Fällen Geld fließt: Die Windstromerzeuger, deren Stromeinspeisung wegen der drohenden Stabilitäts-Störung des Netzes von den Netzbetreibern abgelehnt wird, bekommen trotzdem für die Nichterzeugung von Windstrom eine Entschädigung, „die den entgangenen Vergütungen entspricht.“. Näheres in Kapitel 5.

Die Bundesnetzagentur hat in ihrem „Monitorbericht 2011“ interessante Zahlen mitgeteilt. Die Hälfte von 24 besonders wichtigen Ausbauprojekten verzögere sich und die bestehenden Netze seien „durch die Vielzahl der in den letzten Jahren zu erfüllenden Transportaufgaben und die Veränderung der Erzeugungsstruktur (im Klartext: Massiver Ausbau der Wind- und Solarstromerzeugung, Abschaltung von 8 Kernkraftwerken) „am Rand der Belastbarkeit angekommen.“

Die Netzagentur bezieht sich auf Stromleitungen, die im August 2009 als vordringlich eingestuft wurden – mit der Einführung des Energieleitungsausbaugesetzes.

Der Zeitverzug bei diesen 12 Projekten liege zwischen 1 und 4 Jahren.

Erst 214 km von insgesamt 1807 km seien bislang fertiggestellt. Nach Informationen von SPIEGEL-Online werden in dem Monitorbericht 2011 weitere 73 Projekte genannt, die sich nach Angaben von Übertragungsnetzbetreibern verzögern (Angaben vom 2. Quartal 2011).

Auch die Anbindung der neuen Offshore-Windparks an das Netz an Land gerät in Turbulenzen: Soeben warnte der Netzbetreiber Tennet, der in Norddeutschland das E.ON-Stromnetz übernahm, die Bundesregierung in einem Brandbrief vor Engpässen. Es gebe in sämtlichen laufenden Projekten erhebliche Schwierigkeiten im Planungs- und Baufortschritt. Alle Beteiligten „stießen an die Grenzen ihrer Ressourcen“, auch gebe es massive Probleme bei der Kapitalbeschaffung.

Wie die Bürger auf die Aussicht auf den geplanten massiven Ausbau der Hochspannungstrassen reagieren, wird in Kapitel 9 näher beschrieben. Der bremsende Einfluß der vielen Bürgerinitiativen wird von den Netzbetreibern jedenfalls als noch ernster betrachtet, als die langen Genehmigungszeiträume.

Die Zielvorgabe ist vollkommen unrealistisch

wird aber aufrecht erhalten, denn Berlin will auf keinen seiner Stützpfeiler für die Energiewende-Vision verzichten, seien sie auch noch so brüchig. Aber auch einer eingespielten Maschinerie für die Illumination des Bildes einer vollkommen auf „erneuerbaren“ Energiequellen beruhenden Zukunft passiert hin und wieder ein Fehler – bzw. kommt versehentlich ein Stückchen Wahrheit ans Licht:

Das Bundesumweltministerium BMU hat in seinem bereits mehrfach zitierten „Entwurf des Erfahrungsberichts 2011 zum Erneuerbare-Energien-Gesetz“ auf Seite 38 und 39 bemerkenswerte, fast resignierende, Sätze veröffentlicht:

„Es muß davon ausgegangen werden, daß der Netzausbau auch künftig nicht in dem erforderlichen Maß vorankommen wird.“

Und weiter heißt es:

„Obwohl sich die betroffenen Netzbetreiber bemühten, die bestehenden Netzengpässe im Verteilnetz zu überwinden, stieg die durch das Einspeisemanagement abgeregelte Strommenge (Anm.: Das heißt: die abgelehnte Aufnahme ins Netz) aus Windenergieanlagen von 2004 bis 2009 auf das 7-fache an. Einzelne Netzausbaumaßnahmen an kritischen Stellen im Netz könnten große Wirkung entfalten und diesen Trend abschwächen. Dennoch dürfte das Einspeisemanagement mit zunehmendem Ausbau der erneuerbaren Energien weiter an Bedeutung gewinnen, weil es zunehmend zu Netzengpässen kommen wird.“

Zum Problem Nr. 2: Wie im Kapitel3 „Solarstrom..“ beschrieben, treten Netzprobleme keineswegs nur im Hochspannungsnetz auf, das mit dem Transport der Windstrom-Schwankungen nicht fertig wird, sondern sie zeigen sich zunehmend auch in den unteren Spannungsebenen. Dafür sind die immer zahlreicher werdenden Photovoltaikanlagen, insbesondere Solarparks, aber auch Windparks im Binnenland verantwortlich, die mit ihren wetterabhängigen Schwankungen das nicht für Tausende von Stromeinspeisern ausgelegte regionale Netz in Schwierigkeiten bringen.

Man kämpft jetzt mit dem „50,2 Hertz-Problem“,

der abrupten, massenhaften Selbstabschaltung der Photovoltaikanlagen bei Netzüberlastung durch zu hohe Einspeisung. Diese Sicherheitseinrichtung ist vorgeschrieben und sehr vernünftig. Nur hat die Regierung übersehen, daß sie sich damit ein neues Problem einhandelt, wenn eine riesige Anzahl von PV-Anlagen, mit der kein vernünftiger Mensch im sonnenarmen Deutschland je rechnen konnte, das gleichzeitig tut.

Die nun notwendige technische Nachrüstung aller PV-Anlagen mit automatischen Meß- und Abschaltgeräten sowie die mit Gewißheit auch hier künftig praktizierte Entschädigung der PV-Betreiber für den nicht gelieferten Strom würde wohl unweigerlich wieder den Stromverbrauchern aufgebürdet werden.

Als einzige realistische Abhilfe gilt deshalb der Ausbau nicht nur der höchsten, sondern auch der unteren Spannungsebenen mit ihren Netzen und der Einsatz von Ortsnetztransformatoren. Dazu gab es endlich auch eine Zahl – und zwar eine sehr hohe: Katherina Reiche, parlamentarische Staatssekretärin im BMU, erklärte Ende November 2011 auf einem VDI-Kongress, daß das Netz „massiv umgebaut“ werden müsse. „Beim Höchstspannungsnetz seien 4.200 km, bei den Verteilnetzen 200.000 km in moderner Netztechnik nötig.“

Sie reagierte damit vermutlich auf eine im Auftrag des Bundesverbandes Windenergie angefertigte Studie der Ecofys Germany GmbH, in der ein folgenschwerer Satz steht (eigene Ergänzungen in Klammern):

„Die Ausfallarbeit durch Abregelung (d.h. Abschalten der Wind- und Solarstrom-Einspeiser) aufgrund von Netzengpässen im Übertragungsnetz (Höchstspannungsnetz mit 380 oder 220 Kilovolt; Länge 35.000 km) ist bislang noch wesentlich kleiner als die Ausfallarbeit aufgrund von Netzengpässen im (1,7 Millionen km großen) regionalen Verbundnetz.“

Das Hauptproblem für die Netzstabilität liegt also bei den Verteilnetzen:

Bei dem regionalen Hochspannungsnetz (100 oder 60 kV mit 77.000 km); dem Mittelspannungsnetz (30 – 3 kV mit 500.000 km) und Niederspannungsnetz (400 oder 230 Volt mit über 1 Million km) – und die zusammen sind riesenhaft. (Daten von Verivox).

Der Verband kommunaler Unternehmen VKU forderte deshalb in einer Erklärung vom 17.11.2011 die Politik und die Regulierung auf, ihren Blick auf diese 1,7 Mio km der Stromverteilnetze zu richten und nicht nur auf die knapp 35.000 km der Höchstspannungs-Übertragungsnetze, denn mehr als 80% der Anlagen der „Erneuerbaren Energie“ waren 2009 an die unteren Verteilnetze angeschlossen und haben diesen die Probleme gebracht..

Der VKU rechnet für einen derartigen Ausbau und die Integration der dezentralen Energieversorgung in den Verteilnetzen mit 25 Mrd € bis 2030. Darin seien die Kosten des Umbaus zur vielseitigen Meß- und Steuerbarkeit (Smart Grids) noch nicht einmal enthalten. Auswirkungen auf den Strompreis sind unausweichlich.

Peinlich für die Regierung:

Im neuen Energieleitungsausbau-Gesetz EnLAG sind nur die Höchstspannungs-Trassen des Übertragungsnetzes vorgesehen. Es ging den Gesetzesmachern nur um die Durchleitung des Windstroms von Nord nach Süd. Die Gefährdung der Stabilität des weitaus größeren Verteilnetzes durch die vielen unkontrollierten Stromerzeuger hatte man übersehen.

Während die Bundesregierung und ihre Bundesnetzagentur die anwachsende Bedrohung der Netzstabilität herunterspielen – Röttgen bezeichnete solche Warnungen unlängst als Horrorszenario – wächst in der Industrie eben diese Sorge. Nicht aus Freude an Horrorszenarien, sondern aus konkreten Erfahrungen im Jahre der Energiewende 2011.

Das Handelsblatt berichtete am 29.12.2011 über die sinkende Qualität der Stromversorgung: „Mit der beschleunigten Energiewende kommt es bereits heute zu bedenklichen Qualitätsverlusten bei der Stromversorgung“, wird Volker Schwich, der Vorstandsvorsitzende des Verbandes der Industriellen Energie- und Kraftwirtschaft (VIK) zitiert. Die Stabilität komplexer Produktionsprozesse sei bedroht – lange bevor die Allgemeinheit einen Blackout bemerkt. Kurze Unterbrechungen im Millisekundenbereich und Frequenzschwankungen führten jetzt häufiger als früher zu Problemen.

In einem Brandbrief an den Präsidenten der Bundesnetzagentur M. Kurth listet eine Tochterfirma des norwegischen Norsk-Hydro-Konzerns, der als drittgrößter Aluminiumhersteller der Welt in Deutschland an 14 Standorten Unternehmen der Al-Primärproduktion betreibt, die Probleme aus den Instabilitäten auf. Man beobachte „seit Juli 2011 eine beunruhigende Häufung aus Netz- und Frequenzschwankungen.“

In dem Schreiben werden die 5 wesentlichsten Fälle aus den vergangenen Monaten aufgelistet, die zu teuren Schäden geführt hätten. Die steigende Zahl der netzbedingten Produktionsbeeinträchtigungen sei beunruhigend. Eine solche Häufigkeit von Zwischenfällen habe es in den vergangenen Jahrzehnten nicht gegeben.

Die Bundesnetzagentur, die über die Netzstörungen eine Statistik führt, berücksichtigt aber nur ungeplante Unterbrechungen, die länger als 3 Minuten dauern. Der sich daraus ergebende Index (SAIDI) sieht deshalb optisch gut aus.

Er berücksichtigt aber aus der Sicht der Industrie nicht die sich häufenden und wachsende Probleme verursachenden Störungen von weniger als 3 Minuten Dauer.

In der kurzen Debatte um die Energiewende war die Zuverlässigkeit der Stromversorgung ein zentrales Thema. Heinz-Peter Schlüter, der Aufsichtsratsvorsitzende und Eigentümer von Trimet-Aluminium, hatte in den Anhörungen der Ethik-Kommission „Sichere Energieversorgung“ vor den unausweichlich auf die Industrie zukommenden Problemen gewarnt: Mit dem Wegfall einer zuverlässigen Stromversorgung verliere er seine Existenzgrundlage.

„Nur vier Stunden ohne Stromversorgung und die Produktionsanlagen meines Unternehmens wären irreparabel zerstört“, hatte Schlüter gewarnt.

Die Töpfer-Ethik-Kommission setzte sich darüber hinweg.

Während die Bundesregierung und ihre Bundesnetzagentur die anwachsende Bedrohung der Netzstabilität herunterspielen – Röttgen bezeichnete solche Warnungen unlängst als Horrorszenario – wächst in der Industrie eben diese Sorge. Nicht aus Freude an Horrorszenarien, sondern aus konkreten Erfahrungen im Jahre der Energiewende 2011.

Das Handelsblatt berichtete am 29.12.2011 über die sinkende Qualität der Stromversorgung: „Mit der beschleunigten Energiewende kommt es bereits heute zu bedenklichen Qualitätsverlusten bei der Stromversorgung“, wird Volker Schwich, der Vorstandsvorsitzende des Verbandes der Industriellen Energie- und Kraftwirtschaft (VIK) zitiert. Die Stabilität komplexer Produktionsprozesse sei bedroht – lange bevor die Allgemeinheit einen Blackout bemerkt. Kurze Unterbrechungen im Millisekundenbereich und Frequenzschwankungen führten jetzt häufiger als früher zu Problemen.

In einem Brandbrief an den Präsidenten der Bundesnetzagentur M. Kurth listet eine Tochterfirma des norwegischen Norsk-Hydro-Konzerns, der als drittgrößter Aluminiumhersteller der Welt in Deutschland an 14 Standorten Unternehmen der Al-Primärproduktion betreibt, die Probleme aus den Instabilitäten auf. Man beobachte „seit Juli 2011 eine beunruhigende Häufung aus Netz- und Frequenzschwankungen.“

In dem Schreiben werden die 5 wesentlichsten Fälle aus den vergangenen Monaten aufgelistet, die zu teuren Schäden geführt hätten. Die steigende Zahl der netzbedingten Produktionsbeeinträchtigungen sei beunruhigend. Eine solche Häufigkeit von Zwischenfällen habe es in den vergangenen Jahrzehnten nicht gegeben.

Die Bundesnetzagentur, die über die Netzstörungen eine Statistik führt, berücksichtigt aber nur ungeplante Unterbrechungen, die länger als 3 Minuten dauern. Der sich daraus ergebende Index (SAIDI) sieht deshalb optisch gut aus.

Er berücksichtigt aber aus der Sicht der Industrie nicht die sich häufenden und wachsende Probleme verursachenden Störungen von weniger als 3 Minuten Dauer.

In der kurzen Debatte um die Energiewende war die Zuverlässigkeit der Stromversorgung ein zentrales Thema. Heinz-Peter Schlüter, der Aufsichtsratsvorsitzende und Eigentümer von Trimet-Aluminium, hatte in den Anhörungen der Ethik-Kommission „Sichere Energieversorgung“ vor den unausweichlich auf die Industrie zukommenden Problemen gewarnt: Mit dem Wegfall einer zuverlässigen Stromversorgung verliere er seine Existenzgrundlage.

„Nur vier Stunden ohne Stromversorgung und die Produktionsanlagen meines Unternehmens wären irreparabel zerstört“, hatte Schlüter gewarnt.

Die Töpfer-Ethik-Kommission setzte sich darüber hinweg.

Inzwischen bereitet sich Hamburg auf die Möglichkeit eines totalen Stromausfalls im kommenden Winter vor, wie WELT Online am 21.11.2011 berichtete.

Der Netzbetreiber 50Hertz arbeite an einem Notfallplan und verhandle bereits mit großen Stromverbrauchern über eine Abschaltung. Olivier Felix von 50Hertz:

„Eine solche Situation kann eintreten, wenn im Winter bei Hochdrucklagen keine Windenergie erhältlich ist und zusätzlich das KKW Brokdorf unerwartet abgeschaltet werden muß.“

Vor nicht allzu langer Zeit gab es in dieser Region noch die KKW Stade (wird abgerissen), Brunsbüttel und Krümmel (sind stillgelegt). Deren Leistung fehlt nun.

Zur Erinnerung: Dieser geplante riesenhafte Ausbau des Stromnetzes ist nur eine Folge der Fehlentscheidung, die Windkraft ebenso wie die Photovoltaik so lange übermäßig durch Subventionen zu fördern, bis deren gewaltige Schwankungen und ihr unvorhersehbar auftretender Überschuß zu einer Bedrohung der Netzstabilität wurde. Ohne diese Fehlentscheidung hätte das Netz weiterhin völlig ausgereicht.

Wenn unsere Nachbarländer dem Beispiel Polens, das keinen grünen Spitzenstrom mehr hereinlassen will, folgen sollten, bricht das deutsche Stromnetz durch die selbst verschuldeten Störungen, die dann nicht mehr exportiert werden können, bei jedem Sturmtief zusammen. (Siehe Kap. 12 „Energiewende bedroht die Nachbarländer.“)

Doch die Geldvernichtung im Namen der angeblich davon profitierenden Umwelt geht unvermindert weiter: Die Regierung subventioniert Wind- und Solarstrom weiterhin mit dem EEG und bekämpft anschließend mit weiteren Milliarden die eben dadurch verschärften Probleme.

7. Schäden umverteilen

Daß die Energiewende zu Strompreiserhöhungen führen wird, bestreitet nicht einmal die Regierung. Aber das Ausmaß dieser Erhöhung wird von ihr verniedlicht, während externe Fachleute von mindestens 20% ausgehen. Wesentlicher Grund dafür ist die 2011 erfolgte Abschaltung von 8 deutschen Kernkraftwerken, die bisher preisgünstigen Grundlaststrom erzeugten, der nun vermehrt durch Stromimporte aus Frankreich, Tschechien und Polen ersetzt werden muß – was Frau Merkel zunächst kategorisch ausgeschlossen hatte.

Strom Import-Export Bilanz in Deutschland Janunar-Oktober 2011 (rot: Import, blau: Export; Quelle: wilfriedheck.de)

Ein weiterer Grund ist der weitergehende Ausbau der teuren “erneuerbaren” Stromerzeuger Windkraft, Solarzellen und Biogas-gefeuerte Kleinkraftwerke, deren vom EEG garantierte Einspeisevergütungen den Stromverbrauchern aufgebürdet werden.

Dieser Anteil an der Stromrechnung steigt daher systematisch,

wobei auch wieder festzustellen ist, daß die Regierung wesentlich niedrigere Zahlen nennt als Energiewirtschaftler.

Der EU-Energiekommissar Günther Oettinger warnte bereits Anfang März, danach im Juni, im August, im September und zuletzt am 22.10.2011 vor den dramatischen Folgen des steigenden Strompreises für Deutschland. Hohe Energiekosten gefährdeten nicht nur den Wirtschaftsstandort, sondern auch den sozialen Frieden, wenn ein Teil der Menschen die Stromrechnung nicht mehr bezahlen könne. “Ich bin überrascht, wie gedankenlos die Entwicklung der Strompreise hingenommen wird,” sagte Oettinger auf dem internationalen Wirtschaftsforum in Baden-Baden. Deutschland zähle weltweit zu der Spitzengruppe bei den Strompreisen. Dies sei eine Ursache für die stetige De-Industrialisierung – energieträchtige Produktionen würden ins Ausland verlagert, sagte Oettinger.

Wie ernst diese Situation für die energieintensiven Industrien – Chemie, Papierindustrie, Düngemittelindustrie, Glaswerke, Stahlwerke, Baustoffindustrie, Aluminiumhersteller, Metallverarbeitung – bereits geworden ist, ist der Regierung bereits durch Wirtschaftsverbände und Gewerkschaften klar gemacht worden.

Das Schlupfloch: Die Stromnetzentgeltverordnung

Die Reaktion der Regierung war bezeichnend: Der Staat verzichtet keineswegs auf seine vielfältigen Steuern und Abgaben auf den Strompreis, die ihn hier dermaßen teuer machen. Er verteilt die Lasten einfach um. Das Instrument dafür ist die o.g. am 28.7.2011 geänderte Verordnung (StromNEV), die unauffällig im Konvoi anderer Energiewende-Gesetze versteckt und die von der Presse erst nach einem Vierteljahr entdeckt wurde.

In dem für Laien praktisch unlesbaren Juristenchinesisch verbirgt sich im §19 ein Goldesel: Unternehmen mit einem hohen Verbrauch werden fast komplett von den Netzgebühren befreit – und auch noch rückwirkend für das laufende Jahr. Unternehmen, die mindestens 7000 Stunden jährlich am Stromnetz hängen und mehr als 10 Millionen kWh Strom verbrauchen, müssen gar keine Netzgebühren mehr bezahlen.

Bereits ab einem jährlichen Stromverbrauch von 100.000 kWh sinken die Netzkosten deutlich, so daß Tausende Unternehmen nicht den vollen Preis zahlen müssen. Die dadurch von den Unternehmen gesparten Netzkosten werden voll auf den Strompreis umgelegt – also von den Verbrauchern bezahlt. Geschätzt wird, daß die Strompreise allein durch diese Netzkostenermäßigung um 0,75 bis 1,0 Cent / kWh steigen könnten. Pro Haushalt mit ca. 4000 kWh Jahresverbrauch wären das bis zu 40 Euro mehr.

„Die Industrie zu entlasten und allein die Kleinverbraucher die Zeche zahlen zu lassen, ist eine Dreistigkeit, die bisher ohne Beispiel ist,“

zitierte die „Frankfurter Rundschau“ Verbraucherschützer Holger Krawinkel.

Aber das ist das durchgängige Prinzip bei der Energiewende. Sie beruht schließlich ganz wesentlich auf der Schröpfung der Bürger durch ihre Zwangsbeglückung mit zu teurer Energie. Mit dieser fortgesetzten Umverteilung zu Lasten der kleinen Leute dürften die Warnungen des Energiekommissars vor dem Ende des sozialen Friedens Wirklichkeit werden.

Eine auch gegenüber unseren Nachbarländern betriebene Rücksichtslosigkeit, die bislang ohne Beispiel ist, stellt der Mißbrauch der Stromnetze dieser Länder als Ausgleichspuffer für den in Deutschland nicht verwendbaren Wind- und Solarstrom dar. Mit den dadurch ausgelösten Spannungs- und Frequenzschwankungen dürfen sich dann die Netzbetreiber dieser Länder herumschlagen.

Ohne diesen zum Teil mit teuren Zuzahlungen erkauften Export der nicht nutzbaren Überschüsse (siehe Kap. 5 „Jenseits der Planwirtschaft“) würden die Netzstörungen in Deutschland wohl unbeherrschbar.

Das erklärt, weshalb die Energiewende-Gesetzgebung mit ihrer massiven Grundlast-Abschaltung der 8 KKW ohne jegliche Konsultation oder Vorwarnung der Regierungen der Nachbarländer durchgesetzt worden ist. Die deutsche Regierung wußte sehr genau, wie deren Reaktion ausgesehen hätte: Sie ist im Kap. 15 „Ein internationales Urteil“ nachzulesen.

8. Das stille Ende großer Ankündigungen

Sie haben es sicherlich bemerkt: Klimaschutz ist plötzlich “out”. Jahrelang hat die Regierung Deutschland als einsamen Vorreiter und moralisches Vorbild bei der Reduzierung der CO2-Emissionen hingestellt. Der nach dem Anschluß der DDR dort stattgefundene Zusammenbruch der Industrie sowie die anschließende Modernisierung ihres Restes hat einen beträchtlichen Rückgang der dortigen Emissionen zur Folge gehabt – den sich die Bundesrepublik als eigene Leistung angerechnet hat. Damit konnte sie die Selbstverpflichtung, die CO2-Emissionen gegenüber dem sehr geeigneten Jahr 1990 um 21% zu vermindern, mit 23,4% sogar übertreffen. Anschließend hat sie in der EU die Forderung nach einer Absenkung der Emissionen bis 2020 um 40% erhoben – was von den Grünen als „ambitionierte Vorreiterrolle“ bezeichnet wurde.

Das ist nun seit Verkündigung der Energiewende Makulatur.

Die Abschaltung von 8 unbestreitbar CO2-freien Kernkraftwerken und der Ersatz des Stromausfalls durch Importe – teilweise von Kohlekraftwerken – und Hochfahren auch noch der letzten und ineffizientesten deutschen Kohlekraftwerke hat alle großartigen Selbstverpflichtungen abrupt in eine Peinlichkeit verwandelt. Hinzu kommt, daß Deutschland dringend neue Grundlastkraftwerke benötigt – und das können nach derzeitiger politischer Lage wiederum nur Kohlekraftwerke sein, wenn auch sehr moderne. Die Braunkohle-Bundesländer und die Industriegewerkschaft Bergbau, Chemie, Energie begrüßen das sehr.

Aber die Grünen und zahlreiche Bürgerinitiativen, die vom Ende der Klimaschutzpolitik noch nichts gehört haben, behindern den Neubau von Kohlekraftwerken nach Kräften. – siehe Projekt Datteln. Allein in NRW sind drei Neubauprojekte gestoppt bzw. verzögert: Das EON-Kraftwerk Datteln wurde vom NRW-Oberverwaltungsgericht gestoppt, ebenfalls das Trianel-Kraftwerk Lühen; für beide fordert der Bund für Umwelt und Naturschutz BUND das Ende. Das Trianel-Steinkohlekraftwerk Krefeld wurde nach heftigen Protesten der Umweltschützer aufgegeben – eventuell wird stattdessen innerhalb von 6 Jahren ein Gaskraftwerk gebaut. Und der neue Block 10 des STEAG-Kraftwerks Walsum wird wegen technischer Probleme erst drei Jahre später ans Netz gehen.

Dennoch müßte es unbedingt weitere Kohlekraftwerke geben; die Regierung hat gar keine andere Wahl, als nun auch beim sogenannten Klimaschutz eine 180-Grad-Wende zu fahren. Aber sie streitet über das Neubau-Thema – siehe den Abschnitt „Für die Bürger wird es immer teurer“ im Kapitel 14.

Aber das werden dann auch nicht einmal Kraftwerke mit CO2-Abtrennung (CCS) sein, wie es stets vollmundig verkündet wurde. Denn die Regierung erlitt kürzlich eine schwere Niederlage: Der Bundesrat lehnte ihren Gesetzesvorstoß ab, der es ermöglichen sollte, in Kraftwerken abgetrenntes CO2 zunächst versuchsweise in ehemaligen Gasspeichern zu lagern. Er will auch nicht den Vermittlungsausschuß anrufen. Damit ist die unterirdische Einlagerung von CO2 in Deutschland erst einmal unmöglich.

Die Abtrennungs- und Speichertechnik sollte eigentlich durch ein vom Energieversorger Vattenfall zu bauendes Demonstrationskraftwerk im Brandenburgischen Jänschwalde erprobt werden.

Jetzt hat Vattenfall Anfang Dezember 2011 erklärt, daß dieses Projekt gestoppt wird.

Grund sei das jahrelange erfolglose Ringen um eine gesetzliche Grundlage, teilte Vattenfall mit und bezog sich dabei vermutlich auch auf die kürzliche Ablehnung der CO2-Einlagerung (s.o.). Minister Röttgen zeigte sich enttäuscht. Jetzt fehlt es also weiterhin sowohl an der Abtrenungstechnik als auch an der Möglichkeit zur Lagerung des Gases. Damit sind auch alle Lippenbekenntnisse zum künftigen Bau von ausschließlich CO2-freien Kohlekraftwerken gegenstandslos geworden. Aber neue Kohlekraftwerke werden nach der Abschaltung der AKW dringend benötigt. Es werden dann – falls es der in den vergangenen Jahren stets begrüßte Widerstand der Bevölkerung überhaupt zulässt und die Investoren das Risiko überhaupt tragen wollen– ganz normale Kohlekraftwerke ohne CO2-Abtrennung gebaut.

Womit die CO2-Emissionen Deutschlands noch mehr steigen werden, als es bereits jetzt der Fall ist.

Mit diesem Dilemma ist die Regierung aber nicht allein: Die EU verfolgt das Ziel, 2050 rund 90% weniger CO2 zu emittieren, wozu entscheidend die CCS-Technik gebraucht wird. Die EU-Kommission geht davon aus, daß im Jahre 2035 CO2 aus Kohle- und Gaskraftwerken mit einer Kapazität von 35.000 MW abgetrennt und gespeichert werden kann. Allerdings fehlen Erfolgsmeldungen: Nur Spanien, die Niederlande und Rumänien haben bisher die EU-Richtlinie zur geologischen Speicherung von CO2 vom April 2009 in nationales Recht übernommen. In allen anderen EU-Staaten fehlt Investoren die Rechtssicherheit.

Und von den 6 von der EU-Kommission geplanten Pilotprojekten wird eventuell nur das in Rotterdam bis 2015 in Betrieb gehen. Das deutsche Projekt Jänschwalde hätte keinen Ort zur Speicherung des Gases.

Das Hauptproblem der CCS-Technik ist die fehlende Wirtschaftlichkeit. Eine Tonne CO2 abzuscheiden kostet ca. 50 €. Im Emissionshandel liegt der Preis für diese Menge bei ca. 10 €. Und er könnte später noch weiter sinken, wenn in Europa die neuen Erdgasquellen ausgebeutet werden – siehe Kapitel 13.

Aber auch mit der Verwendung von CO2 als Rohstoff (CCU) kann nur ein kleiner Teil der Emissionen genutzt werden, wie kürzlich auf einem Kongress in Düsseldorf einhellig festgestellt wurde. Die größte Hürde – vor allem in Mitteleuropa und Skandinavien ist aber die fehlende Akzeptanz der CO2-Speicherung vor der eigenen Haustür. Zur Rolle der Bürgerinitiativen mehr in Kapitel 11.

Die Erwartung der Regierung, daß künftig viele neue Gaskraftwerke gebaut werden,

die wegen ihrer geringeren Emissionen als klimafreundlicher gelten und auch als Regelungskraftwerke zum Ausgleich der Einspeisungs-Schwankungen benutzt werden könnten, wird sich nach Aussagen der Kraftwerksbetreiber nicht erfüllen. Das würde sich nicht rechnen, denn einerseits sind die Gaspreise zu hoch, andererseits sind Kraftwerke, die nur gelegentlich angefahren werden, um das Netz zu stabilisieren, unrentabel und rechtfertigen keine Investition. Es bleibt nur die Kohle. Ob Deutschland wenigstens nach 10 Jahren in den Genuß des billigen Erdgases aus „unkonventionellen“ Quellen (Shale-Gas) kommen wird, ist unsicher – siehe Kapitel 13.

Seit 6 Jahren experimentiert Deutschland auch mit Klimaschutz durch den Emissionshandel. Das Ergebnis stellt eine Kapitulation dar: Der Staat beschenkt mittlerweile energieintensive Unternehmen – z.B. Stahl-, Zement- und Chemieindustrie; insgesamt 164 Industriebereiche – üppig mit Emissionsrechten, nach Meinung von Kritikern wie BUND sogar viel mehr als nötig, damit sie nicht abwandern. Diese Emissionsrechte können sie nun weiterverkaufen. Ein Zwang zum erhofften CO2-Sparen entfällt; der Effekt ist gleich Null.

Die Regierung wird somit in den kommenden Jahren stetig ansteigende CO2-Emissionen registrieren,

sie aber vermutlich nicht mehr kommentieren. Sie hat vielleicht die Hoffnung, daß die weltweit stark ansteigenden Emissionen – allein 2010 gegenüber 2009 um +6 Prozent auf knapp 32 Mrd Tonnen, vor allem durch China, Indien, USA, Russland und Japan – von der ehemals „ambitionierten Vorreiterrolle“ Deutschlands ablenken würden.

Man könnte nun auf die Idee kommen, daß eine Regierung, die derart leichthin ihre moralisch überlegen gespielte Rolle als selbsternannte Weltretterin opfert, ebenso eines Tages ihre Energiewende einfach ausklinken könnte. Man kann sich jedoch nicht darauf verlassen, denn die Lobby, die man mit dem EEG geschaffen hat, ist stark.

9. Das Prinzip Hoffnung als Realitätsersatz

Ein von der Politik schon immer eingesetztes Mittel zur Stärkung der Überzeugungskraft von Plänen ist die Projektion von Verheißungen, das Versprechen von neuen Möglichkeiten, wozu sich insbesondere die Schilderung von neuen technischen Lösungen sehr gut eignet, weil hierbei die rasche Nachprüfung durch die Bürger entfällt und auch die Medien erfolgreich als Werbeträger eingesetzt werden können.

In keinem anderen Sachbereich wird von dieser Methode derart viel Gebrauch gemacht,

wie bei der Energieversorgung. Und je ungewisser den Verkündern neuer Lösungswege – zum Beispiel eine Energiewende – die Erfolgschancen erscheinen, umso mehr arbeiten sie mit Visionen, Hoffnungen und Versprechungen.

Die am meisten benutzte Methode ist die Beschreibung von tatsächlich noch nicht entwickelten Techniken als in Kürze sicher und erfolgreich einsetzbar.

Die Begründungsversuche für die sog. Energiewende stützen sich ganz erheblich auf derartige Beispiele. Ihre Merkmale sind:

- Verschweigen des noch verstreichenden Zeitraums bis eine ausgereifte Technik entwickelt ist; statt dessen Erwecken des Eindrucks kurzfristiger Verfügbarkeit.

- Unterschlagung wichtiger Leistungsziffern, insbesondere Wirkungsgrade bzw. Verluste sowie Kosten – z.B. die Investitionskosten pro geleistetem Kilowatt an Leistung und die Kosten einer erzeugten Kilowattstunde.

- Verschleierung der für bestimmte Techniken vergebenen Subventionen bzw. Zwangsabgaben und deren Auswirkung auf die Verbraucher. Drastisches Beispiel: Das erneuerbare Energien-Gesetz EEG.

- Verschweigen der damit verbundenen direkten Umweltbelastungen wie Flächenverbrauch (Biomassenutzung, Energiepflanzen), Lärmemissionen (Windräder), Feinstaubemissionen (Pelletheizungen), Gesundheitsgefahren (CO2-Speicher), Gefährdung von Gebäuden (Geothermie), Landschaftszerschneidung (Höchstspannungs-Trassen). Ebenso auch indirekter schädlicher Auswirkungen wie Biodiversitätsverluste durch Monokulturen (Energiepflanzen), der weltweite Anstieg der Nahrungsmittelpreise durch exzessive energetische Nutzung von Feldfrüchten mit Verlust von Anbauflächen für Nahrungsmittel oder die sozialen Auswirkungen steigender Energiepreise für Menschen mit geringem Einkommen (s. Aussagen von Oettinger).

Hier eine Zusammenstellung einiger Beispiele:

-

Technologien zur CO2-Abtrennung aus den Abgasen von Kohle- und Gaskraftwerken. Dazu Prof. H.-J. Wagner, Institut für Energietechnik der Ruhr-Univ. Bochum: „Kraftwerke mit CO2-Abscheidung werden erst in der übernächsten Generation, also in 30-40 Jahren, zum großtechnischen Einsatz kommen.“

-

Die unterirdische CO2-Speicherung: Bereits die gesetzliche Regelung zur Erprobung ist am Widerstand der Bürger gescheitert;

-

Der Ausbau des Höchstspannungsnetzes um 4200 km innerhalb der nächsten 20 Jahre: Bisher nur 214 km realisiert; angesichts der Widerstände ist selbst das Erreichen eines kleinen Teils dieser Pläne aussichtslos.

-

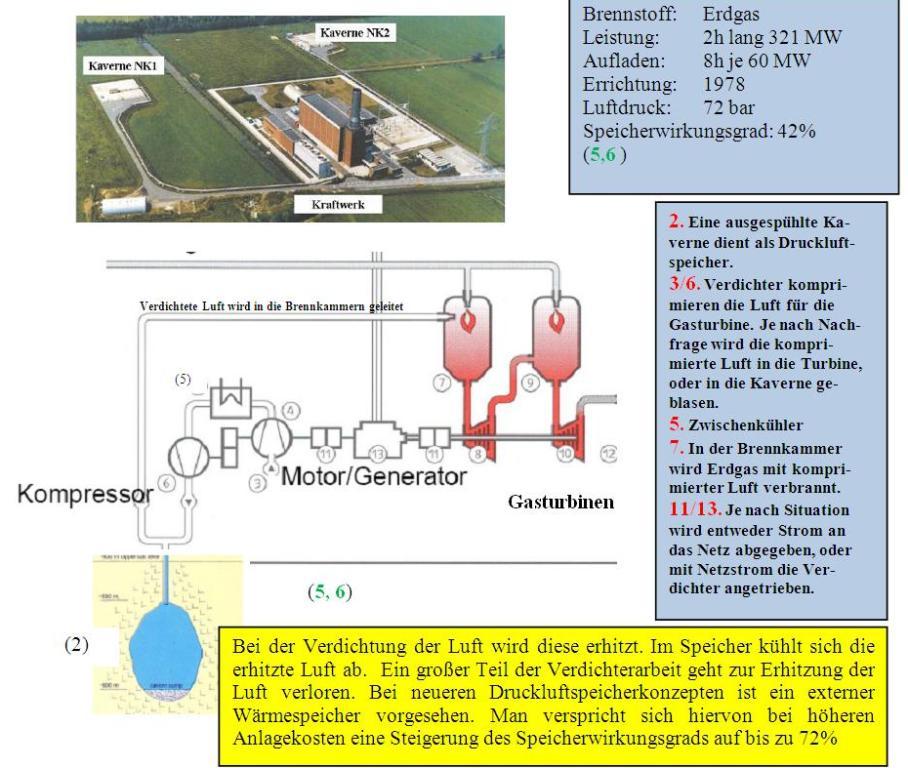

Druckluftspeicher zum Ausgleich von Windstromschwankungen: Das erste und einzige Entwicklungsprojekt für adiabatische Druckluftspeicherung namens ADELE stellte am 22.11.2010 die RWE Power in Staßfurt/Sachsen-Anhalt vor. Zu schaffende Voraussetzungen: „Erfolgreiches Abschließen der technischen Untersuchungen und Planungen; Finanzierung einschließlich der erforderlichen (!) Förderung; Geologie des Standortes.“ Viele wesentliche technische Komponenten müssen ebenfalls erst noch entwickelt werden. Ob in 30 Jahren die Marktreife erreicht werden kann, ist unklar.

-

Seekabelverbindungen zu norwegischen Pumpspeicher-Kraftwerken mit mindestens 5000 MW Übertragungsleistung: Siehe die obigen Ausführungen von Prof. Vahrenholt in Kap.1. Ein erstes kleineres Projekt befindet sich bereits in Schwierigkeiten: Das 530 km lange Nord Link Ein solches Kabel soll es bis Anfang 2017 geben. Es soll 1.400 MW übertragen. Das entspricht der Leistung eines Kernkraftwerks und gerade einmal 4 Prozent der schon jetzt in Deutschland installierten Windstromleistung. Mehrere Partner verließen das Projekt bereits.

Fünf bis zehn dieser Seekabel wären wohl nötig, geplant sind sie nicht, und es gibt noch andere Probleme: Die meisten norwegischen Wasserkraftwerke sind keine in beiden Richtungen (bergauf und bergab) arbeitenden Pumpspeicherwerke. Sie müßten teuer und langwierig umgebaut werden – wenn es die Norweger überhaupt wollen.

Außerdem wollen alle Nordseeanrainer, die ebenfalls Windkraftanlagen gebaut haben, ebenfalls mit Seekabeln an die norwegische Wasserkraft heran. Holland hat es schon getan. Damit fällt für jeden weniger Speicherkapazität ab. Und schließlich: Schon jetzt kämpfen Bürgerinitiativen in Norddeutschland gegen die Umspannstation an Land und die neuen Hochspannungsleitungen. Siehe auch die Ausführungen von Prof. Vahrenholt, Kap. 2: „Windstrom“.

-

Bezahlbare, leistungsfähige und langlebige Batterien für Elektroautos. Diese Entwicklung dauert voraussichtlich mehr als 20 Jahre. Als Speicher für Wind- oder Solarstrom wird auch danach kaum ein Autobesitzer seine Batterien bereitstellen: Ihre Lebensdauer leidet darunter.

-

Brennstoffzellen zur Stromerzeugung aus Wasserstoff, der wiederum per Elektrolyse aus überflüssigem Windstrom gewonnen wurde. Zu teuer, zu geringe Lebensdauer, unausgereifte Technik.

-

Solarstrom aus Nordafrika für Europa: Das DESERTEC-Projekt. Abgesehen von enormen Kosten, enormen Leistungsverlusten bei Stromerzeugung und Transport bis Mitteleuropa sind sehr lange, neue Höchstspannungstrassen notwendig – und kaum realisierbar. Zudem haben die politischen Umbrüche in Nordafrika alle Pläne obsolet gemacht.

-

Unterirdische Pumpspeicherwerke in ehemaligen Bergwerken. Noch existieren nur Pläne. Bis zur Marktreife mindestens 25 Jahre. Problem: Über Tage müßten sehr große und tiefe Speicherseen angelegt werden.

-

Hybridspeicher: Wasserstofferzeugung durch Windstrom-Elektrolyse mit anschließender Stromerzeugung durch Verbrennungskraftmaschine plus Stromgenerator. Diese Anlage würde 81% des eingespeisten Windstroms als Abwärmeverluste vernichten. Absurd, aber als Pilotanlage in Prenzlau errichtet. Eine chancenlose Energievernichtungstechnik, die wahrscheinlich mit Steuergeldern gefördert wurde. Details in Kap.5.

-

Geothermie-Kraftwerke zur Stromerzeugung. Die äußerst geringe Temperaturdifferenz, mit der diese Wärmekraftanlagen arbeiten müssen (ca. 140oC), führt zu einem kläglich kleinen Wirkungsgrad, der fast immer verschwiegen wird. Erstmals wurden im Herbst 2011 in einem Fachbericht über das geplante „petrothermale“ Kraftwerk in Munster-Bispingen (Lüneburger Heide) die interessanten Zahlen genannt: Thermalwassertemperatur 160oC; thermische Leistung 14,7 MW; elektrische Leistung 1,2 MW. Elektrischer Wirkungsgrad somit trotz relativ hoher Temperatur des Thermalwassers nur 8,2%. Das heißt: Sehr wenig elektrische Leistung für sehr hohe Investitionskosten, die hier 43 Mio € betragen; somit 36.000 € für 1 kWel. Zum Vergleich: 1 kW eines Kohlekraftwerks kosten 1.140-1.480 €; selbst bei einer kleinen Haus-Blockheizanlage kostet 1 Kilowatt 3.700-7.500 €. Stromerzeugung mit Geothermie ist also extrem unrentabel. Nur als Fernheizung hat es Sinn.

Diese und weitere Techniken sind zwar realisierbar, jedoch entweder noch weit von einer Markteinführung entfernt, von untragbar hohen Kosten gekennzeichnet, mit unakzeptablen Verlusten behaftet oder ihr Einsatz bleibt durch andere Defizite weit jenseits des politisch anvisierten Zeitraumes. Somit ohne Wirkung für die Umsetzung der Ziele der Energiewende.

Ein weiteres Hoffnungsargument in den Energiewende-Papieren

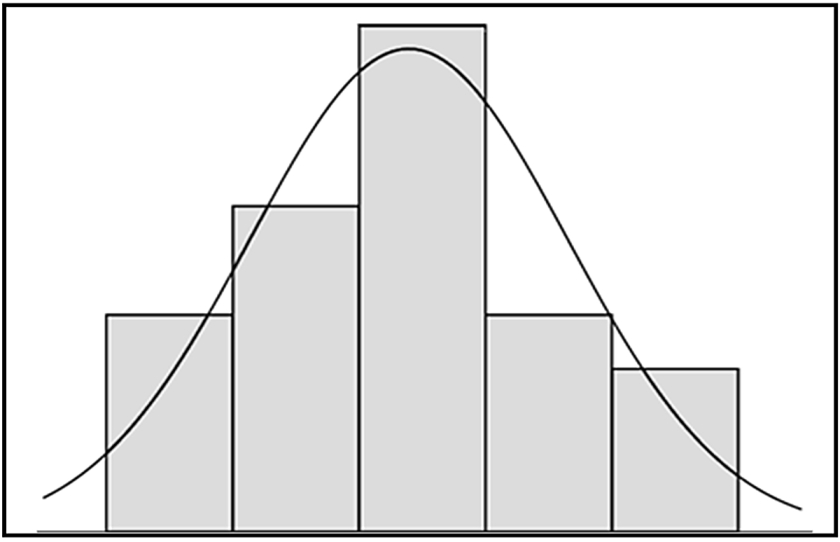

besteht in der Annahme der Regierung, daß der Bedarf an elektrischer Energie jährlich um 1,7% sinken werde. Diese Annahme wurde offenbar sehr zum Erreichen besserer Zahlen benötigt.

Sie wurde aber schon zuvor durch eine Studie der Task Force „Stromversorgung und Umwelt“ des VDE von 2009 widerlegt: Der bisherige langfristige Trend sei im Gegenteil eine Erhöhung von 1,2% pro Jahr gewesen. Seit 2006 habe er +0,6% betragen – und dieser jährliche Verbrauchszuwachs von 0,6% sei auch unter der Annahme von weiterhin erzielbaren Effizienzfortschritten wegen der zunehmenden Anwendung elektrischer Energie auch das wahrscheinlichste Szenario für die Zukunft.

10. Fehlinvestitionen: Die Förderung des Ungeeigneten

10. Fehlinvestitionen: Die Förderung des Ungeeigneten

Die ideologische Überbewertung der Stromerzeugung durch alle sogenannten erneuerbaren Energiequellen und die Vernachlässigung der Nutzung dieser Energiequellen für die Wärmeerzeugung führte zu einer extremen Fehlsteuerung, deren Kern das EEG-Gesetz ist. Milliarden Euro werden den Verbrauchern abgenommen und in unzuverlässige, unrentable und im Falle der großtechnischen Biogasproduktion sogar umweltschädliche Investitionen geleitet, die im Falle von Windkraft und Solarstrom nicht etwa der sicheren Stromversorgung dienen, sondern sie im Gegenteil noch gefährden. Anstatt diese gigantische Fehlinvestition zu beenden, wird sie verstärkt fortgeführt – siehe die Energiewende-Schwerpunkte – und zur Schadensbegrenzung sollen weitere Milliarden für einen zuvor vollkommen unnötigen riesigen Netzausbau und für die verschiedensten Stromspeicherkonzepte ausgegeben werden, von denen die meisten wegen extremer Kosten und ebenso extremer Verluste bereits als Pläne in den Papierkorb gehörten.

Eins der absurdesten Beispiele ist das Wasserstoff-Hybrid-Speicherkraftwerk, das vor kurzem in Prenzlau in Gegenwart von Ministerpräsident Michael Platzeck eingeweiht wurde.

Überschüssiger Windstrom wird darin zur Wasserstoff-Erzeugung benutzt;

danach wird mit dem gespeicherten Wasserstoff in einem Gasmotor wieder Strom erzeugt, der bei Bedarf ins Netz zurück gespeist wird. Die Presse berichtete begeistert; Zahlen zum Speicher-Wirkungsgrad der Anlage und zu den Kosten einer so gespeicherten Kilowattstunde gab es bezeichnenderweise nicht.

Eine Nachrechnung ergibt: Die Umwandlung des Windkraft-Wechselstroms in Gleichstrom für die Druckelektrolyse beschert 10% Verluste; die Wasserstofferzeugung durch Elektrolyse verursacht 25% Verluste und der Gasmotor, der wieder Strom aus dem Wasserstoff erzeugt, hat 70% Verluste. Das ergibt einen Gesamtverlust von mindestens 80% – wertlose Abwärme. Der verbliebene kleine Rest des ohnehin nicht billigen Windstroms ist dann nach dieser „Speicherung“ fünffach teurer geworden.

Diese Anlage ist deshalb kein Stromspeicher, sondern eine teure Energievernichtungsanlage.

Derartige Pläne haben Konjunktur; es gibt offenbar in den zuständigen Ministerien keine fachliche Kontrolle mehr, die diese politisch korrekten Projekte von ihrer Förderung fernhalten könnte.

Das Problem für die Regierung, die Derartiges mit Steuergeld unterstützt, ist die Physik. Sie ist weder durch Programmpapiere, noch durch Sonntagsreden oder Einweihungszeremonien zu beeinflussen. Der einzige Effekt derartiger Projekte ist ein positives Medienecho und ein kleiner Zeitgewinn – bis zur unausweichlichen Pleite, über die aber nicht mehr berichtet wird. Das scheint die Steuergelder wert zu sein.

Eine ernsthafte und ehrliche Energie- und Umweltpolitik

hätte die physikalisch-betriebswirtschaftliche Sackgasse der Stromerzeugung aus ungeeigneten Quellen vermieden und die regenerativen Energiequellen für den Wärmemarkt erschlossen: Solarthermie und die Nutzung von Erdwärme mittels Wärmepumpen hätten eine konsequente und wirkungsvolle Förderung verdient, was niemals geschehen ist. Auch die Fernwärmenutzung aus tiefen Erdschichten – an Stelle absurd unrentabler Geothermie-Kraftwerke (siehe Kap.9) – und die ausschließliche Biogaserzeugung aus verwertbaren Abfällen und nicht aus Feldfrüchten wäre Bestandteil jener Politik. Vorhandene Windkraft dürfte in diesem Pumpspeicher-armen Lande einzig zur Wasserstofferzeugung mit anschließender Verwertung als Brennstoff oder Chemierohstoff eingesetzt werden; neue Installationen müßten gesetzlich unterbunden werden.

Die Reihe der Beispiele für eine intelligente Verbesserung der Wärmebereitstellung ließe sich noch lange fortsetzen.

Und das würde direkt die teuren fossilen Öl- und Gasimporte treffen. Eine derartige konsequente Energiepolitik könnte sich „Kaizen“ nennen – der aus der Industrie bekannte japanische Begriff für „ständige Verbesserung“. Eine „Wende“ hingegen bedeutet eine 90- bis 180-Grad-Kursänderung; diese Bezeichnung war daher korrekt. Abrupte Wenden in der Energiepolitik aber kann die Wirtschaft eines Industrielandes nicht aushalten, erst recht nicht eine Wende mit den beschriebenen Defiziten.

11. Die Geister, die man gestern rief…

Viele Jahre lang wurden die Umweltverbände von den Regierungen mit großer Sympathie behandelt und ungezählte Forderungen wurden ihnen erfüllt. Vernünftiges und auch Unsinniges geschah. Gleichzeitig bildeten sich lokale und regionale Aktionsbündnisse, die Flugplatzerweiterungen, Atomabfall-Endlager, Straßenbauprojekte, Flußbegradigungen, Abholzungen, Sendemasten des Mobilfunks und vieles andere mehr bekämpften; oft mit beachtlichem Erfolg.

Die Bürger haben daraus gelernt,

daß sie recht wirksam unliebsame Entwicklungen in ihrer Umgebung verhindern können. Genau diese Fähigkeiten setzen sie seit einiger Zeit gegen nahezu alle Projekte ein, die jetzt zu wesentlichen Teilvorhaben der Energiewende ernannt worden sind:

Eine kaum übersehbare Anzahl von Bürgerinitiativen – inzwischen von den Medien als „Wutbürger“ bezeichnet – bekämpft Windkraftanlagen:

ArGe für eine windradfreie Heimat; Volksinitiative „Gegen Windräder“ mit 26 angeschlossenen Vereinen; Windkraftgegner; Gegenwind; Windwahn; NAEB; Epaw-Europäische Plattform gegen Windkraftanlagen; Bürgerinitiative „gegenwindlärm“; Sturm im Storm; Freier Wald e.V.; IG Sturmwind; Wind gegen Wind; Sturm gegen Wind u.v.a.m.

Auch die wenigen noch geplanten Pumpspeicher-Kraftwerke sehen sich dem Widerstand der Bürger gegenüber:

- Atorf/Südschwarzwald: Der Schwarzwaldverein als Interessenvertreter der Bevölkerung hatte in den Anhörungen kritisiert, die “Region dürfe nicht bloß das Objekt für energiewirtschaftliche Ausbeutung werden.“ Der Kreisverband der B90/Die Grünen / Waldshut sprach sich gegen das Projekt aus.

- Riedl/Bayern: Das Projekt ist politisch umstritten; eine Bürgerinitiative hat sich dagegen gebildet.

- Blautal / Birkhau: Massive Bürgerproteste in Arnegg und Markbronn führten zu erheblichen Planungsänderungen – auch bezüglich des Ortes der Anlage. Zur Zeit werden Sicherheitsbedenken geltend gemacht; der Widerstand hält auch nach 6 Jahren an; ein Baubeginn ist nicht absehbar.

Eine Bürgerinitiative hat bislang erfolgreich die Errichtung einer Umrichterstation in Norddeutschland verhindert, die als deutscher Endpunkt am Seekabel nach Norwegen das Anzapfen der norwegischen Wasserkraftwerke für die Speicherung deutschen Windstroms möglich machen sollte. (Vgl. Kapitel 1 und Kapitel 9).

Massiven Widerstand gibt es bereits gegen jegliche neue Hochspannungs-Freileitungen.

Angst vor Elektrosmog, entwertete Grundstücke und verschandelte Natur führen die Bürgerinitiativen ins Feld. Das wird sich noch erheblich steigern, wenn die Pläne der Regierung zum Neubau von 3000 km Höchstspannungsleitungen von Nord- nach Süddeutschland verwirklicht werden sollen. Bisher sind davon nur 214realisiert worden. Siehe „Netz“-Kap.6.

Eine weitreichende Niederlage erlitt die Berliner Regierung mit ihrem Gesetzesvorstoß, der es ermöglichen sollte, in Kraftwerken abgetrenntes CO2 zunächst versuchsweise in ehemaligen Gasspeichern zu lagern. Der Bundesrat lehnte es ab und will auch nicht den Vermittlungsausschuß anrufen.

Grund für diese Ablehnung war die im Gesetz vorgesehene Klausel, die es jedem Bundesland ermöglicht hätte, auf seinem Territorium diese Technik zu erproben oder aber die Erprobung zu verbieten. Angesichts des sehr großen Widerstandes in den nördlichen Ländern – zahlreiche Bürgerinitiativen kämpfen dort gegen die Einlagerung des giftigen CO2 „unter ihren Füßen“ – wäre letzteres mit Sicherheit geschehen.

Bereits vor der Bundesrats-Abstimmung hatte es massive Proteste gegeben:

„Stoppt das CO2-Endlager“ stand auf ungezählten Autoaufklebern im Raum Flensburg und massenweise in friesischen Vorgärten, an der Nordseeküste in Schleswig-Holstein und Niedersachsen brannten Mahnfeuer. Die Initiatoren lehnten auch eine Speicherung vor der Küste ab, weil Experten davon ausgehen, daß sich eine CO2-Verpressung noch in 100 km Entfernung auswirken könnte.

Diese Ausstiegsklausel aber lehnte insbesondere Brandenburg ab, das in Jänschwalde den Bau einer große CCS-Pilotanlage von Vattenfall erhoffte, für deren CO2 dann aber wohl keinerlei unterirdische Speichermöglichkeit zu erwarten wäre. Vattenfall fürchtet nun, daß eine EU-Förderung wegzufallen droht.

Greenpeace zeigte sich über das Abstimmungsergebnis im Bundesrat erfreut.

Diese sog. CCS-Technik gilt nun als Voraussetzung, um in Deutschland Kohlekraftwerke auf Dauer wirtschaftlich betreiben zu können, da sonst CO2-Emissionsrechte an der Börse gekauft werden müssen. Das könnte alle Pläne zum Bau neuer Kohlekraftwerke, die die abgeschalteten Kernkraftwerke ersetzen sollen, verhindern. Damit wäre eine entscheidende Voraussetzung der sog. Energiewende entfallen.

Ob die sog. unkonventionellen Erdgasfunde (Shale-Gas; siehe Kap.13) in Europa innerhalb von 10 Jahren zu einem Sinken der Emissionsrechte-Preise und dann zu besseren Chancen für neue Kohle- und Gaskraftwerke – ohne CO2-Abtrennung – führen werden, ist ungewiss.