Bild rechts: Siehe Postscript 2 am Ende des Beitrags

Eine Woche vor Weihnachten gelangte ich in den Besitz von drei USB-Sticks mit 661 Files, zusammen etwa 1 Gigabyte Material. Sie wurden vom IPCC erstellt, einer UN-Organisation, die gegenwärtig an einem hoch profilierten Bericht arbeitet.

Mit der geplanten abschnittsweisen Veröffentlichung im September wird dieser Bericht auf Pressekonferenzen der Regierungen über die ganze Welt verbreitet werden. Funktionäre werden auf die Ergebnisse deuten und weiterhin Milliarden für Maßnahmen gegen die Klimaänderung ausgeben.

Das IPCC besteht aus drei Arbeitsgruppen. Sie untersuchen jeweils die wissenschaftlichen Beweise in Bezug zur Klimaänderung, die Auswirkung auf Mensch und Natur sowie mögliche Reaktionen.

Diese Sticks wurden an das Personal der Arbeitsgruppe 2 ausgegeben – die über die Auswirkungen des Klimawandels schreiben. Der blaue Stick trägt die Bezeichnung „Working Group II AR5 LAM1“ und bezieht sich auf das erste Treffen ihrer Leitautoren im Januar 2011 in Japan. Der goldene Stick steht im Zusammenhang mit einem zweiten Treffen fast ein Jahr später in San Franzisko. Der grüne Stick stammt von ihrem dritten Treffen vor 10 Wochen in Buenos Aires.

Das IPCC hat die Authentizität der beispielhaften Dokumente auf diesen Sticks bestätigt. Heute bin ich dabei, diese massive Datensammlung (mit Kommentaren der Begutachter), die ich „Das geheime Nikolaus-leck“ nenne, zu veröffentlichen. Einige dieser Dokumente stehen bereits online. Viele andere wären vom IPCC wohl erst in Jahren veröffentlicht worden. Noch andere hat das IPCC dauerhaft zu verstecken beabsichtigt.

Es ist sehr viel Information darin, und bislang habe ich nur einen kleinen Teil davon untersucht. Erstens enthält dieses Leck – zusammen mit demjenigen des vorigen Monats – Entwürfe des bevor stehenden IPCC-Berichtes, und zwar solche, die mehrheitlich öffentlich zugänglich gemacht werden sollen. 44 von 60 Kapiteln – 73% – stehen jetzt für eine Untersuchung zur Verfügung. Die Behauptung des IPCC-Vorsitzenden, dass das IPCC eine „absolut transparente” Organisation sei, und das alles, was das IPCC tut, „in jedem Stadium für genaueste Überprüfungen zur Verfügung steht“, ist näher an der Wahrheit als jemals zuvor.

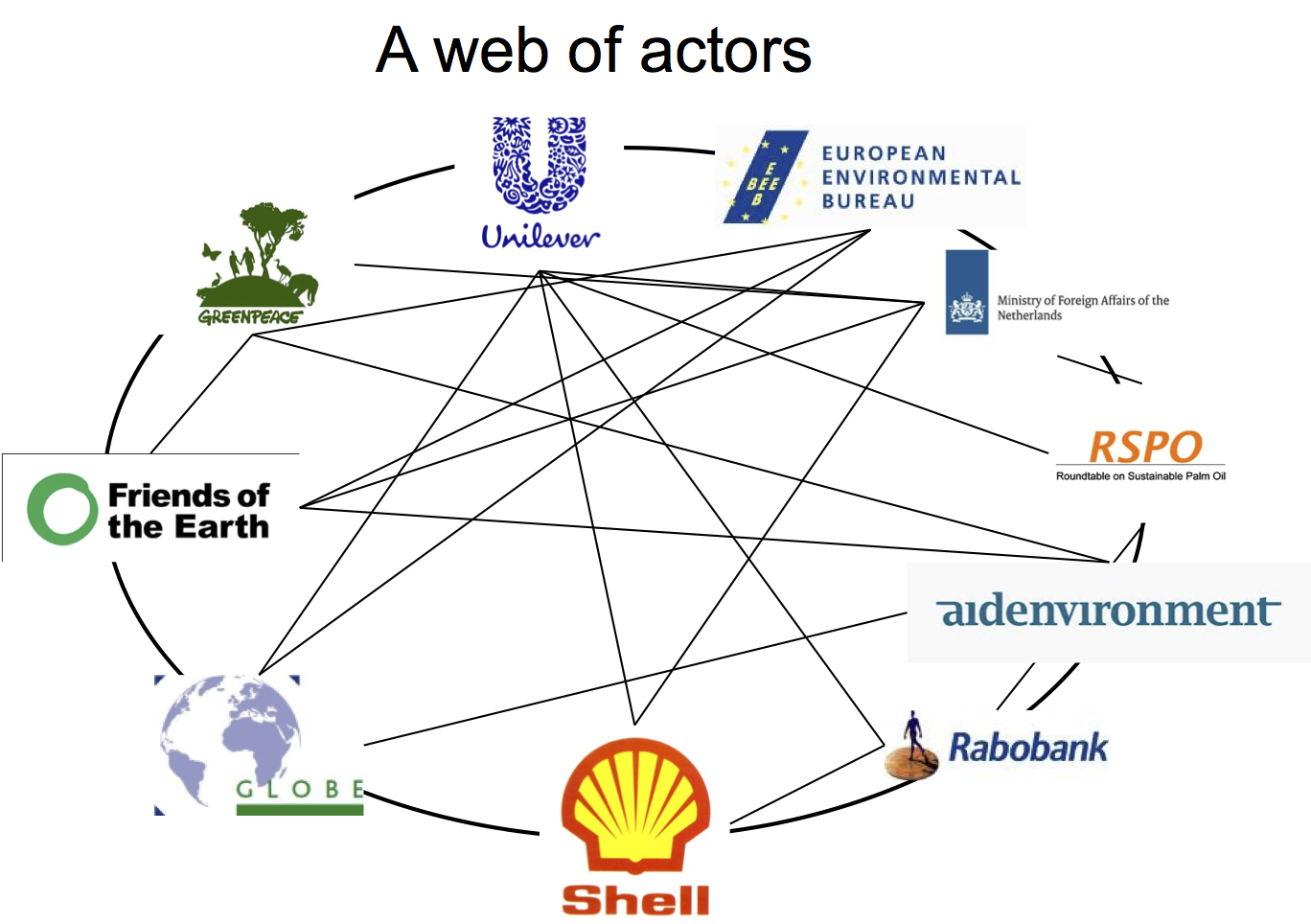

Zweitens, das IPCC hat nicht ein bisschen aus dem Skandal um die Himalaya-Gletscher gelernt. Unter dem Deckmantel „wissenschaftlicher Experten-Begutachtung“ hat es kürzlich bei seinen Autoren aggressive Lobbyarbeit hinter den Kulissen durch WWF-Beschäftigte und andere Aktivisten zugelassen. Die Entwurfs-Version der Arbeitsgruppe 2 listet in den Referenzen am Ende des Kapitels derzeit Veröffentlichungen, die von WWF und Greenpeace erstellt worden sind.

Ich habe ein .zip-File des Inhalts jedes Sticks erstellt. Am Ende dieses Artikels stehen Torrent-Info und andere Optionen zum Herunterladen.

Blue data stick zipped, 26 mb – here or here

Gold data stick zipped, 140 mb – here or here

Green data stick zipped, 675 mb – here or here

Mein 2011 erschienenes Buch The Delinquent Teenager Who Was Mistaken for the World’s Top Climate Expert [es liegt inzwischen auch auf Deutsch vor mit dem Titel „Von einem Jugendstraftäter, der mit dem besten Klimaexperten der Welt verwechselt wurde: Ein IPCC-Exposé“. A. d. Übers.] dokumentiert die zahlreichen Glaubwürdigkeitsprobleme des IPCC. Darunter ist der verstörende Einfluss grüner Aktivisten darauf, was ein rigoroser wissenschaftlicher Körper sein sollte.

Der Abschnitt der Arbeitsgruppe 2 des bevorstehenden IPCC-Berichtes enthält 30 Kapitel. Der dritte Entwurf dieser Kapitel (intern konfus als der zweite Entwurf) ist noch nicht geschrieben worden, aber zwei frühere Versionen befinden sich auf diesen Sticks. Der als erster Entwurf bekannte Abschnitt besteht aus 2465 Seiten und kann hier vollständig heruntergeladen werden oder getrennt nach Kapiteln (unten).

Als Teil der Erstellung dieses Berichtes lädt das IPCC Externe zum Feedback ein, die es als „wissenschaftliche Experten-Begutachter“ beschreibt. Die Namen dieser von der Arbeitsgruppe 2 auserwählten Personen sind hier gelistet. Deren Kommentare finden sich auf dem grünen Stick. Der Pfad lautet: Buenos Aires Documentaion>c_ExpertReviewFiles>Review Editor FOD Reports.

Die meisten dieser Kommentare scheinen konstruktiv zu sein und werden wahrscheinlich die Qualität des endgültigen Berichtes verbessern. Aber einige der Personen, die daran teilhatten, sind Aktivisten. Viele ihrer Vorschläge sind unverhohlene Versuche, aktivistisches Quellenmaterial – und aktivistische Perspektiven – in einem wissenschaftlichen Dokument unterzubringen.

Mit anderen Worten, unter dem Deckmantel „wissenschaftlicher Experten-Begutachtung“ hat das IPCC hinter den Kulissen aggressive Lobbyisten-Bemühungen gefördert.

WWF-Personal drängt das IPCC, sich auf Veröffentlichungen des WWF zu beziehen

Der letzte große IPCC-Bericht aus dem Jahr 2007 enthielt einen blamablen Fehler über die erwartete Abschmelzrate der Gletscher des Himalaya. Dieser Fehler war Anfang 2010 Gegenstand weit verbreiteter Berichterstattung in den Medien, was in vielen prominenten Zeitungen den Ruf nach dem Rücktritt des IPCC-Vorsitzenden laut werden ließ.

Es gibt nichts, das hinsichtlich des Himalaya-Debakels kompliziert wäre. Die damals verantwortlichen Autoren für das Kapitel 10 der Arbeitsgruppe 2 haben weniger alarmistische Schlussfolgerungen, die in begutachteten Fachzeitschriften veröffentlicht worden waren, missachtet und sich stattdessen entschlossen, sich auf Statements zu verlassen, die sich in der Veröffentlichung einer grünen Lobbygruppe fanden (siehe Seite 10 hier).

Die fragliche Gruppe war der WWF. In Nordamerika immer noch unter dem Originalnamen World Wildlife Fund bekannt, hat er sich anderswo umbenannt in World Wildlife Fund for Nature. Er ist wohl kaum eine kleine Anhängsel-Organisation, denn der der WWF unterhält Büros in mehr als 60 Ländern und beschäftigt 5000 Personen.

Der WWF ist die Organisation, die uns jedes Jahr im März die Earth Hour beschert. Seit vier Jahrzehnten durch Zuwendungen von der Industrie fossiler Energie gefördert (die erste Firmen-Sponsor war Shell Oil) glaubt der WWF jetzt, verarmte Nationen dazu bringen zu müssen, ihr fossiles Öl lieber in der Erde zu lassen, anstatt es zu nutzen für Licht, Wärme und Krankenhäuser für ihre Völker.

Mein Buch enthüllt, wie der WWF in der Vergangenheit den Prozess der Erstellung der IPCC-Berichte infiltriert hat. Zwei Drittel der Kapitel im Bericht 2007 wurde unter Teilnahme von mindestens einer Person erstellt, die mit dem WWF verbunden war. Ein Drittel der Kapitel wurde von einem mit dem WWF verbundenen Autor geleitet.

Weder das IPCC noch der WWF scheinen seitdem etwas über Umsicht gelernt zu haben.

Susan Evans arbeitet bei WWF Kanada. Sie hat einen Masterdiplom in Zoologie, aber viele der von ihr dem IPCC eingereichten Kommentare sind frei von wissenschaftlichen Inhalten. Zum Beispiel betrachtet sie diesen Bericht als eine Gelegenheit, „einen Sinn für Verwaltung und Verantwortung für das Ökosystem zu fördern“ (Kapitel 00/Kommentar 44).

Bei vier einzelnen Gelegenheiten rät Evans dem IPCC, ein 72 Seiten starkes Handbuch zu Rate zu ziehen, das vom Global Arctic Programme des WWF veröffentlicht worden ist (Kapitel 00/Kommentar 45, 2/727, 14/577, 15/367).

In einem anderen Fall drängt sie das IPCC dazu, ein 246 Seiten starkes WWF-Dokument mit dem Titel Buying Time in Betracht zu ziehen. Im Vorwort werden Leser dazu ermutigt, politische Aktivisten zu werden (14/406).

Bei drei Gelegenheiten hat Evans die Aufmerksamkeit des IPCC auf ein drittes WWF-Dokument gelenkt über die Pacific marine ecosystems (13/300, 26/260, 26/417). In drei weiteren Beispielen verweist sie auf einen vierten Bericht über Klimaänderung in Westkanada, bei dessen Erstellung der WWF geholfen hat (15/367, 15/370, 26/316). An anderen Stellen drängt sie das IPCC, ein fünftes WWF-Dokument zu konsultieren, und zwar eine 69-seitige Publikation über die Verwaltung der Wasserversorgung (15/455).

In einem längeren Kommentar zu Kapitel 20 lässt sich Evans über die Notwendigkeit aus, „unsere gegenwärtige Rate von Entwicklungs- und Verbrauchsverhalten signifikant zu reduzieren“. Dabei drängt sie das IPCC, den jüngsten Living Planet-Bericht des WWF zu konsultieren (20/16.1 und 16.2).

Über genau dieses Dokument habe ich unmittelbar nach dessen Veröffentlichung etwas geschrieben und darauf hingewiesen, dass die Ausdrücke Gleichheit und Ungleichheit (equality and inequality) 28 mal vorkommen. Mit anderen Worten, es handelt sich um ein politisches Traktat.

Evans Bemühungen, die WWF-Perspektiven im IPCC-Bericht unterzubringen, wurden von ihrer Kollegin Cassandra Brooke weiter vorangetrieben – laut IPCC leitet sie das WWF-Büro in der Schweiz. Eine formelle Biographie zu erhalten ist schwierig, aber laut einer solchen aus dem Jahr 2008 hält sie einen PhD in Geographie.

In ihrer Eigenschaft als Experten-Begutachterin glaubt Brooke, dass das IPCC dem gleichen Arktis-Handbuch Aufmerksamkeit schenken sollte, dass schon Evans zu vier Gelegenheiten empfohlen hatte (4/943).

Sie drängt die IPCC-Wissenschaftler, ihre Informationen über Mangroven und Klimaänderung von einer WWF-Website zu beziehen, und ist enttäuscht darüber, dass der IPCC-Bericht „nicht erkennt, dass kulturelle und spirituelle Werte eine Form des Ökosystem-Service“ sind (4/1011, 5/1204).

Aber es sind ihre Bemerkungen über das Aussterben bestimmter Spezies, die besonders entlarvend sind. Kapitel 19 ist ein Synthese-Kapitel. Sein Ziel ist es, die Ergebnisse der anderen 29 Kapitel der Arbeitsgruppe 2 zusammenzufassen. Der Job jener Autoren ist es also folglich, akkurat zu reflektieren, was anderswo geschrieben worden ist.

Brooke macht es in ihrem Kommentaren zu Kapitel 19 umgekehrt. Sie beobachtet, dass die Sprache in Kapitel 4 „sehr vage“ und „inkonsistent im Tonfall“ mit dem ist, was Kapitel 19 sagt. Ganz klar, sie glaubt, dass die Wortwahl in Kapitel 4 eher verschärft werden sollte als der abgeschwächte Tonfall in der Zusammenfassung.

Brooke ist bekümmert, weil Kapitel 4 „sich selbst von starken Statements distanziert“ hinsichtlich Klimaänderung und dem Aussterben von Spezies, was im IPCC-Bericht aus dem Jahr 2007 erschienen ist (4/664, 19/428). Aber dieser Rückzug ist eine gute Nachricht. Wie ich schon anderswo diskutiert habe, verlässt sich das IPCC auf eine einzige Studie, die bereits von anderen Wissenschaftlern verurteilt worden ist [demolished]. (Ein berühmter Biologe nannte sie „die schlimmste Studie, die ich je in einem wissenschaftlichen Magazin gesehen habe“). Das IPCC hat diese heftigen Zurückweisungen nicht nur nicht beachtet, sondern es sogar abgelehnt, die Leser davon in Kenntnis zu setzen, dass sie überhaupt existieren.

Man würde erwarten, dass wissenschaftliche Experten-Begutachter erfreut sein würden, dass sich das IPCC jetzt verantwortlicher verhält. Man würde erwarten, dass sie dem IPCC ob dessen Hinwendung zu mehr soliden Beweisen applaudieren würden.

Aber Brooke ist keine wirkliche Experten-Begutachterin. Sie ist Mitarbeiterin des WWF. Und das WWF mag Übertreibungen. Wie er auf seiner Haupt-Website erklärt: „Es ist fast unmöglich, die Bedrohung durch den Klimawandel zu überschätzen“.

Andere Aktivisten als „Experten-Begutachter“

Unter den anderen Organisationen, die versuchen, den wissenschaftlichen IPCC-Bericht via Experten-Begutachtung zu beeinflussen, finden wir die Alliance of Small Island States. Deren Website bekennt freimütig, dass es sich dabei um „eine ad-hoc-Lobby handelt und es eine Verhandlungs-Stimme sei“ für bestimmte politische Interessen. Hier sind noch ein paar andere:

Angela Andrade, eine bei Conservation International beschäftigte Anthropologin, drängt IPCC-Wissenschaftler gleich zweimal, ein von einem Dutzend Aktivistengruppen gemeinsam veröffentlichtes Diskussionspapier zu konsultieren (15/172, 16/120).

Bei zwei anderen Gelegenheiten weist sie sie auf ein Dokument mit dem Titel Building Resilience to Climate Change hin [etwa: Resistenzbildung gegen Klimawandel] (15/430, 16/123). Dieses war von der International Union for Conservation of Nature veröffentlicht worden, deren Website von „einer gerechten Welt“ spricht.

Aber Gerechtigkeit ist ein politisches Konzept. Vernünftige Leute stimmen nicht damit überein, wie Gerechtigkeit aussieht. Ist eine grüne Gruppe, die sich Gerechtigkeit auf die Fahnen geschrieben hat, eine verlässliche Informationsquelle? Das IPCC glaubt das offenbar. Der jetzige Entwurf der Arbeitsgruppe 2 erwähnt schon jetzt die Building Resilience-Veröffentlichung in den Kapiteln 5 und 9 (siehe Seiten 379, 402 und 813 des 2465-seitigen Entwurfs).

Ganz ähnlich macht sich die Aktivistengruppe Germanwatch Sorgen über die „globale Gleichheit“ und vertritt bevorzugt gewisse politische und ökonomische Gedanken. Sven Harmeling, der bei ihnen als Teamlader Klimapolitik fungiert, hat die IPCC-Autoren zweimal gedrängt, ein Diskussionspapier von WWF-Germanwatch zu Rate zu ziehen (14/555, 15/224).

Anderswo lenkt er die Aufmerksamkeit des IPCC auf ein zweites, zusammen mit dem WWF veröffentlichtes Dokument mit dem Titel Institutions for Adaptation (15/418). Um alles komplett zu machen, verweist er auf ein drittes Dokument, diesmal ein kurzes Informationspapier von seinem Arbeitgeber und zwei weiteren Organisationen (15/343).

Noch ein weiteres Beispiel ist das International Rivers-Netzwerk. Die Leute, die dort arbeiten, sehen sich selbst als „das Herz der globalen Anstrengungen, Flüsse zu schützen“. Eine Beschäftigte von ihnen, Katy Yan, beschreibt sich selbst auf Twitter als eine „Klima-Kämpferin“. Sie ist ebenfalls eine Experten-Begutachterin des IPCC.

Ähnlich wie die zuvor erwähnten Individuen glaubt Yan, dass die Veröffentlichungen ihrer eigenen Organisation es verdienen, in einem wissenschaftlichen Bericht erwähnt zu werden. Sie verlangt dies zweimal von einem Dokument mit dem Titel Before the Deluge [etwa: Vor der Sintflut]. Es wurde geschrieben vom geschäftsführenden Direktor von International Rivers – mit anderen Worten, von ihrem Chef (3/752, 3/766).

Zusätzlich verlangt Yan nach zwei Nachrichten–Berichten, die auf der Website ihrer Organisation veröffentlicht worden sind, eine Online-Bibliographie von „wissenschaftlichen Schlüssel-Artikeln“, die von ihren Mit-Aktivisten ausgewählt worden sind, nämlich ein 90-seitiger Bericht über alternative Energie in Guatemala sowie zwei andere Dokumente über erneuerbare Energie in Chile. All dieses Material wurde von der Organisation erzeugt (3/869, 3/891, 27/339, 27/345).

Alles das ist also von Aktivisten erstellte graue Literatur – genau die Art von Geschehnissen, die den Kummer des IPCC in der Vergangenheit verursacht haben.

Was denkt das IPCC? Warum rollt es den roten Teppich für Aktivisten aus und erlaubt ihnen, direkt auf die IPCC-Autoren Einfluss zu nehmen?

Das ist nicht geeignet, ein weiteres Himalaya-Debakel zu vermeiden.

Literatur vom WWF und von Greenpeace

Schon vor dieser Lobbyisten-Parade listete der Entwurf der Arbeitsgruppe 2 schon die folgenden neun WWF- und zwei Greenpeace-Veröffentlichungen unter den Referenzen am Ende des Kapitels. (Die Seitenzahlen in Klammern beziehen sich auf diesen 2465-seitigen Entwurf):

- IUCN 2008: Ecosystem-based adaptation: An approach for building resilience and reducing risk for local communities and ecosystems. A submission by IUCN, The Nature Conservancy, WWF, Conservation International, BirdLife International, Indigenous Peoples of Africa Co-ordinating Committee, Practical Action, WILD Foundation, Wildlife Conservation Society, Fauna and Flora International and Wetlands International. Gland, Switzerland: IUNC. [p. 371]

- Fish, M.R. and C. Drews, 2009: Adaptation to Climate Change: Options for Marine Turtles. WWF. San Jose, CA, USA, 20 pp. [p. 514]

- Fish, M.R., A. Lombana and C. Drews, 2009: Climate Change and Marine Turtles in the Wider Caribbean: Regional Climate Projections. WWF, San Jose, CA, USA, 20 pp. [p. 514]

- Kollmuss, A., H. Zink, and C. Polycarp, 2008: Making sense of the voluntary carbon market: A comparison of carbon offset standards. WWF Germany. [p. 1067]

- Harmeling, S., S. Kreft, and S.C. Rai (2011) Institutions for adaptation: Towards an effective multi-level interplay. Germanwatch and WWF International, available at http://www.germanwatch.org/klima/ad-inst.htm [p. 1726]

- Sattler, P., M. Taylor, 2008: Building Australia’s Safety Net 2008: Progress on the directions for the National Reserve System. WWF-Australia, Sydney. [p. 2007; actual title is Building Nature’s Safety Net]

- Allianz and WWF, 2006: Climate Change and Insurance: An Agenda for Action in the United States, Allianz and WWF. [p. 2071]

- Constable, A.J. and S. Doust, 2009: Southern ocean sentinel – an international program to assess climate change impacts on marine ecosystems: Report of an international workshop, Hobart, April 2009. ACE CRC, Commonwealth of Australia & WWF-Australia, pp. 81. [p. 2287]

- Experts Workshop on Bioregionalisation of the Southern Ocean (September 2006: Hobart), S. Grant Antarctic Climate, Ecosystems Cooperative Research Centre, WWF-Australia, Peregrin, S. Grant, A. Constable, B. Raymond, and S. Doust, 2006: Bioregionalisation of the southern ocean: Report of the experts workshop (Hobart, September 2006), [report prepared by: Susie grant … [et al.]] Sydney: WWF-Australia Head Office. [pp. 2289-90]

- Richter, C., S. Teske, and R. Short, 2009: Concentrating solar power: global outlook 2009. SolarPaces, Greenpeace and ESTELA. [p. 879]

- Anisimov, O.A., M.A. Belolutskaya, M.N. Grigor’ev, A. Instanes, V.A. Kokorev, N.G. Oberman, S.A. Reneva, Y.G. Strelchenko, D. Streletsky, and N.I. Shiklomanov, 2010: Assessment Report: The Main Natural and Socioeconomic Consequences of Climate change in Permafrost Areas: A forecast Based upon a Synthesis of Observations and Modelling. Greenpeace, Russia. 40 pp. [p. 1892]

Wenn die den wissenschaftlichen IPCC-Bericht schreibenden Wissenschaftler keine Argumentationskette aufbauen können, ohne sich auf Aktivisten-Literatur zu beziehen, sollten sie diese Argumentation schon von Anfang an gar nicht übernehmen. Sollte man denken.

Deshalb handelt es sich hier um eine Organisation, die nicht ein bisschen aus seiner Erfahrung mit den Himalaya-Gletschern gelernt hat.

Das IPCC & Vertraulichkeit

Alle drei Daten-Sticks enthalten eine Kopie eines IPCC-Dokuments zur Vertraulichkeit (hier auch im Netz zugänglich). Obwohl es mit einer feierlichen Beteuerung beginnt, dass das „IPCC Vorbild für Offenheit“ ist, macht der Rest des Textes klar, dass diese Organisation das gleiche Verhältnis zu Transparenz hat wie Vampire zum Sonnenlicht.

Das IPCC sagt, dass Geheimniskrämerei zu einem „Produkt höchster Qualität“ führt. Es sagt, dass Beratungen hinter verschlossenen Türen einem effektiven Prozess gleichen. Es sagt, dass das IPCC von Vertraulichkeit abhängig ist, während der Bericht geschrieben wird.

Dies ist auf törichte Weise kurzsichtig. Das IPCC muss offen und ehrlich über jeden einzelnen Schritt Auskunft geben, mit denen es zu seinen Schlussfolgerungen kommt. Das Letzte, mit dem man gebildete Leute im 21. Jahrhundert überzeugen kann, ist eine Gruppe von Schatten-Experten, die uns lächelnd sagen, dass wir ihnen vertrauen sollen.

Geheimniskrämerei hat nichts mit Wissenschaft zu tun. Sie wird allerdings von jenen bewertet, die darauf brennen, die Botschaft zu durchleuchten. Geheimniskrämerei erlaubt es dem IPCC, seine Berichte konzertiert zu veröffentlichen, um große Medien-Fanfaren hervorzurufen. Sie erlaubt auch das Durchsickern weiterer Ausgaben an wohlwollende Journalisten.

Angesichts der Tatsache, dass eine Untersuchung „in jedem Schritt des Erstellungsprozesses signifikante Schwächen ans Licht gebracht hat“, ist es jetzt an der Zeit, Licht auf diese Organisation zu werfen.

Die Öffentlichkeit hat ein Recht darauf, jedes jemals von dieser UN-Organisation erstellte Papier genau zu untersuchen. Dies ist nicht nur in der Gegenwart wichtig, sondern auch für Wissenschaftler späterer Zeiten.

Wenn bei Lobbygruppen beschäftigte Aktivisten Entwürfe dieses Berichtes lesen können, kann die Öffentlichkeit das auch. Wir haben auch ein Recht darauf zu erfahren, und zwar in so kurzer Zeit wie möglich, welche Art Rückmeldungen diese Entwürfe erhalten – und zu beurteilen, wie gut oder schlecht das IPCC darauf reagiert.

Das Vertraulichkeits-Dokument enthält diese pathetische Feststellung:

Der Erstellungs-Prozess kann nicht effektiv sein, wenn während der Vorbereitung (des jetzigen Berichtes) Material der Entwürfe bekannt oder öffentlich diskutiert wird.

Aber das IPCC glaubt das nicht wirklich, und zwar aus folgenden Gründen:

Mitte Dezember sind Entwürfe der 14 Kapitel durchgesickert, die den Teil der Arbeitsgruppe 1 im kommenden IPCC-Bericht umfassen. Diese geheimen Nikolaus-Datensticks enthalten Entwürfe von weiteren 30 Kapiteln.

Dies bedeutet, dass inzwischen Entwürfe einer Mehrheit von Kapiteln im kommenden Bericht (44 von 60, oder 73%) in öffentlichem Besitz sind.

Wenn das Vertraulichkeits-Dokument das Papier wert ist, auf dem es geschrieben steht, müsste das IPCC die Arbeit an dem bevorstehenden Bericht sofort suspendieren. Es wird ankündigen, dass die extensive Natur dieser Lecks es unmöglicht macht weiterzuarbeiten.

Aber das Handtuch zu werfen ist das Letzte, was ich von dieser Bürokratie erwarte.

Postscripts:

1. Wir wissen noch nicht, wie viele mit dem WWF verbundene Leute gegenwärtig an diesem IPCC-Bericht arbeiten, weil die Namen aller beitragenden Autoren noch nicht bekannt gemacht worden sind. Aber wir wissen, dass Jennifer Morgan involviert ist, die sonst die Klima-Chef-Sprecherin beim WWF ist.

2. Eine hoch aufgelöste Version des Bildes oben rechts befindet sich hier. Medien und Blogger können alle Versionen dieses Bildes frei verwenden. Photo: Donna Laframboise

3. Falls irgendjemand die technischen Fähigkeiten hat, dass geheime Nikolaus-Leck zugänglich zu machen, wäre das wunderbar.

4. Die Personen der Arbeitsgruppen 1 und 2 werden hiermit herzlich eingeladen, dabei zu helfen, die Öffentlichkeit darüber zu informieren, was hinter verschlossenen Türen vor sich geht. Kontaktinfo hier.

5. Dieser Blog verfügt nicht über ein regelmäßiges Trinkgeld-Konto. … Wenn Sie glauben, dass es wichtig ist, wenn Journalisten das IPCC durchleuchten, bitte überlegen Sie sich eine kleine Spende.

2. Teil: Sind ein Drittel der IPCC-Begutachter MIA?

[MIA = Missing in Action]

Die Begutachter des IPCC sollten im September einen Bericht anfertigen. Ein Drittel von ihnen hat sich offensichtlich gar nicht damit befasst.

Das IPCC arbeitet derzeit an einem Bericht, der so wichtig ist, dass er als Klimabibel bekannt ist. Der IPCC-Vorsitzende Rajendra Pachauri hat immer behauptet, dass der Prozess, mit dem seine Organisation diese Berichte schreibt, ein offenes Buch sei.

In einem Interview für eine Zeitschrift im Jahr 2009 hätte er nicht deutlicher sein können: „Was immer wir tun, steht immer und bei jedem Schritt für eine genaue Untersuchung zur Verfügung“.

Aber ein Dokument unter den über 600 Files in der öffentlichen Domäne als Ergebnis des geheimen Nikolaus-Lecks erzählt eine andere Geschichte. Tatsächlich wird darin gewissen Mitarbeitern des IPCC versichert, dass manche Berichte, die sie schreiben, niemals ans Tageslicht kommen werden:

Alle diese Berichte sind nur für interne Zwecke bestimmt und werden nicht veröffentlicht… Den IPCC-Regeln und Prozeduren zufolge bekommen nur (Experten-Begutachter) und den Autoren Verantwortliche diese Berichte zu Gesicht (siehe hier).

Die fraglichen Berichte können auf dem grünen Stick gefunden werden. Der Pfad ist: Buenos Aires Documentaion>c_ExpertReviewFiles>Review Editor FOD Reports. Es ist unklar, warum das IPCC beabsichtigt hatte, sie für immer unter den Teppich zu kehren. Aufzeichnungen von US-Präsidenten beispielsweise werden der Öffentlichkeit 5 bis 12 Jahre nach dem Ende der Administration bekannt gemacht.

Die wichtigste Nachricht ist jedoch, dass ein Drittel des IPCC-Personals, das aufgefordert wurde, solche Berichte zu schreiben, dies offenbar nicht getan hat.

Das geheime Nikolaus-Leck berührt den Abschnitt der Arbeitsgruppe 2 des bevorstehenden IPCC-Berichtes. Jedes der 30 Kapitel hat eine Gruppe von Autoren, plus zwei oder drei Leute, die als Begutachtungs-Herausgeber [Review Editors, RE] fungieren.

Die Aufgabe der REs ist es sicherzustellen, dass Rückmeldungen von externen Begutachtern von den IPCC-Autoren beachtet und nicht missachtet werden. Ein RE muss nicht unbedingt gut Freund mit dem Autorenteam sein. Er oder sie sollte ein Vorgesetzter sein.

Die Rolle der REs ist einer der wenigen Übersichts-Mechanismen innerhalb des IPCC-Prozesses. Wenn ein Drittel der Übersichtler Missing in Action ist, dann ist irgendetwas ganz furchtbar schief gelaufen.

Das gleiche Dokument, in dem den REs die Geheimhaltung versichert wird, sagt ihnen auch, dass erwartet wird, dass sie ihren ersten Interimsbericht bis zum 24. September 2012 einreichen. Ihnen wird geraten, einen zweiseitigen Beispielbericht zu konsultieren. Und ihnen wird gesagt, dass es Ok für die REs ist, ein gemeinsames Dokument einzureichen, wenn sie am gleichen Kapitel arbeiten.

Von insgesamt 66 REs haben 29 Berichte selbst eingereicht, 16 einen gemeinsamen Bericht, und 21 scheinen überhaupt keinen Bericht geschrieben zu haben.

Diese Berichte waren dazu ausersehen, die „wesentlichen Sorgenbereiche“ zu beleuchten sowie „umstrittene und kontroverse Angelegenheiten“ zu identifizieren, und zwar vor einem Treffen der Leitautoren, das einen Monat später geplant war. Aber die Autoren mancher Kapitel waren offenbar mit ihren Werken allein gelassen worden.

In Kapitel 3 geht es um Frischwasser-Reserven. 950 einzelne Kommentare waren von Begutachtern eingereicht worden. Aber Berichte von REs dieses Kapitels befinden sich nicht auf dem Daten-Stick. Es scheint, dass weder Pavel Kabat (der beim IPCC die Niederlande repräsentiert) noch Zbigniew Kundzewicz (der polnische Vertreter) ihrer Pflicht nachgekommen sind.

In Kapitel 5, in dem es um Küstengebiete und tief liegende Gebiete geht, ist es ähnlich. Das IPCC hat fast 1400 Kommentare zum Entwurf dieses Kapitels erhalten. Aber weder Robert Nicholls (UK) noch Filipe Santos (Portugal) scheinen ihren Kapitel-Autoren irgendeinen Bericht abgeliefert zu haben.

Die Berichte folgender REs fehlen auch noch:

- Omar-Dario Cardona (Columbia), Chapter 8: Urban Areas

- Habib Amamou (Tunisia), Chapter 9: Rural Areas

- Amjad Abdulla (Maldives), Chapter 10: Key Economic Sectors and Services

- He Xu (China), Chapter 10: Key Economic Sectors and Services

- Ulisses Confalonieri (Brazil), Chapter 11: Human Health

- Rita Sharma (India), Chapter 13: Livelihoods and Poverty

- Richard Moss (USA), Chapter 15: Adaptation Planning and Implementation

- James Thurlow (South Africa), Chapter 16: Adaptation Opportunities, Constraints, and Limits

- Ana Iglesias (Spain), Chapter 17: Economics of Adaptation

- Stale Navrud (Norway), Chapter 17: Economics of Adaptation

- Rik Leemans (The Netherlands), Chapter 18: Detection and Attribution of Observed Impacts

- Tom Downing (UK), Chapter 21: Regional Context

- Joan O. Grimalt (Spain), Chapter 23: Europe

- Kazuhiko Takeuchi (Japan), Chapter 24: Asia

- Leonidas Osvaldo Girardin (Argentina), Chapter 27: Central and South America

- Maria Ananicheva (Russian Federation), Chapter 28: Polar Regions

- Omar Ly (Senegal), Chapter 30: Open Oceans

Mit anderen Worten, nur 13 von 30 Kapiteln erhalten die Überwachung, die sie erhalten sollten.

Ob die REs ihren Pflichten nachkommen oder nicht ist kein neues Problem. Ich habe schon früher von einem herbei phantasierten IPCC-RE namens Bubu Jallow berichtet. Er repräsentierte Gambia während der Erstellung des letzten IPCC-Berichtes 2007.

Im November 2006 setzte Jallow seinen Namen unter ein bemerkenswertes Statement. „Ich kann bestätigen“, sagt er, dass das gesamte Feedback an die Autoren von Kapitel 3 „geeignete Beachtung geschenkt worden ist… in Übereinstimmung mit den IPCC-Prozeduren“.

Aber Jallow hatte gar keine Kenntnis von diesem Vorgang aus erster Hand. Einer der Leiter des Kapitels, Kevin Trenberth, machte dies unmissverständlich klar, als er in einer e-mail an IPCC-Funktionäre geschrieben hat:

Ich schreibe dies, um gegen die Nennung von Bubu Pateh Jallow als Review Editor unseres Kapitels zu protestieren. Er spielte keine wie auch immer geartete Rolle in unserem Kapitel. Er nahm an keinem Treffen teil, er hat keine E-Mail beantwortet und sollte NICHT aufgeführt werden (Hervorhebung hinzugefügt).

Das IPCC hat beschlossen, dass Jallow offiziell ohnehin ein Review Editor war. Sein Name findet sich am Ende der Seite der Online-Version von Kapitel 3 der Arbeitsgruppe 1 im Bericht von 2007. Sechs Jahre später wird der Öffentlichkeit immer noch weisgemacht, dass drei Review Editoren in diesem Beispiel verpflichtet worden waren.

Warum ist das so? Das IPCC ist eine UN-Organisation. Daher kümmert es sich intensiv um Dinge wie Diversität und regionale Präsenz. Die anderen beiden REs stammen aus UK und den USA – entwickelten Ländern. Jallows Name lässt das Kapitel mehr multi-regional und multikulturell erscheinen.

Es scheint, dass es den IPCC-Funktionären weitgehend egal ist, ob die REs ihrer Pflicht nachkommen oder nicht.

Postcripts:

1. Eine Untersuchung im Jahr 2010 im IPCC, durchgeführt vom InterAcademy Council-Komitee, kam zu der Schlussfolgerung, dass die REs eigentlich keine formelle Autorität haben. Wie es auf Seite 3 oben heißt: „Die Leitautoren haben das letzte Wort zum Inhalt ihres Kapitels“ – egal was ein RE dabei fühlen könnte. Mit anderen Worten, REs sind ein schwacher Begutachtungs-Mechanismus. Aber selbst dieser Mechanismus scheint bei den meisten Kapiteln der Arbeitsgruppe 2 nicht voll zu funktionieren.

2. Das Statement von Jallow ebenso wie die E-Mail von Trenberth sind Teil eines 7 mb .zip-files, der mir im November 2011 von David Holland zugesandt worden ist. Seinen Worten zufolge enthält der File Material, das von David Hoskins, einem weiteren RE zum Jallow-Kapitel, „nach Klimagate auf Druck vom Information Commissioner von UK“ veröffentlicht worden ist. Es kann hier oder hier heruntergeladen werden.

3. Bubu Jallow arbeitet jetzt bei den UN.

Donna Laframboise is a Canadian investigative journalist. She is the author of The Delinquent Teenager Who Was Mistaken for the World’s Top Climate Expert, an IPCC exposé. Recently translated into German, it is available in a variety of formats. Donna can be reached at NOconsensus.org AT gmail.com.

[Hervorhebung durch Fettdruck durch den Übersetzer im Original! Es ist schön, dass Donna selbst auf die Übersetzung ins Deutsche hinweist! A. d. Übers.]

http://nofrakkingconsensus.com/2013/01/08/the-secret-santa-leak/

Übersetzt von Chris Frey EIKE

Es folgen DOWNLOAD OPTIONS

Blue data stick zipped, 26 mb – here or here

Gold data stick zipped, 140 mb – here or here

Green data stick zipped, 675 mb – here or here

Blue torrent: magnet:?xt=urn:btih:FE53DEE7870921017E63678647B78281F56F45A2&dn=blue.zip&tr=udp%3a%2f%2ftracker.openbittorrent.com%3a80%2fannounce&tr=udp%3a%2f%2ftracker.publicbt.com%3a80%2fannounce&tr=udp%3a%2f%2ffr33domtracker.h33t.com%3a3310%2fannounce

Gold torrent: magnet:?xt=urn:btih:A30CCD2FFEF70C354073D082938894B122870888&dn=gold.zip&tr=udp%3a%2f%2ffr33domtracker.h33t.com%3a3310%2fannounce&tr=udp%3a%2f%2ftracker.openbittorrent.com%3a80%2fannounce&tr=udp%3a%2f%2ftracker.publicbt.com%3a80%2fannounce

Green torrent: magnet:?xt=urn:btih:35BCE4E514069B62D39CFECD26F799E7C36BDA84&dn=green.zip&tr=udp%3a%2f%2ftracker.openbittorrent.com%3a80%2fannounce&tr=udp%3a%2f%2ftracker.publicbt.com%3a80%2fannounce&tr=udp%3a%2f%2ffr33domtracker.h33t.com%3a3310%2fannounce

First Order Draft torrent: magnet:?xt=urn:btih:FEABA896B40807B21E34138183CFE28C2962B248&dn=WGIIAR5_FODall.zip&tr=udp%3a%2f%2ftracker.openbittorrent.com%3a80%2fannounce&tr=udp%3a%2f%2ftracker.publicbt.com%3a80%2fannounce&tr=udp%3a%2f%2ffr33domtracker.h33t.com%3a3310%2fannounce

please leave your client open for a few hours to help speed up other downloads

First Order Draft, 2,465 pages – 125 mb here or here

Chapter 1: Point of Departure – here or here

Chapter 2: Foundations for Decisionmaking – here or here

Chapter 3: Freshwater Resources – here or here

Chapter 4: Terrestrial and Inland Water Systems – here or here

Chapter 5: Coastal Systems and Low-lying Areas – here or here

Chapter 6: Ocean Systems – here or here

Chapter 7: Food Production Systems and Food Security – here or here

Chapter 8: Urban Areas – here or here

Chapter 9: Rural Areas – here or here

Chapter 10: Key Economic Sectors and Services – here or here

Chapter 11: Human Health – here or here

Chapter 12: Human Society – here or here

Chapter 13: Livelihoods and Poverty – here or here

Chapter 14: Adaptation: Needs and Options – here or here

Chapter 15 – Adaptation Planning and Implementation – here or here

Chapter 16: Adaptation Opportunities, Constrains, and Limits – here or here

Chapter 17: Economics of Adaptation – here or here

Chapter 18: Detection and Attribution of Observed Impacts – here or here

Chapter 19: Emergent Risks and Key Vulnerabilities – here or here

Chapter 20: Climate-resilient Pathways: Adaption, Mitigation, and Sustainable Development – here or here

Chapter 21: Regional Context – here or here

Chapter 22: Africa – here or here

Chapter 23: Europe – here or here

Chapter 24: Asia – here or here

Chapter 25: Australasia – here or here

Chapter 26: North America – here or here

Chapter 27: Central and South America – here or here

Chapter 28: Polar Regions – here or here

Chapter 29: Small Islands – here or here

Chapter 30: Open Oceans – here or here

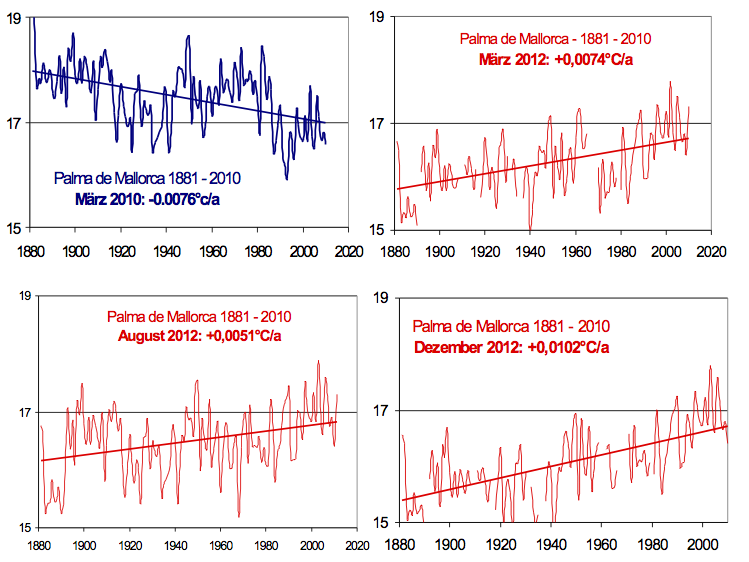

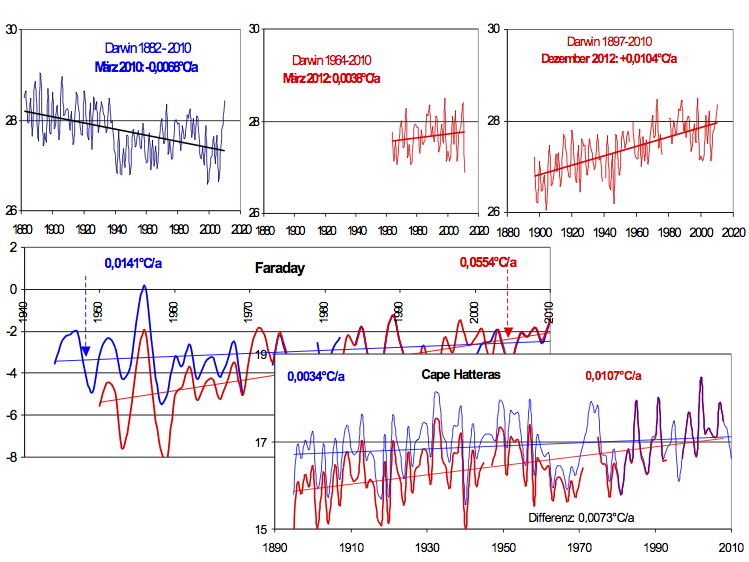

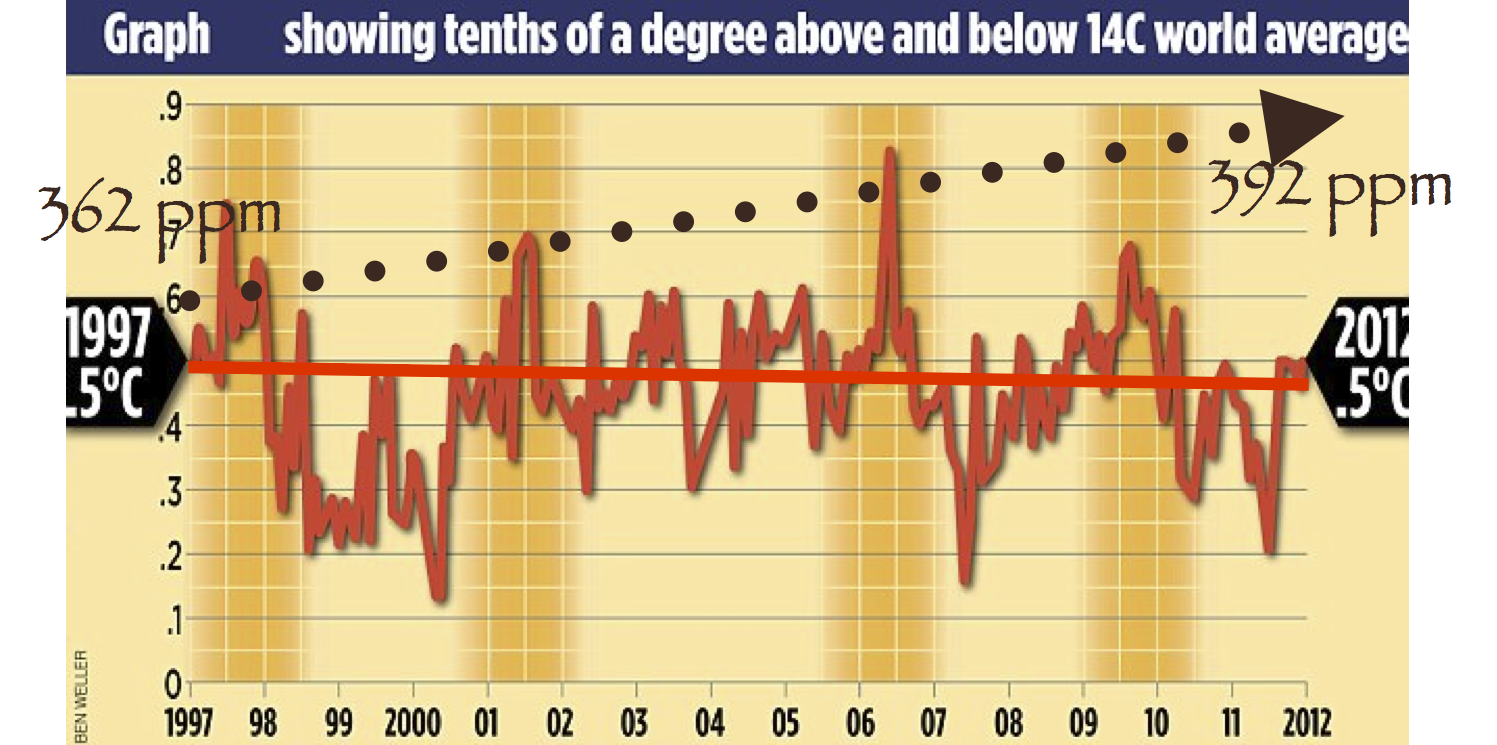

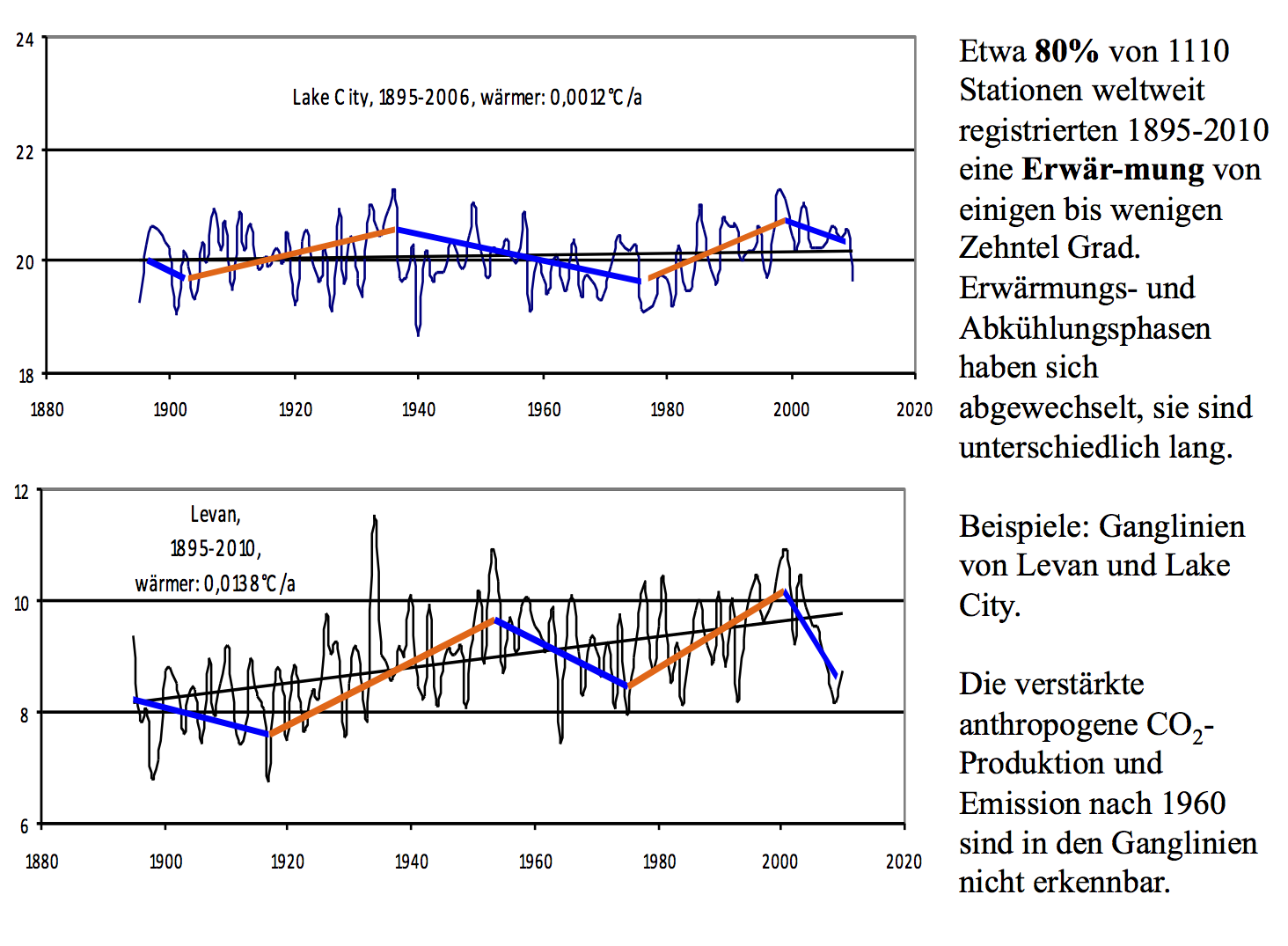

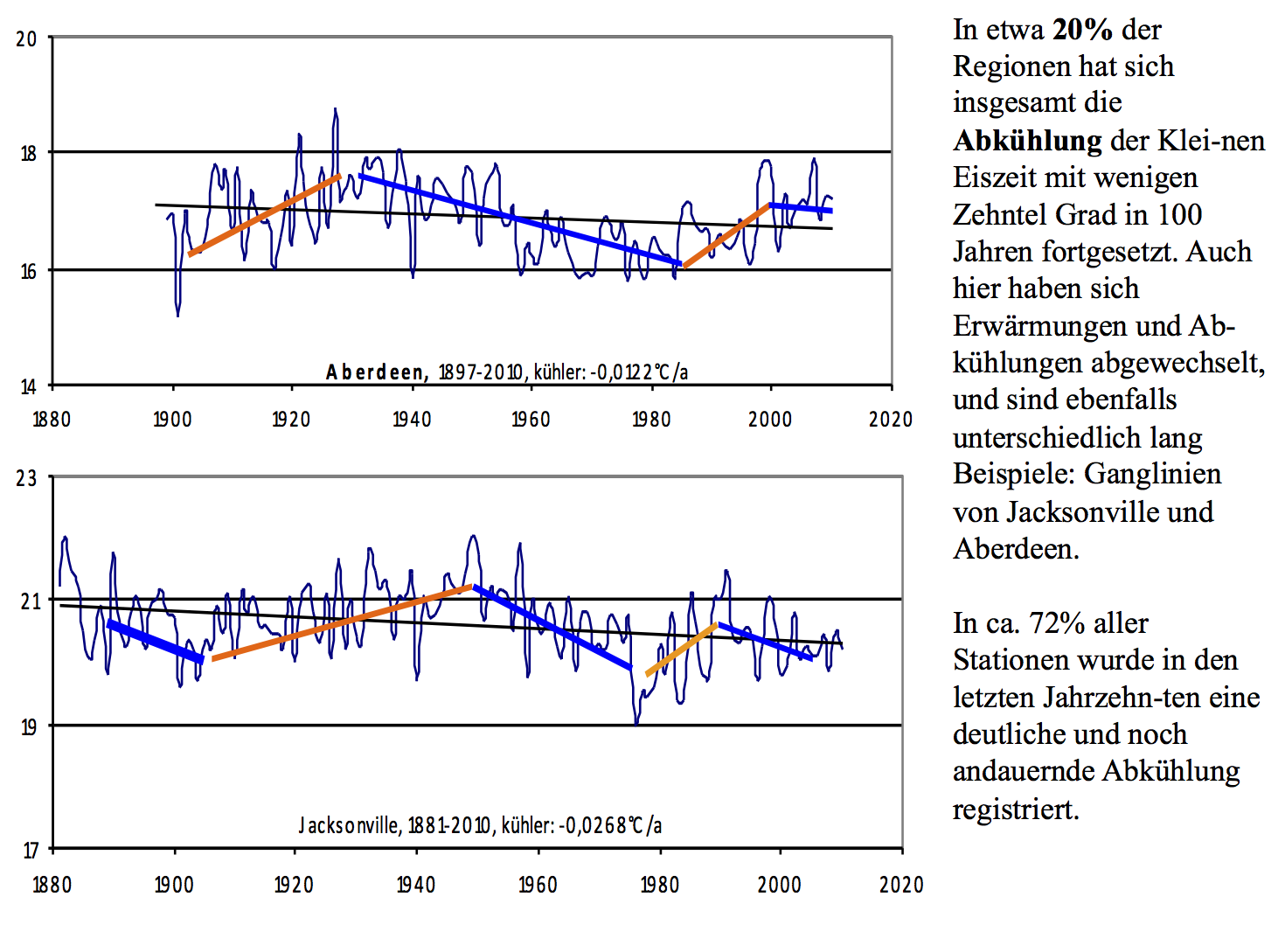

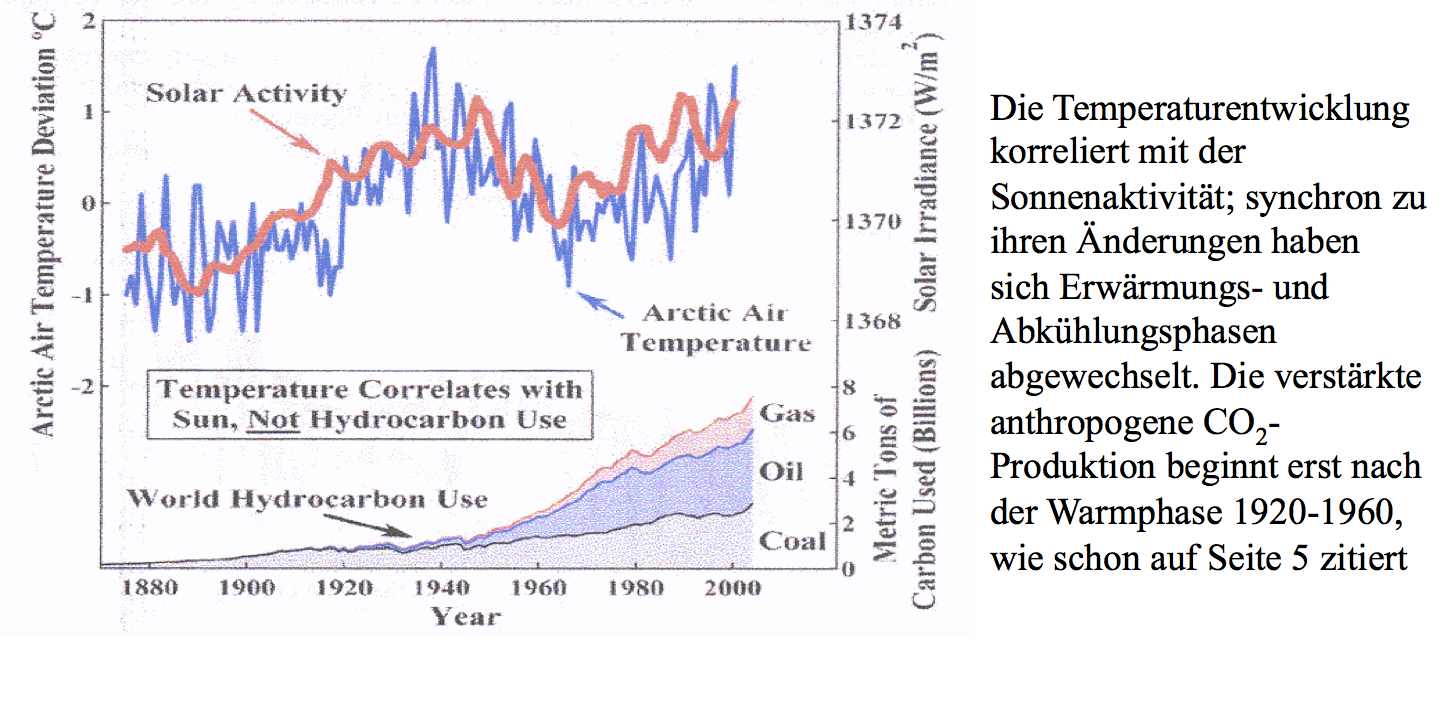

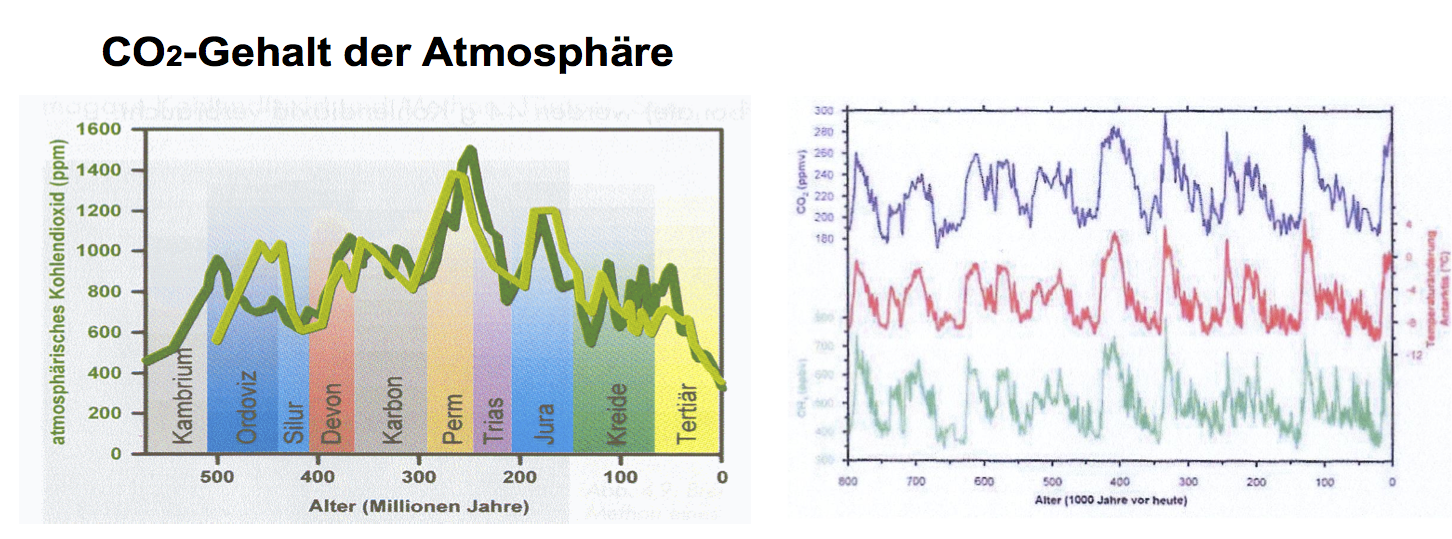

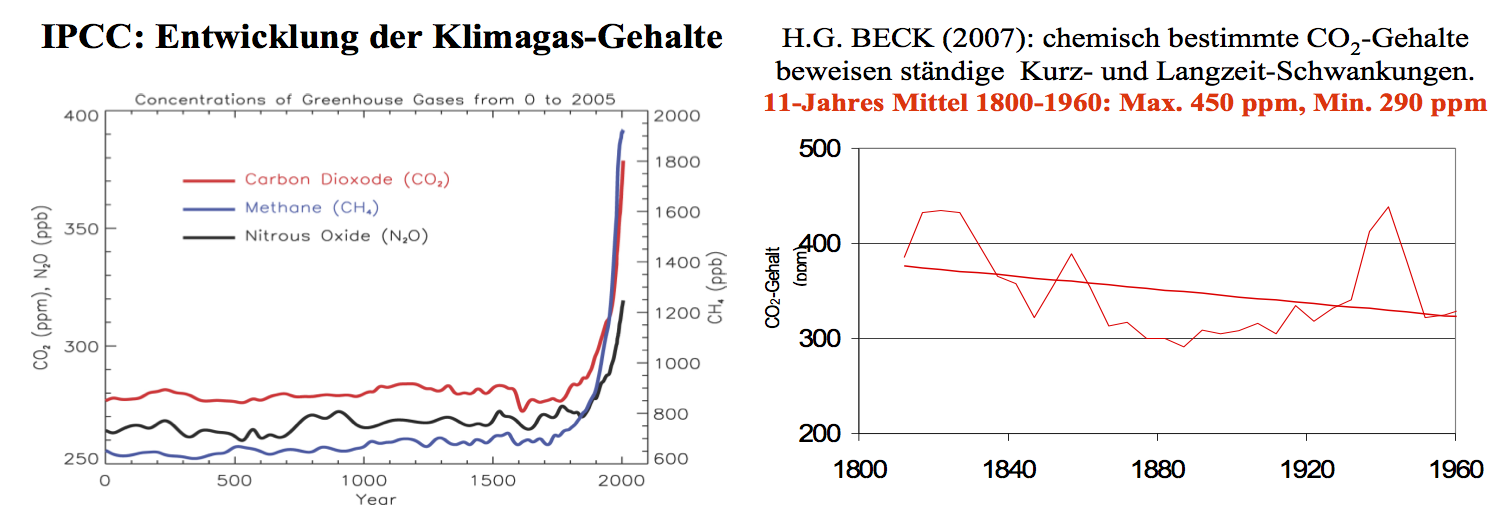

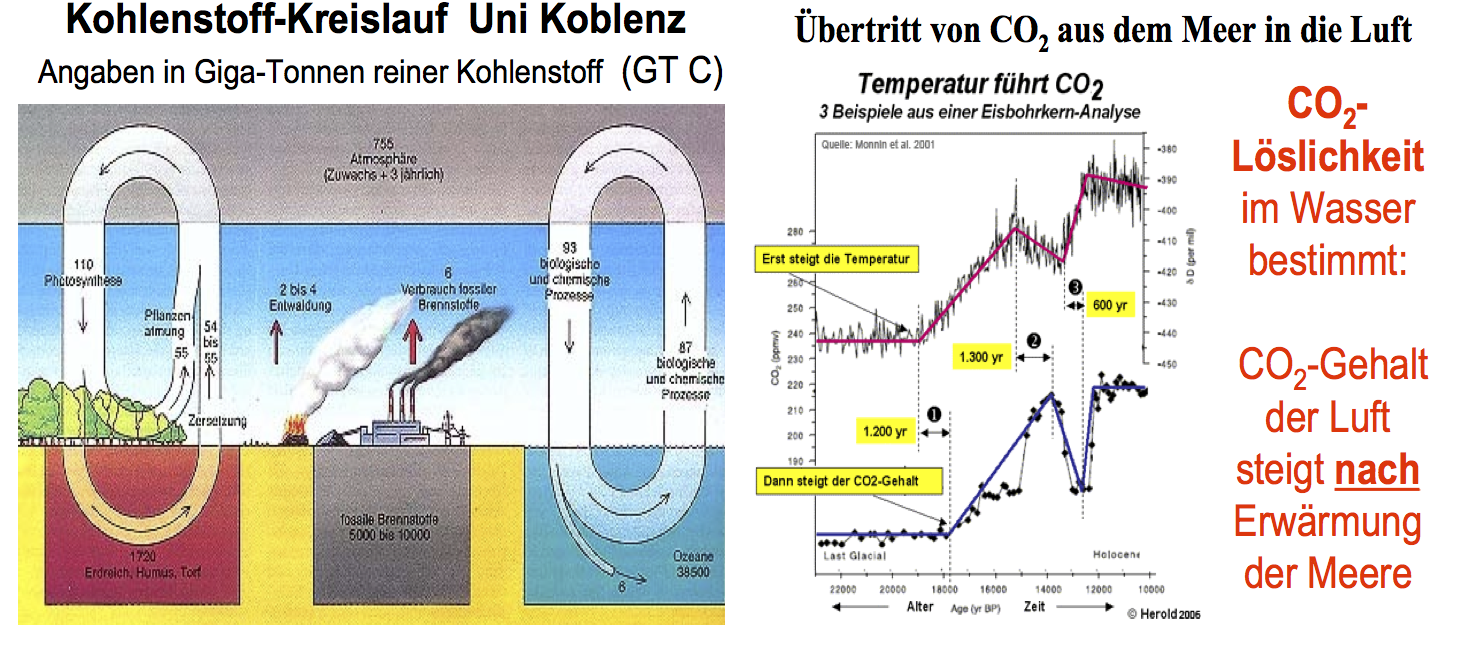

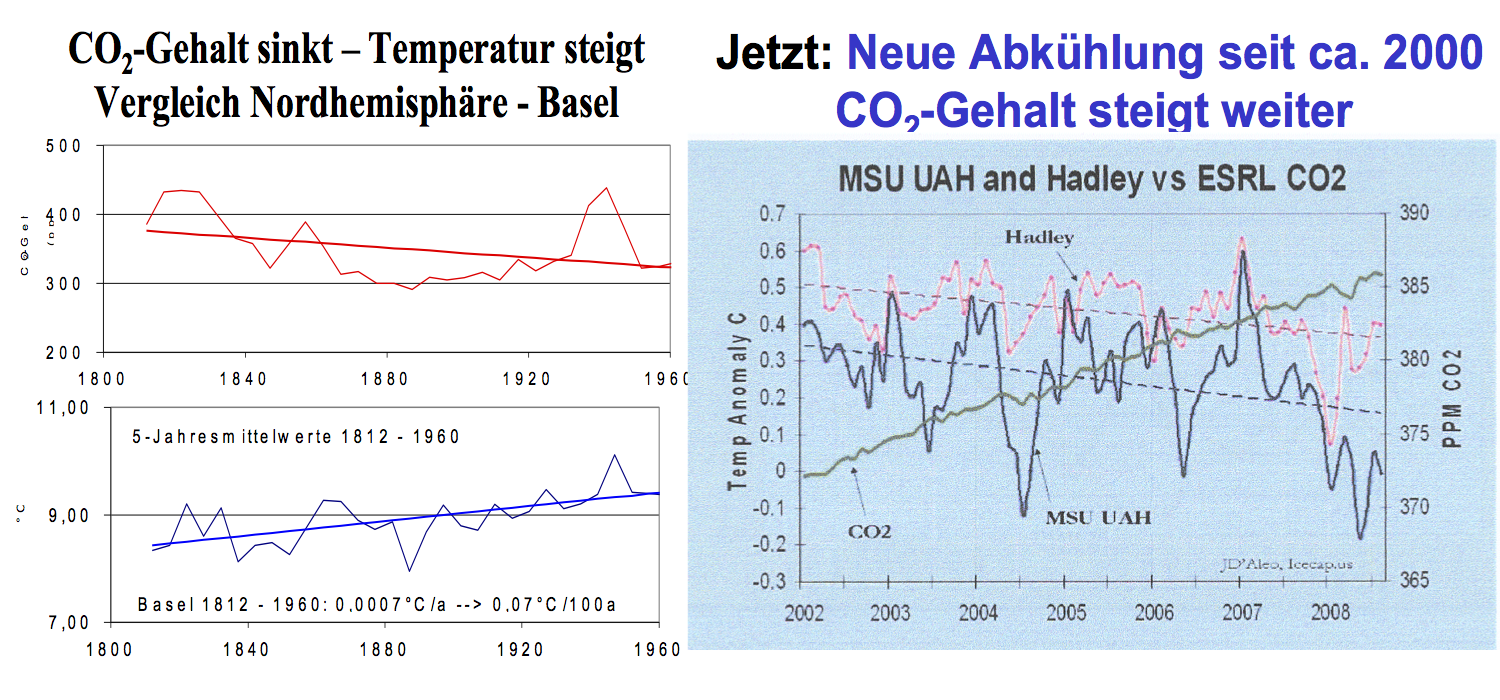

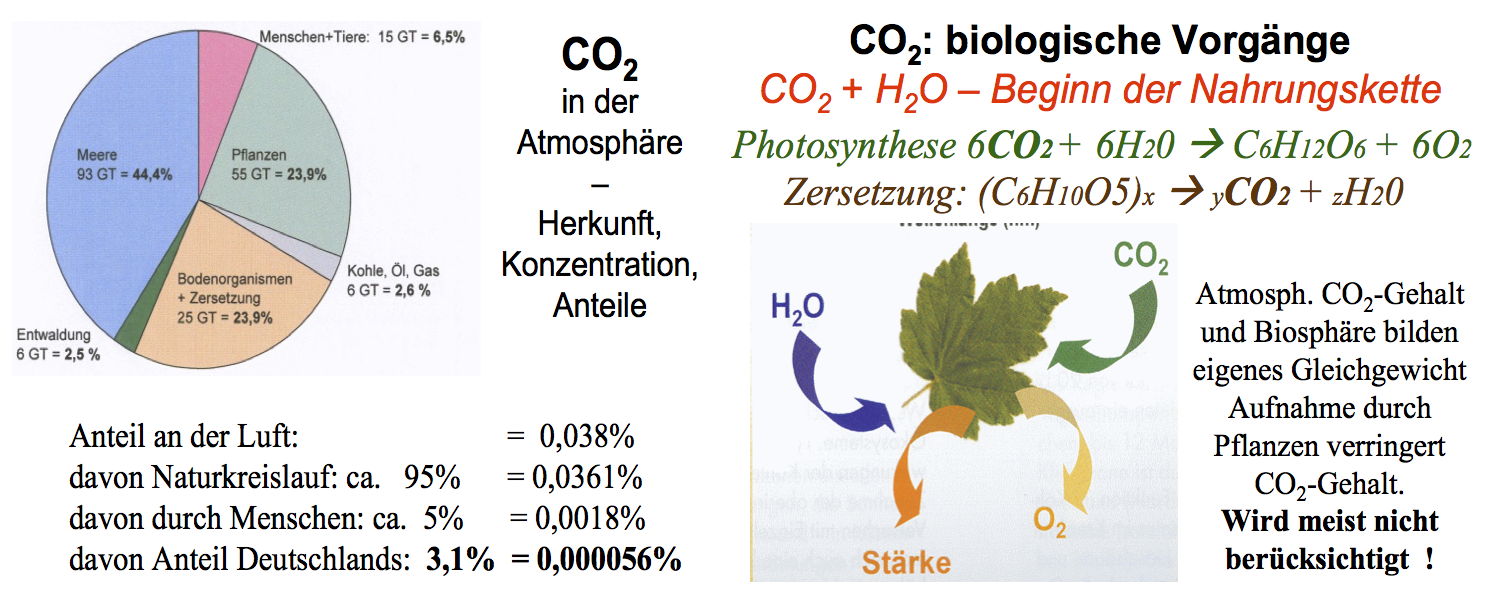

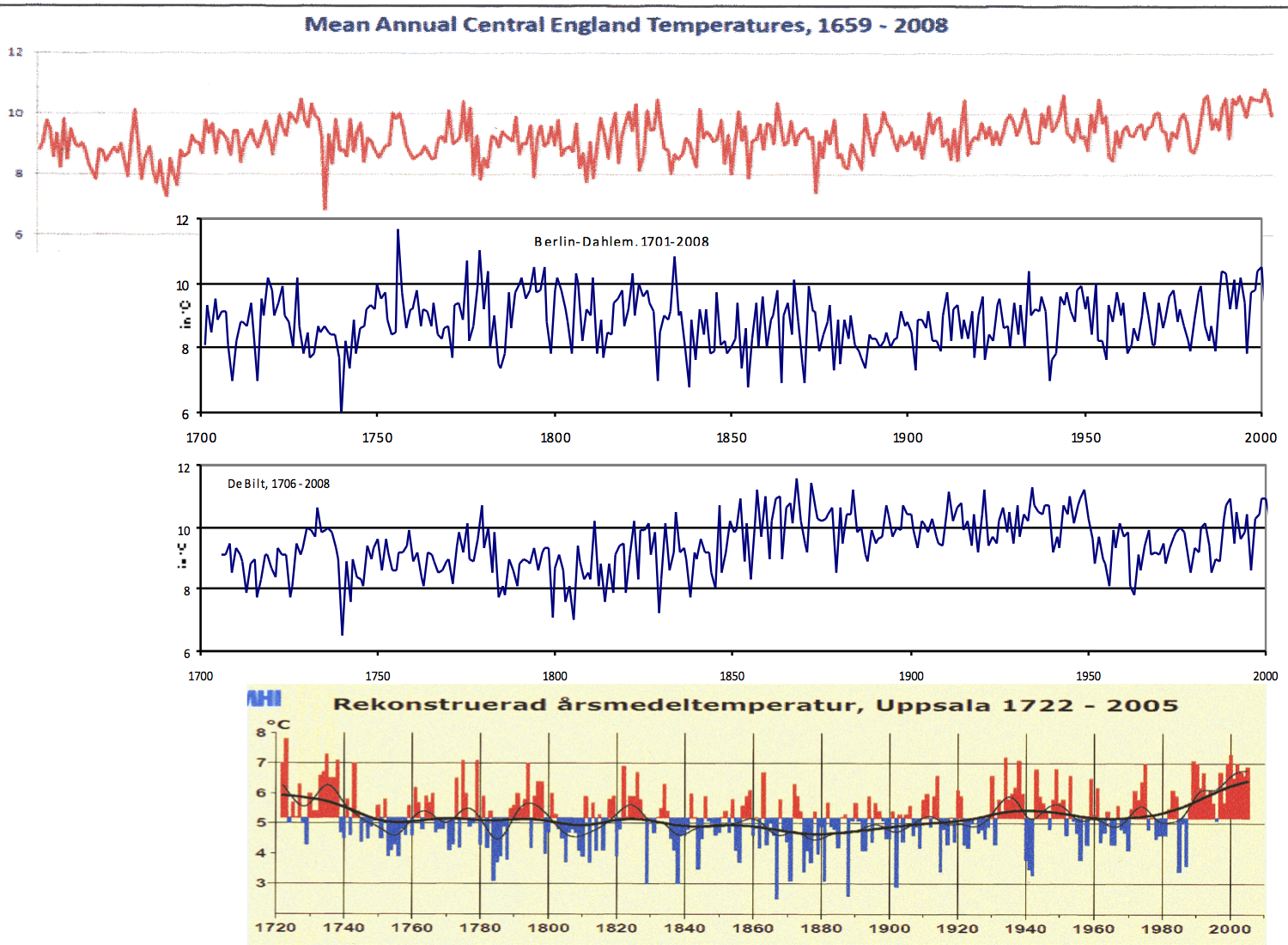

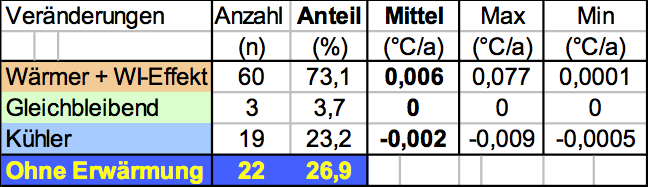

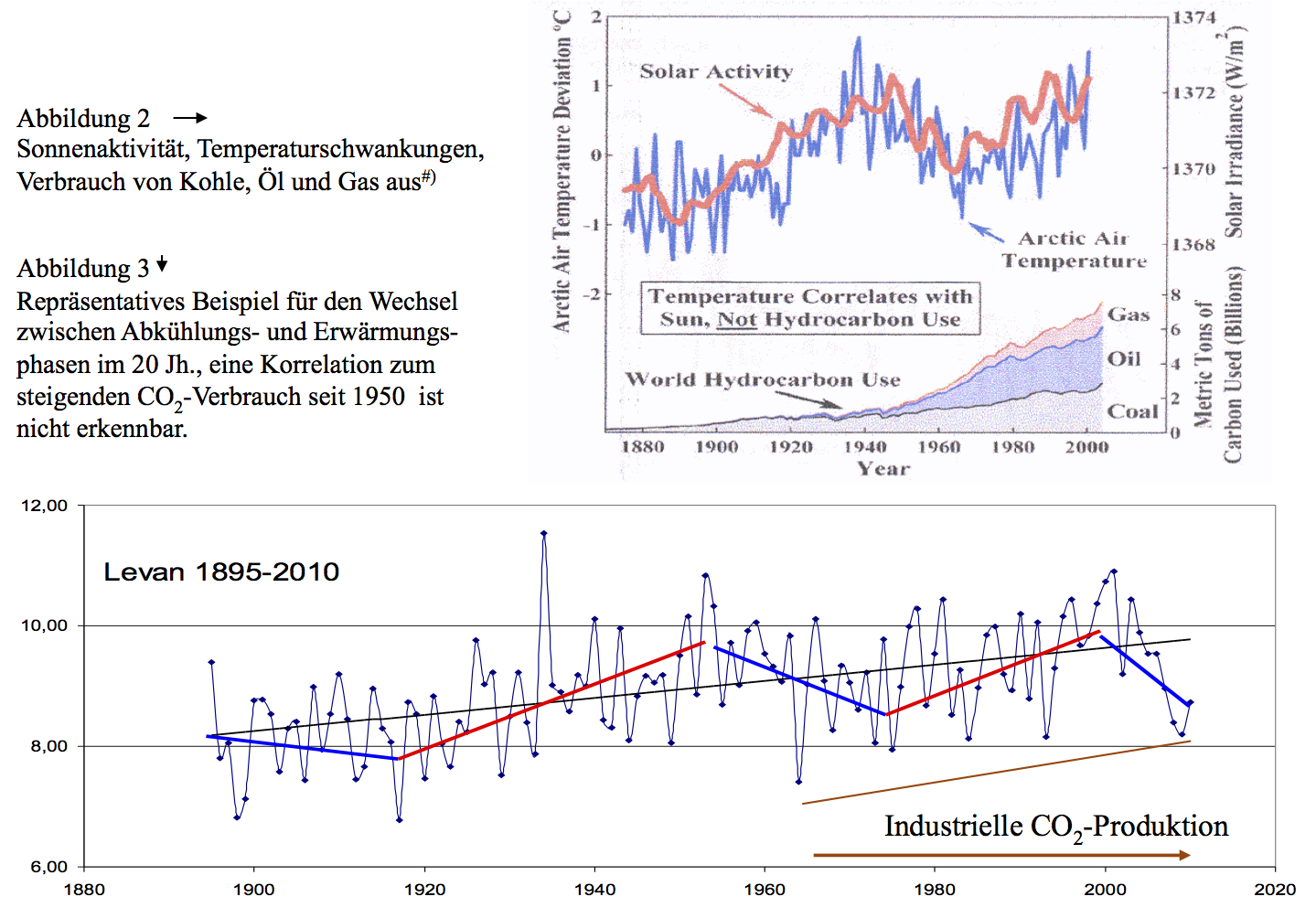

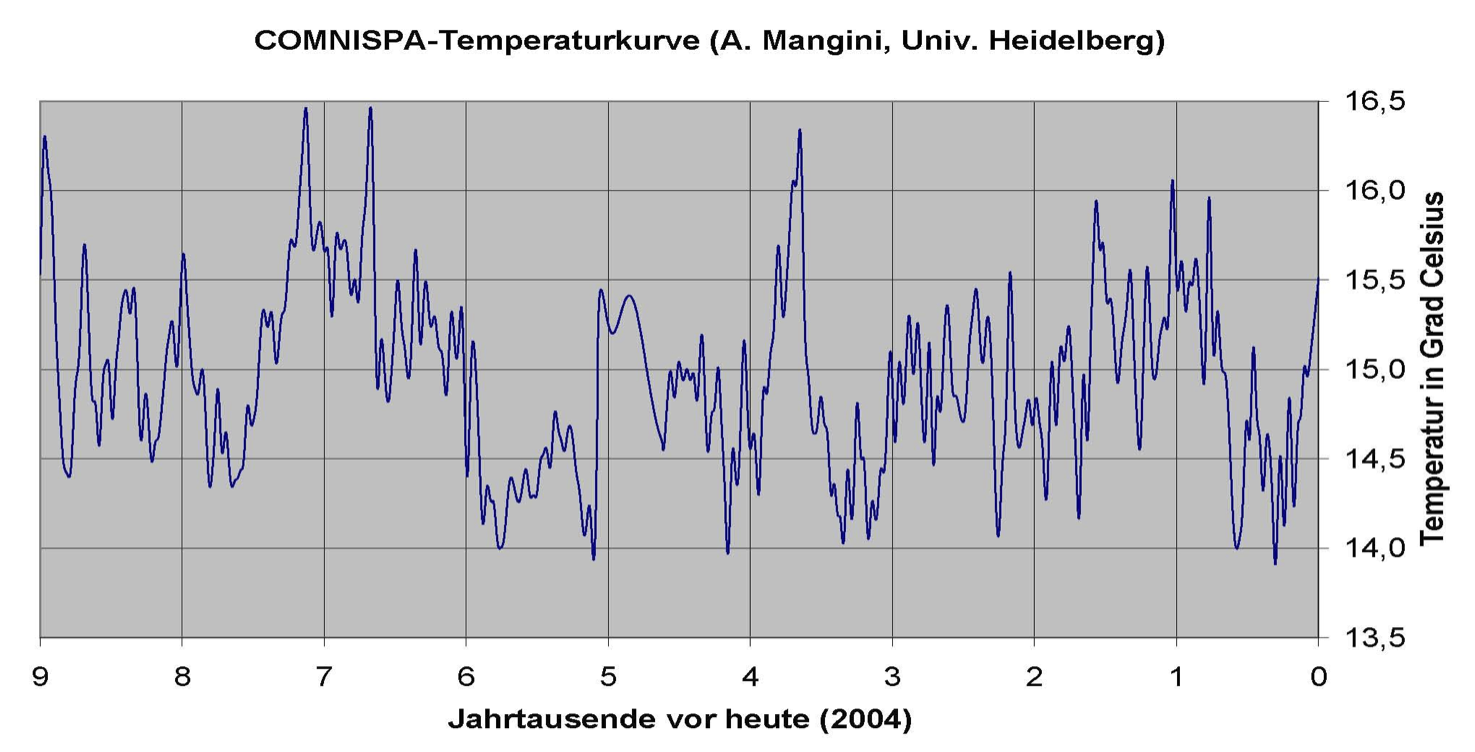

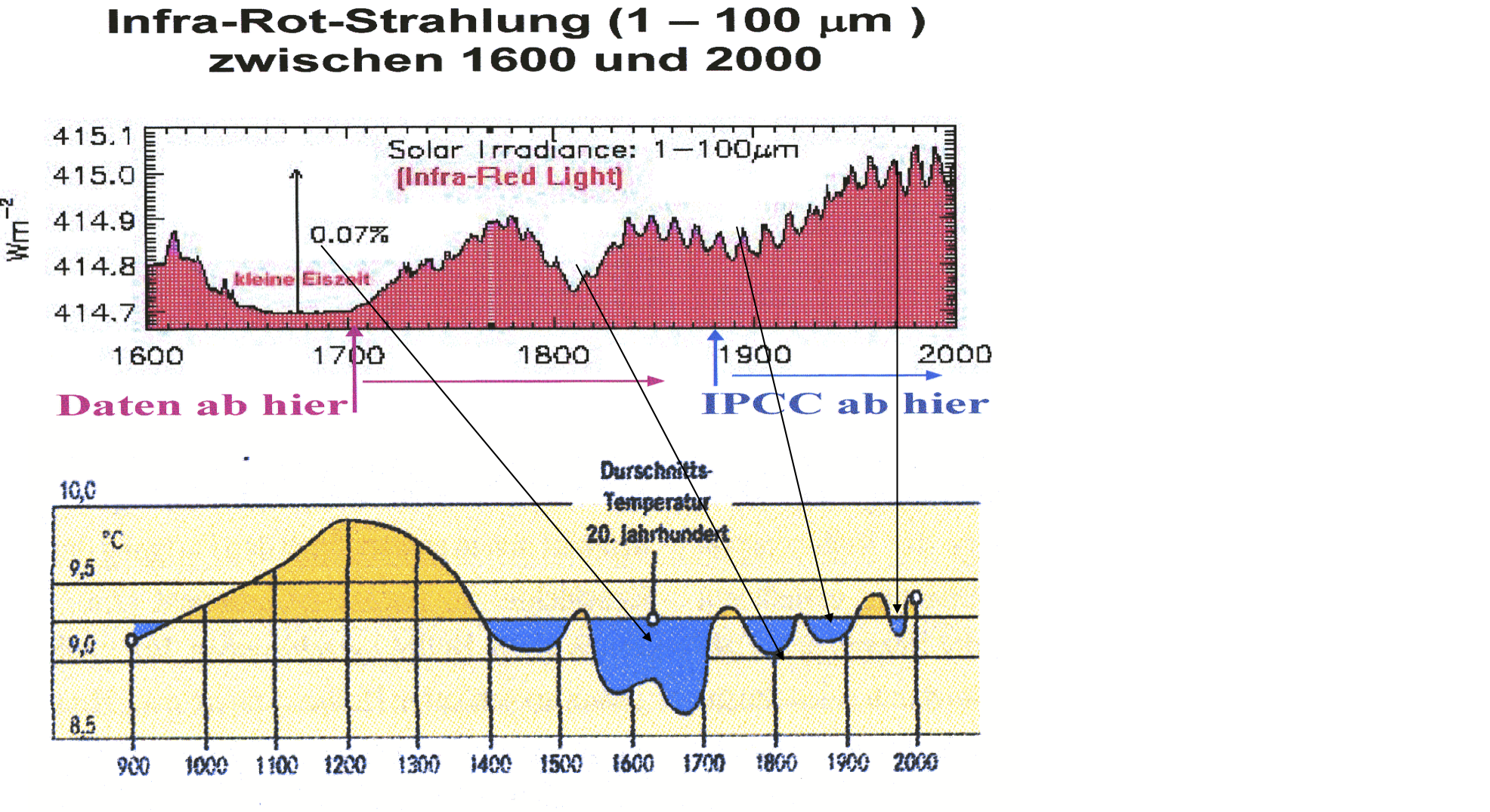

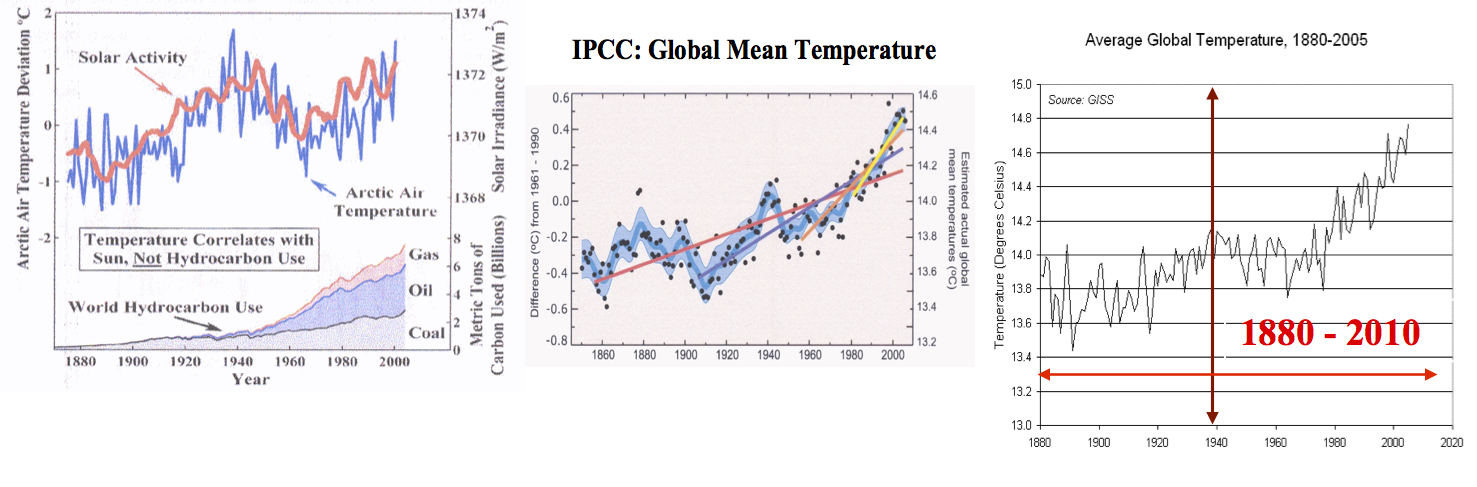

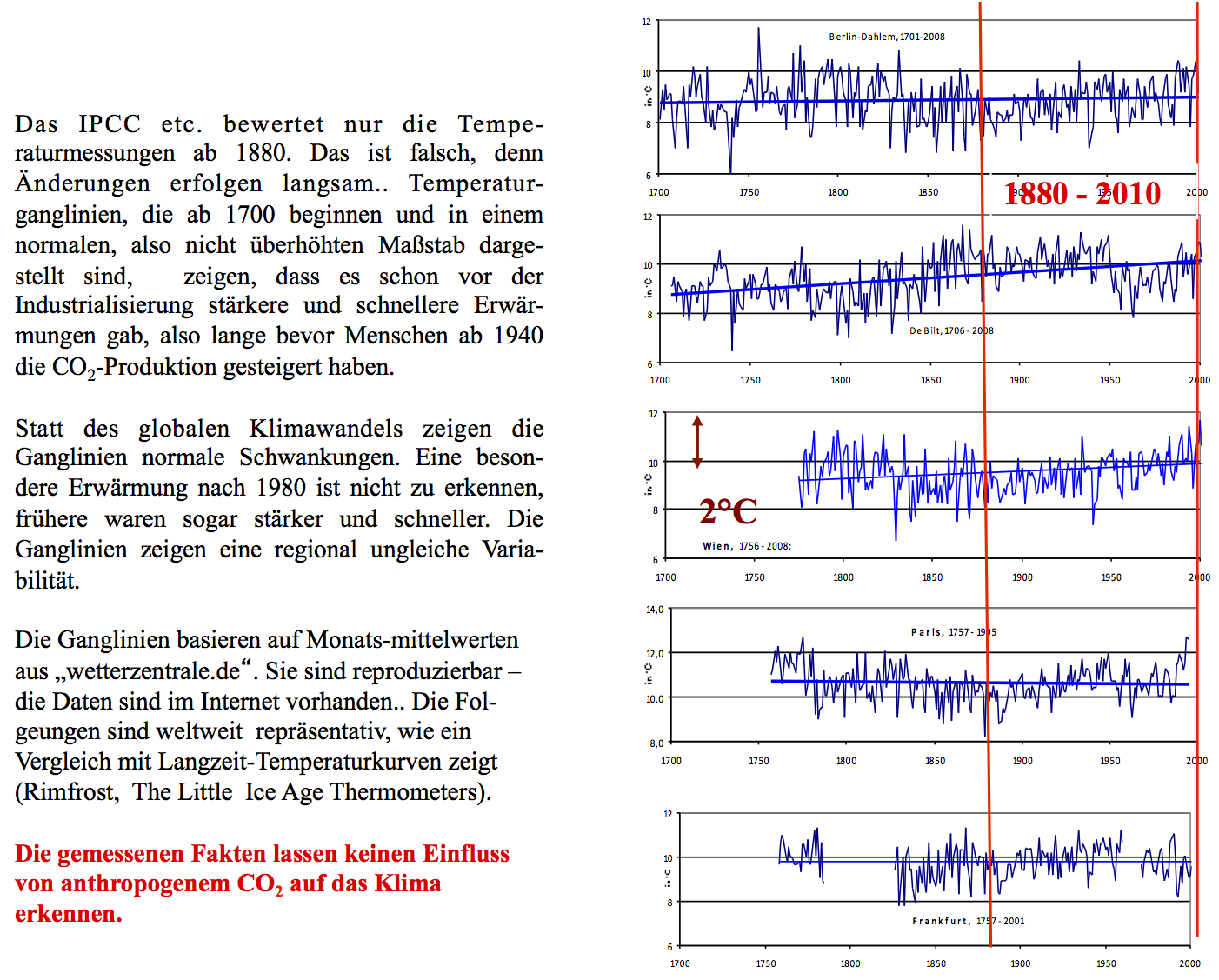

Prof. Singer gibt es keinerlei Beweise für einen Temperaturanstieg, der auf die sogenannten Treibhausgase zurück zu führen sei. CO2 hat vermutlich einen kleinen Effekt, er ist aber bisher überhaupt nicht verstanden und läßt sich mit heutiger Meßtechnik nicht nachweisen.

Prof. Singer gibt es keinerlei Beweise für einen Temperaturanstieg, der auf die sogenannten Treibhausgase zurück zu führen sei. CO2 hat vermutlich einen kleinen Effekt, er ist aber bisher überhaupt nicht verstanden und läßt sich mit heutiger Meßtechnik nicht nachweisen. Warum regnet es nach Finsternissen am stärksten?

Warum regnet es nach Finsternissen am stärksten?

Utz Tillmann, der Hauptgeschäftsführer des Verbandes der Chemischen Industrie (VCI) ausführte, stellt das die Chemie und andere stromintensive Industriezweige vor wachsende Probleme. Er stellte aber Merkels Energiepolitik nicht grundsätzlich in Frage, zumal auch Mitgliedsunternehmen seines Verbandes von der „Energiewende“ profitieren. Er bot der Politik sogar Unterstützung in Form eines fachlich kompetenten Projektmanagements an.

Utz Tillmann, der Hauptgeschäftsführer des Verbandes der Chemischen Industrie (VCI) ausführte, stellt das die Chemie und andere stromintensive Industriezweige vor wachsende Probleme. Er stellte aber Merkels Energiepolitik nicht grundsätzlich in Frage, zumal auch Mitgliedsunternehmen seines Verbandes von der „Energiewende“ profitieren. Er bot der Politik sogar Unterstützung in Form eines fachlich kompetenten Projektmanagements an.

pdf herunter geladen werden

pdf herunter geladen werden

pdf herunterladen

pdf herunterladen