Mindestens seit dem 1995 erschienenen Zweiten Zustandsbericht hat das IPCC immer sicherer klingend festgestellt, dass anthropogenes Kohlendioxid (CO2) das Klima beeinflusst, und dass dies der Hauptgrund für den nachgewiesenen Erwärmungstrend seit 1900 ist. Der gegenwärtige Anteil des atmosphärischen CO2 beträgt 390 parts per million (ppm) oder 0,039% des Gasgemisches der Atmosphäre. Im Jahre 1900 waren es etwa 295 ppm. Falls sich der Trend des 20. Jahrhunderts unvermindert fortsetzt, wird sich der Anteil von CO2 in der Atmosphäre etwa verdoppelt haben bis 600 ppm. Dies ist die Basis für das gewöhnlich „CO2–Verdoppelung“ genannte Szenario.

Die CO2–Verdoppelung ist eine Wegmarke der Klimawissenschaftler für die Abschätzung des Treibhauseffektes. Die Erde empfängt etwa 342 Watt pro Quadratmeter (W/m2) einkommender Strahlung von der Sonne, und alle diese Strahlung wird letztendlich wieder in den Weltraum abgestrahlt. Allerdings absorbieren CO2 und andere Treibhausgase, am meisten Wasserdampf, einiges dieser ausgestrahlten Energie und wärmen so die Atmosphäre. Dies nennt man den Treibhauseffekt. Ohne diesen Effekt läge die mittlere Temperatur der Erde bei frostigen -19°C. Der Treibhauseffekt erwärmt die Erde bis etwa 14°C und macht sie so überhaupt erst bewohnbar9.

Mit steigendem CO2 wird noch mehr der ausgestrahlten Energie absorbiert, was die Thermodynamik der Atmosphäre verändert. Alle zusätzlichen Treibhausgase einschließlich CO2, die seit 1900 in die Atmosphäre gelangt sind, kommen einer zusätzlichen Absorption von etwa 2,7 W/m2 in der Atmosphäre gleich10. Dies ist der besorgliche Treibhauseffekt.

Am 2. Februar 2007 veröffentlichte die Arbeitsgruppe 1 (WG1) des IPCC die „Zusammenfassung für Politiker (Summary for Policymakers SPM) über den Zustand des Erdklimas“11. Er enthält eine umfassende Zusammenfassung der Wissenschaft, die die oben gemachte Vorhersage stützt. Der ganze „Vierte Sachstandsbericht“ (Fourth Assessment Report, 4AR) wurde 2007 nach und nach veröffentlicht.

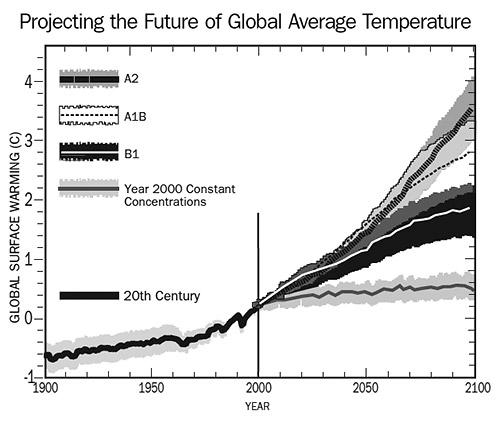

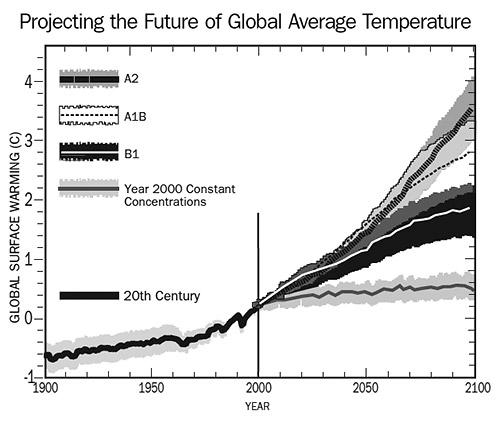

Abbildung 1 zeigt eine Schwarz-weiß-Version des „Sonderberichtes für Emissionsszenarien“ (Special Report on Emission Scenarios SRES) in SPM-5 der WG1 des IPCC, der die Zukunft der globalen Mitteltemperatur projiziert. Diese Projektionen11 wurden mit Hilfe von generellen Zirkulationsmodellen (General Circulation Models GCMs) durchgeführt. GCMs, das sind Computerprogramme, die die physikalischen Auswirkungen des Klimas berechnen; Auswirkungen u. A. auf die Ozeane, die polaren Eiskappen und die dynamische Antwort der Atmosphäre zu verschiedenen Antriebskräften. Antriebe und Feedbacks sind diejenigen Elemente, die den Energiefluss im Klimasystem steuern. Sie schließen das Sonnenlicht, Meeresströme, Stürme und Wolken, die Albedo (die Reflektivität der Erde) sowie die Treibhausgase Wasserdampf, CO2, Methan, Nitrooxide und Fluorchlorkohlenstoffe ein.

In der Abbildung 1 nimmt das B1–Szenario einen CO2–Anstieg auf 600 ppm, A1B bis 850 ppm und A2 einen solchen auf pessimistische 1250 ppm an. Das „Jahr 2000 Szenario“ bildet den optimistischen Fall ab, den CO2–Gehalt stabil bei 390 ppm zu halten.

Die Bildunterschrift unter der Abbildung SPM-5 lautet (in Auszügen): „Durchgezogenen Linien zeigen die Erwärmung der Erdoberfläche im globalen Mittel (im Vergleich zum Zeitraum 1980 – 1999) für die Szenarien A2, A1B und B1, dargestellt als Fortsetzung der Simulationen des 20. Jahrhunderts. Die Schattierungen zeigen die Standartabweichung der individuellen Modelle“.

Gut und schön! Wir schauen uns die Projektionen an und sehen, dass die Fehlergrenzen nicht sehr unterschiedlich sind. Egal was passiert, es wird angenommen, dass die globale Temperatur im 21. Jahrhundert signifikant steigen wird. Eine kleine Woge der Verzweiflung taucht auf, dass es unter keinen Umständen gelingen wird, den CO2–Gehalt auf dem heutigen Stand zu halten. Das Jahr 2000 Szenario wird nur als Kontrast gezeigt. Die Wissenschaft ist hier in Ordnung, und wir können uns gefasst machen auf eine anthropogen verursachte Erwärmung im 21 Jahrhundert, mit all den daraus resultierenden Gefahren. Fühlen Sie sich schon schuldig?

Aber vielleicht ist ja das alles nicht so eindeutig! Im Jahre 2001 wurden in der Zeitschrift Climate Research13 offen die Unsicherheiten der Physik diskutiert, die in die GCMs einfließen. Dieses Papier war sehr kontrovers und verursachte eine [intensive] Debatte14. Aber über alle Kontroversen hinweg wurde nicht über die grundlegenden physikalischen Unsicherheiten gesprochen. Es stellte sich heraus, dass die Unsicherheiten der energetischen Reaktion des Klimasystems der Erde über 10 mal größer sind als der gesamte Effekt zunehmenden CO2–Gehaltes15. Wenn die Unsicherheit größer ist als die [angenommene] Auswirkung, wird die Auswirkung selbst irrelevant. Wenn aber die Auswirkung selbst strittig ist, über was hat das IPCC dann geredet? Und woher nimmt es die Gewissheit des großen Einflusses des CO2 auf die Atmosphäre?

Mit diesen Fragen im Hinterkopf schaue man noch einmal auf die Legende der Abbildung SPM-5. Dort heißt es „Die Schattierungen zeigen die Standardabweichung der individuellen Modelle“. Die Linien in der Abbildung repräsentieren die vom GCM projizierte jährliche Mitteltemperatur. Die Legende besagt, dass während 68% der Zeit (eine Standardabweichung) die Modellprojektionen in den schattierten Bereichen liegen werden. Sie sagt nicht, dass die schattierten Bereiche die physikalische Verlässlichkeit der Projektionen angeben. Die schattierten Bereiche zeigen nichts über die physikalische Ungewissheit der Temperaturprojektionen. Sie zeigen die numerische Instabilität der Modelle. Die Botschaft der Legende lautet, dass Klimamodelle nicht zweimal den gleichen Trend ergeben werden. Sie garantieren nur, dass dies in den schattierten 68% der Zeit der Fall ist16.

Dieser Punkt ist so wichtig, dass er mit einem einfachen Beispiel verdeutlicht werden soll. Nehmen wir an, ich hätte ein Computermodell allgemeiner Arithmetik, das behauptet,

2 + 2 = 5 ± 0,1.

Jedes Mal, wenn ich das Modell rechne, gibt es eine Chance von 68%, dass das Ergebnis innerhalb des Bereiches 0,1 Einheiten um die 5 liegen wird. Meine schattierte Region wäre 0,1 Einheiten breit. Wenn 40 verschiedene Forschergruppen 40 leicht unterschiedliche arithmetische Modelle hätten, die ähnliche Ergebnisse bringen würden, könnten wir uns alle zu einem Konsens gratulieren. Nehmen wir jetzt weiter an, wir könnten die Modelle soweit verbessern, dass das Ergebnis jetzt lauten würde: 2 + 2 = 5 ± 0,01. Dann könnten wir behaupten, wir hätten unsere Modelle so weit verbessert, dass sie jetzt 10 Mal genauer wären als zuvor. Aber natürlich wären sie alle genauso falsch wie vorher, weil die exakte Arithmetik nun einmal ergibt, das 2 + 2 = 4. Dieses Beispiel zeigt den kritischen Unterschied zwischen Präzision und Genauigkeit.

In der Abbildung 1 sind die schattierten Bereiche die rechnerischen Ungenauigkeiten der Computermodelle. Sie zeigen nicht die physikalische Genauigkeit der Projektionen. Sie sagen uns gar nichts über die physikalische Genauigkeit. Aber physikalische Genauigkeit – Verlässlichkeit – war immer das, wonach wir in den Vorhersage über künftige Ereignisse in der realen Welt gesucht haben. Es ist dieser Punkt – die physikalische Genauigkeit von globalen Zirkulationsmodellen GCM – mit dem sich dieser Artikel befassen wird.

Die erste Annäherung an physikalische Präzision in den GCMs ist es, zu ermitteln, was sie projizieren. Der am meisten propagierte Trend – den, den wir immer sehen – ist die globale mittlere Temperatur.

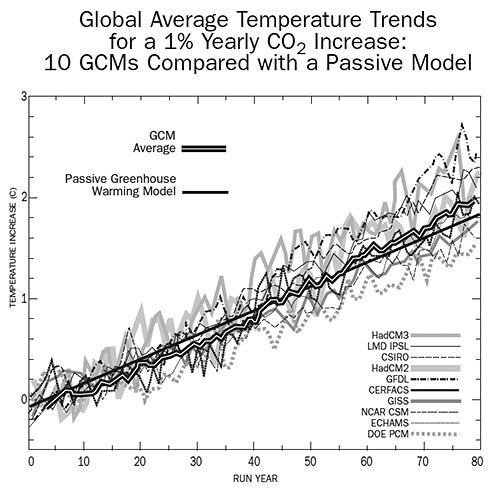

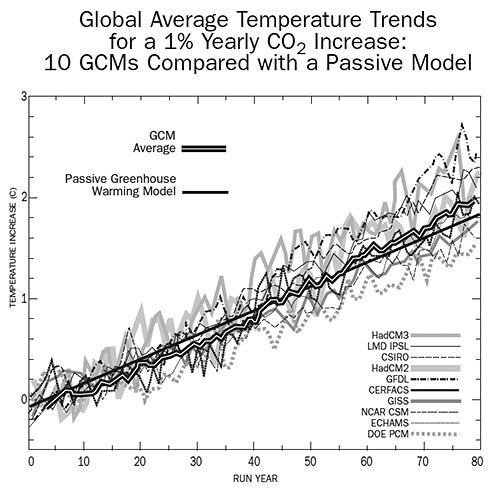

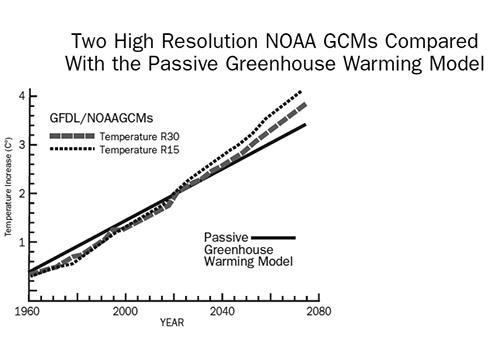

Abbildung 2a zeigt die Trends der Temperatur von 10 GCMs, die in dem Projekt „Coupled Model Intercomparison Project“ (GMIP) [etwa: gekoppeltes Modellvergleichsprojekt] im „Lawrence Livermore National Laboratory“17 berechnet wurden. Sie zeigen, was passieren würde, wenn das atmosphärische CO2 stetig um 1% pro Jahr (etwa doppelt so viel wie gegenwärtig) innerhalb der nächsten 80 Jahre steigen würde. Die Klimamodelle schlossen andere „äußere Antriebe“ aus, wie z. B. Vulkanausbrüche, anthropogenes Aerosol sowie Änderungen der Solarstrahlung. Andererseits berücksichtigten sie interne Feedbacks wie beispielsweise den Wärmeaustausch zwischen Ozean und Atmosphäre, Änderungen des Schneefalls, Schmelzen der Eiskappen und so weiter. Diese GCMs sind entweder identisch oder sehr ähnlich den GCMs, die das IPCC für die Vorhersage der künftigen Temperatur des Erdklimas in Abbildung 1 (SPM-5) zeigt.

Zusammen mit den GCM–Projektionen zeigt Abbildung 2a den Trend eines sehr einfachen Modells, in dem alles, was passiert, nur in einer passiven Erwärmung durch Treibhausgase mit keinerlei Klimafeedbacks besteht. Trotz dieser ihm innewohnenden Einfachheit geht der Graph der passiven Erwärmung genau durch die Mitte der Trendlinien des GCM.

Dieses Resultat bedeutet, dass sich irgendwie die Quintillionen Watt an Feedback von den Ozeanen, der Atmosphäre, der Albedo und den Wolken in den generellen Zirkulationsmodellen zusammen zu null mitteln. Neben den geringen Spielräumen der Intensität simulieren alle GCMs wenig mehr als passive globale Erwärmung.

Alle Berechnungen, die die hier gezeigten Schlussfolgerungen stützen, werden in der unterstützenden Information (Supporting Information SI) präsentiert, die man auf der Site www.skeptic.com einsehen kann. Hier folgt das vereinfachte Treibhausmodell insgesamt:

Global Warming=0,36x(33°C)x[(Total Forcing ÷ (Base Forcing)]

Sehr kompliziert! “33°C” ist die Basis-Treibhaustemperatur der Erde, wie sie im Jahre 1900 definiert wurde19. „0,36“ ist der Teil der Treibhauserwärmung, von dem gesagt wird, dass es durch das CO2 plus „das erweiterte Wasserdampf-Feedback“ geliefert wird20. Die erweiterte Idee dahinter ist, wenn CO2 die Atmosphäre erwärmt, wird auch mehr Wasserdampf produziert. Dieser zusätzliche Wasserdampf beschleunigt die Erwärmung durch das CO221. All dies wird detailliert zur kritischen Durchsicht in Sektion 1 bei der SI ersichtlich.

Die vom IPCC anerkannten Gleichungen10 wurden zur Berechnung der Auswirkungen der Treibhausgase CO2, Methan und Stickstoffoxide [nitrous oxide] benutzt – die hauptsächlichen Treibhausgase derzeit. Das ist alles. Nichts, was komplizierter ist als Algebra, wurde hinzugezogen.

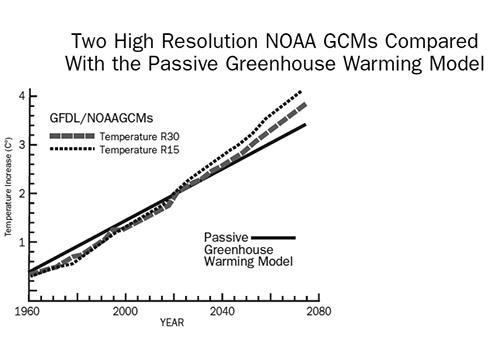

Die Mittellinie des GCM in Abbildung 2a (die schwarze Linie mit der weißen Mitte) ist das „Ensemble Mittel“ aller 10 GCM–Projektionen; das heißt ihre Summe geteilt durch 10. Ensembles werden typischerweise als genauer angesehen als jede einzelne individuelle GCM–Projektion22. Unter diesem Kriterium ist das Modell der passiven Erwärmung physikalisch akkurater als irgendeines der multimillionen teuren GCMs, weil es näher am Ensemblemittel liegt als jedes der 10 Klimamodelle (SI Sektion 2). Abbildung 2b zeigt einen ähnlichen Vergleich mit Projektionen von zwei hochauflösenden GCMs vom Geophysical Fluid Dynamics Laboratory der NOAA18, die Feedbacks von allen bekannten Klimaprozessen auf der Erde enthalten. Das einfache Modell zeigt die Temperaturprojektion näher [am Mittelwert] als viele der anderen komplexen GCMs zusammen.

Abbildung 2a zeigt, dass das physikalische Modell des Erdklimas in den GCMs im Falle einer Zunahme von CO2 simuliert, dass die Temperatur kaum etwas anderes macht außer einer passiven Reaktion in linearer Weise auf den Antrieb der Treibhausgase. Die gleiche Schlussfolgerung ergibt sich beim Betrachten von Kontrollläufen der GCMs, die die Temperaturentwicklung bei konstantem CO2–Gehalt simulieren. Eine davon zeigt Abbildung 1 – das „Jahr-2000-Szenario“. Die Kurve ist beinahe eben.

Besonders seit der Ära der Satelliten konnten spezielle Aspekte des Klimas, wie Bewölkung oder die Oberflächentemperatur um den ganzen Globus aufgezeichnet werden. Man kann GCM mit der Rückwärtsmethode testen, indem man sie das bekannte Klimageschehen der Vergangenheit simulieren lässt anstelle der erwarteten Entwicklung in der Zukunft. Physikalische Fehler in den GCMs bzgl. der simulierten Vergangenheit können dann mit der realen Vergangenheit verglichen werden.

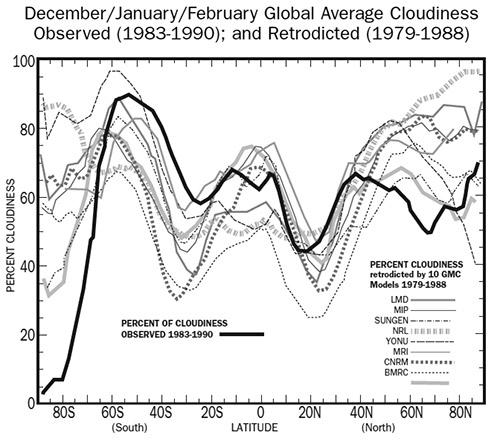

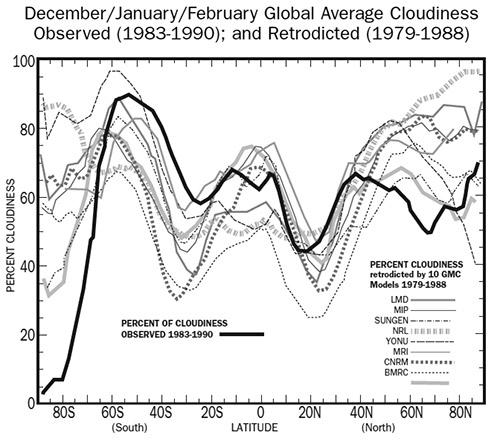

Abbildung 3 zeigt die vom Satelliten beobachtete Bewölkung im Zeitraum Dezember – Januar – Februar, gemittelt über die Jahre 1983 bis 1990. Sie zeigt auch die globale mittlere Bewölkung über die ähnliche Periode von 1979 bis 198823 durch 10 begutachtete GCMs24. Die GCMs wurden benutzt, um zu versuchen, die beobachtete Bewölkung zu reproduzieren und wurden dann überarbeitet und erneut getestet. Diese Studie wurde 1999 veröffentlicht, aber die Genauigkeit zwischen den Rekonstruktionen der GCMs und den Beobachtungen hat sich während der letzten 9 Jahre kaum verbessert25.

Betrachtet man Abbildung 3, zeigen die GCMs ziemlich genau die Form eines W bei der Bewölkung der Erde, aber es zeigen sich signifikante Verluste durch alle Modelle in allen Breiten einschließlich der Tropen, wo die Wolken einen großen Einfluss auf das Klima haben26. Also, wie falsch sind die GCMs?

Eine Methode, den Fehler abzuschätzen, besteht darin, dass man über die Gesamtbewölkung, die von jedem Modell in der Rückschau simuliert wurde, integriert und dies mit der tatsächlich beobachteten Gesamtbewölkung vergleicht (SI Sektion 3). Den Fehler auf diese Weise zu ermitteln ist ein wenig vereinfachend, weil eine positive Abweichung in einer Breite durch eine negative Abweichung in einer anderen Breite kompensiert werden kann. Dieses Verfahren ergab eine mittlere Fehlerquote der Bewölkung von ±10,1%. Dieser Wert ist etwa halb so groß wie die offiziell festgelegte Fehlerquote bei den GCMs. Nennen wir diese ±10,1% den minimalen Fehler bzgl. der Bewölkung bei den GCMs.

Die mittlere Energiezufuhr der Wolken zum Erdklima lässt sich mit einem Wert von etwa -27,6 W/m2 27 beziffern. Das bedeutet, dass ein Fehler von ±10,1% eine Unsicherheit von ±2,8 W/m2 in den GCM–Projektionen hat. Diese Unsicherheit liegt bei etwa 100% des gegenwärtigen Treibhausantriebs durch alle anthropogen erzeugten Treibhausgase, die sich gegenwärtig in der Atmosphäre befinden10. Wenn man dies berücksichtigt, ergibt sich eine wahre, jedoch unvollständige Abschätzung der physikalischen Verlässlichkeit eines GCM–Temperaturtrends.

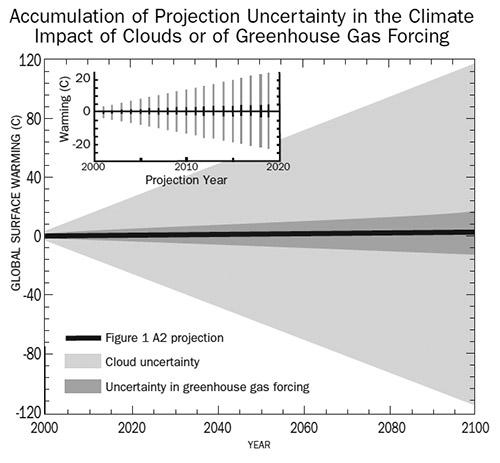

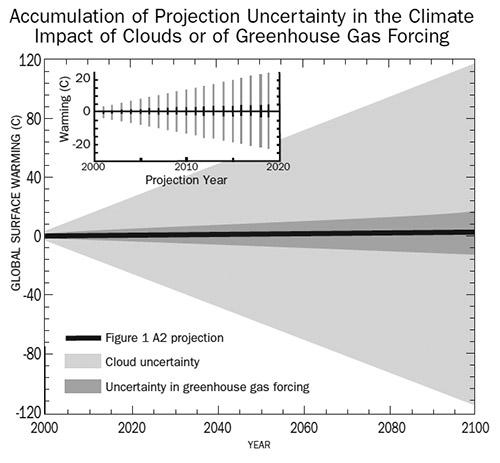

Was passiert also, wenn man diese ±2,8 W/m2 durch die SRES Temperaturtrends laufen lässt, die vom IPCC in Abbildung 1 angeboten werden? Bei der Berechnung einer Temperaturprojektion von Jahr zu Jahr wird jeder neue Temperaturwert plus dessen physikalischer Fehlergrenze in die Berechnung der Temperatur plus dessen Fehlergrenze eingegeben. Diese Art der Unsicherheit akkumuliert sich in jedem Jahr, weil jede vorhergesagte Temperatur die gesamte ±(physikalische Unsicherheit) enthält (SI Sektion 4).

Abbildung 4 zeigt die A2 SRES–Projektion, wie sie ausgesehen haben könnte, wenn das IPCC sich entschieden hätte, den Minimalfehler ±10,1% bzgl. der Wolken als ein Maß der Genauigkeit ihrer Temperaturprojektionen für das 21. Jahrhundert einzuführen. Dieses Resultat ist etwas ärgerlich. Die physikalische Ungewissheit akkumuliert rapide und ist in 100 Jahren so groß, dass sie bei einer Anpassung die steile SRES A2–Projektion in Abbildung 1 beinahe eingeebnet hätte. Die Ungewissheit von ±4,4°C im 4. Jahr übersteigt sogar schon die gesamte Temperaturzunahme von 3,7°C in 100 Jahren. In 50 Jahren liegt die simulierte Unsicherheit schon bei ±55°C. In 100 Jahren liegt dieser Wert bei ±111°C. Man erinnere sich, diese riesige Unsicherheit ergibt sich aus einem minimalen Fehler bei der Abschätzung der Bewölkung!

Hinsichtlich der aktuellen Entwicklung der Erdklimas besagt diese Unsicherheit nicht, dass die GCMs simulieren, in 100 Jahren sei es möglicherweise 100 K wärmer oder kälter als heute. Sie besagt, dass die Grenzen der Auflösung der GCMs – ihre Pixelgröße – gewaltig ist verglichen mit dem, was sie projizieren sollen. In jedem neuen Projektionsjahr einer Berechnung in der Größenordnung eines Jahrhunderts wird die Ungewissheit darüber, wie sehr die Wolken das Klima beeinflussen, größer und das Betrachten eines GCM zunehmend verwirrender.

Es ist, als ob man jedes Mal, wenn man sich umdreht, eine stärker und stärker streuende Linse vor unsere Augen hält. Erst verschwinden die Blumen, dann die Leute, dann die Autos die Häuser und schließlich sogar große Wolkenkratzer. Alles verwischt sich und lässt nur unbestimmte Farbkleckse zurück, und sogar großräumige Bewegungen können nicht mehr erkannt werden. Die Behauptung, dass die GCMs ein verlässliches Bild des zukünftigen Klimas liefern, ist etwa so stimmig wie wenn man beim Sichten eines undefinierbaren Farbkleckses darauf besteht, dass es sich um ein Haus mit einer Katze im Fenster handelt.

Die starke Schattierung in Abbildung 4 zeigt den Fehler, der sich aus den Unsicherheiten des Einflusses der Treibhausgase selbst (~1% für CO2, ~10% für Methan, ~5% für Nitrooxide)10, und wie sehr sich diese kleinen Unsicherheiten über einen Vorhersagezeitraum von 100 Jahren aufschaukeln. Nach einem Jahrhundert beträgt die Unsicherheit der vorhergesagten globalen Mitteltemperatur ±17 K, nur aus der Akkumulation des kleinsten Fehlers beim Antrieb allein.

Die Schwierigkeit ist sogar über kurze Zeiträume ernst. Das kleine Bild in der Abbildung 4 zeigt, dass nach nur 20 Jahren die Unsicherheit bzgl. der Wolken schon ±22 K beträgt und ±3 K bzgl. des Antriebs durch die Gase. Der Effekt der ±1%–Unsicherheit allein zeigt, dass zu 99% akkurate GCMs nicht erkennen können, ob wir in nicht einmal 20 Jahren eine neue Eiszeit oder aber eine tropische Warmzeit haben werden. Diese physikalischen Unsicherheiten sind nicht nur erheblich größer als vom IPCC in Abbildung 1 zugelassenen, sondern die tatsächlich zugelassenen Fehlergrenzen des IPCC sind nicht einmal physikalisch16.

Wenn man eine Akkumulation der Unsicherheiten bzgl. der Wolken und es Antriebs der Gase zusammen zulässt, ergibt sich nach dem A2–Szenario nach 5 Jahren eine um 0,34 K wärmere Erde mit einer Fehlergrenze von ±8,8 K. In 10 Jahren wird daraus 0,44 ± 15 K und in 20 Jahren 0,6 ± 27,7 K. Im Jahre 2100 läge diese Projektion bei 3,7 ± 130 K. Nur aus der Unsicherheit der Bewölkungsmenge ergibt sich, dass die Fehlergrenze sehr viel größer ist als die simulierte Temperaturzunahme. Was ist glaubwürdig an einer Vorhersage, deren Fehlergrenze 20 bis 40 mal größer ist als die Vorhersage selbst? Nach nur wenigen Jahren ist die Simulation der globalen Temperatur durch ein GCM nicht verlässlicher als bloßes raten. Dies bedeutet, dass die Wirkung der Treibhausgase auf die Erdatmosphäre nicht vorhersagbar und damit nicht bestimmbar ist. Und damit irrelevant.

Das rasante Anwachsen der Fehlergrenzen bedeutet, dass die GCMs nach 5 Jahren nicht mehr unterscheiden könne, ob wir eine Eiszeit oder eine Hitzehölle haben werden; geschweige denn nach 100 Jahren. So weit es die GCMs betrifft, kann die Erde im Jahre 2100 ein Winterwunderland sein oder ein tropisches Paradies. Niemand weiß das.Direkte Tests von Klimamodellen zeigen das Gleiche. Im Jahre 2002 hat Matthew Collins vom UK Hadley Centre das GCM HadCM3 benutzt, um ein künstliches Klima zu erschaffen, und hat dann berechnet, wie sich das gleiche Klima entwickelt, dass er selbst erschaffen hat. Es verhielt sich ärmlich, obwohl es sich um das perfekte Modell handelte. Das Problem lag darin, dass kleine Unsicherheiten bei den Eingaben – den Startbedingungen – rapide zunahmen und das GCM sehr schnell in die Belanglosigkeit trieb. Sogar mit dem perfekten Modell, berichtet Collins, „scheint es so, dass die jährliche globale Mitteltemperatur potentiell 1 Jahr im voraus vorhergesagt werden kann, und eine Vorhersage für 5 oder 10 Jahre allenfalls marginal möglich ist.“ Also, mit einem perfekten Klimamodell und fast perfekten Anfangsbedingungen könnte man eines Tages potentiell oder marginal vorhersagen, aber man kann noch nicht 1 Jahr im Voraus Vorhersagen machen. Und mit diesen mangelhaften Modellen macht das IPCC Vorhersagen für 100 Jahre im Voraus!

In einem ähnlichen Test auf Zuverlässigkeit hat William Merryfield 2006 15 GCMs rechnen lassen, um künftige El-Niño Southern Oscillations (ENSO) in einem treibhausgewärmten Klima zu simulieren29. Er fand: „Bei einer Verdoppelung des CO2–Gehaltes zeigen 8 der 15 Modelle Änderungen mit einer signifikant (p<0,1) größeren Streuung als die Änderung der Amplitude selbst. Jedoch nimmt die Amplitude der ENSO in 5 dieser Modelle ab, während sie in 3 zunimmt. Fazit: Es gibt keinen Konsens über Art und Umfang der Änderung.“ Also, von 15 GCMs nahmen sieben keine signifikanten Änderungen an, 5 simulierten einen schwächeren, 3 einen stärkeren ENSO. Dieses Resultat ist gleichbedeutend mit ‚wir wissen es nicht’. Die 15 GCMs, die Merryfield benutzt hat, sind die gleichen, die dem Vierten Assessment Report des IPCC zugrunde lagen.

Wenn man all dies betrachtet, warum ist das IPCC so sicher, dass anthropogen erzeugtes CO2 für die jüngste globale Erwärmung verantwortlich ist? Wie kommt die US National Academy of Science (NAS) in einer kürzlich veröffentlichten Broschüre zu der Aussage, dass „…die Erwärmung der Erde in den letzten Dekaden primär von menschlichen Aktivitäten verursacht wurde, die den Anteil der Treibhausgase in der Atmosphäre haben zunehmen lassen“30? Diese Broschüre zeigt eine sehr aussagekräftige Abbildung 4 (SI Sektion 5), die die Inputs zu einer Projektion der globalen Temperatur aus einem GCM darlegt. Nur wenn die Auswirkungen der anthropogenen Treibhausgase in die normale Temperaturvariation mit einbezogen werden, sagt man uns, passt der Trend des GCM zu dem tatsächlich beobachteten Trend.

Aber ihre Abbildung 4 zeigt noch eine andere Charakteristik, die fast allgegenwärtig in Temperaturprojektionen von GCMs ist. Sie zeigen keinerlei physikalische Fehlergrenzen. Uns wird ein simulierter Temperaturtrend als perfekt genau präsentiert. Die Abbildung 4 der NAS wäre wesentlich glaubwürdiger, wenn die Akademie es zusammen mit der ±100 K Fehlergrenze gezeigt hätte. Dann würde offensichtlich werden, dass der Gleichlauf zwischen der beobachteten und der simulierten Trendlinie nichts als Zufall ist. Oder das GCM wurde künstlich so getrimmt, dass der Temperaturverlauf passt. Es würde auch offensichtlich werden, dass es vollkommen bedeutungslos ist zu behaupten, dass dieser erklärte Gleichlauf ohne die Zufuhr von CO2 nicht möglich ist, wenn tatsächlich ein erklärter Gleichlauf unmöglich ist. Punkt.

Unter Klimatologen ist gut bekannt, dass große Bereiche der Physik in den GCMs nicht gut verstanden werden31. Wo die Unsicherheit signifikant ist, haben die GCMs „Parameter“, die am besten darüber urteilen, wie sicher Klimaprozesse ablaufen. GCMs haben Dutzende von Parametern und eventuell Millionen Variable32, und alle davon haben einige Arten des Irrtums oder der Ungewissheit.

Eine saubere Darstellung ihrer physikalischen Zuverlässigkeit würde die Darstellung aller Unsicherheiten sämtlicher Parameter durch die GCMs einschließen und daraus resultierend eine Darstellung der gesamten Unsicherheit33. Ich habe vergeblich nach einer solchen Studie gesucht. Es scheint, dass niemand jemals die gesamte physikalische Unsicherheit eines GCM betrachtet hat. In der physikalischen Wissenschaft ist eine solche Überprüfung in der Praxis aber unabdingbar und routinemäßig erforderlich. Aber offensichtlich nicht in der Wissenschaft der GCMs. Ergo: Die gleichen Leute, die den Alarm über die künftige Erderwärmung hinaus posaunen, missachten ihre eigene ausgeprägte Unwissenheit.

Unter dem Strich ergibt sich also Folgendes: Wenn es um das zukünftige Klima geht, weiß niemand, wovon überhaupt die Rede ist. Niemand. Nicht das IPCC noch deren Wissenschaftler, nicht der US–Kongress, weder Sie noch ich und schon gar nicht Herr Al Gore. Das Erdklima erwärmt sich, und kein Mensch weiß, warum. Aber es gibt keine belastbare wissenschaftliche Basis, dass diese Erwärmung durch anthropogene Treibhausgase verursacht wird, weil die gegenwärtig zur Verfügung stehenden physikalischen Theorien gänzlich ungeeignet sind, überhaupt irgendeinen Grund zu finden.

Nichtsdestotrotz, jene, die extreme politische Maßnahmen ergreifen, um die

CO2–Emissionen zu reduzieren, beziehen sich ausschließlich auf die Ergebnisse der GCMs, die irgendwie zu realen Vorhersagen in der Öffentlichkeit werden. Aber selbst wenn diese Politiker die Unsicherheit der Modellergebnisse einräumen, werden sie immer noch das Vorsorgeprinzip bemühen und nach extremer Reduzierung rufen, „um auf der sicheren Seite“ zu sein. Dieses Prinzip besagt: „Wenn es Bedrohungen durch ernste oder irreversible Gefahren gibt, sollte das Fehlen genauer wissenschaftlicher Erkenntnisse nicht als Begründung dienen, kostenintensive Maßnahmen zu verschieben, um Umweltschäden zu verhindern“34. Dies bedeutet, selbst wenn wir nicht vollständig wissen, dass das CO2 das Erdklima gefährlich erwärmt, sollten wir doch dessen Emissionen kappen, für alle Fälle. Jedoch, wenn die gegenwärtige Fehlergrenze in den GCMs mindestens bei ±100 K pro Jahrhundert liegt, werden wir in totaler Unkenntnis über die Effekte des CO2 auf die Temperatur gelassen. Es ist nicht „… das Fehlen genauer wissenschaftlicher Erkenntnisse“, sondern es müsste heißen: „…es gibt überhaupt keine wissenschaftlichen Erkenntnisse“. Wir wissen buchstäblich gar nichts darüber, ob eine Verdoppelung des CO2–Gehaltes überhaupt irgendeinen signifikanten Effekt auf das Klima hat.

Solange unser Wissen über das künftige Klima gegen Null tendiert, kann es also sein, dass [in der Vorhersage] sowohl eine Reduzierung als auch eine Zunahme des CO2 das Klima verbessert, verschlechtert oder gar nicht verändert. Die Alternativen sind unangemessen, aber in unserem Stadium der Unwissenheit hat jede Wahl zwei von drei Chancen, den geringsten Schaden anzurichten35. Komplette Unwissenheit macht das Vorsorgeprinzip komplett unbrauchbar. Es gibt gute Gründe, den Verbrauch fossiler Energieträger zu reduzieren, aber die Klimaerwärmung ist dafür kein Grund.

Einige könnten nun beschließen, trotzdem daran zu glauben. „Wir können es nicht beweisen“, könnten sie sagen, „aber die Korrelation zwischen CO2 und der Temperatur ist real (sie nehmen beide zu)36 und so ist die Notwendigkeit da, auch wenn wir es nicht beweisen können“. Aber Korrelation bedeutet nicht Ursache37, und ein Grund kann nicht bei kompletter Unwissenheit herhalten. Die richtige Antwort auf den hartnäckigen Anspruch auf Gewissheit bei kompletter Unwissenheit ist gesunder Skeptizismus. Und ist es nicht viel besser für uns, Ressourcen für dringende aktuelle Dinge zu nutzen, anstatt diese Ressourcen für ungewisse Gefahren aufzuheben?

Also, was hat es denn nun mit schmelzenden Eiskappen, dem Anstieg des Meeresspiegels, dem Aussterben der Eisbären und anderen Wetterextremen auf sich? Was ist, wenn ungewöhnlich intensive Hurrikansaisons wirklich verbreitete Katastrophen auslösen? Es ist kritisch, den Finger auf Gründe und Rationalität zu legen, besonders wenn soziale Einladungen zum gesellschaftlichen Durchdrehen so allgegenwärtig sind. GCMs sind so schrecklich unzuverlässig, dass es keinen objektiven, belastbaren Grund gibt für die Annahme, dass der gegenwärtige Erwärmungstrend durch anthropogenes CO2 erfolgt, oder dass dieses CO2 das Klima überhaupt messbar erwärmt. Daher, selbst falls extreme Ereignisse wegen des sich erwärmenden Klimas vorkommen, gibt es keinen wissenschaftlichen Grund, die Ursache für diese Ereignisse im anthropogenen CO2 zu suchen. Im chaotischen Erdklima könnte es gar keinen Grund für eine Erwärmung geben39. Viele hervorragende Wissenschaftler haben all das in grundlegenden Arbeiten immer wieder geschrieben, um die CO2–Panik zu dämpfen40, aber der Chor singt verführerisch, und einige rechtschaffene Gläubige scheinen sich an Widerlegungen zu weiden.

Patrick Frank,

Die Übersetzung erledigte dankenswerterweise Chris Frey EIKE

Im Original folgen noch Danksagungen

Literatur

1. McCarthy, J. 2005. “The Sustainability of Human Progress.” www.formal.stanford.edu/jmc/progress/ Last accessed on: 14 September 2007.

2. Anon. 2006. “Consequences of Global Warming” National Resources Defense Council. www.nrdc.org/globalWarming/fcons.asp Last accessed on: 14 September 2007.

3. Anon. 2007. “The Hard Facts of Global Warming.” The Sierra Club www.sierraclub.org/globalwarming/overview/overview4.asp Last accessed on: 14 September 2007.

4. Anon. 2007. “Learning About the Science of Climate Change.” Greenpeace. www.greenpeace.org/international/campaigns/climatechange/science Last accessed on: 14 September 2007.

5. Appenzeller, T. and D. R. Dimick. 2007. “Signs from Earth” National Geographic. http://magma.nationalgeographic.com/ngm/0409/feature1/ Last accessed on: 14 September 2007.

6. Cicerone, R., E. J. Barron, R. E. Dickenson, I. Y. Fung, J. E. Hansen, et al. 2006. “Climate Change Science: An Analysis of Some Key Questions” The National Academy of Sciences, Washington, D.C. See also the 2006 report downloadable here: http://dels.nas.edu/basc/. Last accessed on: 14 September 2007.

7. Pelosi, N. 2007. “We Will Work Together to Tackle Global Warming, One of Humanity’s Greatest Challenges.” www.speaker.gov/newsroom/speeches?id=0013 Last accessed on: 14 September 2007.

8. Shermer. M. 2006. “The Flipping Point.” Scientific American 294, 28.

9. Anon. Report FS-1999-06-025-GSFC: Earth’s Energy Balance, NASA: Goddard Space Flight Center Greenbelt, MD.

10. Myhre, G., E. J. Highwood, K. P. Shine and F. Stordal. 1998. “New Estimates of Radiative Forcing Due to Well Mixed Greenhouse Gases.” Geophysical Research Letters 25, 2715–2718.

11. Alley, R., T. Berntsen, N. L. Bindoff, Z. Chen, A. Chidthaisong, et al. “IPCC 2007: Summary for Policymakers.” In: Climate Change 2007: The Physical Science Basis. Cambridge University. http://ipcc-wg1.ucar.edu/wg1/wg1-report.html Last accessed on: 14 September, 2007. See under “WG1 Release”.

12. The IPCC is careful to use “projection” rather than “prediction” to describe what GCMs produce. I.e., the words “predict” or “prediction” do not appear in the SPM of the 4AR. However, “projection” appears 20 times, “scenario” appears 50 times, and the peculiarly apt “storyline” is used 7 times. “Prediction” seems to be the default message for most readers, however.

13. Soon, W., S. Baliunas, S. B. Idso, K. Y. Kondratyev, and E. S. Posmentier. 2001. “Modeling Climatic Effects of Anthropogenic Carbon Dioxide Emissions: Unknowns and Uncertainties” Climate Resear ch. 18, 259–275.

14. Risbey, J. 2002. “Comment on Soon et al. (2001)” Climate Research 22, 185–186; W. Soon, S. Baliunas, S. B. Idso, K. Y. Kondratyev and E. S. Posmentier (2002). Reply to Risbey (2002) Climate Research 22, 187–188; D. J. Karoly, J. f. B. Mitchell, M. Allen, G. Hegerl, J. Marengo, et al. (2003) Comment on Soon et al. (2001) Climate Research 24, 91–92; W. Soon, S. Baliunas, S. B. Idso, K. Y. Kondratyev and E. S. Posmentier (2003). Reply to Karoly et al. (2003) Climate Research. 24, 93–94.

15. One must go into Chapter 8 and especially Ch 8 Supplementary Material in the recently released IPCC 4AR to find GCM errors graphically displayed in W m-2. Figure S8.5, for example, shows that GCM errors in “mean shortwave radiation reflected to space” range across 25 W m-2. The errors in outgoing longwave radiation, Figure S8.7, are similarly large, and the ocean surface heat flux errors, Figure S8.14, minimally range across 10 W m-2. Such forthright displays do not appear in the SPM or in the Technical Summary; i.e., where public bodies are more likely to see them.

16. The Legend of “The Physical Science Basis, Global Climate Projections” WGI analogous Figure 10.4 more cautiously advises that, “uncertainty across scenarios should not be interpreted from this figure (see Section 10.5.4.6 for uncertainty estimates).” However, in 10.5.4.6, it is not reassuring to read that, “*Uncertainty in future temperatures+ results from an expert judgement of the multiple lines of evidence presented in Figure 10.29, and assumes that the models approximately capture the range of uncertainties in

the carbon cycle.” And in WGI Chapter 8 Section 8.1.2.2: “What does the accuracy of a climate model’s simulation of past or contemporary climate say about the accuracy of its projections of climate change? This question is just beginning to be addressed … [T]he development of robust metrics is still at an early stage, [so] the model evaluations presented in this chapter are based primarily on experience and physical reasoning, as has been the norm in the past. (italics added)” That is, there is no validly calculated physical uncertainty limit available for any projection of future global climate.

17. Covey, C., K. M. AchutaRao, U. Cubasch, P. Jones, S. J. Lambert, et al. 2003. “An overview of results from the Coupled Model Intercomparison Project” Global and Planetary Change, 37, 103–133; C. Covey, K. M. AchutaRao, S. J. Lambert and K. E. Taylor. “Intercomparison of Present and Future Climates Simulated by Coupled Ocean-Atmosphere GCMs” PCMDI Report No. 66 Lawrence Livermore National Laboratory 2001 http://www-pcmdi.llnl.gov/publications/pdf/report66/ Last accessed on: 14 September 2007.

18. Dixon, K. R., T. L. Delworth, T. R. Knutson, M. J. Spelman and R. J. Stouffer. 2003. “A Comparison of Climate Change Simulations Produced by Two GFDL Coupled Climate Models.” Global and Planetary Change, 37, 81–102.

19. Houghton, J. T., Y. Ding, D. J. Griggs, M. Noguer, P. J. van der Linden, et al. Climate Change 2001: The Scientific Basis. Chapter 1. The Climate System: An Overview. Section 1.2 Natural Climate Systems, Subsection 1.2.1 Natural Forcing of the Climate System: The Sun and the global energy balance. 2001 http://www.grida.no/climate/ipcc_tar/wg1/041.htm Last accessed on: 14 September 2007 “For the Earth to radiate 235 W m-2, it should radiate at an effective emission temperature of -19° C with typical wavelengths in the infrared part of the spectrum. This is 33° C lower than the average temperature of 14° C at the Earth’s surface.”

20. Inamdar, A. K. and V. Ramanathan. 1998. “Tropical and Global Scale Interactions Among Water Vapor, Atmospheric Greenhouse Effect, and Surface Temperature.” Journal of Geophysical Research 103, 32,177–32,194.

21. Manabe, S. and R. T. Wetherald. 1967. “Thermal Equilibrium of the Atmosphere with a given Distribution of Relative Humidity.” Journal of the Atmospheric Sciences 24, 241–259.

22. Lambert, S. J. and G. J. Boer. 2001. “CMIP1 Evaluation and Intercomparison of Coupled Climate Models.” Climate Dynamics 17, 83–106.

23. Rossow, W. B. and R. A. Schiffer. 1991. “ISCCP Cloud Data Products.” Bulletin of the American Meteorological Society 72, 2–20. Global average cloudiness does not change much from year-toyear. I.e., “Table 3 and Fig. 12 also illustrate how small the interannual variations of global mean values are. … All *the+ complex regional variability appears to nearly cancel in global averages and produces slightly different seasonal cycles in different years.”

24. Gates, W. L., J. S. Boyle, C. Covey, C. G. Dease, C. M. Doutriaux, et al. 1999. “An Overview of the Results of the Atmospheric Model Intercomparison Project.” (AMIP I) Bulletin of the American Meteorological Society 80, 29–55.

25. AchutaRao, K., C. Covey, C. Doutriaux, M. Fiorino, P. Gleckler, et al. 2005. “Report UCRL-TR-202550. An Appraisal of Coupled Climate Model Simulations Lawrence Livermore

National Laboratory.” See Figures 4.11 and 4.12. Especially compare Figure 4.11 with text Figure 3; M. H. Zhang, W. Y. Lin, S. A. Klein, J. T. Bacmeister, S. Bony, et al. 2005. “Comparing Clouds and Their Seasonal Variations in 10 Atmospheric General Circulation Models with Satellite Measurements.” Journal of Geophysical Research 110, D15S02 11–18.

26. Hartmann, D. L. 2002. “Tropical Surprises.” Science, 295, 811–812.

27. Hartmann, D. L., M. E. Ockert-Bell and M. L. Michelsen. 1992. “The Effect of Cloud Type on Earth’s Energy Balance: Global Analysis.” Journal of Climate 5, 1281–1304.

28. Collins, M. 2002. “Climate Predictability on Interannual to Decadal Time Scales: The Initial Value Problem.” Climate Dynamics 19, 671–692.

29. Merryfield, W. J. 2006. “Changes to ENSO under CO2 Doubling in a Multimodel Ensemble.” Journal of Climate 19, 4009–4027.

30. Staudt, A., N. Huddleston and S. Rudenstein. 2006. “Understanding and Responding to Climate Change.” The National Academy of Sciences. http://dels.nas.edu/basc/ Last accessed on: 14 September 2007. The “low-res pdf” is a convenient download.

31. Phillips, T. J., G. L. Potter, D. L. Williamson, R. T. Cederwall, J. S. Boyle, et al. 2004. “Evaluating Parameterizations in General Circulation Models.” Bulletin of the American Meteorological Society 85, 1903–1915.

32. Allen M. R. and D. A. Stainforth. 2002. “Towards Objective Probabilistic Climate Forecasting.” Nature 419, 228; L. A. Smith. 2002. “What Might We Learn from Climate Forecasts?” Proceedings of the National Academy of Science, 99, 2487–2492.

33. This is not the same as a sensitivity analysis in which the effects that variations in GCM parameters or inputs have on climate predictions are compared to observations. In contrast to this, propagating the errors through a GCM means the known or estimated errors and uncertainties in the parameters themselves are totaled up in a manner that quantitatively reflects their transmission through the mathematical structure of the physical theory expressed in the GCM. The total error would then represent the physical uncertainty in each and every prediction made by a GCM.

34. Kriebel, D. J. Tickner, P. Epstein, J. Lemons, R. Levins, et al. 2001. “The Precautionary Principle in Environmental Science.” Environmental Health Perspectives 109, 871–876.

35. Of course, reducing CO2 would likely stop the global greening that has been in progress since at least 1980. The Amazon rainforest alone accounted for 42% of the net global increase in vegetation: R. R. Nemani, C. D. Keeling, H. Hashimoto, W. M. Jolly, S. C. Piper, et al. 2003. “Climate-Driven Increases in Global Terrestrial Net Primary Production from 1982 to 1999.” Science 300, 1560–1563; S. Piao, P. Friedlingstein, C. P., L. Zhou and A. Chen. 2006. “Effect of Climate and CO2 Changes on the Greening of the Northern Hemisphere Over the Past Two Decades.” Geophysical Research Letters 33, L23402 23401–23406.

36. Rising CO2 correlates strongly (r2=0.71) with the greening of the Sahel since 1980, too. SI Section 6.

37. Aldrich, J. 1995. “Correlations Genuine and Spurious in Pearson and Yule.” Statistical Science 10, 364–376. In 1926 G. Udny Yule famously reported a 0.95 correlation between mortality rates and Church of England marriages.

38. On the other hand, the history of Earth includes atmospheric CO2 lagging both glaciations and deglaciations, and large rapid spontaneous jumps in global temperatures without any important changes in atmospheric CO2 and without tipping Earth off into runaway catastrophes. See references for the Dansgaard-Oeschger events, for example: Adams, J. M. Maslin and E. Thomas. 1999. “Sudden Climate Transitions During the Quaternary.” Progress in Physical Geography 23, 1–36; G. G. Bianchi and I. N. McCave. 1999. “Holocene Periodicity in North Atlantic Climate and Deep Ocean Flow South of Iceland.” Nature 397, 515–517; M. McCaffrey, D. Anderson, B. Bauer, M. Eakin, E. Gille, et al. 2003. “Variability During the Last Ice Age: Dansgaard-Oeschger Events.” NOAA Satellites and Information. http://www.ncdc.noaa.gov/paleo/abrupt/data_glacial2.html Last accessed on: 14 September 2007; L. C. Gerhard. 2004. “Climate change: Conflict of Observational Science, Theory, and Politics.” AAPC Bulletin 88, 1211–1220.

39. J. M. Mitchell Jr. 1976 “An overview of climatic variability and its causal mechanisms” Quaternary Research 6, 481–493. Shao, Y. 2002. C. Wunsch 2003 “The spectral description of climate change including the 100 ky energy” Climate Dynamics 20, 253–263. “Chaos of a Simple Coupled System Generated by Interaction and External Forcing.” Meteorology and Atmospheric Physics 81, 191–205; J. A. Rial 2004. “Abrupt Climate Change: Chaos and Order at Orbital and Millennial Scales.” Global and Planetary Change 41, 95–109.

40. Lindzen, R. S. 1997. “Can Increasing Carbon Dioxide Cause Climate Change?” Proceedings of the National Academy of Science, 94, 8335–8342; W. Soon, S. L. Baliunas, A. B. Robinson and Z. W. Robinson. 1999. “Environmental Effects of Increased Carbon Dioxide.” Climate Research 13, 149–164; C. R. de Freitas. 2002. “Are Observed Changes in the Concentration of Carbon Dioxide in the Atmosphere Really Dangerous?” Bulletin of Canadian Petroleum Geology 50, 297–327; C. Essex and R. McKitrick. 2003. “Taken by Storm: The Troubled Science, Policy, and Politics of Global Warming” Key Porter Books: Toronto; W. Kininmonth. 2003. “Climate Change: A Natural Hazard.” Energy & Environment 14, 215–232; M. Leroux. 2005. “Global Warming — Myth or Reality?: The Erring Ways of Climatology”. Springer: Berlin; R. S. Lindzen. 2006. “Is There a Basis for Global Warming Alarm?” In Global Warming: Looking Beyond Kyoto Ed. Yale University: New Haven, in press. The full text is available at: http://www.ycsg.yale.edu/climate/forms/LindzenYaleMtg.pdf Last accessed: 14 September 2007.

Quelle: http://www.skeptic.com/the_magazine/featured_articles/v14n01_climate_of_belief.html

Related Files