Das ist furchtbar. Niemand hier hat die Schwere der Krankheit oder gar ihre Existenz geleugnet. Aber die Wahrscheinlichkeit, sich als einer von 83 Millonen in Deutschland länger oder kürzer hier Lebenden überhaupt zu infizieren, liegt bei unter einem Prozent. Und diese Dimension respektive Verhältnismäßigkeit hat kaum jemand im Auge.

Wenn es denn jemals eine gab, war die Strategie der Politik jedenfalls nicht zielführend. Und das scheint nahezu ein weltweites Phänomen zu sein. Die Regierungen handeln kopflos und panisch. Angst regiert die Welt. Und ein schlechter Ratgeber laut Volkes Munde. Was muss man tun, damit sich derlei nicht wiederholt? Damit meine ich ausdrücklich nicht ein neues Virus, sondern die fast schon

n verantwortungslose, hektische Reaktion auf eine beherrschbare oder vermeintliche Notlage.

Wir haben es ja nicht nur in Sachen Corona mit diesem Phänomen zu tun. Wenn die bestenfalls pubertierende 16-jährige Greta Thunberg vor den Vereinten Nationen heraus schreit, “I want you to panic”, bringt sie das Konzept der Drohung mit dem modernen Fegefeuer auf den Punkt. Und der mittlerweile unvermeidliche Karl Lauterbach erklärt schon in DIE WELT, dass vergleichbare Einschränkungen zur Rettung des Klimas notwendig seien. Nicht nur bei der Pandemie.

Bei der Finanz- und Eurokrise hat Bundeskanzlerin Merkel das Thunberg-Prinzip vorweg genommen: “Scheitert der Euro, scheitert Europa”. Als ob wegen des Untergangs einer Währung ein Kontinent untergehen könnte. Das haben zwei Weltkriege nicht geschafft und auch wegen des “menschengemachten Klimawandels” wird er nicht absaufen. Die Politik agiert mit den Methoden des digitalen Mittelalters. Angst essen nicht nur Seele auf. sondern auch Verstand. Und das macht einen faktenbasierten Diskurs, der auf Emotionalisierung und Personalisierung verzichtet, unmöglich. Wenn wichtiger ist, wer etwas sagt und nicht was, läuft gehörig etwas schief. Mittlerweile sind Augenmaß und Verhältnismäßigkeit vollends verlorengegangen.

Das Erkenntnisproblem der selektiven Wahrnehmung

Arthur Schopenhauer hat sein Hauptwerk “Die Welt als Wille und Vorstellung” genannt und wurde damit zum Gründungsvater des Konstruktivismus. Dessen Protagonist Paul Watzlawick (“Anleitung zum Unglücklichsein”), österreichisch-amerikanischer Psychologe und Kommunikationsforscher, spricht davon, dass wir nur erkennen, was wir erwarten. Einen Widerspruch übersehen wir allzu leicht, weil er nicht in unser “Weltbild” passt. Man kann es aber auch mit Astrid Lindgrens Pippi Langstrumpf sagen: “Ich mach mir die Welt, wie sie mir gefällt.”

Der Schlüssel, sein Weltbild der Realität auszusetzen, sind Aufklärung und kritischer Rationalismus. “Aufklärung ist der Ausgang des Menschen aus einer selbstverschuldeten Unmündigkeit.” So beginnt Immanuel Kant sein Manifest und meint damit, dass wir denken müssen und nicht bloß glauben dürfen. Er ordnet die Verantwortung dafür dem Bürger zu und nicht dem Potentaten. Die Stürmer und Dränger und die Aufklärer haben den Absolutismus vertrieben und die Grundlagen für den freiheitlichen Rechtsstaat, die moderne Wissenschaft, den technologischen Fortschritt und den sukzessive wachsenden Wohlstand der Industriegesellschaft gelegt.

Wir müssen uns also an die eigene Nase fassen und fragen, warum wir nicht im Kleinen den Diskurs fördern, unter Freunden und Bekannten Stellung beziehen und unseren Zweifel äußern. Auf Wissenschaft, Politik und Medien alleine zu zeigen, ist nicht ausreichend.

Man kann es Greta Thunberg nicht übelnehmen, dass sie laut hinausposaunt: “Hört auf die Wissenschaft”. Was sie meint, bedeutet: Glaubt der und glaubt an die Wissenschaft”. Aber wer ist “die Wissenschaft”?

Wissenschaft ist der aktuelle Stand des Irrtums

Das kann keiner wissen, denn die Wissenschaft ist nicht als homogene Institution existent. Wer hier auf die Mehrheitsmeinung pocht, hat das Prinzip nicht verstanden. Wissenschaft ist Wettbewerb um die beste Erklärung. Und Naturwissenschaft ist genauso wenig vom Irrtum gefeit wie die Geisteswissenschaften oder die ökonomischen Wissenschaftler. Natürlich bis auf die physikalischen Gesetze wie das der Schwerkraft, dass sich jederzeit experimentell wiederholen lässt. Würde Wissenschaft konsensbasiert arbeiten, käme die Entdeckung neuen Wissens zum Erliegen.

Um mit Karl Popper zu sprechen: Nichts ist wahr. Alles darf nur solange als bewährt gelten, bis es widerlegt ist. Wenn wir heute also davon sprechen, dass wir die Durchschnittstemperatur auf der Erde im Jahre 2050 vorhersagen könnten, und ein Getriebe entwerfen, mit dessen Zahnrädern wir sie so einstellen könnten wie mit dem Thermostat im heimischen Wohnzimmer, unterliegen wir einem gewaltigen Irrtum und der Anmaßung, den wissenschaftlichen und technischen Fortschritt bis auf die erste Stelle hinter dem Komma prognostizieren zu können.

Ähnlich verhält es sich mit den Prognosen zur Pandemie. Der “R-Faktor” ist eine geschätzte Modellierung, die wie auch die ökonomischen Prognosen auf eine simple Formel zurückgehen, wenn man sie zu Ende differenziert hat. Und die heisst: Pi mal Daumen.

Die normative Kraft der Zahl

Würde man den „R-Faktor“ im Nachhinein mit dem tatsächlichen Infektionsgeschehen vergleichen, was eine komplexe mathematische Operation ausmacht, so wette ich, dass er mit der tatsächlichen Infektionsentwicklung nicht korrealiert. Anders gesagt: Die Modellierungen sind nicht mal für die Katz. Aber einmal von Professor Doktor Lothar H. Wieler auf einer Pressekonferenz vorgetragen und live über die Nachrichtenkanäle und die Social Media verbreitet, steht eine Zahl im Raum und sei sie noch so infiziert. Am 18. März hat der Mann verkündet, ohne Lockdown sei spätestens im Juni 2020 mit 10 Millionen Infizierten zu rechnen. Nur in Deutschland.

Um bei der Bevölkerung Eindruck zu schinden, arbeitet die CORONA-Statistik bei Wieler, Funk und Fernsehen mit dem Instrument der Kumulation. Es wird nicht dargestellt, wie viele Menschen derzeit positiv getestet sind und als infiziert gelten, wie viele so schwer erkrankt sind, dass sie das Krankenhaus aufsuchen mussten, lediglich die Zahl derjenigen, die sich auf Intensivstation befinden oder dort beatmet werden, wird tagesaktuell kommuniziert. Auch die Zahl der täglich Verstorbenen wird als Addition zu den in den vergangenen 9 Monaten genannt. Das ist die Macht der hohen Zahl. Alles erscheint viel schrecklicher.

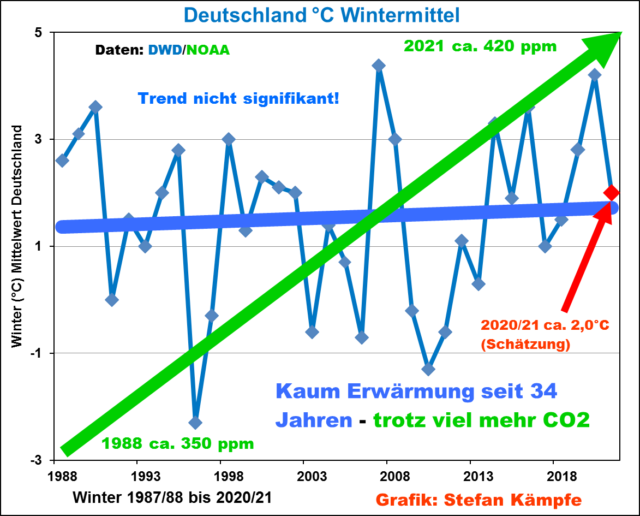

Steht die Zahl einmal im Raum, so verbreitet sie Angst und Schrecken. Das gleiche Prinzip funktioniert ja auch schon bei der globalen Durchschnittstemperatur oder den vermeintlichen CO2-Emissionen, die werden auch im Nachhinein nicht gemessen (wie sollte das funktionieren?), sondern geschätzt. Und das vom Bundesumweltamt.

Wie gut solche Vorhersagen funktionieren, kann man alljährlich an den Steuerschätzungen beobachten. Ähnlich wie bei den Voraussagen der Wahlergebnisse durch die Demoskopen lässt sich mit Sicherheit nur eins prognostizieren: Sie werden so nicht eintreffen. Entweder verschätzt man sich um ein paar Milliarden oder ein paar Prozent. Und je früher die Prognosen, desto diffuser das Bild. Aber das mit der Durchschnittstemperatur, bei der noch Milliarden weitere Parameter berücksichtigt werden müssen, das kriegen wir angeblich hin.

Wenn die Zahl allerdings zu positiv ausfällt und nicht in das jeweilige Schreckensszenario passt, wird sie nicht genannt. Deutschland wird Ende 2020 – und das wäre auch ohne Corona geschehen – im Vergleich zum Stand 1990 etwa 40 Prozent der Klimagase eingespart haben. 2019 waren es ja bereits schon mehr als 38 Prozent (da gibt es unnterschiedliche Aussagen – es handelt sich ja um Schätzzahlen). In Kyoto hatten wir uns zu 35 Prozent verpflichtet. Es besteht also kein Grund zur Panik.

Zahlen suggerieren eine Objektivität, die sie nicht haben. Es handelt sich nicht um das Ergebnis höherer Mathematik, sondern letztlich um Formeln, Modellierungen und Erklärungsmodelle, denen das unvollständige Wissen derjenigen zugrunde liegt, die sie formulieren und entwickeln. Ich bestreite gar nicht, dass solche Prognosen ihren Wert haben und sie einen Trend indizieren. Nur für bare Münze darf man sie nicht nehmen.

Die Macht der Bilder

Können Sie sich noch an die Bilder aus Bergamo erinnern? Kein Regisseur eines Katastrophenfilms hätte sich das besser ausdenken können. Martialische Militär-Lastwagen transportierten wie Lafetten jeweils einen Sarg, obwohl auch ein paar mehr auf die Pritsche gepasst hätten. Die Prozession der Fahrzeuge mit mindestens 7,5 Tonnen Transportgewicht wurde dabei abgelichtet, wie sie in angemessen langsamer Geschwindigkeit durch die menschenleeren Landstriche Norditaliens rollte. Was für ein Bild für eine Pandemie.

Es gab in Norditalien dramatische Verhältnisse und eine deutliche Übersterblichkeit (also mehr Sterbefälle als im üblichen Vergleichszeitraum). Aber die meisten leider Verstorbenen waren schon damals über 80 Jahre alt und hatten mindestens eine Vorerkrankung. Die Pandemie hat ihnen, wenn man das despektierlich ausdrücken möchte, den Rest gegeben. Und während die Ärzte auf den Intensivstationen in Bergamo und Mailand bis zum Umfallen kämpften, standen die Intensivbetten in Neapel leer. Wie wäre die Wahrnehmung der Pandemie wohl ohne die Bilder von den überfüllten Intensivstationen und die LKW-Kolonnen verlaufen? Und hätten die Regierungen europaweit genauso reagiert?

Die “Bilder” haben auch bei einem anderen Thema eine Rolle gespielt. Ich meine nicht den berühmten Satz des Moderators eines Nachrichtensenders auf den Unfall in Fukushima, der, um die Zuschauer über die Werbepause bei der Stange zu halten, sagte: “Und nach der Werbepause sehen Sie hier die Kernschmelze” (aus dem Gedächtnis zitiert).

Die Grenzen wurden nach Angaben des Welt-Journalisten Robin Alexander in seinem Buch im September 2015 nicht aus humanitären Gründen offen gehalten, sondern weil man die dabei entstehenden “Bilder”, für nicht “vermittelbar” hielt. Es ging also nicht um humanitäre Gründe, sondern um den Machterhalt.

Deshalb war das Abkommen mit der Türkei folgerichtig, das möglichst viele “Geflüchtete” zurückhalten sollte. Die haben da die Kamerateams und Fotografen unter Kontrolle. Und wovon es keine Bilder gibt, das passiert in der Wahrnehmung von Politik und Medien gar nicht. Ob die Menschen und Bürger das auch immer so sehen, lassen wir mal dahingestellt.

Der Schrecken des Todes

Sterben war bisher eine private Angelegenheit. Zwar taten die Angehörigen ihre Trauer in Anzeigen oder mittlerweile den sozialen Medien kund, luden zu Trauerfeier, Beerdigung und Leichenschmaus ein, aber eben doch nicht jedermann, sondern nur diejenigen, die am Tod des jeweiligen Menschen Anteil nahmen.

Die einzigen Zahlen von Todesopfern, die mir regelmäßig über den Weg liefen, sind die kolportierten der Verkehrstoten. Das sind bedauernswerte mehr als 3.000 Menschen zuviel. Aber wohl der Preis für unsere Mobilität.

In den deutschen Medien wird stets die Zahl aller jemals an oder im Zusammenhang mit dem Virus Verstorbenen genannt. Das sind seit März mehr als 30.000 Menschen. Auch hier war die absolute Mehrheit über 80 Jahre alt und litt unter einer oder mehreren Vorerkrankungen. Aber in Deutschland sterben jedes Jahr mehr als 900.000 Menschen. Eine Zahl, die vorher niemand kannte und von Lothar Wieler, dem Präsidenten des Robert-Koch-Instituts in seinen bedeutungsschwangeren Pressekonferenzen nie genannt wurde. Täglich sterben im Schnitt rund 2.572 Menschen (Wie gesagt beim Straßenverkehr sind das mehr als 3.000 im Jahr). Wenn am Tag 1.000 Menschen an oder mit dem CORONA-Virus sterben, sind das rund 39 Prozent der täglich Sterbenden. Wenn im Monat rund 77.500 Menschen sterben, sind das 697.500 von März bis April. Davon machen die bedauernswerten rund 30.000 Toten unter 5 Prozent aus.

Mit den vermeintlich offiziellen Zahlen wird Angst geschürt und Panik gemacht. Sie sollen die Ausrufung der “Pandemie von nationaler Tragweite” begründen und damit den Zweck des vollständigen Entzug der Bürgerrechte rechtfertigen. Es ist nicht auszuschließen, dass ihre Erzeuger selber glauben, was sie verkünden.

Das Wort der Propheten

Wussten Sie vor einem Jahr, wer Prof. Dr. Christian Drosten ist? Heute wissen wir: Der Mann trägt schwer das vermeintliche Wissen der weltweiten Virologie auf seinen Schultern. Sein Ruf verhallt nicht ungehört. Schon gar nicht bei der Kanzlerin. Wenn es nötig wird, bestellt sie ihn in die Ministerpräsidentenrunden ein, um die unwilligen Landesfürsten mit einem Blick in den Corona-Abgrund zu disziplinieren. In einem eigenen von den Rundfunkgebühren finanzierten Podcast verbreitet er diesen Blick auch über den reichweitenstarken NDR ohne ausreichende journalistische und wissenschaftliche Kontrolle.

Statt auf die Corona-Propheterie zu vertrauen, hätten Kanzler wie Helmut Schmidt, Helmut Kohl oder auch Gerhard Schröder anders gehandelt. Schmidt hat etwa bei der Schleyer-Entführung einen Krisenstab einberufen, der über Wochen tagte und die Vielfalt der Argumente auf den Tisch des Bonner Kanzleramts brachte. Darin vertreten war auch der Oppositionsführer Helmut Kohl und die Fraktionsvorsitzenden, die nicht im Nachhinein vom Ergebnis obskurer Video-Konferenzen “unterrichtet” wurden.

Nicht anders ist es etwa mit Professor Hans Joachim Schellnhuber und dessen Potsdamer Institut für die Klimafolgenabschätzung. Zwar ist der Mann mittlerweile im Ruhestand, doch Propheten lassen sich nicht pensionieren. Man könnte diese Art von Wissenschaftlern wahlweise Propheten oder Hofalchemisten nennen, die scheinbar alleine im Besitz der allgemeingültigen Wahrheit zu sein scheinen. Die haben früher Gold versprochen und wenigstens Porzellan geliefert. Zweifelhafte Organisationen wie die Leopoldina, die vorher abseits des Lichtes der Öffentlichkeit operiert hatten, liefern Politik und Kanzlerin allzu gerne die Begründung für den ein oder anderen Lockdown. Das unterminiert Vertrauen.

Das multiple Organversagen der Medien

Aus falsch verstandenem Verantwortungsgefühl hat sich bei den Medien spätestens seit der Finanzkrise ein vorauseilender Gehorsam eingeschlichen, der kontroverse Diskussionen und die Abbildung von Meinungspluralismus nur noch in Ausnahmefällen erlaubt. Daraus ergibt sich eine merkwürdige Konsistenz, die über die Bildschirme flackert und aus den Lautsprechern quillt. Gefangen sind die Medienmacher dabei in einer Hatz, die den meisten von ihnen die Chance zur Reflektion und Einordnung nimmt. Beim Nutzer wird diese Hektik durch den Algorithmus verschärft, eine Art mediales Schneeballsystem: Was viele sehen, bekommen noch mehr zu sehen. Dabei wird die mediale Fertigsoße immer gleichförmiger.

Medien stoßen kaum noch Kontroversen an und bilden sie auch nicht ausreichend ab. Außenseiter werden zu “Leugnern” erklärt und oft persönlich diskreditiert, statt ihre Auffassung sachlich zu widerlegen, wenn dies denn nötig und möglich ist. Das Unvermögen mit der Informationsflut der sozialen Netzwerke schafft Begriffe wie “Hatespeech” oder “Fakenews”, mit denen auch Argumente aussortiert werden, die tatsächlich bedenkenswert waren. Das über Jahrhunderte erkämpfte Prinzip der Meinungsfreiheit wird so geschleift. An die Stelle ordentlicher Gerichte sind Laien und Algorithmen getreten. Das Phänomen des vorauseilenden Gehorsams wird so manifestiert.

Natürlich brauchen Politiker, Wissenschaftler und Medienleute Vernunft im Kantschen Sinne. Und dafür braucht es Mut. Und der ist nötig, um ein mögliches Medientrommelfeuer durchzustehen. Betrachtet man den zarten Virologen Hendrik Streeck, dessen empirische Studien geeignet gewesen sind, die Lockdown-Strategen zu widerlegen und wie er angefeindet wurde, versteht man, wovon die Rede ist. Ein Wissenschaftler, der den möglichen menschlichen Einfluß auf das Klima nicht für bestimmmend hält, kann in den Augen der Meute, gar keiner sein. Aber es gibt diesen Mut der Vernunft.

Aber wir lassen ihn oft genug allein. Weil wir selber nicht besser sind als 709 Bundestags- und 1.886 Landtagsabgeordnete, über deren Linientreue wir uns so gern ereifern, und die Talk-Show-Unterhalter, über die wir uns bestenfalls auf der Couch mokieren. Vielleicht sollten die Bürger, egal ob liberal oder konservativ, darüber nachdenken, dass der Prozess, der zur Veränderung führt, unten beginnt. Und nicht von oben. Bevor man die Angst vertreibt, darf man selbst keine haben und sich auch keine machen lassen. Sich auf sein eigenes Urteil zu verlassen und das für recht und richtig Erkannte durchzusetzen, ist als guter Vorsatz womöglich weiterführender, als auf eine Impfung zu hoffen. Gegen die Vernunft sind schon zu viele immun. In diesem Sinne auf ein gutes Neues Jahr.

Der Beitrag erschien zuerst bei ACHGUT hier

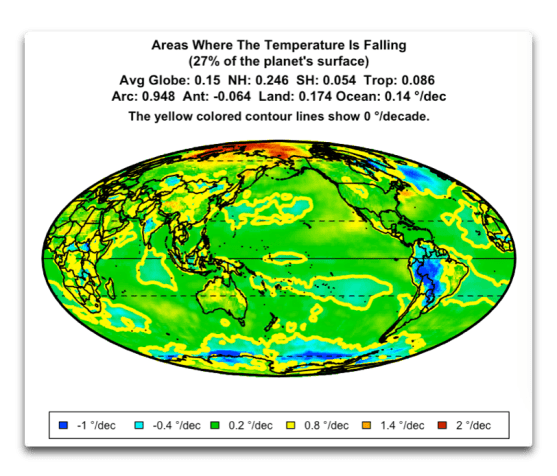

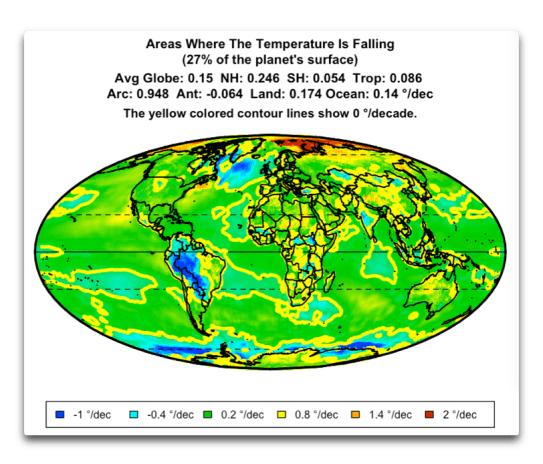

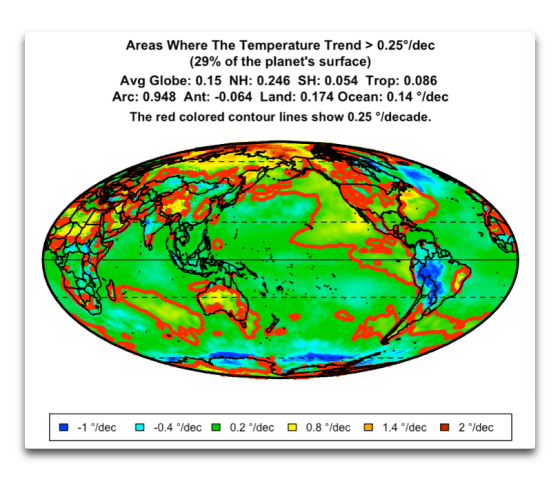

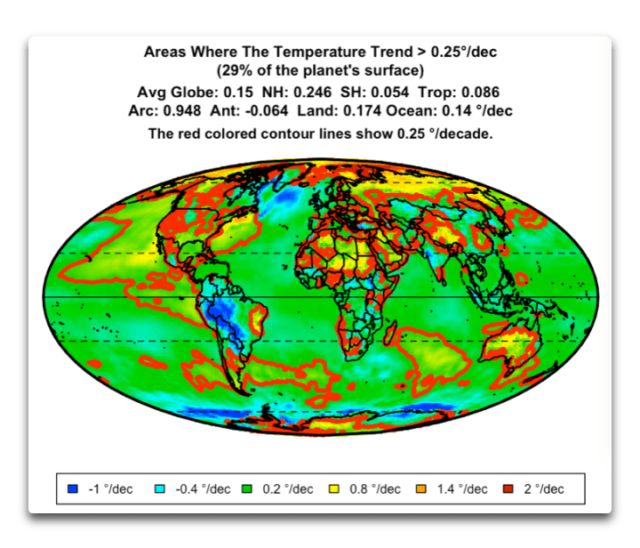

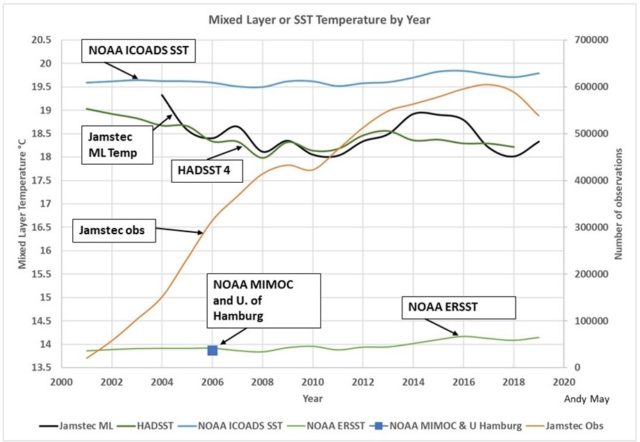

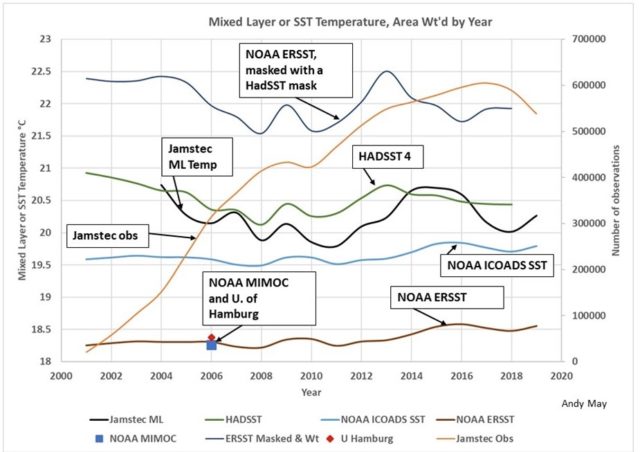

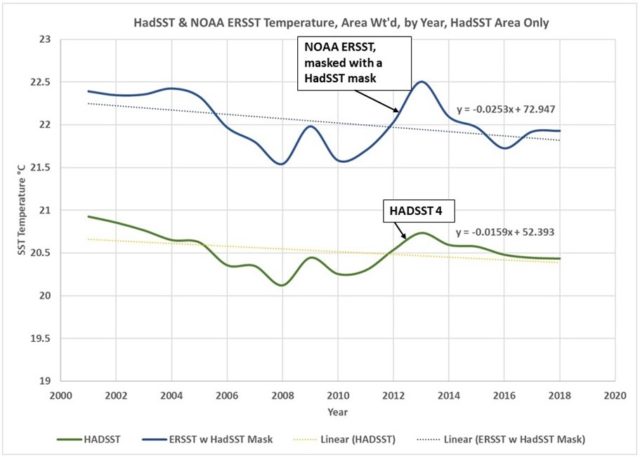

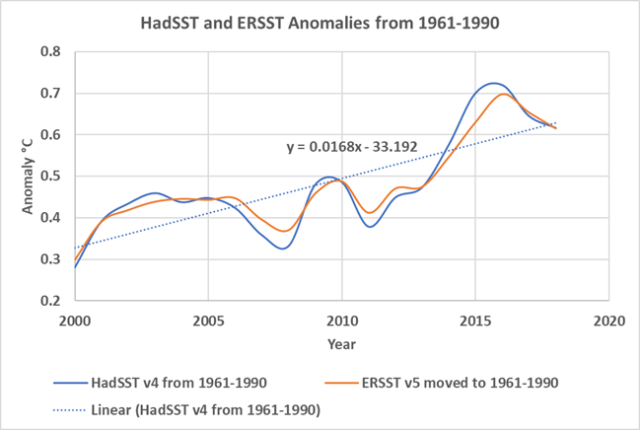

Frage von Marcel Crok: Was schließen Sie aus Ihrer Abbildung 3? Wollen Sie damit sagen, dass die besten verfügbaren Daten darauf hindeuten, dass die Ozean-Temperatur abnimmt?

Antwort von Andy May:

Die allerbesten Daten sind in dieser Abbildung dargestellt. Aber sie repräsentiert nur einen Teil des Weltozeans, und das dargestellte Gebiet ändert sich ständig. Dieser sich ständig verändernde Bereich zeigt sinkende gemessene Temperaturen. Die Schiffe, Schwimmer und Bojen, die die Temperatur messen, sind ständig in Bewegung und verändern sich in jeder Zelle. Die Zellen mit Messungen ändern sich ständig. Die „Referenz“-Periode, zwischen 1961-2000, hat sehr schlechte Daten.

Die einzige Möglichkeit, mit diesen miserablen Daten eine positive Anomalie zu erhalten, besteht darin, monatliche Anomalien aus den Zellen mit vielen Messpunkten in diesem Monat zu erstellen und sie dann als einen Datensatz zu präsentieren. Aber es ist eine Aufzeichnung eines sich ständig ändernden Bereichs, was nützt das?

Weniger als die Hälfte des Ozeans hat gute Daten und diese Hälfte ändert sich ständig, da sich die Instrumente und Schiffe bewegen. Ich habe nur einen Jahresdurchschnitt gebildet, um saisonale Anomalien zu vermeiden. So ist die jährliche Durchschnittstemperatur der Zellen mit den besten Daten (wo auch immer sie sind) in den letzten 20 Jahren gesunken. Dies wurde in den letzten Stunden von Nick Stokes, einem australischen Klimatologen bei den WUWT-Kommentaren bestätigt.

Das Erzeugen von Anomalien, insbesondere die Art und Weise, wie HadSST und ERSST es getan haben, entfernt die gesamte zugrundeliegende Komplexität in den Daten und präsentiert eine irreführende Grafik, die auf sehr, sehr schlechten und nicht repräsentativen Daten basiert.

Meine persönliche Schlussfolgerung nach all dieser Arbeit? Wir haben keine Ahnung, was die durchschnittliche Temperatur des Weltozeans ist, noch wissen wir, ob er sich erwärmt oder abkühlt.

[Hervorhebung vom Übersetzer]