Die arktische Eisausdehnung zum Jahresende 2020

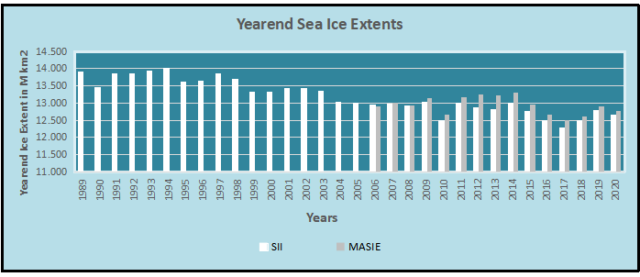

Das obige Diagramm zeigt den verfügbaren Datensatz des Meereisindex (Sea Ice Index SII) seit 1989, zusammen mit dem vergleichbaren Datensatz von MASIE 2006 bis heute. Es zeigt, dass 2020 um 150k km2 (1 %) niedriger ist als 2019 und 300k km2 über dem Tiefstwert von 2017 liegt. Tatsächlich ist 2020 fast der Durchschnitt für das letzte Jahrzehnt.

Wie bereits in einem früheren Beitrag erwähnt, wurden im Oktober Befürchtungen geäußert, dass die Arktis langsamer als im Durchschnitt wieder zufriert. Diese Befürchtungen wurden erstens durch den Anstieg der Eisausdehnung im November und zweitens durch das schnelle Gefrieren der Arktis im Dezember ausgeräumt. Im November wurden 3,5 Wadhams Meereis im Laufe des Monats hinzugefügt. (Die Metrik 1 Wadham = 1 Million km² stammt von den Vorhersagen des Professors über eine eisfreie Arktis, was weniger als 1 Million km² Ausdehnung bedeutet). Im Dezember kamen weitere 2,7 Wadhams hinzu. Die letzten beiden Monate haben das Defizit im Oktober mehr als ausgeglichen.

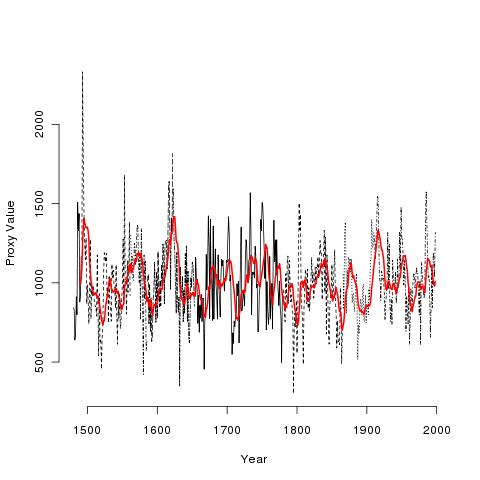

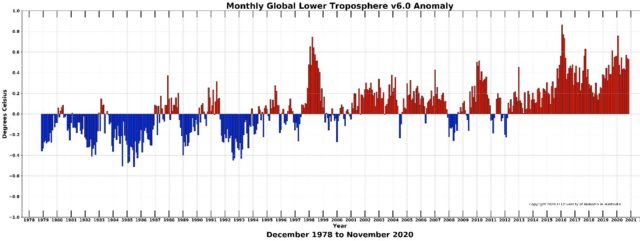

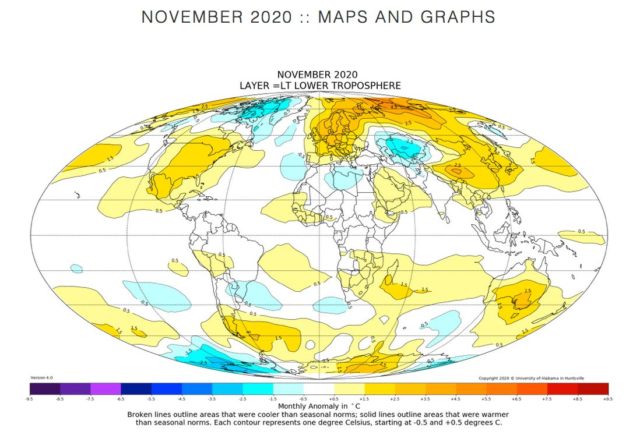

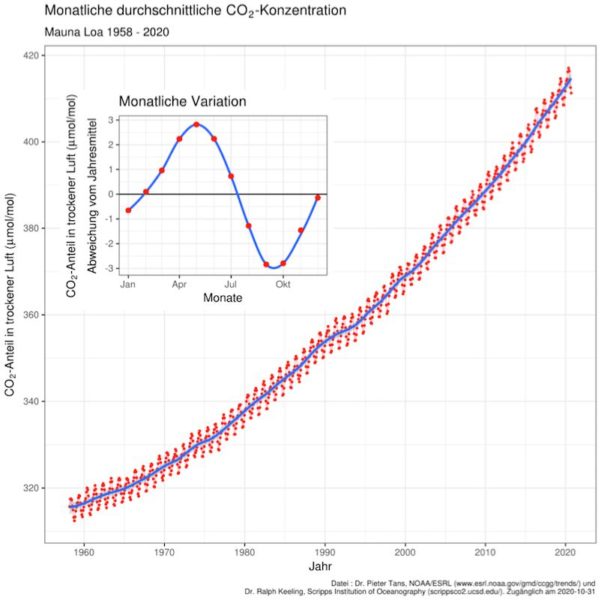

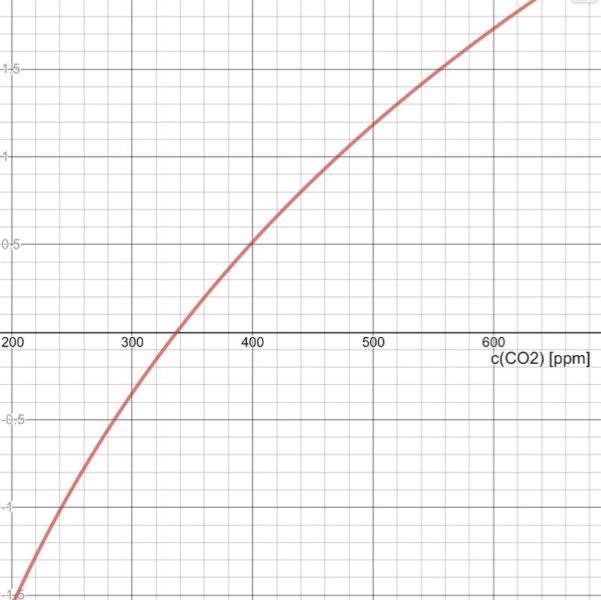

Als ich vor einigen Jahren einen Beitrag über die globale Erwärmung bei WUWT las, fiel mir der Kommentar einer Person auf: „Ich bin Versicherungsmathematiker mit begrenztem Wissen über Klimametriken, aber es scheint mir, wenn man Temperaturänderungen verstehen will, sollte man die Änderungen analysieren, nicht die Temperaturen“. Das ließ bei mir die Alarmglocken läuten, und ich wandte diese Einsicht in einer Reihe von Temperatur-Trend-Analysen von Temperaturaufzeichnungen von Oberflächenstationen an. Diese Beiträge sind unter dieser Überschrift verfügbar: Climate Compilation Part I Temperatures.

In diesem Beitrag wird versucht, die Schwankungen des arktischen Meereises mit einem ähnlichen Ansatz zu verstehen: Der Schwerpunkt liegt auf den Raten der Ausdehnungsänderungen und nicht wie üblich auf der Untersuchung der Eisausdehnung selbst. Glücklicherweise bietet der Sea Ice Index (SII) der NOAA einen geeigneten Datensatz für dieses Projekt. Wie viele wissen, stützt sich der SII auf passive Mikrowellensensoren von Satelliten, um Karten der arktischen Eisausdehnung zu erstellen, die bis ins Jahr 1979 zurückreichen. Die aktuelle Version 3 hat sich stärker an MASIE, der modernen Form der Marine-Eiskartenerstellung zur Unterstützung der arktischen Navigation, angelehnt. Wie man die SII-Daten lesen muss, steht hier.

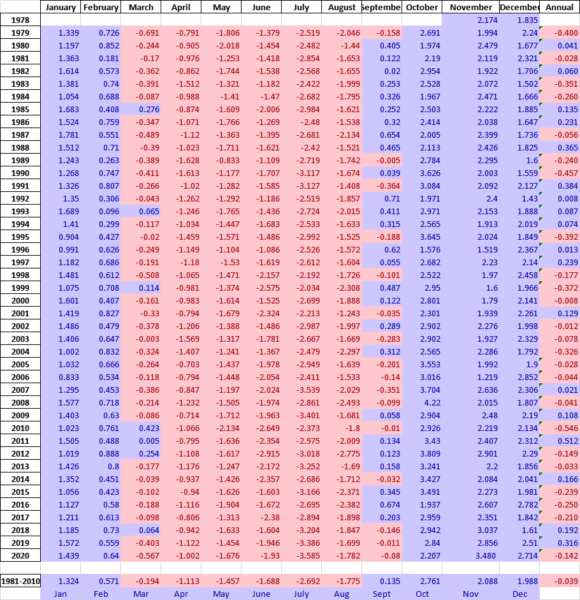

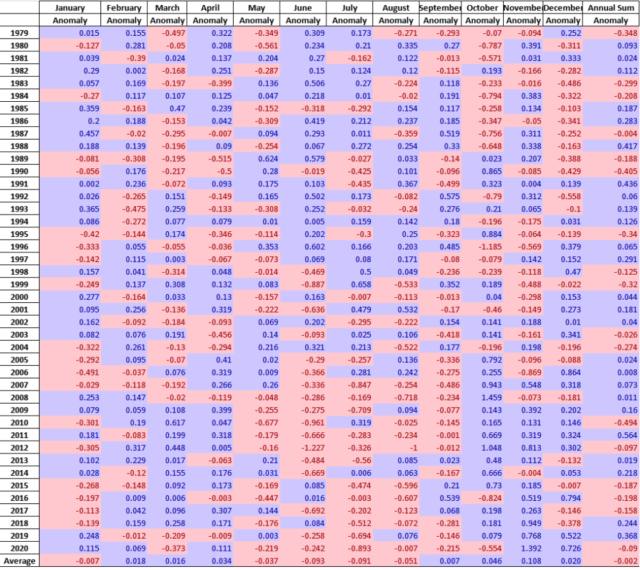

Es sind statistische Analysen verfügbar, und diejenige, die von Interesse ist (Tabelle unten), heißt Sea Ice Index Rates of Change (hier). Wie der Titel schon andeutet, besteht diese Tabelle nicht aus monatlichen Ausdehnungen, sondern aus Änderungen der Ausdehnungen gegenüber dem Vormonat. Konkret wird ein Monatswert berechnet, indem der Durchschnitt der letzten fünf Tage des Vormonats vom Durchschnitt der letzten fünf Tage dieses Monats subtrahiert wird. Der Wert stellt also die Menge an Eis dar, die während des aktuellen Monats zu- oder abgenommen hat.

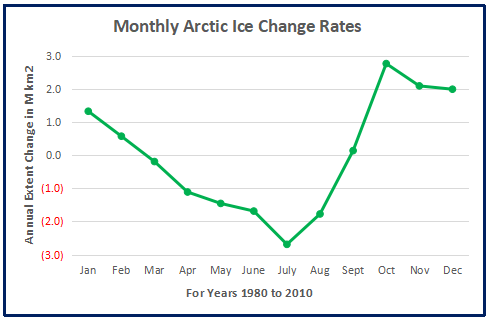

Diese monatlichen Änderungsraten wurden zu einer Basislinie für den Zeitraum 1980 bis 2010 zusammengestellt, die die Schwankungen der arktischen Eisausdehnung im Laufe eines Kalenderjahres zeigt. Unten ist ein Diagramm dieser durchschnittlichen monatlichen Veränderungen während des Basiszeitraums zu sehen. Diejenigen, die mit Studien zum arktischen Eis vertraut sind, werden von der Wellenform des Vorzeichens nicht überrascht sein. Ende Dezember ist ein relativ neutraler Punkt im Zyklus auf halbem Weg zwischen dem Minimum im September und dem Maximum im März.

Die Grafik verdeutlicht die sechs Frühjahrs-/Sommermonate mit Schmelzen und die sechs Herbst-/Wintermonate mit Gefrieren. Man beachte, dass Juni-August den Großteil der Verluste produzieren, während Oktober-Dezember den Großteil des Zuwachses zeigen. Auch die Maximum- bzw. Minimum-Monate März und September zeigen von Anfang bis Ende nur sehr geringe Änderungen in der Ausdehnung.

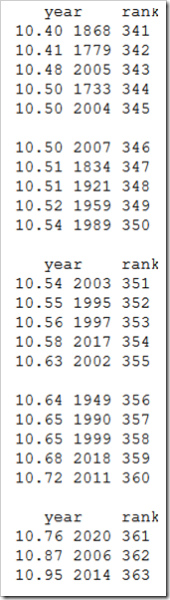

Die Tabelle der monatlichen Daten zeigt die Variabilität der Eisausdehnung während der letzten 4 Jahrzehnte:

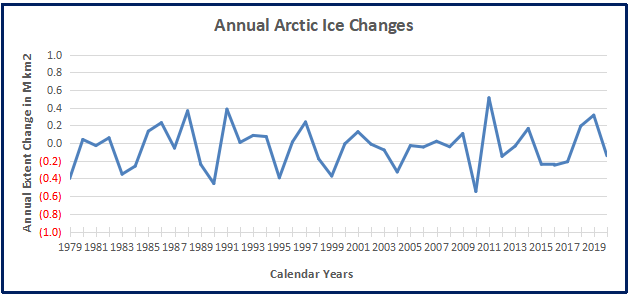

Die Werte im Januar zeigen die Veränderungen gegenüber dem Ende des vorangegangenen Dezembers, und durch Summierung von zwölf aufeinanderfolgenden Monaten können wir eine jährliche Veränderungsrate für die Jahre 1979 bis 2019 berechnen:

Wie viele wissen, hat die Eisausdehnung in der Arktis in diesen 40 Jahren abgenommen, im Durchschnitt um 40.000 km² pro Jahr. Aber Jahr für Jahr wechseln die Veränderungen ständig zwischen Schrumpfen und Wachsen.

Außerdem scheint es Zufall zu sein, welche Monate für ein bestimmtes Jahr ausschlaggebend sind. Zum Beispiel wurde viel Aufhebens darüber gemacht, dass die Eisausdehnung im Oktober 2020 langsamer als erwartet zunahm. Wie es in diesem Datensatz der Fall ist, weist der Oktober die höchste Rate der Eiszunahme auf. Die folgende Tabelle zeigt die verschiedenen monatlichen Raten in der Aufzeichnung als Anomalien gegenüber der Basislinie 1980-2010. In dieser Darstellung ist eine rote Zelle eine negative Anomalie (weniger als die Basislinie für diesen Monat) und blau ist positiv (höher als die Basislinie).

Man beachte, dass die +/- Kursanomalien sind über das gesamte Netz verteilt sind, Sequenzen verschiedener Monate in verschiedenen Jahren, wobei sich Gewinne und Verluste gegenseitig ausgleichen. Ja, der Oktober 2020 verzeichnete einen unterdurchschnittlichen Zuwachs, aber einen höheren als 2016. Der Verlust im Juli 2020 war der größte in diesem Jahr wegen des heißen sibirischen Sommers. Außerdem beachte man, dass die Anomalie des Eiszuwachses im November 2020 die Anomalie des Defizits im Oktober um mehr als das Doppelte überstieg. Der Dezember fügte mehr Überschuss hinzu, so dass die Anomalie für das Jahr Null war. Die untere Zeile zeigt die durchschnittlichen Anomalien für jeden Monat über den Zeitraum 1979-2020. Die Raten der Gewinne und Verluste gleichen sich größtenteils aus, und der Durchschnitt aller Monate in der unteren rechten Zelle ist praktisch Null.

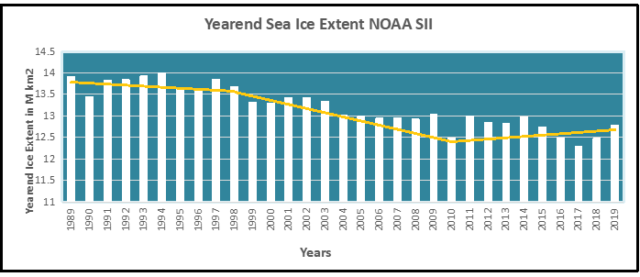

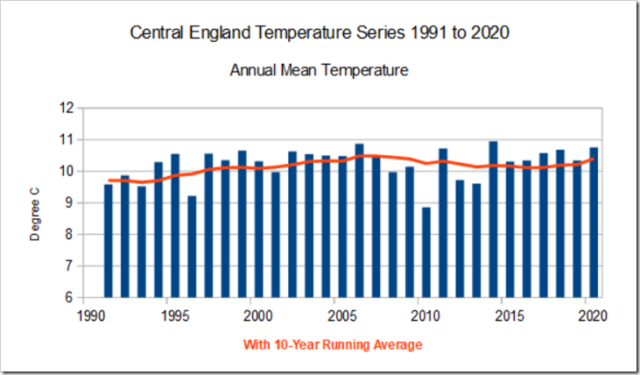

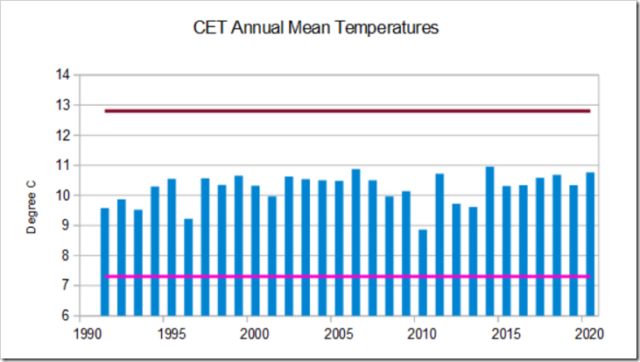

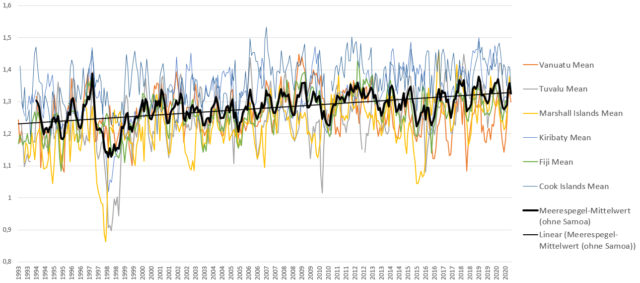

Eine letzte Betrachtung: Die Grafik unten zeigt die Jahresend-Eisausdehnung der Arktis für die letzten 30 Jahre.

Hinweis: Die tägliche SII-Eisausdehnungsdatei liefert keine vollständigen Werte vor 1988.

Die Eisausdehnung am Jahresende in der Arktis (die letzten 5 Tage im Dezember) zeigt drei verschiedene Regimes: 1989-1998, 1998-2010, 2010-2019. Die durchschnittliche Ausdehnung am Jahresende 1989-2010 betrug 13,4 Mio. km². In der letzten Dekade lag sie bei 13,0 Mio. k², und zehn Jahre später, 2019, bei 12,8 Mio. km². Bei all den Schwankungen betrug der Nettoverlust also 200k km² oder 1,5%. Das Gerede von einer Todesspirale des arktischen Eises ist Phantasterei.

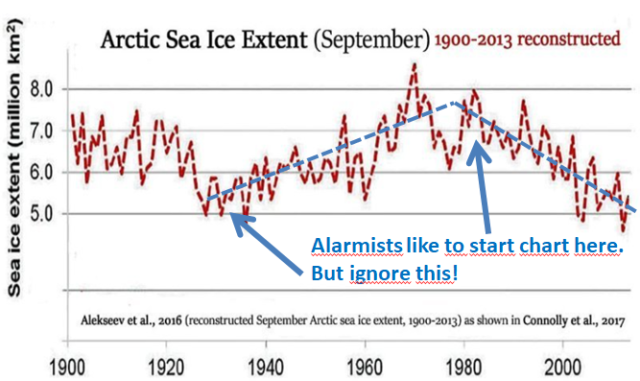

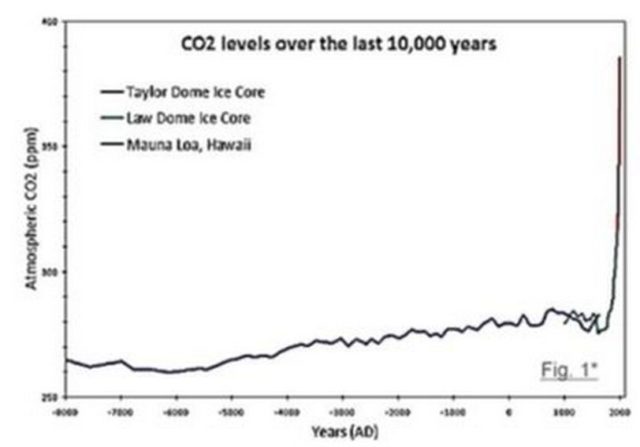

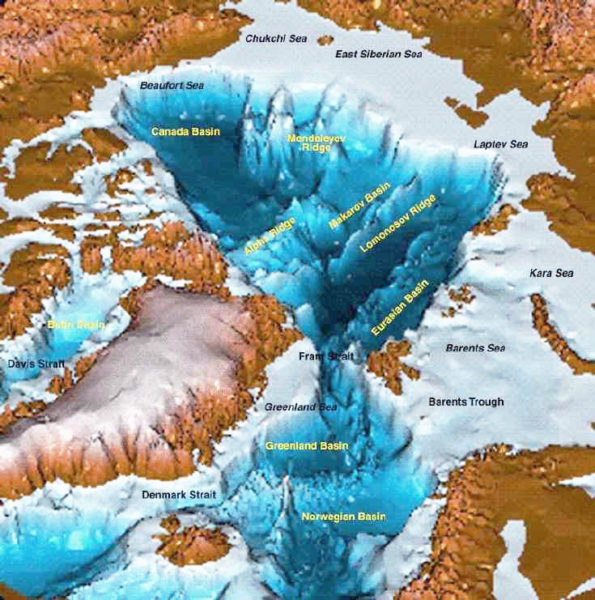

Diese Daten zeigen ein höchst variables Naturphänomen. Es ist klar, dass unvorhersehbare Faktoren im Spiel sind, vor allem die Wasserstruktur und -zirkulation, atmosphärische Zirkulationen und auch Umwälzungen und Stürme. Und längerfristig gesehen sind die heutigen Ausmaße nicht ungewöhnlich.

Übersetzt von Chris Frey EIKE