Windenergie in der Grund-, Mittel- und Spitzenlast?

Die Stromerzeugungskosten in ct/kWh für die ersten 50 Prozent – leicht verständlich und realitätsnah:

Einleitung

In der Diskussion über die Energiewende gilt die Windenergie als die Hauptstütze für die Zukunft. Bisher fehlen jedoch belastbare Zahlen über die Kosten.

Dabei ist eine Überschlagsrechnung einfach durchzuführen. Bei dem beschriebenen Konzept werden Gaskraftwerke mit ähnlich leistungsfähigen Windenergieanlagen (WEA) gekoppelt. Immer dann, wenn der Wind nicht genug leistet, springen Gaskraftwerke ein.

So ist ständig Strom in gefordertem Umfang verfügbar und das macht auch die Preiskalkulation einfach. Es ist gleichzeitig das einzig realistische und heutzutage mögliche Konzept zum Einsatz von Windenergie in maximalem Umfang. Alle Vorstellungen, die weit darüber hinausgehen, sind heute von den technischen Möglichkeiten her lediglich Visionen.

Ermittelt werden maximale (kein Wind) und minimale (100% Wind) Kosten, zwischen denen sich der reale Betrieb bewegt.

Die Ergebnisse sind überraschend:

* wegen der Sicherheit in der Abschätzung,

* wegen der Höhe der Kosten (Grundlast: 10-14 ct/kWh landbasiert, 15-19 ct/kWh Offshore, Mittellast: + 33%) und

* dem technisch-realistisch machbaren Anteil der Windenergie von 50% in Grund- und Mittellast.

Zum Vergleich: Die Stromerzeugungskosten für Kohle liegen bei 2,5-3,3 ct/kWh.

Der Einsatz von Speichertechniken wird ausgeschlossen, da sie in erforderlichem Umfang nicht annähernd verfügbar sind. Auch wird hier nicht dargestellt, wie hoch die Kosten eines Umsteuerns wären, wenn noch wirtschaftlich laufende Kraftwerke vorzeitig abgeschaltet werden. Zusätzlicher Netzausbau und Gasleitungen sind in der Kalkulation ebenfalls nicht enthalten.

Es ist davon auszugehen, dass andere Modelle (www.kombikraftwerk.de) mit höheren Anteilen alternativer Energien (Wind, Sonne, Biogas) und evtl. umfangreichen Speichern angesichts der praktischen Möglichkeiten im Großmaßstab zu keinen günstigeren, sondern deutlich teureren Ergebnissen kommen werden.

Es geht hier nur um Technik und Preise. Eine Bewertung unter sozialen, politischen, Klima- und Umweltgesichtspunkten wird nicht vorgenommen.

Konzept

Es soll Grundlastbetrieb sicher gewährleistet sein.

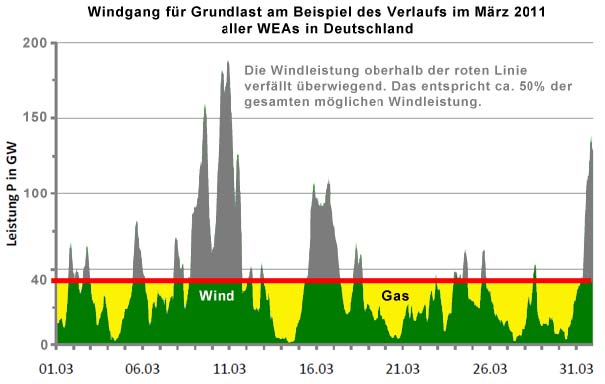

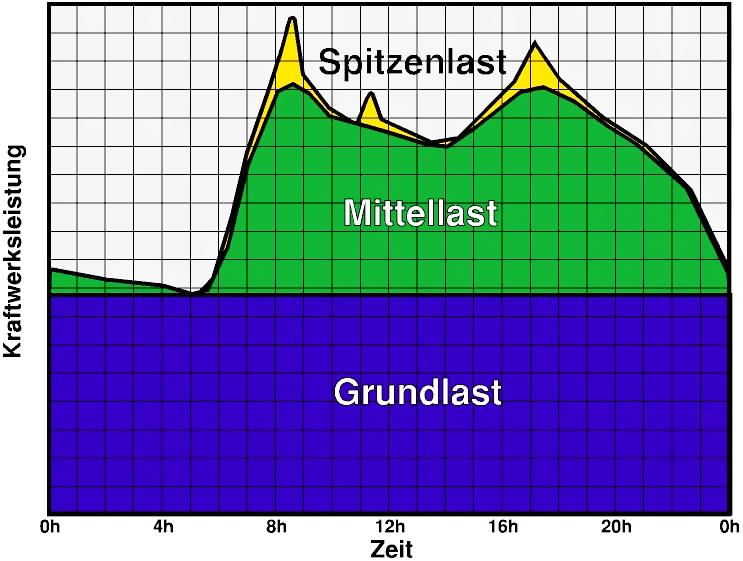

Grundlast bezeichnet die Netzbelastung, die während eines Tages in einem Stromnetz nicht unterschritten wird. In Deutschland liegt sie bei um die 40 GW4 (2005) im Gegensatz zur Jahreshöchstlast mit 75 bis 80 GW.

Dazu werden Gaskraftwerke mit gleich leistungsfähigen WEAs gekoppelt. Dabei wird bei diesen eine durchschnittliche Auslastung im Jahresmittel von 20 % der Nennleistung angenommen, wie sie in der Realität von landbasierten WEAs in Deutschland auch vorkommen. D.h. beispielsweise, dass ein 300 MW Gaskraftwerk mit 1.500 WEAs mit je 1 MW Nennleistung gekoppelt wird, die zusammen ebenfalls im Durchschnitt 300 MW liefern.

Dabei entsteht unvermeidbar überschüssige Windenergie in Höhe von ca. 50%, für die es derzeit überwiegend keine wirtschaftlich vertretbare Verwendung gibt.

Um die Leistung von 40 GW zuverlässig bereitzustellen, wären ca. 130 Gaskraftwerke á 300 MW und 195.000 WEAs mit 1 MW Nennleistung notwendig. Derzeit gibt es ca. 22.000 WEAs in Deutschland mit einer installierten Durchschnittsleistung von 1,3 MW je Anlage. Je nach Anlagengröße und Standort ist daher ein weiterer umfangreicher Ausbau notwendig.

Wie sich Wind und Gas die Erzeugung der Grundlast aufteilen würden ist in der Grafik2a am Beispiel des Windgangs aller deutschen WEAs für März 2011 demonstriert. Für die unvermeidbare überschüssige Windenergie (grau) wird es vermutlich kaum Abnehmer5 geben, obwohl die Kosten anfallen und auch in der Kalkulation hier einbezogen sind. Um es deutlich zu sagen: Windenergie, die angeboten, aber nicht abgenommen werden kann, muss bezahlt werden.

Kalkulation für Grundlast

Dass heutige EEG (Erneuerbare-Energien-Gesetz) bestimmt, dass aller durch WEAs erzeugte Strom auch abgenommen werden muss.

Bei der Verwendung in der Grundlast mit Kopplung von Gaskraftwerken ist das nicht möglich. Dann verfallen ungefähr 50%.

Aber der gesamte angebotene Strom durch WEAs muss bezahlt werden, weil sonst die Anlagenbetreiber nicht auf ihre Kosten kommen würden.

Wenn bspw. von den WEAs mehr als 300 MW Wind erzeugt werden, dann kann alles über 300 MW nicht verwendet werden und muss daher verfallen. Aber bezahlt werden muss es.

Preislich sieht das dann im Durchschnitt so aus:

Es entfallen auf alle der ständig angebotenen 300 MW des gekoppelten Systems im Durchschnitt auch immer die entsprechenden Windkosten von 9 ct pro verbrauchter Kilowattstunde.

Erzeugerpreise1:

9 ct/KWh (Einspeisevergütung) bei WEAs

5 ct/KWh Erzeugerpreis bei Gaskraftwerken im Betrieb und 1 ct/kWh in Bereitschaft (angenommen)

Obere Preisgrenze:

Die Ausgangsfrage: Wo ist ungefähr die obere überhaupt mögliche Preisgrenze, wenn WEAs durch Gaskraftwerke gepuffert werden, um Grundlastbetrieb zu gewährleisten?

Die Antwort: Am teuersten ist es, wenn Gaskraftwerke zu 100% und WEAs zu 0% einspeisen, aber die WEAs mit ihrem Stromangebot bezahlt werden müssen, so, als ob sie 100% liefern würden. Dabei ist es egal wie lange dieser Zustand dauern würde. Die Stromleistung wird gleich zweimal erzeugt, aber nur einmal abgenommen. Einen höheren Preis kann es nicht geben.

Demnach beträgt der gesamte Erzeugerpreis:

5 ct/kWh (Gas, Erzeugerpreis) + 9 ct/kWh (Wind, Einspeisevergütung) = 14 ct/kWh obere Preisgrenze

Untere Preisgrenze:

WEAs liefern 100% Strom und das Gaskraftwerk ist nur in Bereitschaft.

9 ct/kWh + 1 ct/kWh (Bereitstellungskosten) = 10 ct/kWh untere Grenze

Zwischen 10 und 14 ct/kWh muss sich der real existierende Erzeugerpreis dieses Modells in der Realität einpendeln, wobei 12 ct/kWh das Mittel ist.

Bei Offshore Anlagen (14 ct/kWh) dürfte der Erzeugerpreis entsprechend höher (15-19 ct/kWh) und im Mittel 17 ct/kWh sein.

Windenergieanteil

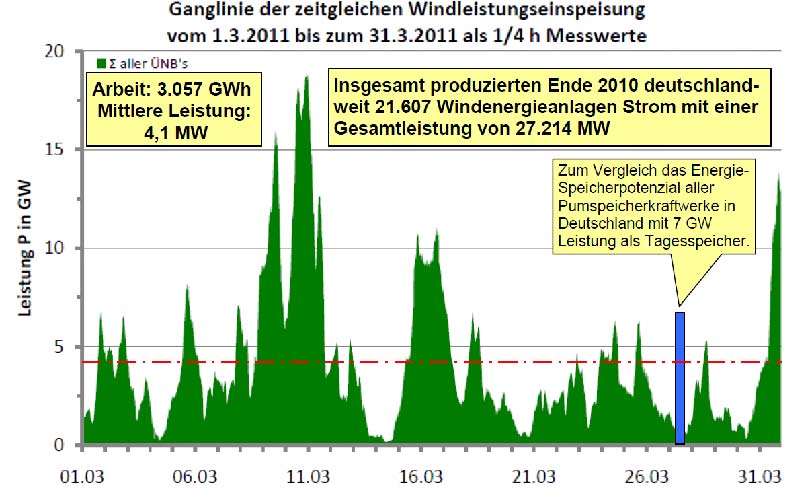

Im Durchschnitt liefern die WEAs 20% ihrer Nennleistung. Alles, was im gegebenen Augenblick über 300 MW erzeugt (angeboten) wird, verfällt. Das ist wahrscheinlich realistisch, da es kaum Speichermöglichkeiten in großem Umfang (Pumpspeicherwerke, etc.) gibt und der Verkauf ins Ausland bei einer nur nationalen Energiewende nicht zuverlässig sein dürfte.

Daher teilen sich im Durchschnitt Gas und Wind die Stromerzeugung je zur Hälfte. Man kann es auch so ausdrücken: Um 50% Gas zu sparen werden 2-3fach höhere Erzeugerkosten bezahlt.

Die rote Linie stellt die durchschnittlich erzeugte Leistung dar und beträgt im Jahresmittel ca. 20% der Spitzenleistung. 2)

Erhöhung des Windanteils auf weit über 50%

Eine Erhöhung des Windanteils ist nur über eine massive Entwicklung von Speichern möglich. Praktisch stehen diese nicht in nennenswertem Umfang zur Verfügung. Die meisten Ideen sind reine Visionen, kaum kalkulierbar und dürften realisiert preislich astronomische Höhen erreichen.

Kalkulation für Mittellast

Mittellast bezeichnet im Kraftwerksmanagement den Bereich der Tageslastkurve, in dem

* über die Grundlast hinaus zusätzlicher Strom verbraucht wird und

* die Charakteristik des Stromverbrauchs so ist, dass sie von Mittellastkraftwerken abgedeckt werden kann.

Für kurze Spitzen des Stromverbrauchs, sehr starke Lastanstiege oder unvorhergesehenen Strombedarf müssen dann Spitzenlastkraftwerke hinzugenommen werden.

Ein Einsatz von ungespeicherter Windenergie in der Mittellast kann wie vorstehend für die Grundlast berechnet werden. Dabei muss berücksichtigt werden, dass ca. 1/3 der gesamten Zeit keine Leistung abgerufen werden kann. Dadurch ist der Preis der Kilowattstunde gegenüber der Grundlast im Mittel um ca. 1/3 höher.

Daher muss sich der real existierende Erzeugerpreis dieses Modells in der Mittellast zwischen 13 und 19 ct/kWh einpendeln wobei 17 ct/kWh das Mittel ist.

Bei Offshore Anlagen (14 ct/kWh) dürfte der Erzeugerpreis entsprechend höher (20-26 ct/kWh) und im Mittel 23 ct/kWh sein.

Es wären dann weitere ca. 34.000 WEAs mit je 1 MW Nennleistung notwendig.

-> Mittellast: http://de.wikipedia.org/wiki/Mittellast

Spitzenlast

Spitzenlast bezeichnet kurzzeitig auftretende hohe Leistungsnachfrage. Bedarfsspitzen zeichnen sich oft durch einen starken Anstieg der nachgefragten Leistung aus, so dass für die Stromversorgung schnell regelbare Spitzenlastkraftwerke eingesetzt werden müssen. Diese können innerhalb von Sekunden oder Minuten hohe Leistungen zur Verfügung stellen. Hierzu zählen unter anderem Pumpspeicher- und Druckluftspeicherkraftwerke, aber auch moderne Gasturbinenkraftwerke.

Vom Leistungsumfang her ist die Spitzenlast vergleichsweise gering.

Ein Einsatz von Windenergie in der Spitzenlast ist zuverlässig nur über Zwischenspeicherung möglich. Dazu können vorhandene Pumpspeicherwerke, etc. verwendet werden.

-> Spitzenlast: http://de.wikipedia.org/wiki/Spitzenlast

Die Grundlast betrug 40 GW im Jahre 2005. Mittellast ist nach dieser Grafik für etwa 2/3 eines Tages notwendig. -> http://de.wikipedia.org/wiki/Kraftwerksmanagement

Verbraucherpreise

Wie würden sich die vorstehend ermittelten Windenergiepreise auf die Verbraucherpreise auswirken?

Die Stromerzeugerpreise für die fossilen Energien (Kohle, Gas) betragen 2,5 bis 5 ct/kWh.

Die Windenergie liefert im Modell wie oben ausgeführt im Mittel für 12 ct (landbasiert) und 17 ct (offshore) die Kilowattstunde, also zu 8 ct oder 12 ct höherem Preis. Bei einem Drei-Personen-Haushalt mit 3.500 kWh jährlichem Verbrauch ergibt sich dadurch eine Erhöhung von 280 € bzw. 420 € (plus MwSt).

Diese Mehrkosten könnten durch Senkung von Steuern und Abgaben kompensiert oder teilkompensiert werden. Staat und Kommunen müssten dann auf Einnahmen verzichten, die dann allerdings auch nicht mehr zu Ausgaben führen können. Auf volkswirtschaftlicher Ebene ergäbe sich dadurch direkt oder indirekt eine Absenkung von gewohnten Standards.

Für das Gewerbe und stromintensive Industrien können Strompreiserhöhungen existenzielle Bedeutungen haben und wären damit ein Politikum ersten Ranges.

Über die Zusammensetzung des Strompreises kann bei Wikipedia nachgelesen werden.

-> http://de.wikipedia.org/wiki/Strompreis

Fazit

Die Windenergie ist unter den Alternativen zu den fossilen Energien diejenige, deren technisches Potential am weitesten entwickelt und die preislich im Vergleich zur Sonne, der anderen Energie mit großem Potential, weit günstiger ist.

Nur eine Entwicklung der Speichertechnik wie Pumpspeicherwerke, Gasgewinnung (Wasserstoff, Methan, etc.) kann den Windanteil nennenswert über 50% anheben. Preislich dürften die Stromerzeugungskosten dadurch weiter stark ansteigen.

Bisher ist die öffentliche Diskussion mehr durch Vermutungen geprägt als durch fundiertes Zahlenmaterial. Vielleicht können die hier vorgelegten Betrachtungen bei der Fundierung und Versachlichung hilfreich sein.

Klaus Öllerer Publizist – Dipl-Ing. Hannover, im Februar 2012

0170 92 60 771

Anmerkung der Redaktion: Russland drosselt Gaslieferung

Bei weiterem Ausbau der Puffer-Gaskraftwerke würde die Abhängigkeit von Russland weiter steigen. Wenn die drosseln wie bereits jetzt geschehen, gehen die Lichter aus: Zitat aus der Welzheimer Zeitung vom 7.2.11

Am vergangenen Freitag habe sich die Lage aber weiter verschärft. In einem daraufhin an alle Großkunden verschickten Brief spricht die GVS-Netz von einer „kritischen Situation“ und fordert die Energieversorger „dringend“ auf Gas zu sparen. Unter anderem sollen – falls vertraglich möglich – Lieferungen heruntergefahren oder unterbrochen werden.

Nach Recherchen unserer Zeitung ist dies auch schon geschehen. So ist seit vergangenen Freitagabend Block vier des Karlsruher EnBW-Meilers RDK nicht mehr am Netz, wie eine EnBW-Sprecherin bestätigte. Die GVS-Netz selbst habe in den vergangenen Tagen die Gaslieferungen für „eine Handvoll Kunden“ reduziert, sagte der Sprecher.

Weitere Quellen

1. Stromerzeugungskosten

http://www.energie-verstehen.de/Energieportal/Navigation/Energieversorgung/stromerzeugung,did=249676.html

Die Einspeisevergütung für Land-WEAs als Kalkulationsgrundlage ist realistisch, da sie die Errichtung, den Betrieb, die Wartung und den Gewinn für die Eigentümer beinhaltet.

2. Windleistung in Deutschland

Prof. Dr.-Ing H. Alt, Fachhochschule Aachen, Hilfsb 123-5 Windleistung Deutschland 3-2011

2a. wie vor, jedoch geändert

3. Foto Windenergie in Landschaft

(c) J. Musehold

4. GW=Gigawatt, MW=Megawatt, kW=Kilowatt, W=Watt

1 GW=1.000 MW=1.000.000 kW=1.000.000.000 W

5. Wind-Wärme-Kopplung

Es wäre denkbar, dass überschüssiger Windstrom niederpreisig zur Wärmeerzeugung (Fernwärme, etc.) verwendet wird.

Bericht als Dateianlage

Bericht als Dateianlage Dr. Felix Kolb, Jahrgang 1973, ist Politikwissenschaftler. Er promovierte an der FU Berlin über die politischen Auswirkungen sozialer Bewegungen. Nach der Beendigung seines Studiums beteiligte er sich als Pressesprecher am Aufbau vonAttac. Zusammen mit Christoph Bautz gab er den Anstoß zur Gründung der Bewegungsstiftung.

Dr. Felix Kolb, Jahrgang 1973, ist Politikwissenschaftler. Er promovierte an der FU Berlin über die politischen Auswirkungen sozialer Bewegungen. Nach der Beendigung seines Studiums beteiligte er sich als Pressesprecher am Aufbau vonAttac. Zusammen mit Christoph Bautz gab er den Anstoß zur Gründung der Bewegungsstiftung.

report &

report &  press release here or see files attached (remark: Downloads of .doc pressrelease with SAFARI seems not to work, FIRFOX workfs fine)

press release here or see files attached (remark: Downloads of .doc pressrelease with SAFARI seems not to work, FIRFOX workfs fine)