Den neuen Startschuss gab kein Geringerer als Barack Obama während seiner Wahlkampagne im August 2008. Er forderte, dass bis zum Jahre 2015 eine Million Hybrid- und Elektroautos (merken Sie was ?) über die Straßen der U.S.A. rollen sollten. Seither ist dort eine sehr erhebliche Summe an Dollars – die Zeitschrift Scientific American spricht von „Milliarden“ – an staatlicher Förderung ausgegeben worden: An Steuervergünstigungen (7.500 US$ beim Kauf) ; 2,4 Mrd. US$ für Batterie-F&E; 115 Mio US$ für Ladestationen…(Es kommt einem sehr bekannt vor – siehe unten die Beschreibung des deutschen „Nationalen Entwicklungsplans Elektromobilität“.)

Dieses Ziel der US-Administration wurde weit verfehlt.

Deutschland folgt: Mit dem Nationalen Entwicklungsplan Elektromobilität (Lit.6)

Dieser Regierungsplan vom August 2009 nennt als Ziele: Forschung und Entwicklung, aber dann auch Marktvorbereitung und Markteinführung – also Planwirtschaft, anstatt die Entwicklung dieses Wirtschaftsbereichs dem Markt zu überlassen. Die gleiche Planwirtschaft, die die gesamte Energiewendepolitik kennzeichnet.

Interessante Aussagen im Plan: (Anmerkungen kursiv)

– „In Verbindung mit erneuerbaren Energien leistet sie (die E-Mobilität) einen bedeutenden Beitrag zur Umsetzung der Klimaschutzziele der Bundesregierung.

Bewertung: Das bedeutet: Wind- und Solarstrom sollen die E-Autos antreiben, was leider nicht funktioniert, weil deren Stromerzeugung unzuverlässig ist und speziell nachts kaum im Netz existiert. Es sei denn, man zwingt die E-Auto-Besitzer zur Installierung sog. Smart Meter für ihre private Ladestation, mit denen man den Strom durch den Versorger abschalten kann, wenn nur der böse Braunkohlestrom im Netz ist – und ihn wieder anschaltet, wenn Petrus etwas Wind wehen lässt.

– „Fahrzeuge in das Stromnetz integrieren“. „Die intelligente Nutzung der Batterien von E-Fahrzeugen als Stromspeicher bietet die Möglichkeit, die Gesamteffizienz der Stromversorgung zu erhöhen. Das geschieht über eine verbesserte Abnahme von Erzeugungsspitzen (die es in der konventionellen Stromversorgung gar nicht gibt), Annäherung von Erzeugungs- und Lastkurven (was eine konventionelle Stromversorgung routinemäßig erledigt) sowie perspektivisch auch die Bereitstellung von Regelenergie (die in einer konventionellen Stromversorgung kaum benötigt wird).

Bewertung: Das durch die Energiewende angerichtete Elend bei der Stromversorgung (massive Netzstörungen durch Windstromspitzen und Flautenlöcher, Ruinierung der Spitzenlast-Gaskraftwerke und auch der Pumpspeicherkraftwerke) soll jetzt durch Heranziehung der noch arglosen Käufer von E-Autos etwas abgemildert werden.

– Ein verblüffend ehrlicher Satz ergänzt diese Absichtserklärungen:

„Die damit verbundene Reduzierung der Batterielebensdauer ist dem gegenüberzustellen.“

Bewertung: Es ist zu hoffen, dass die E-Auto-Besitzer diese Falle rechtzeitig erkennen

(s.u. den Abschnitt „E-Autos als Hilfsspeicher für das Stromnetz ?“).

– Eine weitere sehr zutreffende Feststellung fand ihren etwas versteckten Platz im Plan:

„Der Mangel an Naturwissenschaftlern, Ingenieuren und technischen Fachkräften droht zur vielleicht größten Wachstumsbremse für die E-Mobilität zu werden.“

Bewertung: Das Wörtchen „vielleicht“ ist zu streichen. Prof. Endres, einer der wenigen in Deutschland noch tätigen Fachleute der Physikalischen Chemie, von dem im vorliegenden Artikel ausführliche Stellungnahmen enthalten sind, schrieb dazu in Lit.2

„Forschungsgeld für die physikalische Chemie: Polit-Saison-bedingt.

Die politische Blamage in den 1990er Jahren hatte leider für die Forscher fatale Folgen, denn in der Folge wurde die Elektrochemie an den deutschen Hochschulen faktisch abgewickelt; es gab keine Forschungsgelder mehr für Batterien, höchstens vereinzelt, und in der Szene der physikalischen Chemie wurden Elektrochemiker milde belächelt.

Dann kam ca. 2007/2008 das Thema wieder hoch, dieses Mal begründet mit der „Klimakatastrophe“ und der Endlichkeit der Ressourcen. Diesmal wurde das politische Ziel ausgegeben, gleich eine Million Elektroautos bis 2020 auf die Straßen zu bringen (Manfred Kanther lässt grüßen). Im April 2015 platzte auch diese Politblase, denn auf eine präzise parlamentarische Anfrage vermied die wenig amüsierte Regierung die nochmalige Erwähnung oder gar Bestätigung dieses Ziels.

Zwar gibt es wieder einige Batterieforscher, aber diese sind wegen der geringen Forschungsmittel in gegenseitiger Konkurrenz, der erhebliche technologische Rückstand zum Ausland konnte auch noch nicht aufgeholt werden. Erfahren die Politiker aber vom selbst verschuldeten und kaum aufzuholenden Rückstand, werden sie die Finanzierung vermutlich wieder einstellen, das könnte man auch Grundlagenforschung nach der Methode des politischen Schweinezyklus nennen.

Für neue Ideen, die einen langen Atem erfordern, fehlt Politikern meistens der Mut; lieber werden wohl die alten Fehler schnell vergessen.

Die Musik der Batterieforschung spielt sowieso längst in Asien und jetzt auch vermehrt in den USA.“ (Ende des Zitats)

– Ohne die unausweichlichen Konsequenzen dieses von den Autoren des Nationalen Plans selbst erkannten Riesenproblems zu begreifen, haben sie der kaum noch existierenden Forschung und Entwicklung in der Physikalischen Chemie eine Reihe von Anforderungen an die zu erbringenden Ergebnisse verordnet:

o Kostenziel: 300 – 500 €/kWh (heute 1000 – 1200 €/kWh)

o Energiedichte-Ziel: 200 Wh/kg bis 2015 (das ist der Faktor 2 gegenüber Li-Ionenbatterien im Jahre 2009). Langfristig 1000 Wh/kg.

o Lebensdauer und Zyklenfestigkeit: 10 – 15 Jahre, d.h. 3000 – 5000 Ladezyklen.

Bewertung: So denken Planwirtschaftler. Sie verordnen der viele Jahre vernachlässigten Forschung die tollsten Ergebnisse. Das ist nur noch tragikomisch.

Angela Merkel wünscht sich die Million

Bei der Konferenz „Elektromobilität bewegt die Welt“ am 27.5.2013 mit Vertretern aus Wissenschaft, Industrie und Politik erklärte Merkel: „Ziel der Bundesregierung ist es, dass bis 2020 eine Million Elektrofahrzeuge auf unseren Straßen im Einsatz sind. Bis 2030 könnten es auch 6 Millionen Fahrzeuge sein“. Und noch am 27.5.2013 verkündete sie auf der von der Regierung organisierten Konferenz „Elektromobilität weltweit“: „Das ist machbar.“

Damit übernahm sie Obamas großes Ziel, allerdings für ein viel kleineres Land und ohne die geringste Chance, bei der Entwicklung neuer und sehr viel besserer Batterien – also bei der für E-Autos alles entscheidenden Technologie – noch eine Rolle spielen zu können (s.o.). Aber politische Visionen haben keine Obergrenze und eine Million bringt ja viel mehr PR als mickrige 50.000.

„Der neue und alte Elektroauto-Hype (Zitat von Prof. Frank Endres, Lit.2)

Es scheint eine Gesetzmäßigkeit zu sein, dass die deutschen Politiker in regelmäßigen Abständen meinen, dass sie jetzt in den Automobilmarkt eingreifen müssen, um einer vermeintlich überlegenen Antriebstechnik zu ihrem verdienten Durchbruch zu verhelfen, der ihr von der verstockten Kundschaft verwehrt wird.

Elektrofahrzeuge sind ja in der Tat sehr leise und, so lange die Batterie genügend Ladung hat, entspannt und angenehm zu fahren. Aber eine Reichweite von 60 km im Winter bei einem bald

30.000 € teuren Kleinwagen ist nicht wirklich ein Kaufanreiz, dazu kommt die Alterung von Batterien, und ein schneller Rückgang der Preise ist bei ihnen nicht zu erwarten.

Das Problem der Elektrofahrzeuge liegt somit bei den Batterien – wie schon immer. Die deutsche Politik hat schon einmal den großen Durchbruch verkündet. Zwischen 1992 und 1995 führte die damalige Regierung – begeistert befürwortet durch Forschungsminister Heinz Riesenhuber und die heutige Bundeskanzlerin Angela Merkel, damals Umweltministerin, – einen großen Feldtest für Elektroautos auf Rügen durch. Und der damalige Innenminister Manfred Kanther gab das Ziel aus, dass mindestens 10 Prozent aller neu zugelassenen KFZ im Jahre 2000 Elektroautos sein sollten. Nicht allzu überraschend kam es etwas anders.“ (Lit.2)

Und abermals das Elektroauto – diesmal für den Klimaschutz

Dass die derzeitige Regierung – wie auch schon Regierungen vor ihr – trotzdem wieder einmal das Elektroauto exhumiert, ist nicht weiter verwunderlich. Man kann folgende Gründe finden:

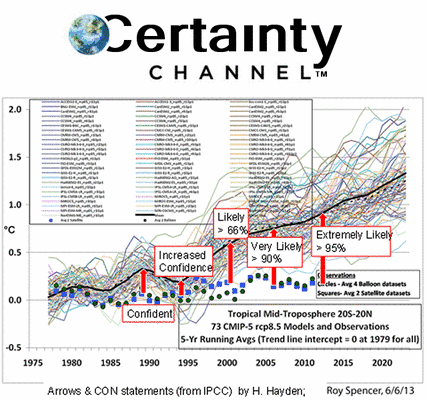

Ø Mit dem sogenannten Klimaschutz glaubt man ein neues und stichhaltiges Argument für E-Mobilität zu haben. Dazu gehört der Glaube an große CO2-Einsparungen durch den Elektroantrieb – was sich als ein Irrglaube herausstellt (s.u.).

Ø Politiker sind zunehmend beratungsresistent und empfinden Sachargumente als kleinkarierte Quengelei und lästige Ablenkung von ihren Plänen zur Beglückung der Wähler.

Ø Die Ministerien, die eigentlich auch die Aufgabe haben, die Regierung von unsinnigen Plänen abzubringen, sind mittlerweile in allen mittleren und oberen Etagen mit Parteibuch-Karrieristen und Mitläufern besetzt, von denen nur Vorschläge für Gesetze und Verordnungen erzeugt werden, die eine Unterstützung der Ideen „derer da oben“ bewirken sollen.

Bisher glaubte man, dass die Regierung deshalb auf die massive Einführung von Elektroautos setzt, weil sie damit etwas für den „Klimaschutz“ tun will. Es wird schließlich fest angenommen, dass E-Autos weniger CO2 produzieren als Benzin- oder Diesel-PKW. Dass mit dieser Annahme etwas nicht stimmt, ergaben bereits einfache Vergleichsmessungen, aus denen hervorging, dass Otto- oder Dieselmotoren kleinerer Leistung schon jetzt nicht mehr CO2 emittieren als die E-Autos.

Aber diese Bilanz wird für die Elektroautos noch schlechter; dafür hat die Regierung bereits gesorgt:

Weil die E-Autos weit überwiegend tagsüber genutzt werden, erfolgt die Aufladung ihrer Batterien nachts in der eigenen Garage. Niemand wird stundenlange Wartezeiten an öffentlichen Aufladestellen in Kauf nehmen. Nachts ist leider absolut kein Solarstrom im Netz – und ob sich etwas Windstrom im Strommix befindet, entscheidet das Wetter. Man kann den Erzeugungs-Diagrammen der gesamten installierten Windkraft entnehmen, dass im Durchschnitt der Nächte etwa 10% des Stroms aus der Steckdose von Windrädern erzeugt wird – der „Rest“ von 90% besteht überwiegend aus Braunkohlestrom – und bis 2022 auch noch aus Kernkraftstrom. Und weil die restliche Kernkraft ab 2022 per Gesetz abgeschaltet wird, bestehen die 90% des Auflade-Nachtstroms danach nur noch aus Braunkohlestrom. Damit sind die Elektroautos dazu verurteilt, die CO2-Emissionen Deutschlands weiter zu erhöhen. Diese Bilanz wird mit jedem abgeschalteten Kernkraftwerk schlechter.

Und sie wird nochmals schlechter durch die von der EU beschlossene mehrfache Anrechenbarkeit von E-Auto-Verkäufen auf den für die Hersteller attraktiven und dann von Strafzahlungen befreiten Verkauf von mehr großen PKW und SUV’s (s.u.).

Von „Klimaschutz“ kann bei Elektroautos also keine Rede sein

Das Bündel schwerwiegender Nachteile hat eine Ursache: Die Batterien

Die Angebote der Industrie an E-Autos überzeugten bisher nur wenige Kunden, was nicht weiter verwundert, wenn man die hohen Preise, das hohe Gewicht, die kläglichen Reichweiten – die im Winter nochmals abnehmen -, die langen Ladezeiten und die begrenzte Lebensdauer der extrem teuren Batterien betrachtet. Autofahrer sind nicht dumm und es spricht für sie, dass sie sich auch nicht für dumm verkaufen lassen. (Lit.4)

Weiter aus dem Beitrag von Prof. Endres (Lit.2):

„Die weitgehend auf Erinnerungsschwäche beruhende neue Begeisterung von Politikern für das alte Thema ignoriert weiterhin das Fehlen zuverlässiger und kostengünstiger Antriebsbatterien. Das ist seit etwa 100 Jahren der Fall, als mit der Erfindung des Automobils sofort auch der Elektroantrieb Anwendung fand. Nach einigen Jahren hängte der Verbrennungsmotor, der seine Energie aus den flüssigen Kohlenwasserstoffen holt, den E-Antrieb hoffnungslos ab. Seither arbeiten Generationen von Experten der physikalischen Chemie an der Verbesserung der Akkumulatoren. Alternativ versucht man den Menschen einzureden, dass sie eh kein Auto bräuchten, das mehr als 100 km Reichweite hat. Sie sollen für längere Strecken schließlich die Bahn nutzen.

Lebensdauer, Alterung und Betriebssicherheit von Batterien

Alle Batterien unterliegen unvermeidbar einer zyklischen (gemäß der Zahl der Lade/Entladezyklen) und kalendarischen Alterung. In den letzten Jahren waren Lithiumionen-Batterien in aller Munde. Lithium ist jedoch ein sehr reaktives und auch nicht sehr häufiges Metall, das mit jedem bekannten Elektrolyten chemisch reagiert. Solche Batterien sind daher nicht dauerhaft stabil. Lässt man eine Lithiumionenbatterie mehrere Jahre liegen, bläht sie sich im Laufe der Zeit wegen der Alterung auf. Wird sie dann stark belastet, kann sie zu brennen beginnen. Auch beim wiederholten Laden/Entladen leidet die Batterie – ihre Materialien werden durch mechanischen Stress während der zyklischen Belastung immer mehr zerstört.

Wir haben post-mortem-Analysen von Batterien, die gebrannt hatten, durchgeführt und konnten sehen, dass sich in den Batterien sog. „hotspots“ bildeten, die schließlich derart viel Wärme erzeugten, dass die Batterie in einen instabilen Überhitzungszustand geriet.

Bei Zink-Luft-Akkumulatoren nimmt die dort verwendete Kalilauge Kohlenstoffdioxid aus der Luft auf; hier altert also der Elektrolyt, und neue Konzepte sind erforderlich.

Wegen der kalendarischen Alterung liegt die maximale Lebensdauer bei 6 Jahren, aber auch nur 3 Jahre Lebensdauer können vorkommen.

Und ein gänzlich neues Batteriekonzept ist so schnell nicht zu erwarten.

Die Energiedichte

In der Frage der erreichbaren Energiedichte schlägt leider die Thermodynamik unbarmherzig zu. Die elektrochemische Spannungsreihe erlaubt maximal 6 Volt für ein Elektrodenpaar; das wäre dann aber eine (hochgefährliche) Lithium/Fluor-Batterie, deren technische Umsetzung und Verwendung kaum vorstellbar sind. Voll geladene Lithiumionen-Akkus heutiger Bauart haben bei einer Einzelzelle eine Spannung von 4,2 Volt. Mehr ist schwer zu erreichen, weil man noch keine Elektrolyte gefunden hat, die für sog. „5-Volt-Batterien“ geeignet sind. Es ergibt sich wegen des spezifischen Gewichts der Batteriematerialien derzeit eine maximale Energiedichte von 0,3 kWh/kg; technisch erreichen kann man heute nicht mehr als 0,15 kWh/kg.

Kohlenwasserstoffe enthalten dagegen rund 12 kWh/kg, wovon ein guter Dieselmotor ca. 5 kWh in mechanische Energie umsetzt.

Wirkungsgrad-bereinigt schneiden Kohlenwasserstoffe bezüglich der Energiedichte also mindestens 30-mal besser ab als Li-Ionen-Akkumulatoren.

Energiedichten von 1 – 5 kWh/kg sind nur mit Metall-Luft-Batterien denkbar. Relativ leicht herstellbare Zink/Luft-Batterien erreichen schon bis zu 0,5 kWh/kg, aber die oben beschriebene Alterung des Elektrolyten ist das zentrale Problem. Neue Konzepte sind in der Erforschung; mit einem Markteinsatz ist frühestens in 5 Jahren zu rechnen – und da am ehesten aus US-amerikanischer Fertigung.

Lithium-Luft-Batterien wurden als die Lösung aller Probleme angepriesen, und man sprach von bis zu 15 kWh/kg, was aber eine höchst unseriöse Zahl ist, da sie nur auf das Lithium alleine bezogen wurde und die andere Elektrode, der Elektrolyt, das Gehäuse usw. nicht berücksichtigt wurden. Im Labor erreichen Lithium/Luft-Batterien 1 kWh/kg, sie altern aber rasch, und eine Lösung für dieses Problem erscheint in weiter Ferne. Ein Einsatz ist frühestens in 20 Jahren zu erwarten, falls überhaupt.

Mit Unterstützung des BMBF arbeitet unser Institut an der TU Clausthal grundlegend an Aluminium/Luft und Silizium/Luft-Batterien. Die denkbaren Energiedichten liegen bei 1 – 4 kWh/kg, aber das ist Grundlagenforschung und ebenfalls weit von einer kommerziellen Nutzung entfernt.

Vielleicht können Lithium/Schwefel-Batterien als Nächstes vermarktet werden. Im Labor erreichen sie schon 1 kWh/kg. Sie altern aber schnell und die nutzbare Energiedichte liegt bei ca. 0,3 kWh/kg, was im Vergleich zu Lithiumionenbatterien immerhin um einen Faktor 2 besser wäre.

Ich rechne eher mit einer langsamen Evolution im Batteriesektor als mit einer schnellen Revolution.

Die Kosten

Wirklich gute Lithiumionen-Akkus, wie sie z.B. im Modellflug verwendet werden, kosten zwischen 1.000 und 1.500 €/kWh und selbst die „billigen“, wie sie in Elektroautos genutzt werden, kosten heute 500 €/kWh. Auf die immer einmal wieder ins Feld geführten 100 – 200 €/kWh werden wir m.E. noch ein wenig warten müssen, und bei der angepriesenen Speicherbatterie eines Elektroautoherstellers mit ca. 300 €/kWh muss man die Langzeitqualität abwarten.

Das Fazit der näheren Betrachtung der elektrochemischen Batteriearten, die mindestens eine gewisse Entwicklungsreife aufweisen, als mögliche Speicher zur großtechnischen Netzstabilisierung lautet somit „nicht langzeitbeständig“ und „unbezahlbar“.

(Ende des Zitats von Prof. Endres)

Feuer !

Akkus, die brennen können, gab es bei den braven, schweren Bleiakkus, die in unseren nichtelektrifizierten Autos immer noch treu ihre Dienste verrichten, niemals. Seit den Lithium-Ionen-Batterien – eine große Erfolgsgeschichte – hat sich das geändert. Als erstes gingen Laptops reihenweise in Flammen auf. Dann traf es auch mehrfach Autos, die mit diesen Stromspeichern angefüllt waren: So verabschiedete sich am 4.1.2016 ein Tesla Modell S an einer norwegischen Ladestation in einer spektakulären Flammenshow. Der Brand konnte nicht gelöscht werden.

Aber die Alarmnachrichten berücksichtigen nicht, dass inzwischen Hunderte von Millionen Li-Ionenbatterien in Gebrauch sind und diese Unfälle daher immer noch selten sind. Benzin- und Dieselautos brennen durchaus häufiger als E-Autos – weshalb es sogar Konferenzen dazu gibt: So die „3. Internationale Konferenz über Feuer in Fahrzeugen“, die am 1. Oktober 2014 in Berlin stattfand.

Aber neue Gefahren rufen immer neue Gegenmaßnahmen hervor, weshalb die Internationale Zivilluftfahrt-Organisation ICAO Anfang ab April 2016 die Mitnahme aller Geräte mit Lithium-Ionen-Akkus im aufgegebenen Fluggepäck verboten hat. Ebenso dürften aber auch gefüllte Benzinkanister verboten sein.

Je näher man den physikalischen Grenzen in der Batterietechnik kommt, desto kritischer scheint es für die Benutzer zu werden. Ob deshalb die Hoffnungen auf Batterietechnologien mit wesentlich höheren Energiedichten so ihr Ende finden, wird sich zeigen.

Mein persönlicher Albtraum ist allerdings die Wasserstoff-Tankstelle in der Nähe.

E-Autos als Hilfsspeicher für das Stromnetz ?

Eine Idee, die schon länger und immer wieder einmal in die hoffnungslose Diskussion über die im Stromnetz zum Ausgleich der gefährlichen Windstromschwankungen erforderlichen Speicher (die es nicht gibt und auch niemals geben kann) geworfen wird, ist die Benutzung von E-Autos als Hilfsspeicher für das Netz.

Die in den Garagen stehenden und am Ladekabel hängenden PKW sollten nach diesen Vorstellungen vom Stromversorgungs-Unternehmen mit einer Fernwirktechnik ansteuerbar gemacht werden, damit man sie bei Bedarf entweder als Stromlieferanten in das Netz oder auch zur Aufnahme von Leistungsspitzen der wetterabhängigen Ökostromerzeuger benutzen kann.

Im Nationalen Entwicklungsplan Elektromobilität, der oben behandelt wurde, ist diese Idee ganz deutlich als politische Absicht enthalten.

Anscheinend hat bei den Verfassern niemand nachgerechnet, weil das bei der Energiewende als unfair gilt.

Jedenfalls erzeugt schon eine Bierdeckel-Kalkulation einiges Kopfschütteln, denn die geringe Kapazität der Antriebsbatterien von ca. 25 kWh, von der nur ein kleinerer Teil wirklich für Lade-Entlade-Vorgänge zur Verfügung stünde, ergibt nur eine bescheidene und uninteressante Gesamt-Speicherkapazität. Hinzu kommt erschwerend, dass die E-Auto-Besitzer genau wissen, dass viele zusätzliche Lade-Entlade-Zyklen die ohnehin schon geringe Batterielebensdauer drastisch verkürzen – siehe die Ausführungen von F. Endres, aber sogar auch der im Text des Plans schamhaft versteckte Hinweis auf dieses Problem. Wenn die teure Batterie dann ein Jahr früher den Geist aufgibt, als es sowieso schon droht, wird sich wohl niemand darauf einlassen. Und die zwangsweise Installierung von Smart Metern bei den E-Auto-Besitzern traut sich die Regierung nicht anzuordnen – noch nicht.

Diese Idee ist also sinnlos, aber teuer, weshalb sie zur Energiewende passt – deshalb wird sie gewiss verwirklicht. Noch nicht mit Zwang, aber mit weiteren Subventionen.

Wie die Industrie gezwungen wurde, E-PKW zu entwickeln

Zu den Methoden, eine offenkundig unattraktive Technik dennoch in den Markt zu bringen, gehört die Ausübung von wirtschaftlichem Druck auf die Hersteller. Das hat die EU sehr wirksam erledigt (s.u.). Nun also bieten die großen Automobilhersteller unter erheblicher Selbstverleugnung gequält begeistert etliche E-Mobile an. Wegen der sehr teuren Technik zu unvermeidlich saftigen Preisen, an denen dennoch nichts verdient werden kann.

Dass die renitenten Autofahrer aber trotzdem und immer noch auf die regierungsamtliche E-Auto-Begeisterung nur mit Kaufverweigerung reagierten, verstört die Politiker sehr.

Es ist das Verdienst des Heidelberger Umwelt- und Prognoseinstituts UPI, mit seinem im August 2015 veröffentlichten Bericht Nr. 79 mit dem Titel „Ist die staatliche Förderung von Elektro- und Hybridautos sinnvoll ?“ (Lit. 1) Licht in diese seltsame Aktivität gebracht zu haben.

Das Geheimnis dieser teuren Aktivität ist die Flottengrenzwertregelung der EU, in der die Elektroautos trotz ihrer Emissionen, die mit ihrer Stromversorgung zusammenhängen, juristisch als „Null-Emissionsfahrzeuge“ definiert sind. Die von den Herstellern sehr erwünschte Folge: Fügen sie E-Autos ihrer PKW-Palette hinzu, dann sinkt der Durchschnitt der Emissionen der ganzen Flotte zwar überhaupt nicht, sehr wohl aber in der EU-Statistik. Hersteller können daher mit den verkauften Elektro- und Plug-In-Hybridautos hohe, über dem Grenzwert liegende Emissionen bei großen PKW rechnerisch kompensieren – und ersparen sich Strafzahlungen.

Dass sich die Hersteller aus EU-fernen Ländern kreativ weitere Statistik-Tricks zur Schönung ihres Flottenverbrauchs ausgedacht haben, wird unten im Abschnitt „Irreführende Fahrzeugstatistik..“ beschrieben.

Die Folgen der „Kompensationslösung“ in der Praxis

– „Ein Elektroauto ermöglicht im Durchschnitt ca. 5 großen PKW mit über dem Grenzwert liegenden CO2-Emissionen die rechnerische Einhaltung des Grenzwerts.

– Die Automobilindustrie kann 2013-2015 und 2020-2022 E-PKW als „Super-Credits“ definieren: Dann zählen Elektroautos mehrfach. Ein E-PKW kompensiert dann auf dem Papier die CO2-Grenzwertüberschreitungen von 7 bis 10 großen PKW.

– Ein E-Auto erspart den Herstellern pro ca. 5 Geländewagen oder SUV Strafzahlungen wegen CO2-Grenzwertüberschreitung in Höhe von z.Zt. 10.000 Euro.

– Dieselben Regelungen gelten bei Plug-In-Hybrid-PKW; die CO2-Kompensationen sind etwa halb so stark wie bei reinen E-Autos.

– Elektro- und Plug-In-Hybridautos führen deshalb entgegen der allgemeinen Meinung nicht zu einer Minderung, sondern zu einer Erhöhung der CO2-Emissionen. Ein neu verkauftes Elektroauto ermöglicht mehreren großen PKW über die Laufzeit gerechnet über dem CO2-Grenzwert liegende Emissionen von ca. 50 Tonnen CO2 ohne Strafzahlungen.“

„Rebound-Effekte“ – wenn gute Absichten ins Leere gehen

Die UPI-Forscher haben weitere Auswirkungen des Einsatzes von E-Autos eingehend betrachtet, und zwar die sog. Rebound-Effekte. Damit werden Nebenwirkungen oder Rückkopplungseffekte einer Maßnahme bezeichnet, die letztlich zum Gegenteil des ursprünglichen mit der Maßnahme Beabsichtigten führen.

Bekanntes Beispiel dafür: Die Anschaffung stromsparender Geräte im Haushalt (z.B. Energiesparlampen) macht eine stärkere Nutzung von Strom attraktiv, weil man ja nun durch das Stromsparen neuen Spielraum für den Verbrauch gewonnen hat. Die Stromkunden verwenden die erzielten Einsparungen zur Erhöhung ihrer Wohnqualität und ihres Komforts; die Ziele der Politiker sind nicht die ihren.

Zu den Rebound-Effekten bei E-Autos sagen die UPI-Experten:

– „Da E-Autos häufig als Zweit-oder Dritt-Wagen angeschafft werden, erhöhen sie die Gesamtzahl der Autos. Das verschärft den Ressourcen- und Flächenverbrauch des Straßenverkehrs und das Stellplatzproblem in den Städten.“

– „Obwohl in der Anschaffung teurer als normale PKW, liegen E-Autos in den Betriebskosten niedriger. Außerdem meint man, besonders umweltfreundlich unterwegs zu sein. Das führt zu einer recht drastischen Verkehrsverlagerung vom öffentlichen zum Individualverkehr:

In Norwegen, dem Land mit besonders vielen Elektro-PKW, nutzten 23% der Bürger den ÖPNV für Fahrten zur Arbeit vor dem Kauf eines E-Autos; nach dem Kauf eines E-Autos waren es nur noch 4%. Weil der Strom in Norwegen fast ausschließlich mit Wasserkraft erzeugt wird, gibt es bezogen auf die Art der genutzten Energie keinen Unterschied zwischen dem ÖPNV (elektrische Bahnen) und E-Autos. Einen anderen Unterschied aber gab es: Mehr Straßenverkehr und Parkplatzknappheit. (Lit.1 und 3).

Eine Umfrage des DLR-Instituts für Verkehrsforschung im Jahre 2014 zum gleichen Thema ergab identische Zahlen für Deutschland.(Lit.1)

– „Wenn der Plan der Bundesregierung, bis 2020 eine Million Elektrofahrzeuge auf die Straßen zu bringen, realisiert werden würde, dann würde die von der EU vorgesehene Absenkung des Grenzwerts von heute 130 auf 95 g CO2/km im Jahr 2020 durch die beschriebenen Kompensationsmöglichkeiten einer Million E-Autos fast vollständig unwirksam gemacht. Es gäbe die damit geplante Absenkung nicht.“ (Lit.1)

Auf diese Weise konterkariert die EU ihre CO2-Absenkungspolitik durch eigene Maßnahmen.

Es ist allerdings nicht zu erwarten, dass der Plan der Regierung aufgehen wird, denn sie hat dabei die Physik gegen sich: UPI: „Die Speicherung von Strom erfordert auch bei modernen Akkus eine um mehr als das 10-fache höhere Masse des Speichers als die Energiespeicherung mit flüssigen Treibstoffen. Deshalb gibt es einen Markterfolg nur bei E-Bikes und Pedelecs, da bei diesen wegen ihrer viel kleineren Masse, der geringeren benötigten Reichweite und der integrierten Muskelkraft die zu speichernde Strommenge viel kleiner ist.

Elektromobilität ist daher wie schon bisher nur beim schienengebundenen öffentlichen Verkehr sinnvoll.“(Lit.1)

Wenn alles nichts mehr nützt: Subventionen verteilen

Als dieser Artikel im Oktober 2015 in einer ersten Fassung geschrieben wurde (Lit.4), lautete der Schlußsatz:

„Es ist zu befürchten, dass die Regierung bei weiter anhaltender Ablehnung der Kunden in ihrer bekannten Methode, Fehler nicht zu beheben, sondern sie mit mehr Geld zuzukleistern, dem Wunsch der Automobilindustrie nach Kaufpreis-Subventionen nachgeben wird. Es wäre die logische Konsequenz in Befolgung des bereits angetretenen Marsches in die staatliche Planwirtschaft.“

Genau das ist nun erfolgt. Die Regierung beschloss eine Subvention – den „Umweltbonus“ (s.u.) – für den Kauf von Elektroautos, Hybrid-Elektro-PKW und auch Brennstoffzellen-Fahrzeugen.

Irreführende Fahrzeugstatistik: Fast jedes zweite Elektroauto in Deutschland verschwindet spurlos

Das war der Titel eines Artikels von Nils-Viktor Sorge in SPIEGEL Online am 12.4.2016. (Lit.5)

Das Kraftfahrzeug-Bundesamt (KBA) hatte gemeldet: In 2015 hätte die Zulassung reiner Batteriefahrzeuge um 45% zugenommen – auf 12.363 Exemplare in diesem einen Jahr. Der SPIEGEL bemerkte aber Ungereimtheiten in dieser Aussage: Im Vergleich zum 1.1.2015 erhöhte sich die Zahl der in D. länger als nur kurzfristig zugelassenen Batterieautos lediglich um 6554 Autos. Mit den vom KBA angegebenen zusätzlichen 12.363 Stück hätten es insgesamt 31.311 in D. zugelassene Batterieautos sein müssen – aber es waren in Wahrheit nur 25.502 Stück.

Fast jedem zweiten neu zugelassenen E-Auto steht also ein anderes gegenüber, das nahezu spurlos aus der Statistik verschwindet.

Ironisch bemerkt der Autor, dass es bei diesem Tempo bis zum Jahr 2168 dauern würde, bis die Merkel‘sche Million erreicht wäre.

Das KBA lehnte es ab, gegenüber der Presse seine Statistik nicht erläutern.

Die SPIEGEL-Leute fanden aber eine Erklärung für dieses Wunder. Es ist eine übliche Praxis für ausländische Hersteller – z.B. wie beim in Deutschland beliebten KIA Soul EV – ihre nach Deutschland importierten Elektroautos auch hier zuzulassen, sie aber anschließend wieder in Drittländer zu exportieren. Zweck dieser Kurzzeitzulassungen ist es, die CO2-Flottenbilanz des Herstellers in der EU zu schönen. Auch der Autoexperte Dudenhöffer meint, dass Exporte eine der wahrscheinlichsten Ursachen für den nur schleppend steigenden E-Auto-Absatz in Deutschland sind. Kurt Sigl, Präsident des Bundesverbandes Elektromobilität erklärte mit Blick auf die „verschwundenen“ Autos: „Die gehen alle ins Ausland“. Zum Absatz in Deutschland meinte er, dass dieser mittlerweile faktisch rückläufig sei.

Autor Sorge meint zu dieser Statistik-Ente: „Damit gerät das offizielle Ziel der Bundesregierung noch mehr zur Lachnummer als ohnehin.“

Der Artikel schließt mit der Aussage, dass die Industrie verzweifelt auf staatliche Kaufanreize hoffe.

Ihre Bitten wurden inzwischen erhört – siehe unten: „Der Umweltbonus“.

Ist die Zukunftstechnik Elektroauto bereits ein Auslaufmodell ?

Dass die Brennstoffzellen-Autos hinzu kamen ist offenbar eine Reaktion auf die Entscheidung von Toyota, in Anbetracht der vielen prinzipiellen Probleme der Batterie-E-Autos künftig auf die Brennstoffzelle (BSZ) zu setzen. Dadurch wird man das Reichweiten- und das Ladezeitproblem der Batterieautos los, handelt sich aber große Schwierigkeiten bei der Reife dieser Technik und angesichts noch viel höherer Kosten ein. Auf jeden Fall ist dieser Schritt des weltgrößten Automobilherstellers ein klares Signal für das absehbare Ende der Batterie-Elektroautos, für die die Deutschen jetzt ein Subventionsprogramm auflegen.

Was den Zeitraum für das Erreichen der Marktreife der Brennstoffzellen-PKW anbelangt, kann der Autor dieser Zeilen aus seinen ersten Erfahrungen beim Eintritt in das Bundesministerium für Forschung und Technologie im Jahre 1972 berichten: Als erstes bekam ich einen Aktenstapel mit laufenden Förderungsprojekten zur weiteren Bearbeitung auf den Tisch. Es waren Entwicklungsprojekte für Brennstoffzellen. Seitdem sind 44 Jahre weiterer Entwicklung ins Land gegangen – und auf die Produktion zuverlässiger und bezahlbarer BSZ werden wir noch lange warten dürfen.

Politiker denken in Legislaturperioden. In diesen 4-Jahres-Etappen verkünden sie sehr gerne Visionen für neue Technologien (die oft schon ziemlich alt sind) und können sich die wahren Zeiträume der Entwicklung bis zur Marktreife nicht im Entferntesten vorstellen. Bei den BSZ sind es schon mehr als 12 Legislaturperioden….Eine besondere Anwendung gibt es aber bereits: In den neuen U-Booten.

Der „Umweltbonus“

So nennt die Bundesregierung ihre neue Subvention. Dass E-Autos der Umwelt eher schaden als nützen, wurde bereits erläutert. In dem Förderungs-Infoblatt des Bundesamts für Wirtschaft und Ausfuhrkontrolle (BAFA) steht dazu immerhin ein verräterischer Satz: „Der Bundesanteil am Umweltbonus beträgt für ein reines Batteriefahrzeug bzw. ein Brennstoffzellenfahrzeug (keine lokale CO2-Emission) 2000 Euro…..“ Damit wird zugegeben, dass die Emissionen nur an einen anderen Ort verlagert werden.

Weitere Einzelheiten: Hybrid-E-Fahrzeuge sollen 1.500 € bekommen; die Automobilhersteller sollen mindestens den gleichen Anteil vom Listenpreis als Nachlass gewähren – und „der Netto-Listenpreis des Basismodells darf 60.000 € netto nicht überschreiten“ (!).

Das könnte man fast eine Sozialklausel nennen.

Man findet noch eine weitere interessante Zahl im BAFA-Infoblatt: Es werde damit auch eine „Stärkung der Nachfrage nach umweltschonenden Elektrofahrzeugen um mindestens 300.000 Fahrzeuge geleistet“. So lange ist es ja nicht her, dass Frau Merkel 1 Million E-Autos in Deutschland sehen konnte. Aber was ist schon ein Faktor 3,3 in der Politik ?

Immerhin gab es wenigstens einige Kritik und es dauerte etwas, bis alle Kabinettsmitglieder zugestimmt hatten. Dies wäre eine Chance für den Finanzminister gewesen, eine unsinnige Ausgabe zu verhindern. Aber er ließ schon viele andere Gelegenheiten dazu verstreichen.

Es gab auch einige Kritik in der Presse: Man konstatierte, dass auch diese Subvention nichts an den immer noch viel zu hohen Kosten dieser Fahrzeuge ändere; von den übrigen zahlreichen Nachteilen, an denen sich auch nichts ändert, ganz abgesehen. Als einzigen Effekt würde man damit die Anschaffung von Zweit- oder Drittwagen durch Wohlhabende subventionieren, die sich mit etwas Öko-Image schmücken möchten. Also etwas Öko-Deko für Reiche auf Kosten des „kleinen Mannes“.

Insofern eine zum Grundprinzip der Energiewende gut passende Maßnahme.

Quellen:

Lit.1: D. Teufel, S. Arnold, P. Bauer, T.Schwarz: „Ist die staatliche Förderung von Elektro- und Hybridautos sinnvoll ?“, UPI-Bericht Nr. 79 vom August 2015,

www.upi-institut.de/upi79_elektroautos.pdf

Lit.2: Frank Endres: „Batterien: Physikalische und ökonomische Grenzen“, aus G. Keil, F. Endres, H. Klinkert, M. Limburg, B. Reimer und H. Stirnberg :„Energiepolitisches Manifest 2 – Argumente für die Beendigung der Energiewende“, Juli 2015, Kap. 2.14, S.115, www.eike-klima-energie.eu/uploads/media/Manifest_2-_Fassg_3-35_1_02.pdf

Lit.3: Bjart Holtsmark, Statistics Norway und Anders Skonhoft, Dept. Of Economics, Norw. University of Science and Technology, Trondheim

Lit.4: Günter Keil: „Der Elektroauto Bluff“:

www.ageu-die-realisten.com/archives/date/2015/10

Lit.5: Nils-Viktor Sorge: „Irreführende Fahrzeugstatistik: Fast jedes zweite Elektroauto in Deutschland verschwindet spurlos“, SPIEGEL Online vom 12.4.2016;

www.spiegel.de/auto/aktuell/elektroautos-jedes-zweite-auto-verschwindet-aus-der-statistik-a-1086729.html

Lit.6: Bundesregierung: „Nationaler Entwicklungsplan Elektromobilität“, August 2009;

www.bundesregierung.de/webs/Breg/DE/Themen/Energiewende/Mobilitaet/podcast/_node.html

Sankt Augustin, 14.8.2016