Die Menschen werden immer dümmer – und der Klimawandel ist nicht schuld daran

Forschung: Menschen werden immer dümmer …

lautete die informative Überschrift einer renommierten Postille [1]. Wissenschaftler in Norwegen haben festgestellt, dass die Bewohner von Norwegen von 1905 bis heute dümmer geworden sind. Sie sind sich darin so sicher, dass sie die Vermutung äußern, der IQ der norwegischen Bevölkerung würde in den nächsten hundert Jahren um weitere sieben, bis zehn Prozent abfallen [5].

BUSINESS INSIDER: [1] … Seit Jahren gibt es Anzeichen dafür, dass der durchschnittliche IQ weltweit sinkt. Die norwegischen Forscher Bernt Bratsberg und Ole Røgeberg vom Frisch Centre der Universität Oslo konnten das nun erstmals anhand der norwegischen Bevölkerung nachweisen.

Während der Schnitt seit der Entwicklung des ersten massentauglichen Intelligenztests im Jahr 1905 immer weiter anstieg und im Jahr 1975 sogar einen Durchschnittswert von 102 erreichte, sank er danach bis zum Jahr 1990 stetig auf unter 100 Punkte ab. Wie die Forscher vermuten, könnte der IQ innerhalb der nächsten hundert Jahre sogar um ganze sieben bis zehn Punkte abfallen.

Das sind nicht hoch genug zu achtende Forschungsergebnisse – wie man sie sonst nur aus der modernen Klima(Folgen)-Forschung kennt. Anhand genauer und mit heutigen IQ-Messungen bestimmt vergleichbaren Daten von 1905 wurden komplexe, statistische Analysen durchgeführt [6]. Mit erschreckendem Ergebnis und noch erschreckenderer, aber präziser Hochrechnung für die kommenden 100 Jahre.

Norwegens Bevölkerung ist dann mit einer – dank hochwertiger, wissenschaftlicher Arbeitsweise engen Vorhersage-Genauigkeit, um 8,5 +-1,5 (7 … 10) Intelligenzpunkte dümmer geworden.

Ein solcher „IQ-Proxy“ erlaubt auch eine Hochrechnung auf die Welt-Gesamtpopulation „ ,,, der durchschnittliche IQ weltweit sinkt“.

Nicht Klima- sondern Umweltfaktoren sollen der Grund dafür sein

Klar wurde mit wissenschaftlicher Akribie auch nach den Gründen gesucht. Und es fand sich kein Klimawandel darunter! Es sollen nun „Veränderungen im Bildungswesen“ und Mediennutzungen sein … Wer wäre bisher ohne neue Forschungen nur auf solche weit, weit weg vom Thema liegende Möglichkeiten gekommen?

BUSINESS INSIDER: [1] … Für ihre Studie ermittelten die Wissenschaftler den Intelligenzquotienten von Testpersonen … und untersuchten außerdem genetische Veränderungen und Veränderungen, die verschiedenen Umweltfaktoren zuzuschreiben sind … Vielmehr sollen Umweltfaktoren für diesen negativen Trend verantwortlich sein. Dazu zählen den Forschern zufolge Veränderungen im Bildungswesen, bei der Nutzung verschiedener Medien sowie bei der Ernährung …

Statistik

Wenn man schon beim Nachsehen ist, anbei ein paar Daten [7]:

– Singapur hat Rang 1 mit einem IQ von 108

– Deutschland Rang 15 mit einem IQ von 100 (gleichauf mit Österreich)

– Norwegen Rang 19 mit einem IQ von 99

– Frankreich und USA Rang 26/27 mit einem IQ von 98

(der gleiche IQ wählt einmal Trump und einmal Macron. Vielleicht unterscheiden sich die Beiden gar nicht so stark)

– Äquatorialguinea steht an letzter Stelle mit Rang 109 und einem IQ von 56

Obwohl die Norweger also dümmer geworden sind, liegen sie lediglich einen einzigen, wohl kaum unterscheidbaren Punkt niedriger als Deutschland. Nun wäre es interessant zu wissen, wo Deutschland im Jahr 1905 stand.

Es gibt verschiedene Korrelationen

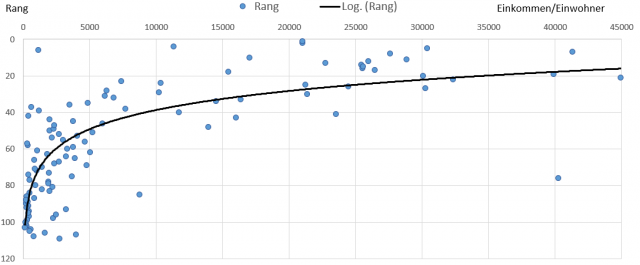

Anbei die Korrelation zwischen den Bildungsausgaben und IQ-Rang eines Landes (Rang 0 ist der Spitzenplatz). Leider ist nicht erkennbar, wie sich diese Bildungsausgaben zusammensetzen. Manche werden ahnen, welche Länder weit links stehen. Der Kontinent mit den meisten Länderprobanden liegt auf dem Globus in Südrichtung direkt unter uns.

Trotzdem war noch etwas mit Intelligenz und Klima

Laenderdaten.Info: [7] … Ist Intelligenz abhängig vom Klima?

Schon seit 1991 besteht die Vermutung, dass über Generationen anhaltende Wärme sich auf den IQ auswirkt. Man ging zunächst davon aus, dass ein Leben in niedrigeren Temperaturen eine höhere körperliche Fitness voraus setzt und höhere soziale Anforderungen an das Leben stellt. Richard Lynn, Professor an der nordirischen University of Ulster geht zudem davon aus, dass die kälteren Temperaturen das Gehirnvolumen ansteigen lassen. Ob die Gehirngröße mit der Intelligenz überhaupt in Verbindung steht, ist allerdings umstritten.

Generell gilt ein heißes Klima als nachteilig für die Entwicklung von Intelligenz. Der Grund hierfür wird heutzutage vorwiegend in dem hohen körperlichen Energiebedarf und dem dadurch entstehenden Stress gesehen. Insbesondere Kleinkinder verwenden bis zu 90% der Körperenergie für das Gehirn. Wenn in dieser für die Entwicklung wichtigsten Lebensphase die Energie anderweitig benötigt wird, kann sich das Gehirn nicht entsprechend entwickeln.

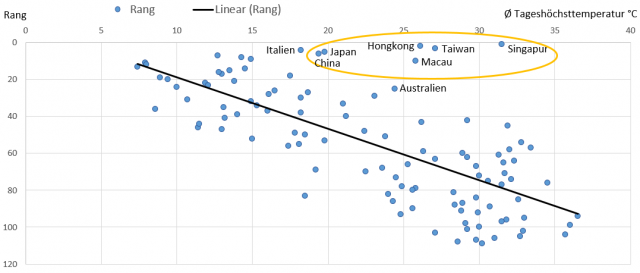

Dazu die Grafik mit dem Scatterdiagramm zwischen IQ-Rang (Rang 0 ist der Spitzenplatz) und der mittleren Tageshöchsttemperatur. Es zeigt sich ein eindeutiger Zusammenhang. Mehr Tageshitze macht das Landesranking und damit den IQ schlechter.

Nach anderen Ursachen braucht niemand mehr zu suchen, erlauben es sich Klimawandel-Forscher zu solch eindeutigen Diagrammen zu sagen. Diese „eindeutige“ Bild wird nur dadurch gestört, dass die schlimmen Ausreißer erfolgreiche, asiatische Staaten sind.

Noch etwas Interessantes findet sich auf der IQ-Infoseite. Der IQ schwankt je nach psychischer Verfassung mit einer Spanne von 20 (+-10) Punkten:

Laenderdaten.Info: [7] … Der Intelligenzquotient wurde so bemessen, dass der Mittelwert bei 100 liegt. Bei einer Standardabweichung von 15% ist also ein IQ zwischen 85 und 115 als normal anzusehen. Je nach psychischer und physischer Verfassung des Probanden können zudem die Messergebnisse um bis zu 10 Punkte nach oben und unten schwanken.

Nun stelle man sich vor, die psychische Verfassung der Proband*innen hat sich die letzten Jahre durch die dauernde, mediale Klimawandelfolgen-Hysterie verändert. Dann ließen sich die wenigen Punkte „Verdummung“ und der minimale Abstand zu Deutschland leicht erklären.

Mit ganz geringem „Bildungsaufwand“ wäre es dann auch möglich, die Norweger vor dem 8,5 +-1,5 IQ-Punkteverlust in 100 Jahren durch einfache (psychische) Maßnahmen zu heilen.

Quercheck

Keine Sichtung ohne den obligatorischen Quercheck. Gibt es etwa in Deutschland Anzeichen, dass – wie in [7] berichtet wird -, die Temperatur im Babyalter Einfluss auf den IQ hat.

Es findet sich eine Quelle mit umfassender Information:

P.M. Magazin (gekürzt): [8] Der Geburtsmonat prägt unser Leben entscheidend

… Der Geburtsmonat eines Menschen hat nachweislich Einfluss auf seine Entwicklung, Gesundheit, Charakter und Beruf, berichtet die Zeitschrift P.M. MAGAZIN in ihrer Februar-Ausgabe. Eine große Rolle spielen dabei die äußeren Einflüsse, denen ein Kind zum Zeitpunkt der Geburt und in den Monaten zuvor im Mutterleib ausgesetzt ist.

Ausgewählte Merkmale für jeden Geburtsmonat:

Januar: höheres Risiko für Schizophrenie, Epilepsie und Alzheimer; tendenziell Frühaufsteher

Februar: höheres Risiko für Essstörungen und Pollenallergien

März: überdurchschnittlich früh einsetzende Wechseljahre bei Frauen; höheres Risiko für Alkoholismus und Kindheit-Diabetes

April: höhere Kinderzahl und Körpergröße bei Männern; tendenziell geringerer Intelligenzquotient

Mai: überdurchschnittlich viele Selbstmorde; erhöhtes Multiple-Sklerose-Risiko; eher Nachtmenschen

Juni: geringes Geburtsgewicht; viele Nobelpreisträger …

So wirklich Hilfreiches findet sich darin nicht. Im April geborene Männer haben einen geringeren Intelligenzquotient. Aber drei Monate später im Hochsommer Geborene können bereits Nobelpreisträger werden. Das war es aber schon über das gesamte Jahr mit einem Temperatureinfluss. Richtig zwingend Temperatur-korrelativ erscheint dies nicht.

Zur wichtigen Eigenanamnese vor Besuchen beim Arzt oder Psychologen ist diese Listung allerdings gut zu gebrauchen. Man kann sich damit als kompetenter Patient fühlen.

Quellen

[1] BUSINESS INSIDER Deutschland 14.06.2018, Jessica Dawid: Die Menschen werden immer dümmer — jetzt gibt es einen wissenschaftlichen Beweis

[2] EIKE 20.02.2018: Der Klimawandel macht dumm

[3] WUWT October 17, 2012: Claim: CO2 makes you stupid? Ask a submariner that question

[4] EIKE 14. Juni 2018: AfD Abgeordnete führen Ministerin Schulze vor – Auf klare einfache Fragen nur verschwiemelte, ausweichende Antworten

[5] Bernt Bratsberg and Ole Rogeberg, Studie: Flynn effect and its reversal are both environmentally caused

[6] Bernt Bratsberg and Ole Rogeberg: Supplementary Information for “The Flynn effect and its reversal are both environmentally caused” Authors:

[7] Laenderdaten.Info: Der IQ im Ländervergleich

[8] Gruner+Jahr, P.M. Magazin, 16.01.2014: Der Geburtsmonat prägt unser Leben entscheidend