Die UN-Umfrage-Wiederbelebung

Bessere Arbeitsplatz-Chancen

Keine Diskriminierung und Verfolgung

Maßnahmen bzgl. des Klimawandels

Unterstützung für Menschen, die nicht arbeitsfähig sind

Zugang zu sauberem Wasser und sanitäre Anlagen

Schutz von Wäldern, Flüssen und Ozeanen

Zuverlässige Energieversorgung zu Hause

Bezahlbare und gesunde Nahrungsmittel

Eine ehrliche und offene Regierung

Gute Bildung

Gleichheit zwischen Männern und Frauen

Telefon und Internet-Zugang

Politische Freiheiten

Bessere Transportbedingungen und gute Straßen

Schutz vor Kriminalität und Gewalt

Bessere Gesundheitsfürsorge

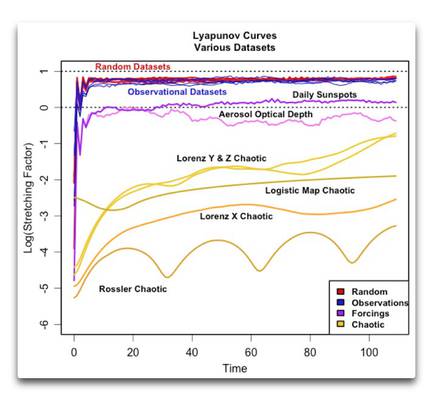

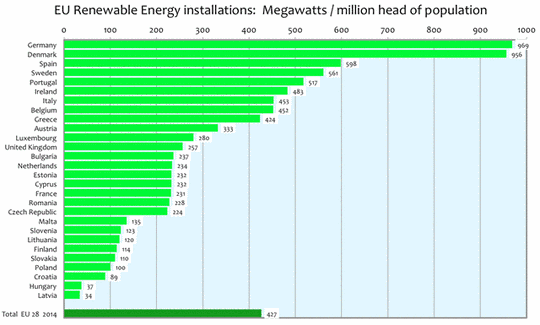

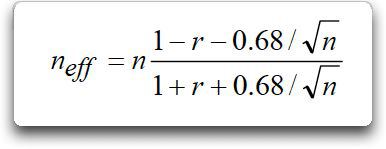

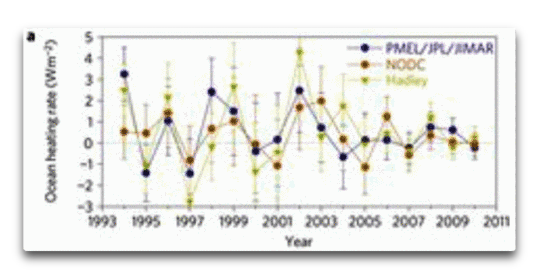

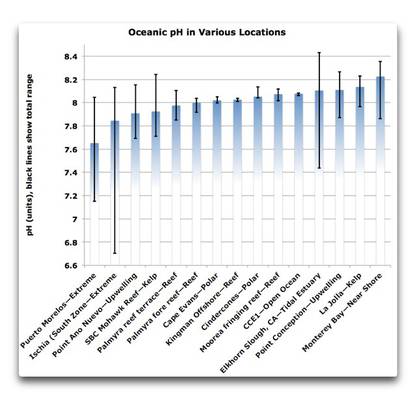

Zum Zeitpunkt meines letzten Beitrages rangierte der Klimawandel abgeschlagen an letzter Stelle. Vor ein paar Tagen habe ich noch einmal nachgeschaut. Die Umfrage ist immer noch im Gange, man kann dort klicken und abstimmen, falls man will. Inzwischen gibt es über neun Millionen Antworten … und jawohl, Klimawandel rangiert immer noch unter ,ferner liefen‘, selbst noch gegenüber dem Themenbereich auf dem vorletzten Platz:

Abbildung 1: Ergebnisse der UN-Umfrage, alle gesellschaftlichen Gruppen.

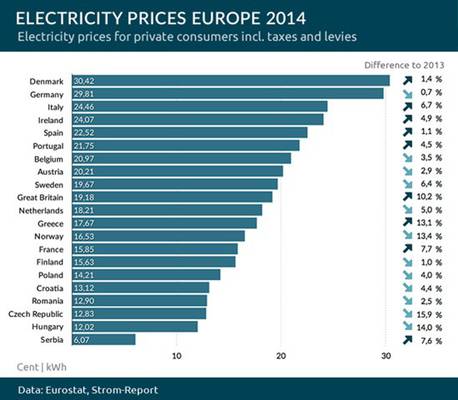

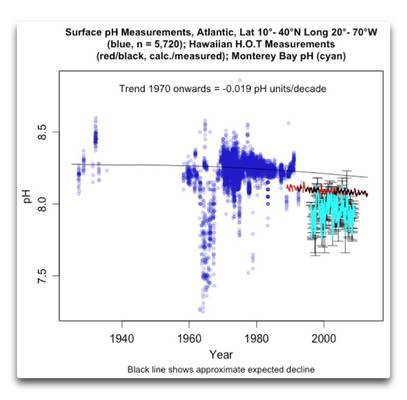

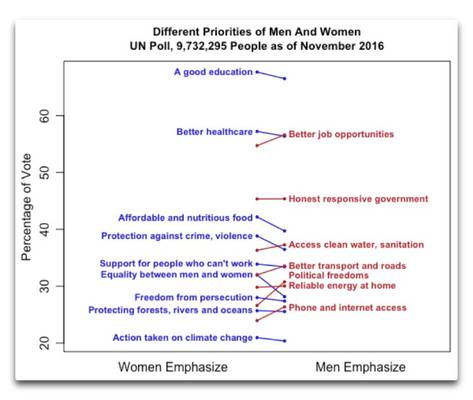

Da habe ich mich entschlossen, ein wenig tiefer in diese Daten einzutauchen. Ich begann mit einem Blick auf die Unterschiede zwischen Männern und Frauen bzgl. der oben gelisteten Themenbereiche:

Abbildung 2: Unterschiede zwischen Männern und Frauen. Die Werte zeigen die Prozentzahl der Antwortenden, die das jeweilige Thema als ihre Wahl unter den sechs Auswahlmöglichkeiten nannten. Die Linien verbinden die Prozentzahlen von Männern bzw. Frauen zum gleichen Thema und sind nur am oberen Ende beschriftet. Blaue Beschriftungen und Linien zeigen Themen, die Frauen wichtiger fanden als Männer, während rote Dinge von den Männern als wichtiger erachtet wurden. Die Enden der farbigen Linien zeigen die Prozentwerte für Frauen (linke Enden) und Männer (rechte Enden).

Die oberen drei Ergebnisse sind interessant, weil sie beiden Gruppen gemeinsam sind. Man erkennt, dass Männer mehr Gewicht auf Arbeitsplätze legen und Frauen mehr Gewicht auf Gesundheitsfürsorge und Bildung. Wie jedoch Abbildung 1 zeigt, stehen diese drei weit vor allen anderen Themen.

Frauen legen auch viel mehr Gewicht auf bezahlbare gute Nahrungsmittel und auf Schutz vor Gewalt und sexuelle Gleichheit (steile blaue Linien) als Männer. Männer andererseits legen mehr Gewicht als Frauen auf politische Freiheit, bessere Straßen und Telefon-Möglichkeiten (steile rote Linien).

Und Maßnahmen gegen die Klimawandel rangieren bei Frauen und Männern gleichermaßen ganz weit unten.

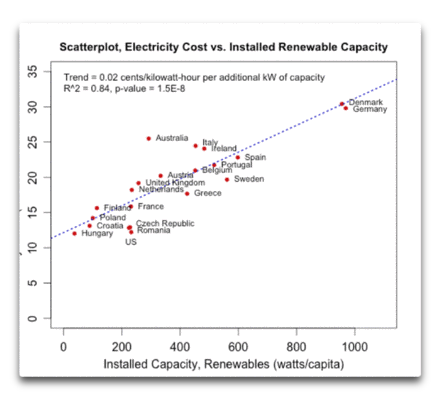

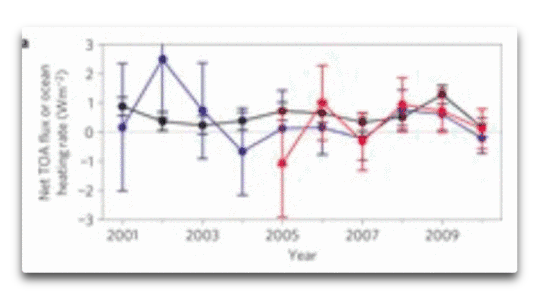

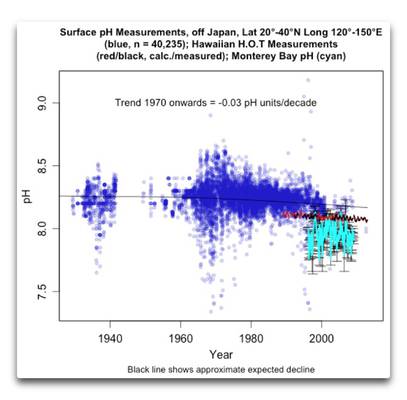

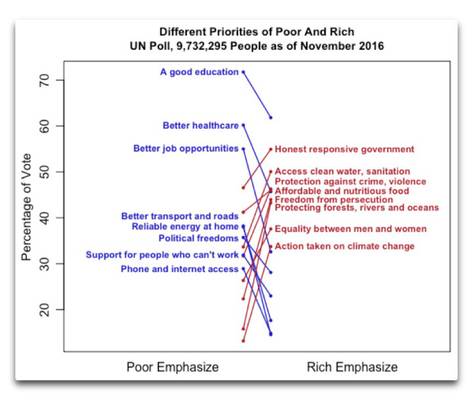

Während das schon ziemlich interessant war, wollte ich jetzt noch wissen, ob und welche Unterschiede es gibt zwischen den armen und den reichen Ländern zu diesen Themen. Die UN unterteilen die Länder in vier Niveaus, von arm bis reich, oder in UN-Termini von „niedrigem HDI (Human Development Index) bis zu „sehr hohem HDI“. Um die Änderungen zu vereinfachen und klarer herauszustellen, habe ich nur die erste und letzte Kategorie betrachtet, also die ärmsten und die reichsten Länder. Die Ergebnisse sehen so aus:

Abbildung 3: Wie in Abbildung 2, aber mit dem Unterschied der Prioritäten zwischen den Armen und den Reichen.

Hier zeigen sich einige interessante Dinge. Erstens, Bildung steht an oberster Stelle für Männer, für Frauen, für die reichsten und die ärmsten Länder. Meiner Ansicht nach zeigt dies das gute Urteilsvermögen der Menschen weltweit. Oder es bedeutet einfach, dass ich mit dem Rest der Welt übereinstimme … Bildung ist wichtig.

Weiter, die starke Neigung aller Linien zeigt, dass die Unterschiede zwischen dem, was für die Menschen in reichen bzw. armen Ländern wichtig ist, viel, viel größer sind als die Unterschiede zwischen Männern und Frauen zum gleichen Thema.

Weiter, die wichtigsten drei Themen aller Gruppen zusammen (Abbildung 1) ebenso wie für Männer und Frauen separat (Abbildung 2) sind Bildung, Gesundheitsfürsorge und Arbeitsplätze. Alle drei sind für die Reichen weitaus weniger wichtig als für die Armen. Auch sind viele andere Dinge wie Telefone, zuverlässige Energie, gute Straße und politische Freiheiten für die Reichen nicht besonders wichtig. Dass die Menschen in reichen Ländern jene Dinge nicht so wichtig finden, hat einen einfachen Grund – im Allgemeinen verfügen sie über all diese Dinge, so dass sie sich den Luxus leisten können, sich um andere Themen Gedanken zu machen.

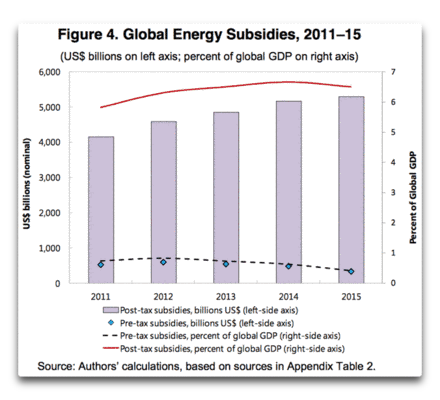

Weiter, es zeigt sich eindeutig, dass Umweltbedenken etwas sind, dass sich nur die Reichen leisten können. Der „Schutz von Wäldern, Flüssen und Ozeanen“ rangiert in reichen Ländern ziemlich weit oben, noch deutlich vor Gelegenheiten bzgl. Arbeitsplätzen … aber in armen Ländern rangiert dies an vorletzter Stelle, noch vor Klima und deutlich unter dem darüber liegenden Thema.

Und schließlich, Klimawandel. Die Menschen, die Maßnahmen gegen Klimawandel favorisieren, egal ob Männer oder Frauen, behaupten, dass sie das für die Armen tun … aber es scheint, als ob die Armen das gar nicht mitbekommen. Für sie rangiert der Klimawandel ebenso wie für die ganze Welt allgemein abgeschlagen an letzter Stelle. Und in den armen Ländern haben nur 13% aller Menschen das überhaupt erwähnt, ein sehr geringer Prozentsatz. Soweit es die Armen betrifft, sollten die Menschen lieber Spenden abliefern für jedes der vielfachen Probleme, die es bei den Armen gibt, als es dem Klimawandel in den Rachen zu schmeißen.

Betrachten wir jetzt die behaupteten Überzeugungen der reichen Länder. Hier folgen Stichproben dessen, was seit einiger Zeit das Narrativ ist; zunächst für die USA:

Unter Verweis darauf, dass der Klimawandel unter den ernstesten Problemen ist, vor denen die Welt derzeit steht – wie Epidemien, Armut, Terrorismus und die Ausbreitung von Massenvernichtungswaffen – appellierte US-Außenminister John Kerry an alle Nationen, auf „diese größte Herausforderung unserer Generation“ zu reagieren.

Von unseren Vettern jenseits des Großen Teiches [= des Atlantiks] beglückte uns der als „Prinz“ bekannte Künstler mit seinen Ansichten hierzu:

Der Kampf gegen die globale Erwärmung ist die größte Herausforderung, vor der die Welt heute steht, sagte Prinz Charles, und drängte die Regierungen, etwas gegen den Klimawandel zu unternehmen, bevor es zu spät sei.

Und schließlich kam von Obamas Pressesprecher Josh Earnest Folgendes:

1. „Was der Präsident hier meint ist, dass es viel mehr Menschen gibt, die jährlich mit den Auswirkungen des Klimawandels konfrontiert sind, den direkten Auswirkungen auf ihre Leben oder die Ausbreitung von Krankheiten als mit Terrorismus“.

2. „Was der Präsident hier meint ist, dass wenn man über die täglichen direkten Auswirkungen dieser Art von Herausforderung auf das tägliche Leben der Amerikaner spricht, besonders der in diesem Land lebenden Amerikaner, dann sind davon mehr Menschen stärker betroffen als von Terrorismus“.

3. „Ich denke, dass sogar das Verteidigungsministerium die signifikante Bedrohung angesprochen hat, die der Klimawandel für unsere nationale Sicherheit darstellt. Hauptsächlich wegen der Auswirkungen, den er auf Länder haben kann, in denen die Infrastruktur weit weniger entwickelt ist als bei uns“.

Die Leute in reichen Ländern glauben also vermeintlich, dass Klimawandel eine größere Gefahr ist als Terrorismus. Allerdings geht aus den Antworten von neun Millionen Menschen hervor, dass die Leute in reichen Ländern diese Botschaft nicht vernommen haben. Anstatt zu glauben, dass Maßnahmen gegen den Klimawandel wichtiger sind als gegen Terrorismus und dass es die größte Herausforderung für die Welt ist, sind in Wirklichkeit Maßnahmen gegen Klimawandel für die Menschen in reichen Ländern weniger wichtig als sexuelle Gleichheit oder bezahlbare Nahrungsmittel. Und Maßnahmen gegen Klimawandel sind in den wohlhabendsten Ländern weit weniger wichtig als sauberes Wasser und sanitäre Anlagen … das sind gute Nachrichten. Sie zeigen, dass es immer noch einigen gesunden Menschenverstand auf dem Planeten gibt. Nicht jeder heult mit dem alarmistischen Mantra „Der Himmel fällt herab! Ein paar Grad Erwärmung werden uns alle töten!“

Kurzversion gefällig? Falls jemand glaubt, den Armen zu helfen mit dem Kampf gegen das furchtbare CO2, würden die Armen den UN zufolge darauf wetten, dass sie anderer Ansicht sind. Die Menschen in den armen Ländern haben eindeutig gezeigt, dass sie es viel lieber sähen, dass falls Menschen helfen wollen, diese ihr Geld und ihre wertvolle Zeit für irgendeines der anderen 15 Themen auf der UN-Liste ausgeben würden, bevor man gegen den Klimawandel vorgeht. Klima ist nicht nur Nummer 16 am Ende ihrer Liste, sondern liegt der Meinung der Armen nach auch weit unter allen übrigen Themen. Der einzige Grund, warum das Thema Klima nicht den 17. Rang einnimmt, ist die Tatsache, dass sich auf der Liste nur 16 Themen finden. …

Und selbst die Menschen in den reichsten aller Länder nehmen nicht die Behauptung ab, dass der Klimawandel das größte Problem ist, vor dem wir stehen, nicht einmal ansatzweise. Zum Kuckuck, der Klimawandel schafft es nicht einmal in die obere Hälfte der Themen, die die Menschen in den reichsten Ländern für wichtig halten.

Aha! Während man von den USA oft behauptet, dass sie einen Ausreißer darstellen, weil so viele Menschen dort (einschließlich des neu gewählten Präsidenten) nicht glauben, dass der Klimawandel ein wichtiges Thema ist, stellt sich heraus, dass die meisten Menschen auf dem Planeten mit dem gewählten Präsidenten darin übereinstimmen, dass das Thema Klima am Ende aller Themen liegt, die von Belang sind. Das Bestehen irgendeiner sagenhaften großen Wählerschaft, die für Maßnahmen gegen Klimawandel sind, scheint eine Erfindung der Medien zu sein … Oha, eine sagenhaft große Wählerschaft, die in Wirklichkeit nur eine Erfindung der Medien ist – wo habe ich das kürzlich noch gehört? Aber ich schweife ab…

Angesichts des Umstandes, dass uns nur begrenzt Zeit zur Verfügung steht, mit Geld und Ressourcen gegen diese Dinge vorzugehen, scheint es mir, dass wir unsere Bemühungen konzentrieren sollten auf die realen Probleme, die die Menschen als wirkliches Problem für ihr Leben ansehen. Die obersten zehn Themen sind – in dieser Reihenfolge – Bildung, Arbeitsplätze, Gesundheitsfürsorge, eine gute Regierung, Nahrung, Schutz vor Gewalt, sauberes Wasser, Versicherung gegen Arbeitslosigkeit, Straßen und sexuelle Gleichheit. Falls sich Menschen wirklich um die Armen kümmern wollen, sollten sie sich eines dieser Themen aussuchen und an die Arbeit gehen. Genau das habe ich lange Zeit während meines Lebens getan.

Wenn wir diese Herausforderungen erst einmal gemeistert haben, könnten wir in Erwägung ziehen, Milliarden für CO2-Abschwächung auszugeben … oder nicht.

Aber bis dahin – sollten wir das nicht tun.

Link: https://wattsupwiththat.com/2016/11/22/the-un-poll-redux/

Übersetzt von Chris Frey EIKE