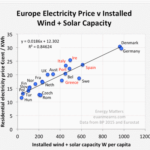

Bild rechts: Das Windkraft-Debakel in Deutschland sieht nicht nur aus wie ,Chaos‘, sondern es IST Chaos!

Verschwendung von 18 Milliarden Euro pro Jahr für Energie – über die Deutschland aus bedeutenden Quellen reichlich verfügt – hat dort eine faire und vernünftige Frage aufgeworfen: Wie viel Energie bekommen denn nun die Deutschen für die Euromilliarden, mit denen sie um sich geworfen haben – und dies für Wind und Solar auch weiterhin tun?

Die Antwort lautet: NICHT VIEL: Die Deutschen geben hunderte Milliarden Euro für ihre „Energiewende“ aus und bekommen im Gegenzug aus diesen Quellen lediglich 3% ihres Energiemix‘ (hier).

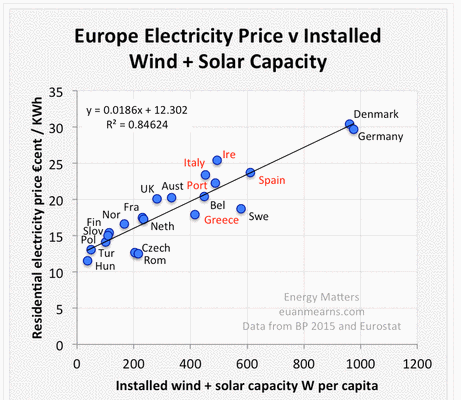

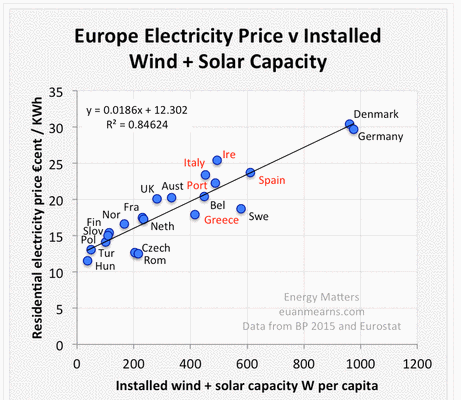

Y-Achse: Private Strompreise in der zweiten Hälfte des Jahres 2014 (Eurostat)

X-Achse: Installierte Wind-/Solarleistung pro Kopf (2015 BP Statistical Review)

Bildquelle: http://irishenergyblog.blogspot.de/2015/08/europe-electricity-price-vs-installed.html?spref=tw

Aber dabei darf man sich nicht nur auf die unsinnig hohen Kosten für die deutschen Energieverbraucher und Steuerzahler konzentrieren – und die überaus mageren Rückläufe für ihre Euromilliarden an Subventionen – sondern man muss auch das betrachten, was sich nur mit der Bezeichnung Markt-Fiasko versehen lässt.

Auf einer mehr praktischen Ebene – die für Energiespekulanten noch wichtiger ist – haben unvorhersagbare Flutwellen von Windenergie das deutsche Netz an den Rand des Zusammenbruchs gebracht (hier).

Weil Deutschland nicht in der Lage ist, selbst weitere Leitungskapazitäten zu schaffen – hauptsächlich weil die Deutschen die Nase voll davon haben, dass ihre teils idyllischen Naturlandschaften in industrielle Fabriklandschaften verwandelt werden – und um die kolossalen und völlig unnötigen Kosten eines zweiten Netzwerkes zu erwähnen, nur um gelegentliche Spitzen bei der Erzeugung von Windenergie aufzufangen – leitet Deutschland seine überschüssige Energie als Abfall in die Netze seiner Nachbarländer.

Die Folge hiervon ist, dass die Nachbarn Tschechien, Polen, die Niederlande, Belgien und Frankreich mit überschüssiger Energie geflutet werden – immer wenn der Wind in Norddeutschland stark auffrischt – was zu Instabilitäten des Netzes und Stromausfällen führt.

Deutschland war hin und wieder ein irgendwie sehr ungestümer Nachbar. Dass Deutschland seine überschüssige Windenergie auf sehr unregelmäßiger Basis in Netze entsorgt, die einfach nicht darauf ausgelegt sind, rapide Zuwächse des Energievolumens aufzunehmen, bringt die Nachbarn Deutschlands wegen dessen Arroganz und wegen der für sie anfallenden Kosten, um diese Energie aufzufangen, in Weißglut.

Hier folgen ein paar Momentaufnahmen noch weiterer Aspekte der deutschen Windkraft-Katastrophe:

Deutschlands Nachbarn erzürnt durch die Energiewende des Landes

The American Interest, 4. August 2015

Der deutsche Energiemix ist während der letzten Jahre radikal verändert worden, hauptsächlich getrieben durch zwei Kräfte: Der Wunsch nach Ausweitung der Marktanteile erneuerbarer Energie (was durch großzügige staatliche Subventionen mit der Bezeichnung Einspeisetarife gefördert wird) und eine Aversion gegen Kernkraft nach dem Unfall in Fukushima im Jahre 2011. Innerhalb Deutschlands hatten diese Änderungen eine Anzahl vielleicht unvorhergesehener und mit Sicherheit schädlicher Konsequenzen, einschließlich explodierender Energiekosten für Geschäfte und Haushalte. Eine weitere, irgendwie bizarre Konsequenz ist eine gestiegene Abhängigkeit von einer besonders ,schmutzigen‘ Kohleart, nämlich Braunkohle. Aber die sich immer mehr steigernden Auswirkungen der Berliner Energiewende breiten sich über nationale Grenzen hinweg aus, und wie Politico berichtet, sehen sich Deutschlands Nachbarn mit der Überlastung ihrer eigenen Netze durch unregelmäßige Wind- und Solarenergie konfrontiert:

Die Abkehr des Landes von Kernkraft und die Zunahme der Erzeugung von Wind- und Solarenergie ist inzwischen an einem Punkt angelangt, an dem die bestehenden Überlandleitungen nicht immer mithalten können. Und es sind Tschechien, Polen, die Niederlande, Frankreich und Belgien, die diese Tatsache ausbaden müssen.

„Falls es in Norddeutschland mal Sturm gibt, dann ist es soweit, dann bekommen wir den Stromausfall!“ sagte Martin Povejšil, ständiger EU-Botschafter der Tschechischen Republik in Brüssel jüngst bei einer Anhörung dort.

Deutschland hat es versäumt, seine Stromnetz-Infrastruktur in gleichem Umfang auszubauen wie die rasant wachsende Solar- und Windindustrie. Das heißt, besonders an sonnigen und gleichzeitig windigen Tagen ist Deutschland abhängig von der Freundlichkeit seiner Nachbarn, diese Menge zu verteilen. Polen und die Tschechische Republik waren gezwungen, 180 Millionen Dollar aufzubringen, um „ihre Systeme vor Energiewellen aus Deutschland zu schützen“. Dagegen verhindert in Deutschland selbst ein zunehmender NIMBY-ismus [NIMBY = Not In My BackYard = etwa: nicht vor meiner Haustür] den Bau neuer Überlandleitungen.

Bei der Betrachtung der Kosten der zunehmenden Erneuerbaren ist es ein großer Fehler, die Ausgaben für die Netzausrichtung zur Handhabung von Überproduktion außen vor zu lassen. Deutschland scheint mit seiner Energiewende genau diesen Fehler gemacht zu haben, und Mitteleuropa hat größte Mühe, damit fertig zu werden.

The American Interest

Deutschlands Wind lässt Mitteleuropa erzittern: Kernkraft auf den Müll zu werfen schafft große Probleme für Deutschlands Nachbarn:

Kalina Oroschakoff, Politico, 3. August 2015

Deutschlands Hinwendung zu erneuerbarer Energie wurde als ein historisches Politikum beschrien – aber Deutschlands Nachbarn mögen das überhaupt nicht.

Die Abkehr des Landes von Kernkraft und die Zunahme der Erzeugung von Wind- und Solarenergie ist inzwischen an einem Punkt angelangt, an dem die bestehenden Überlandleitungen nicht immer mithalten können. Und es sind Tschechien, Polen, die Niederlande, Frankreich und Belgien (hier), die diese Tatsache ausbaden müssen.

„Falls es in Norddeutschland mal Sturm gibt, dann ist es soweit, dann bekommen wir den Stromausfall!“ sagte Martin Povejšil, ständiger EU-Botschafter der Tschechischen Republik in Brüssel jüngst bei einer Anhörung dort.

Deutschlands Nord-Süd-Überlandleitungen haben eine zu geringe Kapazität, um die gesamte, von entlang der Nordsee installierten Windturbinen erzeugte Energie in die industrialisierten Bundesländer wie Bayern und Baden-Württemberg sowie nach Österreich zu leiten. Dies bedeutet, dass die überschüssige Energie durch die Tschechische Republik und Polen gejagt wird.

Um diesen oftmals unerwarteten Energieflüssen aus Deutschland einen Riegel vorzuschieben nehmen diese Länder das jetzt in die eigene Hand. Besorgt hinsichtlich der Stabilität ihrer eigenen Netze, zusätzlicher Kosten und der Fähigkeit, ihre eigene Energie zu exportieren, schaffen beispielsweise die Tschechen technische Installationen, um von 2016 an die Energie aus Deutschland zu blockieren.

Auch Polen arbeitet an solchen Installationen, Phasenschieber genannt, und erwartet, noch in diesem Jahr die ersten davon in Betrieb nehmen zu können. Im Westen haben auch die Niederlande, Belgien und Frankreich Phasenschieber installiert, um die Überschüsse aus Deutschland abzuwehren.

Diese unabhängig voneinander durchgeführten Bemühungen kommen zu einem Zeitpunkt, da Brüssel auf eine Integration der europäischen Energiemärkte drängt. Die Bemühungen zeigen, wie die Hinwendung zu noch mehr erneuerbarer Energie in Kombination mit veralteter Infrastruktur und inkonsistenter Kooperation innerhalb der EU unbeabsichtigte Nebenwirkungen zeitigen.

„In der Vergangenheit war das Energiesystem mit Kohle und Kernkraft extrem leicht vorhersagbar. Jetzt nimmt die Vorhersehbarkeit des Systems mit immer mehr zugeführter erneuerbarer Energie immer mehr ab, was auch zu einer Herausforderung der Markt-Debatte führt“, sagte Joanna Maćkowiak Pandera, eine leitende Mitarbeiterin der deutschen Denkfabrik Agora Energiewende.

„Wir haben dies den Deutschen immer wieder gesagt, ,erweitert euer Leitungssystem, oder wir werden euch ausschließen’“, sagte ein EU-Diplomat bei einer Anhörung in Brüssel.

Flüsse überschüssiger Energie entstehen, wenn die Netz-Infrastruktur eines Landes nicht ausreicht, Produktionsüberschüsse zu verkraften. Dann wird der Strom automatisch durch die Nachbarländer geleitet auf dem Weg zu dem Land, in dem er gebraucht wird.

„Dies führt auch zu Verstopfung in den Nachbarsystemen“, sagte Georg Zachmann von der in Brüssel ansässigen Denkfabrik Bruegel. Dies kommt zusätzlich zu der Situation, dass Länder ihre eigenen Stromexporte nach Süddeutschland reduzieren können, um Platz für den Strom aus Deutschland zu machen. Dies jedoch bedeutet, dass Deutschlands Energiewende das Exportpotential von Ländern wie der Tschechischen Republik und Frankreich schädigt.

Der Druck auf Deutschland, seine Nord-Süd-Verbindungen auszubauen, steigt. Aber diese Pläne führten zu lokalen Protesten in Bayern, wo die Anwohner nicht gewillt sind hinzunehmen, dass ihre wunderschöne Landschaft durch unansehnliche Überlandleitungsmasten verschandelt wird.

„Falls wir einen zunehmenden Anteil an Erneuerbaren haben wollen, müssen wir die Netze ausbauen; sagte Walter Boltz, Vizepräsident des Vorschriften-Gremiums der Agency for the Cooperation of Energy Regulators (ACER).

Die einfachste Lösung wäre es ihm zufolge, dass Deutschland die erforderlichen Verbindungen errichte. Aber das wird dauern. Alternativ könnte Deutschland einfach seine Windenergieanlagen an sehr produktiven Tagen abregeln, aber dem steht die Politik des Landes im Wege.

„Es ist ein unbequemes Problem und hat mit der irrationalen politischen Priorität Deutschlands zu tun, der zufolge man nicht einfach Erneuerbare stilllegen kann“, sagte Boltz.

Deutschlands Nachbarn sind nicht immun gegen Kritik zu dieser Angelegenheit. Polen beispielsweise könnte die Energieimporte aus Deutschland selbst nutzen, den sie seiner Industrie vorenthält. Außerdem müsste auch Polen seine Netze erweitern.

Mehr Kooperation

Deutschland für seinen teil hat die Kooperation mit seinen Nachbarn verstärkt, um dem Problem abzuhelfen. Energie-Staatssekretär Rainer Baake hat jüngst Kritik an der Behauptung geübt, dass Deutschlands Energiewende ein einseitiger politischer Akt gewesen sei. Deutschen Medien zufolge sagte er dazu: „Personen innerhalb und außerhalb Deutschlands, die glauben, dass dies eine Art Re-Nationalisierung der Energiepolitik sei, könnten nicht noch mehr unrecht haben“.

Im Jahre 2014 sind die deutschen Netzbetreiber mit den Tschechen überein gekommen, die grenzüberschreitenden Flüsse zu regulieren, um das Netz in Tschechien vor Überlastung zu bewahren und das Risiko von Stromausfällen zu senken. Ein ähnliches Abkommen zwischen Polen und Deutschland wurde auf den Weg gebracht.

Auf politischer Ebene unterzeichnete Deutschland im Juni einen Pakt mit 11 „Strom“-Nachbarn einschließlich Frankreich, Polen und Tschechischer Republik, um die Integration der jeweiligen Energiemärkte voranzutreiben, gegen Überkapazitäten vorzugehen und es dem Markt zu überlassen, die Energiepreise festzulegen.

Dennoch hat Polen im vorigen Jahr einen Brief an ACER geschrieben mit der Aufforderung, mit einem Standpunkt hinsichtlich der Überschüsse aus Deutschland aufzuwarten. Eine Antwort wird für September erwartet.

Im Jahre 2013 war die Agentur hinsichtlich ungeplanter Überschüsse zu der Schlussfolgerung gekommen, dass „diese Flüsse in den meisten Fällen eine Bedrohung für ein sicheres und effizientes Funktionieren des internen Energiemarktes sind“.

Energiemix ist nationale Politik

Die Lage ist für die Tschechische Republik und Polen heikel. Diese Länder haben lange darauf bestanden, dass die Auswahl, ob Energie durch Wind, Sonne, Kohle, Kernkraft oder auf andere Weise erzeugt wird, auf nationaler Ebene getroffen wird, nicht auf Brüsseler Ebene.

Daher steht es Deutschland frei, Entscheidungen hinsichtlich der Art seiner Energieerzeugung zu treffen, in diesem Falle die Entscheidung zur Schließung seiner Kernkraftwerke.

Brüssel hat Bemühungen gestartet, um die Energiemärkte des Blocks miteinander zu verbinden, wobei die Europäische Kommission in einem politischen Papier im Februar betonte, dass „die Verbindung der Strommärkte eine politische Priorität sein muss“.

Die Kommission erließ Mitte Juli einen initialen Plan dazu, wie ein grenzenloser Energiemarkt geschaffen werden könnte, der mit dem Anstieg der Erneuerbaren fertig wird. Die Vorlage des Entwurfs ist für das Jahr 2016 geplant.

„Wir haben die Netze nicht entwickelt“, sagte Energiechef Miguel Arias Cañete im vorigen Monat und fügte hinzu, dass während es viele Investitionen in Erneuerbare gegeben hatte, die Netze nicht im gleichen Maßstab ausgebaut worden sind. Auch das ist ein Grund, warum Brüssel so erpicht darauf ist, grenzüberschreitende Verbindungen zunehmen zu lassen.

Es unternimmt politische und finanzielle Bemühungen (hier), um am Ende mindestens 10 Prozent der in der EU installierten Erzeugungs-Kapazität bis zum Jahre 2020 zu verbinden.

Aber es ist ein langer Weg, den Block zu verbinden: hatten doch die EU-Länder dieses Ziel bereits für das Jahr 2002 vereinbart.

Politico

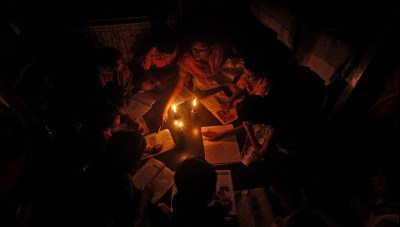

Deutschlands Windkraft-Chaos stürzt dessen Nachbarn in Dunkelheit

Link: http://stopthesethings.com/2015/08/15/germanys-wind-power-surges-plunge-their-neighbours-into-darkness/

Übersetzt von Chris Frey EIKE

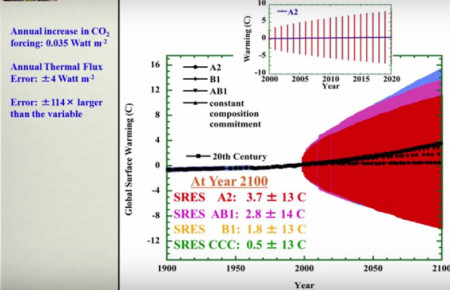

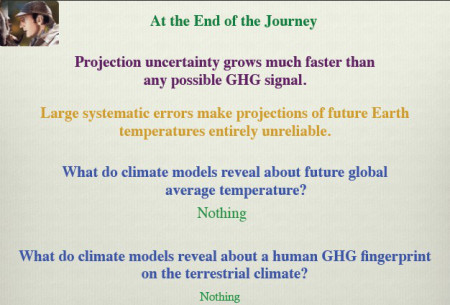

Video mit PP-Folien

Video mit PP-Folien