Strandinterviews: Dr. Klaus Puls

Strandgespräch

Strandgespräch im März 11 auf Sylt über den Meeresspiegel mit Dipl, Meteorologen Klaus Puls EIKE. Das Gespräch führt Wolfgang Müller EIKE

Strandgespräch

Strandgespräch im März 11 auf Sylt über den Meeresspiegel mit Dipl, Meteorologen Klaus Puls EIKE. Das Gespräch führt Wolfgang Müller EIKE

….Die Klima-Katastrophen-Auguren verkünden heute in den Medien zum x-ten Mal die Überflutung der Kontinente, n i c h t auf der Basis von Messungen (die zeigen das Gegenteil! s.w.u.), sondern auf der Basis von Sediment-Analysen;

h i n z u kommt: es handelt sich um eine ausgewählte kleine Küstenregion, von der die Autoren auf alle weltweiten Meere schließen!

in der Original-Presse-Miteilung heißt es nämlich dazu :

"… Das zeigt eine Untersuchung von Ablagerungen an der US-Atlantikküste – …"

Sehen Sie hier ganz aktuell die Verbreitung dieser Ente durch den WDR II. Mit Dank an Solarkritik.de

(1) GLEICHZEITIG zur o.a. Verlautbarung erscheint soeben im US-Coastel Journal der hier beigefügte Artikel, in dem auf der Basis von Pegel-Messungen klipp+klar das Gegenteil bewiesen wird:

"Der weltweite Temperaturanstieg hat keine Beschleunigung des globalen Meeresspiegelanstieges verursacht, sondern wahrscheinlich sogar eine Entschleunigung in den vergangenen 80 Jahren."

hier die gesamte  Publikation :

Publikation :

(2) EUMETSAT hat kürzlich die aktuellen GLOBALEN Daten/Messungen zum Meeres-Spiegel veröffentlicht -ERGEBNIS: Von einem beschleunigten Meeresspiegelanstieg keine Spur !

(3) Zum gleichen Ergebnis kommt das GFZ Potsdam :

Die GFZ-Daten beweisen darüber hinaus, daß es überhaupt keinen globalen einheitlichen Meerestrend gibt, sondern stets auch riesige Areale mit fallendem Meeresspiegel !

(4) Anhand der langjährigen zuverlässigen Pegel von Norderney + Cuxhaven kommen in Niedersachsen die Landesregierung und der Niedersächsische Landesverband NLWKN auch für die Nordseeküste zu der klaren Aussage, daß es keine Beschleunigung des Meeresspiegelanstiegs gibt :

(5) Arbeiten des Institutes für historische Küstenforschung Wilhelmshaven

kommen ebenfalls zu ganz anderen Ergebnissen:

Danach : Der Meeresspiegel ist in den vergangenen Jahren nie so langsam gestiegen, wie im 20. Jahrhundert ! …von einer Beschleunigung keine Spur.

(6) Ein Autorenteam der NASA hat kürzlich eine Arbeit publiziert, aus der u.a. zwei Dinge klar hervor gehen:

(a) Es existiert kein beschleunigter Meeresspiegelanstieg,

(b) die Meerestemperatur zeigt einen abnehmenden(!) Trend,

folglich existiert auch kein thermisch beschleunigter Meeresspiegelanstieg :

(7) Auch das IPCC hat offensichtlich die gleichen Erkenntnisse, denn von Bericht zu Bericht wurde die Prognoserate des Meeresspiegels für 2100 zurück genommen – auf mittlerweile unter 40 cm :

Berücksichtigt man, daß dem Autorenteam weltweit als Alarmisten bekannte Autoren wir Michael Mann (Hockey-Stick-Erfinder), Stefan Rahmstorf (PIK) et al.

angehören, so sind erheblich Zweifel an der Aussagekraft dieses neuen Weltuntergangs-Papiers angebracht.

Eine jüngst erschienene kritische Auseinandersetzung mit dem neuerlichen Meeres-Spiegel-Alarmismus findet sich auch hier:

Klaus-Eckart Puls EIKE

Weiterführender Link z.B hier: Mann´s neues Meeresspiegel Hockeystick Papier

oder hier eine lesenswerte Besprechung des Aufsatzes von Michael Krüger auf Science Skeptical

Was ist Chaos? Ich benutze diesen Ausdruck hier in seiner mathematischen Bedeutung. So, wie in den vergangenen Jahren die Naturwissenschaftler weitere Aggregatzustände der Materie entdeckten (neben fest, flüssig, gasförmig, nun auch plasma), so wurden von der Wissenschaft neue Zustände entdeckt, die Systeme annehmen können.

Einer davon ist mathematisch zugänglich, die zukünftigen Zustandsformen können leicht vorhergesagt werden; im anderen aber passiert scheinbar Zufälliges.

Diesen zweiten Zustand nennen wir “Chaos”. Es kann gelegentlich in vielen Systemen eintreten.

Wenn Sie z. B. das Pech haben, einen Herzanfall zu erleiden, geht der normalerweise vorhersehbare Herzschlag in einen chaotischen Zustand über, wo der Muskel scheinbar zufällig schlägt. Nur ein Schock kann ihn in den Normalzustand zurücksetzen. Wenn Sie jemals ein Motorrad auf einer eisigen Fahrbahn scharf abgebremst haben, mussten Sie ein unkontrollierbares Schlagen des Lenkrads befürchten, eine chaotische Bewegung, die meist zu einem Sturz führte. Es gibt Umstände, wo sich die Meereswogen chaotisch bewegen und unerklärlich hohe Wellen erzeugen.

Die Chaos-Theorie ist das Studium des Chaos und weiterer analytischer Methoden und Messungen und von Erkenntnissen, die während der vergangenen 30 Jahre gesammelt worden sind.

Im Allgemeinen ist Chaos ein ungewöhnliches Ereignis. Wenn die Ingenieure die Werkzeuge dafür haben, werden sie versuchen, es aus ihrem Entwurf „heraus zu entwerfen“, d. h. den Eintritt von Chaos unmöglich zu machen.

Es gibt aber Systeme, wo das Chaos nicht selten, sondern die Regel ist. So eines ist das Wetter. Es gibt weitere, die Finanzmärkte zum Beispiel, und – das ist überraschend – die Natur. Die Erforschung der Raubtierpopulationen und ihrer Beutetierpopulationen zeigt z. B. das sich diese zeitweilig chaotisch verhalten. Der Autor hat an Arbeiten teilgenommen, die demonstrierten, dass sogar einzellige Organismen Populationschaos mit hoher Dichte zeigen können.

Was heißt es also, wenn wir sagen, dass sich ein System anscheinend zufällig verhalten kann? Wenn ein System mit dem zufälligen Verhalten anfängt, wird dann das Gesetz von Ursache und Wirkung ungültig?

Vor etwas mehr als hundert Jahren waren die Wissenschaftler zuversichtlich, dass jedes Ding in der Welt der Analyse zugänglich wäre, dass alles vorhersagbar wäre, vorausgesetzt man hätte die Werkzeuge und die Zeit dazu. Diese gemütliche Sicherheit ist zuerst von Heisenbergs Unschärfeprinzip zerstört worden, dann durch Kurt Gödels Arbeiten, schließlich durch Edward Lorenz, der als Erster das Chaos entdeckte. Wo? natürlich bei Wetter-Simulationen.

Chaotische Systeme sind nicht gänzlich unvorhersagbar, wie wirklich Zufälliges. Sie zeigen abnehmende Vorhersagbarkeit mit zunehmender Dauer, und diese Abnahme wird durch immer größer werdende Rechenleistung verursacht, wenn der nächste Satz von Vorhersagen errechnet werden soll. Die Anforderungen an Rechnerleistung zur Vorhersage von chaotischen Systemen wächst exponentiell. Daher wird mit den verfügbaren begrenzten Möglichkeiten die Genauigkeit der Vorhersagen rapide abfallen, je weiter man in die Zukunft prognostizieren will. Das Chaos tötet die Ursache-Wirkungs-Beziehung nicht, es verwundet sie nur.

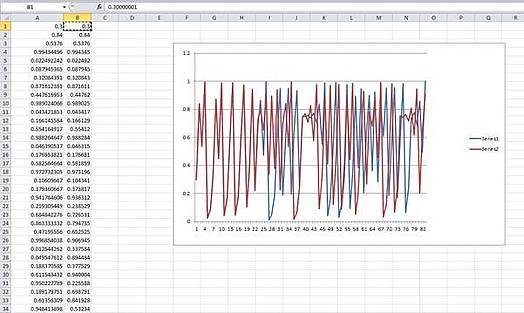

Jedermann hat ein Tabellenkalkulationsprogramm. Das nachfolgende Beispiel kann jeder selbst ganz einfach ausprobieren.

Die einfachste vom Menschen aufgestellte Gleichung zur Erzeugung von Chaos ist die „Logistische Karte“ (logistic map).

In einfachster Form: Xn+1 = 4Xn(1-Xn)

Das bedeutet: der nächste Schritt in Folge gleicht 4 mal dem vorhergehenden Schritt mal (1 – vorhergehender Schritt). Wir öffnen nun ein Blatt in unserer Tabellenkalkulation und bilden zwei Spalten mit Werten:

Jede Spalte A und B wird erzeugt, indem wir in Zelle A2 eingeben [=A1*4* (1-A1)], und wir kopieren das nach unten in so viele Zellen, wie wir möchten. Das gleiche tun wir für Spalte B2, wir schreiben [=B1*4* (1-B1)]. Für A1 und B1 geben wir die Eingangszustände ein. A1 erhält 0.3 und B1 eine ganz gering verschiedene Zahl: 0.30000001.

Der Graph zeigt die beiden Kopien der Serien. Anfänglich sind sie synchron, dann beginnen sie bei etwa Schritt 22, auseinander zulaufen, von Schritt 28 an verhalten sie sich völlig unterschiedlich.

Dieser Effekt stellt sich bei einer großen Spannweite von Eingangszuständen her. Es macht Spaß, sein Tabellenkalkulationsprogramm laufen zu lassen und zu experimentieren. Je größer der Unterschied zwischen den Eingangszuständen ist, desto rascher laufen die Folgen auseinander.

Der Unterschied zwischen den Eingangszuständen ist winzig, aber die Serien laufen allein deswegen auseinander. Das illustriert etwas ganz Wichtiges über das Chaos. Es ist die hohe Empfindlichkeit für Unterschiede in den Eingangszuständen.

In umgekehrter Betrachtung nehmen wir nun an, dass wir nur die Serien hätten; wir machen es uns leicht mit der Annahme, wir wüssten die Form der Gleichung, aber nicht die Eingangszustände. Wenn wir nun Vorhersagen von unserem Modell her treffen wollen, wird jede noch so geringe Ungenauigkeit in unserer Schätzung der Eingangszustände sich auf das Vorhersage-Ergebnis auswirken und das in dramatisch unterschiedlichen Ergebnissen. Der Unterschied wächst exponentiell. Eine Möglichkeit zur Messung gibt uns der sogenannte Lyapunov-Exponent. Er misst in Bits pro Zeitschritt, wie rasch die Werte auseinanderlaufen – als Durchschnitt über eine große Zahl von Samples. Ein positiver Lyapunov-Exponent gilt als Beweis für Chaos. Er nennt uns auch die Grenze für die Qualität der Vorhersage beim Versuch der Modellierung eines chaotischen Systems.

Diese grundlegenden Charakteristiken gelten für alle chaotischen Systeme.

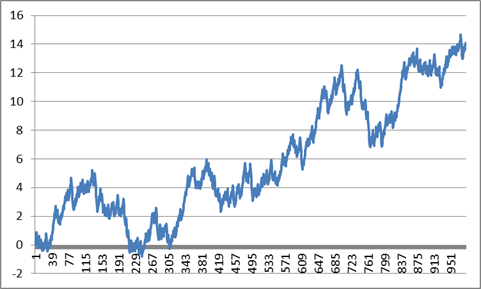

Und nun kommt etwas zum Nachdenken. Die Werte unseres einfachen Chaos-Generators im Kalkulationsblatt bewegen sich zwischen 0 and 1. Wenn wir 0.5 subtrahieren, sodass wir positive and negative Werte haben, und dann summieren, erhalten wir diesen Graphen. Der ist jetzt auf tausend Punkte ausgedehnt.

Wenn ich nun ohne Beachtung der Skalen erzählt hätte, das wäre der Kurs im vergangenen Jahr für eine bestimmten Aktie, oder der jährliche Meerestemperaturverlauf gewesen, hätten Sie mir vermutlich geglaubt. Was ich damit sagen will: Das Chaos selbst kann ein System völlig antreiben und Zustände erzeugen, die so aussehen, als ob das System von einem äußeren Antrieb gesteuert wäre. Wenn sich ein System so verhält, wie in diesem Beispiel, kann es wegen einer äußeren Kraft sein, oder ganz einfach nur wegen des Chaos.

Edward Lorenz (1917 – 2008) ist der Vater der Chaosforschung. Er war auch Wetterforscher. Er schuf eine frühe Wetter-Simulation, indem er drei verkoppelte Gleichungen benutzte und er war erstaunt, dass die Simulationswerte mit dem Fortschritt der Simulation über der Zeit unvorhersehbar wurden.

Dann suchte er nach Beweisen, ob sich das tatsächliche Wetter in der gleichen unvorhersehbaren Weise verhielt. Er fand sie, bevor er noch mehr über die Natur des Chaos entdeckte.

Edward Lorenz schätzte, dass das globale Wetter einen Lyapunov-Exponenten gleich einem Bit von Information alle 4 Tage zeigt. Das ist ein Durchschnitt über die Zeit und über die globale Oberfläche. Zuweilen und an gewissen Stellen ist das Wetter chaotischer, das kann jedermann in England bezeugen. Das bedeutet aber auch, dass, falls man das Wetter mit einer Genauigkeit von 1 Grad C für morgen vorhersagen kann, die beste Vorhersage für das Wetter für den 5. Folgetag bei +/- 2 Grad liegen wird, für den 9. Tag bei +/-4 Grad und den 13. Tag bei +/- 8 Grad. Auf jeden Fall wird die Vorhersage für den 9-10. Tag nutzlos sein. Wenn Sie aber das Wetter für Morgen mit einer Treffsicherheit von +/- 0.1 Grad vorhersagen könnten, dann würde die Zunahme des Fehlers verlangsamt. Weil sie aber exponentiell steigt, wird auch diese Vorhersage bereits nach wenigen weiteren Tagen nutzlos sein.

Interessanterweise fällt die Treffsicherheit der Wettervorhersagen von Institutionen, wie z. B. dem englischen Wetterdienst, genau in dieser Weise ab. Das beweist einen positiven Lyapunov-Exponenten und damit, dass das Wetter chaotisch ist, wenn es noch eines Beweises bedurft hätte.

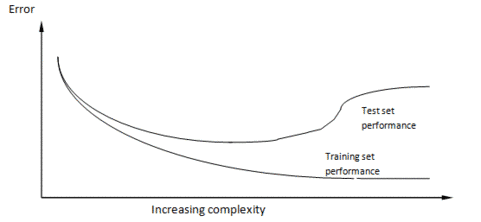

Zuerst zur wissenschaftlichen Methode. Das Grundprinzip ist, dass die Wissenschaft sich so entwickelt, dass jemand eine Hypothese formuliert, diese Hypothese durch ein Experiment erprobt und sie modifiziert, sie beweist oder verwirft, indem er die Ergebnisse des Experiments auswertet.Ein Modell, ob nun eine Gleichung oder ein Computer-Modell, ist nur eine große Hypothese. Wenn man die mit der Hypothesenbildung betroffene Sache nicht durch ein Experiment modifizieren kann, dann muss man Vorhersagen mit dem Modell machen und am System selbst beobachten, ob die Vorhersagen damit zu bestätigen oder zu verwerfen sind.##Ein klassisches Beispiel ist die Herausbildung unseres Wissens über das Sonnensystem. Bei den ersten Modellen standen wir im Mittelpunkt, dann die Sonne, dann kam die Entdeckung der elliptischen Umläufe und viele Beobachtungen, um die exakte Natur dieser Umläufe zu erkennen. Klar, dass wir niemals hoffen konnten, die Bewegungen der Planeten zu beeinflussen, Experimente waren unmöglich. Aber unsere Modelle erwiesen sich als richtig, weil Schlüsselereignisse zu Schlüsselzeiten stattfanden: Sonnenfinsternisse, Venusdurchgänge usw. Als die Modelle sehr verfeinert waren konnten Abweichungen zwischen Modell und Wirklichkeit benutzt werden, um neue Eigenschaften vorherzusagen. Auf diese Art konnten die äußeren Planeten Neptun und Pluto entdeckt werden. Wenn man heute auf die Sekunde genau wissen will, wo die Planeten in zehn Jahren stehen, gibt es im Netz Software, die exakt Auskunft gibt.Die Klimatologen würden nur allzu gerne nach dieser Arbeitsweise verfahren. Ein Problem ist aber, dass sie aufgrund des chaotischen Charakters des Wetters nicht die geringste Hoffnung hegen können, jemals Modellvorhersagen mit der Wirklichkeit in Einklang bringen zu können. Sie können das Modell auch nicht mit kurzfristigen Ereignissen zur Deckung bringen, sagen wir für 6 Monate, weil das Wetter in 6 Monaten völlig unvorhersagbar ist, es sei denn in sehr allgemeinen Worten.Das bedeutet Schlimmes für die ModellierbarkeitNun möchte ich noch etwas in dieses Durcheinander einwerfen. Das stammt aus meiner anderen Spezialisierung, der Welt des Computer-Modellierens von selbst-lernenden Systemen.Das ist das Gebiet der „Künstlichen Intelligenz“, wo Wissenschaftler meist versuchen, Computer- Programme zu erstellen, die sich intelligent verhalten und lernfähig sind. Wie in jedem Forschungsfeld ruft das Konzept Mengen von allgemeiner Theorie hervor, und eine davon hat mit der Natur der Stück-um-Stück zunehmenden Erfahrung (Inkrementelle Erfahrung) zu tun.Inkrementelle Erfahrung findet statt, wenn ein lernender Prozess versucht, etwas Einfaches zu modellieren, indem er vom Einfachen ausgeht und Komplexität zufügt, dabei die Güte des Modells beim Fortgang testet.Beispiele sind Neuronale Netzwerke, wo die Stärke der Verbindungen zwischen simulierten Hirnzellen mit dem Prozess des Lernens angepasst wird. Oder genetische Programme, wo Bits von Computerprogrammen modifiziert werden und bearbeitet werden, um das Modell immer mehr anzupassen.Am Beispiel der Theorien über das Sonnensystem können Sie sehen, dass die wissenschaftliche Methode selbst eine Form des inkrementellen Lernens ist.Es gibt einen universellen Graphen über das Inkrementelle Lernen. Er zeigt die Leistung eines beliebigen inkrementellen Lern-Algorithmus bei zwei Datensätzen, ganz gleich bei welchem.Voraussetzung ist, dass die beiden Datensätze aus der gleichen Quelle stammen müssen, aber sie sind zufällig in zwei Datensätze aufgespaltet, in den Trainingsdatensatz für die Trainierung des Modells und in einen Testdatensatz, der immer wieder für das Überprüfen gebraucht wird. Normalerweise ist der Trainingsdatensatz größer als der Testdatensatz, aber wenn es viele Daten gibt, macht das nichts aus. Mit der Zunahme des Wissens im Trainingsmodell benutzt das lernende System die Trainingsdaten, um sich selbst anzupassen, nicht die Testdaten, die zum Testen des Systems benutzt und sofort wieder vergessen werden.

Wie zu sehen ist, wird die Leistung mit dem Trainingsdatensatz immer besser, je mehr Komplexität dem Modell zugefügt wird, auch die Leistung des Testdatensatzes wird besser, beginnt aber dann, schlechter zu werden.

Um es deutlich zu sagen: der Testsatz ist das Einzige, was zählt. Wenn wir das Modell für Vorhersagen benutzen wollen, werden wir es mit neuen Daten füttern, wie mit unserem Testdatensatz. Die Leistung des Trainingsmodells ist irrelevant.

Über dieses Beispiel wird diskutiert, seit Wilhelm von Ockham den Satz geschrieben hat: “Entia non sunt multiplicanda praeter necessitatem“, besser bekannt als „Ockhams Rasiermesser“ und am besten so übersetzt: “Die Entitäten dürfen nicht ohne Not vermehrt werden”. Mit Entitäten meinte er unnötige Verzierungen und Schnörkel einer Theorie. Die logische Folge daraus ist, dass die am einfachsten die Fakten erklärende Theorie wahrscheinlich stimmt. Es gibt Beweise für die Allgemeingültigkeit dieses Satzes aus dem Gebiet der Bayesianischen Statistik und der Informationstheorie.

Das heißt also, dass unsere kühnen Wettermodellierer von beiden Seiten her in Schwierigkeiten stecken: wenn die Modelle für die Wettererklärung nicht ausreichend komplex sind, sind ihre Modelle nutzlos, wenn sie allzu komplex sind, auch.

Unter der Voraussetzung, dass sie ihre Modelle nicht anhand der Wirklichkeit kalibrieren können, wie entwickeln und prüfen die Wettermodellierer ihre Modelle?Wie wir wissen, verhalten sich auch Wettermodelle chaotisch. Sie zeigen die gleiche Empfindlichkeit auf die Eingangsbedingungen. Das Mittel der Wahl für die Evaluierung (von Lorenz entwickelt) ist, Tausende von Läufen durchzuführen mit jeweils geringfügig anderen Eingangsbedingungen. Die Datensätze heißen „Ensembles”.Jedes Beispiel beschreibt einem möglichen Wetter-Pfad, und durch die Zusammenstellung des Satzes wird eine Verteilung möglicher Zielentwicklungen erzeugt. Für Wettervorhersagen zeigen sie mit dem Spitzenwert ihre Vorhersage an. Interessanterweise gibt es bei dieser Art von Modell-Auswertung wahrscheinlich mehr als nur eine Antwort, also mehr als einen Spitzenwert, aber über die anderen, auch möglichen Entwicklungen, wird nicht gesprochen. In der Statistik heißt dieses Verfahren „Monte Carlo Methode“.Beim Klimawandel wird das Modell so modifiziert, dass mehr CO2 simuliert wird, mehr Sonneneinstrahlung oder andere Parameter von Interesse. Und dann wird ein neues Ensemble gerechnet. Die Ergebnisse stellen eine Serie von Verteilungen über der Zeit dar, keine Einzelwerte, obwohl die von den Modellierern gegebenen Informationen die alternativen Lösungen nicht angeben, nur den Spitzenwert.Die Modelle werden nach der Beobachtung der Erde geschrieben. Landmassen, Luftströmungen, Baumbedeckung, Eisdecken, usw. werden modelliert. Sie sind eine große intellektuelle Errungenschaft, stecken aber noch immer voller Annahmen. Und wie man erwarten kann, sind die Modellierer stets bemüht, das Modell zu verfeinern und neue Lieblingsfunktionen zu implementieren. In der Praxis gibt es aber nur ein wirkliches Modell, weil alle Veränderungen rasch in alle eingebaut werden.Schlüsselfragen der Debatte sind die Interaktionen zwischen den Funktionen. So beruht die Hypothese vom Durchgehen der Temperaturen nach oben infolge von erhöhtem CO2 darauf, dass die Permafrostböden in Sibirien durch erhöhte Temperaturen auftauen würden und dadurch noch mehr CO2 freigesetzt würde. Der daraus resultierende Feedback würde uns alle braten. Das ist eine Annahme. Die Permafrostböden mögen auftauen oder auch nicht, die Auftaugeschwindigkeit und die CO2-Freisetzung sind keine harten wissenschaftlichen Fakten, sondern Schätzungen. So gibt es Tausende von ähnlichen „besten Abschätzungen“ in den Modellen.Wie wir bei den inkrementell lernenden Systemen gesehen haben, ist allzu viel Komplexität genau so fatal, wie zu wenig. Niemand weiß, wo sich die derzeitigen Modelle auf der Graphik oben befinden, weil die Modelle nicht direkt getestet werden.Jedoch macht die chaotische Natur des Wetters alle diese Argumente über die Parameter zunichte. Wir wissen natürlich, dass Chaos nicht die ganze Wahrheit ist. Es ist in den ferner vom Äquator gelegenen Regionen im Sommer im Durchschnitt wärmer als im Winter geworden. Monsune und Eisregen kommen regelmäßig jedes Jahr vor und daher ist die Sichtweise verführerisch, dass das Chaos wie das Rauschen in anderen Systemen aussieht.

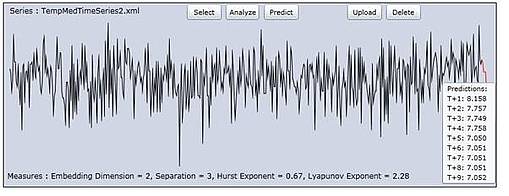

Um ein wenig auszuholen: Diese Idee des “Ausmittelns” von Fehlern/Rauschen hat eine lange Geschichte. Nehmen wir das Beispiel von der Höhenmessung des Mount Everest vor der Erfindung von GPS und Radar-Satelliten. Die Methode der Höhenermittlung war, auf Meereshöhe mit einem Theodoliten zu beginnen und die lokalen Landmarken auszumessen, indem man deren Abstand und Winkel über dem Horizont maß, um die Höhe zu schätzen. Dann wurde von den vermessenen Punkten aus das Gleiche mit weiteren Landmarken gemacht. So bewegte man sich langsam im Binnenland vor. Zum Zeitpunkt der Ankunft der Landvermesser am Fuße des Himalaja beruhten ihre Messungen auf Tausenden vorhergehenden Messungen. Alle mit Messfehlern. Im Endeffekt lag die Schätzung der Vermesser von der Höhe des Everest nur um einige zig Meter daneben.Das kam, weil die Messfehler selbst eine Tendenz zum Ausmitteln hatten. Wenn ein systemischer Fehler drin gewesen wäre, etwa von der Art, dass jeder Theodolit um 5 Grad zu hoch gemessen hätte, dann wären die Fehler enorm groß geworden. Der Punkt dabei ist, dass die Fehler dann keinen Bezug zum vermessenen Objekt gehabt hätten. Es gibt viele Beispiele dafür in der Elektronik, in der Radio-Astronomie und auf anderen Gebieten.Sie verstehen nun, dass die Klimamodellierer hoffen, dass das auch für das Chaos gilt. Sie behaupten ja tatsächlich, dass es so wäre. Bedenken Sie aber, dass die Theodolitenfehler nichts mit der tatsächlichen Höhe des Everest zu tun haben, wie auch das Rauschen in Radioteleskopverstärkern nichts mit den Signalen von weit entfernten Sternen zu tun hat. Das Chaos dagegen ist Bestandteil des Wetters. Daher gibt es keinerlei Grund, warum sich das „ausmitteln“ würde. Es ist nicht Bestandteil der Messung, es ist Bestandteil des gemessenen Systems selbst.Kann Chaos überhaupt „ausgemittelt“ werden? Falls ja, dann müssten wir bei Langzeitmessungen des Wetters kein Chaos erkennen. Als eine italienische Forschergruppe um meine Chaos-Analyse-Software bat, um eine Zeitreihe von 500 Jahren gemittelter süditalienischer Wintertemperaturen auszuwerten, ergab sich die Gelegenheit zur Überprüfung. Das folgende Bild ist die Ausgabe der Zeitreihe mittels meines Chaos-Analyse-Programms „ChaosKit“.

Ergebnis: Ein Haufen Chaos. Der Lyapunov-Exponent wurde mit 2.28 Bits pro Jahr gemessen.

Auf gut Deutsch: Die Treffsicherheit der Temperaturvorhersage vermindert sich um den Faktor 4 für jedes weitere Jahr, für welches eine Vorhersage gemacht werden soll, oder anders herum: die Fehler vervierfachen sich.

Wenn wir einen laufenden Durchschnitt über die Daten bilden würden, wie es die Wettermodellierer tun, um die unerwünschten Spitzen zu verbergen, können wir eine leichten Buckel rechts sehen, und viele Buckel links. Wäre es gerechtfertigt, dass der Buckel rechts ein Beweis für den Klimawandel ist? Wirklich nicht! Man könnte nicht entscheiden, ob der Buckel rechts das Ergebnis des Chaos und der angezeigten Verschiebungen wäre, oder ob da ein grundlegender Wandel wäre, wie zunehmendes CO2.

Fassen wir zusammen: die Klimaforscher haben Modelle konstruiert auf der Grundlage ihres Verständnisses des Klimas, derzeitigen Theorien und einer Reihe von Annahmen. Sie können ihre Modelle wegen der chaotischen Natur des Wetters nicht über kurze Zeiträume testen, das geben sie zu.

Sie hofften aber, dass sie kalibrieren könnten, ihre Modelle bestätigen oder reparieren, indem sie Langzeitdaten auswerteten. Aber wir wissen jetzt, dass auch dort das Chaos herrscht. Sie wissen nicht, und sie werden niemals wissen, ob ihre Modelle zu einfach, zu komplex oder richtig sind, weil – selbst wenn sie perfekt wären – angesichts der chaotischen Natur des Wetters keine Hoffnung besteht, die Modelle an die wirkliche Welt anpassen zu können. Die kleinsten Fehler bei den Anfangsbedingungen würden völlig unterschiedliche Ergebnisse hervorbringen.

Alles, was sie ehrlich sagen können, ist: “Wir haben Modelle geschaffen, wir haben unser Bestes getan, um mit der wirklichen Welt im Einklang zu sein, aber wir können keinen Beweis für die Richtigkeit liefern. Wir nehmen zur Kenntnis, dass kleine Fehler in unseren Modellen dramatisch andere Vorhersagen liefern können, und wir wissen nicht, ob wir Fehler in unseren Modellen haben. Die aus unseren Modellen herrührenden veröffentlichten Abhängigkeiten scheinen haltbar zu sein.“

Meiner Ansicht nach dürfen regierungsamtliche Entscheider nicht auf der Grundlage dieser Modelle handeln. Es ist wahrscheinlich, dass die Modelle so viel Ähnlichkeit mit der wirklichen Welt haben wie Computerspiele.

Zu guter Letzt, es gibt eine andere Denkrichtung in der Wettervorhersage. Dort herrscht die Meinung, dass das Langzeitwetter großenteils von Veränderungen der Sonnenstrahlung bestimmt wird. Nichts in diesem Beitrag bestätigt oder verwirft diese Hypothese, weil Langzeit-Aufzeichnungen der Sonnenflecken enthüllen, dass die Sonnenaktivität ebenfalls chaotisch ist.

Dr. Andy Edmonds

Übesetzt von Helmut Jäger EIKE

Anmerkung von Antony Watts: Nur damit wir uns gleich verstehen: Chaos beim Wetter ist NICHT dasselbe wie der oben beschrieben Klimazusammenbruch – Anthony

Den Originalbeitrag finden Sie hier

Kurzbiografie

Dr. Andrew Edmonds ist Wissenschaftler und schreibt Computer Software. Er hat viele frühe Computer Software Pakete auf dem Gebiet der „Künstlichen Intelligenz“ entworfen und er war möglicherweise der Autor des ersten kommerziellen „Data Mining“ Systems. Er war Vorstandssprecher einer amerikanischen Aktiengesellschaft und bei mehreren erfolgreichen Firmen-Neugründungen tätig. Seine Doktorarbeit behandelte die Vorhersagen von Zeitreihen in chaotischen Reihen. Daraus entstand sein Produkt ChaosKit, des einzigen abgeschlossenen kommerziellen Produkts für die Analyse von Chaos in Zeitreihen. Er hat Papiere über Neuronale Netze veröffentlicht und über genetisches Programmieren von „fuzzy logic“ Systemen, „künstlicher Intelligenz“ für den Handel mit Finanzprodukten. Er war beitragender Autor von Papieren auf den Gebieten der Biotechnologie, des Marketings und des Klimas.

Seine Webseite: http://scientio.blogspot.com/2011/06/chaos-theoretic-argument-that.html

Wissenschaftliche Politikberatung soll politischen Entscheidungsträgern das Werkzeug für rationale Entscheidungen in die Hand geben. Dies gilt offiziell auch für das Intergovernmental Panel on Climate Change (IPCC). Inoffiziell fungiert dieses Gremium jedoch als Durchlauferhitzer des Umweltlobbyismus von Umweltschutz-NGOs, wie Steven McIntyres (Climate Audit) Quellenanalyse der jüngsten Szenarien zum weltweiten Ausbau der Nutzung erneuerbarer Energieträger belegt.

![]() Seiner Recherche nach sind Greenpeace-Szenarien die Grundlage des vom IPCC jüngst veröffentlichten Materials, wobei der verantwortliche IPCC-Autor auch gleichzeitig bei der Erstellung der Szenarien für Greenpeace federführend war. Steve McIntyre kommentiert dieses PR-Desaster: 1)

Seiner Recherche nach sind Greenpeace-Szenarien die Grundlage des vom IPCC jüngst veröffentlichten Materials, wobei der verantwortliche IPCC-Autor auch gleichzeitig bei der Erstellung der Szenarien für Greenpeace federführend war. Steve McIntyre kommentiert dieses PR-Desaster: 1)

The public and policy-makers are starving for independent and authoritative analysis of precisely how much weight can be placed on renewables in the energy future. It expects more from IPCC WG3 than a karaoke version of Greenpeace scenario. (1)

Aber beim IPCC hat man es mit der Wahrheit noch nie sonderlich genau genommen. Bereits 2009 wurde enthüllt, dass die Erzeugnisse dieses IPCC ein kompletter Schwindel sind, der auf der Manipulation von Computermodellrechnungen basiert, die eine Erwärmung wegen des exzessiven Ausstoßes von CO2 simuliert haben. Dabei gab es nie irgendeine Bedrohung durch CO2. Es handelt sich dabei um ein für die Vegetation auf der Erde unabdingbar notwendiges Gas. Es repräsentiert nur einen sehr kleinen, ja winzigen Anteil der Erdatmosphäre.

Damals hatte Dr. Phil Jones, führender Klimaforscher und führendes Mitglied des UN-Welklimarates (IPCC) zerknirscht die Echtheit der veröffentlichten Daten bestätigt, wollte aber keinen Kommentar zu den unglaublichen Abgründen an Betrügereien und Geldbeschaffungen abgeben. (2)

Die gehackten Dateien und E-Mails unter IPCC-Klimawissenschaftlern gaben unter anderem darüber Aufschluss, wie Datensätze mit Tricks und Fälschungen erzeugt werden konnten, um damit anschaulich eine globale Erwärmung der Neuzeit vorzutäuschen.

Sie zeigen auch auf, wie „Abweichler“ gezielt öffentlich persönlich angegriffen und in ihrer wissenschaftlichen Reputation herabgewürdigt wurden. Dazu gehörte auch die Rückweisung ihrer abweichenden wissenschaftlichen Arbeiten im sogenannten „Peer-Review“-Verfahren, die offenbar schon vorher abgesprochen und vereinbart wurde.

(1) http://climateaudit.org/2011/06/14/ipcc-wg3-and-the-greenpeace-karaoke/

(2) http://community.zeit.de/user/schneefan/beitrag/2009/11/21/cruklimawissenschaftler-gehackt-ipccschwindel-weltweit-entlarvt

Autor Roger Baettig | June 16, 2011 Copyright International Business Times Originalartikel Hier

Mit dank an Spürnase Wolfgang Nabers

Wie zur Bestätigung hier ein Link zu einem Artikel bei Joanne Nova : .

Auszug:

The IPCC issued a press release (May 9th) though as usual, with no details or sources at the time. They got the media headlines, then quietly “backed” it up a month later with a 1000 page report they figure no one will read. Certainly, they must be a little surprised that within two days of quietly releasing the tome, it is spreading like fire across the blogosphere, and some of it’s deepest secrets are already out of the bag.

Let’s be clear about this, Greenpeace is a $200-million-euro-per-year machine (see theGreenpeace annual report for 2009). Their charity status was recently revoked in New Zealand. They are a big political animal, like the IPCC. But both are claiming to use science to support them. And both, it seems, cite each other as if they were scientific. Greenpeace openly, but the IPCC hides the reverse-citations in invisible ink, between the lines.

Ganz offensichtlich wird die Wirkung des anthropogenen Treibhauseffekts weit überschätzt, denn insbesondere der CO2-Treibhauseffekt war im wesentlichem schon zu Zeiten Goethes ausgereizt. Dies zeigen eigene quantitative Untersuchungen der IR-Absorption von Kohlendioxid mittels eines FT-IR-Spektrometers. Außerdem gibt es Äußerungen hierzu in der anerkannten Literatur, die offiziell allerdings heruntergespielt werden (23). Wegen des weitgehenden Sättigungseffekts ist der anthropogene Anteil der Treibhausgase für die gegenwärtige Klimaänderung von untergeordneter Bedeutung. Vielmehr geht die Varianz der Erdoberflächentemperatur mit der Wolkenbedeckung einher, die wiederum von der Fluktuation des solaren Magnetfelds abhängt. Mit anderen Worten: ähnlich wie ein offenes Kaminfeuers durch einen Paravent mehr oder weniger abgeschirmt wird, so steuert die Wolkendichte die Erdoberflächentemperatur weit stärker als der Treibhauseffekt. Der Einfluss der Wolkenbedeckung lässt sich aber mit den Klimamodellen des IPCC nur äußerst unzulänglich abbilden. Auch sind Klimamodelle möglicherweise auch deshalb ein spektroskopisches Artefakt, weil sie mit gewillkürten Flusskorrekturen arbeiten müssen, deren Beträge den des anthropogenen Treibhauseffekts um ein Vielfaches übersteigen.

Einleitung

Oftmals wird fälschlicherweise angenommen, der Treibhauseffekt sei mit der Absorption von Infrarotstrahlung (IR-Strahlung) durch atmosphärische Spurengase (CO2, CH4, Wasserdampf u. a.) identisch. Dadurch würde sich die Luft erwärmen, die dann ihre Wärmeenergie auf die Erdoberfläche übertrage. Es verhält sich genau umgekehrt: Die Erdoberfläche wird fast ausschließlich durch Bestrahlung erwärmt und die Atmosphäre nimmt ihre Wärmeenergie durch direkten Kontakt mit dem Erdboden auf.

Die Bestrahlung der Erdoberfläche setzt sich aber aus zwei Teilen zusammen:

1. Die direkte Solareinstrahlung (abhängig von der Wolkenbedeckung)

2. Der atmosphärische Treibhauseffekt (im wesentlichem ausgereizt)

Die Existenz einer atmosphärischen Gegenstrahlung, die den Treibhauseffekt charakterisiert, lässt sich zwar leicht nachweisen, aber bereits die Größenordnung des natürlichen Treibhauseffekts kann nur berechnet werden und die ihm zugeschriebene Auswirkung auf das Klima entzieht sich vollkommen der Falsifikation (18). Zum Verständnis des CO2-Treibhauseffekts ist es dennoch nützlich, sich zunächst einmal die „ganz normale“ Infrarot-Absorption atmosphärischer Spurengases zu betrachten (1).

Nimmt man einmal an, die auf der IR-Absorption beruhende Extinktion (E) würde innerhalb der Troposphäre (bis ca. 10 km Höhe) bei heutiger CO2-Konzentration in der Größenordnung von E = 2 im Maximum des Absorptionspeaks liegen, d.h. die Transmission T = I/I0 = 10-E wäre auf 0,01 reduziert, dann wäre es für jeden, der mit den Grundlagen der quantitativen IR-Spektroskopie vertraut ist, offensichtlich, dass eine Verdopplung des CO2 zu einer merklichenTemperaturerhöhung führen müsste. Tatsächlich liegt aber die Extinktion um viele Zehnerpotenzen höher. Deshalb ist nach einer einfachen Abschätzung von Jack Barrett (2) der maximal mögliche Treibhauseffekt schon nach einem Weg von 100 m über dem Erdboden erreicht. Tatsächlich liegt eine weitestgehende Sättigung aber keine Komplettsättigung vor. Die gibt es nicht aus quantenmechanischen Gründen.

In der Literatur werden vielfach Emissionsspektren (3) oder gelegentlich auch Absorptionsspektren (4) des CO2 gezeigt. Was einen Chemiker aber besonders interessiert, ist eine Abschätzung der Sättigung des Effekts mit Hilfe molarer Extinktionskoeffizienten der einzelnen Absorptionsbanden. CO2 ist zwar das mit am intensivsten untersuchte Molekül, weshalb man auch genügend quantitative Angaben aus der Literatur beziehen kann und natürlich gibt es die HITRAN-Spektren (5). Dennoch existieren offensichtlich unterschiedliche Vorstellungen. Auch unterliegt die prophezeite Klimaerwärmung großen Schwankungen, wobei in der Vergangenheit Angaben von 1,2 °C bis 11,5 °C bei CO2-Verdopplung genannt wurden. Dies war Anlass zu eigenen überschlagsmäßigen Messungen (6).

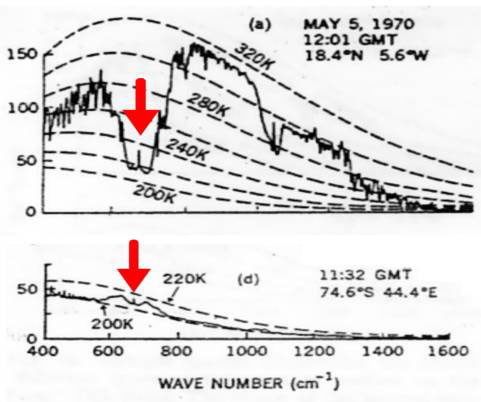

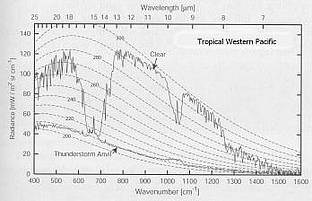

Zunächst muss aber geklärt werden, welche der Absorptions-/Emissionsbande des CO2 von Bedeutung ist. Hierüber geben Satellitenspektren Auskunft (3).

|

Bild 1: Satellitenspektren, oben über der Sahara, unten über der Antarktis

Die gestrichelten Linien im Bild 1 ist die ideale Planck-Strahlungskurve der Erdoberfläche berechnet bei unterschiedlichen Temperaturen in K. Die „gezackte Linien“ repräsentieren neben der ungehinderten Emission der Erdoberfläche (ca. 800 – 1000 cm-1 und ca. 1050 – 1300 cm-1) die Emissionsgraphen der atmosphärischen Treibhausgase. Die roten Pfeile im Bild 1 kennzeichnen die n2-Bande um 15 mm (667 cm-1). Deshalb ist nur diese relativ schwache von Bedeutung und nicht die wesentlich stärkere n3-Bande um 4,2 mm (2349 cm-1). Außerdem erkennt man, die Atmosphäre emittiert tatsächlich IR-Strahlung („Treibhauseffekt“) Dies sieht man ganz deutlich im Satellitenspektrum über der Arktis (unterer Teil im Bild 1). Die Bodentemperatur beträgt dort nämlich ca. 200 K (-73 °C), während die Atmosphäre in etwa 10 km Höhe eine höhere Temperatur von ca. 210 K (-63 °C) aufweist. Dies ist aber ein erster Hinweis darauf, dass der den IPCC-Computermodellen zugrunde liegende Strahlungstransport eine Fiktion ist. Es handelt sich vielmehr um einenEnergietransport. Dabei gelangt wärmere Luft zur Arktis und gibt ihre Energie oberhalb einer Höhe von 10 km als „ungestörte Emission“ ins Weltall ab.

1. Die Meßmethode

Zunächst soll die eigene Messung der Absorption des Kohlendioxids beschrieben werden. Eine 10 cm-Küvette mit IR-durchlässigem Fenster wurde mit synthetischer CO2-freier und wasserfreier Luft gefüllt. Danach wurde soviel CO2 mit einer Mikroliterspritze zugegeben, dass 357 ppm CO2 zugegen waren (Konzentration von 1993). Weiter wurden 2,6 % Wasserdampf zugegeben. Als IR-Strahlungsquelle diente ein Globar, ein elektrisch auf 1000-1200 ºC geheizter Siliziumkarbid-Stab mit nachgeschaltetem variablen Interferenzfilter. Nach der Aufnahme dieses Spektrums wurde mit CO2 aufgestockt, so dass 714 ppm enthalten waren. Die Messung erfolgte mit einem FT-IR-Spektrometer „Bruker IFS 48“. Als Auswertungssoftware diente das Programm OPUS. Ein Nullwert wurde ebenfalls aufgenommen und entsprechend subtrahiert.

1.1 Messung und Auswertung

Bild 2 zeigt das unbearbeitete Spektrum der 15 µm-Bande für 357 ppm CO2 und 2.6% H2O.

|

Bild 2: Unbearbeitetes Spektrum der 15 µm-Bande (n2-Bande)

Deutlich sind der R- (DJ = + 1) und der P- (DJ = – 1) sowie der Q-Zweig (DJ = +/- 0) der n2-Bande zu erkennen. Der Extinktionskoeffizient im Maximum ergab sich zu:

e = 20,2 m2 mol-1 (n2 bei 667 cm-1)

Um die Absorption zu berechnen, wurde der durchschnittliche CO2-Gehalt der Atmosphäre mit c = 1,03.10-3 mol/m3angenommen (aus der Gesamtstoffmenge und dem Volumen der Homosphäre). Setzt man die oben gemessenen molaren Extinktionen nebst der Konzentration und der Schichtdicke der Troposphäre (h = 10 km = 104 m) in das Lambert-Beer’sche-Gesetz ein, so erhält man

E(n2) = 20,2 m2 mol-1 × 1,03.10-3 mol/m3 × 104 m = 208

Dies bedeutet, dass die Transmissionen in der Mitte der Absorptionsbande bei den um 1997 gegebenen 357 ppm CO2 beiT(n2) = 10-208 liegt (Bild 3).

|

Bild 3: Spektrales Auswertungsschema

Dies ist ein extrem geringer Transmissionswert, der eine Steigerung des Treibhauseffektes bei Verdopplung des klimawirksamen Spurengases in diesem Bereich vollkommen ausschließt. Ähnliche Ergebnisse hat Jack Barrett anhand spektroskopischer und kinetischer Überlegungen (2) gefunden und damit prompt in ein Wespennest gestochen, weshalb 1995 von ihm eine äußerst heftige Diskussion angefacht wurde (7 – 10).

Setzt man den molaren Extinktionskoeffizient e für die n2-Bande sowie die Volumenkonzentration in mol/m3 (357 ppm CO2) in das Lambert-Beersche-Gesetz ein und nimmt eine Schichtdicke von 10 m an, resultiert eine Extinktion von

E = 20,2 m2 mol-1 × 0,0159 mol/m3× 10 m = 3,21

Dies entspricht einer Transmission von T = 10-3.21 = 0,6 Promille. Mit anderen Worten: Bereits nach 10 m sind 1 – T = 99,94% der IR-Strahlung absorbiert.

Bei der Absorption an den Peakflanken ist die Extinktion naturgemäß kleiner. Deshalb schreibt das IPCC1990 „The effect of added carbon dioxide molecules is, however, significant at the edges of the 15 µm band, and in particular around 13,7 and 16 µm (13)“. Natürlich existieren diese Ränder, denn die Rotationsquantenzahl J geht von J = + 1 bis J = + ¥ und vonJ = – 1 bis J = – ¥. Bedauerlicherweise werden aber die ungesättigten Bereiche an den Rändern immer schwächer. Die Besetzung der Rotationsniveaus gehorcht nämlich einer Boltzmann-Verteilung, weshalb immer weniger der vorliegenden CO2-Moleküle zu einem gegebenen Zeitpunkt in diesem Bereich absorbieren.

Um die Absorption an den Peakflanken abzuschätzen, wurde als Arbeitshypothese angenommen, die Extinktion soll sich bei Verdopplung des CO2-Gehalts um die Größenordnung E = 3 (T = 10-3) erhöhen. Hierzu wurde das Gesamtintegral der Banden bis zu den auslaufenden Enden des R- und P-Zweiges bei E = 0 ermittelt (s. Bild. 3). Anschließend wurden die digital abgespeicherten Spektren ab einer Extinktion, die dem Wert E = 3 (auf den Gesamtweg innerhalb der Troposphäre bezogen) entsprachen bis zu den auslaufenden Enden (E = 0) des R- und P-Zweiges integriert. Damit waren die „edges„ annähernd erfasst. Diese „edges„ begannen beim P-Zweig bei 14,00 µm und beim R-Zweig bei 15,80 µm und liefen jeweils bis zur Grundlinie E = 0. IPCC lässt die Banden an den Rändern bei 13,7 und 16 µm beginnen (13). Für die n2-Bande ergab sich folgendes:

| 15 µm-Bande | 357 ppm | 714 ppm |

| Gesamtintegral 624,04 cm -1 von 703,84 cm -1 | 0,5171/cm | 1,4678/cm |

| Summe der Flanken-Integrale | 1,11.10-4/cm | 9,79.10-4/cm |

Tabelle: 15 µm-Bande (Gesamtintegral und Flankenintegrale E = 0 bis E = 3)

Der relative Zuwachs des Treibhauseffekts bezogen auf das Gesamtintegral ist entscheidend. Er entspricht der Differenz der Flankenintegrale bei 714 ppm und 357 ppm im Verhältnis zum Gesamtintegral bei 357 ppm.

(9,79.10-4/cm – 1.11.10-4/cm) / 0,5171/cm = 0,17 %

Weil man mit der Planck-Strahlungsgleichung arbeiten muss, sind Extinktionen weniger geeignet, den Treibhauseffekt zu quantifizieren, dennoch zeigen sie sehr gut die Relationen, um die es beim anthropogenen Treibhauseffekt geht (Bild 3). Auch sind die oben angegebenen Messwerte relativ ungenau; sie werden aber durch die Aussage des Nobelpreisträges Paul Crutzen gestützt. Dieser schrieb1993 in einem Lehrbuch (20): „Es gibt bereits so viel CO2 in der Atmosphäre, dass in vielen Spektralbereichen die Aufnahme durch CO2 fast vollständig ist, und zusätzliches CO2 spielt keine große Rolle mehr.“ Man kann es auch so ausdrücken: Ein Treibhaus heizt sich bestenfalls geringfügig (Spureneffekt!) stärker auf, wenn man das normale Fensterglas gegen ein zehn Zentimeter dickes Panzerglas austauscht!

2. Vergleich mit den offiziellen Daten des IPCC

Das zur Messung verwendete und in der Chemie übliche FT-IR-Spektrometer besitzt nur einen Spiegelweg von 5 cm. Dies ergibt eine Auflösung der IR-Banden von 0,2 cm-1. Da die „ungesättigten“ Spektralbereiche ungewöhnlich schwache IR-Banden betrifft, benötigt man Spektrometer, die eine Auflösung von 0,0004 cm-1 erbringen (5). Hierzu muss man ein FT-IR-Spektrometer bauen, das theoretisch über einen Spiegelweg von 25.000 cm (25 m!) verfügt. Nur dann lassen sich dieäußerst schwachen IR-Banden messen, auf die sich die Klimamodellierer des IPCC stützen. Es sind Banden, mit einer „Absorptionsstärke“ von nur 0,05 % der 15 mm CO2-Hauptbande! Da Spiegelwege von 25 m technisch schwierig realisierbar sind, misst man reines CO2 unter höheren Druck und mit käuflichen Geräten, die über Spiegelwege bis zu 10 m verfügen. Die derart gewonnenen Extinktionskoeffizienten sind in der HITRAN-Datenbank abgelegt, welche zur Berechnung des Strahlungsantriebs („radiative forcing“) bei weiterer Steigerung der Treibhausgase (CO2, CH4 usw.) dient. Nimmt man die offiziellen Zahlen (IPCC), dann beträgt der „natürliche“ Treibhauseffekt“ 324 W/m2 (21). Bei Verdopplung des CO2 (100 % Steigerung!) wird nach Übereinkunft („best guess“ aus Computermodellrechnungen) angenommen, dass sich der Strahlungsantrieb um 3,7 W/m2 erhöht (22, 23). Im Bild 4 sind die Verhältnisse dargestellt.

|

Bild 4: Prozentuale Erhöhung des Treibhauseffekts bei Verdopplung des atmosphärischen CO2-Gehalts gemäß der offiziellen Angaben des IPCC

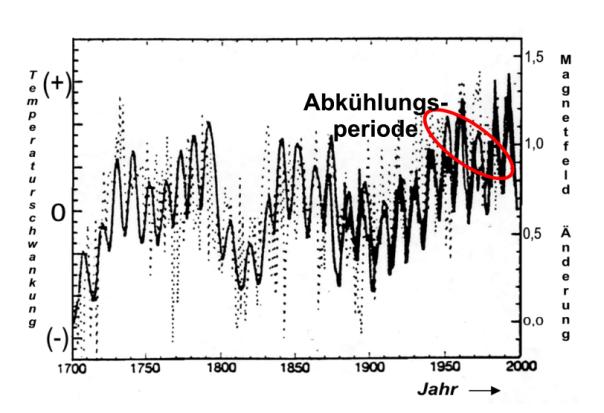

Auch das Bild 4 belegt eindeutig die oben beschriebene weitestgehende Sättigung denn die Steigerung des Treibhauseffekts bei CO2-Verdopplung beträgt nur geringfügige 1,2 %. Dies ist in der Klimaforschung bekannt. Deshalb wird versucht, den „Sättigungscharakter mit dem Argument zu entkräften, das Klima sei ein so empfindliches System, dass es bereits von kleinsten Änderungen des Strahlungsantriebs aus dem Gleichgewicht gebracht werden kann. So wird behauptet, die Abkühlung zwischen 1930 und 1970 sei durch die Staubbelastung der Industriegesellschaft verursacht. Dies ist falsch. Die Abkühlung war durch das geänderte Magnetfeld der Sonne verursacht, wie aus dem Bild 11 (rot eingekreist) hervorgeht.

3. Erdoberflächentemperatur, Treibhauseffekt und CO2-Konzentration

Zur Berechnung der irdischen Oberflächentemperatur ohne Treibhausgasatmosphäre benutzt man eine einfache Gleichung, die auf dem Stefan-Boltzmann- Gesetz beruht.

|

(Gleichung 1)

A ist dabei die Albedo – das durchschnittliche „Rückstrahlvermögen“ der Erde. Sie wird mit A= 0,3 angenommen. Tatsächlich existierten in der Vergangenheit auch andere Angaben. Die Solarkonstante, die in Wirklichkeit gar nicht so konstant ist, hat den Wert Fs = 1368 W/m2. Weiterhin enthält die Gleichung die Stefan-Boltzmann-Konstante s = 5,67 .10-8 W.m-2.K-4.

Rechnet man mit diesen Angaben, so resultiert für die Oberflächentemperatur der Erde:

|

Dieses Ergebnis ist fragwürdig, weil die Erde kein wasserloser Gesteinshaufen im Weltall ist. Sehr wahrscheinlich liegt die irdische Mitteltemperatur ohne Treibhausgase um einiges höher! Aber bleibt man zunächst einmal dabei, dann beträgt die spezifische Ausstrahlung der Erdoberfläche bei dieser Temperatur (Formelzeichen M nach DIN 5031, Teil 1):

M1 = (1-0,7) . 0,25 . 1368 W/m2 = 239 W/m2

Für die Klimanormalperiode bezeichnet, hat man sich vor Jahren unter Konsensbildung auf eine Mitteltemperatur von + 15 °C (T = 288 K) geeinigt. Benutzt man jetzt das „unveränderte“ Stefan-Boltzmann-Gesetz

M2 = s . T4 (Gleichung 2)

und berechnet damit die spezifische Ausstrahlung der Eroberfläche erneut, resultiert:

M2 = s . T4 = 5,67 . 10-8 W.m-2.K-4 . (288 K)4 = 390,0 W.m-2

Folglich erhöht der „natürliche“ Treibhauseffekt, mit einer hypothetische Erwärmung von DT = 288 K – 225 K = 33 K(33 °C), die spezifische Ausstrahlung der Erdoberfläche um

DM = M2 – M1 = 390,0 W/m2 – 239,0 W/m2 = 151 W/m2

Wie bereits oben erläutert, wird bei Verdopplung des CO2 (100 %ige Steigerung) ein zusätzlicher Strahlungsantrieb von 3,7 W.m-2 angenommen (die Größenordnung entzieht sich der Falsifikation und beruht auf Konsens – „best guess“!). Dadurch steigt die spezifische Ausstrahlung der Eroberfläche von 390,0 W.m-2 auf 393,7 W.m-2. Setzt man diesen Wert in die Stefan-Boltzmann-Gleichung (Gleichung 2) ein, resultiert als Erdoberflächentemperatur:

|

Demnach erhöht sich die Temperatur bei CO2-Verdopplung (100 % mehr CO2!) von 288,0 K auf 288,7 K. Das entspricht gerade einmal DT = 288,7 K – 288,0 K = 0,7 K (0,7 °C) und nicht mehr. Die Klimamodellierung hätte keinerlei politische Beachtung gefunden, wenn man nicht die Hypothese der Wasserdampfverstärkung in die Diskussion eingebracht hätte. Dies lässt sich jedoch glücklicherweise falsifizieren, wie im nächsten Absatz dargelegt wird.

4. Die Wasserdampfverstärkung

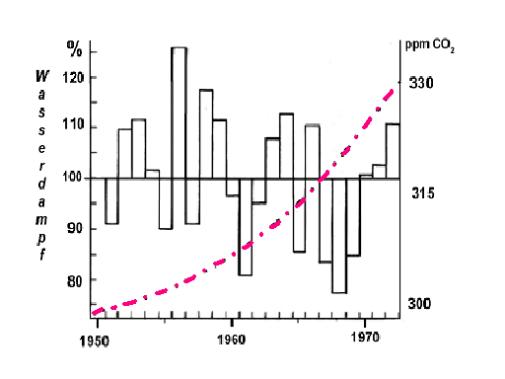

Da eine Erwärmung von lediglich 0,7 °C bei 100 % mehr CO2 zu wenig erscheint, hat man sich vor Jahren darauf geeinigt, dass diese geringfügige Temperaturerhöhung gemäß der altbekannten Clausius-Clapeyronschen-Gleichungdeutlich mehr Wasser aus den Ozeanen verdunsten lasse. Da Wasserdampf selbst ein Treibhausgas sei, fällt dadurch die von CO2 verursachte Temperaturerhöhung wesentlich höher aus. Originalton IPCC (24): „Der Wasserdampf-Feedback’ ist nach wie vor der durchweg wichtigste Rückkopplungseffekt, der die von den allgemeinen Zirkulationsmodellen als Reaktion auf eine CO2-Verdopplung vorhergesagte globale Erwärmung verursacht.“ Wenn dies richtig ist, muss besonders in einer kälteren Periode, während der die direkte Solarstrahlung nicht so viel Wasser verdunsten lässt, der Wasserdampfgehalt über den Ozeanen mit dem atmosphärischen CO2-Gehalt ansteigen. Dies ist eindeutig nicht der Fall, wie das Bild 5 belegt (31). Deshalb können sich die Klimamodellierer auf keinen Fall auf den durchaus einleuchtenden, hypothetischen Wasserdampfverstärkungsmechanismus berufen, der eine viel zu große Temperatursteigerung prophezeit.

|

Bild 5: Prozentuale Abweichung des Wasserdampfgehalts über dem Atlantik (33)

Um Missverständnissen vorzubeugen: Mit der Prozentangabe im Bild 5 ist natürlich nicht die relative Luftfeuchte gemeint, die niemals höher als 100 % sein kann, sondern vielmehr die Abweichung des Wasserdampfgehalts nach oben und nach unten um den Messwert von 1950. So liegt der absolute Wasserdampfgehalt 1956 um 25 % höher als 1950. 1968 liegt der Wasserdampfgehalt um ca. 45 % niedriger, obwohl der CO2-Gehalt weiter angestiegen ist!

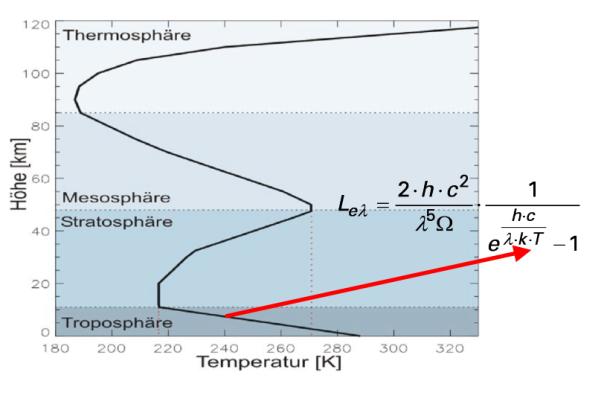

5. Die Strahlungstransportgleichung

Bei der Berechnung des Treibhauseffekts wird ein „Schicht- oder Kaskadenmodell“ zugrunde gelegt nach dem innerhalb der Atmosphäre eine ständige Absorption (I) und Emission (L) stattfindet. Diesem fiktiven Strahlungstransport liegt dieSchwarzschildgleichung zugrunde (11). Bei einem infinitesimalen Weg dz, dem Absorptionskoeffizienten sa und der Teilchenzahl n gilt hierfür im lokalen thermodynamischen Strahlungsgleichgewicht (LTE):

![]()

(Gleichung 3)

Die Größe L ist hierbei die Strahldichte (vgl. DIN 5031, Teil 1), welche die Emission gemäß der temperaturabhängigenPlanck-Strahlungsgleichung angibt.

Dass innerhalb der Atmosphäre ein Strahlungstransport stattfindet, meint man belegen zu können, indem man die gemessenen Satellitenspektren mit den berechneten vergleicht. Das Ergebnis ist verblüffend, wie das Bild 6 belegt.

|

Bild 6: Links das gemessene Emissionsspektrum der Erde (Satellitenspektrum); rechts das mit Hilfe der Strahlungstransportgleichung berechnete Emissionsspektrum

Das lokale thermodynamische Strahlungsgleichgewicht (LTE) begründet man mit dem Kirchhoff’schen Gesetz der Wärmestrahlung. Danach ist das Emissionsvermögen eines Körpers genau so groß wie sein Absorptionsvermögen. Das Ganze hat nur einen Haken. Es existiert kein „Strahlungsenergieerhaltungssatz“, wie er beim lokalen thermodynamischen Strahlungsgleichgewicht stillschweigend vorausgesetzt wird. Tatsächlich gibt man bei der „nachvollziehenden“ Berechnung der Satellitenspektren das gemessene atmosphärische Temperaturprofil in die Plank-Strahlungsgleichung ein, wie aus dem Bild 7 hervorgeht.

|

Bild 7: Strahlungstransport, Planck-Gleichung und gemessener Temperaturgradient

Zur Erinnerung: Beim Treibhauseffekt geht es auch um den Temperaturgradienten ( „Temperaturprofil“), den die Atmosphäre im Kontakt mit dem Erdboden unter adiabatischer Expansion annimmt. Lässt man sich dies durch den Kopf gehen, dann wird das Ergebnis – der Temperaturgradient – in die Rechnung eingesetzt (vgl. Bild 7), um dann daraus das temperaturabhängige Emissionsspektrum der Atmosphäre und des Erdkörpers zu erhalten (vgl. auch Bild 1). Deshalb ist die Übereinstimmung der im Bild 6 gezeigten Spektren kein Beweis für das dem Strahlungstransport zugrunde liegende hypothetische „lokale thermodynamische Strahlungsgleichgewicht“ innerhalb der Atmosphäre. Es ist vielmehr ein Beweis, dass man im Kreis herumrechnet und sich dann über den mathematisch „bewiesenen“ Treibhauseffekt freut.

Experimentelle Untersuchungen und die allgemein akzeptierte Theorie belegen eindeutig, dass die Molekülfluoreszenz anders funktioniert wie die Atomfluoreszenz, bei der die absorbierte Strahlung zu 100 % wieder emittiert wird (25, 26). Das LTE setzt aber eine „100%ige Molekülfluoreszenz“ voraus, die nicht existiert – auch nicht im IR-Bereich. Während angeregte Atome nur unter Emission von Strahlung in den Grundzustand zurückkehren können, erfolgt die Relaxation bei Molekülen wegen der Rotations- und Schwingungsfreiheitsgrade meist strahlungslos gemäß den Prinzipien des Jablonski-Diagramms (27). Deshalb reichte es eigentlich vollkommen aus, wenn man den „theoretischen“ Treibhauseffekt ohne jegliche Absorption nur mit der – temperaturabhängigen – Planck-Gleichung beschreibt, die man mit den jeweiligen Bandenstärken „klimawirksamer“ Spurengase und der „Anzahl IR-aktiver Moleküle in einem Luftvolumen“ multipliziert. Dann erhält man die thermische Emission der Atmosphäre unter Berücksichtigung des Raumwinkels.

Fazit: Dass eine atmosphärische Wärmestrahlung gemäß dem Planck-Gesetz gegeben ist, ist eine Selbstverständlichkeit. Solange aber ein atmosphärisches Temperaturprofil (oben kälter – unten wärmer) existiert und die Konvektion erheblich zum Energietransport beiträgt, solange ist die Hypothese in dem offenen System Atmosphäre existiere ein lokales thermodynamischen Gleichgewichts (LTE) falsch. Denn es gibt nämlich keinen „Strahlungsenergieerhaltungssatz“. Vielmehr übertragen „Treibhausgasmoleküle“ nach der Absorption von IR-Strahlung ihre Energie auf die nicht IR-aktiven Hauptbestandteile des Atmosphäre. Deshalb wird dem Strahlungsgeschehen bei der Klimamodellierung ein viel zu starkes Gewicht beigemessen.

6. Was Klimamodelle nicht können

Klimamodelle sind Computeralgorithmen (sprich: „Rechenvorschriften“, welche die meinungsabhängigen Vorgaben der Programmierung widerspiegeln) und nicht die Realität. Weil die Komplexität des Klimageschehens gegenwärtig und auch in absehbarer Zukunft mit keinem Computer realitätsorientiert erfassbar sein dürfte, handelt es sich mehr um politische Instrumentarien, denn um exakte Naturwissenschaft.

6. 1 Die Flusskorrekturen

Der Hypothese nach soll der „natürliche“ Treibeffekt den Globus um 33 °C aufheizen. Irrigerweise wird dabei angenommen, die Erde, die zu 70 % mit Wasser bedeckt ist, würde sich ähnlich verhalten wie der vollkommen wasserloseMond. Nimmt man an, nur die ersten 10 m Wassertiefe der Ozeane würden die mittlere Erdtemperatur thermostatisch regeln, ergibt die Rechnung, dass die Ozeane im Temperaturbereich von –18 °C bis +15 °C eine Energiemenge von 1,57.1018 MJ speichern. Hierzu die Gegenrechnung: In 24 Stunden werden durch den irdischen Treibhauseffekt 1,43.1016MJ umgeschlagen (22). Der gesamte natürliche Treibhauseffekt macht somit nur 0,9 % der Energie aus, die in den Ozeanen bei einer Wassertiefe bis zu 10 m gespeichert ist. Die Folge sind erhebliche Schwierigkeiten bei der Kopplung atmosphärischer Zirkulationsmodelle („General Circulation Atmospheric Models“) mit ozeanischen Zirkulationsmodellen („General Circulation Oceanic Models“). Diese Probleme lassen sich nur mit Hilfe so genannter „Flusskorrekturen“ überwinden, deren Beträge, wie das Bild 8 belegt, um ein Vielfaches größer sind als der anthropogene Treibhauseffekt. Die rechte Säule in Bild 8 stellt den Strahlungsantrieb des CO2 bei Verdopplung dar. Danach ist allein schon die 100 W/m2-Flusskorrektur zur Kopplung Ozeanoberfläche-Atmosphäre rund 27-mal (!) größer als der anthropogene Treibhauseffekt bei CO2-Verdopplung (3,7 W/m2).

|

Bild 8: Anthropogener Treibhauseffekt (rechte kleine Säule) im Verhältnis zu den bei der Klimamodellierung angewandten Flusskorrekturen

Es soll nicht unerwähnt bleiben, dass von einschlägigen Instituten in neuerer Zeit verlautbart wird, man benötige keine Flusskorrekturen mehr. Tatsächlich kommen Klimamodelle nach wie vor nicht ohne sie aus.

6. 2 Die Wolkendichte

Bei der Abschätzung des Strahlungsantriebs der Wolken kommen Klimamodelle zu äußerst unterschiedlichen Ergebnissen. So findet das „Bureau of Meteorology Research Center“ (BMRC) von Australien, dass die Wolken eine Abkühlung von ca. 1 W/m2 erbringen, während das Labaratoire de Météologie Dynamic (LMD) aus Frankreich meint, Wolken würden eine Erwärmung von ca. 1,7 W/m2 bewirken (Bild 9). Das ist beachtenswert!

|

Bild 9: Strahlungsantrieb der Wolken mit unterschiedlichen Klimamodellen gerechnet

Beispielsweise können bis heute Klimamodelle nicht die im Bild 10 gezeigte Abkühlung zwischen 1930 und 1975 ohne Zuhilfenahme von Kunstgriffen (atmosphärischer Staubeintrag durch die Industriegesellschaft!) nachvollziehen.

|

Bild 10: CO2-Gehalt und Temperaturverlauf (vgl. a. Bild 11)

7. Die Alternative

Da treibhausgasfixierte Computer-Klimamodelle nicht nur im Zeitraum zwischen 1930 bis 1970 versagen sondern auch die kleine Eiszeit (14. bis 18. Jh.) und das mittelalterliche Klimaoptimum (11. – 13. Jh.) nicht nachbilden können, muss es einen anderen entscheidenden Mechanismus geben. Sehr viel spricht dafür, dass dies die Wolkendichte ist, die von der kosmischen Strahlung beeinflusst wird. Diese besteht überwiegend aus Protonen, die als Echo des Urknalls in unser Sonnensystem eindringen. Gelangen diese positiv geladenen Kernbausteine in die Atmosphäre, so führen sie über einen noch nicht restlos geklärten Mechanismus zur Kondensation von Wasserdampf – Wolken entstehen. Erhöht sich dasMagnetfeld der Sonne bei höherer Solaraktivität, dann werden die Protonen stärker abgeschirmt. In der Folge entstehenweniger Wolken und die erwärmende Sonnenstrahlung kann den Globus stärker aufheizen. Deshalb folgt der globale Temperaturverlauf der Schwankung des solaren Magnetfelds (Bild 11).

|

Bild 11: Solares Magnetfeld und Globaltemperatur (abgewandelt nach 28)

Wie Messungen zeigen, war im übrigen die Solaraktivität seit dem Jahr 850 noch nie so hoch wie nach 1940 (29). Auch im Wärmehaushalt der Weltmeere macht sich die wolkenbedeckungsabhängige Schwankung der solaren Einstrahlung stärker bemerkbar. Somit dürfte der anthropogene Treibhauseffekt eine kleine, aufgesetzte Größe auf einer natürlichen Klimaschwankung sein.

Abgesehen davon erscheint die unter Punkt 3 vorgerechnete Temperatur von – 18 °C, welche die Erde ohne Treibhausgase angeblich hätte, viel zu niedrig angesetzt sein. Sie entspricht aber der offiziellen Doktrin, die – und das muss betont werden – eine Hypothese ist. Weil, wie bereits hervorgehoben, die Erde kein wasserloser Gesteinshaufen im Weltall ist, sondern zu 70 % mit Wasser bedeckt ist, muss die direkte Absorption im nahen Infrarotgebiet (NIR) und die sehr verzögerte Strahlungsemission von Ozeanwasser stärker berücksichtigt werden.

Bild 12: Wolkenbedeckung (Wolkendichte) und globale Temperatur

Aus dem Bild 12 geht hervor, dass sich die globale Wolkenbedeckung zwischen 1986 und 2000 von 69 % auf 65 % reduzierte (linke Ordinate, „fallend“ aufgetragen). Parallel hierzu stieg die globale Mitteltemperatur (rechte Ordinate, „steigend“ aufgetragen).

Während die Temperaturschwankungen in der Sahara im Tagesverlauf ohne weiteres bis zu 50 °C betragen können, verhalten sich Meere wesentlich träger. Der Gesamtwärmeumsatz (Wärmeenergie nicht Wärmeleistung!) eines Meeres ist die Summe vieler Größen:

Qges = (QS – QA) – QK – QV – QT + QC + QE + QF + QR

QS = im Meer absorbierte Sonnen- und Himmelsstrahlung (= „Treibhauseffekt“)

QA = effektive Ausstrahlung

QK = „fühlbarer“ Wärmeübergang Luft-Wasser

QV = latenter Wärmeübergang Luft-Wasser (Verdunstung, Kondensation)

QT = Wärmetransport durch Strömung

QC = chemisch-biologische Prozesse

QE = Wärmezufuhr aus dem Erdinnern

QF = Reibungswärme

QR = radioaktiver Zerfall

Da die Speicherfähigkeit des Wassers erheblich über der von Gesteinen liegt, ist es ausgeschlossen, dass sich die Erde bei einer Trägheit des Systems Wasser-Luft nachts schlagartig um 50 °C herunterkühlen. Denn insbesondere die Abstrahlungsleistung dQA/dt unterscheidet sich wegen der wesentlich höheren Wärmespeicherungsfähigkeit von Meerwasser deutlich von jener der Sahara. Gemäß der Stefan-Boltzmann-Gleichung (Gleichung 2) hängt nämlich die spezifische Ausstrahlung der Erdoberfläche mit der Temperatur unmittelbar zusammen. Je höher die letztere ist, desto größer ist auch die Abstrahlung.

Aus der obigen Aufzählung geht aber hervor, dass der Energiegehalt des Meerwassers auch auf der Wärmezufuhr aus dem Erdinnern, auf chemisch-biologischen Prozessen, auf radioaktiven Zerfall und auf Reibungswärme beruht. Die Größe QF (Reibungswärme) in der obigen Aufzählung hängt von der Windgeschwindigkeit ab. Wie H. Volz auf einer Tagung der Bayerischen Akademie der Wissenschaften berichtete, differiert die spezifischen Ausstrahlung bei den Windstärken 0 und 7 in einer Größenordnung von DM = 11,1 W/m2 (30). Die Ein- und Ausstrahlungsbilanz geht aber von einer ruhenden See aus. Addiert man diese Größe zur spezifischen Ausstrahlung bei 15 °C, so erhält man:

M = 239,0 W/m2 + 11,1 W/m2 = 250,1 W/m2

Eingesetzt in die Gleichung 2 resultiert für die Temperatur T = 257,7 K (- 15,3 °C). Diese Temperatur liegt um 2,7 °C höher, als die besagten – 18 °C. Die Treibhausgase erhöhen dann die Mitteltemperatur nicht um 33 °C sondern „nur“ um 30,3 °C, insofern die These richtig ist, die „normale“ Mitteltemperatur der Erde beträgt + 15 °C. Wie hoch war diese eigentlich während des mittelalterlichen Klimaoptimums (11. – 13. Jh. ) und während der „kleinen Eiszeit“ (14. bis 18. Jh)?

Ein weiteres kommt hinzu. Etwa 50 % der Sonneneinstrahlung, die den Erdboden erreicht, ist Wärmestrahlung (nahes und mittleres IR). Diese wird vom Meerwasser absorbiert. Die strahlungsfixierte Treibhausgastheorie saldiert nur die Einstrahlung und Ausstrahlung im Tagesverlauf als könnten sich die Weltmeere auf der Nachtsseite schlagartig auf – 18 °C abkühlen. Die Trägheit der Ozeane ist aber mit einer Relaxationszeit bis zu 200 Jahren sehr hoch. Folglich dürfte die mittlere globale Gleichgewichtstemperatur der Ozeane ohne atmosphärische Treibhausgase eher um + 4 °C (Wasser höchster Dichte am Grunde eines zugefrorenen Gewässers) denn bei – 18 °C liegen. Als ich vor einiger Zeit einmal mit einem ehemaligen Leiter eines Klimarechenzentrums korrespondierte und ihn fragte, wie hoch die irdische Mitteltemperatur ohne Ozeane anzusetzen sei aber mit dem gegenwärtigen atmosphärischen Treibhausgasgehalt, erhielt ich zur Antwort, dies sei eine interessante Frage, die man aber bislang nicht durchgerechnet habe.

Zusammenfassung

· Der anthropogene Treibhauseffekt ist im wesentlichem ausgereizt, wie die Messung der Transmission von IR-Strahlung belegt. Eine globale Klimakatastrophe ist daher selbst bei einer CO2-Verdoppelung nicht zu erwarten.

· Die Steigerung des Treibhauseffekt um 1,2 % bei 100 % mehr CO2 ist eine Bagatelle, die man nur mit Hilfe des Wasserdampfverstärkungsmechanismus vergrößern kann.

· Zweifellos enthält die Atmosphäre gemäß der Clausius-Clapeyronschen-Gleichung mehr Wasserdampf, wenn es wärmer wird. Jedoch lässt sich der hypothetische Wasserdampfverstärkungsmechanismus, ohne den Klimamodelle nicht zu einem merklichen Temperaturanstieg kommen, in der Realität nicht nachzuweisen. Weil sich somit der atmosphärische Wasserdampfgehalt nicht an der Konzentration der Treibhausgase orientiert, erhöht sich die globale Mitteltemperatur bei 100 % mehr CO2 in der Atmosphäre bestenfalls um 0,7 K (0,7 °C).

· Computerklimamodelle kommen u. a. deshalb zu falschen Ergebnissen, weil der hypothetische Wasserdampfverstärkungsmechanismus vollkommen überwertet wird.

· Der atmosphärische Temperaturgradient beruht auf einem Energietransport und nicht auf einem Strahlungstransportmechanismus mit dem fiktiven LTE. Deshalb wird der atmosphärischen Rückstrahlung – dem Treibhauseffekt – eine zu große Bedeutung zugemessen.

· Klimamodelle müssen mit – gewillkürten – Flusskorrekturen arbeiten, deren Größenordnung den des anthropogenen Treibhauseffekts um ein Vielfaches übertreffen. Im anderen Fall „hat (man) als Modellierer … die Wahl, entweder ohne Flusskorrektur mit einem unrealistischen Klimazustand zu operieren, oder die Flusskorrektur mit ihren Schwächen zu akzeptieren, dafür aber ein realistisches Klima zu erhalten.“(32)

· Die Abbildung des Klimas in der Vergangenheit mit Computeralgorithmen gelingt nicht ohne massive Korrekturgrößen.

· Die globale Mitteltemperatur ohne Treibhauseffekt dürfte um einiges höher als bei 255 K (-18 °C) liegen.

· Das Klima wird hängt stärker von der Variation der Wolkenbedeckung ab als vom Gehalt atmosphärischer Treibhausgase.

· Das IPCC ist eine politische Organisation, die sich eines Wissenschaftlergremiums bedient, um volkspädagogische Lernziele durchzusetzen.

Abschließend möchte ich die Leser darauf aufmerksam machen, dass dem gegenwärtigen CO2-Gehalt je nach Literaturstelle ein unterschiedlicher Temperatureffekt zugeordnet wird. In dem von von J.T. Houghton herausgegebenen Buch „The Global Climate“ geben Kondratjew und Moskalenko 7,2 K an (14). Die Autoren zitieren sich dabei selbst (15). Besorgt man sich das in Kyrillisch geschriebene Buch und schaut auf der angegebenen Seite nach, so landet man im Sachwortverzeichnisses. Auch die weitere Suche in dem Buch bringt kein Ergebnis. Andererseits scheint man sich doch recht sicher zu sein, denn die Angaben der Autoren werden gerne zitiert (16). Allerdings gibt es Widersprüche, denn K.P. Shine gibt einen anderen Wert an, nämlich 12 K (17) und R. Lindzen (18) geht davon aus, dass dem CO2 nur etwa 5% des natürlichen Treibhauseffekts zuzuordnen sind. Das wären 1,65 K und damit weniger als ein Viertel des bei IPCC benutzten Werts von 7,2 K.

Literatur

[1] R. Revelle, Scientific American, 247, No.2, Aug. 1982, 33-41

[2] J. Barrett, Spectrochim. Acta Part A, 51, 415 (1995)

[3] R.A. Hanel et al. Journal of Geophysical Research, 77, 2629-2641 (1972)

[4] H. Flohn, Nachr. Chem.Tech.Lab, 32, 305-309 (1984)

[5] L.S.Rothman et al., Appl.Opt. 26, 4058 (1987)

[6] H. Hug, Chemische Rundschau, 20. Febr., p. 9 (1998)

[7] P. S. Braterman, Spectrochim. Acta Part A, 52, 1565 (1996)

[8] K. Shine, Spectrochim. Acta Part A, 51, 1393 (1995)

[9] J. Houghton, Spectrochim. Acta Part A, 51, 1391 (1995)

[10] R. S. Courtney, Spectrochim. Acta Part A, 53, 1601 (1997)

[11] R. P. Wayne, Chemistry of Atmospheres, Oxford University Press,

2nd. Edition, 44-49 (1991),

[12] Murry L. Salby, Fundamentals of Atmospheric Physics, Academic Press, 198-257 (1996)

[13] Climate Change 1990. The IPCC Scientific Assessment, p. 49

[14] K.Ya. Kondratyev, N.I. Moskalenko in J.T.Houghton, The Global Climate, Cambridge

Universitiy Press, 225-233 (1984)

[15] K.Ya. Kondratyev,N.I. Moskalenko, Thermal Emission of Planets, Gidrometeoizdat,

263 pp (1977) (Russisch)

[16] C.D. Schönwiese, Klimaänderungen, Springer-Verlag Berlin Heidelberg, p. 135 (1995)

[17] K. P. Shine, A. Sinha, Nature 354, 382 (1991)

[18] R. S. Lindzen, Proc. Nat. Acad. of Sciences, 94, 8335 (1997)

[19] R. Raschke, R. Hollman, Strahlungsübertragung in der Atmosphäre, Modellierung und Messung, Preprint zum CO2-Kolloquium der DECHEMA in Frankfurt/Main am 11.10.2001

[20] T. E. Graedel, Paul J. Crutzen, Chemie der Atmosphäre, Spektrum Akademischer Verlag, Heidelberg, Berlin, Oxford 1993, S. 414

[21] IPCC, Climate Change 2001, Chap. 1.2.1 Natural Forcing of the Climate System

[22] J. T. Kiehl, K. E. Trendberth, Bull. Amer. Meteor. Soc., 78 (1997) 197

[23] IPCC, Climate Change 1994, Radiative Forcing of Climate Change and Evaluation of the IPCC IS92 Emission Scenarios, Cambridge University Press, S. 174

[24] IPCC, Climate Change 2001, Working Group I: The Scientific Basis. Contribution of Working Group I to the Third Assessment Report of the Intergovernmental Panal on Climate Change, Chap. 7.2.1.1

[25] H. Hug, Energy & Environment, 11, 631, (2000)

[26] N. D. Coggeshall and E. L. Saier, J. Chem. Phys., 15, 65, (1947), Fig. 1

[27] Matthias Otto, Analytische Chemie, Wiley-VCH Verlag, Weinheim (2000), S. 280 ff

[28] S. Solanki, M Schüssler, M Fligge, Nature, 408 (2000) 445

[29] I. G. Usoskin, S. K. Solanki, M. Schüssler, K. Mursula, K. Alanako, Phys. Rev. Let., 91 (2003) 211101-1

[30] Rundgespräche der Kommission für Ökologie, Klimawandel im 20. und 21. Jahrhundert: „Welche Rolle spielen Kohlendioxid, Wasser und Treibhausgase wirklich?“ Bayerische Akademie der Wissenschaften, Verlag Dr. Friedrich Pfeil, Müchen, April 2005, S. 93

[31] Wasserdampfgraphik nach H. Flohn, BdW 12/1978, S. 132

[32] U. Cubasch, Phys. Bl. 51 (1995) 269

[33] H. Hug, Die Angsttrompeter, Signum Verlag, München, 2006, S. 227

Heinz Hug, Wiesbaden Juni 2007

Den Aufsatz können Sie auch als pdf Datei aus dem Anhang herunterladen

Stromausfälle kennen die Menschen in Deutschland bisher nur aus Nachrichten von anderen Ländern, aus einer fernen Welt, als etwas Exotisches. Das wird sich ändern. Stromausfälle stehen auch hierzulande bevor – als Eigenerlebnis zuhause (beim Kühl- und Tiefkühlschrank, beim Kochen am Elektroherd, beim Staubsaugen, Geschirrspülen, Wäschewaschen, Heizen, Surfen im Internet, Fernsehen) und außerhalb der Wohnung am Arbeitsplatz, im Bahnverkehr, in der Wasserversorgung, in der Verkehrsregelung, in den Kühlhäusern, bei den Geldautomaten. Ohne Strom geht heute fast nichts mehr. Solche Eigenerlebnisse werden Erweckungserlebnisse sein: „So haben wir das Umsteigen auf ‚die Erneuerbaren’ aber nicht gewollt.“

Denn nun werden die Menschen die Folgen der vorgeblichen und gemeingefährlichen Klimaschutzpolitik hautnah ganz persönlich erleben. Sind doch die Stromausfälle die unausweichliche Folge jener Politik,

• die den Strombedarf einer hochentwickelten Industrienation mehr und mehr (und eines Tages nur) mit Windkraft und Sonnenschein auf Fotovoltaik-Dächer decken zu können glaubt,

• die angstschürend und wider besseren Wissens ihre Stromerzeugung aus Kernkraft aufgibt,

• die wegen des CO2-Ausstoßes letztlich auch die Kohle- und Gaskraftwerke durch „die Erneuerbaren“ ersetzen will,

• die dieses technisch-anthropogene CO2 unbewiesen als „Treibhausgas“ verteufelt und

• die das diktatorische Vermeiden dieses CO2 den Menschen als Klimaschutz vorgaukelt.

Stete Stromversorgung durch Sonne und Wind ist illusorisch

Warum unausweichliche Folge? Weil der Wind unstetig weht, weil die Generatoren bei Windstärken unter 3 m/s überhaupt keinen Strom erzeugen und bei zu starkem Wind sofort abgestellt werden müssen, erreichen Windkraftanlagen im Jahresdurchschnitt allenfalls 20 Prozent ihrer Nennleistung, auf See nur bis zu 30 Prozent. In Deutschland treiben inzwischen (nach dem Stand vom 31. Dezember 2010) 21 607 Anlagen mit einer Nennleistung von über 27 214 MW ihr kostspieliges Unwesen. Für deren fehlende Leistung von durchschnittlich 80 Prozent müssen herkömmliche Kraftwerke stets bereitstehen, um die Fehlmengen sofort zu liefern („Schattenkraftwerke“) – betrieben mit Kohle, Gas, Kernenergie oder Wasser. Diese müssen häufig außerhalb ihres günstigen Wirkungsgradbereiches gefahren werden, weil der Windstromanteil schwankt, aber die Stabilität des Stromnetzes erhalten bleiben muss. Und auf die Sonne ist in unseren Breiten ebenfalls kein Verlass. Tagsüber scheint sie mal und mal nicht, im Winter ohnehin schwächer, und nächtlichen Sonnenschein werden die Menschen ebenso wenig hinbekommen, wie sie das „Klima schützen“ können. Ohne diese „Schattenkraftwerke“ ist eine stetige und verlässliche Stromversorgung durch Wind und Sonne mit den benötigten Mengen wie bisher zu jeder Tages- und Nachtzeit illusorisch.

Ohnehin wird es mit laufend mehr Wind- und Photovoltaik-Strom schon derzeit trotz der jetzt noch verfügbaren herkömmlichen Kraftwerke immer schwieriger, Angebot und Nachfrage miteinander in Einklang zu bringen, denn Strom auf Halde zu produzieren, also großtechnisch zu speichern, geht bisher nicht. Damit wird es auch immer schwerer, die Spannung im Netz stabil zu halten. Je mehr Wind- und Photovoltaik-Strom, desto instabiler die Netzspannung. Früher war die Verteilung des Stroms vergleichsweise einfach. Produziert wurde er fast nur von den Versorgern und überwiegend in Großkraftwerken. Das war stromtechnisch vergleichsweise einfach zu steuern. Aber mit dem Ausbau des „erneuerbaren“ Wind- und Photovoltaikstroms schwankt die Produktion abhängig von Wetter und Tageszeit. Zudem wird der Strom dezentral produziert und ist so nur schwer zu kalkulieren. Selbst Privathaushalte speisen Elektrizität, die sie von Solardächern gewonnen haben, ins Netz ein. Die Versorgung ist daher nur schwer zu steuern, die Stromspannung nur schwer für die nötigen 50 kHz zu stabilisieren. Stromausfälle sind damit gleichsam programmiert als seien sie festes, noch aber verheimlichtes Programm. Extreme grüne Weltverbesserer machen daraus schon jetzt keinen Hehl.

Wenn nun Deutschland aus der „Kernkraft aussteigt“, also einsam und allein seine Kernkraftwerke abschaltet, dann ist die Gefahr von Stromausfällen schon jetzt akut, vor allem im Winter. Eben darum haben jüngst die vier großen Stromnetzbetreiber in Deutschland vor „großflächigen Versorgungsausfällen“ als Folge des Ausstiegs gewarnt, ebenso die Internationale Energieagentur. Die Stromnetze seien "fernab von jedem operativen Normalbetrieb". Schon jetzt müssten Kraftwerksrevisionen sowie dringende Arbeiten zur Instandhaltung und zum Ausbau der Netze verschoben werden, weil die Netze sonst noch unstabiler würden. Trotz all dieser Maßnahmen steige aber das Risiko für Netzstörungen, da die Reserven und Eingriffsmöglichkeiten der Netzbetreiber nahezu aufgezehrt seien. Eine zusätzliche Herausforderung werden die (ebenfalls subventionierten) Elektroautos, denn unregelmäßig werden sie Strom aus den Zapfsäulen ziehen. Bis 2020 will die Bundesregierung eine Million E-Autos auf die Straße bringen.

Energiefachleute haben schon viel früher gewarnt, auf sie gehört wurde nicht. Die Gefahr, dass durch immer mehr Wind- und Solarstrom das Stromnetz überfordert ist und zusammenbricht, haben allmählich auch die Profiteure dieser unverantwortlichen Energiepolitik erkannt, unter ihnen die Politiker und der Fiskus. Die deutschen Stromerzeuger und Hunderte Kommunalversorger, müssen im nächsten Jahrzehnt ihre Netze gegen die künstlich herbeigeführte Instabilität sichern. Der wetterwendische und dezentral erzeugte Wind- und Fotovoltaik-Strom treibt das Land also auch in einen riesigen Umbau des Stromnetzes, was den Strom zusätzlich verteuert. Deutschland soll mit einem zusätzlichen und technisch neuen Stromleitungsnetz („smart grids“) überzogen werden, tausende Kilometer lang. Dafür sind Milliardeninvestitionen nötig, um zur einstigen Netzstabilität zurückzufinden. Aber Planung, Durchsetzung gegen Bürger-Widerstand und Bau dauern viele, viele Jahre – von der zusätzlichen Landschaftszerstörung ganz abgesehen. Bis dahin werden sich Bürger und Unternehmen in Deutschland auf Stromausfälle einstellen müssen.

Wer ein hochindustrialisiertes und in allem stromabhängiges Land in eine solche Gefahr bringt, führt es in die Desindustrialisierung. Wie schon politisch hat Deutschland dann auch wirtschaftlich nicht mehr viel zu melden. Deutschland begibt sich in schleichende Verarmung und zieht seine Bewohner dabei mit. Auf andere Weise hat die politische Führung Deutschlands diesen Weg ebenfalls schon beschritten – so durch seine Politik der staatlichen Überschuldung, durch seine Selbstentmachtung innerhalb der Europäischen Union, durch seine sklavische Euro-Politik in der EU-Währungsunion, sein Mitwirken am Ausschalten der „Maastricht-Stabilitätskriterien“ und das Retten unsolider Euro-Staaten als Hauptzahler mit dem Steuergeld seiner Bürger.

Wahrscheinlich ist vielen, auch in der politischen Klasse, gar nicht klar, dass die privaten Haushalte 50 bis 60 Elektrogeräte nutzen und dafür eine stets verfügbare Stromversorgung brauchen. Darüber hinaus werden die Stromausfälle begleitet von einer gewaltigen Stromverteuerung. Von 2000 bis 2011 hat sich der Strompreis bereits verdoppelt – auf 23 Cent je Kilowattstunde. Bis 2020 wird er sich abermals verdoppeln – auf über 50 Cent. Spätesten dann müsste der bei den Menschen geschürte CO2-Wahn und Klimaschutz-Irrglaube auf den Boden der Tatsachen zurückfinden. Und spätestens jetzt muss es auch der politischen Führung in Deutschland dämmern, was sie mit ihrer tiefgrünen Energiepolitik anrichtet. Vom dänischen Physiker Niels Bohr stammt die spöttische Bemerkung "Alles ist möglich, vorausgesetzt, dass es genügend unvernünftig ist." Deutschland hält sich dran.

Doch gefährdet Deutschland mit seinem Sonderweg nicht nur sich allein, sondern auch seine Nachbarländer. Eben darum hat die Internationale Energieagentur ebenfalls gewarnt: Mit dem deutschen Alleingang würden Nachhaltigkeit und Versorgungssicherheit in ganz Europa geopfert; es gehe angesichts des Energie-Binnenmarktes der EU nicht um ein deutsches, es gehe um ein europäisches Problem. Vom Stromnetz sind Menschen und Wirtschaft inzwischen abhängiger als vom Schienennetz.

Aber die „Grünen“ wird das alles nicht erschüttern, auch die grün angestrichenen anderen Parteien wie SPD, CDU, CSU, FDP und Linke nicht. Wer sich grün anmalt, den fressen die Ziegen, heißt ein geflügeltes Wort. Täten die Ziegen das, dann wären die Fünf weg. Sind sie aber nicht; es fehlt noch an fresslustigen Ziegen.

Das Bundesumweltministerium ließ verlauten, man nehme die Bedenken der Netzbetreiber sehr ernst. Aber zugleich fügte es hinzu, nunmehr bedenkenlos, die Lage sei beherrschbar. Nein, das ist sie nicht, denn wer für die Versorgung eines hochindustrialisierten Landes mit Strom immer stärker und am Ende ganz auf die sehr unsteten Naturkräfte wie Wind und Sonne setzt, wer diese Erzeugungsform beratungsresistent mit Bracchialgewalt durchpaukt und alle Kernkraftwerke zum Teufel jagen will, der gefährdet damit die bisher sichere und ständige Verfügbarkeit von Strom in Deutschland aufs Höchste. Ablassen von diesem Abenteuer wollen die politischen Hasardeure aber trotzdem nicht – störrisch und verstockt, mutwillig und rücksichtslos. Die Zumutungen für Land und Bürger, die Auswirkungen auf Wirtschaft und Beschäftigung interessieren sie nicht. Noch nicht. Denn wie oft und wie lange werden sich die Menschen Stromausfälle bieten lassen?

Dr. Klaus-Peter Krause 01. Juni 2011

Der Originalartikel erschien in eigentümlich frei hier

"Und ewig sterben die Wälder" Ein Film von Michael Miersch und Tobias Streck

Nachdem die aufwändigen „Klima-Gipfel“ von Kopenhagen und Cancún mit äußerst mageren Ergebnissen endeten, versucht die UN nun in Zusammenarbeit mit großen privaten Stiftungen zu verhindern, dass auch der „Rio+20-Gipfel“ im kommenden Jahr zu einem Flop wird. In Stockholm trat diese Woche eine Jury von an die 20 Nobelpreisträgern zusammen, um einem hochrangigen Expertengremium der UN ihr Urteil über den Zustand der Welt zu übermitteln.

Quelle: Büso „Der Weg zur Bevölkerungsreduktion“ Kommentar zum WBGU Berichtes zu großen Transformation

Zu den Honoratioren, die in Stockholm über die Menschheit richten und über Chancen einer „Wende zur Nachhaltigkeit“ berieten, zählen der deutsche Physik-Nobelpreisträger Peter Grünberg, der indisch-britische Wirtschaftsnobelpreisträger Amartya Sen, der Schweizer Medizin-Nobelpreisträger Werner Arber, der niederländisch-deutsche Chemie-Nobelpreisträger Paul Crutzen und die südafrikanische Literaturnobelpreisträgerin Nadine Gordimer. Aufgabe der Jury sei es gewesen, „Kipp-Prozesse hin zu nachhaltiger Entwicklung“ zu ermitteln, heißt es in einer Mitteilung des Potsdam Instituts für Klimafolgenforschung (PIK), das zu den Organisatoren des 3. Nobelpreisträger-Symposiums über globale Nachhaltigkeit gehört. Neben dem PIK waren die Königlich Schwedische Akademie der Wissenschaften, das Stockholm Resilience Center, das Stockholm Environment Institute und das Beijer Institute of Ecological Economics maßgeblich an der Ausrichtung des Symposiums beteiligt. Gesponsert wurde die Veranstaltung unter anderen von der Volkswagen-Stiftung und der Essener Stiftung Mercator.