So wurde jedes Thema angesprochen und jede Menge Heilsversprechen abgegeben. Auf die Idee, dass die Armen durch eigene Anstrengung reich werden könnten, wie es uns nicht nur die BRIC Staaten oder die asiatischen Tiger seit Jahrzehnten vormachen, kam kaum einer in der Runde. Mittel zum Zweck, um die Umverteilung zu erzwingen, ist die Angst vor dem Klimawandel, induziert durch CO2, einem Klimawandel, wie er nur in den Klimamodellen vorkommt. Daher schauen wir uns jetzt die Klimamodelle an.

Zuvor noch der Einfachheit halber der Einblick in die Sendung, die wir hier mit freundlicher Genehmigung von PHOENIX zeigen. Zur Erinnerung: Bei den Originalzitaten sind die Minuten in Klammern angegeben, in denen man diese Zitate (nicht immer wortgetreu) hören kann.

Sendung vom 9.12.10 „Ist die Welt noch zu retten“ (Mit freundlicher Erlaubnis von Phoenix)

7. Wie gut sind die Klimamodelle?

Ausschließlich auf Computer gestützte Klimamodelle werden eingesetzt, um damit Prognosen über die zukünftige Klimaentwicklung zu errechnen. Wie gut sind nun die Ergebnisse dieser Prognosen? Halt sagt da Prof. Bott (13:16) „Niemand prognostiziert, man entwickelt Scenarien! Es wird nichts vorhergesagt!“. Nichts vorhergesagt, Projektionen? Was denn dann?

Unter den anderen Teilnehmern im Studio, so der allgemeine Eindruck, konnte niemand so recht den Unterschied zwischen den beiden Begriffen erkennen. Wenn das IPCC aber, bestätigt durch Prof. Bott, sagt, dass bei weiterem CO2 Ausstoß die Erde mächtig warm wird, dann soll das keine Prognose sein? Schauen wir nach:

Was sind Prognosen, was sind Szenarien?

Prognose (aus dem griech. „das Vorwissen) ist definiert als eine Vorhersage, also eine Aussage über Ereignisse, Zustände oder Entwicklung in der Zukunft! So schreibt es das in dieser Hinsicht unverdächtige Wikipedia.

Über Szenario steht dort:

Szenario (Plural Szenarios) oder Szenarium (Plural Szenarien) steht übertragen im Allgemeinen für den ausgedachten oder ausgerechneten Entwurf einer Situation oder eines Ablaufes, spezieller für:

* den szenisch gegliederten Entwurf eines Erzählwerks, siehe Handlung (Erzählkunst)

* eine Stufe der Verfilmungsvorbereitung in der Filmkunst: Filmszenario

* die Planung eines möglichen Zustands in der Zukunft, siehe Szenariotechnik

* die Bewertung einer Softwarearchitektur nach einem bestimmten Verfahren.

„Ausgedacht“ oder „ausgerechnet“ steht da. Doch leider passt keines der obigen Beispiele so richtig auf die IPCC-Szenarien, so wie sie uns präsentiert werden. Wenn es sich also wirklich um Szenarien statt Prognosen handelt, dann passt noch am Besten das erste Beispiel des ..szenisch gegliederten Entwurf eines Erzählwerks.. oder evtl. besser …die Planung eines möglichen Zustands in der Zukunft..“ Was hier stört ist das Wort „Planung“. Evtl. könnte man sagen: „Berechnung eines möglichen Zustands in der Zukunft“.

Nun, falls es das wirklich ist, dann kann man – ohne zuviel Phantasie einzusetzen – schnell eine schier unendliche Zahl von möglichen Zuständen in der Zukunft = Szenarien berechnen: Z.B, ob wir von einem Meteor getroffen werden, im Lotto gewinnen, vom Auto überfahren werden, eine glücklich oder unglückliche Ehe führen werden, etc. etc. (Einen klugen Beitrag zu dieser Frage hat der Physiker Peter Heller geschrieben, sie finden ihn hier, mit Dank an Leser Bombosch)

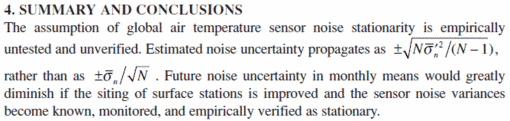

Oder auch, ob und wie sich die Mitteltemperatur der Erde durch CO2 Emissionen erhöht! Das setzt voraus, dass ich in mein Modell einbaue, dass z.B. das CO2 der große Treiber dieser Erhöhung ist und zusätzlich, dass eine geschlossene Theorie des Klimas zur Hand ist. Die erste Voraussetzung, in Gestalt der Wasserdampfrückkopplung, ist in alle Klimamodelle eingebaut, sie ist sozusagen der Motor, obwohl kein Nachweis für die hier wirkenden Rückkoppelungsmechanismen erbracht wurde (eine Reihe von Autoren haben auf Grund von Messungen das Gegenteil hergeleitet, z.B. Lindzen, Choi, Spenccer, Paltridge, Arking). Und eine in sich geschlossene Theorie des Klimas existiert ebenfalls nicht, dafür sind u.a. die Ungewissheiten und die sich daraus ergebenden Ungenauigkeiten noch immer viel zu groß.

Nicht ohne Grund schreibt daher das IPCC im 3. Bericht TAR:

“ In der Klimaforschung und -Modellierung sollten wir beachten, daß wir es mit gekoppelten nichtlinearen chaotischen Systemen zu tun haben und deswegen sind Langzeitprognosen von zukünftigen Klimazuständen nicht möglich“ (Third Assessment Report, Section 14.2.2.2)”

Dabei wurde noch nicht mal der Mangel einer geschlossenen Theorie des Klimas erwähnt. Wie gut also sind die Klimamodelle? Hier herrschte große Uneinigkeit unter den Experten:

Bott (11:56) (Limburg hat sich) …lustig gemacht über Modelle: (sie) sind aus strikten und logischen Gleichungssystemen entwickelt, die absolut korrekt sind. 12:44; aus mathematischen Gesetzmäßigkeiten heraus. …sind (jedoch) hochgradig nichtlinear 13:03; deswegen nicht vorhersagbar. Ist aber nicht schlimm. 13:16 Niemand prognostiziert, man entwickelt Szenarien! Es wird nichts vorhergesagt!

Limburg: 11:56 ausführlicher Widerspruch bis 15:25

Bott übersieht, dass die mathematische-logische Korrektheit eines numerischen Modells überhaupt nichts darüber aussagt, ob es in der Realität zutrifft. Sie ist lediglich eine der Voraussetzungen, die unabdingbar erfüllt sein müssen, mehr nicht. Als stellvertretendes Gegenbeispiel seien die unzähligen – mathematisch-formal vollständig korrekten – volkswirtschaftlichen Modelle genannt, die es noch niemals fertig gebracht haben, die komplexen volkswirtschaftlichen Mechanismen befiriedigend zu beschreiben (die Pleite des LTCC-Hedgefond lässt grüßen). Beim Klima ist es nicht anders. Uns ist kein Modell bekannt, das ohne massive Manipulationen die Klimavergangenheit wiedergeben konnte. Selbst mit so „einfachen“ Phänomenen, wie dem El Nino oder der NAO sind Klimamodelle bereits hoffnungslos überfordert. Kein Modell hat es bis heute geschafft, diese Oszillationen genau zu beschreiben oder gar ihren Eintritt vorherzusagen. Und diese Fähigkeit ist sozusagen als die „leichtere Übung“ unter vielen anderen anzusehen. Mit den Wolken, den klimawirksamsten Gebilden überhaupt, sind Modelle hoffnungslos überfordert. Modelle sind für klimatologische Detailprobleme wertvolle Hilfsmittel, für Weitergehendes kann man sie aber nicht ernst nehmen.

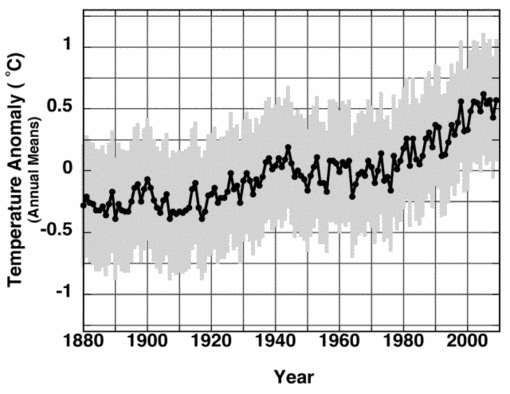

Ein Vergleich der Realität mit den „Szenarien“ erlaubt eine einfache Überprüfung der Qualität dieser Modelle. Für Prognosen wie Szenarien sollte gelten, dass je kürzer die Zeit nach der „Vorhersage, desto sicherer die Aussage ist.

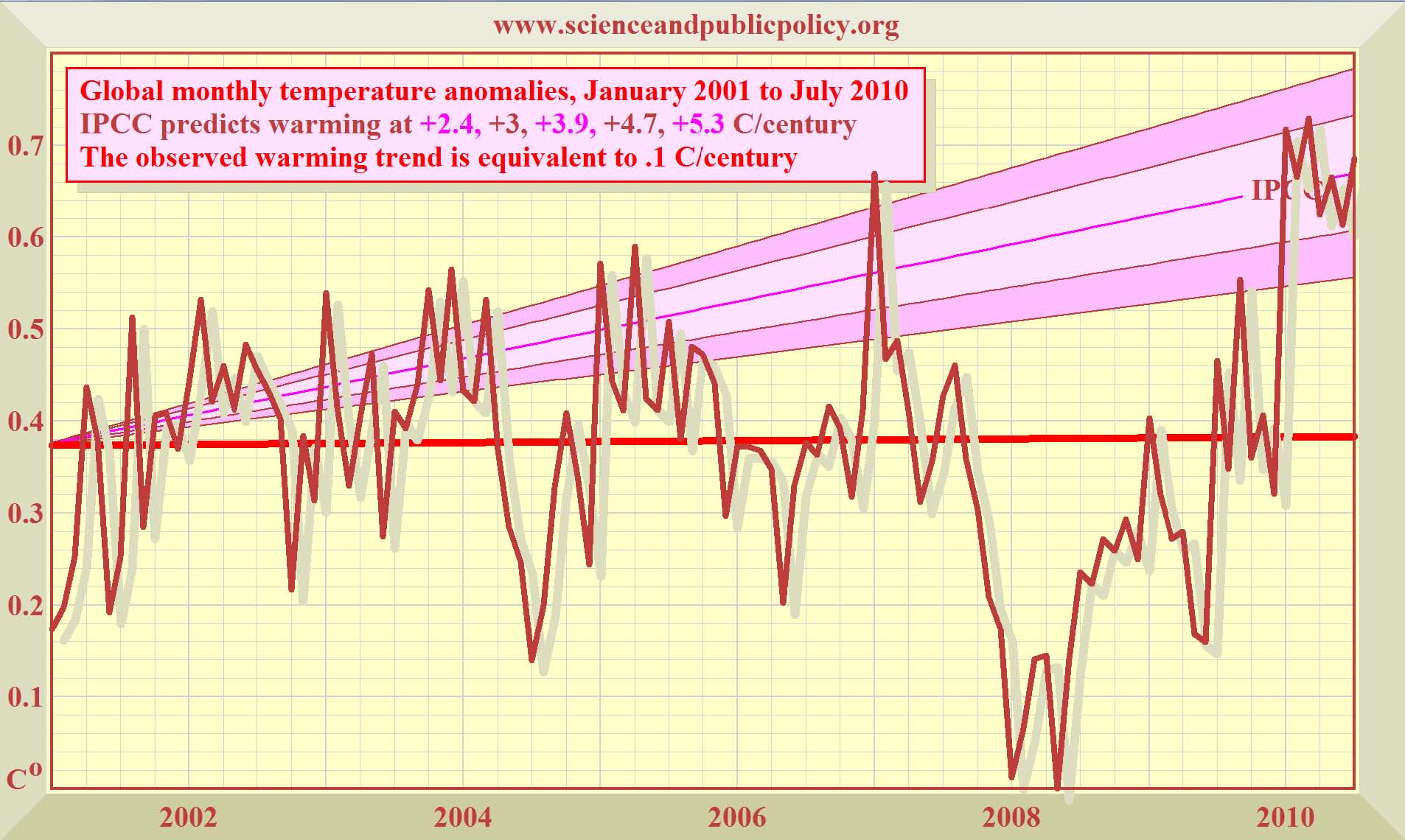

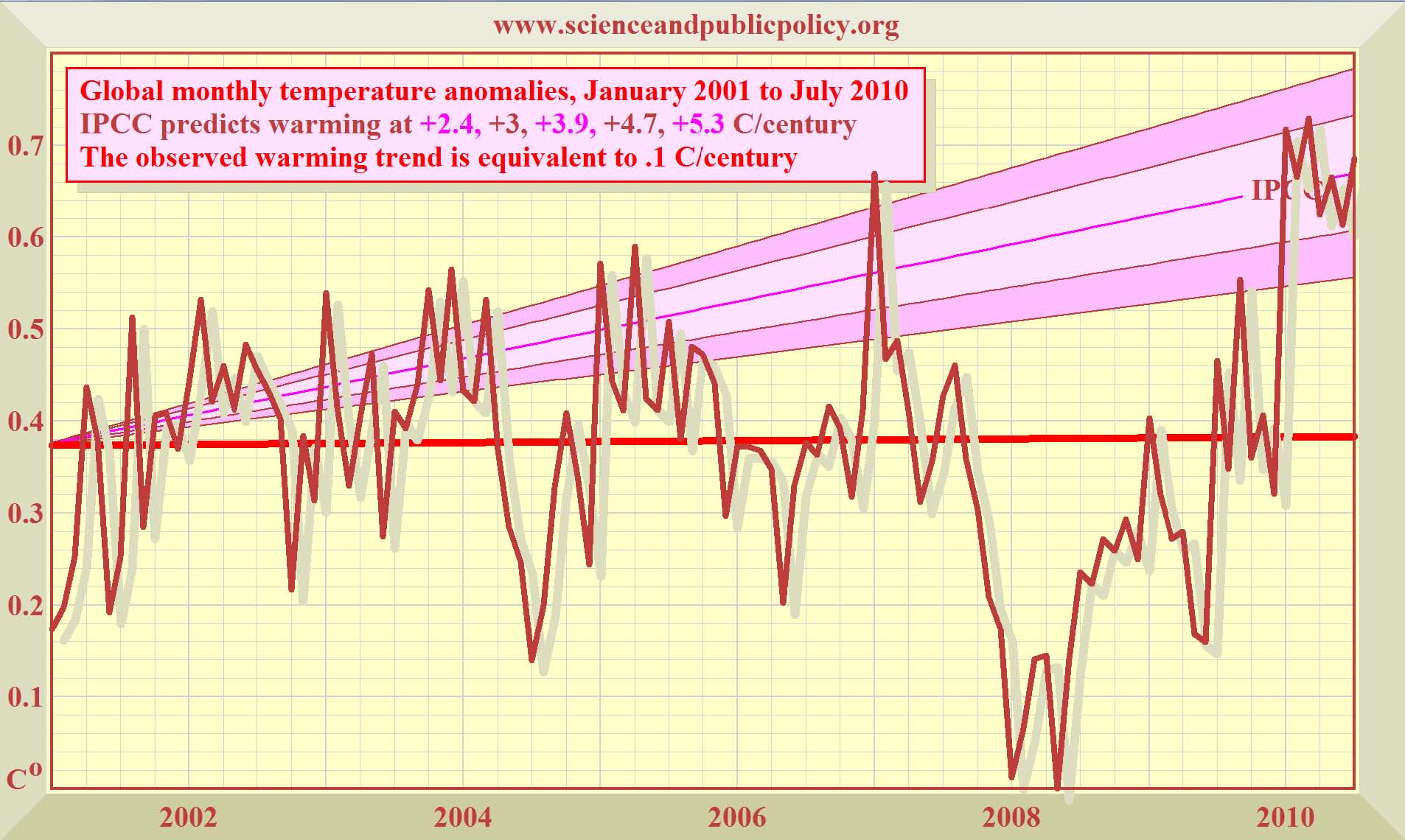

Aus dem IPCC AR4 (4. Abschätzungsbericht von 2007) stammt die folgende Grafik.

Abbildung 9 zeigt verschiedene Szenarien (Prognosen?) A“ bis „Constant“ aus dem AR4 von 2007. Der rote Kringel zeigt die letzten 10 Jahre.

Dazu der Klimamodellierer Mojib Latif vom Geomar in Kiel in der Bild-Zeitung vom 20.09.07 Seite 13:

„Die Erwärmung entwickelt sich wie vorhergesagt. Die Modelle wurden auch an vergangenen Klimaänderungen getestet. Es gibt keinen Grund, den Modellen zu misstrauen „

Gemäß unsreren o.g. Ausführungen ist dies eine Übertreibung (um das Wort „Lüge“ zu vermeiden). Modelle haben definitiv noch nie die Klimavergangenheit befriedigend wiedergeben können!

Abbildung 10. Hier wird der errechnete Verlauf (als Durchschnitt der beiden Satellitenmessungen UAH und RSH ) der globalen Mitteltemperatur seit 9 ½ Jahren ab der Jahrtausendwende gezeigt. Dieser Anstieg über grob 10 Jahre, auf das gesamte Jahrhundert hochgerechnet, beträgt 0,1 K pro Jahrhundert. Das IPCC veröffentlicht in seinen „Szenarien“ dagegen einen Jahrhundertanstieg zwischen 2,4 bis 5,3 K pro Jahrhunder [1]. Also das 24 bis 53 fache! Es muss also noch eine Menge passieren, um die IPCC-Prognosen Wirklichkeit werden zu lassen, wir sind gespannt. Damit wäre auch gleich die Frage mitentschieden, ob es nun immer wärmer wird, oder nicht. Einen netten Artikel dazu finden Sie auch hier!

In der Sendung sagte

Professor Bott dazu (25:10) es ist nicht richtig, dass sich die Erde nicht mehr erwärmt hat in den letzten…10-15 Jahren. Das ist einfach absolut falsch: Einwurf Limburg:-…sagt Phil Jones (25:13)…Bott ..wer das sagt, weiß ich nicht.. Limburg: der IPCC Chef Hauptautor. Keinerlei Erwärmung seit 1995. (sagt Phil Jones) Modelle haben versagt: CO2 steigt an. (18:3) Bott (25:31) WMO sagt 2010 ist das 3. wärmste Jahr seit Aufzeichnung der Wetterdaten. Limburg: (Das sind).. zwei paar Schuhe!

Eine kurze Anmerkung zu der immer wieder verbreiteten Behauptung von den soundso vielen wärmsten Jahren über (beispielsweise) 100 Jahre in den soundsovielten letzten Jahren: in der Tat ergibt die einfache Kombinatorikberechnung eine extrem geringe Wahrscheinlichkeit für diese Häufung – ist also etwas Schreckliches passiert? Keineswegs: Man muss nur ein wenig weiter in der Zeit zurückgehen und sich z.B. die zuverlässige Hohenpeißenberg-Temperaturkurve ansehen. Hier findet man, wenn etwa die 100 Jahre von 1790 bis 1890 betrachtet werden, eine ebenso unwahrscheinliche Häufung von kalten Jahren am Ende dieses Zeitraums. Woran diese Häufungen liegen, kann mit Hilfe der Persistenz von Temperaturreihen erklärt werden (s. beispielsweise Vortrag von Prof. Lüdecke auf der 3. Berliner Klimakonferenz). Wir wollen aber diesen recht technischen und keineswegs einfachen Punkt hier nicht weiter vertiefen.

Der IPCC Leitautor und bekannte Modellierer Kevin Trenberth schrieb im Oktober 11, 2009: email 1255352257 an den Hockeystick Erfinder Michael Mann:

“The fact is that we cannot account for the lack of warming at the moment and it’s a travesty that we can’t.”

„Fakt ist, dass wir für die fehlende Erwärmung (s. Grafik Abb 10) keine Erklärung haben und es ist ein Hohn das wir sie nicht haben“

Man beachte das Datum. Es war vor einem Jahr im Oktober. Wie gut sind also die Szenarien bzw. Prognosen ohne Vorhersage? Der Leser möge selbst entscheiden.

8. Schuld und Sühne

Die anderen Diskutanten waren sich trotzdem weitgehend einig, dass

(1) eine massive Klimabedrohung existiere,

(2) diese vom Menschen verursacht sei und

(3) dazu noch der Westen die Schuld an dem drohenden Desaster trüge wegen seines erfolgreichen kapitalistischen Wirtschaftsmodells.

Dazu sagten:

Frau Henneberger (15:55) Historische Klimaschuld, THG Ausstoss massiv senken, und Gelder bereitstellen. Herr Fischer: (24:16) Vorbild: Müssen beweisen das Wirtschaftswachstum und CO2 Ausstoß korrelieren; nicht miteinander zusammenhängen.

Herr Limburg: ( 21:10 Schuld und Sühne?), (21:25) Es geht ums Geld; Edenhofer Zitat, Modelle zeigen Anstieg, in der Realität zeige sich kein Anstieg.

Wie der bisherige Faktencheck Teil I und Teil II erkennen ließ, lässt sich keiner der von den Diskutanten Henneberger, Fischer und Bott erhobenen Vorwürfe bestätigen. Eine „Schuld“ der westlichen Staaten an irgendeinem Klimawandel, festgemacht an der vermuteten Temperatursteigerung durch anthropogenes CO2, lässt sich nicht erkennen. Dann sollte der Richterspruch lauten: Wo keine Schuld, da keine Sühne. Doch darauf wollte sich bisher keiner einlassen, obwohl Otmar Edenhofer, ehemaliger Jesuit, jetzt Chefvolkswirt des PIK und stellvertretender Vorsitzender des IPCC in einem NZZ [2]( Neue Zürcher Zeitung) Interview ganz deutlich erklärte was von seiten der UNO und der sie unterstützenden Kreise eigentlich angestrebt wird:

„Zunächst mal haben wir Industrieländer die Atmosphäre der Weltgemeinschaft quasi enteignet. Aber man muss klar sagen: Wir verteilen durch die Klimapolitik de facto das Weltvermögen um. Dass die Besitzer von Kohle und Öl davon nicht begeistert sind, liegt auf der Hand. Man muss sich von der Illusion freimachen, dass internationale Klimapolitik Umweltpolitik ist. Das hat mit Umweltpolitik, mit Problemen wie Waldsterben oder Ozonloch, fast nichts mehr zu tun.“

Und direkt oder indirekt stimmten ihm alle Gäste zu. Klingt deutlich nach einer Art neuem kommunistischem Manifest. Früher wurde der Mensch ausgebeutet. Als das nicht mehr klappte, weil das Proletariat nach Mallorca flog, anstatt den Herren Marx und Engels endlich den Gefallen zu tun zu verelenden, musste ein neues Opfer her. Nun wird vom Menschen eben die Natur ausgebeutet (wobei wir hier sogar in vielen Teilen zustimmen, denn was die Menschheit mit dem Fischbestand der Weltmeere und dem Gebrauch dieser Meere als Müllkippe macht, kann man schon als „Ausbeutung“ bezeichnen. Leider scheren sich die Klima-Aktivisten keinen Deut um diese realen Ausbeutungsverbrechen, (wie leicht dies derzeit, ist zeigt der Milliarden Dollar Betrug in Dänemark) sie halten es lieber mit imaginären Klimaschädigungen). Am unverblümtesten stimmte die Aktivistin Henneberger zu, verhaltener die Herren Bott und Fischer.

Alle bejahten die Notwendigkeit der unmittelbaren starken Absenkung der weltweiten CO2 Emissionen mit einer starken Vorreiterrolle Deutschlands, wie sie im Energiekonzept der Bundesregierung festgeschrieben worden ist.

Prof.Bott: (36:15) Man redet von 80 % Reduktion um das 2 °C Ziel zu erreichen. An dem Ziel sollten wir wirklich festhalten…(36:29) Limburg : das bringt 2/1000 Grad weniger Erwärmung rechnerisch. Die 80 % Reduktion: Bott: Da ist sooo nicht meine Meinung! Limburg: Wir haben es gerechnet..“

Die Frage war also nicht mehr, ob das CO2 überhaupt etwas bewirkt, sondern, dass wir in jedem Falle absenken müssen, um 80 % oder sogar mehr, wie die Befürworter forderten.

Was bringt dann die deutsche Vorreiterrolle? Limburg behauptet, ca. 2/1000 °C weniger Erwärmung: Stimmt das?

Wir haben bei EIKE diese Frage mehrfach untersucht. Und je nachdem, ob man den nackten THE ohne Wasserdampfverstärkung berechnet oder mit massiver Wasserdampfverstärkung, wie es das IPCC in allen seinen „Szenarien“ vornimmt, ergeben sich die folgenden Werte .

Tabelle

|

CO2 Absenkung bezogen auf 1990 in Deutschland

|

80 % |

95 % |

| Mit IPCC Verstärkung |

0,0072 °C |

0,0086 °C |

| Ohne IPCC Verstärkung |

0,0017 °C |

0,0020 °C |

Der vereinfachte Rechenweg dazu kann hier eingesehen werden : „Klassenarbeit für die  Obertertia“. Auch wenn man – wie Prof. Bott – von der nicht nachzuweisenden Wasserdampfverstärkung ausgeht, bleiben läppische acht tausendstel Grad oder knapp neun tausendstel Grad Celsius. Wahrlich ein großer Unterschied !

Obertertia“. Auch wenn man – wie Prof. Bott – von der nicht nachzuweisenden Wasserdampfverstärkung ausgeht, bleiben läppische acht tausendstel Grad oder knapp neun tausendstel Grad Celsius. Wahrlich ein großer Unterschied !

Viel Zeit wurde den Fragen zu den „Erneuerbaren“ gewidmet, sowie der wiederum künstlich erzeugten Angst vor dem Ende der fossilen Energien. Moderator Kähler (30:00) Stichwort regenerative Energien.

Zu den „Erneuerbaren“ haben wir schon viel bei EIKE veröffentlicht. Hier finden Sie die jüngsten Veröffentlichungen im Brief an Bundesumweltminister Röttgen, oder in der Stellungnahme von EIKE zum Energiekonzept hier und hier.

Nicht neu und immer wieder gern gebracht, ist die Annahme, dass die fossilen Energien nicht mehr lange zur Verfügung stehen. Die folgende Auswahl kennzeichnet die Stimmung:

(32:48) Henneberger-sehr viele Studien belegen 100 % Erneuerbare sind möglich. (33:07) Uran ist endliche Ressource (Limburg ..5000 Jahre); Kohle ist endliche Ressource; (Limburg 4000 jahre) Henneberger (33:13) innerhalb der nächsten 100 Jahre.. Peakoil rückt immer näher.. (Limburg 150 Jahre)….Henneberger 33:26 …Was sie behaupten ist eine komplette Lüge 34:26 Wir in den Indsutrieländern haben die Verantortung für … wir haben den Klimawandel verursacht..

Es ist hier nicht der Platz, auf den von Frau Henneberger verzapften Unsinn im Detail einzugehen. Stellvertretend sei nur die Ressourcenfrage der Kernbrennstoffe genannt, die in den EIKE-News „Die Renaissance der Kernenergie I und II“ detailliert behandelt wude. Hier zeigt sich, dass sogar ohne auf Uran im Meerwasser zuzugreifen, mit den Kernkraftwerken der kommenden Generationen und mit der Transmutationstechnik Kernbrennstoff für mehrere 10.000 Jahre zur Verfügung steht.

Die Kernaussage aller Teilnehmer mit Ausnahme von Limburg lautete dagegen: Weil die fossilen und kerntechnischen Energieressourcen so begrenzt sind, müssen wir schon heute (gezwungen werden) auf diese zu verzichten und voll auf „Erneuerbare“ setzen. Also schon wieder wird eine unbewiesene Behauptung eingesetzt, um damit Angst und mit der Angst Willfährigkeit zu erzeugen. Eine uralte Taktik, wie sie seit Urzeiten angewendet wird, und wie sie leider immer noch funktioniert.

Sicherheitshalber nutzt man dazu gleich drei Ängste,

* einmal die Angst vor der Kernkraft, mit dem schönen Nebeneffekt des Abschaltens von intakten sicheren Kernkraftwerken, die billigen Strom erzeugen, wenn wir ihn brauchen und nicht dann, wenn es dem Wind oder der Sonne passt.

* die Angst vor dem Klimakiller CO2, die genutzt wird, um Kohlekraftwerke – von denen allein China derzeit etwa jede zweite Woche eines eröffnet – als schmutzig zu verteufeln und als Klimakiller dazu, die uns erfolgreich daran hindert, preiswerte und hocheffiziente Kohlekraftwerke zu bauen, welche die in riesigen Mengen vorhandene Kohle billig verstromen. Wer immer noch von „schmutzigen“ Kohlekraftwerken redet, dem sei eine Exkursion ins Kohlekraftwerk Lippendorf bei Leizig empfohlen, um sich kundig zu machen.

* Und dann die Angst vor der mit dem Begriff „Peakoil“ umschriebenen – sehr kurzfristigen – (behaupteten) Erschöpfung von Gas und Ölvorräten (der Club of Rome lässt grüßen), die uns erfolgreich dazu veranlasst, über den indirekten Zwang des unsozialen EEG das ebenso unbrauchbare wie maßlos überteuerte und völlig konkurrenzunfähige Produkt „Ökostrom“ zu kaufen.

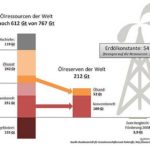

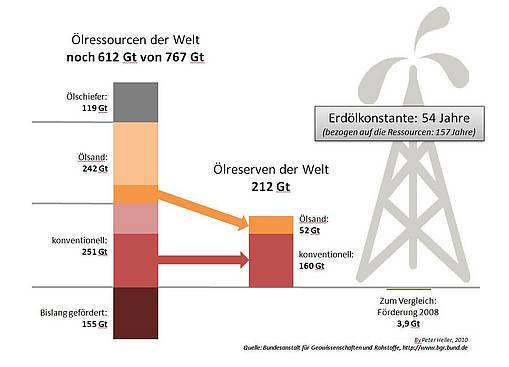

Was hat es nun mit den Reichweiten der dieser Ressourcen auf sich. Die folgende Grafik gibt darüber Auskunft.

Abbildung 11. Reichweite verschiedener Energieträger in Jahren.

Die Abbildung 11 spricht für sich selbst. Deutlich erkennbar die lange Reichweite aller dieser Energieträger, auch wenn hier eine statische Betrachtung angesetzt wurde. Hinzu kommt, dass mit der Suche nach weitere Lagerstätten noch gar nicht so richtig begonnen wurde, wie ständig neue riesige Funde onshore (shale gas) und offshore Öl & Gas fast im 3 bis 4 Wochentakt beweisen.

Den Teilnehmern der Phönix-Diskussion sei eine wichtige Erkenntnis ins Stammbuch geschrieben, die den meisten Menschen völlig unbekannt zu sein scheint. Wie lange eine Ressource (Energie, wertvolle Metalle usw.) der Menschheit zur Verfügung steht, hängt nicht vom realen Vorkommen dieser Ressource, sondern vom technischen Wissen der Menschheit ab. Die Steinzeit endete nicht damit, dass es keine Steine mehr gab, sondern dass Metalle an ihre Stelle traten.

Bleibt uns Autoren daher nur noch der weihnachtliche Wunsch:

Fürchtet Euch nicht!

Michael Limburg

Prof. Dr. Horst-Joachim Lüdecke

[1] Quelle: SPPI Monthly CO2 Report July 2010 Volume 2 Issue 7

[2] NZZ «Klimapolitik verteilt das Weltvermögen neu»

Ederer

Ederer

…

…

Obertertia“. Auch wenn man – wie Prof. Bott – von der nicht nachzuweisenden Wasserdampfverstärkung ausgeht, bleiben läppische acht tausendstel Grad oder knapp neun tausendstel Grad Celsius. Wahrlich ein großer Unterschied !

Obertertia“. Auch wenn man – wie Prof. Bott – von der nicht nachzuweisenden Wasserdampfverstärkung ausgeht, bleiben läppische acht tausendstel Grad oder knapp neun tausendstel Grad Celsius. Wahrlich ein großer Unterschied !