Zwei Stromerzeugungssysteme kollidieren

Einleitung

Das Jahr 2015 war ein Rekordjahr für die Produzenten von Solar- und Windstrom, vor allem, weil das Jahr ein „gutes Windjahr“ war. Nie zuvor wurde in Deutschland so viel Strom aus Wind und Sonne erzeugt. In der Summe waren es 125 TWh. Gemessen am Stromverbrauch liegt der Anteil des in Deutschland produzierten Wind- und Sonnenstroms damit bei 19,3%. Diese Zahl wurde von der Presse und der EE-Lobby gefeiert und der Eindruck erweckt, die erneuerbaren Energien (Wind, Sonne, Biogas, Wasserkraft, Hausmüll und Sonstige) hätten damit tatsächlich 30 % zur Versorgung in Deutschland beigetragen. Genau das ist nicht der Fall. Es wurden zwar Rekordmengen an Strom produziert, aber nicht im Lande verbraucht, sondern in großen Mengen ins angrenzende Ausland exportiert. Die Diskussion darüber, ob es sich bei den Exporten um Kohlestrom oder EE-Strom handelt, ist müßig. Auch der Hinweis darauf, dass der EE-Strom bei der Börse zu Grenzkosten 0 hereingenommen wird, führt an den eigentlichen Problemen vorbei. Unabhängig vom aktuellen Börsenpreis zahlt der Kunde immer den durch das EEG garantierten Strompreis, geht der Preis bei Überproduktion ins Negative, kommen diese Kosten noch hinzu.

Kernproblem sind die immer größer werdenden Schwankungen der EE-Stromproduktion, die von den vorhandenen thermischen Kraftwerken vor allem aus physikalischen und technischen Gründen nicht mehr kompensiert werden können. Im Netz ist der Strom aus EE-Anlagen ein Unruhestifter, dessen Schwankungen ohne die erforderlichen Speicher nicht mehr beherrschbar sind. Mit der Rekordproduktion an EE-Strom stiegen in 2015 auch die Kosten für die Notmaßnahmen zur Verhinderung eines Netzzusammenbruchs: So schreibt DER SPIEGEL am 17. Januar, dass die Eingriffe zur Abwehr eines größeren Stromausfalls im vergangenen Jahr zu Rekordkosten von etwa einer Milliarde Euro geführt haben. Über die Netzentgelte gehen diese Kosten zu Lasten der Verbraucher.

Unsere elektrischen Nachbarn errichten Stromsperren an ihren Grenzen, um die eigenen Netze vor unserem Überschussstrom zu schützen. Die erforderlichen Phasenschiebertransformatoren lassen sie sich vom deutschen Stromkunden auch noch bezahlen! Kosten für die Verbraucher: 200 Millionen Euro.

Dieses Debakel ergibt sich aus fundamentalen technischen und physikalischen Zusammenhängen und schon vor Jahren wurde davor gewarnt: In einer Untersuchung [1] hat das ISE Fraunhofer Institut in Freiburg schon im August 2013 davor gewarnt, dass ein weiterer Ausbau der erneuerbaren Energien zu anwachsenden Exportüberschüssen und zu länger andauernden Zeiten mit niedrigen oder gar negativen Börsenpreisen und zu einem langfristig unüberwindbaren Systemkonflikt führen wird.

Dieser Systemkonflikt ist längst eingetreten. Aus Sätzen der mathematischen Statistik wurde bereits im Jahre 2014 abgeleitet, dass die Leistungsspitzen durch den Ausbau der Windkraft weiter ansteigen und die bekannten Probleme wie Überstromproduktion und Negativpreise an der Börse weiter verschärfen werden [2].

Der Systemkonflikt entsteht durch zwei voneinander unabhängige Stromerzeugungssysteme in Deutschland:

- Das konventionelle Stromerzeugungssystem, bestehend aus Kernkraftwerken, Braunkohlekraftwerken für die Grundlast, Steinkohlekraftwerken für die Mittellast und Gaskraftwerken für die Spitzenlast. Diese Klassifizierung ergibt sich zwangsläufig aus dem technisch möglichen und wirtschaftlich sinnvollen Regelpotenzial dieser Kraftwerke.

Zu dem konventionellen Stromerzeugungssystem kann man aus gutem Grund auch die Biogasanlagen hinzuzählen. Diese lassen sich ähnlich kontinuierlich betreiben wie Kohlekraftwerke und gehören damit auch zu den regelbaren Stromerzeugern. Die konventionellen Anlagen lassen sich bedarfsgerecht betreiben. Aufgrund der Regelbarkeit der Kraftwerke folgt die Stromproduktion auf die Millisekunde genau dem Bedarf. Dieser momentane Ausgleich von Nachfrage und Erzeugung ist die physikalische Grundbedingung für ein stabiles Stromnetz.

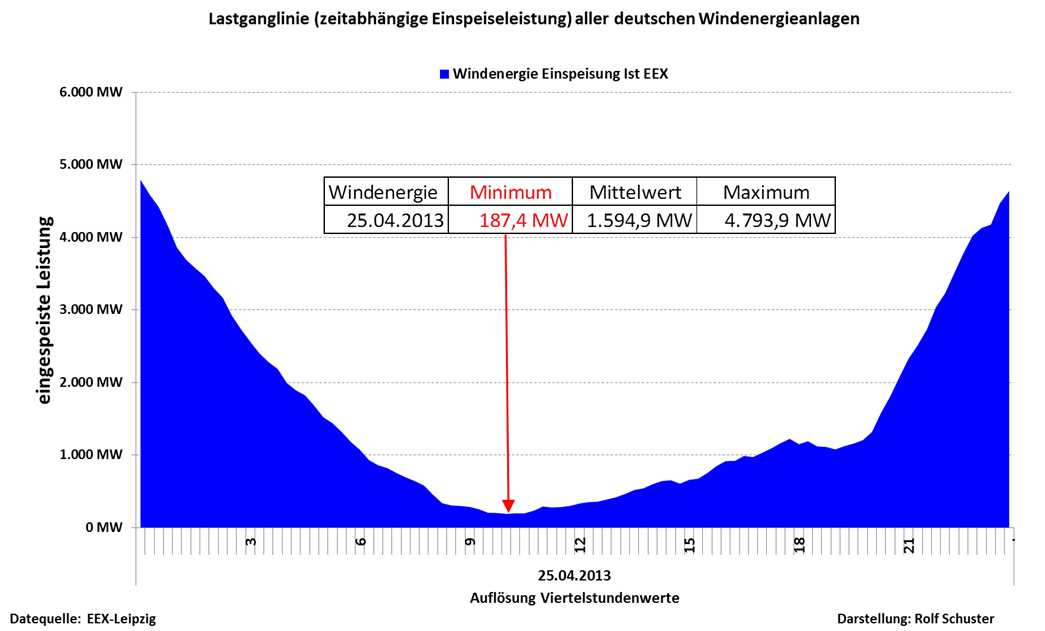

- Das zweite System sind Windkraftanlagen mit ca. 45 GW installierter Leistung und Photovoltaikanlagen mit ca. 40 GW installierter Leistung. Die Stromerzeugung aus Sonne unterliegt dem Tag-Nacht-Rhythmus. Die Periodendauer beträgt 24 Stunden, der Stromeintrag beginnt nach Sonnenaufgang mit geringen Werten und erreicht um 12:00 das Maximum. Der Leistungsbedarf schwankt auch im 24 Stunden Rhythmus, jedoch nicht deckungsgleich mit dem Sonneneintrag. Er beginnt früher als die Sonnenstromlieferung, geht gegen Mittag zur Zeit der höchsten Sonnenausbeute leicht zurück, steigt danach wieder an und endet gegen Abend später als der Sonneneintrag.

Die Windausbeute hängt von den Wetterbedingungen ab. Wind- und Sonnenstrom sind daher in hohem Maße volatil.[1] Bedarfsgerechte Stromerzeugung ist mit diesem System physikalisch nicht möglich.

Die Kombination aus Wind- und Sonnenstrom verursachen für das konventionelle Versorgungssystem unterschiedlich schwierige und unterschiedlich teure Regelsituationen. Der einfachste und auch kostengünstigste Fall ist Windstille bei Nacht. Dann liegt der Regelungsbedarf bei Null. Der teuerste Fall ist viel Wind beispielsweise bei einer Ost-Wetterlage und tagsüber ein hohes Angebot an Solarstrom. Hier müssen konventionelle Kraftwerke vormittags schnell abgeregelt und nachmittags genauso schnell wieder heraufgeregelt werden. Nur so können Netzausfälle vermieden werden.

Die Volatilität von Wind- und Sonnenstrom ist das bisher ungelöste Kernproblem der Energiewende. Liegt die Lösung in noch mehr Windrädern?

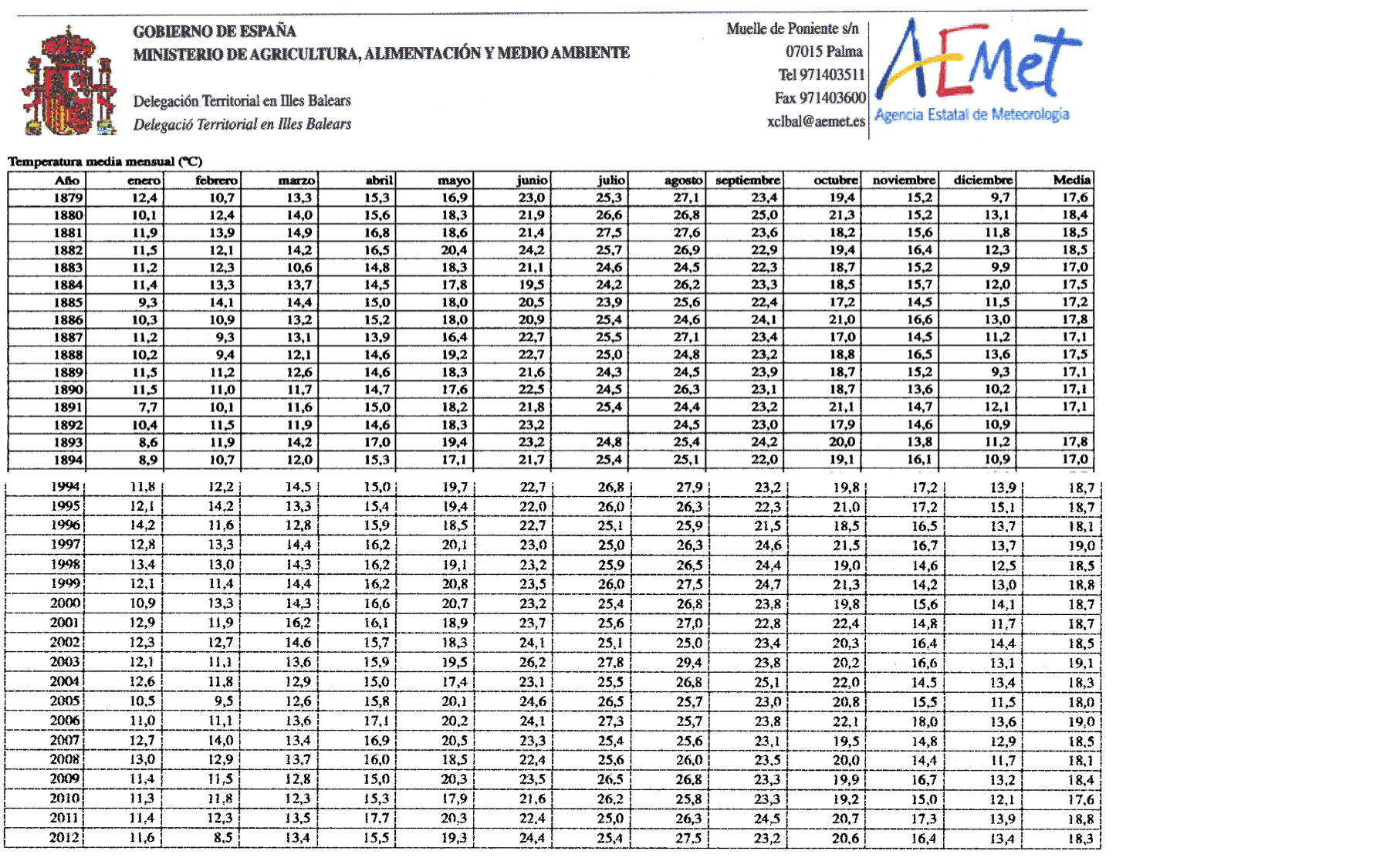

Tabelle 1 Statistische Kennzahlen Windkraft

| Jahr | Installierte Nennleistung am Jahresende | Maximale Windleistung | Mittlere Windleistung | Minimale Windleistung | Standard-abweichung Stundenwerte – Mittelwert | Verhältnis Standard-abweichung zum Mittelwert |

| 2010 | 27.072 MW | 21.679 MW | 4.070 MW | 113 MW | 3.661 MW | 0,90 |

| 2011 | 28.606 MW | 22.870 MW | 5.051 MW | 88 MW | 4.391 MW | 0,87 |

| 2012 | 30.755 MW | 24.086 MW | 5.222 MW | 115 MW | 4.419 MW | 0,85 |

| 2013 | 33.614 MW | 26.269 MW | 5.380 MW | 121 MW | 4.864 MW | 0,91 |

| 2014 | 36.928 MW | 29.687 MW | 5.868 MW | 24 MW | 5.488 MW | 0,93 |

| 2015 | 44.946 MW | 36.956 MW | 8.996 MW | 93 MW | 7.220 MW | 0,80 |

Betrachtet man die Standardabweichung als Maß für die Volatilität so ist festzustellen, dass diese von 2010 bis 2015 gleichzeitig mit dem Anstieg der installierten Wind- und Sonnenleistung zu- und nicht etwa abgenommen hat. Offensichtlich erhöhen noch mehr Windräder lediglich die Spitzenerzeugung, ohne eine sichere Grundlast zur Verfügung stellen zu können. Eine sichere und unterbrechungsfreie Stromversorgung ist unabhängig von der Anzahl der Wind- und Sonnenkraftwerke nicht möglich. Einen Ausgleich der Erzeugung zu einer sicher zur Verfügung stehenden Leistung durch noch mehr Windräder gibt es in Deutschland nicht. Dies ist inzwischen hinreichend belegt [3], obgleich das Gegenteil in Studien zu erneuerbaren Energien immer wieder behauptet wird und damit die Politik zu nachweisbar falschen Entscheidungen drängt.

Strom aus Wind und Sonne hat gemäß EEG Vorrang in den Netzen und wird von der Börse zu Grenzkosten 0 hereingenommen. Dadurch ist das volatile und für den Stromverbraucher teure Stromerzeugungssystem gegenüber dem konventionellen System absolut bevorzugt. Das bedeutet in letzter Konsequenz, dass die konventionellen Kraftwerke bei Nacht und Windstille die gesamte nachgefragte Leistung decken können müssen und dies unabhängig von der Anzahl der installierten Windräder. Die gesamte Sonnen- und Windleistung muss zu 100 % der nachgefragten Leistung ausreichend schnell durch regelbare Kraftwerke ersetzbar sein. Die maximale Residuallast, das ist die Differenz zwischen der benötigten Leistung und der Leistung, die die nicht regelbaren Kraftwerke – das sind die Wind- und Sonnenkraftwerke – erbringen, beträgt in diesem Fall 100% der nachgefragten Leistung.

Wenn ausreichend Sonnen- und Windleistung vorhanden ist, müssen die konventionellen Kraftwerke den Schwankungen der Wind- und Sonnenstromerzeugung schnell folgen und soweit heruntergefahren werden, wie dies technisch und wirtschaftlich vertretbar ist. Diese Schwelle bestimmt die mögliche minimale Residuallast, auf die die konventionellen Kraftwerke heruntergefahren werden können, ohne dass sie die Fähigkeit verlieren, bei Nachlassen von Wind und Sonne die Leistung kurzfristig wieder herauf geregelt zu werden. Welche Residuallast darf also nicht unterschritten werden?

Zur Erinnerung: es sind bereits 85 GW Wind- und Sonnenleistung installiert. Als Maximalwert wurden bisher im Rahmen des Netzmanagements 50 % der Nennleistung, das sind etwa 42 GW zugelassen. Bei weiterem Ausbau der Windenergie wird zumindest in Schwachlastzeiten sehr bald mit negativen Residuallasten zu rechnen sein, d.h. es kann theoretisch mehr EE-Strom produziert als verbraucht werden. Eine Prognos-Studie geht davon aus, dass als Folge eines weiteren Ausbaus von Sonnen- und Windkraft in 2030 an ca. 1100 Stunden eine negative Residuallast anfallen wird. [4]

Beispielsweise am Sonntag den 8. Mai 2016 betrug der Leistungsbedarf in Deutschland gegen 12:00 Uhr ca. 50 GW. Wind und Sonne lieferten zur gleichen Zeit 42 GW, damit betrug die auf den Strombedarf in Deutschland bezogene Residuallast nur 8 GW. Eigentlich würde man hier erwarten, dass die verbleibenden Kraftwerke auf diese Leistung zurückgefahren werden. Warum war das nicht der Fall? Die regelbaren Kraftwerke wurden auf 23 GW abgeregelt. Der Überschuss von 15 GW wurde in ausländische Netze „entsorgt“. Dafür waren zwischen 10:00 Uhr und 17:00 Uhr Entsorgungsgebühren von 21 Mio. € fällig. In der Statistik werden die Entsorgungsgebühren beschönigend „negative Strompreise“ genannt.

Das Kernproblem der Energiewende ist die bedarfsgerechte Bereitstellung der Residuallast. Wie weit und wie schnell kann man die vorhandenen Kraftwerke auf- und abregeln und sind die Kraftwerke dann überhaupt noch wirtschaftlich zu betreiben?

Für die Ermittlung der minimal zulässigen Residuallast sind folgende Faktoren zu berücksichtigen:

- Welches ist die maximal mögliche Abregelgeschwindigkeit, damit die konventionellen Kraftwerke den witterungsbedingten Schwankungen der EE-Stromeinspeisung und damit den steilen Lastgradienten folgen können?

- Welches ist der Minimalwert, von dem aus die konventionellen Kraftwerke ihre Leistung bis zur Nennleistung wieder schnell heraufregeln können?

- Welche minimale generator-basierte Leistung muss zur Bereitstellung der Frequenz stabilisierenden Schwungmasse vorgehalten werden?

Die Leistungsänderung erfolgt in einem technisch bestimmten Leistungsspektrum – nämlich zwischen der minimalen – und technisch sinnvollen – im Normalbetrieb fahrbaren Leistung und der (maximalen) Nennleistung des Kraftwerks.

Thermische Kraftwerke lassen sich schnell auf ca. 40 % ihrer Nennleistung herunterfahren.

Tabelle 2 Leistungskennwerte von Kraftwerken [5]

| Maximale

Leistung |

Minimale

Leistung |

Maximaler Laständerungs-

gradient |

|

| Kernkraftwerke

|

1.260 MW | 630 MW | ± 63 MW/min |

| Neue GuD-Kraftwerke | 875 MW | 260 MW

|

± 38 MW/min |

| Neue Kohlekraftwerke | 800 MW | 320 MW | ± 26 MW/min |

| Alte Kohlekraftwerke | 600 MW | 420 MW | ± 8 MW/min |

Zur Deckung der stark schwankenden Residuallast nutzt man sinnvollerweise die Regelkraftwerke, nämlich Pumpspeicher-Kraftwerke, Gasturbinen- (soweit verfügbar) und Steinkohlekraftwerke. KKWs sind aus wirtschaftlichen Gründen zunächst nicht für die Regelreserve geeignet. Nach Abschaltung der verbliebenen 8 KKWs in 5 Jahren stehen diese ohnehin nicht mehr zur Verfügung.

Unterstellt man eine Mindestleistung von 40 % für einen gesicherten Betrieb, kann man die Produktion aus o.a. Kraftwerken auf ca. 20 GW absenken. Dabei sind KKWs und Laufwasserkraftwerke nicht berücksichtigt. Danach sind etwa 25 bis 30 GW die Mindestleistung, auf die man die konventionelle Erzeugung absenken kann, ohne Kraftwerke komplett „kalt“ fahren zu müssen. Ein Kaltstart dauert bei Gaskraftwerken min. 30 min. Bei einem Kohlekraftwerk dauert ein Kaltstart hingegen 7 bis 15 Stunden.

Ein weiterer fundamentaler Grund, der eine Mindesteinspeisung konventioneller Kraftwerke erfordert, ist die Aufrechterhaltung der Systemstabilität, da Erzeugung und Verbrauch sich zu jedem Zeitpunkt in einem stabilen Gleichgewicht befinden müssen. Ein Abweichen von diesem Gleichgewicht äußert sich in einer Änderung der Frequenz (ein Überangebot führt zu Frequenzanstieg und ein Mangel zu Frequenzabfall). Dieses stabile Gleichgewicht wird durch die kinetische Energie der Turbogeneratoren gewährleistet, die im Netz als Kurzzeitspeicher wirken. Bereits bei einer Frequenzänderung von 0,01 Hz wird zu Maßnahmen der Primärregelung gegriffen. Zu Abweichungen gegenüber dem geplanten Gleichgewicht kann es kommen, da es Prognosefehler bei der Last und bei der Windeinspeisung geben kann und konventionelle Kraftwerke ungeplant vom Netz gehen können. Dann sind sogenannte Redispatch Maßnahmen erforderlich.

Hierzu die Erklärung von Amprion [6]:

„In allen europäischen Kraftwerken drehen sich die Generatoren 50 Mal pro Sekunde und erzeugen den Wechselstrom mit einer Frequenz von 50 Hertz. Sinkt oder steigt die Frequenz im Netz, so wird die Funktion zahlreicher elektrischer Geräte wie Computer, Fernseher oder Motoren beeinflusst. Aber auch die Generatoren können beschädigt werden, sofern die Frequenz auf unter 47,5 Hertz sinkt. Die dann auftretenden Resonanzschwingungen führen zu einer Zerstörung.

Deshalb soll im europäischen Verbundnetz die Netzfrequenz nur wenig vom Sollwert abweichen. Die Netzregelung greift bereits bei einer Abweichung von 0,01 Hertz automatisch ein. Starten in den Fabrikhallen morgens die Maschinen gleichzeitig oder werden am Abend zu den Nachrichten die Fernseher im selben Moment eingeschaltet, so steigt die Belastung der Generatoren und sie werden für einen kurzen Augenblick etwas langsamer. Das Resultat: die Frequenz sinkt ab. Die automatisch einsetzende Leistungs-Frequenz-Regelung im Netz sorgt dafür, dass die Kraftwerke neue Leistungssollwerte erhalten und dadurch die Turbinen mehr Dampf bekommen und die Generatoren wieder mit 50 Hertz (Hz) rotieren. An dieser Regelung sind kontrahierte Kraftwerke im UCTE-Verbund beteiligt, die dafür ein vereinbartes Leistungsband ihrer Erzeugungsleistung als Reserve bereithalten.“

Die Übertragungsnetzbetreiber haben in einer Studie zur Ermittlung der Mindesterzeugung des konventionellen Kraftwerkparks folgende Ergebnisse veröffentlicht [7]:

„Bei einer durchschnittlich bereitgestellten Regelleistung für die Primärregelung in Höhe von 3 % der Nennleistung ergibt sich eine installierte Leistung von knapp 20 GW, die kontinuierlich am Netz sein muss. Auf Basis dieser Mindesterzeugung wird im folgenden Abschnitt der dadurch gesicherte Beitrag zur Schwungmasse im Regelblock Deutschland beziffert und dessen Bedeutung für die Frequenzstabilität abgeleitet.

Die zuvor genannte Mindesterzeugung von 20 GW stellt eine bestimmte mindestens am Netz befindliche Schwungmasse für den Regelblock Deutschland sicher. Da die Regelleistung hauptsächlich durch thermische und hydraulische Erzeugungseinheiten bereitgestellt wird, kann als konservativer Wert eine mittlere Anlaufzeitkonstante der Turbosätze angenommen werden. Somit ergibt sich abhängig von der Netzlast im Regelblock Deutschland die minimale Netzanlaufzeit. Für eine Netzlast zwischen Schwachlast von ca. 35 GW und Starklast von ca. 85 GW liegt die minimale Netzanlaufzeitkonstante für den Regelblock Deutschland zwischen 5,7 s und 2,4 s. Hierbei sind alle Kraftwerke vernachlässigt, die nicht an der Primärregelung teilnehmen. Selbst bei hoher Netzlast stellen die primärgeregelten Kraftwerke annähernd die minimal erforderliche Schwungmasse bereit. Darüber hinaus sind u. a. Laufwasserkraftwerke und KWK nahezu das ganze Jahr am Netz. Es ist davon auszugehen, dass bei mittlerer und hoher Netzlast weitere konventionelle Erzeugungseinheiten am Netz sind, sodass die o.g. Empfehlung für die minimale Schwungmasse ohne zusätzliche Maßnahmen erfüllt werden kann.“

PV-Anlagen und Windkraftanlagen verfügen nicht über Schwungmassen. Diese müssen auch in Zeiten hoher Wind- und Sonnenstromausbeute von konventionellen Kraftwerken bereitgestellt werden.

Aus den oben genannten Gründen kann und darf die Residuallast nicht nennenswert unter 20 GW sinken. Das hat zur Folge, dass auch und gerade in Schwachlastzeiten bei hohem Aufkommen an Sonnen- und Windstrom konventionelle Kraftwerke zur Stabilisierung der Netze in Betrieb gehalten werden müssen, will man die Netzstabilität nicht gefährden. Daraus ergibt sich, dass überschüssiger EE-Strom exportiert oder abgeregelt werden muss. Um teure Exporte zu vermeiden, müssen Windkraft- und Solaranlagen abgeregelt werden. Es gibt also einen kausalen Zusammenhang zwischen der Überproduktion von EE-Strom und den Stromexporten. Das deutsche Stromnetz ist also aus Gründen der Systemstabilität schon heute nicht mehr in der Lage, die Erzeugungsspitzen aus EE-Strom in vollem Umfang aufzunehmen.

![Abbildung 1 Stromexporte zwischen 2010 und 2015 [8]](http://www.eike-klima-energie.eu/wp-content/uploads/2016/12/Abb-1-Import-Export-2-300x187.jpg)

In der Tat haben sich die Exportmengen seit 2010 nahezu verdoppelt. Bevorzugte Exportländer sind Österreich, Niederlande und Belgien.

Eine Reduzierung der Leistung unter 25 GW ist technisch und wirtschaftlich nicht möglich. Der in der Folge entstehende Überschussstrom muss in ausländische Netze geleitet werden. Ein typisches Beispiel ist die 45. Woche 2015.

Abbildung 2 Last und Stromerzeugung in KW 45 2015

Am Sonntag, den 8 Nov. 2015 betrug die EE-Strom Produktion um 00:00 Uhr knapp 26 GW, die nachgefragte Last 42 GW. Die Residuallast wurde aber nicht auf die eigentlich erforderlichen 16 GW gedrosselt, sondern nur auf 26 GW, um genügend Schwungmasse für die Netzstabilität zur Verfügung zu stellen und um die Regelfähigkeit für den weiteren interessanten Lastverlauf des Tages zu sichern. Von 00:00 Uhr bis 02:00 Uhr gingen 10 GW in den Export. Mit steigender Nachfrage in Deutschland verringerte sich der Export auf ca. 2 GW. In der Nacht gab es wieder mehr Windstrom und um 24:00 gingen wieder 12 GW in den Export.

Abbildung 3 Korrelation der Stromexporte mit Wind- und Solarproduktion im Februar 2015 (Stundenwerte)

Wertet man die zugänglichen Daten mittels Regressionsanalysen[2] aus, kommt man zu vergleichbaren Ergebnissen:

Abbildung 3 zeigt einen eindeutigen Zusammenhang zwischen der stündlichen EE-Stromproduktion und den Stromexporten: Je höher die EE-Leistung, desto höher sind die Stromexporte. Dies gilt nicht nur für die Stundenwerte, sondern auch für die summarische jährliche Stromproduktion.

Die Regressionsanalyse der Jahresdaten zeigt einen signifikanten Zusammenhang zwischen EE-Stromerzeugung und -export (Abbildung 4). Der Regressionskoeffizient liegt mit 0.92 nur unwesentlich unter dem höchsten möglichen Wert 1. Zahlenmäßig hat das Anwachsen der EE-Stromerzeugung auf jährlich 120 TWh eine Erhöhung des Stromexports um rund 40 TWh zur Folge gehabt. Ein Drittel der EE-Stromproduktion wurde nicht in Deutschland verbraucht, sondern ins Ausland exportiert. Die verbreitete Behauptung, erneuerbare Energien hätten einen Beitrag von 30% zur deutschen Stromversorgung geleistet, hält daher einer kritischen Prüfung nicht Stand.

Daher ist die EE-Stromerzeugung unter den gegebenen technischen und wirtschaftlichen Randbedingungen die Ursache für den Export und für die unvertretbaren Entsorgungsgebühren.

Abbildung 4 Zusammenhang zwischen Stromexport und Stromproduktion aus Wind- und Solarkraftwerken

Tabelle 3 Entwicklung von negativen Strompreisen

| Jahr | Anzahl Stunden mit negative Börsenpreisen | Handelsmenge EEX | Summe der Handels-menge | Durchschnittlicher negativer Börsenwert |

| 2010 | 12 h/a | 0,32 TWh | -1.695.134 € | -5,40 €/MWh |

| 2011 | 14 h/a | 0,46 TWh | -4.674.723 € | -10,10 €/MWh |

| 2012 | 56 h/a | 1,81 TWh | -106.573.608 € | -58,80 €/MWh |

| 2013 | 64 h/a | 2,17 TWh | -31.403.398 € | -14,50 €/MWh |

| 2014 | 64 h/a | 2,59 TWh | -41.511.253 € | -16,00 €/MWh |

| 2015 | 126 h/a | 4,77 TWh | -44.223.893 € | -9,30 €/MWh |

In 2015 haben die abnehmenden Länder 44,2 Mio. € Entsorgungsgebühr erhalten, obwohl Windräder in zunehmendem Maße abgeschaltet wurden. Die sogenannte Ausfallarbeit [9] hat sich von 1,5 TWh in 2014 auf 3 TWh in 2015 fast verdoppelt. Ohne diesen Anstieg wären die Exportmengen und damit die Entsorgungsgebühren entsprechend höher gewesen.

Folgende Gesetzmäßigkeit lässt sich ableiten: sinkt die Residuallast unter die minimale Regelleistung, dann muss Strom exportiert werden oder die Wind- oder PV-Anlagen müssen vom Netz genommen werden. Eine weitere Schlussfolgerung: wird der vorgesehene weitere Ausbau der Sonnen- und Windkraft nicht gestoppt, muss es zu noch höheren Exporten kommen mit der Folge noch höherer Entsorgungskosten und / oder die neuen Anlagen müssen bei viel Sonne und Wind abgeschaltet werden mit der Folge noch höherer Kosten für die Ausfallarbeit.

Eine im Auftrag des BMWI durchgeführte Studie [10] geht davon aus, dass es für Deutschland mit seinen „elektrischen Nachbarn“ bei weiterem Ausbau der Windkraft Ausgleichseffekte durch unterschiedlichen Lastgang und durch schwankende nationale Produktionen geben wird. Den Beweis für die Ausgleichseffekte erbringt die Studie nicht. Einen Ausgleich bei der Windkraft, und das ist hinreichend bewiesen, gibt es zwischen Deutschland und seinen „elektrischen Nachbarn“ nicht. Ein Ausgleich beim Lastgang ist höchst unwahrscheinlich: in allen europäischen Ländern beginnt der Industrietag am frühen Morgen, die Mittagspause gegen Mittag und das Ende der Produktion gegen Abend. Die Lastgangkurven sind in allen europäischen Ländern im Wesentlichen identisch.

| DE | DE | DE | DE | DE | DE | DE | DE | DE | DE | |

| Jahr | FR | AT | BE | CH | CZ | DK | IT | LU | NL | PL |

| 2006 | 96,8 | 99,7 | 99,8 | 95,9 | 98,5 | 97,9 | 99,7 | 99,6 | 98,5 | |

| 2007 | 96,8 | 99,6 | 99,2 | 99,3 | 98,9 | 96,7 | 99,9 | 97,8 | 99,0 | |

| 2008 | 98,6 | 99,6 | 99,8 | 98,7 | 99,4 | 97,5 | 99,8 | 99,9 | 98,6 | |

| 2009 | 97,7 | 99,7 | 99,3 | 99,1 | 99,4 | 98,9 | 99,7 | 99,9 | 99,1 | |

| 2010 | 97,1 | 99,8 | 100,0 | 99,7 | 99,5 | 100,0 | 97,0 | 99,9 | 100,0 | 99,3 |

| 2011 | 98,9 | 99,6 | 98,4 | 99,3 | 99,4 | 99,5 | 97,1 | 99,5 | 99,8 | 99,6 |

| 2012 | 100,0 | 99,6 | 99,5 | 99,7 | 99,7 | 99,8 | 98,6 | 100,0 | 99,6 | 99,8 |

| 2013 | 96,2 | 99,6 | 99,6 | 99,4 | 99,5 | 99,5 | 97,4 | 100,0 | 99,1 | 99,9 |

| 2014 | 99,3 | 99,8 | 100,0 | 99,7 | 99,7 | 99,6 | 99,8 | 99,9 | 100,0 | 99,5 |

Tabelle 4 Gleichzeitigkeitsfaktoren der Netzlasten [12]

Die in Tabelle 4 dargestellten Gleichzeitigkeitsfaktoren zeigen, dass große Netzlasten in ganz Westeuropa im Wesentlichen zum gleichen Zeitpunkt auftreten. Ein ausgebautes westeuropäisches Stromnetz kann daher keinen Ausgleich bewirken.

Schlussfolgerungen:

- Die Exportüberschüsse und die Stunden mit negativen Börsenpreisen sind, wie in der Fraunhofer ISE Studie aus dem Jahr 2013 vorhergesagt, tatsächlich weiter gestiegen und sie werden mit weiterem Ausbau von Wind- und Sonnenstrom notwendigerweise exponentiell weiter steigen, wenn dies nicht durch Abregelung begrenzt wird.

- Die Systemkonflikte zwischen konventionellem Erzeugungssystem und dem Wind- und Sonnenstrom-System sind bereits eingetreten. Deren Beherrschung wird immer teurer.

- Bereits jetzt schalten energieintensive Industriebetriebe die Produktion ab, wenn die konventionellen Kraftwerke den steilen Lastgradienten nachmittags und abends nicht schnell genug folgen können. [11]

- Die durch das EEG geförderte Energiewende ist an den Grenzen der Physik gescheitert.

- Es müssen endlich technisch realisierbare Lösungen gefordert und gefördert werden: Haushaltspeicher für Sonnenstrom. Sie sind verfügbar, Stand der Technik und geeignet, die Spitzen der Sonnenstrom Erzeugung abzuschneiden und in den Abend und in die Nacht zu verlagern.

- Geothermie-Kraftwerke sind Stand der Technik. Das Potenzial in Deutschland ist hoch, sie sind grundlastfähig und arbeiten 8760 Stunden im Jahr ohne Emissionen. Die bisher realisierten Projekte in Bayern sind vielversprechend.

- Industrielle Abwärme kann zur Stromerzeugung genutzt werden. Hier vermutet der ORC Fachverband ein Potenzial von 4 bis 8 GW grundlastfähiger Leistung. Bereits jetzt laufen in Deutschland 100 Anlagen mit einer installierten Leistung von 120 MW.

Literaturverzeichnis

[1] Johannes N. Mayer, Niklas Kreifels, Bruno Burger: „Kohleverstromung zu Zeiten niedriger Börsenstrompreise“ Fraunhofer ISE, August 2013 https://www.ise.fraunhofer.de/de/downloads/pdf-files/aktuelles/kohleverstromung-zu-zeiten-niedriger-boersenstrompreise.pdf

[2] Ahlborn, D.: „Korrelation der Einspeisung aus Windkraftanlagen macht Grundlastfähigkeit in Deutschland unmöglich“ in: Herbert Niederhausen, Andreas Burkert: Elektrischer Strom: Gestehung, Übertragung, Verteilung, Speicherung und Nutzung elektrischer Energie im Kontext der Energiewende Springer, Vieweg 2014

[3] Ahlborn, D.: „Glättung der Windeinspeisung durch Ausbau der Windkraft?“ in Energiewirtschaftliche Tagesfragen 65. Jg. (2015) Heft 12 S.37-39

[4] Ess, F. et al.: „Bedeutung der internationalen Wasserkraft-Speicherung für die Energiewende“ www.worldenergy.ch/file/Publikationen/Aktuell/prognos_wec_20121009.pdf

[5] http://www.alt.fh-aachen.de/downloads/Vorlesung%20EV/Hilfsb%2060% 20Regelleistungsbereiche%20Lastgradienten%20Kraftwerke.pdf

[6] http://www.amprion.net/netzfrequenz

[7] „Auswirkungen reduzierter Schwungmasse auf einen stabilen Netzbetrieb“

Studie im Auftrag der deutschen Übertragungsnetzbetreiber, Abschlussbericht, 20. Januar 2012

http://www.netzentwicklungsplan.de/sites/default/files/media/documents/Minimale%20Schwungmasse.pdf

[8] Agora Energiewende Denkfabrik, BDEW Energiebilanzen

[9] Bundesnetzagentur, Monitoringbericht 2015

Udo Leuschner: Energie Chronik

http://www.udo-leuschner.de/energie-chronik/151201.htm

[10] „Versorgungssicherheit in Deutschland und seinen Nachbarländern: länderübergreifendes Monitoring und Bewertung“ Consentec GmbH, r2b energy consulting GmbH 06.03.2015 Untersuchung im Auftrag des Bundesministeriums für Wirtschaft und Energie

[11] Dipl.-Ing. Heribert Hauck: „Netzstabilisierung durch flexible Produktion“ Vortrag auf dem Tag der Metallurgie, Goslar, 04.03.2016

[12] Bericht der deutschen Übertragungsnetzbetreiber zur Leistungsbilanz 2015 nach EnWG § 12 Abs. 4 und 5, Stand 30.09.2015

[1] Unter Volatilität versteht man das Ausmaß der Fluktuation einer Größe um ihren Mittelwert oder Trend, gemessen durch die Standardabweichung bzw. den Variationskoeffizienten. Danach hat sich die Volatilität der Windkraft in absoluten Zahlen verdoppelt, während die installierte Leistung um den Faktor 1,8 gestiegen ist (Tabelle 1).

[2] Regressionsanalysen sind statistische Analyseverfahren, die es erlauben Beziehungen zwischen zwei Variablen zu identifizieren.

[1] Dr.-Ing. Detlef Ahlborn, Dr.-Ing. Detlef Ahlborn, Fachbereichsleiter Technologie, VERNUNFTKRAFT. e. V., detlef.ahlborn@vernunftkraft.de

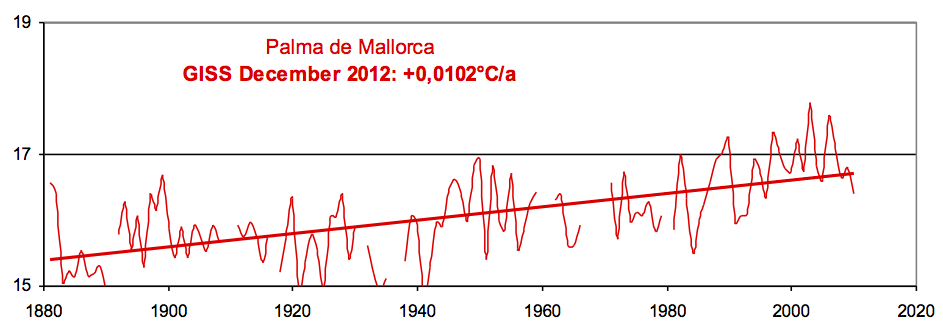

[2] Prof. Dr.-Ing. Hans Jacobi, Jacobi & Partner Industrieberatung GmbH Kennedyplatz 8 45127 Essen