Die deutsche physikalische Gesellschaft (DPG) rezensiert die Bücher „Kampf um Strom“ von Prof. Claudia Kemfert im Vergleich mit „Energie und Klima“ von Prof. Horst-Joachim Lüdecke

Die DPG (hier) ist zweifellos primär für eine fachgerechte Klimadiskussion hierzulande zuständig, nicht etwa Einrichtungen wie das Potsdamer Institut für Klimafolgenforschung (PIK), welches sich vorwiegend durch ökopolitischen Aktivismus auszeichnet und dessen Aussagen daher von den Medien bevorzugt verbreitet werden. Im DPG-Vorstand ist die IPCC-Meinungsrichtung vermutlich kein Konsens. Schon im Aprilheft 2007 des Physikjournals der DPG mahnte nämlich der DPG-Präsident Prof. Eberhard Umbach unter dem Titel “Fakten für die Klimadebatte“ wie folgt an: “Wir müssen ohne Vorurteile und ohne ideologische oder rein ökonomische Befangenheit handeln, und zwar auf der Grundlage von stichhaltigen technischen und wissenschaftlichen Fakten“.

Dieses Statement war etwas kryptisch, weil bis heute überhaupt kein Hinweis darauf erfolgte, wie diese Fakten von der DPG denn nun gesehen werden. Noch weniger ist bekannt, ob die DPG etwas unternimmt, um diese Fakten zu erhalten, zu sichern und zu sichten. Was sind die Gründe? Die Antwort fällt nicht schwer, denn die DPG sprach sich vor Fukushima nachdrücklich für die Nutzung der Kernenergie aus. Sachlich lag sie damit zweifellos richtig, aber die Politik und der Zeitgeist gingen bekanntlich andere Wege. Als Konsequenz aus dieser unverschuldeten Entwicklung, ferner, um in Zukunft nicht noch einmal auf der politisch falschen Seite zu stehen und schlussendlich auch, um die von der Politik abhängigen Forschungsmittel durch politisch unerwünschte Fachaussagen nicht zu gefährden, ist die verständliche Zurückhaltung der DPG in Sachen "anthropogenes CO2" und "Energiewende" zu erklären.

Die DPG veröffentlicht in jedem Heft ihres “Physik Journal“ aus allen physikalischen Gebieten hervorragend gestaltete Fachartikel für Nicht-Spezialisten, hat aber seit Jahren noch nie etwas über die Klimawirkung des anthropogenen CO2 gebracht. Sie hält sich schadlos, indem sie weder den Klima-Alarmisten noch den Klimaskeptikern das Wort erteilt. Dies im Gegensatz zu fast alle deutschen Medien, die freiwillig selbstgleichgeschaltet ihren Kotau vor dem grünen Zeitgeist pflegen. Die Klima- und Energiewendeverlautbarungen insbesondere von ARD, Deutschlandradio, der ZEIT, der Süddeutschen usw. und praktisch aller Lokalzeitungen propagieren Klimakatastrophen in einem Ton und einer Intensität, die Vergleiche mit der ehemaligen DDR-Propaganda für den real existierenden Sozialismus nicht zu scheuen brauchen.

Unabhängige Experten kommen in den deutschen Medien, von denen der unwissende Konsument nunmehr schon seit langem ökogefügig weichgeklopft wird, nur selten zu Wort. Der aufmerksame Medienkonsument kann lediglich noch Zeuge des einen oder anderen amüsanten Lapsus werden. So beispielsweise im Anne Will Talk, 22-45 Uhr am 11.9.2013 in der ARD. Dort gelang es der Publizistin Gertrud Höhler in einem Fall, das pausenlose, unerträgliche Gelaber des vom Forsa-Chef zutreffend als „Kotzbrocken“ (hier) bezeichneten Ralph Stegner (SPD) zu unterbrechen und leise höflich darauf hinzuweisen, dass wir schon lange eine DDR-Planwirtschaft im Energiesektor haben. Die Reaktion darauf war so, als hätte Frau Höhler laut einen Wind streichen lassen: gequältes Lächeln der gesamten Runde und ein schnelles Abschwenken von Frau Will.

Angesichts dieser für eine angeblich „offene Demokratie“ traurigen Verhältnisse sind die Worte, die Prof. Konrad Kleinknecht in seiner Buchrezension findet, eine von jedem politischen Kalkül freie fachliche Meinungsäußerung. Konrad Kleinknecht ist renommierter Kernphysiker mit wissenschaftlichen Auszeichnungen und war in den Jahren 2000-2008 im DPG-Vorstand für die Klimafrage zuständig (hier). Das erste besprochene Buch ist aus der Feder der mediennahen Ökonomie-Professorin Dr. Claudia Kemfert und titelt „Kampf um Strom: Mythen, Macht und Monopole“. Das zweite Buch, verfasst vom Physiker Prof. Dr. Horst-Joachim Lüdecke, hat den Titel „Energie und Klima: Chancen, Risiken, Mythen“. Die Besprechung erschien im August/Septemberheft des „Physik-Journal“ der DPG, S. 86 und ist hier unverändert wiedergegeben:

Kampf um Strom + Energie und Klima

Diese beiden Bücher könnten gegensätzlicher nicht sein. Das erste ist eine politische Kampfschrift einer „Protagonistin“ der Energiewende.

Claudia Kemfert wiederholt zum Thema Klimawandel und Energiewende das, was ein Großteil der Politiker und der Medien glauben und verlauten lassen: Der Klimawandel sei menschgemacht und habe dramatische Folgen, Wind- und Solarenergie seien vorzuziehen, der Umbau unserer gesamten Energieversorgung in zehn Jahren sei möglich, ohne dass Wind- und Solarenergie die Versorgungssicherheit gefährden, steigende Strompreise seien kein Problem.

Dem Buch zu eigen ist die Überzeugung, Personen, die nicht dieselbe Meinung vertreten, könne man persönlich angreifen. Besondere Zielscheiben sind der Wirtschaftsminister und Wissenschaftler, deren Meinung als nicht „politisch korrekt“ eingeschätzt wird. Sie gelten ihr als „Lobbyisten“.

Die zehn Kapitel behandeln jeweils ein Problem der Energiewende, etwa den zu engen Zeitplan, den drohenden Versorgungsengpass, den Anstieg der Strompreise als Gefahr für die Industrie oder den deutschen Alleingang. Kemfert bemüht sich, die jeweiligen Probleme als nicht existent zu charakterisieren. Das geht beispielsweise so: Die Strompreise in Deutschland steigen, sie sind unter den höchsten in Europa. Schuld daran sind aber nicht die Subventionen für Wind- und Solarstrom durch das EEG, sondern die Versorgungsunternehmen, die trotz des niedrigen Börsenpreises die Verbraucher abzocken, und die Regierung, weil sie die energieintensiven Unternehmen von Teilen der EEG-Umlage entlastet. Ganz ähnlich hat man das schon von Jürgen Trittin gehört. Dass die EEG-Umlage jährlich 20 Milliarden Euro und damit 5,3 Cent/KWh beträgt, sei nicht Ursache der Preissteigerungen, das EEG müsse so bleiben. Auch sei der Strom nicht zu teuer, sondern jahrelang zu billig gewesen.

Kemfert fordert, dass die EEG-Umlage auch der energieintensiven Grundstoffindustrie auferlegt wird. Dann wird sich diese andere Produktionsstandorte suchen müssen. Der Ökonomin Kemfert ist offenbar entgangen, dass bei der Produktion von Aluminium, Kupfer, Stahl, Kohlefasern, Zement die Stromkosten bis zu 60% der Gesamtkosten verursachen, vor den Personalkosten.

Die übrigen Kapitel des Buchs folgen dem Muster dieser zwei Beispiele. Begründungen oder Quellen für die Behauptungen fehlen.

Dagegen erlaubt sich Horst-Joachim Lüdecke aufgrund seiner physikalischen Kenntnisse eine unabhängige Beurteilung der Lage nach der Kehrtwende der Politik. Das Buch ist wissenschaftlich gehalten und kommt nicht ohne Zahlen, Diagramme und quantitative Vergleiche aus. Deshalb ist es anspruchsvolle Lektüre.

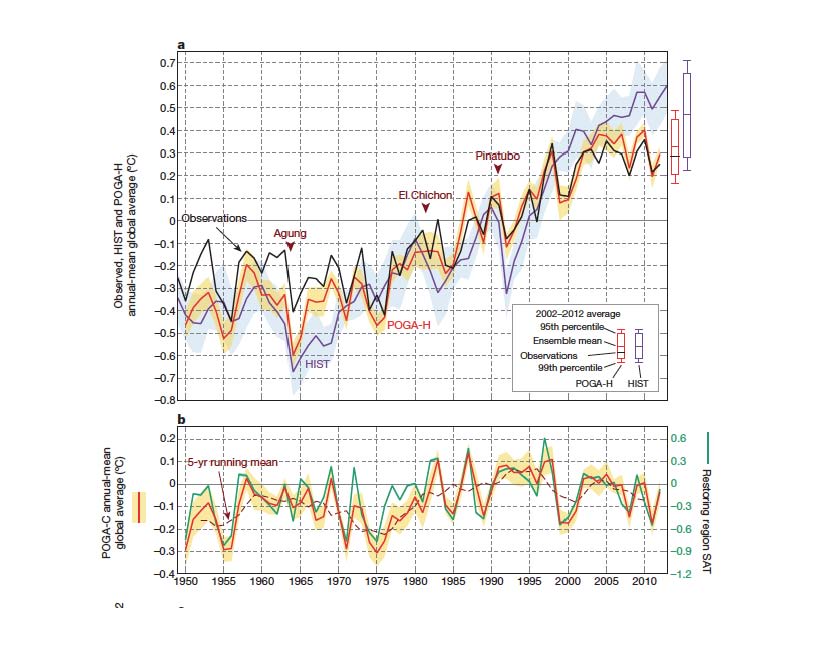

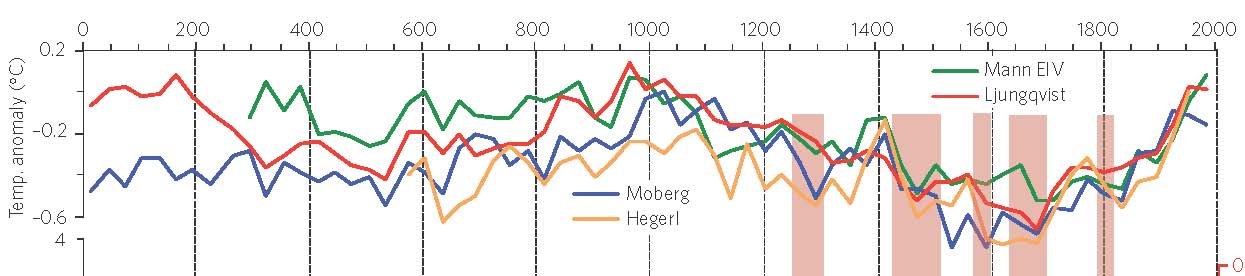

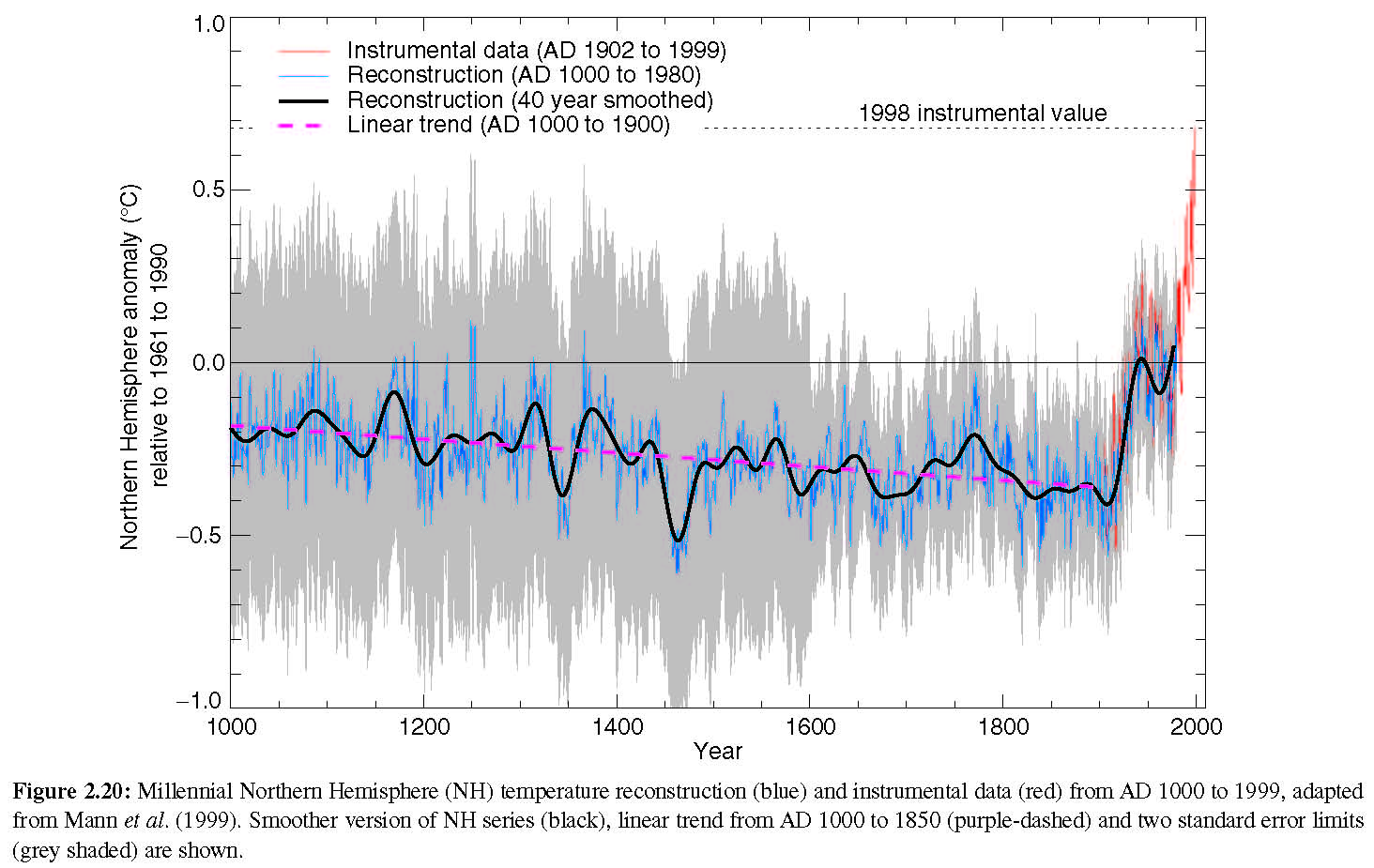

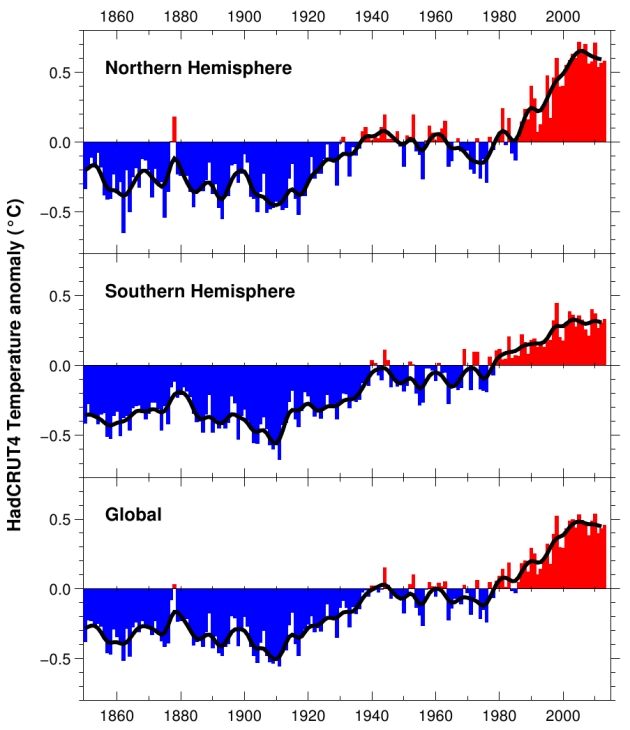

Zum Thema Klima hinterfragt der Autor die These von der monokausalen Wirkung des Kohlendioxids und die Prognosen der Klimamodellrechnungen. Es beschreibt diese hochkomplexen nichtlinearen Differentialgleichungssysteme, in denen positive und negative Rückkoppelungen enthalten sind. Die Stärke der Rückkoppelungen ist nicht genau bekannt, verschiedene Annahmen führen zu mehr als 40 verschiedenen Modellen. Keines davon hat vorausgesagt, dass die mittlere Oberflächentemperatur der Erde in den 15 Jahren von 1997 bis 2012 überhaupt nicht angestiegen ist. Gleichzeitig hat sich der CO2-Gehalt der Atmosphäre von 360 ppm auf 400 ppm erhöht. Der Autor bezweifelt, ob die Voraussage für die Erwärmung über 100 Jahre zuverlässiger ist. Ein Fehler der Modelle sei es, dass die kühlende Wirkung des Wasserdampfs durch Wolkenbildung nach Lindzen und Choi (MIT) vergessen wurde.

Zur Energiepolitik fragt sich Lüdecke, was eine Verminderung des deutschen Beitrags zur weltweiten CO2-Emission von jetzt 2,5 Prozent auf 2% bewirken soll, wenn gleichzeitig in einem Jahr der Ausstoß der großen Industrieländer China, USA, Indien, Russland, Kanada, Brasilien um 6% zunimmt. Wie soll ein deutscher Sonderweg wirken, wenn dem Vorreiter kein anderes Land nachreitet?

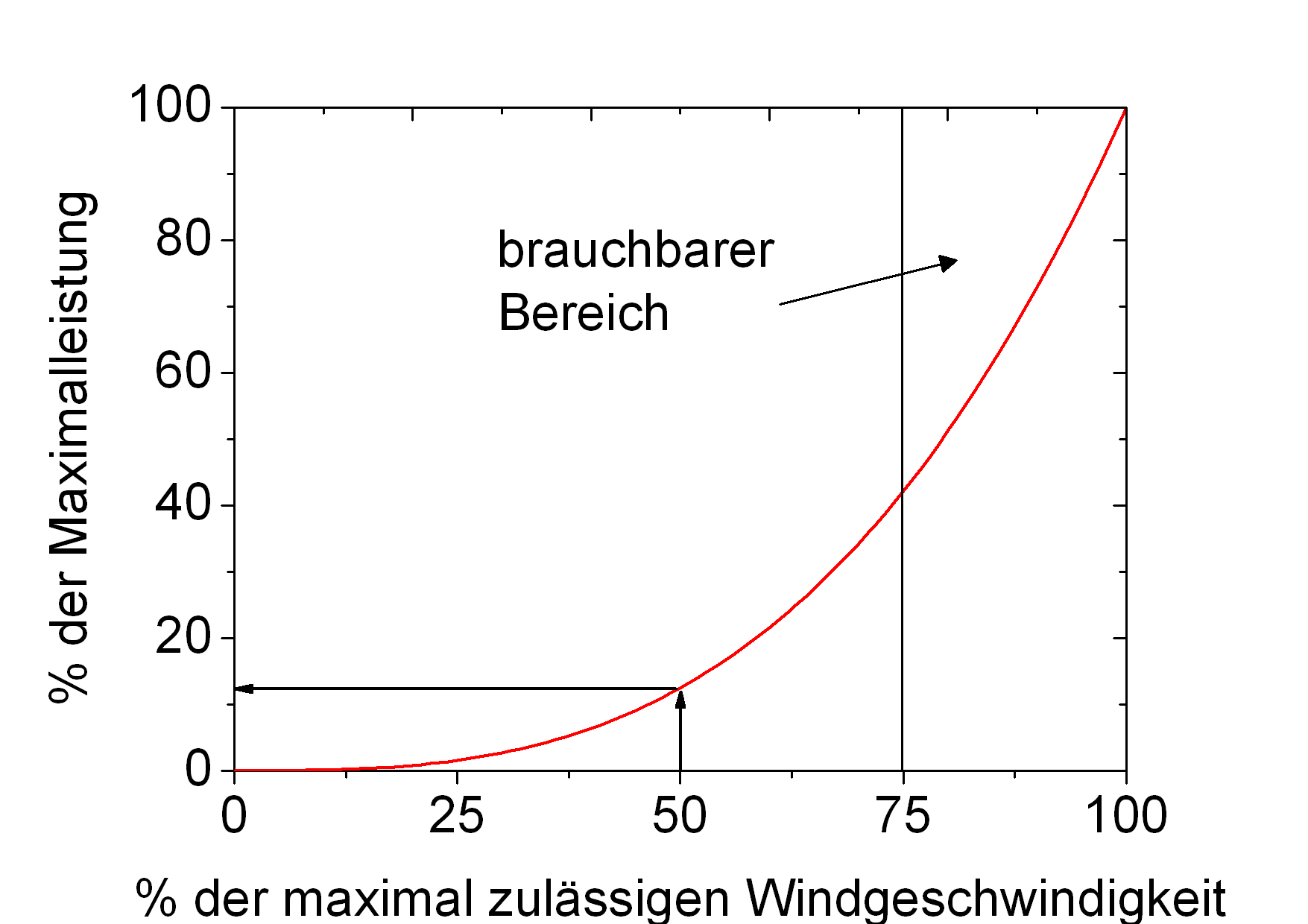

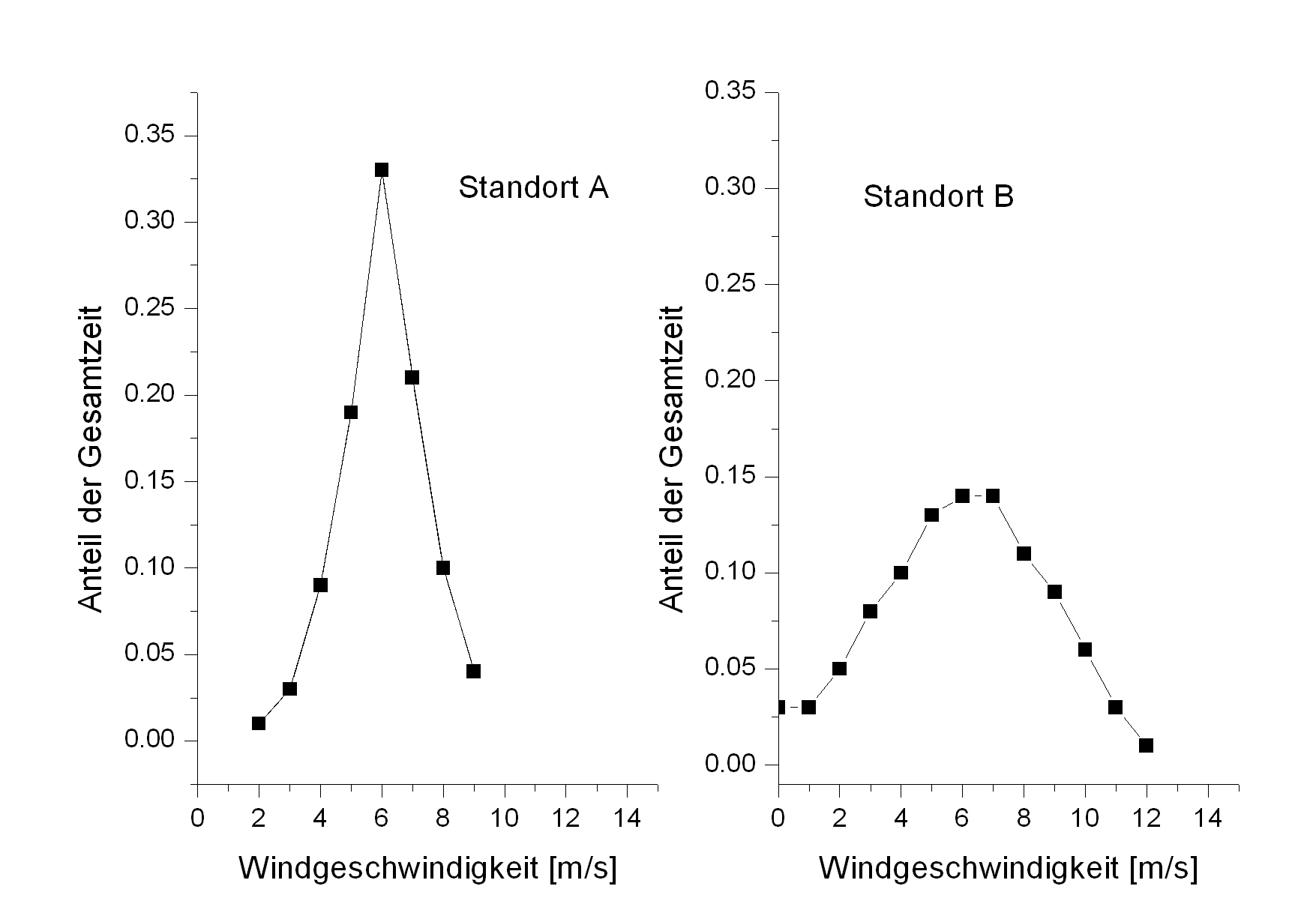

Der Autor beschreibt dann Probleme der geplanten Umstellung auf alternative Energiequellen: ungenügende Kapazität der Pumpspeicherkraftwerke in den deutschen Mittelgebirgen, fehlende Hochspannungsleitungen von Nord nach Süd, ineffiziente „Wind-to-gas“-Option zur Speicherung.

Die größte Gefahr besteht für Lüdecke allerdings in der Strompreiserhöhung durch die teuren alternativen Energiequellen und die abnehmende Versorgungssicherheit durch fluktuierende Quellen. Im Gegensatz zu Kemfert sieht Lüdecke die Gefahr der EEG-Umlage für die energieintensive Grundstoffindustrie.

Wer sich ein quantitatives Bild der Energieprobleme machen will und bereit ist, Dogmen kritisch zu hinterfragen, wird das Buch von Lüdecke mit seinen 300 Quellenangaben spannend und lehrreich finden. Wer weiter an den Erfolg der derzeitigen Wendepolitik glaubt und an einer Wahlkampfbroschüre für eine kleine Partei sucht, der kommt bei dem Band von Frau Kemfert auf seine Kosten.

Konrad Kleinknecht