Lichtblick: European Association of Geoscientists & Engineers (EAGE) veröffentlicht Kritik am Klimaalarmismus

Siehe unsere Zusammenfassung “Pioniere des Klimarealismus: Die Bundesanstalt für Geowissenschaften und Rohstoffe (BGR)“.

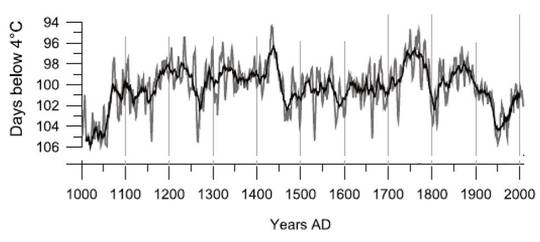

Zur gleichen Zeit glaubte auch ein Heidelberger Klimawissenschaftler an die Überzeugungskraft von harten Fakten und wagte es doch tatsächlich, die starke natürliche Variabilität der vorindustriellen Zeit und die erkannten Muster in die Diskussion einzubringen. Wiederum wurden die Kampfhunde losgelassen und eine mediale Vernichtungskampagne initiiert. Der Fall Mangini wurde schnell erledigt (siehe “Prof. Augusto Mangini – Ein Pionier des Klimarealismus“), der Querulant aus dem Weg geschafft.

Ähnlich erging es dem Bochumer Geochemiker Jan Veizer. Wikipedia fasst Veizers Beitrag wie folgt zusammen:

Zusammen mit anderen Wissenschaftlern verglich Veizer die rekonstruierten historischen Meereswassertemperaturen der letzten 545 Millionen Jahre mit der Variabilität der kosmischen Strahlung, die die Erde erreicht, sowie den historischen CO2-Konzentrationen in der Erdatmosphäre. Nach einem vorsichtig formulierten Artikel in Nature im Jahr 2000,[4] den er zusammen mit Yves Godderis und Louis M. François verfasste, können die Resultate in Übereinstimmung gebracht werden, wenn die CO2-Konzentration in der Erdatmosphäre nicht die Haupttreiber des Klimawandels in geologisch relevanten Zeiträumen sind, zumindest für ein Drittel der phanerozoischen Periode, es sei denn, die rekonstruierten CO2-Konzentrationen seien nicht zuverlässig. 2003 publizierte Veizer zusammen mit dem israelischen Astrophysiker Nir J. Shaviv einen Artikel in der Zeitschrift Geological Society of America.[5] Darin bekräftigt Veizer einen reduzierten (gekappten) Einfluss von CO2 auf den Klimawandel und schreibt der kosmischen Strahlung eine größere Bedeutung zu. Obwohl der Mechanismus noch nicht voll verstanden sei, zeigten die empirischen Daten eine geeignete Übereinstimmung. Der Artikel wurde, unter anderem von Vertretern des Potsdamer Instituts für Klimafolgenforschung scharf kritisiert.[6] Veizer and Shaviv betonten die Anwendbarkeit ihrer Forschung auf das heutige Klima wie auch ihren Respekt für Forscher, die sich auf der Linie des IPCC befinden. Veizer und Shaviv erhalten als Wert für die Klimasensitivität einen Wert von 1,5 °C; das IPCC hält dagegen Werte zwischen 2 und 4,5° für wahrscheinlich, mit einem besten Schätzwert von 3°.

Dies ist übrigens genau die CO2-Klimasensitivität, die auch wir 2012 in unserem Buch “Die kalte Sonne” annahmen, wofür auch wir vom Klimaestablishment seinerzeit heftig abgestraft wurden. Zwei Jahre später wurde Sebastian Lüning von einem Vorstandsmitglied einer großen deutschen geowissenschaftlichen Organisation aufgefordert, seine Thesen in einem Artikel für die Mitgliederzeitschrift vorzustellen. Lüning erstellte das eingeladene Manuskript – und wartete. Und wartete und wartete. Die vormals so emailfreudige Kontaktperson aus der Verbandsleitung schaltete plötzlich auf stumm. Nachfragen zwecklos. Schließlich veröffentlichten wir den Artikel einfach hier im Blog (“Klimawandel in Deutschland: Eine geowissenschaftliche Betrachtung“). Zu gerne hätten wir gewusst, was hier hinter den Kulissen passiert ist. Wer hat sich hier quer gestellt? Gab es politischen Druck, vielleicht Drohungen hinsichtlich der weiteren Karriereentwicklung der Beteiligten? Man weiß es nicht.

Im November 2015 gab es jedoch Grund zur kurzzeitigen Freude. Die 19.000 Mitglieder starke europäische geowissenschaftliche Vereinigung EAGE (European Association of Geoscientists & Engineers) veröffentlichte in ihrer Mitgliederzeitschrift First Break einen Beitrag ihres Mitglieds Bob Heath: Hier der erste Absatz (der Rest des Beitrags leider nur für Mitglieder bzw. hinter einer 30 Euro schweren Paywall):

,Unsettled‘ Wissenschaft

Die wissenschaftliche Methode und Kohlenwasserstoff-Manie.

Die wissenschaftliche Methode ist vielleicht die größte Errungenschaft der Menschheit. Sie legte den Grundstein für die industrielle Revolution, die für so Manchen den Lebensstandard auf zuvor unvorstellbare Niveaus verbessert hat. Es führte zur Ausbeutung fossiler Treibstoffe, die weitaus mehr Energie für eine Einzelperson zur Verfügung stellten als jemals zuvor, was sich sehr förderlich auf den Wohlstand auswirkte. Es gibt direkte Relationen zwischen Pro-Kopf-CO2-Output und Indizes des Lebensstandards, als da wären Kindersterblichkeit/Lebenserwartung sowie verfügbare Mittel für den Umweltschutz. Fast jeder soziale Fortschritt basierte auf Strom, der mittels fossiler Treibstoffe erzeugt worden war, die aufzufinden unsere Aufgabe ist, und trotz der kostspieligen Bemühungen hin zu Erneuerbaren stammen etwa 87% der Weltenergie aus Kohlenwasserstoffen. Seit 150 Jahren geistern Behauptungen durch den Raum, dass fossile Treibstoffe ihren Höhepunkt überschritten hätten. William Jevons prophezeite in den sechziger Jahren des 19. Jahrhunderts, dass UK sehr schnell die Kohle ausgehen würde, was ihn folgern ließ, dass die seinerzeit glücklichen Lebensumstände des Landes nur von kurzer Dauer sein würden. Aber zum großen Teil dank der Geowissenschaftler gibt es immer noch Vorräte im Überfluss. Trotz der Dämonisierung seitens der Umweltaktivisten wird die Zivilisation in absehbarer Zukunft zum allergrößten Teil von Kohlenwasserstoffen abhängig bleiben, was uns weiterhin von den Malthusianischen Grenzen fernhält. Man stelle sich eine Welt vor, in der Jevons recht gehabt hätte und uns die Kohlenwasserstoffe während der Regierungszeit von Queen Victoria ausgegangen wären. Würde sich der Lebensstandard dann auch immer weiter verbessert haben, und wie hätte in diesem Falle die Umwelt gelitten?

In dem erfrischenden achtseitigen Artikel legt Heath die bekannten klimaskeptischen Argumente vor. Interessant auf Seite 101 der Hinweis auf Mauscheleien im 2. IPCC-Bericht (SAR):

Im Zweiten Zustandsbericht wurden viele zentrale wissenschaftliche Abschnitte gelöscht, z. B. die Aussage, dass „bis heute keine Studie (die beobachtete Klimaänderung) teilweise oder ganz anthropogenen Gründen positiv zugeordnet hat“. Das IPCC hat diese Löschungen nicht bestritten, sondern gesagt, dass es unter Druck der Regierungen stand. Am Schluss hieß es: „die Beweise alles in allem zeigen einen erkennbaren menschlichen Einfluss auf das globale Klima“. Prof. Frederick Seiz schrieb: Während meiner über 60 Jahre als Mitglied der amerikanischen wissenschaftlichen Gemeinschaft einschließlich meiner Tätigkeit als Präsident sowohl der National Academy of Sciences als auch der American Physical Society habe ich niemals eine schlimmere Kaperung des Begutachtungs-Prozesses erlebt als das, was zu diesem IPCC-Bericht führte“.

Heath empfiehlt die Lektüre der IPCC-Broschüre von 1997

“AN INTRODUCTION TO SIMPLE CLIMATE MODELS USED IN THE IPCC SECONDASSESSMENT REPORT”

[Übersetzung des Titels: Eine Einführung in im Zweiten Zustandsbericht verwendeten einfache Klimamodelle]

Er schreibt weiter:

Aber im AR3 wurde eingeräumt, dass „wir es mit einem gekoppelten nichtlinearen chaotischen System zu tun haben. Daher sind langfristige Prophezeiungen der Zustände des Klimas nicht möglich“. Dabei wurde die aberwitzige Hypothese aufgestellt, dass die natürliche Variation vollständig geklärt ist.

Nachzulesen im Original des 3. IPCC-Berichts in Kapitel 14.2.2.2. Natürlich hatte sich die EAGE vor Publikation des Beitrags abgesichert und dem Artikel einen Disclaimer vorangestellt:

EAGE möchte klarstellen, dass in dieser Studie geäußerte Meinungen jene des Autors sind und nicht die Haltung der Association zum Klimawandel reflektieren“.

Es ist vermutlich nicht falsch anzunehmen, dass ein großer Teil der EAGE-Mitglieder sich trotzdem mit dem Artikel von Heath identifizieren konnte. Man kann weiter annehmen, dass es eine große Anzahl von Leserbriefen zum Thema gegeben haben muss, die jedoch bis auf zwei Zuschriften in First Break 1/2016 nicht abgedruckt wurden. Hierzu gehört auch ein Leserbrief des Hamburger Geophysikers Uli Weber, der folgendes an die EAGE schrieb:

Sehr geehrter Herausgeber,

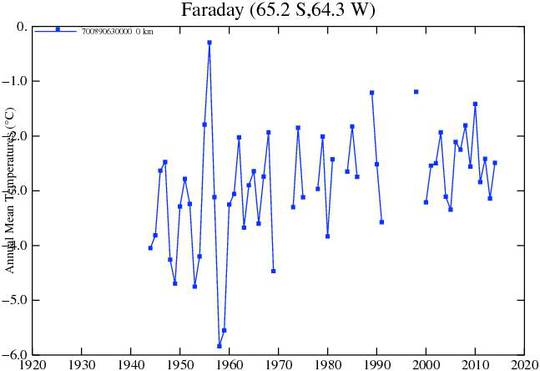

vielen Dank an Bob Heath und das für die Veröffentlichung verantwortliche Team bei der EAGE für den brillanten Artikel über Klimawandel in First Break 11-2015. Als ein Erkundungs-Geophysiker in der E&P-Industrie habe ich in den achtziger Jahren an die wissenschaftliche Vorgehensweise im Bereich Klimawissenschaft geglaubt und den Medienhype für das übliche Verhalten beim Beschreiben extremer Ergebnisse gehalten. In den neunziger Jahren habe ich das Fehlen fundierten paläoklimatischen Wissens in der Medien-Repräsentation bedauert, als man der Öffentlichkeit die befürchtete Klimakatastrophe vortrug. Und nach dem Jahr 2000 musste ich erkennen, dass in den Klimawissenschaften erwiesene paläoklimatische Fakten geleugnet wurden und das „Ende der Diskussion“ für ihre „settled Wissenschaft“ zum Klimawandel proklamiert wurde. Dies brachte mich dazu, nach meinem Rückzug ein Buch zu schreiben über die Verbindung zwischen Geologie und der Abfolge des Klimas, was, ehrlich gesagt, niemand lesen wollte.

Während meiner gesamten Profi-Tätigkeit in der Industrie war das Märchen von der zukünftigen Klimakatastrophe eine permanente Quelle von Gelächter unter den Geowissenschaftlern. Aber dieses Gelächter wurde nicht der geängstigten Öffentlichkeit vermittelt. Im Gegenteil, im Zuge der wachsenden Panik in der Öffentlichkeit über die zukünftige Klimaentwicklung fühlten sich die Geowissenschaftler mit ihren wissenschaftlichen Argumenten zunehmend isoliert, sogar in ihrem privaten Umfeld. Heute wurden politische Maßnahmen bereits umgesetzt, Milliarden Dollar sind ausgegeben worden für abartige Computermodelle, und Organisationen haben sich manifestiert, um die angepeilte Dekarbonisierung der Welt durchzusetzen. Angesichts der zukünftigen Zerschlagung unserer Industrie durch Klimaalarmisten sind wir im Zweifel, ob wir unser wissenschaftliches Wissen über das Paläoklima angemessen einer verängstigten Bevölkerung erklärt haben.

Freundliche Grüße

Ulrich O. Weber

Anmerkung: Dieser Beitrag ist zuerst auf dem Blog „Die Kalte Sonne“ hier erschienen. Übersetzung der englischen Passagen von Chris Frey EIKE