Was sind denn nun die wirklichen Gründe? Nun, es sind weder fehlende Speicher, noch fehlende Stromleitungen von Nord nach Süd, noch fehlender politischer Wille, noch fehlendes fähiges Management. Nein, lieber SPIEGEL, Du bist komplett auf dem Holzweg. Es ist viel einfacher. Bereits der frühere US-Präsident Bill Clinton hatte es begriffen (er meinte damals economics):

„It’s physics, stupid“

Wir empfehlen dem SPIEGEL, seinen Redakteuren elementare Nachholkurse für offenkundig verpassten Physik- und Technikunterricht zu verordnen. Sonst ist es wohl aus mit diesem Blatt einer selbstverschuldeten, monoton absackenden Auflage. Wie das Beitragsbild zeigt ging die Auflage des wöchtl. Verkaufs des SPIEGEL vom 1. Quartal 2012 bis zum 1. Quartal 2019 von rund 930.000 auf 700.000 Exemplare. zurück: Dies ist sicher eine Folge des stetigen Anschreibens gegen die klassischen SPIEGEL-Leser, welche Fakten und keinen grün-ideologischen Unsinn lesen wollen. Den bekommen sie woanders besser..

1. Die deutsche Energiewende

Die Bundesregierung plante ursprünglich, bis zum Jahr 2050 gegenüber 2008 den Stromverbrauch um 25% zu senken, den Anteil an erneuerbaren Energien am Bruttostromverbrauch auf 80% zu erhöhen, die Treibhausgasemissionen um 80 bis 95% zu verringern und die Zahl der Elektroautos auf 6 Millionen zu steigern. Aktuell sind diese Zielstellungen verändert und unverbindlicher im Koalitionsvertrag festgehalten.

Das Vorhaben, als „Energiewende“ bezeichnet, soll mit Strom aus Wind, Sonne und Biomasse realisiert werden, im Folgenden kurz „Erneuerbare“ genannt (die Bezeichnung ist sachlich falsch, hat sich aber dennoch durchgesetzt). Die Energiewende betrifft praktisch nur elektrischen Strom. Elektrische Energie machte 2017 etwa 1/6 der deutschen Primärenergie aus. Sie ist die wichtigste, weil unverzichtbare Energieform für jede moderne Industriegesellschaft. Strom ist nur ein Medium, um Energie zu transportieren. Er wird aus einer anderen Energieform erzeugt und beim Verbraucher in die jeweils benötigte Energieform umgewandelt. Elektrische Energie kann man in größerem Umfang nur über verlustreiche und kostspielige Umwege speichern, etwa mit Pumpspeicherwerken oder Batterien. Das Stromnetz selber ist kein Speichermedium. Ohne Speicherung muss Strom zum Zeitpunkt seiner Erzeugung sofort verbraucht werden.

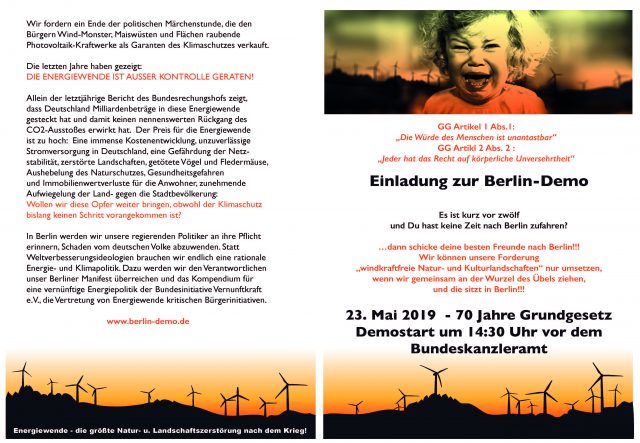

Die Energiewende hat mit erheblichen Problemen zu kämpfen. Trotz im Jahre 2017 über 28.000 installierter Windturbinen, deren Nennleistung bereits alle ehemaligen deutschen Kernkraftwerke übertrifft, macht verbrauchter Windstrom dennoch nur etwa 3% der deutschen Primärenergie aus, Sonnenstrom und Strom aus Biomasse jeweils etwa 1%. Mehr als 1000 Bürgerinitiativen wenden sich gegen die Beeinträchtigung ihrer Naturumgebung durch Windturbinen sowie gegen gesundheitsschädlichen Windrad-Infraschall. Weiterer Windrad-Ausbau lässt daher zunehmenden gesellschaftlichen Widerstand erwarten.

Deutschland hat heute die höchsten Strompreise Europas. Behörden ergreifen inzwischen Maßnahmen gegen großräumige Stromausfälle, weil die Wahrscheinlichkeit gefährlicher Blackout-Ereignisse infolge des zunehmenden Fluktuationsstroms aus Wind und Sonne ansteigt. Dem Fluktuationsproblem von Wind- und Sonnenstrom wird mit aufwendigem Zu- und Abschalten von schnell reagierenden Gaskraftwerken begegnet (GuD Backupkraftwerke). Das für die Netzstabilität notwendige Vorhalten von fossilen Backupkraftwerken, deren Leistung der Gesamtleistung der fluktuierenden Erneuerbaren entspricht, ist zu einem maßgebenden Kostenfaktor der Energiewende geworden.

Sind die Gründe für die Energiewendeprobleme falsches Management, unzureichende Planung oder technische Unzulänglichkeiten? Zu diesen Fragen gibt es bereits reichhaltige Literatur. Der renommierte Ökonom Prof. Hans-Werner Sinn hat erst jüngst wieder eine kritische Studie zur Energiewende vorgelegt. Grundsätzlich unterliegen die „Erneuerbaren“ und damit die Energiewende zwei naturgesetzlich bedingten und daher mit keinem Mittel zu behebenden Fundamentalmängeln. Der wichtigste Mangel dieser beiden wird dabei oft unterschätzt, den Medien ist er so gut wie unbekannt. Mit ihm wird sich der vorliegende Beitrag vorwiegend befassen.

Energie ist der maßgebende Kostenfaktor industrieller Produktion, und alle Industrienationen befinden sich im globalen Wettbewerb. Nicht einmal ein momentan auf ersten Plätzen dieses Wettbewerbs stehendes Land hat die Garantie, nach nachhaltigen Fehlentscheidungen in seiner Energiepolitik auch dort zu verbleiben. Im Folgenden wird dargelegt, warum die beiden Fundamentalmängel der „Erneuerbaren“ eine unvermeidbare Konsequenz elementarer Naturgesetzlichkeiten sind. Die beiden Fundamentalmängel und ihre naturgesetzlichen Gründe sind zwar den Fachleuten geläufig, nicht aber in erkennbarer Weise den für das Projekt „Energiewende“ Verantwortlichen und auch nicht den deutschen Medien.

Ein naturgesetzlich bedingter Mangel ist durch keine technische Maßnahme zu beseitigen. Der Versuch, dies dennoch zu erzwingen, führt zu extremen Kosten und Umweltbelastungen. Falsches Management und falsche Planung sind selbstverständlich bei allen großen Projekten ein gefährlicher Mangel. Es ist aber zu betonen, dass die Energiewende auch bei besten Planungs- und Managementvoraussetzungen immer noch zum Scheitern verurteilt wäre. Politik und unkundige Medien haben noch immer nicht begriffen, dass man Physik und technische Regeln nicht durch Wunschdenken oder Ideologie außer Kraft setzen kann, ohne dass die Folgen katastrophal werden.

2. Energie im Verlauf der Menschheitsgeschichte

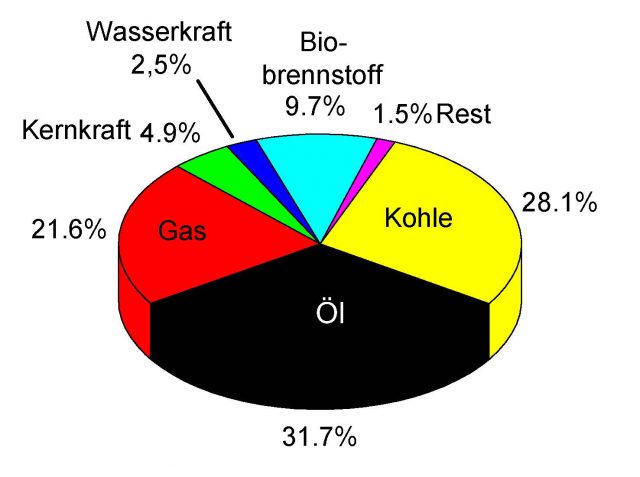

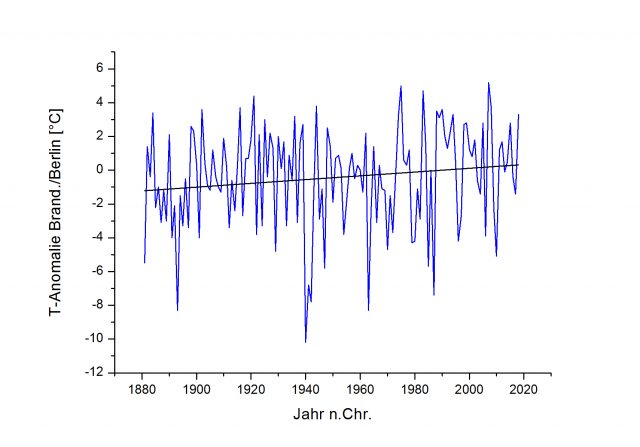

Der tägliche Energiebedarf eines Erwachsenen hat sich im Laufe der Menschheitsgeschichte laufend erhöht. Er betrug um die 8 kWh bei Jägern und Sammlern der Steinzeit, etwa 30 kWh im Mittelalter und ist auf über 200 kWh in modernen Industriegesellschaften angestiegen. Jäger und Sammler deckten ihn noch mit Feuerholz, im Mittelalter kamen Landwirtschaft, Zugtiere sowie Wasserräder und Windmühlen hinzu. Heute (2015) wird der Energiebedarf der Menschheit zu insgesamt 81,4% von Kohle, Erdöl und Gas gedeckt (s. Bild 1).

Bild 1: Weltenergieverbrauch in Methoden-Anteilen im Jahre 2015, erstellt nach den Daten der IEA. Holz– und Holzkohle (hier unter Biobrennstoffe) stellen mit dem 3,75-fachen der Windenergie zumindest in der EU den größten Anteil an den „Erneuerbaren“. Da insbesondere die erhältlichen globalen Werte in der Regel nur Schätzungen sind, können unterschiedliche Quellen voneinander abweichende Werte in den Methoden-Anteilen angeben.

Der Rest kommt aus Uran 4,9%, Wasserkraft 2,5%, Biobrennstoffen 9,7% (Holz, Stroh, Tierdung etc.) und den „Erneuerbaren“ Wind, Sonne, Geothermie, Gezeitenergie etc. 1,5%. An dieser Zusammensetzung wird sich auch in den nächsten Jahren kaum Wesentliches ändern. Wind- und Sonnen-Energie spielen weltweit nur eine verschwindende Rolle. In Deutschland würden sie bei freien Marktverhältnissen (keine Subventionen, keine gesetzliche Zwangseinspeisung von Sonnen- und Windstrom etc.) wegen ihrer zu hohen Kosten, verglichen mit Kohle oder Uran, nicht vorkommen (s. auch Bild 2 im Abschnitt 5.).

Allein die Umlagen zur Förderung der „Erneuerbaren“ gemäß dem Erneuerbare-Energien-Gesetz (EEG) belasten die deutsche Volkswirtschaft und Verbraucher heute mit 30 Milliarden Euro pro Jahr. Bei der Nutzung der „Erneuerbaren“ Wind, Sonne und Biomasse kommt zumindest in Windturbinen und Photovoltaik modernste Technik zum Einsatz. Diese Modernität verstellt freilich den Blick auf die naturgesetzlichen Schwächen dieser alternativen Stromerzeugungsmethoden. Die Energieversorgung im Mittelalter liefert für diese Schwächen ein Anschauungsbeispiel.

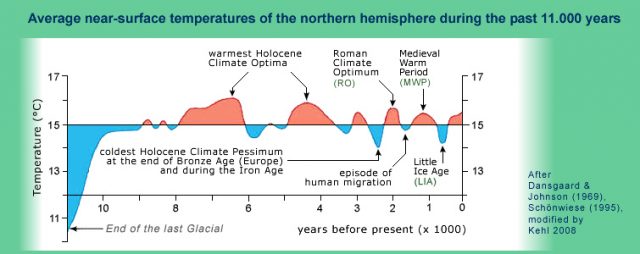

Die ab etwa 700 n.Chr. einsetzende Klimaerwärmung mit ihrem Höhepunkt um das Jahr 1000 ließ Ernteerträge und Bevölkerungszahlen ansteigen. Es wurden riesige Waldflächen für den benötigten Ackerboden gerodet, bis 1400 verschwanden dadurch zwei Drittel des deutschen Waldes. Die erforderliche Ackerfläche zur Ernährung einer Person war um ein Vielfaches größer als heute. 90% der gesamten Bevölkerung waren Bauern oder anderweitig in der Landwirtschaft beschäftigte Menschen. Der Aufwand an menschlicher Arbeit, Zugtieren und Ackerflächen für die Landwirtschaft war kaum noch zu steigern. Daher war es im Spätmittelalter bei einsetzender Klima-Abkühlung und schlechteren Ernten nicht mehr möglich, die stark angewachsene Bevölkerung noch ausreichend zu ernähren. Es begann die Zeit der Hungersnöte, verstärkt durch Seuchen und Pest. Zwischen dem Jahre 1000 und Ende des 19. Jahrhunderts wurden in Westeuropa 400 Hungersnöte registriert.

Erst der dank neuzeitlicher Chemie mögliche Einsatz von Düngern und Schädlingsbekämpfungsmitteln und die Mechanisierung der Agrarwirtschaft durch Verbrennungsmaschinen konnte die Nahrungsversorgung der Bevölkerung auf eine sichere Basis stellen. Heute ernährt ein Landwirt in Deutschland etwa 130 Mitbürger. Der Anteil der Landwirtschaft am Energieverbrauch der deutschen Gesamtwirtschaft beträgt heute nur noch 1,3%. Um die mittelalterliche Energieerzeugung mit Hilfe riesiger Ackerflächen und einem extrem hohen menschlichen Arbeitsaufwand und das im Spätmittelalter entstandene Desaster zu verstehen, sind die physikalischen Größen Energiedichte und Leistungsdichte unverzichtbar. Die zentrale Bedeutung dieser beiden Größen gelten unverändert auch für die heutigen Verhältnisse. Nur mit ihnen ist auch das moderne Desaster „deutsche Energiewende“ verständlich. Dies wird im folgenden Abschnitt zuerst an Hand von Beispielen verdeutlicht.

3. Der entscheidende Begriff der Leistungsdichte

Der russische Eisbrecher Arktika wird von zwei kleinen Kernreaktoren an Bord mit einer Gesamtleistung von 55 MW angetrieben. Wollte man die Arktika mit Photovoltaik anstatt mit Uran betreiben, wären rechnerisch 5,5 Quadratkilometer Photovoltaik-Fläche erforderlich, die etwa 10 W Leistung pro m2 Solarpanelenfläche liefert. Mit Windstrom an Stelle von Uran wären 42 Windturbinen des Typs Enercon E 126 erforderlich, jede 198 m hoch und mit einer realen Leistung von 1,3 MW (den fiktiven Antrieben der Arktika liegen die deutschen Jahresmittelwerte von Wind- und Sonnenstrom zugrunde). Eine wind- oder sonnenbetriebene Arktika wäre zwar bei Flaute oder Wolkenbedeckung nicht fahrtüchtig, aber dies soll hier vorerst keine Rolle spielen. Die Frage nach den Gründen für den extrem hohen Aufwand der beiden „Erneuerbaren“ Wind und Sonne für den Antrieb der Arktika beantwortet die Leistungsdichte

Leistungsdichte = Leistung / Fläche (1) oder

Leistung = Leistungsdichte x Fläche (2)

Auf der linken Seite von Glg. (2) steht für alle drei Antriebsarten der Arktika der gleiche Wert von 55 MW. Die Faktoren der rechten Seite der Gleichung zeigen dagegen entscheidende Unterschiede zwischen Uran, Wind und Sonne. Kernreaktoren haben eine sehr hohe Leistungsdichte, sie bringen höchste Leistung auf minimaler Fläche. Man baut sie sogar seit Jahrzehnten in U-Boote ein. Sonne und Wind haben dagegen, naturgesetzlich bedingt, nur minimale Leistungsdichten. Entsprechend muss die Photovoltaik-Fläche beim Solarantrieb oder die von den Windradpropellern überstrichene Fläche beim Windradantrieb extrem groß sein, damit das Produkt in Glg. (2) noch die hier benötigten 55 MW ergibt. Die folgende Tabelle 1 zeigt Grobwerte von Leistungsdichten.

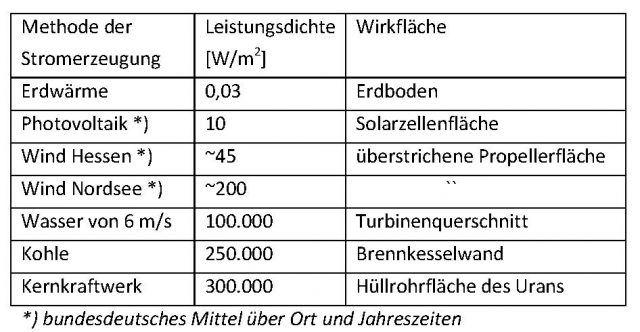

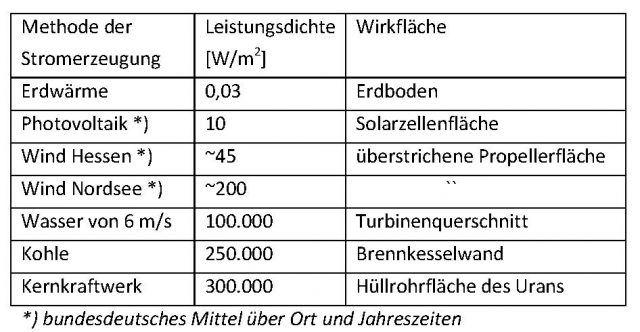

Tabelle 1: Leistungsdichten unterschiedlicher Methoden zur Erzeugung von elektrischem Strom, angegeben in W/m2 des Endprodukts „elektrische Energie“ unter Einbeziehung der jeweiligen Methoden-Wirkungsgrade.

Die in Tab. 1 zu erkennenden Unterschiede der Leitungsdichten von Wind, strömendem Wasser und Kohle sind unschwer anschaulich-verständlich: So kann man sich noch gegen einen Sturm von 20 m/s (72 km/h) Windgeschwindigkeit stemmen, dagegen in einen reißenden Wildfluss von weit weniger als 20 m/s Fließgeschwindigkeit zu geraten, endet oft tödlich. Auch der Unterschied zwischen der in unsere Haut eindringenden Leistung beim Sonnenbad auf der Wiese und der in ein Steak eindringenden Leistung auf einem glühenden Holzkohlengrill ist anschaulich. Letztere ist tausendfach höher als die auf der Schwimmbadwiese.

Der Schwachpunkt der mittelalterlichen Energieversorgung wird nun deutlich. Es handelt sich um Methoden kleinster Leistungsdichten, die mit riesigen, ertragsschwachen Ackerflächen und hohem Aufwand an menschlicher Arbeitskraft und Zugtieren einen bei günstigem Klima gerade noch ausreichenden Ertrag lieferten. Eine Windturbine, obwohl ausgestattet mit modernster Technik, ist wegen der minimalen Leistungsdichte des Windes dennoch nichts anderes als ein Rückschritt zu den mittelalterlichen Methoden der Windmühle und des Segelschiffs. Um strömender Luft ausreichend Energie zu entnehmen, benötigen Windräder riesige Propeller. Zu geringe Leistungsdichte des Windes ist der Grund für die Mammut-Ausmaße dieser Anlagen, wenn man davon absieht, dass Windgeschwindigkeiten mit zunehmender Höhe etwas ansteigen. Nicht umsonst haben unsere Vorfahren Segelschiffe zugunsten des Dampf- und späteren Dieselantriebs freudig aufgegeben.

Das hier betonte „naturgesetzlich“ bedeutet, dass wir auf die Leitungsdichten von Wind und Sonneneinstrahlung keinen Einfluss haben. Lediglich die Ernteerträge von Energiemais lassen sich mit moderner Genetik und Düngung geringfügig erhöhen. Die Natur selber setzt die Grenzen, auch beste Technik ist gegen zu geringe Leitungsdichten machtlos. Aus einer Pferdekutsche wird auch mit heutiger Computersteuerung und modernster Mechanik kein leistungsstarkes Motorfahrzeug. Erstaunlich erscheinen in Tabelle 1 die grob 10 W/m2 gemittelte Leistungsdichte aus Photovoltaik in Deutschland. Am oberen Rand der Erdatmosphäre kommen schließlich 1367 W/m2 an. Verantwortlich für den kleinen Wert am Boden ist vor allem der durch Wolken unterbrochene und bei Nacht völlig fehlende Strahlungsfluss. Hinzu kommt, dass die Wirkungsgrade kommerzieller, im realen Betrieb befindlicher Photovoltaik nur bei grob 10% liegen, weil die Oberflächen der meist fest installierten Solarpanelen nicht dauernd optimal auf die Sonne ausgerichtet sind, sie allmählich verschmutzen und der Wirkungsgrad von Photovoltaikzellen mit steigender Temperatur dramatisch abnimmt.

Neben der Leistungsdichte ist auch die Energiedichte als Energie pro Volumen oder pro Gewicht eine maßgebende Größe. Das Reichweiteproblem von Elektroautos wird mit ihr verständlich. Benzin hat nach Abzug der Wirkungsgradverluste eine Energiedichte von rund 4 kWh/kg, ein Lithium-Ionen-Akku dagegen von 0,18 kWh/kg. Ein Elektroauto muss daher grob das 4/0,18 = 22-fache Treibstoffgewicht eines Benzinautos mit sich führen. Da heute etwa 71% der Güter in Deutschland oft über weite Strecken und mit engen Zeitvorgaben auf der Straße transportiert werden, ist zumindest eine Umwandlung von LkW-Antrieben auf Strom unrealistisch. Hier sind nicht nur das zusätzlich zu transportierende Treibstoffgewicht in Form von Akkus sondern auch die langen Ladezeiten der Batterien die maßgeblichen Hinderungsgründe. Elektroautos sind nur für Innenstadt und Golfplatz sinnvoll.

4. Die entscheidenden Nachteile zu kleiner Leistungsdichte

Bei zu kleiner Leistungsdichte sind sehr große Wirkflächen der betreffenden Methoden erforderlich. Dementsprechend steigt der Aufwand an Energie, Material und Kosten bei Bau und Betrieb, denn diese Wirkflächen müssen mit Technik zugebaut werden. Die folgenden Daten der Großwindanlage Enercon E 126 liefern ein stellvertretendes Beispiel: 198 m Gesamthöhe, überstrichene Propellerfläche 12470 m2 = 1,247 ha, Gewicht 3460 t plus 3500 t Stahlbetonfundament. Drei E 126 haben somit das Gesamtgewicht aller 300 Leopard2 – Panzer von je 68 t der deutschen Bundeswehr. Trotz 7,5 MW Nennleistung liefert die E 126 im bundesdeutschen Orts- und Jahres-Mittel aber nur 1,3 MW elektrische Leistung. Dies entspricht grob 7 Automotoren von je 200 kW.

Neben der geringen Leistungsdichte des Windes gibt es weitere methodenspezifische Gründe für die erstaunlich geringe Leistungsausbeute aus Wind, die im Abschnitt 9. näher erläutert werden. Man müsste schon mehr als 100 km Windturbinen hintereinanderstellen, um die gleiche jahresgemittelte Leistung wie ein einziges großes Kohle- oder Kernkraftwerk zu erzielen. Zudem fluktuiert die aus Wind gewonnene Leistung, die von fossilen Kraftwerken ist dagegen konstant. Windturbinen, inzwischen höher als der Kölner Dom, erweisen sich wegen ihrer zu geringen Leistungsdichte und der sich daraus ergebenden gigantischen Abmessungen als extrem schädlich für die Umwelt. Landschaftsentstellungen, gesundheitliche Schädigung von Windrad-Anrainern durch Infraschall und das jährlich hunderttausendfache Töten von Greifvögeln, Störchen, Fledermäusen und Insekten sind zu nennen. Fledermäuse können zwar durch ihre Ultraschallortung den hohen Tangentialgeschwindigkeiten der Rotorblätter entkommen, die Luft-Druckstöße zerreißen ihnen aber die Lungen. Nicht thematisiert und daher der Öffentlichkeit völlig unbekannt sind die bei intensivem Einsatz von Windturbinen erzeugten schädlichen Klimaveränderungen der tiefen Atmosphäre (hier, hier). Die oft auf Hausdächern installierte Photovoltaik ist dagegen umweltneutral, sieht man von Umweltproblemen durch giftige Metalle (Cadmium) bei der Entsorgung von Solarzellen ab. Beim Energiemais gibt es das Problem der zerstörten Artenvielfalt auf Energiemaisfeldern (hier, hier). Zusammengefasst gilt die Regel:

Je kleiner die Leistungsdichte einer Methode zur Stromerzeugung ist, umso größer müssen die Wirkflächen der Methode sein und umso aufwendiger, kostspieliger und umweltbelastender ist die Methode.

Die historische Entwicklung der Technik belegen, dass technischer Fortschritt bei gleichzeitigem Umweltschutz nur mit immer größeren Leistungsdichten in Stromerzeugung, Produktion, Verkehr etc. zu erreichen war und immer noch ist. Die benötigte Energie für eine anwachsende Bevölkerung bei gleichzeitig zunehmendem Lebensstandard kann wirtschaftlich und umweltschonend nur mit den jeweils verfügbaren Methoden höchster Leistungsdichte bereitgestellt werden. „Erneuerbare“ sind für moderne Industrienationen ungeeignet, können aber vorübergehend in Ländern der Dritten Welt durchaus sinnvoll sein. Die größten Umweltschäden sind heute in Entwicklungsländern zu finden, die den Weg zu höheren Leistungsdichten noch nicht beschreiten können. Das oft in den Medien betonte „sanft“, mit dem „Erneuerbare“ als vorteilhaft und umweltschonend dargestellt werden sollen, stellt die Fakten komplett auf den Kopf. Es verhält sich genau umgekehrt:

Je „sanfter“ eine Methode zur Erzeugung von elektrischer Energie ist, umso kostspieliger und oft umweltschädlicher ist sie.

5. Der Erntefaktor als Maß für Energieeffizienz

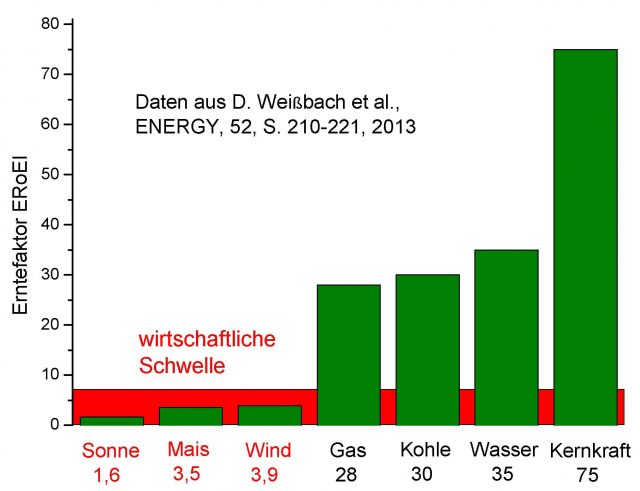

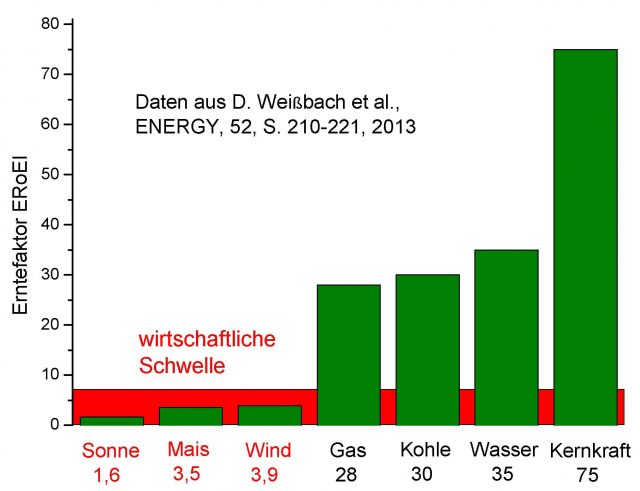

Der Erntefaktor, englisch ERoEI (Energy Returned to Energy Invested), quantifiziert die bisherigen Ausführungen. Vereinfacht ausgedrückt ist er das Verhältnis der gesamten, während der Lebenszeit einer Methode zur Stromerzeugung erzeugten elektrischen Energie zur derjenigen Energie, die für ihren Betrieb selber aufgewendet werden musste, inklusive des erforderlichen Energieaufwands, um die benötigen Brennstoffe zu fördern und bereitzustellen. Der ERoEI ist ein Energiemultiplikator. Man investiert eine Kilowattstunde und erhält ein Vielfaches zurück, natürlich nur bei ERoEI > 1, sonst wäre es ein Verlustgeschäft.

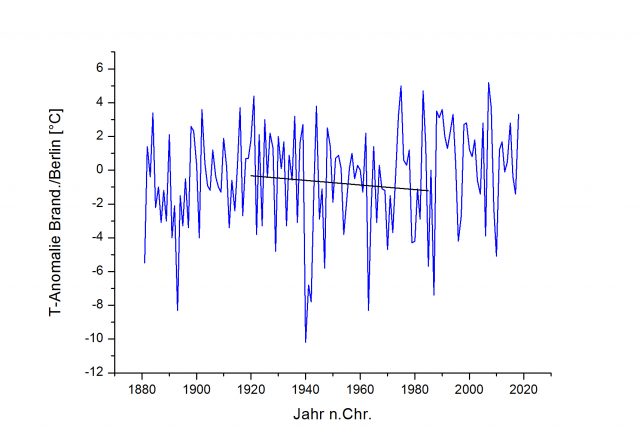

Im Jahre 2012 wurde über den ERoEI eine grundlegende Studie publiziert, auf die sich die Aussagen des vorliegenden Beitrags stützen. Neben der Bedingung ERoEI > 1 gibt es noch die Forderung ERoEI > 7, denn unterhalb von 7 ist eine Methode volkswirtschaftlich nicht mehr sinnvoll. Zur Begründung des Faktors 7 wird auf die Originalarbeit verwiesen. Das Bruttosozialprodukt sowie eine Energieverbrauchs-Technologie, wie die der OECD, gehen dort in die wissenschaftliche Herleitung ein. Bei der Berechnung des ERoEI für Wind- und Sonnenstrom wird auch der Energieaufwand zur Pufferung des fluktuierenden Zufallsstroms berücksichtigt, weil fluktuierender Strom zur direkten Einspeisung in ein Stromnetz ungeeignet ist. Auf diesen zweiten Fundamentalmangel der „Erneuerbaren“ Wind und Sonne wird in Abschnitt 9. eingegangen. Bild 2 zeigt den ERoEI für die wichtigsten Methoden zur Erzeugung von elektrischem Strom.

Bild 2: Erntefaktoren für Methoden der Stromerzeugung gepuffert, d.h. der Fluktuationsausgleich von Sonne und Wind ist berücksichtigt. Sonne, Energiemais (Biomasse) und Wind liegen unter der ökonomischen Schwelle von OECD-Ländern.

6. Leistungsdichte bezogen auf Landschaftsfläche

Zur Angabe einer Leistungsdichte gehört die Spezifizierung der Fläche. An Stelle der in Tabelle 1 in Abschnitt 3 für Leistungsdichten angegebene Wirkflächen sind Landschaftsflächen oft aussagekräftiger. Wählt man Landschaftsfläche, ändert sich bei der Photovoltaik nur wenig. Wenn sich Photovoltaik auf Hausdächern befindet, verbraucht sie sogar überhaupt keine Landschaftsfläche. Für Energiemais beträgt die Leistungsdichte, bezogen auf die Anbaufläche, grob 0,2 W/m2. Dieser kleine Wert lässt fragen, wie viel Anbaufläche rechnerisch benötigt würde, um ausschließlich mit Energiemais den gesamten Inlandsstrom Deutschlands (in 2016) zu erzeugen: Pro Quadratmeter beträgt die Jahresenergiedichte von Energiemais 0,2 W/m2 · 8760 h = 1752 Wh/m2. Der Inlandsstromverbrauch Deutschlands in 2016 betrug 593 TWh = 593 · 1012 Wh. Daher wären (593 · 1012 Wh)/(1752 Wh/m2) = 3,1 ·1011 m2 oder 310.000 km2 Anbaufläche für Vollversorgung nötig. Das ist fast die Gesamtfläche Deutschlands.

Für Windturbinen im deutschen Jahres- und Ortsschnitt und ihre Installation in Wind-„parks“ beträgt die Leistungsdichte bezogen auf Landschaftfläche etwa 1 W/m2. Sie ist daher sehr viel kleiner als bezogen auf die Propellerfläche (vergl. Tab. 1 unter Abschnitt 3), denn Windturbinen werden in der Regel nicht einzeln sondern in Ansammlungen aufgestellt. Hier müssen Mindestabstände eingehalten werden, um Leistungsminderungen durch gegenseitige strömungstechnische Beeinflussung zu vermeiden. Der Wert von 1,1 W/m2 wurde in einer internationalen Fachpublikation für ein Gebiet der USA ermittelt, dessen Windverhältnisse mit Deutschland vergleichbar sind. Er kann aber auch aus den verfügbaren deutschen Daten grob geschätzt werden: in 2016 waren in Deutschland 27.000 Windräder installiert, meist in Windparks mit Mindestabständen. Eine moderne Windturbine nimmt in Windparks etwa 0,3 km2 Bodenfläche in Anspruch. Damit ergibt sich die erzeugte Jahresenergie zu 27.000 · 0,3 · 106 m2 · 1 W/m2 · 8760 h = 71 TWh. Mit der erzeugten Inlandsstromenergie von etwa 80 TWh passt die Schätzung zum o.g. Wert von 1 W/m2. Mit Hilfe des bereits erhaltenen Resultats für Energiemais für Stromvollversorgung ist die zu Windrädern gehörige rechnerische Fläche dann nur noch mit 0,2 W/1 W = 1/5 zu multiplizieren. Dies entspricht etwa der Fläche Bayerns.

In diesem Zusammenhang ist von Interesse, wie weit ein zukünftiger Windradausbau überhaupt noch gesetzlich zulässig ist. Die entscheidende Größe ist hier der minimale zulässige Abstand eines Windrads zur nächsten Wohnsiedlung. Windräder erzeugen Infraschall, dessen gesundheitsschädigende Wirkung durch wissenschaftliche Untersuchungen belegt ist. Die heute gründlichste Studie über gesundheitsschädliche Auswirkungen von Infraschall auf den Menschen wurde in Zusammenarbeit der Charité Berlin mit der Physikalisch Technischen Bundesanstalt PTT Braunschweig und zwei Hamburger Universitätskliniken erstellt. Die Quellenangaben dieser Studie liefern überdies einen guten Überblick zum heutigen wissenschaftlichen Kenntnisstand.

Wegen Infraschall ist inzwischen in Bayern der Mindestabstand 10 H vorgeschrieben, das bedeutet die zehnfache Gesamthöhe des betreffenden Windrads. Aus der Grafik Abb. 12 auf S. 38 einer Studie des Bundesumweltamts geht hervor, dass bei 2000 m Mindestabstand (dies entspricht 10 H bei 200 m hohen Windrädern) nur noch maximal 0,4% der bundesdeutschen Bodenfläche für den weiteren Windradausbau nutzbar ist. Ausgeschlossene Sondergebiete sind dabei nicht berücksichtig, so dass sich der reale Wert noch etwas verringert. Der Ausbauplan der Bundesregierung für Windenergie erscheint daher unrealistisch.

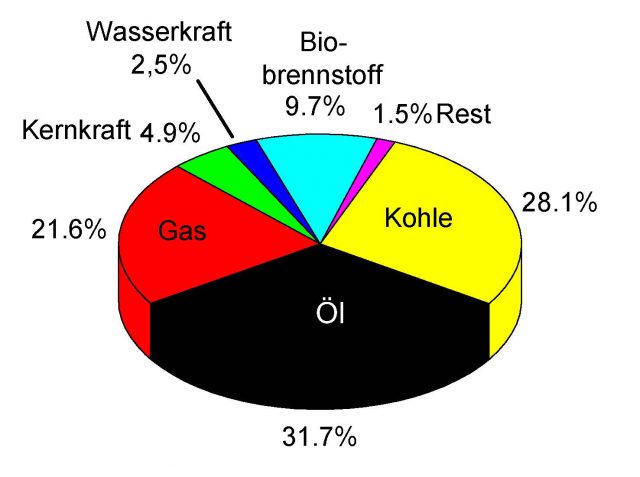

7. Die Fluktuation von Wind- und Sonnenstrom

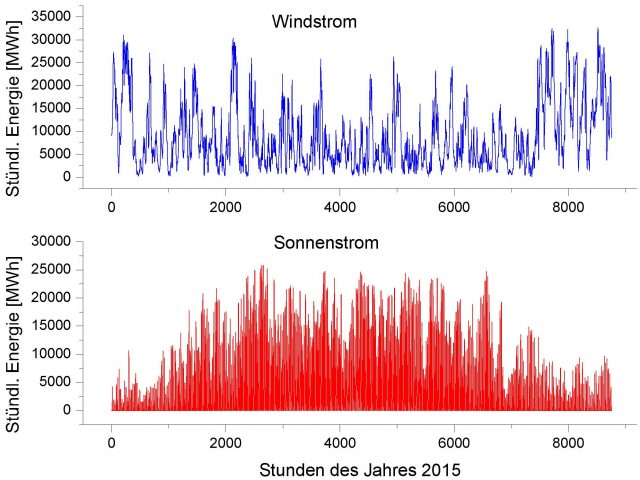

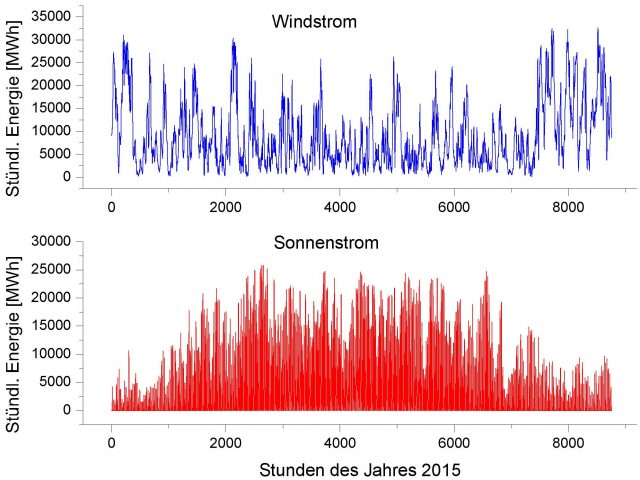

Der zweite Fundamentalmangel von Wind- und Sonnenstrom ist besser bekannt und wird bereits von den Medien thematisiert. Er ist seine Wetterabhängigkeit. Zufallsstrom kann ohne weitere Maßnahmen nicht in das Stromnetz eingespeist werden. Die gelegentlich geäußerte Annahme, dass ein europaweiter Windradverbund für Glättung sorgen würde, hat eine ausführliche VGB-Studie widerlegt. Das gemessene Minimum dieser Studie an geliefertem Windstrom beträgt nur 4% der europaweit installierten Windrad-Nennleistung. Wörtlich heißt es in der VGB-Studie: „Windenergie trägt damit praktisch nicht zur Versorgungssicherheit bei und erfordert 100 % planbare Backup-Systeme nach heutigem Stand der Technik.“

Diese Backup-Systeme sind heute schnell reagierende Gaskraftwerke (GuD). Diskussionswürdige Stromspeicherlösungen sind nicht in Sicht. Man muss daher für Wind- und Sonnenstrom ein gleichstarkes fossiles Backup-System installieren, welches die Gesamtkosten dieser „Erneuerbaren“ zumindest verdoppelt. Bild 3 zeigt die stündliche Einspeisung von Wind- und Sonnenstrom über das Jahr 2015.

Bild 3: Stündliche Einspeisung des gesamten bundesdeutschen Wind- und Sonnenstroms (Daten: R. Schuster, aus den Daten von EEX, Amprion, TenneT, 50Hertz, TransnetBW) im Jahre 2015.

Das Einspeiseproblem von Zufallsstrom wird von den Medien inzwischen als eine der dringendsten Probleme der Energiewende wahrgenommen. Die Soll-Netzfrequenz von 50 Hertz ist in engen Grenzen stabil zu halten, bereits bei Abweichungen von 0,2 Hertz besteht die Gefahr eines großflächigen Netz-Blackouts. So etwas war von den früheren Kohle-, Gas- und Kernkraftwerken mit ihrem stetigen Grundlaststrom unbekannt. Wetterabhängiger Zufallsstrom ist bis heute ohne Ersatzkraftwerke nicht in der Lage, den Strombedarf jederzeit zu decken.

Man benötigt also für Windräder und Photovoltaik noch einmal etwa die gleiche Leistung an fossilen Ersatz-Kraftwerken, denn schließlich ist die Lücke zu füllen, wenn Wind und Sonne fehlen. Grober Unfug dürfte für diese Notwendigkeit eine sehr freundliche Bezeichnung sein. Ersatzkraftwerke sind zudem infolge Teilbetriebs und hoher Lastwechselfrequenz schnellem Verschleiß unterworfen und wirtschaftlich unrentabel. Auf Profit angewiesene Unternehmen haben kein Interesse sie zu bauen. Wirtschaftliche Speichersysteme für Strom in Deutschland als Alternative für Backup-Kraftwerke sind nicht in Sicht. Pumpspeicherwerke als bislang einzige Lösung, wie sie zum Beispiel in Norwegen eingesetzt werden, sind hierzulande aus topo-geografischen Gründen nicht möglich, von Einzelanlagen abgesehen.

8. Photovoltaik in Ländern starker Insolation

Photovoltaik kleinster Einheiten in Entwicklungsländern mit hoher Insolation und fehlender Strom-Infrastruktur ist eine interessante und offenbar auch vielgenutzte Option. Hier reichen für eine Familie bereits wenige Quadratmeter Solarzellen und wenige Autobatterien als Stromspeicher aus, um den Fernseher zu betreiben, nachts elektrisch zu beleuchten und das SmartPhone aufzuladen. Betrachtet man dagegen die Stromgewinnung aus Photovoltaik- oder Sonnenspiegel-Großanlagen, ergibt sich ein anderes Bild. Trotz, verglichen mit Deutschland, etwa doppelter Insolation in afrikanischen Ländern, in Australien oder in den Südstaaten der USA konnte sich dort die Nutzung von Solarstrom nicht durchsetzen. Solarstrom hat, wie Bild 2 zeigt, den kleinsten Erntefaktor aller Verfahren.

Insbesondere von deutscher Seite wurden zahlreiche Solarstromprojekte in Ländern mit hoher Insolation angestoßen. In solche Projekte flossen zum Teil erhebliche Mittel, zwei stellvertretende Beispiele wurden in EIKE näher beschrieben (hier, hier). Ein langfristiger Erfolg irgendeines Großprojekts ist bislang nicht bekannt. Jeder Urlauber auf den kanarischen Inseln kann diese Fehlschläge durch eigene Beobachtung vervollständigen: Es gibt kaum eine Weltgegend, die besser als die kanarischen Inseln mit Wind und Sonne gesegnet ist. Dennoch haben sich selbst hier und trotz hoher finanzieller Anschub-Unterstützung Wind- und Sonnenenergie nicht durchsetzen können. Die Energienutzungs-Statistik von Marokko bestätigt das kanarische Beispiel. Der Grund für die Misserfolge liegt auf der Hand. Sieht man von den eingangs beschriebenen Vorteilen einer Nutzung in sehr kleinen Einheiten ab, verbessert sich in Großanlagen sonnenstarker Länder als einziges Kriterium nur die Insolation. Dieser Vorteil reicht aber bei weitem nicht aus, um die bereits geschilderten Nachteile der Photovoltaik, insbesondere ihre fehlende Stromlieferung in der Nacht, wieder wettzumachen.

9. Weitere Gründe für die unzureichende Leistung von Wind und Sonne

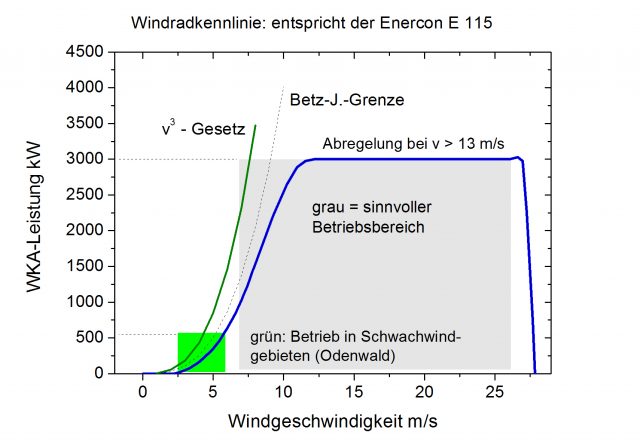

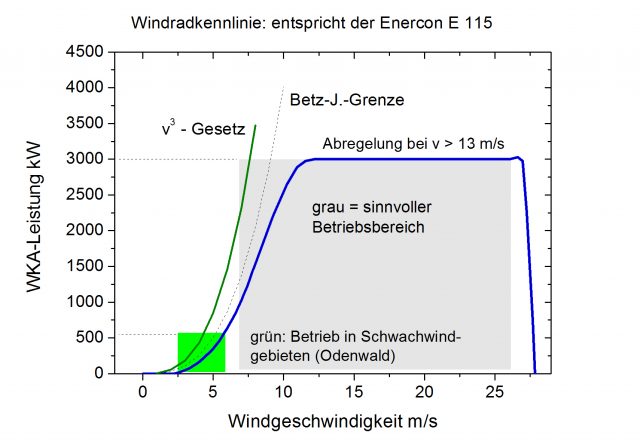

Die geringe Leistungsausbeute von Photovoltaik ist mit den Schwankungen sowie nächstens völligem Fehlen des solaren Strahlungsflusses und den sehr kleinen Wirkungsgraden von Photozellen um die 10% im Wesentlichen erklärt. Für Windräder muss dagegen neben der Windfluktuation auch noch die typische Kennlinie einer Windturbine (Bild 4) beachtet werden Erst damit ist die noch heftigere Schwankung der Stromleistung (Bild 3 oben), verglichen mit Sonnenstrom und die extrem ungünstige Leistungsernte von Windturbinen zu verstehen.

Alle Strömungsmaschinen unterliegen dem physikalischen Gesetz „Leistung gleich proportional zur dritten Potenz der Strömungsgeschwindigkeit“ (s. grüne Kurve in Bild 4). Gemäß diesem v3-Gesetz führt Verdoppelung der Windgeschwindigkeit zur Verachtfachung der Stromleistung, Halbierung aber umgekehrt zu ihrer Verringerung auf ein Achtel. Schwankungen von v wirken sich daher grob mit dritter Potenz verstärkt auf die Schwankungen der Windrad-Leistung aus. Die deutschen Windgeschwindigkeiten, im Binnenland etwa zwischen 0 bis etwa 6 m/s, sind für eine vernünftige Stromausbeute viel zu klein. Offshore und an Meeresküsten ist der Wind zwar wesentlich stärker, man muss aber schon ab etwa v = 8 m/s beginnen die Windrad-Leistung wegen zu großer mechanischer Belastung zu drosseln. Ab etwa v = 13 m/s muss ein Windrad auf die zulässige Maximalleistung (Nennleistung) begrenzt werden. Damit ist gerade der Bereich von sehr hohen Windgeschwindigkeiten nur stark gedrosselt nutzbar.

Bild 4: Beispiel einer Windradkennlinie (blau). Das v3 Gesetz und die Betz-Joukowsky-Grenze werden prinzipiell von einem Windrad nicht erreicht. Die mittleren Windgeschwindigkeiten an der Nordseeküste liegen bei 5,8 bis 5,9 m/s, für Offshore Nordsee um die 9 m/s. Selbst Offshore-Windgeschwindigkeiten lassen daher die Nutzung des sinnvollen Betriebsbereichs von Windturbinen (grau) nur eingeschränkt in dessen linken Randbereich zu.

10. Eine grundsätzliche Sicherheitsgrenze für Wetter-Fluktuationsstrom

Die bisher geschilderten technischen und wirtschaftlichen Begrenzungen für die „Erneuerbaren“ Wind und Sonne sind zwar prinzipiell keine unüberwindbaren Hürden für ihren weiteren Ausbau, falls man auf Kosten, Naturschutz, Landschaftsschutz und den Gesundheitsschutz von Windradanrainern (Infraschall) keine Rücksichten nimmt. Es existiert allerdings eine Grenze seitens der Netzsicherheit. Grund dafür sind schnelle Netzstörungen im Bereich von Sekundenbruchteilen bis zu wenigen Sekunden, etwa Netz-Abtrennungen durch den plötzlichen Ausfall eines großen Umspanntransformators o.ä., die zum Zusammenbruch des gesamten Netzes führen können.

Um die Auswirkungen dieser kurzfristigen Störungen auf die Stabilität des Netzes im zulässigen Bereich der Frequenzstabilität zu halten, muss ein ausreichend hoher Prozentsatz der elektrischen Gesamtleistung von Synchrongeneratoren mit großen Schwungmassen geliefert werden (Der Stromverbraucherschutz e.V. NEAB gibt als Faustformel permanente 45% an), d.s. die klassischen Dampfkraftwerken mit Kohle oder Uran. Leistungsungleichgewichte in Folge von Störungen werden hier durch Abbremsen, also Ausspeicherung kinetischer Energie bzw. Beschleunigen, also Einspeicherung kinetischer Energie der Schwungmassen verzögerungsfrei ausgeglichen. Auch eine Untersuchung der vier großen Netzbetreiber 50Hertz, Amprion, Tennet und TransnetBW geht auf diese Zusammenhänge ein.

Der erforderliche Anteil von Grundlastkraftwerken hängt von der aktuellen Netzstruktur und ferner davon ab, welches Blackout-Risiko man noch toleriert. Die vorgenannte Publikation gibt eine Mindestleistung von 20 GW für den Regelblock Deutschland an. Mit den momentan noch vorhandenen Grundlastkraftwerken wäre damit die erforderliche Sicherheit noch gegeben. Dies wird sich aber mit zunehmendem Windradausbau, dem gesetzlichen Abschalten weiterer Kernkraftwerke sowie durch die aktuell diskutierte Abschaltung von Kohlekraftwerken in Richtung größerer Instabilität und immer höherer Black-Out-Gefahr ändern.