Ich weiß, Einiges dieses Materials ist nicht neu, habe ich doch selbst etwas davon entdeckt. Allerdings ist es an der Zeit, alles noch einmal zusammenzustellen, weil immer mehr Menschen sich dessen bewusst werden, was da vor sich geht, und die jetzt am Schauplatz des Crashs sind.

Das IPCC und seine Befürworter zeichneten eine Karte, bauten die Straßen und gestalteten die Verkehrszeichen, aber sie gestalteten, bauten und fuhren auch das Auto. Sie haben keinen Crash eingeplant und alles getan, um ihr Ziel zu erreichen. Das Problem entstand infolge der Hypothesen, die sie aufgestellt hatten, und infolge der Manipulation der Daten, die sie brauchten, um das Ergebnis der Expedition vorwegzunehmen; ein Crash war unvermeidlich.

Welche Bedingungen haben sie als notwendig angesehen, um ihr Ziel zu erreichen? Es gibt zwei unterschiedliche Listen. Die erste ist eine Liste der Hypothesen, die für den wissenschaftlichen Teil der AGW-Hypothese aufgestellt worden sind. Die zweite ist eine Liste mit Ausgangsbedingungen, die für den politischen Teil der AGW-Objektive gebraucht wurden.

Wissenschaftliche Hypothesen

1. CO2 ist ein Gas mit effektiv lediglich Einbahnstraßen-Eigenschaften, das es dem Sonnenlicht erlaubt, in die Erde einzudringen, dann aber verhindert, dass die Strahlung wieder entweicht.

2. Falls der atmosphärische CO2-Gehalt steigt, wird die globale Temperatur steigen.

3. Der atmosphärische CO2-Gehalt wird zunehmen, weil die Menschen jedes Jahr mehr CO2 freisetzen.

Politische Hypothesen

1. Die globalen Temperaturen sind die höchsten jemals.

2. Die globalen Temperaturen stiegen entsprechend dem Beginn der Industriellen Revolution

3. Das CO2-Niveau ist das höchste jemals.

4. Das CO2-Niveau lag vor der industriellen Revolution viel niedriger.

5. Das CO2-Niveau steigt weiterhin mit einer stetigen Rate infolge des jährlichen Beitrags der Menschen.

Datenquellen

Die wesentlichen Objektiven mussten mit einem niedrigen vorindustriellen Niveau atmosphärischen CO2′ beginnen und während der letzten 150 Jahre stetig ansteigen. Unter den Datenquellen waren Folgende:

1. Luftbläschen aus Eisbohrkernen, aber primär nur aus der Antarktis

2. Pflanzen-Stomata in Blättern, durch die die Pflanzen Gase mit der Atmosphäre austauschen. Deren Anzahl variiert mit dem atmosphärischen CO2-Gehalt.

3. Etwa 90.000 instrumentelle Messungen aus dem 19. Jahrhundert. Die Messungen begannen 1812 als die Wissenschaft die Chemie der Atmosphäre bestimmte.

4. Neuzeitliche instrumentelle Messungen konzentrierten sich primär auf den Mauna Loa, die im Jahre 1958 begannen als Teil des Internationalen Geophysikalischen Jahres.

5. Der jüngst gestartete NASA-Satellit Orbiting Carbon Observatory OCO2 mit den ersten veröffentlichten Daten der CO2-Konzentration vom 1. Oktober bis zum 11. November 2014.

6. IPCC-Schätzungen der menschlichen Erzeugung von CO2, derzeit bekannt unter der Bezeichnung Representative Concentration Pathways (RCP).

Die erste Frage lautet, was die nicht menschlichen Quellen und Senken von CO2 sind. Die Antwort lautet, wir wissen es nicht. Alles was wir haben sind sehr grobe Schätzungen von einigen davon, aber keine aktuellen brauchbaren Messungen. Man erinnere sich, was das IPCC in Box 2.1 Uncertainty in Observational Records sagte:

Unter den Unsicherheiten gemessener Aufzeichnungen sind Messfehler, Effekte der Repräsentation (z. B. Darstellung, Beobachtungshäufigkeit oder Timing), ebenso wie Effekte aufgrund physikalischer Änderungen der Instrumentation (Stationsverlagerungen oder neue Satelliten). Alle weiteren Schritte (Übertragung, Speicherung, Interpolation, Mittelbildung, Gridding) haben ebenfalls ihre eigenen speziellen Unsicherheiten. Weil es keinen einheitlichen und überzeugenden Weg gibt, den nicht-klimatischen Artefakten (sic) in der großen Mehrheit der Aufzeichnungen Rechnung zu tragen, muss es einen Grad der Unsicherheit geben hinsichtlich der Frage, wie sich das Klimasystem verändert hat.

Es ist wichtig festzuhalten, dass sie eine Ausnahme identifizieren, weil diese wichtig ist für ihr Narrativ, aber auch für die Nachbildung des IPCC-Wracks:

Die einzige Ausnahme hiervon sind bestimmte Messungen der atmosphärischen Zusammensetzung und der Flüsse, deren Messungen und Unsicherheiten fest verbunden sind mit einer ununterbrochenen Kette von international anerkannten absoluten Mess-Standards (z. B. die CO2-Messung am Mauna Loa; Keeling et al., 1976a)

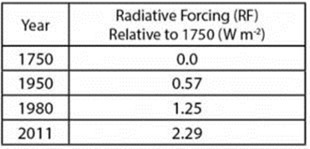

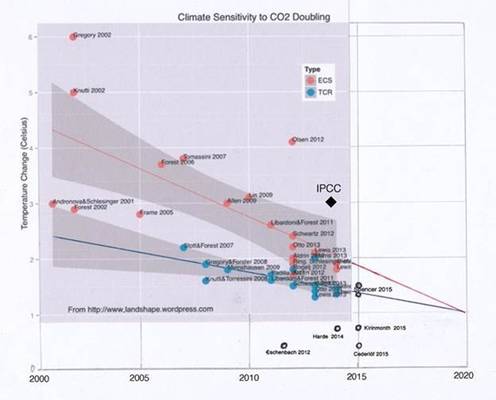

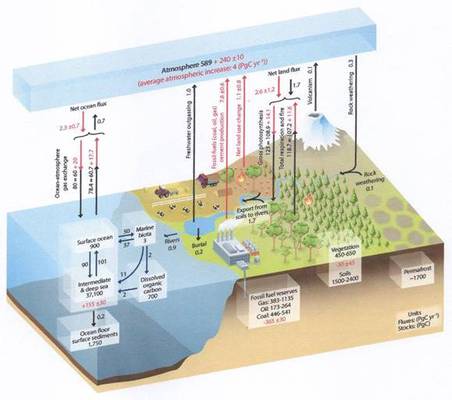

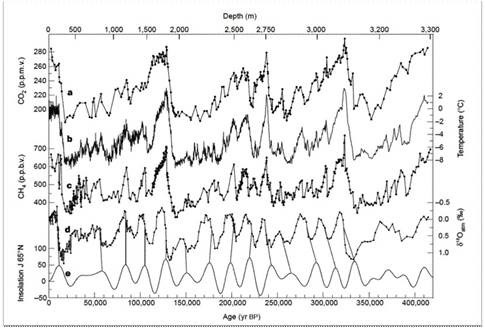

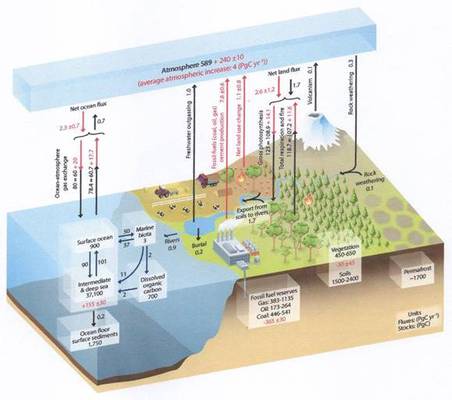

Das IPCC erstellt dann ein bizarres und verwirrendes Diagramm (Abbildung 1, im Original Abbildung 6.1), in dem es eher um das zugrunde liegende Szenario für ihr Narrativ geht als um eine Klarstellung oder Erläuterung:

Abbildung 1

Normalerweise füge ich nicht die Legende einer Graphik oder eines Diagramms bei, aber in diesem Falle ist sie sehr informativ. Nicht, dass sie der Klarstellung dient, sondern weil sie illustriert, wie wenig man weiß und wie wichtig es ist, die menschliche CO2-Erzeugung während der Industriellen Revolution in den Mittelpunkt zu stellen. Dies kommt nicht überraschend, ist dies doch die Definition des Klimawandels, festgelegt in Artikel 1 des UNFCCC. Falls man so vorgeht, ist ein Crash unvermeidlich:

Abbildung 6.1: Vereinfachtes Schema des globalen Kohlenstoff-Kreislaufes. Die Zahlen repräsentieren die Menge im Reservoir, auch ,Kohlenstoff-Speicher‘ in PgC (1 PgC = 1015 gC) sowie jährliche Kohlenstoff-Austausch-Flüsse (in PgC pro Jahr). Schwarze Zahlen und Pfeile stehen für die Menge im Reservoir und Austausch-Flüsse, geschätzt für die Zeit vor der Industriellen Ära, etwa um das Jahr 1750. Die Reserven fossiler Treibstoffe stammen aus GEA (2006) und sind konsistent mit Zahlen der WG III des IPCC für zukünftige Szenarien. Die Sediment-Speicherung ist eine Summe von 150 PgC des organischen Kohlenstoffes in der Grenzschicht [mixed layer] (Emerson und Hedges 1988) sowie von 1600 PgC der verfügbaren CaCO3-Sedimente in der Tiefsee, um das CO2 aus fossilen Treibstoffen zu neutralisieren (Archer et al. 1998). Rote Pfeile und Zahlen zeigen jährliche ,anthropogene‘ Flüsse, gemittelt über den Zeitraum 2000 bis 2009. Diese Flüsse durchdringen den Kohlenstoff-Kreislauf während der industriellen Ära nach 1750. Diese Flüsse (rote Pfeile) sind: CO2-Emissionen aus fossilen Treibstoffen und der Zement-Herstellung, Gesamt-Änderung der Landnutzung, und die mittlere atmosphärische Zunahme von CO2, auch CO2-Wachstumsrate genannt. Die Aufnahme anthropogenen CO2′ durch Ozeane und terrestrische Ökosysteme, oftmals ,Kohlenstoff-Senken‘ genannt, sind der Anteil der roten Pfeile des Gesamten Festland-Flusses und des gesamten Ozean-Flusses. Die roten Zahlen in den Reservoiren zeigen kumulative Änderungen anthropogenen Kohlenstoffes während der Industriellen Periode (1750 bis 2011). Per Konvention bedeutet eine positive kumulative Änderung, dass ein Reservoir seit 1750 Kohlenstoff aufgenommen hat. Die kumulative Änderung anthropogenen Kohlenstoffes im terrestrischen Reservoir ist die Summe des kumulativ verloren gegangenen Kohlenstoffes durch Änderungen des Landverbrauchs und des akkumulierten Kohlenstoffes seit 1750 in anderen Ökosystemen. Man beachte, dass die Massenbilanz der beiden ozeanischen Kohlenstoffspeicher an der Oberfläche, den mittleren Tiefen und der Tiefsee eine jährliche Akkumulation anthropogenen Kohlenstoffes enthält (nicht gezeigt). Unsicherheiten werden in 90%-Vertrauens-Intervallen angegeben. Emissionsschätzungen sowie Festlands- und Ozean-Senken (rot) stammen aus einem späteren Abschnitt. Die Änderung der großen terrestrischen Flüsse (rote Pfeile der Photosynthese) wurden aus CMIP5-Modellergebnissen geschätzt. Die Änderung der Austauschflüsse zwischen Luft und Meer (rote Pfeile des Ozean-Atmosphäre-Gasaustausches) wurden geschätzt aus der Differenz des atmosphärischen Partialdrucks seit 1750 (Sarmiento und Gruber 2006). Individuelle Gesamtflüsse und deren Änderungen seit Beginn der Industriellen Ära weisen typische Unsicherheiten von über 20% auf, während deren Differenzen (Gesamt-Festlands- und Gesamt Ozean-Fluss in der Abbildung) aus unabhängigen Messungen mit einer viel höheren Genauigkeit bestimmt wurden. Um eine Alles-in-Allem-Bilanz zu erstellen, wurden daher die Werte der unsichereren Gesamtflüsse adjustiert, so dass deren Differenzen passen zu den Schätzungen des Gesamt-Festlands- und des Gesamt-Ozean-Flusses. Flüsse durch vulkanische Eruptionen, Verwitterung von Felsen (was zu einer geringen CO2-Aufnahme aus der Atmosphäre führt), der Transfer von Kohlenstoff aus der Erde in Flüssen zum Ozean werden alle als präindustrielle Flüsse vermutet, das heißt sie sind von 1750 bis 2011 unverändert. Einige Studien aus jüngerer Zeit zeigen, dass diese Hypothese wahrscheinlich nicht verifiziert ist, aber globale Schätzungen der Durchdringung all dieser Flüsse während der Industriellen Ära waren aus der begutachteten Literatur nicht verfügbar. Der atmosphärische Vorrat wurde berechnet mittels eines Konversionsfaktors von 2,12 PgC pro ppm (Prather et al. 2012)

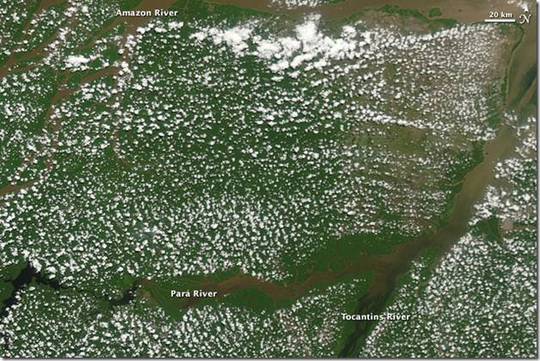

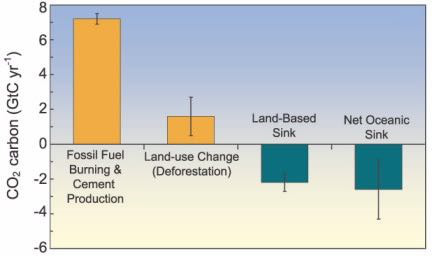

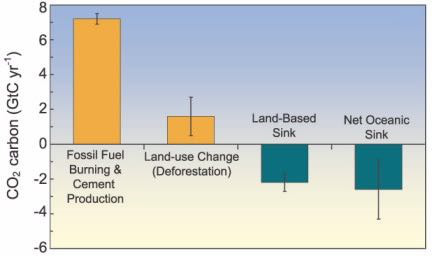

Dies ist vermutlich eines der bemerkenswertesten Beispiele wissenschaftlicher Verschleierung in der Geschichte. Jede Zahl ist eine grobe Schätzung. Der Kommentar sagt, dass wir überhaupt nichts wissen, uns aber völlig sicher sind hinsichtlich der menschlichen CO2-Erzeugung während der industriellen Ära. Meines Wissens nach gibt es keinerlei systematische, umfassende Messungen von CO2-Austausch mit den meisten Landschaftsformen, bedeckt von verschiedenen Wäldern, aber vor allem Grasland. Das Grasland illustriert das Problem, weil – abhängig von der Definition – die Ausdehnung variiert zwischen 15 und 40 Prozent. Der wichtige Punkt hier ist, dass wir kaum Ahnung haben über Volumina oder der Art der Änderung mit der Zeit. Eine Gruppe, die das vermeintlich wissen müsste, die American Chemical Society, bestätigt diesen Punkt. Natürlich wissen wir, wie professionelle Gesellschaften auf die Linie des IPCC getrimmt worden sind. In einem Artikel unter der Überschrift [übersetzt] „Treibhausgas-Quellen und _Senken“ (Greenhouse Gas Sources and Sinks) präsentieren sie ein Diagramm des IPCC (Abbildung 2):

Abbildung 2

Der Text der American Chemical Society, der vermeintlich um die atmosphärische Chemie weiß, sagt:

Die in diesen kurzen Zusammenfassungen genannten Quellen der Gase sind die Wichtigsten, aber es gibt auch andere Quellen geringerer Bedeutung. Die Details der Senken, durch welche die Gase aus der Atmosphäre entfernt werden, sind nicht enthalten. Die Graphik für jedes Gas (oder Gas-Klasse) stammt aus Abbildung 1, FAQ 7.1, IPCC, AR 4 (2007), Kapitel 7. Menschliche Quellen werden in orange und natürliche Quellen und Senken in blaugrün gezeigt. Die Einheiten sind Gramm (g) oder metrische Tonnen. Vielfache hiervon in den Abbildungen sind: Gt (gigatonne) = 109 t = 1015 g; Tg (teragram) = 1012 g = 106 t; and Gg (gigagram) = 109 g = 103 t.

Als eine professionelle Gesellschaft sollten sie wissen, dass über Gase in der Atmosphäre nichts bekannt ist, und doch stützen sie die IPCC-Illusionen als Fakten. Es gibt kaum Hinweise auf Schwächen oder Warnungen der wissenschaftlichen Grenzen, die sogar das IPCC selbst benennt – in Kasten 2.1.

Erzeugung einer geglätteten CO2-Kurve

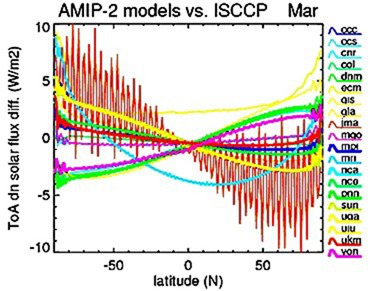

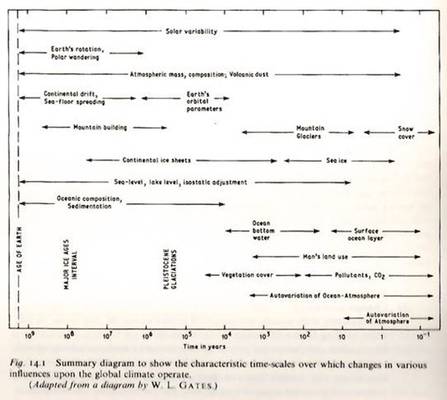

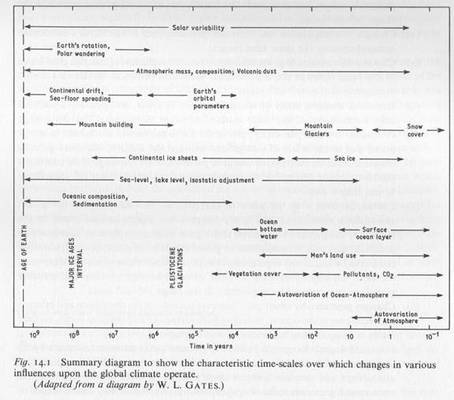

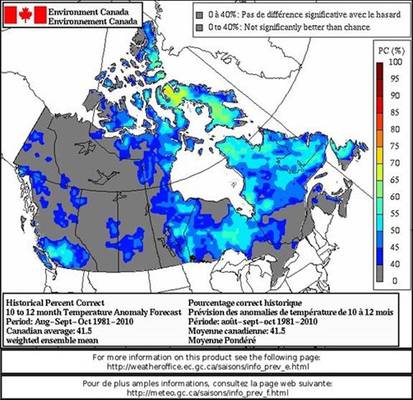

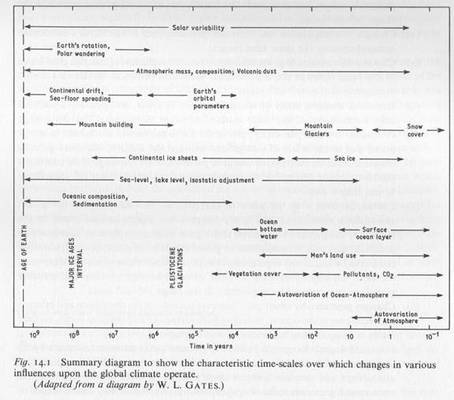

Ein grundlegender Fehler beim ,Hockeyschläger‘ ist es, eine Baumring-Aufzeichnung, den Stiel, mit einer instrumentellen Temperaturaufzeichnung, dem Blatt, zu verbinden. Dies wurde getan, weil die Baumring-Aufzeichnung abnehmende Temperaturen zeigte, was deren Hypothese und ihrer politischen Agenda widersprach. Ironischerweise ist es eine wesentliche Herausforderung in der Klimatologie, eine kontinuierliche Aufzeichnung zu erzeugen mit Daten aus verschiedenen Quellen. H. H. Lamb widmet den ersten Teil seines epischen Werkes Climate, Present, Past and Future (1977) diesen Problemen. Auch zeigt er eine Graphik mit der Länge der möglichen Klima-Zeitreihen und dem Überlappungs-Problem (Abbildung 3). Da gibt es drei Gebiete: instrumental oder säkular, die Historie sowie Biologie und Geologie.

Abbildung 3

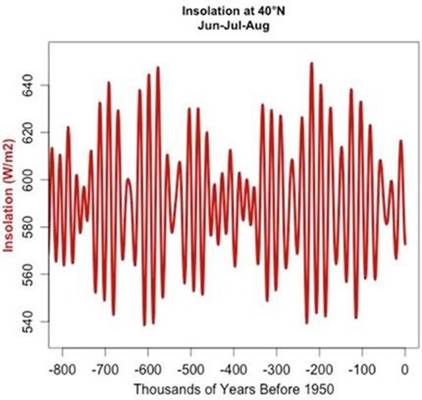

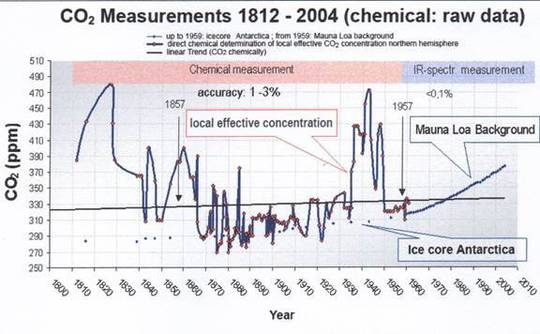

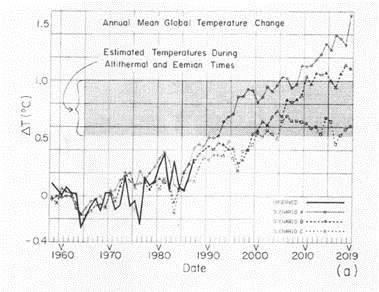

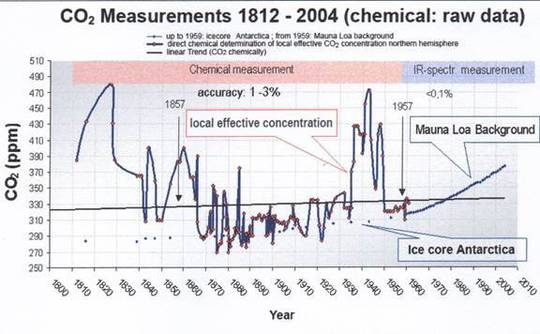

Daten aus verschiedenen Quellen müssen zueinander passen, um vom vorindustriellen Niveau bis heute die kontinuierliche geglättete Kurve von CO2 zu erzeugen. Dies involvierte drei Datensätze: Eisbohrkerne, instrumentelle Messungen aus dem 19. Jahrhundert und die Aufzeichnung vom Mauna Loa. Abbildung 4 zeigt die Rekonstruktion aus diesen drei Quellen von Ernst-Georg Beck. Falls man die Daten aus dem 19. Jahrhundert entfernt, zeigt sich ein weiteres Beispiel eines ,Hockeyschlägers‘. Die Daten aus den Eisbohrkernen sind der Griff aus einer einzigen Quelle, einem Bohrkern aus der Antarktis. Das Blatt ist die Instrumenten-Aufzeichnung vom Mauna Loa. Die Arbeitsgruppe 1 zum IPCC-Bericht 2001 schreibt dazu:

Die CO2-Konzentration in der Atmosphäre stieg von etwa 280 ppm im Jahre 1880 zunächst langsam, dann immer schneller auf den Wert von 367 ppm im Jahre 1999. Dies spiegelt das Tempo der landwirtschaftlichen und industriellen Entwicklung. Dies ist bekannt aus zahlreichen, gut nachgebildeten Messungen der Zusammensetzung von Luftbläschen im antarktischen Eis. Atmosphärische CO2-Konzentrationen wurden seit 1957 mit hoher Präzision direkt gemessen. Diese Messungen stimmen mit den Ergebnissen aus den Eisbohrkernen überein und zeigen einen fortgesetzten zunehmenden Trend bis zur Gegenwart.

Diese Messungen sind nicht gut erfasst und haben viele ernste Begrenzungen. Darunter sind:

1. Es dauert Jahre, bis ein solches Bläschen im Eis gefangen ist. Welches Jahr repräsentiert das Bläschen?

2. Mit dem dicker werdenden Eis wird es unmöglich, die Schichten zu bestimmen, und daher die Datierung der jeweiligen Sequenz schwieriger. Einige sagen, dass man bei einer Tiefe von 2000 m im Eis 245 cm Eis braucht, um eine einzige Stichprobe zu erhalten, aber unter dem Druck und dem Vermischen kann ein einzelnes Bläschen mehrere tausend Jahre repräsentieren.

3. Schmelzwasser an der Oberfläche, welches sich in jedem Sommer bildet, dringt in das Eis ein und verunreinigt die Bläschen. Zbigniew Jaworowski sagte in seiner Anhörung vor dem US-Senat:

Über 20 physikalisch-chemische Prozesse, meistens in Verbindung mit flüssigem Wasser, tragen zur Veränderung der ursprünglichen chemischen Zusammensetzung der Lufteinschlüsse im polaren Eis bei.

4. Einer Studie von Christner (2002) mit dem Titel [übersetzt] Auffinden, Isolierung und Charakterisierung von Bakterien in Gletschereis und dem Eiswachstum im Wostok-See. Zufolge setzen gefundene Bakterien selbst noch in 500.000 Jahre altem Eis Gase frei.

Abbildung 4

Eine Rekonstruktion dieser Teile des Crashs enthüllt, wie dieser erreicht wurde.

Prof. Zbigniew Jaworowski wurde wüst beschimpft während seiner letzten Lebensjahre wegen seinen Ansichten zu Klimawandel und Eisbohrkern-Daten. Wie bei allen, die derartig attackiert werden und wurden, ist dies ein sicheres Anzeichen, dass sie die vorsätzlichen Täuschungen der politischen Agenda der globalen Erwärmung bloß stellen. Hier folgen Auszüge aus Jaworowskis Karriere, die seine Präsentation vor dem US-Komitee für Handel, Wissenschaft und Transportwesen begleiteten:

Ich bin Professor am Central Laboratory for Radiological Protection (CLOR) in Warschau, einer Regierungs-Institution, die sich mit Umweltstudien befasst. CLOR hat eine „spezielle Verbindung“ mit dem US National Council on Radiological Protection and Measurements (NCRP). Einst kooperierte das CLOR etwa zehn Jahre lang sehr eng mit der EPA in den USA bei Forschungen bzgl. des Einflusses von Industrie und atomaren Explosionen auf die Verschmutzung der globalen Umwelt und der Bevölkerung. Ich habe etwa 280 wissenschaftliche Studien veröffentlicht, darunter 20, die sich mit klimatischen Problemen befassen. Ich bin Repräsentant von Polen im United Nations Scientific Committee on the Effects of Atomic Radiation (UNSCEAR),und von 1980 bis 1982 war ich der Vorsitzende dieses Komitees.

Während der letzten 40 Jahre war ich in Gletscherstudien involviert, wobei ich Schnee und Eis als Matrix benutzt habe, um die Historie der vom Menschen verursachten Verschmutzung der globalen Atmosphäre zu rekonstruieren. Ein Teil dieser Studien befasste sich mit Klimathemen. Eisbohrkerne und die Auswertung derselben wurden verbreitet als Beweis angeführt, dass infolge der menschlichen Aktivitäten das gegenwärtige CO2-Niveau der Atmosphäre etwa 25% höher ist als in der vorindustriellen Periode. Diese Aufzeichnungen wurden zu den grundlegenden Eingangs-Parametern in die Modelle des globalen Kohlenstoff-Kreislaufes und ein Eckpfeiler der Hypothese von der vom Menschen verursachten klimatischen Erwärmung. Diese Aufzeichnungen repräsentieren nicht die atmosphärische Realität, wie ich im Folgenden belegen möchte.

Niemand war qualifizierter, etwas zu den Aufzeichnungen aus Eisbohrkernen etwas zu sagen, und hier folgt das, was er vor dem Komitee sagte:

Die Grundlage der meisten IPCC-Schlussfolgerungen zu anthropogenen Gründen und zu Projektionen des Klimawandels ist die Hypothese eines niedrigen Niveaus von CO2 in der vorindustriellen Atmosphäre. Diese Hypothese ist auf der Grundlage glaziologischer Studien falsch“.

Genauso wichtig ist Jaworowskis Aussage:

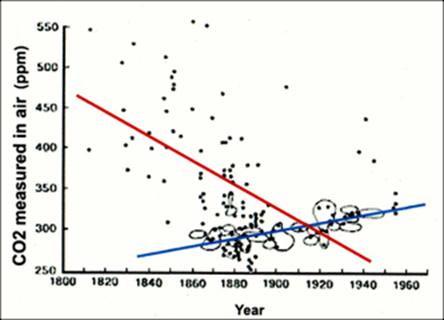

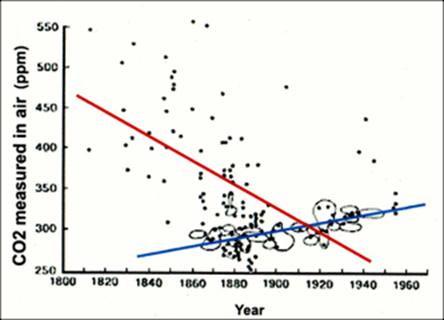

Die Vorstellung eines geringen vorindustriellen CO2-Niveaus in der Atmosphäre auf der Grundlage so geringen Wissens wurde zu einem weithin akzeptierten Heiligen Gral der Klimaerwärmungs-Modelle. Die Modellierer ignorierten die Beweise aus direkten Messungen von CO2 in der Luft, die zeigen, dass dessen mittlere Konzentration im 19. Jahrhundert 335 ppmv betragen hatte (Abbildung 2).Die eingekreisten Werte in Abbildung 2 zeigen eine verzerrte Auswahl von Daten um zu zeigen, dass das CO2-Niveau im 19. Jahrhundert nur 292 ppmv betragen hatte. Eine Untersuchung von Stomata-Häufigkeiten in fossilem Laub aus Ablagerungen in einem holozänen See in Dänemark zeigen, dass das atmosphärische CO2-Niveau vor 9400 Jahren 333 ppmv betragen hatte und vor 9600 Jahren 348 ppmv. Dies falsifiziert das Konzept einer stabilen und geringen CO2-Konzentration bis zum Aufkommen der industriellen Revolution.

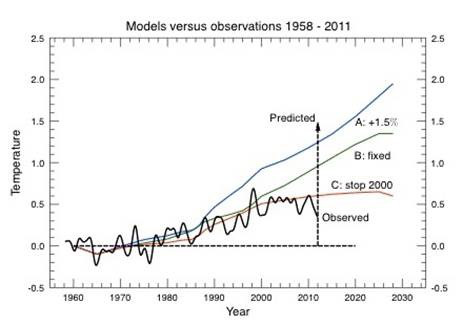

Abbildung 5 zeigt die Beweise aus den Stomata bzgl. des CO2-Niveaus im Vergleich mit den Daten aus Eisbohrkernen, auf die sich Jaworowski bezieht:

Abbildung 5

Unabhängig vom alles in allem höheren Mittel beachte man den glatten Verlauf der Eisbohrkern-Kurve, der in Teilen erreicht wurde durch ein Glättungs-Mittelwert über 70 Jahre. Bei diesem Verfahren gehen große Mengen an Informationen verloren, vor allem hinsichtlich der Variabilität, wie die Aufzeichnungen aus den Stomata zeigen.

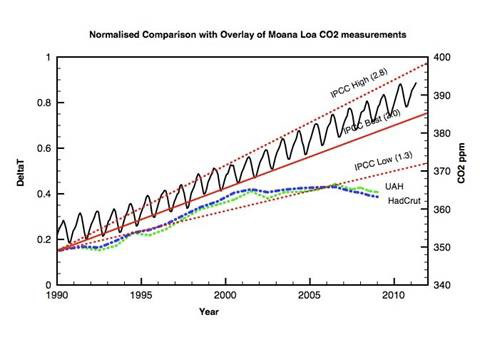

Die andere Referenz Jaworowskis ist eine Graphik (Abbildung 6), die erstellt worden ist durch den Ingenieur bei British Steam Guy Stewart Callendar, der auch ein früher Unterstützer von AGW war.

Abbildung 6 (Trendlinien hinzugefügt vom Autor).

Die Punkte repräsentieren die Messungen des atmosphärischen CO2′ während des 19.Jahrhunderts durch Wissenschaftler mittels rigider Verfahren und gut dokumentierter Instrumentation. Die Objektive der Messungen, begonnen im Jahre 1812, hatte nichts mit Klima zu tun. Vielmehr wollte man die einzelnen Gase der Atmosphäre bestimmen. Damit wurde die Arbeit von Joseph Priestly fortgesetzt, der – obgleich nicht der Erste, der den Sauerstoff entdeckt hatte – der Erste mit veröffentlichten Studien war (1774): Abbildung 6 zeigt die Testmengen, die Callendar ausgewählt hatte (cherry picked), um sein geringes vorindustrielles CO2-Niveau zu behaupten. Was genauso bedeutend ist: Er änderte die Neigung von einem abnehmenden hin zu einem zunehmenden Trend. Abbildung 4 zeigt die gleichen Daten des 19. Jahrhunderts im Vergleich zum Eisbohrkern und den Verläufen am Mauna Loa.

Vorbehalt: Ernst-Georg Beck übermittelte mir seine vorläufigen Arbeiten bzgl. der Daten, und wir haben oft darüber kommuniziert bis zu seinem viel zu frühen Ableben. Ich warnte ihn vor den Angriffen, die dann noch weit über das hinausgingen, was er erwartet hatte. Die Angriffe gehen immer noch weiter, obwohl seine Arbeit akribisch von seinem Freund Edgar Gärtner bei seiner Beerdigung erklärt wurde:

Aufgrund seines immensen Fachwissens und seiner methodischen Strenge fielen Ernst sehr frühzeitig zahlreiche Ungereimtheiten in den Aussagen des „Weltklimarates" IPCC auf. [Originalzitat, da Tim Ball den Link {hier} genannt hat. Keine Rückübersetzung! Anm. d. Übers.]

Das Problem bei der Arbeit von Beck war, dass darin identifiziert wurde, warum Callendar so mit den Daten umgegangen ist, wie er es getan hatte. In der Klima-Gemeinschaft wurde die Bedrohung erkannt und in einer Studie im Jahre 1983 behandelt mit dem Titel „The pre-industrial carbon dioxide level” von Tom Wigley, damals Direktor der CRU. Ich erinnere mich daran, weil ich zu der Zeit Seminare abgehalten hatte zur Bedeutung der Studie.

Die Kritik an den Aufzeichnungen aus dem 19.Jahrhundert wurde in einem einzigen Kommentar zusammengefasst: sie waren Zufall. Ja, in den meisten Studien ist das zufällige Herausgreifen von Stichproben wünschenswerter und repräsentativer hinsichtlich der Realität als willkürlich vorbestimmte Stichproben, von denen man weiß, dass sie das Narrativ stützen, wie es gegenwärtig der Fall ist. Das funktioniert nur unter der Annahme, dass das Gas gut durchmischt ist. Eine Kritik lautet, dass Becks Aufzeichnungen ein hohes Niveau um das Jahr 1942 zeigen im Vergleich mit der Aufzeichnung aus der Antarktis. Der Grund hierfür war wahrscheinlich, dass CO2 nicht gut durchmischt ist, wie es OCO2 und andere Aufzeichnungen zeigen; und auch, dass die meisten dieser Aufzeichnungen in Europa während des Krieges erfolgten. Nebenbei, mit der Periode von 70 Jahren, die es dauert, ein Gasbläschen im antarktischen Eis einzuschließen, würde sich dieses Bläschen erst im Jahre 2012 zeigen. Die Wahrheit ist, dass es keine anderen genauen Messungen von CO2 im Jahre 1942 gibt als die von Beck Verwendeten.

Eine andere Kritik lautet, dass die Stellen einschließlich der Höhe, in der die Messungen durchgeführt worden sind, deutlich variierten. Natürlich ist das genau der Punkt. Sie wurden nicht verengt und manipuliert wie die gegenwärtigen Aufzeichnungen vom Mauna Loa und Ähnlichem. Darum stellen sie nur Messungen an einigen wenigen Punkten dar, die essentiell alle natürlichen Einflüsse eliminieren. Dies ist offensichtlich aus den vorläufigen OCO2, den Stomata und Becks Aufzeichnung, in denen die große Variabilität von Tag zu Tag und von Region zu Region die Norm ist. Weitere Beweise dafür, dass dies die Norm ist: sie haben versucht, all diese natürliche Variabilität aus den Eisbohrkernen und den Mauna-Loa-Messungen zu eliminieren. Wenn die langwellige Ausstrahlung die Oberfläche verlässt, muss sie die gesamte Atmosphäre durchlaufen. Der CO2-Effekt ist überall vorhanden, nicht nur an bestimmten Stellen einer engen Auswahl in bestimmten Höhen wie die Mauna-Loa-Messungen. Beck schreibt dazu:

Die Mauna-Loa-Messungen repräsentieren nicht das typische atmosphärische CO2 an verschiedenen globalen Stellen, sondern sind typisch ausschließlich für diesen Vulkan an einer maritimen Stelle in einer Höhe von etwa 4000 m ü. NN auf jenem Breitengrad.

Charles Keeling stattete die Station am Mauna Loa mit von ihm patentierten Instrumenten aus. Wie Beck schrieb, gehört der Familie das globale Monopol aller CO2-Messungen. Keeling wird als der Erste genannt, der die Welt bzgl. AGW alarmiert hat. Wie es dazu in einem zweifellos bearbeiteten Eintrag bei Wikipedia heißt:

Charles David Keeling (1928 bis 2005) war ein amerikanischer Wissenschaftler, dessen CO2-Aufzeichnungen am Mauna-Loa-Observatorium die Welt zum ersten Mal alarmierten hinsichtlich der Möglichkeit eines menschlichen Beitrags zum Treibhauseffekt und einer globalen Erwärmung.

Keelings Sohn, ein Mitautor der IPCC-Berichte, kontrolliert weiterhin die Einrichtungen am Mauna Loa. Der stetige Anstieg der Keeling-Kurve ist bekanntlich besorglich, vor allem, wenn man die Variabilität betrachtet, die für die IPCC-Story als nicht zuträglich angesehen wird. Wie lange wird sich dieser Trend fortsetzen? Wir wissen, dass die globalen Temperaturen gestiegen sind, bis die Satelliten-Ära Daten erbrachte, die unabhängig vom IPCC sind.

Es gibt keine unabhängige CO2-Aufzeichnungen, die Keelings haben das Monopol und sind die offizielle Aufzeichnung für das IPCC.

Beck erklärte:

Die moderne Treibhaus-Hypothese basiert auf der Arbeit von G. S. Callendar und C. D. Keeling. Sie folgt S. Arrhenius, wie jüngst vom IPCC popularisiert. Eine Begutachtung der verfügbaren Literatur wirft die Frage auf, ob diese Autoren systematisch eine große Zahl valider technischer Studien und älterer CO2-Bestimmungen ausgesondert haben, weil die nicht zu ihrer Hypothese passen. Es ist offensichtlich, dass sie lediglich einige wenige sorgfältig ausgewählte Werte aus der älteren Literatur herangezogen haben, die ausnahmslos Ergebnisse brachten, die mit der Hypothese eines induzierten CO2-Anstiegs in der Luft durch die Verbrennung fossiler Treibstoffe konsistent war.

Jetzt stecken sie in dem Dilemma fest, dass die Temperatur seit über 19 Jahren nicht mehr gestiegen ist, während der CO2-Gehalt den Mauna-Loa-Messungen zufolge seinen stetigen Anstieg fortsetzt. Wie lange wird es dauern, bis wir eine bekannt gemachte Abnahme dieser Aufzeichnungen sehen, um die Daten auf Linie mit der politischen Mission zu bringen? Glücklicherweise ist es dank der Arbeiten von Jaworowski und Beck zu spät, den Schaden kleinzureden, den der Zeitlupen-Crash verursacht, der sich unvermeidlich entwickelt. Die Hockeyschläger des gesamten Teams sind in dem Crash zerbrochen [nur dass der Öffentlichkeit dies geflissentlich verschwiegen wird! Anm. d. Übers.]

Anmerkung von Anthony Watts (1.11.159:

Einige Passagen dieses Beitrags beziehen sich auf eine Reihe chemischer Analysen von Luft-Stichproben bzgl. CO2 an der Erdoberfläche von Georg Beck. Ich denke, dass die Luft-Stichproben nur geringe Qualitätskontrollen durchlaufen haben und nicht notwendigerweise repräsentativ sind für das globale CO2-Niveau zu jener Zeit und an jenen Orten. Ich glaube, dass die Messungen von einem Bias durch den Ort der Messung verzerrt sind und unter atmosphärischen Bedingungen erfolgt sind, die nicht sehr gut durchmischt waren. Daher sollte man sie mit Vorsicht betrachten. Ich bringe diesen Beitrag einfach zur Diskussion, was nicht heißen soll, dass ich uneingeschränkt hinter den Beck-Daten stehe. – Anthony Watts

Link: http://wattsupwiththat.com/2015/10/17/deconstruction-of-the-anthropogenic-global-warming-agw-hypothesis-2/

Übersetzt von Chris Frey EIKE