Über neue Erkenntnisse und alte Postergucker als „Hüter der Wissenschaft“

Zitat:

„… Unter die Postergucker mischte sich ein Älterer: Halbbrille, Glatze, grauer Bart. Dem Gebaren nach ein Wissenschafts-Guru. Kurz nahm der Typ Maß, um dann den jungen Koreaner mit Anwürfen nach dem Muster zu belegen: Wieso meinen Sie denn …? Aber es ist doch sattsam bekannt, dass …! Der Jüngere schien seiner Sache gewiss, blickte dem Älteren tapfer ins Gesicht und verteidigte sich in einem Englisch, das zu genauestem Hinhören zwang. Der Angreifer winkte nach ein paar zusätzlichen Einwänden ab und flanierte weiter durch die Reihen, bis er stirnrunzelnd vor einem anderen Poster verharrte. Dasselbe Szenario. Als ein Hüter der Wissenschaft wollte er imponieren, einer, der allerdings nur das zur Kenntnis nahm, was er sowieso schon wusste und auch nur deshalb zu wissen für werthielt. Leute waren das, die es verstanden, kunstvoll am Winde zu segeln, den sie selbst machten. Ein paar Jahre hin, und diesen Laffen wird niemand mehr kennen. Seine altväterlichen Weisheiten nimmt er dann wie alle vor ihm mit ins Grab.“

Das hemisphärische Stefan-Boltzmann-Modell kommt ohne einen Treibhauseffekt aus

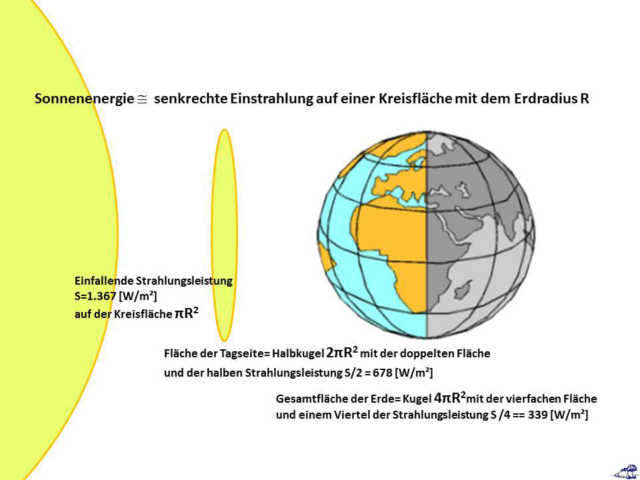

Meine neuartige hemisphärische Stefan-Boltzmann-Betrachtung für die Temperaturgenese auf unserer Erde (Abbildung unten) kommt ohne einen „natürlichen atmosphärischen Treibhauseffekt“ aus und kann unter Einbeziehung der S-B-Umgebungsgleichung die sogenannte „gemessene“ globale Durchschnittstemperatur NST widerspruchsfrei erklären.

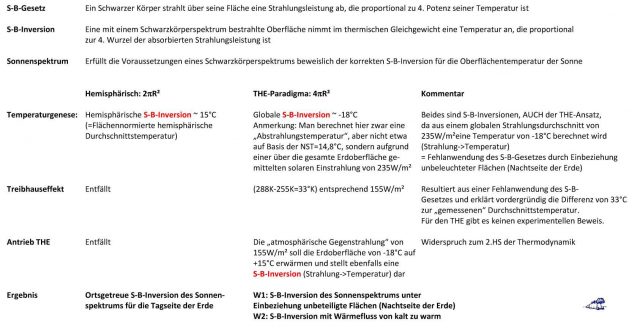

Mein hemisphärischer 2PIR²-S-B-Ansatz für die Tagseite der Erde ohne THE steht also diametral gegen den konventionellen 4PIR²-Tag=Nacht-THE-Ansatz, wie die nachfolgende Tabelle zeigt:

Die von mir bereits mehrfach erhobene Widerlegungsanforderung gegen meinen S-B-Ansatz, nämlich einen physikalischen Gleichwertigkeitsnachweis von Tag und Nacht zu erbringen, wurde von meinen Kritikern bisher nicht erfüllt. Stattdessen mühen sich die üblichen „Postergucker“ als Blogwarte des herkömmlichen 24h=Faktor4-THE-Flacherdeansatzes mit Argumenten „ad hominem“ und „ad auctoritatem“ sowie paternosterartigen KKDMP-Wiederholungen ab. Einer der KKDMP-Namensgeber, ein Herr „Gerhard Kramm, Fairbanks, Alaska, USA“, hat nun noch einen draufgesetzt und zwei Aufsätze gegen meinen hemisphärischen S-B-Ansatz geschrieben. In dem einen argumentiert er „ad auctoritatem“, indem er eine Phalanx von Physikkoryphäen gegen meinen hemisphärischen S-B-Ansatz antreten lässt, von denen sich zeitlebens kein einziger zustimmend zum THE geäußert hatte; im anderen widerlegt er dann Aussagen, die er selbst mir erst freihändig zugeschrieben hatte:

Kramm behauptet in seinem ersten Aufsatz, Zitat Seite 18, Mitte, mit Hervorhebungen: „Während Weber (2019) den Temperaturverlauf auf der Nachtseite einer Erde ohne Atmosphäre bzw. des Mondes ignorierte, um seinen hemisphärischen Stefan-Boltzmann-Ansatz anwenden zu können, …“. Und in seinem zweiten Aufsatz behauptet er dann einfach mal das Gegenteil, Zitat erster Satz mit Hervorhebungen: „Ausgehend von dem Begriff des ‚solaren Klimas‘ wird nachgewiesen, dass die von Herrn WEBER in seinem Beitrag aufgestellten Behauptungen zur global ermittelten Oberflächentemperatur einer Erde ohne Atmosphäre mit den theoretischen Grundlagen unvereinbar sind.“

Kramm skandalisiert also, ich hätte angeblich den Temperaturverlauf „einer Erde ohne Atmosphäre“ ignoriert (1. Aufsatz) und gleichzeitig Behauptungen über „eine Erde ohne Atmosphäre“ aufgestellt (2. Aufsatz). Diese Argumentation ist also ein geschickt konstruierter Zirkelschluss (petitio principii) mit einer Beweisführung ad auditores (vordergründig plausibel für ein Publikum ohne tiefere Kenntnis). Nur zur Erinnerung, mein hemisphärisches S-B-Modell beschreibt die Temperaturgenese auf der REALEN Erde mit Tag und Nacht ohne einen THE, aber unter Einbeziehung der in Atmosphäre und Ozeanen gespeicherten Wärme. Kramms Skandalisierung betrifft also gar nicht meinen realitätsnahen hemisphärischen S-B-Ansatz, sondern vielmehr seine eigene 24h=Faktor4-THE-Flacherde ohne Atmosphäre. Und wo Kramm in seinen Kommentaren unbewiesene justitiable Behauptungen verbreitet, überschreitet er dann auch noch die Grenze zwischen wissenschaftlicher und dichterischer Fiktion.

Kramms Kommentar mit dem Link zu seinem 1. Aufsatz und die dortigen Referenzen zu meinen Arbeiten:

Weber, U. (2018): Die hemisphärische Stefan-Boltzmann Temperatur unserer Erde. Books on Demand, 48 pp.

Weber, U. (2019): Weitere Überlegungen zur hemisphärischen Herleitung einer globalen Durchschnittstemperatur. Mitt. Deutsche Geophysikalische Gesellschaft, 1/2019, 18-25.

Kramms Kommentar mit dem Link zu seinem 2. Aufsatz und die dortigen Referenzen zu meinen Arbeiten:

WEBER, U. (2017): Beweist die Temperatur des Mondes den hemisphärischen Stefan-Boltzmann Ansatz? EIKE e.V., https://eike.institute/2017/07/02/beweist-die-temperatur-des-mondes-den-hemisphaerischen-stefan-boltzmann-ansatz/

WEBER, U. (2018): Die hemisphärische Stefan-Boltzmann Temperatur unserer Erde. Books on Demand, 48 pp.

WEBER, U. (2018): Weitere Überlegungen zur hemisphärischen Herleitung einer globalen Durchschnittstemperatur. Mitt. Deutsche Geophysikalische Gesellschaft, 1/2019, 18-25.

Konkurrierende Modelle können sich untereinander weder bestätigen noch widerlegen

Insgesamt bewahrheitet sich damit erneut, was ich bereits hier auf EIKE über konkurrierende Modelle ausgeführt hatte, Zitat: „…Eine Skandalisierung meines Modells anhand von bekanntem Lehrbuchwissen, in dem diese konkurrierenden Modelle dargestellt werden, ist also wissenschaftlich absolut unzulässig. Konkurrierende Modelle können sich untereinander weder bestätigen noch widerlegen; das geht nur über deren gemeinsame physikalische Grundlagen…“. Murphy, der Lieblingsphilosoph aller Ölsucher, hatte diese Problematik folgendermaßen auf den Punkt gebracht, Zitat, „In a two-boat operation, the idiots are always on the other ship“. Bei der subjektiven Bewertung „Totalverweigerer“ und „Realist“ kommt es nämlich lediglich auf den eigenen Standpunkt an. Da sich neue wissenschaftliche Ansätze, die dem klimawissenschaftlichen Mainstream widersprechen, heutzutage nur sehr schwer verbreiten lassen, beflügeln solche manipulativen Scheinkritiken immerhin den sogenannten „Streisand-Effekt“.

Nun kaprizieren sich einige Kommentatoren aber auch darauf, dass mein hemisphärisches S-B-Modell experimentell noch gar nicht bewiesen worden sei. Dabei hatte Herr Albert Agerius diesen Nachweis über eine Rückrechnung der ERBS-Satellitenmesswerte auf die hemisphärische Sonneneinstrahlung bereits öffentlich geführt (sein Buch hier und sein aktueller EIKE-Artikel hier) und damit das IPCC-KT97-Klimamodell anhand von gemessenen Daten widerlegt. Denn schließlich stellen solche Satellitenmesswerte ein 1:1-Experiment bezüglich unserer realen Erde dar.

Der Teufelskreis zwischen Verständlichkeit und nicht angreifbaren Formulierungen

Der Autor versucht nachfolgend einmal, den Teufelskreis zwischen Verständlichkeit und nicht angreifbaren Formulierungen zu durchbrechen. Im nachfolgenden Text weisen die Zahlen in eckigen Klammern jeweils auf weiter unten verlinkte Artikel hin, in denen einzelne Aspekte meines hemisphärischen S-B-Modells bereits ausführlich behandelt worden waren.

Mein hemisphärisches S-B-Modell kann die Temperaturgenese auf der Tagseite unserer Erde und die „gemessene“ globale Durchschnittstemperatur von ca. 15°C unter Einbeziehung der S-B-Umgebungsgleichung ohne einen „natürlichen atmosphärischen Treibhauseffekt“ widerspruchsfrei erklären.

Dabei erfolgt die globale Abstrahlung von 235W/m² analog zum konventionellen THE-Ansatz über die sogenannte „Abstrahlungshöhe“. Allerdings erklärt sich die Temperaturdifferenz von 33°C zwischen Erdoberfläche (ca. 15°C) und dieser „Abstrahlungshöhe“ von etwa 5.000 Metern (ca.-18°C) ohne eine thermodynamisch widersinnige „atmosphärische Gegenstrahlung“ und ohne einen THE allein über die barometrische Höhenformel [19], wie das erstmals in einem Kommentar des EIKE-Admins ausgeführt worden war.

Immer wieder versuchen zweidimensionale Rechenkünstler und „Segler am selbstgemachten Wind“, mein hemisphärisches S-B-Modell mit vordergründigen THE-Argumenten infrage zu stellen [14-16]. Dieses hemisphärische S-B-Modell ist physikalisch leider nicht ganz barrierefrei und erfordert eine gewisse Abstraktion sowie sphärisches Vorstellungsvermögen. Bitte beachten Sie daher, dass sich die solare Einstrahlung ausschließlich auf die Tageshemisphäre der Erde beschränkt [13] und nur hier die spezifische solare Strahlungsleistung über das Stefan-Boltzmann-Gesetz ZEITGLEICH in ein S-B-Temperaturäquivalent (Strahlung => Temperatur) überführt werden kann. Beachten Sie bitte weiter, dass dieses rechnerische S-B-Temperaturäquivalent auf unserer Erde nur in extremen Ausnahmefällen erreicht wird, weil die örtliche Aufheizung üblicherweise durch Verdunstung und Konvektion begrenzt ist [20], also Wärme in die globalen Zirkulationen abfließt. Und beachten Sie bitte schließlich auch noch, dass die in Atmosphäre und Ozeanen gespeicherten Energiemengen über die S-B-Umgebungsgleichung das Temperaturverhalten auf der Nachtseite und der Winterhemisphäre unserer Erde entscheidend beeinflussen [12].

Die Inversion des Stefan-Boltzmann-Gesetzes

Tatsächlich stellt mein S-B-Modell eine S-B-Inversion (Strahlung => Temperatur) dar [20]. Der Einwand, eine S-B-Inversion würde den Erfahrungswerten beim Gebrauch eines Mikrowellenherdes widersprechen, stellt eine unzulässige dialektische Erweiterung des ursprünglichen Anwendungsbereiches dar; dieses Argument springt also vom sichtbaren (~1015 Hz) und infraroten (~1013 Hz) Licht zu monofrequenter Mikrowellenstrahlung (~1010 Hz). Und außerdem gilt dieser Einwand selbstverständlich für BEIDE konkurrierenden S-B-Modelle, also SOWOHL für mein hemisphärisches S-B-Modell ALS AUCH für den Faktor4=24h-THE-Flacherdeansatz.

Physikalisch ist aber auch die Inversion des S-B-Gesetzes (Strahlung => Temperatur) gültig, solange die S-B-Randbedingungen, also die strenge Gleichzeitigkeit (bei beiden, sowohl beim S-B-Gesetz als auch bei der Inversion) und die geometrisch korrekte spezifische Strahlungsleistung für die betrachtete Fläche (S-B-Gesetz: Strahlende Fläche des Schwarzkörpers/ Inversion: Ausschließlich die bestrahlte Fläche), stringent eingehalten werden. Insbesondere darf eine S-B-Inversion also nur auf die gleichzeitig beleuchtete Fläche angewendet werden; unbeleuchtete Flächen haben in einer solchen S-B-Inversion nichts verloren.

Die Gültigkeit einer solchen S-B-Inversion wird durch eine Übereinstimmung meines hemisphärischen S-B- Ansatzes mit dem Verlauf der gemessenen Tagestemperatur auf dem Mond eindeutig nachgewiesen [5]. Die Oberflächentemperatur auf dem Mond wird durch die einfallende solare Strahlungsleistung erzeugt. Der gemessene Temperaturverlauf auf der Tagseite des Mondes entspricht meinem hemisphärischen S-B-Modell. Damit ist der Beweis erbracht, dass eine Inversion der spezifischen solaren Strahlungsleistung dem Stefan-Boltzmann-Gesetz gehorcht. Somit wäre zunächst beiden S-B-Inversionen abgeholfen; als Knackpunkte eines 24h-Faktor4-THE-Flacherdeansatzes verbleiben allerdings weiterhin dessen Nichterfüllung der S-B Randbedingungen und die Verletzung des 2. HS der Thermodynamik.

Beim Stefan-Boltzmann-Gesetz kommt es streng auf die Reihenfolge an

In manchen Kommentierungen zu meinen Artikeln wird eine grundlegende Unkenntnis über den Zusammenhang der physikalischen Größen „Leistung“ und „Arbeit“ erkennbar. Versuchen Sie doch einfach mal, aus einem Liter kochendem Wasser, das anfänglich eine Temperatur von 8°C hatte, die elektrische Leistung der betreffenden Herdplatte zu ermitteln, ohne dass Ihnen die Zeit bis zum Kochen des Wassers bekannt ist. Sie werden feststellen, dass es für diese Aufgabe keine eindeutige Lösung gibt, sondern unterschiedliche Kombinationen von Heizleistungen und Kochzeiten zum selben Ergebnis führen.

Also, [Leistung] ist, was hinten auf der Herdplatte draufsteht, ganz egal, ob sie heiß oder kalt ist, beispielsweise 2000 Watt bei 230 Volt. Und [Arbeit] ist das Ergebnis, wenn die Herdplatte für einen gewissen Zeitraum eingeschaltet war und Wärme produziert hat, also [Wärme = Leistung mal Zeit]. Wenn Sie jetzt diese Heizplatte bis zum Kochen des Wassers bei voller Leistung im Wechsel für jeweils 30 Sekunden ein- und ausschalten, dann erhalten Sie, von Verlusten einmal abgesehen, prinzipiell die gleiche Wärmemenge, als wenn Sie diese Heizplatte bei halber Leistung über den gesamten Zeitraum betreiben würden. Der wesentliche Unterschied ist dann, dass die Heizplatte bei 1.000 Watt Leistung nicht so heiß geworden ist wie bei 2.000 Watt.

Und damit die KKDMP&B-Fraktion jetzt nicht im Chor aufheult, nein, dieses Beispiel hat nicht direkt mit dem S-B-Gesetz zu tun, sondern nur mit dessen physikalischen Einheiten; es kann aber sinngemäß auch auf das S-B-Gesetz übertragen werden. Denn die primäre Temperaturgenese auf unserer Erde erfolgt allein durch die direkte spezifische Strahlungsleistung der Sonne (S-B-Inversion: Strahlung => Temperatur) auf ihrer hemisphärischen Tagseite. Alle globalen Mittelwerte, die sich aus zeitlich und/oder räumlich gemittelten spezifischen Strahlungsleistungen der Sonne herleiten, verlassen dagegen unwiderruflich das S-B-Gesetz. Sie enden daher, ebenso wie das Beispiel mit der Herdplatte, für die primäre solare Einstrahlung bzw. deren Temperaturäquivalent in einer beliebigen Lösungswolke, deren Ergebnisse noch nicht einmal der physikalischen S-B-T4-Beziehung genügen.

Nicht alles, was hinkt, ist ein Beispiel – aber jedes Beispiel hinkt.

Wenn ein gemeiner Forentroll (Vexator fororum utgardensis) verhindern will, dass der interessierte Leser ein gutes Beispiel versteht, dann fokussiert er seinen Kommentar auf das Hinken dieses Beispiels. Je einfacher und allgemeinverständlicher nämlich ein solches Beispiel ist, umso größere Angriffsflächen bietet es für sophistische Interpretationen. So hatte beispielsweise ein Herr Werner Schulz den physikalischen Unterschied zwischen der Verteilung der solaren Einstrahlung über die Fläche der Tagseite einerseits und über die Gesamtfläche unserer Erde andererseits am Beispiel eines Schweißbrenners erläutert. Und der interessierte Leser kann dieses Beispiel jederzeit in einen direkten Zusammenhang mit der ursprünglichen Argumentation bringen. Wenn er sich also nicht durch Troll-geführtes Störfeuer auf einen sophistischen Holzweg abdrängen lässt, wird er feststellen, dass bei der Umrechnung einer definierten spezifischen Strahlungsleistung in ein S-B-Temperaturäquivalent die Größe der bestrahlten Fläche die alles entscheidende Rolle spielt.

Bei unserer Erde handelt es sich um ein quasistatisches und energetisch „voll mit Wärme aufgeladenes“ System, bei dem Energiespeicherung und Energieabgabe zeitgleich, aber nicht ortsgenau erfolgen [6], wobei die gerade eingestrahlte Sonnenenergie nicht unbedingt im selben Augenblick wieder als IR-Strahlung abgestrahlt, sondern zum Teil in den globalen Zirkulationen von Atmosphäre und Ozeanen „zwischengespeichert“ wird. Nehmen Sie beispielsweise den Golfstrom. Sie könnten behaupten, die Energiemenge, mit der dieser gerade in den Tropen und Subtropen beladen wird, fehle in der momentanen Energiebilanz. Sie könnten aber umgekehrt auch behaupten, die momentane Aufheizung in mittleren und höheren geographischen Breiten durch den Golfstrom müsse der Energiebilanz zusätzlich zugerechnet werden. In Wirklichkeit geschieht aber beides gleichzeitig an unterschiedlichen Orten, sodass es sich insgesamt betrachtet um ein globales Nullsummenspiel handelt.

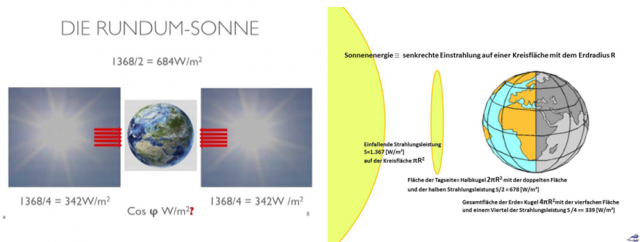

Das Treibhaus-Modell erfordert zwei Sonnen

Gleichgültig, ob eine oder zwei Sonnen mit einer spezifischen Strahlungsleistung von insgesamt 1.367W/m² auf unsere Erde scheinen [20], das 24h=Faktor4-Flacherde-THE-Modell kommt immer auf dasselbe S-B-Temperaturäquivalent von -18°C als sogenannte „theoretische globale Durchschnittstemperatur“.

Und allein mein hemisphärisches S-B-Modell ist in der Lage, den Unterschied zwischen diesen beiden Fällen darzustellen und das jeweilige S-B-Temperaturäquivalent (1 Sonne ~ +15°C / 2 Sonnen ~ -18°C) korrekt zu quantifizieren [17]. Dieses S-B-Modell ist statisch und beruht auf folgender Durchschnittsbetrachtung: Nirgendwo auf der Erde herrscht im Tages- oder Jahresverlauf irgendein energetisches Gleichgewicht, dieses Ungleichgewicht treibt unser Wetter an und Klima ist dessen 30-jahriger Durchschnitt. Für ein generalisiertes makroskopisches Modell unserer Erde muss ich also zeitlich mindestens bis zum Klimabegriff abstrahieren. Und erst hier kann ich dann versuchen, die grundlegenden Phänomene der Klimagenese auf unserer Erde zu beschreiben, wie das in meinem hemisphärischen S-B-Modell ausgeführt wird.

Die sogenannte „globale Durchschnittstemperatur“ NST von ca. 15°C für das energetisch „voll aufgeladene“ System Erde/Atmosphäre/Ozeane lässt sich ganz gut anhand einer „tiefgekühlten“ Erde erläutern, die von der Sonne gerade energetisch aufgeladen wird [6]. Wenn wir jetzt beispielsweise einmal den Golfstrom betrachten, dann nimmt er in dieser Situation zwar Wärme auf, gibt aber in nördlichen Breiten noch keine Energie ab, sodass die NST zunächst deutlich unter 15°C bleibt. Denn aufgrund von Verdunstung und Konvektion wird das örtliche S-B-Temperaturäquivalent nirgendwo erreicht, und andererseits können die globalen Wärmeströme (atmosphärische und ozeanische Zirkulationen) in mittleren und höheren Breiten noch keine gespeicherten Wärmemengen „zurückliefern“, um dieses Defizit auszugleichen. Erst im Endstadium, wenn also sämtliche Wärmespeicher unserer Erde komplett gefüllt sind, ist global gesehen der „Gewinn“ aus Kondensation und Advektion im langjährigen Mittel genauso groß, wie der „Verlust“ durch Verdunstung und Konvektion. Und deshalb konvergiert die maximal mögliche Durchschnittstemperatur auf unserer Erde beim flächengewichteten Durchschnitt von ca. 15°C für das S-B-Temperaturäquivalent aus der hemisphärischen Sonneneinstrahlung [13]. Dieses S-B-Temperaturäquivalent entspricht der „gemessenen“ NST von ca. 15°C und lässt keinerlei Raum für einen „natürlichen atmosphärischen Treibhauseffekt“.

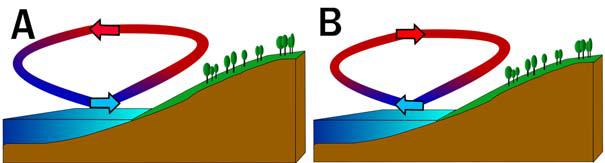

Das Land-Seewind-System als Funktionsbeispiel für die globalen Zirkulationen

Im Ablauf von Tag und Nacht verläuft die Erwärmung und Abkühlung von Land- und Wassermassen sehr unterschiedlich. Das nachstehend abgebildete Land-Seewind-System ist ein bekanntes Beispiel für den Wärmeaustausch zwischen Land und Meer:

Aus der Beschreibung auf Wikipedia, Zitat:

„Seewind: Luftmassen strömen vom Wasser aufs Land, da sich dieses aufgrund des relativ geringen c-Wertes von bspw. Boden, Beton, Häusern, (Dachziegeln c= 0,73 kJ/(kg·K)) und Asphalt tagsüber schneller aufheizt. Wasser dagegen heizt/kühlt sich aufgrund des höheren c-Wertes von 4,18 kJ/(kg·K) wesentlich langsamer auf/ab. Daher steigen tagsüber die Luftmassen über Land auf und es kommt zu einer Ausgleichsbewegung durch vom Wasser aus nachrückende Luftmassen (=Seewinde).“

„Landwind: Luftmassen strömen vom Land zur oder zum See. Grund: Abends, noch mehr nachts, dreht sich diese Zirkulation um; Land kühlt sich viel schneller ab als die/der See, wegen viel geringerer c-Werte der genannten Stoffe, (Dachziegel, c = ca. 0,73 kJ/(kg·K)). D. h. wesentlich geringere Spezifische Wärmekapazität als Wasser (4,18 kJ/ (kg·K)). Nun ist das Wasser relativ wärmer; nun steigt über der/dem See die Luft auf- und relativ kältere Luftmassen fließen vom Land weg zur/zum See nach.“

Im Land-Seewind-System werden nächtliche Wärmeverluste der Landmassen also durch die Advektion erwärmter Luft von den Meeresflächen abgemildert, während am Tage die Wärme der Landflächen durch Konvektion abgeführt wird. Dieses Beispiel lässt sich auf die die globalen Zirkulationen in Atmosphäre und Ozeanen übertragen, wobei hier die Quellen um den Äquator und die Senken in mittleren und höheren Breiten liegen.

Die hemisphärische Sonneneinstrahlung in den Tropen treibt die kombinierte Luft-Wasser-Heizung unserer Erde an

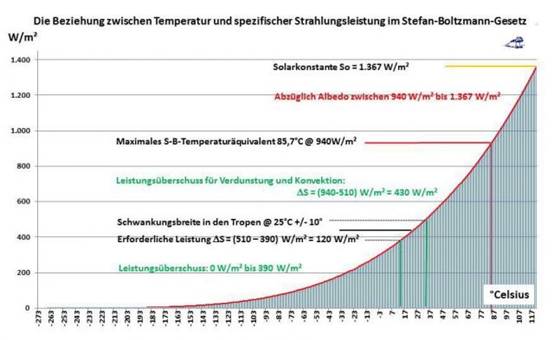

Betrachten wir jetzt einmal die Beziehung zwischen Temperatur und spezifischer Strahlungsleistung nach dem Stefan-Boltzmann-Gesetz am Beispiel der Tropen. Die Mitteltemperatur in den Tropen wird mit ca. 25°C angegeben. Wenn wir dort jetzt einmal eine flächengewichtete Schwankungsbreite von +/-10°C unterstellen, dann würde der Unterschied (DELTA S) im S-B-Strahlungsäquivalent innerhalb von 24 Stunden zwischen Temperaturmaximum und Temperaturminimum etwa 120W/m² betragen. Dieser Verlust von 120W/m² wird auf der Tagseite durch die spezifische Strahlungsleistung der Sonne mehr als kompensiert, wie die nachstehende Abbildung zeigt:

Bei vertikalem Sonnenstand erhalten wir im mittäglichen Zenit der Tropen folgende Maximalwerte:

0 bis390 W/m²: Leistungsüberschuss

390 bis 510 W/m²: Ausgleich der Temperaturspanne zwischen angenommener Maximal- und Minimal-Temperatur in den Tropen von etwa 120W/m²

510 bis 940 W/m²: Leistungsüberschuss

940 bis 1.367 W/m²: Bei einer Albedo von 0,306 bleiben 427W/m² aus der spezifischen solaren Strahlungsleistung auf unserer Erde ohne Einfluss auf die Temperatur. Diese Albedo ist ein Durchschnittswert, sodass örtlich durchaus höhere oder niedrigere spezifische Strahlungsleistungen temperaturwirksam werden können.

Die flächengewichtete tägliche Schwankungsbreite der Ortstemperaturen in den Tropen ist mit +/-10°C eher zu hoch angesetzt, wenn man bedenkt, dass die oberflächennahen Temperaturen im tropischen Ozean eher an die 30°C heranreichen und die tägliche Schwankungsbreite dort wesentlich geringer ausfällt. Es werden also weniger als 13 Prozent der maximalen spezifischen Strahlungsleistung der Sonne für den Temperaturerhalt in der Äquatorregion benötigt, während mehr als 87 Prozent die kombinierte Luft-Wasser-Heizung unserer Erde antreiben. Umgekehrt dürften jenseits der Tropen bis in die Polarzonen hinein Kondensation und Advektion aus den globalen Zirkulationen einen immer weiter ansteigenden Beitrag zur jeweiligen Ortstemperatur liefern, insbesondere auf der jeweiligen Winterhemisphäre.

Die hemisphärische Sonneneinstrahlung auf der Tagseite der tropischen Äquatorialzone treibt also die kombinierte Luft-Wasser-Heizung unserer Erde mit einer maximalen spezifischen Strahlungsleistung von mehr als 820W/m² an. Die dort mit Wärme beladenen Luft- und Wassermassen werden dann durch die globalen Zirkulationen in die mittleren und höheren geographischen Breiten transportiert und dort wieder frei gesetzt. Die Sonneneinstrahlung auf der Tagseite unserer Erde reicht im „voll mit Wärme aufgeladenen“ Stadium der globalen Zirkulationen also völlig aus, um die sogenannte „gemessene globale Durchschnittstemperatur“ von ca. 15°C ohne einen sogenannten „natürlichen atmosphärischen Treibhauseffekt“ zu erklären.

Für alle ernsthaft interessierten EIKE-Leser nachfolgend eine aktuelle Auflistung der bisher hier auf EIKE erschienen Artikel über meinen hemisphärischen S-B-Ansatz:

- 23. Januar 2017: Über einen vergeblichen Versuch, unsere Welt vor der Dekarbonisierung zu retten

- 1. Februar 2017: Wer im Treibhaus sitzt…

- 16. Februar 2017: Nachdem sich der Rauch verzogen hat: Stefan-Boltzmann auf den Punkt gebracht

- 23. Juni 2017: Noch ein paar Fragen zum „natürlichen“ atmosphärischen Treibhauseffekt

- 2. Juli 2017: Beweist die Temperatur des Mondes den hemisphärischen Stefan-Boltzmann Ansatz?

- 19. August 2017: Machen wir mal ein Gedankenexperiment: Es gibt gar keine Erde!

- 26. November 2017: Rückblick: Ein Jahr hemisphärischer Stefan-Boltzmann Ansatz

- 30. November 2017: Nicht immer passt wirklich alles zusammen

- 14. Februar 2018: https://eike.institute/2018/02/14/das-gegenteil-von-gut-ist-gut-gemeint/

- 22. Februar 2018: Eine barrierefreie Erklärung für die hemisphärische Temperaturgenese auf unserer Erde

- 7. Mai 2018: Fangen wir mit dem Stefan-Boltzmann-Gesetz noch einmal ganz von vorne an

- 29. Juli 2019: Safety First: Zum besseren Verständnis meiner hemisphärischen Energiebilanz

- 11. September 2019: https://eike.institute/2019/09/11/anmerkungen-zur-hemisphaerischen-mittelwertbildung-mit-dem-stefan-boltzmann-gesetz/

- 2. Dezember 2019: https://eike.institute/2019/12/02/eine-analyse-der-thesen-antithesen-fuer-einen-natuerlichen-atmosphaerischen-treibhauseffekt-teil-1-gegenueberstellung-der-thesen-antithesen/

- 3. Dezember 2019: https://eike.institute/2019/12/03/eine-analyse-der-thesen-antithesen-fuer-einen-natuerlichen-atmosphaerischen-treibhauseffekt-teil-2-diskussion-der-thesen-antithesen/

- 4. Dezember 2019: https://eike.institute/2019/12/04/eine-analyse-der-thesen-antithesen-fuer-einen-natuerlichen-atmosphaerischen-treibhauseffekt-teil-3-erkenntnisse-zu-den-thesen-antithesen-und-das-ergebn/

- 15. Dezember 2019: https://eike.institute/2019/12/15/kelvin-allein-zu-haus-der-unterschied-zwischen-zwei-watt-ist-deren-umgebungstemperatur/

- 25. Dezember 2019: https://eike.institute/2019/12/25/ein-weihnachtlicher-rueckblick-auf-die-rolle-der-klimarealisten-in-der-oeffentlichkeit/

- 12. Januar 2020: https://eike.institute/2020/01/12/zeigt-der-poynting-vektor-auf-mittelerde-oder-auf-die-sogenannte-abstrahlungshoehe/

- 5. Februar 2020: https://eike.institute/2020/02/05/anmerkungen-zur-bestimmung-der-hemisphaerischen-solaren-einstrahlung-auf-mittelerde/

- 23. Februar 2020: https://eike.institute/2020/02/23/neues-von-willis-eschenbach/

- 18. März 2020: https://eike.institute/2020/03/18/verbesserungswuerdig-ueber-fehlerhafte-ansaetze-fuer-eine-breitenabhaengige-globaltemperatur/

Und hier finden Sie noch ein paar Bücher von Uli Weber, der in seinem ersten Klimabuch (Farbe 2012/ SW 2017) den THE sogar noch als Stand der Wissenschaft beschrieben hatte. Aber man lernt ja glücklicherweise niemals aus…