Steigt der Meeresspiegel immer schneller? (T1/2)

Leider allerdings nur wieder ein Beispiel, wie angebliche „Wissenschaftler“ gemeinsam mit unseren Medien den Bürger bewusst belügen bzw. ihm nicht die ganze Wahrheit sagen. Auf kaltesonne wurde es thematisiert [2]. Da die Info dort etwas kurz geraten ist und den Sachverhalt nur anreißt, anbei eine etwas längere Ausführung.

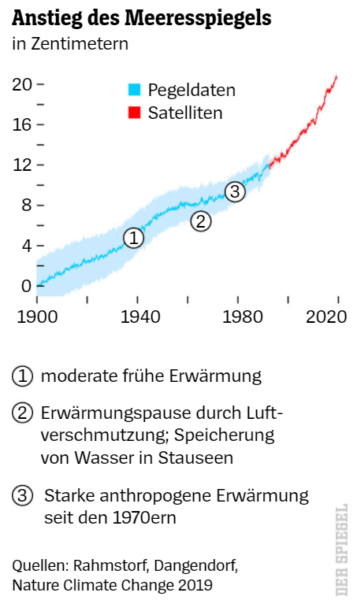

Der Meeresspiegel steigt. Und nicht nur das: Er steigt immer schneller…

…verkündete Prof. Rahmstorf (PIK) im Spiegel [1]. Und er wusste dazu zu erzählen, dass man auch wisse, warum das so ist: „[1] Wie stark der Klimawandel diesen Effekt treibt, ist inzwischen weitgehend entschlüsselt … “. Dazu erzählt er auch, dass die Satelliten den Meerespegel aus einer Bahnhöhe von ca. 1.320 km auf einen Millimeter genau ausmessen könnten: „Die Laufzeit der Wellen erlaubt es, den mittleren globalen Meerespegel auf einen Millimeter genau zu bestimmen“.

Um dann mit der Hiobsbotschaft zu ergänzen: „Seit 1992 ist der globale Meeresspiegel um neun Zentimeter gestiegen. Die Anstiegsgeschwindigkeit hat sich in dieser Zeit mehr als verdoppelt, von 2,1 auf 4,8 Millimeter pro Jahr ... „

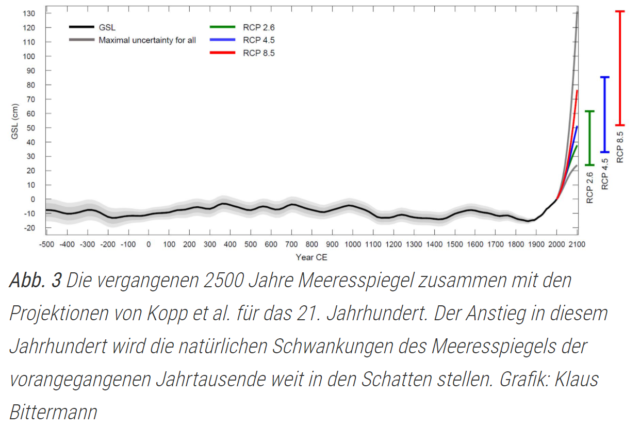

[1] Doch schon dieser Anstieg ist einzigartig mindestens seit der Geburt Christi: Sedimentdaten zeigen, dass es seither in keinem Jahrhundert mehr als fünf Zentimeter Anstieg gegeben hat, und Jahrhunderte mit steigendem und fallendem Pegel hielten sich in etwa die Waage

[1] Die Eismassen haben seit Jahrzehnten bekannte Kipppunkte durch die Eis-Höhen-Rückkopplung in Grönland und die marine Eisschildinstabilität in der Antarktis. Der Kipppunkt für Grönland (genug für sieben Meter Meeresspiegel) liegt wahrscheinlich irgendwo zwischen einem und drei Grad globaler Erwärmung – nach der besten Abschätzung bei 1,6 Grad. Der Kipppunkt für die Westantarktis (genug für drei Meter Meeresspiegel) ist wahrscheinlich sogar schon überschritten …

Eine aktuelle Studie liest aus den gleichen Daten etwas anderes heraus

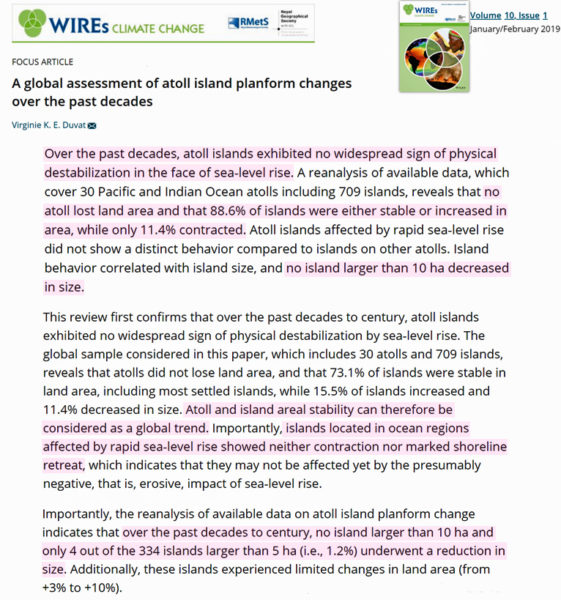

Beim Klimawandel bleibt und ist nichts im „Konsens“ oder gar wie oft behauptet „settled“. Wie immer gibt es Wissenschaftler, die zum genau gleichen Datensatz ganz anderes berichten. So auch wieder in diesem Fall:

[5] H. Bâkiİz and C.K. Shum, January 29, 2020: The certitude of a global sea level acceleration during the satellite altimeter era

Abstract: Recent studies reported a uniform global sea level acceleration during the satellite altimetry era (1993– 2017) by analyzing globally averaged satellite altimetry measurements. Here, we discuss potential omission errors that were not thoroughly addressed in detecting and estimating the reported global sea level acceleration in these studies. Our analyses results demonstrate that the declared acceleration in recent studies can also be explained equally well by alternative kinematic models based on previously well-established multi-decadal global mean sea level variations of various origins, which suggests prudence before declaring the presence of an accelerating global mean sea level with conidence during the satellite altimetry era.

(Leicht angepasste) deepl-Übersetzung: Zusammenfassung: Jüngste Studien berichteten über eine einheitliche globale Meeresspiegel-Beschleunigung während der Satellitenaltimetrie-Ära (1993- 2017) durch die Analyse von global gemittelten Satellitenaltimetrie-Messungen.

Hier diskutieren wir mögliche Auslassungsfehler die bei der Erkennung und Schätzung der berichteten globalen Meeresspiegelbeschleunigung in diesen Studien nicht gründlich behandelt wurden.

Unsere Analyseergebnisse zeigen, dass die angegebene Beschleunigung in den jüngsten Studien ebenso gut auch durch alternative kinematische Modelle erklärt werden kann, die auf gut etablierten multidekadischen globalen mittleren Meeresspiegelschwankungen unterschiedlicher Herkunft basieren. Was zur Vorsicht mahnt, bevor man Erklärungen vertraut, welchen das Vorhandensein eines sich beschleunigenden globalen mittleren Meeresspiegels während der Satelliten Altimetrie-Ära postulieren.

Dem Abstrakt setzten die zwei Studienautoren noch ein Zitat nach: “Nothing is always absolutely so” Sturgeon, The Claustrophile, 1956

In der Studie werden zuerst Daten verschiedener Studien, welche Beschleunigungen im Anstieg der Meerespegel- berichten gelistet und dazu, dass darin (fast immer) keine stichhaltigen Belege enthalten sind. Dann kommt eine eigene Analyse der Satellitendaten:

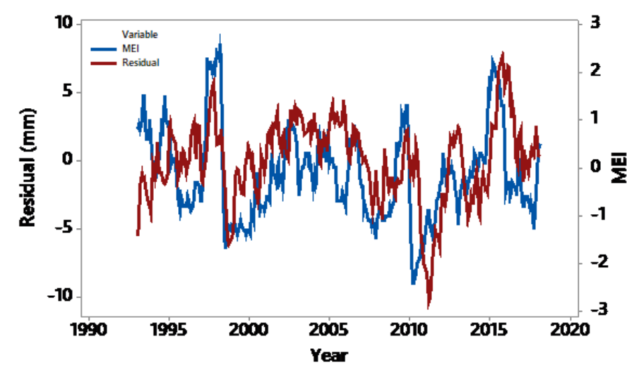

[5] … We analyzed monthly and globally averaged satellite altimetry, SA, global sea level time series to demonstrate that one of the most important approaches to earliest possible detection of a signicant GMSL acceleration lies in recognizing and separating the eect of natural internal forcing of the oceans compounded with the variability of astronomical origin that are not limited to the SA era. We also quanti- ed unusually highly autocorrelated noise in the SA time series, which were not rigorously addressed in recent studies …

(Leicht angepasste) deepl-Übersetzung: ... Wir analysierten monatliche und global gemittelte Zeitreihen der Satellitenaltimetrie SA, (und) des globalen Meeresspiegels, um zu zeigen, dass einer der wichtigsten Ansätze zur frühestmöglichen Erkennung einer signifikanten GMSL-Beschleunigung in der Erkennung und Trennung des Effekts natürlicher interner Antriebe der Ozeane zusammen mit der Variabilität astronomischen Ursprungs (Einfügung. Bsp. Sonnenvariabilität) liegt, die nicht auf die Satelliten-Ära beschränkt sind.

Wir quantifizierten auch ungewöhnlich stark autokorreliertes Rauschen in den SA-Zeitreihen, das in den aktuellen Studien nicht konsequent behandelt wurde …

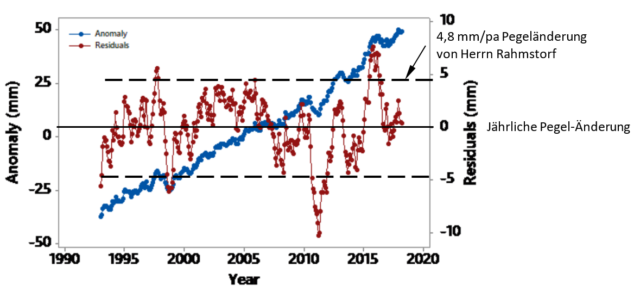

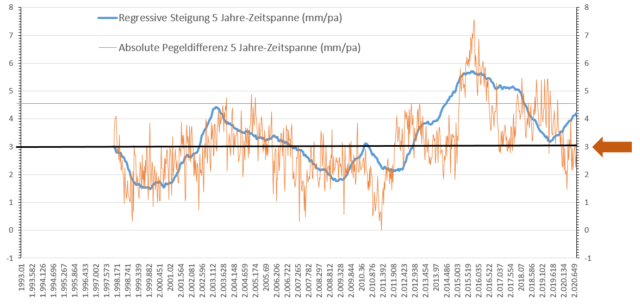

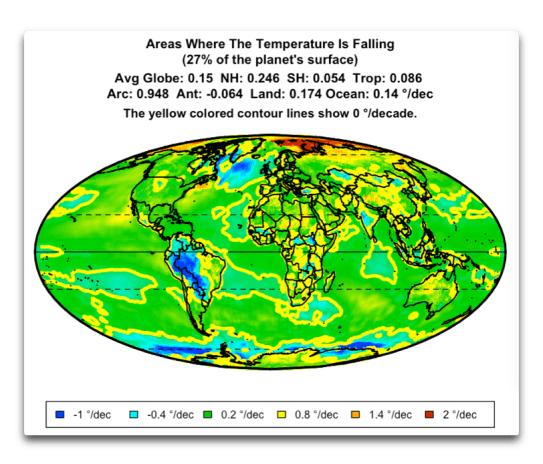

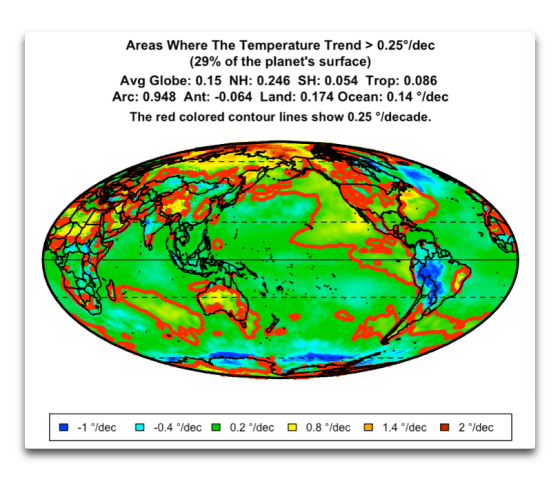

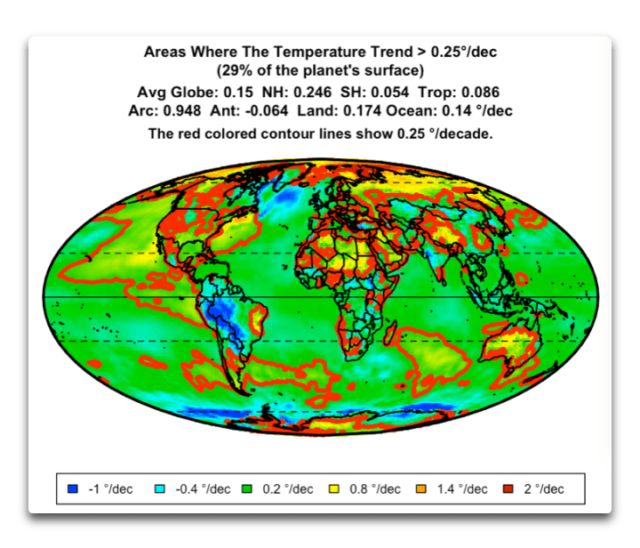

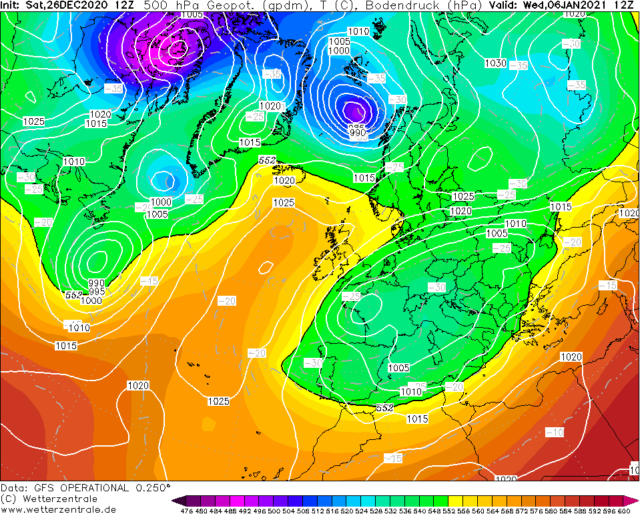

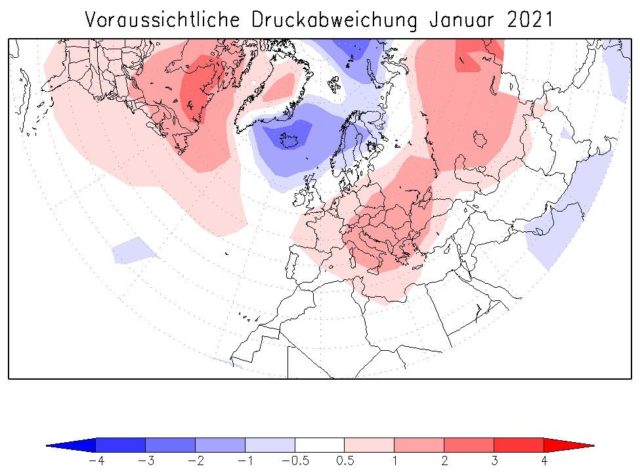

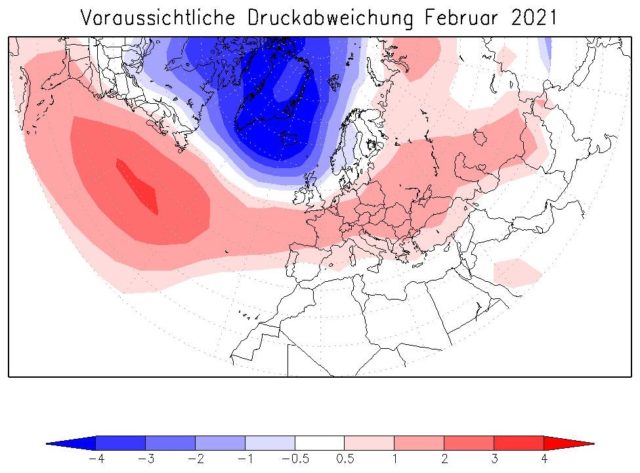

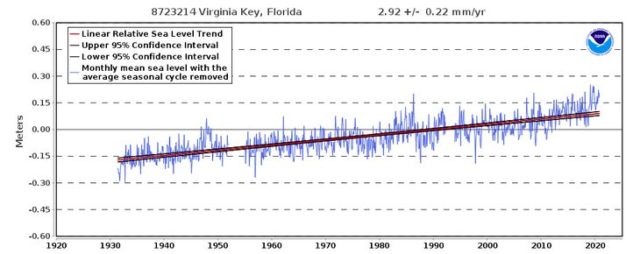

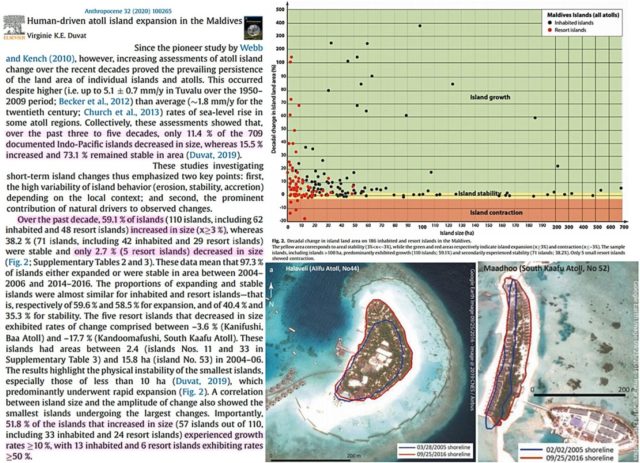

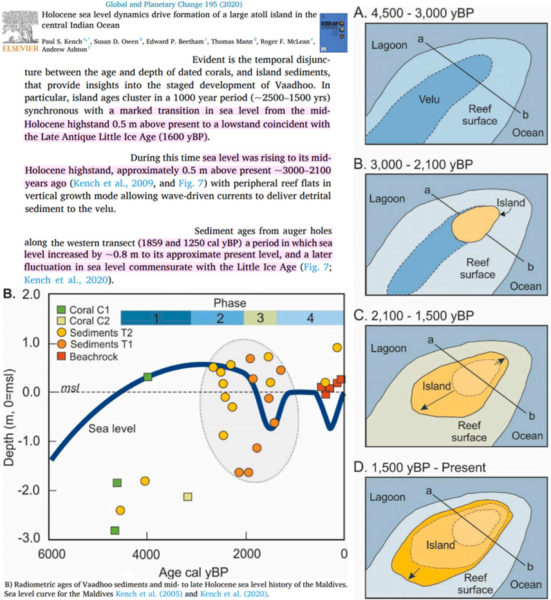

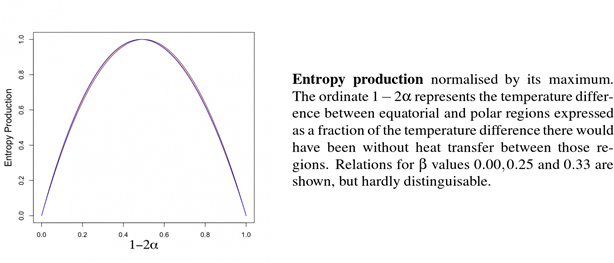

Dann kommt eine Übersichtsgrafik der Satelliten-Pegelreihe (Bild 3). Eigentlich zeigt dieses Bild schon (fast) alles über die alarmistische Aussage von Herrn Rahmstorf und was dieser bewusst dazu nicht gesagt hat: Dass die Pegel-Änderungsrate vom Messbeginn an zyklisch um +- diesen Wert pendelt und aktuell wieder bei Null angekommen ist.

Schlussfolgerung

Was Herr Rahmstorf wie üblich als eine „gesicherte Kenntnis“ publiziert, zeigt sich beim näheren Betrachten (wieder) als höchst spekulativ:

[5] ... Conclusion

Recent analyses of SA time series by Nerem at al., (2018) and Ablain et al., (2019) and others declaring a GMSL acceleration are far from exhaustive for such an important topic. Uncertainty is one of the essential components in assessing variability in global sea level in the context of GMSL budget to ascertain anthropogenic contributions. The omission of the eect of potential confounders including a potential jerk or multidecadal sea level variations (Ablain at al., 2019), or using a conjecture that they will average out because of the superior global coverage of SA by Nerem at al. (2018) is a leap of faith without evidence in quantifying a GMSL acceleration and its uncertainty using globally averaged SA time series. Moreover, conducting projections as in Nerem at al. (2018) without ascribing proper uncertainties to the model estimates have no meaning. Until the uncertainty of a recent GMSL acceleration is established in the context of “total evidence”, i.e. in the light of systematic global sea level variations during the 20th century revealed by TG measurements together with the available SA time series, any prediction of a GMSL rise ought to be made with extreme prudence.

(Leicht angepasste) deepl-Übersetzung: Schlussfolgerung

Die jüngsten Analysen der SA-Zeitreihen von Nerem at al. (2018) und Ablain et al. (2019) und anderen, die eine GMSL-Beschleunigung erklären, sind bei weitem nicht erschöpfend für ein so wichtiges Thema.

Die Unsicherheit ist eine der wesentlichen Komponenten bei der Bewertung der Variabilität des globalen Meeresspiegels im Rahmen des GMSL-Budgets, um die anthropogenen Beiträge zu ermitteln. Die Auslassung des Einflusses potenzieller Störfaktoren, einschließlich eines potenziellen Rucks oder multidekadischer Meeresspiegelschwankungen (Ablain at al., 2019), oder die Verwendung einer Vermutung, dass sie sich aufgrund der überlegenen globalen Abdeckung von SA durch Nerem at al. (2018) ausmitteln werden, ist ein Vertrauensvorschuss ohne Beweise bei der Quantifizierung einer GMSL-Beschleunigung und ihrer Unsicherheit unter Verwendung global gemittelter SA-Zeitreihen. Darüber hinaus ist die Durchführung von Projektionen wie in Nerem at al. (2018), ohne den Modellschätzungen angemessene Unsicherheiten zuzuschreiben, sinnlos.

Solange die Unsicherheit einer rezenten GMSL-Beschleunigung nicht im Kontext der „Gesamtevidenz“, d. h. im Lichte systematischer globaler Meeresspiegelschwankungen während des 20. Jahrhunderts, die durch TG-Messungen zusammen mit den verfügbaren SA-Zeitreihen aufgedeckt wurden, ermittelt ist, sollte jede Vorhersage eines GMSL-Anstiegs mit äußerster Vorsicht erfolgen.

Satellitepegel

Anbei anhand der Originaldaten eine Plausibilitätssichtung.

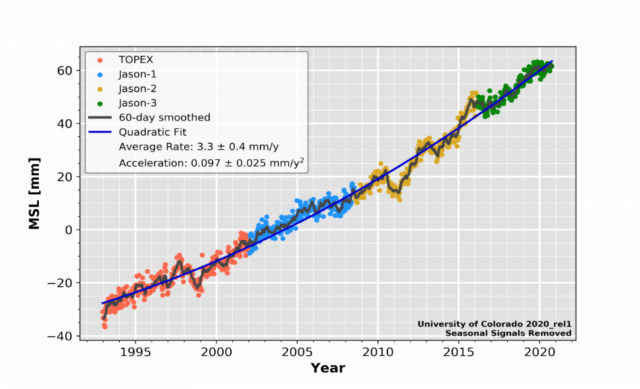

Die Satellitendaten werden gängig wie in Bild 5 dargestellt. Der quadratische, stetig schlimmer steigende Regressions-Fit erscheint in dieser Darstellung plausibel und „zwingend“:

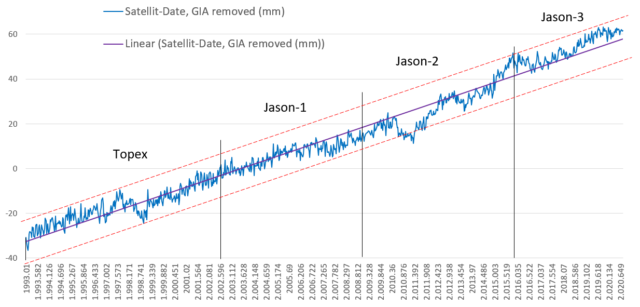

Im WEB sind die Satellitendaten hinterlegt und lassen sich laden. Daraus ergibt sich Bild 6, welches dem Bild 5 in höherer Auflösung entspricht.

Trägt man darin Verlaufsbegrenzungslinien ein, zeigt sich, dass der quadratisch – stetig schlimmer ansteigende – Fit überhaupt nicht zwingend ist. Ein bisheriger – und weiterhin – linearer Anstieg hat genau so gut seine „Berechtigung“ (wie es die Studie [5] auch feststellt).

Der quadratisch steigende Fit zeigt sich demnach lediglich als eine Hypothese und ist durch nichts (außer, dass der Verlauf mathematisch hineinpasst) begründet.

Man muss sich klar machen, dass die Satelliten aus ca. 1.320 km Entfernung den Meeres-Pegel auf den Millimeter genau messen können sollen (was auf Meereshöhe und direkt daneben angeblich nur ungenau erfolgt). Das mag theoretisch stimmen, wenn man alleine die Laufzeit-Messgenauigkeit betrachtet. In Wirklichkeit wird die Laufzeit das Messsignal jedoch durch externe Einflüsse verfälscht, teils driften die Messapparaturen und die Satelliten selbst „taumeln“ mit den Änderungen des Erd-Schwerefeldes. Den Pegelwert bekommt man erst nach vielen, vielen Korrekturen und Anpassungen. Teils werden diese sogar noch nach Jahren nachträglich korrigiert. Es ist also gar nicht sicher, dass die Satelliten-Pegelmesskurve wirklich mit der angegebenen Genauigkeit stimmt.

Herr Rahmstorf ist allerdings überzeugt – zumindest sagt er es -, dass die Satelliten es auf den Millimeter genau könnten. Allerdings ist immer noch ungeklärt, warum die ja weiterhin durchgeführten Tidenpegelmessungen und die Satellitenpegel eine große Abweichung im Pegeltrend aufweisen (Tidenpegel: 1,5 … 2 mm/pa, Satellitenpegel 3,3 mm/pa).

Anmerkung: Diese Abweichung ist der Grund, warum im Pegel-Verlaufsbild (Bild 1) mit den angefügten Satellitendaten so ein großer Beschleunigungsanstieg erfolgt. Es ist der gleiche „Datenbetrug“ wie beim Hockeystick, wo ebenfalls zwei unterschiedliche Messarten mit systembedingt unterschiedlichen Messergebnissen gekoppelt wurden.

Aus diesen Originaldaten lässt sich auch der Verlauf der Pegel-Änderungsrate ermittelt (zum Vergleich mit Bild 3). Die von Rahmstorf genannten, 4,8 mm/pa mit steigender Tendenz erscheinen nun unplausibel und nur eine kurzfristige Momentaufnahme.

Fazit

Der von Prof. Rahmstorf dem Spiegel erzählte, hohe und beschleunigte Meerespegelanstieg ist eher falsch als richtig. Und dies ist anhand der Daten so deutlich erkennbar, dass von einer bewussten Alarmisierung ausgegangen werden muss.

Der „Spiegel“ macht sich dabei eindeutig einer „Mittäterschaft“ schuldig, da zumindest „er“ als unabhängige Institution auch auf die vorliegenden, der Aussage von Herrn Rahmstorf entgegenstehenden Studien und Daten hätte hinweisen müssen.

Damit endet Teil 1. Im zweiten Teil wird der aktuelle Meerespegel-Änderungszustand anhand von Pegeldaten in der (angeblich) am meisten davon betroffenen Region – der Südsee – gezeigt.

Quellen

[1] SPIEGEL Wissenschaft, Rahmstorf 15.12.2020: Klimakrise Warum der Meeresspiegel immer schneller steigt

[2] kaltesonne 23.12.2020: Die Welt säuft ab…wirklich?

[3] STERN, 26.12.2020: Wirtschaftswachstum: Corona-Turbo – China wird die USA schon 2028 hinter sich lassen

[4] RAHMSTORF 22. Feb 2016. SciLogs > KlimaLounge > Allgemein > Meeresspiegel über die Jahrtausende

[5] H. Bâkiİz* and C.K. Shum, January 29, 2020: The certitude of a global sea level acceleration during the satellite altimeter era

[6] EIKE 10. November 2019: Statt 80 sind plötzlich 300 Millionen Küstenbewohner vom Klimawandel bedroht

[7] DKK, Schrift: Zukunft der Meeresspiegel

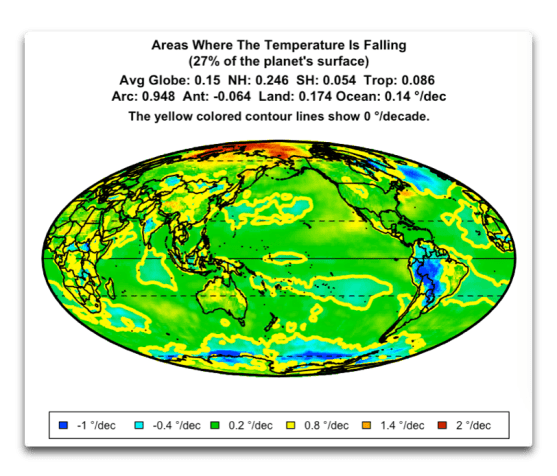

Frage von Marcel Crok: Was schließen Sie aus Ihrer Abbildung 3? Wollen Sie damit sagen, dass die besten verfügbaren Daten darauf hindeuten, dass die Ozean-Temperatur abnimmt?

Antwort von Andy May:

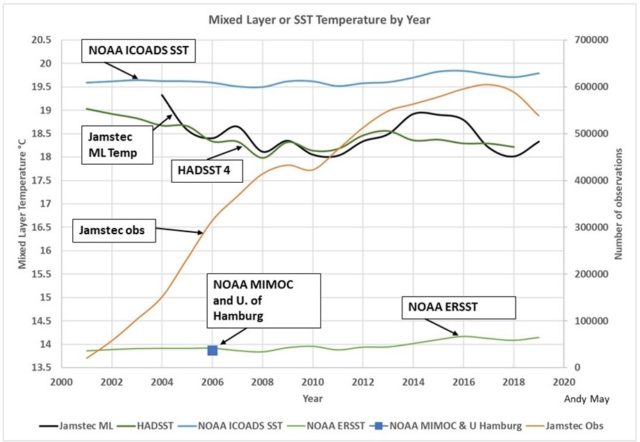

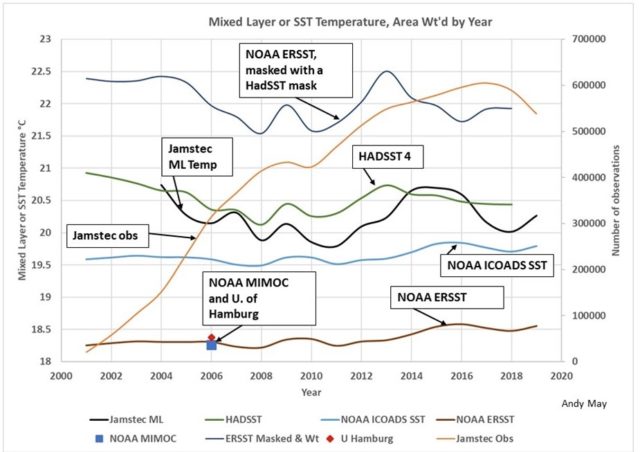

Die allerbesten Daten sind in dieser Abbildung dargestellt. Aber sie repräsentiert nur einen Teil des Weltozeans, und das dargestellte Gebiet ändert sich ständig. Dieser sich ständig verändernde Bereich zeigt sinkende gemessene Temperaturen. Die Schiffe, Schwimmer und Bojen, die die Temperatur messen, sind ständig in Bewegung und verändern sich in jeder Zelle. Die Zellen mit Messungen ändern sich ständig. Die „Referenz“-Periode, zwischen 1961-2000, hat sehr schlechte Daten.

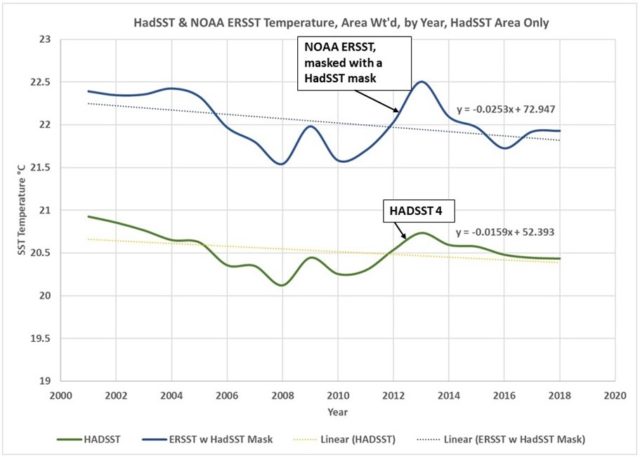

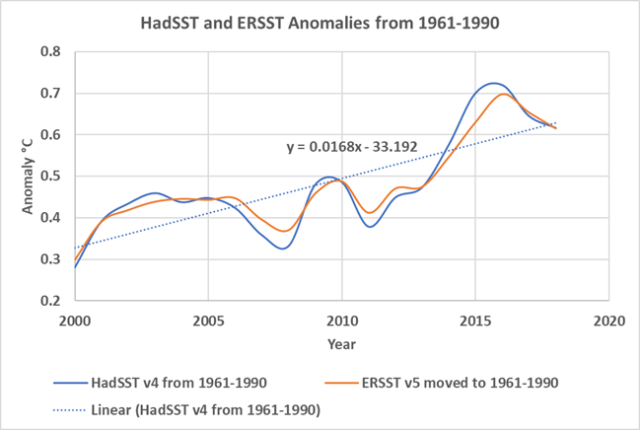

Die einzige Möglichkeit, mit diesen miserablen Daten eine positive Anomalie zu erhalten, besteht darin, monatliche Anomalien aus den Zellen mit vielen Messpunkten in diesem Monat zu erstellen und sie dann als einen Datensatz zu präsentieren. Aber es ist eine Aufzeichnung eines sich ständig ändernden Bereichs, was nützt das?

Weniger als die Hälfte des Ozeans hat gute Daten und diese Hälfte ändert sich ständig, da sich die Instrumente und Schiffe bewegen. Ich habe nur einen Jahresdurchschnitt gebildet, um saisonale Anomalien zu vermeiden. So ist die jährliche Durchschnittstemperatur der Zellen mit den besten Daten (wo auch immer sie sind) in den letzten 20 Jahren gesunken. Dies wurde in den letzten Stunden von Nick Stokes, einem australischen Klimatologen bei den WUWT-Kommentaren bestätigt.

Das Erzeugen von Anomalien, insbesondere die Art und Weise, wie HadSST und ERSST es getan haben, entfernt die gesamte zugrundeliegende Komplexität in den Daten und präsentiert eine irreführende Grafik, die auf sehr, sehr schlechten und nicht repräsentativen Daten basiert.

Meine persönliche Schlussfolgerung nach all dieser Arbeit? Wir haben keine Ahnung, was die durchschnittliche Temperatur des Weltozeans ist, noch wissen wir, ob er sich erwärmt oder abkühlt.

[Hervorhebung vom Übersetzer]