Widerlegung der Wissenschafts-Aussage der Geological Society of London zum Klimawandel

Interessanterweise enthält das Papier diesen Haftungsausschluss:

Datenverfügbarkeit

Datenfreigabe ist für diesen Artikel nicht anwendbar, da während der aktuellen Studie keine Datensätze generiert oder analysiert wurden.

Wissenschaftliche Stellungnahme der Geological Society of London

Die Autoren stellen viele Behauptungen auf, bieten aber wenig unterstützendes Material an. Es wimmelt von Übertreibungen und zumindest ein paar internen Widersprüchen. Das Konzept der Langzeitbetrachtung und der Verlust der [zeitlichen] Auflösung in der geologischen Aufzeichnung im Vergleich zu modernen instrumentellen Beobachtungen scheint völlig zu fehlen.

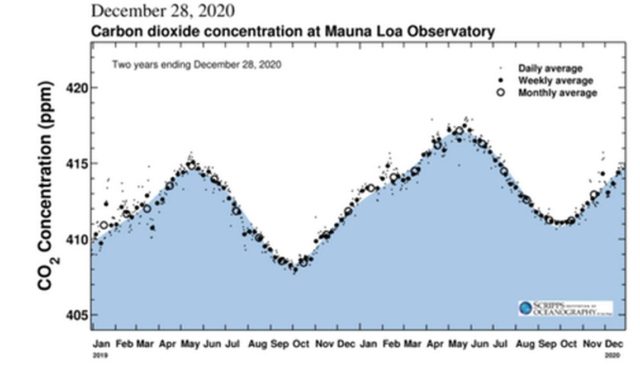

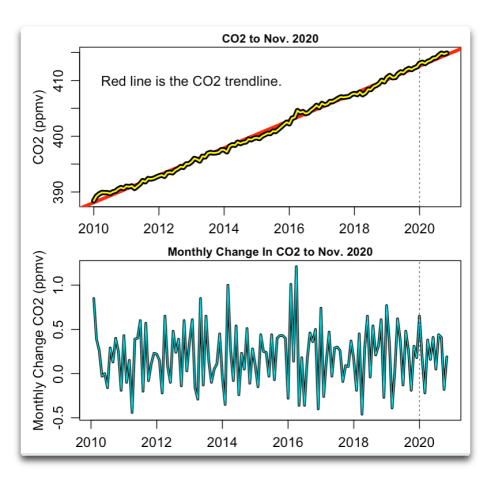

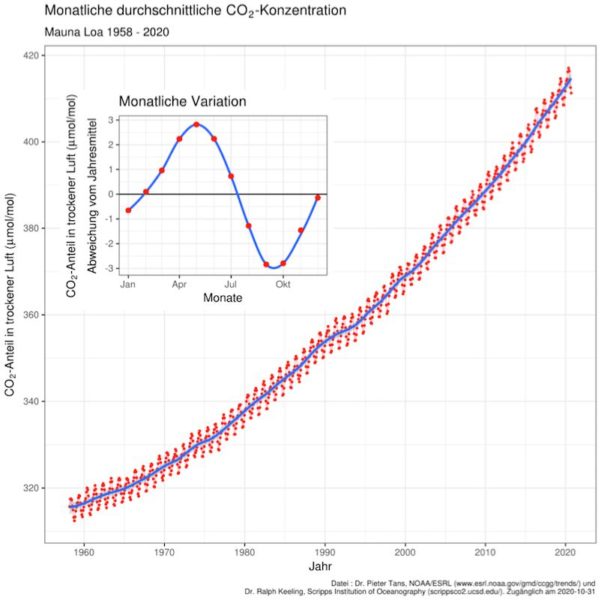

Atmosphärisches CO2

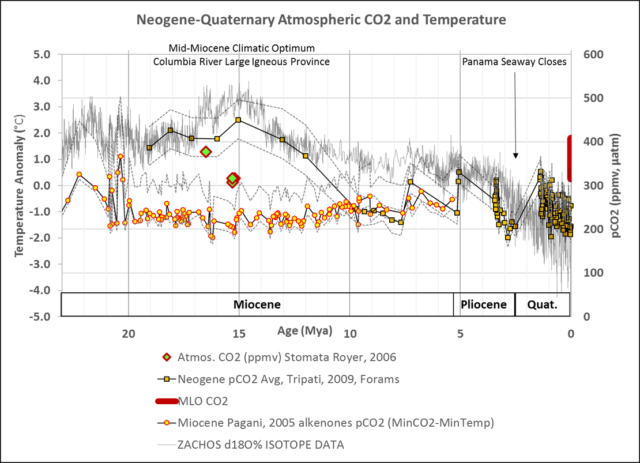

Beobachtungen aus der geologischen Aufzeichnung zeigen, dass die atmosphärischen CO2-Konzentrationen jetzt auf dem höchsten Stand seit mindestens 3 Millionen Jahren sind.

Wissenschaftliche Erklärung der Geological Society of London

Dies ist sehr wahrscheinlich wahr. Die atmosphärischen CO2-Konzentrationen könnten sogar jetzt auf dem höchsten Stand der letzten 12 Millionen Jahre sein.

Die geologische Aufzeichnung von atmosphärischem CO2 ist höchst unsicher, und wird immer unsicherer, je weiter wir in der Zeit zurückgehen. Diese Passage aus Evolution of the Earth (1976) ist heute genauso wahr wie damals, als wir Geologiestudenten im Pleistozän waren…

Leider können wir die Veränderungen des CO2-Gehalts in der Vergangenheit weder in der Atmosphäre noch in den Ozeanen genau abschätzen, und es gibt auch keine solide quantitative Grundlage für die Abschätzung des Ausmaßes des Rückgangs des Kohlendioxidgehalts, der notwendig ist, um eine Vergletscherung auszulösen. Außerdem ist das gesamte Konzept des atmosphärischen Treibhauseffekts umstritten, denn die Geschwindigkeit des Ausgleichs zwischen Ozean und Atmosphäre ist unsicher.

Dott & Batten, 1976

Obwohl sich die Verfahren zur Schätzung vergangener atmosphärischer CO2-Konzentrationen seit den 1970er Jahren verbessert haben, können wir nicht einmal sicher sein, dass die atmosphärische CO2-Konzentration während des viel wärmeren Klimatischen Optimums im Mittel-Miozän im Vergleich zu den extrem niedrigen Werten des Quartärs signifikant erhöht war.

Darüber hinaus ist die derzeitige Geschwindigkeit der vom Menschen verursachten CO2-Veränderung und Erwärmung fast ohne Beispiel in der gesamten geologischen Aufzeichnung, mit der einzigen bekannten Ausnahme des augenblicklichen, durch Meteoriten verursachten Ereignisses, das das Aussterben der nicht vogelartigen Dinosaurier vor 66 Millionen Jahren verursachte.

Wissenschaftliche Stellungnahme der Geological Society of London

Jeffrey Severinghaus und Kollegen wären über diese Aussage sehr überrascht. Sie zeigten, dass zu Beginn des Holozäns, vor etwa 11.700 Jahren, die Temperaturen der nördlichen Hemisphäre innerhalb weniger Jahrzehnte um „5 – 10ºC“ anstiegen (Severinghaus, Sowers, Brook, Alley, & Bender, 1998).

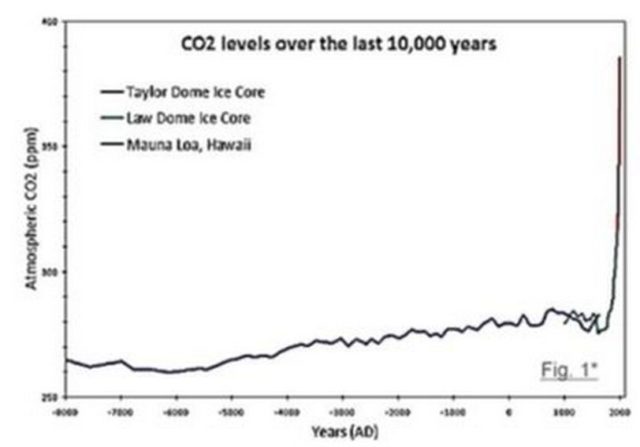

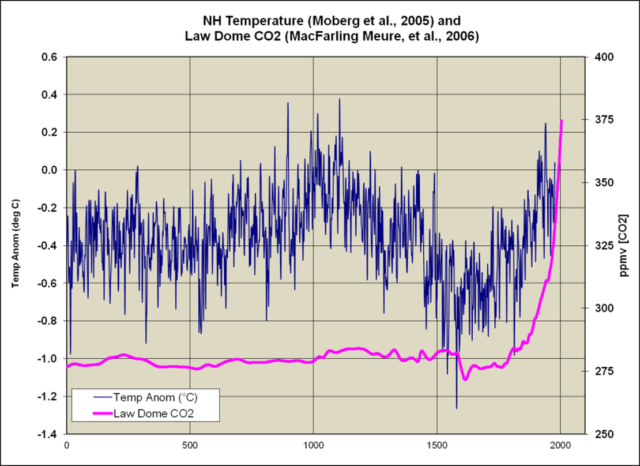

In Bezug auf CO2 ist dies möglich. Es gibt keine geologischen Aufzeichnungen von CO2-Änderungen, die eine ausreichende Auflösung haben, um diese Behauptung mit einem gewissen Grad an Sicherheit aufzustellen. Die einzige Ausnahme wären die Law-Dome-Eisbohrkerne in der Antarktis, die nur etwa 2.000 Jahre zurückreichen. Die mangelnde Auflösung der CO2– und Temperaturschätzungen der vorindustriellen Ära schränkt Vergleiche der geologischen Geschichte mit der Neuzeit stark ein.

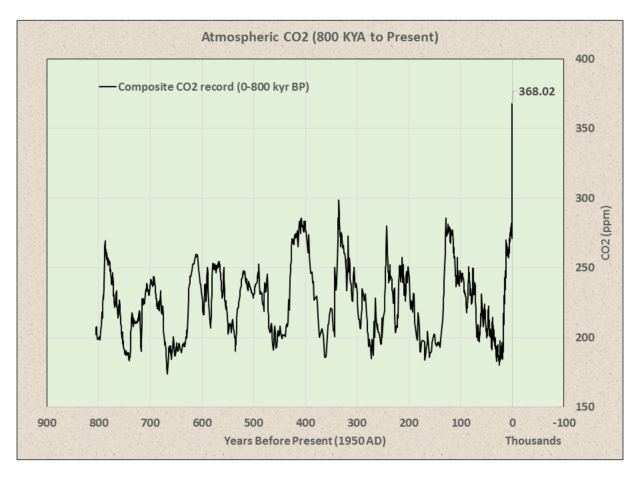

Dieser zusammengesetzte Eisbohrkern-CO2-Datensatz (0-800 kyr BP) von Bereiter et al. (2014) scheint einen sehr überzeugenden Hockeystick zu zeigen:

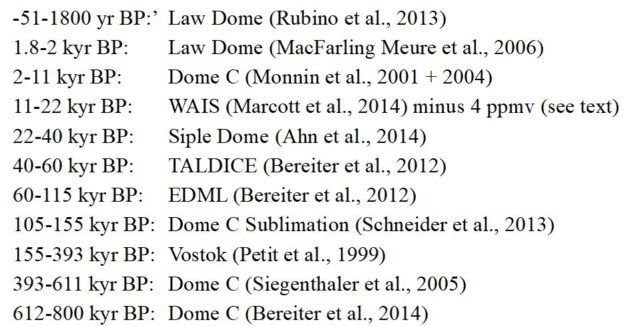

Das Komposit wurde aus folgenden Eisbohrkernen erstellt:

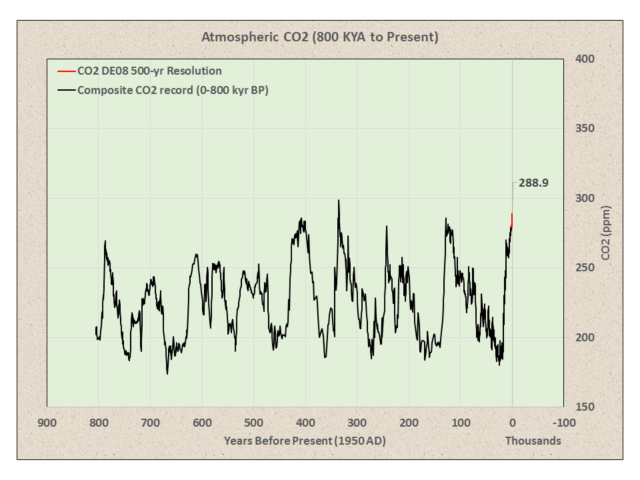

Diese Eisbohrkerne haben sehr unterschiedliche Auflösungen. Petit et al., 1999 geben an, dass die CO2-Auflösung für Vostok 1.500 Jahre beträgt. Lüthi et al., 2008 schlagen eine CO2-Auflösung von etwa 500 Jahren für Dome C vor. Es scheint, dass der hochauflösende Law Dome DE08-Kern einfach an die älteren Eiskerne mit niedrigerer Frequenz angeklebt wurde.

Wendet man auf den DE08-Eiskern Glättungsfilter an, um die Auflösung der niedriger aufgelösten Eiskerne anzugleichen, erhält man ein deutlich anderes Bild:

Die Eiskerne mit niedrigerer Frequenz sind nicht in der Lage, CO2-Verschiebungen im Jahrhundertmaßstab aufzulösen. Als solche können sie nicht verwendet werden, um die Möglichkeit von kurzzeitigen Schwankungen auszuschließen, die mit dem Anstieg des atmosphärischen CO2 im Industriezeitalter während des frühen Holozäns und Pleistozäns vergleichbar sind. Und sie widersprechen damit nicht den Schlussfolgerungen von Wagner et al., 1999:

Im Gegensatz zu konventionellen Eisbohrkern-Schätzungen von 270 bis 280 ppmv [parts per million by volume] legt das Signal der Stomatafrequenz nahe, dass die Kohlendioxid-Konzentration im frühen Holozän deutlich über 300 ppmv lag.

(…)

Die meisten der holozänen Eiskernaufzeichnungen aus der Antarktis haben keine ausreichende zeitliche Auflösung.

(…)

Unsere Ergebnisse falsifizieren das Konzept von relativ stabilen holozänen CO2-Konzentrationen von 270 bis 280 ppmv bis zur industriellen Revolution. SI [stomatal index]-basierte CO2-Rekonstruktionen könnten sogar darauf hindeuten, dass während des frühen Holozäns atmosphärische CO2-Konzentrationen, die 300 ppmv betrugen, eher die Regel als die Ausnahme gewesen sein könnten.

Wagner et al. (1999)

Oder Wagner et al., 2004:

Die Mehrheit der auf der Stomatafrequenz basierenden CO2-Schätzungen für das Holozän unterstützen nicht das weithin akzeptierte Konzept vergleichbar stabiler CO2-Konzentrationen während der letzten 11.500 Jahre. Um der Kritik zu begegnen, dass diese Stomata-Häufigkeitsschwankungen aus lokalen Umweltveränderungen oder methodischen Unzulänglichkeiten resultieren, wurden mehrere Stomata-Häufigkeitsaufzeichnungen für drei klimatische Schlüsselperioden während des Holozäns verglichen, nämlich die präboreale Oszillation, das 8.200 Jahre währende Abkühlungsereignis und die Kleine Eiszeit. Die hochgradig vergleichbaren Schwankungen in den paläoatmosphärischen CO2-Aufzeichnungen, die von verschiedenen Kontinenten und Pflanzenarten (sommergrüne Angiospermen sowie Nadelbäume) unter Verwendung unterschiedlicher Kalibrierungsansätze gewonnen wurden, liefern einen starken Beweis für die Integrität der blattbasierten CO2-Quantifizierung.

Wagner et al., 2004

Die GSL-Autoren präsentierten auch einen starken Widerspruch:

Kurz gesagt: Während die atmosphärischen CO2-Konzentrationen in der geologischen Vergangenheit aufgrund natürlicher Prozesse stark schwankten und oft höher waren als heute, ist die derzeitige Rate der CO2– (und damit Temperatur-) Veränderungen beispiellos in fast der gesamten geologischen Vergangenheit.

Wissenschaftliche Stellungnahme der Geological Society of London

Sie behaupten, dass „die aktuelle Rate der CO2– (und damit Temperatur-)Änderung beispiellos ist in fast der gesamten geologischen Vergangenheit“, um dann wenig später zu sagen:

Angesichts der Aufzeichnung vergangener Klimaveränderungen (Abschnitt 1) ist das Ausmaß der jüngsten beobachteten Klimaveränderungen nicht ungewöhnlich.

Wissenschaftliche Stellungnahme der Geological Society of London

Der moderne Klimawandel ist angeblich sowohl beispiellos als auch „nicht ungewöhnlich“. Sie scheinen CO2 und Temperatur zu verwechseln. Obwohl sie miteinander verwandt sind, sind sie nicht austauschbar.

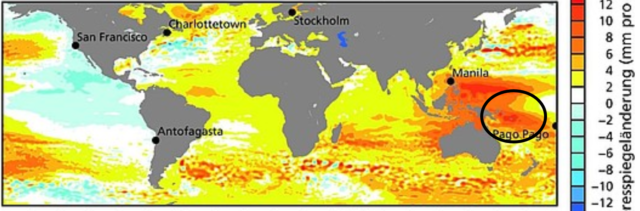

CO2 und Meeresspiegel

Sie stellen auch die Behauptung auf, dass die geologische Aufzeichnung eine Beziehung zwischen CO2 und Meeresspiegel zeigt.

Die geologischen Aufzeichnungen stimmen mit den Vorhersagen überein, dass das langfristige Ausmaß und die Geschwindigkeit des zukünftigen Meeresspiegelanstiegs sehr empfindlich auf zukünftige CO2-Emissionsszenarien reagieren und Intervalle mit sehr schnellem Anstieg enthalten können.

Wissenschaftliche Stellungnahme der Geological Society of London

Es gibt jedoch keine Beziehung zwischen CO2 und Meeresspiegel in den geologischen Aufzeichnungen:

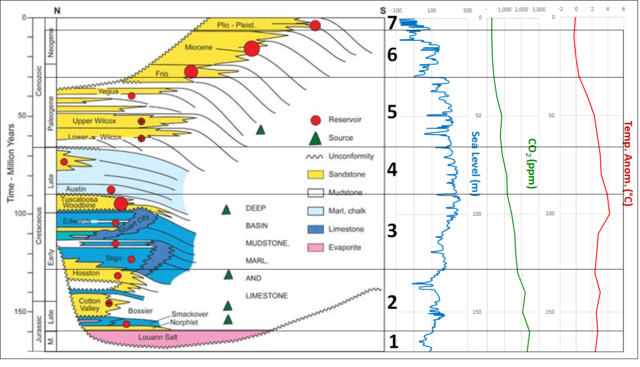

William Galloway von der Jackson School of Geosciences an der University of Texas hat die Ablagerungsgeschichte der Golfküste/des Golfs von Mexiko in dieser Arbeit zusammengefasst…

Die Ablagerungsgeschichte kann in sieben Phasen verallgemeinert werden: (1) Mittel- bis spätjurassische Evaporit- und Karbonatablagerung in einem breiten, flachen, auf ein offenes Meer beschränkten Becken. (2) Spätjurassisch-frühkreidezeitliche sandreiche klastische Progradation von den nördlichen Rändern. (3) Spät-frühkreidezeitliche Entwicklung eines umrandeten Karbonat-Schelfs. (4) Spätkreidezeitliche gemischte klastische und karbonatische Aggradation der Kontinentalränder. (5) Wiederauflebende paläogene klastische Progradation und Auffüllung mit Schwerpunkt im NW-Becken. (6) Miozäne Progradation und Beckenfüllung mit Schwerpunkt im zentralen und nordöstlichen Golf. (7) Spätneogene klimatisch und eustatisch beeinflusste Progradation entlang des zentralen Golfrandes. Im Gegensatz zu dem breiten, progradierenden Sedimentkeil des nördlichen Golfs ist der Florida-Rand eine primär aggradierende Karbonatplattform.

[Linguee-Übersetzer. Anm. d. Übers.]

Abbildung 4 zeigt deutlich die Bedeutung von Klima, atmosphärischem CO2 und Meeresspiegelzyklen in der Ablagerungsgeschichte der US-Golfküste/des Golfs von Mexiko; aber keine Korrelation von CO2 und Meeresspiegel. Beachten Sie, dass die meisten der Ausgangsgesteinsformationen abgelagert wurden, als das atmosphärische CO2 über 1.000 ppm lag und die Erde wesentlich wärmer war als heute, was auf mehr pflanzliches Leben in den wärmeren, CO2-reichen Zeiten schließen lässt.

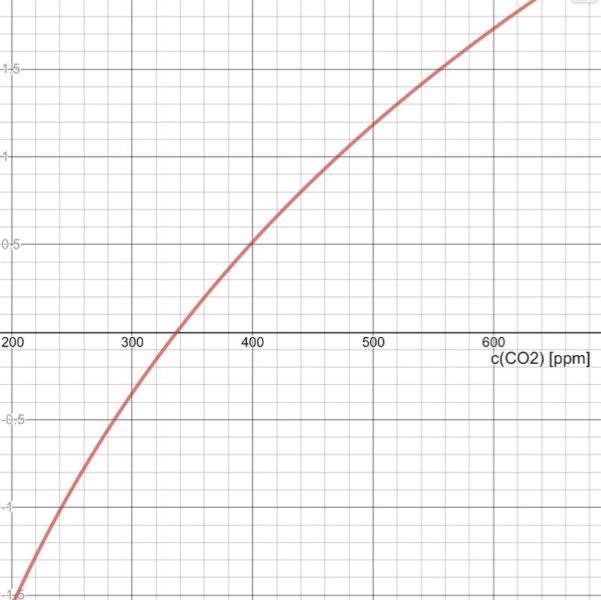

Die Temperatur- und CO2-Diagramme haben eine Auflösung von 10 Millionen Jahren; sie sind stark geglättet. Diese spezielle Temperatur-Rekonstruktion (Royer et al., 2004) beinhaltet eine pH-Anpassung, abgeleitet von CO2. Sie demonstriert eine relativ gute Korrelation zwischen CO2 und Temperatur auf einer geologischen Zeitskala. Ein Cross-Plot ergibt jedoch nur eine Gleichgewichts-Klimasensitivität (ECS) von etwa 1,28 °C.

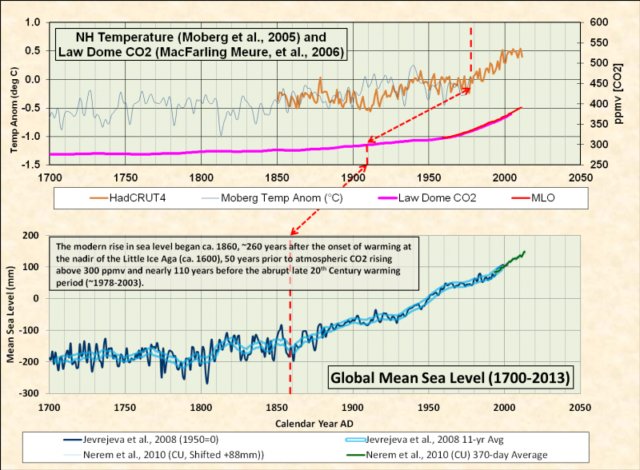

Die moderne Erwärmungsperiode begann am Tiefpunkt der Kleinen Eiszeit (ca. 1600 n. Chr.), der kältesten Periode des Holozäns. Dies war 300 Jahre bevor das atmosphärische CO2 den vermuteten normalen vorindustriellen Bereich deutlich überschritt.

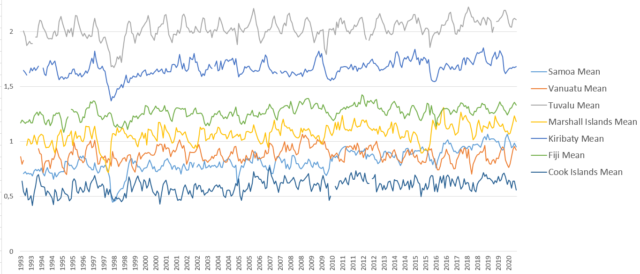

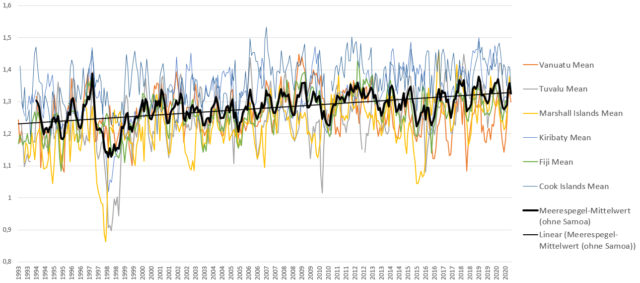

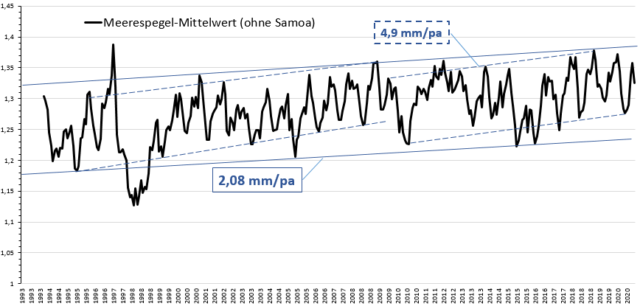

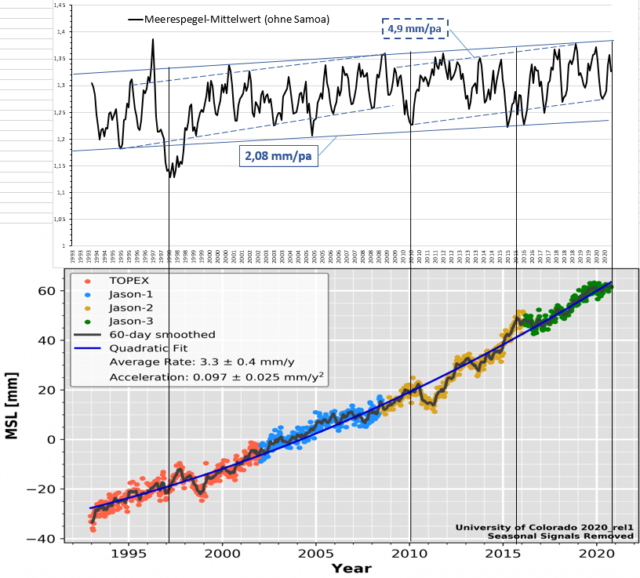

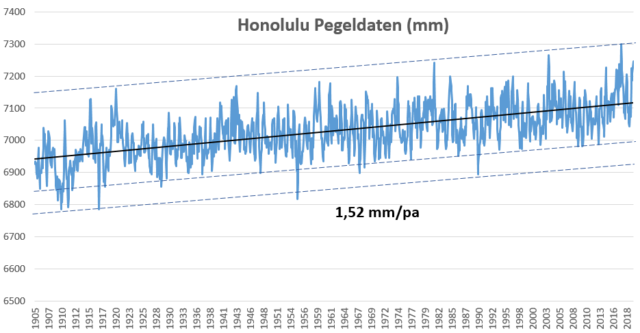

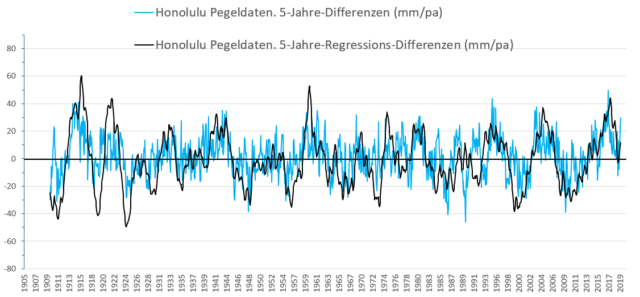

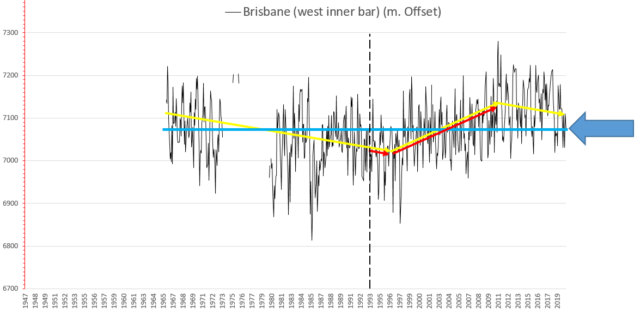

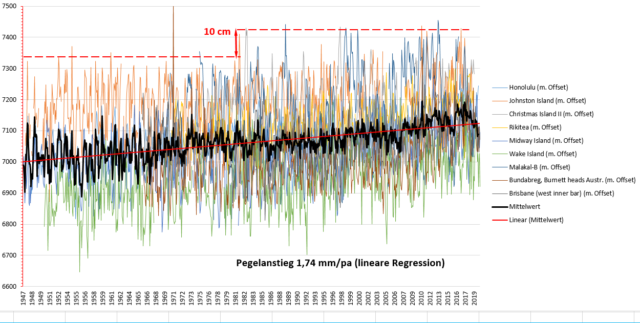

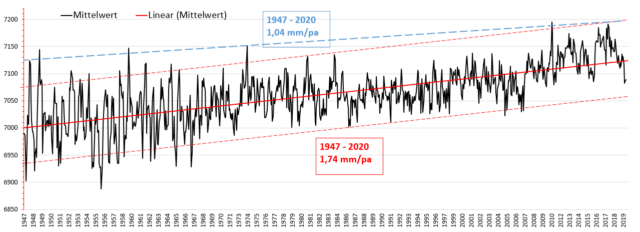

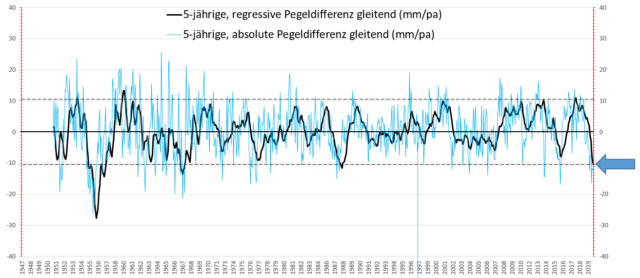

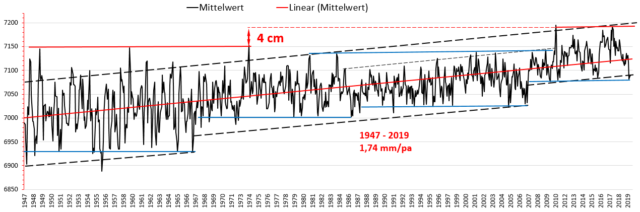

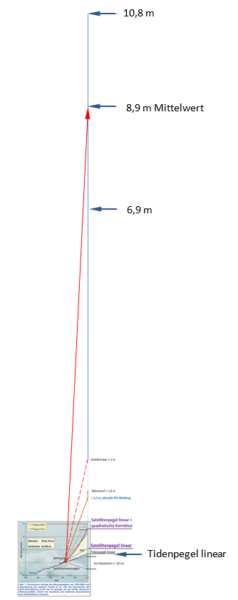

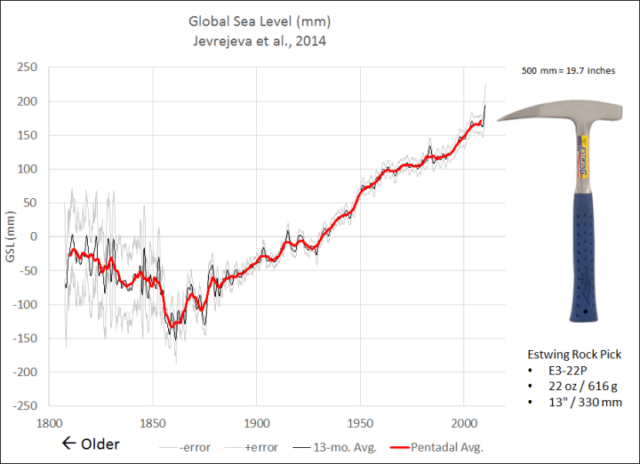

Der moderne Anstieg des Meeresspiegels begann am Ende der Neoglazialzeit. Die Meeresspiegel-Rekonstruktion von Jevrejeva et al., 2014 (J14) zeigt, dass der Meeresspiegel in den frühen 1800er Jahren sank:

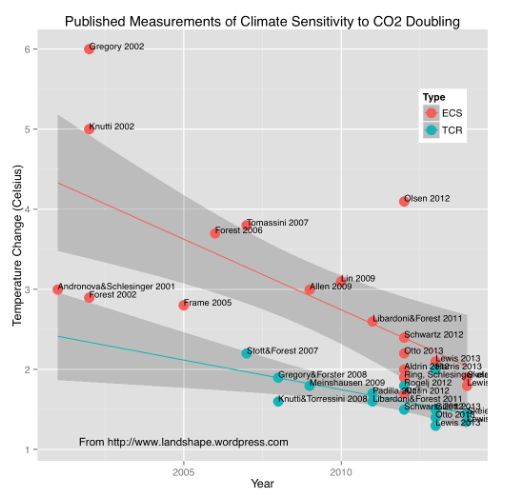

Klima-Sensitivität (ECS)

Der IPCC (2014) gab eine 66%ige Wahrscheinlichkeit an, dass der ECS-Wert zwischen 1,5 und 4,5°C liegt. …

Um ECS aus der geologischen Aufzeichnung abzuschätzen, werden quantitative gepaarte Aufzeichnungen von atmosphärischem CO2 und globaler Temperatur aus Proxies benötigt …

Viele Studien der geologischen Vergangenheit haben den kanonischen Bereich für ECS von 1,5-4,5°C unterstützt

Wissenschaftliche Stellungnahme der Geological Society of London

Die erste, im Charney-Report 1979 veröffentlichte moderne Schätzung des ECS lag bei 1,5 bis 4,5 Grad Celsius pro Verdoppelung des CO2. Mit anderen Worten, der „kanonische Bereich“ hat sich seit über 40 Jahren nicht verändert. Moderne empirische Schätzungen von ECS, basierend auf instrumentellen Daten, liegen zwischen 0,44 Grad C (Lindzen und Choi, 2011) und 1,6 (Lewis und Curry, 2018). Diese Schätzungen beruhen auf hochauflösenden CO2– und Temperaturdaten, was bei geologischen Schätzungen nicht der Fall ist.

Auch wenn die geologischen Schätzungen des ECS höher sein könnten – die GSL sagt, dass die geologischen Schätzungen im Bereich von 2,6 bis 3,9 Grad liegen – können wir uns mit der Genauigkeit oder Präzision dieser Schätzungen nicht anfreunden. Die Daten, insbesondere die CO2-Daten, sind zu schlecht.

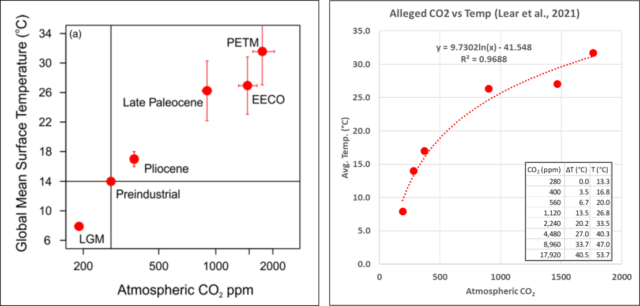

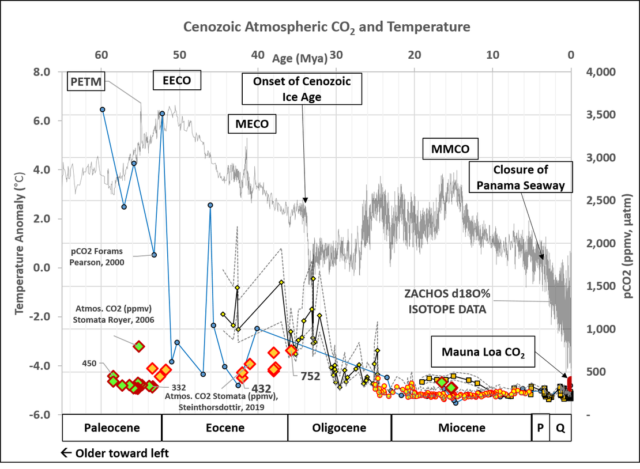

Außerdem präsentieren die Autoren eine Karikatur, die scheinbar eine starke Korrelation von CO2 und Temperatur über das Känozoikum darstellt:

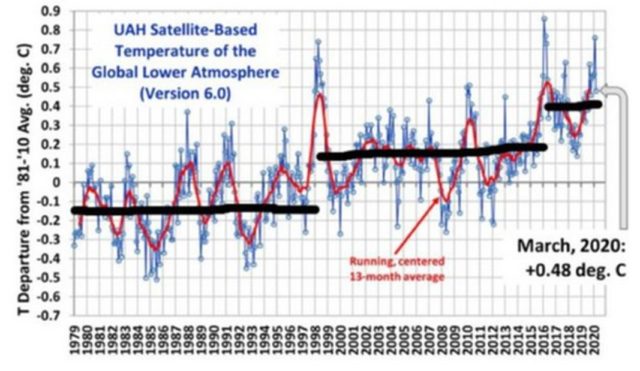

Die GSL-Karikatur zeigt eine Klimasensitivität von fast 7°C pro CO2-Verdoppelung. Dies würde zu einer Erwärmung von etwa 3,5 °C seit Mitte der 1800er Jahre führen, die eindeutig nicht stattgefunden hat. Moderne hochauflösende instrumentelle Messungen ergeben eine viel geringere Klimasensitivität.

Parallelen i n den geologischen Aufzeichnungen

Die Autoren versuchen, aus den geologischen Aufzeichnungen Parallelen zum gegenwärtigen Klimawandel zu finden:

Im mittleren Pliozän (vor 3,3-3,1 Millionen Jahren) lagen die atmosphärischen CO2-Konzentrationen zwischen 389 (-8 bis +38) ppm und 331 (-11 bis +13) ppm (de la Vega et al. 2020), was höher ist als die vorindustriellen Werte von ca. 280 ppm und etwas niedriger als die heutigen Werte (ca. 407,4 ± 0,1 ppm im Jahr 2018). Die kontinentalen Konfigurationen der Erde, die Landerhebungen und die Bathymetrie der Ozeane waren alle ähnlich wie heute (Haywood et al. 2016). Das Pliozän war durch mehrere Intervalle gekennzeichnet, in denen das orbitale Forcing dem der Neuzeit ähnlich war und bietet uns daher ein nahes Analogon zum Klima unter modernen CO2-Konzentrationen (McClymont et al. 2020). Während dieses Intervalls waren die globalen Temperaturen ähnlich wie die für das Jahr 2100 vorhergesagten (+2,6 bis 4,8 °C im Vergleich zur vorindustriellen Zeit) unter einem Business-as-usual-Szenario (d. h. ohne den Versuch, die Emissionen zu verringern). Mehrere Arbeitslinien deuten auf Ähnlichkeiten zwischen der modellierten Ozeanzirkulation der Zukunft und derjenigen der Warmzeit des mittleren Pliozäns hin, mit einer schwächeren thermohalinen Zirkulation, die mit der Erwärmung und Schichtung des oberen Ozeans zusammenhängt, aber auch mit einem Rückgang der Eisschilde und des Meereises, einer polwärts gerichteten Verschiebung der terrestrischen Biome und einer schwächeren atmosphärischen Zirkulation (Haywood and Valdes 2004; Cheng et al. 2013; Corvec and Fletcher 2017; Fischer et al. 2018). Der pliozäne Meeresspiegel könnte bis zu 20 m über dem heutigen Wert gelegen haben und im Durchschnitt um 13 ± 5 m über die pliozänen Glazial-Interglazial-Zyklen variiert haben, in Verbindung mit Schwankungen in der Ausdehnung des antarktischen Eisschildes (Grant et al. 2019).

Geological Society of London Wissenschaftliche Stellungnahme

Während „die kontinentalen Konfigurationen der Erde, die Landerhebungen und die Bathymetrie der Ozeane“ während des Pliozäns der heutigen Zeit ähnlicher waren als in früheren Zeitabschnitten, war es im mittleren Pliozän aufgrund tektonischer Unterschiede deutlich wärmer als heute. Der Panama-Seeweg war noch offen und ermöglichte einen viel effizienteren Wärmetransport durch den Ozean. Signifikante Hebungsepisoden in den Rocky Mountains und im Himalaya während des Pleistozäns waren auch treibende Faktoren für die Abkühlung der Erde in den letzten 2 Millionen Jahren.

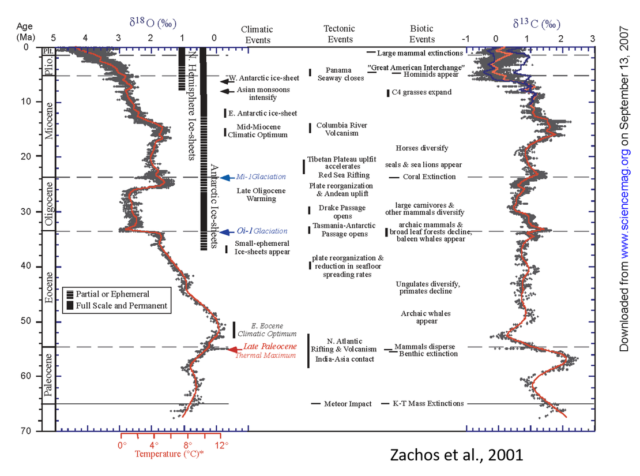

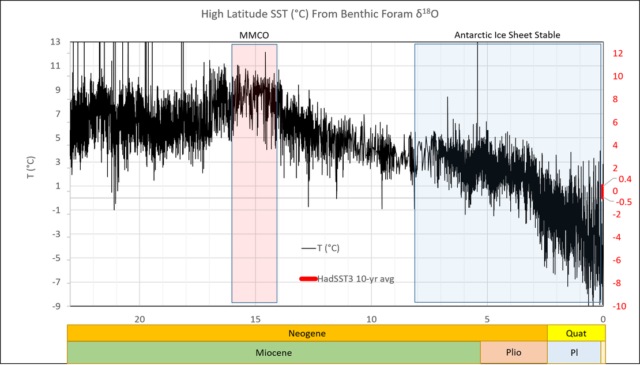

Die geologischen Aufzeichnungen informieren uns darüber, dass die großen klimatischen Verschiebungen des Känozoikums mit tektonischen Veränderungen korreliert waren.

Die Temperaturen in Abbildung 9 wurden aus δ18O in benthischen Foraminiferen unter Verwendung eines Modells ohne Meereis abgeleitet. Salzgehalt und Eisvolumen haben einen Einfluss auf die Umrechnung. Diese Temperaturen sind nur auf das untere Tertiär, das Warmhausklima, anwendbar.

Diese Behauptung über das Pliozän als Präzedenzfall für den modernen Klimawandel ist offenkundig lächerlich:

Während dieses Intervalls waren die globalen Temperaturen ähnlich wie die für das Jahr 2100 vorhergesagten (+2,6 bis 4,8 °C im Vergleich zum vorindustriellen Zeitalter) unter einem Business-as-usual-Szenario (d. h. ohne den Versuch, die Emissionen zu verringern).

Wissenschaftliche Stellungnahme der Geologischen Gesellschaft von London

Sie betrachten RCP8.5 eindeutig als „business as usual“.

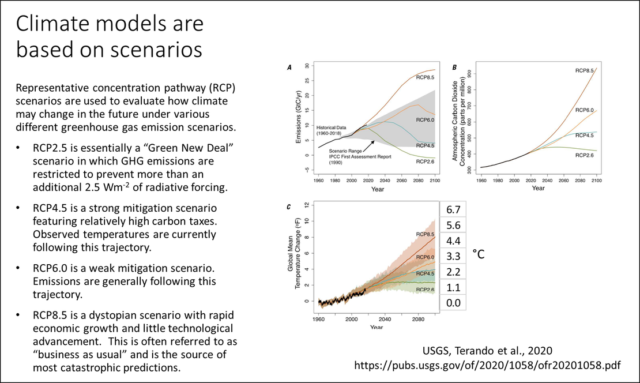

[Bildinschrift: Klimamodelle beruhen auf Szenarien:

RCP-Szenarien werden herangezogen, um zu evaluieren, wie sich das zukünftige Klima unter verschiedenen unterschiedlichen Szenarien von Treibhausgas-Emissionen ändern könnte:

● Das RCP2.5 entspricht im Wesentlichen dem „Green New Deal“-Szenario, welchem zufolge die Emissionen darauf begrenzt sind, einen zusätzlichen Strahlungsangtrieb von mehr als 2,5W/m² zu verhindern.

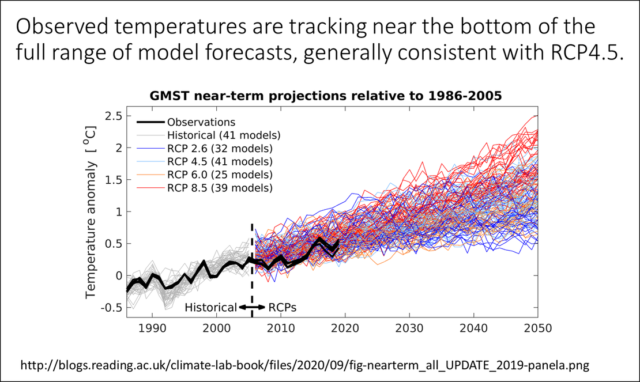

● Das RCP4.5 ist ein Szenario starker Abschwächung, etwa durch relativ hohe Kohlenstoff-Steuern. Gemessene Temperaturen folgen derzeit dieser Trajektorie.

● Das RCP6.0 ist ein Szenario geringer Abschwächung. Die Emissionen folgen allgemein dieser Trajekgtorie.

● Das RCP8.5-Szenario ist ein dystopisches Szenario mit rapidem wirtschaftlichen Wachstum und nur geringen technologischen Fortschritten. Dies wird oftmals als „business as usual“ angesehen und ist die Quelle der meisten Katastrophen-Prophezeiungen.]

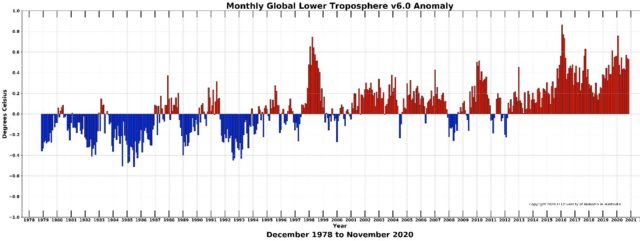

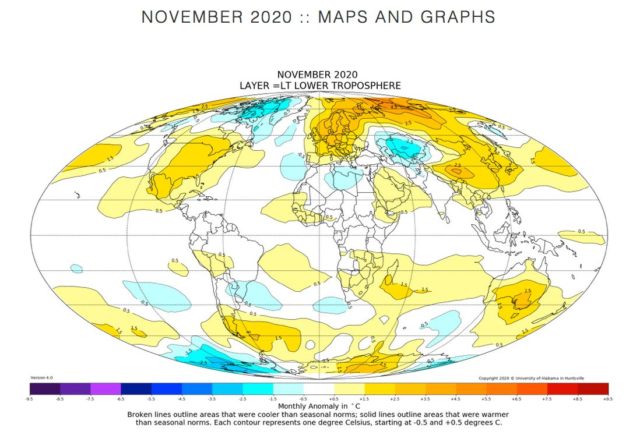

Betrachtet man jedoch die gesamte Bandbreite der Modell-Simulationen, wird klar, dass das Klima mehr dem RCP4.5 als dem RCP8.5 folgt.

Selbst bei einer zusätzlichen Erwärmung von 0,5 bis 1,0 °C bis zum Ende dieses Jahrhunderts wird sich das Klima immer noch im Bereich der pleistozänen Zwischeneiszeitstadien befinden, also deutlich unter dem mittleren Pliozän.

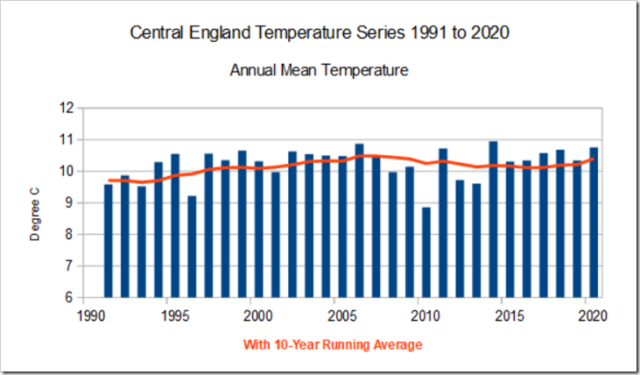

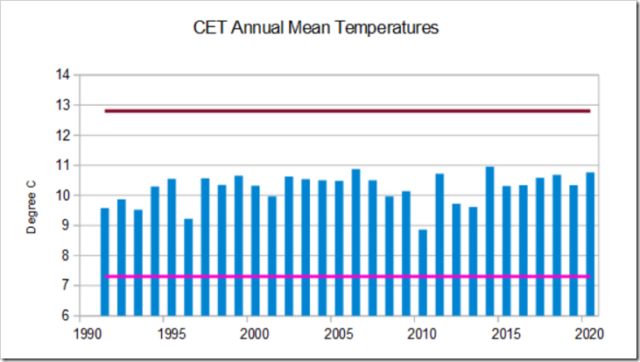

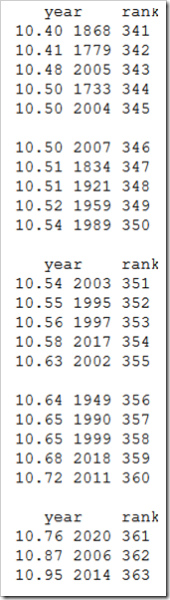

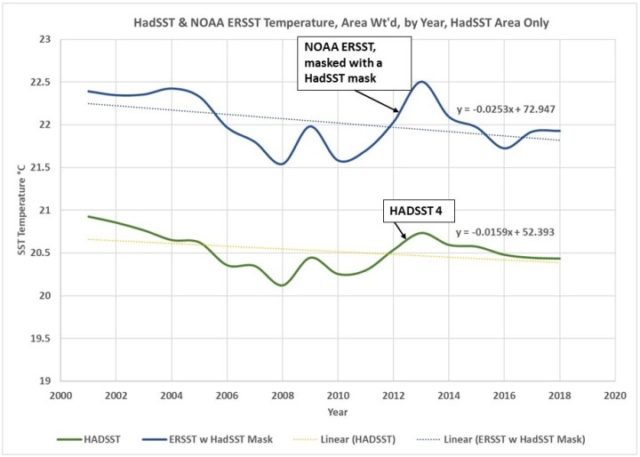

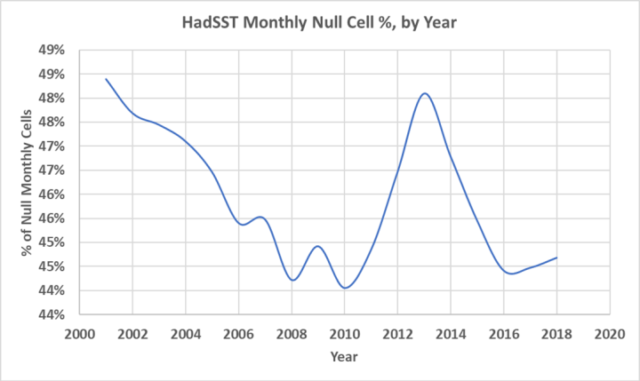

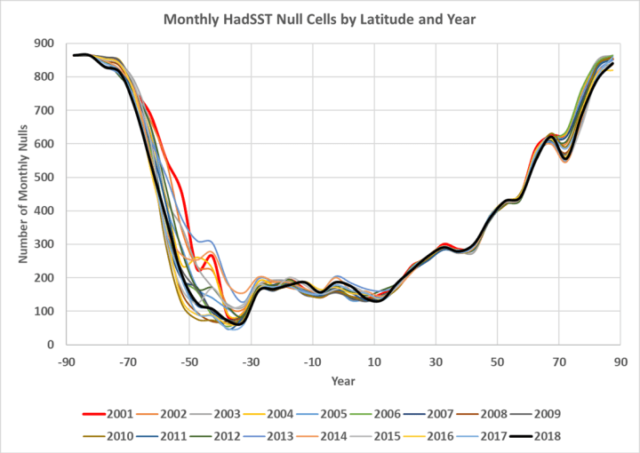

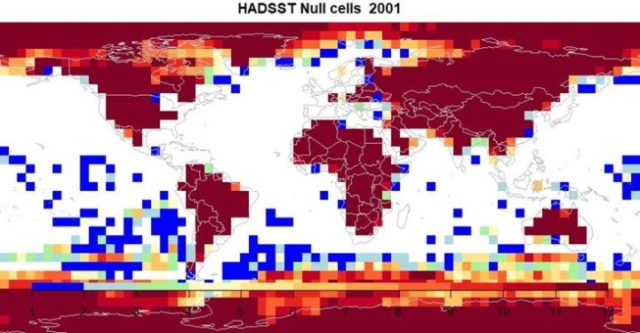

Es kommt alles auf den Kontext und die Auflösung an

Beachten Sie, dass die Auflösung der δ18O-Temperaturrekonstruktion viel geringer ist als die der instrumentellen Aufzeichnung und das HadSST-Signal nicht auflösen würde. Noch einmal: Die geologische Aufzeichnung liefert ein allgemeines Bild des vergangenen Klimawandels, kann aber nicht direkt mit hochauflösenden instrumentellen Aufzeichnungen verglichen werden, ohne sie explizit in den Kontext zu setzen. Die moderne Erwärmung erscheint nur aufgrund der höheren Auflösung der instrumentellen Aufzeichnungen und ihrer Position am Ende der Zeitreihe anomal.

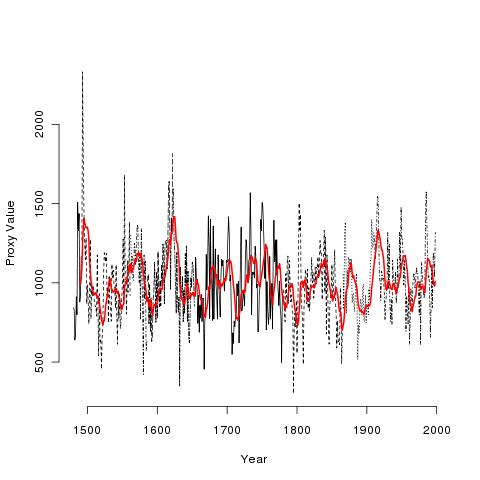

Ljungqvist (2010) hat das Problem durch den direkten Vergleich von instrumentellen Daten mit Proxy-Rekonstruktionen deutlich erklärt.

Die Amplitude der rekonstruierten Temperaturvariabilität auf hundertjährigen Zeitskalen überschreitet 0,6°C. Diese Rekonstruktion ist die erste, die eine ausgeprägte Römische Warmzeit von ca. 1-300 n. Chr. zeigt, die bis zum mittleren Temperaturniveau von 1961-1990 reicht, gefolgt von der Dunkelzeit-Kaltzeit von ca. 300-800 n. Chr. Die mittelalterliche Warmzeit wird ca. 800-1300 n. Chr. gesehen und die kleine Eiszeit ist ca. 1300-1900 n. Chr. deutlich sichtbar, gefolgt von einem raschen Temperaturanstieg im 20 Jahrhundert. Die höchsten Durchschnittstemperaturen in der Rekonstruktion werden in der Mitte bis zum Ende des zehnten Jahrhunderts angetroffen und die niedrigsten im späten siebzehnten Jahrhundert. Die dekadischen Mitteltemperaturen scheinen während wesentlicher Teile der Römischen Warmzeit und der Mittelalterlichen Warmzeit das Niveau der Mitteltemperatur von 1961-1990 erreicht oder überschritten zu haben. Die Temperatur der letzten zwei Jahrzehnte ist jedoch möglicherweise höher als während jeder früheren Zeit in den letzten zwei Jahrtausenden, obwohl dies nur in den instrumentellen Temperaturdaten und nicht in der Multi-Proxy-Rekonstruktion selbst zu sehen ist.

(…)

Die Proxy-Rekonstruktion selbst zeigt keine solch beispiellose Erwärmung, aber wir müssen bedenken, dass nur wenige der in der Rekonstruktion verwendeten Aufzeichnungen bis in die 1990er Jahre reichen. Nichtsdestotrotz wird eine sehr vorsichtige Interpretation des Niveaus der Erwärmung seit 1990 n. Chr. im Vergleich zu den Spitzenwerten der Erwärmung während der römischen Warmzeit und der mittelalterlichen Warmzeit dringend empfohlen.

(… )

Die Amplitude der hier rekonstruierten Temperaturvariabilität auf dekadischen bis hundertjährigen Zeitskalen sollte vermutlich als das Minimum der wahren Variabilität auf diesen Zeitskalen betrachtet werden.

Ljungqvist, 2010

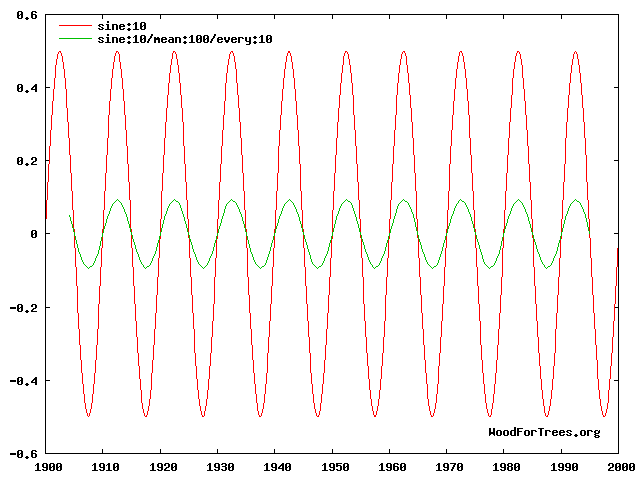

Direkte Vergleiche der modernen instrumentellen Aufzeichnung mit den älteren Proxy-Rekonstruktionen sind nicht robust, weil die Proxy-Daten eine viel geringere Auflösung haben. Die Proxydaten zeigen das „Minimum der wahren Variabilität auf diesen Zeitskalen.“ Die Instrumenten-Daten bilden etwas ab, das näher an der tatsächlichen Variabilität liegt.

Den Proxydaten fehlt die Hochfrequenz-Komponente des Signals. Wenn die Hochfrequenz-Komponente eines Signals herausgefiltert wird, schwächt dies die Amplitude ab. Das ist grundlegende Signaltheorie:

Der direkte Vergleich von Instrumentaldaten mit Proxydaten wird noch problematischer, wenn die Aufzeichnungslänge über 2.000 Jahre hinaus verlängert wird:

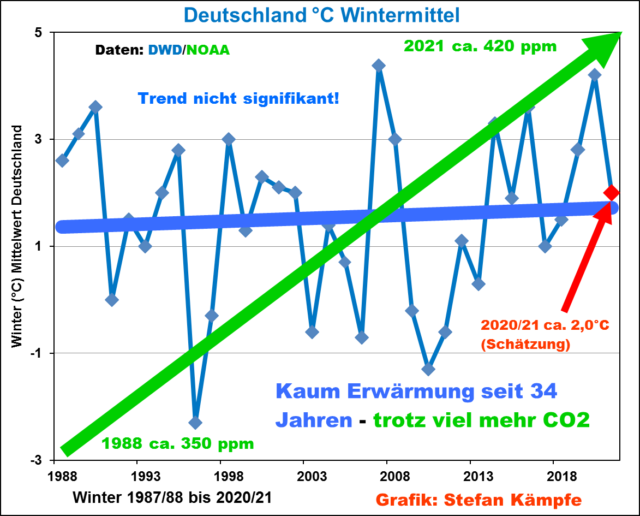

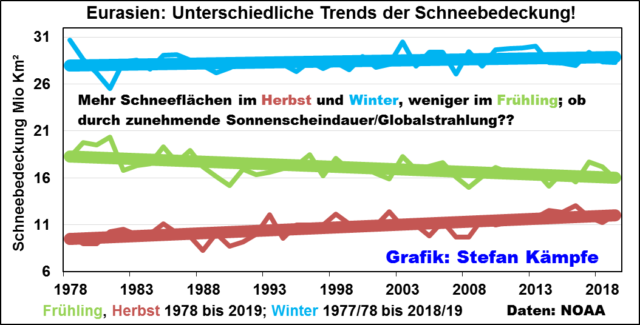

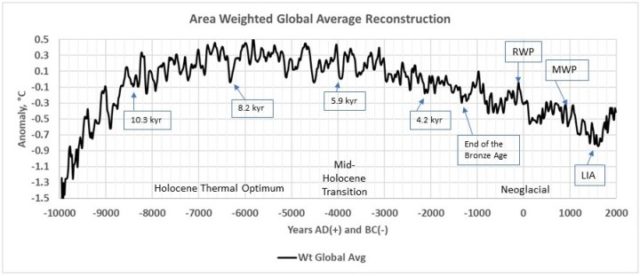

Die vermeintlich „vier wärmsten Jahre seit Beginn der Aufzeichnungen“ sind nur etwa 300 Jahre nach dem kältesten Jahrhundert der letzten 100 Jahrhunderte aufgetreten. Dies könnte nur von jemandem als „Klimakrise“ oder „Klimanotstand“ bezeichnet werden, der sich mit den wissenschaftlichen Grundlagen der Quartärgeologie und der Signalverarbeitung nicht auskennt.

Je länger die Datensatzlänge der Rekonstruktion, desto wichtiger wird die Konsistenz der zeitlichen Auflösung.

„Konsistenz der zeitlichen Auflösung“ bedeutet, dass die Auflösung der älteren Proxies mit den jüngeren Proxies konsistent ist. Die zeitliche Auflösung ist eine Funktion des Stichprobenintervalls…

Wir glauben, dass die größere Fehlerquelle in diesen Rekonstruktionen in der Auswahl der Proxies liegt. Wie in dieser Serie dokumentiert, sind einige der ursprünglichen 73 Proxies von Auflösungsproblemen betroffen, die bedeutende klimatische Ereignisse verbergen, und einige sind von lokalen Bedingungen betroffen, die keine regionale oder globale Bedeutung haben. Andere decken kurze Zeitspannen ab, die die beiden wichtigsten klimatischen Merkmale des Holozäns, die Kleine Eiszeit und das Holozäne Klimaoptimum, nicht abdecken.

(…)

Wir haben auch Proxies mit langen Stichprobenintervallen (größer als 130 Jahre) vermieden, weil sie dazu neigen, die Auflösung der Rekonstruktion zu verringern und wichtige Details abzuschwächen („auszugleichen“). Der kleinste Klimazyklus beträgt etwa 61 bis 64 Jahre, die sogenannte „Stadionwelle“, und wir wollen versuchen, ihrem Einfluss nahe zu kommen. In dieser einfachen Rekonstruktion haben wir versucht, diese Probleme zu berücksichtigen.

Für zusätzliche Lektüre zur Auflösung, siehe: Auflösung und Hockeyschläger, Teil 1.

Diskussion

Während geologische Daten bei der Untersuchung des Klimas sehr hilfreich sind, wie die GSL sagt, wird die Interpretation der Bedeutung des modernen Klimawandels wahrscheinlich nicht von geologischem Input profitieren. Die Erwärmung über das 20. Jahrhundert beträgt nur etwa ein Grad und die Erwärmung seit 1950, die vom IPCC als Richtwert verwendet wird, beträgt nur etwa 0,7 Grad. Die geologischen Zeiträume sind größer als 1.000 Jahre, wie das GSL-Papier feststellt, und die daraus folgenden Erwärmungs- und Abkühlungsereignisse in der geologischen Aufzeichnung sind größer als fünf Grad. Die geologischen Daten, die wir haben, sind sehr niedrig aufgelöst und werden sich wahrscheinlich nicht verbessern. Das Hauptproblem ist, dass die jüngste Erwärmung auf einer geologischen Skala unbedeutend ist.

[Hervorhebung vom Übersetzer]

Wie oben beschrieben, sind die CO2-Daten niedriger aufgelöst und weniger genau als die Temperaturdaten. Wir haben gesehen, dass der Vergleich von Temperatur-Proxydaten über die letzten 2.000 Jahre mit modernen instrumentellen Daten unangemessen ist, und es ist noch weniger angemessen, geologische Daten mit der modernen instrumentellen Aufzeichnung zu vergleichen. Weder das Ausmaß der jüngsten Erwärmung noch die jüngsten CO2-Konzentrationsänderungen sind über geologische Zeiträume hinweg ungewöhnlich.

Geowissenschaftler haben die Verantwortung, den geologischen Kontext des Klimawandels zu vermitteln, anstatt zu behaupten, dass jede Beobachtung, die nicht in der geologischen Aufzeichnung auflösbar ist, beispiellos und Grund für eine wirtschaftlich zerstörerische Regierungspolitik ist. Es sollte ausreichen zu sagen, dass die anthropogenen CO2-Emissionen wahrscheinlich die Ursache für den größten Teil des Anstiegs von ~280-400 ppm in den letzten 200 Jahren sind und dass dies einen Netto-Erwärmungseffekt auf die Atmosphäre hat. Obwohl so ziemlich jede aktuelle, auf Beobachtungen basierende Schätzung darauf hinweist, dass der Erwärmungseffekt minimal ist.

Obwohl es keinen „Klimanotstand“ gibt, existieren wirtschaftlich gangbare Wege, um die Kohlenstoffintensität unserer Energieproduktion zu reduzieren und das endgültige Wachstum des atmosphärischen CO2 auf ~600 ppm bis zum Ende dieses Jahrhunderts zu begrenzen. Dies würde uns im „Rauschpegel“ des Känozoikums halten.

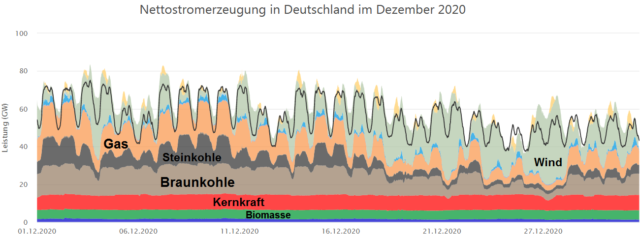

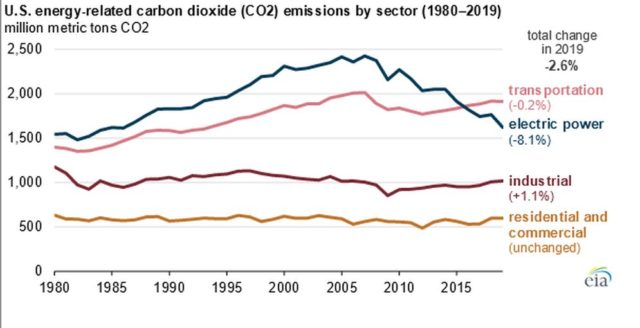

Anstatt Fristen für „Netto-Null-Emissionen“ und andere unerreichbare und willkürliche Kriterien festzulegen, sollte der Schwerpunkt auf der Reduktion der Kohlenstoffintensität der Energieerzeugung auf wirtschaftlich nachhaltige Weise liegen. Die Vereinigten Staaten haben dies, größtenteils durch unseren privaten Sektor, bereits getan. Die CO2-Emissionen bei der Stromerzeugung in den USA sind auf das Niveau der 1980er Jahre gesunken, was vor allem auf den Ersatz von Kohle- durch Erdgas-Strom zurückzuführen ist.

Geowissenschaftler werden in diesem Prozess eine entscheidende Rolle spielen, indem sie weiterhin wirtschaftlich förderbare Öl- und Gasreserven finden, die Methoden der geologischen Kohlenstoffabscheidung und -speicherung verbessern, den Weg für die Erweiterung unseres Zugangs zu der riesigen Bandbreite an mineralischen Ressourcen ebnen, die für den Ausbau der „erneuerbaren Energien“ (Wind und Sonne), Batterie- und andere Speichertechnologien benötigt werden, und die sichere geologische Entsorgung von nuklearen Abfallprodukten fördern, und all dies auf die sicherste Art und Weise, mit so wenig Umweltbelastung wie möglich. Wirtschafts-Geowissenschaftler in den Bereichen Öl & Gas und Mineralien sind aufgrund ihrer Erfahrung mit der Projektökonomie besonders gut positioniert, um den Weg zu weisen.

Energie, Wirtschaft und Umwelt sind untrennbar miteinander verbunden. Ohne erschwingliche, zuverlässige Energie kann eine Gesellschaft nicht die wirtschaftlichen Mittel haben, die Umwelt zu schützen. Nichts korreliert stärker mit menschlichem Wohlstand und einer sauberen Umwelt als der billige Zugang zu Energie (May, Climate Catastrophe! Science or Science Fiction?, 2018, S. 7, 18). Für eine Diskussion über Energie und Armut siehe hier.

[Hervorhebung vom Übersetzer]

Der texanische Staatsgeologe und Direktor des Bureau of Economic Geology Scott Tinker hat es in diesem Editorial über Kohlenstoff-Bepreisung sehr gut zusammengefasst:

Kohlenstoff-Bepreisung ist kein Allheilmittel für Klimawandel

Scott Tinker, 23. August 2019

Heute wird viel über die Bepreisung von Kohlendioxid gesprochen, um die CO2-Emissionen zu reduzieren und den Klimawandel zu bekämpfen. Anders als viele Umweltschadstoffe, die eine lokale oder regionale Auswirkung haben, ist Kohlendioxid (CO2) global – es gibt nur eine Atmosphäre. Wenn Maßnahmen zur Reduzierung der atmosphärischen Emissionen in einer Region zu erhöhten Emissionen an anderer Stelle führen, dann gilt das für die gesamte Atmosphäre.

Eine Form der Kohlenstoff-Bepreisung – -steuer, -handel, -gutschriften – wird von vielen Politikern, NGOs, Akademikern und sogar einigen in der Industrie favorisiert. Aber die Realität ist, dass ein Preis für Kohlenstoff von den Entwicklungs- und Schwellenländern nicht durchgesetzt werden wird, weil er ihre Energie teurer macht, und sie zu sehr damit beschäftigt sind, ihre Wirtschaft aufzubauen und sich aus der Armut zu befreien.

In den Industrieländern verteuert die Bepreisung von Kohlenstoff die Herstellung und die Produkte, was wiederum die Produktion in die Entwicklungsländer treibt, wo sie aufgrund niedrigerer Arbeitskosten und weniger strenger Umweltvorschriften und Emissionsstandards günstiger ist. Die globalen Emissionen steigen in der einen gesamten Atmosphäre.

Anders ausgedrückt: Die guten Absichten der Kohlenstoffbepreisung haben einen unbeabsichtigten negativen Einfluss auf den Klimawandel. Dies ist nicht hypothetisch. Es ist Realität.

Wenn die Kohlenstoff-Bepreisung nicht funktioniert, was dann? Die Energiewissenschaft sagt uns, wie wir die CO2-Emissionen in die Atmosphäre in dem erforderlichen Zeitrahmen tatsächlich senken können. Leider scheinen diejenigen, die den Klimawandel am leidenschaftlichsten angehen wollen, die Antworten der Energieexperten nicht zu mögen.

(…)

Welche Optionen mit großem Einfluss auf den Klimawandel schlagen also die Energiewissenschaftler vor?

Erdgas und Kernenergie als Ersatz für Kohle bei der Stromerzeugung in großen Entwicklungsländern wie Indien, China und Vietnam würden einen großen Einfluss haben. Kohlenstoffabscheidung, -nutzung und -speicherung, direkte Kohlenstoffabscheidung aus der Atmosphäre und vielleicht naturbasierte Lösungen wie die Vergrößerung der Wälder würden helfen, besonders in Regionen, die fossile Brennstoffe produzieren, wie die USA, Russland, China und der Nahe Osten.

(…)

Diese wissenschaftlich fundierten und wirtschaftlich untermauerten Energielösungen stellen ein Problem dar. Viele werden von den Menschen, die am meisten über den Klimawandel besorgt sind, nicht favorisiert. Daher werben Politiker, die auf der Suche nach Wählerstimmen für das Klima sind, weiterhin leidenschaftlich für Programme und Maßnahmen, die den Klimawandel nicht wirklich bekämpfen.

Aber wir haben eine bemerkenswerte Gelegenheit. Die Rechte kann die Notwendigkeit anerkennen, den Klimawandel zu bekämpfen. Die Linke kann die Energiewissenschaft anerkennen, die notwendig ist, um eine echte globale Reduktion der Emissionen in die Atmosphäre zu erreichen. Und die Entwicklungs- und Schwellenländer können sich weiter aus der Energiearmut befreien.

Leider scheint dies noch lange nicht der Fall zu sein. Klimapolitik scheint in Europa und den USA Energielösungen zu übertrumpfen, und die Entwicklungsländer verbrennen weiterhin Kohle.

Scott Tinker ist der Allday-Stiftungslehrstuhl für Untergrundgeologie und Direktor des Bureau of Economic Geology an der University of Texas in Austin.

Sollte der Klimawandel wirklich ein Problem sein, können wir ihn nur angehen, wenn wir wirtschaftlich tragfähige Wege verfolgen, die den Zugang zu erschwinglicher, zuverlässiger Energie bewahren und den weiteren Ausbau des menschlichen Wohlstands ermöglichen. Und der private Sektor ist weitaus besser darin, dies zu tun als jede Regierung.

References

Bereiter, Bernhard. Sarah Eggleston, Jochen Schmitt, Christoph Nehrbass-Ahles, Thomas F. Stocker, Hubertus Fischer, Sepp Kipfstuhl and Jerome Chappellaz. 2015. Revision of the EPICA Dome C CO2 record from 800 to 600 kyr before present. Geophysical Research Letters. . doi: 10.1002/2014GL061957. LINK

Bereiter et al. (2014), Revision of the EPICA Dome C CO2 record from 800 to 600 kyr before present, Geophysical Research Letters, doi: 10.1002/2014GL061957. Data

Berner, R.A. and Z. Kothavala, 2001. GEOCARB III: A Revised Model of Atmospheric CO2 over Phanerozoic Time, American Journal of Science, v.301, pp.182-204, February 2001.

Charney, J., Arakawa, A., Baker, D., Bolin, B., Dickinson, R., Goody, R., . . . Wunsch, C. (1979). Carbon Dioxide and Climate: A Scientific Assessment. National Research Council. Washington DC: National Academies Press. Doi: https://doi.org/10.17226/12181

Dott, Robert H. & Roger L. Batten. Evolution of the Earth. McGraw-Hill, Inc. Second Edition 1976. p. 441.

Galloway, William. (2008). “Chapter 15 Depositional Evolution of the Gulf of Mexico Sedimentary Basin”. Volume 5: Ed. Andrew D. Miall, The Sedimentary Basins of the United States and Canada., ISBN: 978-0-444-50425-8, Elsevier B.V., pp. 505-549.

Jevrejeva, S., J. C. Moore, A. Grinsted, and P. L. Woodworth (2008). “Recent global sea level acceleration started over 200 years ago?”. Geophys. Res. Lett., 35, L08715, doi:10.1029/2008GL033611.

Jevrejeva, S. , J.C. Moore, A. Grinsted, A.P. Matthews, G. Spada. 2014. “Trends and acceleration in global and regional sea levels since 1807”. Global and Planetary Change. %vol 113, 10.1016/j.gloplacha.2013.12.004 https://www.psmsl.org/products/reconstructions/jevrejevaetal2014.php

Lear, Caroline H., Pallavi Anand, Tom Blenkinsop, Gavin L. Foster, Mary Gagen, Babette Hoogakker, Robert D. Larter, Daniel J. Lunt, I. Nicholas McCave, Erin McClymont, Richard D. Pancost, Rosalind E.M. Rickaby, David M. Schultz, Colin Summerhayes, Charles J.R. Williams and Jan Zalasiewicz. Geological Society of London Scientific Statement: what the geological record tells us about our present and future climate.

Journal of the Geological Society, 178, jgs2020-239, 28 December 2020, https://doi.org/10.1144/jgs2020-239

Lewis, N., & Curry, J. (2018, April 23). The impact of recent forcing and ocean heat uptake data on estimates of climate sensitivity. Journal of Climate. Retrieved from https://journals.ametsoc.org/doi/10.1175/JCLI-D-17-0667.1

Lindzen, R., & Choi, Y.-S. (2011, August 28). On the Observational Determination of Climate Sensitivity and Implications. Asia-Pacific Journal of Atmospheric Sciences, 47(377). Retrieved from https://link.springer.com/article/10.1007/s13143-011-0023-x#citeas

Ljungqvist, F.C. 2010. “A new reconstruction of temperature variability in the extra-tropical Northern Hemisphere during the last two millennia”. Geografiska Annaler: Physical Geography, Vol. 92 A(3), pp. 339-351, September 2010. DOI: 10.1111/j.1468-459.2010.00399.x

MacFarling-Meure, C., D. Etheridge, C. Trudinger, P. Steele, R. Langenfelds, T. van Ommen, A. Smith, and J. Elkins (2006). “Law Dome CO2, CH4 and N2O ice core records extended to 2000 years BP“. Geophys. Res. Lett., 33, L14810, doi:10.1029/2006GL026152.

May, Andy. Climate Catastrophe! Science or Science Fiction? American Freedom Publications LLC, 2018.

Miller, Kenneth & Kominz, Michelle & V Browning, James & Wright, James & Mountain, Gregory & E Katz, Miriam & J Sugarman, Peter & Cramer, Benjamin & Christie-Blick, Nicholas & Pekar, S. (2005). “The Phanerozoic Record of Global Sea-Level Change”. Science (New York, N.Y.). 310. 1293-8. 10.1126/science.1116412.

Moberg, A., D.M. Sonechkin, K. Holmgren, N.M. Datsenko and W. Karlén. 2005. “Highly variable Northern Hemisphere temperatures reconstructed from low- and high-resolution proxy data”. Nature, Vol. 433, No. 7026, pp. 613-617, 10 February 2005.

Nerem, R. S., B. D. Beckley, J. T. Fasullo, B. D. Hamlington, D. Masters, G. T. Mitchum. “Climate-change–driven accelerated sea-level rise”. Proceedings of the National Academy of Sciences. Feb 2018, 115 (9) 2022-2025; DOI: 10.1073/pnas.1717312115

Pagani, Mark, Michael Arthur & Katherine Freeman. (1999). “Miocene evolution of atmospheric carbon dioxide”. Paleoceanography. 14. 273-292. 10.1029/1999PA900006.

Royer, D. L., R. A. Berner, I. P. Montanez, N. J. Tabor and D. J. Beerling. “CO2 as a primary driver of Phanerozoic climate”. GSA Today, Vol. 14, No. 3. (2004), pp. 4-10

Severinghaus, J. P., Sowers, T., Brook, E. J., Alley, R. B., & Bender, M. L. (1998, January 8). Timing of abrupt climate change at the end of the Younger Dryas interval from thermally fractionated gases in polar ice. Nature, 391, pp. 141-146. Retrieved from http://shadow.eas.gatech.edu/~jean/paleo/Severinghaus_1998.pdf

Terando, A., Reidmiller, D., Hostetler, S.W., Littell, J.S., Beard, T.D., Jr., Weiskopf, S.R., Belnap, J., and Plumlee, G.S., 2020, Using information from global climate models to inform policymaking—The role of the U.S. Geological Survey: U.S. Geological Survey Open-File Report 2020–1058, 25 p., https://doi.org/10.3133/ofr20201058.

Tripati, A.K., C.D. Roberts, and R.A. Eagle. 2009. “Coupling of CO2 and Ice Sheet Stability Over Major Climate Transitions of the Last 20 Million Years”. Science, Vol. 326, pp. 1394 1397, 4 December 2009. DOI: 10.1126/science.1178296

Wagner F, et al., 1999. Century-scale shifts in Early Holocene CO2 concentration. Science 284:1971–1973.

Wagner F, Kouwenberg LLR, van Hoof TB, Visscher H, 2004. Reproducibility of Holocene atmospheric CO2 records based on stomatal frequency. Quat Sci Rev 23:1947–1954. LINK

Zachos, J. C., Pagani, M., Sloan, L. C., Thomas, E. & Billups, K. “Trends, rhythms, and aberrations in global climate 65 Ma to present”. Science 292, 686–-693 (2001).

Übersetzt von Chris Frey EIKE