Unsichtbare Katastrophen und Untergangs-Prophezeiungen

Patrick Moore, einer der Gründer von Greenpeace, verließ die Organisation, als sie aufhörte, sich um die Umwelt zu kümmern und nur noch eine weitere profitorientierte, hart-linke Frontgruppe wurde – in seinen Worten „ein Schläger, der mit Junk-Wissenschaft hausieren geht“. Jetzt hat er das beste Buch über den Klimawandel geschrieben, das ich gelesen habe – und ich habe viele gelesen.

Der Titel „Fake invisible catastrophes and threats of doom“ [siehe oben] ist holprig. Aber das Buch selbst ist in Patricks charakteristischem, sanften, leichtfüßigen Stil geschrieben, so dass der nicht-wissenschaftliche Leser es leicht verstehen kann. Das Buch ist bereits vor der Veröffentlichung auf Amazon erhältlich, und Patrick bekommt schon jetzt begeisterte Kritiken von Lesern. Hier ist eine:

„Ich habe gerade eine Kindle-Version gekauft. Ich kann es nicht glauben. Ich bin schon im 3. Kapitel. Es klärt selbst für Nicht-Wissenschaftler wie mich in einem so feinen Detail auf. Ich habe meinen Tennispartner angerufen und das Spiel abgesagt. Ich werde mit dem Buch sitzen, bis es fertig ist, und dann werde ich es noch einmal lesen.“

Die zentrale These desselben ist Folgende:

Vor einiger Zeit dämmerte mir, dass die große Mehrheit der Schauergeschichten über den gegenwärtigen und zukünftigen Zustand des Planeten und der Menschheit als Ganzes auf Themen basieren, die entweder unsichtbar, extrem weit entfernt oder beides sind. Daher hat die große Mehrheit der Menschen keine Möglichkeit, den Wahrheitsgehalt dieser Behauptungen, die diese angeblichen Katastrophen und verheerenden Bedrohungen vorhersagen, selbst zu beobachten und zu überprüfen. Stattdessen müssen sie sich auf die Aktivisten, die Medien, die Politiker und die Wissenschaftler verlassen – die allesamt ein sehr großes finanzielles und/oder politisches Interesse an dem Thema haben – um ihnen die Wahrheit zu sagen. Dies lädt geradezu dazu ein, einfach Narrative zu erfinden, wie zum Beispiel die Behauptung, dass „CO2-Emissionen aus der Verbrennung fossiler Brennstoffe einen Klimanotstand verursachen.“

Niemand kann tatsächlich sehen oder in irgendeiner Weise spüren, was CO2 tatsächlich tun könnte, denn es ist unsichtbar, geruchlos, geschmacklos, geräuschlos und kann nicht ertastet werden. Daher ist es schwierig, solche Behauptungen zu widerlegen, weil es nichts gibt, worauf man zeigen und die Falschheit dieser Behauptungen greifbar machen könnte. Man kann nicht einfach auf sichtbares CO2 zeigen und sagen: „Schaut mal, was für schreckliche Dinge das CO2 dort anrichtet.“ CO2 als schädliche, weltvernichtende Emission ist also ein nahezu perfektes Thema, um eine Weltuntergangsgeschichte zu erfinden und zu propagieren, und diese Tatsache ist denjenigen nicht entgangen, die mit unbelegten Behauptungen hausieren gehen. CO2 ist zum Sündenbock für eine ganzen Katalog negativer Effekte geworden, deren Aufzeichnung und tabellarische Auflistung 118 Bücher erfordern würde. Tatsächlich listet die Website www.goodreads.com 118 Bücher zum Thema Klimawandel, und das beschränkt sich auf Bücher aus dem angelsächsischen Sprachraum.

Wenn man diese „Narrative“ über unsichtbare und weit entlegene Umstände studiert, kommt man nicht umhin zu bemerken, dass sich die Verfechter oft dazu herablassen, sich lächerlich zu machen und zu beschämen und auch keine Bereitschaft zeigen, die Behauptungen in einer zivilisierten Weise zu diskutieren. Es ist praktisch unmöglich, sich auf eine Debatte einzulassen, da sie diejenigen, die ihr Narrativ in Frage stellen, gewöhnlich als Skeptiker, Lügner, Leugner oder als unter einer Decke mit „Big Oil“ steckend abtun. Und falls der angebliche Skeptiker eine Anstellung hat, werden diese Erzähler heimtückisch daran arbeiten, diesen von seinem Lebensunterhalt oder seiner Position entfernen zu lassen. Zusammenfassend lässt sich sagen, dass diese Befürworter globaler Umweltkatastrophen definitiv ein skurriler und unehrlicher Haufen sind. Ein gesunder Skeptizismus ist das Herzstück wissenschaftlicher Forschung, und er hat eine wesentliche Rolle bei der Ermittlung der faktischen, wissenschaftlichen Wahrheit gespielt. Es ist die Pflicht der Wissenschaftler, allen neuen Behauptungen gegenüber skeptisch zu sein, besonders wenn es sich um Vorhersagen von Katastrophen handelt, die noch nicht eingetreten sind.

[Hervorhebung vom Übersetzer]

Fake Invisible Catastrophes spricht in einem einzelnen Absatz zahlreiche dieser Pseudo-Katastrophen an: „Afrikas älteste Affenbrotbäume sterben in einem noch nie dagewesenen Tempo, und der Klimawandel könnte daran schuld sein“ [USA Today], „93% des Great Barrier Reefs sind praktisch tot“ [Huffpost], „Das Great Barrier Reef ist jetzt im Endstadium“ [National Geographic], Eisbären in der Arktis, eine Million Arten, die angeblich vom Aussterben bedroht sind, Müll im Pazifik, gentechnisch veränderte Lebensmittel, Angst vor atomarer Strahlung, Waldbrände, Massensterben von Walrossen und die „Versauerung“ der Ozeane – all das bezeichnegt Patrick als „eine komplette Erfindung“.

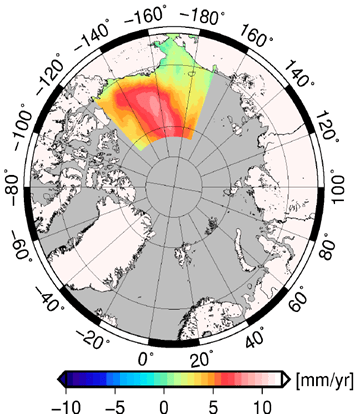

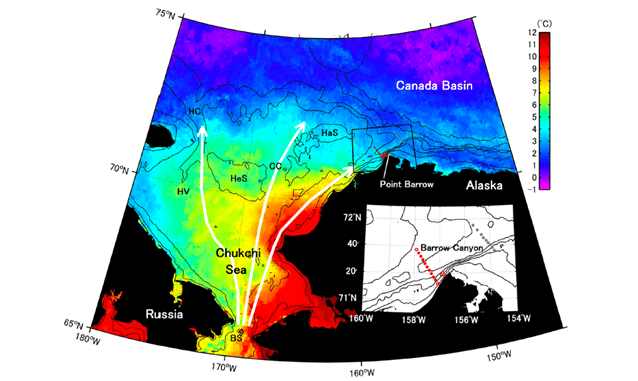

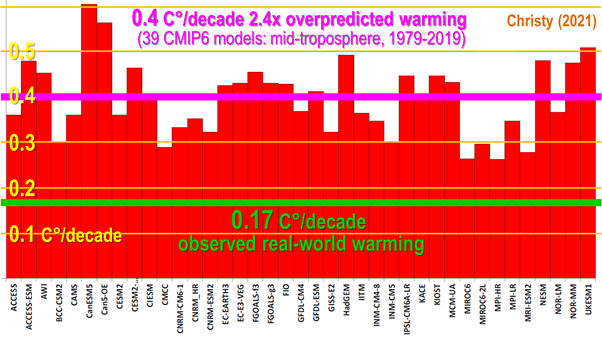

Die harte Wissenschaft beschränkt sich auf ein einziges, massives Kapitel, Klima der Angst und der Schuld, das Patrick an dritter Stelle im Buch platziert hat, damit die Leser nicht gleich zu Beginn davon abgeschreckt werden. Dennoch ist es ein klares, überzeugendes Kapitel, das sich mit den zahlreichen wissenschaftlichen Fiktionen beschäftigt, mit denen die Profiteure des Untergangs hausieren gehen. Das Kapitel listet einige der tausenden von angeblichen Schäden durch unsere Emissionssünden auf: Höhere Temperaturen, niedrigere Temperaturen, mehr Schnee, weniger Schnee, mehr Dürre, mehr Überschwemmungen, höherer Meeresspiegel, weniger Gletscher, kein Eis am Nordpol, massenhaftes Artensterben, mehr Stürme, stärkere Stürme, brennende Wälder, sterbende Korallenriffe, verschwindende Fische, tödliche Hitzewellen, dünnere Schweine, fettere Pferde, Missernten, Nahrungsmittelknappheit, saure Ozeane, Milliarden von Klimawandel-Flüchtlingen, mehr Krebs, mehr Herzkrankheiten, mehr Lungenkrankheiten, mehr Geisteskrankheiten, weniger französische Weine.

Patrick stellt unverblümt fest: „Tatsache ist, dass es keine stichhaltigen Beweise dafür gibt, dass irgendetwas von diesen Dingen durch vom Menschen verursachte CO2-Emissionen ausgelöst wurde oder wird. Es sind alles Mutmaßungen, die auf der Hypothese beruhen, dass Kohlendioxid die Temperatur steuert, was selbst nie als Tatsache festgestellt wurde. Noch wichtiger ist, dass die meisten dieser Behauptungen Vorhersagen über Dinge sind, die bis heute nicht eingetreten sind und vielleicht nie eintreten werden.“

Das Wissenschaftskapitel weist darauf hin, dass Wissenschaft nicht durch Konsens betrieben wird („kein gültiger wissenschaftlicher Begriff, sondern ein sozialer und politischer Begriff“), und dass viele der größten Wissenschaftler der Welt – Galileo, Mendel, Darwin und Einstein – den zuvor bestehenden Konsens umstürzten.

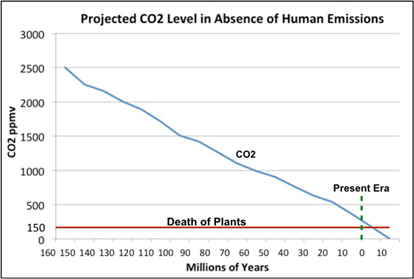

Einer von Patricks wissenschaftlichen Lieblingspunkten kommt im Wissenschaftskapitel gut zur Geltung: Der große Rückgang des CO2 – warum ist er passiert? „Beginnend vor etwa 150 Millionen Jahren ist Kohlendioxid kontinuierlich auf den niedrigsten bekannten Wert in der Geschichte des Lebens auf der Erde gesunken. Während des letzten glazialen Maximums, vor 20.000 Jahren, fiel der CO2-Gehalt auf etwa 180 ppm, nur 30 ppm über dem Niveau, bei dem Pflanzen beginnen, an CO2-Hunger zu sterben.“ Wären wir nicht gewesen, wäre innerhalb weniger Millionen Jahre genug CO2 aus der Atmosphäre verschwunden, um die meisten Pflanzen und Bäume verhungern zu lassen.

[Hervorhebung vom Übersetzer]

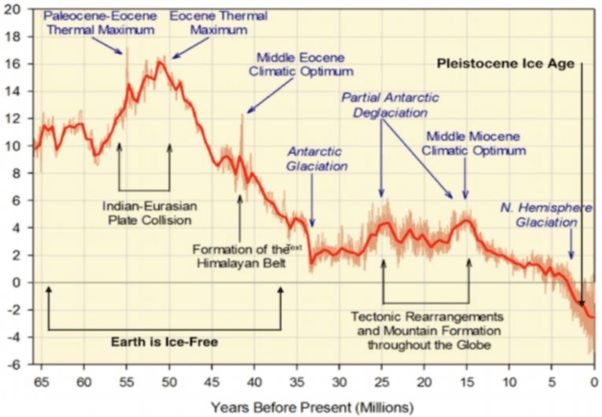

Und hier wird gezeigt, wie die Temperatur der Tiefsee seit etwa 50 Millionen Jahren sinkt:

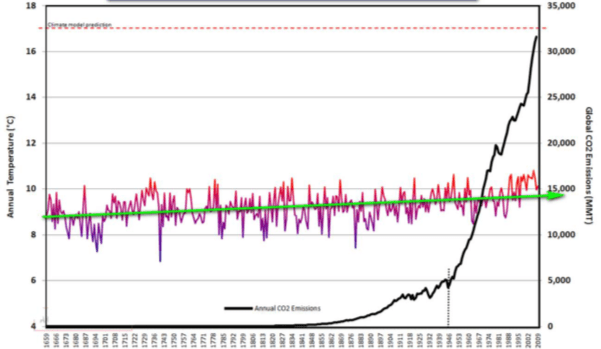

Sogar Homer nickt. Die folgende Grafik der Temperaturen in Mittelengland im Vergleich zu den globalen CO2-Emissionen in Millionen Tonnen verwendet einen statistischen Trickbetrug der normalerweise von den Klimafanatikern begangen wird:

Die Grafik scheint zu zeigen, dass sich erstere kaum verändert haben, während letztere in die Höhe geschossen sind. Die Wahrheit ist, dass die y-Achse des CO2-Diagramms gestreckt wurde, während die des Temperaturdiagramms gestaucht wurde. Machen wir diese Manipulationen doch einmal rückgängig:

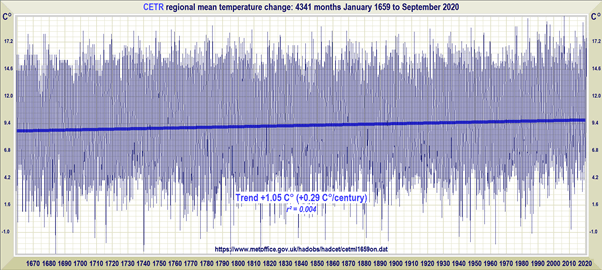

Der Trend beträgt etwas mehr als 1 Grad in 360 Jahren, oder weniger als ein Drittel Grad pro Jahrhundert. Aber fast drei Fünftel dieser Erwärmung fand in den 30 Jahren seit 1990 statt, seither hat sich unsere feuchte Insel [UK] mit einer Rate erwärmt, die 2 Grad pro Jahrhundert entspricht:

Abgesehen von ein paar Kleinigkeiten wie diesem, ist Patricks Buch eine erstklassige Lektüre. Selbst ich, der ich mich seit 15 Jahren für das Klima interessiere, fand darin vieles, was ich nicht wusste. Besonders wertvoll wird das Buch für diejenigen sein, die sich bisher damit begnügt haben, mit der Parteilinie mitzuschwimmen. Für sie wird das Buch eine Offenbarung sein: Die Entheiligung von Attenborough ist besonders befriedigend.

Heutzutage werden die Bestsellerlisten stark von den Verkäufen vor der Veröffentlichung beeinflusst. Falls Sie also jetzt bestellen, sind Sie für die Marketingkampagne von echtem Wert. Und Patrick, der mehr Schläge einstecken musste als die meisten von uns, weil er es wagte, den Profiteuren des Untergangs Fragen zu stellen, verdient unsere volle Unterstützung.

Link: https://wattsupwiththat.com/2021/01/20/fake-invisible-catastrophes-and-threats-of-doom/

Übersetzt von Chris Frey EIKE