PAGES 12K: Die Eiszeit geht weiter

Ich denke, das Papier stellt einen gutgläubigen Versuch dar, den globalen Klimawandel über die letzten 12.000 Jahre zu rekonstruieren. Die Autoren waren sehr transparent, was die Daten und Verfahren angeht, und merkten sogar an, dass niemand wirklich weiß, wie man das Klima auf dieser Art von Skala rekonstruieren kann. Obwohl es sich nicht um einen Mann’schen Hockeystick oder ein Marcott’sches Durcheinander handelt, bestanden sie darauf, die niederfrequente Komponente des Klimasignals auszublenden und die hochauflösende instrumentelle Aufzeichnung direkt mit der sehr niederfrequenten, stark geglätteten Multi-Proxy-Rekonstruktion zu vergleichen. Das heißt, eine ihrer fünf Rekonstruktions-Verfahren bewahrte das niederfrequente Klimasignal (ja, ich verwende das Wort „Signal“ korrekt). Dieser Beitrag soll auf zwei Dinge hinweisen:

1. Direkte Vergleiche der instrumentellen Daten mit der Rekonstruktion verletzen die Grundprinzipien der Signaltheorie.

2.Nur das Composite Plus Scale (CPS)-Verfahren ist mit den Beobachtungen konsistent.

Verletzung der Signaltheorie, 15-Yard-Raumstrafe* und Loss of Down*

[*Diese Begriffe stammen aus dem American Football und lassen sich nicht übersetzen. Sie sind sehr grob vergleichbar mit einem Elfmeter im Fußball. A. d. Übers.]

Dies ist aus der Einleitung der Studie:

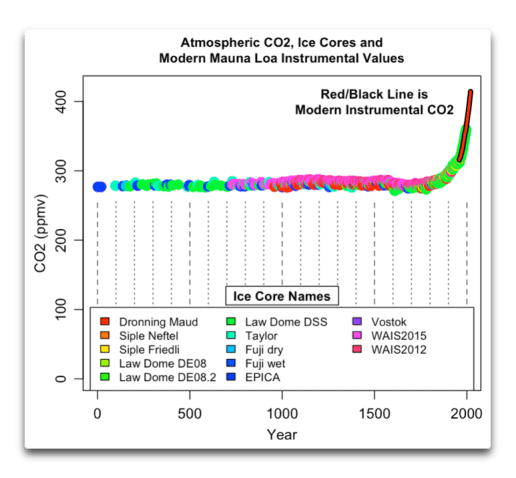

Die Datenbank ist die umfassendste derzeit verfügbare globale Zusammenstellung von bisher veröffentlichten holozänen Proxy-Temperaturzeitreihen. Sie umfasst eine Qualitäts-kontrollierte Sammlung von hochauflösenden Zeitreihen (durchschnittlicher Probenabstand von 164 Jahren) mit gut etablierten Zeitskalen (durchschnittlich 1,0 Alterskontrollpunkte pro 1000 Jahre), die aus einer viel größeren Sammlung von Temperatur-sensitiven Proxy-Aufzeichnungen ausgewählt wurde. Die Multi-Proxy-Datenbank umfasst insgesamt 1319 Paläo-Temperaturaufzeichnungen von 470 terrestrischen und 209 maritimen Standorten, an denen ökologische, geochemische und biophysikalische Proxy-Indikatoren verwendet wurden, um auf vergangene Temperaturänderungen zu schließen. Unter der Vielzahl der Proxy-Typen sind Alkenone und Isotope die dominierenden Proxy-Typen für die Meeresoberflächentemperatur, während Pollen und Chironomiden die häufigsten terrestrischen Temperatur-Proxy-Typen sind. Die meisten Aufzeichnungen (97 %) sind als quantitative, auf °C kalibrierte Temperaturrekonstruktionen verfügbar, während die restlichen 42 Aufzeichnungen nicht-quantitative, Temperatur-sensitive Proxy-Aufzeichnungen darstellen.

Dies ist aus „Timing and magnitude of peak Holocene global temperature“:

Um den wahrscheinlichen Bereich der zeitlichen Auflösung der GMST-Rekonstruktion einzugrenzen, konzentrieren wir uns auf Intervalle von 1000 und 200 Jahren und quantifizieren den Unterschied in der Größe und dem Zeitpunkt des Höhepunktes der Erwärmung (Abb. 4).

In meinem vorherigen Beitrag habe ich die Rekonstruktion so behandelt, als hätte sie eine 100-Jahre-Auflösung…

Während ich immer noch denke, dass die Arbeit eine sehr gute paläoklimatologische Leistung ist, ist dieser Absatz in keiner Weise wissenschaftlich belegbar.

Die Verteilung der globalen Spitzentemperaturen während des Holozäns kann auch mit den jüngsten Temperaturen verglichen werden. Die GMST der letzten Dekade (2011-2019) lag im Durchschnitt 1 °C höher als 1850-190011. Für 80 % der Ensemblemitglieder übertraf kein 200-Jahres-Intervall während der letzten 12.000 Jahre die Wärme der jüngsten Dekade. Für die anderen 20 % der Fälle, die hauptsächlich aus der CPS-Rekonstruktion stammen, übertraf mindestens ein 200-Jahres-Intervall die jüngste Dekade. Dieser Vergleich ist konservativ im Kontext der für den Rest dieses Jahrhunderts und darüber hinaus prognostizierten Temperaturen, die sehr wahrscheinlich 1 °C über der vorindustriellen Temperatur liegen werden. Solche Projektionen stellen die Temperatur des letzten Jahrzehnts in einen langfristigen Kontext, der besser mit der holozänen GMST-Rekonstruktion vergleichbar ist. Wenn die Rekonstruktion außerdem durch eine Verzerrung des Sommers der nördlichen Hemisphäre beeinflusst wird (siehe unten), dann würde die Spitzenerwärmung überschätzt werden und die jüngste Erwärmung würde daher im Vergleich noch stärker hervorstechen.

Die Rekonstruktion kann keine Temperaturänderungen auf dekadischer Skala auflösen. Bei der Auflösung der Rekonstruktion wäre HadCRUT4 ein einzelner Datenpunkt bei 0,23 °C.

Die Eiszeit geht weiter

Folgendes hatten die Autoren über die CPS-Rekonstruktionsmethode zu sagen…

Unter den fünf Rekonstruktionsverfahren sticht CPS mit seinen großen Temperaturänderungen hervor (Abb. 3), vor allem auf der Nordhemisphäre (Abb. 1 und 2). Zum Beispiel zeigt das mediane Ensemble-Mitglied der CPS-Rekonstruktion, dass sich die GMST zwischen 12 und 10 ka um etwa 3,9 °C erwärmt hat, verglichen mit etwa 1,1 °C für die anderen Verfahren. Die mediane GMST während des Zeitraums um 6 ka, dem langjährigen Zielwert für paläoklimatische Modellexperimente (z. B. Ref. 15), war in der CPS-Rekonstruktion um 1,1 °C wärmer als das 19. Jahrhundert, verglichen mit etwa 0,4-0,5 °C für die anderen Verfahren (Tabelle 1).

(…)

Obwohl es sich um einen Ausreißer handelt, haben wir keine unwiderlegbaren Beweise, um die CPS-Rekonstruktion auszuschließen, und können nicht ausschließen, dass die anderen Rekonstruktionsverfahren die Gesamtvarianz unterschätzen. Das Ergebnis des CPS-Verfahrens hängt von der Gültigkeit des für die Skalierung verwendeten Ziels ab, was schwer zu überprüfen ist. Die hohe Amplitude der durch CPS rekonstruierten Temperaturänderungen könnte chronologische und andere Unsicherheiten widerspiegeln, die die Temperaturvarianz auf der Hundertskala während des Zusammensetzens ausmitteln und dadurch die relative Größe der Varianz auf der Jahrtausendskala im Verbund erhöhen. Wenn das Komposit dann auf die Rekonstruktionen der letzten zwei Jahrtausende skaliert wird, die eine realistischere Varianz auf der Jahrtausendskala aufweisen, wird die Varianz auf der Jahrtausendskala (und damit die langfristigen Trends) künstlich aufgebläht. Nichtsdestotrotz trägt CPS als unabhängiger Ansatz zu einer vollständigeren Abtastung des Unsicherheitsraums bei. Daher behalten wir CPS als ein Fünftel des Multi-Methoden-Ensembles bei, und wir konzentrieren uns auf den Median und nicht auf den Mittelwert als beste Darstellung der zentralen Tendenz des Ensembles. Der Ausschluss von CPS aus dem Ensemble hat wenig Einfluss auf den Median der GMST-Rekonstruktion. Zum Beispiel ist der Median des Ensembles für das mittlere Holozän (6,5-5,5 ka) nur um 0,05 °C kühler, wenn man die CPS-Mitglieder ausschließt; der Median des Fünf-Methoden-Ensembles beträgt 0,51 °C (0,19, 1,35) gegenüber 0,46 °C (0,17, 0,79), wenn man die CPS-Mitglieder ausschließt.

Sie ließen zähneknirschend CPS in der Mischung, denn: „Obwohl es ein Ausreißer ist, haben wir keine unwiderlegbaren Beweise, um die CPS-Rekonstruktion auszuschließen, und können die Möglichkeit nicht ausschließen, dass die anderen Rekonstruktionsverfahren die Gesamtvarianz unterschätzen.“

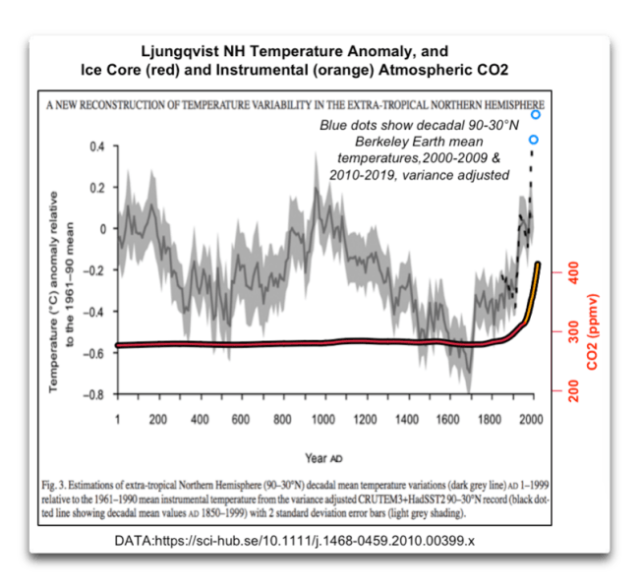

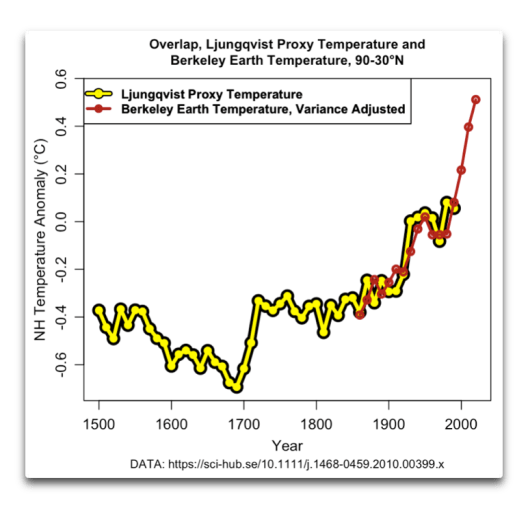

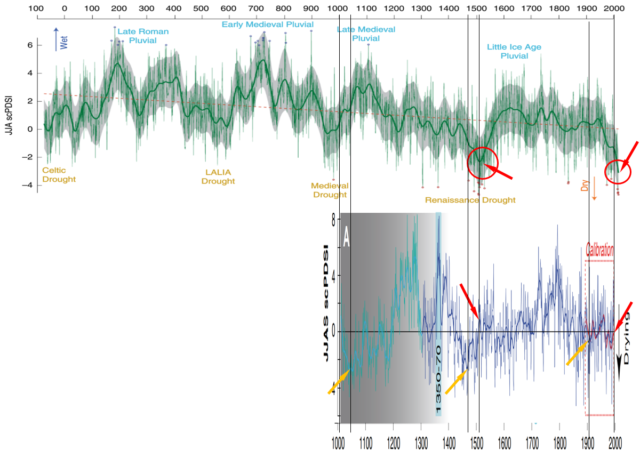

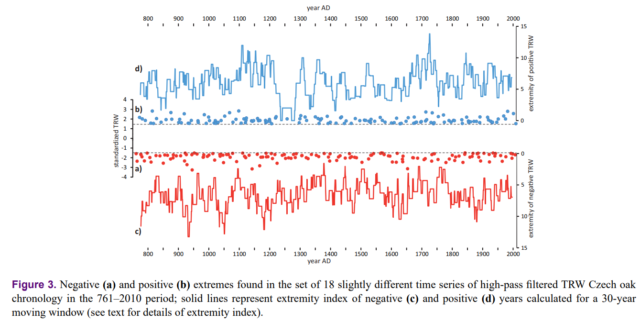

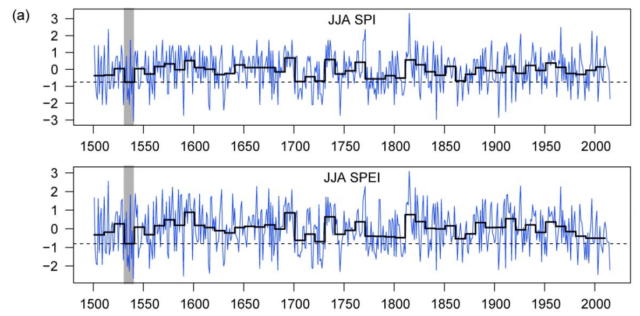

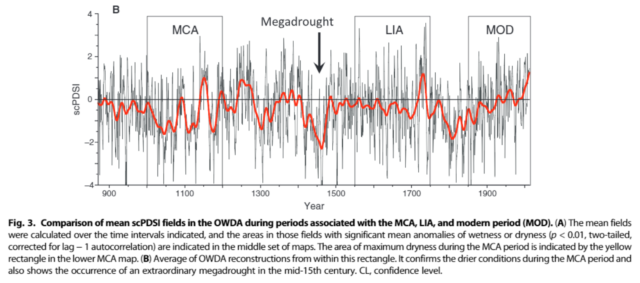

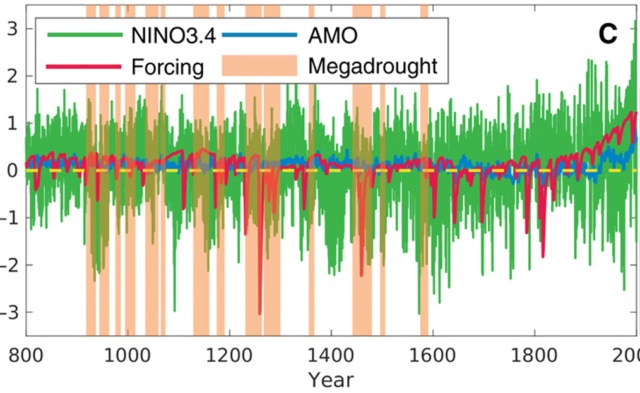

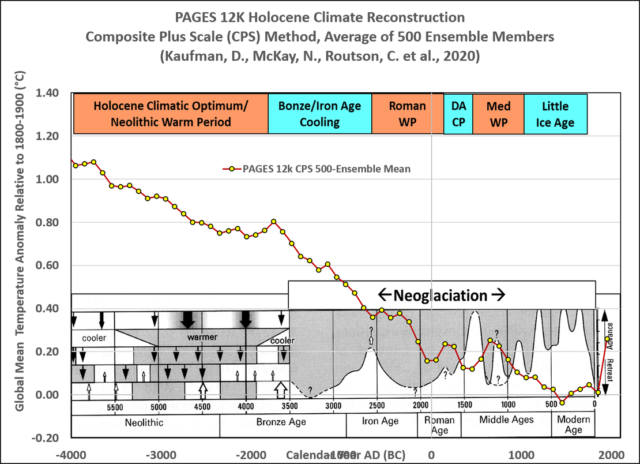

Allerdings hätten sie leicht Beweise finden können dafür, „dass die anderen Rekonstruktionsverfahren die Gesamtvarianz unterschätzen.“ CPS ist das einzige Verfahren, das das holozäne Klimaoptimum, die römische Warmzeit, die mittelalterliche Warmzeit und die Neu-Vergletscherung eindeutig auflöste…

[Hinweis: Die Abbildungen 1 und 2 sind bis Redaktionsschluss am 28.3. auch im Original nicht existent]

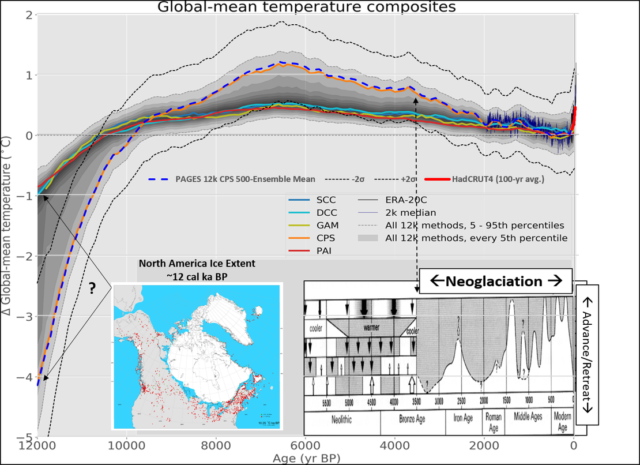

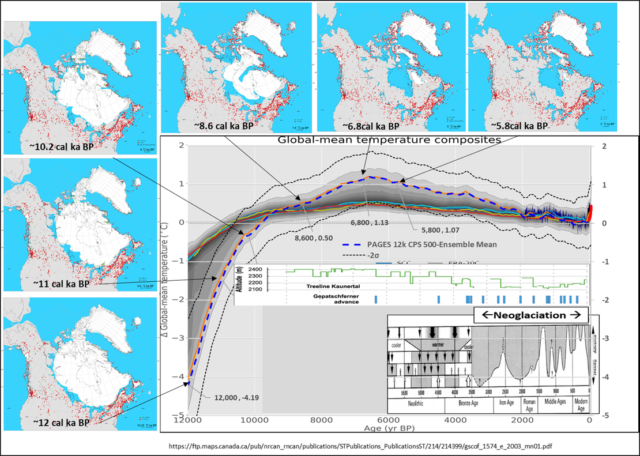

Ich habe einen Plot von CPS als Overlay von Abbildung 3 aus dem PAGES 12K-Paper erstellt und den 2K-Inset mit den historischen Klimaperioden und der Neoglazialisierung aus Grosjean et al., 2007 und einer Nordamerika-Eisausdehnungskarte aus Dyke et al., 2003 ersetzt. Ich habe auch ein 2σ-Konfidenzband aus den 500 Ensemblemitgliedern eingefügt. Meine Version des CPS-Mittelwerts ist die gestrichelte orangefarbene Kurve…

Sieht die nordamerikanische Eisausdehnung vor 12.000 Kalenderjahren eher 1 °C kühler aus als 1800-1900? Oder 4 °C kühler?

OK… geophysikalische Trägheit könnte erklären, wie es bei Temperaturen, die nur 1 °C kühler waren als 1800-1900, immer noch so viel Eis gegeben haben kann, aber ich glaube nicht, dass es das hier erklären kann:

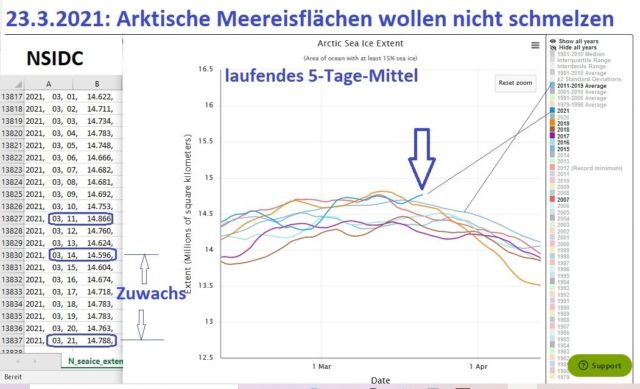

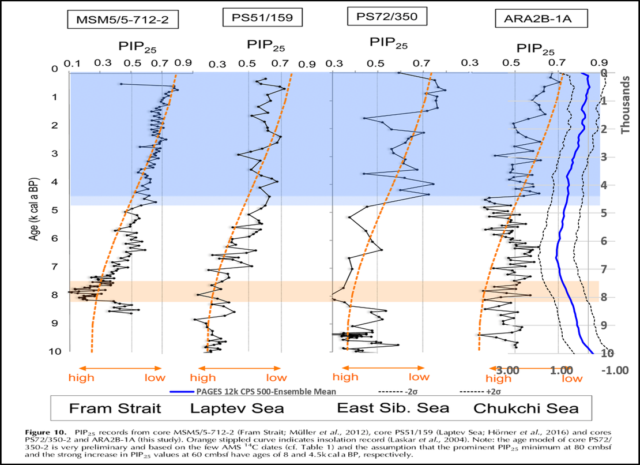

Die anderen vier Verfahren zeigen sehr geringe Temperaturänderungen von vor 9.500 Jahren bis 1850 n. Chr… Ein Zeitraum, von dem wir wissen, dass es in den ersten 5.000 Jahren einen massiven Eisrückgang und in den meisten der folgenden 4.500 Jahre einen Eisvorstoß (Neoglazial) gab. CPS ist das einzige der vier Verfahren, das mit der holozänen Entwicklung der Eisschilde und Gletscher in der nördlichen Hemisphäre übereinstimmt. Das ist auch konsistent mit der holozänen Entwicklung des arktischen Meereises.

Das CPS-Verfahren ist eindeutig konsistent mit den nahezu eisfreien Bedingungen von vor 10.000 bis 5.000 Jahren und der neoglazialen Ausdehnung des Meereises von vor 5.000 Jahren bis Mitte des 18. Jahrhunderts. Die anderen vier Verfahren deuten auf eine sehr geringe Temperaturveränderung über diesen Zeitraum hin.

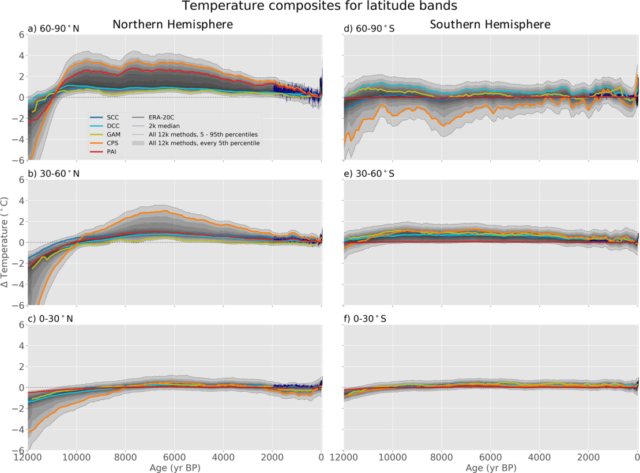

Was ist mit der Sommerverzerrung der nördlichen Hemisphäre?

Drei der vier Verfahren zeigen alle einen flachen Verlauf in der Arktis. Nur das PAI-Verfahren (Paarweiser Vergleich) zeigt eine angemessene Temperaturänderung für die Meereisentwicklung. Allerdings ist CPS das einzige Verfahren, das ein signifikantes ΔT im Bereich der gemäßigten Breiten der Nordhemisphäre aufweist.

Die überwiegende Mehrheit der Alpen-/Talgletscher (wie in den Alpen und im Glacier National Park) befindet sich in den gemäßigten Breiten. Diese Gletscher bildeten sich nach dem holozänen Klimaoptimum, erreichten ihre Spitzenausdehnung in der Mitte des 18. Jahrhunderts und zogen sich dann im Allgemeinen auf ihre derzeitigen Positionen zurück. CPS ist das einzige Verfahren, das damit in Einklang zu stehen scheint.

Bestätigungs-Bias!

Falls man bei einer Frage die Möglichkeit hat, fünf Antworten auszuwählen:

1. Sieht korrekt aus

2. Sieht vermutlich korrekt aus

3. Offensichtlich falsch

4. Offensichtlich falsch

5. Offensichtlich falsch

Würden Sie die Antwort auswählen, die richtig aussah? Oder würden Sie den Durchschnitt der fünf Antworten bilden, um zu einem Konsens zu kommen?

Ausmerzen unbequemer Wahrheiten

Seit den Tagen von Climategate versucht Climate Cancel Culture aktiv, das niederfrequente Klimasignal auszulöschen. Dies ist kein neuer Kampf:

Was würde es also bedeuten, wenn die Rekonstruktionen eine größere (Esper et al., 2002; Pollack und Smerdon, 2004; Moberg et al., 2005) oder kleinere (Jones et al., 1998; Mann et al., 1999) Temperaturamplitude anzeigen? Wir vermuten, dass die erstere Situation, d.h. eine erhöhte Variabilität während der vorindustriellen Zeit, zu einer Umverteilung des Gewichts in Richtung der Rolle natürlicher Faktoren bei der Erzwingung von Temperaturänderungen führen würde, wodurch der Einfluss anthropogener Emissionen relativ abgewertet und zukünftige Vorhersageszenarien beeinflusst würden. Sollte sich dies bewahrheiten, wären Vereinbarungen wie das Kyoto-Protokoll, die auf eine Reduzierung der anthropogenen Treibhausgasemissionen abzielen, weniger effektiv als gedacht.

Hockeyschläger sind in der Regel das Ergebnis der Dämpfung der Amplitude des niederfrequenten Klimasignals und des anschließenden Aufspleißens der hochauflösenden Instrumentaldaten. Das Hockey-Team hat die Stempelkultur erfunden:

CRU-E-Mail #1140039406. Diese E-Mail, datiert auf den 15. Februar 2006, dokumentiert den Austausch zwischen mehreren Klimawissenschaftlern, einschließlich des stellvertretenden Direktors der CRU, in Bezug auf ihre Beiträge zu Kapitel sechs des IPCC AR4. In einem solchen Austausch warnte der stellvertretende Direktor der CRU seine Kollegen davor, „sich von [dem Co-Vorsitzenden der AR4 WGl] (oder [einem Forscher an der Pennsylvania State University]) über das hinaus drängen zu lassen, von dem wir wissen, dass es richtig ist“ in Bezug auf die Angabe von „Schlussfolgerungen im AR4, die über das hinausgehen, was wir sicher rechtfertigen können“.

Keith Briffa von der CRU warnte seine Kollegen davor, sich von Susan Solomon von der NOAA oder Michael Mann von der Penn State dazu zwingen zu lassen, unhaltbare Schlussfolgerungen zu ziehen. Dieser spezielle E-Mail-Austausch befasste sich ausgiebig mit Paläoklima-Rekonstruktionen. Briffa forderte seine Kollegen auch auf, Anders Moberg nicht „anzugreifen“, der vor kurzem eine Klimarekonstruktion veröffentlicht hatte, die die Daten tatsächlich würdigte und korrekte Verfahren der Signalverarbeitung verwendete.

Susan Solomon ist die NOAA-Beamtin, die behauptete, dass die Arbeit der NOAA im Zusammenhang mit dem IPCC nicht dem FOIA unterliege. Michael Mann war der Hauptautor des gründlich entlarvten Original-Hockeysticks. Der verstorbene Keith Briffa war der Hauptautor einer der problematischen Rekonstruktionen, in denen „Mikes Naturtrick“ angewendet wurde, um den Rückgang zu „verstecken“. Glücklicherweise haben sich Wissenschaftler wie Jan Esper, Anders Moberg, etc. nicht dem Mobbing unterworfen.

Also… Hut ab vor Kaufman, McKay, Routson und den et al dafür, dass sie die CPS-Rekonstruktion nicht gelöscht haben, um den Anstieg und den Rückgang des holozänen Klimaoptimums zu verbergen…

References

Bohleber, P., Schwikowski, M., Stocker-Waldhuber, M. et al. New glacier evidence for ice-free summits during the life of the Tyrolean Iceman. Sci Rep 10, 20513 (2020). https://doi.org/10.1038/s41598-020-77518-9

Dyke, A.S., Moore, A. and L. Robertson. [computer file]. Deglaciation of North America. Geological Survey of Canada Open File 1547. Ottawa: Natural Resources Canada, 2003.

Esper, J., R.J.S. Wilson, D.C. Frank, A. Moberg, H. Wanner, & J. Luterbacher. 2005. “Climate: past ranges and future changes”. Quaternary Science Reviews 24: 2164-2166.

Grosjean, Martin, Suter, Peter, Trachsel, Mathias & Wanner, Heinz. (2007). “Ice‐borne prehistoric finds in the Swiss Alps reflect Holocene glacier fluctuations”. Journal of Quaternary Science. 22. 203 – 207. 10.1002/jqs.1111.

Kaufman, D., McKay, N., Routson, C. et al. Holocene global mean surface temperature, a multi-method reconstruction approach. Sci Data 7, 201 (2020). https://doi.org/10.1038/s41597-020-0530-7

Stein, R. , Fahl, K. , Schade, I. , Manerung, A. , Wassmuth, S. , Niessen, F. and Nam, S. (2017), Holocene variability in sea ice cover, primary production, and Pacific‐Water inflow and climate change in the Chukchi and East Siberian Seas (Arctic Ocean). J. Quaternary Sci., 32: 362-379. doi:10.1002/jqs.2929 stein2017

Link: https://wattsupwiththat.com/2021/03/26/pages-12k-the-ice-age-goeth/

Übersetzt von Chris Frey EIKE